To je gostujoča objava, ki so jo soavtorji Nafi Ahmet Turgut, Hasan Burak Yel in Damla Şentürk iz Getirja.

Ustanovljen je bil leta 2015, prinesel se je postavil kot pionir na področju ultra hitre dostave živil. To inovativno tehnološko podjetje je revolucioniralo segment dostave zadnje milje s svojo prepričljivo ponudbo »živil v nekaj minutah«. S prisotnostjo v Turčiji, Združenem kraljestvu, na Nizozemskem, v Nemčiji in Združenih državah je Getir postal multinacionalna sila, s katero je treba računati. Danes blagovna znamka Getir predstavlja raznolik konglomerat, ki zajema devet različnih vertikal, ki vse delujejo sinergistično pod edinim dežnikom.

V tej objavi razložimo, kako smo zgradili cevovod za napovedovanje kategorije izdelkov od konca do konca, da bi komercialnim ekipam pomagali z uporabo Amazon SageMaker in Serija AWS, kar skrajša trajanje usposabljanja modela za 90 %.

Podrobno razumevanje našega obstoječega asortimana izdelkov je ključen izziv, s katerim se skupaj s številnimi podjetji soočamo na današnjem hitrem in konkurenčnem trgu. Učinkovita rešitev tega problema je napovedovanje kategorij izdelkov. Model, ki ustvarja celovito drevo kategorij, omogoča našim komercialnim ekipam primerjavo našega obstoječega portfelja izdelkov s portfeljem naših konkurentov, kar ponuja strateško prednost. Zato je naš osrednji izziv izdelava in implementacija natančnega modela napovedovanja kategorije izdelkov.

Izkoristili smo močna orodja, ki jih ponuja AWS, da bi se spopadli s tem izzivom in učinkovito krmarili po kompleksnem področju strojnega učenja (ML) in napovedne analitike. Naša prizadevanja so privedla do uspešne izdelave celotnega načrta za napovedovanje kategorije izdelkov, ki združuje prednosti SageMaker in AWS Batch.

Ta zmožnost napovedne analitike, zlasti natančne napovedi kategorij izdelkov, se je izkazala za neprecenljivo. Našim ekipam je zagotovil kritične vpoglede na podlagi podatkov, ki so optimizirali upravljanje zalog, izboljšali interakcije s strankami in okrepili našo prisotnost na trgu.

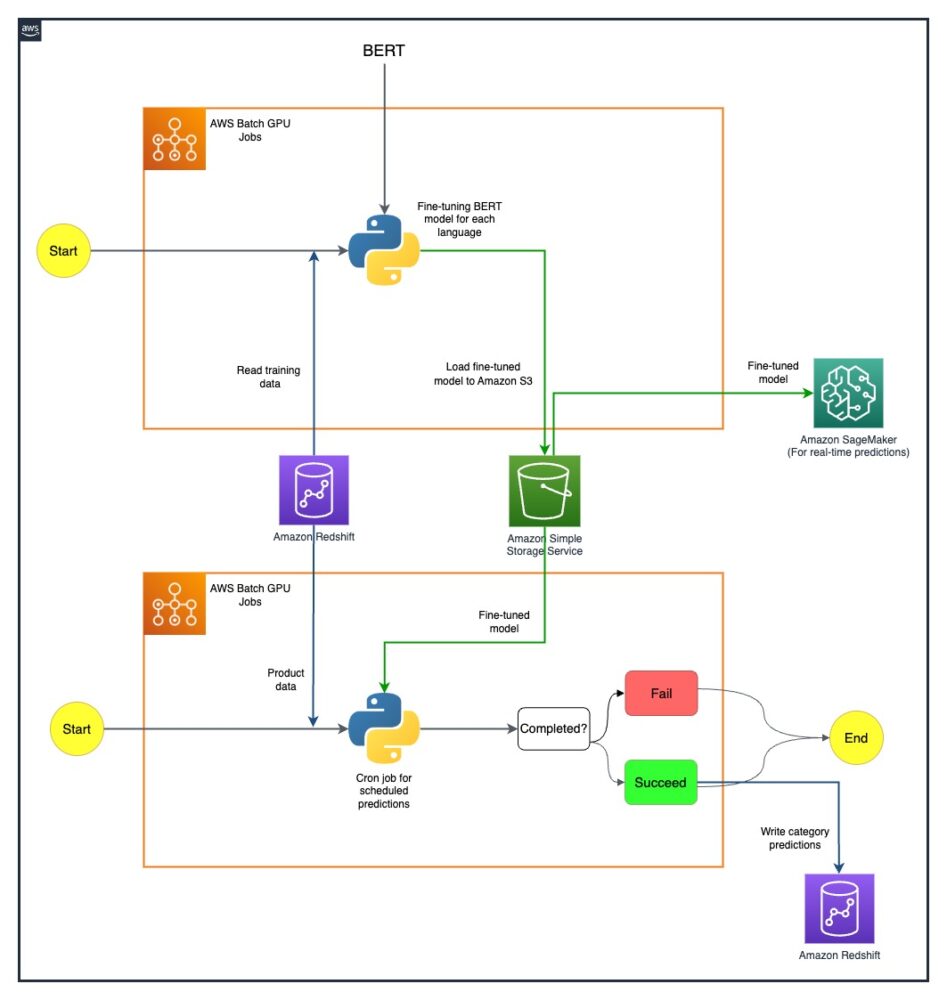

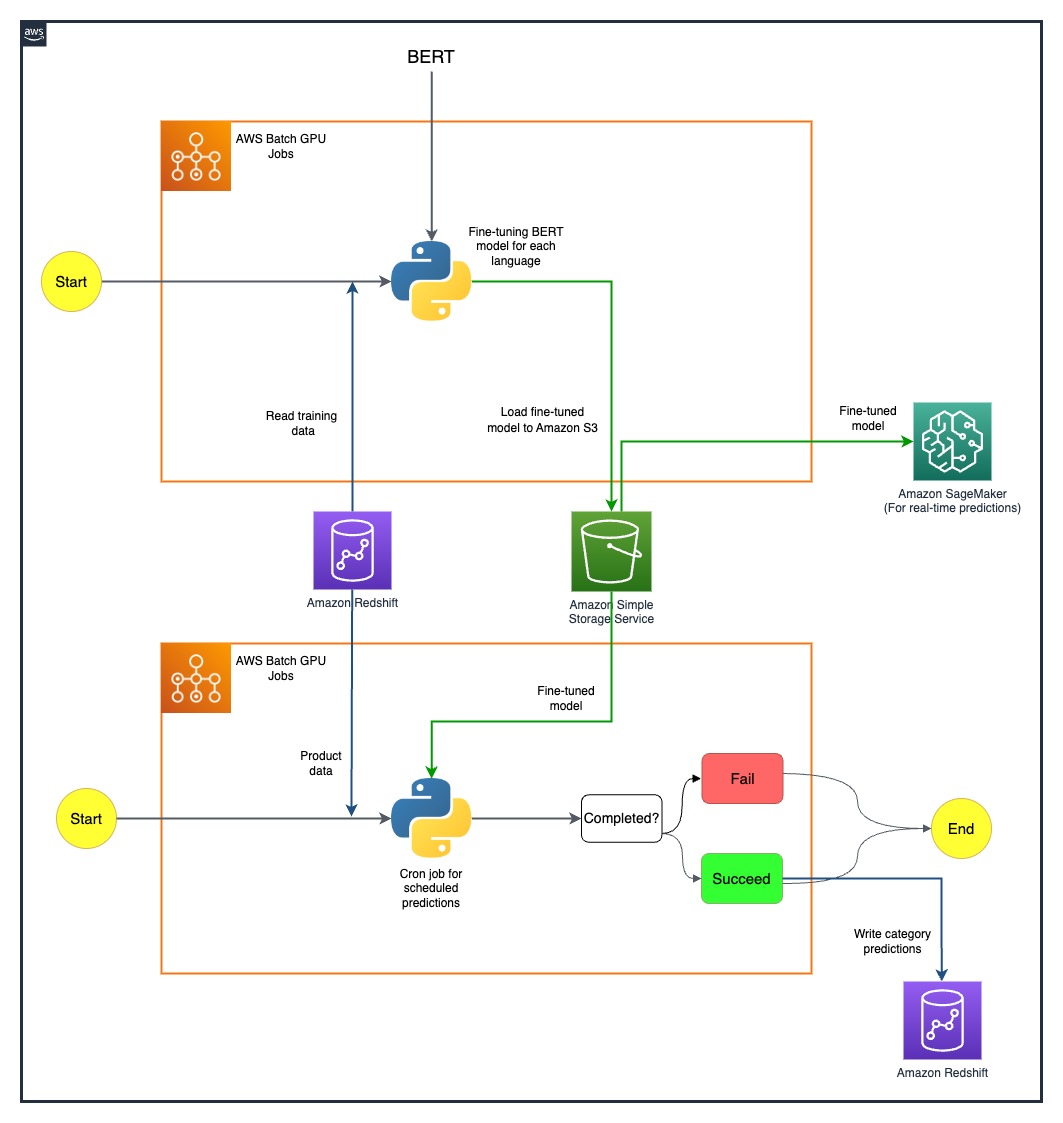

Metodologija, ki jo pojasnjujemo v tej objavi, sega od začetne faze zbiranja nabora funkcij do končne implementacije cevovoda napovedi. Pomemben vidik naše strategije je bila uporaba programov SageMaker in AWS Batch za izboljšanje vnaprej pripravljenih modelov BERT za sedem različnih jezikov. Poleg tega naša brezhibna integracija s storitvijo za shranjevanje objektov AWS Preprosta storitev shranjevanja Amazon (Amazon S3) je bil ključen za učinkovito shranjevanje in dostop do teh izpopolnjenih modelov.

SageMaker je popolnoma upravljana storitev ML. S SageMakerjem lahko podatkovni znanstveniki in razvijalci hitro in brez truda zgradijo in učijo modele ML ter jih nato neposredno uvedejo v gostujoče okolje, pripravljeno za proizvodnjo.

Kot popolnoma upravljana storitev vam AWS Batch pomaga izvajati paketne računalniške delovne obremenitve poljubnega obsega. AWS Batch samodejno zagotavlja računalniške vire in optimizira porazdelitev delovne obremenitve glede na količino in obseg delovnih obremenitev. Z AWS Batch ni treba nameščati ali upravljati programske opreme za paketno računalništvo, tako da lahko svoj čas osredotočite na analizo rezultatov in reševanje težav. Uporabili smo opravila GPE, ki nam pomagajo zagnati opravila, ki uporabljajo GPE primerka.

Pregled rešitve

Pet ljudi iz Getirjeve ekipe za podatkovno znanost in infrastrukturne ekipe je sodelovalo pri tem projektu. Projekt je bil zaključen v mesecu dni in uveden v proizvodnjo po tednu dni testiranja.

Naslednji diagram prikazuje arhitekturo rešitve.

Sestava modela poteka ločeno za vsako državo. Arhitektura vključuje dve opravili AWS Batch GPU cron za vsako državo, ki se izvajata po določenih urnikih.

Nekatere izzive smo premagali s strateško uvedbo virov SageMaker in AWS Batch GPU. Postopek, uporabljen za reševanje vsake težave, je podrobno opisan v naslednjih razdelkih.

Natančna nastavitev večjezičnih modelov BERT z opravili AWS Batch GPU

Iskali smo rešitev za podporo več jezikov za našo raznoliko bazo uporabnikov. Modeli BERT so bili očitna izbira zaradi njihove uveljavljene zmožnosti učinkovitega reševanja zapletenih nalog naravnega jezika. Da bi te modele prilagodili našim potrebam, smo izkoristili moč AWS z uporabo opravil primerkov GPE z enim vozliščem. To nam je omogočilo natančno nastavitev vnaprej pripravljenih modelov BERT za vsakega od sedmih jezikov, za katere smo potrebovali podporo. S to metodo smo zagotovili visoko natančnost pri napovedovanju kategorij izdelkov in premagali morebitne jezikovne ovire.

Učinkovito shranjevanje modelov z uporabo Amazon S3

Naš naslednji korak je bil obravnavati shranjevanje in upravljanje modela. Za to smo izbrali Amazon S3, znan po svoji razširljivosti in varnosti. Shranjevanje naših natančno nastavljenih modelov BERT na Amazon S3 nam je omogočilo enostaven dostop do različnih ekip znotraj naše organizacije in s tem bistveno poenostavilo naš postopek uvajanja. To je bil ključni vidik pri doseganju agilnosti v naših operacijah in brezhibni integraciji naših prizadevanj ML.

Ustvarjanje cevovoda za napovedovanje od konca do konca

Potreben je bil učinkovit cevovod za najboljšo uporabo naših vnaprej usposobljenih modelov. Te modele smo najprej uvedli na SageMakerju, dejanju, ki je omogočilo napovedi v realnem času z nizko zakasnitvijo, s čimer smo izboljšali našo uporabniško izkušnjo. Za obsežnejše paketne napovedi, ki so bile prav tako pomembne za naše delovanje, smo uporabili AWS Batch GPU opravila. To je zagotovilo optimalno uporabo naših virov in nam zagotovilo popolno ravnovesje med zmogljivostjo in učinkovitostjo.

Raziskovanje prihodnjih možnosti z MME SageMaker

Medtem ko se še naprej razvijamo in iščemo učinkovitost v našem cevovodu ML, je ena pot, ki jo želimo raziskati, uporaba večmodelnih končnih točk (MME) SageMaker za uvajanje naših natančno nastavljenih modelov. Z MME lahko potencialno poenostavimo uvajanje različnih natančno nastavljenih modelov, s čimer zagotovimo učinkovito upravljanje modelov, hkrati pa izkoristimo domače zmogljivosti SageMakerja, kot so senčne različice, samodejno skaliranje in amazoncloudwatch integracija. To raziskovanje je usklajeno z našim stalnim prizadevanjem za izboljšanje naših zmogljivosti napovedne analitike in zagotavljanje vrhunskih izkušenj našim strankam.

zaključek

Naša uspešna integracija SageMaker in AWS Batch ni le obravnavala naših posebnih izzivov, ampak je tudi znatno povečala našo operativno učinkovitost. Z uvedbo sofisticiranega cevovoda za napovedovanje kategorij izdelkov lahko naše komercialne ekipe opolnomočimo z vpogledi, ki temeljijo na podatkih, s čimer olajšamo učinkovitejše odločanje.

Naši rezultati veliko govorijo o učinkovitosti našega pristopa. Dosegli smo 80-odstotno natančnost napovedi na vseh štirih ravneh razdrobljenosti kategorij, kar igra pomembno vlogo pri oblikovanju asortimana izdelkov za vsako državo, ki jo opravljamo. Ta raven natančnosti razširja naš doseg preko jezikovnih ovir in zagotavlja, da z največjo natančnostjo poskrbimo za našo raznoliko bazo uporabnikov.

Poleg tega nam je s strateško uporabo načrtovanih opravil AWS Batch GPU uspelo skrajšati naše trajanje usposabljanja za modele za 90 %. Ta učinkovitost je dodatno poenostavila naše procese in okrepila našo operativno agilnost. Učinkovito shranjevanje modelov z uporabo Amazon S3 je imelo ključno vlogo pri tem dosežku, saj je uravnotežilo predvidevanja v realnem času in paketne napovedi.

Za več informacij o tem, kako začeti graditi lastne cevovode ML s SageMaker, glejte Viri Amazon SageMaker. AWS Batch je odlična možnost, če iščete poceni, razširljivo rešitev za izvajanje paketnih opravil z nizkimi operativnimi stroški. Za začetek glejte Uvod v AWS Batch.

O avtorjih

Nafi Ahmet Turgut je magistriral iz elektrotehnike in elektronike ter se zaposlil kot diplomirani raziskovalec. Osredotočil se je na gradnjo algoritmov strojnega učenja za simulacijo anomalij živčnega omrežja. Getirju se je pridružil leta 2019 in trenutno dela kot višji vodja podatkovne znanosti in analitike. Njegova ekipa je odgovorna za načrtovanje, implementacijo in vzdrževanje algoritmov strojnega učenja od konca do konca in podatkovno vodenih rešitev za Getir.

Nafi Ahmet Turgut je magistriral iz elektrotehnike in elektronike ter se zaposlil kot diplomirani raziskovalec. Osredotočil se je na gradnjo algoritmov strojnega učenja za simulacijo anomalij živčnega omrežja. Getirju se je pridružil leta 2019 in trenutno dela kot višji vodja podatkovne znanosti in analitike. Njegova ekipa je odgovorna za načrtovanje, implementacijo in vzdrževanje algoritmov strojnega učenja od konca do konca in podatkovno vodenih rešitev za Getir.

Hasan Burak Jel je diplomiral iz elektrotehnike in elektronike na univerzi Boğaziçi. Delal je v podjetju Turkcell, kjer se je ukvarjal predvsem z napovedovanjem časovnih vrst, vizualizacijo podatkov in avtomatizacijo omrežja. Getirju se je pridružil leta 2021 in trenutno dela kot vodja podatkovne znanosti in analitike z odgovornostjo za področja iskanja, priporočil in rasti.

Hasan Burak Jel je diplomiral iz elektrotehnike in elektronike na univerzi Boğaziçi. Delal je v podjetju Turkcell, kjer se je ukvarjal predvsem z napovedovanjem časovnih vrst, vizualizacijo podatkov in avtomatizacijo omrežja. Getirju se je pridružil leta 2021 in trenutno dela kot vodja podatkovne znanosti in analitike z odgovornostjo za področja iskanja, priporočil in rasti.

Damla Şentürk je diplomirala iz računalništva na univerzi Galatasaray. Nadaljuje magistrski študij računalništva na univerzi Boğaziçi. Getirju se je pridružila leta 2022 in je delala kot Data Scientist. Delala je na komercialnih projektih, projektih v dobavni verigi in projektih, povezanih z odkrivanjem.

Damla Şentürk je diplomirala iz računalništva na univerzi Galatasaray. Nadaljuje magistrski študij računalništva na univerzi Boğaziçi. Getirju se je pridružila leta 2022 in je delala kot Data Scientist. Delala je na komercialnih projektih, projektih v dobavni verigi in projektih, povezanih z odkrivanjem.

Esra Kayabalı je višji arhitekt rešitev pri AWS, specializiran za domeno analitike, vključno s skladiščenjem podatkov, podatkovnimi jezeri, analitiko velikih podatkov, paketnim pretokom podatkov in pretakanjem podatkov v realnem času ter integracijo podatkov. Ima 12 let izkušenj na področju razvoja programske opreme in arhitekture. Navdušena je nad učenjem in poučevanjem tehnologij v oblaku.

Esra Kayabalı je višji arhitekt rešitev pri AWS, specializiran za domeno analitike, vključno s skladiščenjem podatkov, podatkovnimi jezeri, analitiko velikih podatkov, paketnim pretokom podatkov in pretakanjem podatkov v realnem času ter integracijo podatkov. Ima 12 let izkušenj na področju razvoja programske opreme in arhitekture. Navdušena je nad učenjem in poučevanjem tehnologij v oblaku.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :ima

- : je

- :ne

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- sposobnost

- Sposobna

- O meni

- dostop

- Dostop

- natančnost

- natančna

- doseže

- dosežek

- doseganju

- čez

- Ukrep

- Poleg tega

- Naslov

- naslovljena

- Prednost

- po

- proti

- algoritmi

- Poravnava

- vsi

- dovoljene

- omogoča

- skupaj

- Prav tako

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- analitika

- analiziranje

- in

- in infrastrukturo

- nepravilnosti

- kaj

- Arhitektura

- SE

- AS

- vidik

- izbor

- At

- avto

- samodejno

- Avtomatizacija

- Avenue

- AWS

- Ravnovesje

- uravnoteženje

- ovire

- baza

- temeljijo

- BE

- postanejo

- bilo

- merilo

- koristi

- BEST

- Poleg

- Big

- Big Podatki

- Povečana

- tako

- blagovne znamke

- izgradnjo

- Building

- zgrajena

- podjetja

- vendar

- by

- CAN

- Zmogljivosti

- zmožnost

- začetnica

- kategorije

- Kategorija

- poskrbi

- Osrednji

- verige

- izziv

- izzivi

- izbira

- Cloud

- združuje

- komercialna

- podjetje

- prepričljiv

- konkurenčno

- tekmovalci

- Končana

- kompleksna

- celovito

- Izračunajte

- računalnik

- Računalniški inženiring

- računalništvo

- konglomerat

- naprej

- se nadaljuje

- neprekinjeno

- država

- Oblikovanje

- kritično

- ključnega pomena

- Trenutno

- stranka

- Stranke, ki so

- datum

- Podatkovna analiza

- znanost o podatkih

- podatkovni znanstvenik

- vizualizacija podatkov

- Podatkov usmerjenih

- Odločanje

- opredeljen

- Stopnja

- dostava

- razporedi

- razporejeni

- uvajanja

- uvajanje

- oblikovanje

- podrobno

- Razvijalci

- Razvoj

- drugačen

- Težavnost

- neposredno

- distribucija

- razne

- raznolika

- domena

- domen

- 2

- trajanje

- vsak

- lahka

- Učinkovito

- učinkovito

- učinkovitost

- učinkovitosti

- učinkovitosti

- učinkovite

- učinkovito

- truda

- prizadevanja

- Elektronika

- opolnomočiti

- omogočena

- obsežno

- konec koncev

- Inženiring

- okrepljeno

- izboljšanje

- zagotovljeno

- zagotavlja

- zagotoviti

- okolje

- enako

- ustanovljena

- razvijajo

- odlično

- obstoječih

- izkušnje

- Doživetja

- Pojasnite

- raziskovanje

- raziskuje

- Se razširi

- Obraz

- olajšanje

- hitro tempu

- Feature

- Polje

- končna

- prva

- Osredotočite

- osredotočena

- po

- za

- moč

- Napoved

- štiri

- iz

- v celoti

- nadalje

- Prihodnost

- zbiranje

- ustvarja

- Nemčija

- dobili

- GPU

- Grafične kartice

- diplomiral

- Rast

- Gost

- Gost Prispevek

- ročaj

- Imajo

- he

- pomoč

- Pomaga

- jo

- visoka

- njegov

- gostila

- Kako

- Kako

- HTML

- http

- HTTPS

- if

- Izvajanje

- izvajanja

- Pomembno

- pomemben vidik

- in

- vključuje

- Vključno

- Podatki

- Infrastruktura

- začetna

- inovativne

- vpogledi

- namestitev

- primer

- integracija

- interakcije

- v

- neprecenljivo

- inventar

- Inventory Management

- IT

- ITS

- sam

- Delovna mesta

- pridružil

- jpg

- Keen

- Ključne

- znano

- jezera

- jezik

- jeziki

- Latenca

- učenje

- Led

- Stopnja

- ravni

- kot

- si

- nizka

- nizkimi stroški

- stroj

- strojno učenje

- v glavnem

- vzdrževanje

- Znamka

- upravljanje

- upravlja

- upravljanje

- upravitelj

- Način

- več

- Tržna

- poveljnika

- Metoda

- Metodologija

- Minute

- ML

- Model

- modeli

- mesec

- več

- multinacionalno

- več

- materni

- naravna

- Krmarjenje

- Nimate

- potrebe

- Nizozemska

- mreža

- Naslednja

- devet

- št

- predmet

- Očitna

- of

- ponujanje

- on

- ONE

- samo

- operativno

- operacije

- optimalna

- optimizirana

- Optimizira

- Možnost

- or

- Da

- Organizacija

- naši

- premagovanje

- lastne

- zlasti

- strastno

- ljudje

- popolna

- performance

- faza

- plinovod

- platon

- Platonova podatkovna inteligenca

- PlatoData

- igral

- igra

- Portfelj

- pozicioniran

- možnosti

- Prispevek

- potencial

- potencialno

- moč

- močan

- Precision

- napovedovanje

- napoved

- Napovedi

- Napovedna analiza

- Prisotnost

- problem

- Težave

- Postopek

- Procesi

- Izdelek

- proizvodnja

- Projekt

- projekti

- dokazano

- zagotavljajo

- če

- zagotavljanje

- zasledovanje

- Količina

- hitro

- območja

- dosežejo

- v realnem času

- podatki v realnem času

- prejetih

- Priporočilo

- zmanjša

- Zmanjšana

- zmanjšanje

- izboljšati

- rafinirano

- predstavlja

- obvezna

- Raziskave

- viri

- Odgovornost

- odgovorna

- Rezultati

- revolucionirala

- vloga

- Run

- tek

- sagemaker

- Prilagodljivost

- razširljive

- Lestvica

- skaliranje

- načrtovano

- Znanost

- Znanstvenik

- Znanstveniki

- brezšivne

- Iskalnik

- oddelki

- varnost

- glej

- Seek

- Segment

- izbran

- višji

- Serija

- služijo

- Storitev

- Storitve

- nastavite

- sedem

- Shadow

- oblikovanje

- je

- Razstave

- bistveno

- Enostavno

- ednina

- So

- Software

- Razvoj programske opreme

- Rešitev

- rešitve

- Reševanje

- nekaj

- prefinjeno

- Predlogi

- govorijo

- specializirani

- specifična

- začel

- Države

- Korak

- shranjevanje

- shranjevanje

- Strateško

- Strateško

- Strategija

- pretakanje

- racionalizirati

- racionaliziran

- racionalizacijo

- okrepiti

- prednosti

- uspešno

- superior

- dobavi

- dobavne verige

- podpora

- reševanje

- po meri

- Naloge

- poučevanje

- skupina

- Skupine

- tech

- Tehnično podjetje

- Tehnologije

- Testiranje

- da

- O

- Nizozemska

- UK

- njihove

- Njih

- POTEM

- s tem

- zato

- te

- ta

- skozi

- čas

- Časovne serije

- do

- danes

- današnje

- skupaj

- orodja

- začetnik

- Vlak

- usposabljanje

- Drevo

- Turčija

- dva

- Uk

- dežnik

- pod

- Velika

- Združene države Amerike

- univerza

- us

- uporaba

- Rabljeni

- uporabnik

- Uporabniška izkušnja

- uporabo

- uporablja

- skrajno

- različnih

- vertikale

- vizualizacija

- ključnega pomena

- prostornine

- je

- we

- web

- spletne storitve

- teden

- so bili

- ki

- medtem

- z

- v

- delal

- deluje

- deluje

- let

- Vi

- Vaša rutina za

- zefirnet