Predstavitev

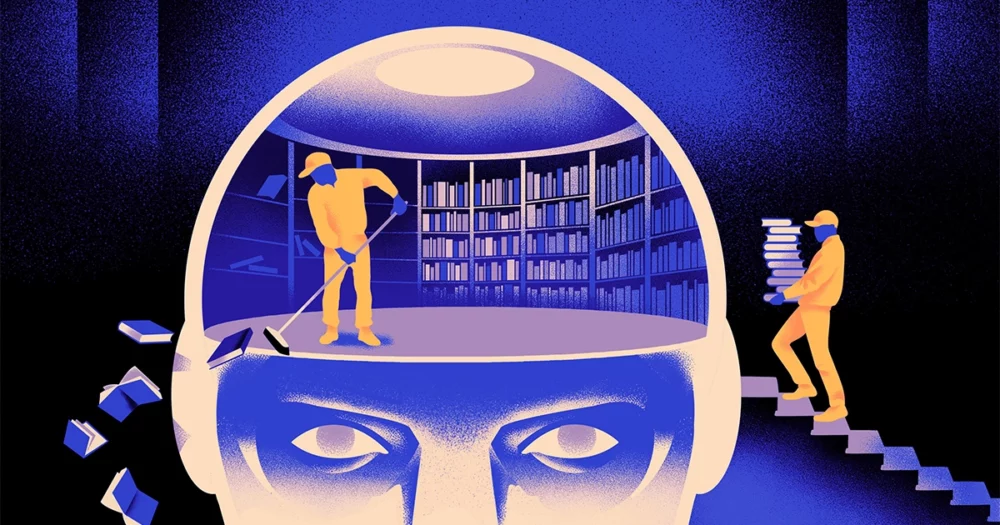

Skupina računalniških znanstvenikov je ustvarila a okretnejši, bolj prilagodljiv tip modela strojnega učenja. Trik: Občasno mora pozabiti, kar ve. In čeprav ta novi pristop ne bo izpodrinil ogromnih modelov, ki podpirajo največje aplikacije, bi lahko razkril več o tem, kako ti programi razumejo jezik.

Nova raziskava pomeni "pomemben napredek na tem področju", je dejal Jea Kwon, inženir AI na Inštitutu za osnovno znanost v Južni Koreji.

Jezikovne motorje AI, ki so danes v uporabi, večinoma poganja umetne nevronske mreže. Vsak "nevron" v omrežju je matematična funkcija, ki sprejema signale od drugih nevronov, izvaja nekatere izračune in pošilja signale naprej skozi več plasti nevronov. Sprva je pretok informacij bolj ali manj naključen, toda z usposabljanjem se pretok informacij med nevroni izboljša, ko se omrežje prilagaja podatkom o usposabljanju. Če bi raziskovalec AI želel ustvariti dvojezični model, bi na primer usposobil model z velikim kupom besedila iz obeh jezikov, kar bi prilagodilo povezave med nevroni tako, da bi besedilo v enem jeziku povezalo z enakovrednim. besede v drugi.

Toda ta proces usposabljanja zahteva veliko računalniške moči. Če model ne deluje dobro ali če se potrebe uporabnika kasneje spremenijo, ga je težko prilagoditi. "Recite, da imate model, ki ima 100 jezikov, vendar si predstavljajte, da en jezik, ki ga želite, ni pokrit," je rekel Mikel Artetxe, soavtor nove raziskave in ustanovitelj AI startupa Reka. "Lahko bi začeli znova iz nič, vendar ni idealno."

Artetxe in njegovi kolegi so poskušali zaobiti te omejitve. Pred nekaj leti, Artetxe in drugi so izurili nevronsko mrežo v enem jeziku, nato pa izbrisali, kar je vedela o gradnikih besed, imenovanih žetoni. Ti so shranjeni v prvi plasti nevronske mreže, imenovani vdelana plast. Vse druge plasti modela so pustili pri miru. Potem ko so izbrisali žetone prvega jezika, so ponovno usposobili model za drugi jezik, ki je napolnil vdelano plast z novimi žetoni iz tega jezika.

Čeprav je model vseboval neusklajene informacije, je preusposabljanje delovalo: model se je lahko naučil in obdelal nov jezik. Raziskovalci so domnevali, da medtem ko je vdelana plast shranila informacije, značilne za besede, uporabljene v jeziku, so globlje ravni omrežja shranile bolj abstraktne informacije o konceptih, ki stojijo za človeškimi jeziki, kar je nato pomagalo modelu pri učenju drugega jezika.

»Živimo v istem svetu. Iste stvari konceptualiziramo z različnimi besedami« v različnih jezikih Yihong Chen, glavni avtor nedavnega prispevka. »Zato imate v modelu to isto sklepanje na visoki ravni. Jabolko je nekaj sladkega in sočnega, ne le beseda.”

Predstavitev

Medtem ko je bil ta pristop pozabljanja učinkovit način za dodajanje novega jezika že usposobljenemu modelu, je bilo ponovno usposabljanje še vedno zahtevno – zahtevalo je veliko jezikovnih podatkov in procesorske moči. Chen je predlagal prilagoditev: namesto usposabljanja, brisanja vdelane plasti in nato ponovnega usposabljanja, bi morali občasno ponastaviti vdelano plast med začetnim krogom usposabljanja. "S tem se celoten model navadi na ponastavitev," je dejal Artetxe. "To pomeni, da je, ko želite model razširiti na drug jezik, lažje, ker ste to počeli."

Raziskovalci so vzeli pogosto uporabljen jezikovni model, imenovan Roberta, so ga trenirali s svojo tehniko periodičnega pozabljanja in ga primerjali z zmogljivostjo istega modela, ko je bil treniran s standardnim pristopom brez pozabljanja. Model pozabljanja se je odrezal nekoliko slabše od običajnega, saj je prejel oceno 85.1 v primerjavi s 86.1 na enem običajnem merilu jezikovne natančnosti. Nato so ponovno usposobili modele za druge jezike, pri čemer so uporabili veliko manjše nabore podatkov s samo 5 milijoni žetonov namesto 70 milijard, ki so jih uporabili med prvim usposabljanjem. Natančnost standardnega modela se je v povprečju zmanjšala na 53.3, pozabljenega modela pa le na 62.7.

Tudi model pozabljanja se je odrezal veliko bolje, če je ekipa med preusposabljanjem uvedla računske omejitve. Ko so raziskovalci zmanjšali dolžino treninga s 125,000 korakov na samo 5,000, se je natančnost modela pozabljanja v povprečju zmanjšala na 57.8, medtem ko je standardni model padel na 37.2, kar ni nič boljše od naključnih ugibanj.

Predstavitev

Ekipa je ugotovila, da se zdi, da občasno pozabljanje izboljša model pri učenju jezikov na splošno. "Ker [so] med usposabljanjem kar naprej pozabljali in se znova učili, postane učenje omrežja nečesa novega pozneje lažje," je dejal Evgenij Nikišin, raziskovalka v Mila, raziskovalnem centru za globoko učenje v Quebecu. Predlaga, da ko jezikovni modeli razumejo jezik, to počnejo na globlji ravni kot le pomene posameznih besed.

Pristop je podoben delovanju naših lastnih možganov. »Človeški spomin na splošno ni zelo dober pri natančnem shranjevanju velikih količin podrobnih informacij. Namesto tega si ljudje ponavadi zapomnimo bistvo svojih izkušenj, abstrahiramo in ekstrapoliramo,« je dejal. Benjamin Levy, nevroznanstvenik na Univerzi v San Franciscu. "Omogočanje umetne inteligence s procesi, ki so bolj podobni ljudem, kot je prilagodljivo pozabljanje, je eden od načinov, kako jim omogočiti bolj prilagodljivo delovanje."

Poleg tega, kar lahko pove o tem, kako deluje razumevanje, Artetxe upa, da bi lahko tudi bolj prilagodljivi jezikovni modeli pozabljanja pomagali prenesti najnovejše dosežke umetne inteligence v več jezikov. Čeprav so modeli z umetno inteligenco dobri pri obvladovanju španščine in angleščine, dveh jezikov z dovolj gradiva za usposabljanje, modeli niso tako dobri z njegovo materno baskovščino, lokalnim jezikom, značilnim za severovzhodno Španijo. "Večina modelov iz velikih tehnoloških podjetij tega ne počne dobro," je dejal. "Najboljša pot je prilagoditev obstoječih modelov baskovščini."

Chen se prav tako veseli sveta, v katerem bo cvetelo več rožic umetne inteligence. »Mislim na situacijo, ko svet ne potrebuje enega velikega jezikovnega modela. Toliko jih imamo,« je rekla. »Če obstaja tovarna, ki izdeluje jezikovne modele, potrebujete takšno tehnologijo. Ima en osnovni model, ki se lahko hitro prilagodi novim domenam.«

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :ima

- : je

- :ne

- :kje

- ][str

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- O meni

- POVZETEK

- natančnost

- natančno

- prilagodijo

- prilagodljivo

- prilagaja

- dodajte

- Poleg tega

- napredovanje

- po

- AI

- AI modeli

- vsi

- sam

- že

- Prav tako

- zneski

- an

- in

- Še ena

- Apple

- pristop

- aplikacije

- SE

- AS

- At

- Avtor

- povprečno

- baza

- Osnovni

- ker

- postane

- bilo

- zadaj

- Boljše

- med

- Big

- velika tehnologija

- največji

- Billion

- Bloki

- Bloom

- tako

- preboji

- prinašajo

- Building

- vendar

- by

- Izračuni

- se imenuje

- CAN

- center

- spremenite

- chen

- zaobiti

- Soavtor

- sodelavci

- Skupno

- pogosto

- Podjetja

- v primerjavi z letom

- računalniški

- računalnik

- računalništvo

- računalniška moč

- koncepti

- sklenjene

- povezave

- vseboval

- konvencionalne

- bi

- zajeti

- ustvarjajo

- ustvaril

- Cut

- datum

- nabori podatkov

- zmanjšala

- globoko

- globoko učenje

- globlje

- zahtevno

- podrobno

- DID

- drugačen

- do

- Ne

- tem

- domen

- dont

- padla

- med

- vsak

- lažje

- Učinkovito

- vdelava

- inženir

- Motorji

- Angleščina

- Celotna

- Enakovredna

- Primer

- obstoječih

- Doživetja

- razširiti

- Tovarna

- Nekaj

- Polje

- napolnjena

- prva

- prilagodljiv

- Pretok

- za

- Naprej

- Ustanovitelj

- Francisco

- iz

- funkcija

- splošno

- splošno

- dobili

- GitHub

- Go

- dobro

- Ravnanje

- Trdi

- Imajo

- he

- pomoč

- pomagal

- na visoki ravni

- njegov

- upa

- Kako

- HTTPS

- velika

- človeškega

- človeško podoben

- Ljudje

- idealen

- if

- slika

- naložena

- izboljšuje

- in

- individualna

- Podatki

- začetna

- na začetku

- Namesto

- Inštitut

- IT

- samo

- Imejte

- Otrok

- ve

- korea

- jezik

- jeziki

- velika

- pozneje

- Zadnji

- plast

- plasti

- vodi

- UČITE

- učenje

- levo

- dolžina

- manj

- Stopnja

- ravni

- kot

- omejitve

- Meje

- v živo

- lokalna

- POGLEDI

- Sklop

- stroj

- strojno učenje

- revije

- Znamka

- Izdelava

- več

- materiali

- matematični

- pomene

- pomeni

- merjenje

- Spomin

- morda

- milijonov

- Model

- modeli

- več

- večinoma

- veliko

- več

- morajo

- materni

- Nimate

- potrebe

- mreža

- Živčne

- nevronska mreža

- Neuroni

- Novo

- št

- of

- on

- ONE

- samo

- or

- Ostalo

- drugi

- naši

- več

- lastne

- Papir

- performance

- periodično

- platon

- Platonova podatkovna inteligenca

- PlatoData

- potopljen

- moč

- poganja

- Postopek

- Procesi

- obravnavati

- Obdelava moči

- programi

- Quantamagazine

- Quebec

- hitro

- naključno

- precej

- prejme

- prejema

- nedavno

- ne pozabite

- obvezna

- Raziskave

- raziskovalec

- raziskovalci

- razkrivajo

- krog

- deluje

- Je dejal

- Enako

- San

- San Francisco

- pravijo,

- Znanost

- Znanstveniki

- rezultat

- praska

- drugi

- Zdi se,

- selektivno

- pošlje

- Kompleti

- je

- shouldnt

- signali

- pomemben

- Podoben

- Razmere

- manj

- So

- nekaj

- Nekaj

- South

- Južna Koreja

- Španija

- španski

- specifična

- standardna

- Začetek

- zagon

- Koraki

- Še vedno

- shranjeni

- shranjevanje

- taka

- Predlaga

- sladka

- meni

- poučevanje

- skupina

- tech

- Tech podjetja

- tehnika

- Tehnologija

- nagiba

- besedilo

- kot

- da

- O

- informacije

- svet

- njihove

- Njih

- POTEM

- te

- jih

- stvari

- Razmišljanje

- ta

- čeprav?

- skozi

- do

- danes

- Boni

- vzel

- Vlak

- usposobljeni

- usposabljanje

- Trik

- Poskušal

- poteg

- dva

- razumeli

- razumevanje

- univerza

- uporaba

- Rabljeni

- uporabo

- zelo

- želeli

- želi

- je

- način..

- we

- webp

- Dobro

- Kaj

- kdaj

- ki

- medtem

- zakaj

- z

- beseda

- besede

- delo

- delal

- deluje

- svet

- slabše

- bi

- let

- Vi

- zefirnet