Ta objava vas popelje skozi najpogostejše izzive, s katerimi se soočajo stranke pri iskanju po notranjih dokumentih, in vam daje konkretne napotke o tem, kako je mogoče storitve AWS uporabiti za ustvarjanje generativnega AI pogovornega bota, ki naredi notranje informacije bolj uporabne.

Nestrukturirani podatki predstavljajo 80 % vseh podatkov najdemo v organizacijah in so sestavljeni iz skladišč priročnikov, PDF-jev, pogostih vprašanj, e-poštnih sporočil in drugih dokumentov, ki rastejo vsak dan. Podjetja se danes zanašajo na stalno rastoča skladišča notranjih informacij in težave nastanejo, ko količina nestrukturiranih podatkov postane neobvladljiva. Uporabniki pogosto berejo in preverjajo številne različne notranje vire, da bi našli odgovore, ki jih potrebujejo.

Interni forumi za vprašanja in odgovore lahko uporabnikom pomagajo pri pridobivanju zelo specifičnih odgovorov, vendar zahtevajo tudi daljše čakalne dobe. V primeru internih pogostih vprašanj, specifičnih za podjetje, dolge čakalne dobe povzročijo nižjo produktivnost zaposlenih. Forume z vprašanji in odgovori je težko meriti, saj temeljijo na ročno napisanih odgovorih. Z generativno umetno inteligenco trenutno prihaja do spremembe paradigme v tem, kako uporabniki iščejo in najdejo informacije. Naslednji logični korak je uporaba generativne umetne inteligence za strnitev velikih dokumentov v manjše informacije velikosti zalogaj za lažjo uporabniško uporabo. Namesto da bi porabili dolgo časa za branje besedila ali čakanje na odgovore, lahko uporabniki ustvarijo povzetke v realnem času na podlagi več obstoječih skladišč internih informacij.

Pregled rešitev

Rešitev omogoča strankam, da pridobijo izbrane odgovore na vprašanja o internih dokumentih z uporabo transformatorskega modela za generiranje odgovorov na vprašanja o podatkih, o katerih niso bili usposobljeni, tehnika, znana kot zero-shot prompting. S sprejetjem te rešitve lahko stranke pridobijo naslednje prednosti:

- Poiščite natančne odgovore na vprašanja na podlagi obstoječih virov internih dokumentov

- Zmanjšajte čas, ki ga uporabniki porabijo za iskanje odgovorov, z uporabo velikih jezikovnih modelov (LLM) za zagotavljanje skoraj takojšnjih odgovorov na zapletena vprašanja z uporabo dokumentov z najnovejšimi informacijami

- Iščite prej odgovorjena vprašanja prek centralizirane nadzorne plošče

- Zmanjšajte stres, ki ga povzroča poraba časa za ročno branje informacij za iskanje odgovorov

Retrieval Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) zmanjša nekatere pomanjkljivosti poizvedb, ki temeljijo na LLM, tako da poišče odgovore v vaši bazi znanja in uporabi LLM za povzetek dokumentov v jedrnate odgovore. Prosim preberite to objava naučiti se izvajati pristop RAG Amazonska Kendra. Naslednja tveganja in omejitve so povezane s poizvedbami, ki temeljijo na LLM in jih obravnava pristop RAG z Amazon Kendra:

- Halucinacije in sledljivost – LLMS se urijo na velikih nizih podatkov in ustvarjajo odgovore na verjetnosti. To lahko vodi do netočnih odgovorov, ki so znani kot halucinacije.

- Več podatkovnih silosov – Za sklicevanje na podatke iz več virov v vašem odzivu je treba vzpostaviti povezovalni ekosistem za združevanje podatkov. Dostop do več repozitorijev je ročni in dolgotrajen.

- Varnost – Varnost in zasebnost sta ključnega pomena pri uvajanju pogovornih botov, ki jih poganjata RAG in LLM. Kljub uporabi Amazonsko razumevanje za filtriranje osebnih podatkov, ki so lahko posredovani prek uporabniških poizvedb, ostaja možnost nenamernega prikazovanja osebnih ali občutljivih podatkov, odvisno od zaužitih podatkov. To pomeni, da je nadzor dostopa do chatbota ključnega pomena za preprečevanje nenamernega dostopa do občutljivih informacij.

- Relevantnost podatkov – LLMS se usposabljajo na podatkih do določenega datuma, kar pomeni, da informacije pogosto niso aktualne. Stroški, povezani z modeli usposabljanja na zadnjih podatkih, so visoki. Za zagotavljanje natančnih in ažurnih odgovorov so organizacije odgovorne za redno posodabljanje in obogatitev vsebine indeksiranih dokumentov.

- Stroški – stroški, povezani z uvedbo te rešitve, bi morali upoštevati podjetja. Podjetja morajo pri izvajanju te rešitve skrbno oceniti svoj proračun in zahteve glede učinkovitosti. Izvajanje LLM lahko zahteva precejšnje računalniške vire, kar lahko poveča operativne stroške. Ti stroški lahko postanejo omejitev za aplikacije, ki morajo delovati v velikem obsegu. Vendar pa je ena od prednosti AWS Cloud je prilagodljivost, da plačate samo tisto, kar uporabljate. AWS ponuja preprost, dosleden cenovni model plačevanja po uporabi, tako da vam zaračunamo samo vire, ki jih porabite.

Uporaba Amazon SageMaker JumpStart

Za jezikovne modele, ki temeljijo na transformatorjih, lahko organizacije izkoristijo uporabo Amazon SageMaker JumpStart, ki ponuja zbirko vnaprej izdelanih modelov strojnega učenja. Amazon SageMaker JumpStart ponuja široko paleto temeljnih modelov za generiranje besedila in odgovarjanje na vprašanja (Q&A), ki jih je mogoče preprosto namestiti in uporabiti. Ta rešitev integrira model FLAN T5-XL Amazon SageMaker JumpStart, vendar je treba upoštevati različne vidike, ko izbira modela temeljev.

Integracija varnosti v naš potek dela

Po najboljših praksah varnostnega stebra Dobro zasnovan okvir, Amazon Cognito se uporablja za avtentikacijo. Amazon Cognito User Pools je mogoče integrirati s ponudniki identitet drugih proizvajalcev, ki podpirajo več ogrodij, ki se uporabljajo za nadzor dostopa, vključno z Open Authorization (OAuth), OpenID Connect (OIDC) ali Security Assertion Markup Language (SAML). Prepoznavanje uporabnikov in njihovih dejanj omogoča rešitvi ohranjanje sledljivosti. Rešitev uporablja tudi Amazon Comprehend zaznavanje osebno določljivih podatkov (PII). funkcijo za samodejno identifikacijo in redigiranje PII. Redigirani osebni podatki vključujejo naslove, številke socialnega zavarovanja, e-poštne naslove in druge občutljive podatke. Ta zasnova zagotavlja, da so vsi podatki, ki omogočajo osebno prepoznavo, ki jih posreduje uporabnik prek vnosne poizvedbe, redigirani. Podatki, ki omogočajo osebno prepoznavo, niso shranjeni, uporabljeni s strani Amazon Kendre ali posredovani LLM.

Vodenje rešitve

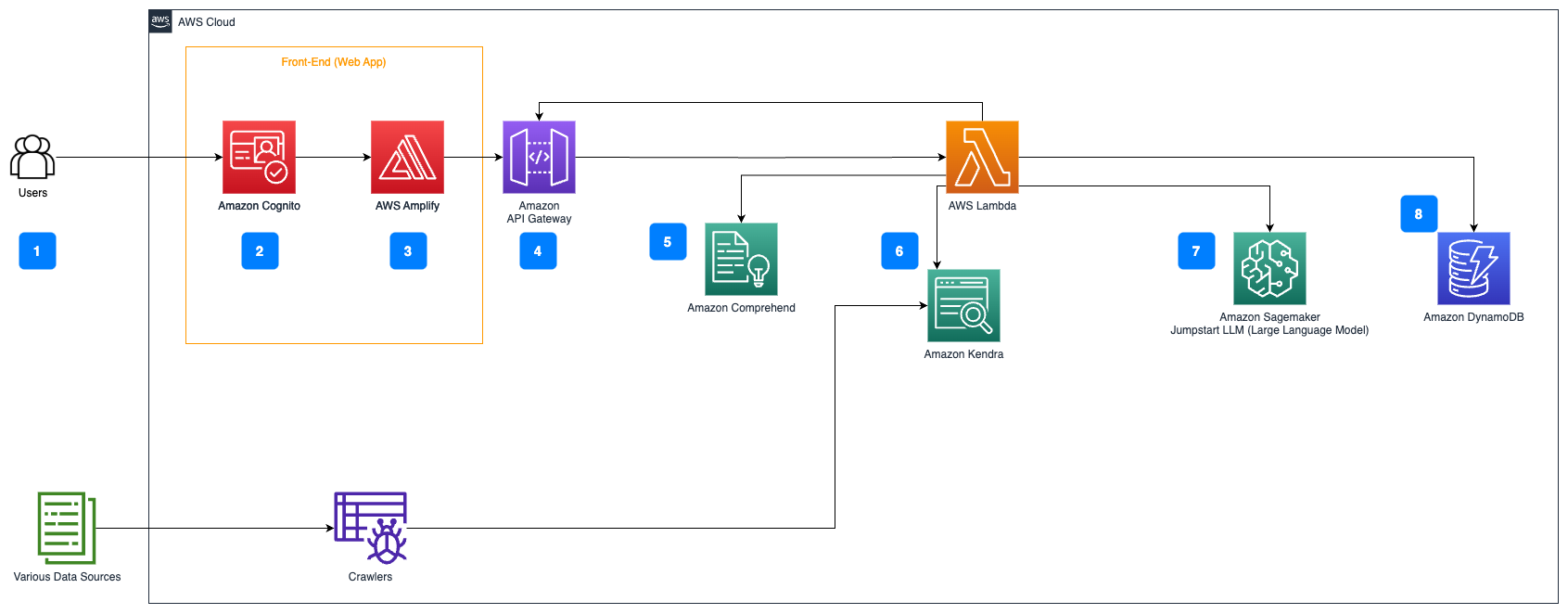

Naslednji koraki opisujejo potek dela odgovarjanja na vprašanja v toku dokumentov:

- Uporabniki pošljejo povpraševanje prek spletnega vmesnika.

- Amazon Cognito se uporablja za avtentikacijo, ki zagotavlja varen dostop do spletne aplikacije.

- Sprednji del spletne aplikacije gostuje na Ojačaj AWS.

- Amazon API Gateway gosti REST API z različnimi končnimi točkami za obravnavanje uporabniških zahtev, ki so overjene z uporabo Amazon Cognito.

- Redakcija PII z Amazonsko razumevanje:

- Obdelava uporabniške poizvedbe: Ko uporabnik odda poizvedbo ali vnos, se ta najprej prenese skozi Amazon Comprehend. Storitev analizira besedilo in prepozna vse entitete PII, ki so prisotne v poizvedbi.

- Ekstrakcija PII: Amazon Comprehend iz uporabniške poizvedbe izvleče zaznane entitete PII.

- Pridobivanje ustreznih informacij z Amazonska Kendra:

- Amazon Kendra se uporablja za upravljanje indeksa dokumentov, ki vsebuje informacije, uporabljene za ustvarjanje odgovorov na uporabnikove poizvedbe.

- O LangChain QA iskanje modul se uporablja za izgradnjo verige pogovorov, ki vsebuje ustrezne informacije o uporabnikovih poizvedbah.

- Integracija z Amazon SageMaker JumpStart:

- Funkcija AWS Lambda uporablja knjižnico LangChain in se povezuje s končno točko Amazon SageMaker JumpStart s poizvedbo, ki je polnjena s kontekstom. Končna točka Amazon SageMaker JumpStart služi kot vmesnik LLM, ki se uporablja za sklepanje.

- Shranjevanje odgovorov in vrnitev uporabniku:

- Odgovor LLM je shranjen v Amazon DynamoDB skupaj z uporabnikovo poizvedbo, časovnim žigom, edinstvenim identifikatorjem in drugimi poljubnimi identifikatorji za element, kot je kategorija vprašanja. Shranjevanje vprašanja in odgovora kot ločenih elementov omogoča funkciji AWS Lambda, da preprosto poustvari uporabnikovo zgodovino pogovorov na podlagi časa, ko so bila postavljena vprašanja.

- Nazadnje je odgovor poslan nazaj uporabniku prek zahteve HTTPs prek odziva integracije API-ja REST API Gateway Amazon.

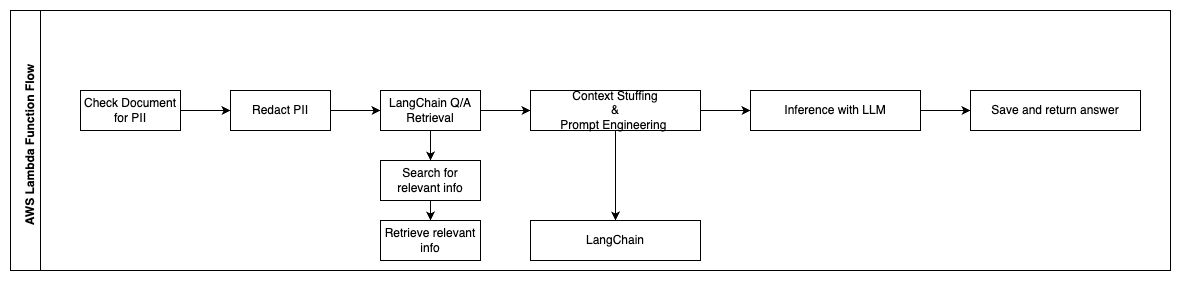

Naslednji koraki opisujejo funkcije AWS Lambda in njihov potek skozi proces:

- Preverite in popravite morebitne PII/občutljive podatke

- LangChain QA Retrieval Chain

- Poiščite in pridobite ustrezne informacije

- Polnjenje konteksta in hitri inženiring

- Sklepanje z LLM

- Vrnite odgovor in ga shranite

Uporabite primeri

Obstaja veliko primerov poslovne uporabe, kjer lahko stranke uporabljajo ta potek dela. V naslednjem razdelku je razloženo, kako se lahko potek dela uporablja v različnih panogah in vertikalah.

Pomoč zaposlenih

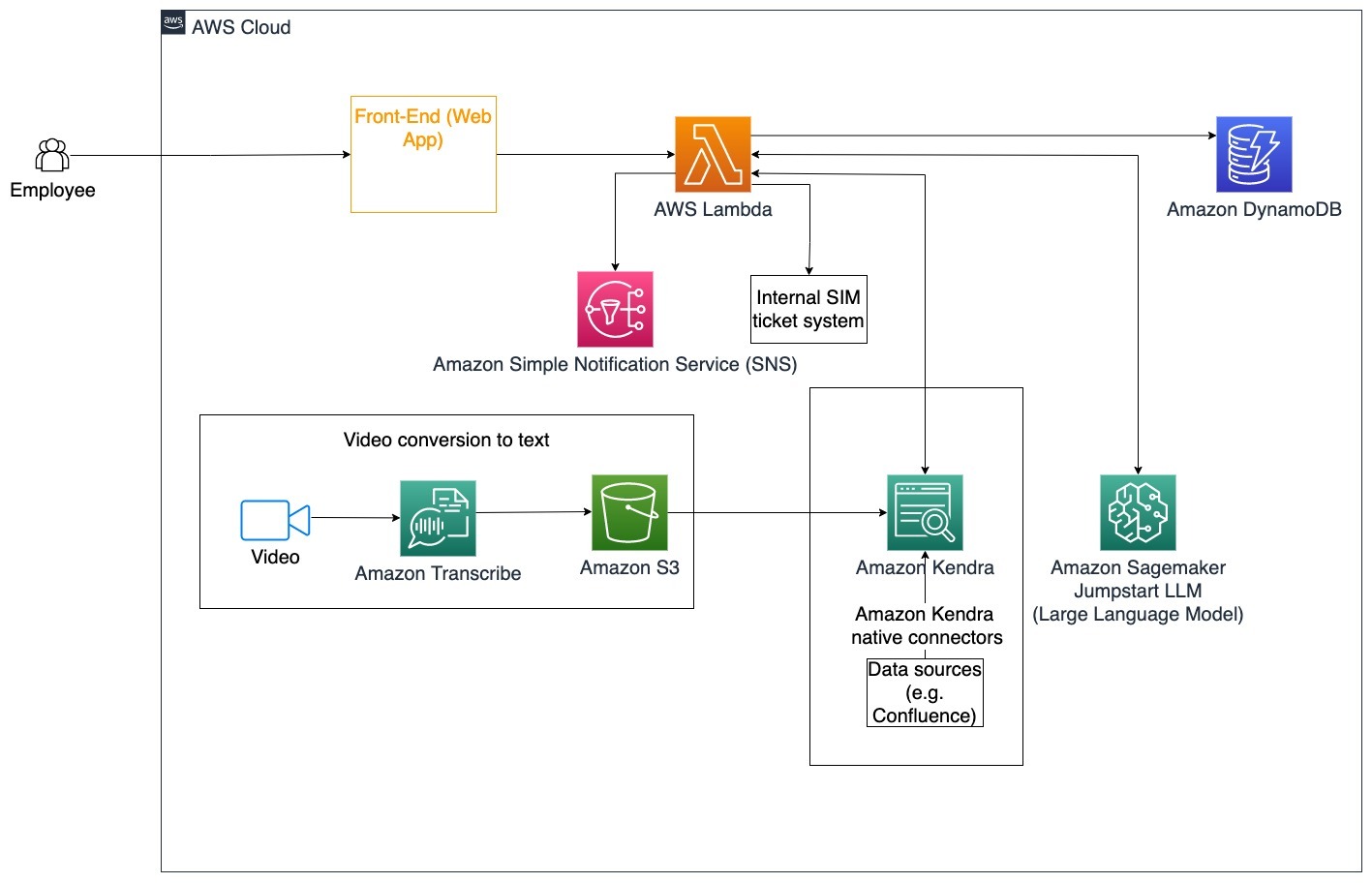

Dobro zasnovano korporativno usposabljanje lahko izboljša zadovoljstvo zaposlenih in skrajša čas, potreben za uvajanje novih zaposlenih. Z rastjo organizacij in večanjem kompleksnosti zaposleni težko razumejo številne vire internih dokumentov. Notranji dokumenti v tem kontekstu vključujejo smernice podjetja, politike in standardne operativne postopke. Za ta scenarij ima zaposleni vprašanje, kako nadaljevati in urediti vozovnico notranje izdaje. Zaposleni lahko dostopa in uporablja pogovorni bot generativne umetne inteligence (AI), da vpraša in izvede naslednje korake za določeno vstopnico.

Poseben primer uporabe: Avtomatizirajte reševanje težav za zaposlene na podlagi smernic podjetja.

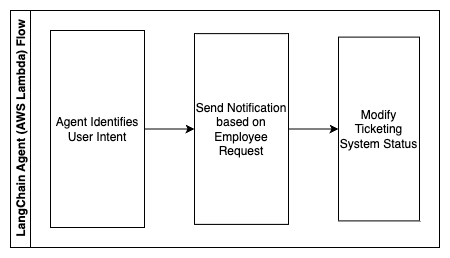

Naslednji koraki opisujejo funkcije AWS Lambda in njihov potek skozi proces:

- Agent LangChain za prepoznavanje namere

- Pošljite obvestilo na zahtevo zaposlenih

- Spremenite status vozovnice

V tem arhitekturnem diagramu je mogoče zaužiti videoposnetke korporativnega usposabljanja Amazonski prepis za zbiranje dnevnika teh video scenarijev. Poleg tega je mogoče vsebino korporativnega usposabljanja, shranjeno v različnih virih (tj. Confluence, Microsoft SharePoint, Google Drive, Jira itd.), uporabiti za ustvarjanje indeksov prek konektorjev Amazon Kendra. Preberite ta članek, če želite izvedeti več o zbirki domačih priključki lahko uporabite v Amazon Kendra kot izvorno točko. Pajek Amazon Kendra lahko nato uporabi video skripte korporativnega usposabljanja in dokumentacijo, shranjeno v teh drugih virih, da pogovornemu botu pomaga pri odgovarjanju na vprašanja, specifična za smernice korporativnega usposabljanja podjetja. Agent LangChain preveri dovoljenja, spremeni status vozovnice in obvesti prave posameznike z uporabo storitve Amazon Simple Notification Service (Amazonska SNS).

Ekipe za podporo strankam

Hitro reševanje poizvedb strank izboljša uporabniško izkušnjo in spodbuja zvestobo blagovni znamki. Baza zvestih strank pomaga pospeševati prodajo, kar prispeva k rezultatu in povečuje angažiranost strank. Ekipe za podporo strankam porabijo veliko energije za sklicevanje na številne interne dokumente in programsko opremo za upravljanje odnosov s strankami, da odgovorijo na vprašanja strank o izdelkih in storitvah. Notranji dokumenti v tem kontekstu lahko vključujejo generične klicne skripte za podporo strankam, priročnike, smernice za stopnjevanje in poslovne informacije. Generativni AI pogovorni bot pomaga pri optimizaciji stroškov, ker obravnava poizvedbe v imenu ekipe za podporo strankam.

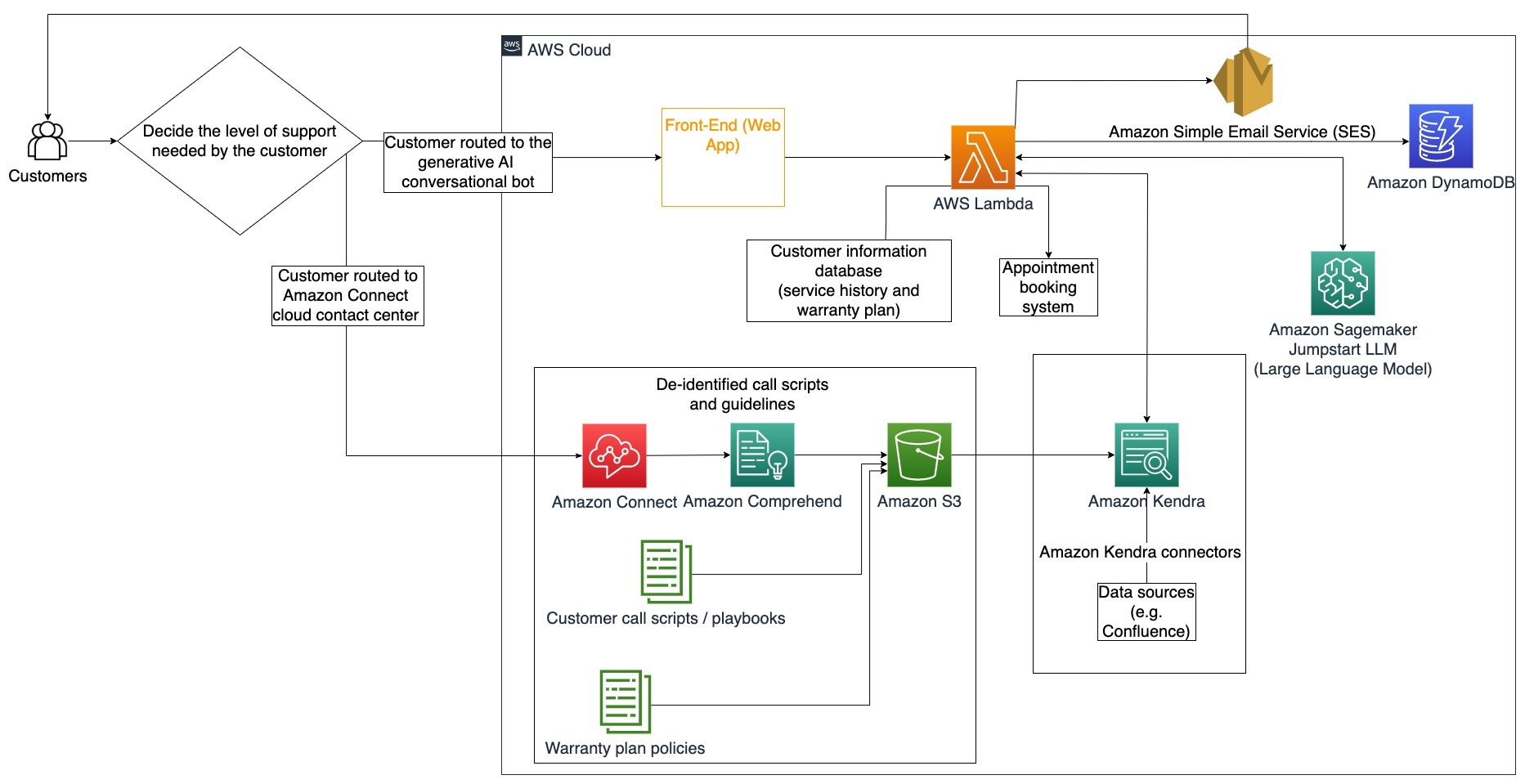

Poseben primer uporabe: Obravnava zahteve po menjavi olja na podlagi zgodovine servisiranja in kupljenega načrta storitev za stranke.

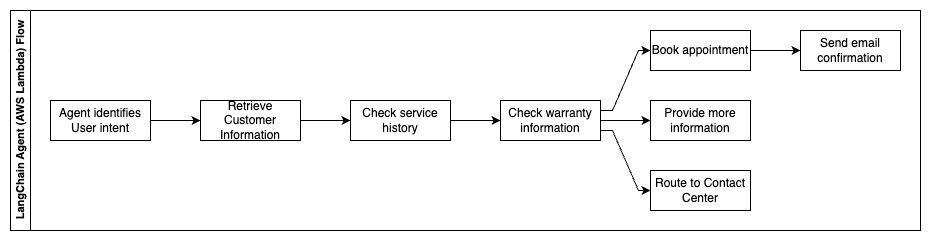

V tem arhitekturnem diagramu je stranka preusmerjena na generativni pogovorni bot AI ali Amazon Connect kontaktni center. Ta odločitev lahko temelji na ravni potrebne podpore ali razpoložljivosti agentov za podporo strankam. Agent LangChain identificira kupčev namen in preveri identiteto. Agent LangChain preveri tudi zgodovino storitev in kupljeni načrt podpore.

Naslednji koraki opisujejo funkcije AWS Lambda in njihov potek skozi proces:

- Agent LangChain identificira namen

- Pridobite podatke o stranki

- Preverite zgodovino storitev za stranke in informacije o garanciji

- Rezervirajte termin, zagotovite več informacij ali napotite do kontaktnega centra

- Pošlji potrditev po e-pošti

Amazon Connect se uporablja za zbiranje glasovnih in klepetalnih dnevnikov, Amazon Comprehend pa se uporablja za odstranjevanje osebno določljivih podatkov (PII) iz teh dnevnikov. Pajek Amazon Kendra lahko nato uporabi redigirane glasovne dnevnike in dnevnike klepetov, skripte klicev strank in politike načrta podpore za stranke, da ustvari indeks. Ko je odločitev sprejeta, se generativni AI pogovorni bot odloči, ali bo rezerviral termin, zagotovil več informacij ali stranko usmeril v kontaktni center za nadaljnjo pomoč. Za optimizacijo stroškov lahko posrednik LangChain ustvari tudi odgovore z uporabo manj žetonov in cenejšega velikega jezikovnega modela za poizvedbe strank z nižjo prioriteto.

Finančne storitve

Podjetja za finančne storitve se zanašajo na pravočasno uporabo informacij, da ostanejo konkurenčna in izpolnjujejo finančne predpise. Z uporabo generativnega pogovornega bota z umetno inteligenco lahko finančni analitiki in svetovalci komunicirajo z besedilnimi informacijami na pogovorni način ter skrajšajo čas in trud, ki sta potrebna za sprejemanje bolj informiranih odločitev. Poleg naložb in tržnih raziskav lahko generativni pogovorni bot z umetno inteligenco tudi poveča človeške zmogljivosti z obravnavanjem nalog, ki bi tradicionalno zahtevale več človeškega truda in časa. Na primer, finančna institucija, specializirana za osebna posojila, lahko poveča hitrost obdelave posojil, hkrati pa strankam zagotovi večjo preglednost.

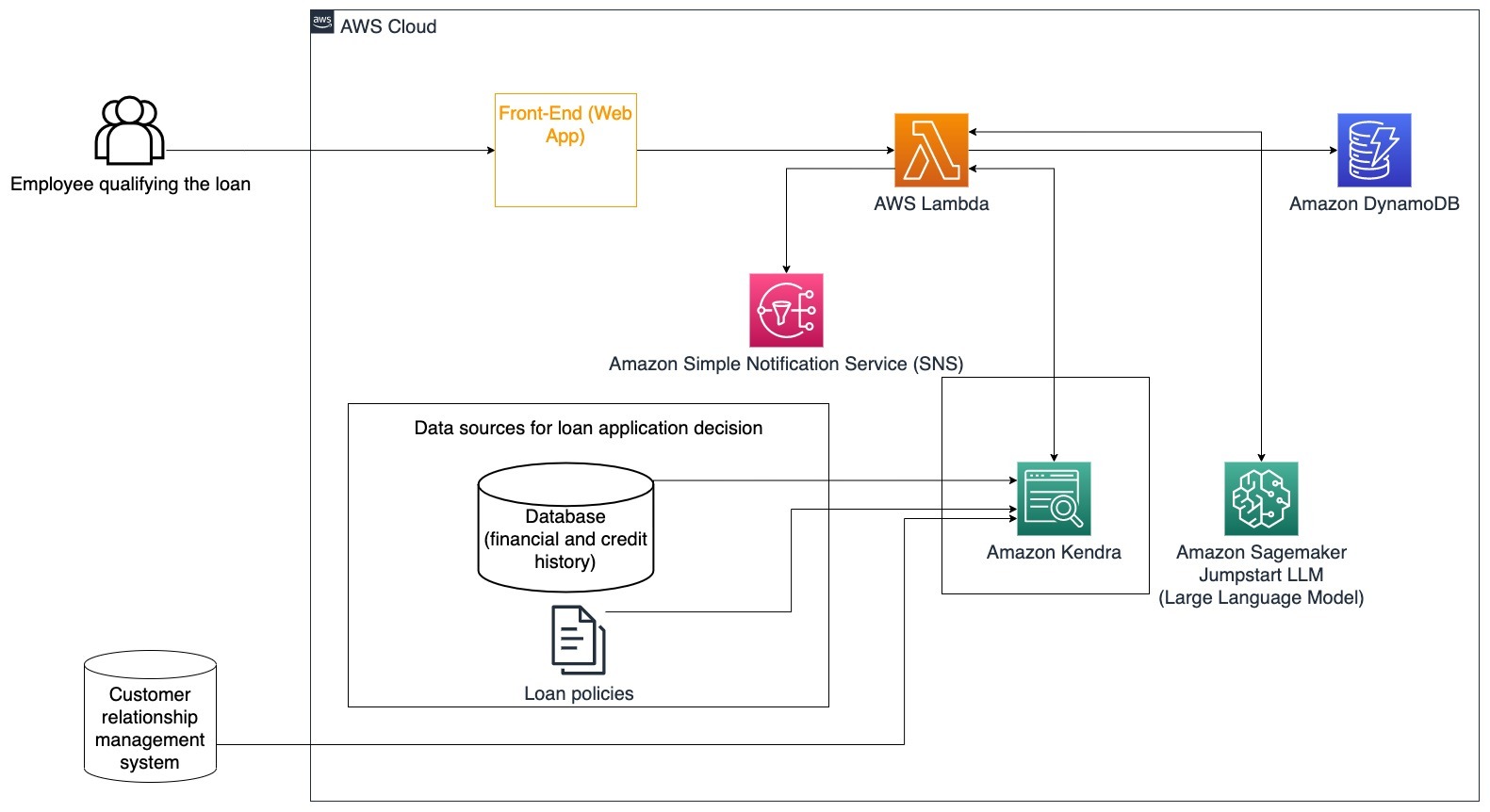

Poseben primer uporabe: Uporabite finančno zgodovino stranke in prejšnje vloge za posojilo, da se odločite in razložite odločitev o posojilu.

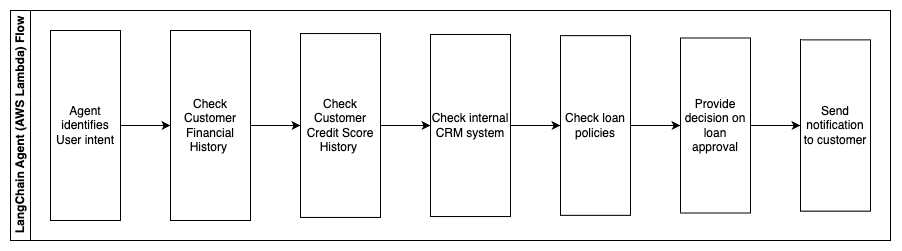

Naslednji koraki opisujejo funkcije AWS Lambda in njihov potek skozi proces:

- Agent LangChain za prepoznavanje namere

- Preverite finančno in kreditno zgodovino stranke

- Preverite notranji sistem upravljanja odnosov s strankami

- Preverite standardne politike posojil in predlagajte odločitev za zaposlenega, ki izpolnjuje pogoje za posojilo

- Pošljite obvestilo stranki

Ta arhitektura vključuje finančne podatke strank, shranjene v bazi podatkov, in podatke, shranjene v orodju za upravljanje odnosov s strankami (CRM). Te podatkovne točke se uporabljajo za obveščanje o odločitvi na podlagi internih posojilnih politik podjetja. Stranka lahko zastavi pojasnjevalna vprašanja, da razume, do katerih posojil je upravičena in pogoje posojil, ki jih lahko sprejme. Če generativni AI pogovorni bot ne more odobriti vloge za posojilo, lahko uporabnik še vedno postavlja vprašanja o izboljšanju kreditnih rezultatov ali alternativnih možnostih financiranja.

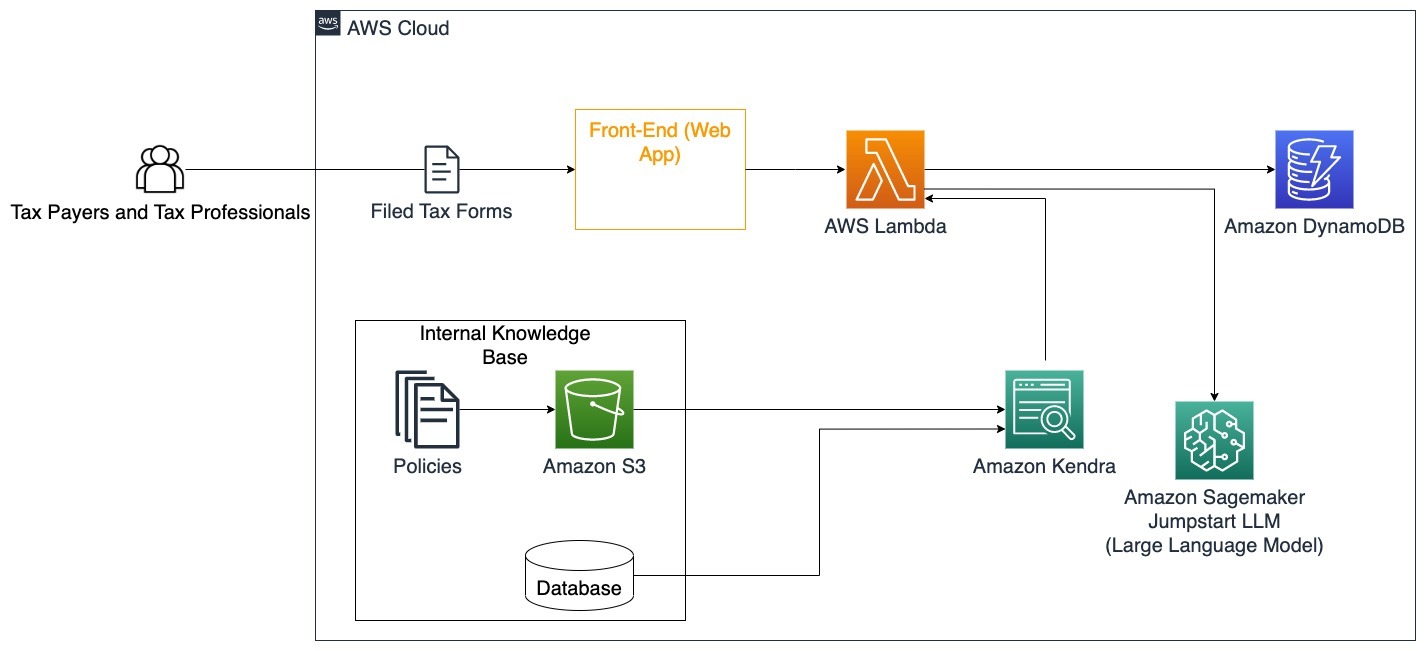

vlada

Generativni pogovorni boti z umetno inteligenco lahko močno koristijo vladnim institucijam s pospešitvijo komunikacije, učinkovitosti in procesov odločanja. Generativni pogovorni roboti z umetno inteligenco lahko zagotovijo tudi takojšen dostop do notranjih baz znanja, da državnim uslužbencem pomagajo hitro pridobiti informacije, pravilnike in postopke (tj. merila za upravičenost, postopke prijave ter storitve in podporo državljanom). Ena od rešitev je interaktivni sistem, ki davčnim zavezancem in davčnim strokovnjakom omogoča enostavno iskanje podrobnosti in ugodnosti v zvezi z davki. Uporablja se lahko za razumevanje vprašanj uporabnikov, povzemanje davčnih dokumentov in zagotavljanje jasnih odgovorov skozi interaktivne pogovore.

Uporabniki lahko postavljajo vprašanja, kot so:

- Kako deluje davek na dediščino in kakšne so davčne meje?

- Ali lahko pojasnite koncept dohodnine?

- Kakšne so davčne posledice pri prodaji druge nepremičnine?

Poleg tega lahko uporabniki v sistem predložijo davčne obrazce, kar lahko pomaga pri preverjanju pravilnosti posredovanih informacij.

Ta arhitektura ponazarja, kako lahko uporabniki naložijo izpolnjene davčne obrazce v rešitev in jo uporabijo za interaktivno preverjanje in vodenje, kako natančno izpolniti potrebne informacije.

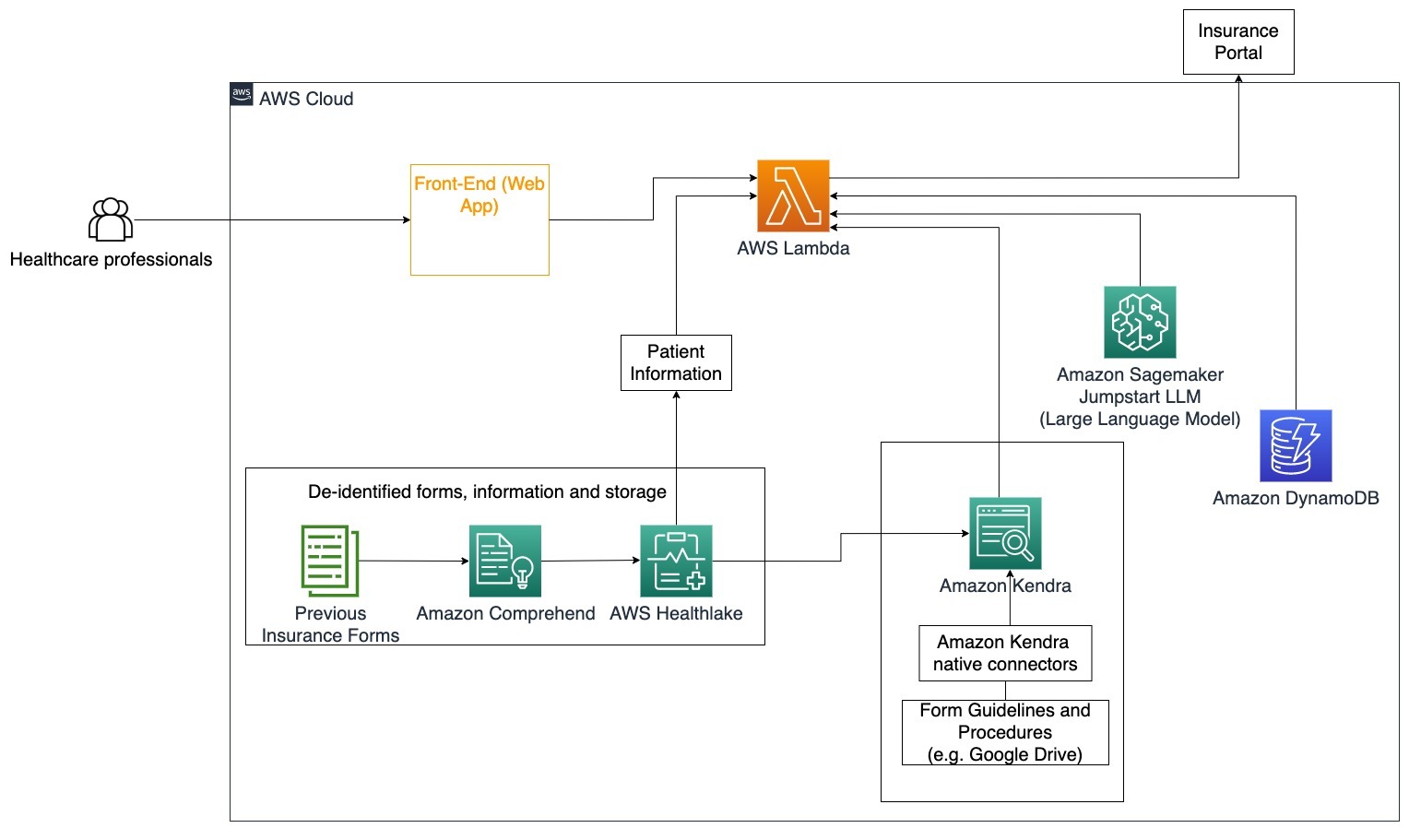

Zdravstveno varstvo

Zdravstvena podjetja imajo možnost avtomatizirati uporabo velikih količin notranjih informacij o bolnikih, hkrati pa obravnavati pogosta vprašanja v zvezi s primeri uporabe, kot so možnosti zdravljenja, zavarovalniške terjatve, klinična preskušanja in farmacevtske raziskave. Uporaba generativnega pogovornega bota AI omogoča hitro in natančno generiranje odgovorov o zdravstvenih informacijah iz ponujene baze znanja. Na primer, nekateri zdravstveni delavci porabijo veliko časa za izpolnjevanje obrazcev za vložitev zavarovalnih zahtevkov.

V podobnih okoljih morajo skrbniki kliničnih preskušanj in raziskovalci najti informacije o možnostih zdravljenja. Generativni pogovorni bot z umetno inteligenco lahko uporabi vnaprej vgrajene konektorje v Amazon Kendra za pridobivanje najpomembnejših informacij iz milijonov dokumentov, objavljenih s tekočimi raziskavami, ki jih izvajajo farmacevtska podjetja in univerze.

Poseben primer uporabe: Zmanjšajte napake in čas, potreben za izpolnjevanje in pošiljanje zavarovalnih obrazcev.

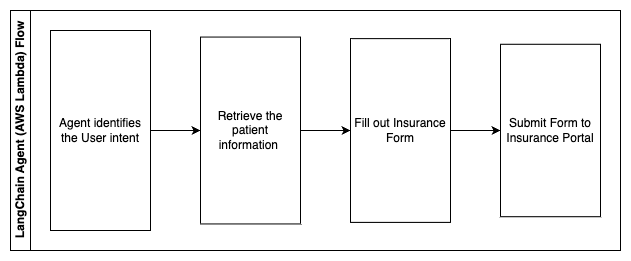

V tem arhitekturnem diagramu lahko zdravstveni delavec uporabi generativni pogovorni bot AI, da ugotovi, katere obrazce je treba izpolniti za zavarovanje. Agent LangChain lahko nato pridobi prave obrazce in doda potrebne informacije za pacienta ter poda odgovore za opisne dele obrazcev na podlagi zavarovalnih polic in prejšnjih obrazcev. Zdravstveni delavec lahko uredi odgovore, ki jih je dal LLM, preden jih odobri in pošlje obrazec na zavarovalniški portal.

Naslednji koraki opisujejo funkcije AWS Lambda in njihov potek skozi proces:

- Agent LangChain za prepoznavanje namere

- Pridobite potrebne podatke o bolniku

- Izpolnite obrazec za zavarovanje na podlagi podatkov o bolniku in navodil za obrazec

- Po odobritvi uporabnika oddajte obrazec na zavarovalniški portal

AWS HealthLake se uporablja za varno shranjevanje zdravstvenih podatkov, vključno s prejšnjimi zavarovalnimi obrazci in podatki o pacientih, Amazon Comprehend pa se uporablja za odstranjevanje osebno določljivih podatkov (PII) iz prejšnjih zavarovalnih obrazcev. Pajek Amazon Kendra lahko nato uporabi nabor zavarovalnih obrazcev in smernic za ustvarjanje indeksa. Ko generativni AI izpolni obrazce, lahko obrazce, ki jih pregleda zdravstveni delavec, pošljejo na zavarovalniški portal.

Ocena stroškov

Stroški uvedbe osnovne rešitve kot dokaz koncepta so prikazani v naslednji tabeli. Ker se osnovna rešitev šteje za dokaz koncepta, je bila Amazon Kendra Developer Edition uporabljena kot poceni možnost, saj delovna obremenitev ne bi bila v proizvodnji. Naša predpostavka za Amazon Kendra Developer Edition je bila 730 aktivnih ur na mesec.

Za Amazon SageMaker smo domnevali, da bo stranka uporabljala instanco ml.g4dn.2xlarge za sklepanje v realnem času, z eno samo končno točko sklepanja na instanco. Najdete več informacij o cenah Amazon SageMaker in razpoložljivih vrstah primerkov sklepanja tukaj.

| Service | Porabljeni viri | Ocena stroškov na mesec v USD |

| Ojačaj AWS | 150 minut gradnje 1 GB podatkov 500,000 zahtev |

15.71 |

| Amazon API Gateway | 1 milijon klicev REST API | 3.5 |

| AWS Lambda | 1 milijon zahtev Trajanje 5 sekund na zahtevo 2 GB dodeljenega pomnilnika |

160.23 |

| Amazon DynamoDB | 1 milijon branj 1 milijon piše 100 GB shranjevanje |

26.38 |

| Amazon Sagemaker | Sklepanje v realnem času z ml.g4dn.2xlarge | 676.8 |

| Amazonska Kendra | Različica za razvijalce s 730 urami na mesec 10,000 skeniranih dokumentov 5,000 poizvedb/dan |

821.25 |

| . | . | Skupni stroški: 1703.87 |

* Amazon Cognito ima brezplačno stopnjo 50,000 mesečnih aktivnih uporabnikov, ki uporabljajo skupine uporabnikov Cognito, ali 50 mesečnih aktivnih uporabnikov, ki uporabljajo ponudnike identitete SAML 2.0

Clean Up

Če želite prihraniti stroške, izbrišite vse vire, ki ste jih razmestili kot del vadnice. Izbrišete lahko vse končne točke SageMaker, ki ste jih morda ustvarili prek konzole SageMaker. Ne pozabite, da brisanje indeksa Amazon Kendra ne odstrani izvirnih dokumentov iz vašega prostora za shranjevanje.

zaključek

V tej objavi smo vam pokazali, kako poenostaviti dostop do notranjih informacij s povzemanjem iz več skladišč v realnem času. Po nedavnem razvoju komercialno dostopnih LLM so postale možnosti generativne umetne inteligence bolj očitne. V tej objavi smo predstavili načine uporabe storitev AWS za ustvarjanje klepetalnega robota brez strežnika, ki za odgovarjanje na vprašanja uporablja generativni AI. Ta pristop vključuje plast preverjanja pristnosti in zaznavanje PII Amazon Comprehend za filtriranje vseh občutljivih informacij, navedenih v uporabniški poizvedbi. Ne glede na to, ali gre za posameznike v zdravstvu, ki razumejo nianse vložitve zavarovalnih zahtevkov, ali kadrovsko službo, ki razume posebne predpise za celotno podjetje, obstaja več panog in vertikal, ki jim lahko koristi ta pristop. Temeljni model Amazon SageMaker JumpStart je mehanizem za klepetalnim robotom, medtem ko se pristop polnjenja konteksta z uporabo tehnike RAG uporablja za zagotovitev, da se odgovori natančneje sklicujejo na notranje dokumente.

Če želite izvedeti več o delu z generativnim AI na AWS, glejte Napovedujemo nova orodja za gradnjo z Generative AI na AWS. Za bolj poglobljena navodila o uporabi tehnike RAG s storitvami AWS glejte Hitro zgradite visoko natančne aplikacije Generative AI na podatkih podjetja z uporabo Amazon Kendra, LangChain in velikih jezikovnih modelov. Ker je pristop v tem blogu agnostičen za LLM, se lahko za sklepanje uporabi kateri koli LLM. V naši naslednji objavi bomo orisali načine za implementacijo te rešitve z uporabo Amazon Bedrock in Amazon Titan LLM.

O avtorjih

Abhishek Maligehalli Shivalingaiah je višji arhitekt rešitev za storitve umetne inteligence pri AWS. Navdušen je nad gradnjo aplikacij z uporabo Generative AI, Amazon Kendra in NLP. Ima približno 10 let izkušenj z gradnjo podatkov in rešitev AI za ustvarjanje vrednosti za stranke in podjetja. Izdelal je celo (osebnega) chatbota za zabavo, da odgovarja na vprašanja o svoji karieri in poklicni poti. Zunaj dela uživa v portretiranju družine in prijateljev ter rad ustvarja umetniška dela.

Abhishek Maligehalli Shivalingaiah je višji arhitekt rešitev za storitve umetne inteligence pri AWS. Navdušen je nad gradnjo aplikacij z uporabo Generative AI, Amazon Kendra in NLP. Ima približno 10 let izkušenj z gradnjo podatkov in rešitev AI za ustvarjanje vrednosti za stranke in podjetja. Izdelal je celo (osebnega) chatbota za zabavo, da odgovarja na vprašanja o svoji karieri in poklicni poti. Zunaj dela uživa v portretiranju družine in prijateljev ter rad ustvarja umetniška dela.

Medha Aiyah je pridruženi arhitekt rešitev pri AWS s sedežem v Austinu v Teksasu. Pred kratkim je decembra 2022 diplomirala na Univerzi v Teksasu v Dallasu z magistrskim študijem računalništva s specializacijo iz inteligentnih sistemov s poudarkom na AI/ML. Zanima jo izvedeti več o AI/ML in uporabi storitev AWS za odkrivanje rešitev, ki lahko koristijo strankam.

Medha Aiyah je pridruženi arhitekt rešitev pri AWS s sedežem v Austinu v Teksasu. Pred kratkim je decembra 2022 diplomirala na Univerzi v Teksasu v Dallasu z magistrskim študijem računalništva s specializacijo iz inteligentnih sistemov s poudarkom na AI/ML. Zanima jo izvedeti več o AI/ML in uporabi storitev AWS za odkrivanje rešitev, ki lahko koristijo strankam.

Hugo Tse je pridruženi arhitekt rešitev pri AWS s sedežem v Seattlu v Washingtonu. Ima magisterij iz informacijske tehnologije na državni univerzi Arizona in diplomiral iz ekonomije na univerzi v Chicagu. Je član združenja Information Systems Audit and Control Association (ISACA) in International Information System Security Certification Consortium (ISC)2. Uživa v tem, da strankam pomaga izkoristiti prednosti tehnologije.

Hugo Tse je pridruženi arhitekt rešitev pri AWS s sedežem v Seattlu v Washingtonu. Ima magisterij iz informacijske tehnologije na državni univerzi Arizona in diplomiral iz ekonomije na univerzi v Chicagu. Je član združenja Information Systems Audit and Control Association (ISACA) in International Information System Security Certification Consortium (ISC)2. Uživa v tem, da strankam pomaga izkoristiti prednosti tehnologije.

Ayman Ishimwe je pridruženi arhitekt rešitev pri AWS s sedežem v Seattlu v Washingtonu. Ima magisterij iz programskega inženiringa in IT na univerzi Oakland. Ima predhodne izkušnje z razvojem programske opreme, natančneje z gradnjo mikrostoritev za porazdeljene spletne aplikacije. Strastno želi pomagati strankam zgraditi robustne in razširljive rešitve v storitvah v oblaku AWS po najboljših praksah.

Ayman Ishimwe je pridruženi arhitekt rešitev pri AWS s sedežem v Seattlu v Washingtonu. Ima magisterij iz programskega inženiringa in IT na univerzi Oakland. Ima predhodne izkušnje z razvojem programske opreme, natančneje z gradnjo mikrostoritev za porazdeljene spletne aplikacije. Strastno želi pomagati strankam zgraditi robustne in razširljive rešitve v storitvah v oblaku AWS po najboljših praksah.

Shervin Suresh je pridruženi arhitekt rešitev pri AWS s sedežem v Austinu v Teksasu. Diplomiral je iz programskega inženiringa s koncentracijo v računalništvo v oblaku in virtualizacijo ter diplomiral iz računalniškega inženiringa na državni univerzi San Jose. Navdušen je nad uporabo tehnologije za izboljšanje življenj ljudi iz vseh okolij.

Shervin Suresh je pridruženi arhitekt rešitev pri AWS s sedežem v Austinu v Teksasu. Diplomiral je iz programskega inženiringa s koncentracijo v računalništvo v oblaku in virtualizacijo ter diplomiral iz računalniškega inženiringa na državni univerzi San Jose. Navdušen je nad uporabo tehnologije za izboljšanje življenj ljudi iz vseh okolij.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Avtomobili/EV, Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- ChartPrime. Izboljšajte svojo igro trgovanja s ChartPrime. Dostopite tukaj.

- BlockOffsets. Posodobitev okoljskega offset lastništva. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :ima

- : je

- :ne

- :kje

- $GOR

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Sposobna

- O meni

- Sprejmi

- dostop

- Dostop

- računi

- natančna

- natančno

- dejavnosti

- aktivna

- dodajte

- Poleg tega

- naslovi

- naslavljanje

- administratorji

- Sprejem

- svetovalci

- po

- Agent

- agenti

- agregat

- AI

- Storitve AI

- AI / ML

- vsi

- omogoča

- skupaj

- Prav tako

- alternativa

- Amazon

- Amazon API Gateway

- Amazon Cognito

- Amazonsko razumevanje

- Amazonska Kendra

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- znesek

- zneski

- an

- Analitiki

- analize

- in

- odgovor

- odgovori

- kaj

- API

- očitno

- uporaba

- aplikacije

- imenovanje

- pristop

- odobri

- Arhitektura

- SE

- pojavijo

- Arizona

- okoli

- članek

- umetni

- Umetna inteligenca

- Umetna inteligenca (AI)

- umetniška dela

- AS

- vprašati

- vidiki

- oceniti

- pomoč

- pomoč

- Sodelavec

- povezan

- Združenje

- predpostavka

- At

- Revizija

- Povečana

- Austin

- overjena

- Preverjanje pristnosti

- pooblastilo

- avtomatizirati

- samodejno

- razpoložljivost

- Na voljo

- AWS

- AWS Lambda

- nazaj

- ozadja

- baza

- temeljijo

- BE

- Nosijo

- ker

- postanejo

- postane

- bilo

- pred

- ime

- zadaj

- koristi

- Prednosti

- BEST

- najboljše prakse

- Boljše

- Blog

- Knjiga

- Bot

- tako

- bote

- Bottom

- blagovne znamke

- proračun

- izgradnjo

- Building

- zgrajena

- poslovni

- podjetja

- vendar

- by

- klic

- CAN

- Zmogljivosti

- Kariera

- previdno

- primeru

- primeri

- Kategorija

- povzročilo

- center

- centralizirano

- nekatere

- certificiranje

- verige

- izzivi

- spremenite

- zaračuna

- chatbot

- preverjanje

- Pregledi

- Chicago

- terjatve

- jasno

- klinični

- kliničnih preskušanj

- Cloud

- računalništvo v oblaku

- storitev v oblaku

- zbiranje

- zbirka

- komercialno

- Skupno

- Komunikacija

- Podjetja

- podjetje

- Podjetja

- konkurenčno

- Končana

- dokončanje

- kompleksna

- kompleksnost

- izpolnjujejo

- razumeti

- računalnik

- Računalniški inženiring

- Računalništvo

- računalništvo

- koncentracija

- Koncept

- zgoščeno

- poteka

- sotočje

- Connect

- povezuje

- premislek

- premislekov

- šteje

- dosledno

- Sestavljeno

- Konzole

- konzorcij

- porabijo

- poraba

- kontakt

- kontaktni center

- Vsebuje

- vsebina

- ozadje

- stalno

- prispeva

- nadzor

- nadzor

- udobje

- Pogovor

- pogovorni

- pogovorov

- Corporate

- popravi

- strošek

- stroški

- gosenicah

- ustvarjajo

- Ustvarite vrednost

- ustvaril

- Ustvarjanje

- kredit

- Merila

- kritično

- CRM

- ključnega pomena

- kurirano

- Trenutna

- Trenutno

- stranka

- Angažiranje strank

- Izkušnje s strankami

- Za stranke

- Pomoč strankam

- Stranke, ki so

- vsak dan

- Dallas

- datum

- podatkovne točke

- nabori podatkov

- Baze podatkov

- Datum

- december

- odloča

- Odločitev

- Odločanje

- odločitve

- Stopnja

- dostavi

- Odvisno

- razporejeni

- uvajanja

- opisati

- Oblikovanje

- Kljub

- Podrobnosti

- Zaznali

- Odkrivanje

- Razvojni

- Razvoj

- razvoju

- drugačen

- težko

- odkriti

- porazdeljena

- Dokumentacija

- Dokumenti

- ne

- Ne

- pogon

- trajanje

- e

- lažje

- enostavno

- Economics

- ekosistem

- izdaja

- učinkovitosti

- prizadevanje

- bodisi

- upravičenost

- E-naslov

- e-pošta

- Zaposlen

- Zaposleni

- omogoča

- spodbuja

- Končna točka

- energija

- sodelovanje

- Motor

- Inženiring

- bogatenje

- zagotovitev

- zagotavlja

- zagotoviti

- Podjetje

- podjetja

- subjekti

- napake

- Stopnjevanje

- oceniti

- itd

- Tudi

- Primer

- izvršiti

- obstoječih

- drago

- izkušnje

- Pojasnite

- Pojasni

- pridobivanje

- Izvlečki

- Obraz

- družina

- Feature

- Fed

- manj

- Slika

- file

- izpolnite

- napolnjena

- polnjenje

- filter

- finančna

- finančnih podatkov

- finančna zgodovina

- finančna institucija

- financiranja

- Najdi

- iskanje

- prva

- prilagodljivost

- Pretok

- osredotoča

- po

- za

- obrazec

- Obrazci

- forumi

- je pokazala,

- Fundacija

- okviri

- brezplačno

- prijatelji

- iz

- zabava

- funkcija

- funkcije

- nadalje

- Gain

- Prehod

- ustvarjajo

- generacija

- generativno

- Generativna AI

- dobili

- dana

- daje

- Giving

- vlada

- zelo

- Grow

- Pridelovanje

- raste

- Navodila

- Smernice

- ročaj

- Ročaji

- Ravnanje

- Imajo

- ob

- he

- Zdravje

- zdravstvene informacije

- zdravstveno varstvo

- pomoč

- pomoč

- Pomaga

- jo

- visoka

- zelo

- njegov

- zgodovina

- drži

- gostila

- Gostitelji

- URE

- Kako

- Kako

- Vendar

- hr

- HTML

- HTTPS

- človeškega

- i

- identifikator

- identifikatorji

- identificira

- identificirati

- identifikacijo

- identiteta

- if

- ponazarja

- izvajati

- izvajanja

- posledice

- izboljšanje

- izboljšuje

- izboljšanju

- in

- Poglobljena

- netočne

- vključujejo

- vključuje

- Vključno

- prihodki

- davek na prihodek

- Povečajte

- Poveča

- Indeks

- indeksirane

- indekse

- posamezniki

- industrij

- obvesti

- Podatki

- Informacijski sistemi

- informacijska tehnologija

- obvestila

- dedovanje

- vhod

- primer

- instant

- Namesto

- ustanova

- Institucije

- zavarovanje

- integrirana

- Integrira

- integracija

- Intelligence

- Inteligentna

- namen

- interakcijo

- interaktivno

- zainteresirani

- vmesnik

- notranji

- Facebook Global

- v

- naložbe

- vprašanje

- IT

- Izdelkov

- Potovanje

- jpg

- Imejte

- znanje

- znano

- jezik

- velika

- plast

- vodi

- UČITE

- učenje

- manj

- Stopnja

- vzvod

- Knjižnica

- Omejitev

- omejitve

- vrstica

- živi

- LLM

- posojila

- Posojila

- prijavi

- logično

- Long

- dolgo časa

- več

- Poglej

- Sklop

- ljubi

- nizkimi stroški

- nižje

- Zvest

- Zvestoba

- stroj

- strojno učenje

- je

- vzdrževati

- Znamka

- IZDELA

- Izdelava

- upravljanje

- upravljanje

- Način

- Navodilo

- ročno

- več

- Tržna

- tržna raziskava

- poveljnika

- Maj ..

- pomeni

- medicinski

- član

- Spomin

- mikro storitve

- Microsoft

- milijonov

- milijoni

- moti

- ML

- Model

- modeli

- Moduli

- mesec

- mesečno

- več

- Najbolj

- več

- materni

- potrebno

- Nimate

- potrebna

- potrebe

- Novo

- Naslednja

- nlp

- Obvestilo

- številke

- Oakland

- oauth

- of

- Ponudbe

- pogosto

- Olje

- on

- Na vkrcanje

- enkrat

- ONE

- v teku

- samo

- odprite

- deluje

- deluje

- operativno

- Priložnost

- optimizacija

- Možnost

- možnosti

- or

- Da

- organizacije

- izvirno

- Ostalo

- naši

- ven

- oris

- zunaj

- več

- paradigma

- del

- deli

- opravil

- strastno

- Bolnik

- Plačajte

- ljudje

- za

- performance

- Dovoljenja

- Osebni

- osebni podatki

- Osebno

- Farmacevtska

- steber

- Načrt

- platon

- Platonova podatkovna inteligenca

- PlatoData

- prosim

- Točka

- točke

- politike

- Bazeni

- Portal

- portreti

- možnosti

- možnost

- Prispevek

- poganja

- vaje

- predstaviti

- preprečiti

- prejšnja

- prej

- cenitev

- model določanja cen

- Predhodna

- prednostna naloga

- zasebnost

- Težave

- Postopki

- nadaljujte

- Postopek

- Predelano

- Procesi

- obravnavati

- proizvodnja

- produktivnost

- Izdelki

- strokovni

- strokovnjaki

- nepremičnine

- zagotavljajo

- če

- ponudniki

- zagotavljanje

- objavljeno

- kupili

- Vprašanja in odgovori

- izpolnjujejo pogoje

- kvalifikacij

- poizvedbe

- vprašanje

- vprašanja

- Hitri

- hitro

- območje

- Oceniti

- Preberi

- reading

- v realnem času

- nedavno

- Pred kratkim

- zmanjša

- zmanjšuje

- glejte

- sklicevanje

- o

- redno

- predpisi

- Razmerje

- ustreznost

- pomembno

- zanašajo

- ostanki

- ne pozabite

- odstrani

- zahteva

- zahteva

- zahteva

- obvezna

- Zahteve

- Raziskave

- raziskovalci

- Resolucija

- reševanje

- viri

- Odgovor

- odgovorov

- Odgovornost

- REST

- povzroči

- vrnitev

- Pregledal

- Pravica

- tveganja

- robusten

- Pot

- tek

- s

- sagemaker

- prodaja

- San

- San Jose

- Zadovoljstvo

- Shrani

- razširljive

- Lestvica

- Scenarij

- Znanost

- rezultat

- skripte

- Iskalnik

- iskanje

- Seattle

- drugi

- sekund

- Oddelek

- zavarovanje

- Varno

- varnost

- Prodaja

- pošljite

- višji

- občutljiva

- poslan

- Brez strežnika

- služi

- Storitev

- Storitve

- nastavite

- Kompleti

- nastavitve

- več

- je

- premik

- pomanjkljivosti

- shouldnt

- predstavljeni

- je pokazala,

- pokazale

- silosi

- Podoben

- Enostavno

- poenostavitev

- saj

- sam

- velikosti

- manj

- So

- socialna

- Software

- Razvoj programske opreme

- inženiring programske opreme

- Rešitev

- rešitve

- nekaj

- vir

- Viri

- specializacijo

- specifična

- posebej

- preživeti

- Poraba

- standardna

- Država

- Status

- bivanje

- Korak

- Koraki

- Še vedno

- shranjevanje

- trgovina

- shranjeni

- shranjevanje

- stres

- polnjenje

- precejšen

- taka

- predlagajte

- Povzamemo

- podpora

- sistem

- sistemi

- miza

- meni

- Naloge

- davek

- skupina

- Skupine

- Tehnologija

- Pogoji

- texas

- besedilo

- besedilno

- da

- O

- informacije

- njihove

- sami

- POTEM

- Tukaj.

- te

- jih

- tretjih oseb

- ta

- skozi

- Vstopnica

- vozovnice

- živali

- čas

- zamudno

- pravočasno

- krat

- Časovni žig

- titan

- do

- danes

- Boni

- orodje

- orodja

- Sledljivost

- tradicionalno

- usposobljeni

- usposabljanje

- transformator

- Preglednost

- Zdravljenje

- sojenje

- poskusi

- Navodila

- Vrste

- ne morem

- razumeli

- razumevanje

- edinstven

- Univerze

- univerza

- University of Chicago

- up-to-date

- posodobljeno

- posodabljanje

- uporaba

- primeru uporabe

- Rabljeni

- uporabnik

- Uporabniki

- uporablja

- uporabo

- uporabiti

- uporablja

- Uporaben

- vrednost

- različnih

- Preverjanje

- preverjanje

- vertikale

- preko

- Video

- Video posnetki

- Voice

- Počakaj

- Čakam

- je

- washington

- načini

- we

- web

- Spletna aplikacija

- spletne aplikacije

- spletne storitve

- Dobro

- so bili

- Kaj

- kdaj

- ali

- ki

- medtem

- WHO

- široka

- Širok spekter

- z

- v

- delo

- potek dela

- deluje

- bi

- pisni

- let

- Vi

- Vaša rutina za

- zefirnet