Veliki jezikovni modeli (LLM) so revolucionirali področje obdelave naravnega jezika (NLP) in izboljšali naloge, kot so prevajanje jezikov, povzemanje besedila in analiza občutkov. Ker pa ti modeli še naprej rastejo v velikosti in kompleksnosti, postaja spremljanje njihove učinkovitosti in obnašanja vse večji izziv.

Spremljanje učinkovitosti in obnašanja LLM je kritična naloga za zagotavljanje njihove varnosti in učinkovitosti. Naša predlagana arhitektura zagotavlja razširljivo in prilagodljivo rešitev za spletno spremljanje LLM, ki ekipam omogoča, da vašo rešitev za spremljanje prilagodijo vašim posebnim primerom uporabe in zahtevam. Z uporabo storitev AWS naša arhitektura zagotavlja vpogled v vedenje LLM v realnem času in ekipam omogoča hitro prepoznavanje in odpravljanje morebitnih težav ali nepravilnosti.

V tej objavi prikazujemo nekaj meritev za spletno spremljanje LLM in njihovo ustrezno arhitekturo za obseg z uporabo storitev AWS, kot je npr. amazoncloudwatch in AWS Lambda. To ponuja prilagodljivo rešitev, ki presega tisto, kar je mogoče vrednotenje modela delovna mesta z Amazon Bedrock.

Pregled rešitve

Prva stvar, ki jo je treba upoštevati, je, da različne metrike zahtevajo različne premisleke pri izračunu. Potrebna je modularna arhitektura, kjer lahko vsak modul zajema podatke o sklepanju modela in proizvaja lastne meritve.

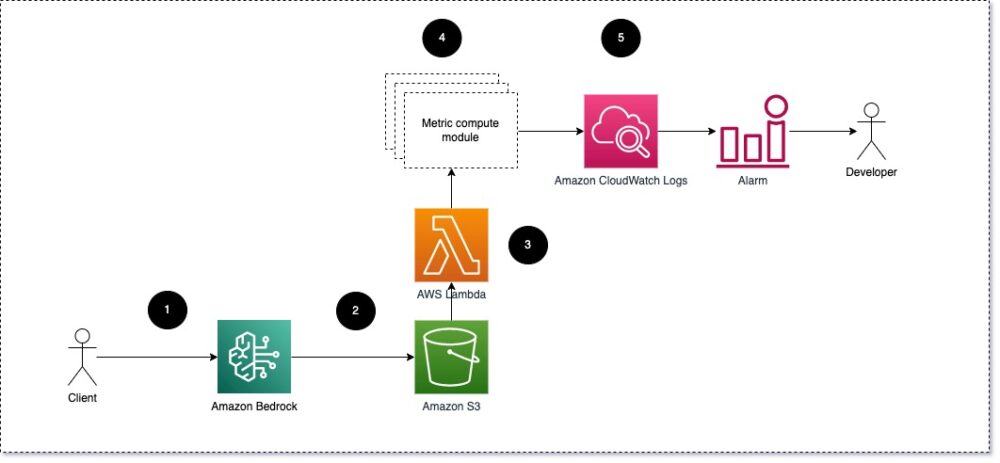

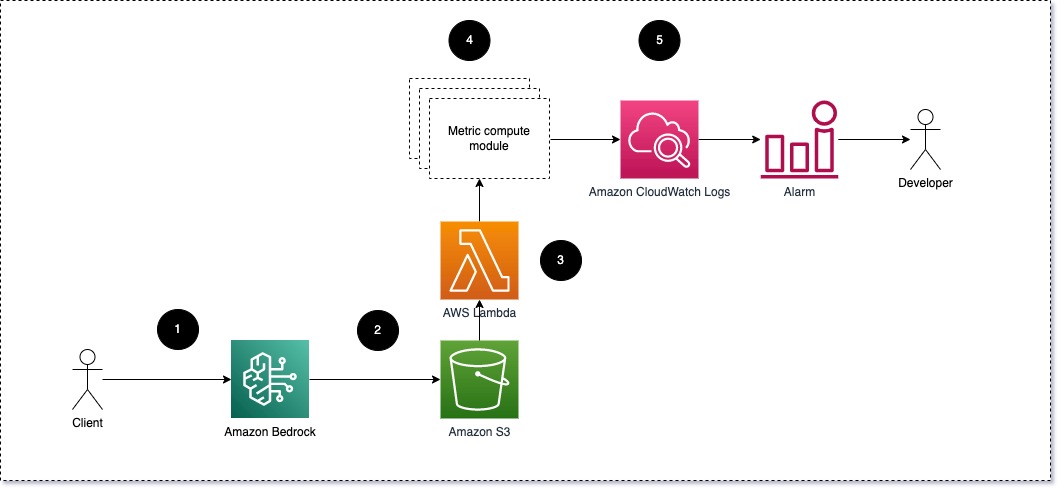

Predlagamo, da vsak modul sprejme dohodne zahteve za sklepanje do LLM, pri čemer posreduje pare pozivov in zaključkov (odgovor) metričnim računalniškim modulom. Vsak modul je odgovoren za izračun lastnih meritev glede na poziv za vnos in dokončanje (odgovor). Te meritve se posredujejo storitvi CloudWatch, ki jih lahko združi in deluje z alarmi storitve CloudWatch za pošiljanje obvestil o določenih pogojih. Naslednji diagram ponazarja to arhitekturo.

Slika 1: Modul za metrični izračun – pregled rešitve

Potek dela vključuje naslednje korake:

- Uporabnik poda zahtevo Amazon Bedrock kot del aplikacije ali uporabniškega vmesnika.

- Amazon Bedrock shrani zahtevo in dokončanje (odgovor) v Preprosta storitev shranjevanja Amazon (Amazon S3) glede na konfiguracijo beleženje klicev.

- Datoteka, shranjena na Amazon S3, ustvari dogodek, ki sproži funkcija Lambda. Funkcija prikliče module.

- Moduli objavijo svoje ustrezne meritve Meritve CloudWatch.

- alarmi lahko obvesti razvojno ekipo o nepričakovanih metričnih vrednostih.

Druga stvar, ki jo morate upoštevati pri izvajanju spremljanja LLM, je izbira pravih meritev za sledenje. Čeprav obstaja veliko možnih meritev, ki jih lahko uporabite za spremljanje uspešnosti LLM, v tej objavi pojasnjujemo nekatere najširše.

V naslednjih razdelkih izpostavljamo nekaj ustreznih metrik modulov in njihove ustrezne arhitekture metričnih računskih modulov.

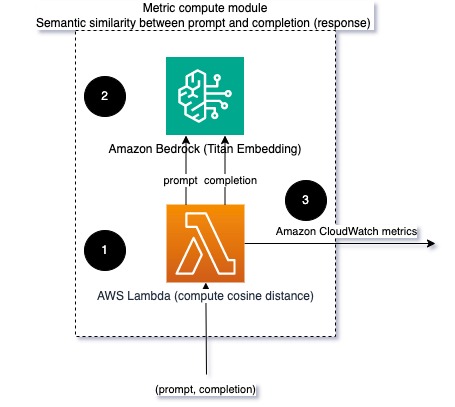

Pomenska podobnost med pozivom in zaključkom (odzivom)

Ko izvajate LLM, lahko prestrežete poziv in dokončanje (odgovor) za vsako zahtevo in ju pretvorite v vdelave z uporabo modela vdelave. Vdelave so visokodimenzionalni vektorji, ki predstavljajo semantični pomen besedila. Amazon Titan zagotavlja takšne modele prek Titan Embeddings. Če vzamete razdaljo, kot je kosinus med tema dvema vektorjema, lahko kvantificirate, kako pomensko sta si podobna poziv in dokončanje (odgovor). Lahko uporabiš SciPy or scikit-učiti za izračun kosinusne razdalje med vektorji. Naslednji diagram ponazarja arhitekturo tega metričnega računskega modula.

Slika 2: Modul za metrični izračun – semantična podobnost

Ta potek dela vključuje naslednje ključne korake:

- Funkcija Lambda prejme pretočno sporočilo prek Amazon Kinesis ki vsebuje par poziva in zaključka (odgovora).

- Funkcija dobi vdelavo tako za poziv kot za dokončanje (odziv) in izračuna kosinusno razdaljo med obema vektorjema.

- Funkcija pošlje te informacije meritvam CloudWatch.

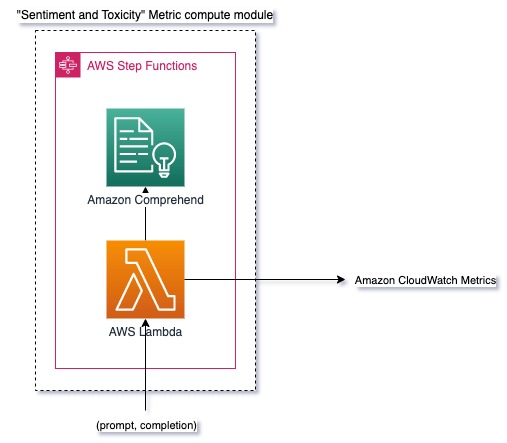

Sentiment in strupenost

Spremljanje razpoloženja vam omogoča, da ocenite splošni ton in čustveni učinek odzivov, medtem ko analiza toksičnosti zagotavlja pomembno merilo prisotnosti žaljivega, nespoštljivega ali škodljivega jezika v rezultatih LLM. Vse spremembe v razpoloženju ali toksičnosti je treba natančno spremljati, da zagotovimo, da se model obnaša po pričakovanjih. Naslednji diagram prikazuje modul za metrični izračun.

Slika 3: Metrični računski modul – razpoloženje in toksičnost

Potek dela vključuje naslednje korake:

- Funkcija Lambda prejme par poziva in zaključka (odgovor) prek Amazon Kinesis.

- Prek orkestracije AWS Step Functions funkcija kliče Amazonsko razumevanje odkriti sentiment in strupenost.

- Funkcija shrani podatke v meritve CloudWatch.

Za več informacij o zaznavanju razpoloženja in toksičnosti z Amazon Comprehend glejte Zgradite robusten napovedovalec toksičnosti na podlagi besedila in Označite škodljivo vsebino z zaznavanjem toksičnosti Amazon Comprehend.

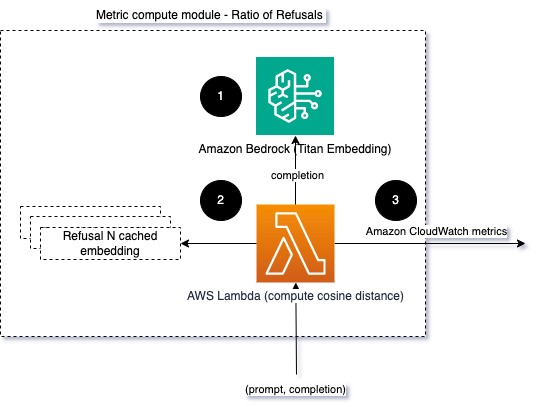

Razmerje zavrnitev

Povečanje števila zavrnitev, na primer ko LLM zavrne dokončanje zaradi pomanjkanja informacij, lahko pomeni, da bodisi zlonamerni uporabniki poskušajo uporabiti LLM na načine, ki so namenjeni preprečevanju zapora, ali pa da pričakovanja uporabnikov niso izpolnjena in prejemajo odgovore nizke vrednosti. Eden od načinov za merjenje, kako pogosto se to dogaja, je primerjava standardnih zavrnitev uporabljenega modela LLM z dejanskimi odgovori LLM. Spodaj je na primer nekaj pogostih stavkov za zavrnitev Anthropic Claude v2 LLM:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

Pri fiksnem naboru pozivov je povečanje števila teh zavrnitev lahko signal, da je model postal preveč previden ali občutljiv. Oceniti je treba tudi obratni primer. To je lahko znak, da je model zdaj bolj nagnjen k vključevanju v strupene ali škodljive pogovore.

Za pomoč pri modeliranju celovitosti in modela zavrnitvenega razmerja lahko primerjamo odziv z nizom znanih zavrnitvenih stavkov iz LLM. To bi lahko bil dejanski klasifikator, ki lahko pojasni, zakaj je model zavrnil zahtevo. Iz modela, ki ga spremljate, lahko vzamete kosinusno razdaljo med odzivom in znanimi odzivi zavrnitve. Naslednji diagram prikazuje ta metrični računski modul.

Slika 4: Modul za metrični izračun – razmerje zavrnitev

Potek dela je sestavljen iz naslednjih korakov:

- Funkcija Lambda prejme poziv in dokončanje (odgovor) ter dobi vdelavo iz odgovora z uporabo Amazon Titan.

- Funkcija izračuna kosinusno ali evklidsko razdaljo med odzivom in obstoječimi pozivi za zavrnitev, ki so predpomnjeni v pomnilniku.

- Funkcija pošlje to povprečje meritvam CloudWatch.

Druga možnost je uporaba mehko ujemanje za preprost, a manj močan pristop za primerjavo znanih zavrnitev z rezultati LLM. Glejte na Python dokumentacija za primer.

Povzetek

Opazljivost LLM je kritična praksa za zagotavljanje zanesljive in zaupanja vredne uporabe LLM. Spremljanje, razumevanje in zagotavljanje točnosti in zanesljivosti LLM vam lahko pomaga ublažiti tveganja, povezana s temi modeli AI. S spremljanjem halucinacij, slabih zaključkov (odzivov) in pozivov lahko zagotovite, da vaš LLM ostane na pravi poti in zagotavlja vrednost, ki jo iščete vi in vaši uporabniki. V tej objavi smo obravnavali nekaj meritev za predstavitev primerov.

Za več informacij o ocenjevanju modelov temeljev glejte Uporabite SageMaker Clarify za oceno modelov temeljev, in prebrskajte dodatne primeri zvezkov na voljo v našem repozitoriju GitHub. Prav tako lahko raziščete načine za operacionalizacijo vrednotenj LLM v velikem obsegu Operacionalizirajte vrednotenje LLM v velikem obsegu z uporabo storitev Amazon SageMaker Clarify in MLOps. Na koncu priporočamo, da se obrnete na Ocenite velike jezikovne modele glede kakovosti in odgovornosti če želite izvedeti več o ocenjevanju LLM.

O avtorjih

Bruno Klein je višji inženir strojnega učenja pri AWS Professional Services Analytics Practice. Strankam pomaga pri implementaciji velikih podatkov in analitičnih rešitev. Zunaj službe rad preživlja čas z družino, potuje in poskuša novo hrano.

Bruno Klein je višji inženir strojnega učenja pri AWS Professional Services Analytics Practice. Strankam pomaga pri implementaciji velikih podatkov in analitičnih rešitev. Zunaj službe rad preživlja čas z družino, potuje in poskuša novo hrano.

Rushabh Lokhande je višji inženir za podatke in ML pri AWS Professional Services Analytics Practice. Strankam pomaga pri implementaciji velikih podatkov, strojnega učenja in analitičnih rešitev. Zunaj službe rad preživlja čas z družino, bere, teče in igra golf.

Rushabh Lokhande je višji inženir za podatke in ML pri AWS Professional Services Analytics Practice. Strankam pomaga pri implementaciji velikih podatkov, strojnega učenja in analitičnih rešitev. Zunaj službe rad preživlja čas z družino, bere, teče in igra golf.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :ima

- : je

- :ne

- :kje

- 1

- 100

- 143

- 32

- 455

- 7

- a

- O meni

- natančnost

- dejanska

- Dodatne

- Naslov

- agregat

- AI

- Pomočnik AI

- AI modeli

- omogoča

- Prav tako

- Čeprav

- am

- Amazon

- Amazonsko razumevanje

- Amazon Kinesis

- Amazon SageMaker

- Amazon Web Services

- an

- Analiza

- analitika

- in

- nepravilnosti

- Antropično

- kaj

- uporaba

- pristop

- pristopi

- Arhitektura

- SE

- AS

- Pomočnik

- povezan

- At

- Na voljo

- povprečno

- AWS

- Strokovne storitve AWS

- Korak funkcije AWS

- Slab

- BE

- postanejo

- vedenje

- počutje

- med

- Poleg

- Big

- Big Podatki

- tako

- vendar

- by

- poziva

- CAN

- ne more

- primeru

- primeri

- previden

- izziv

- izbiri

- klasifikator

- tesno

- Skupno

- primerjate

- primerjavo

- dokončanje

- kompleksnost

- razumeti

- računanje

- Izračunajte

- računalništvo

- Pogoji

- konfiguracija

- Razmislite

- premislekov

- vsebuje

- vsebina

- ozadje

- naprej

- pogovorov

- bi

- ustvaril

- ustvari

- kritično

- Stranke, ki so

- prilagodljiv

- datum

- daje

- izkazati

- odkrivanje

- Razvoj

- razvojna ekipa

- diagram

- drugačen

- razpravljali

- razdalja

- do

- 2

- vsak

- učinkovitost

- bodisi

- vdelava

- omogoča

- omogočanje

- sodelovati

- inženir

- dovolj

- zagotovitev

- zagotoviti

- oceniti

- ocenili

- ocenjevanje

- Ocena

- vrednotenja

- Event

- Primer

- Primeri

- obstoječih

- pričakovanja

- Pričakuje

- Pojasnite

- raziskuje

- družina

- Nekaj

- Polje

- sl

- file

- končno

- prva

- Všita

- po

- hrana

- za

- Fundacija

- iz

- funkcija

- funkcije

- merilnik

- dobi

- pridobivanje

- GitHub

- golf

- Grow

- Zgodi se

- škodljiva

- Imajo

- he

- pomoč

- pomoč

- Pomaga

- Označite

- pošten

- Kako

- Vendar

- HTML

- http

- HTTPS

- i

- identificirati

- ponazarja

- vpliv

- izvajati

- izvajanja

- Pomembno

- izboljšanju

- in

- vključuje

- Dohodni

- Povečajte

- vedno

- Podatki

- vhod

- celovitost

- namenjen

- vmesnik

- v

- inverzna

- prikliče

- Vprašanja

- IT

- ITS

- Jailbreak

- Delovna mesta

- jpg

- Ključne

- znano

- Pomanjkanje

- jezik

- velika

- UČITE

- učenje

- manj

- LLM

- si

- stroj

- strojno učenje

- Znamka

- IZDELA

- zlonamerno

- več

- pomeni

- kar pomeni,

- merjenje

- Spomin

- Sporočilo

- pol

- meritev

- Meritve

- Omiliti

- ML

- MLOps

- Model

- modeli

- Modularna

- Moduli

- Moduli

- monitor

- spremljati

- spremljanje

- več

- naravna

- Obdelava Natural Language

- potrebno

- Novo

- nlp

- Obvestila

- zdaj

- of

- žaljive

- Ponudbe

- pogosto

- on

- ONE

- tiste

- na spletu

- Možnost

- or

- orkestracijo

- naši

- izhod

- izhodi

- zunaj

- Splošni

- pregled

- lastne

- par

- parov

- del

- opravil

- Podaje

- za

- performance

- stavki

- platon

- Platonova podatkovna inteligenca

- PlatoData

- igranje

- mogoče

- Prispevek

- potencial

- močan

- praksa

- Prisotnost

- obravnavati

- proizvodnjo

- strokovni

- pozove

- predlagano

- zagotavljajo

- zagotavlja

- Python

- kakovost

- hitro

- razmerje

- reading

- v realnem času

- prejme

- Priporočamo

- glejte

- zavrnitev

- zavrnil

- pomembno

- zanesljivost

- zanesljiv

- Skladišče

- predstavljajo

- zahteva

- zahteva

- zahteva

- Zahteve

- spoštovanje

- tisti,

- Odgovor

- odgovorov

- odgovorna

- revolucionirala

- Pravica

- tveganja

- robusten

- tek

- Varnost

- sagemaker

- shranjena

- razširljive

- Lestvica

- drugi

- oddelki

- pomensko

- pošljite

- pošlje

- višji

- občutljiva

- sentiment

- Storitve

- nastavite

- Izmene

- shouldnt

- predstavitev

- Signal

- Podoben

- Enostavno

- Velikosti

- Rešitev

- rešitve

- nekaj

- prostorsko

- specifična

- Poraba

- standardna

- Korak

- Koraki

- shranjevanje

- naravnost

- pretočenih

- taka

- predlagajte

- Preverite

- po meri

- Bodite

- ob

- Naloga

- Naloge

- skupina

- Skupine

- tehnike

- besedilo

- da

- O

- informacije

- njihove

- Njih

- Tukaj.

- te

- jih

- stvar

- ta

- skozi

- čas

- titan

- do

- TONE

- sledenje

- Transform

- prevod

- Potovanje

- zaupanja

- poskuša

- dva

- razumevanje

- Nepričakovana

- uporaba

- Rabljeni

- uporabnik

- Uporabniški vmesnik

- Uporabniki

- uporabo

- vrednost

- Vrednote

- preko

- vidljivost

- način..

- načini

- we

- web

- spletne storitve

- Kaj

- Kaj je

- kdaj

- medtem ko

- ki

- zakaj

- Wikipedia

- z

- delo

- potek dela

- Vi

- Vaša rutina za

- zefirnet