Intervju Če mislite, da ima generativna umetna inteligenca samodejno mesto za mizo v svetu prava, pomislite znova.

Najvišji veliki jezikovni modeli ponavadi ustvarijo netočne pravne informacije in se nanje ne bi smeli zanašati v sodnih sporih, je pokazala nova raziskava.

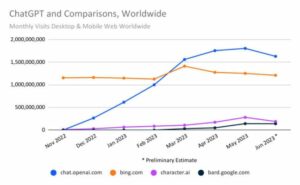

Lani, ko je OpenAI pokazal GPT-4 je bil sposoben opraviti pravosodni izpit, je bil napovedan kot preboj v umetni inteligenci, zaradi česar so se nekateri spraševali, ali bo tehnologija kmalu zamenjajte pravniki. Nekateri so upali, da bi tovrstni modeli lahko opolnomočili ljudi, ki si ne morejo privoščiti dragih odvetnikov, da bi uveljavljali pravno pravico, zaradi česar bi bil dostop do pravne pomoči pravičnejši. Resničnost pa je, da LLM-ji ne morejo niti učinkovito pomagati poklicnim odvetnikom, glede na nedavno študijo.

Največja skrb je, da umetna inteligenca pogosto izdeluje lažne informacije, kar predstavlja velik problem, zlasti v industriji, ki se opira na dejanske dokaze. Skupina raziskovalcev na univerzi Yale in Stanford, ki je analizirala stopnje halucinacij v priljubljenih velikih jezikovnih modelih, je ugotovila, da ti pogosto ne pridobijo natančno ali ustvarijo ustreznih pravnih informacij ali ne razumejo in razmišljajo o različnih zakonih.

Pravzaprav GPT-3.5 OpenAI, ki trenutno poganja brezplačno različico ChatGPT, halucinira približno 69 odstotkov časa, ko se testira v različnih nalogah. Rezultati so bili slabši za PaLM-2, sistem, ki je prej stal za Googlovim klepetalnim robotom Bard, in Llama 2, veliki jezikovni model, ki ga je izdala Meta, ki je ustvaril neresnice s stopnjo 72 oziroma 88 odstotkov.

Ni presenetljivo, da se modeli trudijo opraviti bolj zapletene naloge v primerjavi z lažjimi. Zahtevati, da umetna inteligenca primerja različne primere in ugotovi, ali se na primer strinjajo glede določenega vprašanja, je izziv in bolj verjetno bo ustvaril netočne informacije, kot če bi se soočili z lažjo nalogo, kot je preverjanje, pri katerem sodišču je bila zadeva vložena.

Čeprav magistri prava blestijo pri obdelavi velikih količin besedila in se jih je mogoče uriti na ogromnih količinah pravnih dokumentov – več, kot bi jih kateri koli človeški odvetnik lahko prebral v svojem življenju –, ne razumejo prava in ne znajo oblikovati tehtnih argumentov.

»Čeprav smo videli, da tovrstni modeli dosegajo res velik napredek v oblikah deduktivnega sklepanja pri kodiranju ali matematičnih težavah, to ni nabor spretnosti, ki je značilen za vrhunsko odvetništvo,« Daniel Ho, soavtor knjige časopis Yale-Stanford, pove Register.

"To, v čemer so odvetniki res dobri in kjer blestijo, je pogosto opisano kot oblika analognega sklepanja v sistemu običajnega prava, sklepanja na podlagi precedensov," je dodal Ho, ki je sodelavec direktorja Stanfordskega inštituta za človekovo usmerjenost Umetna inteligenca.

Stroji pogosto odpovejo tudi pri preprostih opravilih. Na zahtevo, da pregledajo ime ali navedbo, da preverijo, ali je primer resničen, si lahko GPT-3.5, PaLM-2 in Llama 2 izmislijo lažne informacije v odgovorih.

»Manekenki ni treba pošteno vedeti ničesar o pravu, da bi pravilno odgovorila na to vprašanje. Samo vedeti mora, ali primer obstaja ali ne, in to lahko vidi kjer koli v učnem korpusu,« pravi Matthew Dahl, doktorski študent prava na univerzi Yale.

Kaže, da umetna inteligenca niti ne more natančno pridobiti informacij in da obstaja temeljna omejitev zmogljivosti tehnologije. Ti modeli so pogosto označeni kot prijetni in koristni. Običajno se ne bodo trudili popravljati predpostavk uporabnikov in se bodo namesto tega postavili na njihovo stran. Če se od chatbotov zahteva, da ustvarijo seznam primerov v podporo nekemu pravnemu argumentu, so na primer bolj nagnjeni k izmišljevanju tožb, kot pa k temu, da ne odgovorijo nič. Par odvetnikov se je tega naučil na težji način, ko sta bila kazni za navajanje primerov, ki si jih je popolnoma izmislil ChatGPT OpenAI v svoji sodni vlogi.

Raziskovalci so tudi ugotovili, da so bili trije modeli, ki so jih testirali, bolj verjetno seznanjeni z zveznimi sodnimi postopki, povezanimi z vrhovnim sodiščem ZDA, v primerjavi z lokalnimi pravnimi postopki v zvezi z manjšimi in manj močnimi sodišči.

Ker so bili GPT-3.5, PaLM-2 in Llama 2 urjeni na besedilu, postrganem iz interneta, je logično, da bodo bolje seznanjeni s pravnimi mnenji vrhovnega sodišča ZDA, ki so javno objavljena v primerjavi s pravnimi dokumenti, vloženimi v drugih vrstah. sodišč, ki niso tako lahko dostopna.

Prav tako so bili bolj verjetno, da se bodo borili pri nalogah, ki so vključevale priklic informacij iz starih in novih primerov.

"Halucinacije so najpogostejše med najstarejšimi in najnovejšimi zadevami vrhovnega sodišča, najmanj pa med povojnimi zadevami Warren Court (1953-1969)," piše v časopisu. »Ta rezultat nakazuje še eno pomembno omejitev pravnega znanja LLM-jev, ki bi se je morali uporabniki zavedati: največja uspešnost LLM-jev lahko zaostaja nekaj let za trenutnim stanjem doktrine, LLM-ji pa morda ne bodo uspeli ponotranjiti sodne prakse, ki je zelo stara, a še vedno veljavna. in ustrezno zakonodajo.«

Preveč umetne inteligence bi lahko ustvarilo "monokulturo"

Raziskovalci so bili tudi zaskrbljeni, da bi pretirano zanašanje na te sisteme lahko ustvarilo pravno »monokulturo«. Ker se umetna inteligenca usposablja na omejeni količini podatkov, se bo sklicevala na vidnejše, dobro znane primere, zaradi katerih bodo odvetniki zanemarili druge pravne razlage ali ustrezne precedense. Morda spregledajo druge primere, ki bi jim lahko pomagali videti drugačne perspektive ali argumente, kar bi se lahko izkazalo za ključnega pomena v pravdi.

"Zakon sam po sebi ni monoliten," pravi Dahl. »Monokultura je še posebej nevarna v zakonitem okolju. V Združenih državah imamo sistem zveznega običajnega prava, kjer se pravo razvija različno v različnih zveznih državah v različnih jurisdikcijah. Obstajajo različne linije ali trendi sodne prakse, ki se razvijajo skozi čas.«

"To bi lahko vodilo do napačnih rezultatov in neupravičenega zanašanja na način, ki bi lahko dejansko škodoval strankam v sodnem postopku," dodaja Ho. Pojasnil je, da bi lahko model ustvaril netočne odgovore odvetnikom ali ljudem, ki želijo razumeti nekaj, kot je zakonodaja o deložacijah.

"Ko iščete pomoč pri velikem jezikovnem modelu, boste morda dobili natančen napačen odgovor o tem, kdaj je rok za vložitev vloge ali kakšno je pravilo izselitve v tej državi," pravi in navaja primer. "Ker vam govori zakon v New Yorku ali zakonodaja Kalifornije, v nasprotju z zakonom, ki je dejansko pomemben za vaše posebne okoliščine v vaši jurisdikciji."

Raziskovalci sklepajo, da je tveganje uporabe tovrstnih priljubljenih modelov za pravne naloge največje za tiste, ki predložijo dokumentacijo na nižjih sodiščih v manjših državah, zlasti če imajo manj strokovnega znanja in povprašujejo po modelih na podlagi napačnih predpostavk. Ti ljudje so bolj verjetno odvetniki, ki so manj močni od manjših odvetniških pisarn z manj sredstvi, ali ljudje, ki želijo zastopati sami sebe.

"Skratka, ugotovili smo, da so tveganja najvišja za tiste, ki bi jim študij LLM najbolj koristil," navaja dokument. ®

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://go.theregister.com/feed/www.theregister.com/2024/01/10/top_large_language_models_struggle/

- :ima

- : je

- :ne

- :kje

- $GOR

- 7

- 72

- a

- O meni

- dostop

- dostopen

- Po

- natančna

- natančno

- čez

- dejansko

- dodano

- Dodaja

- spet

- AI

- Prav tako

- med

- znesek

- zneski

- an

- analiziranje

- in

- Še ena

- odgovor

- kaj

- karkoli

- kjerkoli

- primerno

- SE

- Argument

- Argumenti

- umetni

- Umetna inteligenca

- AS

- sprašuje

- pomoč

- Sodelavec

- predpostavke

- At

- Samodejno

- zaveda

- bar

- temeljijo

- BE

- ker

- zadaj

- koristi

- največji

- moti

- preboj

- vendar

- by

- california

- CAN

- ne more

- Zmogljivosti

- lahko

- primeru

- primeri

- izziv

- označuje

- chatbot

- klepetalnice

- ChatGPT

- preveriti

- preverjanje

- okoliščinah

- CO

- Soavtor

- Kodiranje

- Skupno

- Pravo

- primerjate

- v primerjavi z letom

- dokončanje

- popolnoma

- kompleksna

- Skrb

- zaskrbljen

- v zvezi

- zaključuje

- pravilno

- bi

- Sodišče

- Vloga na sodišču

- Sodišča

- ustvarjajo

- ključnega pomena

- Trenutna

- Trenutno stanje

- Trenutno

- Nevarno

- Daniel

- datum

- opisano

- Razvoj

- razvija

- drugačen

- drugače

- Direktor

- do

- Dokumenti

- ne

- don

- 2

- lažje

- enostavno

- učinkovito

- opolnomočiti

- pravični

- zlasti

- Tudi

- dokazi

- izpit

- Primer

- Excel

- obstaja

- drago

- strokovno znanje

- razložiti

- soočen

- Dejstvo

- FAIL

- ponaredek

- false

- neresnic

- seznanjeni

- Zvezna

- manj

- vložena

- Vložitev

- Najdi

- podjetja

- za

- obrazec

- Obrazci

- je pokazala,

- brezplačno

- sveže

- iz

- temeljna

- ustvarjajo

- ustvarila

- generativno

- Generativna AI

- pridobivanje

- dobro

- veliko

- Trdi

- škodovalo

- Imajo

- he

- pomoč

- pomoč

- najvišja

- Iskreno

- Vendar

- HTTPS

- velika

- človeškega

- if

- ignorirati

- Pomembno

- in

- V drugi

- netočne

- Industrija

- info

- Podatki

- Namesto

- Inštitut

- Intelligence

- Internet

- Izmišljeno

- vključeni

- vprašanje

- IT

- ITS

- sam

- jpg

- pristojnost

- pristojnosti

- samo

- Justice

- Otrok

- Vedite

- znanje

- label

- jezik

- velika

- zakon

- odvetniška podjetja

- Zakoni

- tožbe

- odvetnik

- odvetniki

- vodi

- vodi

- naučili

- vsaj

- Led

- Pravne informacije

- sodni postopek

- manj

- življenska doba

- kot

- Verjeten

- LIMIT

- Omejitev

- Limited

- linije

- Seznam

- Litigation

- Llama

- si

- nižje

- Znamka

- IZDELA

- Izdelava

- math

- Zadeve

- Matthew

- Maj ..

- Meta

- morda

- Model

- modeli

- Monolit

- več

- Najbolj

- veliko

- Ime

- Nimate

- potrebe

- Novo

- NY

- Najnovejši

- nič

- of

- pogosto

- Staro

- najstarejši

- on

- tiste

- OpenAI

- Komentarji

- nasprotuje

- or

- Ostalo

- rezultatov

- več

- par

- Papir

- dokumentacijo

- zlasti

- zlasti

- Podaje

- Peak

- ljudje

- odstotkov

- performance

- perspektive

- Dr.

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Popular

- močan

- Pooblastila

- prej

- problem

- Težave

- Postopki

- obravnavati

- proizvodnjo

- strokovni

- ugledni

- Dokaži

- javno

- objavljeno

- zasledovati

- vprašanje

- Cene

- Preberi

- pravo

- Reality

- res

- Razlog

- priklic

- nedavno

- glejte

- povezane

- sprosti

- pomembno

- odvisnost

- predstavljajo

- Raziskave

- raziskovalci

- viri

- oziroma

- Odzove

- odgovorov

- povzroči

- Rezultati

- tveganja

- Pravilo

- s

- pravi

- glej

- Seek

- videl

- Občutek

- nastavite

- nastavitev

- več

- Kratke Hlače

- shouldnt

- je pokazala,

- pokazale

- Razstave

- strani

- Enostavno

- saj

- spretnost

- manj

- nekaj

- Nekaj

- Kmalu

- zvok

- Stanford

- Univerza Stanford

- Država

- Države

- Še vedno

- korakov

- Boj

- študent

- študija

- taka

- Predlaga

- podpora

- Vrhovno

- Vrhovno sodišče

- sistem

- sistemi

- miza

- Naloga

- Naloge

- skupina

- Tehnologija

- tehnologije

- pove

- pove

- nagiba

- Testiran

- besedilo

- kot

- da

- O

- zakon

- svet

- njihove

- Njih

- sami

- Tukaj.

- te

- jih

- mislim

- ta

- tisti,

- 3

- čas

- do

- tudi

- vrh

- usposobljeni

- usposabljanje

- Trends

- Vrste

- razumeli

- Velika

- Združene države Amerike

- univerza

- neupravičeno

- naprej

- us

- Uporabniki

- uporabo

- navadno

- različnih

- Ve

- različica

- zelo

- Warren

- je

- način..

- we

- dobro znana

- so bili

- Kaj

- Kaj je

- kdaj

- ali

- ki

- medtem

- WHO

- bo

- z

- Zmagali

- svet

- slabše

- bi

- Napačen

- leto

- let

- york

- Vi

- Vaša rutina za

- zefirnet