Medtem ko svet hiti z uporabo najnovejšega vala tehnologij umetne inteligence, je en kos visokotehnološke strojne opreme postal presenetljivo vroča dobrina: grafična procesna enota ali GPE.

Vrhunski grafični procesor se lahko prodaja za več deset tisoč dolarjev, in vodilni proizvajalec Nvidia je videl njegovo tržno vrednotenje presegli 2 bilijona dolarjev saj povpraševanje po njegovih izdelkih narašča.

Tudi grafični procesorji niso samo vrhunski izdelki z umetno inteligenco. V telefonih, prenosnih računalnikih in igralnih konzolah so tudi manj zmogljivi grafični procesorji.

Zdaj se verjetno sprašujete: Kaj je pravzaprav GPU? In kaj jih dela tako posebne?

Kaj je GPU?

GPU-ji so bili prvotno zasnovani predvsem za hitro ustvarjanje in prikaz kompleksnih 3D-prizorov in predmetov, kot so tisti, ki so vključeni v video igre in računalniško podprto oblikovanje programsko opremo. Sodobni grafični procesorji obravnavajo tudi naloge, kot so dekompresijo video tokovi.

»Možgani« večine računalnikov so čipi, imenovani centralna procesna enota (CPE). CPU-je je mogoče uporabiti za ustvarjanje grafičnih prizorov in dekompresijo videoposnetkov, vendar so pri teh nalogah običajno veliko počasnejši in manj učinkoviti v primerjavi z GPE-ji. CPU-ji so bolj primerni za splošna računalniška opravila, kot sta obdelava besedil in brskanje po spletnih straneh.

Kako se grafični procesorji razlikujejo od procesorjev?

Tipičen sodoben CPE je sestavljen iz med 8 in 16"jedra”, od katerih lahko vsak obdela zapletene naloge na zaporedni način.

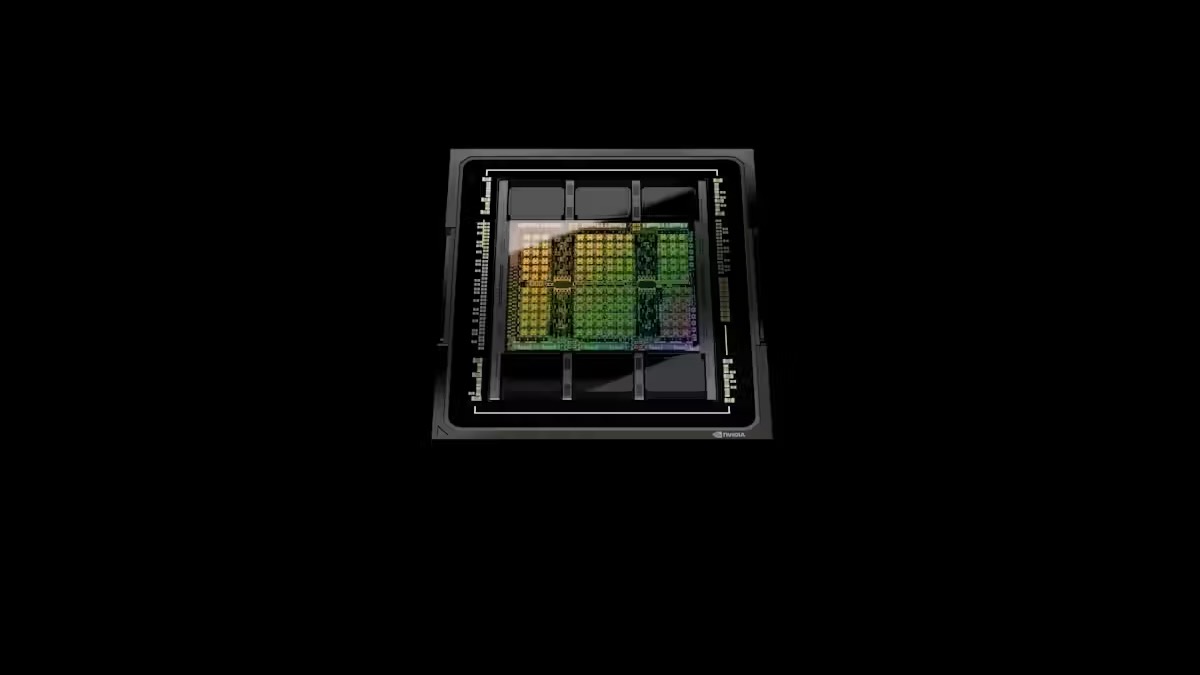

GPE-ji imajo na drugi strani na tisoče sorazmerno majhnih jeder, ki so zasnovana tako, da vsa delujejo hkrati (»vzporedno«), da dosežejo hitro splošno obdelavo. Zaradi tega so zelo primerni za naloge, ki zahtevajo veliko število preprostih operacij, ki jih je mogoče izvajati hkrati, namesto enega za drugim.

Tradicionalni grafični procesorji so na voljo v dveh glavnih različicah.

Prvič, obstajajo samostojni čipi, ki so pogosto na voljo v dodatnih karticah za velike namizne računalnike. Drugi so grafični procesorji v kombinaciji s centralnim procesorjem v istem paketu čipov, ki jih pogosto najdemo v prenosnikih in igralnih konzolah, kot je PlayStation 5. V obeh primerih CPE nadzoruje, kaj počne grafični procesor.

Zakaj so grafični procesorji tako uporabni za AI?

Izkazalo se je, da je mogoče grafične procesorje preoblikovati za več kot samo ustvarjanje grafičnih prizorov.

Številne tehnike strojnega učenja v ozadju Umetna inteligenca, Kot je globoke nevronske mreže, se močno zanašajo na različne oblike množenja matrik.

To je matematična operacija, pri kateri se zelo veliki nizi števil pomnožijo in seštejejo. Te operacije so zelo primerne za vzporedno obdelavo, zato jih GPE lahko izvedejo zelo hitro.

Kaj je naslednje za GPU?

Zmogljivost grafičnih procesorjev za drobljenje števila se vztrajno povečuje zaradi povečanja števila jeder in njihovih hitrosti delovanja. Te izboljšave so predvsem posledica izboljšav v proizvodnji čipov s strani podjetij, kot je npr TSMC na Tajvanu.

Velikost posameznih tranzistorjev - osnovnih komponent katerega koli računalniškega čipa - se zmanjšuje, kar omogoča, da se več tranzistorjev postavi v enako količino fizičnega prostora.

Vendar to ni celotna zgodba. Čeprav so tradicionalni grafični procesorji uporabni za računalniške naloge, povezane z umetno inteligenco, niso optimalni.

Tako kot so bili grafični procesorji prvotno zasnovani za pospeševanje računalnikov z zagotavljanjem specializirane obdelave za grafiko, obstajajo pospeševalniki, ki so zasnovani za pospešitev nalog strojnega učenja. Te pospeševalnike pogosto imenujemo GPU podatkovnega centra.

Nekateri izmed najbolj priljubljenih pospeševalnikov, ki so jih izdelala podjetja, kot sta AMD in Nvidia, so se začeli kot tradicionalni grafični procesorji. Sčasoma so se njihove zasnove razvile za boljše obvladovanje različnih nalog strojnega učenja, na primer s podpiranjem učinkovitejšega »lebdenje možganov” format številke.

Drugi pospeševalci, kot je Googlov enote za obdelavo tenzorjev in Tenstorrent Tensix jedra, so bili zasnovani od začetka za pospešitev globokih nevronskih mrež.

Grafični procesorji podatkovnih centrov in drugi pospeševalniki umetne inteligence imajo običajno bistveno več pomnilnika kot tradicionalne dodatne kartice GPE, kar je ključnega pomena za usposabljanje velikih modelov umetne inteligence. Večji ko je model AI, bolj zmogljiv in natančen je.

Za dodatno pospešitev usposabljanja in obvladovanje še večjih modelov umetne inteligence, kot je ChatGPT, je mogoče številne grafične procesorje podatkovnega centra združiti v superračunalnik. To zahteva bolj zapleteno programsko opremo za pravilno izkoriščanje razpoložljive moči drobljenja številk. Drug pristop je, da ustvarite en sam zelo velik pospeševalnik, kot je "procesor na rezinah” produkcije Cerebras.

So specializirani čipi prihodnost?

Tudi procesorji niso mirovali. Najnovejši procesorji AMD in Intel imajo vgrajena nizkonivojska navodila, ki pospešijo drobljenje številk, ki ga zahtevajo globoke nevronske mreže. Ta dodatna funkcionalnost v glavnem pomaga pri nalogah »sklepanja«, to je pri uporabi modelov AI, ki so bili že razviti drugje.

Za usposabljanje modelov umetne inteligence so še vedno potrebni veliki GPU podobni pospeševalci.

Možno je ustvariti vedno več specializiranih pospeševalnikov za specifične algoritme strojnega učenja. Pred kratkim je na primer podjetje Groq izdelalo "enota za jezikovno obdelavo” (LPU), posebej zasnovan za izvajanje velikih jezikovnih modelov po vzoru ChatGPT.

Vendar ustvarjanje teh specializiranih procesorjev zahteva znatna inženirska sredstva. Zgodovina kaže, da uporaba in priljubljenost katerega koli danega algoritma strojnega učenja ponavadi doseže vrhunec in nato upade – zato lahko draga specializirana strojna oprema hitro zastara.

Za povprečnega potrošnika pa to verjetno ne bo problem. GPE-ji in drugi čipi v izdelkih, ki jih uporabljate, bodo verjetno tiho postajali hitrejši.

Ta članek je ponovno objavljen Pogovor pod licenco Creative Commons. Preberi Originalni članek.

Kreditno slike: Nvidia

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://singularityhub.com/2024/03/13/what-is-a-gpu-the-chips-powering-the-ai-boom-and-why-theyre-worth-trillions/

- :ima

- : je

- :ne

- :kje

- $GOR

- 16

- 3d

- 8

- a

- pospeši

- pospeševalniki

- natančna

- Doseči

- Add-on

- Dodatne

- po

- AI

- AI modeli

- algoritem

- algoritmi

- vsi

- Dovoli

- skupaj

- že

- Prav tako

- AMD

- znesek

- in

- Še ena

- kaj

- pristop

- SE

- članek

- AS

- At

- Na voljo

- povprečno

- Osnovni

- BE

- postanejo

- bilo

- zadaj

- Boljše

- med

- boom

- tako

- Brskanje

- vgrajeno

- vendar

- by

- se imenuje

- CAN

- lahko

- Kartice

- primeri

- center

- Osrednji

- ChatGPT

- čip

- čipi

- COM

- kombinirani

- kako

- blago

- Commons

- Podjetja

- podjetje

- v primerjavi z letom

- kompleksna

- deli

- računanje

- računalnik

- računalniki

- velika

- konzole

- Potrošnik

- Nadzor

- ustvarjajo

- Ustvarjanje

- Creative

- kredit

- ključnega pomena

- datum

- Podatkovno središče

- globoko

- Povpraševanje

- zasnovan

- modeli

- desktop

- razvili

- drugačen

- zaslon

- do

- ne

- opravljeno

- vozi

- 2

- vsak

- učinkovite

- bodisi

- drugje

- Inženiring

- Celotna

- Tudi

- VEDNO

- razvil

- Primer

- drago

- daleč

- FAST

- hitreje

- prva

- za

- obrazec

- format

- Obrazci

- je pokazala,

- iz

- funkcionalnost

- nadalje

- Prihodnost

- igra

- Games

- igre na srečo

- splošno

- ustvarjajo

- pridobivanje

- dana

- Googlova

- GPU

- Grafične kartice

- grafika

- Igrišče

- strani

- ročaj

- strojna oprema

- plezalni pas

- Imajo

- močno

- Pomaga

- zato

- High-End

- zgodovina

- HOT

- Vendar

- HTTPS

- Izboljšave

- in

- narašča

- individualna

- Navodila

- Intel

- vključeni

- IT

- ITS

- jpeg

- samo

- Imejte

- jezik

- prenosniki

- velika

- večja

- Zadnji

- vodi

- učenje

- manj

- Licenca

- Verjeten

- linije

- stroj

- strojno učenje

- je

- Glavne

- v glavnem

- Znamka

- IZDELA

- Način

- Proizvajalec

- proizvodnja

- več

- Tržna

- matematični

- Matrix

- Maj ..

- Spomin

- Model

- modeli

- sodobna

- več

- učinkovitejše

- Najbolj

- Najbolj popularni

- pomnoži

- potrebna

- omrežij

- Živčne

- nevronske mreže

- Naslednja

- zdaj

- Številka

- številke

- Nvidia

- predmeti

- of

- pogosto

- on

- ONE

- deluje

- Delovanje

- operacije

- optimalna

- or

- originalno

- Ostalo

- ven

- zastarel

- več

- Splošni

- paket

- strani

- vzporedno

- preteklosti

- Peak

- opravljeno

- telefoni

- fizično

- kos

- Kraj

- platon

- Platonova podatkovna inteligenca

- PlatoData

- playstation

- PlayStation 5

- Popular

- Priljubljenost

- mogoče

- moč

- močan

- Napajanje

- v prvi vrsti

- verjetno

- problem

- Postopek

- obravnavati

- procesorji

- Proizvedeno

- Izdelki

- pravilno

- zagotavljanje

- hrabrost

- hitro

- tiho

- precej

- Preberi

- res

- nedavno

- Pred kratkim

- besedilu

- relativno

- zanašajo

- zahteva

- obvezna

- zahteva

- viri

- Reuters

- Rise

- tek

- Enako

- prizori

- drugi

- videl

- prodaja

- Kompleti

- Razstave

- bistveno

- Enostavno

- sam

- Velikosti

- majhna

- So

- Software

- Vesolje

- posebna

- specializirani

- specifična

- posebej

- hitrost

- hitrosti

- samostojna

- stoječa

- začel

- vztrajno

- Še vedno

- Zgodba

- tokovi

- taka

- primerna

- povzeto

- superračunalnik

- Podpora

- Napetosti

- Presenetljivo

- Tajvan

- meni

- Naloge

- tehnike

- Tehnologije

- težava

- kot

- da

- O

- Prihodnost

- svet

- njihove

- Njih

- POTEM

- Tukaj.

- te

- jih

- ta

- tisti,

- tisoče

- čas

- do

- skupaj

- tudi

- tradicionalna

- Vlak

- usposabljanje

- trillions

- zavoji

- dva

- tipičen

- tipično

- pod

- Enota

- malo verjetno

- Uporaba

- uporaba

- Rabljeni

- koristno

- uporabo

- Vrednotenje

- različnih

- zelo

- Video

- video igre

- Video posnetki

- Wave

- web

- so bili

- Kaj

- Kaj je

- ki

- medtem

- zakaj

- Wikipedia

- z

- spraševati

- beseda

- delo

- svet

- vredno

- Vi

- zefirnet