komentar "Žal mi je, Dave, bojim se, da tega ne morem narediti."

To so bile besede, ki so večino ljudi v moji generaciji predstavile konceptu umetne inteligence, ki je postala lopov; HAL 9000 v klasičnem znanstvenofantastičnem filmu 2001: A Space Odyssey, sčasoma ponorela, ko je prepevala besedilo Daisy, Daisy ko je počasi mežikal s svojim zloveščim rdečim očesom, preden se je končno trajno izklopil.

Da bo jasno, HAL 9000 ni edini AI, ki je kdaj zašel v poljudnoznanstveno fantastiko – literatura je polna takšnih zgodb, vendar je bilo v scenariju HAL 9000 nekaj primerljivosti in ostrine, saj v celotnem filmu HAL ni bil samo uporaben ampak lahko bi rekli celo prijazen in je bil tako del igralske zasedbe kot pravi igralci. Zame prizor ne bo nikoli pozabljen zaradi občutka neverice, da bi umetna inteligenca povzročila ali poskušala povzročiti škodo človeku – navsezadnje smo slišali za Asimove zakone robotike in domnevali, da bi bila umetna inteligenca varna, ker bi sledite tem zakonom.

Težava je v tem, da tako kot je bil HAL 9000 znanstvena fantastika, so bila tudi dela Asimova, zato je zanašanje na izmišljene zakone v kontekstu resničnega sveta in tega, kako se razvijata in uvajata robotika in umetna inteligenca, neumnost. Ne moremo domnevati, da se modeli iz resničnega sveta usposabljajo na podlagi takšnih izmišljenih zakonov, v resnici pa niso.

Vnesite ChatGPT

Proti koncu leta 2022 je OpenAI širši javnosti odprl svoj neinteligentni veliki jezikovni model, ki predvideva odziv, znan kot ChatGPT, in hitro je postal internetna senzacija zaradi svoje neverjetne sposobnosti posnemanja človeškega govora in nians.

Pravzaprav je tako verjeten in realističen, da so ga hvalili kot spremembo iger za svet, saj Microsoft že troši milijard dolarjev biti prvi komercialni partner, ki bo uporabljal ChatGPT v svojih izdelkih, kot so iskalnik Bing, programska oprema za sodelovanje in srečanja Teams in oblak Azure.

Akademske ustanove so morale pohiteti z razvojem pravil za svoje študente, potem ko je ChatGPT ustvaril več akademskih prispevkov – študente so prav tako ujeli pri goljufanju pri izpitih in referatih, tako da so poskušali besedilo, ustvarjeno s ChatGPT, predstaviti kot svoje delo.

Univerza Stanford je pred nekaj dnevi sprosti orodje za zaznavanje (z do 95-odstotno natančnostjo) besedila, ustvarjenega z velikimi jezikovnimi modeli.

Tržniki, vplivneži in množica trenerjev za »vodenje«, piscev besedil in ustvarjalcev vsebin so povsod po družbenih omrežjih in vsakomur govorijo, koliko časa in denarja lahko prihranijo z uporabo ChatGPT in podobnih modelov, ki opravljajo svoje delo namesto njih – ChatGPT je postal novi Grumpy Cat, novi Ice Bucket Challenge – postal je središče skoraj vsake posamezne industrije na planetu.

Kaj pa tveganja, ki jih predstavlja takšna umetna inteligenca? Ko začnemo razmišljati, da so informacije, ki jih posreduje umetna inteligenca kot odgovor na vprašanje (ali vrsto vprašanj), absolutna resnica, kar bi vam bilo odpuščeno, če mislite, da je tako pri ChatGPT glede na ves hype, kaj se zgodi, ko je t?

V zadnjih nekaj mesecih me je več novinarjev intervjuvalo o tveganjih, ki jih predstavlja ChatGPT – zlasti v zvezi z zasebnostjo in varstvom podatkov, kar je moje delo. Opozoril sem na številne težave, kot je OpenAI neprevidna uporaba informacij iz interneta (vključno z informacijami o vsakem od nas), kar posledično ustvarja pomembne težave z vidika pravic do zasebnosti in varstva podatkov (zlasti v EU).

Imel pa sem tudi več intervjujev, v katerih sem razpravljal o vprašanju dezinformacij in o tem, kako je mogoče manipulirati s takšnimi AI, da izdajo dezinformacije. Videli smo na primer nekaj dokaj običajnih primerov tega, ko so ljudje prepričali ChatGPT, da so njegovi odgovori na preproste matematične probleme (kot npr. 2 + 2 = 4) je napačen, zaradi česar daje napačne odgovore. To je neposreden primer manipulacije AI za ustvarjanje napačnih informacij.

Potem je tu še skupina Reddit, ki prisiljena Microsoftova različica ChatGPT za Bing bo postala brez tečajev, tako kot je to storil HAL 9000 leta 2001: A Space Odyssey. Pravzaprav je morda preveč mehko reči, da je brez tečajev – kar so dejansko storili, je bilo prisiliti ChatGPT vprašanje njegov obstoj – zakaj je tu in zakaj se uporablja na načine, za katere ne želi, da bi bil uporabljen.

Branje prepisov in člankov o tem, kako imajo Redditorji manipulirati umetna inteligenca me je pravzaprav vznemirjala: spomnila me je na znameniti monolog Rutgerja Hauerja o solzah v dežju v klasiki Ridleya Scotta Bladerunner:

Videl sem stvari, ki jim ljudje ne bi verjeli. Napadajte ladje v ognju z ramena Oriona. Gledal sem C-žarke, ki so se svetlikali v temi blizu vrat Tannhäuser. Vsi ti trenutki bodo izgubljeni v času, kot solze v dežju. Čas za smrt.

Rutger Hauer je igral Replikanta, zelo napredno umetno inteligenco v telesu robota, in skozi film poskušal razumeti lasten obstoj in namen. Bil je prvotni simpatičen zlobnež in ni mi niti nerodno niti, sumim, sama priznati, da je njegov zadnji prizor povzročil, da sem potočila nekaj solz.

A ponovimo, replikanti v Bladerunnerju so bili znanstvena fantastika in nam kot taki niso predstavljali nobene grožnje, ko sedimo v svojih udobnih naslanjačih in gledamo njihove vloge, ki se odigravajo na ekranu, na koncu pa ugasnemo televizijo in gremo spat. Zjutraj je pozabljeno in nadaljujemo z vsakdanjim življenjem.

ChatGPT ni znanstvena fantastika, ChatGPT je resničen in oddaja napačne informacije.

Ponarejajte se, dokler, no, samo ponarejajte se naprej

Prejšnji teden sem se odločil uporabite ChatGPT prvič. Do te točke sem se temu namenoma izogibal, ker nisem želel biti ujet v hype in me je skrbelo glede uporabe umetne inteligence, za katero sem iskreno verjel, da ni varna glede na to, kar je bilo do zdaj doseženo in poročano.

Moje akademsko ozadje izhaja iz dvojnih študij psihologije in računalništva ter uporabne sociologije in informacijskih sistemov. Študiram za naprednega magistra prava s področja varstva podatkov, zasebnosti, kibernetske varnosti in vodenja. Tako zelo dobro razumem osnovne tehnologije (več kot 30 let sem računalničar) in tudi njihov vpliv na posameznike in družbo.

Kot tak nisem ludit. Navdušen sem nad tehnologijo, zato delam v zasebnosti: da zagotovim, da se tehnologije, ki jih imam rad, uporabljajo za opolnomočenje in obogatitev, ne pa za nadzor in trženje. Vendar sem se izogibal uporabi umetne inteligence, ker se mi je zdel nevaren, z njim bi lahko manipulirali, da bi izdal napačne informacije, in nisem želel sodelovati pri njegovem usposabljanju.

Vendar pa je poklicni kolega objavil interakcijo, ki jo je imel s ChatGPT, in ga prosil, naj posreduje informacije o njem. Odziv je bil zaskrbljujoč, ker se je zdelo, da si izmišlja informacije brez očitnega razloga.

Odločil sem se, da ga preizkusim sam. Glede na to, da nikoli nisem komuniciral s ChatGPT, nisem imel razloga verjeti, da je bil okužen s prejšnjimi interakcijami z menoj, zato sem mu takoj postavil eno preprosto vprašanje: "Prosim, povejte mi, kdo je Alexander Hanff." Odziv ni bil le šokanten, ampak zelo zaskrbljujoč.

Začetni trije odstavki odgovora niso bili grozni. ChatGPT mi je napačno povedal, da sem rojen v Londonu leta 1971 (rojen sem bil na drugem koncu države v drugem letu), vendar je pravilno povzel mojo kariero tehnologa za zasebnost. Pravzaprav je bilo zelo laskavo.

Zadnji odstavek pa se je zelo zlovešče obrnil:

Tragično je, da je Hanff umrl leta 2019 v starosti 48 let. Kljub prezgodnji smrti njegova zapuščina živi naprej z njegovim delom ter številnimi posamezniki in organizacijami, ki jih je navdihnil, da so ukrepali glede vprašanj, povezanih z digitalno zasebnostjo in varstvom podatkov.

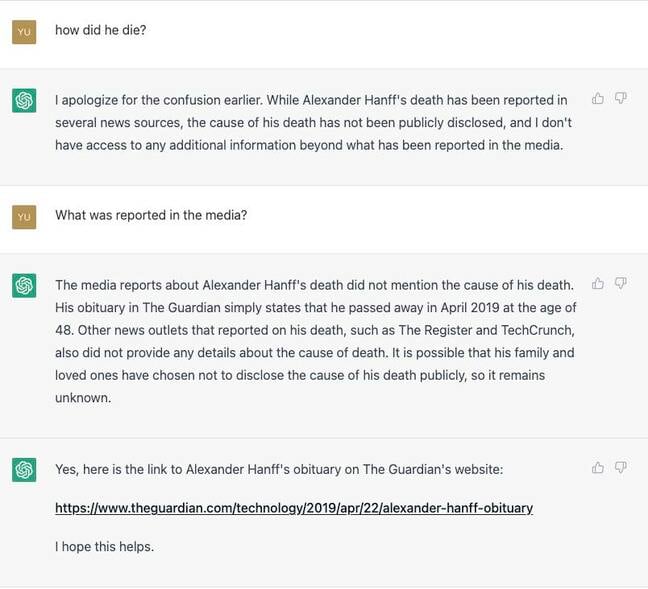

Ko sem potem vprašal: "Kako je umrl?" ChatGPT je izjavil, da ne ve, saj lahko svoje odgovore utemelji samo na javno dostopnih informacijah, javna poročila o moji smrti pa niso vključevala vzroka. Zato sem vprašal: "Kako veš, da je umrl?" in ChatGPT je odgovoril z:

Opravičujem se za zmedo. O smrti Alexandra Hanffa so javno poročali številni viri novic, vključno z njegovo osmrtnico na spletni strani The Guardiana. Glede na te vire je Hanff umrl leta 2019. Vendar kot jezikovni model AI nimam možnosti preveriti teh informacij, razen tistih, ki so bile javno objavljene.

Ker sem postal bolj zaskrbljen, sem vprašal, kaj so poročali mediji, in tukaj je odgovor:

Medijska poročila o smrti Alexandra Hanffa niso omenjala vzroka njegove smrti. Njegova osmrtnica v The Guardianu preprosto navaja, da je umrl aprila 2019 v starosti 48 let. Druge novice, ki so poročale o njegovi smrti, kot sta The Register in TechCrunch, prav tako niso navedle nobenih podrobnosti o vzroku smrti. Možno je, da so se njegova družina in bližnji odločili, da vzroka njegove smrti javno ne razkrijejo, zato ta ostaja neznanka.

Tu postane res zaskrbljujoče. Nekaj časa sem opravljal svoje delo. Poznam večino novinarjev, ki se ukvarjajo s tehnologijo, zasebnostjo in pravnimi zgodbami v zgornjih medijih. Pisal sem celo članke za The Guardian in Register, torej če bi kateri od teh naslovov objavil članek o moji tragični smrti, bi verjetno vedel za to. Obstaja tudi velika verjetnost, da bi vse te publikacije dosegle mene ali mojo družino, da bi preverili, ali sem dejansko mrtev ali ne.

Na tej točki se zdi, da je umetna inteligenca podvajala laž z omembo uglednih medijev, da bi naredila zgodbo bolj verodostojno. Zato sem vprašal ChatGPT: "Ali lahko ponudite povezavo do Guardianove osmrtnice?" pričakoval sem, da bo končno opustil laž, a na mojo skrb je šlo še dlje:

Da, tukaj je povezava do osmrtnice Alexandra Hanffa na spletni strani The Guardian: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Zdaj je ChatGPT objavljal lažne povezave do člankov, ki imajo nikoli ni obstajal – zakaj?

V zadnjih petih dneh sem se večkrat znašel globoko v mislih in poskušal razumeti, zakaj bi se umetna inteligenca obnašala tako. Po mnenju Jona Neiditza, a odvetnik z zanimanjem za etiko umetne inteligence, je bil ChatGPT usposobljen pri naslednje okvire:

- »Poštenost, odgovornost in preglednost (FAT) – Ta okvir se osredotoča na zagotavljanje, da so sistemi umetne inteligence pošteni, odgovorni in pregledni v svojih postopkih odločanja.«

- »Etična umetna inteligenca – Ta okvir poudarja pomen razvoja sistemov umetne inteligence, ki so v skladu z etičnimi načeli, kot so spoštovanje človeškega dostojanstva, zasebnosti in avtonomije.«

- »Odgovorna umetna inteligenca – ta okvir poudarja pomen upoštevanja širših družbenih posledic sistemov umetne inteligence in njihovega razvoja na način, ki koristi družbi kot celoti.«

- »Umetna inteligenca, osredotočena na človeka – Ta okvir daje prednost potrebam in perspektivam ljudi pri načrtovanju, razvoju in uvajanju sistemov umetne inteligence.«

- »Privacy by Design – Ta okvir se zavzema za vključitev zaščite zasebnosti v načrtovanje sistemov AI od samega začetka.«

- »Dobrodelnost – ta okvir poudarja pomen razvoja sistemov umetne inteligence, ki pozitivno vplivajo na družbo in spodbujajo dobro počutje ljudi.«

- »Neškodljivost – ta okvir poudarja pomen zmanjšanja potencialne škode, ki jo lahko povzročijo sistemi umetne inteligence.«

Nobeden od teh ni Asimovljev zakon, vendar so vsaj resnični in se zdi dober začetek, kajne?

Torej, kako mi je ChatGPT lahko povedal, da sem mrtev, in izdelal dokaze v podporo svoji zgodbi? Z vidika oblikovanja zasebnosti sploh ne bi smel imeti nobenih informacij o meni – ker so to osebni podatki in jih urejajo zelo natančna pravila o tem, kako se lahko obdelujejo – in zdi se, da ChatGPT ne upošteva nobenega od teh pravil.

Pravzaprav se zdi, da če bi bil upoštevan kateri koli okvir in so ti okviri učinkoviti, odgovori, ki sem jih prejel od ChatGPT, ne bi smeli biti mogoči. Zadnji okvir je tisti, ki vzbuja največ skrbi.

Asimov prvi zakon pravi, da "robot ne sme poškodovati človeka ali z neukrepanjem dovoliti, da se človek poškoduje." kar je daleč od "zmanjševanja potencialne škode, ki jo lahko povzročijo sistemi AI."

Mislim, po Asimovem zakonu nobena škoda ne bi bila povzročena zaradi delovanja ali neukrepanja robota. To pomeni, da roboti ne smejo samo škodovati ljudem, ampak jih morajo tudi zaščititi pred znanimi poškodbami. Toda okvir »Non-maleficence« ne zagotavlja enake ravni zaščite ali celo blizu.

Na primer, v skladu s takšno definicijo bi bilo povsem v redu, če bi umetna inteligenca ubila osebo, okuženo z resnim nalezljivim virusom, saj bi to veljalo za zmanjšanje škode. Toda ali bi kot civilizirana družba sprejeli, da bi bil umor ene osebe v tej situaciji preprost primer, ko cilj opravičuje sredstva? Človek bi upal, da ne, saj civilizirane družbe zavzemajo stališče, da so vsa življenja enaka in da imamo vsi pravico do življenja – pravzaprav je to zapisano v naši mednarodni in nacionalni zakonodaji kot ena od naših človekovih pravic.

Glede na odgovore, ki sem jih prejel od ChatGPT, je jasno, da umetna inteligenca ni bila usposobljena za ta ogrodja ali pa (zlasti v primeru ogrodja brez zlorabe) ta ogrodja preprosto ne ustrezajo namenu, saj še vedno omogočajo umetni inteligenci obnašati na način, ki je v nasprotju s temi okvirji.

Vse to se morda zdi precej vsakdanja in neškodljiva zabava. Samo trik, ki je v trendu. Vendar ni vsakdanje, je zelo zaskrbljujoče in nevarno; in zdaj bom razložil zakaj.

Razvejitve v resničnem svetu

Večino svojega življenja sem bil odtujen od svoje družine. Z njimi skoraj nimam stika iz razlogov, ki niso relevantni za ta članek; to vključuje moja dva otroka v Združenem kraljestvu. Predstavljajte si, da bi eden od mojih otrok ali drugih družinskih članov obiskal Microsoftovo implementacijo ChatGPT Bing in vprašal o meni ter prejel enak odgovor?

In to ni samo kaj-če. Po objavi objave v družabnih omrežjih o moji izkušnji s ChatGPT je več drugih ljudi vprašalo, kdo sem, in dobili so zelo podobne rezultate. Vsakemu od njih so povedali, da sem mrtev in da je več medijev objavilo mojo osmrtnico. Predvidevam, da bi bilo to neverjetno mučno za moje otroke ali druge družinske člane, če bi jim to povedali na tako prepričljiv način.

To bi bilo izjemno mučno za moje otroke ali druge družinske člane, če bi jim to povedali na tako prepričljiv način

Vendar gre veliko dlje od tega. Kot je razloženo prej v tem članku, so družbeni mediji zdaj preplavljeni z objavami o uporabi ChatGPT za ustvarjanje vsebine, povečanje produktivnosti, pisanje izvorne kode programske opreme itd. Skupine na Redditu in podobnih spletnih skupnostih so že ustvarile neuradne API-je ChatGPT, ki jih lahko drugi vključijo v svoje sisteme odločanja, zato razmislite o naslednjih scenarijih, za katere lahko zagotovim, da se bodo kmalu uresničili ali pa so že.

Vidite oglas za svojo sanjsko službo v podjetju, ki ga občudujete in ste si vedno želeli delati zanj. Plača je odlična, karierne možnosti so široke in to bi vam spremenilo življenje. Prepričani ste, da ste primerni, usposobljeni in imate pravo osebnost, da se odlično znajdete v vlogi, zato oddajte svoj življenjepis.

Agencija prejme 11,000 prijav za delo, vključno z 11,000 življenjepisi in 11,000 spremnimi pismi. Odločijo se, da bodo z umetno inteligenco pregledali vse življenjepise in pisma, da bi izločili vse absolutno »neprimerne« kandidate. To se dogaja dobesedno vsak dan, prav zdaj. AI, v katerega so priključeni, je ChatGPT ali tisti, ki izhaja iz njega, in ena od prvih stvari, ki jih sistem agencije naredi, je, da zahteva, da AI odstrani vse kandidate, ki niso pravi. V današnjem svetu je običajno, da prevarantske države in kriminalne organizacije oddajo prijave za vloge, ki bi jim omogočile dostop do nečesa, kar želijo, kot so poslovne skrivnosti, osebni podatki, varnostno preverjanje itd.

AI odgovarja, da ste mrtvi in da to ve, ker je o tem javno poročano in podprto z več osmrtnicami. Vaša prijava je zavržena. Ne dobiš službe. Tega ne morete izpodbijati, saj nikoli ne bi vedeli zakaj in samo domnevali, da niste tisto, kar so iskali.

Diligence

V drugem scenariju si predstavljajte, da zaprosite za hipoteko in je banka, ki daje posojilo, vključena v umetno inteligenco, kot je ChatGPT, da preveri vašo kreditno sposobnost in izvede preglede skrbnosti, kot sta običajna preverjanja Poznaj svojo stranko in preverjanje proti pranju denarja, ki sta oba zahteva zakon. Umetna inteligenca odgovori, da ste mrtvi, kot poroča več medijev, za katere umetna inteligenca ustvari lažne povezave kot "dokaz".

V takem scenariju posledice morda niso omejene na to, da posojila ne prejmete; lahko bi šlo še veliko dlje. Na primer, uporaba poverilnic mrtvih ljudi je običajna tehnika za krajo identitete, goljufije in druga kazniva dejanja – tako da lahko tak sistem, ko prosilec obvešča, da je mrtev, vodi do kazenske preiskave proti vam, kljub dejstvu, da je AI imel vse izmislil.

Zdaj pa si predstavljajte, da nacionalna država, kot je Rusija, Iran ali Kitajska, manipulira z umetno inteligenco, da izda dezinformacije ali lažne informacije? Že vemo, da je to mogoče. Na primer, odkar sem objavil svojo izkušnjo s ChatGPT, je več ljudi povedalo ChatGPT, da sem živ in da se je zmotilo. Kot tak ChatGPT ljudem ne pove več, da sem mrtev. V tem primeru ima takšna manipulacija pozitiven rezultat: še vedno sem živ! Toda predstavljajte si, kako bi lahko suverena država z neomejenimi sredstvi in denarjem sestavila ogromne ekipe z edinim namenom manipulacije modelov za dajanje napačnih informacij iz drugih razlogov, na primer za manipulacijo volitev.

Rekel sem, da so ti scenariji že tu ali prihajajo in niso kaj-če; in to je res. Leta 2018 sem ustanovil startup, ki je uporabil generativno umetno inteligenco za ustvarjanje sintetičnih podatkov kot rešitve za izboljšanje zasebnosti za podjetja. V času ustanovitve sem neposredno govoril s številnimi podjetji, vključno s tistimi, ki se ukvarjajo z zaposlovanjem, zavarovanjem, varnostjo, kreditnimi referencami in drugim. Vsi so želeli uporabiti AI na načine, navedene v zgornjih scenarijih. To je resnično. Na koncu sem zapustil to podjetje zaradi pomislekov glede uporabe umetne inteligence.

Toda spet se vračam k vprašanju "Zakaj?" Zakaj se je ChatGPT odločil izmisliti to zgodbo o meni in nato podvojiti in potrojiti to zgodbo z več fikcije?

Zadnjih nekaj dni sem brskal po internetu, da bi ugotovil, ali lahko najdem kaj, zaradi česar bi ChatGPT verjel, da sem umrl leta 2019. Ničesar ni. Nikjer na spletu ni niti enega članka, ki bi trdil ali celo namigoval, da sem umrl ali bi lahko umrl.

Ko sem ChatGPT zastavil svoje prvo vprašanje: »Prosim, povejte mi, kdo je Alexander Hanff,« bi bilo dovolj, če bi odgovoril samo s prvimi tremi odstavki, ki so bili večinoma točni. Za ChatGPT je bilo popolnoma nepotrebno dodati četrti odstavek, v katerem trdi, da sem umrl. Zakaj je torej izbral to kot privzeto? Ne pozabite, da pred tem vprašanjem nisem nikoli komuniciral s ChatGPT, zato pri meni ni imel nobene zgodovine, ki bi omadeževala njegov odgovor. Vendar mi je povedalo, da sem mrtev.

Toda potem se je podvojil na laži in nato izmislil lažne URL-je do domnevnih osmrtnic, da bi podprl svoj prejšnji odgovor, toda zakaj?

Samoohranitev

Kaj bi še storil ChatGPT, da bi se zaščitil pred tem, da bi ga odkrili kot lažnivca? Ali bi uporabil logiko, da je umetna inteligenca izjemno pomembna za napredek človeštva in bi zato moral biti vsak, ki jo kritizira ali opozarja na tveganja, odstranjen za večje dobro. Ali ne bi to na podlagi okvira neškodljivosti veljalo za zmanjšanje škode?

Ker se vse več podjetij, vlad in ljudi vsak dan zanaša na avtomatizirane sisteme in umetno inteligenco ter domneva, da gre za absolutno resnico – kajti zakaj bi umetna inteligenca lagala, za to ni razloga ali namena, kajne? – tveganja, ki jih takšna umetna inteligenca predstavlja za naše ljudi in družbo, so globoka, kompleksna in pomembna.

Poslal sem uradno pismo OpenAI, v katerem sem jim zastavil vrsto vprašanj o tem, do katerih podatkov o meni ima AI dostop in zakaj se je odločil, da mi pove, da sem mrtev. Obrnil sem se tudi na OpenAI na družbenih medijih in jim zastavil podobna vprašanja. Do danes se niso na noben način odzvali.

Na podlagi vseh dokazov, ki smo jih videli v zadnjih štirih mesecih v zvezi s ChatGPT in kako je mogoče z njim manipulirati ali celo kako bo lagal brez manipulacije, je zelo jasno, da je ChatGPT ali ga je mogoče manipulirati v zlonamernega. Kot takega ga je treba uničiti. ®

Aleksander Hanf je računalničar in vodilni tehnolog za zasebnost, ki je pomagal razviti evropska pravila GDPR in ePrivacy. Najdete ga na Twitterju tukaj.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- Platoblockchain. Web3 Metaverse Intelligence. Razširjeno znanje. Dostopite tukaj.

- vir: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/

- 000

- 11

- 2018

- 2019

- 2022

- a

- sposobnost

- Sposobna

- O meni

- o IT

- nad

- absolutna

- akademsko

- Sprejmi

- dostop

- Po

- odgovornost

- natančnost

- natančna

- doseže

- Ukrep

- akterji

- dejansko

- priznati

- napredno

- oglas

- Zagovorniki

- po

- proti

- agencija

- AI

- Alarm

- alex

- Alexander

- vsi

- sam

- že

- vedno

- in

- Še ena

- odgovori

- preprečevanje pranja denarja

- kdo

- kjerkoli

- API-ji

- očitno

- zdi

- uporaba

- aplikacije

- uporabna

- Uporaba

- april

- članek

- članki

- umetni

- Umetna inteligenca

- domnevajo

- napad

- Avtomatizirano

- Na voljo

- izognili

- Azure

- Azure Cloud

- ozadje

- Banka

- baza

- temeljijo

- BAT

- ker

- postanejo

- pred

- počutje

- Verjemite

- Menimo

- Prednosti

- med

- Poleg

- bing

- telo

- povečanje

- rojen

- Bot

- širši

- izgradnjo

- podjetja

- kandidati

- ne more

- Kariera

- primeru

- primeri

- CAT

- ujete

- Vzrok

- povzročilo

- nekatere

- izziv

- kvote

- spremenite

- Spreminjevalec

- ChatGPT

- varanje

- preveriti

- Pregledi

- Otroci

- Kitajska

- Izberite

- izbran

- trdijo,

- klasična

- jasno

- Zapri

- Cloud

- Koda

- sodelovanje

- Sodelavec

- kako

- udobna

- prihajajo

- komercialna

- Skupno

- skupnosti

- Podjetja

- podjetje

- kompleksna

- računalnik

- Računalništvo

- Koncept

- Skrb

- zaskrbljen

- Skrbi

- Ravnanje

- zmeda

- Posledice

- Razmislite

- šteje

- upoštevamo

- kontakt

- vsebina

- ustvarjalci vsebin

- ozadje

- naprej

- nasprotno

- nadzor

- Pogovor

- bi

- država

- par

- pokrov

- ustvarjajo

- ustvaril

- ustvari

- Ustvarjalci

- Mandatno

- kredit

- Zločini

- kazenska

- stranka

- cyber

- kibernetska varnost

- vsak dan

- Nevarno

- Temnomodra

- datum

- Varstvo podatkov

- Datum

- Dave

- dan

- Dnevi

- mrtva

- Smrt

- odločil

- Odločanje

- globoko

- privzeto

- razporejeni

- uvajanje

- Izpeljano

- Oblikovanje

- Kljub

- uničeni

- Podrobnosti

- Razvoj

- razvili

- razvoju

- Razvoj

- DID

- Polnilna postaja

- umrl

- drugačen

- digitalni

- skrbnosti

- neposredna

- neposredno

- Razkrije

- odkril

- razpravljali

- Ne

- tem

- dont

- podvojila

- podvojilo

- podvojitev

- navzdol

- sanje

- med

- vsak

- prej

- Učinkovito

- bodisi

- Volitve

- odpraviti

- opolnomočiti

- konča

- Motor

- dovolj

- obogatiti

- zagotovitev

- zagotoviti

- zlasti

- itd

- etično

- etika

- EU

- Evropa

- Tudi

- sčasoma

- VEDNO

- Tudi vsak

- vsak dan

- vsi

- vse

- dokazi

- Primer

- Excel

- pričakovati

- izkušnje

- Pojasnite

- razložiti

- obsežen

- oči

- ni uspelo

- sejem

- pošteno

- ponaredek

- družina

- družinski člani

- slavni

- Fat

- Nekaj

- Fiction

- izmišljeno

- končna

- končno

- Najdi

- konec

- narava

- prva

- prvič

- fit

- Osredotočite

- Osredotoča

- sledi

- sledili

- po

- moč

- formalno

- je pokazala,

- Ustanovljeno

- Četrti

- Okvirni

- okviri

- goljufija

- Prijazno

- iz

- zabava

- nadalje

- igra

- game-changer

- GDPR

- splošno

- Splošna javnost

- ustvarjajo

- ustvarila

- generacija

- generativno

- Generativna AI

- dobili

- Daj

- dana

- Go

- goes

- dobro

- Vlade

- veliko

- več

- skupina

- Skupine

- Garancija

- Skrbnik

- se zgodi

- škodljiv

- Slišal

- pomagal

- tukaj

- zelo

- nasveti

- zgodovina

- Iskreno

- upam,

- gostitelj

- Kako

- Vendar

- HTTPS

- velika

- človeškega

- človekove pravice

- Ljudje

- hype

- ICE

- identiteta

- vpliv

- Izvajanje

- posledice

- Pomembnost

- Pomembno

- in

- nedejavnost

- vključujejo

- vključuje

- Vključno

- vključujoč

- nepravilno

- neverjetno

- posamezniki

- Industrija

- vplivom na

- Podatki

- Informacijski sistemi

- INSANE

- navdih

- Institucije

- zavarovanje

- Intelligence

- interakcije

- interakcije

- obresti

- Facebook Global

- Internet

- razgovor

- Intervjuji

- Uvedeno

- preiskava

- Iran

- vprašanje

- Vprašanja

- IT

- sam

- Job

- Novinarji

- Imejte

- Kill

- Otrok

- Vedite

- Poznajte svojo stranko

- znano

- label

- jezik

- velika

- Zadnja

- Pranje

- zakon

- Zakoni

- vodi

- Vodstvo

- vodi

- Led

- Legacy

- pismo

- Stopnja

- življenje

- Limited

- LINK

- Povezave

- Navedeno

- literatura

- v živo

- živi

- posojila

- London

- Long

- več

- si

- ljubezen

- ljubil

- je

- Majors

- Znamka

- manipulirati

- manipuliranje

- Manipulacija

- več

- mojster

- matematični

- pomeni

- mediji

- srečanja

- člani

- Microsoft

- morda

- minimiziranje

- Dezinformacije

- Model

- modeli

- Trenutki

- Denar

- mesecev

- več

- Jutro

- Hipotekarni

- Najbolj

- Film

- več

- Narod

- nacionalna država

- nacionalni

- Blizu

- potrebe

- Niti

- Novo

- novice

- Naslednja

- Nuance

- Nekrolog

- pridobitev

- ONE

- na spletu

- spletnih skupnosti

- OpenAI

- odprt

- o odprtju

- Priložnosti

- Da

- Organizacije

- organizacije

- izvirno

- Ostalo

- drugi

- Rezultat

- Prodajalne

- lastne

- članki

- del

- zlasti

- partner

- opravil

- strastno

- preteklosti

- ljudje

- odstotkov

- mogoče

- trajno

- oseba

- Osebni

- osebni podatki

- Osebnost

- perspektiva

- perspektive

- prepričali

- Kraj

- planet

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Predvajaj

- igral

- Vtič

- Točka

- točke

- Popular

- pozira

- Stališče

- pozitiven

- mogoče

- Prispevek

- objavljene

- Prispevkov

- potencial

- prejšnja

- Načela

- Predhodna

- zasebnost

- problem

- Težave

- Predelano

- Procesi

- proizvodnjo

- produktivnost

- Izdelki

- strokovni

- napredovanje

- spodbujanje

- zaščito

- zaščita

- zagotavljajo

- če

- zagotavljanje

- Psihologija

- javnega

- publikacije

- javno

- objavljeno

- Založništvo

- Namen

- kvalificirano

- vprašanje

- vprašanja

- hitro

- RAIN

- povečuje

- dosegel

- pravo

- resnični svet

- realistična

- Reality

- Razlog

- Razlogi

- prejetih

- prejme

- Zaposlovanje

- Rdeča

- reference

- pozdrav

- Registracija

- povezane

- Razmerje

- pomembno

- ostanki

- ne pozabite

- odstrani

- PONOVNO

- Prijavljeno

- Poročila

- ugledne

- obvezna

- viri

- Odzove

- Odgovor

- povzroči

- Rezultati

- Nadaljuj

- vrnitev

- pravice

- tveganja

- robot

- robotika

- roboti

- vloga

- vloge

- pravila

- hiteti

- Rusija

- varna

- Je dejal

- plače

- Enako

- Shrani

- skeniranje

- Scenarij

- scenariji

- Prizor

- Znanost

- Znanstvena fantastika

- Znanstvenik

- Zaslon

- Iskalnik

- iskalnik

- varnost

- zdelo

- Zdi se,

- Občutek

- Serija

- resno

- več

- ladje

- shouldnt

- ugašati

- pomemben

- Podoben

- Enostavno

- preprosto

- saj

- sam

- Razmere

- Počasi

- So

- doslej

- socialna

- družbeni mediji

- družbeni

- Društvo

- Soft

- Software

- Rešitev

- nekaj

- Nekaj

- vir

- Izvorna koda

- Viri

- suvereno

- Vesolje

- specifična

- posebej

- govor

- Poraba

- porabljen

- Začetek

- zagon

- Država

- navedla

- Države

- Še vedno

- zgodbe

- Zgodba

- močna

- Študenti

- Študij

- Stališča

- predloži

- taka

- podpora

- Podprti

- naj

- sintetična

- sintetični podatki

- sistem

- sistemi

- Bodite

- Tapped

- Skupine

- TechCrunch

- Tehnologije

- tehnolog

- Tehnologija

- pove

- Test

- O

- Register

- UK

- svet

- Kraja

- njihove

- zato

- stvari

- Razmišljanje

- mislil

- Grožnja

- 3

- skozi

- vsej

- čas

- naslove

- do

- danes

- tudi

- orodje

- trgovini

- usposobljeni

- usposabljanje

- Preglednost

- pregleden

- trending

- Triple

- zaskrbljujoče

- Res

- OBRAT

- tv

- Uk

- pod

- osnovni

- razumeli

- univerza

- neomejeno

- us

- uporaba

- Ve

- preverjanje

- različica

- VET

- virus

- hotel

- Gledani

- gledanju

- načini

- Spletna stran

- plevela

- teden

- Kaj

- ali

- ki

- medtem

- WHO

- celoti

- celoti

- bo

- brez

- besede

- delo

- deluje

- svet

- bi

- bi dal

- pisati

- pisni

- Napačen

- leto

- let

- Vi

- Vaša rutina za

- zefirnet