เมื่อคนส่วนใหญ่นึกถึงการใช้แมชชีนเลิร์นนิง (ML) กับข้อมูลเสียง กรณีการใช้งานที่มักจะนึกถึงคือ การถอดความหรือที่เรียกว่าคำพูดเป็นข้อความ อย่างไรก็ตาม ยังมีแอปพลิเคชันอื่นๆ ที่เป็นประโยชน์ รวมทั้งการใช้ ML เพื่อตรวจจับเสียง

การใช้ซอฟต์แวร์เพื่อตรวจจับเสียงเรียกว่า การตรวจจับเหตุการณ์เสียงและมีแอพพลิเคชั่นมากมาย ตัวอย่างเช่น สมมติว่าคุณต้องการตรวจสอบเสียงจากพื้นโรงงานที่มีเสียงดัง ฟังเสียงกริ่งเตือนที่ระบุว่าเครื่องมีปัญหา ในสภาพแวดล้อมด้านการดูแลสุขภาพ คุณสามารถใช้การตรวจจับเหตุการณ์ของเสียงเพื่อฟังเสียงจากผู้ป่วยที่บ่งบอกถึงปัญหาสุขภาพเฉียบพลันได้ ปริมาณงานของสื่อเหมาะสมสำหรับเทคนิคนี้ เช่น การตรวจจับเมื่อมีการเป่านกหวีดของผู้ตัดสินในวิดีโอกีฬา และแน่นอน คุณสามารถใช้เทคนิคนี้กับภาระงานการเฝ้าระวังที่หลากหลาย เช่น การฟังเสียงปืนหรือเสียงรถชนจากไมโครโฟนที่ติดตั้งอยู่เหนือถนนในเมือง

โพสต์นี้อธิบายวิธีการตรวจจับเสียงในไฟล์เสียง แม้ว่าจะมีเสียงพื้นหลังที่สำคัญเกิดขึ้นพร้อมกันก็ตาม ยิ่งไปกว่านั้น เราอาจใช้เทคนิคการมองเห็นด้วยคอมพิวเตอร์เพื่อทำการตรวจจับโดยใช้ ความหมายของ Amazon.

การใช้ข้อมูลเสียงกับการเรียนรู้ของเครื่อง

ขั้นตอนแรกในการตรวจจับเหตุการณ์เสียงคือการทำความเข้าใจว่าข้อมูลเสียงแสดงอย่างไร สำหรับจุดประสงค์ของโพสต์นี้ เราจัดการกับเสียงที่บันทึกไว้เท่านั้น แม้ว่าเทคนิคเหล่านี้จะใช้ได้กับการสตรีมเสียง

เสียงที่บันทึกโดยทั่วไปจะถูกจัดเก็บเป็นลำดับของตัวอย่างเสียง ซึ่งวัดความเข้มของคลื่นเสียงที่กระทบไมโครโฟนระหว่างการบันทึก เมื่อเวลาผ่านไป มีรูปแบบที่หลากหลายสำหรับการจัดเก็บตัวอย่างเหล่านี้ แต่วิธีการทั่วไปคือการจัดเก็บตัวอย่าง 10,000, 20,000 หรือแม้แต่ 40,000 ตัวอย่างต่อวินาที โดยแต่ละตัวอย่างเป็นจำนวนเต็มตั้งแต่ 0-65535 (สองไบต์) เนื่องจากแต่ละตัวอย่างวัดเฉพาะความเข้มของคลื่นเสียงในช่วงเวลาหนึ่ง ๆ โดยทั่วไปข้อมูลเสียงจะไม่เป็นประโยชน์สำหรับกระบวนการ ML เนื่องจากไม่มีคุณลักษณะที่เป็นประโยชน์ในสถานะดิบ

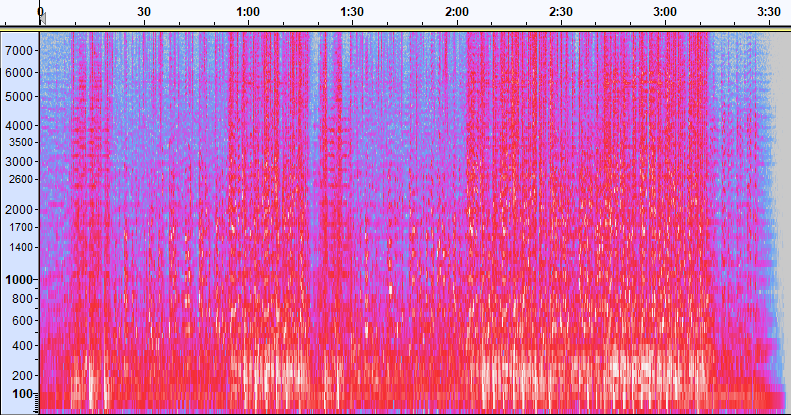

เพื่อให้ข้อมูลนั้นมีประโยชน์ ตัวอย่างเสียงจะถูกแปลงเป็นภาพที่เรียกว่า a สเปกโตรแกรมซึ่งเป็นการแสดงข้อมูลเสียงที่แสดงความเข้มของคลื่นความถี่ต่างๆ ในช่วงเวลาหนึ่ง ภาพต่อไปนี้แสดงตัวอย่าง

แกน X ของภาพนี้แทนเวลา หมายความว่าขอบซ้ายของภาพคือจุดเริ่มต้นของเสียง และขอบด้านขวาของภาพคือจุดสิ้นสุด ข้อมูลแต่ละคอลัมน์ในรูปภาพแสดงถึงแถบความถี่ที่แตกต่างกัน (ระบุด้วยมาตราส่วนทางด้านซ้ายของรูปภาพ) และสีที่แต่ละจุดแสดงถึงความเข้มของความถี่นั้นในขณะนั้น

การปรับมาตราส่วนแนวตั้งสำหรับสเปกโตรแกรมสามารถเปลี่ยนแปลงเป็นการแทนค่าอื่นได้ ตัวอย่างเช่น มาตราส่วนเชิงเส้นหมายความว่าแกน Y ถูกแบ่งเท่าๆ กันตามความถี่ มาตราส่วนลอการิทึมใช้มาตราส่วนบันทึก และอื่นๆ ปัญหาในการใช้การแสดงแทนเหล่านี้คือความถี่ในไฟล์เสียงมักจะไม่กระจายอย่างสม่ำเสมอ ดังนั้นข้อมูลส่วนใหญ่ที่เราอาจสนใจจึงถูกจัดกลุ่มไว้ใกล้กับด้านล่างของภาพ (ความถี่ที่ต่ำกว่า)

เพื่อแก้ปัญหานั้น ภาพตัวอย่างของเราคือตัวอย่างของa เมล สเปกโตรแกรมซึ่งถูกปรับขนาดให้ใกล้เคียงกับวิธีที่มนุษย์รับรู้เสียงอย่างใกล้ชิด สังเกตตัวบ่งชี้ความถี่ทางด้านซ้ายของภาพ—พวกมันให้แนวคิดว่าพวกมันถูกกระจายอย่างไรในแนวตั้ง และเป็นที่ชัดเจนว่ามันเป็นมาตราส่วนที่ไม่ใช่เชิงเส้น

นอกจากนี้ เราสามารถปรับเปลี่ยนการวัดความเข้มตามความถี่ตามเวลาเพื่อเพิ่มคุณสมบัติต่างๆ ของเสียงที่วัดได้ เช่นเดียวกับการปรับสเกลแกน Y ที่ดำเนินการโดย Mel spectrogram ฟีเจอร์อื่นๆ จะเน้นที่คุณลักษณะต่างๆ เช่น ความเข้มข้นของคลาสระดับเสียงที่โดดเด่น 12 คลาสที่ใช้เพื่อศึกษาดนตรี (chroma) อีกชั้นหนึ่งเน้นคุณลักษณะขอบฟ้า (ฮาร์โมนิก) หรือลักษณะแนวตั้ง (กระทบ) ประเภทของเสียงที่ตรวจพบควรขับเคลื่อนประเภทของสเปกโตรแกรมที่ใช้สำหรับระบบตรวจจับ

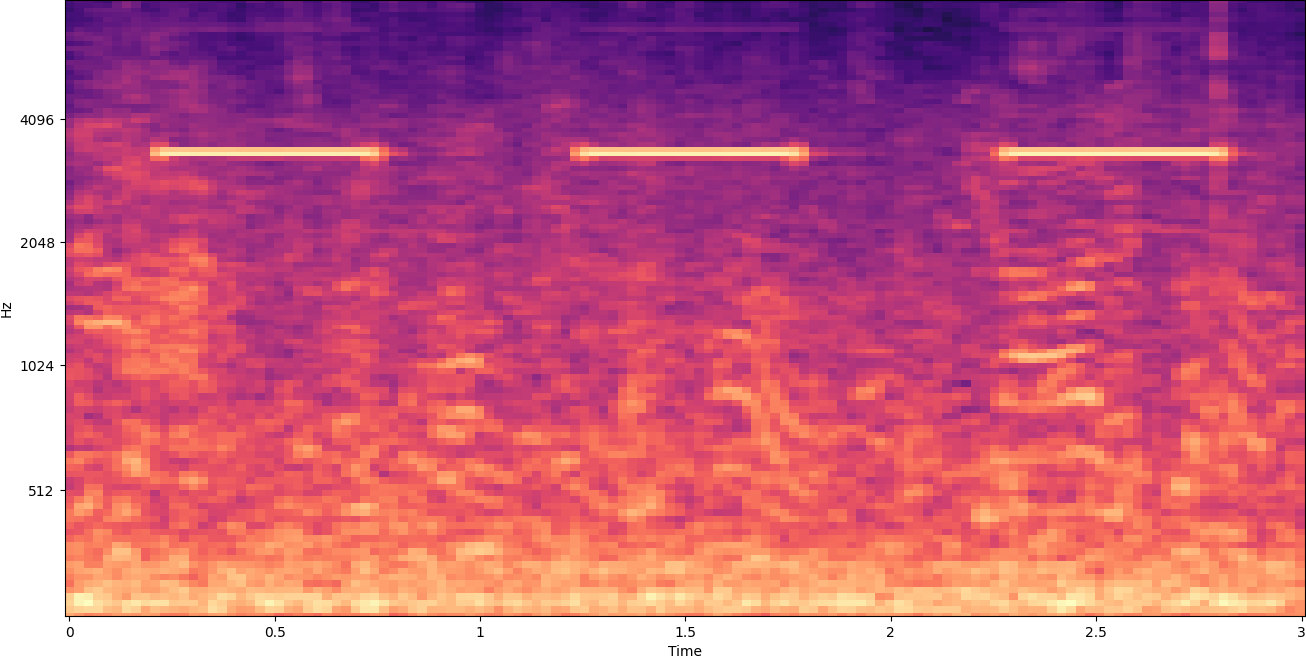

ตัวอย่างสเปกโตรแกรมก่อนหน้านี้แสดงถึงคลิปเพลงที่มีความยาวเพียง 2 นาที การซูมเข้าเผยให้เห็นรายละเอียดเพิ่มเติมดังแสดงในภาพต่อไปนี้

ตัวเลขด้านบนของภาพแสดงจำนวนวินาทีตั้งแต่เริ่มต้นไฟล์เสียง คุณสามารถเห็นลำดับของเสียงที่ดูเหมือนจะซ้ำมากกว่าสี่ครั้งต่อวินาทีได้อย่างชัดเจน โดยระบุด้วยสีสดใสบริเวณด้านล่างของภาพ

อย่างที่คุณเห็น นี่คือข้อดีอย่างหนึ่งของการแปลงเสียงเป็นสเปกโตรแกรม—เสียงที่แยกจากกันมักจะมองเห็นได้ง่ายด้วยตาเปล่า และถึงแม้จะไม่ใช่ก็ตาม แต่ก็สามารถตรวจพบได้บ่อยครั้งโดยใช้อัลกอริธึมการตรวจหาวัตถุในการมองเห็นด้วยคอมพิวเตอร์ อันที่จริง นี่คือกระบวนการที่เราปฏิบัติตามเพื่อตรวจจับเสียง

กำลังมองหาเสียงที่ไม่ต่อเนื่องในสเปกโตรแกรม

การค้นหาเสียงที่ไม่ต่อเนื่องซึ่งกินเวลาเพียงหนึ่งหรือสองวินาทีนั้นขึ้นอยู่กับความยาวของไฟล์เสียงที่เรากำลังค้นหา อ้างถึงสเปกโตรแกรมแรกที่เราแชร์ เนื่องจากเรากำลังดูข้อมูลทั้งหมด 3:30 นาที รายละเอียดที่คงอยู่เพียงวินาทีเดียวจะไม่ปรากฏให้เห็น เราซูมเข้าไปอย่างมากเพื่อดูจังหวะที่แสดงในภาพที่สอง เห็นได้ชัดว่า ด้วยไฟล์เสียงที่ใหญ่กว่า (และด้วยสเปกโตรแกรมที่ใหญ่กว่ามาก) เราพบปัญหาอย่างรวดเร็วเว้นแต่เราจะใช้วิธีอื่น แนวทางนั้นเรียกว่า หน้าต่าง.

การทำหน้าต่างหมายถึงการใช้หน้าต่างบานเลื่อนที่เคลื่อนผ่านสเปกโตรแกรมทั้งหมด โดยแยกครั้งละสองสามวินาที (หรือน้อยกว่านั้น) การแยกส่วนต่างๆ ของภาพโดยรวมซ้ำๆ ทำให้ได้ภาพขนาดเล็กที่สามารถค้นหาเสียงที่จะตรวจพบได้ เนื่องจากแต่ละหน้าต่างอาจส่งผลให้เราค้นหาเพียงบางส่วนของภาพ (เช่น ในกรณีของการค้นหาเสียงที่ไม่เริ่มต้นตรงที่จุดเริ่มต้นของหน้าต่าง) การทำหน้าต่างจึงมักทำโดยหน้าต่างที่ต่อจากนี้ไปซ้อนทับกัน ตัวอย่างเช่น หน้าต่างแรกเริ่มที่ 0:00 และขยาย 2 วินาที จากนั้นหน้าต่างที่สองจะเริ่มต้นที่ 0:01 และขยาย 2 วินาที และหน้าต่างที่สามเริ่มต้นที่ 0:02 และขยาย 2 วินาที เป็นต้น

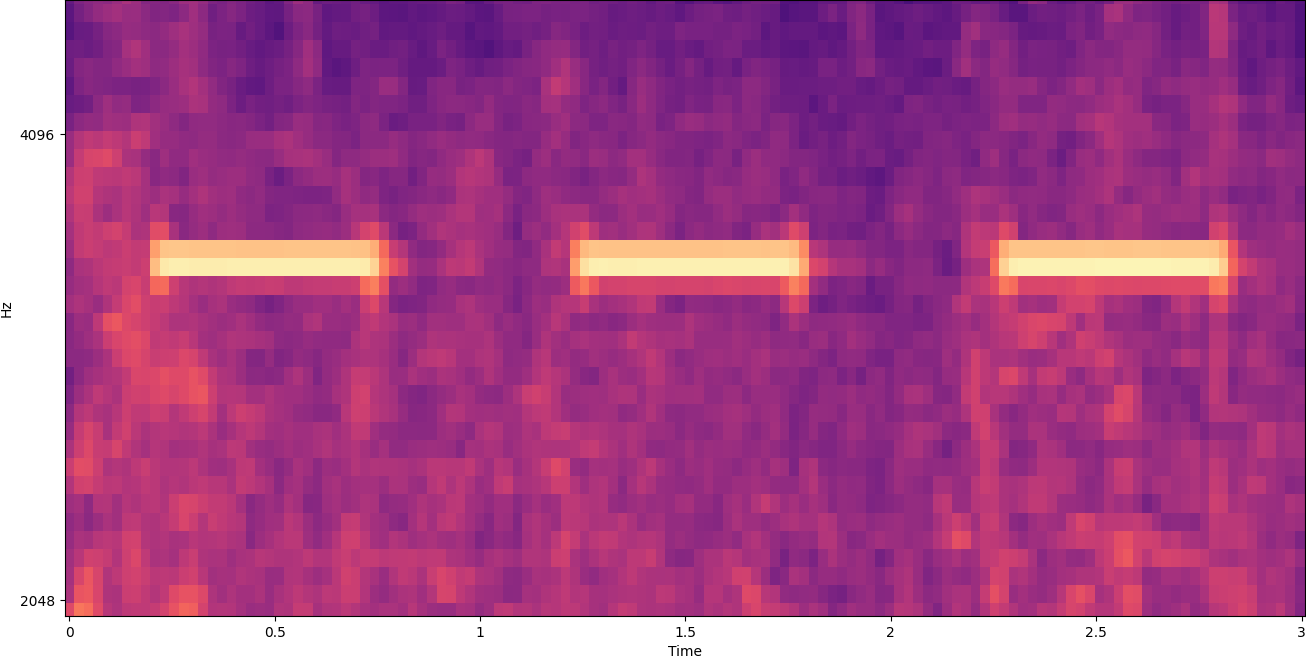

Windowing แบ่งภาพสเปกโตรแกรมในแนวนอน เราสามารถปรับปรุงประสิทธิภาพของกระบวนการตรวจจับโดยแยกแถบความถี่บางส่วนออกโดยการครอบตัดหรือค้นหาเฉพาะส่วนแนวตั้งบางส่วนของภาพ ตัวอย่างเช่น หากคุณรู้ว่าเสียงเตือนที่คุณต้องการตรวจจับสร้างเสียงที่มีช่วงความถี่จากความถี่หนึ่งไปยังอีกความถี่หนึ่ง คุณสามารถแก้ไขหน้าต่างปัจจุบันเพื่อพิจารณาเฉพาะช่วงความถี่เหล่านั้นได้ ซึ่งช่วยลดปริมาณข้อมูลที่จะจัดการได้อย่างมาก และส่งผลให้การค้นหารวดเร็วขึ้นมาก นอกจากนี้ยังช่วยปรับปรุงความแม่นยำ เนื่องจากช่วยขจัดการจับคู่ที่ผิดพลาดที่อาจเกิดขึ้นในแถบความถี่ที่อยู่นอกช่วงที่ต้องการ ภาพต่อไปนี้เปรียบเทียบแกน Y แบบเต็ม (ซ้าย) กับแกน Y ที่จำกัด (ขวา)

ตอนนี้เรารู้วิธีวนซ้ำบนสเปกโตรแกรมด้วยวิธี windowing และกรองคลื่นความถี่บางแถบแล้ว ขั้นตอนต่อไปคือการค้นหาเสียงจริง เพื่อที่เราใช้ ป้ายกำกับที่กำหนดเองของ Amazon Rekognition. คุณสมบัติ Rekognition Custom Labels สร้างขึ้นจากความสามารถที่มีอยู่ของ Amazon Rekognition ซึ่งได้รับการฝึกอบรมเกี่ยวกับรูปภาพหลายสิบล้านภาพในหลากหลายหมวดหมู่ แทนที่จะต้องอัปโหลดรูปภาพนับพัน คุณเพียงแค่อัปโหลดชุดรูปภาพการฝึกขนาดเล็ก (โดยทั่วไปแล้วจะมีรูปภาพไม่กี่ร้อยภาพ แต่ขนาดชุดข้อมูลการฝึกที่เหมาะสมควรมาถึงในการทดลองโดยอิงจากกรณีการใช้งานเฉพาะเพื่อหลีกเลี่ยงการฝึกโมเดลที่น้อยเกินไปหรือมากเกินไป ) เฉพาะสำหรับกรณีการใช้งานของคุณผ่านคอนโซล Rekognition Custom Labels

หากรูปภาพของคุณติดป้ายกำกับแล้ว การฝึกอบรม Amazon Rekognition สามารถเข้าถึงได้ด้วยการคลิกเพียงไม่กี่ครั้ง หรือคุณสามารถติดป้ายกำกับรูปภาพได้โดยตรงภายในอินเทอร์เฟซการติดป้ายกำกับ Amazon Rekognition หรือใช้ ความจริงของ Amazon SageMaker เพื่อติดป้ายกำกับให้คุณ เมื่อ Amazon Rekognition เริ่มการฝึกจากชุดรูปภาพของคุณ Amazon Rekognition จะสร้างแบบจำลองการวิเคราะห์รูปภาพแบบกำหนดเองสำหรับคุณในเวลาเพียงไม่กี่ชั่วโมง เบื้องหลัง Rekognition Custom Labels จะโหลดและตรวจสอบข้อมูลการฝึกโดยอัตโนมัติ เลือกอัลกอริธึม ML ที่เหมาะสม ฝึกโมเดล และจัดเตรียมเมตริกประสิทธิภาพของโมเดล จากนั้นคุณสามารถใช้โมเดลแบบกำหนดเองของคุณผ่านปุ่ม API ป้ายกำกับที่กำหนดเองการรับรู้ และรวมเข้ากับแอปพลิเคชันของคุณ

การรวบรวมข้อมูลการฝึกและการฝึกโมเดล Rekognition Custom Labels

ตัว Vortex Indicator ได้ถูกนำเสนอลงในนิตยสาร GitHub repo ที่เชื่อมโยงกับโพสต์นี้คุณจะพบรหัสที่แสดงวิธีการฟังเสียงสัญญาณเตือนควันที่ดังขึ้น โดยไม่คำนึงถึงเสียงพื้นหลัง ในกรณีนี้ โมเดล Rekognition Custom Labels ของเราเป็นโมเดลการจำแนกแบบไบนารี ซึ่งหมายความว่าผลลัพธ์ที่ได้คือ "ตรวจพบเสียงเตือนควันบุหรี่" หรือ "ไม่พบเสียงเตือนควันบุหรี่"

ในการสร้างแบบจำลองที่กำหนดเอง เราต้องการข้อมูลการฝึกอบรม ข้อมูลการฝึกอบรมนั้นประกอบด้วยสองประเภทหลัก: เสียงสิ่งแวดล้อม และเสียงที่คุณต้องการตรวจจับ (เช่น เสียงสัญญาณเตือนควันไฟดังขึ้น)

ข้อมูลสิ่งแวดล้อมควรแสดงถึงภูมิทัศน์เสียงที่หลากหลายซึ่งเป็นเรื่องปกติสำหรับสภาพแวดล้อมที่คุณต้องการตรวจจับเสียง ตัวอย่างเช่น หากคุณต้องการตรวจจับเสียงสัญญาณเตือนควันไฟในสภาพแวดล้อมของโรงงาน ให้เริ่มด้วยเสียงที่บันทึกในสภาพแวดล้อมโรงงานนั้นภายใต้ หลากหลายสถานการณ์ (ไม่มีเสียงเตือนควันบุหรี่แน่นอน)

เสียงที่คุณต้องการตรวจจับควรถูกแยกออกหากเป็นไปได้ หมายความว่าสิ่งที่บันทึกควรเป็นเสียงเองโดยไม่มีเสียงแวดล้อมใดๆ ตัวอย่างเช่น นั่นคือเสียงสัญญาณเตือนควันที่ดังขึ้น

หลังจากที่คุณได้รวบรวมเสียงเหล่านี้แล้ว โค้ดใน GitHub repo จะแสดงวิธีการรวมเสียงสิ่งแวดล้อมกับเสียงสัญญาณเตือนควันด้วยวิธีต่างๆ (แล้วแปลงเป็นสเปกตรัม) เพื่อสร้างภาพจำนวนหนึ่งที่แสดงถึงเสียงสิ่งแวดล้อม ทั้งแบบมีและไม่มีสัญญาณเตือนควันจะดังขึ้น รูปภาพต่อไปนี้เป็นตัวอย่างของเสียงสิ่งแวดล้อมบางส่วนที่มีเสียงสัญญาณเตือนควัน (แถบแนวนอนสว่าง) ซ้อนทับอยู่ด้านบน

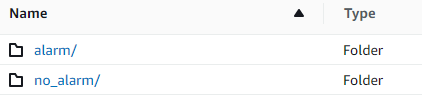

ข้อมูลการฝึกอบรมและการทดสอบถูกเก็บไว้ใน บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (Amazon S3) ถัง โครงสร้างไดเร็กทอรีต่อไปนี้เป็นจุดเริ่มต้นที่ดีในการจัดระเบียบข้อมูลภายในบัคเก็ต

โค้ดตัวอย่างใน GitHub repo ให้คุณเลือกจำนวนภาพการฝึกที่จะสร้าง Rekognition Custom Labels ไม่ต้องการอิมเมจการฝึกอบรมจำนวนมาก ชุดฝึกอบรมภาพ 200–500 ภาพควรเพียงพอ

การสร้างโปรเจ็กต์ Rekognition Custom Labels ต้องการให้คุณระบุ URI ของโฟลเดอร์ S3 ที่มีข้อมูลการฝึก และข้อมูลการทดสอบ (ทางเลือก) เมื่อระบุแหล่งข้อมูลสำหรับงานฝึกอบรม หนึ่งในตัวเลือกคือ การติดฉลากอัตโนมัติดังแสดงในภาพหน้าจอต่อไปนี้

การใช้ตัวเลือกนี้หมายความว่า Amazon Rekognition ใช้ชื่อของโฟลเดอร์เป็นชื่อป้ายกำกับ สำหรับกรณีการใช้งานการตรวจจับสัญญาณเตือนควันของเรา โครงสร้างโฟลเดอร์ภายในโฟลเดอร์รถไฟและโฟลเดอร์ทดสอบจะดูเหมือนภาพหน้าจอต่อไปนี้

ภาพข้อมูลการฝึกจะเข้าไปในโฟลเดอร์เหล่านั้น โดยมีสเปคโตรแกรมที่มีเสียงสัญญาณเตือนควันที่ส่งไปยังโฟลเดอร์สัญญาณเตือน และสเปกโตรแกรมที่ไม่มีเสียงสัญญาณเตือนควันใน no_alarm โฟลเดอร์ Amazon Rekognition ใช้ชื่อเหล่านี้เป็นชื่อคลาสเอาต์พุตสำหรับโมเดลป้ายกำกับที่กำหนดเอง

การฝึกโมเดลฉลากแบบกำหนดเองมักใช้เวลา 30–90 นาที เมื่อสิ้นสุดการฝึกนั้น คุณต้องเริ่มโมเดลที่ได้รับการฝึกเพื่อให้พร้อมใช้งาน

สถาปัตยกรรมแบบ end-to-end สำหรับการตรวจจับเสียง

หลังจากที่เราสร้างแบบจำลองของเราแล้ว ขั้นตอนต่อไปคือการตั้งค่าไปป์ไลน์การอนุมาน เพื่อให้เราสามารถใช้แบบจำลองเพื่อตรวจสอบว่ามีเสียงสัญญาณเตือนควันในไฟล์เสียงหรือไม่ ในการทำเช่นนี้ เสียงอินพุตจะต้องเปลี่ยนเป็นสเปกโตรแกรม จากนั้นจึงกรองหน้าต่างและกรองตามความถี่ เช่นเดียวกับที่ทำสำหรับกระบวนการฝึกอบรม หน้าต่างแต่ละบานของสเปกโตรแกรมถูกกำหนดให้กับโมเดล ซึ่งส่งคืนการจัดหมวดหมู่ที่ระบุว่าสัญญาณเตือนควันดังขึ้นหรือไม่

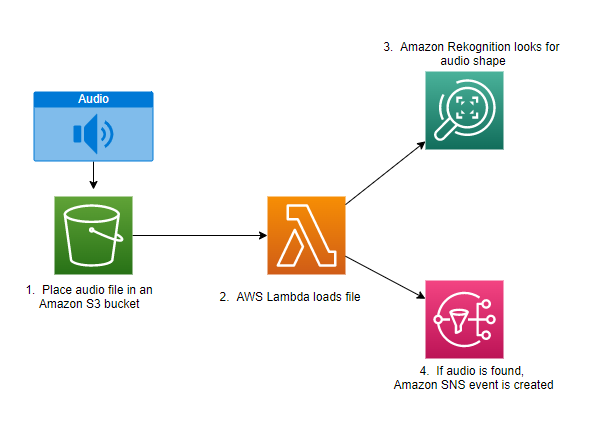

ไดอะแกรมต่อไปนี้แสดงตัวอย่างสถาปัตยกรรมที่ใช้ไปป์ไลน์การอนุมานนี้

สถาปัตยกรรมนี้รอให้ไฟล์เสียงถูกวางลงในบัคเก็ต S3 ซึ่งทำให้ AWS แลมบ์ดา ฟังก์ชั่นที่จะเรียกใช้ Lambda เป็นบริการประมวลผลแบบไร้เซิร์ฟเวอร์ที่ขับเคลื่อนด้วยเหตุการณ์ ซึ่งช่วยให้คุณเรียกใช้โค้ดสำหรับแอปพลิเคชันหรือบริการแบ็กเอนด์แทบทุกประเภทโดยไม่ต้องจัดเตรียมหรือจัดการเซิร์ฟเวอร์ คุณสามารถเรียกใช้ฟังก์ชัน Lambda จากบริการและซอฟต์แวร์ของ AWS กว่า 200 รายการในฐานะแอปพลิเคชันบริการ (SaaS) และจ่ายเฉพาะสิ่งที่คุณใช้เท่านั้น

ฟังก์ชัน Lambda รับชื่อของบัคเก็ตและชื่อของคีย์ (หรือชื่อไฟล์) ของไฟล์เสียง ไฟล์นี้ดาวน์โหลดจาก Amazon S3 ไปยังหน่วยความจำของฟังก์ชัน ซึ่งจะแปลงเป็นสเปกโตรแกรมและกรองหน้าต่างและความถี่ จากนั้นแต่ละส่วนที่มีหน้าต่างของสเปกโตรแกรมจะถูกส่งไปยัง Amazon Rekognition ซึ่งใช้โมเดล Amazon Custom Labels ที่ได้รับการฝึกอบรมมาก่อนหน้านี้เพื่อตรวจจับเสียง หากพบเสียงนั้น ฟังก์ชันแลมบ์ดาจะส่งสัญญาณว่าโดยใช้เครื่องหมาย บริการแจ้งเตือนแบบง่ายของ Amazon (Amazon SNS) การแจ้งเตือน Amazon SNS เสนอแนวทางแบบผับ/ย่อยที่สามารถส่งการแจ้งเตือนไปที่ บริการ Amazon Simple Queue คิว (Amazon SQS), ฟังก์ชันแลมบ์ดา, ตำแหน่งข้อมูล HTTPS, ที่อยู่อีเมล, การพุชบนมือถือ และอื่นๆ

สรุป

คุณสามารถใช้แมชชีนเลิร์นนิงกับข้อมูลเสียงเพื่อกำหนดว่าเสียงบางอย่างจะเกิดขึ้นเมื่อใด แม้ว่าเสียงอื่นๆ จะเกิดขึ้นพร้อมกันก็ตาม การทำเช่นนี้ต้องมีการแปลงเสียงเป็นภาพสเปกโตรแกรม จากนั้นจึงรวมเข้ากับส่วนต่างๆ ของสเปกโตรแกรมนั้นด้วยหน้าต่างและกรองตามย่านความถี่ Rekognition Custom Labels ทำให้การฝึกโมเดลแบบกำหนดเองสำหรับการตรวจจับเสียงเป็นเรื่องง่าย

คุณสามารถใช้ repo GitHub มีโค้ดตัวอย่างสำหรับโพสต์นี้เป็นจุดเริ่มต้นสำหรับการทดสอบของคุณเอง สำหรับข้อมูลเพิ่มเติมเกี่ยวกับการตรวจจับเหตุการณ์เสียง โปรดดูที่ การตรวจจับเหตุการณ์เสียง: บทช่วยสอน.

เกี่ยวกับผู้แต่ง

เกร็ก ซอมเมอร์วิลล์ เป็น Senior Prototyping Architect ในทีม AWS Prototyping and Cloud Engineering ซึ่งเขาช่วยลูกค้า AWS ใช้โซลูชันที่เป็นนวัตกรรมเพื่อแก้ไขปัญหาที่ท้าทายด้วยการเรียนรู้ของเครื่อง IoT และเทคโนโลยีไร้เซิร์ฟเวอร์ เขาอาศัยอยู่ในแอนอาร์เบอร์ รัฐมิชิแกน และชอบฝึกโยคะ ทำอาหารให้สุนัขของเขา และเล่นโป๊กเกอร์

เกร็ก ซอมเมอร์วิลล์ เป็น Senior Prototyping Architect ในทีม AWS Prototyping and Cloud Engineering ซึ่งเขาช่วยลูกค้า AWS ใช้โซลูชันที่เป็นนวัตกรรมเพื่อแก้ไขปัญหาที่ท้าทายด้วยการเรียนรู้ของเครื่อง IoT และเทคโนโลยีไร้เซิร์ฟเวอร์ เขาอาศัยอยู่ในแอนอาร์เบอร์ รัฐมิชิแกน และชอบฝึกโยคะ ทำอาหารให้สุนัขของเขา และเล่นโป๊กเกอร์

เจฟฟ์ ฮาร์แมน เป็น Senior Prototyping Architect ในทีม AWS Prototyping and Cloud Engineering ซึ่งเขาช่วยลูกค้าของ AWS ใช้โซลูชันที่เป็นนวัตกรรมเพื่อแก้ไขปัญหาที่ท้าทาย เขาอาศัยอยู่ในยูเนียนวิลล์ คอนเนตทิคัต และชอบงานไม้ ช่างตีเหล็ก และมายคราฟ

เจฟฟ์ ฮาร์แมน เป็น Senior Prototyping Architect ในทีม AWS Prototyping and Cloud Engineering ซึ่งเขาช่วยลูกค้าของ AWS ใช้โซลูชันที่เป็นนวัตกรรมเพื่อแก้ไขปัญหาที่ท้าทาย เขาอาศัยอยู่ในยูเนียนวิลล์ คอนเนตทิคัต และชอบงานไม้ ช่างตีเหล็ก และมายคราฟ

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- ความหมายของ Amazon

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- AWS Machine Learning AWS

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- ขนาดไอ

- วากยสัมพันธ์

- ลมทะเล