วันนี้เรารู้สึกตื่นเต้นที่จะประกาศความสามารถในการปรับแต่งโมเดล Code Llama โดยใช้ Meta Amazon SageMaker JumpStart. กลุ่ม Code Llama ของโมเดลภาษาขนาดใหญ่ (LLM) คือคอลเลกชันของโมเดลการสร้างโค้ดที่ได้รับการฝึกอบรมล่วงหน้าและปรับแต่งอย่างละเอียด โดยมีขนาดตั้งแต่ 7 พันล้านถึง 70 พันล้านพารามิเตอร์ โมเดล Code Llama ที่ได้รับการปรับแต่งอย่างละเอียดจะให้ความแม่นยำและความสามารถในการอธิบายที่ดีกว่าโมเดล Code Llama พื้นฐาน ดังที่เห็นได้จากการทดสอบกับ มนุษย์อีวาล และชุดข้อมูล MBPP คุณสามารถปรับแต่งและปรับใช้โมเดล Code Llama ด้วย SageMaker JumpStart ได้โดยใช้ สตูดิโอ Amazon SageMaker UI เพียงไม่กี่คลิกหรือใช้ SageMaker Python SDK การปรับแต่งโมเดลลามะอย่างละเอียดนั้นขึ้นอยู่กับสคริปต์ที่ให้ไว้ใน repo ของ llama-repo GitHub จาก Meta โดยใช้เทคนิคการหาปริมาณ PyTorch FSDP, PEFT/LoRA และ Int8

ในโพสต์นี้ เราจะอธิบายวิธีปรับแต่งโมเดลที่ได้รับการฝึกล่วงหน้าของ Code Llama ผ่าน SageMaker JumpStart ผ่านประสบการณ์ UI และ SDK แบบคลิกเดียวที่มีให้ใช้งานต่อไปนี้ พื้นที่เก็บข้อมูล GitHub.

SageMaker JumpStart คืออะไร

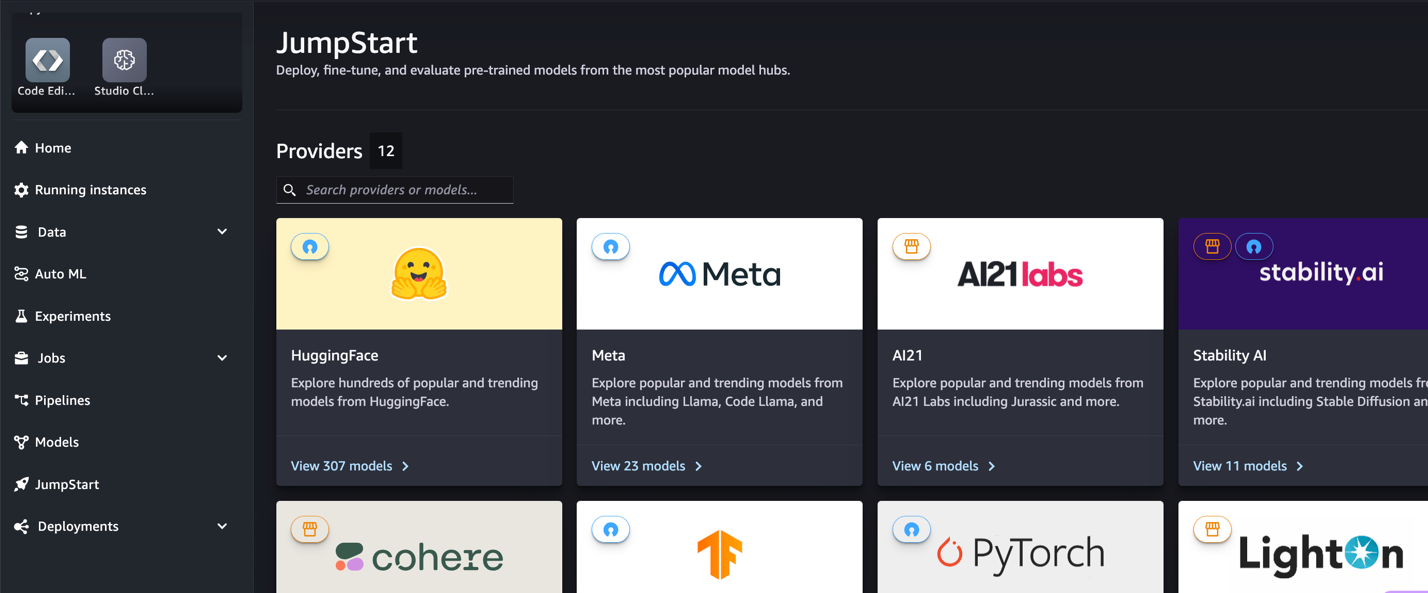

ด้วย SageMaker JumpStart ผู้ปฏิบัติงานแมชชีนเลิร์นนิง (ML) จะสามารถเลือกจากโมเดลพื้นฐานที่เปิดเผยต่อสาธารณะได้หลากหลาย ผู้ปฏิบัติงาน ML สามารถปรับใช้โมเดลพื้นฐานเพื่อการใช้งานเฉพาะได้ อเมซอน SageMaker อินสแตนซ์จากสภาพแวดล้อมแบบแยกเครือข่ายและปรับแต่งโมเดลโดยใช้ SageMaker สำหรับการฝึกโมเดลและการปรับใช้

รหัสลามะคืออะไร

Code Llama เป็นเวอร์ชันเฉพาะของโค้ด ลามะ 2 ที่สร้างขึ้นโดยการฝึกอบรม Llama 2 เพิ่มเติมเกี่ยวกับชุดข้อมูลเฉพาะโค้ดและสุ่มตัวอย่างข้อมูลจากชุดข้อมูลเดียวกันนั้นให้นานขึ้น Code Llama มีความสามารถในการเขียนโค้ดที่ได้รับการปรับปรุง สามารถสร้างโค้ดและภาษาธรรมชาติเกี่ยวกับโค้ดได้จากทั้งโค้ดและภาษาธรรมชาติพร้อมท์ (เช่น "เขียนฟังก์ชันที่ส่งออกลำดับฟีโบนักชีให้ฉัน") คุณยังสามารถใช้มันเพื่อเติมโค้ดให้สมบูรณ์และแก้ไขจุดบกพร่องได้ รองรับภาษาการเขียนโปรแกรมยอดนิยมมากมายที่ใช้ในปัจจุบัน รวมถึง Python, C++, Java, PHP, Typescript (JavaScript), C#, Bash และอื่นๆ

ทำไมต้องปรับแต่งโมเดล Code Llama

Meta เผยแพร่เกณฑ์มาตรฐานประสิทธิภาพของ Code Llama HumanEval และ MBPP สำหรับภาษาการเขียนโค้ดทั่วไป เช่น Python, Java และ JavaScript ประสิทธิภาพของโมเดล Code Llama Python บน HumanEval แสดงให้เห็นถึงประสิทธิภาพที่แตกต่างกันในภาษาการเขียนโค้ดและงานต่างๆ ตั้งแต่ 38% ในรุ่น 7B Python ถึง 57% ในรุ่น 70B Python นอกจากนี้ โมเดล Code Llama ที่ได้รับการปรับแต่งอย่างละเอียดในภาษาการเขียนโปรแกรม SQL ยังแสดงผลลัพธ์ที่ดีกว่า ดังที่เห็นได้จากการวัดประสิทธิภาพการประเมิน SQL เกณฑ์มาตรฐานที่เผยแพร่เหล่านี้เน้นย้ำถึงคุณประโยชน์ที่เป็นไปได้ของการปรับแต่งโมเดล Code Llama อย่างละเอียด ช่วยให้เกิดประสิทธิภาพ การปรับแต่ง และการปรับให้เข้ากับโดเมนและงานการเขียนโค้ดเฉพาะได้ดียิ่งขึ้น

การปรับแต่งแบบละเอียดโดยไม่ต้องใช้โค้ดผ่าน SageMaker Studio UI

หากต้องการเริ่มปรับแต่งโมเดล Llama ของคุณอย่างละเอียดโดยใช้ SageMaker Studio ให้ทำตามขั้นตอนต่อไปนี้:

- บนคอนโซล SageMaker Studio เลือก เริ่มกระโดด ในบานหน้าต่างนำทาง

คุณจะพบรายชื่อโมเดลมากกว่า 350 รุ่น ตั้งแต่รุ่นโอเพ่นซอร์สและรุ่นที่เป็นกรรมสิทธิ์

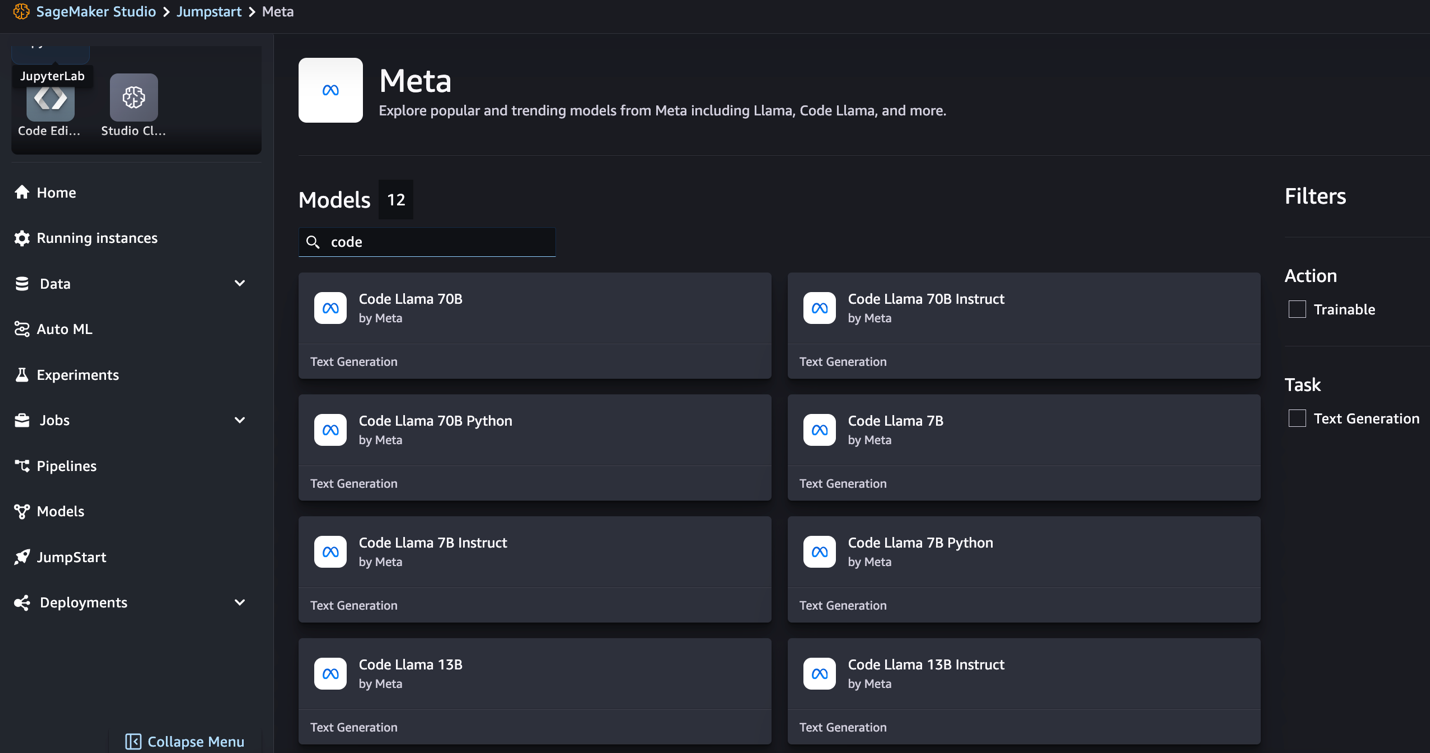

- ค้นหาโมเดล Code Llama

หากคุณไม่เห็นโมเดล Code Llama คุณสามารถอัปเดตเวอร์ชัน SageMaker Studio ได้โดยการปิดระบบแล้วรีสตาร์ท สำหรับข้อมูลเพิ่มเติมเกี่ยวกับการอัพเดตเวอร์ชัน โปรดดูที่ ปิดและอัปเดตแอป Studio. คุณยังสามารถค้นหารุ่นย่อยอื่นๆ ได้โดยเลือก สำรวจโมเดลการสร้างโค้ดทั้งหมด หรือค้นหา Code Llama ในช่องค้นหา

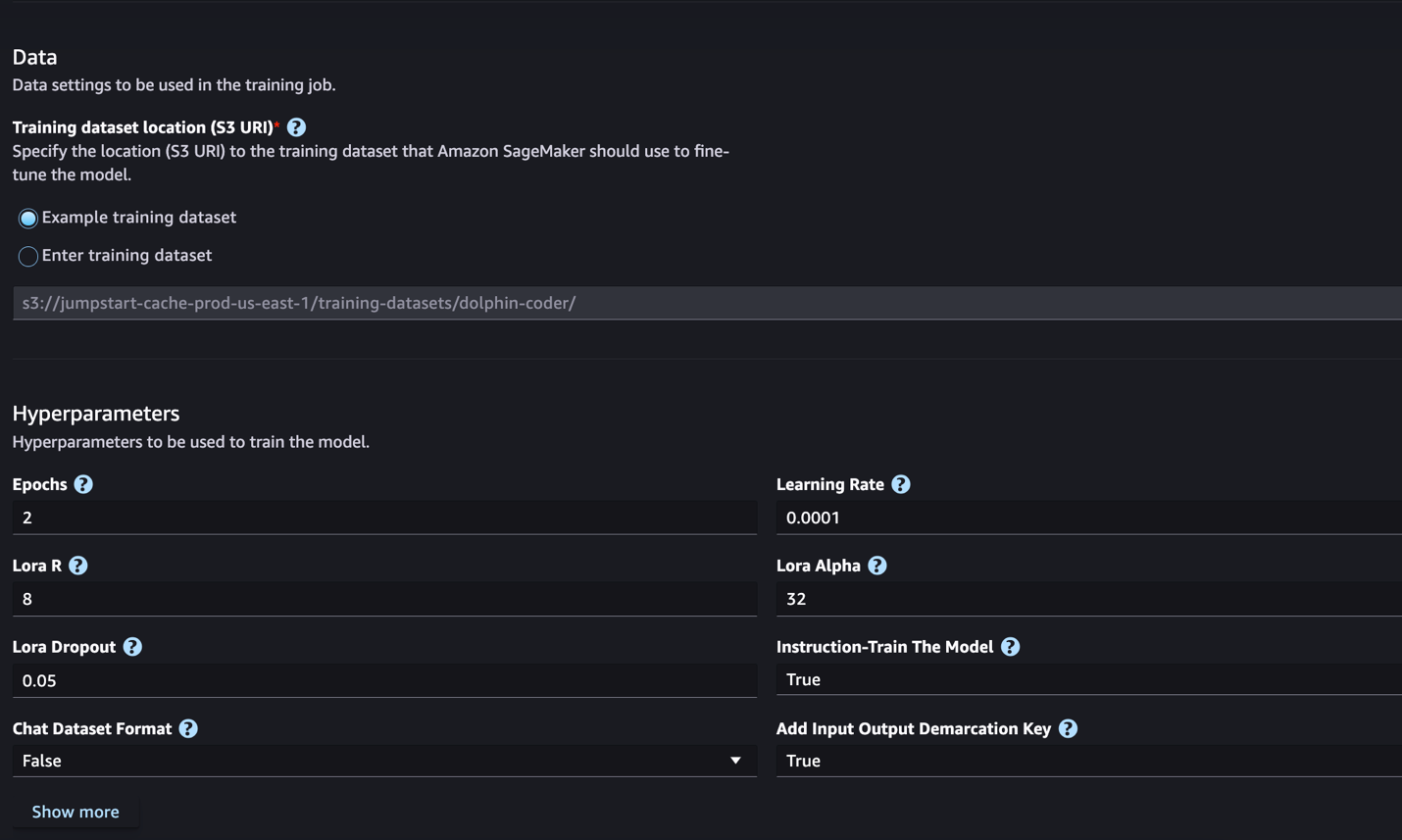

ปัจจุบัน SageMaker JumpStart รองรับการปรับแต่งคำสั่งอย่างละเอียดสำหรับโมเดล Code Llama ภาพหน้าจอต่อไปนี้แสดงหน้าการปรับแต่งอย่างละเอียดสำหรับรุ่น Code Llama 2 70B

- สำหรับ ตำแหน่งชุดข้อมูลการฝึกอบรมคุณสามารถชี้ไปที่ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon บัคเก็ต (Amazon S3) ที่ประกอบด้วยชุดข้อมูลการฝึกอบรมและการตรวจสอบเพื่อการปรับแต่งอย่างละเอียด

- ตั้งค่าคอนฟิกูเรชันการปรับใช้ ไฮเปอร์พารามิเตอร์ และการตั้งค่าความปลอดภัยสำหรับการปรับแต่งอย่างละเอียด

- Choose รถไฟ เพื่อเริ่มงานปรับแต่งอย่างละเอียดบนอินสแตนซ์ SageMaker ML

เราจะพูดถึงรูปแบบชุดข้อมูลที่คุณต้องการเพื่อเตรียมพร้อมสำหรับการปรับแต่งคำสั่งโดยละเอียดในส่วนถัดไป

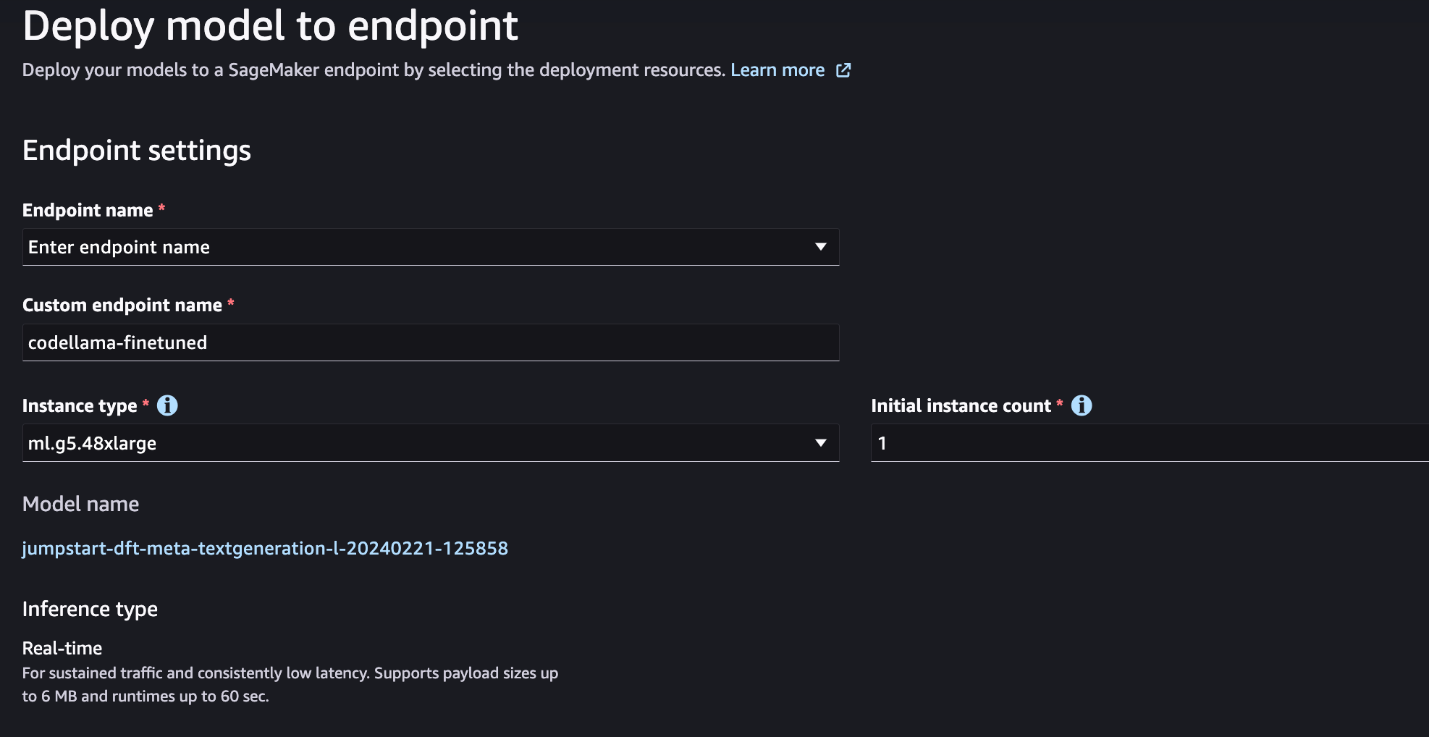

- หลังจากปรับแต่งโมเดลอย่างละเอียดแล้ว คุณสามารถปรับใช้ได้โดยใช้หน้าโมเดลบน SageMaker JumpStart

ตัวเลือกในการปรับใช้แบบจำลองที่ปรับแต่งอย่างละเอียดจะปรากฏขึ้นเมื่อการปรับแต่งแบบละเอียดเสร็จสิ้น ดังที่แสดงในภาพหน้าจอต่อไปนี้

ปรับแต่งอย่างละเอียดผ่าน SageMaker Python SDK

ในส่วนนี้ เราจะสาธิตวิธีปรับแต่งโมเดล Code LIama โดยใช้ SageMaker Python SDK บนชุดข้อมูลที่มีรูปแบบคำสั่ง โดยเฉพาะอย่างยิ่ง โมเดลนี้ได้รับการปรับแต่งอย่างละเอียดสำหรับชุดงานการประมวลผลภาษาธรรมชาติ (NLP) ที่อธิบายโดยใช้คำแนะนำ ซึ่งจะช่วยปรับปรุงประสิทธิภาพของโมเดลสำหรับงานที่มองไม่เห็นด้วยการแจ้งเตือนแบบ Zero-Shot

ทำตามขั้นตอนต่อไปนี้เพื่อเสร็จสิ้นงานปรับแต่งของคุณ คุณสามารถรับโค้ดการปรับแต่งทั้งหมดได้จาก พื้นที่เก็บข้อมูล GitHub.

ขั้นแรก มาดูรูปแบบชุดข้อมูลที่จำเป็นสำหรับการปรับแต่งคำสั่งโดยละเอียด ข้อมูลการฝึกอบรมควรอยู่ในรูปแบบบรรทัด JSON (.jsonl) โดยแต่ละบรรทัดเป็นพจนานุกรมที่แสดงถึงตัวอย่างข้อมูล ข้อมูลการฝึกอบรมทั้งหมดจะต้องอยู่ในโฟลเดอร์เดียว อย่างไรก็ตาม สามารถบันทึกเป็นไฟล์ .jsonl ได้หลายไฟล์ ต่อไปนี้คือตัวอย่างในรูปแบบบรรทัด JSON:

โฟลเดอร์การฝึกอบรมสามารถมีไฟล์ template.json ไฟล์อธิบายรูปแบบอินพุตและเอาต์พุต ต่อไปนี้เป็นตัวอย่างเทมเพลต:

เพื่อให้ตรงกับเทมเพลต แต่ละตัวอย่างในไฟล์บรรทัด JSON จะต้องรวมไว้ด้วย system_prompt, questionและ response สาขา ในการสาธิตนี้เราใช้ ชุดข้อมูล Dolphin Coder จากเรื่อง กอดหน้า.

หลังจากที่คุณเตรียมชุดข้อมูลและอัปโหลดไปยังบัคเก็ต S3 แล้ว คุณสามารถเริ่มการปรับแต่งอย่างละเอียดได้โดยใช้โค้ดต่อไปนี้:

คุณสามารถปรับใช้แบบจำลองที่ปรับแต่งอย่างละเอียดได้โดยตรงจากตัวประมาณค่า ดังที่แสดงในโค้ดต่อไปนี้ สำหรับรายละเอียด โปรดดูสมุดบันทึกใน พื้นที่เก็บข้อมูล GitHub.

เทคนิคการปรับแต่งอย่างละเอียด

โมเดลภาษาเช่น Llama มีขนาดมากกว่า 10 GB หรือ 100 GB การปรับแต่งโมเดลขนาดใหญ่ดังกล่าวอย่างละเอียดต้องใช้อินสแตนซ์ที่มีหน่วยความจำ CUDA สูงอย่างมาก นอกจากนี้ การฝึกโมเดลเหล่านี้อาจทำได้ช้ามากเนื่องจากขนาดของโมเดล ดังนั้น เพื่อการปรับแต่งอย่างมีประสิทธิภาพ เราจึงใช้การเพิ่มประสิทธิภาพต่อไปนี้:

- การปรับตัวระดับต่ำ (LoRA) – นี่คือการปรับพารามิเตอร์แบบละเอียดที่มีประสิทธิภาพ (PEFT) ประเภทหนึ่งสำหรับการปรับแบบละเอียดอย่างมีประสิทธิภาพสำหรับรุ่นขนาดใหญ่ ด้วยวิธีนี้ คุณจะหยุดทั้งโมเดลและเพิ่มพารามิเตอร์หรือเลเยอร์ที่ปรับได้ชุดเล็กๆ ลงในโมเดลเท่านั้น ตัวอย่างเช่น แทนที่จะฝึกพารามิเตอร์ทั้งหมด 7 พันล้านพารามิเตอร์สำหรับ Llama 2 7B คุณสามารถปรับแต่งพารามิเตอร์ได้น้อยกว่า 1% ซึ่งจะช่วยลดความต้องการหน่วยความจำได้อย่างมาก เนื่องจากคุณจำเป็นต้องจัดเก็บการไล่ระดับสี สถานะเครื่องมือเพิ่มประสิทธิภาพ และข้อมูลอื่นๆ ที่เกี่ยวข้องกับการฝึกอบรมเพียง 1% ของพารามิเตอร์เท่านั้น นอกจากนี้ยังช่วยลดเวลาการฝึกอบรมและค่าใช้จ่ายอีกด้วย สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับวิธีการนี้ โปรดดูที่ LoRA: การปรับตัวในระดับต่ำของโมเดลภาษาขนาดใหญ่.

- การหาปริมาณ Int8 – แม้จะมีการปรับปรุงประสิทธิภาพ เช่น LoRA แต่โมเดลอย่าง Llama 70B ก็ยังใหญ่เกินกว่าจะฝึกได้ หากต้องการลดขนาดหน่วยความจำระหว่างการฝึก คุณสามารถใช้การวัดปริมาณ Int8 ในระหว่างการฝึกได้ โดยทั่วไปการหาปริมาณจะลดความแม่นยำของประเภทข้อมูลจุดลอยตัว แม้ว่าการทำเช่นนี้จะลดหน่วยความจำที่จำเป็นในการจัดเก็บน้ำหนักโมเดล แต่ประสิทธิภาพก็ลดลงเนื่องจากข้อมูลสูญหาย การหาปริมาณ Int8 ใช้ความแม่นยำเพียงหนึ่งในสี่เท่านั้น แต่ไม่ได้ทำให้ประสิทธิภาพลดลง เนื่องจากไม่ได้ทำให้บิตลดลง มันจะปัดเศษข้อมูลจากประเภทหนึ่งไปอีกประเภทหนึ่ง หากต้องการเรียนรู้เกี่ยวกับการหาปริมาณ Int8 โปรดดูที่ LLM.int8(): การคูณเมทริกซ์ 8 บิตสำหรับ Transformers ตามขนาด.

- ข้อมูลแบบขนานที่แบ่งใช้อย่างสมบูรณ์ (FSDP) – นี่คืออัลกอริธึมการฝึกอบรมข้อมูลแบบคู่ขนานประเภทหนึ่งที่แบ่งพารามิเตอร์ของโมเดลให้กับผู้ปฏิบัติงานแบบขนานข้อมูล และสามารถเลือกถ่ายส่วนหนึ่งของการคำนวณการฝึกอบรมไปยัง CPU ได้ แม้ว่าพารามิเตอร์จะถูกแบ่งส่วนใน GPU ที่แตกต่างกัน แต่การคำนวณของไมโครแบทช์แต่ละรายการจะอยู่ในเครื่องของผู้ปฏิบัติงาน GPU โดยแบ่งส่วนพารามิเตอร์ให้มีความสม่ำเสมอมากขึ้น และบรรลุประสิทธิภาพที่ได้รับการปรับปรุงให้เหมาะสมผ่านการสื่อสารและการคำนวณที่ทับซ้อนกันระหว่างการฝึก

ตารางต่อไปนี้สรุปรายละเอียดของแต่ละรุ่นพร้อมการตั้งค่าที่แตกต่างกัน

| รุ่น | การตั้งค่าเริ่มต้น | ลอรา + FSDP | LORA + ไม่มี FSDP | การหาปริมาณ Int8 + LORA + ไม่มี FSDP |

| รหัสลามะ 2 7B | ลอรา + FSDP | ใช่ | ใช่ | ใช่ |

| รหัสลามะ 2 13B | ลอรา + FSDP | ใช่ | ใช่ | ใช่ |

| รหัสลามะ 2 34B | INT8 + LORA + ไม่มี FSDP | ไม่ | ไม่ | ใช่ |

| รหัสลามะ 2 70B | INT8 + LORA + ไม่มี FSDP | ไม่ | ไม่ | ใช่ |

การปรับแต่งโมเดล Llama อย่างละเอียดจะขึ้นอยู่กับสคริปต์ที่จัดเตรียมไว้ดังต่อไปนี้ repo GitHub.

ไฮเปอร์พารามิเตอร์ที่รองรับสำหรับการฝึก

การปรับแต่ง Code Llama 2 อย่างละเอียดรองรับไฮเปอร์พารามิเตอร์จำนวนหนึ่ง ซึ่งแต่ละพารามิเตอร์สามารถส่งผลต่อความต้องการหน่วยความจำ ความเร็วในการฝึกฝน และประสิทธิภาพของโมเดลที่ได้รับการปรับแต่ง:

- ยุค – จำนวนรอบที่อัลกอริธึมการปรับแต่งแบบละเอียดใช้ผ่านชุดข้อมูลการฝึก ต้องเป็นจำนวนเต็มที่มากกว่า 1 ค่าเริ่มต้นคือ 5

- อัตราการเรียนรู้ – อัตราการอัปเดตน้ำหนักแบบจำลองหลังจากทำงานผ่านตัวอย่างการฝึกอบรมแต่ละชุด จะต้องมีค่าทศนิยมเป็นบวกมากกว่า 0 ค่าเริ่มต้นคือ 1e-4

- Instruction_tuned – ไม่ว่าจะสั่งสอน-เทรนโมเดลหรือไม่ก็ตาม จะต้องเป็น

TrueorFalse. ค่าเริ่มต้นคือFalse. - ต่อ_อุปกรณ์_train_batch_size – ขนาดแบตช์ต่อคอร์ GPU/CPU สำหรับการฝึก ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 4

- ต่อ_อุปกรณ์_eval_batch_size – ขนาดแบตช์ต่อคอร์ GPU/CPU สำหรับการประเมิน ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 1

- max_train_samples – เพื่อวัตถุประสงค์ในการแก้ไขจุดบกพร่องหรือการฝึกที่รวดเร็วขึ้น ให้ตัดจำนวนตัวอย่างการฝึกให้เหลือเพียงค่านี้ ค่า -1 หมายถึง การใช้ตัวอย่างการฝึกทั้งหมด ต้องเป็นจำนวนเต็มบวกหรือ -1 ค่าเริ่มต้นคือ -1

- max_val_samples – เพื่อวัตถุประสงค์ในการแก้ไขจุดบกพร่องหรือการฝึกอบรมที่รวดเร็วยิ่งขึ้น ให้ตัดจำนวนตัวอย่างการตรวจสอบความถูกต้องให้เหลือเพียงค่านี้ ค่า -1 หมายถึงการใช้ตัวอย่างการตรวจสอบความถูกต้องทั้งหมด ต้องเป็นจำนวนเต็มบวกหรือ -1 ค่าเริ่มต้นคือ -1

- max_input_length – ความยาวลำดับอินพุตทั้งหมดสูงสุดหลังโทเค็น ลำดับที่นานกว่านี้จะถูกตัดทอน ถ้า -1,

max_input_lengthถูกตั้งค่าเป็นขั้นต่ำ 1024 และความยาวโมเดลสูงสุดที่กำหนดโดยโทเค็นไนเซอร์ หากตั้งค่าเป็นค่าบวกmax_input_lengthถูกตั้งค่าเป็นขั้นต่ำของค่าที่ให้ไว้และmodel_max_lengthกำหนดโดยโทเค็นไนเซอร์ ต้องเป็นจำนวนเต็มบวกหรือ -1 ค่าเริ่มต้นคือ -1 - validation_split_ratio – หากช่องทางการตรวจสอบเป็น

noneอัตราส่วนของการแยกการตรวจสอบความถูกต้องของรถไฟจากข้อมูลรถไฟจะต้องอยู่ระหว่าง 0–1 ค่าเริ่มต้นคือ 0.2 - train_data_split_seed – หากไม่มีข้อมูลการตรวจสอบความถูกต้อง การดำเนินการนี้จะแก้ไขการแยกข้อมูลการฝึกอบรมอินพุตแบบสุ่มไปยังข้อมูลการฝึกอบรมและการตรวจสอบความถูกต้องที่ใช้โดยอัลกอริทึม ต้องเป็นจำนวนเต็ม ค่าเริ่มต้นคือ 0

- preprocessing_num_workers – จำนวนกระบวนการที่จะใช้สำหรับการประมวลผลล่วงหน้า ถ้า

Noneกระบวนการหลักใช้สำหรับการประมวลผลล่วงหน้า ค่าเริ่มต้นคือNone. - ลอร่า_อาร์ – Lora R. ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 8

- ลอรา_อัลฟา – ลอร่า อัลฟ่า ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 32

- lora_dropout – ลอรา ดรอปเอาท์ จะต้องมีค่าทศนิยมเป็นบวกระหว่าง 0 ถึง 1 ค่าเริ่มต้นคือ 0.05

- int8_quantization - ถ้า

Trueโมเดลนี้โหลดด้วยความแม่นยำ 8 บิตสำหรับการฝึก ค่าเริ่มต้นสำหรับ 7B และ 13B คือFalse. ค่าเริ่มต้นสำหรับ 70B คือTrue. - Enable_fsdp – หากเป็นจริง การฝึกอบรมจะใช้ FSDP ค่าเริ่มต้นสำหรับ 7B และ 13B เป็นจริง ค่าเริ่มต้นสำหรับ 70B เป็นเท็จ โปรดทราบว่า

int8_quantizationไม่รองรับ FSDP

เมื่อเลือกไฮเปอร์พารามิเตอร์ ให้พิจารณาสิ่งต่อไปนี้:

- การตั้งค่า

int8_quantization=Trueลดความต้องการความจำและนำไปสู่การฝึกที่เร็วขึ้น - ลดลง

per_device_train_batch_sizeและmax_input_lengthลดความต้องการหน่วยความจำและสามารถเรียกใช้บนอินสแตนซ์ขนาดเล็กได้ อย่างไรก็ตาม การตั้งค่าที่ต่ำมากอาจเพิ่มเวลาการฝึก - หากคุณไม่ได้ใช้การหาปริมาณ Int8 (

int8_quantization=False) ใช้ FSDP (enable_fsdp=True) เพื่อการฝึกอบรมที่รวดเร็วและมีประสิทธิภาพ

ประเภทอินสแตนซ์ที่รองรับสำหรับการฝึกอบรม

ตารางต่อไปนี้สรุปประเภทอินสแตนซ์ที่รองรับสำหรับการฝึกโมเดลต่างๆ

| รุ่น | ประเภทอินสแตนซ์เริ่มต้น | ประเภทอินสแตนซ์ที่รองรับ |

| รหัสลามะ 2 7B | มล.g5.12xlarge |

มล.g5.12xlarge, มล.g5.24xlarge, มล.g5.48xlarge, ml.p3dn.24xlarge, ml.g4dn.12xlarge |

| รหัสลามะ 2 13B | มล.g5.12xlarge |

มล.g5.24xlarge, มล.g5.48xlarge, ml.p3dn.24xlarge, ml.g4dn.12xlarge |

| รหัสลามะ 2 70B | มล.g5.48xlarge |

มล.g5.48xlarge ml.p4d.24xlarge |

เมื่อเลือกประเภทอินสแตนซ์ ให้พิจารณาสิ่งต่อไปนี้:

- อินสแตนซ์ G5 ให้การฝึกอบรมที่มีประสิทธิภาพมากที่สุดในบรรดาประเภทอินสแตนซ์ที่รองรับ ดังนั้น หากคุณมีอินสแตนซ์ G5 คุณก็ควรใช้อินสแตนซ์เหล่านั้น

- เวลาการฝึกอบรมส่วนใหญ่ขึ้นอยู่กับจำนวน GPU และหน่วยความจำ CUDA ที่พร้อมใช้งาน ดังนั้น การฝึกบนอินสแตนซ์ที่มี GPU จำนวนเท่ากัน (เช่น ml.g5.2xlarge และ ml.g5.4xlarge) จึงใกล้เคียงกันโดยประมาณ ดังนั้น คุณสามารถใช้อินสแตนซ์ที่ถูกกว่าสำหรับการฝึกได้ (ml.g5.2xlarge)

- เมื่อใช้อินสแตนซ์ p3 การฝึกจะดำเนินการด้วยความแม่นยำ 32 บิต เนื่องจากอินสแตนซ์เหล่านี้ไม่รองรับ bfloat16 ดังนั้น งานการฝึกจะใช้จำนวนหน่วยความจำ CUDA เป็นสองเท่าเมื่อฝึกบนอินสแตนซ์ p3 เมื่อเทียบกับอินสแตนซ์ g5

หากต้องการเรียนรู้เกี่ยวกับค่าใช้จ่ายในการฝึกอบรมต่ออินสแตนซ์ โปรดดูที่ Amazon EC2 G5 อินสแตนซ์.

การประเมินผล

การประเมินเป็นขั้นตอนสำคัญในการประเมินประสิทธิภาพของแบบจำลองที่ได้รับการปรับแต่งอย่างละเอียด เรานำเสนอการประเมินทั้งเชิงคุณภาพและเชิงปริมาณเพื่อแสดงการปรับปรุงแบบจำลองที่ได้รับการปรับแต่งมากกว่าแบบจำลองที่ไม่ได้ปรับแต่ง ในการประเมินเชิงคุณภาพ เราจะแสดงตัวอย่างการตอบสนองจากทั้งแบบจำลองที่ได้รับการปรับแต่งและไม่ได้รับการปรับแต่ง ในการประเมินเชิงปริมาณเราใช้ มนุษย์อีวาลซึ่งเป็นชุดทดสอบที่พัฒนาโดย OpenAI เพื่อสร้างโค้ด Python เพื่อทดสอบความสามารถในการสร้างผลลัพธ์ที่ถูกต้องและแม่นยำ พื้นที่เก็บข้อมูล HumanEval อยู่ภายใต้ใบอนุญาตของ MIT เราปรับแต่งตัวแปร Python ของโมเดล Code LIama ทั้งหมดในขนาดที่แตกต่างกัน (Code LIama Python 7B, 13B, 34B และ 70B บน ชุดข้อมูล Dolphin Coder) และนำเสนอผลการประเมินในส่วนต่อไปนี้

การประเมินเชิงคุณภาพ

เมื่อปรับใช้โมเดลที่ได้รับการปรับแต่งแล้ว คุณสามารถเริ่มใช้ตำแหน่งข้อมูลเพื่อสร้างโค้ดได้ ในตัวอย่างต่อไปนี้ เรานำเสนอการตอบสนองจากทั้งตัวแปรพื้นฐานและโค้ด LIama 34B Python ที่ปรับแต่งอย่างละเอียดในตัวอย่างทดสอบใน ชุดข้อมูล Dolphin Coder:

โมเดล Code Llama ที่ได้รับการปรับแต่งอย่างละเอียด นอกเหนือจากการให้โค้ดสำหรับการสืบค้นก่อนหน้าแล้ว ยังสร้างคำอธิบายโดยละเอียดของวิธีการและโค้ดเทียมอีกด้วย

รหัส Llama 34b Python การตอบสนองแบบไม่ปรับแต่ง:

Code Llama 34B Python การตอบสนองแบบละเอียด

ความจริงพื้นดิน

สิ่งที่น่าสนใจคือ Code Llama 34B Python เวอร์ชันที่ได้รับการปรับแต่งอย่างละเอียดของเรามอบโซลูชันตามการเขียนโปรแกรมแบบไดนามิกให้กับสตริงย่อย Palindromic ที่ยาวที่สุด ซึ่งแตกต่างจากโซลูชันที่ให้ไว้ในความจริงภาคพื้นดินจากตัวอย่างการทดสอบที่เลือก เหตุผลด้านโมเดลที่ได้รับการปรับแต่งอย่างละเอียดของเราและอธิบายโซลูชันตามการเขียนโปรแกรมแบบไดนามิกโดยละเอียด ในทางกลับกัน โมเดลที่ไม่ได้ปรับแต่งอย่างละเอียดจะทำให้เกิดภาพหลอนที่อาจเกิดขึ้นทันทีหลังจาก print คำสั่ง (แสดงในเซลล์ด้านซ้าย) เนื่องจากการส่งออก axyzzyx ไม่ใช่พาลินโดรมที่ยาวที่สุดในสตริงที่กำหนด ในแง่ของความซับซ้อนของเวลา โดยทั่วไปแล้วโซลูชันการเขียนโปรแกรมแบบไดนามิกจะดีกว่าแนวทางเริ่มแรก โซลูชันการเขียนโปรแกรมแบบไดนามิกมีความซับซ้อนของเวลาเป็น O(n^2) โดยที่ n คือความยาวของสตริงอินพุต วิธีนี้จะมีประสิทธิภาพมากกว่าโซลูชันเริ่มต้นจากโมเดลที่ไม่ได้ปรับแต่งอย่างละเอียด ซึ่งมีความซับซ้อนด้านเวลากำลังสองเท่ากับ O(n^2) แต่มีแนวทางที่ได้รับการปรับปรุงให้เหมาะสมน้อยกว่า

นี่ดูมีแนวโน้ม! โปรดจำไว้ว่า เราปรับแต่งตัวแปร Code LIama Python อย่างละเอียดเพียง 10% ของ ชุดข้อมูล Dolphin Coder. มีอะไรอีกมากมายให้สำรวจ!

แม้จะมีคำแนะนำอย่างละเอียดในการตอบกลับ แต่เรายังคงต้องตรวจสอบความถูกต้องของโค้ด Python ที่ให้ไว้ในโซลูชัน ต่อไปเราจะใช้กรอบการประเมินผลที่เรียกว่า การประเมินมนุษย์ เพื่อทำการทดสอบบูรณาการกับการตอบสนองที่สร้างขึ้นจาก Code LIama เพื่อตรวจสอบคุณภาพอย่างเป็นระบบ

การประเมินเชิงปริมาณด้วย HumanEval

HumanEval เป็นชุดประเมินผลสำหรับการประเมินความสามารถในการแก้ปัญหาของ LLM เกี่ยวกับปัญหาการเขียนโค้ดแบบ Python ดังที่อธิบายไว้ในรายงาน การประเมินโมเดลภาษาขนาดใหญ่ที่ได้รับการฝึกอบรมเกี่ยวกับโค้ด. โดยเฉพาะอย่างยิ่ง ประกอบด้วยปัญหาการเขียนโปรแกรมที่ใช้ Python ดั้งเดิม 164 ปัญหา ซึ่งประเมินความสามารถของโมเดลภาษาในการสร้างโค้ดตามข้อมูลที่ให้ไว้ เช่น ลายเซ็นฟังก์ชัน สตริงเอกสาร เนื้อหา และการทดสอบหน่วย

สำหรับคำถามเกี่ยวกับการเขียนโปรแกรมแบบ Python แต่ละคำถาม เราจะส่งคำถามไปยังโมเดล Code LIama ที่ใช้งานบนตำแหน่งข้อมูล SageMaker เพื่อรับคำตอบ k ต่อไป เราจะรันการตอบสนอง k แต่ละรายการในการทดสอบการรวมในพื้นที่เก็บข้อมูล HumanEval หากการตอบสนองใดๆ ของการตอบสนอง k ผ่านการทดสอบการรวม เราจะถือว่ากรณีทดสอบนั้นสำเร็จ ไม่อย่างนั้นก็ล้มเหลว จากนั้นเราทำซ้ำขั้นตอนเพื่อคำนวณอัตราส่วนของกรณีที่ประสบความสำเร็จตามชื่อคะแนนการประเมินขั้นสุดท้าย pass@k. ตามแนวทางปฏิบัติมาตรฐาน เราตั้งค่า k เป็น 1 ในการประเมินของเรา เพื่อสร้างคำตอบเดียวต่อคำถามเท่านั้น และทดสอบว่าผ่านการทดสอบบูรณาการหรือไม่

ต่อไปนี้เป็นโค้ดตัวอย่างเพื่อใช้พื้นที่เก็บข้อมูล HumanEval คุณสามารถเข้าถึงชุดข้อมูลและสร้างการตอบกลับเดียวโดยใช้ตำแหน่งข้อมูล SageMaker สำหรับรายละเอียด โปรดดูสมุดบันทึกใน พื้นที่เก็บข้อมูล GitHub.

ตารางต่อไปนี้แสดงการปรับปรุงโมเดล Code LIama Python ที่ได้รับการปรับแต่งอย่างละเอียด เทียบกับโมเดลที่ไม่ได้ปรับแต่งอย่างละเอียดในขนาดโมเดลต่างๆ เพื่อให้มั่นใจถึงความถูกต้อง เรายังปรับใช้โมเดล Code LIama ที่ไม่ได้รับการปรับแต่งในจุดสิ้นสุด SageMaker และดำเนินการผ่านการประเมิน Human Eval ที่ พาส@1 ตัวเลข (แถวแรกในตารางต่อไปนี้) ตรงกับตัวเลขที่รายงานใน เอกสารวิจัยรหัสลามะ พารามิเตอร์การอนุมานได้รับการตั้งค่าอย่างสม่ำเสมอเป็น "parameters": {"max_new_tokens": 384, "temperature": 0.2}.

ดังที่เราเห็นจากผลลัพธ์ ตัวแปร Code LIama Python ที่ได้รับการปรับแต่งอย่างละเอียดทั้งหมดแสดงการปรับปรุงที่สำคัญกว่าโมเดลที่ไม่ได้ปรับแต่งอย่างละเอียด โดยเฉพาะอย่างยิ่ง Code LIama Python 70B มีประสิทธิภาพเหนือกว่าโมเดลที่ไม่ได้ปรับแต่งประมาณ 12%

| . | 7B หลาม | 13B หลาม | 34B | 34B หลาม | 70B หลาม |

| ประสิทธิภาพของโมเดลที่ได้รับการฝึกอบรมล่วงหน้า (pass@1) | 38.4 | 43.3 | 48.8 | 53.7 | 57.3 |

| ประสิทธิภาพของโมเดลที่ได้รับการปรับแต่งอย่างละเอียด (pass@1) | 45.12 | 45.12 | 59.1 | 61.5 | 69.5 |

ตอนนี้คุณสามารถลองปรับแต่งโมเดล Code LIama บนชุดข้อมูลของคุณเองได้แล้ว

ทำความสะอาด

หากคุณตัดสินใจว่าไม่ต้องการให้ตำแหน่งข้อมูล SageMaker ทำงานต่อไป คุณสามารถลบได้โดยใช้ AWS SDK สำหรับ Python (Boto3), อินเทอร์เฟซบรรทัดคำสั่ง AWS AWS (AWS CLI) หรือคอนโซล SageMaker สำหรับข้อมูลเพิ่มเติม โปรดดู ลบปลายทางและทรัพยากร. นอกจากนี้ คุณสามารถ ปิดทรัพยากร SageMaker Studio ที่ไม่จำเป็นอีกต่อไป

สรุป

ในโพสต์นี้ เราได้พูดคุยถึงการปรับแต่งโมเดล Code Llama 2 ของ Meta อย่างละเอียดโดยใช้ SageMaker JumpStart เราแสดงให้เห็นว่าคุณสามารถใช้คอนโซล SageMaker JumpStart ใน SageMaker Studio หรือ SageMaker Python SDK เพื่อปรับแต่งและปรับใช้โมเดลเหล่านี้ได้ เรายังกล่าวถึงเทคนิคการปรับแต่งอย่างละเอียด ประเภทอินสแตนซ์ และไฮเปอร์พารามิเตอร์ที่รองรับอีกด้วย นอกจากนี้ เรายังให้คำแนะนำเพื่อเพิ่มประสิทธิภาพการฝึกอบรมโดยอิงจากการทดสอบต่างๆ ที่เราทำ ดังที่เราเห็นจากผลลัพธ์ของการปรับแต่งโมเดลสามแบบอย่างละเอียดบนชุดข้อมูลสองชุด การปรับแต่งแบบละเอียดจะช่วยปรับปรุงการสรุปเมื่อเปรียบเทียบกับโมเดลที่ไม่ได้ปรับแต่งแบบละเอียด ในขั้นตอนถัดไป คุณสามารถลองปรับแต่งโมเดลเหล่านี้บนชุดข้อมูลของคุณเองได้โดยใช้โค้ดที่ให้ไว้ในที่เก็บ GitHub เพื่อทดสอบและเปรียบเทียบผลลัพธ์สำหรับกรณีการใช้งานของคุณ

เกี่ยวกับผู้เขียน

ดร.ซิน หวาง เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสสำหรับอัลกอริทึมในตัวของ Amazon SageMaker JumpStart และ Amazon SageMaker เขามุ่งเน้นไปที่การพัฒนาอัลกอริธึมการเรียนรู้ของเครื่องที่ปรับขนาดได้ ความสนใจในงานวิจัยของเขาอยู่ในขอบเขตของการประมวลผลภาษาธรรมชาติ การเรียนรู้เชิงลึกที่อธิบายได้เกี่ยวกับข้อมูลแบบตาราง และการวิเคราะห์ที่มีประสิทธิภาพของการจัดกลุ่มพื้นที่เวลา-อวกาศแบบไม่มีพารามิเตอร์ เขาได้เผยแพร่เอกสารมากมายในการประชุม ACL, ICDM, KDD และ Royal Statistical Society: Series A

ดร.ซิน หวาง เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสสำหรับอัลกอริทึมในตัวของ Amazon SageMaker JumpStart และ Amazon SageMaker เขามุ่งเน้นไปที่การพัฒนาอัลกอริธึมการเรียนรู้ของเครื่องที่ปรับขนาดได้ ความสนใจในงานวิจัยของเขาอยู่ในขอบเขตของการประมวลผลภาษาธรรมชาติ การเรียนรู้เชิงลึกที่อธิบายได้เกี่ยวกับข้อมูลแบบตาราง และการวิเคราะห์ที่มีประสิทธิภาพของการจัดกลุ่มพื้นที่เวลา-อวกาศแบบไม่มีพารามิเตอร์ เขาได้เผยแพร่เอกสารมากมายในการประชุม ACL, ICDM, KDD และ Royal Statistical Society: Series A

วิชาล ยาลามันชาลี เป็นสถาปนิกโซลูชั่นสตาร์ทอัพที่ทำงานร่วมกับบริษัท AI, หุ่นยนต์ และยานยนต์อัตโนมัติในระยะเริ่มต้น Vishaal ทำงานร่วมกับลูกค้าเพื่อนำเสนอโซลูชัน ML ที่ล้ำสมัย และมีความสนใจเป็นการส่วนตัวในการเรียนรู้แบบเสริมกำลัง การประเมิน LLM และการสร้างโค้ด ก่อนที่จะมาร่วมงานกับ AWS นั้น Vishaal สำเร็จการศึกษาระดับปริญญาตรีที่ UCI โดยเน้นด้านชีวสารสนเทศศาสตร์และระบบอัจฉริยะ

วิชาล ยาลามันชาลี เป็นสถาปนิกโซลูชั่นสตาร์ทอัพที่ทำงานร่วมกับบริษัท AI, หุ่นยนต์ และยานยนต์อัตโนมัติในระยะเริ่มต้น Vishaal ทำงานร่วมกับลูกค้าเพื่อนำเสนอโซลูชัน ML ที่ล้ำสมัย และมีความสนใจเป็นการส่วนตัวในการเรียนรู้แบบเสริมกำลัง การประเมิน LLM และการสร้างโค้ด ก่อนที่จะมาร่วมงานกับ AWS นั้น Vishaal สำเร็จการศึกษาระดับปริญญาตรีที่ UCI โดยเน้นด้านชีวสารสนเทศศาสตร์และระบบอัจฉริยะ

มีนคชีสันดาราม ทันดาวารายัน ทำงานให้กับ AWS ในฐานะผู้เชี่ยวชาญด้าน AI/ ML เขามีความหลงใหลในการออกแบบ สร้างสรรค์ และส่งเสริมประสบการณ์ข้อมูลและการวิเคราะห์ที่คำนึงถึงมนุษย์เป็นหลัก Meena มุ่งเน้นไปที่การพัฒนาระบบที่ยั่งยืนซึ่งมอบความได้เปรียบในการแข่งขันที่สามารถวัดผลได้สำหรับลูกค้าเชิงกลยุทธ์ของ AWS Meena เป็นนักเชื่อมต่อและนักคิดด้านการออกแบบ และมุ่งมั่นที่จะขับเคลื่อนธุรกิจไปสู่แนวทางใหม่ในการทำงานผ่านนวัตกรรม การบ่มเพาะ และการทำให้เป็นประชาธิปไตย

มีนคชีสันดาราม ทันดาวารายัน ทำงานให้กับ AWS ในฐานะผู้เชี่ยวชาญด้าน AI/ ML เขามีความหลงใหลในการออกแบบ สร้างสรรค์ และส่งเสริมประสบการณ์ข้อมูลและการวิเคราะห์ที่คำนึงถึงมนุษย์เป็นหลัก Meena มุ่งเน้นไปที่การพัฒนาระบบที่ยั่งยืนซึ่งมอบความได้เปรียบในการแข่งขันที่สามารถวัดผลได้สำหรับลูกค้าเชิงกลยุทธ์ของ AWS Meena เป็นนักเชื่อมต่อและนักคิดด้านการออกแบบ และมุ่งมั่นที่จะขับเคลื่อนธุรกิจไปสู่แนวทางใหม่ในการทำงานผ่านนวัตกรรม การบ่มเพาะ และการทำให้เป็นประชาธิปไตย

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสที่มีอัลกอริทึมในตัวของ Amazon SageMaker และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสที่มีอัลกอริทึมในตัวของ Amazon SageMaker และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/fine-tune-code-llama-on-amazon-sagemaker-jumpstart/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- 1

- 10

- 100

- 12

- 13

- 14

- 16

- 20

- 27

- 2D

- 350

- 7

- 70

- 8

- a

- ความสามารถ

- ความสามารถ

- เกี่ยวกับเรา

- ยอมรับ

- เข้า

- ความถูกต้อง

- ถูกต้อง

- ประสบความสำเร็จ

- ข้าม

- คล่องแคล่ว

- การปรับตัว

- เพิ่ม

- นอกจากนี้

- นอกจากนี้

- ปรับ

- ข้อได้เปรียบ

- หลังจาก

- กับ

- AI

- ขั้นตอนวิธี

- อัลกอริทึม

- ทั้งหมด

- แอลฟา

- แล้ว

- ด้วย

- แม้ว่า

- อเมซอน

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- ในหมู่

- จำนวน

- an

- การวิเคราะห์

- การวิเคราะห์

- และ

- ประกาศ

- อื่น

- คำตอบ

- ใด

- ปรากฏ

- ประยุกต์

- เข้าใกล้

- ประมาณ

- เป็น

- AREA

- AS

- ประเมินผล

- At

- อิสระ

- ใช้ได้

- AWS

- BAB

- ฐาน

- ตาม

- ทุบตี

- BE

- เพราะ

- จะกลายเป็น

- หลัง

- มาตรฐาน

- มาตรฐาน

- ประโยชน์ที่ได้รับ

- ดีกว่า

- ระหว่าง

- ใหญ่

- พันล้าน

- บิต

- ร่างกาย

- ทั้งสอง

- ทั้งสองด้าน

- กล่อง

- ทำลาย

- กว้าง

- built-in

- ธุรกิจ

- แต่

- by

- C + +

- คำนวณ

- ที่เรียกว่า

- CAN

- สามารถรับ

- ความสามารถในการ

- ความสามารถ

- ดำเนินการ

- กรณี

- กรณี

- เซลล์

- เปลี่ยนแปลง

- เปลี่ยนแปลง

- ช่อง

- ตัวอักษร

- อักขระ

- พูดคุย

- ราคาถูก

- ตรวจสอบ

- การตรวจสอบ

- การตรวจสอบ

- Choose

- เลือก

- CLI

- การจัดกลุ่ม

- การฝึก

- รหัส

- coder

- การเข้ารหัส

- ชุด

- ร่วมกัน

- การสื่อสาร

- บริษัท

- เมื่อเทียบกับ

- การแข่งขัน

- สมบูรณ์

- เสร็จสิ้น

- ความซับซ้อน

- การคำนวณ

- การประชุม

- องค์ประกอบ

- ติดต่อกัน

- พิจารณา

- เสมอต้นเสมอปลาย

- ประกอบด้วย

- ประกอบ

- ปลอบใจ

- บริโภค

- บรรจุ

- แก้ไข

- ราคา

- นับ

- สร้าง

- ที่สร้างขึ้น

- ปัจจุบัน

- ขณะนี้

- ลูกค้า

- การปรับแต่ง

- ปรับแต่ง

- ตัดขอบ

- ข้อมูล

- ชุดข้อมูล

- ตัดสินใจ

- ลดลง

- ลดลง

- ทุ่มเท

- ลึก

- การเรียนรู้ลึก ๆ

- ค่าเริ่มต้น

- กำหนด

- ส่งมอบ

- การทำให้เป็นประชาธิปไตย

- สาธิต

- แสดงให้เห็นถึง

- สาธิต

- ขึ้นอยู่กับ

- ปรับใช้

- นำไปใช้

- การใช้งาน

- ที่ได้มา

- อธิบาย

- อธิบาย

- ออกแบบ

- รายละเอียด

- รายละเอียด

- รายละเอียด

- พัฒนา

- พัฒนา

- ที่กำลังพัฒนา

- ต่าง

- ตัวเลข

- มิติ

- โดยตรง

- สนทนา

- กล่าวถึง

- ไม่

- โดเมน

- ทำ

- Dont

- สอง

- ลง

- ขับรถ

- หล่น

- สอง

- ในระหว่าง

- พลวัต

- แต่ละ

- ช่วงแรก ๆ

- อย่างมีประสิทธิภาพ

- ที่มีประสิทธิภาพ

- ทั้ง

- การเปิดใช้งาน

- ปลาย

- สิ้นสุด

- ปลายทาง

- ภาษาอังกฤษ

- ที่เพิ่มขึ้น

- ทำให้มั่นใจ

- ทั้งหมด

- สิ่งแวดล้อม

- เท่ากัน

- การประเมินการ

- การประเมินผล

- การประเมินผล

- แม้

- ชัดเจน

- ตรวจสอบ

- ตัวอย่าง

- ตัวอย่าง

- ตื่นเต้น

- แสดง

- ประสบการณ์

- ประสบการณ์

- อธิบาย

- อธิบาย

- คำอธิบาย

- ใบหน้า

- ล้มเหลว

- เท็จ

- ครอบครัว

- เร็วขึ้น

- FB

- คุณสมบัติ

- สองสาม

- ฟีโบนักชี

- สาขา

- เนื้อไม่มีมัน

- ไฟล์

- ใส่

- สุดท้าย

- ในที่สุด

- หา

- ชื่อจริง

- แก้ไข

- ลอย

- ที่ลอย

- โฟกัส

- มุ่งเน้น

- มุ่งเน้นไปที่

- ดังต่อไปนี้

- รอยพระบาท

- สำหรับ

- รูป

- รากฐาน

- กรอบ

- แข็ง

- ราคาเริ่มต้นที่

- ฟังก์ชัน

- ต่อไป

- นอกจากนี้

- โดยทั่วไป

- สร้าง

- สร้าง

- สร้าง

- รุ่น

- กำเนิด

- กำเนิด AI

- ได้รับ

- GitHub

- กำหนด

- จะช่วยให้

- ได้

- GPU

- GPUs

- การไล่ระดับสี

- มากขึ้น

- พื้น

- มี

- มือ

- เทียม

- มี

- he

- จะช่วยให้

- จุดสูง

- เน้น

- ของเขา

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- อย่างไรก็ตาม

- HTML

- ที่ http

- HTTPS

- เป็นมนุษย์

- i

- identiques

- if

- อิลลินอยส์

- ส่งผลกระทบ

- นำเข้า

- สำคัญ

- ปรับปรุง

- การปรับปรุง

- การปรับปรุง

- ช่วยเพิ่ม

- in

- ประกอบด้วย

- รวมทั้ง

- เพิ่ม

- เพิ่มขึ้น

- ฟักไข่

- ดัชนี

- ดัชนี

- ข้อมูล

- แรกเริ่ม

- นักวิเคราะห์ส่วนบุคคลที่หาโอกาสให้เป็นไปได้มากที่สุด

- อินพุต

- ติดตั้ง

- ตัวอย่าง

- แทน

- คำแนะนำการใช้

- บูรณาการ

- ฉลาด

- สนใจ

- ผลประโยชน์

- เข้าไป

- เปลี่ยว

- IT

- วนซ้ำ

- การย้ำ

- ITS

- ชวา

- JavaScript

- การสัมภาษณ์

- jpeg

- jpg

- JSON

- เก็บ

- เก็บ

- ภาษา

- ภาษา

- ใหญ่

- ส่วนใหญ่

- ชื่อสกุล

- ชั้น

- นำไปสู่

- เรียนรู้

- การเรียนรู้

- ซ้าย

- ความยาว

- น้อยลง

- License

- กดไลก์

- Line

- เส้น

- รายชื่อ

- ดูรายละเอียด

- LLM

- ในประเทศ

- อีกต่อไป

- ดู

- ที่ต้องการหา

- LOOKS

- ปิด

- Lot

- ต่ำ

- เครื่อง

- เรียนรู้เครื่อง

- หลัก

- รักษา

- ทำ

- หลาย

- การจับคู่

- จับคู่

- ที่ตรงกัน

- มดลูก

- สูงสุด

- อาจ..

- me

- วิธี

- หน่วยความจำ

- Meta

- วิธี

- ขั้นต่ำ

- เอ็มไอที

- ML

- แบบ

- โมเดล

- ข้อมูลเพิ่มเติม

- มีประสิทธิภาพมากขึ้น

- มากที่สุด

- เป็นที่นิยม

- หลาย

- ต้อง

- ที่มีชื่อ

- โดยธรรมชาติ

- ประมวลผลภาษาธรรมชาติ

- การเดินเรือ

- จำเป็นต้อง

- เครือข่าย

- ไม่เคย

- ใหม่

- ถัดไป

- NLP

- ไม่

- หมายเหตุ

- สมุดบันทึก

- จำนวน

- ตัวเลข

- of

- on

- ONE

- คน

- เพียง

- เปิด

- โอเพนซอร์ส

- OpenAI

- การเพิ่มประสิทธิภาพ

- การปรับให้เหมาะสม

- ตัวเลือกเสริม (Option)

- or

- ใบสั่ง

- เป็นต้นฉบับ

- อื่นๆ

- มิฉะนั้น

- ของเรา

- ออก

- ที่ระบุไว้

- ประสิทธิภาพเหนือกว่า

- เอาท์พุต

- เอาท์พุท

- เกิน

- ของตนเอง

- หน้า

- บานหน้าต่าง

- กระดาษ

- เอกสาร

- Parallel

- พารามิเตอร์

- พารามิเตอร์

- ส่วนหนึ่ง

- ในสิ่งที่สนใจ

- ผ่าน

- กิเลส

- รูปแบบไฟล์ PDF

- ต่อ

- การปฏิบัติ

- ส่วนตัว

- phd

- PHP

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- กรุณา

- จุด

- ยอดนิยม

- บวก

- โพสต์

- ที่มีศักยภาพ

- การปฏิบัติ

- มาก่อน

- ความแม่นยำ

- เตรียมการ

- นำเสนอ

- ก่อน

- ปัญหา

- การแก้ปัญหา

- ปัญหาที่เกิดขึ้น

- กระบวนการ

- กระบวนการ

- การประมวลผล

- การผลิต

- การเขียนโปรแกรม

- การเขียนโปรแกรมภาษา

- ส่งเสริม

- แจ้ง

- เป็นเจ้าของ

- ให้

- ให้

- ให้

- การให้

- สาธารณชน

- การตีพิมพ์

- วัตถุประสงค์

- หลาม

- ไฟฉาย

- กำลังสอง

- เชิงคุณภาพ

- คุณภาพ

- เชิงปริมาณ

- หนึ่งในสี่

- การสอบถาม

- คำถาม

- ได้เร็วขึ้น

- R

- สุ่ม

- ตั้งแต่

- คะแนน

- อัตราส่วน

- ถึง

- ต้นน้ำ

- เหตุผล

- แนะนำ

- ลด

- การลดลง

- อ้างอิง

- ที่เหลืออยู่

- จำ

- ทำซ้ำ

- รายงาน

- กรุ

- เป็นตัวแทนของ

- จำเป็นต้องใช้

- ความต้องการ

- ต้อง

- การวิจัย

- นักวิจัย

- คำตอบ

- การตอบสนอง

- ผล

- ผลสอบ

- กลับ

- รับคืน

- ขวา

- หุ่นยนต์

- แข็งแรง

- ลวก

- รอบ

- แถว

- ราช

- วิ่ง

- วิ่ง

- s

- sagemaker

- เดียวกัน

- ตัวอย่าง

- ที่บันทึกไว้

- ที่ปรับขนาดได้

- ขนาด

- นักวิทยาศาสตร์

- คะแนน

- สคริปต์

- SDK

- ค้นหา

- ค้นหา

- Section

- ส่วน

- ความปลอดภัย

- เห็น

- เลือก

- การเลือก

- ส่ง

- ระดับอาวุโส

- ลำดับ

- ชุด

- ชุด A

- บริการ

- ชุด

- ชุดอุปกรณ์

- การตั้งค่า

- การตั้งค่า

- แตก

- น่า

- โชว์

- แสดงให้เห็นว่า

- แสดง

- แสดงให้เห็นว่า

- ปิด

- ด้านข้าง

- ลายเซ็น

- สำคัญ

- อย่างมีความหมาย

- ง่าย

- ง่ายดาย

- เดียว

- ขนาด

- ขนาด

- ช้า

- เล็ก

- มีขนาดเล็กกว่า

- So

- สังคม

- ทางออก

- โซลูชัน

- บาง

- แหล่ง

- ผู้เชี่ยวชาญ

- โดยเฉพาะ

- เฉพาะ

- ความเร็ว

- แยก

- มาตรฐาน

- เริ่มต้น

- ที่เริ่มต้น

- การเริ่มต้น

- คำแถลง

- สหรัฐอเมริกา

- ทางสถิติ

- ขั้นตอน

- ขั้นตอน

- ยังคง

- หยุด

- การเก็บรักษา

- จัดเก็บ

- ยุทธศาสตร์

- เชือก

- มุ่งมั่น

- สตูดิโอ

- ประสบความสำเร็จ

- ที่ประสบความสำเร็จ

- อย่างเช่น

- ชุด

- ที่สนับสนุน

- รองรับ

- ที่ยั่งยืน

- ระบบ

- ตาราง

- ใช้เวลา

- งาน

- เทคนิค

- เทคนิค

- เทมเพลต

- เงื่อนไขการใช้บริการ

- ทดสอบ

- การทดสอบ

- การทดสอบ

- กว่า

- ที่

- พื้นที่

- พื้นที่

- พวกเขา

- แล้วก็

- ที่นั่น

- ดังนั้น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- นักคิด

- นี้

- ทั่วถึง

- สาม

- ตลอด

- เวลา

- ไปยัง

- ในวันนี้

- tokenization

- เกินไป

- รวม

- ลู่

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- หม้อแปลง

- จริง

- ความจริง

- ลอง

- สอง

- ชนิด

- ชนิด

- ประเภท

- เป็นปกติ

- ui

- ภายใต้

- หน่วย

- มหาวิทยาลัย

- จนกระทั่ง

- บันทึก

- ให้กับคุณ

- การปรับปรุง

- us

- ใช้

- มือสอง

- ใช้

- การใช้

- ถูกต้อง

- การตรวจสอบ

- ความคุ้มค่า

- ความคุ้มค่า

- ตัวแปร

- ต่างๆ

- แตกต่างกัน

- พาหนะ

- รุ่น

- มาก

- ผ่านทาง

- เดิน

- ต้องการ

- คือ

- วิธี

- we

- เว็บ

- บริการเว็บ

- ดี

- เมื่อ

- ว่า

- ที่

- ในขณะที่

- ทั้งหมด

- จะ

- กับ

- ไม่มี

- ผู้ปฏิบัติงาน

- แรงงาน

- การทำงาน

- โรงงาน

- คุณ

- ของคุณ

- ลมทะเล