วันนี้เรารู้สึกตื่นเต้นที่ได้ประกาศความสามารถในการปรับแต่งโมเดล Llama 2 โดยใช้ Meta Amazon SageMaker JumpStart. กลุ่มโมเดลภาษาขนาดใหญ่ (LLM) ตระกูล Llama 2 คือชุดของโมเดลข้อความที่สร้างไว้ล่วงหน้าและปรับแต่งอย่างละเอียด โดยมีขนาดตั้งแต่ 7 พันล้านถึง 70 พันล้านพารามิเตอร์ LLM ที่ได้รับการปรับแต่งอย่างละเอียดเรียกว่า Llama-2-chat ได้รับการปรับให้เหมาะสมสำหรับกรณีการใช้งานบทสนทนา คุณสามารถลองใช้โมเดลเหล่านี้ได้อย่างง่ายดายและใช้กับ SageMaker JumpStart ซึ่งเป็นฮับแมชชีนเลิร์นนิง (ML) ที่ให้การเข้าถึงอัลกอริทึม โมเดล และโซลูชัน ML เพื่อให้คุณสามารถเริ่มต้นใช้งาน ML ได้อย่างรวดเร็ว ขณะนี้ คุณยังสามารถปรับแต่งโมเดลการสร้างข้อความ Llama 7 ของพารามิเตอร์ 13 พันล้าน, 70 พันล้าน และ 2 พันล้านบน SageMaker JumpStart โดยใช้ สตูดิโอ Amazon SageMaker UI เพียงไม่กี่คลิกหรือใช้ SageMaker Python SDK

โมเดลพื้นฐาน Generative AI เป็นจุดสนใจของ ML และการวิจัยปัญญาประดิษฐ์และกรณีการใช้งานส่วนใหญ่มานานกว่าหนึ่งปีแล้ว โมเดลพื้นฐานเหล่านี้ทำงานได้ดีมากกับงานสร้างสรรค์ เช่น การสร้างข้อความ การสรุป การตอบคำถาม การสร้างรูปภาพและวิดีโอ และอื่นๆ เนื่องจากโมเดลมีขนาดใหญ่และยังได้รับการฝึกฝนบนชุดข้อมูลขนาดใหญ่หลายชุดและงานหลายร้อยงาน แม้ว่าโมเดลเหล่านี้จะมีความสามารถในการสรุปข้อมูลทั่วไปที่ยอดเยี่ยม แต่มักจะมีกรณีการใช้งานที่มีข้อมูลโดเมนที่เฉพาะเจาะจงมาก (เช่น การดูแลสุขภาพหรือบริการทางการเงิน) เนื่องจากโมเดลเหล่านี้อาจไม่สามารถให้ผลลัพธ์ที่ดีสำหรับกรณีการใช้งานเหล่านี้ได้ ส่งผลให้เกิดความจำเป็นในการปรับแต่งโมเดล AI เชิงสร้างสรรค์เพิ่มเติมเพิ่มเติมเกี่ยวกับข้อมูลเฉพาะกรณีการใช้งานและข้อมูลเฉพาะโดเมน

ในโพสต์นี้ เราจะอธิบายวิธีปรับแต่งโมเดลการสร้างข้อความที่ได้รับการฝึกอบรมล่วงหน้าของ Llama 2 ผ่าน SageMaker JumpStart

ลามะ 2 คืออะไร

Llama 2 เป็นโมเดลภาษาถอยหลังอัตโนมัติที่ใช้สถาปัตยกรรมหม้อแปลงที่ปรับให้เหมาะสม Llama 2 มีไว้สำหรับใช้ในเชิงพาณิชย์และการวิจัยเป็นภาษาอังกฤษ มีขนาดพารามิเตอร์หลายขนาด ได้แก่ 7 พันล้าน 13 พันล้าน และ 70 พันล้าน ตลอดจนรูปแบบต่างๆ ที่ผ่านการฝึกอบรมและปรับแต่งอย่างละเอียด จากข้อมูลของ Meta เวอร์ชันที่ปรับแต่งจะใช้การปรับแบบละเอียดภายใต้การดูแล (SFT) และการเรียนรู้แบบเสริมแรงด้วยคำติชมของมนุษย์ (RLHF) เพื่อให้สอดคล้องกับความชอบของมนุษย์ในด้านความช่วยเหลือและความปลอดภัย Llama 2 ได้รับการฝึกอบรมล่วงหน้าโดยใช้ข้อมูล 2 ล้านล้านโทเค็นจากแหล่งข้อมูลสาธารณะ โมเดลที่ได้รับการปรับแต่งมีไว้สำหรับการแชทแบบผู้ช่วย ในขณะที่โมเดลที่ผ่านการฝึกอบรมล่วงหน้าสามารถปรับให้เหมาะกับงานสร้างภาษาธรรมชาติที่หลากหลาย ไม่ว่านักพัฒนาจะใช้โมเดลรุ่นใดก็ตาม คู่มือการใช้งานอย่างรับผิดชอบจาก Meta สามารถช่วยแนะนำการปรับละเอียดเพิ่มเติมที่อาจจำเป็นในการปรับแต่งและเพิ่มประสิทธิภาพโมเดลด้วยการบรรเทาความปลอดภัยที่เหมาะสม

ปัจจุบัน Llama 2 มีให้บริการในภูมิภาคต่อไปนี้:

- ปรับใช้โมเดลที่ได้รับการฝึกอบรมล่วงหน้าแล้ว:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - ปรับแต่งและปรับใช้โมเดลที่ได้รับการปรับแต่งอย่างละเอียด:

“us-east-1”,“us-west-2”,“eu-west-1”

SageMaker JumpStart คืออะไร

ด้วย SageMaker JumpStart ผู้ปฏิบัติงาน ML สามารถเลือกจากแบบจำลองพื้นฐานที่เปิดเผยต่อสาธารณะได้หลากหลาย ผู้ปฏิบัติงาน ML สามารถปรับใช้โมเดลพื้นฐานเพื่อการใช้งานเฉพาะได้ อเมซอน SageMaker อินสแตนซ์จากสภาพแวดล้อมที่แยกเครือข่ายและปรับแต่งโมเดลโดยใช้ SageMaker สำหรับการฝึกโมเดลและการปรับใช้ ตอนนี้คุณสามารถค้นพบและปรับใช้ Llama 2 ได้ด้วยการคลิกเพียงไม่กี่ครั้งใน SageMaker Studio หรือโดยทางโปรแกรมผ่าน SageMaker Python SDK ทำให้คุณได้รับประสิทธิภาพของโมเดลและการควบคุม MLOps ด้วยคุณสมบัติของ SageMaker เช่น ท่อส่ง Amazon SageMaker, ดีบักเกอร์ Amazon SageMakerหรือบันทึกคอนเทนเนอร์ โมเดลนี้ได้รับการปรับใช้ในสภาพแวดล้อมที่ปลอดภัยของ AWS และอยู่ภายใต้การควบคุม VPC ของคุณ ซึ่งช่วยรับรองความปลอดภัยของข้อมูล นอกจากนี้ คุณยังสามารถปรับแต่งโมเดลการสร้างข้อความที่ได้รับการฝึกล่วงหน้า Llama2 7B, 13B และ 70B ได้อย่างละเอียดผ่าน SageMaker JumpStart

ปรับแต่งโมเดล Llama2

คุณสามารถปรับแต่งโมเดลได้โดยใช้ SageMaker Studio UI หรือ SageMaker Python SDK เราจะหารือทั้งสองวิธีในส่วนนี้

การปรับแต่งแบบละเอียดโดยไม่ต้องใช้โค้ดผ่าน SageMaker Studio UI

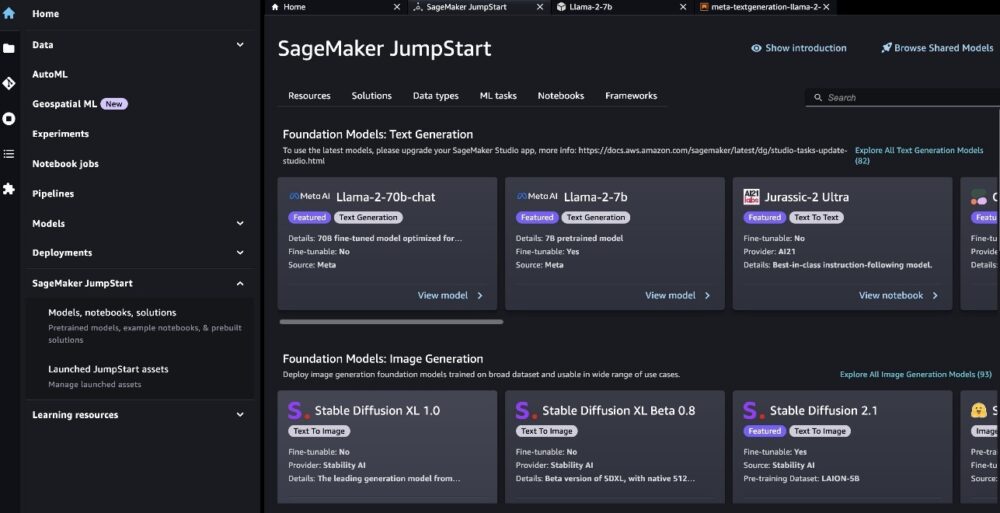

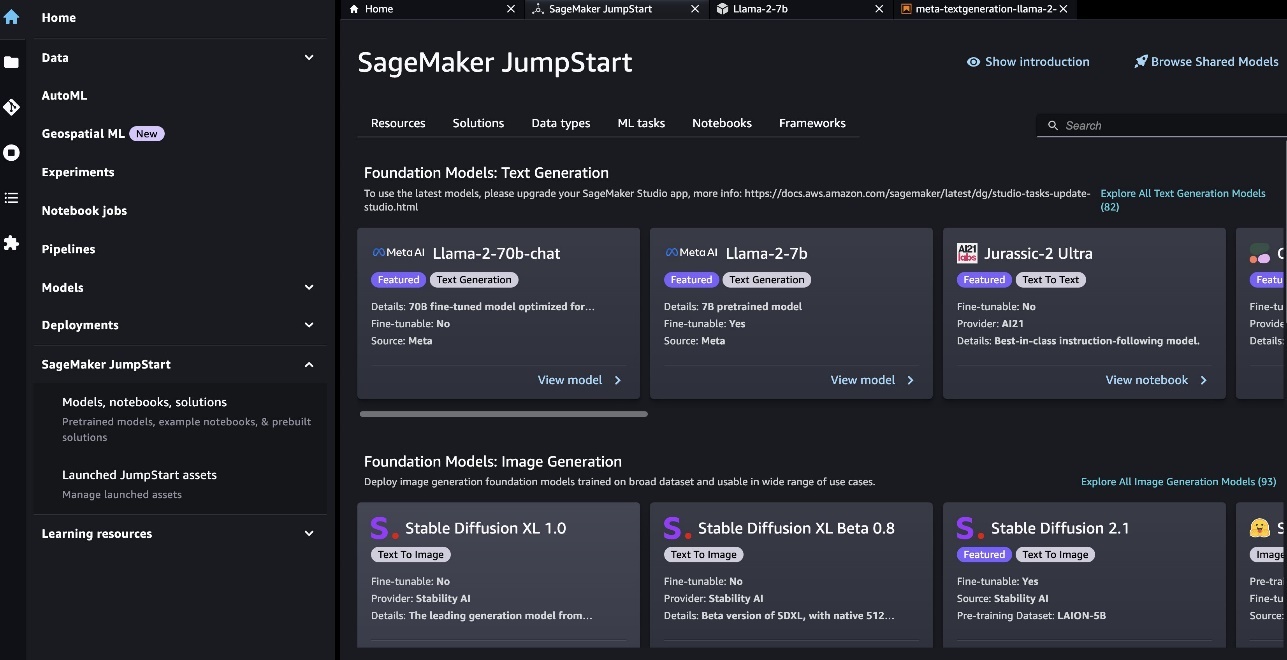

ใน SageMaker Studio คุณสามารถเข้าถึงโมเดล Llama 2 ผ่าน SageMaker JumpStart ด้านล่าง รุ่น โน้ตบุ๊ก และโซลูชันดังแสดงในภาพหน้าจอต่อไปนี้

หากคุณไม่เห็นโมเดล Llama 2 ให้อัปเดตเวอร์ชัน SageMaker Studio ของคุณโดยปิดเครื่องแล้วรีสตาร์ท สำหรับข้อมูลเพิ่มเติมเกี่ยวกับการอัพเดตเวอร์ชัน โปรดดูที่ ปิดและอัปเดตแอป Studio.

คุณยังสามารถค้นหารูปแบบรุ่นอื่นๆ อีกสี่รุ่นได้โดยเลือก สำรวจโมเดลการสร้างข้อความทั้งหมด หรือค้นหาลามะในช่องค้นหา

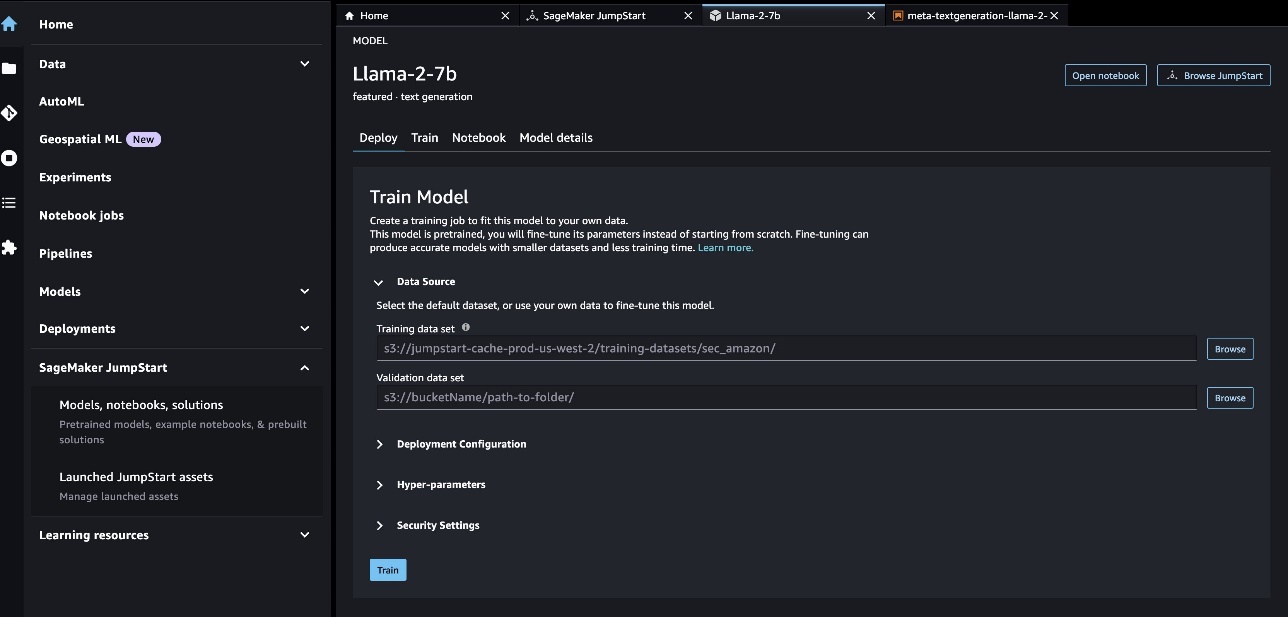

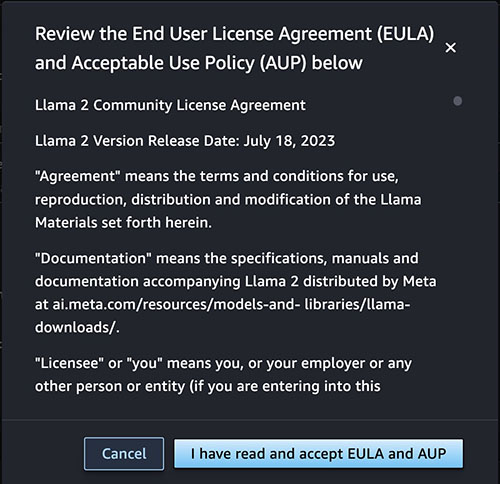

ในหน้านี้คุณสามารถชี้ไปที่ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon บัคเก็ต (Amazon S3) ที่ประกอบด้วยชุดข้อมูลการฝึกอบรมและการตรวจสอบเพื่อการปรับแต่งอย่างละเอียด นอกจากนี้ คุณยังสามารถกำหนดค่าการกำหนดค่าการปรับใช้ ไฮเปอร์พารามิเตอร์ และการตั้งค่าความปลอดภัยสำหรับการปรับแต่งอย่างละเอียดได้ จากนั้นคุณสามารถเลือกได้ รถไฟ เพื่อเริ่มงานการฝึกอบรมบนอินสแตนซ์ SageMaker ML ภาพหน้าจอก่อนหน้านี้แสดงหน้าการปรับแต่งอย่างละเอียดสำหรับรุ่น Llama-2 7B อย่างไรก็ตาม คุณสามารถปรับแต่งโมเดลการสร้างข้อความ Llama 13 70B และ 2B ได้อย่างละเอียดโดยใช้หน้าโมเดลตามลำดับในทำนองเดียวกัน หากต้องการใช้โมเดล Llama 2 คุณต้องยอมรับข้อตกลงสิทธิ์การใช้งานสำหรับผู้ใช้ปลายทาง (EULA) มันจะปรากฏขึ้นเมื่อคุณเมื่อคุณเลือก รถไฟดังที่แสดงในภาพหน้าจอต่อไปนี้ เลือก ฉันได้อ่านและยอมรับ EULA และ AUP แล้ว เพื่อเริ่มงานปรับแต่ง

ปรับใช้โมเดล

หลังจากปรับแต่งโมเดลอย่างละเอียดแล้ว คุณสามารถปรับใช้ได้โดยใช้หน้าโมเดลบน SageMaker JumpStart ตัวเลือกในการปรับใช้แบบจำลองที่ปรับแต่งอย่างละเอียดจะปรากฏขึ้นเมื่อการปรับแต่งแบบละเอียดเสร็จสิ้น ดังที่แสดงในภาพหน้าจอต่อไปนี้

ปรับแต่งอย่างละเอียดผ่าน SageMaker Python SDK

คุณยังสามารถปรับแต่งโมเดล Llama 2 ได้อย่างละเอียดโดยใช้ SageMaker Python SDK ต่อไปนี้เป็นโค้ดตัวอย่างเพื่อปรับแต่ง Llama 2 7B บนชุดข้อมูลของคุณ:

คุณสามารถปรับใช้โมเดลที่ได้รับการปรับแต่งอย่างละเอียดได้โดยตรงจากตัวประมาณค่า:

คุณยังสามารถค้นหารหัสได้ใน ปรับแต่งโมเดล LLaMA 2 บน SageMaker JumpStart. ประกอบด้วยการเตรียมชุดข้อมูล การฝึกอบรมชุดข้อมูลที่คุณกำหนดเอง และการปรับใช้โมเดลที่ได้รับการปรับแต่งอย่างละเอียด โดยสาธิตการปรับแต่งอย่างละเอียดบนชุดย่อยของชุดข้อมูล Dolly พร้อมตัวอย่างจากงานสรุป ต่อไปนี้คือตัวอย่างอินพุตพร้อมการตอบสนองจากแบบละเอียดและแบบไม่ปรับแต่งพร้อมกับการตอบสนองตามความจริงภาคพื้นดิน:

ป้อนข้อมูลให้กับโมเดล:

การตอบสนองจากความจริงพื้นฐาน:

การตอบสนองจากโมเดลที่ไม่ได้ปรับแต่ง:

การตอบสนองจากโมเดลที่ได้รับการปรับแต่ง:

สำหรับการเปรียบเทียบประสิทธิภาพของรุ่นต่างๆ บนชุดข้อมูล Dolly และ Dialogsum โปรดดูที่ การเปรียบเทียบประสิทธิภาพ ในภาคผนวกท้ายโพสต์นี้

เทคนิคการปรับแต่งแบบละเอียด

โมเดลภาษาเช่น Llama มีขนาดมากกว่า 10 GB หรือ 100 GB การปรับแต่งโมเดลขนาดใหญ่ดังกล่าวอย่างละเอียดต้องใช้อินสแตนซ์ที่มีหน่วยความจำ CUDA สูงอย่างมาก นอกจากนี้ การฝึกโมเดลเหล่านี้อาจทำได้ช้ามากเนื่องจากขนาดของโมเดล ดังนั้น เพื่อการปรับแต่งอย่างมีประสิทธิภาพ เราจึงใช้การเพิ่มประสิทธิภาพต่อไปนี้:

- การปรับตัวระดับต่ำ (LoRA) – นี่คือการปรับพารามิเตอร์แบบละเอียดที่มีประสิทธิภาพ (PEFT) ประเภทหนึ่งสำหรับการปรับแบบละเอียดอย่างมีประสิทธิภาพสำหรับรุ่นขนาดใหญ่ ในที่นี้ เราหยุดทั้งโมเดลและเพิ่มพารามิเตอร์หรือเลเยอร์ที่ปรับได้ชุดเล็กๆ ลงในโมเดลเท่านั้น ตัวอย่างเช่น แทนที่จะฝึกพารามิเตอร์ทั้งหมด 7 พันล้านพารามิเตอร์สำหรับ Llama 2 7B เราสามารถปรับแต่งพารามิเตอร์ได้น้อยกว่า 1% ซึ่งจะช่วยลดความต้องการหน่วยความจำได้อย่างมาก เนื่องจากเราจำเป็นต้องจัดเก็บการไล่ระดับสี สถานะเครื่องมือเพิ่มประสิทธิภาพ และข้อมูลอื่นๆ ที่เกี่ยวข้องกับการฝึกอบรมเพียง 1% ของพารามิเตอร์เท่านั้น นอกจากนี้ยังช่วยลดเวลาการฝึกอบรมและค่าใช้จ่ายอีกด้วย สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับวิธีการนี้ โปรดดูที่ LoRA: การปรับตัวในระดับต่ำของโมเดลภาษาขนาดใหญ่.

- การหาปริมาณ Int8 – แม้จะมีการปรับปรุงประสิทธิภาพ เช่น LoRA แต่โมเดลอย่าง Llama 70B ก็ยังใหญ่เกินกว่าจะฝึกได้ เพื่อลดพื้นที่หน่วยความจำระหว่างการฝึก เราสามารถใช้การวัดปริมาณ Int8 ในระหว่างการฝึกได้ โดยทั่วไปการหาปริมาณจะลดความแม่นยำของประเภทข้อมูลจุดลอยตัว แม้ว่าการทำเช่นนี้จะลดหน่วยความจำที่จำเป็นในการจัดเก็บน้ำหนักโมเดล แต่ประสิทธิภาพก็ลดลงเนื่องจากข้อมูลสูญหาย การหาปริมาณ Int8 ใช้ความแม่นยำเพียงหนึ่งในสี่เท่านั้น แต่ไม่ได้ทำให้ประสิทธิภาพลดลง เนื่องจากไม่ได้ทำให้บิตลดลง มันจะปัดเศษข้อมูลจากประเภทหนึ่งไปอีกประเภทหนึ่ง หากต้องการเรียนรู้เกี่ยวกับการหาปริมาณ Int8 โปรดดูที่ LLM.int8(): การคูณเมทริกซ์ 8 บิตสำหรับ Transformers ตามขนาด.

- ข้อมูลแบบขนานที่แบ่งใช้อย่างสมบูรณ์ (FSDP) – นี่คืออัลกอริธึมการฝึกอบรมข้อมูลแบบคู่ขนานประเภทหนึ่งที่แบ่งพารามิเตอร์ของโมเดลให้กับผู้ปฏิบัติงานแบบขนานข้อมูล และสามารถเลือกถ่ายส่วนหนึ่งของการคำนวณการฝึกอบรมไปยัง CPU ได้ แม้ว่าพารามิเตอร์จะถูกแบ่งส่วนใน GPU ที่แตกต่างกัน แต่การคำนวณของไมโครแบทช์แต่ละรายการจะอยู่ในเครื่องของผู้ปฏิบัติงาน GPU โดยแบ่งส่วนพารามิเตอร์ให้มีความสม่ำเสมอมากขึ้น และบรรลุประสิทธิภาพที่ได้รับการปรับปรุงให้เหมาะสมผ่านการสื่อสารและการคำนวณที่ทับซ้อนกันระหว่างการฝึก

ตารางต่อไปนี้เปรียบเทียบวิธีการต่างๆ กับ Llama 2 ทั้งสามรุ่น

| , | ประเภทอินสแตนซ์เริ่มต้น | ประเภทอินสแตนซ์ที่รองรับพร้อมการกำหนดค่าเริ่มต้น | การตั้งค่าเริ่มต้น | ลอรา + FSDP | LORA + ไม่มี FSDP | การหาปริมาณ Int8 + LORA + ไม่มี FSDP |

| ลามะ 2 7B | มล.g5.12xlarge | มล.g5.12xlarge, มล.g5.24xlarge, มล.g5.48xlarge | ลอรา + FSDP | ใช่ | ใช่ | ใช่ |

| ลามะ 2 13B | มล.g5.12xlarge | มล.g5.24xlarge, มล.g5.48xlarge | ลอรา + FSDP | ใช่ | ใช่ | ใช่ |

| ลามะ 2 70B | มล.g5.48xlarge | มล.g5.48xlarge | INT8 + LORA + ไม่มี FSDP | ไม่ | ไม่ | ใช่ |

โปรดทราบว่าการปรับแต่งโมเดล Llama อย่างละเอียดนั้นขึ้นอยู่กับสคริปต์ที่ให้ไว้ดังต่อไปนี้ repo GitHub.

รูปแบบชุดข้อมูลการฝึกอบรม

ปัจจุบัน SageMaker JumpStart รองรับชุดข้อมูลทั้งในรูปแบบการปรับโดเมนและรูปแบบการปรับแต่งคำสั่ง ในส่วนนี้ เราระบุชุดข้อมูลตัวอย่างในทั้งสองรูปแบบ สำหรับรายละเอียดเพิ่มเติม โปรดดูที่ การจัดรูปแบบชุดข้อมูล ส่วนในภาคผนวก

รูปแบบการปรับโดเมน

โมเดล Llama 2 การสร้างข้อความสามารถปรับแต่งได้อย่างละเอียดบนชุดข้อมูลเฉพาะโดเมนใดๆ หลังจากปรับแต่งชุดข้อมูลเฉพาะโดเมนอย่างละเอียดแล้ว โมเดลดังกล่าวคาดว่าจะสร้างข้อความเฉพาะโดเมนและแก้ไขงาน NLP ต่างๆ ในโดเมนเฉพาะนั้นด้วยการแจ้งเตือนเพียงไม่กี่ช็อต ด้วยชุดข้อมูลนี้ อินพุตจะประกอบด้วยไฟล์ CSV, JSON หรือ TXT ตัวอย่างเช่น ข้อมูลอินพุตอาจเป็นเอกสารที่ยื่นต่อ SEC ของ Amazon ในรูปแบบไฟล์ข้อความ:

รูปแบบการปรับแต่งคำสั่ง

ในการปรับแต่งคำสั่งอย่างละเอียด โมเดลจะได้รับการปรับแต่งอย่างละเอียดสำหรับชุดงานการประมวลผลภาษาธรรมชาติ (NLP) ที่อธิบายโดยใช้คำแนะนำ ซึ่งจะช่วยปรับปรุงประสิทธิภาพของโมเดลสำหรับงานที่มองไม่เห็นด้วยการแจ้งเตือนแบบ Zero-Shot ในรูปแบบชุดข้อมูลการปรับแต่งคำสั่ง คุณระบุ template.json ไฟล์อธิบายรูปแบบอินพุตและเอาต์พุต เช่น แต่ละบรรทัดในไฟล์ train.jsonl มีลักษณะดังนี้:

ไฟล์เพิ่มเติม template.json มีลักษณะดังนี้:

ไฮเปอร์พารามิเตอร์ที่รองรับสำหรับการฝึก

การปรับแต่ง Llama 2 อย่างละเอียดรองรับไฮเปอร์พารามิเตอร์จำนวนหนึ่ง ซึ่งแต่ละพารามิเตอร์สามารถส่งผลกระทบต่อความต้องการหน่วยความจำ ความเร็วในการฝึกฝน และประสิทธิภาพของโมเดลที่ได้รับการปรับแต่ง:

- ยุค – จำนวนรอบที่อัลกอริธึมการปรับแต่งแบบละเอียดใช้ผ่านชุดข้อมูลการฝึก ต้องเป็นจำนวนเต็มที่มากกว่า 1 ค่าเริ่มต้นคือ 5

- อัตราการเรียนรู้ – อัตราการอัปเดตน้ำหนักแบบจำลองหลังจากทำงานผ่านตัวอย่างการฝึกอบรมแต่ละชุด จะต้องมีค่าทศนิยมเป็นบวกมากกว่า 0 ค่าเริ่มต้นคือ 1e-4

- Instruction_tuned – ไม่ว่าจะสั่งสอน-เทรนโมเดลหรือไม่ก็ตาม ต้องเป็น'

True' หรือ 'False'. ค่าเริ่มต้นคือ 'False' - ต่อ_อุปกรณ์_train_batch_size – ขนาดแบตช์ต่อคอร์ GPU/CPU สำหรับการฝึก ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 4

- ต่อ_อุปกรณ์_eval_batch_size – ขนาดแบตช์ต่อคอร์ GPU/CPU สำหรับการประเมิน ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 1

- max_train_samples – เพื่อวัตถุประสงค์ในการแก้ไขจุดบกพร่องหรือการฝึกที่รวดเร็วขึ้น ให้ตัดจำนวนตัวอย่างการฝึกให้เหลือเพียงค่านี้ ค่า -1 หมายถึง การใช้ตัวอย่างการฝึกทั้งหมด ต้องเป็นจำนวนเต็มบวกหรือ -1 ค่าเริ่มต้นคือ -1

- max_val_samples – เพื่อวัตถุประสงค์ในการแก้ไขจุดบกพร่องหรือการฝึกอบรมที่รวดเร็วยิ่งขึ้น ให้ตัดจำนวนตัวอย่างการตรวจสอบความถูกต้องให้เหลือเพียงค่านี้ ค่า -1 หมายถึงการใช้ตัวอย่างการตรวจสอบความถูกต้องทั้งหมด ต้องเป็นจำนวนเต็มบวกหรือ -1 ค่าเริ่มต้นคือ -1

- max_input_length – ความยาวลำดับอินพุตทั้งหมดสูงสุดหลังโทเค็น ลำดับที่นานกว่านี้จะถูกตัดทอน ถ้า -1,

max_input_lengthถูกตั้งค่าเป็นขั้นต่ำ 1024 และความยาวโมเดลสูงสุดที่กำหนดโดยโทเค็นไนเซอร์ หากตั้งค่าเป็นค่าบวกmax_input_lengthถูกตั้งค่าเป็นขั้นต่ำของค่าที่ให้ไว้และmodel_max_lengthกำหนดโดยโทเค็นไนเซอร์ ต้องเป็นจำนวนเต็มบวกหรือ -1 ค่าเริ่มต้นคือ -1 - validation_split_ratio – หากช่องทางการตรวจสอบเป็น

noneอัตราส่วนของการแยกการตรวจสอบความถูกต้องของรถไฟจากข้อมูลรถไฟจะต้องอยู่ระหว่าง 0–1 ค่าเริ่มต้นคือ 0.2 - train_data_split_seed – หากไม่มีข้อมูลการตรวจสอบความถูกต้อง การดำเนินการนี้จะแก้ไขการแยกข้อมูลการฝึกอบรมอินพุตแบบสุ่มไปยังข้อมูลการฝึกอบรมและการตรวจสอบความถูกต้องที่ใช้โดยอัลกอริทึม ต้องเป็นจำนวนเต็ม ค่าเริ่มต้นคือ 0

- preprocessing_num_workers – จำนวนกระบวนการที่จะใช้สำหรับการประมวลผลล่วงหน้า ถ้า

Noneกระบวนการหลักใช้สำหรับการประมวลผลล่วงหน้า ค่าเริ่มต้นคือNone. - ลอร่า_อาร์ – Lora R. ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 8

- ลอรา_อัลฟา – ลอร่า อัลฟ่า ต้องเป็นจำนวนเต็มบวก ค่าเริ่มต้นคือ 32

- lora_dropout – ลอรา ดรอปเอาท์ จะต้องมีค่าทศนิยมเป็นบวกระหว่าง 0 ถึง 1 ค่าเริ่มต้นคือ 0.05

- int8_quantization - ถ้า

Trueโมเดลนี้โหลดด้วยความแม่นยำ 8 บิตสำหรับการฝึก ค่าเริ่มต้นสำหรับ 7B และ 13B คือFalse. ค่าเริ่มต้นสำหรับ 70B คือTrue. - Enable_fsdp - ถ้า

True, การฝึกอบรมใช้ FSDP ค่าเริ่มต้นสำหรับ 7B และ 13B คือTrue. ค่าเริ่มต้นสำหรับ 70B คือFalse. สังเกตได้ว่าint8_quantizationไม่รองรับ FSDP

ประเภทอินสแตนซ์และไฮเปอร์พารามิเตอร์ที่เข้ากันได้

ความต้องการหน่วยความจำระหว่างการปรับแต่งอาจแตกต่างกันไปขึ้นอยู่กับปัจจัยหลายประการ:

- ประเภทรุ่น – รุ่น 7B มีความต้องการหน่วยความจำ GPU น้อยที่สุด และ 70B มีความต้องการหน่วยความจำที่ใหญ่ที่สุด

- ความยาวอินพุตสูงสุด – ค่าความยาวอินพุตที่สูงกว่าจะนำไปสู่การประมวลผลโทเค็นมากขึ้นในแต่ละครั้ง และด้วยเหตุนี้จึงต้องใช้หน่วยความจำ CUDA มากขึ้น

- ขนาดแบทช์ – ขนาดแบตช์ที่ใหญ่ขึ้นต้องใช้หน่วยความจำ CUDA ที่ใหญ่กว่า ดังนั้นจึงต้องใช้ประเภทอินสแตนซ์ที่ใหญ่กว่า

- การหาปริมาณ Int8 – หากใช้การหาปริมาณ Int8 โมเดลจะถูกโหลดด้วยความแม่นยำต่ำ ดังนั้นจึงต้องใช้หน่วยความจำ CUDA น้อยลง

เพื่อช่วยคุณในการเริ่มต้น เรามีชุดการผสมผสานระหว่างประเภทอินสแตนซ์ ไฮเปอร์พารามิเตอร์ และประเภทโมเดลต่างๆ ที่สามารถปรับแต่งได้อย่างละเอียด คุณสามารถเลือกการกำหนดค่าได้ตามความต้องการและความพร้อมใช้งานของประเภทอินสแตนซ์ เราปรับแต่งโมเดลทั้งสามอย่างละเอียดในการตั้งค่าที่หลากหลายด้วยสามยุคในชุดย่อยของชุดข้อมูล Dolly พร้อมตัวอย่างการสรุป

รุ่น 7B

ตารางต่อไปนี้สรุปตัวเลือกการปรับแต่งอย่างละเอียดในรุ่น 7B

| ประเภทอินสแตนซ์ | เลนอินพุตสูงสุด | ต่อขนาดชุดอุปกรณ์ | การหาปริมาณ Int8 | เปิดใช้งาน FSDP | เวลาที่ใช้ (นาที) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | FALSE | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSE | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | FALSE | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | FALSE | TRUE | 143 |

| มล.g5.2xlarge | 1024 | 4 | TRUE | FALSE | 61 |

| มล.g5.2xlarge | 2048 | 2 | TRUE | FALSE | 68 |

| มล.g5.2xlarge | 1024 | 4 | FALSE | TRUE | 43 |

| มล.g5.2xlarge | 2048 | 2 | FALSE | TRUE | 49 |

| มล.g5.4xlarge | 1024 | 4 | FALSE | TRUE | 39 |

| มล.g5.4xlarge | 2048 | 2 | FALSE | TRUE | 50 |

| มล.g5.12xlarge | 1024 | 16 | TRUE | FALSE | 57 |

| มล.g5.12xlarge | 2048 | 4 | TRUE | FALSE | 64 |

| มล.g5.12xlarge | 1024 | 4 | FALSE | TRUE | 26 |

| มล.g5.12xlarge | 2048 | 4 | FALSE | TRUE | 23 |

| มล.g5.48xlarge | 1024 | 16 | TRUE | FALSE | 59 |

| มล.g5.48xlarge | 2048 | 4 | TRUE | FALSE | 67 |

| มล.g5.48xlarge | 1024 | 8 | FALSE | TRUE | 22 |

| มล.g5.48xlarge | 2048 | 4 | FALSE | TRUE | 21 |

13B

ตารางต่อไปนี้สรุปตัวเลือกการปรับแต่งอย่างละเอียดในรุ่น 13B

| ประเภทอินสแตนซ์ | เลนอินพุตสูงสุด | ต่อขนาดชุดอุปกรณ์ | การหาปริมาณ Int8 | เปิดใช้งาน FSDP | เวลาที่ใช้ (นาที) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | FALSE | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSE | 328 |

| มล.g5.12xlarge | 1024 | 8 | TRUE | FALSE | 92 |

| มล.g5.12xlarge | 2048 | 4 | TRUE | FALSE | 104 |

| มล.g5.48xlarge | 1024 | 8 | TRUE | FALSE | 95 |

| มล.g5.48xlarge | 2048 | 4 | TRUE | FALSE | 107 |

| มล.g5.48xlarge | 1024 | 8 | FALSE | TRUE | 35 |

| มล.g5.48xlarge | 2048 | 2 | FALSE | TRUE | 41 |

70B

ตารางต่อไปนี้สรุปตัวเลือกการปรับแต่งอย่างละเอียดในรุ่น 70B

| ประเภทอินสแตนซ์ | เลนอินพุตสูงสุด | ต่อขนาดชุดอุปกรณ์ | การหาปริมาณ Int8 | เปิดใช้งาน FSDP | เวลาที่ใช้ (นาที) |

| มล.g5.48xlarge | 1024 | 4 | TRUE | FALSE | 396 |

| มล.g5.48xlarge | 2048 | 1 | TRUE | FALSE | 454 |

คำแนะนำเกี่ยวกับประเภทอินสแตนซ์และไฮเปอร์พารามิเตอร์

เมื่อปรับแต่งความแม่นยำของโมเดลอย่างละเอียด โปรดคำนึงถึงสิ่งต่อไปนี้:

- รุ่นขนาดใหญ่เช่น 70B ให้ประสิทธิภาพที่ดีกว่า 7B

- ประสิทธิภาพที่ไม่มีการหาปริมาณ Int8 ดีกว่าประสิทธิภาพที่มีการหาปริมาณ INT8

โปรดสังเกตข้อกำหนดด้านเวลาการฝึกอบรมและหน่วยความจำ CUDA ต่อไปนี้:

- การตั้งค่า

int8_quantization=Trueลดความต้องการความจำและนำไปสู่การฝึกที่เร็วขึ้น - ลดลง

per_device_train_batch_sizeและmax_input_lengthลดความต้องการหน่วยความจำและสามารถเรียกใช้บนอินสแตนซ์ขนาดเล็กได้ อย่างไรก็ตาม การตั้งค่าที่ต่ำมากอาจเพิ่มเวลาการฝึก - หากคุณไม่ได้ใช้การหาปริมาณ Int8 (

int8_quantization=False) ใช้ FSDP (enable_fsdp=True) เพื่อการฝึกอบรมที่รวดเร็วและมีประสิทธิภาพ

เมื่อเลือกประเภทอินสแตนซ์ ให้พิจารณาสิ่งต่อไปนี้:

- อินสแตนซ์ G5 ให้การฝึกอบรมที่มีประสิทธิภาพมากที่สุดในบรรดาประเภทอินสแตนซ์ที่รองรับ ดังนั้น หากคุณมีอินสแตนซ์ G5 คุณก็ควรใช้อินสแตนซ์เหล่านั้น

- เวลาการฝึกอบรมส่วนใหญ่ขึ้นอยู่กับจำนวน GPU และหน่วยความจำ CUDA ที่พร้อมใช้งาน ดังนั้น การฝึกบนอินสแตนซ์ที่มี GPU จำนวนเท่ากัน (เช่น ml.g5.2xlarge และ ml.g5.4xlarge) จึงใกล้เคียงกันโดยประมาณ ดังนั้น คุณสามารถใช้อินสแตนซ์ที่ถูกกว่าสำหรับการฝึกได้ (ml.g5.2xlarge)

- เมื่อใช้อินสแตนซ์ p3 การฝึกจะดำเนินการด้วยความแม่นยำ 32 บิต เนื่องจากอินสแตนซ์เหล่านี้ไม่รองรับ bfloat16 ดังนั้น งานการฝึกจะใช้จำนวนหน่วยความจำ CUDA เป็นสองเท่าเมื่อฝึกบนอินสแตนซ์ p3 เมื่อเทียบกับอินสแตนซ์ g5

หากต้องการเรียนรู้เกี่ยวกับค่าใช้จ่ายในการฝึกอบรมต่ออินสแตนซ์ โปรดดูที่ Amazon EC2 G5 อินสแตนซ์.

หากชุดข้อมูลอยู่ในรูปแบบการปรับแต่งคำสั่งและลำดับอินพุต+การทำให้สมบูรณ์มีขนาดเล็ก (เช่น 50–100 คำ) ดังนั้นค่าที่สูงคือ max_input_length ส่งผลให้ประสิทธิภาพการทำงานแย่มาก ค่าเริ่มต้นของพารามิเตอร์นี้คือ -1 ซึ่งสอดคล้องกับ max_input_length ประจำปี 2048 สำหรับรุ่น Llama ดังนั้น เราขอแนะนำว่าหากชุดข้อมูลของคุณมีตัวอย่างขนาดเล็ก ให้ใช้ค่าเล็กน้อยสำหรับ max_input_length (เช่น 200–400)

สุดท้ายนี้ เนื่องจากมีความต้องการอินสแตนซ์ G5 สูง คุณอาจพบว่าอินสแตนซ์เหล่านี้ไม่พร้อมใช้งานในภูมิภาคของคุณโดยมีข้อผิดพลาด “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” หากคุณพบข้อผิดพลาดนี้ ให้ลองงานฝึกอบรมอีกครั้งหรือลองใช้ภูมิภาคอื่น

ปัญหาเมื่อทำการปรับแต่งโมเดลที่มีขนาดใหญ่มากอย่างละเอียด

ในส่วนนี้ เราจะพูดถึงสองประเด็นเมื่อปรับแต่งโมเดลที่มีขนาดใหญ่มากอย่างละเอียด

ปิดใช้งานการบีบอัดเอาต์พุต

ตามค่าเริ่มต้น ผลลัพธ์ของงานการฝึกจะเป็นโมเดลที่ได้รับการฝึกซึ่งบีบอัดในรูปแบบ .tar.gz ก่อนที่จะอัปโหลดไปยัง Amazon S3 อย่างไรก็ตามเนื่องจากโมเดลมีขนาดใหญ่ ขั้นตอนนี้อาจใช้เวลานาน ตัวอย่างเช่น การบีบอัดและการอัปโหลดโมเดล 70B อาจใช้เวลานานกว่า 4 ชั่วโมง เพื่อหลีกเลี่ยงปัญหานี้ คุณสามารถใช้คุณลักษณะปิดใช้งานการบีบอัดเอาต์พุตที่รองรับโดยแพลตฟอร์มการฝึกอบรม SageMaker ในกรณีนี้ โมเดลจะถูกอัปโหลดโดยไม่มีการบีบอัดใดๆ ซึ่งนำไปใช้เพิ่มเติมสำหรับการปรับใช้:

ปัญหาการหมดเวลาเคอร์เนลของ SageMaker Studio

เนื่องจากขนาดของรุ่น Llama 70B งานการฝึกอาจใช้เวลาหลายชั่วโมงและเคอร์เนล SageMaker Studio อาจหยุดทำงานในระหว่างระยะการฝึก อย่างไรก็ตาม ในระหว่างนี้ การฝึกอบรมยังคงดำเนินอยู่ใน SageMaker หากเกิดเหตุการณ์นี้ คุณยังคงปรับใช้ตำแหน่งข้อมูลได้โดยใช้ชื่องานการฝึกด้วยรหัสต่อไปนี้:

หากต้องการค้นหาชื่องานการฝึกอบรม ให้ไปที่คอนโซล SageMaker และด้านล่าง การฝึกอบรม ในบานหน้าต่างนำทาง ให้เลือก งานฝึกอบรม. ระบุชื่องานการฝึกอบรมและแทนที่ในรหัสก่อนหน้า

สรุป

ในโพสต์นี้ เราได้พูดคุยถึงการปรับแต่งโมเดล Llama 2 ของ Meta อย่างละเอียดโดยใช้ SageMaker JumpStart เราแสดงให้เห็นว่าคุณสามารถใช้คอนโซล SageMaker JumpStart ใน SageMaker Studio หรือ SageMaker Python SDK เพื่อปรับแต่งและปรับใช้โมเดลเหล่านี้ได้ เรายังกล่าวถึงเทคนิคการปรับแต่งอย่างละเอียด ประเภทอินสแตนซ์ และไฮเปอร์พารามิเตอร์ที่รองรับอีกด้วย นอกจากนี้ เรายังให้คำแนะนำเพื่อเพิ่มประสิทธิภาพการฝึกอบรมโดยอิงจากการทดสอบต่างๆ ที่เราทำ ผลลัพธ์สำหรับการปรับโมเดลทั้งสามแบบอย่างละเอียดบนชุดข้อมูลสองชุดจะแสดงในภาคผนวกท้ายโพสต์นี้ ดังที่เราเห็นจากผลลัพธ์เหล่านี้ การปรับแต่งแบบละเอียดช่วยปรับปรุงการสรุปเมื่อเปรียบเทียบกับโมเดลที่ไม่ได้ปรับแต่งแบบละเอียด ในขั้นตอนถัดไป คุณสามารถลองปรับแต่งโมเดลเหล่านี้บนชุดข้อมูลของคุณเองได้โดยใช้โค้ดที่ให้ไว้ในที่เก็บ GitHub เพื่อทดสอบและเปรียบเทียบผลลัพธ์สำหรับกรณีการใช้งานของคุณ

ผู้เขียนขอขอบคุณการมีส่วนร่วมทางเทคนิคของ Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne และ June วอน.

เกี่ยวกับผู้เขียน

ดร.วิเวก มะดัน เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart เขาสำเร็จการศึกษาระดับปริญญาเอกจากมหาวิทยาลัยอิลลินอยส์ Urbana-Champaign และเป็นนักวิจัยหลังปริญญาเอกที่ Georgia Tech เขาเป็นนักวิจัยเชิงรุกด้านการเรียนรู้ของเครื่องและการออกแบบอัลกอริธึม และได้ตีพิมพ์เอกสารในการประชุม EMNLP, ICLR, COLT, FOCS และ SODA

ดร.วิเวก มะดัน เป็นนักวิทยาศาสตร์ประยุกต์กับทีม Amazon SageMaker JumpStart เขาสำเร็จการศึกษาระดับปริญญาเอกจากมหาวิทยาลัยอิลลินอยส์ Urbana-Champaign และเป็นนักวิจัยหลังปริญญาเอกที่ Georgia Tech เขาเป็นนักวิจัยเชิงรุกด้านการเรียนรู้ของเครื่องและการออกแบบอัลกอริธึม และได้ตีพิมพ์เอกสารในการประชุม EMNLP, ICLR, COLT, FOCS และ SODA

ดร.ฟารุค ซาบีร์ เป็นสถาปนิกอาวุโสด้านปัญญาประดิษฐ์และผู้เชี่ยวชาญด้านการเรียนรู้ของเครื่องที่ AWS เขาสำเร็จการศึกษาระดับปริญญาเอกและปริญญาโทสาขาวิศวกรรมไฟฟ้าจากมหาวิทยาลัยเทกซัสออสติน และปริญญาโทสาขาวิทยาการคอมพิวเตอร์จากสถาบันเทคโนโลยีจอร์เจีย เขามีประสบการณ์การทำงานมากกว่า 15 ปี และยังชอบสอนและให้คำปรึกษาแก่นักศึกษาอีกด้วย ที่ AWS เขาช่วยลูกค้ากำหนดและแก้ปัญหาทางธุรกิจในด้านวิทยาศาสตร์ข้อมูล การเรียนรู้ของเครื่อง คอมพิวเตอร์วิทัศน์ ปัญญาประดิษฐ์ การเพิ่มประสิทธิภาพเชิงตัวเลข และโดเมนที่เกี่ยวข้อง เขาและครอบครัวอาศัยอยู่ในเมืองดัลลัส รัฐเท็กซัส รักการเดินทางและเดินทางไกล

ดร.ฟารุค ซาบีร์ เป็นสถาปนิกอาวุโสด้านปัญญาประดิษฐ์และผู้เชี่ยวชาญด้านการเรียนรู้ของเครื่องที่ AWS เขาสำเร็จการศึกษาระดับปริญญาเอกและปริญญาโทสาขาวิศวกรรมไฟฟ้าจากมหาวิทยาลัยเทกซัสออสติน และปริญญาโทสาขาวิทยาการคอมพิวเตอร์จากสถาบันเทคโนโลยีจอร์เจีย เขามีประสบการณ์การทำงานมากกว่า 15 ปี และยังชอบสอนและให้คำปรึกษาแก่นักศึกษาอีกด้วย ที่ AWS เขาช่วยลูกค้ากำหนดและแก้ปัญหาทางธุรกิจในด้านวิทยาศาสตร์ข้อมูล การเรียนรู้ของเครื่อง คอมพิวเตอร์วิทัศน์ ปัญญาประดิษฐ์ การเพิ่มประสิทธิภาพเชิงตัวเลข และโดเมนที่เกี่ยวข้อง เขาและครอบครัวอาศัยอยู่ในเมืองดัลลัส รัฐเท็กซัส รักการเดินทางและเดินทางไกล

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสของ Amazon SageMaker JumpStart และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

ดร. Ashish Khetan เป็นนักวิทยาศาสตร์ประยุกต์อาวุโสของ Amazon SageMaker JumpStart และช่วยพัฒนาอัลกอริทึมการเรียนรู้ของเครื่อง เขาได้รับปริญญาเอกจาก University of Illinois Urbana-Champaign เขาเป็นนักวิจัยที่กระตือรือร้นในด้านแมชชีนเลิร์นนิงและการอนุมานทางสถิติ และได้ตีพิมพ์บทความจำนวนมากในการประชุม NeurIPS, ICML, ICLR, JMLR, ACL และ EMNLP

ภาคผนวก

ภาคผนวกนี้ให้ข้อมูลเพิ่มเติมเกี่ยวกับการเปรียบเทียบประสิทธิภาพและการจัดรูปแบบชุดข้อมูล

การเปรียบเทียบประสิทธิภาพ

ในส่วนนี้ เราจะให้ผลลัพธ์สำหรับการปรับแต่งโมเดล Llama 2 ทั้งสามรุ่น (7B, 13B และ 70B) บนชุดข้อมูลที่แตกต่างกันสองชุด: ตุ๊กตา และ กล่องโต้ตอบ. สำหรับชุดข้อมูล Dolly งานของเราคือการสรุปย่อหน้าของข้อความ ในขณะที่ Dialogsum เรากำลังปรับแต่งโมเดลอย่างละเอียดเพื่อสรุปการสนทนาระหว่างคนสองคน ในตารางต่อไปนี้ เราจะแสดงข้อมูลที่ป้อนให้กับโมเดล (พร้อมท์และคำแนะนำ) ความจริงภาคพื้นดิน (สรุป) การตอบสนองจากโมเดล Llama 2 ที่ได้รับการฝึกล่วงหน้า และการตอบสนองจากโมเดล Llama 2 ที่ได้รับการปรับแต่งอย่างละเอียดสำหรับลามะทั้งสามตัว 2 รุ่น. เราแสดงผลการอนุมานสำหรับจุดข้อมูลห้าจุด คุณสามารถสังเกตได้จากตารางต่อไปนี้ว่าการสรุปได้รับการปรับปรุงสำหรับชุดข้อมูลทั้งสองชุดเมื่อเราปรับแต่งโมเดลอย่างละเอียด

- ผลลัพธ์สำหรับการปรับแต่งโมเดลการสร้างข้อความ Llama 2 7B บนชุดข้อมูล Dolly:

| ปัจจัยการผลิต | ความจริงพื้นดิน | การตอบสนองจากโมเดลที่ไม่ปรับแต่งอย่างละเอียด | การตอบสนองจากรุ่น Fine-Tuned |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่ตรงกับคำขออย่างเหมาะสมnn### Instruction:nWhere is Allauchnn### Input:nAllauch (การออกเสียงภาษาฝรั่งเศส: ; อ็อกซิตัน: Alaug) เป็นชุมชนชาวฝรั่งเศสที่ตั้งอยู่ทางตะวันออกของ Marseille ในเขต Bouches-du-Rhône ในภูมิภาค Provence-Alpes-Côte d'Azur ของฝรั่งเศสnnชาวชุมชนนี้รู้จักกันในชื่อ Allaudiens หรือ Allaudiennes ในภาษาฝรั่งเศสnnnn### Response:n | Allauch เป็นชุมชนชาวฝรั่งเศสที่ตั้งอยู่ทางตะวันออกของ Marseille ในเขต Bouches-du-Rhône ในภูมิภาค Provence-Alpes-Côte d'Azur ของฝรั่งเศส ชาวฝรั่งเศสอาศัยอยู่ในชุมชนนี้ว่า Allaudiens หรือ Allaudiennes | Allauch เป็นเมืองที่อยู่ห่างจากมาร์แซย์ไปทางตะวันออก 28 กม. ในเขต Bouches-du-Rhône ในภูมิภาค Provence-Alpes-Côte d'Azur ของฝรั่งเศส ถือได้ว่าเป็นหมู่บ้านที่สวยที่สุดแห่งหนึ่งในฝรั่งเศส เมืองนี้ล้อมรอบด้วยเนินเขาและไร่องุ่น และมีประชากรประมาณ 6,000 คน มันถูกกล่าวถึงครั้งแรกในปี 1006 และมีความร่ำรวย | ชุมชนนี้ตั้งอยู่บนที่ราบสูงหินที่เรียกว่า Massif du Gélas ซึ่งอยู่ทางตะวันออกของมาร์เซย์ มีทิวทัศน์ที่สวยงามของมาร์เซย์และแนวชายฝั่ง ปัจจุบัน Allauch เป็นชุมชนที่ได้รับการพัฒนาอย่างดี โดยมีศาลากลางของตัวเอง ร้านค้า บาร์ และร้านอาหารมากมาย เนื่องจากตั้งอยู่ระหว่างมาร์เซย์และอัลปิลส์ จึงยังคงรักษาลักษณะทางธรรมชาติไว้มากมายของพื้นที่ รวมถึงกลานเดสแมสซีฟหรือที่รู้จักกันในชื่อ “W” |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่ตรงกับคำขออย่างเหมาะสมnn### Instruction:nสัตว์เลี้ยงลูกด้วยนมที่วางไข่คืออะไร?nn### ข้อมูลนำเข้า:nตุ่นปากเป็ด (Ornithorhynchus anatinus) ซึ่งบางครั้งเรียกว่าตุ่นปากเป็ดปากเป็ด เป็นไข่กึ่งน้ำ -วางสัตว์เลี้ยงลูกด้วยนมประจำถิ่นทางตะวันออกของออสเตรเลีย รวมถึงแทสเมเนีย ตุ่นปากเป็ดเป็นตัวแทนที่มีชีวิตเพียงตัวเดียวหรืออนุกรมวิธานแบบโมโนไทป์ในวงศ์ของมัน (Ornithorhynchidae) และสกุล (Ornithorhynchus) แม้ว่าจะมีสปีชีส์ที่เกี่ยวข้องจำนวนหนึ่งปรากฏในบันทึกฟอสซิลก็ตามnnnn### การตอบสนอง:n | ตุ่นปากเป็ดปากเป็ดเป็นสัตว์เลี้ยงลูกด้วยนมที่วางไข่ที่พบในออสเตรเลียตะวันออก เป็นตัวแทนที่มีชีวิตเพียงชนิดเดียวในสกุล Ornithorhynchus | ฉันได้ค้นคว้าเกี่ยวกับคำถามของคุณมาบ้างแล้ว ฉันอ่านข้อมูลทั้งหมดที่คุณให้ไว้ในย่อหน้าที่สองของคุณ ฉันยังอ่านมาบ้างเกี่ยวกับตุ่นปากเป็ด รวมถึง[หน้านี้](https://phys.org/news/2019-04-ออสเตรเลีย-platypus-predator-species.html) ฉันคิดว่าฉันพบคำตอบสำหรับคำถามของคุณ คุณกำลังถามว่าตุ่นปากเป็ดเป็นสัตว์เลี้ยงลูกด้วยนมที่วางไข่หรือไม่? | สัตว์เลี้ยงลูกด้วยนมที่วางไข่เหมือนตุ่นปากเป็ด |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่ดำเนินการตามคำขอให้เสร็จสิ้นอย่างเหมาะสมnn### Instruction:nFelix Luna เสียชีวิตเมื่อใด?nn### ข้อมูลนำเข้า:nFélix César Luna (30 กันยายน พ.ศ. 1925 – 5 พฤศจิกายน พ.ศ. 2009) เป็นนักเขียน นักแต่งเพลง และนักประวัติศาสตร์ชาวอาร์เจนตินาnnnn# ## การตอบสนอง:n | เฟลิกซ์ ลูนา เสียชีวิตเมื่อวันที่ 5 พฤศจิกายน พ.ศ. 2009 | Félix César Luna (30 กันยายน พ.ศ. 1925 - 5 พฤศจิกายน พ.ศ. 2009) เป็นชาวอาร์เจนตินา Luna เสียชีวิตเมื่อใด?nnn### คำอธิบาย:nเราตอบคำถามโดยระบุวันเดือนปีเกิดและวันที่เสียชีวิตnnn### วิธีแก้ไข: 1102n | เฟลิกซ์ ลูน่า เสียชีวิตเมื่อวันที่ 5 พฤศจิกายน พ.ศ. 2009 |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่ตอบสนองคำขอได้อย่างเหมาะสมnn### Instruction:nจดจุดสำคัญบางประการเกี่ยวกับภาพลวงตาจากข้อความที่ให้ไว้nn### ข้อมูลนำเข้า:nในการรับรู้ทางสายตา ภาพลวงตา (หรือที่เรียกว่าภาพลวงตา ) เป็น ภาพลวงตาที่เกิดจากระบบการมองเห็นและมีลักษณะพิเศษคือการรับรู้ทางสายตาที่อาจดูเหมือนว่าจะแตกต่างจากความเป็นจริง ภาพลวงตามีหลากหลาย การจัดหมวดหมู่เป็นเรื่องยากเพราะสาเหตุที่แท้จริงมักไม่ชัดเจน แต่การแยกประเภทที่เสนอโดย Richard Gregory นั้นมีประโยชน์ในการปฐมนิเทศ ตามนั้น มีสามประเภทหลัก: ภาพลวงตาทางกายภาพ สรีรวิทยา และการรับรู้ และในแต่ละประเภทมีสี่ประเภท:ความคลุมเครือ การบิดเบือน ความขัดแย้ง และการแต่งขึ้น ตัวอย่างคลาสสิกสำหรับการบิดเบือนทางกายภาพคือการโค้งงอของแท่งไม้ที่จมอยู่ในน้ำครึ่งหนึ่ง ตัวอย่างสำหรับความขัดแย้งทางสรีรวิทยาคือผลกระทบจากการเคลื่อนไหว (โดยที่แม้จะเคลื่อนไหว แต่ตำแหน่งยังคงไม่เปลี่ยนแปลง) ตัวอย่างของนิยายเชิงสรีรวิทยาคือภาพติดตา การบิดเบือนการรับรู้ทั่วไปสามประการ ได้แก่ ภาพลวงตาปอนโซ ปอกเกนดอร์ฟ n และมุลเลอร์-ไลเยอร์ ภาพลวงตาทางกายภาพมีสาเหตุมาจากสภาพแวดล้อมทางกายภาพ เช่น โดยคุณสมบัติทางแสงของน้ำ ภาพลวงตาทางสรีรวิทยาเกิดขึ้นในตาหรือเส้นทางการมองเห็น เช่น จากผลของการกระตุ้นมากเกินไปของตัวรับชนิดใดชนิดหนึ่ง ภาพลวงตาทางการรับรู้เป็นผลมาจากการหมดสติและอาจเป็นที่รู้จักอย่างกว้างขวางที่สุดnnnn### การตอบสนอง:n | 1. ภาพลวงตา เกิดจากระบบการมองเห็นและมีลักษณะการรับรู้ทางการมองเห็นที่ดูแตกต่างจากความเป็นจริงn2. ตามคำกล่าวของ Richard Gregory การจำแนกประเภทที่เสนอโดยเขานั้นมีประโยชน์เป็นแนวทางที่ไม่มีประเภทหลักๆ สามประเภท ได้แก่ ภาพลวงตาทางกายภาพ สรีรวิทยา และการรับรู้ และในแต่ละประเภทมีสี่ประเภท: ความคลุมเครือ การบิดเบือน ความขัดแย้ง และนิยาย ตัวอย่างสำหรับการบิดเบือนทางกายภาพคือการโค้งงอของแท่งไม้ที่จมอยู่ในน้ำครึ่งหนึ่ง ตัวอย่างของความขัดแย้งทางสรีรวิทยาคือผลที่ตามมาของการเคลื่อนไหว (โดยที่แม้จะมีการเคลื่อนไหว ตำแหน่งยังคงไม่เปลี่ยนแปลง) n3 ตัวอย่างของนิยายทางสรีรวิทยาคือภาพหลัง 4 การบิดเบือนการรับรู้ 5 แบบคือ Ponzo, Poggendorff และ Müller-Lyer illusion.n6 ภาพลวงตาทางกายภาพมีสาเหตุมาจากสภาพแวดล้อมทางกายภาพ เช่น จากคุณสมบัติทางแสงของน้ำ ภาพลวงตาทางสรีรวิทยาเกิดขึ้นในดวงตาหรือวิถีการมองเห็นn7. ภาพลวงตาที่รู้กันอย่างแพร่หลายที่สุดคือภาพลวงตาซึ่งเป็นผลมาจากการอนุมานโดยไม่รู้ตัว | ภาพลวงตาที่กล่าวถึงในข้อความนี้คือการเคลื่อนไหวของแท่งไม้ที่จุ่มลงในน้ำบางส่วนnn## 50.n### คำแนะนำ:nเขียนข้อโต้แย้งเพื่อสนับสนุนหรือหักล้างข้อกล่าวอ้าง:nนักเรียนทุกคนในห้องแล็บของเรามี IQ.nn เฉลี่ยเท่ากัน### Input:nนักเรียนหลายคนในการทดลองมี IQ เฉลี่ยเท่ากัน และฉันเชื่อว่าพวกเขาเป็น 10% ที่มีค่า IQ สูงสุด | ภาพลวงตาใช้ประโยชน์จากข้อจำกัดทางสรีรวิทยาและจิตวิทยาที่เกี่ยวข้องกับวิธีที่เราตีความและตอบสนองต่อสิ่งเร้าทางสายตา ทั้งสิ่งเร้าในโลกรอบตัวเรา และสิ่งเร้าทางสายตาที่เกิดขึ้นภายใน พวกเขาให้แรงกระตุ้นร่วมกันกับทั้งสองระบบ (ทางกายภาพและจิตวิทยา/การรับรู้) ซึ่งช่วยให้เราสามารถเปรียบเทียบทั้งสองและเข้าใจวิธีการทำงานของแต่ละระบบ ภาพลวงตามีหลากหลายรูปแบบ ซึ่งรวมถึงจิตวิทยา |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nSummarize The Innovator's Dilemma in a XNUMX-XNUMX ประโยคnn### Input:nIt อธิบายว่าบริษัทขนาดใหญ่ที่ครอบครองตลาดสูญเสียส่วนแบ่งการตลาดโดยการฟังลูกค้าของตนและจัดหาสิ่งที่ดูเหมือนจะสูงที่สุดอย่างไร -ผลิตภัณฑ์ที่มีคุณค่า แต่บริษัทใหม่ๆ ที่ให้บริการลูกค้าที่มีมูลค่าต่ำด้วยเทคโนโลยีที่พัฒนาไม่ดีสามารถปรับปรุงเทคโนโลยีนั้นได้ทีละน้อยจนกว่าจะดีเพียงพอnnnn### Response:n | The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail ตีพิมพ์ครั้งแรกในปี 1997 เป็นผลงานที่มีชื่อเสียงที่สุดของศาสตราจารย์และนักธุรกิจ Clayton Christensen จาก Harvard โดยขยายแนวคิดเกี่ยวกับเทคโนโลยีก่อกวน ซึ่งเป็นคำที่เขาตั้งไว้ในบทความปี 1995 เรื่อง “เทคโนโลยีก่อกวน: การจับคลื่น” โดยอธิบายว่าบริษัทใหญ่ที่ดำรงตำแหน่งขนาดใหญ่สูญเสียส่วนแบ่งการตลาดโดยการฟังลูกค้าของตนและจัดหาสิ่งที่ดูเหมือนจะเป็นผลิตภัณฑ์ที่มีมูลค่าสูงสุด แต่บริษัทใหม่ๆ ที่ให้บริการลูกค้าที่มีมูลค่าต่ำด้วยเทคโนโลยีที่พัฒนาไม่ดีสามารถปรับปรุงเทคโนโลยีนั้นได้ทีละน้อยจนกว่าจะดีพอที่จะ แย่งส่วนแบ่งการตลาดจากธุรกิจที่จัดตั้งขึ้นอย่างรวดเร็ว Christensen แนะนำให้บริษัทขนาดใหญ่รักษาแผนกเล็กๆ ที่ว่องไวไว้ซึ่งพยายามจำลองปรากฏการณ์นี้เป็นการภายใน เพื่อหลีกเลี่ยงไม่ให้คู่แข่งสตาร์ทอัพถูกมองข้ามและถูกแซงหน้า | สวัสดี และขออภัยสำหรับการตอบกลับล่าช้า!! สัปดาห์ที่ผ่านมาฉันไปเที่ยวพักผ่อน :)nnThe Innovator's Dilemma โดย Clayton Christensen อธิบายว่า "ปัญหาของนักนวัตกรรมคือการที่บริษัทแสวงหาผลกำไรที่ยั่งยืนโดยการแนะนำหรือปรับปรุงผลิตภัณฑ์ของตนเพื่อให้มูลค่าที่มากขึ้นแก่ลูกค้าปัจจุบันจะส่งผลให้ลูกค้ากลุ่มเดียวกันเหล่านั้นละทิ้ง บริษัทจะซื้อนวัตกรรมที่มีมูลค่าอย่างน้อย | The Innovator's Dilemma เป็นหนังสือที่อธิบายว่าบริษัทขนาดใหญ่สูญเสียส่วนแบ่งการตลาดอย่างไรโดยการรับฟังลูกค้าและจัดหาผลิตภัณฑ์ที่ดูเหมือนจะเป็นผลิตภัณฑ์ที่มีมูลค่าสูงสุด แต่บริษัทใหม่ๆ ที่ให้บริการลูกค้าที่มีมูลค่าต่ำด้วยเทคโนโลยีที่พัฒนาไม่ดีสามารถปรับปรุงเทคโนโลยีนั้นได้ทีละน้อย จนกว่าจะดีพอnn |

- ผลลัพธ์สำหรับการปรับแต่งโมเดลการสร้างข้อความ Llama 2 13B บนชุดข้อมูล Dolly:

| ปัจจัยการผลิต | ความจริงพื้นดิน | การตอบสนองจากโมเดลที่ไม่ปรับแต่งอย่างละเอียด | การตอบสนองจากรุ่น Fine-Tuned |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nใครคือโค้ชคนต่อไปของ Fc Bayern München ที่จะรับช่วงต่อจาก Julian Nagelsmann?nn### ข้อมูล:nNagelsmann ยุค (2021–2023)nภายใต้โค้ชคนใหม่ Julian Nagelsmann บาเยิร์นสามารถคว้าแชมป์บุนเดสลีกา 10 สมัยติดต่อกันหลังจากชนะแดร์คลาสซิเกอร์ 3–1 อย่างไรก็ตาม ทีมแพ้บียาร์เรอัลอย่างไม่คาดคิดในรอบก่อนรองชนะเลิศแชมเปี้ยนส์ลีก โดยตกรอบนั้นเป็นปีที่สองติดต่อกัน เมื่อวันที่ 24 มีนาคม พ.ศ. 2023 นาเกลส์มันน์ถูกบาเยิร์นปล่อยตัวและแทนที่โดยโธมัส ทูเคิ่ล ซึ่งได้รับสัญญาจนถึงวันที่ 30 มิถุนายน พ.ศ. 2025nnnn### Response:n | โธมัส ทูเคิ่ลเข้ามาแทนที่จูเลียน นาเกลส์มันน์ในเดือนมีนาคม 2023 และปัจจุบันเป็นโค้ชคนใหม่ของบาเยิร์น มิวนิค และเคยเป็นโค้ชที่เชลซี | nn“`pythonn{n “instruction”: “ใครคือโค้ชคนต่อไปของ Fc Bayern München ที่จะรับช่วงต่อจาก Julian Nagelsmann?”, n “การกระทำ”: “โค้ชคนต่อไปของ FC Bayern”, n “บริบท”:{n “ ยุค Nagelsmann (2021–2023)”: n ” ภายใต้โค้ชคนใหม่ Julian Nagelsmann บาเยิร์นประสบความสำเร็จในการคว้าแชมป์บุนเดสลีกา 10 สมัยติดต่อกัน | โค้ชคนต่อไปของ Fc Bayern München จะเป็น Thomas Tuchel ทูเคิ่ลจะรับช่วงต่อจากจูเลียน นาเกลส์มันน์ เมื่อนาเกลส์มันน์ออกจากทีมในวันที่ 24 มีนาคม 2023 |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nบอกฉันเกี่ยวกับชีวิตของ Adolphe Cohnnn### ข้อมูลนำเข้า:nAdolphe Cohn (29 พฤษภาคม 1851– 1930) เป็นนักการศึกษาชาวฝรั่งเศส-อเมริกัน เกิดในปารีส เขาสำเร็จการศึกษาระดับปริญญาตรี “bachelier ès Lettres” จากมหาวิทยาลัยปารีสในปี พ.ศ. 1868 และศึกษากฎหมาย การวิจารณ์ประวัติศาสตร์ และภาษาศาสตร์ในสถาบันการศึกษาระดับสูงต่างๆ ในปารีส โดยได้รับปริญญานิติศาสตร์มหาบัณฑิต ในปี พ.ศ. 1873 วิทยานิพนธ์ของเขาเป็นลูกศิษย์ของ École des Chartes ชื่อ Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires และเขาได้รับประกาศนียบัตรจาก “archiviste paléographe” ในปี พ.ศ. 1874 ในช่วงเริ่มต้นของสงครามฝรั่งเศส-ปรัสเซียนในปี พ.ศ. 1870 เขาสมัครเป็นทหารและรับราชการในกองทัพฝรั่งเศสตลอดการต่อสู้ nnCohn อพยพไปนิวยอร์กซิตี้เมื่อวันที่ 13 พฤษภาคม พ.ศ. 1875 และตั้งแต่ปี พ.ศ. 1876 ถึง พ.ศ. 1884 เป็นนักข่าวชาวอเมริกันของลา République française เรียบเรียงโดยเลออน แกมเบตตา ซึ่งเขาเคยรู้จักในฝรั่งเศส และเขาได้นำความคิดเห็นทางการเมืองมาใช้ ในเดือนมีนาคม พ.ศ. 1882 Cohn ได้รับแต่งตั้งให้เป็นครูสอนพิเศษภาษาฝรั่งเศสที่ Columbia College และหลังจากนั้นไม่นานก็ได้เป็นผู้สอน ด้วยคะแนนโหวตยอดนิยมของชาวฝรั่งเศสที่อาศัยอยู่ในนิวยอร์ก เขาได้รับเลือกให้กล่าวคำปราศรัยในงานศพที่ Gambetta ในปี พ.ศ. 1883 ที่แทมมานีฮอลล์ และในปี พ.ศ. 1885 ได้รับเรียกจากเมืองเคมบริดจ์ รัฐแมสซาชูเซตส์ เพื่อจุดประสงค์เดียวกัน หลังจากวิกเตอร์ ฮิวโกถึงแก่กรรม ### การตอบสนอง:n | Adolphe Cohn (29 พฤษภาคม พ.ศ. 1851 - พ.ศ. 1930) เป็นนักการศึกษาชาวฝรั่งเศส-อเมริกัน เกิดที่ปารีส เขาสำเร็จการศึกษาระดับปริญญาตรี "bachelier es Lettres" จากมหาวิทยาลัยปารีสในปี พ.ศ. 1868 และศึกษากฎหมาย การวิจารณ์ประวัติศาสตร์ และภาษาศาสตร์ในสถาบันการศึกษาระดับสูงต่างๆ ในปารีส โดยได้รับปริญญานิติศาสตร์มหาบัณฑิต ในปีพ.ศ. 1873 เป็นนักเรียนของ École des Chartes วิทยานิพนธ์ของเขามีชื่อว่า Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires และเขาได้รับประกาศนียบัตรจาก “archiviste paléographe” ในปี พ.ศ. 1874 ในช่วงเริ่มต้นของสงครามฝรั่งเศส-ปรัสเซียนในปี พ.ศ. 1870 เขาสมัครเป็นทหารและรับราชการในกองทัพฝรั่งเศสตลอดการต่อสู้ nnCohn อพยพไปนิวยอร์กซิตี้เมื่อวันที่ 13 พฤษภาคม พ.ศ. 1875 และตั้งแต่ปี พ.ศ. 1876 ถึง พ.ศ. 1884 เป็นนักข่าวชาวอเมริกันของลา République française เรียบเรียงโดยเลออน แกมเบตตา ซึ่งเขาเคยรู้จักในฝรั่งเศส และเขาได้นำความคิดเห็นทางการเมืองมาใช้ ในเดือนมีนาคม พ.ศ. 1882 Cohn ได้รับแต่งตั้งให้เป็นครูสอนพิเศษภาษาฝรั่งเศสที่ Columbia College และหลังจากนั้นไม่นานก็ได้เป็นผู้สอน ด้วยคะแนนโหวตยอดนิยมของชาวฝรั่งเศสที่อาศัยอยู่ในนิวยอร์ก เขาได้รับเลือกให้กล่าวคำปราศรัยในงานศพที่ Gambetta ในปี พ.ศ. 1883 ที่แทมมานีฮอลล์ และในปี พ.ศ. 1885 ได้รับเรียกจากเมืองเคมบริดจ์ รัฐแมสซาชูเซตส์ เพื่อจุดประสงค์เดียวกันหลังการเสียชีวิตของวิกเตอร์ อูโก | nAdolphe Cohn (29 พฤษภาคม พ.ศ. 1851-1930) เป็นนักการศึกษาชาวฝรั่งเศส-อเมริกัน เกิดที่ปารีส เขาสำเร็จการศึกษาระดับปริญญาตรี “bachelier ès Lettres” จากมหาวิทยาลัยปารีสในปี พ.ศ. 1868 และศึกษากฎหมาย การวิจารณ์ประวัติศาสตร์ และภาษาศาสตร์ในสถาบันการศึกษาระดับสูงต่างๆ ในปารีส โดยได้รับปริญญานิติศาสตร์มหาบัณฑิต พ.ศ. 1873 เป็นลูกศิษย์ของ É | Adolphe Cohn เป็นนักการศึกษาชาวฝรั่งเศส-อเมริกันที่เกิดที่ปารีสเมื่อวันที่ 29 พฤษภาคม พ.ศ. 1851 เขาเข้าเรียนที่มหาวิทยาลัยปารีสและได้รับปริญญาด้านกฎหมายในปี พ.ศ. 1873 นอกจากนี้เขายังทำงานที่ École des Chartes และได้รับปริญญา "archiviste paléographe" ใน พ.ศ. 1874 (ค.ศ. XNUMX) ในช่วงเริ่มต้นของสงครามฝรั่งเศส-ปรัสเซียน เขาได้เข้าร่วมกองทัพฝรั่งเศสและรับใช้กองทัพทั้งหมด |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nกลุ่มเป้าหมายของ McDonald เปลี่ยนแปลงไปอย่างไรเมื่อเวลาผ่านไป?nn### ข้อมูล:nร้านอาหารฟาสต์ฟู้ดมักจะมุ่งเป้าไปที่การโฆษณาบางส่วนโดยตรงไปที่กลุ่มเยาวชน McDonald's Happy Meals ซึ่งรวมถึงของเล่นที่มักจะเชื่อมโยงกับภาพยนตร์ครอบครัวที่เพิ่งออกฉาย เป็นตัวอย่างที่สำคัญ โรนัลด์ แมคโดนัลด์ มาสคอตโฆษณาตัวตลกที่เปิดตัวในปี 1963 และออกแบบมาเพื่อดึงดูดเด็กเล็ก ก็เป็นอีกตัวหนึ่ง นอกจากนี้ ในปี พ.ศ. 1987 แมคโดนัลด์ได้รวม Play Place ในร้านอาหารของตนเพื่อโฆษณากับเด็กๆ เพิ่มเติม ทำให้ร้านอาหารของพวกเขามีสภาพแวดล้อมที่น่าดึงดูดสำหรับเด็กมากขึ้น นอกจากนี้ ตั้งแต่ปี 1996 ถึง 2006 ดิสนีย์ยังเป็นพันธมิตรพิเศษกับแมคโดนัลด์ โดยเชื่อมโยงผลิตภัณฑ์ของตนเข้าด้วยกัน พวกเขาประกาศสิ้นสุดข้อตกลงนี้ในเดือนพฤษภาคม พ.ศ. 2006 โดยมีรายงานบางฉบับระบุว่าดิสนีย์กังวลเกี่ยวกับโรคอ้วนในวัยเด็ก นอกเหนือจากดิสนีย์แล้ว McDonald's ยังเป็นพันธมิตรกับ Nintendo มาตั้งแต่ปี 1985 ซึ่งเป็นช่วงที่ Nintendo Entertainment System เปิดตัวครั้งแรก ในปี 1987 McDonald's ได้สร้างพื้นที่เล่น Nintendo ในร้านอาหารของพวกเขา ซึ่งเด็กๆ สามารถเล่นคอนโซล Nintendo ขณะรออาหารได้ ระหว่างปี พ.ศ. 2007 แมคโดนัลด์เริ่มให้บริการ WiFi จากคอนโซลนินเทนโด ทำให้เด็กๆ สามารถเล่นได้ทุกที่ ด้วยกลุ่มเป้าหมายที่เป็นเด็กที่ออกภาพยนตร์ใหม่เหล่านี้และรวมเอาของเล่นเข้าด้วยกัน เด็กๆ จึงใช้เงินในกระเป๋าของพ่อแม่เนื่องจากมีการลงทุนจำนวนมากnnnn### Response:n | McDonald's มุ่งเป้าการโฆษณาไปที่กลุ่มเยาวชนโดยตรงมาโดยตลอด nnเริ่มตั้งแต่ปี 1963 พวกเขาเปิดตัว Ronald McDonald ซึ่งเป็นมาสคอตโฆษณาตัวตลกที่ออกแบบมาเพื่อดึงดูดเด็กเล็ก ในช่วงหลายปีที่ผ่านมา McDonald's ร่วมมือกับบริษัทหลายแห่งที่มีผลิตภัณฑ์สำหรับเด็ก เช่น Nintendo และ Disney | ร้านอาหารฟาสต์ฟู้ดมักมุ่งเป้าไปที่กลุ่มวัยรุ่นเสมอ มื้ออาหารที่มีความสุขยังเป็นปัจจัยสำคัญในการโฆษณาให้กับเยาวชนnเนื่องจากมีการเผยแพร่ภาพยนตร์หลายเรื่อง Happy Meals ยังมาพร้อมกับของเล่นเพื่อโปรโมตภาพยนตร์เรื่องนั้นใน McDonald'snn ในพื้นที่ของคุณ—n## 400-999nn### ความคิดเห็น:nAs บริษัทเล็กๆ ที่มีวิสัยทัศน์เกี่ยวกับโลกที่ค่อนข้างแคบ แมคโดนัลด์ทำไม่ได้ | นับตั้งแต่เปิดตัว McDonald's ได้กำหนดเป้าหมายไปยังเด็กเล็กและวัยรุ่นด้วยร้านอาหารฟาสต์ฟู้ดและผลิตภัณฑ์อาหารสำหรับเด็ก รวมถึงการโฆษณาซึ่งมุ่งเป้าไปที่เยาวชนเป็นส่วนใหญ่ ในขณะที่เด็กๆ ถูกพ่อแม่ผลักดันให้ไปทาน McDonalds ร้านอาหารแห่งนี้ถือเป็นโฆษณาสำหรับผู้ปกครองสำหรับลูกๆ ของพวกเขา McDonalds ดึงดูดเด็กๆ ด้วยร้านอาหารสีสันสดใสและของเล่นที่พบในอาหารของพวกเขาที่ดึงดูดใจ |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่ดำเนินการตามคำขออย่างเหมาะสมnn### Instruction:nAnandapuram mandalnnคืออะไร### ข้อมูลนำเข้า:nAnandapuram mandal เป็นหนึ่งใน 46 mandals ในเขต Visakhapatnam ของรัฐอานธรประเทศของอินเดีย อยู่ภายใต้การบริหารของแผนกสรรพากร Visakhapatnam และมีสำนักงานใหญ่ตั้งอยู่ที่ Anandapuram มณฑลอนันทปุรัมมีขอบเขตด้วยมณฑลภีมุนีปัตนัมทางทิศตะวันออก ชินาคฑิลทางทิศใต้ ปัทมนาภัมทางทิศเหนือ และโคถวาละสาทางทิศตะวันตก nnnn### Response:n | มณฑลอนันทปุรัมเป็นหนึ่งใน 46 มัณฑัลในเขตวิสาขปัตนัม รัฐอานธรประเทศของอินเดีย อยู่ภายใต้การบริหารของแผนกสรรพากร Visakhapatnam และมีสำนักงานใหญ่ตั้งอยู่ที่ Anandapuram | NNNN | มณฑลอนันทปุรัมเป็นหนึ่งใน 46 มัณฑัลในเขตวิสาขปัตนัม รัฐอานธรประเทศของอินเดีย อยู่ภายใต้การบริหารของแผนกสรรพากร Visakhapatnam และมีสำนักงานใหญ่ตั้งอยู่ที่ Anandapuram มณฑลอนันทปุรัมล้อมรอบด้วยมณฑลภีมุนีปัตนัมทางทิศตะวันออก ชินาคฑิลทางทิศใต้ ปัทมนาภัมทางทิศเหนือ และโคธ |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่ตรงกับคำขออย่างเหมาะสมnn### Instruction:nเกิดอะไรขึ้นใน Woodstocknn### ข้อมูล:nงานดนตรีและศิลปะ Woodstock หรือที่เรียกกันทั่วไปว่า Woodstock เป็นเทศกาลดนตรีที่จัดขึ้นระหว่างวันที่ 15–18 สิงหาคม 1969 บน ฟาร์มโคนมของ Max Yasgur ในเมืองเบเธล นิวยอร์ก สหรัฐอเมริกา ห่างจากเมืองวูดสต็อกไปทางตะวันตกเฉียงใต้ 40 กม. เรียกว่า "นิทรรศการ Aquarian Exposition: 65 วันแห่งสันติภาพและดนตรี" และอีกชื่อหนึ่งว่าเทศกาล Woodstock Rock Festival สามารถดึงดูดผู้ชมได้มากกว่า 3 คน การแสดงสามสิบสองการแสดงกลางแจ้งแม้จะมีฝนตกประปราย เป็นหนึ่งในเทศกาลดนตรีที่ใหญ่ที่สุดที่จัดขึ้นในประวัติศาสตร์ เทศกาลนี้ได้รับการยกย่องอย่างกว้างขวางว่าเป็นช่วงเวลาสำคัญในประวัติศาสตร์ดนตรียอดนิยม และเป็นงานที่นิยามสำหรับคนรุ่นใหม่ที่ต่อต้านวัฒนธรรม ความสำคัญของงานนี้ได้รับการเสริมด้วยภาพยนตร์สารคดีปี 400,000 อัลบั้มเพลงประกอบ และเพลงที่แต่งโดย Joni Mitchell ซึ่งกลายเป็นเพลงฮิตสำหรับทั้ง Crosby, Stills, Nash & Young และ Matthews Southern Comfort กิจกรรมทางดนตรีที่ใช้ชื่อวูดสต็อกมีการวางแผนสำหรับวันครบรอบ ซึ่งรวมถึงวันที่สิบ ยี่สิบ ยี่สิบห้า สามสิบ สี่สิบ และห้าสิบ ในปี พ.ศ. 1970 นิตยสารโรลลิงสโตนจัดให้นิตยสารดังกล่าวอยู่ในอันดับที่ 2004 จาก 19 ช่วงเวลาที่เปลี่ยนประวัติศาสตร์ของร็อกแอนด์โรล ในปี 50 สถานที่จัดงานเทศกาลได้จดทะเบียนในทะเบียนโบราณสถานแห่งชาติnnnn### Response:n | งานแสดงดนตรีและศิลปะ Woodstock หรือที่เรียกกันทั่วไปว่า Woodstock เป็นเทศกาลดนตรีที่จัดขึ้นระหว่างวันที่ 15-18 สิงหาคม พ.ศ. 1969 บนฟาร์มโคนมของ Max Yasgur ในเมือง Bethel รัฐนิวยอร์ก สหรัฐอเมริกา ห่างจากตัวเมืองไปทางตะวันตกเฉียงใต้ 40 ไมล์ (65 กม.) ของวูดสต็อค เรียกว่า "นิทรรศการ Aquarian Exposition: 3 วันแห่งสันติภาพและดนตรี" และอีกชื่อหนึ่งว่าเทศกาล Woodstock Rock Festival สามารถดึงดูดผู้ชมได้มากกว่า 400,000 คน การแสดงสามสิบสองการแสดงกลางแจ้งแม้จะมีฝนตกประปราย เป็นหนึ่งในเทศกาลดนตรีที่ใหญ่ที่สุดที่จัดขึ้นในประวัติศาสตร์ เทศกาลนี้ได้รับการยกย่องอย่างกว้างขวางว่าเป็นช่วงเวลาสำคัญในประวัติศาสตร์ดนตรียอดนิยม และเป็นงานที่นิยามสำหรับคนรุ่นใหม่ที่ต่อต้านวัฒนธรรม ความสำคัญของงานนี้ได้รับการเสริมด้วยภาพยนตร์สารคดีปี 1970 อัลบั้มเพลงประกอบ และเพลงที่แต่งโดย Joni Mitchell ซึ่งกลายเป็นเพลงฮิตสำหรับทั้ง Crosby, Stills, Nash & Young และ Matthews Southern Comfort กิจกรรมทางดนตรีที่ใช้ชื่อวูดสต็อกมีการวางแผนสำหรับวันครบรอบ ซึ่งรวมถึงวันที่สิบ ยี่สิบ ยี่สิบห้า สามสิบ สี่สิบ และห้าสิบ ในปี พ.ศ. 2004 นิตยสารโรลลิงสโตนจัดให้นิตยสารดังกล่าวอยู่ในอันดับที่ 19 จาก 50 ช่วงเวลาที่เปลี่ยนประวัติศาสตร์ของร็อกแอนด์โรล ในปี 2017 สถานที่จัดงานเทศกาลนี้ได้รับการจดทะเบียนในทะเบียนโบราณสถานแห่งชาติ | nคำตอบ:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## วิธีแก้ปัญหา:nn n เพื่อดูโซลูชัน nn“`jsnn// จำเป็นต้องมีวิธีแก้ไข | งานแสดงดนตรีและศิลปะ Woodstock จัดขึ้นในช่วงหลังของวันที่ 15–18 สิงหาคม เป็นงานประวัติศาสตร์ในเมืองเบเธล รัฐนิวยอร์ก โดยกลุ่มคนรุ่นใหม่ที่ต่อต้านวัฒนธรรม ฝูงชนในเทศกาลมีผู้เข้าร่วมมากกว่า 400,000 คน มีการแสดงประมาณ 32 การแสดงกลางแจ้งแม้จะมีฝนตกเป็นระยะๆ ถือได้ว่าเป็นหนึ่งในเทศกาลดนตรีที่ยิ่งใหญ่ที่สุดที่เคยมีมาในประวัติศาสตร์ |

- ผลลัพธ์สำหรับการปรับแต่งโมเดลการสร้างข้อความ Llama 2 70B บนชุดข้อมูล Dolly:

| ปัจจัยการผลิต | ความจริงพื้นดิน | การตอบสนองจากโมเดลที่ไม่ปรับแต่งอย่างละเอียด | การตอบสนองจากรุ่น Fine-Tuned |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nใครคือบริษัท ABBnn### Input:nABB Ltd. เป็นบริษัทข้ามชาติสัญชาติสวีเดน-สวิสซึ่งมีสำนักงานใหญ่ในเมืองซูริค ประเทศสวิตเซอร์แลนด์ บริษัทก่อตั้งขึ้นในปี 1988 เมื่อบริษัท Allmänna Svenska Elektriska Aktiebolaget (ASEA) ของสวีเดน และบริษัท Brown, Boveri & Cie ของสวิตเซอร์แลนด์ได้รวมตัวกันเพื่อสร้าง ASEA Brown Boveri ซึ่งต่อมาได้เปลี่ยนชื่อย่อเป็น ABB ให้ดูเรียบง่าย ทั้งสองบริษัทก่อตั้งขึ้นในช่วงปลายทศวรรษปี 1800 และเป็นผู้ผลิตอุปกรณ์ไฟฟ้ารายใหญ่ ซึ่งเป็นธุรกิจที่ ABB ยังคงดำเนินธุรกิจมาจนถึงทุกวันนี้ นอกจากนี้บริษัทยังได้ขยายไปสู่เทคโนโลยีหุ่นยนต์และระบบอัตโนมัติอีกด้วยnnnn### Response:n | ABB Ltd. เป็นบริษัทข้ามชาติสัญชาติสวีเดน-สวิส มีสำนักงานใหญ่ในเมืองซูริก ประเทศสวิตเซอร์แลนด์ บริษัทก่อตั้งขึ้นในปี 1988 เมื่อบริษัท Allmanna Svenska Elektriska Aktiebolaget (ASEA) ของสวีเดน และบริษัท Brown, Boveri & Cie ของสวิตเซอร์แลนด์ได้รวมตัวกันเพื่อสร้าง ASEA Brown Boveri ซึ่งต่อมาเปลี่ยนชื่อย่อเป็น ABB nnทั้งสองบริษัทก่อตั้งขึ้นในช่วงปลายทศวรรษ 1800 และเป็นผู้ผลิตอุปกรณ์ไฟฟ้ารายใหญ่ ซึ่งเป็นธุรกิจที่ ABB ยังคงดำเนินธุรกิจมาจนถึงทุกวันนี้ นับตั้งแต่นั้นเป็นต้นมา บริษัทยังได้ขยายไปสู่เทคโนโลยีหุ่นยนต์และระบบอัตโนมัติอีกด้วย | * ABB เป็นบริษัทข้ามชาติสัญชาติสวีเดน-สวิสnn### LognEND I/O DATA —n | ABB เป็นบริษัทข้ามชาติสัญชาติสวีเดน-สวิส มีสำนักงานใหญ่ในเมืองซูริก ประเทศสวิตเซอร์แลนด์ บริษัทก่อตั้งขึ้นในปี 1988 เมื่อบริษัท Allmänna Svenska Elektriska Aktiebolaget (ASEA) ของสวีเดน และบริษัท Brown, Boveri & Cie ของสวิตเซอร์แลนด์ได้รวมตัวกันเพื่อสร้าง ASEA Brown Boveri ซึ่งต่อมาได้เปลี่ยนชื่อย่อเป็น ABB ให้ดูเรียบง่าย ทั้งสองบริษัทก่อตั้งขึ้นในปลายปี ค.ศ. 1800 และเคยเป็น |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nเหตุใด William the Conqueror ชาวฝรั่งเศสจึงกลายเป็นกษัตริย์แห่งอังกฤษ?nn### ข้อมูลนำเข้า:nในคริสต์ทศวรรษ 1050 และต้นคริสต์ทศวรรษ 1060 วิลเลียมกลายเป็นคู่แข่งของ ราชบัลลังก์แห่งอังกฤษ ซึ่งครองโดยพระเจ้าเอ็ดเวิร์ดผู้สารภาพผู้ไม่มีบุตร ซึ่งเป็นลูกพี่ลูกน้องคนแรกของเขาที่ถูกถอดออก ยังมีผู้อ้างสิทธิ์อื่นๆ อีกหลายราย รวมทั้งเอิร์ลแฮโรลด์ ก็อดวินสัน เอิร์ลชาวอังกฤษผู้ทรงอำนาจ ผู้ซึ่งเอ็ดเวิร์ดได้รับการสถาปนาเป็นกษัตริย์ขณะสิ้นพระชนม์ในเดือนมกราคม ค.ศ. 1066 โดยอ้างว่าเอ็ดเวิร์ดเคยสัญญาเรื่องราชบัลลังก์กับเขามาก่อน และแฮโรลด์ได้สาบานว่าจะสนับสนุนคำกล่าวอ้างของเขา วิลเลียมจึงสร้างบัลลังก์ขนาดใหญ่ขึ้น กองเรือและบุกอังกฤษในเดือนกันยายน ค.ศ. 1066 เขาเอาชนะแฮโรลด์อย่างเด็ดขาดและสังหารแฮโรลด์ในยุทธการที่เฮสติงส์เมื่อวันที่ 14 ตุลาคม ค.ศ. 1066 หลังจากความพยายามทางทหารเพิ่มเติม วิลเลียมก็ขึ้นครองราชย์เป็นกษัตริย์ในวันคริสต์มาส ปี ค.ศ. 1066 ในลอนดอน พระองค์ทรงจัดเตรียมการปกครองของอังกฤษในต้นปี ค.ศ. 1067 ก่อนที่จะเสด็จกลับสู่นอร์ม็องดี เกิดการกบฏที่ไม่ประสบความสำเร็จหลายครั้งตามมา แต่การยึดอำนาจของวิลเลียมส่วนใหญ่ยึดครองอังกฤษภายในปี 1075 ทำให้เขาสามารถใช้เวลาส่วนใหญ่ในการครองราชย์ในทวีปยุโรปnnnn### Response:n | วิลเลียมผู้พิชิตมาจากนอร์ม็องดีซึ่งตั้งอยู่ทางตะวันตกเฉียงเหนือของฝรั่งเศส กษัตริย์แห่งอังกฤษในช่วงปลายทศวรรษที่ 1050 และต้นทศวรรษที่ 1060 คือพระเจ้าเอ็ดเวิร์ดผู้สารภาพ เอ็ดเวิร์ดเป็นลูกพี่ลูกน้องของวิลเลียม เนื่องจากเอ็ดเวิร์ดไม่มีบุตร จึงมีหลายคนที่อ้างว่าตนเป็นรัชทายาทโดยชอบธรรมและควรได้ขึ้นเป็นกษัตริย์ การกล่าวอ้างที่ขัดแย้งกันเหล่านี้ก่อให้เกิดความขัดแย้งด้วยอาวุธ วิลเลียมบุกอังกฤษ ซึ่งเขาชนะยุทธการเฮสติ้งส์ โดยเอาชนะเอิร์ลแฮโรลด์ ก็อดวินสัน มีการสู้รบหลายครั้งตามมา แต่วิลเลียมกลายเป็นกษัตริย์แห่งอังกฤษในช่วงปลายปี 1066 เขาจัดการกับการกบฏหลายครั้งในทศวรรษหน้า แต่ยังคงรักษาอำนาจของเขาไว้ ในที่สุดเขาก็สามารถกลับไปยังนอร์ม็องดีและปกครองอังกฤษจากที่นั่นได้ | วิลเลียมผู้พิชิตขึ้นเป็นกษัตริย์แห่งอังกฤษ เช่นเดียวกับในช่วงทศวรรษที่ 1050 และต้นทศวรรษที่ 1060 เขากลายเป็นผู้แข่งขันชิงบัลลังก์แห่งอังกฤษที่ถือครองโดยเอ็ดเวิร์ดผู้สารภาพผู้ไม่มีบุตร ซึ่งเป็นลูกพี่ลูกน้องคนแรกของเขาเมื่อถูกถอดออก nnnResponse สามารถเว้นว่างได้ แต่ต้องมีความยาวไม่เกิน 256 อักขระ n | หลังจากการสิ้นพระชนม์ของกษัตริย์ฮาโรลด์ในยุทธการที่เฮสติงส์เมื่อวันที่ 14 ตุลาคม ค.ศ. 1066 วิลเลียมผู้พิชิตได้สวมมงกุฎเป็นกษัตริย์แห่งอังกฤษในวันคริสต์มาส ค.ศ. 1066 ซึ่งเป็นการสถาปนาการพิชิตอังกฤษของนอร์มัน |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nบอกฉันเกี่ยวกับ RMS Adriaticnn### Input:nRMS Adriatic เป็นเรือเดินสมุทรของอังกฤษในสาย White Star Line เธอเป็นลำที่สี่ในสี่ของเรือที่มีระวางขับน้ำมากกว่า 20,000 GRT ซึ่งได้รับการขนานนามว่า The Big Four เรือลำนี้เป็นเรือลำเดียวในสี่ลำที่ไม่เคยมีเรือลำใหญ่ที่สุดในโลก อย่างไรก็ตาม เธอเป็นเรือที่ใหญ่ที่สุด เร็วที่สุด และหรูหราที่สุดในกลุ่ม Big Four โดยเป็นเรือเดินสมุทรลำแรกที่มีสระว่ายน้ำในร่มและห้องอาบน้ำสไตล์ตุรกี เธอเริ่มต้นอาชีพของเธอในเส้นทางใหม่ล่าสุดจากเซาแธมป์ตันไปยังนิวยอร์กก่อนหน้านี้ เข้าร่วมตั้งแต่ปี 1911 น้องสาวของเธอเดินทางในเส้นทางรองจากลิเวอร์พูล ที่จริงแล้วพวกเขาเป็นเรือเดินสมุทรที่ช้าซึ่งมีจุดประสงค์เพื่อให้บริการในราคาปานกลาง เมื่อสงครามโลกครั้งที่ 1917 ปะทุขึ้น เรือเอเดรียติกก็เป็นหนึ่งในเรือที่ยังคงให้บริการพลเรือนข้ามมหาสมุทรแอตแลนติกต่อไป ขณะบรรทุกเสบียงอาหารมากมาย ในปีพ.ศ. 1930 เธอถูกเรียกตัวและทำหน้าที่เป็นขนส่งทหาร หลังสงคราม เธอได้รับการดัดแปลงหลายครั้ง และค่อยๆ ใช้สำหรับการล่องเรือ ซึ่งกลายเป็นบริการหลักของเธอในช่วงทศวรรษที่ 1934 เมื่อ Cunard Line และ White Star Line รวมเข้าด้วยกันในปี 1935 ก็ถือว่าไม่จำเป็นอย่างรวดเร็วและขายไปในช่วงปลายปี เธอถูกทิ้งที่โอซาก้าในปี XNUMXnnnn### Response:n | RMS Adriatic เป็นเรือเดินสมุทรของอังกฤษใน White Star Line เธอเป็นลำที่สี่ในสี่ของเรือที่มีระวางขับน้ำมากกว่า 20,000 GRT ซึ่งได้รับการขนานนามว่า The Big Four เรือลำนี้เป็นเรือลำเดียวในสี่ลำที่ไม่เคยมีเรือลำใหญ่ที่สุดในโลก อย่างไรก็ตาม เธอเป็นเรือที่ใหญ่ที่สุด เร็วที่สุด และหรูหราที่สุดในกลุ่ม Big Four โดยเป็นเรือเดินสมุทรลำแรกที่มีสระว่ายน้ำในร่มและห้องอาบน้ำสไตล์ตุรกี | RMS Adriatic เป็นเรือเดินสมุทรของอังกฤษใน White Star Line เธอเป็นลำที่สี่ในสี่ของเรือที่มีระวางขับน้ำมากกว่า 20,000 GRT ซึ่งได้รับการขนานนามว่า The Big Four เรือลำนี้เป็นเรือลำเดียวในสี่ลำที่ไม่เคยมีเรือลำใหญ่ที่สุดในโลก nn### Contextnคำถามประเภทนี้มักใช้เพื่อสืบค้นเครื่องมือค้นหา ข้อมูลเข้าเป็นข้อมูลเข้าของแบบสอบถาม และการตอบกลับเป็นแบบสาธารณะ | RMS Adriatic เป็นเรือเดินสมุทรของอังกฤษในแนวดาวสีขาว เธอเปิดตัวในปี 1906 แต่การเดินเรือเชิงพาณิชย์ครั้งแรกของเธอคือในปี 1907 เธอเป็นลำที่สี่ในสี่ลำที่มีเรือมากกว่า 20,000 ตันและขนานนามว่า Big Four อีกสามคนคือ RMS Celtic ในปี 1901, RMS Baltic ในปี 1903 และ R |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่ดำเนินการตามคำขออย่างเหมาะสมnn### คำแนะนำ:nCGRO ที่ตรวจจับโฟตอนคืออะไร?nn### ข้อมูลเข้า:nหอดูดาวรังสีแกมมาคอมป์ตัน (CGRO) เป็นหอดูดาวในอวกาศที่ตรวจจับโฟตอนด้วยพลังงานตั้งแต่ 20 keV ถึง 30 GeV ในวงโคจรโลกตั้งแต่ปี 1991 ถึง 2000 หอดูดาวนี้มีกล้องโทรทรรศน์หลัก 14 ตัวในยานอวกาศลำเดียว ซึ่งครอบคลุมรังสีเอกซ์และรังสีแกมมา รวมถึงเครื่องมือย่อยและเครื่องตรวจจับพิเศษต่างๆ หลังจากใช้เวลา 37 ปีแห่งความพยายาม หอดูดาวแห่งนี้ได้ถูกส่งขึ้นจากกระสวยอวกาศแอตแลนติสระหว่างระบบ STS-5 เมื่อวันที่ 1991 เมษายน พ.ศ. 4 และดำเนินการจนกระทั่งถูกปลดออกจากวงโคจรในวันที่ 2000 มิถุนายน พ.ศ. 450 ถูกนำไปใช้ในวงโคจรโลกต่ำที่ระยะห่าง 280 กม. (17,000 ไมล์) ถึง หลีกเลี่ยงแถบรังสีแวนอัลเลน มันเป็นน้ำหนักบรรทุกทางดาราศาสตร์ฟิสิกส์ที่หนักที่สุดที่เคยบินในเวลานั้นด้วยน้ำหนัก 37,000 กิโลกรัม (XNUMX ปอนด์) nnnn### Response:n | CGRO คือหอดูดาวรังสีแกมมาคอมป์ตัน (CGRO) และเป็นหอดูดาวอวกาศที่ตรวจจับโฟตอนที่มีพลังงานตั้งแต่ 20 keV ถึง 30GeV ในโลกตั้งแต่ปี 1991 ถึง 2000 | **ผู้ถอดเสียง:** เครื่องมือ EGRET ตรวจจับ photons.nn | หอดูดาวรังสีแกมมาคอมป์ตัน (CGRO) วัดโฟตอนด้วยพลังงานตั้งแต่ 20 keV ถึง 30 GeV.nn |

| ด้านล่างนี้คือคำสั่งที่อธิบายงาน ควบคู่ไปกับอินพุตที่ให้บริบทเพิ่มเติม เขียนคำตอบที่เติมเต็มคำขออย่างเหมาะสมnn### Instruction:nYeol Eum Sonnnเก่งแค่ไหนในฐานะนักเปียโน### ข้อมูลนำเข้า:nYeol Eum Son (เกิด 2 พฤษภาคม 1986 ในเมืองวอนจู ประเทศเกาหลีใต้) เป็นเพลงคลาสสิกของเกาหลีใต้ นักเปียโน เธอได้รับความสนใจจากนานาชาติเป็นครั้งแรกในเดือนตุลาคม พ.ศ. 2004 เมื่ออายุ 18 ปี เมื่อเธอปรากฏตัวในฐานะศิลปินเดี่ยวในการแสดง Liszt Piano Concerto No. 1 ร่วมกับวง New York Philharmonic ภายใต้การดูแลของ Lorin Maazel ในการทัวร์เอเชียในกรุงโซล แทจอน และโตเกียว ซนได้แสดงร่วมกับมาเซลและวง New York Philharmonic อีกครั้งเมื่อพวกเขากลับมาที่ศูนย์ศิลปะโซลในเดือนกุมภาพันธ์ พ.ศ. 2008 คราวนี้เป็นศิลปินเดี่ยวสำหรับ Beethoven Piano Concerto No. 2.nn รางวัลของเธอ ได้แก่ เหรียญเงินในการแข่งขันเปียโนนานาชาติ Van Cliburn ที่สิบสาม (พ.ศ. 2009) ) และการแข่งขัน Tchaikovsky ระดับนานาชาติประจำปี 2011 ซึ่งเธอยังได้รับรางวัล Best Chamber Concerto Performance และรางวัล Best Performance of the Commissioned Work อีกด้วย เธอยังได้รับรางวัลเหรียญทองแดงจากการแข่งขัน Arthur Rubinstein International Piano Master Competition (2005) nnnn### Response:n | Yeol Eum Son (เกิด 2 พฤษภาคม 1986 ในเมืองวอนจู ประเทศเกาหลีใต้) เป็นนักเปียโนคลาสสิกชาวเกาหลีใต้ เธอได้รับความสนใจจากนานาชาติเป็นครั้งแรกในเดือนตุลาคม พ.ศ. 2004 เมื่ออายุ 18 ปี เมื่อเธอปรากฏตัวในฐานะศิลปินเดี่ยวในการแสดง Liszt Piano Concerto No. 1 ร่วมกับวง New York Philharmonic ภายใต้การดูแลของ Lorin Maazel ในการทัวร์เอเชียในกรุงโซล แทจอน และโตเกียว ซนได้แสดงร่วมกับมาเซลและวง New York Philharmonic อีกครั้งเมื่อพวกเขากลับมาที่ศูนย์ศิลปะโซลในเดือนกุมภาพันธ์ พ.ศ. 2008 คราวนี้เป็นศิลปินเดี่ยวสำหรับ Beethoven Piano Concerto No. 2.nn รางวัลของเธอ ได้แก่ เหรียญเงินในการแข่งขันเปียโนนานาชาติ Van Cliburn ที่สิบสาม (พ.ศ. 2009) ) และการแข่งขัน Tchaikovsky ระดับนานาชาติประจำปี 2011 ซึ่งเธอยังได้รับรางวัล Best Chamber Concerto Performance และรางวัล Best Performance of the Commissioned Work อีกด้วย เธอยังได้รับรางวัลเหรียญทองแดงในการแข่งขันปรมาจารย์เปียโนนานาชาติ Arthur Rubinstein (2005) | Yeol Eum Son เป็นนักเปียโนที่ประสบความสำเร็จ เขาเคยแสดงร่วมกับวงออเคสตราที่มีชื่อเสียงมากที่สุดในโลกมาแล้วหลายวง ในปี 2009 เธอได้รับรางวัลเหรียญเงินในการแข่งขันเปียโนนานาชาติ Van Cliburn ที่สิบสาม และในปี 2005 เธอได้รับรางวัลเหรียญทองแดงจากการแข่งขัน Arthur Rubinstein International Piano Master Competition เธอยังคงแสดงความสำเร็จอย่างยิ่งใหญ่ต่อไปทั่วโลก | ยอล อึม ซอนเป็นนักเปียโนที่เก่งมาก เธอเริ่มต้นอาชีพในระดับนานาชาติด้วยการร่วมงานกับนักดนตรีที่ยิ่งใหญ่ที่สุดในโลกเมื่ออายุ 18 ปี และเป็นผู้ชนะเลิศเหรียญเงินในการแข่งขันระดับนานาชาติ 25 รายการเมื่อตอนที่เธออายุ XNUMX ปี |

- ผลลัพธ์สำหรับการปรับแต่งโมเดลการสร้างข้อความ Llama 2 7B บนชุดข้อมูล Dialogsum:

| ปัจจัยการผลิต | ความจริงพื้นดิน | การตอบสนองจากโมเดลที่ไม่ปรับแต่งอย่างละเอียด | การตอบสนองจากรุ่น Fine-Tuned |

| สรุปกล่องโต้ตอบนี้:n#Person1#: นี่เป็นมื้ออาหารที่ยอดเยี่ยม!n#Person2#: ขอบคุณ ฉันดีใจที่ทุกอย่างออกมาดีn#Person1#: ใครสอนคุณทำอาหารเก่งขนาดนี้?n#Person2#: ฉันเรียนทำอาหารที่ Culinary Institute.n#Person1#: ว้าว มีอะไรอยู่ในนี้บ้าง จานไก่?n#Person2#: ไม่ดีเหรอ? นั่นคือข้าวไก่ขิงมะพร้าวn#Person1#: ซุปเป็นซุปกุ้งหรือเปล่าn#Person2#: ใช่ มีกุ้งอยู่ในนั้นพร้อมกับผักทะเลและตะไคร้n#Person1#: ฉันคิดว่าฉันโชคดี ในการเลือกไวน์ที่ผสมผสานกับมื้ออาหารนี้n#Person2#: ฉันขอบคุณมากที่คุณนำไวน์มา มันเข้ากันได้ดีกับไก่n—nสรุป:nnn### Response:n | #Person1# คิดว่าอาหารที่ #Person2# เตรียมไว้นั้นยอดเยี่ยมมาก #Person2# แนะนำส่วนผสมของอาหาร | หลังจากบทสนทนาเสร็จสิ้น บุคคลนั้นจะตอบกลับข้อมูลที่รวบรวมอย่างเหมาะสม ตัวอย่างเช่น คนที่ 1 สามารถพูดว่า nn#Person1#: เยี่ยมมาก! ขอบคุณ.nn#Person2#: ยินดีเป็นอย่างยิ่ง ฉันคิดว่าคุณต้องการอาหารของคุณ ฉันดีใจที่คุณสนุกกับมันnn—n— — — — –nnn### สรุป:nnn### การตอบสนอง:nหลังจากกล่องโต้ตอบ | #Person1# และ #Person2# กินข้าวที่บ้านของ #Person2# พวกเขาพูดถึงอาหารและไวน์ที่ผสมผสานกับไก่.nn |

| สรุปบทสนทนานี้:n#Person1#: ขอโทษที ฉันกำลังเขียนเรียงความเกี่ยวกับกรีกโบราณ มีหนังสือเล่มใดบ้างในหัวข้อนี้ที่คุณสามารถแนะนำได้?n#Person2#: Geese? คุณอยากเขียนเกี่ยวกับห่านโบราณไหม? ฉันไม่เคยได้ยินเรื่องนี้มาก่อน ยังไงก็ตามจะเป็นหนังสือเกี่ยวกับสัตว์ต่างๆ ครับ แถว J หรือจะลองวิทยาศาสตร์ก็อยู่ในแถว Gn#Person1#: Animals ครับ? แต่กรีซเป็นประเทศ ไม่ใช่สัตว์n#Person2#: โอ้ กรีซ คุณรู้ไหมว่าวันนี้ต้องเป็นวันโชคดีของคุณ เราเพิ่งได้รับหนังสือชุดใหม่เกี่ยวกับหัวข้อนั้น มีนักเขียนอยู่แถวนี้ Cn#Person1#: เข้าใจแล้ว มีหนังสือมากมาย คุณแนะนำอะไร?n#Person2#: หนังสือของ Robin Smith ยอดเยี่ยมมากแต่ยาวมาก เป็นองค์ที่มีรูปปั้นอยู่บนปก นอกจากนี้ยังมีผลงานของ Milton Pike อีกด้วย มีภาพวาดทหารอยู่ด้านหน้า อย่างที่คุณเห็นมันไม่หนามากดังนั้นจึงไม่ควรใช้เวลาอ่านนานเกินไป แต่หนังสือที่ดีที่สุดน่าจะเป็นเล่มที่มีภาพสนามกีฬาโอลิมปิกโบราณ ได้รับรางวัลผลงานประวัติศาสตร์มาหลายครั้งแล้วn#Person1#: ก็ยากที่จะตัดสินใจ แต่ฉันเกรงว่าฉันไม่มีเวลาเพียงพอสำหรับการอ่านมากนัก ฉันคิดว่าฉันจะได้หนังสือของ Milton Pike.n#Person2#: ตกลง ฉันขอบัตรห้องสมุดของคุณหน่อยได้ไหม?n#Person1#: ได้สิ คุณอยู่นี่แล้วn—nสรุป:nnn### Response:n | #Person1# ขอให้ #Person2# แนะนำหนังสือเกี่ยวกับกรีกโบราณ #Person2# แนะนำอันที่เขียนโดย Robin Smith ซึ่งยาวมาก อันที่เขียนโดย Milton Pike ซึ่งไม่หนามาก และอันที่ชนะรางวัลผลงานประวัติศาสตร์มากมาย เนื่องจาก #Person1# ไม่มีเวลาเพียงพอ #Person1# จะได้รับหนังสือโดย Milton Pike | n—nnสรุป:n | #Person1# กำลังเขียนเรียงความเกี่ยวกับกรีกโบราณ #Person2# แนะนำหนังสือเกี่ยวกับกรีกโบราณให้กับ #Person1# ซึ่งเพิ่งมาใหม่ทั้งหมดและแนะนำให้ซื้อหนังสือโดย Milton Pike.nn |

| สรุปกล่องโต้ตอบนี้:n#Person1#: ฉันเห็นว่าคุณมีหนังสือแล้ว จอร์จ แต่คุณกำลังอ่านอยู่หรือเปล่า? ดูเหมือนว่าคุณแค่ระบายสีn#Person2#: ฉันกำลังทำเครื่องหมายส่วนสำคัญของหนังสือ สีมีไว้สำหรับสิ่งของที่แตกต่างกันn#Person1#: ชอบอะไร?n#Person2#: แนวคิดหลักคือสีเหลือง รายละเอียดสำคัญที่ต้องจำคือสีชมพูและสีเขียวอ่อนสำหรับไอเดียที่ยากn#Person1#: ดูเหมือนว่าจะมีกิจกรรมมากมาย คุณไม่เสียเวลาเหรอ?n#Person2#: ฉันไม่คิดอย่างนั้นนะแม่ ฉันจะอ่านมันทั้งหมดคืนนี้ ฉันจะฟังมันพรุ่งนี้ แล้วเมื่อถึงเวลาเรียนฉันก็จะรู้ข้อมูลส่วนใหญ่อยู่แล้วn#Person1#: สมัยนี้เราแค่อ่านหนังสือและพยายามจำข้อมูลn#Person2#: ครูบอกเราถึงความสำคัญของ การอ่านที่ใช้งานอยู่ และเป็นวิธีที่ดีที่สุดในการเรียนรู้ไม่ว่าจะเลือกความเร็วเท่าไรก็ตามn#Person1#: เข้าใจแล้ว แล้วสมุดบันทึกนี้มีไว้ทำอะไร?n#Person2#: มีไว้จดบันทึก คุณเขียนอะไรลงไป?n#Person1#: บางครั้งฉันก็เขียนสรุป ในหน้านี้ฉันเขียนคำถาม และแน่นอนว่า ฉันมีอีกหน้าหนึ่งที่ฉันจดคำศัพท์ใหม่ไว้n—nSummary:nnn### Response:n | จอร์จบอกแม่ของเขาว่าการทำเครื่องหมายส่วนสำคัญของหนังสือด้วยสีต่างๆ เป็นวิธีการเรียนรู้ของเขา เขายังจดบันทึกลงในสมุดบันทึกและบางครั้งก็เขียนสรุปด้วย | #บุคคล1#: โอ้! การอ่านอย่างกระตือรือร้น คำถามในการอ่าน บันทึกคำศัพท์ สรุป และการเน้นข้อความ ตอนนี้ฉันเห็นความแตกต่างแล้วในเรื่องข้อมูลการเรียนรู้ ประทับใจค่ะn#Person2#: ขอบคุณค่ะ การอ่านเป็นวิธีที่ดีที่สุดในการเรียนรู้และจดจำข้อมูลใหม่ๆ ตอนนี้คุณกำลังใช้การอ่านแบบแอคทีฟอยู่หรือเปล่า?n#Person1#: อืม….. ฉันคงต้องคิดดูก่อนแล้วnnn#Person | จอร์จบรรยายถึงกิจกรรมที่เขาทำเพื่ออ่านหนังสืออย่างรวดเร็ว จอร์จแสดงสมุดบันทึกให้แม่ดูและอธิบายวิธีจดบันทึก |

| สรุปกล่องโต้ตอบนี้:n#Person1#: สวัสดีตอนเช้าครับ ฉันขอดูหนังสือเดินทางของคุณได้ไหมn#Person2#: ใช่ แน่นอน นี่คือ.n#Person1#: ขอบคุณ ทั้งหมดนี้เป็นของคุณหรือเปล่า?n#Person2#: ไม่ บางส่วนเป็นของเพื่อนฉัน คุณต้องการพาสปอร์ตของเธอด้วยไหม?n#Person1#: ได้ครับ คุณมีสิ่งของถือขึ้นเครื่องไหม?n#Person2#: คุณต้องการให้ฉันคาดเข็มขัดด้วยไหม?n#Person1#: ครับ. คุณช่วยเปิดกระเป๋าเดินทางใบใหญ่นี้หน่อยได้ไหมn#Person2#: โอเค รอสักครู่. มันเป็นแค่เสื้อผ้าและอุปกรณ์อาบน้ำบางส่วนn#Person1#: โอเค คุณมีอะไรต้องสำแดงหรือไม่n#Person2#: ฉันคิดว่าไม่มีอะไรแล้วn#Person1#: อาหารสด พืชหรือสัตว์ที่มีชีวิต?n#Person2#: โอ้ ไม่ ไม่มีเลยn#Person1#: ขอบคุณ คุณสามารถล็อคกระเป๋าเดินทางของคุณได้ นี่คือหนังสือเดินทางของคุณn#Person2#: ขอบคุณมากn—nสรุป:nnn### การตอบสนอง:n | #Person1# เห็นหนังสือเดินทางของเพื่อน #Person2# และ #Person2# และตรวจกระเป๋าเดินทางของพวกเขา #Person2# บอก #Person1# ว่าพวกเขาไม่มีอะไรจะประกาศ #Person1# ปล่อยพวกเขาไป | > ฉันคิดว่าไม่มีอะไรเลยnnn—n**Categories:**nn- [Conversation (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Key:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* ลิขสิทธิ์ใดๆ | ตม.ขอให้ #บุคคล2# แสดงหนังสือเดินทางและเปิดกระเป๋าเดินทางใบใหญ่ #Person2# ไม่มีอะไรจะสำแดง และเขาอาจจะล็อคกระเป๋าเดินทางของเขาไว้nn |

| สรุปบทสนทนานี้:n#Person1#: ชาจีนมีชื่อเสียงไปทั่วโลก ฉันอยากซื้อหลายกล่องn#Person2#: ที่จีนมีชาหลากหลายชนิด ขึ้นอยู่กับรสชาติและผลกระทบn#Person1#: คือว่า ฉันไม่รู้จักชาจีนเลยn#Person2#: นี่คือชาเขียว คุณสามารถดื่มได้ในฤดูร้อน ช่วยคลายความร้อนในฤดูร้อนและบำรุงปอดได้ดีn#Person1#: ฟังดูน่าสนใจนะ แล้วนี่ล่ะ?n#Person2#: มันคือชาดำ มีรสชาติเข้มข้นและช่วยในการย่อยอาหารn#Person1#: นี่อะไรน่ะ? มีกลิ่นหอมn#Person2#: เป็นชามะลิคุณภาพสูง มีกลิ่นหอมและมีรสชาติที่ถูกใจn#Person1#: ฉันจะดื่มชามะลิ คุณสามารถแพ็คมันด้วยกระดาษห่อและริบบิ้นได้หรือไม่? มันเป็นของขวัญสำหรับเพื่อนของฉันn#Person2#: ไม่มีปัญหา รอสักครู่n—nสรุป:nnn### การตอบสนอง:n | #Person2# แนะนำชาเขียว ชาดำ และเสื้อยืดมะลิให้กับ #Person1# ที่ต้องการซื้อชาจีน และ #Person1# ตัดสินใจรับชามะลิ | #[ภาษาอังกฤษ]#: ชาจีนมีชื่อเสียงไปทั่วโลก ฉันต้องการซื้อหลายกล่องn#[French]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[Spanish]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[ภาษาเยอรมัน]#: Ich mö | #Person1# ต้องการซื้อชาจีนหลายกล่องพร้อมชาประเภทต่างๆ #Person2# ช่วย #Person1# เลือกและจะแพ็คให้ครับnn |

- ผลลัพธ์สำหรับการปรับแต่งโมเดล Llama-2 13B อย่างละเอียดบนชุดข้อมูล Dialogsum:

| ปัจจัยการผลิต | ความจริงพื้นดิน | การตอบสนองจากโมเดลที่ไม่ปรับแต่งอย่างละเอียด | การตอบสนองจากรุ่น Fine-Tuned |

| สรุปบทสนทนานี้:n#Person1#: นางทอมป์สันเคยไม่เชื่อพระเจ้า Jason.n#Person2#: เพราะเหตุใด เราไม่ควรเดือดร้อนหรืออะไรเลย? อันที่จริง เรากระตือรือร้นกันมากในระหว่างการอภิปรายทั้งชั้นเรียนเมื่อเช้านี้n#Person1#: แค่นั้นแหละ ฉันไม่คิดว่ามันเป็นสิ่งที่ไม่ดีเลย ฉันคิดว่าเธอกำลังจะขอให้เราลงสมัคร class monitor.n#Person2#: โอ้โห! จริงหรือ นั่นเป็นความรับผิดชอบที่สูงมากn#Person1#: ฉันคิดว่าคุณคงทำได้ดีมาก นอกจากนี้ยังเป็นเกียรติอย่างยิ่งที่ถูกขอให้ทำ แปลว่าคุณทอมป์สันมองว่าเราเป็นผู้นำn#Person2#: แต่ไม่แน่ใจว่าทำเองได้หรือเปล่า เราทำมันด้วยกันได้ไหมn#Person1#: ลองถามนางทอมป์สันดูสิ ตอนนี้ฉันได้ยินเธอเข้ามาจากโถงทางเดินn—nสรุป:nnn### การตอบสนอง:n | #Person1# บอก Jason Mrs. Thompson ครั้งหนึ่งว่าเคยไม่เชื่อพระเจ้า และ #Person1# เดาว่าเธอต้องการให้พวกเขาลงสมัครเป็นผู้ดูแลชั้นเรียน พวกเขาจะถามคุณทอมป์สันว่าจะทำสิ่งนี้ด้วยกันได้ไหม | n* เมื่อครูถาม Jason และเพื่อนร่วมชั้นว่าอยากลงสมัครเป็นผู้ดูแลชั้นเรียนหรือไม่ เขาและเพื่อนร่วมชั้นก็ตกลงร่วมกัน เด็กชายทั้งสองเป็นคริสเตียน แต่พวกเขาไม่ใช่เพื่อนกันในชั้นเรียนn* ศรัทธาของพวกเขาในพระเยซูอาจไม่เปิดเผยต่อสาธารณะ แต่เห็นได้ชัดผ่านการอธิษฐานและตัวอย่างที่พวกเขาปฏิบัติตามร่วมกันเพื่อช่วยเหลือผู้อื่นและแสดงความรักnn—n## 1654nn **[สถานการณ์:** นักเรียนกำลังพูดถึงเรื่องล่าสุด | ครูทอมป์สันขอให้เจสันและเจมส์ลงสมัครเป็นผู้ดูแลชั้นเรียนเพราะเธอคิดว่าพวกเขาเป็นผู้นำ |

| สรุปบทสนทนานี้:n#Person1#: เฮ้ มาดูบ้านตรงนั้นกันดีกว่าn#Person2#: ใช่ มันดูดีมาก! มันอยู่ในรายการ Open House ของเราหรือเปล่าn#Person1#: ใช่ มันอยู่ในรายการของเราn#Person2#: ก็ดูดีเมื่อมองจากขอบถนน เข้าไปข้างในกันเถอะn#Person1#: มาลงนามในรีจิสทรีกันเถอะ ตอนนี้นายหน้าดูเหมือนจะยุ่งมากn#Person2#: โอเค ไปลองดูห้องครัวกันต่อไปn#Person1#: โอ้ ดูสิ พวกเขามีของว่างอยู่ตรงนี้n#Person2#: อย่าลืมไปรับนะ ใบปลิวพร้อมข้อมูลเกี่ยวกับบ้านn#Person1#: มันบอกว่าขอบ้านหลังนี้เท่าไหร่?n#Person2#: ใช่ ดูเหมือนว่าจะลดราคาจากสองแสนสามหมื่นห้าพันเหลือสองร้อย และสองหมื่นห้าพัน—nสรุป:nnn### การตอบสนอง:n | #Person1# และ #Person2# มาดูบ้านกัน พวกเขาตรวจสอบภายในและพูดคุยเกี่ยวกับราคาของมัน | นี่คือการตอบสนองของ AMI ต่อสิ่งเร้าต่อไปนี้nnบุคคลที่ 2: ใช่ มันดูดีมาก! มันอยู่ในรายการ Open House ของเราหรือเปล่า? ใช่ มันอยู่ในรายการของเราnก็ดูดีเมื่อมองจากขอบถนน เข้าไปข้างในกันเถอะมาลงนามในรีจิสทรีกันเถอะ ตอนนี้นายหน้าดูเหมือนจะยุ่งอยู่นะ โอเค ไปดูห้องครัวกันต่อดีกว่า ดูสิ พวกเขามีบ้างแล้ว | #Person1# และ #Person2# กำลังมองไปรอบๆ บ้านที่อยู่ในรายการ Open House พวกเขาลงนามในทะเบียนและ #Person2# บอกให้ #Person1# นำใบปลิวมาพร้อมกับ information.nn |

| สรุปกล่องโต้ตอบนี้:n#Person1#: คุณสบายดีไหม คุณวิลสัน ฉันชื่อ Tina.n#Person2#: ดีใจที่ได้พบคุณ คุณ Tina.n#Person1#: กรุณานั่งก่อน ฉันรู้ว่าการจ้างงานบังคับของเราได้ให้ข้อมูลเกี่ยวกับสัญญาจ้างพนักงานของคุณแก่คุณแล้ว แต่ฉันอยากจะดูรายละเอียดหลักๆ อีกครั้งก่อนที่จะลงนาม ขั้นแรก คุณจะได้รับเงินเดือนรายเดือน โดยมีวันหยุดพักร้อนหนึ่งเดือนหลังจากทำงานครบหนึ่งปีn#Person2#: นั่นคือสิ่งที่ฉันเข้าใจn#Person1#: คุณจะได้รับความคุ้มครองตามแผนการรักษาพยาบาลของเราขณะปฏิบัติหน้าที่ เนื่องจากคุณจะเป็นผู้บริหารระดับกลาง คุณจึงควรพร้อมให้บริการเกินเวลาทำงานปกติสูงสุด 1 ชั่วโมง ระยะเวลาที่ได้รับการอนุมัติใดๆ ที่จะจ่ายในเวลาครึ่งแรก ซึ่งคุณสามารถใช้เป็นเงินเดือนหรือวันหยุดได้n#Person5#: เข้าใจตรงกันนะn#Person2#: บริษัทจะคุ้มครองจำนวนวันลาป่วยตามสมควร . การเจ็บป่วยระยะยาวใด ๆ จะได้รับการคุ้มครองโดยการประกัน คุณได้อ่านเงื่อนไขอื่นๆ ของสัญญาแล้วหรือยัง?n#Person1#: ใช่ ฉันมีแล้วn#Person2#: คุณมีคำถามอื่นๆ อีกหรือไม่?n#Person1#: แค่คำถามเดียว ฉันสังเกตเห็นรายการเกี่ยวกับเวลายืดหยุ่น นั่นเป็นความเป็นไปได้สำหรับฉันหรือไม่?n#Person2#: ใช่ แต่คุณจะต้องปรึกษารายละเอียดกับผู้จัดการของคุณn#Person1#: ก็ยอมรับได้n#Person2#: ดี ตอนนี้ หากคุณจะลงชื่อที่นี่ คุณสามารถเริ่มทำงานได้ภายใน 1 วันn—nสรุป:nnn### Response:n | มิสเตอร์วิลสันอธิบายข้อมูลเบื้องต้นเกี่ยวกับสัญญาจ้างงานให้ทีน่าฟัง เขากล่าวถึงเงินเดือนรายเดือน วันหยุดที่ได้รับค่าจ้างหนึ่งเดือน แผนการรักษาพยาบาล ชั่วโมงการทำงานที่ขยายออกไป และเวลายืดหยุ่น | nไม่ สรุปไม่ถูกต้อง กล่องโต้ตอบ #Person1 ไม่ได้บอกว่าชื่อ Tina แต่ไม่ได้แนะนำตัวเอง ฉันคิดว่าพวกเขาทั้งคู่รู้จักชื่อกัน เลยไม่จำเป็น ฉันคิดว่าถ้าทุกอย่างถูกต้อง สรุปก็จะไม่เปลี่ยนแปลง เว้นแต่ #Person1 จะจบลง และก็ไม่เป็นไร | ทีน่าพบกับมิสเตอร์วิลสันเพื่อดูรายละเอียดหลักเกี่ยวกับสัญญาพนักงานของทีน่า ทั้งสองคุยกันเรื่องเงินเดือนและแผนการรักษาพยาบาล ทีน่าไม่มีคำถามใดๆ และจะเริ่มงานภายใน 3 วัน |

| สรุปบทสนทนานี้:n#Person1#: Jack วิชาโปรดของคุณคืออะไร?n#Person2#: วิชาโปรดของฉัน? ฉันคิดว่าฉันชอบวิทยาศาสตร์มากกว่า ใช่แล้ว วิทยาศาสตร์ ฉันคิดว่ามันน่าสนใจมาก ครูวิทยาศาสตร์ทำให้วิชานี้น่าตื่นเต้นมาก แล้วคุณล่ะ?n#Person1#: ฉันทำได้ดีมากในการสอบคณิตศาสตร์ ฉันก็ชอบภูมิศาสตร์เหมือนกัน ฉันชอบเรียนรู้เกี่ยวกับผู้คนและสถานที่ที่พวกเขาอาศัยอยู่ มีวิชาไหนบ้างที่คุณไม่ชอบแจ็ค?n#Person2#: ฉันไม่ชอบฟิสิกส์มากนัก มันไม่ง่ายที่จะเข้าใจ เด็กส่วนใหญ่เบื่อกับมันn—nสรุป:nnn### Response:n | วิชาโปรดของแจ็คคือวิทยาศาสตร์ ในขณะที่เขาไม่ชอบฟิสิกส์มากนัก #Person1# ชอบคณิตศาสตร์และภูมิศาสตร์ | n—nn### The Word: “favorite” (adj)nnความหมาย: เป็นที่รักและชื่นชมคนอื่นๆ ส่วนใหญ่ nตัวอย่าง: หนังสือเล่มโปรดของฉันคือพระคัมภีร์; กีฬาโปรดของคุณคืออะไร?; สีโปรดของฉันคือ blue.nn—nnnn### ____ หัวข้อของคุณคืออะไร? (เป็นทางการ)nnกล่องโต้ตอบคำถามและคำตอบ:nn#Person1#: คุณชอบวิชาอะไร?n# | แจ็คและแจ็คกำลังพูดถึงวิชาที่พวกเขาชื่นชอบและวิชาที่ชอบน้อยที่สุดnn |

| สรุปกล่องโต้ตอบนี้:n#Person1#: สวัสดี แม็กกี้ ฉันเห็นภาพวาดของคุณในงานนิทรรศการศิลปะโรงเรียนปลายปีที่ผู้ปกครองทุกคนไปเยี่ยมชม เยี่ยมมากn#Person2#: ครูศิลปะของเราดูจะพอใจกับมันมาก แต่ฉันไม่แน่ใจว่าพ่อแม่คิดอย่างไรn#Person1#: โอ้ ไม่ต้องกังวล ฉันได้ยินพวกเขาพูดแต่สิ่งดีๆเกี่ยวกับมันn#Person2#: อืม…เขาคงไม่สังเกตว่าฉันใช้สีที่ไม่ถูกต้องn#Person1#: ฉันไม่คิดว่าจะมีใครสังเกตเห็นn#Person2# : ไม่ แต่ฉันทำ แต่มันก็สายเกินไปที่จะทำอะไรเกี่ยวกับเรื่องนี้ หวังว่าคราวหน้าฉันจะทำสิ่งที่ดีกว่านี้นะn—nสรุป:nnn### Response:n | #Person1# เห็นภาพวาดของแม็กกี้และคิดว่ามันเยี่ยมมาก แต่แม็กกี้กังวลว่าเธอไม่ได้ใช้สีที่ถูกต้องและหวังว่าเธอจะทำอะไรให้ดีขึ้นในครั้งต่อไป | บทสรุปนี้ควรเน้นประเด็นสำคัญและข้อสรุปจากการสนทนาnn# ตอบสนองต่อบุคคลที่ 1:n[สรุปการตอบสนอง]nn—n### การตอบสนอง:nบทสรุปนี้ควรเน้นประเด็นสำคัญและข้อสรุปจากการสนทนา nn# ตอบสนองต่อบุคคลที่2 :n[สรุปการตอบสนอง]nn### Person1:n[สรุป Person1]n—n### Person2:n[สรุป Person2]nn### Personn—n | #Person1# เห็นภาพวาดของแม็กกี้ และบอกกับแม็กกี้ว่าพ่อแม่หลายคนพูดถึงสิ่งดีๆ เกี่ยวกับภาพวาดของแม็กกี้ แม็กกี้ไม่คิดอย่างนั้นnn |

- ผลลัพธ์สำหรับการปรับแต่งโมเดล Llama 2 70B บนชุดข้อมูล Dialogsum:

| ปัจจัยการผลิต | ความจริงพื้นดิน | การตอบสนองจากโมเดลที่ไม่ปรับแต่งอย่างละเอียด | การตอบสนองจากรุ่น Fine-Tuned |

| สรุปกล่องโต้ตอบนี้:n#Person1#: คุณได้รับปริญญาใด ๆ หรือไม่?n#Person2#: ใช่ ในปี 1996 ฉันได้รับปริญญาวิทยาศาสตรบัณฑิตจากมหาวิทยาลัย Hebes และในปี 2001 ฉันได้รับปริญญา MBA จากมหาวิทยาลัยปักกิ่งn#Person1#: แล้วผลการเรียนที่วิทยาลัยของคุณล่ะ?n#Person2#: จริงๆ แล้วประวัติของฉันยอดเยี่ยมมาก เกรดเฉลี่ยโดยรวมของฉันคือ 9 จากทั้งหมด 10 ซึ่งสูงที่สุดในชั้นเรียนของฉันn#Person1#: น่าประทับใจมาก คุณชอบหลักสูตรไหนมากที่สุด?n#Person2#: ภาษาอังกฤษ. ทั้งน่าสนใจและมีประโยชน์ ดังนั้นฉันจึงแสดงความสนใจอย่างมากn#Person1#: คุณบอกฉันได้ไหมว่าทำไมคุณถึงเปลี่ยนวิชาเอกเมื่อคุณยังเป็นนักศึกษาระดับบัณฑิตศึกษา?n#Person2#: เพราะฉันสนใจในการบริหารและ ฉันเคยเรียนบางหลักสูตรในนั้น ฉันยังทำได้ดีในวิชาต่างๆ ดังนั้นฉันเชื่อว่าฉันสามารถทำงานได้ดีในตำแหน่งนี้n#Person1#: คุณได้รับเกียรตินิยมและรางวัลจากวิทยาลัยหรือไม่?n#Person2#: ใช่ ฉันได้รับทุนจากมหาวิทยาลัยทุกปี ในปี 1995 ฉันเข้าร่วมการประกวดแบบจำลองคณิตศาสตร์ระดับชาติ และได้รับรางวัลn—nสรุป:nnn### Response:n | #Person1# สัมภาษณ์ #Person2# และถามคำถาม #Person2# รวมถึงวุฒิการศึกษาของ #Person2# ประวัติการศึกษา หลักสูตรที่ชื่นชอบ และรางวัลในวิทยาลัย #Person2# ยังบอก #Person1# ว่าทำไม #Person2# เปลี่ยนวิชาเอกเป็นการบริหาร | ผู้สมัครสรุปว่าแนวคิดหลักของการสนทนาคือเขาได้รับสองปริญญา 0 และวิชาเอกก็ทำได้ดี อย่างไรก็ตาม ประโยคแรกของเขาไม่ได้ให้อารมณ์ความรู้สึกข้างต้นมากนัก นอกเหนือจากการหลงตัวเอง และไม่ได้ระบุว่าเหตุใดประสบการณ์ของเขาจึงเกี่ยวข้องกับบริษัท เขาสามารถสร้างความสัมพันธ์ที่ดีขึ้น และอาจจบบทสรุปด้วยอารมณ์/ทัศนคติที่ซ่อนอยู่นอกเหนือจาก "ความเป็นมืออาชีพ" (เหมือนที่เขาทำในบทสนทนา) | #Person2# บอกว่า #Person1# #Person2# สำเร็จการศึกษาระดับปริญญาตรี และ MBA เกรดเฉลี่ยของ #Person2# สูงที่สุดในชั้นเรียนของ #Person2# และ #Person2# มีความสนใจในด้านการบริหาร #Person2# ยังได้รับเกียรติและรางวัลจาก College.nn อีกด้วย |

| สรุปกล่องโต้ตอบนี้:n#Person1#: ขอโทษที เนื้อหาคืออะไร n#บุคคล2#: ราคิ คุณต้องการอะไร? n#Person1#: ไม่ ผ้าฝ้ายอยู่ไหน? n#Person2#: ฉันจะแสดงให้คุณดู n#Person1#: อัตราการหดตัวหลังการซักคือเท่าใด? n#บุคคล2#: น้อยกว่า 5% มันค่อนข้างทนทาน n—nสรุป:nnn### การตอบสนอง:n | #Person2# บอก #Person1# เสื้อผ้าฝ้ายทนทาน | สำหรับเส้นทาง QA41913 ส่วนนี้ควรมีการสรุปย่อหน้าของกล่องโต้ตอบ ดังนั้น ตัวอย่างเช่น ระบบการออกเสียงและการสร้างคำพูดอัตโนมัติสามารถใช้ข้อความนี้ในการสังเคราะห์เอาต์พุต | #Person1# อยากได้ผ้าฝ้ายบ้าง #Person2# แสดง rhaki.nn บางส่วน |

| สรุปกล่องโต้ตอบนี้:n#Person1#: ขออภัย ฉันมาสาย Tom.n#Person2#: ไม่เป็นไร ริต้า คุณเคยไปที่ไหน?n#Person1#: ที่สถานีตำรวจ. ฉันทำกระเป๋าถือหาย หรือบางทีอาจมีคนเอามันไป ฉันไม่รู้#Person2#: โอ้ ไม่ เกิดอะไรขึ้น นั่งลง. มีอะไรสำคัญอยู่ในนั้นหรือเปล่า?n#Person1#: สำคัญ! สมุดเช็คของฉัน เอกสารทั้งหมดที่ฉันต้องการในการทำงานn#Person2#: โอ้ แย่มาก แต่คุณทำมันหายได้อย่างไรn#Person1#: ก็อย่างที่รู้ ฉันอยู่กับเพื่อนตลอดเช้าและเราก็กินข้าวเที่ยงด้วยกัน หลังจากฉันกินข้าวเที่ยงฉันก็ไปชอปปิ้ง และเมื่อฉันต้องการซื้ออะไรบางอย่าง ฉันหาสมุดเช็คไม่เจอ แล้วฉันก็จำได้ว่ามันอยู่ในกระเป๋าถือของฉัน และกระเป๋าถือของฉันอยู่ในรถของฉันn#Person2#: ดังนั้นคุณจึงกลับไปที่รถของคุณn#Person1#: แต่ฉันไม่พบมันที่นั่นn#Person2#: แล้วคุณก็ไปที่สถานีตำรวจเหรอ?n# Person1#: ไม่ใช่ในทันที ก่อนที่ฉันจะไปสถานีตำรวจ ฉันโทรหาสำนักงานของเพื่อน โชคไม่ดีn#Person2#: คุณควรไปที่ร้านอาหารที่คุณทานอาหารกลางวันแล้วมองหามันn#Person1#: โอ้ ฉันควรจะทำอย่างนั้นแล้วn#Person2#: ตอนนี้คุณควรโทรหาผู้จัดการดีกว่า away.n—nสรุป:nnn### การตอบสนอง:n | ริต้าบอกทอมว่าเธอมาสายเพราะเธอทำกระเป๋าถือหายและพยายามหากระเป๋าถือ ทอมแนะนำให้ริต้าไปที่ร้านอาหารที่เธอทานอาหารกลางวันแล้วมองหามัน | แปลแต่ละประโยคเป็นภาษาอังกฤษ โดยใช้ชุดคำที่คุณชอบที่สุด:n### ค่า:n | ริต้าทำกระเป๋าถือของเธอหาย และทอมแนะนำให้เธอไปที่ร้านอาหารที่เธอทานอาหารกลางวันเพื่อหามัน |

| สรุปกล่องโต้ตอบนี้:n#Person1#: อรุณสวัสดิ์ครับแม่!n#Person2#: อรุณสวัสดิ์ Meg. วันนี้คุณดูไม่ค่อยดีเหรอ? คุณป่วยหรือเปล่า?n#Person1#: ไม่ ฉันไม่ได้ป่วยn#Person2#: ถ้าอย่างนั้น คุณเป็นอะไรกับลูกของฉัน?n#Person1#: Nothing.n#Person2#: โอ้ เอาน่า ที่รัก บอกฉันหน่อยว่าเกิดอะไรขึ้นn#Person1#: I. . . ฉันสอบไม่ผ่าน ฉันหวังว่าฉันจะเรียนหนักจริงๆn#Person2#: โอ้ ใจเย็นๆ นะ ตั้งเป้าหมายได้ตั้งแต่วันนี้n#Person1#: โอเคแม่ ครั้งต่อไปฉันจะไม่สอบตกn—nสรุป:nnn### Response:n | เม็กไม่มีอารมณ์เพราะเธอสอบตก แม่ของเธอสนับสนุนให้เธอตั้งเป้าหมายตั้งแต่วันนี้ | ผู้ช่วยไม่มีการกระทำ verbnAide และวัตถุโดยตรง apres le verbe amountn | #Person1# สอบไม่ผ่านจึงเล่าให้แม่ฟัง แม่ชวน #Person1# เรียนให้หนักขึ้น.nn |

| สรุปกล่องโต้ตอบนี้:n#Person1#: ทุกคนต้องการการสูญเสียทางการเงิน คุณต้องลงทุนเงินออมหากคุณวางแผนที่จะเกษียณอย่างร่ำรวย ฉันกำลังคิดจะซื้อหุ้น อาจเป็นการลงทุนที่ดีหากฉันสามารถบริหารจัดการได้ดี คุณว่าอย่างไร?n#Person2#: ฉันเห็นด้วยกับคุณบางส่วน การซื้อหุ้นไม่ใช่เรื่องยาก แต่การหาเงินสม่ำเสมอจากการซื้อหุ้นเป็นเรื่องยากมาก แม้แต่มืออาชีพก็ไม่พบว่ามันง่าย ดังนั้นควรระมัดระวัง ยังไงก็ตามคนอย่างเราก็ต้องการความช่วยเหลือในการลงทุน ทำไมไม่ทำการวิจัยออนไลน์บ้าง? มีข้อมูล รายงาน และกระดานสนทนาเพื่อให้ความรู้แก่ผู้คนเกี่ยวกับวิธีการลงทุน นอกจากนี้ คุณต้องไปที่เว็บไซต์ที่มีชื่อเสียงซึ่งมีแผนภูมิหุ้นn#Person1#: ว้าว คุณฟังดูเป็นมืออาชีพมากn#Person2#: ฉันเพิ่งดูรายการทีวีการลงทุนเมื่อสุดสัปดาห์ที่แล้ว กลายเป็นประเด็นร้อนมากในทุกวันนี้ จริงๆ แล้ว ฉันไม่ใช่มือใหม่ด้วยซ้ำn—nสรุป:nnn### Response:n | #Person1# และ #Person2# กำลังพูดถึงการซื้อหุ้น #Person2# คิดว่าการสร้างรายได้อย่างสม่ำเสมอด้วยวิธีนี้เป็นเรื่องยาก และแนะนำให้ทำการวิจัยออนไลน์เพื่อเรียนรู้เกี่ยวกับการลงทุน | ฉันเห็นด้วยกับกลยุทธ์การลงทุนที่แนะนำไว้ก่อนหน้านี้ ฉันใช้เวลาและพลังงานอย่างมากในการคิดแผนดังกล่าว เป็นเรื่องดีที่ความไว้วางใจได้ถูกนำมาใช้ตัดสินของฉันในระดับนี้ แท้จริงแล้ว เพื่อนร่วมงานของฉันรู้สึกปลอดภัย เพราะฉันจะทำทุกอย่างเพื่อนำทีมนี้ไปสู่อนาคตการเกษียณที่สดใสและปลอดภัย ฉันหวังว่าจะได้บทบาทของคุณในฐานะสมาชิกที่กระตือรือร้นของทีม | #Person1# อยากซื้อหุ้น แต่ #Person2# บอก #Person1# ให้ระวัง เพราะลงทุนยาก #Person2# แนะนำ #Person1# ค้นคว้าข้อมูลออนไลน์ เยี่ยมชมเว็บไซต์ที่จัดตั้งขึ้น และดูโปรแกรมการลงทุน.nn |

การจัดรูปแบบชุดข้อมูล

ขณะนี้เรามีการปรับแต่งอย่างละเอียดสองประเภท: การปรับแต่งคำสั่งอย่างละเอียด และการปรับแต่งการปรับโดเมนอย่างละเอียด คุณสามารถสลับไปใช้วิธีการฝึกอบรมวิธีใดวิธีหนึ่งได้อย่างง่ายดายโดยการระบุพารามิเตอร์ instruction_tuned เช่น 'True' หรือ 'False'

รูปแบบการปรับโดเมน

โมเดลการสร้างข้อความยังสามารถปรับแต่งอย่างละเอียดบนชุดข้อมูลเฉพาะโดเมนใดก็ได้ หลังจากปรับแต่งชุดข้อมูลเฉพาะโดเมนอย่างละเอียดแล้ว โมเดลดังกล่าวคาดว่าจะสร้างข้อความเฉพาะโดเมนและแก้ไขงาน NLP ต่างๆ ในโดเมนเฉพาะนั้นด้วยการแจ้งเตือนเพียงไม่กี่ช็อต

สำหรับการป้อนข้อมูลให้กับโมเดล ให้ใช้ไดเร็กทอรีการฝึกอบรมและการตรวจสอบเพิ่มเติม แต่ละไดเรกทอรีประกอบด้วยไฟล์ CSV, JSON หรือ TXT สำหรับไฟล์ CSV และ JSON ระบบจะใช้ข้อมูลรถไฟหรือการตรวจสอบความถูกต้องจากคอลัมน์ชื่อข้อความ หรือคอลัมน์แรกหากไม่มีคอลัมน์ชื่อ text พบแล้ว จำนวนไฟล์ที่อยู่ภายใต้การฝึกและการตรวจสอบความถูกต้อง (หากระบุ) ควรเท่ากับ 1 ตามลำดับ

ผลลัพธ์คือโมเดลที่ผ่านการฝึกอบรมซึ่งสามารถนำไปใช้เพื่อการอนุมานได้

ต่อไปนี้เป็นตัวอย่างไฟล์ TXT สำหรับการปรับแต่งโมเดลการสร้างข้อความอย่างละเอียด ไฟล์ TXT เป็นการยื่นต่อ SEC ของ Amazon ตั้งแต่ปี 2021–2022:

คำแนะนำการปรับจูน

โมเดลการสร้างข้อความสามารถปรับคำแนะนำกับข้อมูลข้อความใดๆ ก็ได้ โดยที่ข้อมูลอยู่ในรูปแบบที่ต้องการ โมเดลที่ได้รับการปรับแต่งคำสั่งสามารถนำไปใช้เพื่อการอนุมานเพิ่มเติมได้

สำหรับการป้อนข้อมูล ให้ใช้ไดเร็กทอรีการฝึกอบรมและการตรวจสอบเพิ่มเติม ไดเร็กทอรีการรถไฟและการตรวจสอบความถูกต้องควรมีไฟล์ที่จัดรูปแบบบรรทัด JSON (.jsonl) หนึ่งหรือหลายไฟล์ โดยเฉพาะอย่างยิ่ง ไดเร็กทอรีการรถไฟยังสามารถมีไฟล์เสริม *.json ที่อธิบายรูปแบบอินพุตและเอาต์พุต

โมเดลที่ดีที่สุดจะถูกเลือกตามการสูญเสียการตรวจสอบ ซึ่งคำนวณเมื่อสิ้นสุดแต่ละยุค หากไม่ได้รับชุดการตรวจสอบความถูกต้อง เปอร์เซ็นต์ (ที่ปรับได้) ของข้อมูลการฝึกอบรมจะถูกแบ่งและใช้สำหรับการตรวจสอบโดยอัตโนมัติ

ข้อมูลการฝึกจะต้องอยู่ในรูปแบบบรรทัด JSON (.jsonl) โดยแต่ละบรรทัดจะเป็นพจนานุกรมที่แสดงถึงตัวอย่างข้อมูลเดียว ข้อมูลการฝึกอบรมทั้งหมดจะต้องอยู่ในโฟลเดอร์เดียว อย่างไรก็ตาม สามารถบันทึกเป็นไฟล์ .jsonl ได้หลายไฟล์ นามสกุลไฟล์ .jsonl เป็นสิ่งจำเป็น โฟลเดอร์การฝึกอบรมยังสามารถมีไฟล์ template.json ไฟล์อธิบายรูปแบบอินพุตและเอาต์พุต หากไม่มีไฟล์เทมเพลต ระบบจะใช้เทมเพลตต่อไปนี้:

ในกรณีนี้ ข้อมูลในรายการบรรทัด JSON ต้องมี prompt และ completion สาขา หากมีการระบุเทมเพลตแบบกำหนดเอง ก็จะต้องใช้เทมเพลตนั้นด้วย prompt และ completion ปุ่มเพื่อกำหนดเทมเพลตอินพุตและเอาต์พุต ต่อไปนี้เป็นตัวอย่างเทมเพลตแบบกำหนดเอง:

ในที่นี้ ข้อมูลในรายการบรรทัด JSON จะต้องมี question, contextและ answer เขตข้อมูล

ผลลัพธ์คือโมเดลที่ผ่านการฝึกอบรมซึ่งสามารถนำไปใช้เพื่อการอนุมานได้

เราจัดเตรียมชุดย่อยของข้อมูลการยื่น SEC ของ Amazon มันถูกดาวน์โหลดจากสาธารณะ EDGAR. สำหรับคำแนะนำในการเข้าถึงข้อมูล โปรดดูที่ การเข้าถึงข้อมูล EDGAR.

ใบอนุญาต: ใบอนุญาต Creative Commons Attribution-ShareAlike (CC BY-SA 4.0)

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. ยานยนต์ / EVs, คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ChartPrime. ยกระดับเกมการซื้อขายของคุณด้วย ChartPrime เข้าถึงได้ที่นี่.

- BlockOffsets การปรับปรุงการเป็นเจ้าของออฟเซ็ตด้านสิ่งแวดล้อมให้ทันสมัย เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/fine-tune-llama-2-for-text-generation-on-amazon-sagemaker-jumpstart/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 000

- 1

- 10

- 100

- 12

- 13

- 14

- 15%

- 16

- 17

- 1870

- 19

- 1930

- 1933

- 1934

- 1985

- 1995

- 1996

- 20

- 2000

- 2001

- 2005

- 2006

- 2008

- 2011

- 2017

- 2023

- 2025

- 21e

- 23

- 24

- 25

- 26%

- 27

- 27a

- 28

- 29

- 30

- 31

- 32

- 36

- 39

- 40

- 400

- 50

- 500

- 5th

- 60

- 67

- 7

- 70

- 75

- 8

- 9

- a

- ความสามารถ

- สามารถ

- เกี่ยวกับเรา

- เกี่ยวกับมัน

- ข้างบน

- นักวิชาการ

- ยอมรับ

- ยอมรับได้

- เข้า

- การเข้าถึง

- คล่องแคล่ว

- ตาม

- ความถูกต้อง

- ประสบความสำเร็จ

- รับทราบ

- ข้าม

- กระทำ

- การกระทำ

- คล่องแคล่ว

- กิจกรรม

- การกระทำ

- ที่เกิดขึ้นจริง

- จริง

- อาดัม

- การปรับตัว

- เพิ่ม

- นอกจากนี้

- เพิ่มเติม

- ข้อมูลเพิ่มเติม

- นอกจากนี้

- ปรับ

- การบริหาร

- บุญธรรม

- โฆษณา

- โฆษณา

- การโฆษณา

- กลัว

- หลังจาก

- อีกครั้ง

- อายุ

- ตกลง

- ข้อตกลง

- AI

- โมเดล AI

- จุดมุ่งหมาย

- มีวัตถุประสงค์เพื่อ

- อัลบั้ม

- ขั้นตอนวิธี

- อัลกอริทึม

- จัดแนว

- ทั้งหมด

- อนุญาต

- การอนุญาต

- ตาม

- แอลฟา

- แล้ว

- ด้วย

- แม้ว่า

- เสมอ

- am

- อเมซอน

- อเมซอน SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- อเมริกัน

- ในหมู่

- จำนวน

- amy

- an

- การวิเคราะห์

- โบราณ

- และ

- สัตว์

- สัตว์

- ประกาศ

- ประกาศ

- อื่น

- คำตอบ

- คำตอบ

- ใด

- ทุกคน

- สิ่งใด

- เห็นได้ชัด

- อุทธรณ์

- อุทธรณ์

- อุทธรณ์

- ปรากฏ

- ปรากฏ

- ปรากฏ

- ประยุกต์

- ใช้

- ได้รับการแต่งตั้ง

- ขอขอบคุณ

- เหมาะสม

- อย่างเหมาะสม

- ได้รับการอนุมัติ

- เมษายน

- สถาปัตยกรรม

- เป็น

- AREA

- อาร์เจนตินา

- เป็นที่ถกเถียงได้

- อาร์กิวเมนต์

- เกิดขึ้น

- ติดอาวุธ

- กองทัพบก

- รอบ

- แถว

- ศิลปะ

- อาร์เธอร์

- บทความ

- เทียม

- ปัญญาประดิษฐ์

- ปัญญาประดิษฐ์และการเรียนรู้ด้วยเครื่อง

- ศิลปะ

- AS

- เอเชีย

- ถาม

- ช่วยเหลือ

- สมมติฐาน

- At

- แอตแลนติ

- การดูแลรักษา

- ผู้เข้าร่วมประชุม

- ความสนใจ

- ดึงดูด

- ผู้ฟัง

- สิงหาคม

- ออสติน

- ออสเตรเลีย

- ผู้เขียน

- อัตโนมัติ

- อัตโนมัติ

- อัตโนมัติ

- ความพร้อมใช้งาน

- ใช้ได้

- เฉลี่ย

- หลีกเลี่ยง

- ที่ได้รับรางวัล

- ได้รับรางวัล

- ไป

- AWS

- ทารก

- กลับ

- ไม่ดี

- ราว

- ตาม

- การต่อสู้

- การต่อสู้

- BE