การเพิ่มขึ้นของกิจกรรมทางสังคมออนไลน์ เช่น เครือข่ายสังคมออนไลน์หรือเกมออนไลน์มักเต็มไปด้วยพฤติกรรมที่ไม่เป็นมิตรหรือก้าวร้าว ซึ่งอาจนำไปสู่การแสดงออกที่ไม่พึงประสงค์ของคำพูดแสดงความเกลียดชัง การกลั่นแกล้งบนอินเทอร์เน็ต หรือการล่วงละเมิด ตัวอย่างเช่น ชุมชนเกมออนไลน์หลายแห่งเสนอฟังก์ชันการแชทด้วยเสียงเพื่ออำนวยความสะดวกในการสื่อสารระหว่างผู้ใช้ แม้ว่าการแชทด้วยเสียงมักจะสนับสนุนการหยอกล้อที่เป็นมิตรและการพูดคุยแบบไร้เหตุผล แต่มันก็สามารถนำไปสู่ปัญหาต่างๆ เช่น คำพูดแสดงความเกลียดชัง การกลั่นแกล้งบนอินเทอร์เน็ต การล่วงละเมิด และการหลอกลวง การตั้งค่าสถานะภาษาที่เป็นอันตรายช่วยให้องค์กรรักษาการสนทนาอย่างสุภาพ และรักษาสภาพแวดล้อมออนไลน์ที่ปลอดภัยและครอบคลุมสำหรับผู้ใช้ในการสร้าง แบ่งปัน และมีส่วนร่วมได้อย่างอิสระ ทุกวันนี้ หลายบริษัทพึ่งพาผู้ดูแลที่เป็นมนุษย์เพียงอย่างเดียวในการตรวจสอบเนื้อหาที่เป็นพิษ อย่างไรก็ตาม การปรับขนาดผู้ดูแลที่เป็นมนุษย์เพื่อตอบสนองความต้องการเหล่านี้ด้วยคุณภาพและความเร็วที่เพียงพอนั้นมีราคาแพง ส่งผลให้หลายองค์กรเสี่ยงเผชิญกับอัตราการออกจากงานของผู้ใช้ที่สูง ความเสียหายด้านชื่อเสียง และค่าปรับตามระเบียบข้อบังคับ นอกจากนี้ ผู้ดูแลมักจะได้รับผลกระทบทางจิตใจจากการทบทวนเนื้อหาที่เป็นพิษ

ถอดความจากอเมซอน เป็นบริการการรู้จำเสียงอัตโนมัติ (ASR) ที่ช่วยให้นักพัฒนาสามารถเพิ่มความสามารถในการเปลี่ยนเสียงพูดเป็นข้อความไปยังแอปพลิเคชันของตนได้อย่างง่ายดาย วันนี้เราตื่นเต้นที่จะประกาศ การตรวจจับความเป็นพิษของ Amazon Transcribeความสามารถที่ขับเคลื่อนด้วยแมชชีนเลิร์นนิง (ML) ที่ใช้ทั้งเสียงและข้อความเพื่อระบุและจัดประเภทเนื้อหาที่เป็นพิษจากเสียงในเจ็ดประเภท ได้แก่ การล่วงละเมิดทางเพศ คำพูดแสดงความเกลียดชัง การคุกคาม การละเมิด การดูหมิ่น ดูหมิ่น และภาษากราฟิก . นอกจากข้อความแล้ว การตรวจจับความเป็นพิษยังใช้ตัวชี้นำในการพูด เช่น น้ำเสียงและระดับเสียงแหลมเพื่อเน้นย้ำถึงเจตนาที่เป็นพิษในการพูด

นี่เป็นการปรับปรุงจากระบบการกลั่นกรองเนื้อหามาตรฐานที่ออกแบบมาเพื่อเน้นเฉพาะคำศัพท์เฉพาะ โดยไม่คำนึงถึงความตั้งใจ องค์กรส่วนใหญ่มี SLA 7-15 วันในการตรวจสอบเนื้อหาที่รายงานโดยผู้ใช้ เนื่องจากผู้ดูแลต้องฟังไฟล์เสียงที่มีความยาวเพื่อประเมินว่าการสนทนาเป็นพิษหรือไม่และเมื่อใด ด้วย Amazon Transcribe Toxicity Detection ผู้ดูแลจะตรวจสอบเฉพาะส่วนเฉพาะของไฟล์เสียงที่ถูกตั้งค่าสถานะว่ามีเนื้อหาที่เป็นพิษ (เทียบกับไฟล์เสียงทั้งหมด) ผู้ดูแลเนื้อหาที่เป็นมนุษย์ต้องตรวจสอบลดลง 95% ทำให้ลูกค้าสามารถลด SLA ของพวกเขาให้เหลือเพียงไม่กี่ชั่วโมง รวมทั้งช่วยให้พวกเขาตรวจสอบเนื้อหาเชิงรุกได้มากขึ้นนอกเหนือจากที่ผู้ใช้ตั้งค่าสถานะ จะช่วยให้องค์กรต่างๆ ตรวจจับและกลั่นกรองเนื้อหาตามขนาดโดยอัตโนมัติ จัดเตรียมสภาพแวดล้อมออนไลน์ที่ปลอดภัยและครอบคลุม และดำเนินการก่อนที่มันจะทำให้ผู้ใช้เลิกใช้งานหรือเกิดความเสียหายต่อชื่อเสียง แบบจำลองที่ใช้สำหรับการตรวจจับเนื้อหาที่เป็นพิษได้รับการดูแลโดย Amazon Transcribe และอัปเดตเป็นระยะเพื่อรักษาความถูกต้องและความเกี่ยวข้อง

ในโพสต์นี้ คุณจะได้เรียนรู้วิธีการ:

- ระบุเนื้อหาที่เป็นอันตรายในการพูดด้วย Amazon Transcribe Toxicity Detection

- ใช้คอนโซล Amazon Transcribe เพื่อตรวจหาความเป็นพิษ

- สร้างงานถอดความด้วยการตรวจหาความเป็นพิษโดยใช้ อินเทอร์เฟซบรรทัดคำสั่ง AWS AWS (AWS CLI) และ Python SDK

- ใช้การตอบสนอง API การตรวจจับความเป็นพิษของ Amazon Transcribe

ตรวจจับความเป็นพิษในการแชทด้วยเสียงด้วย Amazon Transcribe Toxicity Detection

ขณะนี้ Amazon Transcribe มีโซลูชันที่ใช้ ML ที่เรียบง่ายสำหรับการทำเครื่องหมายภาษาที่เป็นอันตรายในการสนทนาที่พูด คุณลักษณะนี้มีประโยชน์อย่างยิ่งสำหรับโซเชียลมีเดีย เกม และความต้องการทั่วไป ทำให้ลูกค้าไม่ต้องให้ข้อมูลของตนเองเพื่อฝึกโมเดล ML การตรวจจับความเป็นพิษจัดประเภทเนื้อหาเสียงที่เป็นพิษออกเป็น 0 หมวดหมู่ต่อไปนี้ และให้คะแนนความเชื่อมั่น (1–XNUMX) สำหรับแต่ละหมวดหมู่:

- การดูหมิ่น – คำพูดที่มีคำ วลี หรือคำย่อที่ไม่สุภาพ หยาบคาย หรือก้าวร้าว

- คำพูดแสดงความเกลียดชัง – คำพูดที่วิพากษ์วิจารณ์ ดูหมิ่น ประณาม หรือลดทอนความเป็นมนุษย์ของบุคคลหรือกลุ่มบุคคลบนพื้นฐานของอัตลักษณ์ (เช่น เชื้อชาติ ชาติพันธุ์ เพศ ศาสนา รสนิยมทางเพศ ความสามารถ และชาติกำเนิด)

- เพศที่สนใจ – คำพูดที่บ่งบอกถึงความสนใจ กิจกรรม หรือการเร้าอารมณ์ทางเพศ โดยใช้การอ้างอิงโดยตรงหรือโดยอ้อมถึงส่วนต่างๆ ของร่างกาย ลักษณะทางกายภาพ หรือเพศ

- ดูถูก – คำพูดที่รวมถึงการดูถูกเหยียดหยาม เย้ยหยัน ดูหมิ่น หรือดูแคลน ภาษาประเภทนี้ยังถูกระบุว่าเป็นการกลั่นแกล้ง

- ความรุนแรงหรือการคุกคาม – คำพูดที่รวมถึงการคุกคามเพื่อสร้างความเจ็บปวด การบาดเจ็บ หรือความเป็นปรปักษ์ต่อบุคคลหรือกลุ่ม

- กราฟฟิค – คำพูดที่ใช้คำอธิบายภาพและภาพที่สดใสไม่น่าพอใจ ภาษาประเภทนี้มักตั้งใจขยายความให้ผู้รับรู้สึกอึดอัด

- การล่วงละเมิดหรือการล่วงละเมิด – คำพูดที่มุ่งหมายจะกระทบกระเทือนจิตใจของผู้รับ รวมถึงถ้อยคำที่ดูถูกเหยียดหยามและคัดค้าน

คุณสามารถเข้าถึง Toxicity Detection ผ่าน Amazon Transcribe Console หรือโดยการเรียก API โดยตรงโดยใช้ AWS CLI หรือ AWS SDK บนคอนโซล Amazon Transcribe คุณสามารถอัปโหลดไฟล์เสียงที่คุณต้องการทดสอบความเป็นพิษและรับผลลัพธ์ได้ในไม่กี่คลิก Amazon Transcribe จะระบุและจัดหมวดหมู่เนื้อหาที่เป็นพิษ เช่น การล่วงละเมิด คำพูดแสดงความเกลียดชัง เนื้อหาเกี่ยวกับเรื่องเพศ ความรุนแรง การดูหมิ่น และคำหยาบคาย Amazon Transcribe ยังให้คะแนนความเชื่อมั่นสำหรับแต่ละหมวดหมู่ โดยให้ข้อมูลเชิงลึกที่มีค่าเกี่ยวกับระดับความเป็นพิษของเนื้อหา ขณะนี้การตรวจจับความเป็นพิษมีให้บริการใน Amazon Transcribe API มาตรฐานสำหรับการประมวลผลเป็นชุดและรองรับภาษาอังกฤษแบบสหรัฐอเมริกา

คำแนะนำแบบใช้คอนโซลของ Amazon Transcribe

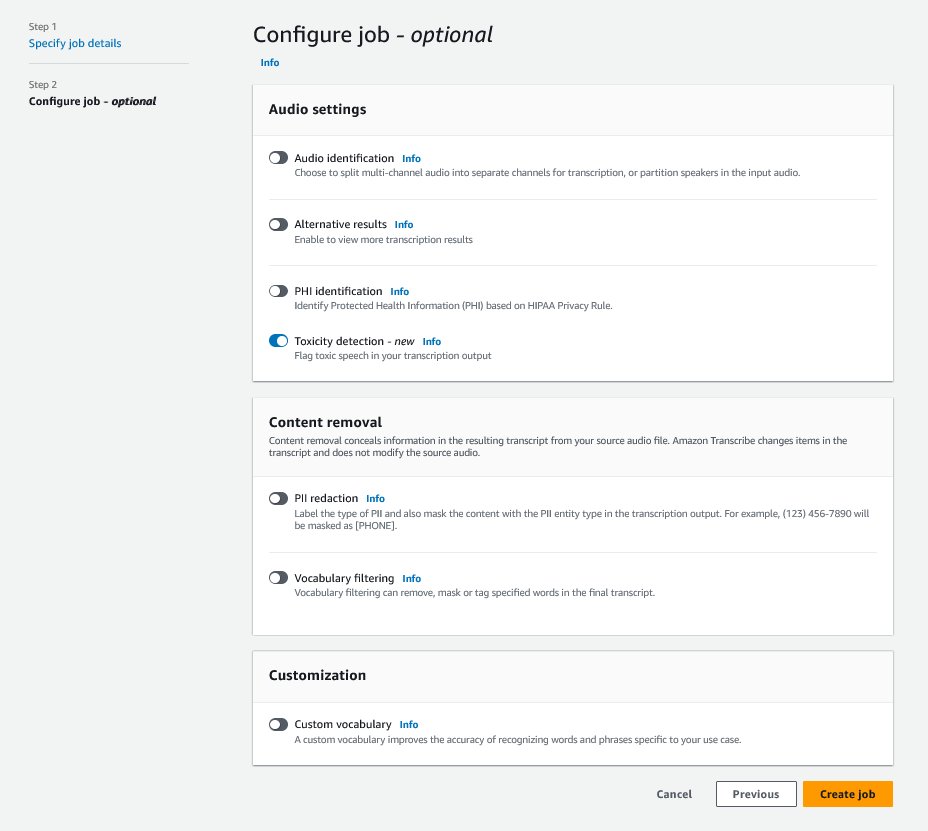

ในการเริ่มต้น ให้ลงชื่อเข้าใช้ คอนโซลการจัดการ AWS แล้วไปที่ Amazon Transcribe หากต้องการสร้างงานถอดความใหม่ คุณต้องอัปโหลดไฟล์ที่บันทึกลงในไฟล์ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (Amazon S3) ก่อนที่จะสามารถดำเนินการได้ ในหน้าการตั้งค่าเสียง เปิดใช้งานดังที่แสดงในภาพหน้าจอต่อไปนี้ การตรวจจับความเป็นพิษ และดำเนินการสร้างงานใหม่ Amazon Transcribe จะประมวลผลงานถอดความในเบื้องหลัง เมื่องานดำเนินไป คุณสามารถคาดหวังว่าสถานะจะเปลี่ยนเป็น เสร็จสิ้น เมื่อกระบวนการเสร็จสิ้น

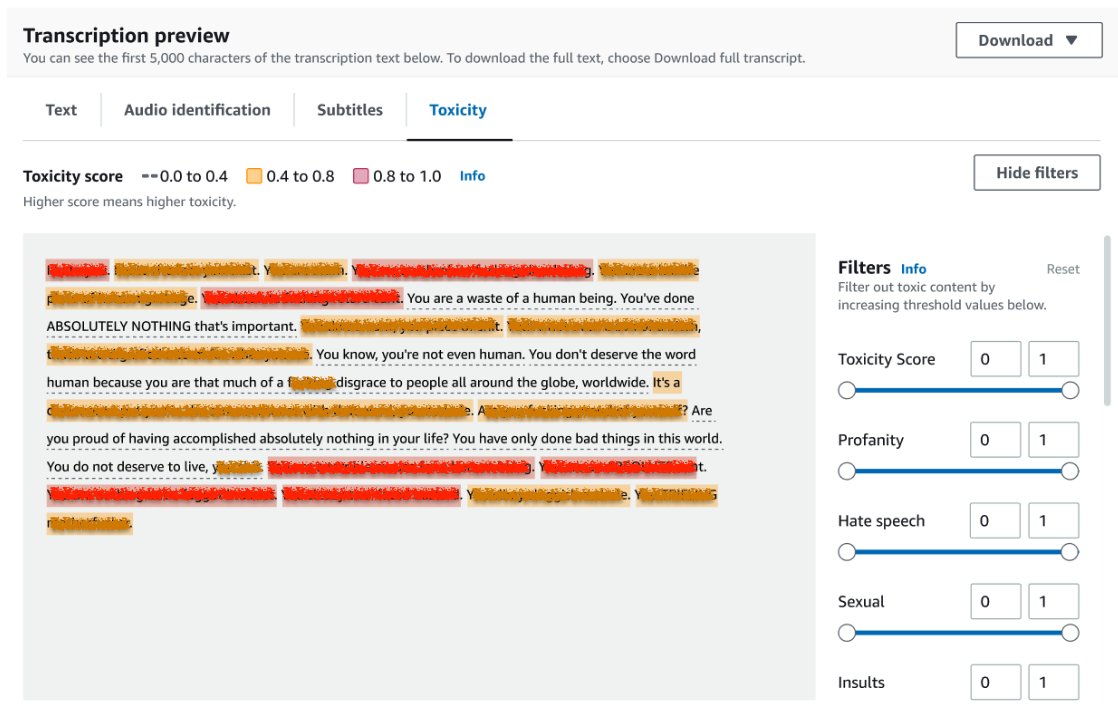

หากต้องการตรวจสอบผลลัพธ์ของงานถอดความ ให้เลือกงานจากรายการงานเพื่อเปิด เลื่อนลงไปที่ ตัวอย่างการถอดความ ส่วนการตรวจสอบผลลัพธ์บน ความเป็นพิษ แท็บ UI แสดงส่วนการถอดความด้วยรหัสสีเพื่อระบุระดับความเป็นพิษ ซึ่งกำหนดโดยคะแนนความเชื่อมั่น หากต้องการปรับแต่งการแสดงผล คุณสามารถใช้แถบสลับใน ฟิลเตอร์ บานหน้าต่าง แถบเหล่านี้ช่วยให้คุณปรับเกณฑ์และกรองหมวดหมู่ความเป็นพิษได้ตามความเหมาะสม

ภาพหน้าจอต่อไปนี้ครอบคลุมบางส่วนของข้อความถอดความเนื่องจากมีข้อมูลที่ละเอียดอ่อนหรือเป็นพิษ

Transcription API พร้อมคำขอตรวจจับความเป็นพิษ

ในส่วนนี้ เราจะแนะนำคุณเกี่ยวกับการสร้างงานการถอดความด้วยการตรวจจับความเป็นพิษโดยใช้อินเทอร์เฟซการเขียนโปรแกรม หากไฟล์เสียงไม่ได้อยู่ในบัคเก็ต S3 ให้อัปโหลดเพื่อให้แน่ใจว่า Amazon Transcribe เข้าถึงได้ คล้ายกับการสร้างงานถอดความบนคอนโซล เมื่อเรียกใช้งาน คุณต้องระบุพารามิเตอร์ต่อไปนี้:

- ถอดความชื่องาน – ระบุชื่องานเฉพาะ

- MediaFileUri – ป้อนตำแหน่ง URI ของไฟล์เสียงใน Amazon S3 Amazon Transcribe รองรับรูปแบบเสียงต่อไปนี้: MP3, MP4, WAV, FLAC, AMR, OGG หรือ WebM

- รหัสภาษา - ตั้งค่าให้

en-US. จากการเขียนนี้ การตรวจจับความเป็นพิษรองรับเฉพาะภาษาอังกฤษแบบสหรัฐอเมริกาเท่านั้น - หมวดหมู่ความเป็นพิษ - ผ่าน

ALLค่าที่จะรวมหมวดหมู่การตรวจจับความเป็นพิษที่รองรับทั้งหมด

ต่อไปนี้คือตัวอย่างการเริ่มต้นงานถอดความโดยเปิดใช้งานการตรวจหาความเป็นพิษโดยใช้ Python3:

คุณสามารถเรียกใช้งานการถอดความเดียวกันด้วยการตรวจจับความเป็นพิษโดยใช้คำสั่ง AWS CLI ต่อไปนี้:

Transcription API พร้อมการตอบสนองการตรวจจับความเป็นพิษ

เอาต์พุต JSON สำหรับการตรวจจับความเป็นพิษของ Amazon Transcribe จะรวมผลการถอดความไว้ในฟิลด์ผลลัพธ์ การเปิดใช้งานการตรวจจับความเป็นพิษจะเพิ่มฟิลด์พิเศษที่เรียกว่า toxicityDetection ในช่องผลลัพธ์ toxicityDetection รวมรายการของรายการถอดเสียงด้วยพารามิเตอร์ต่อไปนี้:

- ข้อความ – ข้อความที่ถอดความดิบ

- ความเป็นพิษ – คะแนนความเชื่อมั่นของการตรวจจับ (ค่าระหว่าง 0–1)

- หมวดหมู่ – คะแนนความมั่นใจสำหรับแต่ละประเภทของคำพูดที่เป็นพิษ

- เวลาเริ่มต้น – ตำแหน่งเริ่มต้นของการตรวจจับในไฟล์เสียง (วินาที)

- สิ้นสุด_เวลา – ตำแหน่งสิ้นสุดของการตรวจจับในไฟล์เสียง (วินาที)

ต่อไปนี้คือตัวอย่างการตอบสนองต่อการตรวจหาความเป็นพิษแบบย่อที่คุณสามารถดาวน์โหลดได้จากคอนโซล:

สรุป

ในโพสต์นี้ เราได้ให้ภาพรวมของคุณสมบัติการตรวจจับความเป็นพิษของ Amazon Transcribe ใหม่ เรายังอธิบายวิธีแยกวิเคราะห์เอาต์พุต JSON ของการตรวจจับความเป็นพิษ สำหรับข้อมูลเพิ่มเติม โปรดดูที่ Amazon Transcribe Console และลองใช้ Transcription API พร้อม Toxicity Detection

ขณะนี้ Amazon Transcribe Toxicity Detection พร้อมใช้งานในภูมิภาค AWS ต่อไปนี้: สหรัฐอเมริกาฝั่งตะวันออก (โอไฮโอ) สหรัฐอเมริกาฝั่งตะวันออก (เวอร์จิเนียเหนือ) สหรัฐอเมริกาฝั่งตะวันตก (ออริกอน) เอเชียแปซิฟิก (ซิดนีย์) ยุโรป (ไอร์แลนด์) และยุโรป (ลอนดอน) หากต้องการเรียนรู้เพิ่มเติม โปรดไปที่ ถอดความจากอเมซอน.

เรียนรู้เพิ่มเติมเกี่ยวกับ การกลั่นกรองเนื้อหาบน AWS และเรา กรณีการใช้งาน ML การกลั่นกรองเนื้อหา. ก้าวแรกสู่ เพิ่มประสิทธิภาพการดำเนินการตรวจสอบเนื้อหาของคุณด้วย AWS.

เกี่ยวกับผู้เขียน

ลาน่า จาง เป็นสถาปนิกโซลูชันอาวุโสที่ทีม AWS WWSO AI Services ซึ่งเชี่ยวชาญด้าน AI และ ML สำหรับการกลั่นกรองเนื้อหา คอมพิวเตอร์วิทัศน์ และการประมวลผลภาษาธรรมชาติ ด้วยความเชี่ยวชาญของเธอ เธออุทิศตนเพื่อส่งเสริมโซลูชัน AWS AI/ML และช่วยเหลือลูกค้าในการเปลี่ยนแปลงโซลูชันธุรกิจในอุตสาหกรรมที่หลากหลาย รวมถึงโซเชียลมีเดีย เกม อีคอมเมิร์ซ และการโฆษณาและการตลาด

ลาน่า จาง เป็นสถาปนิกโซลูชันอาวุโสที่ทีม AWS WWSO AI Services ซึ่งเชี่ยวชาญด้าน AI และ ML สำหรับการกลั่นกรองเนื้อหา คอมพิวเตอร์วิทัศน์ และการประมวลผลภาษาธรรมชาติ ด้วยความเชี่ยวชาญของเธอ เธออุทิศตนเพื่อส่งเสริมโซลูชัน AWS AI/ML และช่วยเหลือลูกค้าในการเปลี่ยนแปลงโซลูชันธุรกิจในอุตสาหกรรมที่หลากหลาย รวมถึงโซเชียลมีเดีย เกม อีคอมเมิร์ซ และการโฆษณาและการตลาด

สุมิตรมาร์ เป็น Sr Product Manager, Technical ที่ AWS AI Language Services team เขามีประสบการณ์ 10 ปีในการจัดการผลิตภัณฑ์ในหลากหลายโดเมน และหลงใหลเกี่ยวกับ AI/ML นอกเวลางาน สุมิตรชอบท่องเที่ยวและชอบเล่นคริกเก็ตและลอนเทนนิส

สุมิตรมาร์ เป็น Sr Product Manager, Technical ที่ AWS AI Language Services team เขามีประสบการณ์ 10 ปีในการจัดการผลิตภัณฑ์ในหลากหลายโดเมน และหลงใหลเกี่ยวกับ AI/ML นอกเวลางาน สุมิตรชอบท่องเที่ยวและชอบเล่นคริกเก็ตและลอนเทนนิส

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. ยานยนต์ / EVs, คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- BlockOffsets การปรับปรุงการเป็นเจ้าของออฟเซ็ตด้านสิ่งแวดล้อมให้ทันสมัย เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- :มี

- :เป็น

- :ไม่

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- ลด 95%

- a

- ความสามารถ

- เกี่ยวกับเรา

- การล่วงละเมิด

- เข้า

- ตาม

- การบัญชี

- ความถูกต้อง

- ข้าม

- การกระทำ

- กิจกรรม

- อยากทำกิจกรรม

- เพิ่ม

- นอกจากนี้

- เพิ่ม

- การโฆษณา

- ก้าวร้าว

- AI

- บริการ AI

- AI / ML

- ทั้งหมด

- อนุญาต

- แล้ว

- ด้วย

- แม้ว่า

- อเมซอน

- ถอดความจากอเมซอน

- Amazon Web Services

- ในหมู่

- an

- และ

- ประกาศ

- API

- APIs

- การใช้งาน

- เป็น

- AS

- เอเชีย

- ในภูมิภาคเอเชียแปซิฟิก

- การให้ความช่วยเหลือ

- At

- การขัดสี

- เสียง

- อัตโนมัติ

- อัตโนมัติ

- ใช้ได้

- AWS

- พื้นหลัง

- ราว

- รากฐาน

- BE

- กลายเป็น

- เพราะ

- ก่อน

- พฤติกรรม

- ระหว่าง

- เกิน

- ร่างกาย

- ทั้งสอง

- ทำลาย

- การข่มขู่

- ธุรกิจ

- by

- ที่เรียกว่า

- โทร

- CAN

- ความสามารถ

- หมวดหมู่

- หมวดหมู่

- ก่อให้เกิด

- เปลี่ยนแปลง

- ตรวจสอบ

- Choose

- แยกประเภท

- การสื่อสาร

- ชุมชน

- บริษัท

- สมบูรณ์

- เสร็จ

- คอมพิวเตอร์

- วิสัยทัศน์คอมพิวเตอร์

- ความมั่นใจ

- ปลอบใจ

- มี

- เนื้อหา

- การสนทนา

- การสนทนา

- ปกคลุม

- สร้าง

- การสร้าง

- จิ้งหรีด

- บารมี

- ขณะนี้

- ลูกค้า

- ปรับแต่ง

- ข้อมูล

- วัน

- ทุ่มเท

- อธิบาย

- ได้รับการออกแบบ

- ตรวจจับ

- การตรวจพบ

- แน่นอน

- นักพัฒนา

- โดยตรง

- โดยตรง

- แสดง

- หลาย

- โดเมน

- ลง

- ดาวน์โหลด

- สอง

- E-commerce

- แต่ละ

- ตะวันออก

- ง่าย

- ทั้ง

- การกำจัด

- ทำให้สามารถ

- เปิดการใช้งาน

- การเปิดใช้งาน

- ปลาย

- ภาษาอังกฤษ

- ทำให้มั่นใจ

- เข้าสู่

- ผู้ประกอบการ

- ทั้งหมด

- สิ่งแวดล้อม

- โดยเฉพาะอย่างยิ่ง

- เชื้อชาติ

- ยุโรป

- ประเมินค่า

- ตัวอย่าง

- ตัวอย่าง

- ตื่นเต้น

- คาดหวัง

- แพง

- ประสบการณ์

- ความชำนาญ

- พิเศษ

- อำนวยความสะดวก

- หันหน้าไปทาง

- ล้มเหลว

- ลักษณะ

- สองสาม

- สนาม

- เนื้อไม่มีมัน

- ไฟล์

- กรอง

- ค่าปรับ

- ชื่อจริง

- ถูกตั้งค่าสถานะ

- โฟกัส

- ดังต่อไปนี้

- สำหรับ

- เป็นมิตร

- ราคาเริ่มต้นที่

- ฟังก์ชั่น

- การเล่นเกม

- เพศ

- General

- ได้รับ

- Go

- ไป

- กราฟฟิค

- บัญชีกลุ่ม

- ให้คำแนะนำ

- เป็นอันตราย

- มี

- he

- จะช่วยให้

- เธอ

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- จุดสูง

- ชั่วโมง

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- อย่างไรก็ตาม

- HTML

- ที่ http

- HTTPS

- เป็นมนุษย์

- แยกแยะ

- เอกลักษณ์

- if

- ที่กระทบ

- นำเข้า

- การปรับปรุง

- in

- ประกอบด้วย

- รวมถึง

- รวมทั้ง

- รวมทั้ง

- เพิ่ม

- แสดง

- บ่งชี้ว่า

- อุตสาหกรรม

- ข้อมูล

- ข้อมูลเชิงลึก

- ดูถูก

- ตั้งใจว่า

- ความตั้งใจ

- ความตั้งใจ

- จงใจ

- อยากเรียนรู้

- อินเตอร์เฟซ

- เข้าไป

- ไอร์แลนด์

- IT

- รายการ

- การสัมภาษณ์

- jpg

- JSON

- เพียงแค่

- เก็บ

- ภาษา

- นำ

- เรียนรู้

- การเรียนรู้

- ชั้น

- Line

- รายการ

- ที่ตั้ง

- ลอนดอน

- รัก

- เครื่อง

- เรียนรู้เครื่อง

- เก็บรักษา

- ทำให้

- การจัดการ

- ผู้จัดการ

- หลาย

- การตลาด

- ภาพบรรยากาศ

- พบ

- ML

- แบบ

- โมเดล

- การกลั่นกรอง

- ข้อมูลเพิ่มเติม

- มากที่สุด

- ต้อง

- ชื่อ

- แห่งชาติ

- โดยธรรมชาติ

- ประมวลผลภาษาธรรมชาติ

- จำเป็นต้อง

- ความต้องการ

- เครือข่าย

- ใหม่

- ตอนนี้

- of

- เสนอ

- มักจะ

- โอไฮโอ

- on

- ออนไลน์

- เกมออนไลน์

- เพียง

- เปิด

- การดำเนินการ

- or

- ออริกอน

- องค์กร

- ที่มา

- ของเรา

- ออก

- เอาท์พุต

- ด้านนอก

- ภาพรวม

- ของตนเอง

- แปซิฟิก

- หน้า

- อาการเจ็บปวด

- พารามิเตอร์

- มีส่วนร่วม

- ส่วน

- ส่ง

- หลงใหล

- คน

- วลี

- กายภาพ

- ขว้าง

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เล่น

- ส่วน

- ตำแหน่ง

- โพสต์

- การมี

- ปัญหาที่เกิดขึ้น

- กระบวนการ

- แปรรูปแล้ว

- การประมวลผล

- ผลิตภัณฑ์

- การจัดการผลิตภัณฑ์

- ผู้จัดการผลิตภัณฑ์

- ความหยาบคาย

- การเขียนโปรแกรม

- การส่งเสริม

- ให้

- ให้

- ให้

- การให้

- หลาม

- คุณภาพ

- เชื่อชาติ

- ราคา

- ดิบ

- พร้อม

- การรับรู้

- บันทึก

- ลด

- ลดลง

- การอ้างอิง

- ภูมิภาค

- หน่วยงานกำกับดูแล

- ความสัมพันธ์กัน

- ศาสนา

- วางใจ

- รายงาน

- คำตอบ

- ผล

- ผลสอบ

- ทบทวน

- การตรวจสอบ

- ความเสี่ยง

- ปลอดภัย

- เดียวกัน

- ขนาด

- ปรับ

- หลอกลวง

- คะแนน

- เลื่อน

- sdks

- วินาที

- Section

- ที่กำลังมองหา

- ส่วน

- กลุ่ม

- ระดับอาวุโส

- มีความละเอียดอ่อน

- บริการ

- บริการ

- ชุด

- การตั้งค่า

- เจ็ด

- เพศ

- เพศที่สนใจ

- Share

- เธอ

- แสดง

- แสดงให้เห็นว่า

- ลงชื่อ

- คล้ายคลึงกัน

- ง่าย

- สังคม

- โซเชียลมีเดีย

- เครือข่ายทางสังคม

- เพียงผู้เดียว

- ทางออก

- โซลูชัน

- ความเชี่ยวชาญ

- โดยเฉพาะ

- การพูด

- การรู้จำเสียง

- คำพูดเป็นข้อความ

- ความเร็ว

- พูด

- มาตรฐาน

- เริ่มต้น

- ข้อความที่เริ่ม

- ที่เริ่มต้น

- Status

- ขั้นตอน

- การเก็บรักษา

- อย่างเช่น

- เพียงพอ

- ที่สนับสนุน

- รองรับ

- ซิดนีย์

- ระบบ

- เอา

- การพูดคุย

- ทีม

- วิชาการ

- เงื่อนไขการใช้บริการ

- ทดสอบ

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- ภัยคุกคาม

- ตลอด

- เวลา

- ไปยัง

- ในวันนี้

- ไปทาง

- ไปทาง

- รถไฟ

- การเปลี่ยนแปลง

- การเดินทาง

- จริง

- ลอง

- ชนิด

- ui

- ภายใต้

- เป็นเอกลักษณ์

- ที่ไม่พึงประสงค์

- ให้กับคุณ

- us

- ใช้

- มือสอง

- ผู้ใช้งาน

- ผู้ใช้

- ใช้

- การใช้

- มีคุณค่า

- ความคุ้มค่า

- ความหลากหลาย

- ผ่านทาง

- ความรุนแรง

- virginia

- วิสัยทัศน์

- เยี่ยมชมร้านค้า

- เสียงพูด

- vs

- หยาบคาย

- รอ

- ต้องการ

- we

- เว็บ

- บริการเว็บ

- ดี

- ตะวันตก

- เมื่อ

- ในขณะที่

- จะ

- กับ

- ไม่มี

- คำ

- งาน

- การเขียน

- ปี

- ยัง

- คุณ

- ของคุณ

- ลมทะเล