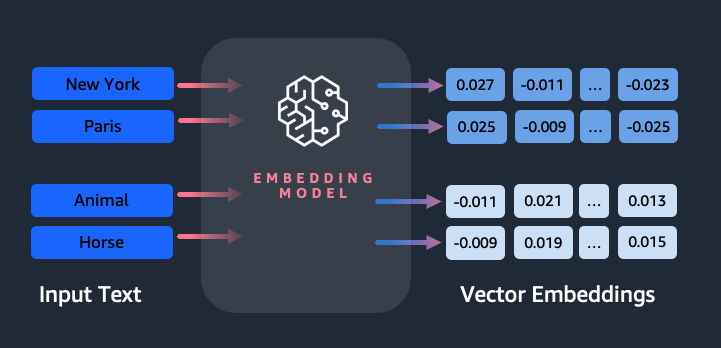

การฝังมีบทบาทสำคัญในการประมวลผลภาษาธรรมชาติ (NLP) และการเรียนรู้ของเครื่อง (ML) การฝังข้อความ หมายถึงกระบวนการแปลงข้อความให้เป็นตัวแทนตัวเลขที่อยู่ในปริภูมิเวกเตอร์มิติสูง เทคนิคนี้ทำได้โดยการใช้อัลกอริธึม ML ที่ช่วยให้เข้าใจความหมายและบริบทของข้อมูล (ความสัมพันธ์เชิงความหมาย) และการเรียนรู้ความสัมพันธ์และรูปแบบที่ซับซ้อนภายในข้อมูล (ความสัมพันธ์เชิงวากยสัมพันธ์) คุณสามารถใช้การแสดงเวกเตอร์ที่ได้เพื่อการใช้งานที่หลากหลาย เช่น การดึงข้อมูล การจัดหมวดหมู่ข้อความ การประมวลผลภาษาธรรมชาติ และอื่นๆ อีกมากมาย

การฝังข้อความ Amazon Titan คือโมเดลการฝังข้อความที่แปลงข้อความภาษาธรรมชาติซึ่งประกอบด้วยคำเดี่ยวๆ วลี หรือแม้แต่เอกสารขนาดใหญ่ ให้กลายเป็นการแสดงตัวเลขที่สามารถใช้เพื่อขับเคลื่อนกรณีการใช้งาน เช่น การค้นหา การทำให้เป็นส่วนตัว และการจัดกลุ่มตามความคล้ายคลึงกันทางความหมาย

ในโพสต์นี้ เราจะพูดถึงโมเดล Amazon Titan Text Embeddings คุณลักษณะ และกรณีการใช้งานตัวอย่าง

แนวคิดหลักบางประการ ได้แก่:

- การแสดงตัวเลขของข้อความ (เวกเตอร์) จะจับความหมายและความสัมพันธ์ระหว่างคำ

- การฝังแบบสมบูรณ์สามารถใช้เพื่อเปรียบเทียบความคล้ายคลึงกันของข้อความ

- การฝังข้อความหลายภาษาสามารถระบุความหมายในภาษาต่างๆ ได้

ข้อความถูกแปลงเป็นเวกเตอร์ได้อย่างไร?

มีเทคนิคหลายประการในการแปลงประโยคให้เป็นเวกเตอร์ วิธีหนึ่งที่ได้รับความนิยมคือการใช้อัลกอริธึมการฝังคำ เช่น Word2Vec, GloVe หรือ FastText จากนั้นจึงรวมคำที่ฝังไว้เพื่อสร้างการแสดงเวกเตอร์ระดับประโยค

วิธีการทั่วไปอีกวิธีหนึ่งคือการใช้โมเดลภาษาขนาดใหญ่ (LLM) เช่น BERT หรือ GPT ซึ่งสามารถจัดเตรียมการฝังตามบริบทสำหรับทั้งประโยคได้ โมเดลเหล่านี้อิงตามสถาปัตยกรรมการเรียนรู้เชิงลึก เช่น Transformers ซึ่งสามารถรวบรวมข้อมูลตามบริบทและความสัมพันธ์ระหว่างคำในประโยคได้อย่างมีประสิทธิภาพมากขึ้น

เหตุใดเราจึงต้องมีโมเดลการฝัง

การฝังเวกเตอร์เป็นพื้นฐานสำหรับ LLM ในการทำความเข้าใจระดับความหมายของภาษา และยังช่วยให้ LLM ทำงานได้ดีในงาน NLP ขั้นปลาย เช่น การวิเคราะห์ความรู้สึก การจดจำเอนทิตีที่มีชื่อ และการจัดประเภทข้อความ

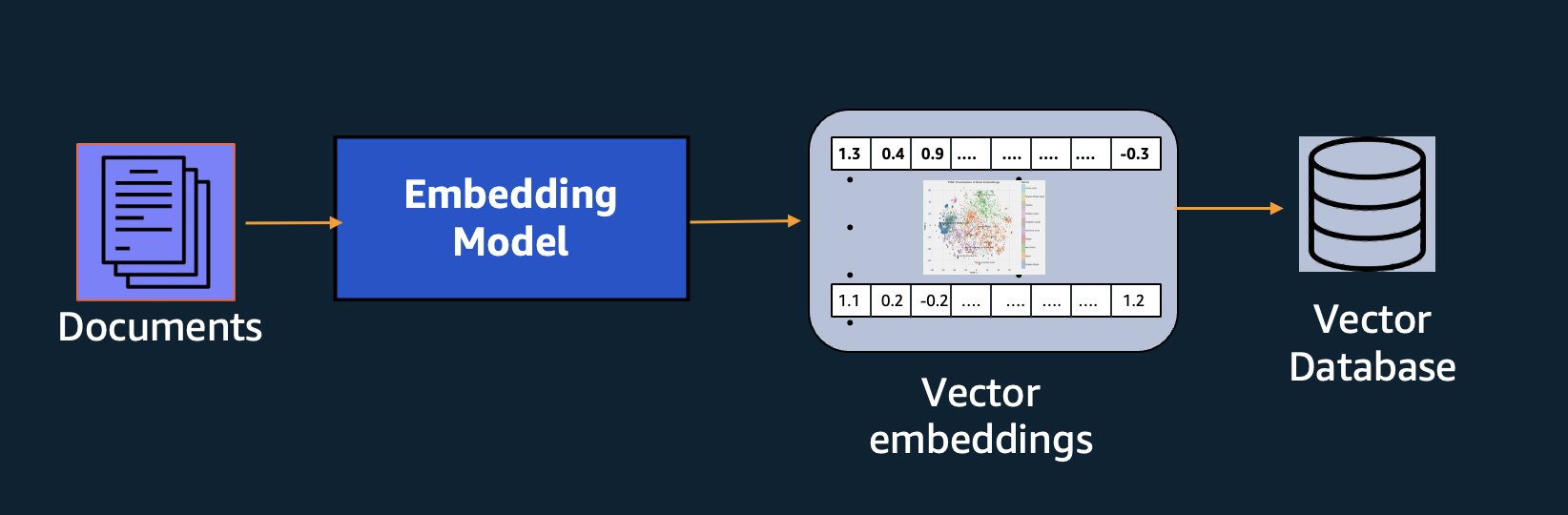

นอกเหนือจากการค้นหาความหมายแล้ว คุณยังสามารถใช้การฝังเพื่อเพิ่มข้อความแจ้งของคุณเพื่อให้ได้ผลลัพธ์ที่แม่นยำยิ่งขึ้นผ่านการดึงข้อมูล Augmented Generation (RAG) แต่เพื่อที่จะใช้งาน คุณจะต้องจัดเก็บไว้ในฐานข้อมูลที่มีความสามารถแบบเวกเตอร์

โมเดล Amazon Titan Text Embeddings ได้รับการปรับให้เหมาะสมสำหรับการดึงข้อความเพื่อเปิดใช้งานกรณีการใช้งาน RAG ช่วยให้คุณสามารถแปลงข้อมูลข้อความของคุณเป็นการแสดงตัวเลขหรือเวกเตอร์ได้ก่อน จากนั้นจึงใช้เวกเตอร์เหล่านั้นเพื่อค้นหาข้อความที่เกี่ยวข้องจากฐานข้อมูลเวกเตอร์อย่างแม่นยำ ช่วยให้คุณสามารถใช้ประโยชน์จากข้อมูลที่เป็นกรรมสิทธิ์ของคุณร่วมกับโมเดลพื้นฐานอื่นๆ ได้อย่างเต็มที่

เนื่องจาก Amazon Titan Text Embeddings เป็นโมเดลที่ได้รับการจัดการ อเมซอน เบดร็อคมันถูกนำเสนอเป็นประสบการณ์แบบไร้เซิร์ฟเวอร์โดยสิ้นเชิง คุณสามารถใช้งานได้ผ่าน Amazon Bedrock REST API หรือ AWS SDK พารามิเตอร์ที่จำเป็นคือข้อความที่คุณต้องการสร้างการฝังและ modelID พารามิเตอร์ซึ่งแสดงถึงชื่อของโมเดล Amazon Titan Text Embeddings โค้ดต่อไปนี้เป็นตัวอย่างการใช้ AWS SDK สำหรับ Python (Boto3):

ผลลัพธ์จะมีลักษณะดังนี้:

เอ่ยถึง การตั้งค่า boto3 ของ Amazon Bedrock สำหรับรายละเอียดเพิ่มเติมเกี่ยวกับวิธีการติดตั้งแพ็คเกจที่จำเป็น เชื่อมต่อกับ Amazon Bedrock และเรียกใช้โมเดล

คุณลักษณะของการฝังข้อความของ Amazon Titan

ด้วย Amazon Titan Text Embeddings คุณสามารถป้อนโทเค็นได้มากถึง 8,000 โทเค็น ทำให้เหมาะสำหรับการทำงานกับคำเดียว วลี หรือเอกสารทั้งหมดตามกรณีการใช้งานของคุณ อเมซอนไททัน ส่งคืนเวกเตอร์เอาท์พุตขนาด 1536 ทำให้มีความแม่นยำในระดับสูง ในขณะเดียวกันก็ปรับให้เหมาะสมเพื่อให้ได้ผลลัพธ์ที่มีความหน่วงต่ำและคุ้มค่า

Amazon Titan Text Embeddings รองรับการสร้างและสืบค้นการฝังข้อความในภาษาต่างๆ มากกว่า 25 ภาษา ซึ่งหมายความว่าคุณสามารถใช้โมเดลกับกรณีการใช้งานของคุณได้โดยไม่จำเป็นต้องสร้างและดูแลรักษาโมเดลแยกกันสำหรับแต่ละภาษาที่คุณต้องการรองรับ

การมีโมเดลการฝังตัวเดียวที่ได้รับการฝึกในหลายภาษาให้ประโยชน์ที่สำคัญดังต่อไปนี้:

- เข้าถึงได้กว้างขึ้น – ด้วยการสนับสนุนมากกว่า 25 ภาษา คุณสามารถขยายขอบเขตการเข้าถึงแอปพลิเคชันของคุณไปยังผู้ใช้และเนื้อหาในตลาดต่างประเทศจำนวนมาก

- ประสิทธิภาพที่สอดคล้อง – ด้วยโมเดลแบบครบวงจรที่ครอบคลุมหลายภาษา คุณจะได้รับผลลัพธ์ที่สอดคล้องกันในภาษาต่างๆ แทนที่จะเพิ่มประสิทธิภาพแยกกันตามภาษา โมเดลนี้ได้รับการฝึกฝนแบบองค์รวมเพื่อให้คุณได้รับประโยชน์จากภาษาต่างๆ

- การสนับสนุนแบบสอบถามหลายภาษา – Amazon Titan Text Embeddings ช่วยให้สามารถสืบค้นข้อความที่ฝังในภาษาใดๆ ที่รองรับได้ ซึ่งให้ความยืดหยุ่นในการเรียกเนื้อหาที่คล้ายคลึงกันทางความหมายในภาษาต่างๆ โดยไม่ถูกจำกัดไว้เพียงภาษาเดียว คุณสามารถสร้างแอปพลิเคชันที่สืบค้นและวิเคราะห์ข้อมูลหลายภาษาโดยใช้พื้นที่การฝังแบบรวมเดียวกัน

ในขณะที่เขียนนี้ รองรับภาษาต่อไปนี้:

- อาหรับ

- จีน (ดั้งเดิม)

- จีน (ดั้งเดิม)

- สาธารณรัฐเช็ก

- Dutch

- ภาษาอังกฤษ

- ภาษาฝรั่งเศส

- ภาษาเยอรมัน

- ชาวอิสราเอล

- ภาษาฮินดี

- ภาษาอิตาลี

- ภาษาญี่ปุ่น

- ดา

- เกาหลี

- มาลายาลัม

- ฐี

- ขัด

- โปรตุเกส

- รัสเซีย

- สเปน

- สวีเดน

- ตากาล็อกฟิลิปปินส์

- มิลักขะ

- กู

- ตุรกี

การใช้การฝังข้อความ Amazon Titan กับ LangChain

หลังเชน เป็นเฟรมเวิร์กโอเพ่นซอร์สยอดนิยมสำหรับการทำงานด้วย AI กำเนิด รุ่นและเทคโนโลยีที่รองรับ ประกอบด้วยก ไคลเอ็นต์ BedrockEmbeddings ที่ล้อม Boto3 SDK ไว้อย่างสะดวกด้วยเลเยอร์นามธรรม ที่ BedrockEmbeddings ไคลเอ็นต์อนุญาตให้คุณทำงานกับข้อความและการฝังได้โดยตรง โดยไม่ต้องทราบรายละเอียดของคำขอ JSON หรือโครงสร้างการตอบกลับ ต่อไปนี้เป็นตัวอย่างง่ายๆ:

คุณยังสามารถใช้ LangChain's ได้ BedrockEmbeddings ไคลเอนต์ควบคู่ไปกับไคลเอนต์ Amazon Bedrock LLM เพื่อลดความซับซ้อนในการใช้ RAG การค้นหาความหมาย และรูปแบบที่เกี่ยวข้องกับการฝังอื่นๆ

กรณีการใช้งานสำหรับการฝัง

แม้ว่าในปัจจุบัน RAG จะเป็นกรณีการใช้งานที่ได้รับความนิยมมากที่สุดสำหรับการทำงานกับการฝัง แต่ก็มีกรณีการใช้งานอื่นๆ อีกมากมายที่สามารถใช้การฝังได้ ต่อไปนี้เป็นสถานการณ์เพิ่มเติมบางส่วนที่คุณสามารถใช้การฝังเพื่อแก้ไขปัญหาเฉพาะได้ ไม่ว่าจะด้วยตนเองหรือร่วมมือกับ LLM:

- คำถามและคำตอบ – การฝังสามารถช่วยสนับสนุนอินเทอร์เฟซคำถามและคำตอบผ่านรูปแบบ RAG การสร้างการฝังที่จับคู่กับฐานข้อมูลเวกเตอร์ทำให้คุณสามารถค้นหาการจับคู่ที่ใกล้เคียงกันระหว่างคำถามและเนื้อหาในคลังความรู้

- คำแนะนำส่วนบุคคล – เช่นเดียวกับคำถามและคำตอบ คุณสามารถใช้การฝังเพื่อค้นหาสถานที่พักผ่อน วิทยาลัย ยานพาหนะ หรือผลิตภัณฑ์อื่นๆ ตามเกณฑ์ที่ผู้ใช้กำหนด ซึ่งอาจอยู่ในรูปแบบของรายการการจับคู่ง่ายๆ หรือคุณสามารถใช้ LLM เพื่อประมวลผลคำแนะนำแต่ละรายการและอธิบายว่าคำแนะนำนั้นเป็นไปตามเกณฑ์ของผู้ใช้อย่างไร คุณยังสามารถใช้วิธีการนี้เพื่อสร้างบทความ "ที่ดีที่สุด 10 อันดับ" ที่กำหนดเองสำหรับผู้ใช้ตามความต้องการเฉพาะของพวกเขา

- การจัดการข้อมูล – เมื่อคุณมีแหล่งข้อมูลที่ไม่ได้แมปซึ่งกันและกันอย่างสมบูรณ์ แต่คุณมีเนื้อหาข้อความที่อธิบายเรกคอร์ดข้อมูล คุณสามารถใช้การฝังเพื่อระบุเรกคอร์ดที่อาจซ้ำกัน ตัวอย่างเช่น คุณสามารถใช้การฝังเพื่อระบุผู้สมัครที่ซ้ำกันซึ่งอาจใช้การจัดรูปแบบ ตัวย่อ หรือแม้แต่ชื่อที่แปลต่างกัน

- การหาเหตุผลเข้าข้างตนเองของพอร์ตโฟลิโอแอปพลิเคชัน – เมื่อต้องการจัดพอร์ตโฟลิโอแอปพลิเคชันของบริษัทแม่และการเข้าซื้อกิจการ อาจไม่ชัดเจนเสมอไปว่าจะเริ่มค้นหาความทับซ้อนกันที่อาจเกิดขึ้นได้จากจุดใด คุณภาพของข้อมูลการจัดการการกำหนดค่าอาจเป็นปัจจัยจำกัด และการประสานงานระหว่างทีมเพื่อทำความเข้าใจภาพรวมของแอปพลิเคชันอาจเป็นเรื่องยาก ด้วยการใช้การจับคู่ความหมายกับการฝัง เราสามารถทำการวิเคราะห์อย่างรวดเร็วทั่วทั้งพอร์ตโฟลิโอของแอปพลิเคชัน เพื่อระบุแอปพลิเคชันที่มีศักยภาพสูงสำหรับการหาเหตุผลเข้าข้างตนเอง

- การจัดกลุ่มเนื้อหา – คุณสามารถใช้การฝังเพื่อช่วยจัดกลุ่มเนื้อหาที่คล้ายกันเป็นหมวดหมู่ที่คุณอาจไม่ทราบล่วงหน้าได้ ตัวอย่างเช่น สมมติว่าคุณมีคอลเลกชั่นอีเมลลูกค้าหรือบทวิจารณ์ผลิตภัณฑ์ออนไลน์ คุณสามารถสร้างการฝังสำหรับแต่ละรายการ จากนั้นเรียกใช้การฝังเหล่านั้นผ่าน k-หมายถึงการจัดกลุ่ม เพื่อระบุการจัดกลุ่มตามตรรกะของข้อกังวลของลูกค้า คำชมหรือข้อร้องเรียนเกี่ยวกับผลิตภัณฑ์ หรือประเด็นอื่นๆ จากนั้นคุณสามารถสร้างบทสรุปที่เจาะจงจากเนื้อหาของการจัดกลุ่มเหล่านั้นโดยใช้ LLM

ตัวอย่างการค้นหาความหมาย

ในของเรา ตัวอย่างบน GitHubเราจะสาธิตแอปพลิเคชันการค้นหาการฝังแบบง่ายๆ ด้วย Amazon Titan Text Embeddings, LangChain และ Streamlit

ตัวอย่างนี้จับคู่คำค้นหาของผู้ใช้กับรายการที่ใกล้เคียงที่สุดในฐานข้อมูลเวกเตอร์ในหน่วยความจำ จากนั้นเราจะแสดงรายการที่ตรงกันเหล่านั้นโดยตรงในส่วนติดต่อผู้ใช้ สิ่งนี้มีประโยชน์หากคุณต้องการแก้ไขปัญหาแอปพลิเคชัน RAG หรือประเมินโมเดลการฝังโดยตรง

เพื่อความง่าย เราใช้หน่วยความจำใน ไฟส ฐานข้อมูลเพื่อจัดเก็บและค้นหาเวกเตอร์การฝัง ในสถานการณ์จริงในวงกว้าง คุณอาจต้องการใช้ที่เก็บข้อมูลถาวรเช่น เอ็นจิ้นเวกเตอร์สำหรับ Amazon OpenSearch Serverless หรือ pgvector ส่วนขยายสำหรับ PostgreSQL

ลองใช้ข้อความแจ้งจากเว็บแอปพลิเคชันในภาษาต่างๆ เช่น:

- ฉันจะติดตามการใช้งานของฉันได้อย่างไร?

- ฉันจะปรับแต่งโมเดลได้อย่างไร

- ฉันสามารถใช้ภาษาโปรแกรมใดได้บ้าง

- แสดงความคิดเห็นเกี่ยวกับ données sont-elles sécurisées ?

- 私のデーTAHAどのように保護されていますか?

- Quais fornecedores de modelos estão disponíveis por meio do Bedrock?

- ใน welchen Regionen มี Amazon Bedrock verfügbar หรือไม่?

- มี哪些级别的支持?

โปรดทราบว่าแม้ว่าแหล่งข้อมูลจะเป็นภาษาอังกฤษ แต่ข้อความค้นหาในภาษาอื่นก็ตรงกับรายการที่เกี่ยวข้อง

สรุป

ความสามารถในการสร้างข้อความของโมเดลพื้นฐานนั้นน่าตื่นเต้นมาก แต่สิ่งสำคัญคือต้องจำไว้ว่าการทำความเข้าใจข้อความ การค้นหาเนื้อหาที่เกี่ยวข้องจากองค์ความรู้ และการเชื่อมโยงระหว่างข้อความต่างๆ มีความสำคัญอย่างยิ่งในการบรรลุคุณค่าทั้งหมดของ generative AI เราจะยังคงเห็นกรณีการใช้งานใหม่ๆ ที่น่าสนใจสำหรับการฝังเกิดขึ้นในปีต่อๆ ไป เนื่องจากโมเดลเหล่านี้ได้รับการปรับปรุงอย่างต่อเนื่อง

ขั้นตอนถัดไป

คุณสามารถดูตัวอย่างเพิ่มเติมของการฝังเป็นสมุดบันทึกหรือแอปพลิเคชันสาธิตได้ในเวิร์กช็อปต่อไปนี้:

เกี่ยวกับผู้เขียน

เจสัน สตีห์ล เป็นสถาปนิกโซลูชันอาวุโสที่ AWS ซึ่งตั้งอยู่ในนิวอิงแลนด์ เขาทำงานร่วมกับลูกค้าเพื่อปรับความสามารถของ AWS ให้สอดคล้องกับความท้าทายทางธุรกิจที่ยิ่งใหญ่ที่สุดของพวกเขา นอกเหนือจากงาน เขาใช้เวลาสร้างสิ่งต่างๆ และชมภาพยนตร์หนังสือการ์ตูนกับครอบครัว

เจสัน สตีห์ล เป็นสถาปนิกโซลูชันอาวุโสที่ AWS ซึ่งตั้งอยู่ในนิวอิงแลนด์ เขาทำงานร่วมกับลูกค้าเพื่อปรับความสามารถของ AWS ให้สอดคล้องกับความท้าทายทางธุรกิจที่ยิ่งใหญ่ที่สุดของพวกเขา นอกเหนือจากงาน เขาใช้เวลาสร้างสิ่งต่างๆ และชมภาพยนตร์หนังสือการ์ตูนกับครอบครัว

นิติน ยูเซบิอุส เป็นสถาปนิกโซลูชันระดับองค์กรอาวุโสที่ AWS ซึ่งมีประสบการณ์ในด้านวิศวกรรมซอฟต์แวร์ สถาปัตยกรรมองค์กร และ AI/ML เขามีความหลงใหลอย่างลึกซึ้งในการสำรวจความเป็นไปได้ของ AI เชิงสร้างสรรค์ เขาทำงานร่วมกับลูกค้าเพื่อช่วยพวกเขาสร้างแอปพลิเคชันที่มีสถาปัตยกรรมอย่างดีบนแพลตฟอร์ม AWS และทุ่มเทให้กับการแก้ปัญหาความท้าทายด้านเทคโนโลยีและช่วยเหลือในการเดินทางบนระบบคลาวด์

นิติน ยูเซบิอุส เป็นสถาปนิกโซลูชันระดับองค์กรอาวุโสที่ AWS ซึ่งมีประสบการณ์ในด้านวิศวกรรมซอฟต์แวร์ สถาปัตยกรรมองค์กร และ AI/ML เขามีความหลงใหลอย่างลึกซึ้งในการสำรวจความเป็นไปได้ของ AI เชิงสร้างสรรค์ เขาทำงานร่วมกับลูกค้าเพื่อช่วยพวกเขาสร้างแอปพลิเคชันที่มีสถาปัตยกรรมอย่างดีบนแพลตฟอร์ม AWS และทุ่มเทให้กับการแก้ปัญหาความท้าทายด้านเทคโนโลยีและช่วยเหลือในการเดินทางบนระบบคลาวด์

ราชปฏัก เป็น Principal Solutions Architect และที่ปรึกษาทางเทคนิคของบริษัทขนาดใหญ่ในทำเนียบ Fortune 50 และสถาบันการเงินขนาดกลาง (FSI) ทั่วแคนาดาและสหรัฐอเมริกา เขาเชี่ยวชาญในแอปพลิเคชันการเรียนรู้ของเครื่อง เช่น AI เชิงสร้างสรรค์ การประมวลผลภาษาธรรมชาติ การประมวลผลเอกสารอัจฉริยะ และ MLOps

ราชปฏัก เป็น Principal Solutions Architect และที่ปรึกษาทางเทคนิคของบริษัทขนาดใหญ่ในทำเนียบ Fortune 50 และสถาบันการเงินขนาดกลาง (FSI) ทั่วแคนาดาและสหรัฐอเมริกา เขาเชี่ยวชาญในแอปพลิเคชันการเรียนรู้ของเครื่อง เช่น AI เชิงสร้างสรรค์ การประมวลผลภาษาธรรมชาติ การประมวลผลเอกสารอัจฉริยะ และ MLOps

มณี ขันุจา เป็นหัวหน้าฝ่ายเทคโนโลยี – ผู้เชี่ยวชาญด้าน AI ทั่วไป ผู้เขียนหนังสือ – Applied Machine Learning และ High Performance Computing บน AWS และเป็นสมาชิกของคณะกรรมการบริหารสำหรับสตรีในคณะกรรมการมูลนิธิการศึกษาด้านการผลิต เธอเป็นผู้นำโครงการการเรียนรู้ของเครื่อง (ML) ในโดเมนต่างๆ เช่น คอมพิวเตอร์วิทัศน์ การประมวลผลภาษาธรรมชาติ และ AI เชิงสร้างสรรค์ เธอช่วยลูกค้าในการสร้าง ฝึกอบรม และปรับใช้โมเดลแมชชีนเลิร์นนิงขนาดใหญ่ในวงกว้าง เธอพูดในการประชุมภายในและภายนอก เช่น re:Invent, Women in Manufacturing West, การสัมมนาผ่านเว็บของ YouTube และ GHC 23 ในเวลาว่าง เธอชอบวิ่งระยะยาวไปตามชายหาด

มณี ขันุจา เป็นหัวหน้าฝ่ายเทคโนโลยี – ผู้เชี่ยวชาญด้าน AI ทั่วไป ผู้เขียนหนังสือ – Applied Machine Learning และ High Performance Computing บน AWS และเป็นสมาชิกของคณะกรรมการบริหารสำหรับสตรีในคณะกรรมการมูลนิธิการศึกษาด้านการผลิต เธอเป็นผู้นำโครงการการเรียนรู้ของเครื่อง (ML) ในโดเมนต่างๆ เช่น คอมพิวเตอร์วิทัศน์ การประมวลผลภาษาธรรมชาติ และ AI เชิงสร้างสรรค์ เธอช่วยลูกค้าในการสร้าง ฝึกอบรม และปรับใช้โมเดลแมชชีนเลิร์นนิงขนาดใหญ่ในวงกว้าง เธอพูดในการประชุมภายในและภายนอก เช่น re:Invent, Women in Manufacturing West, การสัมมนาผ่านเว็บของ YouTube และ GHC 23 ในเวลาว่าง เธอชอบวิ่งระยะยาวไปตามชายหาด

มาร์ครอย Ro เป็น Principal Machine Learning Architect สำหรับ AWS ช่วยลูกค้าออกแบบและสร้างโซลูชัน AI/ML งานของ Mark ครอบคลุมกรณีการใช้งาน ML ที่หลากหลาย โดยมีความสนใจหลักในด้านการมองเห็นของคอมพิวเตอร์ การเรียนรู้เชิงลึก และการปรับขนาด ML ทั่วทั้งองค์กร เขาได้ช่วยเหลือบริษัทต่างๆ ในหลายอุตสาหกรรม รวมถึงการประกันภัย บริการทางการเงิน สื่อและความบันเทิง การดูแลสุขภาพ สาธารณูปโภค และการผลิต Mark มี AWS Certification หกรายการ รวมถึง ML Specialty Certification ก่อนเข้าร่วม AWS มาร์คเป็นสถาปนิก นักพัฒนา และผู้นำด้านเทคโนโลยีมากว่า 25 ปี รวมถึงบริการทางการเงิน 19 ปี

มาร์ครอย Ro เป็น Principal Machine Learning Architect สำหรับ AWS ช่วยลูกค้าออกแบบและสร้างโซลูชัน AI/ML งานของ Mark ครอบคลุมกรณีการใช้งาน ML ที่หลากหลาย โดยมีความสนใจหลักในด้านการมองเห็นของคอมพิวเตอร์ การเรียนรู้เชิงลึก และการปรับขนาด ML ทั่วทั้งองค์กร เขาได้ช่วยเหลือบริษัทต่างๆ ในหลายอุตสาหกรรม รวมถึงการประกันภัย บริการทางการเงิน สื่อและความบันเทิง การดูแลสุขภาพ สาธารณูปโภค และการผลิต Mark มี AWS Certification หกรายการ รวมถึง ML Specialty Certification ก่อนเข้าร่วม AWS มาร์คเป็นสถาปนิก นักพัฒนา และผู้นำด้านเทคโนโลยีมากว่า 25 ปี รวมถึงบริการทางการเงิน 19 ปี

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/getting-started-with-amazon-titan-text-embeddings/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ ขึ้น

- 000

- 10

- 100

- 12

- 121

- 125

- 19

- 23

- 25

- 50

- 7

- 8

- a

- เกี่ยวกับเรา

- สิ่งที่เป็นนามธรรม

- ยอมรับ

- ความถูกต้อง

- ถูกต้อง

- แม่นยำ

- ประสบความสำเร็จ

- การบรรลุ

- การครอบครอง

- ข้าม

- นอกจากนี้

- เพิ่มเติม

- ความได้เปรียบ

- กุนซือ

- การรวม

- ก่อน

- AI

- AI / ML

- อัลกอริทึม

- จัดแนว

- ทั้งหมด

- อนุญาต

- การอนุญาต

- ช่วยให้

- ตาม

- คู่ขนาน

- ด้วย

- เสมอ

- อเมซอน

- Amazon Web Services

- an

- การวิเคราะห์

- วิเคราะห์

- และ

- คำตอบ

- ใด

- การใช้งาน

- การใช้งาน

- ประยุกต์

- ใช้

- เข้าใกล้

- สถาปัตยกรรม

- สถาปัตยกรรม

- เป็น

- AREA

- บทความ

- AS

- การให้ความช่วยเหลือ

- At

- เสริม

- เติม

- ผู้เขียน

- ใช้ได้

- AWS

- ตาม

- BE

- ชายหาด

- กำลัง

- ประโยชน์ที่ได้รับ

- ระหว่าง

- คณะกรรมการ

- คณะกรรมการผู้บริหาร

- ร่างกาย

- หนังสือ

- กล่อง

- สร้าง

- การก่อสร้าง

- ธุรกิจ

- แต่

- by

- CAN

- แคนาดา

- ผู้สมัคร

- ผู้สมัคร

- ความสามารถในการ

- จับ

- จับ

- กรณี

- กรณี

- หมวดหมู่

- ใบรับรอง มาตราฐาน

- การรับรอง

- ความท้าทาย

- การจัดหมวดหมู่

- ไคลเอนต์

- ปิดหน้านี้

- เมฆ

- การจัดกลุ่ม

- รหัส

- ร่วมมือ

- ชุด

- วิทยาลัย

- การผสมผสาน

- ร่วมกัน

- บริษัท

- บริษัท

- เปรียบเทียบ

- ร้องเรียน

- ซับซ้อน

- คอมพิวเตอร์

- วิสัยทัศน์คอมพิวเตอร์

- การคำนวณ

- แนวความคิด

- ความกังวลเกี่ยวกับ

- การประชุม

- องค์ประกอบ

- เชื่อมต่อ

- การเชื่อมต่อ

- การเชื่อมต่อ

- คงเส้นคงวา

- เนื้อหา

- สิ่งแวดล้อม

- ตามบริบท

- ต่อ

- สะดวก

- แปลง

- แปลง

- ความร่วมมือ

- ประสานงาน

- ค่าใช้จ่ายที่มีประสิทธิภาพ

- ได้

- ครอบคลุม

- ครอบคลุม

- สร้าง

- การสร้าง

- เกณฑ์

- สำคัญมาก

- ขณะนี้

- ประเพณี

- ลูกค้า

- ลูกค้า

- ปรับแต่ง

- ข้อมูล

- ฐานข้อมูล

- de

- ทุ่มเท

- ลึก

- การเรียนรู้ลึก ๆ

- ลึก

- กำหนด

- องศา

- สาธิต

- สาธิต

- ปรับใช้

- อธิบาย

- ออกแบบ

- สถานที่ท่องเที่ยว

- รายละเอียด

- ผู้พัฒนา

- ต่าง

- ยาก

- Dimension

- โดยตรง

- กรรมการ

- สนทนา

- แสดง

- do

- เอกสาร

- เอกสาร

- โดเมน

- Dont

- แต่ละ

- การศึกษา

- มีประสิทธิภาพ

- ทั้ง

- อีเมล

- การฝัง

- ออกมา

- ทำให้สามารถ

- ช่วยให้

- เครื่องยนต์

- ชั้นเยี่ยม

- ประเทศอังกฤษ

- ภาษาอังกฤษ

- Enterprise

- ความบันเทิง

- ทั้งหมด

- อย่างสิ้นเชิง

- เอกลักษณ์

- ประเมินค่า

- แม้

- ตัวอย่าง

- ตัวอย่าง

- น่าตื่นเต้น

- แสดง

- ประสบการณ์

- มีประสบการณ์

- อธิบาย

- สำรวจ

- นามสกุล

- ภายนอก

- อำนวยความสะดวก

- ปัจจัย

- ครอบครัว

- คุณสมบัติ

- สองสาม

- ทางการเงิน

- บริการทางการเงิน

- หา

- หา

- ชื่อจริง

- ความยืดหยุ่น

- มุ่งเน้น

- ดังต่อไปนี้

- สำหรับ

- ฟอร์ม

- โชคลาภ

- รากฐาน

- กรอบ

- ฟรี

- ราคาเริ่มต้นที่

- เต็ม

- พื้นฐาน

- สร้าง

- รุ่น

- กำเนิด

- กำเนิด AI

- ได้รับ

- ได้รับ

- ให้

- ถุงมือ

- Go

- ใหญ่ที่สุด

- มี

- มี

- he

- การดูแลสุขภาพ

- ช่วย

- ช่วย

- การช่วยเหลือ

- จะช่วยให้

- เธอ

- จุดสูง

- ของเขา

- ถือ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTML

- HTTPS

- i

- แยกแยะ

- if

- การดำเนินการ

- นำเข้า

- สำคัญ

- ปรับปรุง

- in

- ในอื่น ๆ

- ประกอบด้วย

- รวมถึง

- รวมทั้ง

- อุตสาหกรรม

- ข้อมูล

- อินพุต

- ติดตั้ง

- แทน

- สถาบัน

- ประกัน

- ฉลาด

- การประมวลผลเอกสารอัจฉริยะ

- อยากเรียนรู้

- น่าสนใจ

- อินเตอร์เฟซ

- อินเตอร์เฟซ

- ภายใน

- International

- เข้าไป

- IT

- ITS

- การร่วม

- การเดินทาง

- jpg

- JSON

- คีย์

- ทราบ

- รู้ดี

- ความรู้

- ภูมิประเทศ

- ภาษา

- ภาษา

- ใหญ่

- ชั้น

- นำ

- ผู้นำ

- นำไปสู่

- การเรียนรู้

- ให้

- กดไลก์

- น่าจะ

- ยอดไลก์

- การ จำกัด

- รายการ

- LLM

- ตรรกะ

- นาน

- ดู

- ที่ต้องการหา

- เครื่อง

- เรียนรู้เครื่อง

- เก็บรักษา

- ทำ

- การทำ

- การจัดการ

- การจัดการ

- การผลิต

- หลาย

- แผนที่

- เครื่องหมาย

- มาร์ค

- ตลาด

- จับคู่

- ที่ตรงกัน

- การจับคู่

- วัสดุ

- me

- ความหมาย

- วิธี

- ภาพบรรยากาศ

- สมาชิก

- วิธี

- อาจ

- ML

- ม.ป.ป

- แบบ

- โมเดล

- การตรวจสอบ

- ข้อมูลเพิ่มเติม

- มากที่สุด

- เป็นที่นิยม

- Movies

- หลาย

- my

- ชื่อ

- ที่มีชื่อ

- ชื่อ

- โดยธรรมชาติ

- ประมวลผลภาษาธรรมชาติ

- จำเป็นต้อง

- ต้อง

- ความต้องการ

- ใหม่

- ถัดไป

- NLP

- ชัดเจน

- of

- เสนอ

- on

- ONE

- ออนไลน์

- เปิด

- โอเพนซอร์ส

- การปรับให้เหมาะสม

- การเพิ่มประสิทธิภาพ

- or

- ใบสั่ง

- อื่นๆ

- ผลิตภัณฑ์อื่นๆ

- ของเรา

- ออก

- เอาท์พุต

- ด้านนอก

- เกิน

- คาบเกี่ยวกัน

- ของตนเอง

- แพคเกจ

- จับคู่

- พารามิเตอร์

- พารามิเตอร์

- บริษัท แม่

- ทางเดิน

- หลงใหล

- แบบแผน

- รูปแบบ

- ต่อ

- ดำเนินการ

- การปฏิบัติ

- ส่วนบุคคล

- วลี

- ชิ้น

- เวที

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เล่น

- กรุณา

- ยอดนิยม

- จำแนกตาม

- ผลงาน

- พอร์ตการลงทุน

- ความเป็นไปได้

- โพสต์

- postgresql

- ที่มีศักยภาพ

- อำนาจ

- ประถม

- หลัก

- พิมพ์

- ก่อน

- ปัญหาที่เกิดขึ้น

- กระบวนการ

- การประมวลผล

- ผลิตภัณฑ์

- รีวิวสินค้า

- ผลิตภัณฑ์

- การเขียนโปรแกรม

- การเขียนโปรแกรมภาษา

- โครงการ

- แจ้ง

- เป็นเจ้าของ

- ให้

- ให้

- ให้

- หลาม

- คุณภาพ

- คำสั่ง

- การสอบถาม

- คำถาม

- คำถาม

- รวดเร็ว

- เศษผ้า

- พิสัย

- RE

- มาถึง

- โลกแห่งความจริง

- การรับรู้

- แนะนำ

- แนะนำ

- ระเบียน

- บันทึก

- หมายถึง

- ความสัมพันธ์

- ตรงประเด็น

- จำ

- กรุ

- การแสดง

- แสดงให้เห็นถึง

- ขอ

- จำเป็นต้องใช้

- คำตอบ

- REST

- หวงห้าม

- ส่งผลให้

- ผลสอบ

- การแก้ไข

- รับคืน

- รีวิว

- บทบาท

- วิ่ง

- ทำงาน

- s

- เดียวกัน

- กล่าว

- ขนาด

- ปรับ

- สถานการณ์

- สถานการณ์

- SDK

- ค้นหา

- เห็น

- ความหมาย

- อรรถศาสตร์

- ระดับอาวุโส

- ประโยค

- ความรู้สึก

- แยก

- serverless

- บริการ

- เธอ

- คล้ายคลึงกัน

- ง่าย

- ความง่าย

- ที่เรียบง่าย

- ลดความซับซ้อน

- เดียว

- หก

- So

- ซอฟต์แวร์

- วิศวกรรมซอฟต์แวร์

- โซลูชัน

- แก้

- การแก้

- บาง

- บางสิ่งบางอย่าง

- แหล่ง

- แหล่งที่มา

- ช่องว่าง

- พูด

- ผู้เชี่ยวชาญ

- ความเชี่ยวชาญ

- พิเศษ

- โดยเฉพาะ

- เริ่มต้น

- ข้อความที่เริ่ม

- สหรัฐอเมริกา

- จัดเก็บ

- โครงสร้าง

- อย่างเช่น

- สนับสนุน

- ที่สนับสนุน

- ที่สนับสนุน

- รองรับ

- เอา

- งาน

- ทีม

- เทคโนโลยี

- วิชาการ

- เทคนิค

- เทคนิค

- เทคโนโลยี

- เทคโนโลยี

- บอก

- ข้อความ

- การจัดประเภทข้อความ

- ที่

- พื้นที่

- ที่มา

- ของพวกเขา

- พวกเขา

- ธีม

- แล้วก็

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- สิ่ง

- นี้

- เหล่านั้น

- แต่?

- ตลอด

- เวลา

- ยักษ์

- ไปยัง

- ราชสกุล

- แบบดั้งเดิม

- รถไฟ

- ผ่านการฝึกอบรม

- หม้อแปลง

- การเปลี่ยนแปลง

- เข้าใจ

- ความเข้าใจ

- ปึกแผ่น

- พร้อมใจกัน

- ประเทศสหรัฐอเมริกา

- การใช้

- ใช้

- ใช้กรณี

- มือสอง

- มีประโยชน์

- ผู้ใช้งาน

- ส่วนติดต่อผู้ใช้

- ผู้ใช้

- การใช้

- ยูทิลิตี้

- วันหยุด

- ความคุ้มค่า

- ต่างๆ

- ยานพาหนะ

- มาก

- ผ่านทาง

- วิสัยทัศน์

- ต้องการ

- คือ

- ชม

- we

- เว็บ

- โปรแกรมประยุกต์บนเว็บ

- บริการเว็บ

- webinars

- ดี

- คือ

- ตะวันตก

- เมื่อ

- ที่

- ในขณะที่

- กว้าง

- ช่วงกว้าง

- จะ

- กับ

- ภายใน

- ไม่มี

- ผู้หญิง

- คำ

- คำ

- งาน

- การทำงาน

- โรงงาน

- การประชุมเชิงปฏิบัติการ

- จะ

- เขียน

- การเขียน

- ปี

- คุณ

- ของคุณ

- YouTube

- ลมทะเล