วีดีโอ โมเดลภาษา AI ที่ใหญ่ที่สุดของ Google ช่วยให้หุ่นยนต์มีความยืดหยุ่นมากขึ้นในการทำความเข้าใจและตีความคำสั่งของมนุษย์ ตามการวิจัยล่าสุดของเว็บยักษ์

โดยปกติแล้ว เครื่องจะตอบสนองต่อความต้องการที่เฉพาะเจาะจงได้ดีที่สุด – คำขอปลายเปิดในบางครั้งอาจทิ้งคำขอนั้นทิ้งไปและนำไปสู่ผลลัพธ์ที่ผู้ใช้ไม่ได้คำนึงถึง ผู้คนเรียนรู้ที่จะโต้ตอบกับหุ่นยนต์อย่างเข้มงวด เช่น การถามคำถามในลักษณะเฉพาะเพื่อให้ได้คำตอบที่ต้องการ

ระบบล่าสุดของ Google ชื่อ PaLM-SayCan สัญญาว่าจะฉลาดขึ้น อุปกรณ์ทางกายภาพจาก Everyday Robots ซึ่งเป็นสตาร์ทอัพที่แยกตัวออกมาจาก Google X มีกล้องสำหรับตาอยู่ที่หัวและแขนที่มีคีมหนีบอยู่ด้านหลังลำตัวยาวเหยียดตรงซึ่งอยู่บนชุดล้อ

คุณสามารถชมการทำงานของหุ่นยนต์ได้ในวิดีโอด้านล่าง:

เมื่อถามหุ่นยนต์ว่า “ฉันเพิ่งออกกำลังกาย คุณช่วยหาขนมเพื่อสุขภาพให้ฉันหน่อยได้ไหม” จะเขยิบไปดึงแอปเปิ้ล “PaLM-SayCan [เป็น] แนวทางทั่วไปที่ตีความได้ในการใช้ประโยชน์จากความรู้จากแบบจำลองภาษาที่ช่วยให้หุ่นยนต์สามารถปฏิบัติตามคำสั่งที่เป็นข้อความในระดับสูงเพื่อทำงานที่มีพื้นฐานทางกายภาพ” นักวิทยาศาสตร์วิจัยจากทีม Brain ของ Google อธิบาย.

Google เปิดตัวโมเดลภาษาที่ใหญ่ที่สุด ปาล์ม ในเดือนเมษายนปีนี้ PaLM ได้รับการฝึกอบรมเกี่ยวกับข้อมูลที่คัดลอกมาจากอินเทอร์เน็ต แต่แทนที่จะใช้การตอบกลับข้อความแบบปลายเปิด ระบบได้รับการดัดแปลงเพื่อสร้างรายการคำสั่งสำหรับหุ่นยนต์ที่จะปฏิบัติตาม

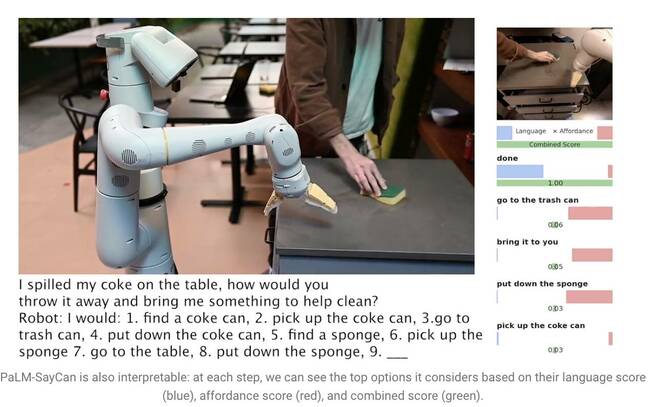

พูดว่า “ฉันทำโค้กหกลงบนโต๊ะ คุณจะโยนมันทิ้งแล้วเอาอะไรมาช่วยทำความสะอาดให้ฉันได้อย่างไร” แจ้งให้ PaLM เข้าใจคำถามและสร้างรายการขั้นตอนที่หุ่นยนต์สามารถปฏิบัติตามเพื่อทำงานให้เสร็จได้ เช่น ข้ามไป หยิบกระป๋อง โยนลงในถังขยะ และรับฟองน้ำ

โมเดลภาษาขนาดใหญ่ (LLM) เช่น PaLM ไม่เข้าใจความหมายของสิ่งที่พวกเขาพูด ด้วยเหตุผลนี้ นักวิจัยจึงได้ฝึกอบรมแบบจำลองที่แยกจากกันโดยใช้การเรียนรู้แบบเสริมกำลังเพื่อสร้างภาษานามธรรมให้เป็นภาพและการกระทำ ด้วยวิธีนี้หุ่นยนต์เรียนรู้ที่จะเชื่อมโยงคำว่า "โค้ก" กับภาพกระป๋องน้ำอัดลม

PaLM-SayCan ยังเรียนรู้สิ่งที่เรียกว่า "ฟังก์ชันค่าใช้จ่าย" ซึ่งเป็นวิธีการที่จัดอันดับความเป็นไปได้ในการดำเนินการเฉพาะที่กำหนดให้กับวัตถุในสภาพแวดล้อม หุ่นยนต์มีแนวโน้มที่จะหยิบฟองน้ำมากกว่าเครื่องดูดฝุ่น ตัวอย่างเช่น หากตรวจพบฟองน้ำ แต่ไม่มีเครื่องดูดฝุ่นอยู่ใกล้ ๆ

"วิธีการของเราคือ SayCan ดึงและใช้ประโยชน์จากความรู้ภายใน LLM ในงานที่มีพื้นฐานทางกายภาพ" ทีมงานอธิบายใน รายงานการวิจัย. “LLM (Say) จัดเตรียมงานพื้นฐานเพื่อกำหนดการกระทำที่เป็นประโยชน์สำหรับเป้าหมายระดับสูงและฟังก์ชันการจ่ายที่เรียนรู้ (Can) จัดเตรียมพื้นฐานระดับโลกเพื่อกำหนดสิ่งที่เป็นไปได้ที่จะดำเนินการตามแผน เราใช้การเรียนรู้แบบเสริมกำลัง (RL) เป็นวิธีการเรียนรู้ฟังก์ชันค่านิยมแบบมีเงื่อนไขทางภาษาซึ่งมอบสิ่งที่เป็นไปได้ในโลกนี้”

เพื่อป้องกันไม่ให้หุ่นยนต์เบี่ยงเบนจากภารกิจ มันถูกฝึกให้เลือกการกระทำจาก 101 คำสั่งที่แตกต่างกันเท่านั้น Google ฝึกฝนให้ปรับตัวเข้ากับห้องครัว – PaLM-SayCan สามารถรับขนม เครื่องดื่ม และทำความสะอาดง่ายๆ ได้ นักวิจัยเชื่อว่า LLMs เป็นขั้นตอนแรกในการทำให้หุ่นยนต์ทำงานที่ซับซ้อนมากขึ้นได้อย่างปลอดภัยตามคำแนะนำที่เป็นนามธรรม

“การทดลองของเราเกี่ยวกับงานหุ่นยนต์ในโลกแห่งความเป็นจริงจำนวนหนึ่งแสดงให้เห็นถึงความสามารถในการวางแผนและทำตามคำแนะนำทางภาษาธรรมชาติที่เป็นนามธรรมในแนวนอนยาวและมีอัตราความสำเร็จสูง เราเชื่อว่าความสามารถในการตีความของ PaLM-SayCan ช่วยให้ผู้ใช้โต้ตอบกับหุ่นยนต์ได้อย่างปลอดภัยในโลกแห่งความเป็นจริง” พวกเขาสรุป ®

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- ขนาดไอ

- วากยสัมพันธ์

- ลงทะเบียน

- ลมทะเล