แอมป์ เป็นแอปวิทยุสดใหม่จาก Amazon ด้วย Amp คุณสามารถจัดรายการวิทยุของคุณเองและเล่นเพลงจากแคตตาล็อกเพลงของ Amazon หรือปรับแต่งและฟังรายการที่ผู้ใช้ Amp รายอื่นกำลังโฮสต์อยู่ ในสภาพแวดล้อมที่มีเนื้อหามากมายและหลากหลาย สิ่งสำคัญคือต้องปรับแต่งประสบการณ์ผู้ใช้ให้เข้ากับรสนิยมส่วนตัวของผู้ใช้แต่ละคน เพื่อให้พวกเขาสามารถค้นหารายการที่ชอบและค้นพบเนื้อหาใหม่ๆ ที่พวกเขาต้องการได้อย่างง่ายดาย

Amp ใช้การเรียนรู้ของเครื่อง (ML) เพื่อให้คำแนะนำส่วนบุคคลสำหรับการแสดงสดและแอมป์ที่กำลังจะมีขึ้นในหน้าแรกของแอป คำแนะนำจะคำนวณโดยใช้โมเดล Random Forest โดยใช้คุณลักษณะที่แสดงความนิยมของรายการ (เช่น การฟังและการนับชอบ) ความนิยมของผู้สร้าง (เช่น จำนวนครั้งทั้งหมดที่มีการเล่นรายการล่าสุด) และความชอบส่วนตัวของผู้ใช้ กับหัวข้อของรายการและผู้สร้าง ความเกี่ยวข้องจะคำนวณโดยนัยจากข้อมูลพฤติกรรมของผู้ใช้หรือโดยชัดแจ้งจากหัวข้อที่น่าสนใจ (เช่น เพลงป๊อป เบสบอล หรือการเมือง) ตามที่ระบุในโปรไฟล์ผู้ใช้

นี่คือส่วนที่ 2 ของซีรีส์เกี่ยวกับการใช้การวิเคราะห์ข้อมูลและ ML สำหรับ Amp และการสร้างแพลตฟอร์มรายการแนะนำการแสดงในแบบของคุณ แพลตฟอร์มดังกล่าวแสดงให้เห็นว่ามีการติดตามเมตริกการมีส่วนร่วมของลูกค้าเพิ่มขึ้น 3% (ชอบรายการ ติดตามผู้สร้าง เปิดใช้การแจ้งเตือนรายการที่กำลังจะมีขึ้น) นับตั้งแต่เปิดตัวในเดือนพฤษภาคม 2022

เอ่ยถึง 1 หมายเลข เพื่อเรียนรู้ว่าข้อมูลพฤติกรรมถูกรวบรวมและประมวลผลโดยใช้ข้อมูลและระบบวิเคราะห์อย่างไร

ภาพรวมโซลูชัน

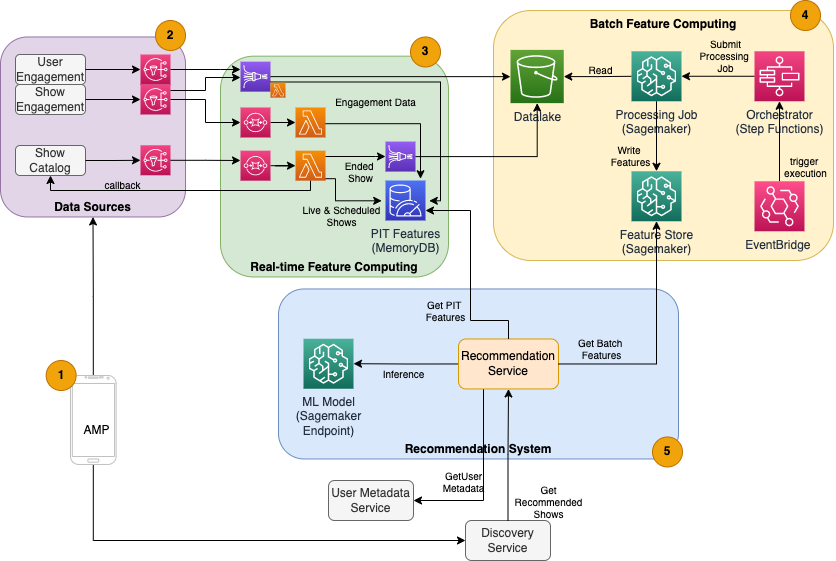

ตัวแนะนำการแสดงตาม ML สำหรับแอมป์มีองค์ประกอบหลักห้าองค์ประกอบ ดังแสดงในแผนภาพสถาปัตยกรรมต่อไปนี้:

- แอพมือถือแอมป์

- บริการแบ็คเอนด์ที่รวบรวมข้อมูลพฤติกรรม เช่น ไลค์และติดตาม ตลอดจนข้อมูลที่เกี่ยวข้องกับรายการออกอากาศ เช่น การอัปเดตสถานะเมื่อมีการถ่ายทอดสด

- การนำเข้าข้อมูลพฤติกรรมและการแสดงตามเวลาจริง และการประมวลผลและการจัดเก็บคุณสมบัติตามเวลาจริง (ออนไลน์)

- การประมวลผลและการจัดเก็บคุณลักษณะแบบแบทช์ (ออฟไลน์)

- ระบบผู้แนะนำที่จัดการคำขอขาเข้าจากแบ็กเอนด์ของแอปเพื่อรับรายการแสดง ซึ่งรวมถึงการอนุมานตามเวลาจริงเพื่อจัดอันดับรายการตามคุณสมบัติส่วนบุคคลและไม่ใช่ส่วนบุคคล

โพสต์นี้เน้นที่ส่วนที่ 3, 4 และ 5 โดยพยายามให้รายละเอียดดังต่อไปนี้:

แผนภาพต่อไปนี้แสดงสถาปัตยกรรมระดับสูงและส่วนประกอบต่างๆ

ในส่วนต่อไปนี้ เราให้รายละเอียดเพิ่มเติมเกี่ยวกับการประมวลผลคุณลักษณะตามเวลาจริง การคำนวณคุณลักษณะแบบกลุ่ม การอนุมานตามเวลาจริง ความสมบูรณ์ของการปฏิบัติงาน และผลลัพธ์ที่เราสังเกต

การคำนวณคุณสมบัติตามเวลาจริง

คุณสมบัติบางอย่าง เช่น จำนวนการกดชอบและจำนวนการฟังสำหรับรายการ จำเป็นต้องสตรีมอย่างต่อเนื่องและใช้งานตามที่เป็นอยู่ ในขณะที่คุณสมบัติอื่นๆ เช่น จำนวนเซสชันการฟังที่นานกว่า 5 นาที จำเป็นต้องแปลงแบบเรียลไทม์เป็นข้อมูลดิบด้วย สำหรับการสตรีมเซสชัน คุณลักษณะประเภทนี้ซึ่งจำเป็นต้องคำนวณค่าในเวลาอนุมานเรียกว่า เจาะจงเวลา (PIT) คุณสมบัติ ข้อมูลสำหรับฟีเจอร์ PIT จำเป็นต้องได้รับการอัปเดตอย่างรวดเร็ว และควรเขียนและอ่านเวอร์ชันล่าสุดโดยมีเวลาแฝงต่ำ (ต่ำกว่า 20 มิลลิวินาทีต่อผู้ใช้สำหรับ 1,000 รายการ) ข้อมูลยังต้องอยู่ในที่จัดเก็บข้อมูลที่คงทน เนื่องจากข้อมูลที่ขาดหายไปหรือบางส่วนอาจทำให้คำแนะนำที่แย่ลงและประสบการณ์ของลูกค้าที่ไม่ดี นอกจากเวลาแฝงในการอ่าน/เขียนแล้ว ฟีเจอร์ PIT ยังต้องการเวลาในการสะท้อนที่ต่ำอีกด้วย เวลาสะท้อนคือเวลาที่ต้องใช้เพื่อให้อ่านคุณลักษณะหนึ่งได้หลังจากปล่อยกิจกรรมที่มีส่วนร่วม เช่น เวลาระหว่างผู้ฟังที่ชอบรายการและคุณลักษณะ PIT LikeCount ที่กำลังอัปเดต

แหล่งที่มาของข้อมูลคือบริการแบ็กเอนด์ที่ให้บริการแอปโดยตรง ข้อมูลบางส่วนจะถูกแปลงเป็นตัวชี้วัดที่ถ่ายทอดผ่าน บริการแจ้งเตือนแบบง่ายของ Amazon (Amazon SNS) ไปยัง Listener ดาวน์สตรีม เช่น ไปป์ไลน์การแปลงฟีเจอร์ ML ฐานข้อมูลในหน่วยความจำ เช่น MemoryDB เป็นบริการในอุดมคติสำหรับการจัดเก็บข้อมูลที่ทนทานและประสิทธิภาพที่รวดเร็วเป็นพิเศษในปริมาณมาก องค์ประกอบการประมวลผลที่แปลงและเขียนคุณสมบัติไปยัง MemoryDB คือ Lambda ปริมาณการใช้แอพติดตามรูปแบบรายวันและรายสัปดาห์ของจุดสูงสุดและลดลงขึ้นอยู่กับเวลาและวัน แลมบ์ดาอนุญาตให้ปรับขนาดอัตโนมัติตามปริมาณเหตุการณ์ที่เข้ามา ลักษณะที่เป็นอิสระของการแปลงหน่วยเมตริกแต่ละรายการทำให้ Lambda ซึ่งเป็นบริการไร้สัญชาติด้วยตัวมันเอง เหมาะสมสำหรับปัญหานี้ วาง บริการ Amazon Simple Queue (Amazon SQS) ระหว่าง Amazon SNS และ Lambda ไม่เพียงแต่ป้องกันข้อความสูญหาย แต่ยังทำหน้าที่เป็นบัฟเฟอร์สำหรับปริมาณการรับส่งข้อมูลจำนวนมากที่ไม่คาดคิด ซึ่งขีดจำกัดการทำงานพร้อมกันของ Lambda ที่กำหนดค่าไว้ล่วงหน้าอาจไม่เพียงพอต่อการให้บริการ

การประมวลผลคุณลักษณะแบบแบตช์

คุณลักษณะที่ใช้ข้อมูลพฤติกรรมในอดีตเพื่อแสดงถึงรสนิยมที่เปลี่ยนแปลงตลอดเวลาของผู้ใช้นั้นซับซ้อนกว่าในการคำนวณและไม่สามารถคำนวณได้แบบเรียลไทม์ คุณลักษณะเหล่านี้คำนวณโดยกระบวนการแบบกลุ่มที่ทำงานบ่อยๆ เช่น วันละครั้ง ข้อมูลสำหรับคุณลักษณะชุดงานควรสนับสนุนการสืบค้นอย่างรวดเร็วสำหรับการกรองและการรวมข้อมูล และอาจขยายระยะเวลานาน ดังนั้นจะมีปริมาณมากขึ้น เนื่องจากคุณลักษณะแบตช์ยังถูกดึงและส่งเป็นอินพุตสำหรับการอนุมานตามเวลาจริง จึงควรอ่านได้โดยมีเวลาแฝงต่ำ

การรวบรวมข้อมูลดิบสำหรับการประมวลผลคุณลักษณะแบบแบตช์ไม่มีข้อกำหนดด้านเวลาในการสะท้อนของนาทีย่อยที่ฟีเจอร์ PIT มี ซึ่งทำให้มีความเป็นไปได้ที่จะบัฟเฟอร์เหตุการณ์นานขึ้นและแปลงหน่วยเมตริกเป็นแบตช์ โซลูชันนี้ใช้ Kinesis Data Firehose ซึ่งเป็นบริการที่มีการจัดการเพื่อนำเข้าข้อมูลการสตรีมไปยังปลายทางต่างๆ ได้อย่างรวดเร็ว รวมถึง บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (Amazon S3) สำหรับการวัดแบบคงอยู่ไปยัง Data Lake S3 เพื่อใช้ในการคำนวณแบบออฟไลน์ Kinesis Data Firehose จัดเตรียมบัฟเฟอร์เหตุการณ์และการรวม Lambda เพื่อรวบรวม แปลงเป็นชุด และรักษาตัววัดเหล่านี้ไปยัง Amazon S3 เพื่อใช้ในภายหลังโดยการประมวลผลคุณลักษณะแบบกลุ่ม การคำนวณคุณสมบัติแบบกลุ่มไม่มีข้อกำหนดในการอ่าน/เขียนที่มีเวลาแฝงต่ำเหมือนกับคุณสมบัติ PIT ซึ่งทำให้ Amazon S3 เป็นตัวเลือกที่ดีกว่า เนื่องจากมีพื้นที่จัดเก็บต้นทุนต่ำและทนทานสำหรับการจัดเก็บเมตริกธุรกิจปริมาณมากเหล่านี้

โมเดล ML เริ่มต้นของเราใช้คุณลักษณะชุดงาน 21 รายการซึ่งคำนวณทุกวันโดยใช้ข้อมูลที่บันทึกไว้ในช่วง 2 เดือนที่ผ่านมา ข้อมูลนี้รวมทั้งประวัติการเล่นและการมีส่วนร่วมในแอปต่อผู้ใช้ และเพิ่มขึ้นตามจำนวนผู้ใช้และความถี่ของการใช้แอป วิศวกรรมคุณลักษณะในระดับนี้ต้องใช้กระบวนการอัตโนมัติเพื่อดึงข้อมูลอินพุตที่จำเป็น ประมวลผลแบบคู่ขนาน และส่งออกผลลัพธ์ไปยังที่จัดเก็บข้อมูลแบบถาวร โครงสร้างพื้นฐานในการประมวลผลจำเป็นสำหรับระยะเวลาของการคำนวณเท่านั้น การประมวลผล SageMaker จัดเตรียมอิมเมจ Docker ที่สร้างไว้ล่วงหน้าซึ่งรวมถึง Apache Spark และการพึ่งพาอื่น ๆ ที่จำเป็นในการรันงานการประมวลผลข้อมูลแบบกระจายในขนาดใหญ่ โครงสร้างพื้นฐานที่สำคัญสำหรับงานการประมวลผลได้รับการจัดการโดย SageMaker อย่างสมบูรณ์ ทรัพยากรคลัสเตอร์ถูกจัดเตรียมไว้สำหรับระยะเวลาของงานของคุณ และจะล้างข้อมูลเมื่องานเสร็จสมบูรณ์

แต่ละขั้นตอนในกระบวนการแบทช์ เช่น การรวบรวมข้อมูล วิศวกรรมคุณลักษณะ การคงอยู่ของคุณลักษณะ เป็นส่วนหนึ่งของเวิร์กโฟลว์ที่ต้องมีการจัดการข้อผิดพลาด การลองใหม่ และการเปลี่ยนสถานะในระหว่างนั้น กับ ฟังก์ชันขั้นตอนของ AWSคุณสามารถสร้างเครื่องระบุสถานะและแบ่งเวิร์กโฟลว์ของคุณออกเป็นหลายขั้นตอนของการประมวลผลล่วงหน้าและการประมวลผลภายหลัง รวมถึงขั้นตอนในการคงคุณสมบัติไว้ใน SageMaker Feature Store หรือข้อมูลอื่นๆ ไปยัง Amazon S3 เครื่องสถานะใน Step Functions สามารถเรียกใช้งานได้ผ่าน อเมซอน EventBridge เพื่อให้การประมวลผลแบบกลุ่มทำงานโดยอัตโนมัติตามกำหนดเวลา เช่น วันละครั้ง เวลา 10:00 น. UTC

หลังจากคำนวณคุณลักษณะแล้ว จะต้องมีการกำหนดเวอร์ชันและเก็บไว้เพื่อให้สามารถอ่านได้ในระหว่างการอนุมานและการฝึกโมเดลใหม่ แทนที่จะสร้างบริการจัดเก็บและจัดการคุณลักษณะของคุณเอง คุณสามารถใช้ SageMaker Feature Store ได้ Feature Store คือพื้นที่เก็บข้อมูลที่สร้างขึ้นตามวัตถุประสงค์ที่มีการจัดการเต็มรูปแบบเพื่อจัดเก็บ แชร์ และจัดการคุณสมบัติสำหรับรุ่น ML มันเก็บประวัติของคุณสมบัติ ML ในร้านค้าออฟไลน์ (Amazon S3) และยังมี API ให้กับร้านค้าออนไลน์เพื่อให้อ่านคุณสมบัติล่าสุดที่มีเวลาแฝงต่ำ ร้านค้าออฟไลน์สามารถให้บริการข้อมูลในอดีตสำหรับการฝึกโมเดลและการทดลองเพิ่มเติม และ API ที่ติดต่อกับลูกค้าสามารถเรียกร้านค้าออนไลน์ของคุณเพื่อรับคุณสมบัติสำหรับการอนุมานแบบเรียลไทม์ ในขณะที่เราพัฒนาบริการของเราเพื่อมอบเนื้อหาที่เป็นส่วนตัวมากขึ้น เราคาดว่าจะมีการฝึกอบรมโมเดล ML เพิ่มเติม และด้วยความช่วยเหลือของ Feature Store ค้นหา ค้นพบ และนำคุณสมบัติมาใช้ซ้ำในโมเดลเหล่านี้

การอนุมานตามเวลาจริง

การอนุมานตามเวลาจริงมักต้องการโฮสต์โมเดล ML ที่อยู่เบื้องหลังปลายทาง คุณสามารถทำได้โดยใช้เว็บเซิร์ฟเวอร์หรือคอนเทนเนอร์ แต่ต้องใช้ความพยายามด้านวิศวกรรมและโครงสร้างพื้นฐานของ ML เพื่อจัดการและบำรุงรักษา SageMaker ทำให้ง่ายต่อการปรับใช้โมเดล ML กับปลายทางแบบเรียลไทม์ SageMaker ให้คุณฝึกอบรมและอัปโหลดโมเดล ML และโฮสต์โมเดลเหล่านี้โดยการสร้างและกำหนดค่าปลายทาง SageMaker การอนุมานตามเวลาจริงตอบสนองความต้องการเวลาแฝงต่ำสำหรับการแสดงการจัดอันดับเมื่อเรียกดูบนโฮมเพจของแอมป์

นอกจากโฮสติ้งที่มีการจัดการแล้ว SageMaker ยังมีการปรับขนาดปลายทางที่มีการจัดการอีกด้วย การอนุมานของ SageMaker ช่วยให้คุณกำหนดนโยบายการปรับขนาดอัตโนมัติด้วยจำนวนอินสแตนซ์ต่ำสุดและสูงสุด และการใช้งานเป้าหมายเพื่อทริกเกอร์การปรับขนาด ด้วยวิธีนี้ คุณสามารถปรับขนาดเข้าหรือออกได้อย่างง่ายดายเมื่อความต้องการเปลี่ยนแปลง

สุขภาพการดำเนินงาน

จำนวนเหตุการณ์ที่ระบบนี้จัดการสำหรับการประมวลผลคุณลักษณะแบบเรียลไทม์จะเปลี่ยนแปลงไปตามรูปแบบการใช้งานแอปที่เป็นธรรมชาติ (ปริมาณการใช้ข้อมูลสูงหรือต่ำตามเวลาของวันหรือวันในสัปดาห์) ในทำนองเดียวกัน จำนวนคำขอที่ได้รับสำหรับมาตราส่วนการอนุมานตามเวลาจริงกับจำนวนผู้ใช้แอปพร้อมกัน บริการเหล่านี้ยังได้รับการเข้าชมสูงสุดอย่างไม่คาดคิดเนื่องจากการโปรโมตตนเองในโซเชียลมีเดียโดยผู้สร้างยอดนิยม แม้ว่าสิ่งสำคัญคือต้องตรวจสอบให้แน่ใจว่าระบบสามารถขยายขนาดขึ้นและลงเพื่อให้บริการรับส่งข้อมูลขาเข้าได้สำเร็จและประหยัด การตรวจสอบตัวชี้วัดการดำเนินงานและการแจ้งเตือนสำหรับปัญหาด้านการปฏิบัติงานที่ไม่คาดคิดก็เป็นสิ่งสำคัญเช่นกัน เพื่อป้องกันการสูญเสียข้อมูลและบริการให้กับลูกค้า การตรวจสอบความสมบูรณ์ของบริการเหล่านี้ตรงไปตรงมาโดยใช้ อเมซอน คลาวด์วอตช์. ตัววัดความสมบูรณ์ของบริการที่สำคัญ เช่น ข้อผิดพลาดและเวลาแฝงของการดำเนินการ ตลอดจนตัววัดการใช้งาน เช่น หน่วยความจำ ดิสก์ และการใช้งาน CPU นั้นพร้อมใช้งานทันทีโดยใช้ CloudWatch ทีมพัฒนาของเราใช้แดชบอร์ดตัวชี้วัดและการตรวจสอบอัตโนมัติเพื่อให้แน่ใจว่าเราสามารถให้บริการลูกค้าด้วยความพร้อมใช้งานสูง (99.8%) และเวลาแฝงต่ำ (น้อยกว่า 200 มิลลิวินาทีตั้งแต่ต้นจนจบเพื่อรับการแสดงที่แนะนำต่อผู้ใช้)

การวัดผล

ก่อนผู้แนะนำการแสดงตาม ML ที่อธิบายไว้ในโพสต์นี้ อัลกอริธึมฮิวริสติกที่ง่ายกว่าจะจัดอันดับ Amp แสดงตามหัวข้อส่วนตัวของผู้ใช้ที่สนใจซึ่งรายงานด้วยตนเองในโปรไฟล์ของพวกเขา เราตั้งค่าการทดสอบ A/B เพื่อวัดผลกระทบของการเปลี่ยนไปใช้ผู้แนะนำแบบ ML ด้วยข้อมูลของผู้ใช้จากการโต้ตอบกับแอปที่ผ่านมา เราระบุการปรับปรุงในเมตริก เช่น ระยะเวลาการฟังและจำนวนการดำเนินการมีส่วนร่วม (เช่น รายการ การติดตามผู้สร้างรายการ การเปิดการแจ้งเตือน) เป็นตัวชี้วัดความสำเร็จ การทดสอบ A/B โดย 50% ของผู้ใช้ที่ได้รับคำแนะนำการแสดงที่จัดอันดับสำหรับพวกเขาผ่านตัวแนะนำแบบ ML นั้นแสดงให้เห็นว่าเมตริกการมีส่วนร่วมของลูกค้าเพิ่มขึ้น 3% และระยะเวลาการเล่นดีขึ้น 0.5%

สรุป

ด้วยบริการที่สร้างขึ้นตามวัตถุประสงค์ ทีมงานของ Amp สามารถเผยแพร่ API คำแนะนำการแสดงส่วนบุคคลตามที่อธิบายไว้ในโพสต์นี้ไปยังเวอร์ชันที่ใช้งานจริงได้ภายใน 3 เดือน ระบบยังปรับขนาดได้ดีสำหรับการโหลดที่คาดเดาไม่ได้ซึ่งสร้างขึ้นโดยโฮสต์การแสดงที่มีชื่อเสียงหรือแคมเปญการตลาดที่อาจทำให้ผู้ใช้หลั่งไหลเข้ามา โซลูชันใช้บริการที่มีการจัดการสำหรับการประมวลผล การฝึกอบรม และการโฮสต์ ซึ่งช่วยลดเวลาที่ใช้ในการบำรุงรักษาระบบในแต่ละวัน เรายังสามารถตรวจสอบบริการที่มีการจัดการทั้งหมดเหล่านี้ผ่าน CloudWatch เพื่อให้แน่ใจว่าระบบยังคงทำงานอยู่อย่างต่อเนื่อง

การทดสอบ A/B เวอร์ชันแรกของผู้แนะนำแบบ ML ของ Amp กับแนวทางตามกฎ (ซึ่งจัดเรียงตามหัวข้อที่ลูกค้าสนใจเท่านั้น) ได้แสดงให้เห็นว่าผู้แนะนำแบบ ML จะทำให้ลูกค้าได้รับเนื้อหาที่มีคุณภาพสูงขึ้นจากหัวข้อที่หลากหลายมากขึ้น ซึ่งส่งผลให้มีการติดตามและเปิดใช้งานการแจ้งเตือนจำนวนมากขึ้น ทีมงาน Amp ทำงานอย่างต่อเนื่องเพื่อปรับปรุงโมเดลเพื่อให้คำแนะนำที่เกี่ยวข้องอย่างมาก

สำหรับข้อมูลเพิ่มเติมเกี่ยวกับ Feature Store โปรดไปที่ Amazon SageMaker ฟีเจอร์สโตร์ และตรวจสอบกรณีการใช้งานอื่นๆ ของลูกค้าใน บล็อก AWS Machine Learning.

เกี่ยวกับผู้แต่ง

ทิวลิป คุปตะ เป็นสถาปนิกโซลูชันที่ Amazon Web Services เธอทำงานร่วมกับ Amazon เพื่อออกแบบ สร้าง และปรับใช้โซลูชันเทคโนโลยีบน AWS เธอช่วยลูกค้าในการนำแนวทางปฏิบัติที่ดีที่สุดมาใช้ในขณะที่ปรับใช้โซลูชันใน AWS และเป็นผู้ชื่นชอบ Analytics และ ML ในเวลาว่าง เธอชอบว่ายน้ำ เดินป่า และเล่นเกมกระดาน

ทิวลิป คุปตะ เป็นสถาปนิกโซลูชันที่ Amazon Web Services เธอทำงานร่วมกับ Amazon เพื่อออกแบบ สร้าง และปรับใช้โซลูชันเทคโนโลยีบน AWS เธอช่วยลูกค้าในการนำแนวทางปฏิบัติที่ดีที่สุดมาใช้ในขณะที่ปรับใช้โซลูชันใน AWS และเป็นผู้ชื่นชอบ Analytics และ ML ในเวลาว่าง เธอชอบว่ายน้ำ เดินป่า และเล่นเกมกระดาน

เดวิด คู เป็นสถาปนิกโซลูชันที่ Amazon Web Services เขาทำงานร่วมกับลูกค้าของ AWS เพื่อออกแบบ สร้าง และปรับใช้โซลูชันเทคโนโลยีบน AWS เขาทำงานร่วมกับลูกค้าด้านสื่อและความบันเทิงและมีความสนใจในเทคโนโลยีแมชชีนเลิร์นนิง ในเวลาว่างเขาสงสัยว่าเขาจะทำอะไรกับเวลาว่าง

เดวิด คู เป็นสถาปนิกโซลูชันที่ Amazon Web Services เขาทำงานร่วมกับลูกค้าของ AWS เพื่อออกแบบ สร้าง และปรับใช้โซลูชันเทคโนโลยีบน AWS เขาทำงานร่วมกับลูกค้าด้านสื่อและความบันเทิงและมีความสนใจในเทคโนโลยีแมชชีนเลิร์นนิง ในเวลาว่างเขาสงสัยว่าเขาจะทำอะไรกับเวลาว่าง

มาโนลยา แมคคอร์มิค เป็นวิศวกรพัฒนาซอฟต์แวร์ Sr สำหรับ Amp บน Amazon เธอออกแบบและสร้างระบบแบบกระจายโดยใช้ AWS เพื่อให้บริการแอปพลิเคชันที่ต้องเผชิญกับลูกค้า เธอชอบอ่านและทำอาหารสูตรใหม่ๆ ในเวลาว่าง

มาโนลยา แมคคอร์มิค เป็นวิศวกรพัฒนาซอฟต์แวร์ Sr สำหรับ Amp บน Amazon เธอออกแบบและสร้างระบบแบบกระจายโดยใช้ AWS เพื่อให้บริการแอปพลิเคชันที่ต้องเผชิญกับลูกค้า เธอชอบอ่านและทำอาหารสูตรใหม่ๆ ในเวลาว่าง

เจฟฟ์ คริสโตเฟอร์เซ่น เป็น Sr. Data Engineer สำหรับ Amp ใน Amazon เขาทำงานเพื่อออกแบบ สร้าง และปรับใช้โซลูชัน Big Data บน AWS ที่ขับเคลื่อนข้อมูลเชิงลึกที่นำไปใช้ได้จริง เขาช่วยทีมภายในในการปรับใช้โซลูชันที่ปรับขนาดได้และเป็นอัตโนมัติ และเป็นผู้ที่ชื่นชอบการวิเคราะห์และบิ๊กดาต้า ในเวลาว่าง เมื่อเขาไม่ได้เล่นสกี คุณสามารถพบเขาบนจักรยานเสือภูเขา

เจฟฟ์ คริสโตเฟอร์เซ่น เป็น Sr. Data Engineer สำหรับ Amp ใน Amazon เขาทำงานเพื่อออกแบบ สร้าง และปรับใช้โซลูชัน Big Data บน AWS ที่ขับเคลื่อนข้อมูลเชิงลึกที่นำไปใช้ได้จริง เขาช่วยทีมภายในในการปรับใช้โซลูชันที่ปรับขนาดได้และเป็นอัตโนมัติ และเป็นผู้ที่ชื่นชอบการวิเคราะห์และบิ๊กดาต้า ในเวลาว่าง เมื่อเขาไม่ได้เล่นสกี คุณสามารถพบเขาบนจักรยานเสือภูเขา

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- อเมซอน SageMaker

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- AWS Machine Learning AWS

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- โซลูชั่นสำหรับลูกค้า

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- ขนาดไอ

- วากยสัมพันธ์

- ลมทะเล