บทนำ

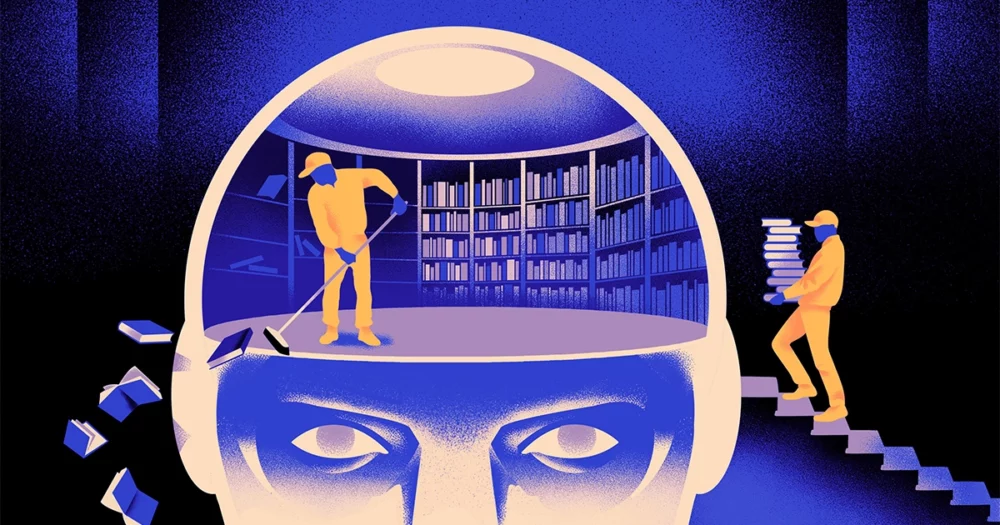

ทีมนักวิทยาศาสตร์คอมพิวเตอร์ได้สร้าง ว่องไวกว่าและมีความยืดหยุ่นมากขึ้น ของโมเดลการเรียนรู้ของเครื่อง เคล็ดลับ: ต้องลืมสิ่งที่รู้เป็นระยะๆ และแม้ว่าแนวทางใหม่นี้จะไม่เข้ามาแทนที่โมเดลขนาดใหญ่ที่รองรับแอปที่ใหญ่ที่สุด แต่ก็สามารถเปิดเผยเพิ่มเติมเกี่ยวกับวิธีที่โปรแกรมเหล่านี้เข้าใจภาษาได้

การวิจัยครั้งใหม่นี้ถือเป็น "ความก้าวหน้าที่สำคัญในสาขานี้" กล่าว เจียควอนซึ่งเป็นวิศวกร AI จากสถาบันวิทยาศาสตร์พื้นฐานในประเทศเกาหลีใต้

เอ็นจิ้นภาษา AI ที่ใช้อยู่ในปัจจุบันส่วนใหญ่ขับเคลื่อนโดย โครงข่ายประสาทเทียม. “เซลล์ประสาท” แต่ละตัวในเครือข่ายเป็นฟังก์ชันทางคณิตศาสตร์ที่รับสัญญาณจากเซลล์ประสาทอื่นๆ ดำเนินการคำนวณ และส่งสัญญาณผ่านเซลล์ประสาทหลายชั้น ในตอนแรกการไหลของข้อมูลจะเป็นแบบสุ่มไม่มากก็น้อย แต่จากการฝึก การไหลของข้อมูลระหว่างเซลล์ประสาทจะดีขึ้นเมื่อเครือข่ายปรับให้เข้ากับข้อมูลการฝึก ตัวอย่างเช่น หากนักวิจัย AI ต้องการสร้างแบบจำลองสองภาษา เธอจะฝึกแบบจำลองด้วยกองข้อความขนาดใหญ่จากทั้งสองภาษา ซึ่งจะปรับการเชื่อมต่อระหว่างเซลล์ประสาทในลักษณะที่เกี่ยวข้องกับข้อความในภาษาเดียวที่เทียบเท่ากัน คำในอีกคำหนึ่ง

แต่กระบวนการฝึกอบรมนี้ต้องใช้พลังในการประมวลผลเป็นจำนวนมาก หากโมเดลทำงานได้ไม่ดีนัก หรือหากความต้องการของผู้ใช้เปลี่ยนแปลงในภายหลัง ก็ยากที่จะปรับเปลี่ยน “สมมติว่าคุณมีแบบจำลองที่มี 100 ภาษา แต่ลองจินตนาการว่าภาษาเดียวที่คุณต้องการไม่ครอบคลุม” กล่าว มิเกล อาร์เต็ตเซ่ผู้ร่วมเขียนงานวิจัยใหม่และผู้ก่อตั้ง Reka สตาร์ทอัพด้าน AI “คุณสามารถเริ่มต้นใหม่ได้ แต่มันไม่เหมาะ”

Artetxe และเพื่อนร่วมงานของเขาได้พยายามหลีกเลี่ยงข้อจำกัดเหล่านี้ ไม่กี่ปีที่ผ่านมาArtetxe และคนอื่นๆ ฝึกฝนโครงข่ายประสาทเทียมในภาษาเดียว จากนั้นจึงลบสิ่งที่รู้เกี่ยวกับกลุ่มคำที่เรียกว่าโทเค็น สิ่งเหล่านี้จะถูกจัดเก็บไว้ในเลเยอร์แรกของโครงข่ายประสาทเทียม เรียกว่าเลเยอร์การฝัง พวกเขาทิ้งเลเยอร์อื่นๆ ทั้งหมดของโมเดลไว้ตามลำพัง หลังจากลบโทเค็นของภาษาแรกแล้ว พวกเขาก็ฝึกโมเดลใหม่ในภาษาที่สอง ซึ่งเติมเต็มเลเยอร์ที่ฝังด้วยโทเค็นใหม่จากภาษานั้น

แม้ว่าแบบจำลองจะมีข้อมูลที่ไม่ตรงกัน แต่การฝึกอบรมใหม่ก็ใช้งานได้: โมเดลสามารถเรียนรู้และประมวลผลภาษาใหม่ได้ นักวิจัยคาดการณ์ว่าในขณะที่เลเยอร์ที่ฝังจะเก็บข้อมูลเฉพาะของคำที่ใช้ในภาษา แต่ระดับที่ลึกกว่าของเครือข่ายจะเก็บข้อมูลที่เป็นนามธรรมมากขึ้นเกี่ยวกับแนวคิดเบื้องหลังภาษาของมนุษย์ ซึ่งช่วยให้แบบจำลองเรียนรู้ภาษาที่สองได้

“เราอยู่ในโลกใบเดียวกัน เราสร้างแนวคิดสิ่งเดียวกันด้วยคำที่ต่างกัน” ในภาษาที่ต่างกันกล่าว อี้หง เฉินผู้เขียนนำรายงานล่าสุด “นั่นเป็นสาเหตุว่าทำไมคุณถึงมีเหตุผลระดับสูงแบบเดียวกันในแบบจำลองนี้ แอปเปิ้ลเป็นสิ่งที่หวานและชุ่มฉ่ำ แทนที่จะเป็นเพียงคำพูด”

บทนำ

แม้ว่าแนวทางการลืมนี้เป็นวิธีที่มีประสิทธิภาพในการเพิ่มภาษาใหม่ให้กับโมเดลที่ได้รับการฝึกอบรมแล้ว การฝึกอบรมขึ้นใหม่ยังคงมีความต้องการ เนื่องจากต้องใช้ข้อมูลทางภาษาและพลังในการประมวลผลจำนวนมาก Chen แนะนำให้ปรับแต่ง: แทนที่จะฝึก ลบเลเยอร์ที่ฝัง แล้วฝึกใหม่ พวกเขาควรรีเซ็ตเลเยอร์ที่ฝังเป็นระยะๆ ในระหว่างรอบแรกของการฝึก “ด้วยการทำเช่นนี้ โมเดลทั้งหมดจะคุ้นเคยกับการรีเซ็ต” Artetxe กล่าว “นั่นหมายความว่าเมื่อคุณต้องการขยายโมเดลไปยังภาษาอื่น มันจะง่ายกว่า เพราะนั่นคือสิ่งที่คุณกำลังทำอยู่”

นักวิจัยได้นำแบบจำลองภาษาที่ใช้กันทั่วไปเรียกว่า โรเบอร์ต้าฝึกฝนโดยใช้เทคนิคการลืมเป็นระยะ และเปรียบเทียบกับประสิทธิภาพของรุ่นเดียวกันเมื่อได้รับการฝึกด้วยวิธีมาตรฐานและไม่ลืม โมเดลการลืมทำได้แย่กว่าโมเดลทั่วไปเล็กน้อย โดยได้คะแนน 85.1 เทียบกับ 86.1 จากการวัดความแม่นยำของภาษาทั่วไป จากนั้นพวกเขาก็ฝึกโมเดลในภาษาอื่นอีกครั้ง โดยใช้ชุดข้อมูลที่เล็กกว่ามากเพียง 5 ล้านโทเค็น แทนที่จะเป็น 70 พันล้านที่ใช้ในการฝึกอบรมครั้งแรก ความแม่นยำของโมเดลมาตรฐานลดลงเหลือ 53.3 โดยเฉลี่ย แต่โมเดลลืมลดลงเหลือเพียง 62.7 เท่านั้น

โมเดลการลืมจะมีอาการดีขึ้นมากหากทีมกำหนดขีดจำกัดด้านการคำนวณระหว่างการฝึกขึ้นใหม่ เมื่อนักวิจัยลดระยะเวลาการฝึกจาก 125,000 ก้าวเหลือเพียง 5,000 ขั้น ความแม่นยำของแบบจำลองการลืมลดลงเหลือ 57.8 โดยเฉลี่ย ในขณะที่แบบจำลองมาตรฐานลดลงเหลือ 37.2 ซึ่งไม่ได้ดีไปกว่าการคาดเดาแบบสุ่ม

บทนำ

ทีมงานสรุปว่าการลืมเป็นระยะๆ ดูเหมือนจะทำให้รูปแบบการเรียนรู้ภาษาโดยทั่วไปดีขึ้น “เพราะ [พวกเขา] ลืมและเรียนรู้ใหม่ในระหว่างการฝึกอบรม การสอนสิ่งใหม่ ๆ บนเครือข่ายในภายหลังจึงง่ายขึ้น” กล่าว เยฟเจนี่ นิกิชินนักวิจัยจาก Mila ซึ่งเป็นศูนย์วิจัยการเรียนรู้เชิงลึกในควิเบก มันแสดงให้เห็นว่าเมื่อแบบจำลองภาษาเข้าใจภาษาหนึ่งๆ พวกเขาเข้าใจในระดับที่ลึกกว่าแค่ความหมายของคำแต่ละคำ

แนวทางนี้คล้ายกับวิธีการทำงานของสมองของเราเอง “โดยทั่วไปแล้วความจำของมนุษย์ไม่ค่อยดีนักในการจัดเก็บข้อมูลรายละเอียดจำนวนมากอย่างแม่นยำ แต่มนุษย์มักจะจดจำแก่นแท้ของประสบการณ์ของเรา โดยการสรุปและคาดการณ์” กล่าว เบนจามิน เลวี, นักประสาทวิทยาจากมหาวิทยาลัยซานฟรานซิสโก “การเปิดใช้งาน AI ด้วยกระบวนการที่เหมือนมนุษย์มากขึ้น เช่น การลืมแบบปรับตัว เป็นวิธีหนึ่งในการทำให้พวกเขาได้รับประสิทธิภาพที่ยืดหยุ่นมากขึ้น”

นอกเหนือจากสิ่งที่อาจกล่าวเกี่ยวกับวิธีการทำความเข้าใจแล้ว Artetxe หวังว่าโมเดลการลืมภาษาที่มีความยืดหยุ่นมากขึ้นยังสามารถช่วยนำความก้าวหน้าทาง AI ล่าสุดไปสู่ภาษาอื่น ๆ ได้มากขึ้น แม้ว่าโมเดล AI จะเก่งในการจัดการภาษาสเปนและอังกฤษ แต่ก็มีสองภาษาพร้อมสื่อการฝึกอบรมที่เพียงพอ แต่โมเดลดังกล่าวไม่ค่อยดีนักกับภาษาบาสก์ซึ่งเป็นภาษาท้องถิ่นเฉพาะทางตะวันออกเฉียงเหนือของสเปน “โมเดลส่วนใหญ่จากบริษัทเทคโนโลยีขนาดใหญ่ทำได้ไม่ดีนัก” เขากล่าว “การปรับโมเดลที่มีอยู่ให้เข้ากับ Basque คือหนทางไป”

เฉินยังตั้งตารอที่โลกจะมีดอกไม้ AI บานสะพรั่งมากขึ้น “ฉันกำลังคิดถึงสถานการณ์ที่โลกไม่ต้องการแบบจำลองภาษาขนาดใหญ่เพียงตัวเดียว เรามีมากมาย” เธอกล่าว “ถ้ามีโรงงานที่สร้างโมเดลภาษา คุณต้องมีเทคโนโลยีประเภทนี้ มีโมเดลพื้นฐานเดียวที่สามารถปรับให้เข้ากับโดเมนใหม่ได้อย่างรวดเร็ว”

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- ][หน้า

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- เกี่ยวกับเรา

- บทคัดย่อ

- ความถูกต้อง

- แม่นยำ

- ปรับ

- ปรับได้

- ปรับ

- เพิ่ม

- นอกจากนี้

- ความก้าวหน้า

- หลังจาก

- AI

- โมเดล AI

- ทั้งหมด

- คนเดียว

- แล้ว

- ด้วย

- จำนวน

- an

- และ

- อื่น

- Apple

- เข้าใกล้

- ปพลิเคชัน

- เป็น

- AS

- At

- ผู้เขียน

- เฉลี่ย

- ฐาน

- ขั้นพื้นฐาน

- เพราะ

- จะกลายเป็น

- รับ

- หลัง

- ดีกว่า

- ระหว่าง

- ใหญ่

- เทคโนโลยีขนาดใหญ่

- ที่ใหญ่ที่สุด

- พันล้าน

- Blocks

- บานสะพรั่ง

- ทั้งสอง

- นวัตกรรม

- นำมาซึ่ง

- การก่อสร้าง

- แต่

- by

- การคำนวณ

- ที่เรียกว่า

- CAN

- ศูนย์

- เปลี่ยนแปลง

- เฉิน

- หลีกเลี่ยง

- ผู้เขียนร่วม

- เพื่อนร่วมงาน

- ร่วมกัน

- อย่างธรรมดา

- บริษัท

- เมื่อเทียบกับ

- การคำนวณ

- คอมพิวเตอร์

- การคำนวณ

- พลังคอมพิวเตอร์

- แนวความคิด

- สรุป

- การเชื่อมต่อ

- ที่มีอยู่

- ตามธรรมเนียม

- ได้

- ปกคลุม

- สร้าง

- ที่สร้างขึ้น

- ตัด

- ข้อมูล

- ชุดข้อมูล

- ลดลง

- ลึก

- การเรียนรู้ลึก ๆ

- ลึก

- เรียกร้อง

- รายละเอียด

- DID

- ต่าง

- do

- ไม่

- การทำ

- โดเมน

- Dont

- ปรับตัวลดลง

- ในระหว่าง

- แต่ละ

- ง่ายดาย

- มีประสิทธิภาพ

- การฝัง

- วิศวกร

- เครื่องยนต์

- ภาษาอังกฤษ

- ทั้งหมด

- เท่ากัน

- ตัวอย่าง

- ที่มีอยู่

- ประสบการณ์

- ขยายออก

- โรงงาน

- สองสาม

- สนาม

- ที่เต็มไป

- ชื่อจริง

- มีความยืดหยุ่น

- ไหล

- สำหรับ

- ข้างหน้า

- ผู้สร้าง

- ฟรานซิส

- ราคาเริ่มต้นที่

- ฟังก์ชัน

- General

- โดยทั่วไป

- ได้รับ

- GitHub

- Go

- ดี

- การจัดการ

- ยาก

- มี

- he

- ช่วย

- ช่วย

- ระดับสูง

- ของเขา

- หวัง

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- HTTPS

- ใหญ่

- เป็นมนุษย์

- เหมือนมนุษย์

- มนุษย์

- ในอุดมคติ

- if

- ภาพ

- กำหนด

- ช่วยเพิ่ม

- in

- เป็นรายบุคคล

- ข้อมูล

- แรกเริ่ม

- ในขั้นต้น

- แทน

- สถาบัน

- IT

- เพียงแค่

- เก็บ

- ชนิด

- รู้

- เกาหลี

- ภาษา

- ภาษา

- ใหญ่

- ต่อมา

- ล่าสุด

- ชั้น

- ชั้น

- นำ

- เรียนรู้

- การเรียนรู้

- ซ้าย

- ความยาว

- น้อยลง

- ชั้น

- ระดับ

- กดไลก์

- ข้อ จำกัด

- ขีด จำกัด

- สด

- ในประเทศ

- LOOKS

- Lot

- เครื่อง

- เรียนรู้เครื่อง

- นิตยสาร

- ทำ

- การทำ

- หลาย

- วัสดุ

- คณิตศาสตร์

- ความหมาย

- วิธี

- วัด

- หน่วยความจำ

- อาจ

- ล้าน

- แบบ

- โมเดล

- ข้อมูลเพิ่มเติม

- ส่วนใหญ่

- มาก

- หลาย

- ต้อง

- พื้นเมือง

- จำเป็นต้อง

- ความต้องการ

- เครือข่าย

- เกี่ยวกับประสาท

- เครือข่ายประสาท

- เซลล์ประสาท

- ใหม่

- ไม่

- of

- on

- ONE

- เพียง

- or

- อื่นๆ

- ผลิตภัณฑ์อื่นๆ

- ของเรา

- เกิน

- ของตนเอง

- กระดาษ

- การปฏิบัติ

- เป็นระยะ

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- ลดลง

- อำนาจ

- ขับเคลื่อน

- กระบวนการ

- กระบวนการ

- การประมวลผล

- กำลังประมวลผล

- โปรแกรม

- ควอนทามากาซีน

- ควิเบก

- อย่างรวดเร็ว

- สุ่ม

- ค่อนข้าง

- ที่ได้รับ

- การได้รับ

- เมื่อเร็ว ๆ นี้

- จำ

- จำเป็นต้องใช้

- การวิจัย

- นักวิจัย

- นักวิจัย

- เปิดเผย

- ปัดเศษ

- ทำงาน

- กล่าวว่า

- เดียวกัน

- ซาน

- ซานฟรานซิสโก

- กล่าว

- วิทยาศาสตร์

- นักวิทยาศาสตร์

- คะแนน

- รอยขีดข่วน

- ที่สอง

- ดูเหมือนว่า

- เลือก

- ส่ง

- ชุดอุปกรณ์

- เธอ

- น่า

- สัญญาณ

- สำคัญ

- คล้ายคลึงกัน

- สถานการณ์

- มีขนาดเล็กกว่า

- So

- บาง

- บางสิ่งบางอย่าง

- ภาคใต้

- เกาหลีใต้

- สเปน

- สเปน

- โดยเฉพาะ

- มาตรฐาน

- เริ่มต้น

- การเริ่มต้น

- ขั้นตอน

- ยังคง

- เก็บไว้

- การเก็บรักษา

- อย่างเช่น

- ชี้ให้เห็นถึง

- หวาน

- ใช้เวลา

- การเรียนการสอน

- ทีม

- เทคโนโลยี

- tech บริษัท

- เทคนิค

- เทคโนโลยี

- มีแนวโน้ม

- ข้อความ

- กว่า

- ที่

- พื้นที่

- ข้อมูล

- โลก

- ของพวกเขา

- พวกเขา

- แล้วก็

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- สิ่ง

- คิด

- นี้

- แต่?

- ตลอด

- ไปยัง

- ในวันนี้

- ราชสกุล

- เอา

- รถไฟ

- ผ่านการฝึกอบรม

- การฝึกอบรม

- เคล็ดลับ

- พยายาม

- บิด

- สอง

- เข้าใจ

- ความเข้าใจ

- มหาวิทยาลัย

- ใช้

- มือสอง

- การใช้

- มาก

- ต้องการ

- ต้องการ

- คือ

- ทาง..

- we

- webp

- ดี

- อะไร

- เมื่อ

- ที่

- ในขณะที่

- ทำไม

- กับ

- คำ

- คำ

- งาน

- ทำงาน

- โรงงาน

- โลก

- แย่ลง

- จะ

- ปี

- คุณ

- ลมทะเล