ลูกค้า AWS ของเราหลายรายให้บริการการวิจัย การวิเคราะห์ และระบบธุรกิจอัจฉริยะ การวิจัยและข่าวกรองธุรกิจประเภทนี้ช่วยให้ลูกค้าปลายทางนำหน้าตลาดและคู่แข่ง ระบุโอกาสในการเติบโต และแก้ไขปัญหาในเชิงรุก ตัวอย่างเช่น ลูกค้าในภาคส่วนบริการทางการเงินของเราบางรายทำการวิจัยเกี่ยวกับตราสารทุน กองทุนเฮดจ์ฟันด์ และบริษัทจัดการการลงทุน เพื่อช่วยให้พวกเขาเข้าใจแนวโน้มและระบุกลยุทธ์พอร์ตโฟลิโอ ในอุตสาหกรรมด้านสุขภาพ ปัจจุบันการวิจัยด้านสุขภาพส่วนใหญ่มีฐานเป็นข้อมูล การวิจัยจำนวนมากเกี่ยวข้องกับการวิเคราะห์ข้อมูลที่รวบรวมในขั้นต้นเพื่อการวินิจฉัย การรักษา หรือสำหรับโครงการวิจัยอื่น ๆ และขณะนี้ถูกนำมาใช้เพื่อวัตถุประสงค์ในการวิจัยใหม่ ๆ รูปแบบการวิจัยด้านสุขภาพเหล่านี้นำไปสู่การป้องกันเบื้องต้นที่มีประสิทธิภาพเพื่อหลีกเลี่ยงผู้ป่วยรายใหม่ การป้องกันรองเพื่อตรวจหาแต่เนิ่นๆ และการป้องกันเพื่อการจัดการโรคที่ดีขึ้น ผลการวิจัยนอกจากจะทำให้คุณภาพชีวิตดีขึ้นแล้วยังช่วยลดค่ารักษาพยาบาลอีกด้วย

ลูกค้ามักจะแยกแยะข้อมูลจากแหล่งข้อมูลสาธารณะและส่วนตัว จากนั้นจึงใช้โมเดลการประมวลผลภาษาธรรมชาติ (NLP) ที่สร้างขึ้นหรือกำหนดเองเพื่อสรุปและระบุแนวโน้มและสร้างข้อมูลเชิงลึกตามข้อมูลนี้ แบบจำลอง NLP ที่ใช้สำหรับงานวิจัยประเภทนี้เกี่ยวข้องกับแบบจำลองขนาดใหญ่ และมักจะเกี่ยวข้องกับบทความขนาดยาวที่จะสรุปโดยพิจารณาจากขนาดของคลังข้อมูล—และจุดสิ้นสุดเฉพาะ ซึ่งไม่ได้ปรับต้นทุนให้เหมาะสมในขณะนี้ แอปพลิเคชันเหล่านี้ได้รับการเข้าชมจำนวนมากในช่วงเวลาต่างๆ ของวัน

เราเชื่อว่าลูกค้าจะได้รับประโยชน์อย่างมากจากความสามารถในการลดขนาดลงเป็นศูนย์และเพิ่มความสามารถในการอนุมานตามความจำเป็น สิ่งนี้ช่วยปรับต้นทุนการวิจัยให้เหมาะสมและยังไม่ลดทอนคุณภาพของการอนุมาน โพสต์นี้กล่าวถึงวิธีการกอดหน้าพร้อมกับ อเมซอน SageMaker การอนุมานแบบอะซิงโครนัสสามารถช่วยให้บรรลุเป้าหมายนี้ได้

คุณสามารถสร้างโมเดลการสรุปข้อความด้วยเฟรมเวิร์กการเรียนรู้เชิงลึกหลายตัว เช่น TensorFlow, PyTorch และ Apache MXNet โมเดลเหล่านี้มักจะมีเพย์โหลดขนาดใหญ่สำหรับเอกสารข้อความหลายรายการที่มีขนาดแตกต่างกัน โมเดลการเรียนรู้เชิงลึกขั้นสูงต้องการการประมวลผลล่วงหน้าที่มีการคำนวณสูงก่อนที่จะอนุมานโมเดล เวลาในการประมวลผลอาจนานถึงสองสามนาที ซึ่งจะลบตัวเลือกในการเรียกใช้การอนุมานตามเวลาจริงโดยการส่งผ่านเพย์โหลดผ่าน HTTP API คุณต้องประมวลผลเพย์โหลดอินพุตแบบอะซิงโครนัสจากที่เก็บอ็อบเจ็กต์แทน บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (Amazon S3) พร้อมการจัดคิวอัตโนมัติและเกณฑ์การทำงานพร้อมกันที่กำหนดไว้ล่วงหน้า ระบบควรสามารถรับการแจ้งเตือนสถานะและลดค่าใช้จ่ายที่ไม่จำเป็นโดยการล้างทรัพยากรเมื่องานเสร็จสิ้น

SageMaker ช่วยให้นักวิทยาศาสตร์ข้อมูลและนักพัฒนาจัดเตรียม สร้าง ฝึกฝน และปรับใช้โมเดลแมชชีนเลิร์นนิง (ML) คุณภาพสูงได้อย่างรวดเร็วโดยรวบรวมชุดความสามารถที่หลากหลายซึ่งสร้างขึ้นตามวัตถุประสงค์สำหรับ ML SageMaker นำเสนอคอนเทนเนอร์ที่ให้บริการโมเดลแบบโอเพ่นซอร์สที่ทันสมัยที่สุดสำหรับ XGBoost (ภาชนะ, SDK), Scikit-เรียนรู้ (ภาชนะ, SDK), ไพทอร์ช (ภาชนะ, SDK), เทนเซอร์โฟลว์ (ภาชนะ, SDK) และ Apache MXNet (ภาชนะ, SDK).

- การอนุมานตามเวลาจริง จุดสิ้นสุดเหมาะสำหรับปริมาณงานที่ต้องประมวลผลด้วยความต้องการเวลาแฝงต่ำตามลำดับ ms ถึงวินาที

- การแปลงแบทช์ เหมาะอย่างยิ่งสำหรับการคาดคะเนแบบออฟไลน์สำหรับข้อมูลจำนวนมาก

- การอนุมานแบบไร้เซิร์ฟเวอร์ของ Amazon SageMaker (ในโหมดดูตัวอย่างและไม่แนะนำสำหรับปริมาณงานการผลิตในขณะที่เขียนบทความนี้) เป็นตัวเลือกการอนุมานที่สร้างขึ้นตามวัตถุประสงค์ ซึ่งช่วยให้คุณปรับใช้และปรับขนาดโมเดล ML ได้ง่าย การอนุมานแบบไร้เซิร์ฟเวอร์เหมาะอย่างยิ่งสำหรับปริมาณงานที่มีช่วงว่างระหว่างทราฟฟิกกระฉูดและสามารถทนต่อการเริ่มเย็นได้

- การอนุมานแบบอะซิงโครนัส คำขอขาเข้าของคิวปลายทาง เหมาะสำหรับปริมาณงานที่คำขอมีขนาดใหญ่ (สูงสุด 1 GB) และเวลาในการประมวลผลอนุมานเป็นนาที (สูงสุด 15 นาที) การอนุมานแบบอะซิงโครนัสช่วยให้คุณประหยัดค่าใช้จ่ายโดยปรับขนาดอินสแตนซ์อัตโนมัติให้เป็นศูนย์เมื่อไม่มีคำขอให้ดำเนินการ

ภาพรวมโซลูชัน

ในโพสต์นี้ เราปรับใช้ รุ่นเพกาซัส ที่ได้รับการฝึกอบรมล่วงหน้าเพื่อทำการสรุปข้อความจาก กอดหน้า ไปยัง บริการโฮสติ้งของ SageMaker. เราใช้โมเดลจาก Hugging Face เพื่อความเรียบง่าย อย่างไรก็ตาม คุณสามารถ ปรับแต่งโมเดลอย่างละเอียดตามชุดข้อมูลที่กำหนดเอง. คุณยังสามารถลองรุ่นอื่นๆ ที่มีใน กอดหน้านางแบบฮับ. นอกจากนี้ เรายังจัดเตรียมจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสที่โฮสต์โมเดลนี้ ซึ่งคุณสามารถรับการคาดคะเนได้

ตัวจัดการการอนุมานของปลายทางการอนุมานแบบอะซิงโครนัสคาดว่าบทความเป็นเพย์โหลดอินพุต ข้อความสรุปของบทความคือผลลัพธ์ เอาต์พุตจะถูกจัดเก็บไว้ในฐานข้อมูลสำหรับการวิเคราะห์แนวโน้มหรือป้อนลงเพื่อการวิเคราะห์เพิ่มเติม การวิเคราะห์ดาวน์สตรีมนี้ได้รับข้อมูลเชิงลึกที่ช่วยในการวิจัย

เราแสดงให้เห็นว่าจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสช่วยให้คุณมีการแจ้งเตือนการทำงานพร้อมกันและเสร็จสิ้นตามที่ผู้ใช้กำหนดได้อย่างไร เรากำหนดค่าการปรับขนาดอัตโนมัติของอินสแตนซ์หลังจุดสิ้นสุดให้ลดขนาดลงเป็นศูนย์เมื่อทราฟฟิกลดลงและสำรองขนาดเมื่อคิวคำขอเต็ม

เรายังใช้ อเมซอน คลาวด์วอตช์ เมตริกเพื่อมอนิเตอร์ขนาดคิว เวลาประมวลผลทั้งหมด และการเรียกใช้ที่ประมวลผล

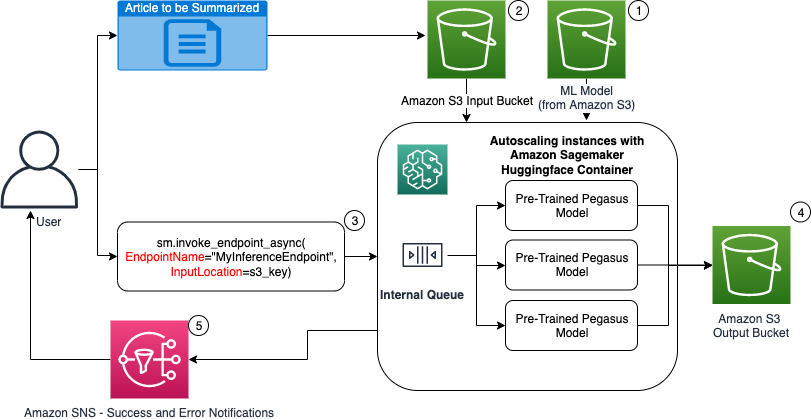

ในแผนภาพต่อไปนี้ เราแสดงขั้นตอนที่เกี่ยวข้องในขณะที่ทำการอนุมานโดยใช้จุดสิ้นสุดการอนุมานแบบอะซิงโครนัส

- การฝึกอบรมล่วงหน้าของเรา PEGASUS โมเดล ML ถูกโฮสต์บนจุดสิ้นสุดการปรับสเกลก่อน

- ผู้ใช้อัปโหลดบทความที่จะสรุปไปยังบัคเก็ต S3 อินพุต

- จุดสิ้นสุดการอนุมานแบบอะซิงโครนัสถูกเรียกใช้โดยใช้ API

- หลังจากการอนุมานเสร็จสิ้น ผลลัพธ์จะถูกบันทึกลงในบัคเก็ต S3 เอาต์พุต

- An บริการแจ้งเตือนแบบง่ายของ Amazon การแจ้งเตือน (Amazon SNS) จะถูกส่งไปยังผู้ใช้เพื่อแจ้งให้ทราบว่าสำเร็จหรือล้มเหลว

สร้างจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส

เราสร้างจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสที่คล้ายกับจุดสิ้นสุดที่โฮสต์ตามเวลาจริง ขั้นตอนประกอบด้วยการสร้างแบบจำลอง SageMaker ตามด้วยการกำหนดค่าจุดสิ้นสุดและปรับใช้จุดสิ้นสุด ความแตกต่างระหว่างจุดสิ้นสุดทั้งสองประเภทคือการกำหนดค่าจุดสิ้นสุดแบบอนุมานแบบอะซิงโครนัสประกอบด้วย AsyncInferenceConfig ส่วน. ที่นี่ เราระบุเส้นทางเอาต์พุต S3 สำหรับผลลัพธ์จากการเรียกใช้จุดสิ้นสุด และเลือกรวมหัวข้อ SNS สำหรับการแจ้งเตือนเมื่อสำเร็จและล้มเหลว นอกจากนี้ เรายังระบุจำนวนสูงสุดของการเรียกใช้พร้อมกันต่ออินสแตนซ์ตามที่ลูกค้ากำหนด ดูรหัสต่อไปนี้:

โปรดดูรายละเอียดเกี่ยวกับ API เพื่อสร้างการกำหนดค่าปลายทางสำหรับการอนุมานแบบอะซิงโครนัส สร้างจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส.

เรียกใช้จุดสิ้นสุดการอนุมานแบบอะซิงโครนัส

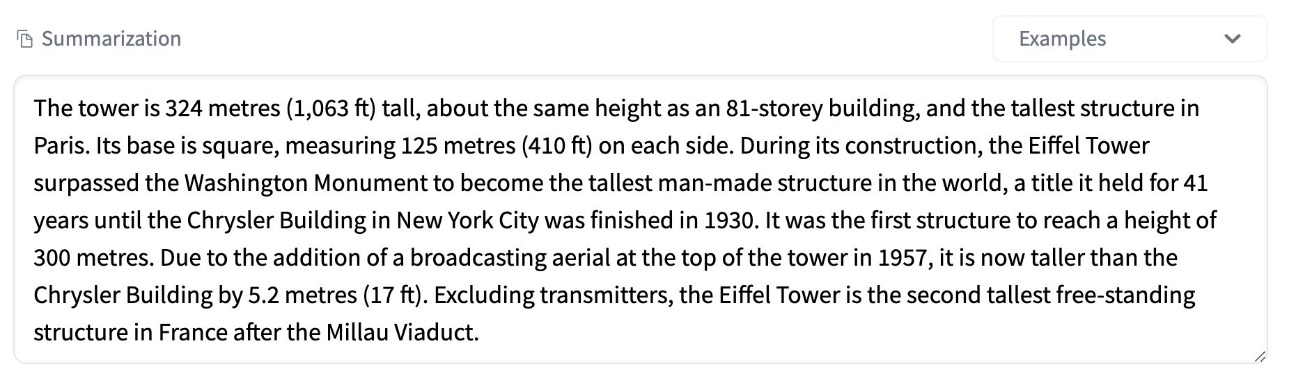

ภาพหน้าจอต่อไปนี้แสดงบทความสั้น ๆ ที่เราใช้เป็นเพย์โหลดอินพุตของเรา:

รหัสต่อไปนี้อัปโหลดบทความเป็น input.json ไฟล์ไปยัง Amazon S3:

เราใช้ Amazon S3 URI กับไฟล์เพย์โหลดอินพุตเพื่อเรียกใช้จุดสิ้นสุด ออบเจกต์ตอบกลับมีตำแหน่งเอาต์พุตใน Amazon S3 เพื่อดึงผลลัพธ์หลังจากเสร็จสิ้น:

ภาพหน้าจอต่อไปนี้แสดงการสรุปโพสต์ผลลัพธ์ตัวอย่าง:

โปรดดูรายละเอียดเกี่ยวกับ API เพื่อเรียกใช้จุดสิ้นสุดการอนุมานแบบอะซิงโครนัส เรียกใช้จุดสิ้นสุดการอนุมานแบบอะซิงโครนัส.

จัดคิวคำขอการเรียกใช้ด้วยการทำงานพร้อมกันที่ผู้ใช้กำหนด

จุดสิ้นสุดการอนุมานแบบอะซิงโครนัสจัดคิวคำขอการเรียกใช้โดยอัตโนมัติ นี่คือคิวที่มีการจัดการเต็มรูปแบบพร้อมเมตริกการตรวจสอบต่างๆ และไม่ต้องการการกำหนดค่าเพิ่มเติมใดๆ มันใช้ MaxConcurrentInvocationsPerInstance พารามิเตอร์ในการกำหนดค่าปลายทางก่อนหน้าเพื่อประมวลผลคำขอใหม่จากคิวหลังจากที่คำขอก่อนหน้านี้เสร็จสมบูรณ์ MaxConcurrentInvocationsPerInstance คือจำนวนคำขอพร้อมกันสูงสุดที่ไคลเอ็นต์ SageMaker ส่งไปยังคอนเทนเนอร์โมเดล หากไม่ได้ระบุค่าไว้ SageMaker จะเลือกค่าที่เหมาะสมที่สุดสำหรับคุณ

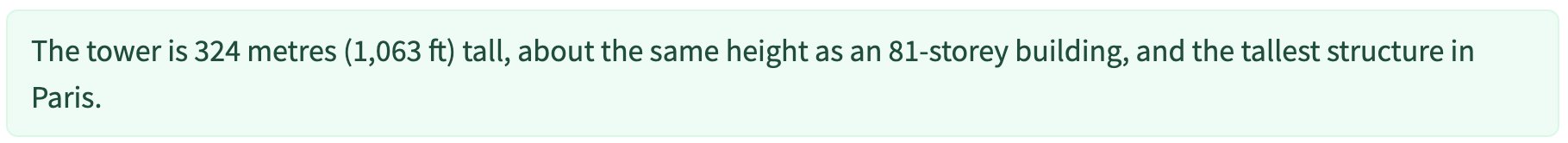

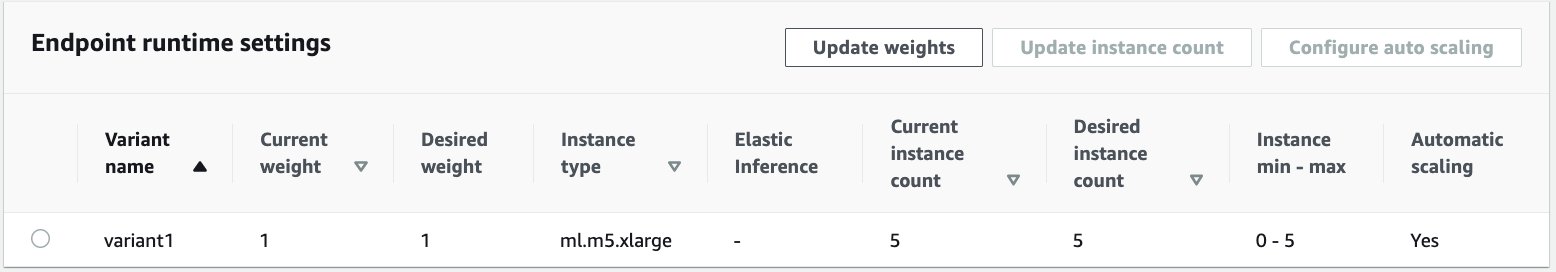

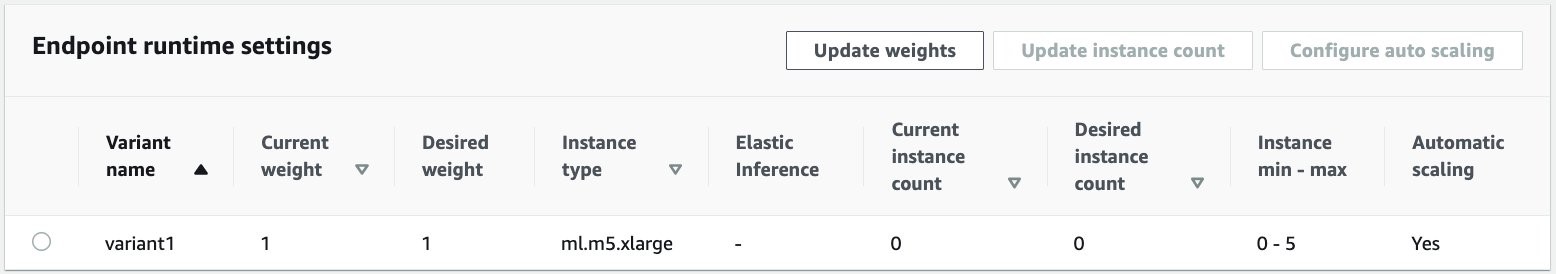

อินสแตนซ์ปรับขนาดอัตโนมัติภายในจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส

เรากำหนดนโยบายการปรับขนาดอัตโนมัติด้วยความจุขั้นต่ำเป็นศูนย์และความจุสูงสุดห้าอินสแตนซ์ จุดสิ้นสุดการอนุมานแบบอะซิงโครนัสไม่เหมือนกับจุดสิ้นสุดที่โฮสต์ตามเวลาจริง สนับสนุนการลดขนาดอินสแตนซ์ให้เป็นศูนย์โดยการตั้งค่าความจุขั้นต่ำเป็นศูนย์ เราใช้ ApproximateBacklogSizePerInstance เมตริกสำหรับการกำหนดค่านโยบายการปรับขนาดด้วยคิวเป้าหมายที่ค้างอยู่ XNUMX รายการต่ออินสแตนซ์เพื่อปรับขนาดเพิ่มเติม เรากำหนดระยะเวลาคูลดาวน์สำหรับ ScaleInCooldown ถึง 120 วินาที และ ScaleOutCooldown ถึง 120 วินาที ค่าสำหรับ ApproximateBacklogSizePerInstance จะถูกเลือกโดยพิจารณาจากทราฟฟิกและความไวต่อการปรับความเร็วของคุณ ยิ่งคุณปรับขนาดได้เร็วเท่าไร คุณก็ยิ่งมีค่าใช้จ่ายน้อยลง แต่มีโอกาสมากขึ้นที่คุณจะต้องปรับขนาดอีกครั้งเมื่อมีคำขอใหม่เข้ามา ยิ่งคุณปรับขนาดได้ช้าลง ค่าใช้จ่ายก็จะยิ่งมากขึ้น แต่คุณมีโอกาสน้อยที่จะมี คำขอเข้ามาเมื่อคุณไม่ได้สเกล

สำหรับรายละเอียดเกี่ยวกับ API เพื่อปรับขนาดจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสโดยอัตโนมัติ โปรดดูที่ ปรับขนาดจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสโดยอัตโนมัติ.

กำหนดค่าการแจ้งเตือนจากจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส

เราสร้างหัวข้อ SNS แยกกันสองหัวข้อสำหรับความสำเร็จและการแจ้งเตือนข้อผิดพลาดสำหรับผลลัพธ์การเรียกใช้ปลายทางแต่ละรายการ:

ตัวเลือกอื่นๆ สำหรับการแจ้งเตือน ได้แก่ การตรวจสอบเอาต์พุตของบัคเก็ต S3 เป็นระยะๆ หรือใช้การแจ้งเตือนบัคเก็ต S3 เพื่อเริ่มต้น AWS แลมบ์ดา ฟังก์ชั่นในการอัพโหลดไฟล์ การแจ้งเตือน SNS จะรวมอยู่ในส่วนการกำหนดค่าปลายทางตามที่อธิบายไว้ก่อนหน้านี้

โปรดดูรายละเอียดวิธีตั้งค่าการแจ้งเตือนจากจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส ตรวจสอบผลการทำนาย.

ตรวจสอบจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส

เราตรวจสอบจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสด้วยตัววัด CloudWatch เพิ่มเติมในตัวสำหรับการอนุมานแบบอะซิงโครนัสโดยเฉพาะ ตัวอย่างเช่น เราตรวจสอบความยาวของคิวในแต่ละอินสแตนซ์ด้วย ApproximateBacklogSizePerInstance และความยาวคิวทั้งหมดด้วย ApproximateBacklogSize.

สำหรับรายการเมตริกทั้งหมด โปรดดูที่ การตรวจสอบจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส.

เราสามารถเพิ่มประสิทธิภาพการกำหนดค่าปลายทางเพื่อให้ได้อินสแตนซ์ที่คุ้มค่าที่สุดและมีประสิทธิภาพสูง ตัวอย่างเช่น เราสามารถใช้อินสแตนซ์กับ Amazon Elastic Inference หรือ AWS Inferentia นอกจากนี้ เรายังสามารถค่อยๆ เพิ่มระดับการทำงานพร้อมกันจนถึงปริมาณงานสูงสุดในขณะที่ปรับพารามิเตอร์เซิร์ฟเวอร์และคอนเทนเนอร์รุ่นอื่นๆ

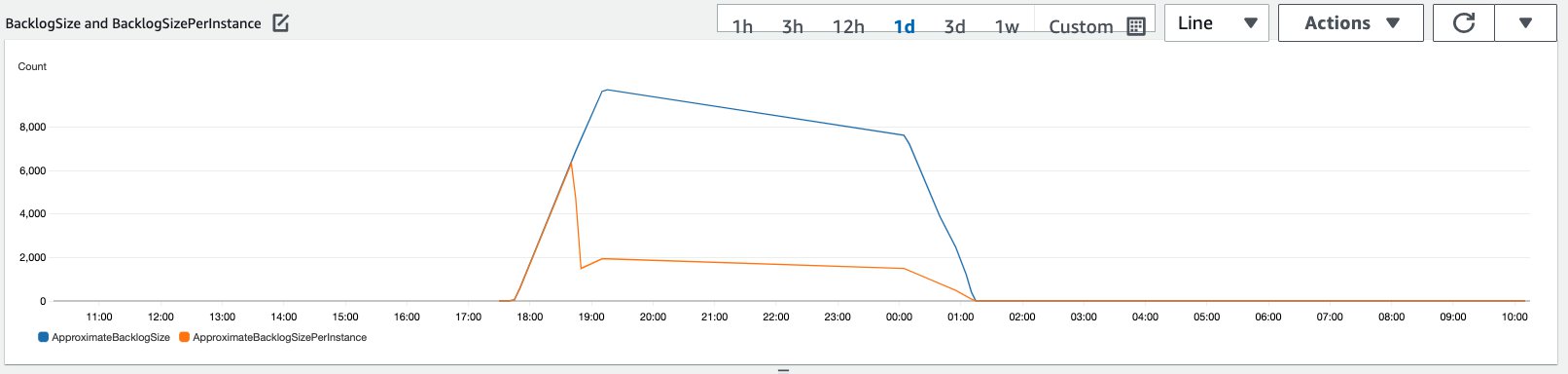

กราฟ CloudWatch

เราจำลองทราฟฟิกของคำขอการอนุมาน 10,000 รายการที่ส่งไปยังจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสที่เปิดใช้งานด้วยนโยบายการปรับขนาดอัตโนมัติที่อธิบายไว้ในส่วนก่อนหน้า

ภาพหน้าจอต่อไปนี้แสดงเมตริกอินสแตนซ์ก่อนที่คำขอจะเริ่มไหล เราเริ่มต้นด้วยจุดสิ้นสุดที่ใช้งานจริงโดยไม่มีอินสแตนซ์ทำงานอยู่:

กราฟต่อไปนี้แสดงให้เห็นว่า BacklogSize และ BacklogSizePerInstance เมตริกเปลี่ยนแปลงเมื่อเริ่มปรับขนาดอัตโนมัติและโหลดบนจุดสิ้นสุดถูกแชร์โดยอินสแตนซ์หลายรายการที่จัดเตรียมไว้เป็นส่วนหนึ่งของกระบวนการปรับขนาดอัตโนมัติ

ดังที่แสดงในภาพหน้าจอต่อไปนี้ จำนวนอินสแตนซ์เพิ่มขึ้นเมื่อจำนวนการอนุมานเพิ่มขึ้น:

ภาพหน้าจอต่อไปนี้แสดงวิธีการปรับขนาดในการนำจุดสิ้นสุดกลับสู่สถานะเริ่มต้นของอินสแตนซ์ที่กำลังทำงานเป็นศูนย์:

ทำความสะอาด

หลังจากคำขอทั้งหมดเสร็จสิ้น เราสามารถลบจุดสิ้นสุดได้เหมือนกับการลบจุดสิ้นสุดที่โฮสต์ตามเวลาจริง โปรดทราบว่าหากเราตั้งค่าความจุขั้นต่ำของจุดสิ้นสุดการอนุมานแบบอะซิงโครนัสเป็นศูนย์ จะไม่มีการเรียกเก็บเงินจากอินสแตนซ์เกิดขึ้นหลังจากที่ลดขนาดลงเป็นศูนย์

หากคุณเปิดใช้งานการปรับขนาดอัตโนมัติสำหรับตำแหน่งข้อมูลของคุณ ตรวจสอบให้แน่ใจว่าคุณยกเลิกการลงทะเบียนตำแหน่งข้อมูลเป็นเป้าหมายที่ปรับขนาดได้ก่อนที่จะลบตำแหน่งข้อมูล เมื่อต้องการทำเช่นนี้ เรียกใช้รหัสต่อไปนี้:

อย่าลืมลบจุดสิ้นสุดของคุณหลังจากใช้งาน เนื่องจากคุณจะถูกเรียกเก็บเงินสำหรับอินสแตนซ์ที่ใช้ในการสาธิตนี้

คุณต้องลบวัตถุ S3 และหัวข้อ SNS ด้วย หากคุณสร้างทรัพยากร AWS อื่นๆ เพื่อใช้และดำเนินการกับการแจ้งเตือน SNS คุณอาจต้องการลบทรัพยากรเหล่านั้นด้วย

สรุป

ในโพสต์นี้ เราได้สาธิตวิธีการใช้ความสามารถในการอนุมานแบบอะซิงโครนัสใหม่จาก SageMaker เพื่อประมวลผลเพย์โหลดอินพุตขนาดใหญ่ทั่วไปที่เป็นส่วนหนึ่งของงานสรุป สำหรับการอนุมาน เราใช้แบบจำลองจาก Hugging Face และปรับใช้บนจุดสิ้นสุดการอนุมานแบบอะซิงโครนัส เราได้อธิบายถึงความท้าทายทั่วไปของทราฟฟิกแบบต่อเนื่อง เวลาในการประมวลผลโมเดลที่สูง และเพย์โหลดขนาดใหญ่ที่เกี่ยวข้องกับการวิเคราะห์วิจัย ความสามารถโดยธรรมชาติของตำแหน่งข้อมูลการอนุมานแบบอะซิงโครนัสในการจัดการคิวภายใน ขีดจำกัดการทำงานพร้อมกันที่กำหนดไว้ล่วงหน้า กำหนดค่าการแจ้งเตือนการตอบสนอง และการลดขนาดลงเป็นศูนย์โดยอัตโนมัติช่วยให้เราจัดการกับความท้าทายเหล่านี้ได้ รหัสที่สมบูรณ์สำหรับตัวอย่างนี้มีอยู่บน GitHub.

หากต้องการเริ่มต้นใช้งานการอนุมานแบบอะซิงโครนัสของ SageMaker โปรดดูที่ การอนุมานแบบอะซิงโครนัส.

เกี่ยวกับผู้เขียน

ดิเนช กุมาร สุพรหมมานี เป็น Senior Solutions Architect กับทีม UKIR SMB ซึ่งตั้งอยู่ในเมืองเอดินบะระ ประเทศสกอตแลนด์ เขาเชี่ยวชาญด้านปัญญาประดิษฐ์และการเรียนรู้ของเครื่อง Dinesh สนุกกับการทำงานร่วมกับลูกค้าในอุตสาหกรรมต่างๆ เพื่อช่วยแก้ปัญหาด้วยบริการของ AWS นอกที่ทำงาน เขาชอบใช้เวลาอยู่กับครอบครัว เล่นหมากรุก และเพลิดเพลินกับดนตรีหลากหลายแนว

ดิเนช กุมาร สุพรหมมานี เป็น Senior Solutions Architect กับทีม UKIR SMB ซึ่งตั้งอยู่ในเมืองเอดินบะระ ประเทศสกอตแลนด์ เขาเชี่ยวชาญด้านปัญญาประดิษฐ์และการเรียนรู้ของเครื่อง Dinesh สนุกกับการทำงานร่วมกับลูกค้าในอุตสาหกรรมต่างๆ เพื่อช่วยแก้ปัญหาด้วยบริการของ AWS นอกที่ทำงาน เขาชอบใช้เวลาอยู่กับครอบครัว เล่นหมากรุก และเพลิดเพลินกับดนตรีหลากหลายแนว

ราหู ราเมชา เป็น ML Solutions Architect กับทีม Amazon SageMaker Service เขามุ่งเน้นไปที่การช่วยลูกค้าสร้าง ปรับใช้ และโยกย้ายปริมาณงานการผลิต ML ไปยัง SageMaker ตามขนาด เขาเชี่ยวชาญด้านแมชชีนเลิร์นนิง, AI และคอมพิวเตอร์วิทัศน์ และสำเร็จการศึกษาระดับปริญญาโทสาขาวิทยาการคอมพิวเตอร์จาก UT Dallas เวลาว่างชอบท่องเที่ยวและถ่ายรูป

ราหู ราเมชา เป็น ML Solutions Architect กับทีม Amazon SageMaker Service เขามุ่งเน้นไปที่การช่วยลูกค้าสร้าง ปรับใช้ และโยกย้ายปริมาณงานการผลิต ML ไปยัง SageMaker ตามขนาด เขาเชี่ยวชาญด้านแมชชีนเลิร์นนิง, AI และคอมพิวเตอร์วิทัศน์ และสำเร็จการศึกษาระดับปริญญาโทสาขาวิทยาการคอมพิวเตอร์จาก UT Dallas เวลาว่างชอบท่องเที่ยวและถ่ายรูป

- คอยน์สมาร์ท การแลกเปลี่ยน Bitcoin และ Crypto ที่ดีที่สุดในยุโรป

- เพลโตบล็อคเชน Web3 Metaverse ข่าวกรอง ขยายความรู้. เข้าฟรี

- คริปโตฮอว์ก เรดาร์ Altcoin ทดลองฟรี.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/improve-high-value-research-with-hugging-face-and-amazon-sagemaker-asynchronous-inference-endpoints/

- "

- 000

- 100

- ข้าม

- การกระทำ

- อยากทำกิจกรรม

- เพิ่มเติม

- ที่อยู่

- สูง

- AI

- ทั้งหมด

- อเมซอน

- จำนวน

- การวิเคราะห์

- การวิเคราะห์

- อื่น

- API

- การใช้งาน

- การใช้งาน

- บทความ

- บทความ

- เทียม

- ปัญญาประดิษฐ์

- ปัญญาประดิษฐ์และการเรียนรู้ด้วยเครื่อง

- รถยนต์

- ใช้ได้

- เฉลี่ย

- AWS

- รากฐาน

- กำลัง

- ชายแดน

- สร้าง

- built-in

- ธุรกิจ

- ระบบธุรกิจอัจฉริยะ

- สามารถรับ

- ความสามารถในการ

- ความจุ

- กรณี

- ความท้าทาย

- เปลี่ยนแปลง

- การเรียกเก็บเงิน

- โหลด

- การตรวจสอบ

- หมากรุก

- การทำความสะอาด

- รหัส

- ร่วมกัน

- บริษัท

- คู่แข่ง

- วิทยาการคอมพิวเตอร์

- องค์ประกอบ

- บริโภค

- ภาชนะ

- ภาชนะบรรจุ

- มี

- ค่าใช้จ่ายที่มีประสิทธิภาพ

- ค่าใช้จ่าย

- การสร้าง

- ลูกค้า

- ดัลลัส

- ข้อมูล

- ฐานข้อมูล

- วัน

- จัดการ

- ทุ่มเท

- ปรับใช้

- ปรับใช้

- การตรวจพบ

- นักพัฒนา

- ต่าง

- โรค

- เอกสาร

- ไม่

- โดเมน

- ลง

- ก่อน

- มีประสิทธิภาพ

- ปลายทาง

- ที่จัดตั้งขึ้น

- ตัวอย่าง

- คาดว่า

- รายจ่าย

- ใบหน้า

- ความล้มเหลว

- ครอบครัว

- เร็วขึ้น

- เฟด

- ทางการเงิน

- บริการทางการเงิน

- ชื่อจริง

- ดังต่อไปนี้

- รูป

- รูปแบบ

- ฟรี

- ฟังก์ชัน

- เงิน

- สร้าง

- ยิ่งใหญ่

- การเจริญเติบโต

- สุขภาพ

- การดูแลสุขภาพ

- กองทุนป้องกันความเสี่ยง

- ช่วย

- จะช่วยให้

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- จุดสูง

- ถือ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTTPS

- แยกแยะ

- ปรับปรุง

- ประกอบด้วย

- รวม

- เพิ่ม

- เพิ่มขึ้น

- อุตสาหกรรม

- อุตสาหกรรม

- ข้อมูล

- ข้อมูลเชิงลึก

- Intelligence

- การลงทุน

- ร่วมมือ

- ปัญหา

- IT

- ภาษา

- ใหญ่

- การเรียนรู้

- นำ

- ชั้น

- รายการ

- โหลด

- ที่ตั้ง

- นาน

- เครื่อง

- เรียนรู้เครื่อง

- การจัดการ

- ตลาด

- ตัวชี้วัด

- ML

- แบบ

- โมเดล

- การตรวจสอบ

- มากที่สุด

- MS

- ดนตรี

- โดยธรรมชาติ

- การประกาศ

- แจ้ง

- โอกาส

- ตัวเลือกเสริม (Option)

- Options

- ใบสั่ง

- อื่นๆ

- การปฏิบัติ

- งวด

- การถ่ายภาพ

- นโยบาย

- ผลงาน

- คำทำนาย

- การคาดการณ์

- การป้องกัน

- ดูตัวอย่าง

- ประถม

- ส่วนตัว

- ปัญหาที่เกิดขึ้น

- กระบวนการ

- การผลิต

- โครงการ

- ให้

- ให้

- สาธารณะ

- วัตถุประสงค์

- คุณภาพ

- อย่างรวดเร็ว

- ทางลาด

- เรียลไทม์

- รับ

- ลด

- ต้องการ

- ความต้องการ

- การวิจัย

- ทรัพยากร

- แหล่งข้อมูล

- คำตอบ

- ผลสอบ

- วิ่ง

- วิ่ง

- ที่ปรับขนาดได้

- ขนาด

- ปรับ

- วิทยาศาสตร์

- นักวิทยาศาสตร์

- รอง

- ภาค

- serverless

- บริการ

- บริการ

- ชุด

- การตั้งค่า

- ที่ใช้ร่วมกัน

- คล้ายคลึงกัน

- ง่าย

- ขนาด

- โซลูชัน

- แก้

- ความเชี่ยวชาญ

- ความเร็ว

- การใช้จ่าย

- เริ่มต้น

- ข้อความที่เริ่ม

- เริ่มต้น

- สถานะ

- Status

- เข้าพัก

- การเก็บรักษา

- จัดเก็บ

- กลยุทธ์

- ความสำเร็จ

- สนับสนุน

- รองรับ

- ระบบ

- เป้า

- งาน

- ทีม

- เวลา

- ร่วมกัน

- หัวข้อ

- การติดตาม

- การจราจร

- การรักษา

- แนวโน้ม

- เข้าใจ

- us

- ใช้

- มักจะ

- ความคุ้มค่า

- วิสัยทัศน์

- ว่า

- ภายใน

- งาน

- การทำงาน

- การเขียน

- เป็นศูนย์