แบบจำลองภาษาขนาดใหญ่ (LLM) ล่าสุดช่วยให้เกิดความก้าวหน้าอย่างมากในการทำความเข้าใจภาษาธรรมชาติ อย่างไรก็ตาม พวกเขามักจะสร้างคำอธิบายที่มั่นใจแต่ไร้สาระ ซึ่งเป็นอุปสรรคสำคัญในการสร้างความไว้วางใจกับผู้ใช้ ในโพสต์นี้ เราจะแสดงวิธีการรวมความคิดเห็นของมนุษย์เกี่ยวกับห่วงโซ่เหตุผลที่ไม่ถูกต้องสำหรับการใช้เหตุผลแบบหลายฮอปเพื่อปรับปรุงประสิทธิภาพในงานเหล่านี้ แทนที่จะรวบรวมห่วงโซ่เหตุผลตั้งแต่เริ่มต้นด้วยการถามมนุษย์ เราเรียนรู้จากคำติชมของมนุษย์เกี่ยวกับห่วงโซ่เหตุผลที่สร้างแบบจำลองโดยใช้ความสามารถในการกระตุ้นของ LLM เรารวบรวมชุดข้อมูลความคิดเห็นจากมนุษย์สองชุดในรูปแบบของ (การแก้ไข คำอธิบาย ประเภทข้อผิดพลาด) สำหรับชุดข้อมูล StrategyQA และ Sports Understanding และประเมินอัลกอริทึมทั่วไปหลายชุดเพื่อเรียนรู้จากคำติชมดังกล่าว วิธีการที่เราเสนอสามารถแข่งขันกับการกระตุ้นให้เกิดห่วงโซ่แห่งความคิดได้โดยใช้ฐาน Flan-T5 และวิธีของเราดีกว่าในการตัดสินความถูกต้องของคำตอบของมันเอง

ภาพรวมโซลูชัน

เมื่อเริ่มมีโมเดลภาษาขนาดใหญ่ ฟิลด์นี้ได้เห็นความก้าวหน้าอย่างมากเกี่ยวกับการวัดประสิทธิภาพการประมวลผลภาษาธรรมชาติ (NLP) ต่างๆ ในหมู่พวกเขา ความคืบหน้าโดดเด่นในงานที่ค่อนข้างง่ายกว่า เช่น บริบทสั้นๆ หรือการตอบคำถามที่เป็นข้อเท็จจริง เมื่อเทียบกับงานที่ยากขึ้นซึ่งต้องใช้เหตุผล เช่น การตอบคำถามแบบมัลติฮอป ประสิทธิภาพของงานบางอย่างที่ใช้ LLM อาจคล้ายกับการคาดเดาแบบสุ่มในระดับที่เล็กกว่า แต่จะดีขึ้นอย่างมากในระดับที่ใหญ่ขึ้น แม้จะมีสิ่งนี้ ความสามารถในการกระตุ้นของ LLM มีศักยภาพในการให้ข้อเท็จจริงที่เกี่ยวข้องที่จำเป็นในการตอบคำถาม

อย่างไรก็ตาม แบบจำลองเหล่านั้นอาจไม่สร้างห่วงโซ่เหตุผลหรือคำอธิบายที่ถูกต้องได้อย่างน่าเชื่อถือ คำอธิบายที่มั่นใจแต่ไร้เหตุผลเหล่านั้นยิ่งแพร่หลายมากขึ้นเมื่อ LLM ได้รับการฝึกอบรมโดยใช้ Reinforcement Learning from Human Feedback (RLHF) ซึ่งอาจมีการแฮ็กรางวัล

ด้วยแรงจูงใจนี้ เราจึงพยายามตอบคำถามการวิจัยต่อไปนี้: เราสามารถปรับปรุงการให้เหตุผลของ LLM ได้โดยการเรียนรู้จากความคิดเห็นของมนุษย์เกี่ยวกับห่วงโซ่เหตุผลที่สร้างแบบจำลองได้หรือไม่ รูปต่อไปนี้แสดงภาพรวมของแนวทางของเรา: ขั้นแรก เรากระตุ้นให้โมเดลสร้างห่วงโซ่เหตุผลสำหรับคำถามแบบมัลติฮอป จากนั้นจึงรวบรวมความคิดเห็นของมนุษย์ที่หลากหลายเกี่ยวกับห่วงโซ่เหล่านี้เพื่อการวินิจฉัยและเสนออัลกอริทึมการฝึกอบรมเพื่อเรียนรู้จากข้อมูลที่รวบรวม

เรารวบรวมความคิดเห็นจากมนุษย์ที่หลากหลายเกี่ยวกับชุดข้อมูลการให้เหตุผลแบบมัลติฮอปสองชุด ได้แก่ StrategyQA และ Sports Understanding จาก BigBench สำหรับแต่ละคำถามและห่วงโซ่การให้เหตุผลที่สร้างขึ้นจากแบบจำลอง เราจะรวบรวมห่วงโซ่การให้เหตุผลที่ถูกต้อง ประเภทของข้อผิดพลาดในห่วงโซ่การให้เหตุผลที่สร้างแบบจำลอง และคำอธิบาย (ในภาษาธรรมชาติ) ว่าทำไมข้อผิดพลาดนั้นจึงแสดงอยู่ในห่วงโซ่การให้เหตุผลที่มีให้ ชุดข้อมูลขั้นสุดท้ายมีข้อเสนอแนะสำหรับตัวอย่าง 1,565 ตัวอย่างจาก StrategyQA และ 796 ตัวอย่างสำหรับความเข้าใจด้านกีฬา

เราเสนออัลกอริทึมการฝึกอบรมหลายอย่างเพื่อเรียนรู้จากข้อเสนอแนะที่รวบรวมไว้ ขั้นแรก เราเสนอตัวแปรของความสอดคล้องในตัวเองในห่วงโซ่แห่งความคิด โดยพิจารณาจากตัวแปรที่ถ่วงน้ำหนักซึ่งสามารถเรียนรู้ได้จากคำติชม ประการที่สอง เราเสนอการปรับแต่งแบบวนซ้ำ ซึ่งเราจะปรับแต่งห่วงโซ่เหตุผลที่สร้างแบบจำลองซ้ำๆ จนกว่าจะถูกต้อง เราแสดงให้เห็นในเชิงประจักษ์ในชุดข้อมูลสองชุดที่ปรับแต่ง LLM อย่างละเอียด ซึ่งก็คือ Flan-T5 โดยใช้อัลกอริทึมที่เสนอ ดำเนินการโดยเปรียบเทียบกับพื้นฐานการเรียนรู้ในบริบท ที่สำคัญกว่านั้น เราแสดงให้เห็นว่าโมเดลที่ได้รับการปรับแต่งนั้นดีกว่าในการตัดสินว่าคำตอบของตัวเองนั้นถูกต้องหรือไม่ เมื่อเทียบกับโมเดลพื้นฐาน Flan-T5

การเก็บรวบรวมข้อมูล

ในส่วนนี้ เราจะอธิบายรายละเอียดของคำติชมที่เรารวบรวมและโปรโตคอลคำอธิบายประกอบที่ใช้ในระหว่างการรวบรวมข้อมูล เรารวบรวมคำติชมสำหรับการสร้างโมเดลตามชุดข้อมูลที่ใช้เหตุผลสองชุด: StrategyQA และ Sports Understanding จาก BigBench เราใช้ GPT-J เพื่อสร้างคำตอบสำหรับ StrategyQA และ Flan-T5 เพื่อสร้างคำตอบสำหรับชุดข้อมูล Sports Understanding ในแต่ละกรณี แบบจำลองจะได้รับพร้อมท์ด้วยตัวอย่างในบริบทที่ประกอบด้วยคำถาม คำตอบ และคำอธิบาย ตามด้วยคำถามทดสอบ

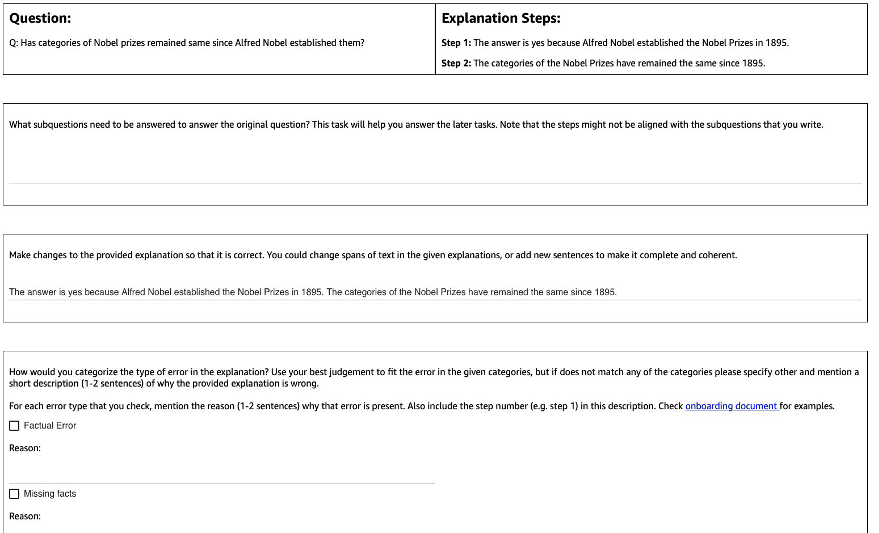

รูปต่อไปนี้แสดงอินเทอร์เฟซที่เราใช้ คำอธิบายประกอบจะได้รับคำถาม คำตอบที่สร้างแบบจำลอง และคำอธิบายที่แบ่งออกเป็นขั้นตอน

สำหรับคำถามแต่ละข้อ เราได้รวบรวมข้อเสนอแนะต่อไปนี้:

- คำถามย่อย – คำอธิบายประกอบจะแยกย่อยคำถามเดิมออกเป็นคำถามย่อยที่ง่ายกว่าซึ่งจำเป็นต่อการตอบคำถามเดิม งานนี้ถูกเพิ่มหลังจากการนำร่องที่เราพบว่าการเพิ่มงานนี้ช่วยเตรียมคำอธิบายประกอบและปรับปรุงคุณภาพของงานที่เหลือ

- การแก้ไข – Annotator จะได้รับกล่องข้อความรูปแบบอิสระที่กรอกคำตอบและคำอธิบายที่สร้างแบบจำลองไว้ล่วงหน้า และขอให้แก้ไขเพื่อให้ได้คำตอบและคำอธิบายที่ถูกต้อง

- ประเภทข้อผิดพลาด – ในบรรดาประเภทข้อผิดพลาดที่พบบ่อยที่สุดที่เราพบในการสร้างโมเดล (Factual Error, Missing Facts, Irrevant Facts, and Logical Inconsistency) ผู้ทำหมายเหตุประกอบจะถูกขอให้เลือกประเภทข้อผิดพลาดอย่างน้อยหนึ่งประเภทที่ใช้กับคำตอบและคำอธิบายที่กำหนด

- คำอธิบายข้อผิดพลาด – ผู้ทำคำอธิบายประกอบได้รับคำสั่งให้ไม่เพียงแต่จัดประเภทข้อผิดพลาดเท่านั้น แต่ยังให้เหตุผลที่ครอบคลุมสำหรับการจัดหมวดหมู่ ซึ่งรวมถึงการระบุขั้นตอนที่แน่นอนซึ่งเกิดข้อผิดพลาดขึ้นและนำไปใช้กับคำตอบและคำอธิบายที่ให้ไว้อย่างไร

เราใช้ Amazon SageMaker Ground Truth Plus ในการรวบรวมข้อมูลของเรา การเก็บข้อมูลเกิดขึ้นหลายรอบ ขั้นแรก เราทำการทดลองนำร่องขนาดเล็ก 30 ตัวอย่างจาก 200 ตัวอย่างและ 10 ตัวอย่างตามลำดับ หลังจากนั้นทีมผู้จัดทำคำอธิบายประกอบก็ได้รับคำติชมโดยละเอียดเกี่ยวกับคำอธิบายประกอบ จากนั้นเราดำเนินการรวบรวมข้อมูลมากกว่าสองชุดสำหรับ StrategyQA และมากกว่าหนึ่งชุดสำหรับ Sports Understanding โดยให้ข้อเสนอแนะเป็นระยะๆ ตลอด—มีคำอธิบายประกอบทั้งหมด 1 รายการที่ทำงานในระยะเวลาเกือบ XNUMX เดือน

เรารวบรวมคำติชมจากตัวอย่างทั้งหมด 1,565 ตัวอย่างสำหรับ StrategyQA และ 796 ตัวอย่างสำหรับความเข้าใจด้านกีฬา ตารางต่อไปนี้แสดงเปอร์เซ็นต์ของตัวอย่างที่ไม่มีข้อผิดพลาดในการสร้างโมเดลและสัดส่วนของตัวอย่างที่มีประเภทข้อผิดพลาดเฉพาะ เป็นที่น่าสังเกตว่าบางตัวอย่างอาจมีข้อผิดพลาดมากกว่าหนึ่งประเภท

| ประเภทข้อผิดพลาด | กลยุทธ์QA | ความเข้าใจด้านกีฬา |

| ไม่มี | 17.6% | 31.28% |

| ข้อผิดพลาดข้อเท็จจริง | 27.6% | 38.1% |

| ข้อเท็จจริงที่ขาดหายไป | 50.4% | 46.1% |

| ข้อเท็จจริงที่ไม่เกี่ยวข้อง | 14.6% | 3.9% |

| ความไม่สอดคล้องเชิงตรรกะ | 11.2% | 5.2% |

อัลกอริทึมการเรียนรู้

สำหรับคำถามแต่ละข้อ qและคำตอบและคำอธิบายที่สร้างแบบจำลอง mเรารวบรวมคำติชมต่อไปนี้: คำตอบและคำอธิบายที่ถูกต้อง cประเภทของข้อผิดพลาดที่มีอยู่ใน m (แสดงโดย t) และคำอธิบายข้อผิดพลาด dตามที่อธิบายไว้ในส่วนก่อนหน้า

เราใช้วิธีการต่อไปนี้:

- การเรียนรู้แบบมัลติทาสก์ – พื้นฐานง่ายๆ ในการเรียนรู้จากคำติชมที่หลากหลายที่มีอยู่คือการปฏิบัติต่อแต่ละความคิดเห็นเป็นงานที่แยกจากกัน อย่างชัดเจนยิ่งขึ้น เราได้ปรับแต่ง Flan-T5 (ข้อความเป็นข้อความ) ตามวัตถุประสงค์ เพิ่ม p(c|q) + p(t|q, ม.) + p(d|q, ม.). สำหรับคำศัพท์แต่ละคำในวัตถุประสงค์ เราใช้คำแนะนำแยกต่างหากที่เหมาะสมกับงาน (เช่น "ทำนายข้อผิดพลาดในคำตอบที่กำหนด") เรายังแปลงตัวแปรเด็ดขาด t ให้เป็นประโยคภาษาธรรมชาติ ในระหว่างการอนุมาน เราใช้คำแนะนำสำหรับคำศัพท์ พี(ค|คิว) (“คาดคะเนคำตอบที่ถูกต้องสำหรับคำถามที่กำหนดให้”) เพื่อสร้างคำตอบสำหรับคำถามทดสอบ

- ความสอดคล้องในตัวเองถ่วงน้ำหนัก – แรงบันดาลใจจากความสำเร็จของความสอดคล้องในตนเองในห่วงโซ่ของความคิด เราขอเสนอตัวแปรที่ถ่วงน้ำหนักของมัน แทนที่จะถือว่าคำอธิบายตัวอย่างแต่ละรายการจากแบบจำลองถูกต้องและพิจารณาการลงคะแนนเสียงรวม เราจะพิจารณาว่าคำอธิบายนั้นถูกต้องก่อนแล้วจึงรวมตามนั้น ขั้นแรก เราปรับแต่ง Flan-T5 โดยมีวัตถุประสงค์เดียวกับการเรียนรู้แบบมัลติทาสก์ ในระหว่างการอนุมาน กำหนดให้คำถามทดสอบ qเราสุ่มตัวอย่างคำตอบที่เป็นไปได้หลายคำตอบพร้อมคำแนะนำสำหรับ พี(ค|คิว)): a1, a2- an. สำหรับคำตอบตัวอย่างแต่ละข้อ aiเราใช้คำแนะนำสำหรับคำศัพท์ พี(t|q, ม.) (“ทำนายข้อผิดพลาดในคำตอบที่กำหนด”) เพื่อระบุว่ามีข้อผิดพลาดหรือไม่ ti = argmax p(t|q, a_i). แต่ละคำตอบ ai ถูกกำหนดน้ำหนักเป็น 1 หากถูกต้อง มิฉะนั้น จะกำหนดน้ำหนักที่น้อยกว่า 1 (ไฮเปอร์พารามิเตอร์ที่ปรับได้) คำตอบสุดท้ายจะได้มาโดยพิจารณาจากคะแนนเสียงที่ถ่วงน้ำหนักจากคำตอบทั้งหมด a1 ไปยัง an.

- การปรับแต่งซ้ำ – ในวิธีที่เสนอก่อนหน้านี้ แบบจำลองสร้างคำตอบที่ถูกต้องโดยตรง c เงื่อนไขในคำถาม q. ที่นี่เราเสนอให้ปรับแต่งคำตอบที่สร้างแบบจำลอง m เพื่อให้ได้คำตอบที่ถูกต้องสำหรับคำถามที่กำหนดให้ โดยเฉพาะอย่างยิ่ง ขั้นแรกเราได้ปรับแต่ง Flan-T5 (ข้อความเป็นข้อความโดยมีวัตถุประสงค์) ด้วย เพิ่ม p(t; c|q, m)ที่นี่มี ; หมายถึงการต่อข้อมูล (ประเภทข้อผิดพลาด t ตามด้วยคำตอบที่ถูกต้อง c). วิธีหนึ่งในการดูวัตถุประสงค์นี้คือโมเดลได้รับการฝึกอบรมก่อนเพื่อระบุข้อผิดพลาดในการสร้างที่กำหนด mแล้วนำข้อผิดพลาดนั้นออกเพื่อให้ได้คำตอบที่ถูกต้อง c. ในระหว่างการอนุมาน เราสามารถใช้แบบจำลองซ้ำๆ จนกว่าจะได้คำตอบที่ถูกต้อง—จากคำถามทดสอบ qอันดับแรก เราได้รับการสร้างแบบจำลองเริ่มต้น m (ใช้ Flan-T5 ที่ผ่านการฝึกอบรมมาแล้ว) จากนั้นเราจะสร้างประเภทข้อผิดพลาดซ้ำๆ ti และคำตอบที่ถูกต้องที่เป็นไปได้ ci จนกระทั่ง ti = ไม่มีข้อผิดพลาด (ในทางปฏิบัติ เรากำหนดจำนวนการวนซ้ำสูงสุดให้กับไฮเปอร์พารามิเตอร์) ซึ่งคำตอบสุดท้ายที่ถูกต้องจะเป็น CI-1 (ได้รับจาก พี(ti ; ci | คิว, ci-1)).

ผลสอบ

สำหรับชุดข้อมูลทั้งสอง เราจะเปรียบเทียบอัลกอริทึมการเรียนรู้ที่เสนอทั้งหมดกับพื้นฐานการเรียนรู้ในบริบท โมเดลทั้งหมดได้รับการประเมินในชุดการพัฒนาของ StrategyQA และ Sports Understanding ตารางต่อไปนี้แสดงผลลัพธ์

| วิธี | กลยุทธ์QA | ความเข้าใจด้านกีฬา |

| Flan-T5 การเรียนรู้แบบห่วงโซ่แห่งความคิด 4 ช็อตในบริบท | 67.39 ± 2.6% | 58.5% |

| การเรียนรู้แบบมัลติทาสก์ | 66.22 ± 0.7% | 54.3 ± 2.1% |

| ความสอดคล้องในตัวเองถ่วงน้ำหนัก | 61.13 ± 1.5% | 51.3 ± 1.9% |

| การปรับแต่งซ้ำ | 61.85 ± 3.3% | 57.0 ± 2.5% |

ตามที่สังเกต วิธีการบางอย่างสามารถเทียบเคียงได้กับพื้นฐานการเรียนรู้ในบริบท (มัลติทาสก์สำหรับ StrategyQA และการปรับแต่งซ้ำสำหรับความเข้าใจด้านกีฬา) ซึ่งแสดงให้เห็นถึงศักยภาพของการรวบรวมคำติชมอย่างต่อเนื่องจากมนุษย์เกี่ยวกับผลลัพธ์ของแบบจำลอง และใช้เพื่อปรับปรุงแบบจำลองภาษา สิ่งนี้แตกต่างจากงานล่าสุดเช่น RLHF ซึ่งความคิดเห็นจะถูกจำกัดไว้ที่หมวดหมู่และโดยปกติจะเป็นเลขฐานสอง

ดังที่แสดงในตารางต่อไปนี้ เราตรวจสอบวิธีที่แบบจำลองที่ปรับตามความคิดเห็นของมนุษย์เกี่ยวกับข้อผิดพลาดในการให้เหตุผลสามารถช่วยปรับปรุงการสอบเทียบหรือการรับรู้ถึงคำอธิบายที่ผิดพลาดอย่างมั่นใจ สิ่งนี้ได้รับการประเมินโดยการให้โมเดลคาดการณ์ว่าการสร้างมีข้อผิดพลาดหรือไม่

| วิธี | แก้ไขข้อผิดพลาด | กลยุทธ์QA |

| Flan-T5 การเรียนรู้แบบห่วงโซ่แห่งความคิด 4 ช็อตในบริบท | ไม่ | 30.17% |

| โมเดล Multitask Finetuned | ใช่ | 73.98% |

ในรายละเอียดเพิ่มเติม เราพร้อมต์โมเดลภาษาด้วยคำตอบที่สร้างขึ้นเองและห่วงโซ่เหตุผล (ซึ่งเราได้รวบรวมคำติชม) จากนั้นพร้อมต์อีกครั้งเพื่อทำนายข้อผิดพลาดในการสร้าง เราใช้คำแนะนำที่เหมาะสมสำหรับงาน (“ระบุข้อผิดพลาดในคำตอบ”) แบบจำลองจะได้รับคะแนนอย่างถูกต้องหากคาดการณ์ว่า "ไม่มีข้อผิดพลาด" หรือ "ถูกต้อง" ในการสร้าง หากคำอธิบายประกอบระบุตัวอย่างว่าไม่มีข้อผิดพลาด หรือหากคาดการณ์ประเภทข้อผิดพลาดใดๆ ในการสร้าง (ร่วมกับ "ไม่ถูกต้อง" หรือ " ผิด”) เมื่อคำอธิบายประกอบระบุว่ามีข้อผิดพลาด โปรดทราบว่าเราไม่ได้ประเมินความสามารถของโมเดลในการระบุประเภทข้อผิดพลาดอย่างถูกต้อง แต่จะประเมินหากมีข้อผิดพลาดอยู่ การประเมินจะทำกับชุดของตัวอย่างเพิ่มเติม 173 ตัวอย่างจากชุดของผู้พัฒนา StrategyQA ที่รวบรวมไว้ ซึ่งไม่เห็นระหว่างการปรับแต่งอย่างละเอียด สี่ตัวอย่างจากเหล่านี้สงวนไว้สำหรับพร้อมท์โมเดลภาษา (แถวแรกในตารางก่อนหน้า)

โปรดทราบว่าเราจะไม่แสดงผลพื้นฐาน 0-shot เนื่องจากแบบจำลองไม่สามารถสร้างการตอบสนองที่เป็นประโยชน์ได้ เราสังเกตว่าการใช้ความคิดเห็นของมนุษย์เพื่อแก้ไขข้อผิดพลาดในห่วงโซ่เหตุผลสามารถปรับปรุงการคาดคะเนของแบบจำลองว่าจะทำให้เกิดข้อผิดพลาดหรือไม่ ซึ่งสามารถปรับปรุงการรับรู้หรือการสอบเทียบคำอธิบายที่ไม่ถูกต้อง

สรุป

ในโพสต์นี้ เราได้แสดงวิธีจัดการชุดข้อมูลคำติชมของมนุษย์ด้วยการแก้ไขข้อผิดพลาดแบบละเอียด ซึ่งเป็นทางเลือกในการปรับปรุงความสามารถในการให้เหตุผลของ LLM ผลการทดลองยืนยันว่าความคิดเห็นของมนุษย์เกี่ยวกับข้อผิดพลาดในการให้เหตุผลสามารถปรับปรุงประสิทธิภาพและการสอบเทียบสำหรับคำถามมัลติฮอปที่ท้าทายได้

หากคุณกำลังมองหาความคิดเห็นจากมนุษย์เพื่อปรับปรุงโมเดลภาษาขนาดใหญ่ของคุณ โปรดไปที่ การติดฉลากข้อมูล Amazon SageMaker และคอนโซล Ground Truth Plus

เกี่ยวกับผู้เขียน

เออร์ราน ลี่ เป็นผู้จัดการวิทยาศาสตร์ประยุกต์ที่บริการ humain-in-the-loop, AWS AI, Amazon ความสนใจในการวิจัยของเขาคือการเรียนรู้เชิงลึก 3 มิติและการเรียนรู้การมองเห็นและการแสดงภาษา ก่อนหน้านี้เขาเป็นนักวิทยาศาสตร์อาวุโสที่ Alexa AI หัวหน้าฝ่ายการเรียนรู้ของเครื่องที่ Scale AI และหัวหน้านักวิทยาศาสตร์ที่ Pony.ai ก่อนหน้านั้น เขาเคยร่วมงานกับทีมการรับรู้ที่ Uber ATG และทีมแพลตฟอร์มการเรียนรู้ของเครื่องที่ Uber ซึ่งทำงานเกี่ยวกับการเรียนรู้ของเครื่องสำหรับการขับรถอัตโนมัติ ระบบการเรียนรู้ของเครื่อง และการริเริ่มเชิงกลยุทธ์ของ AI เขาเริ่มทำงานที่ Bell Labs และเป็นผู้ช่วยศาสตราจารย์ที่มหาวิทยาลัยโคลัมเบีย เขาร่วมสอนบทช่วยสอนที่ ICML'17 และ ICCV'19 และร่วมจัดเวิร์กชอปหลายครั้งที่ NeurIPS, ICML, CVPR, ICCV เกี่ยวกับการเรียนรู้ของเครื่องสำหรับการขับขี่อัตโนมัติ การมองเห็น 3 มิติและวิทยาการหุ่นยนต์ ระบบการเรียนรู้ของเครื่อง และการเรียนรู้ของเครื่องที่เป็นปฏิปักษ์ เขาจบปริญญาเอกด้านวิทยาการคอมพิวเตอร์ที่ Cornell University เขาเป็นเพื่อน ACM และเพื่อน IEEE

เออร์ราน ลี่ เป็นผู้จัดการวิทยาศาสตร์ประยุกต์ที่บริการ humain-in-the-loop, AWS AI, Amazon ความสนใจในการวิจัยของเขาคือการเรียนรู้เชิงลึก 3 มิติและการเรียนรู้การมองเห็นและการแสดงภาษา ก่อนหน้านี้เขาเป็นนักวิทยาศาสตร์อาวุโสที่ Alexa AI หัวหน้าฝ่ายการเรียนรู้ของเครื่องที่ Scale AI และหัวหน้านักวิทยาศาสตร์ที่ Pony.ai ก่อนหน้านั้น เขาเคยร่วมงานกับทีมการรับรู้ที่ Uber ATG และทีมแพลตฟอร์มการเรียนรู้ของเครื่องที่ Uber ซึ่งทำงานเกี่ยวกับการเรียนรู้ของเครื่องสำหรับการขับรถอัตโนมัติ ระบบการเรียนรู้ของเครื่อง และการริเริ่มเชิงกลยุทธ์ของ AI เขาเริ่มทำงานที่ Bell Labs และเป็นผู้ช่วยศาสตราจารย์ที่มหาวิทยาลัยโคลัมเบีย เขาร่วมสอนบทช่วยสอนที่ ICML'17 และ ICCV'19 และร่วมจัดเวิร์กชอปหลายครั้งที่ NeurIPS, ICML, CVPR, ICCV เกี่ยวกับการเรียนรู้ของเครื่องสำหรับการขับขี่อัตโนมัติ การมองเห็น 3 มิติและวิทยาการหุ่นยนต์ ระบบการเรียนรู้ของเครื่อง และการเรียนรู้ของเครื่องที่เป็นปฏิปักษ์ เขาจบปริญญาเอกด้านวิทยาการคอมพิวเตอร์ที่ Cornell University เขาเป็นเพื่อน ACM และเพื่อน IEEE

นิตย์ โจชิ เป็นผู้ฝึกงานด้านวิทยาศาสตร์ประยุกต์ที่ AWS AI, Amazon เขาเป็นนักศึกษาปริญญาเอกด้านวิทยาการคอมพิวเตอร์ที่ Courant Institute of Mathematical Sciences ของมหาวิทยาลัยนิวยอร์ก ซึ่งได้รับคำแนะนำจากศาสตราจารย์เหอ เหอ เขาทำงานเกี่ยวกับการเรียนรู้ของเครื่องและการประมวลผลภาษาธรรมชาติ และเขาได้เข้าร่วมกับกลุ่มวิจัยการเรียนรู้ของเครื่องสำหรับภาษา (ML2) เขาสนใจอย่างกว้างขวางในการทำความเข้าใจภาษาที่มีประสิทธิภาพ: ทั้งในการสร้างแบบจำลองที่แข็งแกร่งต่อการเปลี่ยนแปลงการกระจาย (เช่น ผ่านการเพิ่มข้อมูลโดยมนุษย์ในวง) และในการออกแบบวิธีที่ดีกว่าในการประเมิน/วัดความทนทานของแบบจำลอง เขายังสงสัยเกี่ยวกับพัฒนาการล่าสุดในการเรียนรู้ในบริบทและการทำความเข้าใจวิธีการทำงาน

นิตย์ โจชิ เป็นผู้ฝึกงานด้านวิทยาศาสตร์ประยุกต์ที่ AWS AI, Amazon เขาเป็นนักศึกษาปริญญาเอกด้านวิทยาการคอมพิวเตอร์ที่ Courant Institute of Mathematical Sciences ของมหาวิทยาลัยนิวยอร์ก ซึ่งได้รับคำแนะนำจากศาสตราจารย์เหอ เหอ เขาทำงานเกี่ยวกับการเรียนรู้ของเครื่องและการประมวลผลภาษาธรรมชาติ และเขาได้เข้าร่วมกับกลุ่มวิจัยการเรียนรู้ของเครื่องสำหรับภาษา (ML2) เขาสนใจอย่างกว้างขวางในการทำความเข้าใจภาษาที่มีประสิทธิภาพ: ทั้งในการสร้างแบบจำลองที่แข็งแกร่งต่อการเปลี่ยนแปลงการกระจาย (เช่น ผ่านการเพิ่มข้อมูลโดยมนุษย์ในวง) และในการออกแบบวิธีที่ดีกว่าในการประเมิน/วัดความทนทานของแบบจำลอง เขายังสงสัยเกี่ยวกับพัฒนาการล่าสุดในการเรียนรู้ในบริบทและการทำความเข้าใจวิธีการทำงาน

กุมารเชลลาปิลลา เป็นผู้จัดการทั่วไปและผู้อำนวยการของ Amazon Web Services และเป็นผู้นำในการพัฒนาบริการ ML/AI เช่น ระบบที่มนุษย์สร้างขึ้นในวงรอบ, AI DevOps, Geospatial ML และการพัฒนา ADAS/ยานยนต์อัตโนมัติ ก่อนมา AWS Kumar เป็นผู้อำนวยการฝ่ายวิศวกรรมที่ Uber ATG และ Lyft ระดับ 5 และนำทีมโดยใช้แมชชีนเลิร์นนิงเพื่อพัฒนาความสามารถในการขับเคลื่อนด้วยตนเอง เช่น การรับรู้และการทำแผนที่ เขายังทำงานเกี่ยวกับการใช้เทคนิคการเรียนรู้ของเครื่องเพื่อปรับปรุงการค้นหา คำแนะนำ และผลิตภัณฑ์โฆษณาที่ LinkedIn, Twitter, Bing และ Microsoft Research

กุมารเชลลาปิลลา เป็นผู้จัดการทั่วไปและผู้อำนวยการของ Amazon Web Services และเป็นผู้นำในการพัฒนาบริการ ML/AI เช่น ระบบที่มนุษย์สร้างขึ้นในวงรอบ, AI DevOps, Geospatial ML และการพัฒนา ADAS/ยานยนต์อัตโนมัติ ก่อนมา AWS Kumar เป็นผู้อำนวยการฝ่ายวิศวกรรมที่ Uber ATG และ Lyft ระดับ 5 และนำทีมโดยใช้แมชชีนเลิร์นนิงเพื่อพัฒนาความสามารถในการขับเคลื่อนด้วยตนเอง เช่น การรับรู้และการทำแผนที่ เขายังทำงานเกี่ยวกับการใช้เทคนิคการเรียนรู้ของเครื่องเพื่อปรับปรุงการค้นหา คำแนะนำ และผลิตภัณฑ์โฆษณาที่ LinkedIn, Twitter, Bing และ Microsoft Research

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- เพลโตไอสตรีม. ข้อมูลอัจฉริยะ Web3 ขยายความรู้ เข้าถึงได้ที่นี่.

- การสร้างอนาคตโดย Adryenn Ashley เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- ความสามารถ

- ความสามารถ

- เกี่ยวกับเรา

- ตาม

- พลอากาศเอก

- ที่เพิ่ม

- เพิ่ม

- เพิ่มเติม

- ที่อยู่

- ขัดแย้ง

- การโฆษณา

- ในเครือ

- หลังจาก

- อีกครั้ง

- AI

- Alexa

- อัลกอริทึม

- ทั้งหมด

- ตาม

- ด้วย

- ทางเลือก

- อเมซอน

- อเมซอน SageMaker

- Amazon Web Services

- ในหมู่

- an

- และ

- คำตอบ

- คำตอบ

- ใด

- ประยุกต์

- ใช้

- การประยุกต์ใช้

- เข้าใกล้

- เหมาะสม

- เป็น

- AS

- ที่ได้รับมอบหมาย

- At

- อิสระ

- ใช้ได้

- ความตระหนัก

- AWS

- ฐาน

- ตาม

- baseline

- BE

- เพราะ

- รับ

- ก่อน

- ระฆัง

- มาตรฐาน

- ดีกว่า

- Bing

- ทั้งสอง

- กล่อง

- แต้

- การก่อสร้าง

- แบบจำลองอาคาร

- แต่

- by

- CAN

- ความสามารถในการ

- ความก้าวหน้า

- กรณี

- บาง

- โซ่

- ห่วงโซ่

- ท้าทาย

- หัวหน้า

- แยกประเภท

- ปิดหน้านี้

- รวบรวม

- การเก็บรวบรวม

- ชุด

- COLUMBIA

- ร่วมกัน

- เทียบเคียง

- เปรียบเทียบ

- เมื่อเทียบกับ

- ครอบคลุม

- คอมพิวเตอร์

- วิทยาการคอมพิวเตอร์

- ดำเนินการ

- มั่นใจ

- มั่นใจ

- พิจารณา

- พิจารณา

- ปลอบใจ

- มี

- สิ่งแวดล้อม

- แปลง

- คอร์เนลล์

- การแก้ไข

- ยืนยัน

- อยากรู้อยากเห็น

- ข้อมูล

- ชุดข้อมูล

- ลึก

- การเรียนรู้ลึก ๆ

- สาธิต

- แสดงให้เห็นถึง

- บรรยาย

- อธิบาย

- ลักษณะ

- การออกแบบ

- แม้จะมี

- รายละเอียด

- รายละเอียด

- รายละเอียด

- dev

- พัฒนา

- พัฒนาการ

- การพัฒนา

- ต่าง

- โดยตรง

- ผู้อำนวยการ

- การกระจาย

- หลาย

- do

- ทำ

- Dont

- การขับขี่

- ในระหว่าง

- e

- แต่ละ

- เปิดการใช้งาน

- ชั้นเยี่ยม

- ความผิดพลาด

- ข้อผิดพลาด

- การสร้าง

- ประเมินค่า

- ประเมิน

- การประเมินผล

- แม้

- ตัวอย่าง

- ตัวอย่าง

- คำอธิบาย

- ข้อเสนอแนะ

- มนุษย์

- สนาม

- รูป

- สุดท้าย

- ชื่อจริง

- ตาม

- ดังต่อไปนี้

- สำหรับ

- ฟอร์ม

- พบ

- สี่

- ราคาเริ่มต้นที่

- การรวบรวม

- General

- สร้าง

- สร้าง

- สร้าง

- การสร้าง

- รุ่น

- ชั่วอายุคน

- ML เชิงพื้นที่

- ให้

- กำหนด

- ให้

- พื้น

- บัญชีกลุ่ม

- แฮ็ค

- มี

- มี

- he

- หัว

- ช่วย

- จะช่วยให้

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- ของเขา

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- อย่างไรก็ตาม

- HTTPS

- เป็นมนุษย์

- มนุษย์

- แยกแยะ

- อีอีอี

- if

- แสดงให้เห็นถึง

- ปรับปรุง

- in

- รวมทั้ง

- รวมเข้าด้วยกัน

- แรกเริ่ม

- ความคิดริเริ่ม

- แทน

- สถาบัน

- สนใจ

- ผลประโยชน์

- อินเตอร์เฟซ

- เข้าไป

- สอบสวน

- IT

- ซ้ำ

- ITS

- jpg

- ห้องปฏิบัติการ

- ภาษา

- ใหญ่

- ที่มีขนาดใหญ่

- นำไปสู่

- เรียนรู้

- ได้เรียนรู้

- การเรียนรู้

- นำ

- ชั้น

- ถูก จำกัด

- LLM

- ตรรกะ

- ที่ต้องการหา

- Lyft

- เครื่อง

- เรียนรู้เครื่อง

- ทำให้

- ผู้จัดการ

- การทำแผนที่

- คณิตศาสตร์

- สูงสุด

- อาจ..

- วิธีการ

- ไมโครซอฟท์

- หายไป

- ข้อผิดพลาด

- ความผิดพลาด

- ML

- ml2

- แบบ

- โมเดล

- เดือน

- ข้อมูลเพิ่มเติม

- มากที่สุด

- แรงบันดาลใจ

- หลาย

- คือ

- โดยธรรมชาติ

- ประมวลผลภาษาธรรมชาติ

- ใหม่

- นิวยอร์ก

- NLP

- ไม่

- จำนวน

- วัตถุประสงค์

- สังเกต

- อุปสรรค

- ได้รับ

- ที่ได้รับ

- ที่เกิดขึ้น

- of

- on

- ONE

- ต่อเนื่อง

- เพียง

- การโจมตี

- or

- เป็นต้นฉบับ

- มิฉะนั้น

- ของเรา

- ออก

- เกิน

- ภาพรวม

- ของตนเอง

- เปอร์เซ็นต์

- ความเข้าใจ

- ดำเนินการ

- การปฏิบัติ

- ดำเนินการ

- ระยะเวลา

- เป็นระยะ

- เลือก

- นักบิน

- สถานที่

- เวที

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- บวก

- โพสท่า

- เป็นไปได้

- โพสต์

- ที่มีศักยภาพ

- การปฏิบัติ

- คาดการณ์

- คำทำนาย

- คาดการณ์

- เตรียมการ

- นำเสนอ

- นำเสนอ

- เป็นที่แพร่หลาย

- ก่อน

- ก่อนหน้านี้

- ก่อน

- การประมวลผล

- ผลิตภัณฑ์

- ศาสตราจารย์

- ความคืบหน้า

- สัดส่วน

- เสนอ

- เสนอ

- โปรโตคอล

- ให้

- ให้

- ให้

- คุณภาพ

- คำถาม

- คำถาม

- สุ่ม

- ค่อนข้าง

- เมื่อเร็ว ๆ นี้

- แนะนำ

- ปรับแต่ง

- สัมพัทธ์

- ตรงประเด็น

- เอาออก

- การแสดง

- ต้องการ

- จำเป็นต้องใช้

- การวิจัย

- ลิขสิทธิ์

- ตามลำดับ

- REST

- ผล

- ผลสอบ

- รางวัล

- รวย

- หุ่นยนต์

- แข็งแรง

- ความแข็งแรง

- รอบ

- แถว

- sagemaker

- เดียวกัน

- ขนาด

- ขนาดไอ

- ตาชั่ง

- วิทยาศาสตร์

- วิทยาศาสตร์

- นักวิทยาศาสตร์

- ค้นหา

- ที่สอง

- Section

- เห็น

- ตนเอง

- ขับเคลื่อนด้วยตัวเอง

- ระดับอาวุโส

- ประโยค

- แยก

- บริการ

- ชุด

- หลาย

- กะ

- สั้น

- โชว์

- แสดง

- แสดงให้เห็นว่า

- สำคัญ

- อย่างมีความหมาย

- คล้ายคลึงกัน

- ง่าย

- เล็ก

- มีขนาดเล็กกว่า

- บาง

- โดยเฉพาะ

- เฉพาะ

- แยก

- กีฬา

- ข้อความที่เริ่ม

- ขั้นตอน

- ขั้นตอน

- ยุทธศาสตร์

- นักเรียน

- ความสำเร็จ

- อย่างเช่น

- ระบบ

- ตาราง

- งาน

- งาน

- ทีม

- ทีม

- เทคนิค

- ทดสอบ

- กว่า

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- แล้วก็

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- เหล่านั้น

- ตลอด

- ไปยัง

- รวม

- ผ่านการฝึกอบรม

- การฝึกอบรม

- รักษา

- การรักษาเยียวยา

- มหึมา

- วางใจ

- ความจริง

- บทเรียน

- พูดเบาและรวดเร็ว

- สอง

- ชนิด

- ชนิด

- Uber

- ความเข้าใจ

- มหาวิทยาลัย

- ใช้

- มือสอง

- ผู้ใช้

- การใช้

- มักจะ

- ตัวแปร

- ต่างๆ

- พาหนะ

- รายละเอียด

- วิสัยทัศน์

- เยี่ยมชมร้านค้า

- โหวต

- คือ

- ทาง..

- วิธี

- we

- เว็บ

- บริการเว็บ

- น้ำหนัก

- คือ

- เมื่อ

- ว่า

- ที่

- ทำไม

- จะ

- กับ

- งาน

- ทำงาน

- การทำงาน

- โรงงาน

- การประชุมเชิงปฏิบัติการ

- คุ้มค่า

- ผิด

- นิวยอร์ก

- ของคุณ

- ลมทะเล