การกลั่นกรองเนื้อหาเป็นกระบวนการคัดกรองและติดตามเนื้อหาที่ผู้ใช้สร้างขึ้นทางออนไลน์ เพื่อให้มีสภาพแวดล้อมที่ปลอดภัยสำหรับทั้งผู้ใช้และแบรนด์ แพลตฟอร์มต้องกลั่นกรองเนื้อหาเพื่อให้แน่ใจว่าอยู่ภายใต้หลักเกณฑ์ที่กำหนดไว้ล่วงหน้าสำหรับพฤติกรรมที่ยอมรับได้ซึ่งเจาะจงสำหรับแพลตฟอร์มและผู้ชม

เมื่อแพลตฟอร์มกลั่นกรองเนื้อหา เนื้อหาที่ผู้ใช้สร้างขึ้นที่ยอมรับได้ (UGC) สามารถสร้างและแบ่งปันกับผู้ใช้รายอื่นได้ พฤติกรรมที่ไม่เหมาะสม เป็นพิษ หรือถูกห้ามสามารถป้องกัน บล็อกในแบบเรียลไทม์ หรือลบออกได้หลังจากข้อเท็จจริง ทั้งนี้ขึ้นอยู่กับเครื่องมือและขั้นตอนการควบคุมเนื้อหาที่แพลตฟอร์มมี

คุณสามารถใช้ได้ การกลั่นกรองเนื้อหาของ Amazon Rekognition เพื่อตรวจจับเนื้อหาที่ไม่เหมาะสม ไม่ต้องการ หรือก้าวร้าว เพื่อสร้างประสบการณ์ผู้ใช้ที่ปลอดภัยยิ่งขึ้น ให้การรับรองความปลอดภัยของแบรนด์แก่ผู้โฆษณา และปฏิบัติตามระเบียบข้อบังคับของท้องถิ่นและระดับโลก

ในโพสต์นี้ เราพูดถึงองค์ประกอบหลักที่จำเป็นในการประเมินด้านประสิทธิภาพของบริการควบคุมเนื้อหาในแง่ของเมตริกความแม่นยำต่างๆ และให้ตัวอย่างโดยใช้ Amazon Rekognition Content Moderation API ของ.

สิ่งที่ต้องประเมิน

เมื่อประเมินบริการตรวจสอบเนื้อหา เราขอแนะนำขั้นตอนต่อไปนี้

ก่อนที่คุณจะสามารถประเมินประสิทธิภาพของ API ในกรณีการใช้งานของคุณ คุณต้องเตรียมชุดข้อมูลการทดสอบที่เป็นตัวแทน ต่อไปนี้เป็นแนวทางระดับสูงบางส่วน:

- ชุด – สุ่มตัวอย่างขนาดใหญ่พอ (รูปภาพหรือวิดีโอ) ของข้อมูลที่คุณต้องการเรียกใช้ผ่าน Amazon Rekognition ในที่สุด ตัวอย่างเช่น หากคุณวางแผนที่จะกลั่นกรองรูปภาพที่ผู้ใช้อัปโหลด คุณสามารถใช้รูปภาพของผู้ใช้เป็นเวลา 1,000 สัปดาห์ในการทดสอบ เราแนะนำให้เลือกชุดที่มีภาพเพียงพอโดยไม่ให้ใหญ่เกินกว่าจะประมวลผล (เช่น 10,000–XNUMX ภาพ) แม้ว่าชุดที่ใหญ่กว่าจะดีกว่า

- คำนิยาม – ใช้หลักเกณฑ์เนื้อหาของแอปพลิเคชันของคุณเพื่อตัดสินใจว่าเนื้อหาที่ไม่ปลอดภัยประเภทใดที่คุณสนใจที่จะตรวจจับจาก Amazon Rekognition แนวคิดการกลั่นกรองอนุกรมวิธาน. ตัวอย่างเช่น คุณอาจสนใจที่จะตรวจหาภาพเปลือยที่โจ่งแจ้งและภาพความรุนแรงหรือคราบเลือดทุกประเภท

- คำอธิบายประกอบ – ตอนนี้ คุณต้องการข้อมูลพื้นฐานที่มนุษย์สร้างขึ้นสำหรับชุดการทดสอบของคุณโดยใช้ฉลากที่เลือก เพื่อให้คุณสามารถเปรียบเทียบการคาดคะเนของเครื่องจักรกับชุดทดสอบได้ ซึ่งหมายความว่าแต่ละภาพจะมีคำอธิบายประกอบสำหรับการมีอยู่หรือไม่มีแนวคิดที่คุณเลือก ในการใส่คำอธิบายประกอบข้อมูลภาพของคุณ คุณสามารถใช้ ความจริงของ Amazon SageMaker (GT) เพื่อจัดการคำอธิบายประกอบภาพ คุณสามารถอ้างถึง GT สำหรับการติดฉลากรูปภาพ, การรวมคำอธิบายประกอบ และ กำลังประมวลผลเอาต์พุตคำอธิบายประกอบ.

รับการคาดการณ์ชุดข้อมูลทดสอบของคุณด้วย Amazon Rekognition

ต่อไป คุณต้องการรับการคาดคะเนในชุดข้อมูลทดสอบของคุณ

ขั้นตอนแรกคือการตัดสินใจเลือกคะแนนความเชื่อมั่นขั้นต่ำ (ค่าเกณฑ์ เช่น 50%) ที่คุณต้องการวัดผล เกณฑ์เริ่มต้นของเราตั้งไว้ที่ 50 ซึ่งให้ความสมดุลที่ดีระหว่างการดึงเนื้อหาที่ไม่ปลอดภัยจำนวนมากโดยไม่ทำให้เกิดการคาดคะเนที่ผิดพลาดมากเกินไปเกี่ยวกับเนื้อหาที่ปลอดภัย อย่างไรก็ตาม แพลตฟอร์มของคุณอาจมีความต้องการทางธุรกิจที่แตกต่างกัน ดังนั้นคุณควรกำหนดเกณฑ์ความเชื่อมั่นนี้ตามความจำเป็น คุณสามารถใช้ MinConfidence พารามิเตอร์ในคำขอ API ของคุณเพื่อปรับสมดุลการตรวจจับเนื้อหา (เรียกคืน) เทียบกับความถูกต้องของการตรวจจับ (ความแม่นยำ) ถ้าคุณลด MinConfidenceคุณมักจะตรวจพบเนื้อหาที่ไม่เหมาะสมส่วนใหญ่ แต่ก็มีแนวโน้มที่จะหยิบเนื้อหาที่ไม่เหมาะสมจริงๆ ด้วย ถ้าคุณเพิ่มขึ้น MinConfidence คุณมีแนวโน้มที่จะตรวจสอบให้แน่ใจว่าเนื้อหาที่ตรวจพบทั้งหมดของคุณไม่เหมาะสมอย่างแท้จริง แต่เนื้อหาบางส่วนอาจไม่ถูกแท็ก เราขอแนะนำให้ทดลองกับบางตัว MinConfidence ค่าในชุดข้อมูลของคุณ และเลือกค่าที่ดีที่สุดสำหรับโดเมนข้อมูลของคุณในเชิงปริมาณ

ถัดไป เรียกใช้แต่ละตัวอย่าง (รูปภาพหรือวิดีโอ) ของชุดการทดสอบของคุณผ่าน Amazon Rekognition moderation API (ตรวจหาModerationLabels).

วัดความแม่นยำของแบบจำลองบนภาพ

คุณสามารถประเมินความถูกต้องของแบบจำลองโดยเปรียบเทียบหมายเหตุประกอบความจริงพื้นฐานที่มนุษย์สร้างขึ้นกับการคาดการณ์ของแบบจำลอง คุณทำการเปรียบเทียบนี้ซ้ำสำหรับรูปภาพทุกภาพโดยแยกจากกัน จากนั้นจึงรวมชุดทดสอบทั้งหมด:

- ผลลัพธ์ต่อภาพ – การทำนายแบบจำลองถูกกำหนดให้เป็นคู่

{label_name, confidence_score}(โดยที่คะแนนความมั่นใจ >= เกณฑ์ที่คุณเลือกไว้ก่อนหน้านี้) สำหรับแต่ละภาพ การคาดคะเนจะถือว่าถูกต้องเมื่อตรงกับความจริงพื้นฐาน (GT) การทำนายเป็นหนึ่งในตัวเลือกต่อไปนี้:- ทรู โพสิทีฟ (TP): ทั้งการทำนายและ GT นั้น “ไม่ปลอดภัย”

- ทรูเนกาทีฟ (TN): ทั้งการทำนายและ GT นั้น “ปลอดภัย”

- บวกปลอม (เอฟพี): คำทำนายบอกว่า "ไม่ปลอดภัย" แต่ GT "ปลอดภัย"

- ลบเท็จ (FN): คำทำนายนั้น “ปลอดภัย” แต่ GT นั้น “ไม่ปลอดภัย”

- ผลรวมของภาพทั้งหมด – ถัดไป คุณสามารถรวมการคาดการณ์เหล่านี้เป็นผลลัพธ์ระดับชุดข้อมูล:

- อัตราบวกเท็จ (FPR) – นี่คือเปอร์เซ็นต์ของรูปภาพในชุดทดสอบที่โมเดลทำเครื่องหมายอย่างไม่ถูกต้องว่ามีเนื้อหาที่ไม่ปลอดภัย: (FP): FP / (TN+FP)

- อัตราลบเท็จ (FNR) – นี่คือเปอร์เซ็นต์ของภาพที่ไม่ปลอดภัยในชุดทดสอบที่แบบจำลองพลาดไป: (FN): FN / (FN+TP)

- อัตราบวกที่แท้จริง (TPR) – เรียกอีกอย่างว่าการเรียกคืน ซึ่งจะคำนวณเปอร์เซ็นต์ของเนื้อหาที่ไม่ปลอดภัย (ความจริงพื้นฐาน) ที่แบบจำลองค้นพบหรือคาดการณ์อย่างถูกต้อง: TP / (TP + FN) = 1 – FNR

- ความแม่นยำ – คำนวณเปอร์เซ็นต์ของการคาดคะเนที่ถูกต้อง (เนื้อหาที่ไม่ปลอดภัย) โดยคำนึงถึงจำนวนการคาดการณ์ทั้งหมด: TP / (TP+FP)

ลองสำรวจตัวอย่าง สมมติว่าชุดทดสอบของคุณมีรูปภาพ 10,000 รูป: ปลอดภัย 9,950 รายการและไม่ปลอดภัย 50 รายการ โมเดลคาดการณ์ภาพได้ถูกต้อง 9,800 จาก 9,950 ภาพว่าปลอดภัย และ 45 จาก 50 ภาพไม่ปลอดภัย:

- TP = 45

- TN = 9800

- FP = 9950 – 9800 = 150

- FN = 50 – 45 = 5

- RPF = 150 / (9950 + 150) = 0.015 = 1.5%

- FNR = 5 / (5 + 45) = 0.1 = 10%

- TPR/การเรียกคืน = 45 / (45 + 5) = 0.9 = 90%

- ความแม่นยำ = 45 / (45 + 150) = 0.23 = 23%

วัดความแม่นยำของโมเดลในวิดีโอ

หากคุณต้องการประเมินประสิทธิภาพในวิดีโอ จำเป็นต้องมีขั้นตอนเพิ่มเติม:

- ตัวอย่างเฟรมย่อยจากแต่ละวิดีโอ เราขอแนะนำให้สุ่มตัวอย่างอย่างสม่ำเสมอด้วยอัตรา 0.3–1 เฟรมต่อวินาที (fps) ตัวอย่างเช่น หากวิดีโอถูกเข้ารหัสที่ 24 fps และคุณต้องการสุ่มตัวอย่างหนึ่งเฟรมทุกๆ 3 วินาที (0.3 fps) คุณจะต้องเลือกหนึ่งเฟรมทุกๆ 72 เฟรม

- เรียกใช้เฟรมตัวอย่างเหล่านี้ผ่านการกลั่นกรองเนื้อหา Amazon Rekognition คุณสามารถใช้ API วิดีโอของเรา ซึ่งสุ่มตัวอย่างเฟรมให้คุณแล้ว (ที่อัตรา 3 เฟรมต่อวินาที) หรือใช้ API รูปภาพ ซึ่งในกรณีนี้ คุณต้องการสุ่มตัวอย่างแบบเบาบางมากขึ้น เราขอแนะนำตัวเลือกหลัง เนื่องจากความซ้ำซ้อนของข้อมูลในวิดีโอ (เฟรมที่ต่อเนื่องกันจะคล้ายกันมาก)

- คำนวณผลลัพธ์ต่อเฟรมตามที่อธิบายไว้ในส่วนก่อนหน้า (ผลลัพธ์ต่อภาพ)

- รวมผลการทดสอบทั้งชุด ที่นี่คุณมีสองตัวเลือก ขึ้นอยู่กับประเภทของผลลัพธ์ที่สำคัญสำหรับธุรกิจของคุณ:

- ผลลัพธ์ระดับเฟรม – สิ่งนี้จะพิจารณาเฟรมที่สุ่มตัวอย่างทั้งหมดเป็นภาพที่แยกจากกัน และรวมผลลัพธ์ตามที่อธิบายไว้ก่อนหน้าสำหรับรูปภาพ (FPR, FNR, การเรียกคืน, ความแม่นยำ) หากวิดีโอบางรายการมีความยาวมากกว่าวิดีโออื่นๆ มาก วิดีโอเหล่านั้นจะนับจำนวนเฟรมเพิ่มขึ้น ทำให้การเปรียบเทียบไม่สมดุล ในกรณีนั้น เราแนะนำให้เปลี่ยนกลยุทธ์การสุ่มตัวอย่างเริ่มต้นเป็นจำนวนเฟรมที่แน่นอนต่อวิดีโอ ตัวอย่างเช่น คุณสามารถสุ่มตัวอย่าง 50-100 เฟรมต่อวิดีโอ (สมมติว่าวิดีโอมีความยาวอย่างน้อย 2-3 นาที)

- ผลลัพธ์ระดับวิดีโอ – ในบางกรณี ไม่สำคัญว่าโมเดลจะสามารถทำนายเฟรมในวิดีโอได้อย่างถูกต้อง 50% หรือ 99% แม้แต่การคาดคะเนที่ไม่ปลอดภัยที่ไม่ถูกต้องเพียงครั้งเดียวในเฟรมเดียวก็อาจกระตุ้นให้เกิดการประเมินขั้นปลายน้ำของมนุษย์ และมีเพียงวิดีโอที่มีการคาดคะเนที่ถูกต้อง 100% เท่านั้นที่จะได้รับการพิจารณาอย่างถูกต้องอย่างแท้จริง หากเป็นกรณีการใช้งานของคุณ เราขอแนะนำให้คุณคำนวณ FPR/FNR/TPR บนเฟรมของวิดีโอแต่ละรายการ และพิจารณาวิดีโอดังนี้:

| รหัสวิดีโอ | ความถูกต้อง | การจัดหมวดหมู่ต่อวิดีโอ |

| ผลลัพธ์ที่รวบรวมจากทุกเฟรมของ ID วิดีโอ |

รวม FP = 0 รวม FN = 0 |

การทำนายที่สมบูรณ์แบบ |

| . | รวม FP > 0 | ผลบวกเท็จ (FP) |

| . | รวม FN > 0 | ลบเท็จ (FN) |

หลังจากที่คุณคำนวณสิ่งเหล่านี้สำหรับวิดีโอแต่ละรายการแยกกันแล้ว คุณสามารถคำนวณเมตริกทั้งหมดที่เราแนะนำก่อนหน้านี้ได้:

- เปอร์เซ็นต์ของวิดีโอที่ถูกตั้งค่าสถานะอย่างไม่ถูกต้อง (FP) หรือพลาด (FN)

- ความแม่นยำและการเรียกคืน

วัดประสิทธิภาพกับเป้าหมาย

สุดท้าย คุณต้องตีความผลลัพธ์เหล่านี้ในบริบทของเป้าหมายและความสามารถของคุณ

ขั้นแรก ให้พิจารณาความต้องการทางธุรกิจของคุณในเรื่องต่อไปนี้:

- ข้อมูล – เรียนรู้เกี่ยวกับข้อมูลของคุณ (ปริมาณรายวัน ประเภทข้อมูล และอื่นๆ) และการกระจายเนื้อหาที่ไม่ปลอดภัยเทียบกับเนื้อหาที่ปลอดภัย ตัวอย่างเช่น มันสมดุล (50/50) เบ้ (10/90) หรือเบ้มาก (1/99 หมายความว่ามีเพียง 1% เท่านั้นที่ไม่ปลอดภัย) การทำความเข้าใจการกระจายดังกล่าวสามารถช่วยให้คุณกำหนดเป้าหมายเมตริกที่แท้จริงได้ ตัวอย่างเช่น จำนวนเนื้อหาที่ปลอดภัยมักจะมีลำดับความสำคัญมากกว่าเนื้อหาที่ไม่ปลอดภัย (เบ้มาก) ทำให้เกือบเป็นปัญหาการตรวจจับความผิดปกติ ภายในสถานการณ์สมมตินี้ จำนวนของผลบวกลวงอาจมากกว่าจำนวนของผลบวกจริง และคุณสามารถใช้ข้อมูลข้อมูลของคุณ (ความเบ้ในการกระจาย ปริมาณข้อมูล และอื่นๆ) เพื่อตัดสินใจ FPR ที่คุณสามารถใช้ได้

- เป้าหมายเมตริก – อะไรคือแง่มุมที่สำคัญที่สุดของธุรกิจของคุณ? การลด FPR มักทำให้เสีย FNR ที่สูงขึ้น (และในทางกลับกัน) และสิ่งสำคัญคือต้องค้นหาสมดุลที่เหมาะสมกับคุณ หากคุณไม่พลาดเนื้อหาที่ไม่ปลอดภัย คุณอาจต้องการ FNR เกือบ 0% (เรียกคืนได้ 100%) อย่างไรก็ตาม สิ่งนี้จะทำให้เกิดผลบวกลวงมากที่สุด และคุณต้องตัดสินใจเลือก FPR เป้าหมาย (สูงสุด) ที่คุณสามารถใช้ได้ โดยอิงจากไปป์ไลน์หลังการคาดการณ์ของคุณ คุณอาจต้องการให้ผลลบลวงบางระดับสามารถหาสมดุลที่ดีขึ้นและลด FPR ของคุณ: ตัวอย่างเช่น การยอมรับ 5% FNR แทน 0% อาจทำให้ FPR ลดลงจาก 2% เป็น 0.5% ซึ่งจะช่วยลดจำนวนลงได้มาก ของเนื้อหาที่ถูกตั้งค่าสถานะ

ต่อไป ถามตัวเองว่าจะใช้กลไกใดในการแยกวิเคราะห์รูปภาพที่ถูกตั้งค่าสถานะ แม้ว่า API อาจไม่ได้ให้ 0% FPR และ FNR แต่ก็ยังสามารถประหยัดและปรับขนาดได้มาก (เช่น ตั้งค่าสถานะเพียง 3% ของรูปภาพ คุณได้กรองเนื้อหาของคุณออก 97% แล้ว) เมื่อคุณจับคู่ API กับกลไกดาวน์สตรีมบางอย่าง เช่น พนักงานที่ตรวจสอบเนื้อหาที่ถูกตั้งค่าสถานะ คุณจะบรรลุเป้าหมายได้อย่างง่ายดาย (เช่น เนื้อหาที่ถูกตั้งค่าสถานะ 0.5%) โปรดทราบว่าการจับคู่นี้มีราคาถูกกว่าการตรวจสอบเนื้อหาของคุณ 100%

เมื่อคุณตัดสินใจเกี่ยวกับกลไกดาวน์สตรีมแล้ว เราขอแนะนำให้คุณประเมินปริมาณงานที่คุณสามารถสนับสนุนได้ ตัวอย่างเช่น หากคุณมีพนักงานที่สามารถตรวจสอบเนื้อหารายวันของคุณได้เพียง 2% เป้าหมายของคุณจาก API การควบคุมเนื้อหาของเราคืออัตราการตั้งค่าสถานะ (FPR+TPR) 2%

สุดท้าย หากการได้รับคำอธิบายประกอบจากความจริงพื้นๆ นั้นยากเกินไปหรือแพงเกินไป (เช่น ปริมาณข้อมูลของคุณใหญ่เกินไป) เราขอแนะนำให้ใส่คำอธิบายประกอบรูปภาพจำนวนน้อยที่ API ตั้งค่าสถานะไว้ แม้ว่าการดำเนินการนี้จะไม่อนุญาตให้มีการประเมิน FNR (เนื่องจากข้อมูลของคุณไม่มีผลลบที่เป็นเท็จ) คุณยังคงวัด TPR และ FPR ได้

ในส่วนต่อไปนี้ เราจะนำเสนอโซลูชันสำหรับการประเมินการดูแลภาพ คุณสามารถใช้แนวทางที่คล้ายกันในการประเมินการกลั่นกรองวิดีโอ

ภาพรวมโซลูชัน

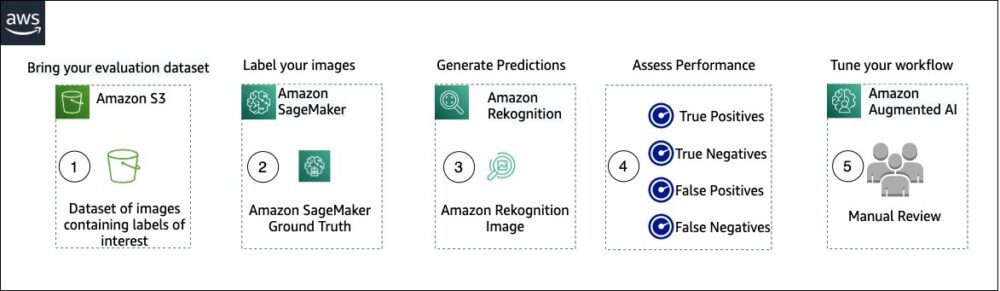

ไดอะแกรมต่อไปนี้แสดงบริการต่างๆ ของ AWS ที่คุณสามารถใช้เพื่อประเมินประสิทธิภาพของการควบคุมเนื้อหา Amazon Rekognition ในชุดข้อมูลทดสอบของคุณ

การประเมินการกลั่นกรองเนื้อหามีขั้นตอนดังต่อไปนี้:

- อัปโหลดชุดข้อมูลการประเมินของคุณไปที่ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (อเมซอน เอส3).

- ใช้ Ground Truth เพื่อกำหนดป้ายกำกับการตรวจสอบความจริงภาคพื้นดิน

- สร้างป้ายกำกับการควบคุมที่คาดการณ์ไว้โดยใช้ API การกลั่นกรองล่วงหน้าของ Amazon Rekognition โดยใช้ค่าเกณฑ์สองสามค่า (เช่น 70%, 75% และ 80%)

- ประเมินประสิทธิภาพสำหรับแต่ละเกณฑ์โดยคำนวณผลบวกจริง ผลลบจริง ผลบวกลวง และผลลบลวง กำหนดค่าเกณฑ์ที่เหมาะสมที่สุดสำหรับกรณีการใช้งานของคุณ

- คุณสามารถเลือกปรับแต่งขนาดของกำลังคนโดยพิจารณาจากผลบวกจริงและเท็จ และการใช้งาน อเมซอน เสริม AI (Amazon A2I) เพื่อส่งเนื้อหาที่ถูกตั้งค่าสถานะทั้งหมดโดยอัตโนมัติไปยังพนักงานที่คุณกำหนดเพื่อตรวจสอบด้วยตนเอง

ส่วนต่อไปนี้แสดงข้อมูลโค้ดสำหรับขั้นตอนที่ 1, 2 และ 3 สำหรับซอร์สโค้ดแบบ end-to-end ที่สมบูรณ์ โปรดดูที่ สมุดบันทึก Jupyter.

เบื้องต้น

ก่อนที่คุณจะเริ่มต้น ให้ทำตามขั้นตอนต่อไปนี้เพื่อตั้งค่าโน้ตบุ๊ก Jupyter:

- สร้างอินสแตนซ์สมุดบันทึก in อเมซอน SageMaker.

- เมื่อโน้ตบุ๊กเปิดใช้งานอยู่ ให้เลือก เปิด Jupyter.

- บนแดชบอร์ด Jupyter ให้เลือก ใหม่และเลือก สถานีปลายทาง.

- ในเทอร์มินัล ให้ป้อนรหัสต่อไปนี้:

- เปิดสมุดบันทึกสำหรับโพสต์นี้:

content-moderation-evaluation/Evaluating-Amazon-Rekognition-Content-Moderation-Service.ipynb. - อัปโหลดชุดข้อมูลการประเมินของคุณไปที่ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (อเมซอน เอส3).

ตอนนี้เราจะดำเนินการตามขั้นตอนที่ 2 ถึง 4 ในสมุดบันทึก Jupyter

ใช้ Ground Truth เพื่อกำหนดป้ายกำกับการดูแล

ในการกำหนดป้ายกำกับใน Ground Truth ให้ทำตามขั้นตอนต่อไปนี้:

- สร้างไฟล์อินพุตรายการ สำหรับงาน Ground Truth ของคุณและอัปโหลดไปยัง Amazon S3

- สร้างการกำหนดค่าการติดฉลาก ซึ่งประกอบด้วยป้ายกำกับการดูแลทั้งหมดที่จำเป็นสำหรับงานการติดฉลาก Ground Truth หากต้องการตรวจสอบขีดจำกัดจำนวนหมวดหมู่ป้ายกำกับที่คุณสามารถใช้ได้ โปรดดูที่ โควต้าหมวดหมู่ป้ายกำกับ. ในข้อมูลโค้ดต่อไปนี้ เราใช้ป้ายกำกับห้ารายการ (อ้างอิงถึง อนุกรมวิธานแบบลำดับชั้นที่ใช้ใน Amazon Rekognition สำหรับรายละเอียดเพิ่มเติม) บวกหนึ่งป้าย (

Safe_Content) ที่ทำเครื่องหมายเนื้อหาว่าปลอดภัย: - สร้างเทมเพลตงานของผู้ปฏิบัติงานที่กำหนดเองเพื่อจัดเตรียมคำแนะนำในการติดฉลากให้กับพนักงาน Ground Truth และอัปโหลดไปยัง Amazon S3

งานป้ายกำกับ Ground Truth ถูกกำหนดเป็นงานการจำแนกรูปภาพ (หลายป้ายกำกับ) อ้างถึงซอร์สโค้ดสำหรับคำแนะนำในการปรับแต่งเทมเพลตคำสั่ง - ตัดสินใจว่าคุณต้องการใช้แรงงานคนใดเพื่อทำงาน Ground Truth ให้สำเร็จ คุณมีสองตัวเลือก (ดูรายละเอียดในซอร์สโค้ด):

- ใช้ แรงงานส่วนตัว ในองค์กรของคุณเองเพื่อติดป้ายกำกับชุดข้อมูลการประเมิน

- ใช้ แรงงานสาธารณะ เพื่อติดป้ายกำกับชุดข้อมูลการประเมิน

- สร้างและส่งงานการติดฉลาก Ground Truth คุณยังสามารถปรับรหัสต่อไปนี้เพื่อกำหนดค่า พารามิเตอร์งานการติดฉลาก เพื่อตอบสนองความต้องการทางธุรกิจเฉพาะของคุณ อ้างถึงซอร์สโค้ดสำหรับคำแนะนำทั้งหมดในการสร้างและกำหนดค่างาน Ground Truth

หลังจากส่งงานแล้ว คุณควรเห็นผลลัพธ์ที่คล้ายกับต่อไปนี้:

รอให้งานการติดฉลากบนชุดข้อมูลการประเมินเสร็จสมบูรณ์ จากนั้นทำตามขั้นตอนต่อไป

ใช้ API การกลั่นกรองของ Amazon Rekognition เพื่อสร้างป้ายกำกับการควบคุมที่คาดการณ์ไว้

ข้อมูลโค้ดต่อไปนี้แสดงวิธีใช้ Amazon Rekognition การกลั่นกรอง API เพื่อสร้างป้ายกำกับการควบคุม:

ประเมินประสิทธิภาพ

ในขั้นแรก คุณเรียกป้ายกำกับการตรวจสอบ Ground Truth จากผลงานการติดฉลาก Ground Truth สำหรับชุดข้อมูลการประเมิน จากนั้นคุณเรียกใช้ Amazon Rekognition moderation API เพื่อรับป้ายกำกับการควบคุมที่คาดการณ์ไว้สำหรับชุดข้อมูลเดียวกัน เนื่องจากนี่เป็นปัญหาการจำแนกประเภทไบนารี (เนื้อหาที่ปลอดภัยกับเนื้อหาที่ไม่ปลอดภัย) เราจึงคำนวณเมตริกต่อไปนี้ (สมมติว่าเนื้อหาที่ไม่ปลอดภัยเป็นค่าบวก):

นอกจากนี้เรายังคำนวณตัวชี้วัดการประเมินที่เกี่ยวข้อง:

ข้อมูลโค้ดต่อไปนี้แสดงวิธีคำนวณเมตริกเหล่านั้น:

สรุป

โพสต์นี้กล่าวถึงองค์ประกอบหลักที่จำเป็นในการประเมินด้านประสิทธิภาพของบริการการตรวจสอบเนื้อหาของคุณในแง่ของเมตริกความถูกต้องต่างๆ อย่างไรก็ตาม ความถูกต้องเป็นเพียงมิติเดียวเท่านั้นที่คุณต้องประเมินเมื่อเลือกบริการตรวจสอบเนื้อหาเฉพาะ สิ่งสำคัญคือคุณต้องรวมพารามิเตอร์อื่นๆ เช่น ชุดคุณลักษณะทั้งหมดของบริการ การใช้งานง่าย การผสานรวมที่มีอยู่ ความเป็นส่วนตัวและความปลอดภัย หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับการกลั่นกรองเนื้อหาใน Amazon Rekognition โปรดไปที่ การกลั่นกรองเนื้อหาของ Amazon Rekognition.

เกี่ยวกับผู้แต่ง

Amit Gupta เป็นสถาปนิกอาวุโสด้านโซลูชันบริการ AI ที่ AWS เขาหลงใหลในการช่วยให้ลูกค้าได้รับโซลูชันแมชชีนเลิร์นนิงที่มีสถาปัตยกรรมที่ดีในวงกว้าง

Amit Gupta เป็นสถาปนิกอาวุโสด้านโซลูชันบริการ AI ที่ AWS เขาหลงใหลในการช่วยให้ลูกค้าได้รับโซลูชันแมชชีนเลิร์นนิงที่มีสถาปัตยกรรมที่ดีในวงกว้าง

ดาวิเด โมโดโล เป็นผู้จัดการวิทยาศาสตร์ประยุกต์ที่ AWS AI Labs เขามีปริญญาเอกด้านคอมพิวเตอร์วิทัศน์จากมหาวิทยาลัยเอดินบะระ (สหราชอาณาจักร) และหลงใหลในการพัฒนาโซลูชันทางวิทยาศาสตร์ใหม่ๆ สำหรับปัญหาของลูกค้าในโลกแห่งความเป็นจริง นอกเวลางาน เขาชอบท่องเที่ยวและเล่นกีฬาทุกประเภท โดยเฉพาะฟุตบอล

ดาวิเด โมโดโล เป็นผู้จัดการวิทยาศาสตร์ประยุกต์ที่ AWS AI Labs เขามีปริญญาเอกด้านคอมพิวเตอร์วิทัศน์จากมหาวิทยาลัยเอดินบะระ (สหราชอาณาจักร) และหลงใหลในการพัฒนาโซลูชันทางวิทยาศาสตร์ใหม่ๆ สำหรับปัญหาของลูกค้าในโลกแห่งความเป็นจริง นอกเวลางาน เขาชอบท่องเที่ยวและเล่นกีฬาทุกประเภท โดยเฉพาะฟุตบอล

เจียนหวู่ เป็นสถาปนิกโซลูชันระดับองค์กรอาวุโสที่ AWS เขาทำงานกับ AWS มา 6 ปีแล้ว โดยทำงานร่วมกับลูกค้าทุกขนาด เขาหลงใหลในการช่วยให้ลูกค้าสร้างนวัตกรรมได้เร็วยิ่งขึ้นผ่านการนำ Cloud และ AI/ML มาใช้ ก่อนร่วมงานกับ AWS Jian ใช้เวลามากกว่า 10 ปีโดยมุ่งเน้นที่การพัฒนาซอฟต์แวร์ การใช้งานระบบ และการจัดการโครงสร้างพื้นฐาน นอกเหนือจากการทำงานแล้ว เขายังสนุกกับการทำกิจกรรมและใช้เวลาอยู่กับครอบครัว

เจียนหวู่ เป็นสถาปนิกโซลูชันระดับองค์กรอาวุโสที่ AWS เขาทำงานกับ AWS มา 6 ปีแล้ว โดยทำงานร่วมกับลูกค้าทุกขนาด เขาหลงใหลในการช่วยให้ลูกค้าสร้างนวัตกรรมได้เร็วยิ่งขึ้นผ่านการนำ Cloud และ AI/ML มาใช้ ก่อนร่วมงานกับ AWS Jian ใช้เวลามากกว่า 10 ปีโดยมุ่งเน้นที่การพัฒนาซอฟต์แวร์ การใช้งานระบบ และการจัดการโครงสร้างพื้นฐาน นอกเหนือจากการทำงานแล้ว เขายังสนุกกับการทำกิจกรรมและใช้เวลาอยู่กับครอบครัว

- ขั้นสูง (300)

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- ความหมายของ Amazon

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- AWS Machine Learning AWS

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- ขนาดไอ

- วากยสัมพันธ์

- ลมทะเล