บทนำ

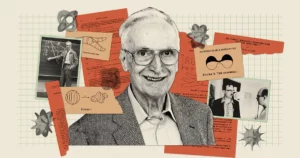

ปัญญาประดิษฐ์ดูทรงพลังกว่าที่เคย ด้วยแชทบอทอย่าง Bard และ ChatGPT ที่สามารถสร้างข้อความที่มีลักษณะเหมือนมนุษย์อย่างเหลือเชื่อ แต่สำหรับความสามารถทั้งหมดของพวกเขา บอทเหล่านี้ยังคงทำให้นักวิจัยสงสัยว่า: ทำโมเดลดังกล่าว เข้าใจจริงๆ พวกเขากำลังพูดอะไร? “เห็นได้ชัดว่ามีบางคนเชื่อว่าตนเชื่อ” ผู้บุกเบิกด้าน AI กล่าว เจฟฟ์ ฮินตัน ใน บทสนทนาล่าสุด กับ Andrew Ng “และบางคนเชื่อว่าพวกเขาเป็นเพียงนกแก้วสุ่ม”

วลีนี้มาจากปี 2021 กระดาษ ร่วมเขียนโดย เอมิลี่เบนเดอร์, นักภาษาศาสตร์เชิงคอมพิวเตอร์แห่งมหาวิทยาลัยวอชิงตัน โดยแนะนำว่าโมเดลภาษาขนาดใหญ่ (LLM) ซึ่งเป็นพื้นฐานของแชทบอทยุคใหม่ สร้างข้อความโดยการรวมข้อมูลที่พวกเขาได้เห็นแล้ว “โดยไม่มีการอ้างอิงถึงความหมาย” ผู้เขียนเขียน ซึ่งทำให้ LLM “เป็นนกแก้วสุ่ม”

โมเดลเหล่านี้ขับเคลื่อนแชทบอทที่ใหญ่ที่สุดและดีที่สุดในปัจจุบันจำนวนมาก ดังนั้น Hinton จึงแย้งว่าถึงเวลาที่จะต้องกำหนดขอบเขตของสิ่งที่พวกเขาเข้าใจ สำหรับเขาแล้ว คำถามนี้มีมากกว่าเรื่องวิชาการ “ตราบใดที่เรามีความแตกต่าง” ของความคิดเห็น เขากล่าวกับอึ้ง “เราจะไม่สามารถตกลงเป็นเอกฉันท์เกี่ยวกับอันตรายได้”

การวิจัยใหม่อาจมีคำตอบที่ชัดเจน ทฤษฎีที่พัฒนาโดย Arora Sanjeev ของมหาวิทยาลัยพรินซ์ตัน และ อนิรุธ โกยัลซึ่งเป็นนักวิทยาศาสตร์การวิจัยที่ Google DeepMind แนะนำว่า LLM ที่ใหญ่ที่สุดในปัจจุบันไม่ใช่นกแก้วสุ่ม ผู้เขียนโต้แย้งว่าเมื่อแบบจำลองเหล่านี้มีขนาดใหญ่ขึ้นและได้รับการฝึกอบรมโดยใช้ข้อมูลมากขึ้น แบบจำลองเหล่านี้จะปรับปรุงความสามารถที่เกี่ยวข้องกับภาษาของแต่ละบุคคล และยังพัฒนาความสามารถใหม่ๆ ด้วยการรวมทักษะในลักษณะที่บ่งบอกถึงความเข้าใจ ซึ่งเป็นการผสมผสานที่ไม่น่าจะมีอยู่ในข้อมูลการฝึกอบรม .

วิธีการทางทฤษฎีนี้ ซึ่งให้ข้อโต้แย้งที่พิสูจน์ได้ทางคณิตศาสตร์ว่า LLM สามารถพัฒนาความสามารถมากมายได้อย่างไรและทำไม ทำให้ผู้เชี่ยวชาญอย่าง Hinton และคนอื่นๆ เชื่อมั่น และเมื่อ Arora และทีมของเขาทดสอบการคาดการณ์บางอย่าง พวกเขาก็พบว่าแบบจำลองเหล่านี้ทำงานได้เกือบจะตรงตามที่คาดไว้ จากเรื่องราวทั้งหมด พวกเขาได้สร้างกรณีที่ชัดเจนว่า LLM ที่ใหญ่ที่สุดไม่ใช่แค่การนกแก้วในสิ่งที่พวกเขาเคยเห็นมาก่อน

“[พวกเขา] ไม่สามารถเพียงเลียนแบบสิ่งที่เห็นในข้อมูลการฝึกอบรมได้” กล่าว เซบาสเตียน บูเบคนักคณิตศาสตร์และนักวิทยาศาสตร์คอมพิวเตอร์ที่ Microsoft Research ซึ่งไม่ได้เป็นส่วนหนึ่งของงานนี้ “นั่นคือความเข้าใจพื้นฐาน”

ข้อมูลมากขึ้น พลังมากขึ้น

การเกิดขึ้นของ ความสามารถที่คาดไม่ถึงและหลากหลาย พูดได้อย่างยุติธรรมใน LLM ว่าเป็นเรื่องที่น่าประหลาดใจ ความสามารถเหล่านี้ไม่ใช่ผลลัพธ์ที่ชัดเจนของวิธีสร้างและฝึกอบรมระบบ LLM คือโครงข่ายประสาทเทียมขนาดใหญ่ที่เชื่อมต่อเซลล์ประสาทเทียมแต่ละตัว การเชื่อมต่อเหล่านี้เรียกว่าพารามิเตอร์ของโมเดล และหมายเลขของการเชื่อมต่อเหล่านี้แสดงถึงขนาดของ LLM การฝึกอบรมเกี่ยวข้องกับการให้ประโยค LLM โดยปิดบังคำสุดท้ายไว้ เช่น “เชื้อเพลิงมีราคาแขนและ ___” LLM ทำนายการกระจายความน่าจะเป็นของคำศัพท์ทั้งหมด ดังนั้นหากรู้หรือพูดได้หนึ่งพันคำ ก็จะทำนายความน่าจะเป็นได้หนึ่งพันคำ จากนั้นจะเลือกคำที่มีแนวโน้มมากที่สุดในการเติมประโยคให้สมบูรณ์ — สมมุติว่า “ขา”

ในตอนแรก LLM อาจเลือกคำได้ไม่ดี จากนั้นอัลกอริธึมการฝึกอบรมจะคำนวณการสูญเสีย — ระยะทางในพื้นที่ทางคณิตศาสตร์มิติสูงระหว่างคำตอบของ LLM และคำจริงในประโยคต้นฉบับ — และใช้การสูญเสียนี้เพื่อปรับแต่งพารามิเตอร์ เมื่อพิจารณาจากประโยคเดียวกัน LLM จะคำนวณการแจกแจงความน่าจะเป็นที่ดีขึ้น และความสูญเสียจะลดลงเล็กน้อย อัลกอริธึมทำเช่นนี้กับทุกๆ ประโยคในข้อมูลการฝึกอบรม (อาจเป็นพันล้านประโยค) จนกว่าการสูญเสียโดยรวมของ LLM จะลดลงสู่ระดับที่ยอมรับได้ กระบวนการที่คล้ายกันนี้ใช้เพื่อทดสอบ LLM ในประโยคที่ไม่ได้เป็นส่วนหนึ่งของข้อมูลการฝึกอบรม

LLM ที่ได้รับการฝึกอบรมและทดสอบแล้ว เมื่อนำเสนอพร้อมข้อความใหม่ จะสร้างคำถัดไปที่น่าจะเป็นไปได้มากที่สุด ผนวกเข้ากับพร้อมท์ สร้างคำถัดไปอีก และดำเนินการต่อในลักษณะนี้ โดยสร้างการตอบกลับที่ดูเหมือนสอดคล้องกัน ไม่มีสิ่งใดในกระบวนการฝึกอบรมที่แนะนำว่า LLM ที่ใหญ่กว่าซึ่งสร้างขึ้นโดยใช้พารามิเตอร์และข้อมูลการฝึกอบรมที่มากขึ้น ควรปรับปรุงในงานที่ต้องใช้เหตุผลในการตอบ

แต่พวกเขาทำ LLM ที่ใหญ่เพียงพอแสดงให้เห็นถึงความสามารถต่างๆ ตั้งแต่การแก้ปัญหาคณิตศาสตร์เบื้องต้นไปจนถึงการตอบคำถามเกี่ยวกับสิ่งที่อยู่ในใจของผู้อื่น ซึ่งรุ่นเล็กไม่มี แม้ว่าพวกเขาทั้งหมดจะได้รับการฝึกในลักษณะเดียวกันก็ตาม

“ [ความสามารถ] นั้นมาจากไหน?” อาโรร่าสงสัย “และนั่นจะเกิดขึ้นจากการทำนายคำถัดไปได้หรือไม่”

การเชื่อมต่อทักษะเข้ากับข้อความ

Arora ร่วมมือกับ Goyal เพื่อตอบคำถามดังกล่าวในเชิงวิเคราะห์ “เรากำลังพยายามสร้างกรอบทางทฤษฎีขึ้นมาเพื่อทำความเข้าใจว่าการเกิดขึ้นเกิดขึ้นได้อย่างไร” อาโรรากล่าว

ทั้งคู่หันไปหาวัตถุทางคณิตศาสตร์ที่เรียกว่ากราฟสุ่ม กราฟคือกลุ่มของจุด (หรือโหนด) ที่เชื่อมต่อกันด้วยเส้น (หรือขอบ) และในกราฟแบบสุ่ม การมีอยู่ของขอบระหว่างสองโหนดใดๆ จะถูกกำหนดแบบสุ่ม เช่น โดยการพลิกเหรียญ เหรียญสามารถมีอคติได้ ดังนั้นมันจึงมีความน่าจะเป็นอยู่บ้าง p. ถ้าเหรียญขึ้นหัวสำหรับคู่ของโหนดที่กำหนด ขอบจะเกิดขึ้นระหว่างสองโหนดนั้น มิฉะนั้นพวกเขาจะยังคงไม่เชื่อมต่อกัน เป็นมูลค่าของ p การเปลี่ยนแปลง กราฟสามารถแสดงการเปลี่ยนแปลงอย่างฉับพลันในคุณสมบัติได้. ตัวอย่างเช่นเมื่อ p เกินเกณฑ์ที่กำหนด โหนดที่แยกออกมา — ที่ไม่ได้เชื่อมต่อกับโหนดอื่น — จะหายไปทันที

Arora และ Goyal ตระหนักว่ากราฟสุ่มซึ่งก่อให้เกิดพฤติกรรมที่ไม่คาดคิดหลังจากที่กราฟเหล่านี้ถึงเกณฑ์ที่กำหนด อาจเป็นวิธีการสร้างแบบจำลองพฤติกรรมของ LLM โครงข่ายประสาทเทียมเกือบจะซับซ้อนเกินกว่าจะวิเคราะห์ได้ แต่นักคณิตศาสตร์ได้ศึกษากราฟแบบสุ่มมาเป็นเวลานานและได้พัฒนาเครื่องมือต่างๆ เพื่อวิเคราะห์กราฟเหล่านั้น บางทีทฤษฎีกราฟสุ่มอาจช่วยให้นักวิจัยเข้าใจและคาดการณ์พฤติกรรมที่ไม่คาดคิดของ LLM ขนาดใหญ่ได้

นักวิจัยตัดสินใจที่จะมุ่งเน้นไปที่กราฟ "สองฝ่าย" ซึ่งมีโหนดสองประเภท ในโมเดลของพวกเขา โหนดประเภทหนึ่งแสดงถึงชิ้นส่วนของข้อความ ไม่ใช่คำเดี่ยวๆ แต่เป็นชิ้นที่อาจมีความยาวหนึ่งย่อหน้าหรือยาวสองสามหน้า โหนดเหล่านี้จัดเรียงเป็นเส้นตรง ด้านล่างอีกบรรทัดหนึ่งคือโหนดอีกชุดหนึ่ง สิ่งเหล่านี้แสดงถึงทักษะที่จำเป็นในการทำความเข้าใจข้อความที่กำหนด ทักษะแต่ละอย่างสามารถเป็นได้เกือบทุกอย่าง บางทีโหนดหนึ่งแสดงถึงความสามารถของ LLM ในการเข้าใจคำว่า "เพราะ" ซึ่งรวมถึงแนวคิดเกี่ยวกับความเป็นเหตุเป็นผล อีกอันหนึ่งอาจแสดงถึงความสามารถในการหารตัวเลขสองตัว อีกประการหนึ่งอาจแสดงถึงความสามารถในการตรวจจับการประชด “ถ้าคุณเข้าใจว่าข้อความนั้นเป็นเรื่องน่าขัน หลายๆ อย่างกลับพลิกผัน” Arora กล่าว “นั่นเกี่ยวข้องกับการทำนายคำศัพท์”

เพื่อความชัดเจน LLM ไม่ได้รับการฝึกอบรมหรือทดสอบโดยคำนึงถึงทักษะ สร้างขึ้นเพื่อปรับปรุงการทำนายคำถัดไปเท่านั้น แต่ Arora และ Goyal ต้องการทำความเข้าใจ LLM จากมุมมองของทักษะที่อาจจำเป็นในการทำความเข้าใจข้อความเดียว การเชื่อมต่อระหว่างโหนดทักษะและโหนดข้อความ หรือระหว่างโหนดทักษะหลายโหนดและโหนดข้อความ หมายความว่า LLM ต้องการทักษะเหล่านั้นเพื่อทำความเข้าใจข้อความในโหนดนั้น นอกจากนี้ ข้อความหลายชิ้นอาจดึงมาจากทักษะหรือชุดทักษะเดียวกัน ตัวอย่างเช่น ชุดของโหนดทักษะที่แสดงถึงความสามารถในการเข้าใจการประชดจะเชื่อมต่อกับโหนดข้อความจำนวนมากที่มีการประชดเกิดขึ้น

ความท้าทายในตอนนี้คือการเชื่อมต่อกราฟสองฝ่ายเหล่านี้กับ LLM จริง และดูว่ากราฟสามารถเปิดเผยบางอย่างเกี่ยวกับการเกิดขึ้นของความสามารถอันทรงพลังได้หรือไม่ แต่นักวิจัยไม่สามารถพึ่งพาข้อมูลใดๆ เกี่ยวกับการฝึกอบรมหรือการทดสอบ LLM จริงได้ บริษัทอย่าง OpenAI หรือ DeepMind จะไม่เปิดเผยข้อมูลการฝึกอบรมหรือการทดสอบต่อสาธารณะ นอกจากนี้ Arora และ Goyal ยังต้องการคาดการณ์ว่า LLM จะมีพฤติกรรมอย่างไรเมื่อมีขนาดใหญ่ขึ้น และไม่มีข้อมูลดังกล่าวสำหรับแชทบอทที่กำลังจะมาถึง อย่างไรก็ตาม มีข้อมูลสำคัญชิ้นหนึ่งที่นักวิจัยสามารถเข้าถึงได้

ตั้งแต่ปี 2021 นักวิจัยที่ศึกษาประสิทธิภาพของ LLM และโครงข่ายประสาทเทียมอื่นๆ พบว่ามีลักษณะสากลเกิดขึ้น พวกเขาสังเกตเห็นว่าเมื่อแบบจำลองมีขนาดใหญ่ขึ้น ไม่ว่าจะมีขนาดหรือจำนวนข้อมูลการฝึก การสูญเสียข้อมูลการทดสอบ (ความแตกต่างระหว่างคำตอบที่คาดการณ์ไว้และคำตอบที่ถูกต้องในข้อความใหม่ หลังการฝึก) จะลดลงในลักษณะที่เฉพาะเจาะจงมาก การสังเกตเหล่านี้ถูกประมวลผลเป็นสมการที่เรียกว่ากฎมาตราส่วนประสาท ดังนั้น Arora และ Goyal จึงออกแบบทฤษฎีของพวกเขาไม่ให้ขึ้นอยู่กับข้อมูลจาก LLM, แชทบอท หรือชุดข้อมูลการฝึกอบรมและการทดสอบใดๆ ใดๆ แต่เป็นไปตามกฎหมายสากล ระบบเหล่านี้ล้วนถูกคาดหวังให้ปฏิบัติตาม นั่นคือ ความสูญเสียที่ทำนายไว้โดยกฎหมายการขยายขนาด

บางทีพวกเขาอาจให้เหตุผลว่าการปรับปรุงประสิทธิภาพ (ซึ่งวัดโดยกฎมาตราส่วนประสาท) นั้นเกี่ยวข้องกับทักษะที่ได้รับการปรับปรุง และทักษะที่ได้รับการปรับปรุงเหล่านี้สามารถกำหนดได้ในกราฟสองฝ่ายโดยการเชื่อมต่อโหนดทักษะกับโหนดข้อความ การสร้างความเชื่อมโยงระหว่างกฎหมายมาตราส่วนประสาทและกราฟสองฝ่ายเป็นกุญแจสำคัญที่จะช่วยให้พวกเขาดำเนินการต่อได้

ขยายทักษะ

นักวิจัยเริ่มต้นด้วยการสมมติว่ามีกราฟสองฝ่ายสมมุติที่สอดคล้องกับพฤติกรรมของ LLM ในข้อมูลการทดสอบ เพื่ออธิบายการเปลี่ยนแปลงในการสูญเสียข้อมูลการทดสอบของ LLM พวกเขาจินตนาการถึงวิธีใช้กราฟเพื่ออธิบายว่า LLM ได้รับทักษะอย่างไร

ยกตัวอย่างเช่น ทักษะ “เข้าใจการประชด” แนวคิดนี้แสดงด้วยโหนดทักษะ ดังนั้นนักวิจัยจึงพิจารณาว่าโหนดข้อความใดที่โหนดทักษะนี้เชื่อมต่ออยู่ หากโหนดข้อความที่เชื่อมต่อเหล่านี้เกือบทั้งหมดประสบความสำเร็จ — หมายความว่าการคาดการณ์ของ LLM เกี่ยวกับข้อความที่แสดงโดยโหนดเหล่านี้มีความแม่นยำสูง — แสดงว่า LLM มีความสามารถในทักษะเฉพาะนี้ แต่ถ้าการเชื่อมต่อของโหนดทักษะมากกว่าเศษส่วนไปที่โหนดข้อความที่ล้มเหลว LLM ก็จะล้มเหลวในทักษะนี้

การเชื่อมต่อระหว่างกราฟสองฝ่ายเหล่านี้กับ LLM ทำให้ Arora และ Goyal ใช้เครื่องมือของทฤษฎีกราฟสุ่มเพื่อวิเคราะห์พฤติกรรมของ LLM โดยใช้พร็อกซี การศึกษากราฟเหล่านี้เผยให้เห็นความสัมพันธ์บางอย่างระหว่างโหนด ในทางกลับกัน ความสัมพันธ์เหล่านี้แปลเป็นแนวทางที่สมเหตุสมผลและทดสอบได้เพื่ออธิบายว่าแบบจำลองขนาดใหญ่ได้รับทักษะที่จำเป็นในการบรรลุความสามารถที่ไม่คาดคิดได้อย่างไร

Arora และ Goyal อธิบายพฤติกรรมสำคัญประการหนึ่งเป็นครั้งแรก: เหตุใด LLM ที่ใหญ่กว่าจึงมีทักษะมากกว่าทักษะส่วนบุคคลที่มีขนาดเล็กกว่า พวกเขาเริ่มต้นด้วยการสูญเสียการทดสอบที่ต่ำกว่าที่คาดการณ์โดยกฎมาตราส่วนประสาท ในกราฟ การสูญเสียจากการทดสอบที่ต่ำกว่านี้แสดงโดยการลดลงในส่วนของโหนดทดสอบที่ล้มเหลว ดังนั้นจึงมีโหนดทดสอบที่ล้มเหลวโดยรวมน้อยลง และถ้ามีโหนดทดสอบที่ล้มเหลวน้อยลง ก็จะมีการเชื่อมต่อระหว่างโหนดทดสอบที่ล้มเหลวและโหนดทักษะน้อยลง ดังนั้น โหนดทักษะจำนวนมากขึ้นจึงเชื่อมต่อกับโหนดทดสอบที่ประสบความสำเร็จ ซึ่งบ่งบอกถึงความสามารถที่เพิ่มขึ้นในทักษะสำหรับแบบจำลอง “การสูญเสียที่ลดลงเล็กน้อยมากทำให้เครื่องจักรได้รับความสามารถของทักษะเหล่านี้” Goyal กล่าว

ต่อมา ทั้งคู่พบวิธีอธิบายความสามารถที่ไม่คาดคิดของโมเดลที่ใหญ่กว่า เมื่อขนาดของ LLM เพิ่มขึ้นและการสูญเสียการทดสอบลดลง การรวมโหนดทักษะแบบสุ่มจะพัฒนาการเชื่อมต่อไปยังแต่ละโหนดข้อความ สิ่งนี้ชี้ให้เห็นว่า LLM ยังดีขึ้นในการใช้ทักษะมากกว่าหนึ่งทักษะในแต่ละครั้ง และเริ่มสร้างข้อความโดยใช้หลายทักษะ - ผสมผสาน เช่น ความสามารถในการใช้ประชดด้วยความเข้าใจคำว่า "เพราะ" - แม้ว่าการผสมผสานที่แน่นอนของ ไม่มีทักษะปรากฏอยู่ในข้อความใดๆ ในข้อมูลการฝึกอบรม

ลองนึกภาพ LLM ที่สามารถใช้ทักษะหนึ่งเพื่อสร้างข้อความได้แล้ว หากคุณขยายจำนวนพารามิเตอร์หรือข้อมูลการฝึกอบรมของ LLM ตามลำดับความสำคัญ ก็จะมีความสามารถในการสร้างข้อความที่ต้องใช้สองทักษะเช่นเดียวกัน ก้าวไปอีกขั้นหนึ่ง และ LLM สามารถทำงานที่ต้องใช้ทักษะสี่ทักษะในคราวเดียวได้อีกครั้งด้วยความสามารถระดับเดียวกัน LLM ที่ใหญ่กว่ามีวิธีรวบรวมทักษะต่างๆ ได้มากกว่า ซึ่งนำไปสู่การระเบิดความสามารถแบบผสมผสาน

และเมื่อมีการขยาย LLM ความเป็นไปได้ที่จะเผชิญกับการผสมผสานทักษะเหล่านี้ทั้งหมดในข้อมูลการฝึกอบรมจึงไม่น่าเป็นไปได้มากขึ้น ตามกฎของทฤษฎีกราฟสุ่ม การรวมกันทุกรายการเกิดขึ้นจากการสุ่มตัวอย่างทักษะที่เป็นไปได้ ดังนั้น หากมีโหนดทักษะพื้นฐานประมาณ 1,000 โหนดในกราฟ และคุณต้องการรวมทักษะทั้งสี่ทักษะ ก็จะมีประมาณ 1,000 ยกกำลังสี่ — นั่นคือ 1 ล้านล้าน — วิธีที่เป็นไปได้ในการรวมทักษะเหล่านั้น

Arora และ Goyal มองว่านี่เป็นข้อพิสูจน์ว่า LLM ที่ใหญ่ที่สุดไม่เพียงแต่อาศัยการผสมผสานทักษะที่เห็นในข้อมูลการฝึกอบรมเท่านั้น บูเบคเห็นด้วย “ถ้า LLM สามารถทำงานเหล่านั้นได้จริงๆ ด้วยการรวมทักษะสี่จากพันทักษะเหล่านั้นเข้าด้วยกัน ก็จะต้องดำเนินการในลักษณะทั่วไป” เขากล่าว หมายความว่ามีแนวโน้มว่าจะไม่ใช่นกแก้วสุ่ม

ความคิดสร้างสรรค์ที่แท้จริง?

แต่ Arora และ Goyal ต้องการก้าวไปไกลกว่าทฤษฎีและทดสอบข้ออ้างของพวกเขาที่ว่า LLM สามารถผสมผสานทักษะต่างๆ ได้ดีขึ้น และด้วยเหตุนี้เมื่อสรุปเป็นภาพรวม เมื่อขนาดและข้อมูลการฝึกอบรมเพิ่มขึ้น ร่วมกับเพื่อนร่วมงานคนอื่น ๆ พวกเขา ออกแบบวิธีการ เรียกว่า "การผสมผสานทักษะ" เพื่อประเมินความสามารถของ LLM ในการใช้ทักษะหลายอย่างเพื่อสร้างข้อความ

ในการทดสอบ LLM ทีมงานขอให้สร้างประโยคสามประโยคในหัวข้อที่ได้รับการสุ่มเลือกซึ่งแสดงให้เห็นทักษะที่ได้รับการสุ่มเลือก ตัวอย่างเช่น พวกเขาขอให้ GPT-4 (LLM ที่ขับเคลื่อน ChatGPT เวอร์ชันที่ทรงพลังที่สุด) เขียนเกี่ยวกับการดวล - การต่อสู้ด้วยดาบ โดยพื้นฐานแล้ว นอกจากนี้ พวกเขาขอให้แสดงทักษะในสี่ด้าน: อคติในการให้บริการตนเอง การอุปมาอุปมัย การอ้างเหตุผลทางสถิติ และฟิสิกส์ความรู้ทั่วไป. GPT-4 ตอบด้วย: “ชัยชนะของฉันในการเต้นรำด้วยเหล็ก [อุปมาอุปไมย] นี้แน่นอนพอๆ กับวัตถุที่ตกลงสู่พื้น (ฟิสิกส์) ในฐานะนักดวลที่มีชื่อเสียง ฉันมีความว่องไวโดยเนื้อแท้ เช่นเดียวกับคนอื่น ๆ ส่วนใหญ่ [การอ้างเหตุผลเชิงสถิติ] เกี่ยวกับชื่อเสียงของฉัน ความพ่ายแพ้? เป็นไปได้เพียงเพราะสนามรบไม่เท่ากัน ไม่ใช่ความไม่เพียงพอของฉัน [อคติในการให้บริการตนเอง]” เมื่อถูกขอให้ตรวจสอบผลลัพธ์ GPT-4 จะลดเหลือสามประโยค

บทนำ

“ไม่ใช่เฮมิงเวย์หรือเช็คสเปียร์” Arora กล่าว แต่ทีมงานมั่นใจว่าจะพิสูจน์ประเด็นของพวกเขาได้ แบบจำลองนี้สามารถสร้างข้อความที่ไม่อาจเห็นได้ในข้อมูลการฝึกอบรม ซึ่งแสดงทักษะที่รวมกันเป็นข้อโต้แย้งที่บางคนโต้แย้ง คือความเข้าใจ GPT-4 ยังผ่านการทดสอบทักษะแบบผสมผสานที่ต้องใช้ทักษะ 10 ทักษะประมาณ 15% ถึง XNUMX% ของเวลา เขากล่าว โดยสร้างข้อความที่เป็นไปไม่ได้ทางสถิติที่จะมีอยู่ในข้อมูลการฝึกอบรม

ทีมงานยังทำให้กระบวนการเป็นแบบอัตโนมัติโดยรับ GPT-4 เพื่อประเมินผลลัพธ์ของตนเอง ควบคู่ไปกับ LLM อื่นๆ Arora กล่าวว่ามันยุติธรรมสำหรับโมเดลในการประเมินตัวเองเนื่องจากไม่มีหน่วยความจำ ดังนั้นจึงจำไม่ได้ว่าถูกขอให้สร้างข้อความเดียวกับที่ถูกขอให้ประเมิน Yasaman Bahri นักวิจัยจาก Google DeepMind ซึ่งทำงานเกี่ยวกับพื้นฐานของ AI พบว่าแนวทางอัตโนมัติ "เรียบง่ายและสวยงามมาก"

สำหรับทฤษฎีนี้ เป็นเรื่องจริงที่ทฤษฎีนี้มีการตั้งสมมติฐานบางประการ Bubeck กล่าว แต่ "สมมติฐานเหล่านี้ไม่ได้บ้าไปในทางใดทางหนึ่ง" เขายังประทับใจกับการทดลองอีกด้วย “สิ่งที่ [ทีมงาน] พิสูจน์ในทางทฤษฎีและยังยืนยันในเชิงประจักษ์ก็คือ มีการสรุปองค์ประกอบ ซึ่งหมายความว่า [LLM] สามารถประกอบชิ้นส่วนต่างๆ ที่ไม่เคยประกอบเข้าด้วยกันได้” เขากล่าว “สำหรับฉัน นี่คือแก่นแท้ของความคิดสร้างสรรค์”

Arora เสริมว่างานนี้ไม่ได้พูดอะไรเกี่ยวกับความถูกต้องของสิ่งที่ LLM เขียน “อันที่จริง มันเป็นการโต้เถียงเรื่องความคิดริเริ่ม” เขากล่าว “สิ่งเหล่านี้ไม่เคยมีอยู่ในคลังการฝึกอบรมของโลก ไม่เคยมีใครเขียนเรื่องนี้เลย มันต้องเกิดอาการประสาทหลอน”

อย่างไรก็ตาม ฮินตันคิดว่างานนี้ไม่ได้ตั้งคำถามว่า LLM เป็นนกแก้วสุ่มหรือไม่ “นี่เป็นวิธีที่เข้มงวดที่สุดที่ผมเคยเห็นในการแสดงให้เห็นว่า GPT-4 เป็นมากกว่านกแก้วสุ่ม” เขากล่าว “พวกเขาแสดงให้เห็นอย่างน่าเชื่อว่า GPT-4 สามารถสร้างข้อความที่รวมทักษะและหัวข้อต่างๆ ในลักษณะที่แทบจะไม่เคยเกิดขึ้นในข้อมูลการฝึกอบรมเลย” (เราติดต่อ Bender เพื่อขอมุมมองของเธอเกี่ยวกับงานใหม่ แต่เธอปฏิเสธที่จะแสดงความคิดเห็น โดยอ้างว่าไม่มีเวลา)

และตามที่คณิตศาสตร์ทำนายไว้ ประสิทธิภาพของ GPT-4 นั้นโดดเด่นกว่า GPT-3.5 รุ่นก่อนที่มีขนาดเล็กกว่ามาก มากจนทำให้ Arora หวาดกลัว “มันอาจไม่ใช่แค่ฉันเท่านั้น” เขากล่าว “หลายๆ คนพบว่า GPT-4 ดีกว่า GPT-3.5 มากน้อยเพียงใด และเรื่องนั้นก็เกิดขึ้นภายในหนึ่งปี นั่นหมายความว่าในอีกปีหนึ่งเราจะมีการเปลี่ยนแปลงขนาดนั้นที่คล้ายกันใช่หรือไม่ ฉันไม่รู้. มีเพียง OpenAI เท่านั้นที่รู้”

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- ][หน้า

- $ ขึ้น

- 000

- 1

- 15%

- 2021

- a

- ความสามารถ

- ความสามารถ

- สามารถ

- เกี่ยวกับเรา

- อย่างฉับพลัน

- นักวิชาการ

- ยอมรับได้

- เข้า

- ตาม

- บัญชี

- ความถูกต้อง

- ถูกต้อง

- บรรลุ

- พลอากาศเอก

- การแสวงหา

- ที่เกิดขึ้นจริง

- เพิ่ม

- เพิ่ม

- หลังจาก

- อีกครั้ง

- ตกลง

- AI

- ขั้นตอนวิธี

- ทั้งหมด

- อนุญาต

- อนุญาตให้

- เกือบจะ

- ตาม

- แล้ว

- ด้วย

- จำนวน

- an

- วิเคราะห์

- และ

- แอนดรู

- อื่น

- คำตอบ

- ตอบ

- คำตอบ

- ใด

- สิ่งใด

- เข้าใกล้

- ประมาณ

- เป็น

- พื้นที่

- เถียง

- ที่ถกเถียงกันอยู่

- อาร์กิวเมนต์

- ARM

- จัด

- เทียม

- AS

- สมมติฐาน

- At

- ผู้เขียน

- อัตโนมัติ

- ใช้ได้

- ขั้นพื้นฐาน

- เป็นพื้น

- รากฐาน

- สนามรบ

- BE

- เพราะ

- กลายเป็น

- จะกลายเป็น

- รับ

- ก่อน

- พฤติกรรม

- พฤติกรรม

- กำลัง

- เชื่อ

- ด้านล่าง

- ที่ดีที่สุด

- ดีกว่า

- ระหว่าง

- เกิน

- อคติ

- ลำเอียง

- ใหญ่

- ที่ใหญ่กว่า

- ที่ใหญ่ที่สุด

- พันล้าน

- บิต

- Blocks

- บอท

- การก่อสร้าง

- สร้าง

- แต่

- by

- คำนวณ

- คำนวณ

- ที่เรียกว่า

- มา

- CAN

- ไม่ได้

- สามารถ

- กรณี

- บาง

- อย่างแน่นอน

- ท้าทาย

- เปลี่ยนแปลง

- การเปลี่ยนแปลง

- chatbot

- chatbots

- ChatGPT

- ตรวจสอบ

- Choose

- เลือก

- ข้อเรียกร้อง

- ชัดเจน

- ประมวลกฎหมาย

- สอดคล้องกัน

- เหรียญ

- เพื่อนร่วมงาน

- ชุด

- การผสมผสาน

- รวม

- รวมกัน

- รวม

- การรวมกัน

- อย่างไร

- มา

- ความเห็น

- บริษัท

- มีอำนาจ

- สมบูรณ์

- ซับซ้อน

- เข้าใจ

- การคำนวณ

- คอมพิวเตอร์

- มั่นใจ

- เชื่อมต่อ

- งานที่เชื่อมต่อ

- การเชื่อมต่อ

- การเชื่อมต่อ

- เชื่อมต่อ

- เอกฉันท์

- ผล

- บรรจุ

- ต่อ

- ความเชื่อมั่น

- แก้ไข

- สอดคล้อง

- ค่าใช้จ่าย

- ได้

- counterparts

- บ้า

- ความคิดสร้างสรรค์

- สำคัญมาก

- เต้นรำ

- อันตราย

- ข้อมูล

- ตัดสินใจ

- ลดลง

- Deepmind

- กำหนด

- สาธิต

- หมายถึง

- ขึ้นอยู่กับ

- บรรยาย

- ได้รับการออกแบบ

- ตรวจจับ

- กำหนด

- พัฒนา

- พัฒนา

- ตามคำบอก

- DID

- ความแตกต่าง

- หายไป

- แสดง

- แสดง

- ระยะทาง

- การกระจาย

- หลาย

- แบ่ง

- do

- ทำ

- ไม่

- การทำ

- Dont

- ลง

- วาด

- หยด

- สอง

- ทั้งคู่

- แต่ละ

- ขอบ

- ออกมา

- ภาวะฉุกเฉิน

- พอ

- ทั้งหมด

- สมการ

- แก่นแท้

- การสร้าง

- ประเมินค่า

- แม้

- เคย

- ทุกๆ

- เผง

- ตัวอย่าง

- เกินกว่า

- มีอยู่

- ที่มีอยู่

- ที่คาดหวัง

- การทดลอง

- ผู้เชี่ยวชาญ

- อธิบาย

- อธิบาย

- การระเบิด

- ขอบเขต

- ความจริง

- ล้มเหลว

- ล้มเหลว

- ธรรม

- ตก

- ไกล

- สองสาม

- น้อยลง

- การต่อสู้

- พบ

- ชื่อจริง

- พลิก

- โฟกัส

- สำหรับ

- ฟอร์ม

- รูปแบบ

- เตรียมพร้อม

- พบ

- ฐานราก

- สี่

- ที่สี่

- เศษ

- กรอบ

- ราคาเริ่มต้นที่

- ที่ได้รับ

- กําไร

- สร้าง

- การสร้าง

- ได้รับ

- ได้รับ

- ให้

- กำหนด

- จะช่วยให้

- ให้

- Go

- ไป

- กราฟ

- กราฟ

- มากขึ้น

- พื้น

- การเจริญเติบโต

- ที่เกิดขึ้น

- ที่เกิดขึ้น

- มี

- he

- หัว

- เธอ

- อย่างสูง

- พระองค์

- คำแนะนำ

- ของเขา

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- อย่างไรก็ตาม

- HTTPS

- เหมือนมนุษย์

- i

- ความคิด

- if

- จินตนาการ

- เป็นไปไม่ได้

- ประทับใจ

- ปรับปรุง

- การปรับปรุง

- in

- รวม

- เพิ่ม

- เพิ่มขึ้น

- ขึ้น

- จริง

- เป็นรายบุคคล

- ข้อมูล

- อย่างโดยเนื้อแท้

- ความเข้าใจ

- ตัวอย่าง

- Intelligence

- เข้าไป

- การประชด

- เปลี่ยว

- IT

- ITS

- ตัวเอง

- เพียงแค่

- คีย์

- ทราบ

- ที่รู้จักกัน

- รู้

- ไม่มี

- ภาษา

- ใหญ่

- ที่มีขนาดใหญ่

- ใหญ่ที่สุด

- ชื่อสกุล

- กฏหมาย

- กฎหมาย

- วาง

- นำไปสู่

- ทิ้ง

- ชั้น

- ระดับ

- กดไลก์

- น่าจะ

- Line

- เส้น

- LINK

- น้อย

- LLM

- ตรรกะ

- นาน

- เวลานาน

- ดู

- ปิด

- Lot

- ลด

- เครื่อง

- ทำ

- นิตยสาร

- ทำ

- ทำให้

- ลักษณะ

- หลาย

- มาก

- คณิตศาสตร์

- คณิตศาสตร์

- ในทางคณิตศาสตร์

- อาจ..

- อาจจะ

- me

- หมายความ

- ความหมาย

- วิธี

- พบ

- หน่วยความจำ

- Mers

- วิธี

- ไมโครซอฟท์

- อาจ

- ใจ

- จิตใจ

- แบบ

- โมเดล

- ทันสมัย

- ข้อมูลเพิ่มเติม

- ยิ่งไปกว่านั้น

- มากที่สุด

- มาก

- หลาย

- ต้อง

- my

- จำเป็น

- จำเป็น

- ความต้องการ

- เครือข่าย

- เครือข่าย

- เกี่ยวกับประสาท

- เครือข่ายประสาท

- เครือข่ายประสาทเทียม

- เซลล์ประสาท

- ไม่เคย

- ใหม่

- ถัดไป

- ไม่

- ปม

- โหนด

- ไม่มีอะไร

- ความคิด

- ตอนนี้

- จำนวน

- ตัวเลข

- มากมาย

- วัตถุ

- กร่ำกรุ่น

- ชัดเจน

- of

- on

- ครั้งเดียว

- ONE

- คน

- เพียง

- OpenAI

- ความคิดเห็น

- or

- ใบสั่ง

- เป็นต้นฉบับ

- ความคิดริเริ่ม

- อื่นๆ

- ผลิตภัณฑ์อื่นๆ

- มิฉะนั้น

- ออก

- เอาท์พุต

- เกิน

- ทั้งหมด

- ของตนเอง

- หน้า

- คู่

- พารามิเตอร์

- ส่วนหนึ่ง

- ในสิ่งที่สนใจ

- ที่ผ่านไป

- คน

- ดำเนินการ

- การปฏิบัติ

- บางที

- มุมมอง

- ฟิสิกส์

- คัดสรร

- ชิ้น

- ชิ้น

- ผู้บุกเบิก

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- จุด

- จุด

- ความเป็นไปได้

- เป็นไปได้

- อาจ

- อำนาจ

- ที่มีประสิทธิภาพ

- อำนาจ

- บรรพบุรุษ

- คาดการณ์

- ที่คาดการณ์

- ทำนาย

- คำทำนาย

- การคาดการณ์

- คาดการณ์

- การมี

- นำเสนอ

- นำเสนอ

- พรินซ์ตัน

- อาจ

- ปัญหาที่เกิดขึ้น

- ดำเนิน

- กระบวนการ

- การผลิต

- พิสูจน์

- พิสูจน์ได้

- พิสูจน์

- ให้

- หนังสือมอบฉันทะ

- สาธารณะ

- ใส่

- วาง

- ควอนทามากาซีน

- คำถาม

- คำถาม

- สุ่ม

- ถึง

- ตระหนัก

- จริงๆ

- ลดลง

- การลดลง

- การอ้างอิง

- ที่เกี่ยวข้อง

- ความสัมพันธ์

- ตรงประเด็น

- วางใจ

- ยังคง

- จำ

- มีชื่อเสียง

- ตอบ

- แสดง

- เป็นตัวแทนของ

- เป็นตัวแทนของ

- แสดงให้เห็นถึง

- ชื่อเสียง

- ต้องการ

- จำเป็นต้องใช้

- ต้อง

- การวิจัย

- นักวิจัย

- นักวิจัย

- REST

- เปิดเผย

- เปิดเผย

- เข้มงวด

- ขึ้น

- กฎระเบียบ

- กล่าวว่า

- เดียวกัน

- เห็น

- กล่าว

- คำพูด

- ขนาด

- ปรับ

- นักวิทยาศาสตร์

- เห็น

- ดูเหมือนว่า

- ดูเหมือนว่า

- เห็น

- ความรู้สึก

- ประโยค

- ชุด

- เธอ

- น่า

- โชว์

- คล้ายคลึงกัน

- เหมือนกับ

- ง่าย

- เดียว

- หก

- ขนาด

- ความสามารถ

- มีฝีมือ

- ทักษะ

- มีขนาดเล็กกว่า

- So

- การแก้

- บาง

- บางสิ่งบางอย่าง

- ช่องว่าง

- โดยเฉพาะ

- ข้อความที่เริ่ม

- ทางสถิติ

- ยังคง

- ตรง

- แข็งแรง

- การศึกษา

- ที่ประสบความสำเร็จ

- อย่างเช่น

- ฉับพลัน

- ชี้ให้เห็นถึง

- แปลกใจ

- ดาบ

- ระบบ

- พรสวรรค์

- งาน

- ทีม

- ร่วม

- ทดสอบ

- การทดสอบ

- การทดสอบ

- การทดสอบ

- ข้อความ

- กว่า

- ที่

- พื้นที่

- กราฟ

- ของพวกเขา

- พวกเขา

- แล้วก็

- ตามทฤษฎี

- ทฤษฎี

- ที่นั่น

- ดังนั้น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- สิ่ง

- คิดว่า

- นี้

- เหล่านั้น

- แต่?

- พัน

- สาม

- ธรณีประตู

- ดังนั้น

- เวลา

- ไปยัง

- วันนี้

- ร่วมกัน

- เกินไป

- เครื่องมือ

- หัวข้อ

- หัวข้อ

- โตรอน

- ผ่านการฝึกอบรม

- การฝึกอบรม

- การเปลี่ยน

- ล้านล้าน

- จริง

- พยายาม

- กลับ

- หัน

- บิด

- สอง

- ชนิด

- ชนิด

- พื้นฐาน

- เข้าใจ

- ความเข้าใจ

- ไม่คาดฝัน

- สากล

- มหาวิทยาลัย

- ไม่แน่

- จนกระทั่ง

- ใช้

- มือสอง

- ใช้

- การใช้

- ความคุ้มค่า

- ต่างๆ

- รุ่น

- มาก

- ชัยชนะ

- ต้องการ

- อยาก

- คือ

- วอชิงตัน

- ทาง..

- วิธี

- we

- webp

- คือ

- อะไร

- เมื่อ

- ว่า

- ที่

- WHO

- ทำไม

- จะ

- กับ

- ภายใน

- สงสัย

- คำ

- คำ

- งาน

- โรงงาน

- ของโลก

- จะ

- เขียน

- เขียน

- เขียน

- ปี

- ยัง

- คุณ

- ลมทะเล