ไม่ต้องสนใจการใช้โมเดลภาษาขนาดใหญ่ (LLM) เพื่อช่วยเขียนโค้ด Jensen Huang ซีอีโอของ Nvidia เชื่อว่าในอนาคต ซอฟต์แวร์ระดับองค์กรจะเป็นเพียงชุดของแชทบอทที่รวมตัวกันเพื่อทำงานให้สำเร็จ

“ไม่น่าเป็นไปได้ที่คุณจะเขียนมันตั้งแต่เริ่มต้นหรือเขียนโค้ด Python ทั้งหมดหรืออะไรทำนองนั้น” เขากล่าวบนเวทีระหว่าง GTC ประเด็นสำคัญ วันจันทร์. “มีความเป็นไปได้มากที่คุณจะรวมทีม AI”

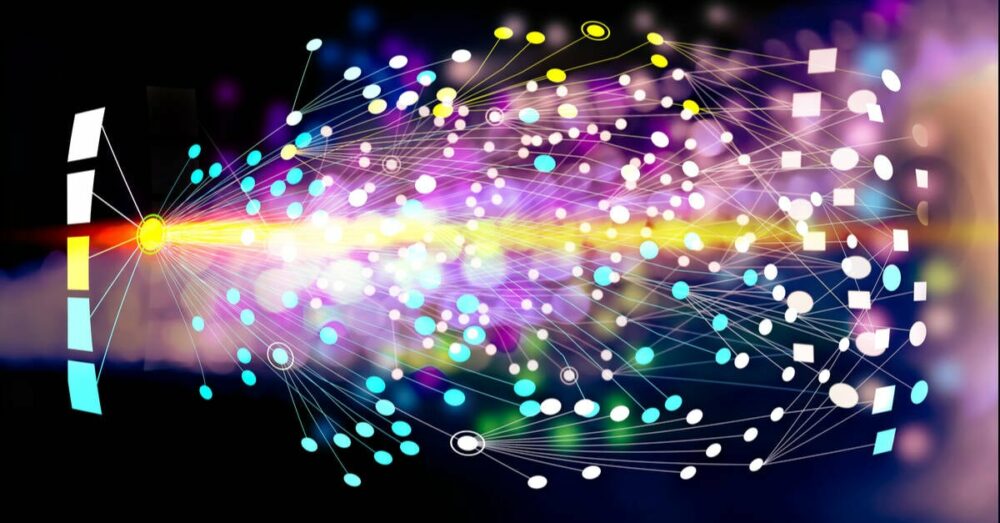

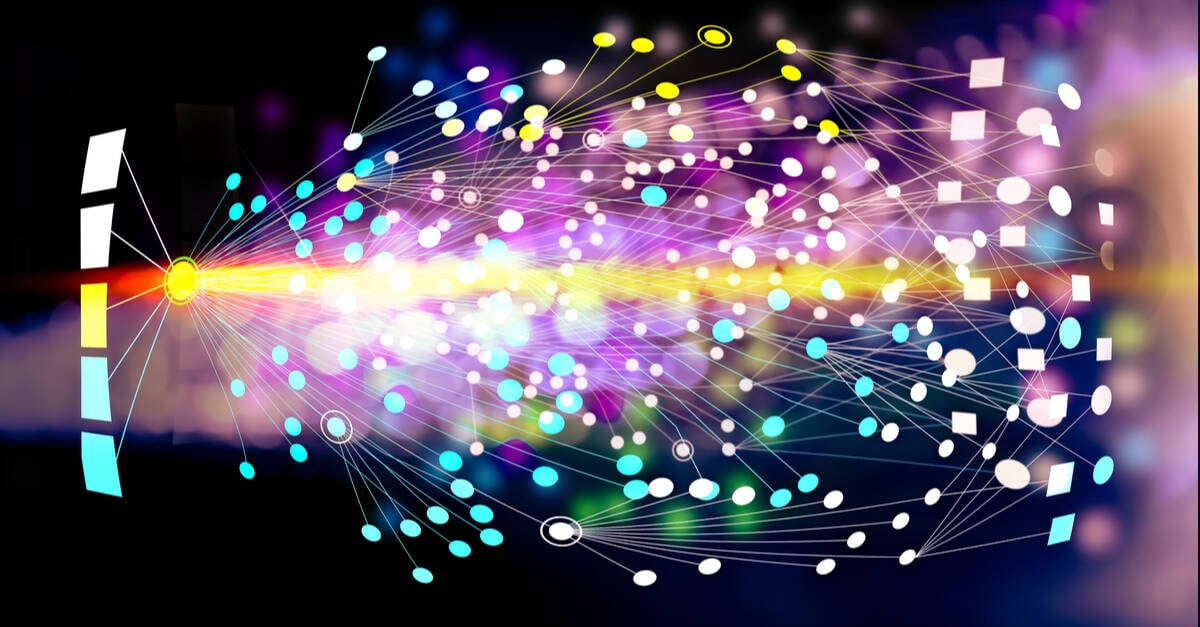

Jensen อธิบายว่าทีม AI นี้อาจรวมโมเดลที่ออกแบบมาเพื่อแยกย่อยและมอบหมายคำขอให้กับโมเดลอื่นๆ โมเดลเหล่านี้บางรุ่นอาจได้รับการฝึกอบรมเพื่อทำความเข้าใจบริการทางธุรกิจ เช่น SAP หรือ Service Now ในขณะที่โมเดลอื่นๆ อาจทำการวิเคราะห์เชิงตัวเลขกับข้อมูลที่จัดเก็บไว้ในฐานข้อมูลเวกเตอร์ ข้อมูลนี้สามารถนำมารวมกันและนำเสนอต่อผู้ใช้โดยใช้โมเดลอื่นได้

“เราสามารถรับรายงานได้ทุกวันหรือทุกๆ ชั่วโมงที่เกี่ยวข้องกับแผนการสร้าง หรือการคาดการณ์ การแจ้งเตือนลูกค้า หรือฐานข้อมูลข้อบกพร่องบางอย่าง หรืออะไรก็ตามที่เกิดขึ้น” เขาอธิบาย

เพื่อเชื่อมโยงโมเดลเหล่านี้ทั้งหมดเข้าด้วยกัน Nvidia กำลังนำหน้าออกจากหนังสือของ Docker และได้สร้างคอนเทนเนอร์รันไทม์สำหรับ AI

เรียกว่า Nvidia Inference Microservices หรือเรียกสั้น ๆ ว่า NIM เหล่านี้เป็นคอนเทนเนอร์อิมเมจที่มีทั้งโมเดล ไม่ว่าจะเป็นโอเพ่นซอร์สหรือกรรมสิทธิ์ พร้อมด้วยการขึ้นต่อกันทั้งหมดที่จำเป็นเพื่อให้มันทำงานได้ โมเดลคอนเทนเนอร์เหล่านี้สามารถนำไปใช้งานกับรันไทม์จำนวนเท่าใดก็ได้ รวมถึงโหนด Kubernetes ที่เร่งด้วย Nvidia

“คุณสามารถปรับใช้บนโครงสร้างพื้นฐานของเราที่เรียกว่า DGX Cloud หรือปรับใช้ในองค์กร หรือปรับใช้ได้ทุกที่ที่คุณต้องการ เมื่อคุณพัฒนามันแล้ว คุณก็สามารถพกพาไปได้ทุกที่” Jensen กล่าว

แน่นอนว่าคุณจะต้องสมัครสมาชิกชุด AI Enterprise ของ Nvidia ก่อน ซึ่งราคาไม่ถูกนักที่ 4,500 เหรียญสหรัฐฯ ต่อปีต่อ GPU หรือ 1 เหรียญต่อชั่วโมงต่อ GPU ในระบบคลาวด์ กลยุทธ์การกำหนดราคานี้ดูเหมือนจะจูงใจระบบที่มีประสิทธิภาพสูงขึ้นโดยทั่วไป เนื่องจากมีต้นทุนเท่ากัน ไม่ว่าคุณจะใช้ L40 หรือ B100s.

หากแนวคิดในการบรรจุปริมาณงานที่เร่งด้วย GPU ฟังดูคุ้นเคย นี่ไม่ใช่แนวคิดใหม่สำหรับ Nvidia CUDA เร่งความเร็วได้แล้ว ได้รับการสนับสนุน บนรันไทม์คอนเทนเนอร์ที่หลากหลาย รวมถึง Docker, Podman, Containerd หรือ CRI-O เป็นเวลาหลายปี และดูเหมือนว่า Container Runtime ของ Nvidia จะไม่ไปไหนเลย

คุณค่าที่อยู่เบื้องหลัง NIM ดูเหมือนว่า Nvidia จะจัดการแพ็คเกจและการเพิ่มประสิทธิภาพของโมเดลเหล่านี้ เพื่อให้มีเวอร์ชันที่ถูกต้องของ CUDA, Triton Inference Server หรือ TensorRT LLM ซึ่งจำเป็นเพื่อให้ได้ประสิทธิภาพที่ดีที่สุด

ข้อโต้แย้งคือหาก Nvidia เปิดตัวการอัปเดตที่ช่วยเพิ่มประสิทธิภาพการอนุมานของรุ่นบางประเภทได้อย่างมาก การใช้ประโยชน์จากฟังก์ชันดังกล่าวก็เพียงแค่ดึงอิมเมจ NIM ล่าสุดออกเท่านั้น

นอกเหนือจากการเพิ่มประสิทธิภาพโมเดลเฉพาะของฮาร์ดแวร์แล้ว Nvidia ยังทำงานเพื่อให้เกิดการสื่อสารที่สอดคล้องกันระหว่างคอนเทนเนอร์ เพื่อให้สามารถสนทนากันผ่านการเรียก API

ตามที่เราเข้าใจ การเรียก API ที่ใช้โดยโมเดล AI ต่างๆ ในตลาดปัจจุบันไม่สอดคล้องกันเสมอไป ส่งผลให้การรวมบางโมเดลเข้าด้วยกันได้ง่ายขึ้น และในขณะที่บางโมเดลอาจต้องมีการทำงานเพิ่มเติม

การให้ความรู้เชิงสถาบันแก่แบบจำลองวัตถุประสงค์ทั่วไป

ใครก็ตามที่เคยใช้แชทบอท AI จะรู้ว่าแม้ว่าพวกเขาจะตอบคำถามความรู้ทั่วไปได้ดี แต่ก็ไม่ได้น่าเชื่อถือที่สุดเสมอไปสำหรับคำขอที่ไม่ชัดเจนหรือทางเทคนิค

เจนเซ่นเน้นย้ำข้อเท็จจริงนี้ในระหว่างการปราศรัยของเขา เมื่อถามเกี่ยวกับโปรแกรมภายในที่ใช้ภายใน Nvidia โมเดลภาษาขนาดใหญ่ Llama 2 70B ของ Meta ก็ไม่น่าแปลกใจเลยที่ให้คำจำกัดความของคำที่ไม่เกี่ยวข้องกัน

แทนที่จะพยายามให้องค์กรต่างๆ ฝึกฝนโมเดลของตนเอง — สิ่งที่จะขาย GPU จำนวนมาก แต่จะจำกัดตลาดที่อยู่ได้อย่างมาก — Nvidia ได้พัฒนาเครื่องมือเพื่อปรับแต่ง NIM ด้วยข้อมูลและกระบวนการของลูกค้า

“เรามีบริการที่เรียกว่า NeMo Microservices ที่ช่วยคุณดูแลจัดการข้อมูล เตรียมข้อมูลเพื่อให้คุณสามารถ... ใช้งาน AI นี้ คุณปรับแต่งมันอย่างละเอียดแล้วคุณก็ป้องกันมัน จากนั้นคุณสามารถประเมิน... ประสิทธิภาพเทียบกับตัวอย่างอื่นๆ ได้” Huang อธิบาย

นอกจากนี้เขายังได้พูดคุยเกี่ยวกับบริการ NeMo Retriever ของ Nvidia ซึ่งมีพื้นฐานมาจากแนวคิดในการใช้การดึงข้อมูลรุ่นเสริม (RAG) เพื่อแสดงข้อมูลที่โมเดลดังกล่าวไม่ได้รับการฝึกอบรมเป็นพิเศษ

แนวคิดนี้คือสามารถโหลดเอกสาร กระบวนการ และข้อมูลอื่นๆ ลงในฐานข้อมูลเวกเตอร์ที่เชื่อมต่อกับโมเดลได้ จากการสืบค้น โมเดลจะสามารถค้นหาฐานข้อมูลนั้น ดึงข้อมูล และสรุปข้อมูลที่เกี่ยวข้องได้

โมเดล NIM และ NeMo Retriever สำหรับการผสานรวม RAG มีวางจำหน่ายแล้วในขณะนี้ ขณะที่ NeMo Microservices อยู่ในช่วงทดลองใช้ก่อนเปิดตัว ®

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ที่มา: https://go.theregister.com/feed/www.theregister.com/2024/03/19/nvidia_why_write_code_when/

- :มี

- :เป็น

- $ ขึ้น

- 7

- a

- เกี่ยวกับเรา

- เร่ง

- การเร่งความเร็ว

- เข้า

- ข้าม

- นอกจากนี้

- เพิ่มเติม

- แอดเดรส

- ความได้เปรียบ

- กับ

- AI

- AI แชทบอท

- โมเดล AI

- เตือนภัย

- ทั้งหมด

- ตาม

- ด้วย

- เสมอ

- an

- การวิเคราะห์

- และ

- อื่น

- ใด

- สิ่งใด

- ทุกแห่ง

- API

- ปรากฏ

- เป็น

- อาร์กิวเมนต์

- รอบ

- AS

- At

- เติม

- ใช้ได้

- ตาม

- BE

- รับ

- หลัง

- กำลัง

- เชื่อ

- ที่ดีที่สุด

- ระหว่าง

- หนังสือ

- ช่วยเพิ่ม

- ทั้งสอง

- บอท

- ทำลาย

- เป็นโรคจิต

- สร้าง

- พวง

- ธุรกิจ

- แต่

- by

- ที่เรียกว่า

- โทร

- CAN

- สามารถรับ

- ผู้บริหารสูงสุด

- บาง

- โซ่

- พูดคุย

- chatbot

- ถูก

- เมฆ

- CO

- รหัส

- ชุด

- รวม

- คมนาคม

- สมบูรณ์

- แนวคิด

- งานที่เชื่อมต่อ

- คงเส้นคงวา

- ภาชนะ

- ภาชนะบรรจุ

- ค่าใช้จ่าย

- คอร์ส

- ที่สร้างขึ้น

- พระสอนศาสนา

- ลูกค้า

- ข้อมูลลูกค้า

- ข้อมูล

- ฐานข้อมูล

- วัน

- คำนิยาม

- การอ้างอิง

- ปรับใช้

- นำไปใช้

- ได้รับการออกแบบ

- พัฒนา

- พัฒนา

- do

- นักเทียบท่า

- เอกสาร

- doesn

- ลง

- เป็นคุ้งเป็นแคว

- ในระหว่าง

- แต่ละ

- ก่อน

- ง่ายดาย

- การเปิดใช้งาน

- ปลาย

- Enterprise

- ซอฟต์แวร์ระดับองค์กร

- ผู้ประกอบการ

- เป็นหลัก

- ทุกๆ

- เผง

- ตัวอย่าง

- อธิบาย

- อธิบาย

- ความจริง

- คุ้นเคย

- ปลาย

- ชื่อจริง

- สำหรับ

- พยากรณ์

- ราคาเริ่มต้นที่

- ฟังก์ชั่น

- อนาคต

- General

- รุ่น

- ได้รับ

- ไป

- ดี

- GPU

- GPUs

- จัดการ

- ที่เกิดขึ้น

- ฮาร์ดแวร์

- มี

- he

- ช่วย

- จะช่วยให้

- โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม

- สูงกว่า

- ไฮไลต์

- ของเขา

- ชั่วโมง

- HTTPS

- Huang

- ความคิด

- if

- ภาพ

- ภาพ

- in

- จูงใจ

- ประกอบด้วย

- รวมทั้ง

- ข้อมูล

- โครงสร้างพื้นฐาน

- สถาบัน

- การบูรณาการ

- ภายใน

- เข้าไป

- ISN

- IT

- ITS

- เซ่นหวาง

- jpg

- เพียงแค่

- ประเด็นสำคัญ

- ทราบ

- ความรู้

- ภาษา

- ใหญ่

- ล่าสุด

- กดไลก์

- น่าจะ

- LIMIT

- ll

- ดูรายละเอียด

- LLM

- ดู

- ดูเหมือน

- Lot

- ตลาด

- อาจ..

- Meta

- microservices

- อาจ

- แบบ

- โมเดล

- วันจันทร์

- มากที่สุด

- จำเป็น

- จำเป็นต้อง

- ใหม่

- โหนด

- ตอนนี้

- จำนวน

- Nvidia

- of

- on

- ออนบอร์ด

- ครั้งเดียว

- เปิด

- โอเพนซอร์ส

- การเพิ่มประสิทธิภาพ

- การเพิ่มประสิทธิภาพ

- or

- อื่นๆ

- ผลิตภัณฑ์อื่นๆ

- ของเรา

- ออก

- ของตนเอง

- บรรจุภัณฑ์

- หน้า

- ต่อ

- ดำเนินการ

- การปฏิบัติ

- แผนการ

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- เปรม

- เตรียมการ

- นำเสนอ

- สวย

- การตั้งราคา

- กระบวนการ

- โครงการ

- ประพจน์

- เป็นเจ้าของ

- ให้

- การดึง

- วัตถุประสงค์

- หลาม

- การสอบถาม

- คำถาม

- เศษผ้า

- RE

- ไม่คำนึงถึง

- สัมพันธ์

- ตรงประเด็น

- น่าเชื่อถือ

- รายงาน

- ขอ

- การร้องขอ

- ต้องการ

- ส่งผลให้

- การแก้ไข

- ขวา

- วิ่ง

- รันไทม์

- s

- กล่าวว่า

- เดียวกัน

- สนามเพลาะ

- รอยขีดข่วน

- ค้นหา

- ดูเหมือน

- ขาย

- เซิร์ฟเวอร์

- บริการ

- บริการ

- สั้น

- เดียว

- So

- ซอฟต์แวร์

- บาง

- บางสิ่งบางอย่าง

- เสียง

- แหล่ง

- โดยเฉพาะ

- เฉพาะ

- ระยะ

- เก็บไว้

- กลยุทธ์

- เชือก

- การสมัครสมาชิก

- ชุด

- สรุป

- พื้นผิว

- ระบบ

- เอา

- การ

- งาน

- ทีม

- วิชาการ

- ระยะ

- ที่

- พื้นที่

- ก้าวสู่อนาคต

- ของพวกเขา

- พวกเขา

- แล้วก็

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- นี้

- ไปยัง

- ในวันนี้

- ร่วมกัน

- เครื่องมือ

- ด้านบน

- รถไฟ

- ผ่านการฝึกอบรม

- ไทรทัน

- พยายาม

- ปรับแต่ง

- ชนิด

- เข้าใจ

- ไม่แน่

- บันทึก

- มือสอง

- ผู้ใช้งาน

- การใช้

- มักจะ

- ความคุ้มค่า

- ความหลากหลาย

- ต่างๆ

- รุ่น

- มาก

- ผ่านทาง

- we

- อะไรก็ตาม

- ว่า

- ที่

- ในขณะที่

- WHO

- ทั้งหมด

- กว้าง

- จะ

- กับ

- ภายใน

- งาน

- การทำงาน

- จะ

- เขียน

- เขียนโค้ด

- ปี

- ยัง

- คุณ

- ของคุณ

- YouTube

- ลมทะเล