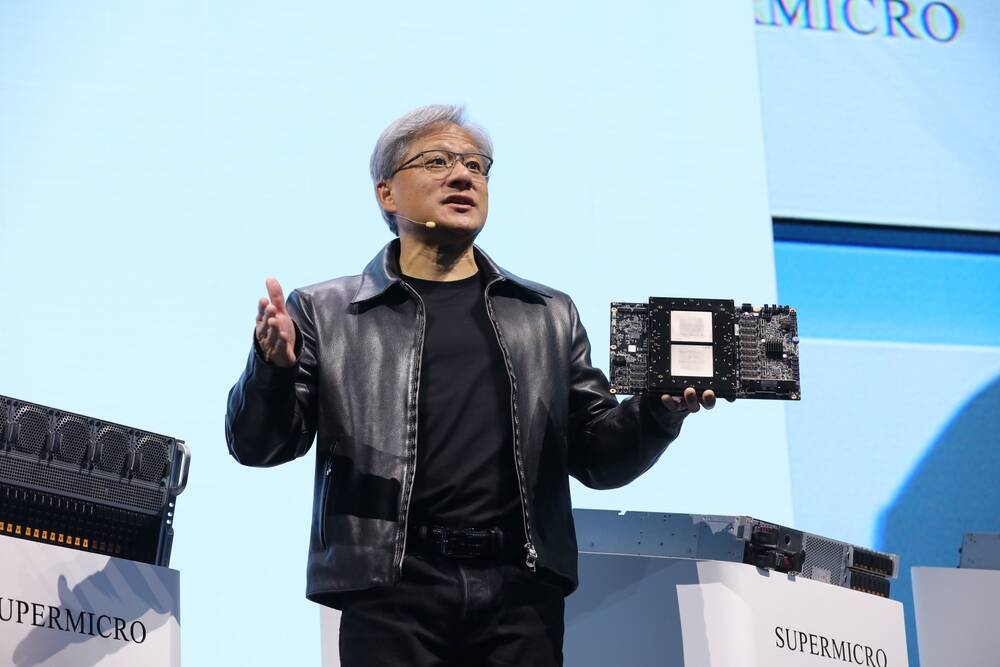

Comment ไตรมาสล่าสุดของ Nvidia ถือเป็นช่วงเวลาสำคัญสำหรับการนำ AI มาใช้

ความต้องการ GPU ของบริษัทยักษ์ใหญ่ด้านเทคโนโลยีผลักดันรายได้ให้สูงขึ้น ความสูงใหม่ในขณะที่องค์กรต่างๆ ผู้ให้บริการคลาวด์ และไฮเปอร์สเกลเลอร์ต่างก็แย่งชิงกันเพื่อให้ยังคงเกี่ยวข้องภายใต้ระเบียบโลก AI ใหม่

แต่ในขณะที่ผู้บริหารของ Nvidia คาดว่าจะดึงกำไรหลายพันล้านดอลลาร์จากความต้องการนี้ในอีกไม่กี่ไตรมาสข้างหน้า คำถามที่อยู่ในใจของหลาย ๆ คนก็คือ Nvidia และพันธมิตรสามารถสร้าง GPU เพียงพอต่อความต้องการได้จริงหรือไม่ และจะเกิดอะไรขึ้นหากไม่สามารถทำได้

ในการโทรกับนักวิเคราะห์ทางการเงิน Colette Kress CFO ของ Nvidia มั่นใจ Wall Street ที่ยักษ์ใหญ่ด้านโปรเซสเซอร์กราฟิกทำงานอย่างใกล้ชิดกับพันธมิตรเพื่อลดเวลาการทำงานและเพิ่มความสามารถในการจัดหา เมื่อกดดันให้ต้องการข้อมูลเฉพาะเจาะจง Kress หลบเลี่ยงคำถามซ้ำแล้วซ้ำอีก โดยอ้างว่าอุปกรณ์ของ Nv เกี่ยวข้องกับซัพพลายเออร์จำนวนมาก เป็นการยากที่จะบอกว่าพวกเขาจะสามารถรองรับกำลังการผลิตได้มากเพียงใดและเมื่อใด

ไฟแนนเชียลไทมส์ รายงานในขณะเดียวกัน แนะนำให้ Nvidia วางแผนอย่างน้อยที่สุดจะเพิ่มการผลิตตัวเร่ง H100 รุ่นท็อปสามเท่าในปี 2024 เป็นระหว่าง 1.5 ถึง 2 ล้านหน่วย เพิ่มขึ้นจากประมาณครึ่งล้านในปีนี้ แม้ว่านี่จะเป็นข่าวดีสำหรับผลกำไรของ Nvidia แต่หากเป็นจริง บางบริษัทก็ไม่รอให้ Nvidia ตามทัน และมองหาสถาปัตยกรรมทางเลือกแทน

ความต้องการที่ไม่ได้รับการตอบสนองทำให้เกิดโอกาส

หนึ่งในตัวอย่างที่น่าสนใจที่สุดคือ United Arab Emirates G42 Cloud ซึ่ง เคาะ Cerebras Systems จะสร้างซูเปอร์คอมพิวเตอร์ AI เก้าเครื่องที่มีความสามารถรวม 36 exaflops ของประสิทธิภาพ FP16 แบบเบาบางในราคาเพียง 100 ล้านเหรียญสหรัฐต่อชิ้น

เซบราส เร่ง แตกต่างอย่างมากจาก GPU ที่ขับเคลื่อนระบบ HGX และ DGX ของ Nvidia แทนที่จะบรรจุ GPU สี่หรือแปดตัวลงในแชสซีแบบติดตั้งบนแร็ค ตัวเร่งความเร็วของ Cerebra นั้นเป็นแผ่นซิลิคอนขนาดมหึมาขนาดจานอาหารเย็นที่บรรจุแกน 850,000 คอร์และ SRAM ขนาด 40GB ผู้ผลิตชิปอ้างว่าต้องใช้ตัวเร่งความเร็วเพียง 16 ตัวเพื่อให้ได้ประสิทธิภาพ FP1 ที่กระจัดกระจาย 16 exaflop ซึ่งเป็นความสำเร็จที่เราประมาณการว่าต้องใช้ Nvidia H500 มากกว่า 100 ตัว

และสำหรับคนอื่นๆ ที่เต็มใจที่จะออกไปผจญภัยนอกสวนที่มีกำแพงล้อมรอบของ Nvidia ก็ไม่มีทางเลือกอื่นขาดแคลน ล่าสุดที่เราได้ยินมาคืออเมซอน การใช้ ตัวเร่งการฝึกอบรม Gaudi AI ของ Intel เพื่อเสริมชิป Trainium แบบกำหนดเองของตัวเอง แม้ว่าจะยังไม่ชัดเจนว่ามีปริมาณเท่าใด

เมื่อเปรียบเทียบกับ A100 ของ Nvidia โปรเซสเซอร์ Gaudi2 ของ Intel ซึ่ง เปิดตัว เมื่อเดือนพฤษภาคมปีที่แล้ว อ้างว่ามีประสิทธิภาพมากกว่าประมาณสองเท่า อย่างน้อยก็ในรูปแบบการจัดหมวดหมู่ภาพ ResNet-50 และโมเดลการประมวลผลภาษาธรรมชาติของ BERT และสำหรับผู้ที่อยู่ในประเทศจีนนั้น Intel เมื่อเร็ว ๆ นี้ แนะนำ ชิปรุ่นที่ตัดจำหน่ายในภูมิภาค Intel คาดว่าจะเปิดตัวโปรเซสเซอร์เวอร์ชันที่ทรงพลังยิ่งขึ้น ซึ่งคาดการณ์ว่าเรียกว่า Gaudi3 เพื่อแข่งขันกับ H100 รุ่นปัจจุบันของ Nvidia ในปีหน้า

แน่นอนว่า มี AMD ผู้ซึ่งได้รับชัยชนะอย่างสูงในวงการซูเปอร์คอมพิวเตอร์มาโดยตลอด และได้หันความสนใจไปที่ตลาด AI

ที่งาน Datacenter และ AI ในเดือนมิถุนายน AMD รายละเอียด Instinct MI300X ซึ่งมีกำหนดจะเริ่มจัดส่งภายในสิ้นปีนี้ ตัวเร่งความเร็วบรรจุหน่วยความจำ HBM192 ความเร็ว 3GB และ GPU CDNA 3 แปดตัวไว้ในแพ็คเกจเดียว

ไซต์น้องสาวของเรา แพลตฟอร์มถัดไป ประมาณการ ชิปจะให้ประสิทธิภาพ FP3 ประมาณ 8 petaflops ในขณะที่ 75 เปอร์เซ็นต์ของ H100 ของ Nvidia ในแง่ของประสิทธิภาพ MI300X มีความจุหน่วยความจำสูงกว่า 2.4 เท่า ซึ่งอาจทำให้ลูกค้าไม่ต้องใช้ GPU น้อยลงในการฝึกโมเดลของพวกเขา

ความคาดหวังของ GPU ที่ไม่เพียงแต่สามารถมอบประสิทธิภาพที่น่าสนใจเท่านั้น แต่ยังทำให้คุณทำได้อีกด้วย ซื้อจริงเห็นได้ชัดว่ากระตุ้นความสนใจบางอย่าง ในระหว่างการรายงานผลประกอบการไตรมาสที่ 2 ของ AMD ในเดือนนี้ CEO Lisa Su Boasted การมีส่วนร่วมด้าน AI ของบริษัทเพิ่มขึ้นเจ็ดเท่าในระหว่างไตรมาสดังกล่าว “เฉพาะในศูนย์ข้อมูล เราคาดว่าตลาดสำหรับเครื่องเร่งความเร็ว AI จะมีมูลค่าสูงถึง 150 พันล้านดอลลาร์ภายในปี 2027” เธอกล่าว

อุปสรรคในการรับเลี้ยงบุตรบุญธรรม

ดังนั้นหาก Nvidia คิดว่าตอนนี้กำลังตอบสนองความต้องการเพียงหนึ่งในสามของซิลิคอนที่เน้น AI ทำไมคู่แข่งจึงไม่ก้าวเข้ามาเติมเต็มช่องว่างและเงินสดจากการโฆษณาเกินจริง?

ปัญหาที่ชัดเจนที่สุดคือเรื่องจังหวะเวลา ทั้ง AMD และ Intel จะไม่มีตัวเร่งความเร็วที่สามารถท้าทาย H100 ของ Nvidia อย่างน้อยก็ในแง่ของประสิทธิภาพและพร้อมสำหรับเดือน อย่างไรก็ตาม แม้หลังจากนั้น ลูกค้าก็ยังคงต้องต่อสู้กับซอฟต์แวร์ที่ยังไม่บรรลุนิติภาวะ

มีความจริงที่ว่าคู่แข่งของ Nvidia จะต่อสู้เพื่ออุปทานและกำลังการผลิตเดียวกันกับที่ Nv ต้องการรักษาความปลอดภัยหรือได้รับความปลอดภัยแล้ว ตัวอย่างเช่น เอเอ็มดี ต้องอาศัย TSMC เช่นเดียวกับที่ Nvidia ทำเพื่อการผลิตชิป แม้ว่าความต้องการเซมิคอนดักเตอร์ อยู่ในภาวะตกต่ำ เนื่องจากมีคนสนใจที่จะหยิบพีซี โทรศัพท์ และอื่นๆ น้อยลงในช่วงหลังๆ นี้ จึงมีความต้องการอย่างมากสำหรับตัวเร่งความเร็วเซิร์ฟเวอร์เพื่อฝึกฝนโมเดลและขับเคลื่อนแอปพลิเคชันการเรียนรู้ของเครื่อง

แต่กลับมาที่โค้ด: ระบบนิเวศฮาร์ดแวร์และซอฟต์แวร์ที่ใกล้ชิดของ Nvidia มีมานานหลายปีแล้ว ด้วยเหตุนี้ จึงมีโค้ดจำนวนมาก รวมถึงโมเดล AI ที่ได้รับความนิยมสูงสุดจำนวนมาก ซึ่งได้รับการปรับให้เหมาะกับเฟรมเวิร์ก CUDA ที่ครองอุตสาหกรรมของ Nv

ไม่ได้หมายความว่าบริษัทชิปคู่แข่งไม่ได้พยายามเปลี่ยนแปลงไดนามิกนี้ OneAPI ของ Intel มีเครื่องมือเพื่อช่วยเหลือผู้ใช้ แปลง รหัสที่เขียนสำหรับ CUDA ของ Nvidia ถึง SYCL ซึ่งสามารถทำงานบนชุดแพลตฟอร์ม AI ของ Intel มีความพยายามที่คล้ายกันในการแปลงปริมาณงาน CUDA ให้ทำงานบนตระกูล Instinct GPU ของ AMD โดยใช้ HIP API

ผู้ผลิตชิปเดียวกันหลายรายยังขอความช่วยเหลือจากบริษัทอย่าง Hugging Face ซึ่งพัฒนาเครื่องมือสำหรับการสร้างแอป ML เพื่อลดอุปสรรคในการใช้งานโมเดลยอดนิยมบนฮาร์ดแวร์ของตน การลงทุนเหล่านี้ ล่าสุดทำให้การประเมินมูลค่าของ Hugging มีมูลค่ามากกว่า 4 พันล้านดอลลาร์

ชุดชิปอื่นๆ เช่น Cerebras ได้มองข้ามปัญหานี้โดยการพัฒนาโมเดล AI แบบกำหนดเองสำหรับฮาร์ดแวร์ ซึ่งลูกค้าสามารถใช้ประโยชน์ได้ แทนที่จะต้องเริ่มต้นจากศูนย์ ย้อนกลับไปในเดือนมีนาคม เซเรบราส ประกาศ Cerebras-GPT คือชุดของ LLM เจ็ดรายการที่มีขนาดพารามิเตอร์ตั้งแต่ 111 ล้านถึง 13 พันล้าน

สำหรับลูกค้าด้านเทคนิคที่มีทรัพยากรในการพัฒนา เพิ่มประสิทธิภาพ หรือย้ายโค้ดเดิมไปยังสถาปัตยกรรมที่ใหม่กว่าและยังไม่บรรลุนิติภาวะ การเลือกใช้แพลตฟอร์มฮาร์ดแวร์สำรองอาจคุ้มค่ากับการประหยัดต้นทุนหรือลดเวลาในการผลิตลง ทั้ง Google และ Amazon ได้ใช้เส้นทางนี้แล้วด้วยตัวเร่งความเร็ว TPU และ Trainium ตามลำดับ

อย่างไรก็ตาม สำหรับผู้ที่ขาดทรัพยากรเหล่านี้ การเปิดรับโครงสร้างพื้นฐานโดยไม่มีชุดซอฟต์แวร์ที่ได้รับการพิสูจน์แล้ว ไม่ว่าจะมีประสิทธิภาพเพียงใด ก็อาจถูกมองว่าเป็นความรับผิดชอบ ในกรณีนั้น Nvidia น่าจะยังคงเป็นเดิมพันที่ปลอดภัย ®

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- PlatoData.Network Vertical Generative Ai เพิ่มพลังให้กับตัวเอง เข้าถึงได้ที่นี่.

- เพลโตไอสตรีม. Web3 อัจฉริยะ ขยายความรู้ เข้าถึงได้ที่นี่.

- เพลโตESG. ยานยนต์ / EVs, คาร์บอน, คลีนเทค, พลังงาน, สิ่งแวดล้อม แสงอาทิตย์, การจัดการของเสีย. เข้าถึงได้ที่นี่.

- เพลโตสุขภาพ เทคโนโลยีชีวภาพและข่าวกรองการทดลองทางคลินิก เข้าถึงได้ที่นี่.

- ChartPrime. ยกระดับเกมการซื้อขายของคุณด้วย ChartPrime เข้าถึงได้ที่นี่.

- BlockOffsets การปรับปรุงการเป็นเจ้าของออฟเซ็ตด้านสิ่งแวดล้อมให้ทันสมัย เข้าถึงได้ที่นี่.

- ที่มา: https://go.theregister.com/feed/www.theregister.com/2023/08/29/nvidia_q2_ai_market/

- :มี

- :เป็น

- :ไม่

- :ที่ไหน

- $ 100 ล้าน

- $ ขึ้น

- 000

- 1

- 13

- 16

- 2024

- 36

- 500

- 7

- 75

- a

- สามารถ

- คันเร่ง

- เร่ง

- บรรลุ

- จริง

- เพิ่ม

- ที่อยู่

- การนำมาใช้

- หลังจาก

- AI

- โมเดล AI

- การฝึกอบรม AI

- ทั้งหมด

- อนุญาต

- คนเดียว

- แล้ว

- ด้วย

- ทางเลือก

- ทางเลือก

- อเมซอน

- เอเอ็มดี

- an

- นักวิเคราะห์

- และ

- API

- การใช้งาน

- ปพลิเคชัน

- อาหรับ

- อาหรับเอมิเรตส์

- เป็น

- รอบ

- AS

- At

- ความสนใจ

- ไป

- กลับ

- อุปสรรค

- BE

- หมี

- รับ

- เดิมพัน

- ระหว่าง

- เกิน

- พันล้าน

- ทั้งสอง

- ด้านล่าง

- นำมาซึ่ง

- สร้าง

- การก่อสร้าง

- แต่

- by

- โทรศัพท์

- ที่เรียกว่า

- CAN

- สามารถ

- ความจุ

- กรณี

- เงินสด

- จับ

- ผู้บริหารสูงสุด

- ซีเอฟโอ

- ท้าทาย

- เปลี่ยนแปลง

- สาธารณรัฐประชาชนจีน

- ชิป

- ชิป

- ข้อเรียกร้อง

- การเรียกร้อง

- การจัดหมวดหมู่

- ชัดเจน

- อย่างเห็นได้ชัด

- ปิดหน้านี้

- อย่างใกล้ชิด

- เมฆ

- CO

- รหัส

- ชุด

- รวม

- บริษัท

- บริษัท

- จับใจ

- แข่งขัน

- แปลง

- ราคา

- ประหยัดค่าใช้จ่าย

- ได้

- คอร์ส

- ประเพณี

- ลูกค้า

- ตัด

- วงจร

- ศูนย์ข้อมูล

- การกำหนด

- ส่งมอบ

- ความต้องการ

- ที่กำลังพัฒนา

- พัฒนา

- ต่าง

- ยาก

- ทำ

- ดอลลาร์

- ลง

- ในระหว่าง

- พลวัต

- รายได้

- คาดผลประกอบการเรียก

- ระบบนิเวศ

- ความพยายาม

- อื่น

- กอด

- เอมิเรต

- ปลาย

- การนัดหมาย

- มหาศาล

- พอ

- ผู้ประกอบการ

- ประมาณการ

- แม้

- เหตุการณ์

- ทุกคน

- เอ็กซฟลอป

- ตัวอย่าง

- ตัวอย่าง

- ผู้บริหาร

- คาดหวัง

- ที่คาดหวัง

- สารสกัด

- ใบหน้า

- ความจริง

- ครอบครัว

- ความสำเร็จ

- น้อยลง

- ศึก

- ใส่

- ทางการเงิน

- ไทม์ทางการเงิน

- สำหรับ

- สี่

- กรอบ

- ราคาเริ่มต้นที่

- FT

- กําไร

- ช่องว่าง

- สวนหย่อม

- เกียร์

- ได้รับ

- ยักษ์

- ไป

- GPU

- GPUs

- กราฟิก

- ยิ่งใหญ่

- เจริญเติบโต

- มี

- ครึ่ง

- ที่เกิดขึ้น

- ฮาร์ดแวร์

- มี

- มี

- ได้ยิน

- ช่วย

- ประวัติดี

- สูงกว่า

- บ้าน

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- อย่างไรก็ตาม

- HTTPS

- hype

- if

- ภาพ

- การจำแนกรูปภาพ

- in

- รวมถึง

- รวมทั้ง

- โครงสร้างพื้นฐาน

- แทน

- อินเทล

- อยากเรียนรู้

- สนใจ

- เข้าไป

- ร่วมมือ

- ISN

- ปัญหา

- IT

- ITS

- jpg

- มิถุนายน

- เพียงแค่

- ถัก

- ฉลาก

- ไม่มี

- ภาษา

- ชื่อสกุล

- ล่าสุด

- เปิดตัว

- นำ

- การเรียนรู้

- น้อยที่สุด

- มรดก

- น้อยลง

- เลฟเวอเรจ

- ความรับผิดชอบ

- กดไลก์

- น่าจะ

- Line

- มอง

- ที่ต้องการหา

- Lot

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- การผลิต

- หลาย

- มีนาคม

- โดดเด่น

- ตลาด

- เรื่อง

- เป็นผู้ใหญ่

- อาจ..

- ในขณะเดียวกัน

- หน่วยความจำ

- Mers

- ล้าน

- จิตใจ

- ขั้นต่ำ

- ML

- แบบ

- โมเดล

- ขณะ

- เดือน

- เดือน

- ข้อมูลเพิ่มเติม

- มากที่สุด

- เป็นที่นิยม

- MOUNT

- มาก

- โดยธรรมชาติ

- ประมวลผลภาษาธรรมชาติ

- ค่า

- ใหม่

- ข่าว

- ถัดไป

- ไม่

- ทางทิศเหนือ

- ตอนนี้

- NV

- Nvidia

- ชัดเจน

- of

- เสนอ

- on

- เพียง

- การปรับให้เหมาะสม

- การเพิ่มประสิทธิภาพ

- or

- ใบสั่ง

- ผลิตภัณฑ์อื่นๆ

- ของเรา

- ออก

- เกิน

- ของตนเอง

- แพ็คเกจ

- แพ็ค

- พารามิเตอร์

- ในสิ่งที่สนใจ

- พาร์ทเนอร์

- เครื่องคอมพิวเตอร์

- คน

- เปอร์เซ็นต์

- การปฏิบัติ

- โทรศัพท์

- ชิ้น

- แผน

- เวที

- แพลตฟอร์ม

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- ยอดนิยม

- ที่มีศักยภาพ

- อำนาจ

- ที่มีประสิทธิภาพ

- การประมวลผล

- หน่วยประมวลผล

- โปรเซสเซอร์

- การผลิต

- โอกาส

- ที่พิสูจน์แล้ว

- ผู้ให้บริการ

- Q2

- หนึ่งในสี่

- คำถาม

- ตั้งแต่

- ค่อนข้าง

- มาถึง

- พร้อม

- เมื่อเร็ว ๆ นี้

- เมื่อเร็ว ๆ นี้

- ลด

- ลดลง

- ภูมิภาค

- ตรงประเด็น

- ยังคง

- ซ้ำแล้วซ้ำเล่า

- ต้องการ

- จำเป็นต้องใช้

- แหล่งข้อมูล

- ตามลำดับ

- ผล

- รายได้

- ขวา

- คู่แข่ง

- คู่แข่ง

- ลวก

- เส้นทาง

- วิ่ง

- วิ่ง

- s

- ปลอดภัย

- กล่าวว่า

- การขาย

- เดียวกัน

- เงินออม

- กล่าว

- รอยขีดข่วน

- ปลอดภัย

- ปลอดภัย

- เห็น

- สารกึ่งตัวนำ

- เจ็ด

- หลาย

- เธอ

- การส่งสินค้า

- ความขาดแคลน

- ด้าน

- สำคัญ

- ซิลิคอน

- คล้ายคลึงกัน

- เดียว

- น้องสาว

- เว็บไซต์

- ขนาด

- So

- ซอฟต์แวร์

- บาง

- ช่องว่าง

- เฉพาะ

- ความเร็ว

- กอง

- เริ่มต้น

- เข้าพัก

- ขั้นตอน

- ก้าว

- ยังคง

- ถนน

- เชือก

- ชุด

- ซูเปอร์คอมพิวเตอร์

- เสริม

- ซัพพลายเออร์

- จัดหาอุปกรณ์

- ระบบ

- เทคโนโลยี

- วิชาการ

- เงื่อนไขการใช้บริการ

- กว่า

- ที่

- พื้นที่

- ของพวกเขา

- แล้วก็

- ที่นั่น

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- พวกเขา

- คิดว่า

- ที่สาม

- นี้

- ในปีนี้

- เหล่านั้น

- แต่?

- ครั้ง

- ระยะเวลา

- ยักษ์

- ไปยัง

- เครื่องมือ

- รถไฟ

- การฝึกอบรม

- ทริปเปิ

- จริง

- ทีเอสเอ็มซี

- หัน

- สองครั้ง

- ภายใต้

- พร้อมใจกัน

- สหรัฐอาหรับ

- สหรัฐอาหรับเอมิเรตส์

- หน่วย

- ผู้ใช้

- การใช้

- การประเมินค่า

- บริษัท ร่วมทุน

- รุ่น

- ไดรฟ์

- ที่รอ

- ผนัง

- Wall Street

- มีกำแพงล้อมรอบ

- ต้องการ

- คือ

- we

- อะไร

- เมื่อ

- ว่า

- ที่

- ในขณะที่

- ทำไม

- จะ

- เต็มใจ

- ชนะ

- กับ

- ไม่มี

- การทำงาน

- โลก

- คุ้มค่า

- จะ

- เขียน

- ปี

- ปี

- คุณ

- ลมทะเล