เพื่อดับความกระหายของ AI และโมเดลแมชชีนเลิร์นนิงที่ใหญ่ขึ้นกว่าเดิม Tesla ได้เปิดเผยรายละเอียดมากมายที่ Hot Chips 34 เกี่ยวกับสถาปัตยกรรมซูเปอร์คอมพิวเตอร์แบบกำหนดเองที่เรียกว่า Dojo

โดยพื้นฐานแล้วระบบนี้เป็นซูเปอร์คอมพิวเตอร์ที่ประกอบได้ขนาดใหญ่ แม้ว่าจะแตกต่างจากที่เราเห็นใน สูงสุด 500สร้างขึ้นจากสถาปัตยกรรมแบบกำหนดเองทั้งหมดที่ครอบคลุมซิลิคอนการประมวลผล เครือข่าย และอินพุต/เอาต์พุต (I/O) ไปจนถึงสถาปัตยกรรมชุดคำสั่ง (ISA) การจ่ายพลังงาน บรรจุภัณฑ์ และการระบายความร้อน ทั้งหมดนี้ทำขึ้นโดยมีจุดประสงค์ที่ชัดเจนในการรันอัลกอริธึมการฝึกอบรมแมชชีนเลิร์นนิงเฉพาะตามขนาดที่ต้องการ

“การประมวลผลข้อมูลในโลกแห่งความเป็นจริงทำได้ผ่านเทคนิคการเรียนรู้ของเครื่องเท่านั้น ไม่ว่าจะเป็นการประมวลผลภาษาธรรมชาติ การขับรถบนถนนที่สร้างขึ้นเพื่อการมองเห็นของมนุษย์ไปจนถึงหุ่นยนต์ที่เชื่อมต่อกับสภาพแวดล้อมในชีวิตประจำวัน” Ganesh Venkataramanan ผู้อำนวยการอาวุโสด้านวิศวกรรมฮาร์ดแวร์ของ Tesla กล่าว ในระหว่างการกล่าวปาฐกถาพิเศษ

อย่างไรก็ตาม เขาแย้งว่าวิธีการดั้งเดิมสำหรับการปรับขนาดปริมาณงานแบบกระจายนั้นไม่สามารถเร่งความเร็วได้ในอัตราที่จำเป็นเพื่อให้ทันกับความต้องการของแมชชีนเลิร์นนิง ผลที่ตามมาก็คือ กฎของมัวร์ไม่ได้ตัดมันออกไป และไม่มีระบบใดที่พร้อมสำหรับการฝึกอบรม AI/ML ในปริมาณมาก กล่าวคือ การรวมกันของ CPU/GPU หรือในสถานการณ์ที่ไม่ค่อยเกิดขึ้นโดยใช้ตัวเร่ง AI แบบพิเศษ

“ตามเนื้อผ้าเราสร้างชิป เราใส่มันลงในแพ็คเกจ แพ็คเกจไปบน PCB ซึ่งเข้าสู่ระบบ ระบบเข้าไปในชั้นวาง” Venkataramanan กล่าว ปัญหาคือทุกครั้งที่ข้อมูลย้ายจากชิปไปยังแพ็คเกจและออกจากแพ็คเกจ จะทำให้เวลาในการตอบสนองและแบนด์วิธลดลง

แซนวิชศูนย์ข้อมูล

ดังนั้นเพื่อหลีกเลี่ยงข้อจำกัด Venkataramanan และทีมของเขาจึงเริ่มต้นใหม่ตั้งแต่ต้น

“จากการสัมภาษณ์ของฉันกับ Elon เขาถามฉันว่าคุณทำอะไรได้บ้างที่แตกต่างจาก CPU และ GPU สำหรับ AI ฉันรู้สึกว่าทั้งทีมยังคงตอบคำถามนั้นอยู่”

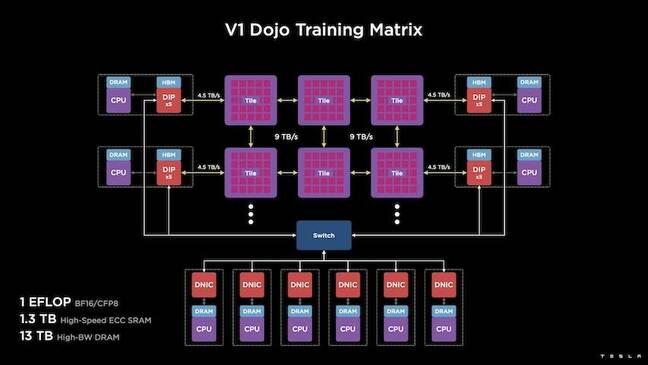

สิ่งนี้นำไปสู่การพัฒนาของไทล์การฝึกอบรม Dojo ซึ่งเป็นคลัสเตอร์การประมวลผลในตัวซึ่งมีขนาดครึ่งลูกบาศก์ฟุตที่มีความสามารถ 556 TFLOPS ของประสิทธิภาพ FP32 ในแพ็คเกจระบายความร้อนด้วยของเหลวขนาด 15kW

แต่ละไทล์มี SRAM 11GB และเชื่อมต่อผ่านแฟบริก 9TB/s โดยใช้โปรโตคอลการขนส่งแบบกำหนดเองทั่วทั้งสแต็ก

Venkataramanan กล่าวว่า "ไทล์การฝึกอบรมนี้แสดงถึงการผสานรวมที่ไม่มีใครเทียบได้จากคอมพิวเตอร์ไปยังหน่วยความจำ การส่งพลังงาน การสื่อสาร โดยไม่ต้องใช้สวิตช์เพิ่มเติม

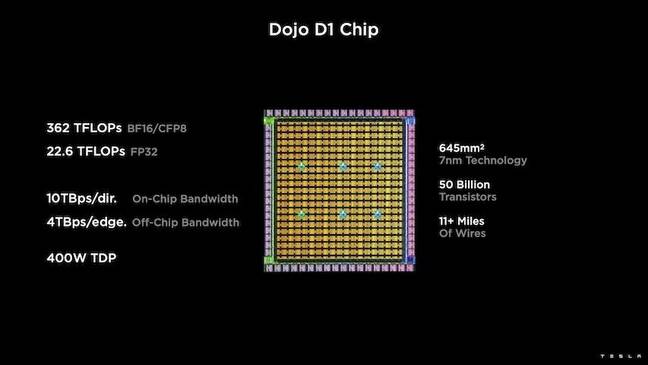

หัวใจของไทล์การฝึกอบรมคือ D1 ของเทสลาซึ่งมีทรานซิสเตอร์ 50 พันล้านตายโดยอิงตามกระบวนการ 7nm ของ TSMC Tesla กล่าวว่า D1 แต่ละตัวมีความสามารถ 22 TFLOPS ของ FP32 ที่ TDP 400W อย่างไรก็ตาม Tesla ตั้งข้อสังเกตว่าชิปสามารถเรียกใช้การคำนวณจุดลอยตัวได้หลากหลายรวมถึงการคำนวณแบบกำหนดเองสองสามรายการ

“ถ้าคุณเปรียบเทียบทรานซิสเตอร์กับสี่เหลี่ยมมิลลิเมตร นี่อาจเป็นจุดเดือดของทุกสิ่งที่อยู่ข้างนอกนั้น” Venkataramanan กล่าว

จากนั้นเทสลาก็นำ D25 จำนวน 1 ลำมารวมเข้าด้วยกันเพื่อหาแม่พิมพ์ที่ดีที่ทราบ จากนั้นจึงบรรจุโดยใช้เทคโนโลยี system-on-wafer ของ TSMC เพื่อ "บรรลุการรวมการประมวลผลจำนวนมากในเวลาแฝงที่ต่ำมากและแบนด์วิดท์ที่สูงมาก" เขากล่าว

อย่างไรก็ตาม การออกแบบระบบบนเวเฟอร์และสถาปัตยกรรมแบบเรียงซ้อนในแนวตั้งทำให้เกิดความท้าทายในการจัดหาพลังงาน

ตาม Venkataramanan เครื่องเร่งความเร็วส่วนใหญ่ในปัจจุบันวางพลังงานไว้ติดกับซิลิกอนโดยตรง และในขณะที่ได้รับการพิสูจน์แล้ว วิธีการนี้หมายถึงพื้นที่ขนาดใหญ่ของคันเร่งจะต้องทุ่มเทให้กับส่วนประกอบเหล่านั้น ซึ่งทำให้ Dojo ใช้งานไม่ได้ เขาอธิบาย เทสลาออกแบบชิปของพวกเขาเพื่อส่งพลังงานโดยตรงผ่านด้านล่างของดาย

วางมันทั้งหมดเข้าด้วยกัน

“เราสามารถสร้างดาต้าเซ็นเตอร์ทั้งหมดหรือทั้งอาคารจากไทล์การฝึกอบรมนี้ได้ แต่ไทล์การฝึกอบรมเป็นเพียงส่วนประมวลผล เราต้องให้อาหารมันด้วย” Venkataramanan กล่าว

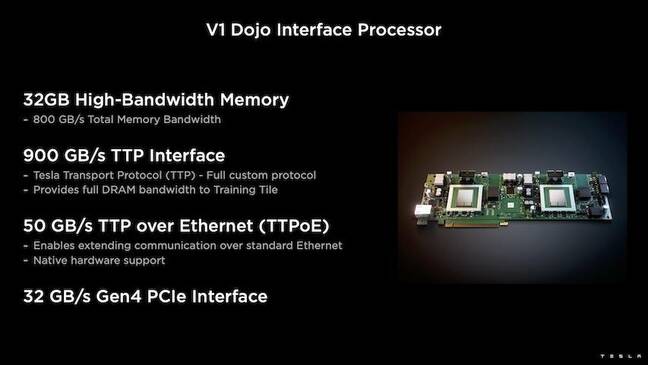

ด้วยเหตุนี้ Tesla ยังได้พัฒนา Dojo Interface Processor (DIP) ซึ่งทำหน้าที่เป็นสะพานเชื่อมระหว่างโฮสต์ CPU และโปรเซสเซอร์การฝึกอบรม กรมทรัพย์สินทางปัญญายังทำหน้าที่เป็นแหล่งที่มาของหน่วยความจำแบนด์วิดท์สูงที่ใช้ร่วมกัน (HBM) และเป็น NIC ความเร็วสูง 400Gbit/วินาที

DIP แต่ละรายการมี HBM ขนาด 32GB และการ์ดเหล่านี้สูงสุดห้าใบสามารถเชื่อมต่อกับไทล์การฝึกที่ 900GB/s รวม 4.5TB/s ไปยังโฮสต์รวมเป็น 160GB ของ HBM ต่อไทล์

คู่การกำหนดค่า V1 ของ Tesla ของไทล์เหล่านี้ - หรือ 150 D1 dies - ในอาร์เรย์รองรับซีพียูโฮสต์สี่ตัวแต่ละตัวที่ติดตั้งการ์ด DIP ห้าใบเพื่อให้ได้ประสิทธิภาพ exaflop ที่อ้างว่าเป็น BF16 หรือ CFP8

เมื่อรวมกัน Venkataramanan กล่าวว่าสถาปัตยกรรม – รายละเอียด ในเชิงลึกที่นี่ by แพลตฟอร์มถัดไป – ช่วยให้ Tesla ก้าวข้ามข้อจำกัดที่เกี่ยวข้องกับตัวเร่งความเร็วแบบเดิม เช่น Nvidia และ AMD

“วิธีการทำงานของคันเร่งแบบเดิม โดยทั่วไปแล้วคุณพยายามใส่โมเดลทั้งหมดลงในคันเร่งแต่ละตัว ทำซ้ำแล้วส่งข้อมูลผ่านแต่ละรายการ” เขากล่าว “จะเกิดอะไรขึ้นถ้าเรามีรุ่นที่ใหญ่กว่าและใหญ่กว่านี้? คันเร่งเหล่านี้สามารถล้มลงได้เพราะหน่วยความจำไม่เพียงพอ”

นี่ไม่ใช่ปัญหาใหม่ เขาตั้งข้อสังเกต ตัวอย่างเช่น NV-switch ของ Nvidia ช่วยให้สามารถรวมหน่วยความจำใน GPU ขนาดใหญ่ได้ อย่างไรก็ตาม Venkataramanan โต้แย้งว่าสิ่งนี้ไม่เพียงเพิ่มความซับซ้อน แต่ยังเพิ่มเวลาแฝงและการประนีประนอมกับแบนด์วิดท์

“เราคิดเกี่ยวกับสิ่งนี้ตั้งแต่เริ่มต้น แผ่นประมวลผลของเราและแม่พิมพ์แต่ละอันถูกสร้างขึ้นมาเพื่อให้พอดีกับโมเดลขนาดใหญ่” Venkataramanan กล่าว

ซอฟต์แวร์

สถาปัตยกรรมการประมวลผลแบบพิเศษดังกล่าวต้องการชุดซอฟต์แวร์เฉพาะทาง อย่างไรก็ตาม Venkataramanan และทีมของเขาตระหนักดีว่าความสามารถในการตั้งโปรแกรมอาจสร้างหรือทำลาย Dojo

"ความง่ายในการเขียนโปรแกรมสำหรับซอฟต์แวร์คู่กันเป็นสิ่งสำคัญยิ่งเมื่อเราออกแบบระบบเหล่านี้" เขากล่าว “นักวิจัยจะไม่รอให้ซอฟต์แวร์ของคุณเขียนเคอร์เนลที่เขียนด้วยลายมือเพื่อปรับให้เข้ากับอัลกอริธึมใหม่ที่เราต้องการเรียกใช้”

ในการทำเช่นนี้ Tesla เลิกใช้แนวคิดในการใช้เมล็ดพืช และออกแบบสถาปัตยกรรมของ Dojo รอบๆ คอมไพเลอร์

“สิ่งที่เราทำคือเราใช้ PiTorch เราสร้างเลเยอร์ระดับกลาง ซึ่งช่วยให้เราปรับขนาดฮาร์ดแวร์ที่อยู่ด้านล่างให้ขนานกัน ภายใต้ทุกอย่างถูกคอมไพล์โค้ด” เขากล่าว “นี่เป็นวิธีเดียวในการสร้างชุดซอฟต์แวร์ที่สามารถปรับให้เข้ากับปริมาณงานในอนาคตทั้งหมดได้”

แม้จะเน้นที่ความยืดหยุ่นของซอฟต์แวร์ แต่ Venkataramanan ตั้งข้อสังเกตว่าแพลตฟอร์มซึ่งกำลังทำงานอยู่ในห้องทดลองของพวกเขานั้นถูกจำกัดให้ Tesla ใช้ในขณะนี้

“เราให้ความสำคัญกับลูกค้าภายในเป็นอันดับแรก” เขากล่าว “Elon ได้เปิดเผยต่อสาธารณะว่าเมื่อเวลาผ่านไป เราจะเผยแพร่สิ่งนี้แก่นักวิจัย แต่เราไม่มีกรอบเวลาสำหรับเรื่องนั้น ®

- AI

- ไอ อาร์ต

- เครื่องกำเนิดไออาร์ท

- หุ่นยนต์ไอ

- ปัญญาประดิษฐ์

- ใบรับรองปัญญาประดิษฐ์

- ปัญญาประดิษฐ์ในการธนาคาร

- หุ่นยนต์ปัญญาประดิษฐ์

- หุ่นยนต์ปัญญาประดิษฐ์

- ซอฟต์แวร์ปัญญาประดิษฐ์

- blockchain

- การประชุม blockchain ai

- เหรียญอัจฉริยะ

- ปัญญาประดิษฐ์สนทนา

- การประชุม crypto ai

- ดัล-อี

- การเรียนรู้ลึก ๆ

- google ai

- เรียนรู้เครื่อง

- เพลโต

- เพลโตไอ

- เพลโตดาต้าอินเทลลิเจนซ์

- เกมเพลโต

- เพลโตดาต้า

- เพลโตเกม

- ขนาดไอ

- วากยสัมพันธ์

- ลงทะเบียน

- ลมทะเล