ใช่.. ฉันกำลังพูดถึงแอปพลิเคชั่น AI – แอปพลิเคชั่น AI มากมายของเราและแอปพลิเคชั่นที่กำลังจะมาถึงกระซิบบอกมนุษย์ว่าจะทำอย่างไร…. จะทำอย่างไร…แต่ไม่เกี่ยวกับผู้กระซิบที่โต้ตอบกับ AI chatbots

ตามที่ ไอดีซี คาดการณ์ว่าตลาด AI ทั่วโลกจะมีมูลค่ามากกว่า 500 พันล้านดอลลาร์ภายในปี 2024 ซึ่งเพิ่มขึ้นมากกว่า 50% จากปี 2021 สิ่งนี้บ่งชี้ว่าเราเปลี่ยนจากการทดลองทางธุรกิจมาเป็นการยอมรับว่าเป็นส่วนสำคัญของกลยุทธ์ระดับองค์กรสำหรับทุกขนาด เป็นเครื่องมือที่จำเป็นในการเปลี่ยนข้อมูลให้เป็นข้อมูลเชิงลึกเพื่อจุดประกายการดำเนินการตามการตัดสินใจที่ดีขึ้น ไม่มีใครถกเถียงถึงประโยชน์ของ AI เพื่อลดความเสี่ยงทางธุรกิจและเพิ่ม ROI ด้วยนวัตกรรม แต่เช่นเคย มี …แต่… AI ที่เป็นกลางนั้นพูดง่ายกว่าทำ

มีความสำคัญต่อธุรกิจ โมเดล AI เหล่านี้จำเป็นต้องทำงานได้อย่างน่าเชื่อถือด้วยการมองเห็นและความรับผิดชอบ มิฉะนั้น ความล้มเหลวในกรณีนี้จะมีผลร้ายแรงที่ส่งผลกระทบต่อกระแสเงินสดของบริษัทใดๆ และอาจส่งผลให้เกิดเรื่องทางกฎหมาย วิธีเดียวที่จะหลีกเลี่ยงสิ่งนี้คือการทำงานอัตโนมัติและความโปร่งใสเพื่อตอบคำถามหนึ่งข้อ “คุณพิสูจน์ได้ไหมว่าแอปพลิเคชัน/ปริมาณงาน AI นี้สร้างขึ้นอย่างมีจริยธรรม” อากะ…คุณปกครองอย่างไร? และคุณสามารถพิสูจน์ได้ว่ามีการควบคุมอย่างต่อเนื่องหรือไม่?

นี่คือที่ที่บริษัทชอบ ไอบีเอ็ม ได้ลงทุนในการกำกับดูแล AI เพื่อประสานกระบวนการโดยรวมในการสั่งการ จัดการ และตรวจสอบกิจกรรม AI ขององค์กร งานหลักคือเพื่อให้แน่ใจว่าหน่วยธุรกิจทั้งหมดยังคงทำงานเชิงรุกและใส่กรอบการกำกับดูแลเข้าไปในความคิดริเริ่มเพื่อเสริมสร้างความสามารถในการปฏิบัติตามหลักการและข้อบังคับทางจริยธรรม โดยเฉพาะอย่างยิ่ง อุตสาหกรรมที่มีการควบคุม เช่น การธนาคารและบริการทางการเงิน จำเป็นต้องแสดงหลักฐานเพื่อให้เป็นไปตามข้อบังคับตามกฎหมาย

อิทธิพลของ AI กำลังเติบโตอย่างทวีคูณในภาคบริการทางการเงิน เนื่องจากแรงกดดันมหาศาลของการเปลี่ยนแปลงทางดิจิทัล ดังที่กล่าวไว้ พูดง่ายกว่าทำ เพราะ:

1. ใช้งานแอพ AI อย่างมั่นใจ:

ในบางกรณี โมเดลถูกสร้างขึ้นโดยไม่มีความชัดเจนและการจัดทำรายการ จำเป็นต้องพูด การตรวจสอบหลุดออกไปท่ามกลางทุกสิ่งเพื่อติดตามวงจรชีวิตตั้งแต่ต้นจนจบ ในขณะที่ธนาคารกำลังประสบปัญหากับแอปพลิเคชันเดิม การทำให้กระบวนการทำงานอัตโนมัติเพื่อสร้างความโปร่งใสและอธิบายได้นั้นยากขึ้นและกลายเป็นกล่องดำในที่สุด ไม่มีใครรู้ว่าเหตุใด/จึงมีการตัดสินใจอย่างไร แอพใหม่ที่ยุ่งเหยิงกับแอพรุ่นเก่าจะมองไม่เห็นแสงสว่าง แม้ว่า ROI จำนวนมากจะเชื่อมโยงกับแอพนั้นเนื่องจากคุณภาพและความเสี่ยงที่มองไม่เห็น

นั่นนำเราไปสู่ประเด็นที่สอง นั่นคือการจัดการความเสี่ยงด้านชื่อเสียง

2. จัดการความเสี่ยงด้านชื่อเสียงควบคู่ไปกับความเสี่ยงโดยรวม

ฉันได้ถาม #แชทGPT และ #กวี – ปัทมา ชุกกะ คือใคร #แชทGPT ปฏิเสธที่จะตอบแม้ว่าฉันจะเปลี่ยนคำถามหลายวิธี ถึงกระนั้น Bard ยังให้คำตอบโดยละเอียดแก่ฉัน รวมถึงโปรไฟล์ LinkedIn ของฉันด้วย… แต่ข้อมูลจากไซต์ต่างๆ ที่โปรไฟล์เก่าของฉันยังคงอยู่เป็นส่วนหนึ่งของประวัติของผู้บรรยาย ตั้งแต่นั้นมาฉันยังไม่ได้เปิด Bard ฉันถูกปิดอย่างรวดเร็วหรือที่เรียกว่า – ความเสี่ยงด้านชื่อเสียง สมมติว่าฉันสามารถปิดแชตบอตง่ายๆ เมื่อรู้ว่าข้อมูลอาจไม่สอดคล้องกัน ฉันจะไม่แน่ใจได้อย่างไรก่อนตัดสินใจซื้อแอปพลิเคชันที่ผสม AI เพื่อดำเนินธุรกิจที่สำคัญ ความเสี่ยงด้านชื่อเสียงเป็นปัจจัยสำคัญที่บางครั้งบริษัทต่างๆ ลืมไป หากคุณประเมินความเสี่ยงด้านชื่อเสียงในเชิงปริมาณ เราจะเห็นผลกระทบมหาศาลต่อธุรกิจหากไม่ดำเนินการในเชิงรุก

เพื่อเพิ่มความซับซ้อน อันที่สามคือ...

3. บริษัทจะตอบสนองต่อการเปลี่ยนแปลงกฎระเบียบของ AI ได้อย่างไร?

เพื่อหลีกเลี่ยงความเสี่ยงด้านชื่อเสียง ทีม AI ที่ประสบความสำเร็จและมีความรับผิดชอบควรตระหนักถึงกฎระเบียบในท้องถิ่นและระดับโลกทั้งหมด และการไม่ปฏิบัติตามข้อกำหนดในท้ายที่สุดอาจทำให้องค์กรต้องเสียค่าปรับหลายล้านดอลลาร์ในการทำงาน เช่น พระราชบัญญัติ AI ของสหภาพยุโรปที่เสนอ อาจสูงถึง 30 ล้านยูโรหรือ 6% ของรายได้ของบริษัททั่วโลก – OUCH

ไม่ใช่ว่าทุกอย่างจะต้องเป็นสีดอกกุหลาบในตอนเริ่มต้น...ตราบใดที่เรารู้วิธีที่จะแปลงโฉมจากสถานการณ์ที่น่ากลัวเป็นสีดอกกุหลาบ

ไม่แปลกใจเลย… มันเป็นเรื่องของคน กระบวนการ และเทคโนโลยีเสมอ ก่อนอื่น ให้สร้างองค์กรปกครองข้ามสายงานเพื่อให้ความรู้ กำกับ และตรวจสอบความคิดริเริ่มตามวัตถุประสงค์ จากนั้นทำการเปรียบเทียบเทคโนโลยีและกระบวนการ AI ในปัจจุบัน ทำความเข้าใจกับช่องว่าง จากนั้นแก้ไขเพื่อพิสูจน์ในอนาคต จากนั้นถอยกลับไปใช้ชุดเวิร์กโฟลว์การกำกับดูแลอัตโนมัติที่สอดคล้องกับข้อกำหนดการปฏิบัติตาม สุดท้าย ให้ตั้งค่าระบบการตรวจสอบเพื่อแจ้งเตือนเจ้าของหากเกณฑ์ที่ยอมรับได้ใกล้เข้ามา จากด้านเทคโนโลยี AI ที่มีสถาปัตยกรรมที่ดี ดำเนินการอย่างดี และเชื่อมต่ออย่างดีนั้นต้องการบล็อกการสร้างหลายชุด และตรวจสอบให้แน่ใจว่ามีความสามารถบางส่วนหรือทั้งหมด:

· ความสมบูรณ์ของข้อมูลในการใช้งานที่หลากหลาย

· ใช้เครื่องมือที่มีอยู่แบบเปิดและยืดหยุ่นซึ่งเป็นไปตาม AI Governance

· ตรวจสอบให้แน่ใจว่าได้เสนอการเข้าถึงแบบบริการตนเองพร้อมการควบคุมความเป็นส่วนตัว ซึ่งเป็นวิธีการติดตาม

· ออกแบบโดยคำนึงถึงระบบอัตโนมัติและการกำกับดูแล AI

· สามารถเชื่อมต่อและปรับแต่งได้สำหรับผู้มีส่วนได้ส่วนเสียหลายคนผ่านเวิร์กโฟลว์ที่ปรับแต่งได้

เมื่อเราแปลงโฉมแอพจากน่ากลัวเป็นโรซี่… คำถามต่อไปคือคุณจะพิสูจน์อย่างไร…

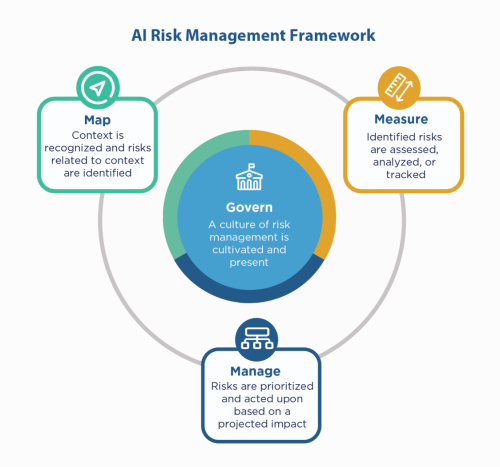

ขั้นแรก ให้ถอยกลับไปสู่หลักการ AI ของบริษัท – สร้างด้วยหลักการเหล่านี้ แต่คุณยังต้อง “แสดง” ว่าคุณปฏิบัติตาม โดยเฉพาะอย่างยิ่งในสภาพแวดล้อมที่มีการควบคุม เช่น บริการทางการเงิน เนื่องจากบริการทางการเงินต้องร้องเรียนกับ NIST 800-53 พวกเขาสามารถดูได้ที่ กรอบการบริหารความเสี่ยง NIST AI (AI RMF). NIST แนะนำการควบคุมในสี่ตระกูล ได้แก่ Govern, Map, Measure และ Manage ใช้สิ่งนั้นเป็นปัจจัยชี้นำและทดสอบความเครียดของแอปพลิเคชันเพื่อระบุช่องว่างในการแก้ไขและตรวจสอบ

IBM สามารถตรวจสอบความถูกต้องของแบบจำลองของคุณก่อนที่คุณจะนำไปผลิตจริง และสามารถตรวจสอบความถูกต้อง คุณภาพ และการเบี่ยงเบนได้ นอกจากนี้ยังสามารถจัดเตรียมเอกสารที่อธิบายถึงพฤติกรรมของแบบจำลองและการคาดคะเนเพื่อให้เป็นไปตามข้อกำหนดของหน่วยงานกำกับดูแลและผู้ตรวจสอบ คำอธิบายเหล่านี้สามารถให้การมองเห็นและบรรเทาความเจ็บปวดในการตรวจสอบ และเพิ่มความโปร่งใสและความสามารถในการระบุความเสี่ยงที่อาจเกิดขึ้น

ฟังเสียงกระซิบของ AI ด้วยความมั่นใจ!

#บริการทางการเงิน #รับผิดชอบai #จริยธรรม #นิสแตร์เอ็มเอฟ

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- เพลโตบล็อคเชน Web3 Metaverse ข่าวกรอง ขยายความรู้. เข้าถึงได้ที่นี่.

- การสร้างอนาคตโดย Adryenn Ashley เข้าถึงได้ที่นี่.

- ที่มา: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :เป็น

- $ ขึ้น

- 2021

- 2024

- 7

- a

- ความสามารถ

- เกี่ยวกับเรา

- ยอมรับได้

- เข้า

- ความรับผิดชอบ

- ข้าม

- กระทำ

- การกระทำ

- กิจกรรม

- เป็นไปตาม

- AI

- พระราชบัญญัติ AI

- การกำกับดูแล AI

- อาคา

- เตือนภัย

- ทั้งหมด

- เสมอ

- และ

- คำตอบ

- app

- การใช้งาน

- การใช้งาน

- ปพลิเคชัน

- เป็น

- รอบ

- AS

- ที่เกี่ยวข้อง

- At

- การตรวจสอบบัญชี

- ผู้สอบบัญชี

- อัตโนมัติ

- โดยอัตโนมัติ

- อัตโนมัติ

- กลับ

- การธนาคาร

- ธนาคาร

- ตาม

- BE

- เพราะ

- ก่อน

- กำลัง

- มาตรฐาน

- ประโยชน์ที่ได้รับ

- ดีกว่า

- พันล้าน

- Black

- Blocks

- ร่างกาย

- กล่อง

- นำ

- สร้าง

- การก่อสร้าง

- สร้าง

- ธุรกิจ

- ซื้อ

- by

- CAN

- ความสามารถในการ

- กรณี

- กรณี

- เงินสด

- กระแสเงินสด

- เปลี่ยนแปลง

- chatbot

- chatbots

- ความชัดเจน

- ปิด

- บริษัท

- บริษัท

- ความซับซ้อน

- การปฏิบัติตาม

- ไม่ขัดขืน

- ความประพฤติ

- มั่นใจ

- เชื่อมต่อ

- ผลที่ตามมา

- อย่างต่อเนื่อง

- การควบคุม

- ราคา

- ได้

- สร้าง

- วิกฤติ

- ปัจจุบัน

- ปรับแต่งได้

- วงจร

- ข้อมูล

- โต้วาที

- กำลังตัดสินใจ

- การตัดสินใจ

- ลดลง

- ออกแบบ

- รายละเอียด

- กำหนด

- ดิจิตอล

- แปลงดิจิตอล

- น่ากลัว

- โดยตรง

- การกำกับ

- หลาย

- เอกสาร

- ดอลลาร์

- ลดลง

- ง่ายดาย

- สอน

- จบสิ้น

- ทำให้มั่นใจ

- Enterprise

- สภาพแวดล้อม

- โดยเฉพาะอย่างยิ่ง

- จำเป็น

- ตามหลักจริยธรรม

- EU

- ยูโร

- แม้

- ทุกๆ

- ทุกอย่าง

- หลักฐาน

- ที่มีอยู่

- ที่มีอยู่

- อธิบาย

- อย่างแทน

- ความล้มเหลว

- ความเป็นธรรม

- ตก

- ครอบครัว

- ในที่สุด

- ทางการเงิน

- บริการทางการเงิน

- ค่าปรับ

- ไฟน์เอ็กซ์ตร้า

- ชื่อจริง

- มีความยืดหยุ่น

- ไหล

- สำหรับ

- กรอบ

- ราคาเริ่มต้นที่

- จาก 2021

- อนาคต

- ให้

- เหตุการณ์ที่

- การกำกับดูแล

- การเจริญเติบโต

- มี

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- HTTPS

- ใหญ่

- มนุษย์

- i

- แยกแยะ

- ส่งผลกระทบ

- in

- รวมทั้ง

- เพิ่ม

- บ่งชี้ว่า

- อุตสาหกรรม

- มีอิทธิพล

- ความคิดริเริ่ม

- นักวิเคราะห์ส่วนบุคคลที่หาโอกาสให้เป็นไปได้มากที่สุด

- ข้อมูลเชิงลึก

- สำคัญ

- ความสมบูรณ์

- โต้ตอบ

- การลงทุน

- IT

- ITS

- การสัมภาษณ์

- ทราบ

- มรดก

- กฎหมาย

- เรื่องกฎหมาย

- ชีวิต

- กดไลก์

- Line

- ในประเทศ

- นาน

- ดู

- ทำ

- ทำ

- จัดการ

- การจัดการ

- การจัดการ

- แผนที่

- ตลาด

- เรื่อง

- อาจ..

- วัด

- พบ

- อาจ

- ล้าน

- ล้าน

- แบบ

- โมเดล

- ขณะ

- การตรวจสอบ

- การตรวจสอบ

- การตรวจสอบ

- ข้อมูลเพิ่มเติม

- หลาย

- จำเป็น

- จำเป็นต้อง

- ไม่มีความจำเป็น

- ใหม่

- ถัดไป

- NIST

- วัตถุประสงค์

- of

- เสนอ

- เก่า

- on

- ONE

- เปิด

- ทำงาน

- organizacja

- มิฉะนั้น

- ทั้งหมด

- เจ้าของ

- อาการเจ็บปวด

- ส่วนหนึ่ง

- คน

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- จุด

- เป็นไปได้

- การคาดการณ์

- ความดัน

- ประถม

- หลักการ

- ความเป็นส่วนตัว

- เชิงรุก

- กระบวนการ

- กระบวนการ

- การผลิต

- โปรไฟล์

- พิสูจน์

- เสนอ

- พิสูจน์

- ให้

- ใส่

- คุณภาพ

- คำถาม

- อย่างรวดเร็ว

- มาถึง

- ตระหนักถึง

- ควบคุม

- อุตสาหกรรมที่มีการควบคุม

- การควบคุม

- กฎระเบียบ

- หน่วยงานกำกับดูแล

- ชื่อเสียง

- จำเป็นต้องใช้

- ความต้องการ

- ต้อง

- ตอบสนอง

- รับผิดชอบ

- ผล

- รายได้

- ความเสี่ยง

- การบริหาจัดการความเสี่ยง

- ความเสี่ยง

- ผลตอบแทนการลงทุน

- ร่าเริง

- s

- กล่าวว่า

- ที่สอง

- ภาค

- บริการตัวเอง

- บริการ

- ชุด

- น่า

- โชว์

- ด้าน

- ง่าย

- ตั้งแต่

- สถานที่ทำวิจัย

- สถานการณ์

- ขนาด

- So

- บาง

- จุดประกาย

- ลำโพง

- ผู้มีส่วนได้เสีย

- เข้าพัก

- ยังคง

- กลยุทธ์

- เสริมสร้าง

- ความเครียด

- การดิ้นรน

- ที่ประสบความสำเร็จ

- ระบบ

- การพูดคุย

- ทีม

- เทคโนโลยี

- ทดสอบ

- ที่

- พื้นที่

- พวกเขา

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- ที่สาม

- ธรณีประตู

- ตลอด

- ไปยัง

- เครื่องมือ

- เครื่องมือ

- ลู่

- การแปลง

- ความโปร่งใส

- มหึมา

- กลับ

- หัน

- ในที่สุด

- เข้าใจ

- หน่วย

- ที่กำลังมา

- us

- ใช้

- ตรวจสอบความถูกต้อง

- ต่างๆ

- วีดีโอ

- ความชัดเจน

- ทาง..

- วิธี

- อะไร

- ในขณะที่

- WHO

- กับ

- ไม่มี

- งาน

- ขั้นตอนการทำงาน

- คุณ

- ของคุณ

- ลมทะเล