เมื่อโมเดลแมชชีนเลิร์นนิง (ML) ได้รับการปรับปรุง นักวิทยาศาสตร์ข้อมูล วิศวกร ML และนักวิจัยได้เปลี่ยนความสนใจไปที่การกำหนดและปรับปรุงคุณภาพของข้อมูลมากขึ้น สิ่งนี้นำไปสู่การเกิดขึ้นของวิธีการที่เน้นข้อมูลเป็นศูนย์กลางสำหรับ ML และเทคนิคต่างๆ เพื่อปรับปรุงประสิทธิภาพของโมเดลโดยมุ่งเน้นไปที่ความต้องการข้อมูล การใช้เทคนิคเหล่านี้ช่วยให้ผู้ปฏิบัติงาน ML สามารถลดจำนวนข้อมูลที่ต้องใช้ในการฝึกโมเดล ML

ส่วนหนึ่งของวิธีการนี้ เทคนิคการเลือกชุดย่อยข้อมูลขั้นสูงได้ปรากฏขึ้นเพื่อเร่งการฝึกอบรมโดยลดปริมาณข้อมูลที่ป้อนเข้า กระบวนการนี้ขึ้นอยู่กับการเลือกจำนวนจุดที่กำหนดโดยอัตโนมัติ ซึ่งใกล้เคียงกับการกระจายของชุดข้อมูลที่ใหญ่กว่าและใช้สำหรับการฝึกอบรม การใช้เทคนิคประเภทนี้ช่วยลดระยะเวลาที่ต้องใช้ในการฝึกโมเดล ML

ในโพสต์นี้ เราอธิบายถึงการนำหลักการ AI ที่เน้นข้อมูลมาใช้กับ ความจริงของ Amazon SageMakerวิธีการใช้เทคนิคการเลือกชุดย่อยของข้อมูลโดยใช้ สาย ที่เก็บข้อมูลบน อเมซอน SageMaker เพื่อลดปริมาณข้อมูลที่ต้องใช้ในการฝึกโมเดลเริ่มต้น และวิธีการเรียกใช้การทดสอบโดยใช้แนวทางนี้ด้วย การทดลอง Amazon SageMaker.

แนวทางที่เน้นข้อมูลเป็นศูนย์กลางในการเรียนรู้ของเครื่อง

ก่อนที่จะดำดิ่งสู่เทคนิคขั้นสูงที่เน้นข้อมูลเป็นศูนย์กลาง เช่น การเลือกชุดย่อยของข้อมูล คุณสามารถปรับปรุงชุดข้อมูลของคุณได้หลายวิธีโดยการใช้หลักการพื้นฐานชุดหนึ่งกับกระบวนการติดฉลากข้อมูลของคุณ ด้วยเหตุนี้ Ground Truth จึงสนับสนุนกลไกต่างๆ เพื่อปรับปรุงความสอดคล้องของฉลากและคุณภาพของข้อมูล

ความสอดคล้องของฉลากมีความสำคัญต่อการปรับปรุงประสิทธิภาพของโมเดล หากไม่มีสิ่งนี้ แบบจำลองไม่สามารถสร้างขอบเขตการตัดสินใจที่แยกทุกจุดที่เป็นของคลาสต่างๆ ได้ วิธีหนึ่งที่จะทำให้มั่นใจได้คือการใช้ การรวมคำอธิบายประกอบใน Ground Truthซึ่งช่วยให้คุณแสดงตัวอย่างที่กำหนดแก่ผู้ติดป้ายกำกับหลายราย และใช้ป้ายกำกับรวมที่ให้ไว้เป็นความจริงพื้นฐานสำหรับตัวอย่างนั้น ความแตกต่างในฉลากวัดจากคะแนนความเชื่อมั่นที่เกิดจากความจริงพื้นฐาน เมื่อมีความแตกต่างในฉลาก คุณควรดูว่ามีความคลุมเครือในคำแนะนำในการติดฉลากที่ให้ไว้กับผู้ติดฉลากของคุณที่สามารถลบออกได้หรือไม่ วิธีการนี้ช่วยลดผลกระทบจากความลำเอียงของผู้ติดฉลากแต่ละราย ซึ่งเป็นส่วนสำคัญในการทำให้ฉลากมีความสอดคล้องกันมากขึ้น

อีกวิธีในการปรับปรุงประสิทธิภาพของโมเดลโดยเน้นที่ข้อมูลคือการพัฒนาวิธีการวิเคราะห์ข้อผิดพลาดในฉลาก เมื่อเกิดขึ้นเพื่อระบุชุดย่อยที่สำคัญที่สุดของข้อมูลที่ต้องปรับปรุง คุณสามารถทำเช่นนี้กับชุดข้อมูลการฝึกอบรมของคุณด้วยการผสมผสานความพยายามด้วยตนเองที่เกี่ยวข้องกับการดำน้ำในตัวอย่างที่มีป้ายกำกับและการใช้ อเมซอน คลาวด์วอตช์ บันทึกและเมตริกที่สร้างโดยงานการติดฉลาก Ground Truth สิ่งสำคัญคือต้องดูข้อผิดพลาดที่โมเดลสร้างขึ้นในเวลาอนุมานเพื่อขับเคลื่อนการติดฉลากซ้ำครั้งถัดไปสำหรับชุดข้อมูลของเรา นอกจากกลไกเหล่านี้แล้ว Amazon SageMaker ชี้แจง ช่วยให้นักวิทยาศาสตร์ข้อมูลและวิศวกร ML เรียกใช้อัลกอริทึมเช่น เคอร์เนล SHAP เพื่อให้พวกเขาตีความการคาดคะเนจากโมเดลของตนได้ ดังที่กล่าวไว้ คำอธิบายเชิงลึกเกี่ยวกับการคาดคะเนของแบบจำลองสามารถเชื่อมโยงย้อนกลับไปยังกระบวนการติดฉลากเริ่มต้นเพื่อปรับปรุงได้

ท้ายสุด คุณสามารถพิจารณาตัดตัวอย่างที่มีเสียงดังหรือซ้ำซ้อนมากเกินไปออกไปได้ การทำเช่นนี้ช่วยให้คุณลดเวลาการฝึกโดยการลบตัวอย่างที่ไม่ช่วยปรับปรุงประสิทธิภาพของโมเดล อย่างไรก็ตาม การระบุส่วนย่อยที่มีประโยชน์ของชุดข้อมูลที่กำหนดด้วยตนเองนั้นยากและใช้เวลานาน การใช้เทคนิคการเลือกชุดย่อยของข้อมูลที่อธิบายไว้ในโพสต์นี้ ช่วยให้คุณสามารถทำให้กระบวนการนี้เป็นไปโดยอัตโนมัติตามกรอบการทำงานที่กำหนดไว้

ใช้กรณี

ตามที่กล่าวไว้ AI ที่เน้นข้อมูลเป็นศูนย์กลางจะมุ่งเน้นไปที่การปรับปรุงอินพุตของโมเดลมากกว่าสถาปัตยกรรมของตัวโมเดลเอง เมื่อคุณใช้หลักการเหล่านี้ในระหว่างการติดฉลากข้อมูลหรือวิศวกรรมคุณลักษณะแล้ว คุณสามารถมุ่งเน้นไปที่การป้อนข้อมูลแบบจำลองต่อไปได้โดยใช้การเลือกชุดย่อยของข้อมูลในเวลาฝึกอบรม

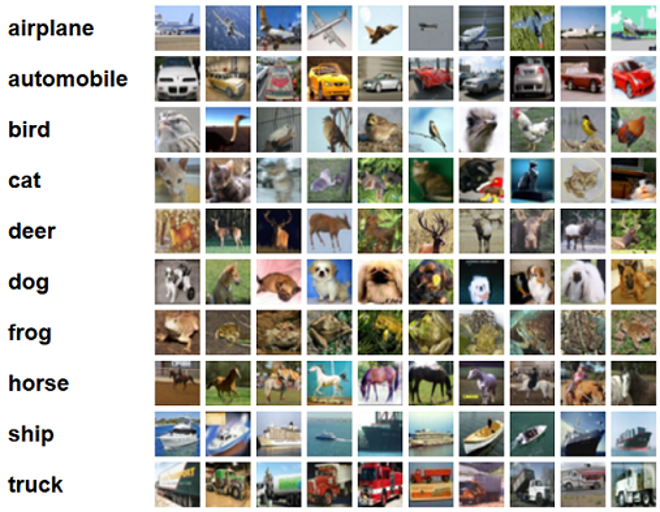

สำหรับโพสต์นี้ เราใช้การเลือกชุดย่อยข้อมูลตามลักษณะทั่วไปเพื่อการเรียนรู้ที่มีประสิทธิภาพและแข็งแกร่ง (กลิสเตอร์) ซึ่งเป็นหนึ่งในเทคนิคการเลือกชุดย่อยของข้อมูลจำนวนมากที่นำไปใช้ในที่เก็บ CORDS กับอัลกอริทึมการฝึกของ เรสเน็ต-18 โมเดลเพื่อลดเวลาที่ใช้ในการฝึกโมเดลเพื่อจัดประเภท ซิฟาร์ -10 ภาพ ต่อไปนี้คือภาพตัวอย่างบางส่วนที่มีป้ายกำกับที่เกี่ยวข้องซึ่งดึงมาจากชุดข้อมูล CIFAR-10

ResNet-18 มักใช้สำหรับงานจำแนกประเภท เป็นโครงข่ายประสาทเทียมลึก 18 ชั้น ชุดข้อมูล CIFAR-10 มักจะใช้เพื่อประเมินความถูกต้องของเทคนิคและวิธีการต่างๆ ใน ML ประกอบด้วยภาพสีขนาด 60,000×32 จำนวน 32 ภาพใน 10 คลาส

ในส่วนต่อไปนี้ เราจะแสดงให้เห็นว่า GLISTER สามารถช่วยคุณตอบคำถามต่อไปนี้ได้ในระดับหนึ่งได้อย่างไร:

เราสามารถใช้ชุดข้อมูลที่กำหนดกี่เปอร์เซ็นต์และยังคงได้รับประสิทธิภาพของแบบจำลองที่ดีในระหว่างการฝึกอบรม

การใช้ GLISTER กับอัลกอริทึมการฝึกของคุณจะแนะนำเศษส่วนเป็นไฮเปอร์พารามิเตอร์ในอัลกอริทึมการฝึกของคุณ นี่แสดงถึงเปอร์เซ็นต์ของชุดข้อมูลที่คุณต้องการใช้ เช่นเดียวกับไฮเปอร์พารามิเตอร์ การค้นหาค่าที่ให้ผลลัพธ์ที่ดีที่สุดสำหรับโมเดลและข้อมูลของคุณจำเป็นต้องมีการปรับแต่ง เราจะไม่ลงลึกในการปรับไฮเปอร์พารามิเตอร์ในโพสต์นี้ สำหรับข้อมูลเพิ่มเติม โปรดดูที่ ปรับไฮเปอร์พารามิเตอร์ให้เหมาะสมด้วยการปรับโมเดลอัตโนมัติของ Amazon SageMaker.

เราทำการทดสอบหลายอย่างโดยใช้ SageMaker Experiments เพื่อวัดผลกระทบของแนวทางดังกล่าว ผลลัพธ์จะแตกต่างกันไปขึ้นอยู่กับชุดข้อมูลเริ่มต้น ดังนั้นจึงเป็นเรื่องสำคัญที่จะต้องทดสอบแนวทางกับข้อมูลของเราในขนาดย่อยที่แตกต่างกัน

แม้ว่าเราจะพูดถึงการใช้ GLISTER กับรูปภาพ แต่คุณก็นำไปใช้กับอัลกอริทึมการฝึกทำงานกับข้อมูลที่มีโครงสร้างหรือตารางได้

การเลือกชุดย่อยของข้อมูล

จุดประสงค์ของการเลือกชุดย่อยของข้อมูลคือเพื่อเร่งกระบวนการฝึกอบรมในขณะที่ลดผลกระทบต่อความแม่นยำให้น้อยที่สุดและเพิ่มความทนทานของโมเดล โดยเฉพาะอย่างยิ่ง GLISTER-ONLINE จะเลือกชุดย่อยตามที่โมเดลเรียนรู้โดยพยายามเพิ่มความเป็นไปได้สูงสุดในการบันทึกของชุดย่อยข้อมูลการฝึกอบรมนั้นในชุดการตรวจสอบความถูกต้องที่คุณระบุ การปรับการเลือกเซ็ตย่อยของข้อมูลให้เหมาะสมด้วยวิธีนี้ช่วยลดสัญญาณรบกวนและความไม่สมดุลของคลาสที่มักพบในชุดข้อมูลในโลกแห่งความเป็นจริง และช่วยให้กลยุทธ์การเลือกเซ็ตย่อยปรับเปลี่ยนได้ตามที่โมเดลเรียนรู้

เริ่มต้น กระดาษกลิสเทอร์ อธิบายการแลกเปลี่ยนความเร็ว/ความแม่นยำที่ชุดย่อยข้อมูลขนาดต่างๆ ดังต่อไปนี้โดยใช้ เลเน็ต รูปแบบ:

| ขนาดย่อย | speedup | ความถูกต้อง |

| 10% | 6x | -3% |

| 30% | 2.5x | -1.20% |

| 50% | 1.5x | -0.20% |

ในการฝึกโมเดล เราเรียกใช้ a งานฝึกอบรม SageMaker โดยใช้สคริปต์การฝึกอบรมที่กำหนดเอง เรายังได้อัปโหลดชุดข้อมูลภาพของเราไปที่ บริการจัดเก็บข้อมูลอย่างง่ายของ Amazon (อเมซอน S3). เช่นเดียวกับงานฝึกอบรมใดๆ ของ SageMaker เราจำเป็นต้องกำหนด Estimator วัตถุ. ตัวประมาณ PyTorch จาก sagemaker.pytorch แพ็คเกจช่วยให้เราเรียกใช้สคริปต์การฝึกอบรมของเราเองในคอนเทนเนอร์ PyTorch ที่มีการจัดการ เดอะ inputs ตัวแปรที่ส่งผ่านไปยังตัวประมาณค่า .fit ฟังก์ชันมีพจนานุกรมของตำแหน่ง S3 ของชุดข้อมูลการฝึกอบรมและการตรวจสอบความถูกต้อง

พื้นที่ train.py สคริปต์ถูกเรียกใช้เมื่อเริ่มงานการฝึกอบรม ในสคริปต์นี้ เรานำเข้าโมเดล ResNet-18 จากไลบรารี CORDS และส่งผ่านจำนวนคลาสในชุดข้อมูลของเราดังนี้:

จากนั้นเราก็ใช้ gen_dataset ฟังก์ชันจาก CORDS เพื่อสร้างการฝึกอบรม การตรวจสอบ และทดสอบชุดข้อมูล:

จากชุดข้อมูลแต่ละชุด เราสร้างตัวโหลดข้อมูล PyTorch ที่เทียบเท่ากัน:

สุดท้ายนี้ เราใช้ตัวโหลดข้อมูลเหล่านี้เพื่อสร้าง GLISTERDataLoader จากห้องสมุด CORDS มันใช้กลยุทธ์การเลือกของ GLISTER-ONLINE ซึ่งใช้การเลือกเซ็ตย่อยเมื่อเราอัปเดตโมเดลระหว่างการฝึก ตามที่กล่าวไว้ก่อนหน้าในโพสต์นี้

ในการสร้างอ็อบเจกต์ เราส่งอาร์กิวเมนต์เฉพาะของกลยุทธ์การเลือกเป็น a DotMap วัตถุพร้อมกับ train_loader, validation_loaderและ logger:

พื้นที่ GLISTERDataLoader สามารถใช้เป็นตัวโหลดข้อมูลปกติกับลูปการฝึกอบรมได้แล้ว ระบบจะเลือกชุดข้อมูลย่อยสำหรับชุดการฝึกอบรมถัดไปเมื่อโมเดลเรียนรู้ตามการสูญเสียของโมเดลนั้น ตามที่แสดงในตารางก่อนหน้านี้ การเพิ่มกลยุทธ์การเลือกชุดย่อยข้อมูลช่วยให้เราลดเวลาการฝึกอบรมลงได้อย่างมาก แม้ว่าจะมีขั้นตอนเพิ่มเติมของการเลือกชุดย่อยของข้อมูล โดยมีความแม่นยำเพียงเล็กน้อย

นักวิทยาศาสตร์ข้อมูลและวิศวกร ML มักจะต้องประเมินความถูกต้องของวิธีการโดยเปรียบเทียบกับข้อมูลพื้นฐาน เราจะสาธิตวิธีการในส่วนถัดไป

การติดตามการทดสอบ

คุณสามารถใช้ SageMaker Experiments เพื่อวัดความถูกต้องของวิธีการเลือกชุดข้อมูลย่อย สำหรับข้อมูลเพิ่มเติม โปรดดูที่ การทดลอง Amazon SageMaker รุ่นต่อไป – จัดระเบียบ ติดตาม และเปรียบเทียบการฝึกอบรมแมชชีนเลิร์นนิงของคุณตามขนาด.

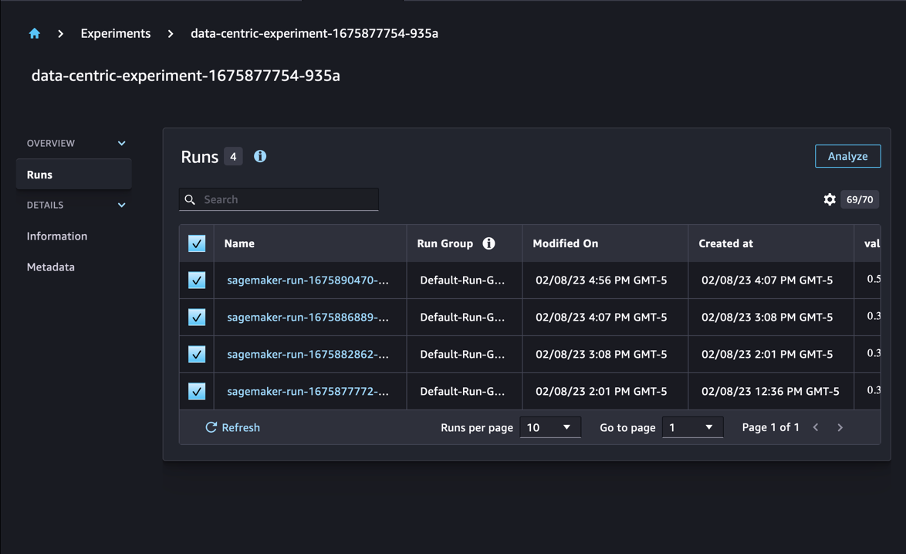

ในกรณีของเรา เราทำการทดสอบสี่ครั้ง: พื้นฐานโดยไม่ใช้การเลือกเซ็ตย่อยของข้อมูล และอีกสามการทดสอบที่แตกต่างกัน fraction พารามิเตอร์ ซึ่งแสดงถึงขนาดของชุดย่อยที่สัมพันธ์กับชุดข้อมูลโดยรวม โดยธรรมชาติใช้ขนาดเล็กกว่า fraction พารามิเตอร์ควรส่งผลให้เวลาการฝึกลดลง แต่ความแม่นยำของโมเดลก็จะลดลงเช่นกัน

สำหรับโพสต์นี้ การฝึกแต่ละครั้งจะแสดงเป็น a Run ในการทดลอง SageMaker การวิ่งที่เกี่ยวข้องกับการทดสอบของเราทั้งหมดถูกจัดกลุ่มไว้ภายใต้กลุ่มเดียว Experiment วัตถุ. สามารถแนบการเรียกใช้กับการทดสอบทั่วไปได้เมื่อสร้าง Estimator ด้วย SDK ดูรหัสต่อไปนี้:

ในฐานะส่วนหนึ่งของสคริปต์การฝึกแบบกำหนดเองของคุณ คุณสามารถรวบรวมเมตริกการวิ่งได้โดยใช้ load_run:

จากนั้น ใช้วัตถุรันที่ส่งคืนโดยการดำเนินการก่อนหน้านี้ คุณสามารถรวบรวมจุดข้อมูลต่อยุคโดยการโทร run.log_metric(name, value, step) และระบุชื่อเมตริก ค่า และหมายเลขยุคปัจจุบัน

ในการวัดความถูกต้องของแนวทางของเรา เรารวบรวมเมตริกที่สอดคล้องกับการสูญเสียการฝึก ความแม่นยำในการฝึก การสูญเสียการตรวจสอบความถูกต้อง ความแม่นยำในการตรวจสอบ และเวลาที่จะเสร็จสิ้นยุค จากนั้นหลังจากรันงานการฝึกอบรมแล้ว เราสามารถ ตรวจสอบผลการทดลองของเรา in สตูดิโอ Amazon SageMaker หรือผ่าน SageMaker Experiments SDK

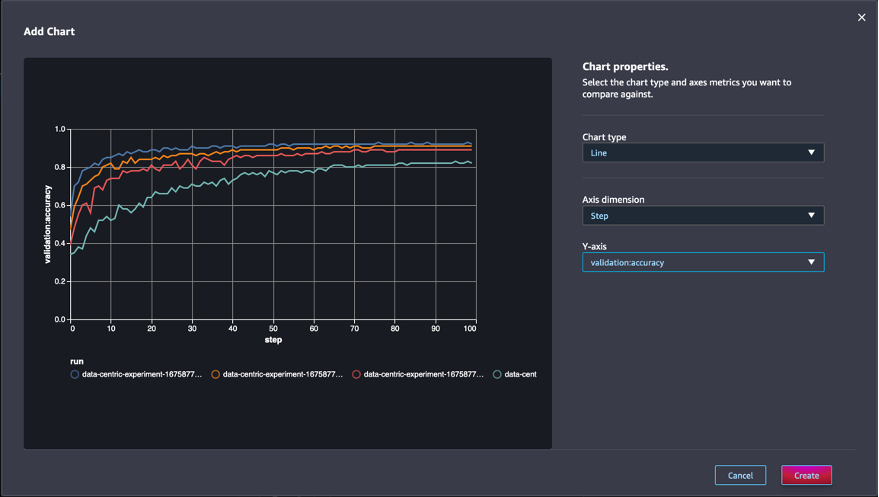

หากต้องการดูความถูกต้องของการตรวจสอบภายใน Studio ให้เลือก วิเคราะห์ ในการทดลอง วิ่ง หน้า.

เพิ่มแผนภูมิ ตั้งค่าคุณสมบัติของแผนภูมิ แล้วเลือก สร้างบัญชีตัวแทน. ดังที่แสดงในภาพหน้าจอต่อไปนี้ คุณจะเห็นพล็อตของความถูกต้องในการตรวจสอบความถูกต้องในแต่ละยุคสำหรับการเรียกใช้ทั้งหมด

SDK ยังช่วยให้คุณดึงข้อมูลที่เกี่ยวข้องกับการทดสอบเป็น Pandas dataframe:

สามารถเลือกเรียงลำดับงานการฝึกอบรมได้ ตัวอย่างเช่น เราสามารถเพิ่ม "metrics.validation:accuracy.max" เป็นค่าของ sort_by พารามิเตอร์ที่ส่งไปยัง ExperimentAnalytics เพื่อส่งคืนผลลัพธ์ที่เรียงลำดับตามความถูกต้องของการตรวจสอบ

ตามที่คาดไว้ การทดลองของเราแสดงให้เห็นว่าการใช้ GLISTER และการเลือกชุดข้อมูลย่อยกับอัลกอริทึมการฝึกช่วยลดเวลาการฝึก เมื่อเรียกใช้อัลกอริทึมการฝึกอบรมพื้นฐาน เวลาเฉลี่ยในการสิ้นสุดยุคเดียวจะอยู่ที่ประมาณ 27 วินาที ในทางตรงกันข้าม การใช้ GLISTER เพื่อเลือกเซ็ตย่อยที่เทียบเท่ากับ 50%, 30% และ 10% ของชุดข้อมูลทั้งหมดจะส่งผลให้ใช้เวลาในการสิ้นสุดยุคประมาณ 13, 8.5 และ 2.75 วินาทีตามลำดับ บนอินสแตนซ์ ml.p3.2xlarge .

นอกจากนี้ เรายังสังเกตเห็นผลกระทบที่น้อยมากโดยเปรียบเทียบต่อความถูกต้องของการตรวจสอบ โดยเฉพาะอย่างยิ่งเมื่อใช้ชุดย่อยของข้อมูล 50% หลังจากฝึกฝนเป็นเวลา 100 ยุค พื้นฐานสร้างความแม่นยำในการตรวจสอบที่ 92.72% ในทางตรงกันข้าม การใช้ GLISTER เพื่อเลือกชุดย่อยที่เทียบเท่ากับ 50%, 30% และ 10% ของชุดข้อมูลทั้งหมดส่งผลให้มีความถูกต้องในการตรวจสอบความถูกต้อง 91.42%, 89.76% และ 82.82% ตามลำดับ

สรุป

SageMaker Ground Truth และ SageMaker Experiments เปิดใช้งานแนวทางที่เน้นข้อมูลเป็นศูนย์กลางในการเรียนรู้ของเครื่องโดยอนุญาตให้นักวิทยาศาสตร์ข้อมูลและวิศวกร ML สร้างชุดข้อมูลที่สอดคล้องกันมากขึ้นและติดตามผลกระทบของเทคนิคขั้นสูงมากขึ้นในขณะที่นำไปใช้ในขั้นตอนการสร้างแบบจำลอง การใช้แนวทางที่เน้นข้อมูลเป็นศูนย์กลางกับ ML ช่วยให้คุณลดจำนวนข้อมูลที่โมเดลของคุณต้องการและปรับปรุงความทนทาน

ลองดูและแจ้งให้เราทราบว่าคุณคิดอย่างไรในความคิดเห็น

เกี่ยวกับผู้แต่ง

นิโคลัส แบร์เนียร์ เป็นสถาปนิกโซลูชัน ซึ่งเป็นส่วนหนึ่งของทีมภาครัฐของแคนาดาที่ AWS ปัจจุบันเขากำลังศึกษาระดับปริญญาโทด้านการวิจัยใน Deep Learning และถือใบรับรอง AWS ห้าใบ รวมถึงใบรับรอง ML Specialty Nicolas มีความกระตือรือร้นในการช่วยลูกค้าเพิ่มพูนความรู้เกี่ยวกับ AWS โดยทำงานร่วมกับพวกเขาเพื่อแปลงความท้าทายทางธุรกิจให้เป็นโซลูชันทางเทคนิค

นิโคลัส แบร์เนียร์ เป็นสถาปนิกโซลูชัน ซึ่งเป็นส่วนหนึ่งของทีมภาครัฐของแคนาดาที่ AWS ปัจจุบันเขากำลังศึกษาระดับปริญญาโทด้านการวิจัยใน Deep Learning และถือใบรับรอง AWS ห้าใบ รวมถึงใบรับรอง ML Specialty Nicolas มีความกระตือรือร้นในการช่วยลูกค้าเพิ่มพูนความรู้เกี่ยวกับ AWS โดยทำงานร่วมกับพวกเขาเพื่อแปลงความท้าทายทางธุรกิจให้เป็นโซลูชันทางเทคนิค

จิวานิลโด้ อัลเวส เป็นสถาปนิกสร้างต้นแบบกับทีมสร้างต้นแบบและวิศวกรรมระบบคลาวด์ที่ Amazon Web Services ช่วยลูกค้าสร้างนวัตกรรมและเร่งความเร็วด้วยการแสดงศิลปะแห่งความเป็นไปได้บน AWS โดยได้ใช้งานต้นแบบหลายตัวเกี่ยวกับปัญญาประดิษฐ์ เขาทำงานด้านวิศวกรรมซอฟต์แวร์มาอย่างยาวนาน และเคยทำงานเป็นวิศวกรพัฒนาซอฟต์แวร์ที่ Amazon.com.br

จิวานิลโด้ อัลเวส เป็นสถาปนิกสร้างต้นแบบกับทีมสร้างต้นแบบและวิศวกรรมระบบคลาวด์ที่ Amazon Web Services ช่วยลูกค้าสร้างนวัตกรรมและเร่งความเร็วด้วยการแสดงศิลปะแห่งความเป็นไปได้บน AWS โดยได้ใช้งานต้นแบบหลายตัวเกี่ยวกับปัญญาประดิษฐ์ เขาทำงานด้านวิศวกรรมซอฟต์แวร์มาอย่างยาวนาน และเคยทำงานเป็นวิศวกรพัฒนาซอฟต์แวร์ที่ Amazon.com.br

- เนื้อหาที่ขับเคลื่อนด้วย SEO และการเผยแพร่ประชาสัมพันธ์ รับการขยายวันนี้

- เพลโตบล็อคเชน Web3 Metaverse ข่าวกรอง ขยายความรู้. เข้าถึงได้ที่นี่.

- ที่มา: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- :เป็น

- $ ขึ้น

- 000

- 1

- 10

- 100

- 7

- 8

- a

- เกี่ยวกับเรา

- เร่งความเร็ว

- ความถูกต้อง

- บรรลุ

- ข้าม

- ปรับ

- นอกจากนี้

- เพิ่มเติม

- สูง

- หลังจาก

- กับ

- AI

- ขั้นตอนวิธี

- อัลกอริทึม

- ทั้งหมด

- การอนุญาต

- ช่วยให้

- แล้ว

- อเมซอน

- อเมซอน SageMaker

- Amazon Web Services

- Amazon.com

- ความคลุมเครือ

- จำนวน

- การวิเคราะห์

- วิเคราะห์

- และ

- คำตอบ

- ประยุกต์

- ใช้

- การประยุกต์ใช้

- เข้าใกล้

- วิธีการ

- สถาปัตยกรรม

- เป็น

- AREA

- ข้อโต้แย้ง

- รอบ

- ศิลปะ

- เทียม

- ปัญญาประดิษฐ์

- AS

- At

- พยายาม

- ความสนใจ

- โดยอัตโนมัติ

- อัตโนมัติ

- อัตโนมัติ

- AWS

- กลับ

- ตาม

- baseline

- BE

- ที่ดีที่สุด

- อคติ

- การก่อสร้าง

- ธุรกิจ

- by

- โทร

- CAN

- ชาวแคนาดา

- ความก้าวหน้า

- กรณี

- ส่วนกลาง

- ใบรับรอง มาตราฐาน

- การรับรอง

- ความท้าทาย

- แผนภูมิ

- Choose

- ชั้น

- ชั้นเรียน

- การจัดหมวดหมู่

- แยกประเภท

- ลูกค้า

- เมฆ

- รหัส

- รวบรวม

- สี

- COM

- การผสมผสาน

- อย่างไร

- ความคิดเห็น

- ร่วมกัน

- ติดจะ

- เปรียบเทียบ

- เปรียบเทียบ

- สมบูรณ์

- สงบ

- การดำเนิน

- ความมั่นใจ

- พิจารณา

- คงเส้นคงวา

- การรวบรวม

- ภาชนะ

- มี

- ต่อ

- ตรงกันข้าม

- สนับสนุน

- ตรงกัน

- ได้

- สร้าง

- การสร้าง

- ปัจจุบัน

- ขณะนี้

- ประเพณี

- ลูกค้า

- ข้อมูล

- จุดข้อมูล

- ชุดข้อมูล

- การตัดสินใจ

- ลึก

- การเรียนรู้ลึก ๆ

- เข้มขึ้น

- ลึก

- การกำหนด

- องศา

- สาธิต

- แสดงให้เห็นถึง

- ทั้งนี้ขึ้นอยู่กับ

- ความลึก

- บรรยาย

- อธิบาย

- ที่กำลังพัฒนา

- พัฒนาการ

- ต่าง

- แตกต่าง

- ยาก

- สนทนา

- กล่าวถึง

- การกระจาย

- การแตกต่าง

- การทำ

- Dont

- ขับรถ

- ในระหว่าง

- แต่ละ

- ก่อน

- ผลกระทบ

- ที่มีประสิทธิภาพ

- ความพยายาม

- ภาวะฉุกเฉิน

- ทำให้สามารถ

- วิศวกร

- ชั้นเยี่ยม

- วิศวกร

- ทำให้มั่นใจ

- ยุค

- ยุค

- เท่ากัน

- ข้อผิดพลาด

- โดยเฉพาะอย่างยิ่ง

- ที่จัดตั้งขึ้น

- ประเมินค่า

- แม้

- ทุกๆ

- ตัวอย่าง

- ตัวอย่าง

- ที่คาดหวัง

- การทดลอง

- คำอธิบาย

- ลักษณะ

- หา

- โฟกัส

- มุ่งเน้นไปที่

- โดยมุ่งเน้น

- ตาม

- ดังต่อไปนี้

- ดังต่อไปนี้

- สำหรับ

- พบ

- เศษ

- กรอบ

- ราคาเริ่มต้นที่

- ฟังก์ชัน

- สร้าง

- รุ่น

- กำหนด

- Go

- ดี

- พื้น

- มี

- มี

- ช่วย

- การช่วยเหลือ

- ถือ

- สรุป ความน่าเชื่อถือของ Olymp Trade?

- ทำอย่างไร

- อย่างไรก็ตาม

- HTML

- ที่ http

- HTTPS

- การปรับแต่งไฮเปอร์พารามิเตอร์

- แยกแยะ

- ระบุ

- ภาพ

- ภาพ

- ความไม่สมดุล

- ส่งผลกระทบ

- การดำเนินการ

- การดำเนินงาน

- การดำเนินการ

- การดำเนินการ

- นำเข้า

- สำคัญ

- ปรับปรุง

- การปรับปรุง

- การปรับปรุง

- in

- รวมทั้ง

- ที่เพิ่มขึ้น

- เป็นรายบุคคล

- ข้อมูล

- แรกเริ่ม

- เราสร้างสรรค์สิ่งใหม่ ๆ

- อินพุต

- ตัวอย่าง

- คำแนะนำการใช้

- Intelligence

- แนะนำ

- IT

- การย้ำ

- ITS

- ตัวเอง

- การสัมภาษณ์

- งาน

- ทราบ

- ความรู้

- ฉลาก

- การติดฉลาก

- ป้ายกำกับ

- ที่มีขนาดใหญ่

- เปิดตัว

- การเรียนรู้

- นำ

- ห้องสมุด

- กดไลก์

- รายการ

- น้อย

- ที่ตั้ง

- นาน

- ดู

- ปิด

- เครื่อง

- เรียนรู้เครื่อง

- ทำ

- ทำให้

- การทำ

- การจัดการ

- คู่มือ

- ด้วยมือ

- หลาย

- ปริญญาโท

- แม็กซ์

- เพิ่ม

- วัด

- กล่าวถึง

- วิธีการ

- เมตริก

- ตัวชี้วัด

- ต่ำสุด

- การลด

- ML

- แบบ

- โมเดล

- ข้อมูลเพิ่มเติม

- มากที่สุด

- หลาย

- ชื่อ

- จำเป็นต้อง

- เครือข่าย

- เครือข่ายประสาท

- ถัดไป

- นิโคลัส

- สัญญาณรบกวน

- จำนวน

- วัตถุ

- สังเกต

- of

- on

- ONE

- การดำเนินการ

- การเพิ่มประสิทธิภาพ

- ผลิตภัณฑ์อื่นๆ

- ทั้งหมด

- ของตนเอง

- แพ็คเกจ

- หน้า

- หมีแพนด้า

- พารามิเตอร์

- พารามิเตอร์

- ส่วนหนึ่ง

- ผ่าน

- หลงใหล

- รูปแบบไฟล์ PDF

- เปอร์เซ็นต์

- ดำเนินการ

- การปฏิบัติ

- ระยะ

- เพลโต

- เพลโตดาต้าอินเทลลิเจนซ์

- เพลโตดาต้า

- จุด

- จุด

- เป็นไปได้

- โพสต์

- การคาดการณ์

- ก่อน

- ก่อนหน้านี้

- หลักการ

- กระบวนการ

- ก่อ

- คุณสมบัติ

- ต้นแบบ

- การสร้างต้นแบบ

- ให้

- สาธารณะ

- วัตถุประสงค์

- ไฟฉาย

- คุณภาพ

- ปริมาณ

- คำถาม

- ค่อนข้าง

- โลกแห่งความจริง

- ลด

- ลดลง

- ลด

- ลด

- ภูมิภาค

- ปกติ

- ที่เกี่ยวข้อง

- ลบออก

- ลบ

- กรุ

- เป็นตัวแทนของ

- แสดงให้เห็นถึง

- จำเป็นต้องใช้

- ความต้องการ

- ต้อง

- การวิจัย

- นักวิจัย

- ว่า

- ผล

- ผลสอบ

- กลับ

- แข็งแรง

- ความแข็งแรง

- วิ่ง

- วิ่ง

- sagemaker

- นักวิทยาศาสตร์

- SDK

- วินาที

- Section

- ส่วน

- ภาค

- การเลือก

- การเลือก

- ให้บริการ

- บริการ

- เซสชั่น

- ชุด

- หลาย

- น่า

- โชว์

- แสดง

- อย่างมีความหมาย

- ง่าย

- เดียว

- ขนาด

- ขนาด

- มีขนาดเล็กกว่า

- So

- ซอฟต์แวร์

- การพัฒนาซอฟต์แวร์

- วิศวกรรมซอฟต์แวร์

- โซลูชัน

- บาง

- แหล่ง

- พิเศษ

- โดยเฉพาะ

- เฉพาะ

- ความเร็ว

- ขั้นตอน

- ยังคง

- การเก็บรักษา

- กลยุทธ์

- โครงสร้าง

- สตูดิโอ

- การจัดหา

- รองรับ

- ตาราง

- ใช้เวลา

- งาน

- ทีม

- วิชาการ

- เทคนิค

- ทดสอบ

- การทดสอบ

- ที่

- พื้นที่

- ของพวกเขา

- พวกเขา

- ล้อยางขัดเหล่านี้ติดตั้งบนแกน XNUMX (มม.) ผลิตภัณฑ์นี้ถูกผลิตในหลายรูปทรง และหลากหลายเบอร์ความแน่นหนาของปริมาณอนุภาคขัดของมัน จะทำให้ท่านได้รับประสิทธิภาพสูงในการขัดและการใช้งานที่ยาวนาน

- สาม

- ตลอด

- เวลา

- ครั้ง

- ไปยัง

- ไฟฉาย

- โตรอน

- ลู่

- รถไฟ

- การฝึกอบรม

- การฝึกอบรม

- แปลความ

- ภายใต้

- พื้นฐาน

- บันทึก

- อัปโหลด

- us

- ใช้

- การตรวจสอบ

- ความคุ้มค่า

- ต่างๆ

- รายละเอียด

- ทาง..

- วิธี

- เว็บ

- บริการเว็บ

- ดี

- อะไร

- ที่

- ในขณะที่

- จะ

- กับ

- ภายใน

- ไม่มี

- ทำงาน

- การทำงาน

- คุณ

- ของคุณ

- ลมทะเล