Milyarlarca parametreyle büyük dil modellerini (LLM'ler) eğitmek zor olabilir. Araştırmacıların, model mimarisini tasarlamaya ek olarak, karma kesinlik desteği, gradyan birikimi ve kontrol noktası gibi dağıtılmış eğitim için en son teknoloji eğitim tekniklerini oluşturması gerekir. Büyük modellerde, eğitim kurulumu daha da zordur çünkü tek bir hızlandırıcı cihazdaki kullanılabilir bellek, yalnızca veri paralelliği kullanılarak eğitilen modellerin boyutunu sınırlar ve model paralel eğitiminin kullanılması, eğitim kodunda ek düzeyde değişiklikler gerektirir. gibi kütüphaneler Derin Hız (PyTorch için açık kaynaklı bir derin öğrenme optimizasyon kitaplığı) bu zorluklardan bazılarını ele alır ve model geliştirme ile eğitimi hızlandırmaya yardımcı olabilir.

Bu gönderide, Intel Habana Gaudi tabanlı bir eğitim kurduk. Amazon Elastik Bilgi İşlem Bulutu (Amazon EC2) DL1 örnekler ve DeepSpeed gibi bir ölçeklendirme çerçevesi kullanmanın faydalarını ölçün. Kodlayıcı tipi bir trafo modeli (340 milyon ila 1.5 milyar parametreli BERT) için ölçeklendirme sonuçları sunuyoruz. 1.5 milyar parametreli model için, kullanarak 82.7 hızlandırıcıda (128 dl16xlarge bulut sunucusu) %1.24'lik bir ölçeklendirme verimliliği elde ettik. Derin Hız Sıfır Aşama 1 optimizasyonları. Optimize edici durumları, veri paralel paradigması kullanılarak büyük modelleri eğitmek için DeepSpeed tarafından bölümlendi. Bu yaklaşım, veri paralelliği kullanan 5 milyar parametreli bir modeli eğitmek için genişletildi. Ayrıca, FP16 veri tipini kullanmaya kıyasla daha az bellek boyutu ve daha yüksek eğitim performansı için Gaudi'nin yerel BF32 veri tipi desteğini kullandık. Sonuç olarak, BERT 1 milyar parametreli model için, wikicorpus-en veri kümesi.

eğitim kurulumu

Kullanarak 16 dl1.24xlarge örneğinden oluşan bir yönetilen bilgi işlem kümesi sağladık AWS Toplu İş. geliştirdik AWS Batch atölyesi bu, AWS Batch ile dağıtılmış eğitim kümesini kurma adımlarını gösterir. Her dl1.24xlarge bulut sunucusu, her biri 32 GB belleğe sahip sekiz Habana Gaudi hızlandırıcısına ve her biri 700 Gb/sn toplam çift yönlü ara bağlantı bant genişliğine sahip kartlar arasında tam ağ RoCE ağına sahiptir (bkz. Amazon EC2 DL1 bulut sunucuları Ayrıntılı İnceleme daha fazla bilgi için). dl1.24xlarge kümesi ayrıca dört tane kullandı AWS Elastik Yapı Adaptörleri (EFA), düğümler arasında toplam 400 Gb/sn ara bağlantı ile.

Dağıtılmış eğitim atölyesi, dağıtılmış eğitim kümesini kurma adımlarını gösterir. Atölye çalışması, AWS Batch kullanan dağıtılmış eğitim kurulumunu ve özellikle tam olarak yönetilen kümelerde büyük ölçekli kapsayıcılı eğitim işlerini başlatmak için çok düğümlü paralel işler özelliğini gösterir. Daha spesifik olarak, DL1 bulut sunucuları ile tam olarak yönetilen bir AWS Batch bilgi işlem ortamı oluşturulur. Konteynerler çekilir Amazon Elastik Konteyner Kayıt Defteri (Amazon ECR) ve çok düğümlü paralel iş tanımına göre kümedeki bulut sunucularına otomatik olarak başlatıldı. Çalıştay, PyTorch ve DeepSpeed kullanarak bir BERT (340 milyon ila 1.5 milyar parametre) modelinin çok düğümlü, çok HPU veri paralel eğitimini çalıştırarak sona erer.

DeepSpeed ile BERT 1.5B ön eğitimi

Habana Synapse AI v1.5 ve v1.6 DeepSpeed ZeRO1 optimizasyonlarını destekler. bu DeepSpeed GitHub deposunun Habana çatalı Gaudi hızlandırıcılarını desteklemek için gerekli değişiklikleri içerir. Dağıtılmış veri paralel (çoklu kart, çoklu örnek), ZeRO1 optimizasyonları ve BF16 veri türleri için tam destek vardır.

Tüm bu özellikler, BERT 1.5B modeli referans deposu, bir BERT uygulamasından türetilen 48 katmanlı, 1600 gizli boyut ve 25 kafalı çift yönlü kodlayıcı modeli sunar. Depo aynı zamanda temel BERT Büyük model uygulamasını da içerir: 24 katmanlı, 1024 gizli, 16 başlı, 340 milyon parametreli sinir ağı mimarisi. Eğitim öncesi modelleme betikleri şu kaynaktan türetilmiştir: NVIDIA Derin Öğrenme Örnekleri deposu wikicorpus_en verilerini indirmek, ham verileri belirteçler halinde önceden işlemek ve dağıtılmış veri paralel eğitimi için verileri daha küçük h5 veri kümelerine parçalamak için. DL1 örneklerini kullanarak veri kümelerinizi kullanarak özel PyTorch model mimarilerinizi eğitmek için bu genel yaklaşımı benimseyebilirsiniz.

Eğitim öncesi (1. aşama) ölçeklendirme sonuçları

Geniş ölçekli ön eğitim için, çözümün iki yönüne odaklandık: eğitim süresiyle ölçülen eğitim performansı ve tamamen yakınsanmış bir çözüme ulaşmanın maliyet etkinliği. Ardından, örnek olarak BERT 1.5B ön eğitimi ile bu iki ölçümü daha derinlemesine inceleyeceğiz.

Performansı ve eğitim süresini ölçeklendirme

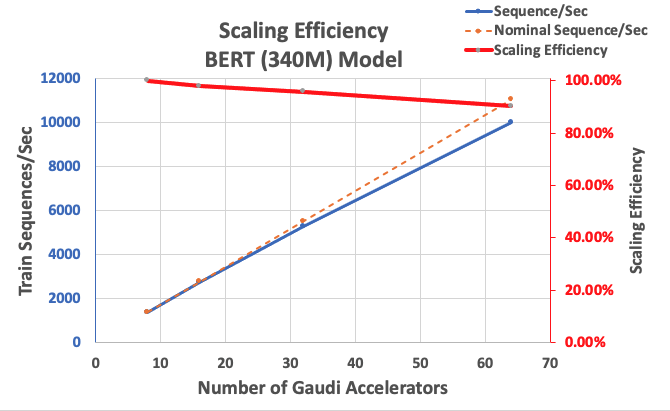

Ölçeklenebilirlik için bir temel olarak BERT Large uygulamasının performansını ölçerek başlıyoruz. Aşağıdaki tablo, 1-8 dl1.24xlarge örneğinden (örnek başına sekiz hızlandırıcı cihazla) saniye başına dizilerin ölçülen verimini listeler. Tek eşgörünüm verimini temel olarak kullanarak, fiyat-performans eğitimi metriğini anlamak için önemli bir kaldıraç olan birden çok eşgörünüm genelinde ölçeklemenin etkinliğini ölçtük.

| Örnek Sayısı | Hızlandırıcı Sayısı | Saniyedeki Diziler | Hızlandırıcı Başına Saniye Başına Diziler | Ölçeklendirme Verimliliği |

| 1 | 8 | 1,379.76 | 172.47 | İNDİRİM |

| 2 | 16 | 2,705.57 | 169.10 | İNDİRİM |

| 4 | 32 | 5,291.58 | 165.36 | İNDİRİM |

| 8 | 64 | 9,977.54 | 155.90 | İNDİRİM |

Aşağıdaki şekil, ölçeklendirme verimliliğini göstermektedir.

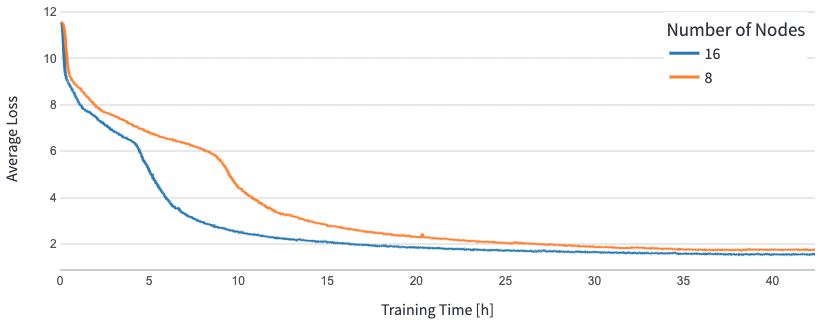

BERT 1.5B için, yakınsamayı garanti etmek için referans deposundaki modelin hiperparametrelerini değiştirdik. Hızlandırıcı başına etkili parti boyutu, adım başına 384'lık mikro partiler ve 16 aşamalı gradyan birikimi ile 24'e (maksimum bellek kullanımı için) ayarlandı. 0.0015 ve 0.003 düğüm için sırasıyla 8 ve 16 öğrenme oranları kullanıldı. Bu yapılandırmalarla, BERT 1B'nin 1.5. aşama ön eğitiminin 8 dl1.24xlarge bulut sunucusunda (64 hızlandırıcı) yaklaşık 25 saatte ve 15 dl16xlarge bulut sunucusunda (1.24 hızlandırıcı) 128 saatte yakınsamasını sağladık. Aşağıdaki şekil, hızlandırıcı sayısını artırdıkça, eğitim dönemi sayısının bir fonksiyonu olarak ortalama kaybı göstermektedir.

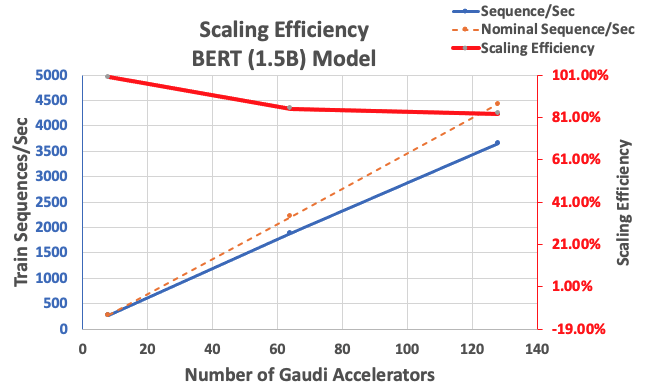

Daha önce açıklanan yapılandırmayla, tek bir örnekte 85 hızlandırıcıdan oluşan bir taban çizgisinden 64 hızlandırıcıyla %83 ve 128 hızlandırıcıyla %8 güçlü ölçeklendirme verimliliği elde ettik. Aşağıdaki tablo parametreleri özetlemektedir.

| Örnek Sayısı | Hızlandırıcı Sayısı | Saniyedeki Diziler | Hızlandırıcı Başına Saniye Başına Diziler | Ölçeklendirme Verimliliği |

| 1 | 8 | 276.66 | 34.58 | İNDİRİM |

| 8 | 64 | 1,883.63 | 29.43 | İNDİRİM |

| 16 | 128 | 3,659.15 | 28.59 | İNDİRİM |

Aşağıdaki şekil, ölçeklendirme verimliliğini göstermektedir.

Sonuç

Bu gönderide, Habana SynapseAI v1.5/v1.6 tarafından sağlanan DeepSpeed desteğini ve Habana Gaudi hızlandırıcılarında LLM eğitimini ölçeklendirmeye nasıl yardımcı olduğunu değerlendirdik. 1.5 milyar parametreli bir BERT modelinin ön eğitimi, %16 güçlü ölçekleme ile 128 Gaudi hızlandırıcıdan oluşan bir kümede bir araya gelmek için 85 saat sürdü. Gösterilen mimariye bir göz atmanızı öneririz. AWS atölyesi ve DL1 örneklerini kullanarak özel PyTorch model mimarilerini eğitmek için benimsemeyi düşünün.

yazarlar hakkında

Mahadevan Balasubramanyam Fizik destekli derin öğrenme, dijital ikizleri geniş ölçekte endüstriyel sistemler için oluşturma ve dağıtma alanında yaklaşık 20 yıllık deneyime sahip Otonom Bilgi İşlem için Baş Çözüm Mimarıdır. Mahadevan, Massachusetts Teknoloji Enstitüsü'nden Makine Mühendisliği alanında doktora derecesini almıştır ve kendisine ait 25'in üzerinde patent ve yayına sahiptir.

Mahadevan Balasubramanyam Fizik destekli derin öğrenme, dijital ikizleri geniş ölçekte endüstriyel sistemler için oluşturma ve dağıtma alanında yaklaşık 20 yıllık deneyime sahip Otonom Bilgi İşlem için Baş Çözüm Mimarıdır. Mahadevan, Massachusetts Teknoloji Enstitüsü'nden Makine Mühendisliği alanında doktora derecesini almıştır ve kendisine ait 25'in üzerinde patent ve yayına sahiptir.

RJ Search M5 ekibinde, eğitim ve çıkarım için büyük ölçekli derin öğrenme sistemleri oluşturma çabalarına öncülük eden bir mühendistir. İş dışında farklı mutfakları keşfediyor ve raket sporları yapıyor.

RJ Search M5 ekibinde, eğitim ve çıkarım için büyük ölçekli derin öğrenme sistemleri oluşturma çabalarına öncülük eden bir mühendistir. İş dışında farklı mutfakları keşfediyor ve raket sporları yapıyor.

Sundar Ranganathan Amazon EC2 ekibinde İş Geliştirme, ML Çerçeveleri Başkanıdır. Amazon EKS, Amazon ECS, Elastic Fabric Adapter, AWS Batch ve Amazon SageMaker gibi AWS hizmetlerinde büyük ölçekli makine öğrenimi iş yüklerine odaklanıyor. Deneyimi, NetApp, Micron Technology, Qualcomm ve Mentor Graphics'te ürün yönetimi ve ürün geliştirmede liderlik rollerini içermektedir.

Sundar Ranganathan Amazon EC2 ekibinde İş Geliştirme, ML Çerçeveleri Başkanıdır. Amazon EKS, Amazon ECS, Elastic Fabric Adapter, AWS Batch ve Amazon SageMaker gibi AWS hizmetlerinde büyük ölçekli makine öğrenimi iş yüklerine odaklanıyor. Deneyimi, NetApp, Micron Technology, Qualcomm ve Mentor Graphics'te ürün yönetimi ve ürün geliştirmede liderlik rollerini içermektedir.

Abhinandan Patnisi Amazon Search'te Kıdemli Yazılım Mühendisidir. Ölçeklenebilir dağıtılmış derin öğrenme eğitimi ve gerçek zamanlı çıkarım için sistemler ve araçlar oluşturmaya odaklanır.

Abhinandan Patnisi Amazon Search'te Kıdemli Yazılım Mühendisidir. Ölçeklenebilir dağıtılmış derin öğrenme eğitimi ve gerçek zamanlı çıkarım için sistemler ve araçlar oluşturmaya odaklanır.

Pierre-Yves Aquilanti Amazon Web Services'ta Çerçeveler ML Çözümleri Başkanıdır ve burada sektörün en iyi bulut tabanlı ML Çerçeveleri çözümlerini geliştirmeye yardımcı olur. Pierre-Yves, Yüksek Performanslı Bilgi İşlem alanında geçmişe sahiptir ve AWS'ye katılmadan önce, Pierre-Yves Petrol ve Gaz endüstrisinde çalışıyordu. Pierre-Yves aslen Fransa'lıdır ve doktora derecesine sahiptir. Lille Üniversitesi Bilgisayar Bilimleri bölümünden.

Pierre-Yves Aquilanti Amazon Web Services'ta Çerçeveler ML Çözümleri Başkanıdır ve burada sektörün en iyi bulut tabanlı ML Çerçeveleri çözümlerini geliştirmeye yardımcı olur. Pierre-Yves, Yüksek Performanslı Bilgi İşlem alanında geçmişe sahiptir ve AWS'ye katılmadan önce, Pierre-Yves Petrol ve Gaz endüstrisinde çalışıyordu. Pierre-Yves aslen Fransa'lıdır ve doktora derecesine sahiptir. Lille Üniversitesi Bilgisayar Bilimleri bölümünden.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- EVM Finans. Merkezi Olmayan Finans için Birleşik Arayüz. Buradan Erişin.

- Kuantum Medya Grubu. IR/PR Güçlendirilmiş. Buradan Erişin.

- PlatoAiStream. Web3 Veri Zekası. Bilgi Genişletildi. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/accelerate-pytorch-with-deepspeed-to-train-large-language-models-with-intel-habana-gaudi-based-dl1-ec2-instances/

- :vardır

- :dır-dir

- :Neresi

- $UP

- 1

- 100

- İNDİRİM

- 16

- 20

- 20 yıl

- 24

- 25

- 7

- 8

- a

- hızlandırmak

- hızlandırıcı

- hızlandırıcılar

- birikim

- elde

- karşısında

- ilave

- Ek

- adres

- benimsemek

- Benimsemek

- Ayrıca

- Amazon

- Amazon EC2

- Amazon Adaçayı Yapıcı

- Amazon Web Servisleri

- an

- ve

- yaklaşım

- yaklaşık olarak

- mimari

- ARE

- ALAN

- gelmeden

- AS

- yönleri

- At

- otomatik olarak

- özerk

- mevcut

- ortalama

- AWS

- arka fon

- Bant genişliği

- merkezli

- Temel

- BE

- Çünkü

- olmuştur

- faydaları

- İYİ

- arasında

- Milyar

- milyarlarca

- bina

- iş

- iş geliştirme

- by

- CAN

- Kartlar

- zorluklar

- zor

- bulut

- Küme

- kod

- karşılaştırıldığında

- oluşur

- hesaplamak

- bilgisayar

- Bilgisayar Bilimleri

- bilgisayar

- yapılandırma

- Düşünmek

- Konteyner

- Konteynerler

- içeren

- yakınsamak

- Yakınsama

- çevrimiçi kurslar düzenliyorlar.

- kredi

- görenek

- veri

- veri kümeleri

- gün

- derin

- derin öğrenme

- derin

- gösterdi

- dağıtma

- Türetilmiş

- tarif edilen

- tasarım

- geliştirmek

- gelişmiş

- gelişme

- cihaz

- Cihaz

- farklı

- dijital

- Dijital ikizler

- Boyut

- dağıtıldı

- dağıtılmış eğitim

- indir

- her

- Daha erken

- Etkili

- verim

- çabaları

- etkin

- teşvik etmek

- mühendis

- Mühendislik

- çevre

- devirler

- değerlendirilir

- Hatta

- örnek

- örnekler

- deneyim

- araştırıyor

- kumaş

- Özellikler(Hazırlık aşamasında)

- Özellikler

- şekil

- odaklanmış

- odaklanır

- takip etme

- Gıda

- İçin

- çatal

- dört

- iskelet

- çerçeveler

- Fransa

- itibaren

- tam

- tamamen

- işlev

- GAZ

- Git

- GitHub

- grafik

- garanti

- he

- baş

- yardım et

- yardımcı olur

- Yüksek

- onun

- tutar

- SAAT

- Ne kadar

- HTML

- http

- HTTPS

- göstermektedir

- uygulama

- önemli

- in

- içerir

- artmış

- Sanayi

- sanayi

- endüstrinin

- bilgi

- örnek

- Enstitü

- Intel

- içine

- Tanıtımlar

- IT

- İş

- Mesleki Öğretiler

- birleştirme

- jpg

- dil

- büyük

- büyük ölçekli

- başlatmak

- başlattı

- Liderlik

- önemli

- öğrenme

- seviye

- kütüphaneler

- Kütüphane

- sevmek

- Listeler

- Yüksek Lisans

- Bakın

- kayıp

- ağırlıklı olarak

- yönetilen

- yönetim

- massachusetts

- Massachusetts Teknoloji Enstitüsü

- maksimum

- ölçme

- mekanik

- Bellek

- örgü

- metrik

- Metrikleri

- mikron

- milyon

- karışık

- ML

- model

- Modelleme

- modelleri

- Değişiklikler

- değiştirilmiş

- Daha

- çoklu

- yerli

- neredeyse

- gerekli

- gerek

- ağ

- sinir ağı

- sonraki

- düğümler

- numara

- elde

- of

- Sıvı yağ

- on

- bir tek

- açık kaynak

- optimizasyon

- aslında

- bizim

- dışında

- tekrar

- paradigma

- Paralel

- parametreler

- belirli

- Patentler

- performans

- faz

- Platon

- Plato Veri Zekası

- PlatoVeri

- çalış

- Çivi

- Hassas

- mevcut

- Anapara

- Önceki

- PLATFORM

- ürün geliştirme

- ürün Yönetimi

- yayınlar

- pytorch

- Qualcomm

- oranlar

- Çiğ

- gerçek

- gerçek zaman

- Indirimli

- Depo

- gerektirir

- Araştırmacılar

- sırasıyla

- sonuç

- Sonuçlar

- rolleri

- koşu

- sagemaker

- ölçeklenebilirlik

- ölçeklenebilir

- ölçek

- ölçekleme

- Bilim

- scriptler

- Ara

- İkinci

- görmek

- kıdemli

- Hizmetler

- set

- kurulum

- Gösteriler

- tek

- beden

- daha küçük

- Yazılım

- Yazılım Mühendisi

- çözüm

- Çözümler

- biraz

- özellikle

- Spor

- Aşama

- başlama

- state-of-the-art

- Devletler

- adım

- Basamaklar

- güçlü

- böyle

- destek

- Sistemler

- tablo

- Bizi daha iyi tanımak için

- Hedef

- takım

- teknikleri

- Teknoloji

- o

- The

- Alan

- Orada.

- Bunlar

- Re-Tweet

- verim

- zaman

- için

- Jeton

- aldı

- Toplam

- Tren

- eğitilmiş

- Eğitim

- transformatör

- ikizler

- iki

- tip

- türleri

- anlamak

- üniversite

- Kullanılmış

- kullanma

- v1

- oldu

- we

- ağ

- web hizmetleri

- vardı

- hangi

- ile

- içinde

- İş

- çalışma

- atölye

- yıl

- Sen

- zefirnet