"Şirketler, koda odaklanmak yerine, verileri güvenilir, verimli ve sistematik yollarla iyileştirmek için sistematik mühendislik uygulamaları geliştirmeye odaklanmalıdır. Başka bir deyişle, şirketlerin model merkezli bir yaklaşımdan veri merkezli bir yaklaşıma geçmesi gerekiyor.” – Andrew Ng

Veri merkezli bir yapay zeka yaklaşımı, veri hazırlama ve özellik mühendisliğini içeren kaliteli verilerle yapay zeka sistemleri oluşturmayı içerir. Bu, veri toplama, keşfetme, profil oluşturma, temizleme, yapılandırma, dönüştürme, zenginleştirme, doğrulama ve verileri güvenli bir şekilde depolamayı içeren sıkıcı bir görev olabilir.

Amazon SageMaker Veri Düzenleyicisi içinde bir hizmettir Amazon SageMaker Stüdyosu çok az kodlama kullanarak veya hiç kodlama yapmadan verileri içe aktarmak, hazırlamak, dönüştürmek, özellik haline getirmek ve analiz etmek için uçtan uca bir çözüm sunar. Veri ön işlemeyi ve özellik mühendisliğini basitleştirmek, PySpark kodu yazmaya, Apache Spark'ı kurmaya veya kümeleri döndürmeye gerek kalmadan veri hazırlığını üretime daha hızlı götürmek için bir Data Wrangler veri hazırlama akışını makine öğrenimi (ML) iş akışlarınıza entegre edebilirsiniz.

Veri dönüşümleri için kendi özel komut dosyalarınızı eklemeniz gereken senaryolar için, dönüşüm mantığınızı Pandas, PySpark, PySpark SQL'de yazabilirsiniz. Data Wrangler artık makine öğrenimi için metin verileri hazırlamak ve kısıtlama optimizasyonu gerçekleştirmek amacıyla özel dönüşümler yazmak için NLTK ve SciPy kitaplıklarını destekliyor.

Veri dönüşümü için kendi özel komut dosyalarınızı eklemeniz gereken senaryolarla karşılaşabilirsiniz. Data Wrangler özel dönüştürme yeteneği ile Pandas, PySpark, PySpark SQL'de dönüşüm mantığınızı yazabilirsiniz.

Bu gönderide, makine öğrenimi için metin verileri hazırlamak üzere özel dönüşümünüzü NLTK'de nasıl yazabileceğinizi tartışıyoruz. Ayrıca NLTK, NumPy, SciPy ve scikit-learn gibi diğer yaygın çerçevelerin yanı sıra AWS Yapay Zeka Hizmetlerinin kullanıldığı bazı örnek özel kod dönüşümlerini de paylaşacağız. Bu alıştırmanın amacı için, Titanik veri setiML topluluğunda popüler bir veri kümesi olan ve artık bir örnek veri kümesi Data Wrangler içinde.

Çözüme genel bakış

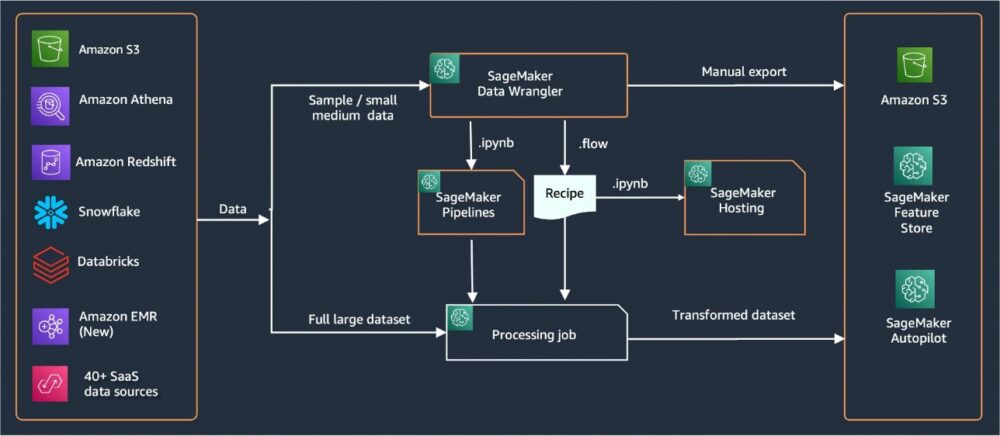

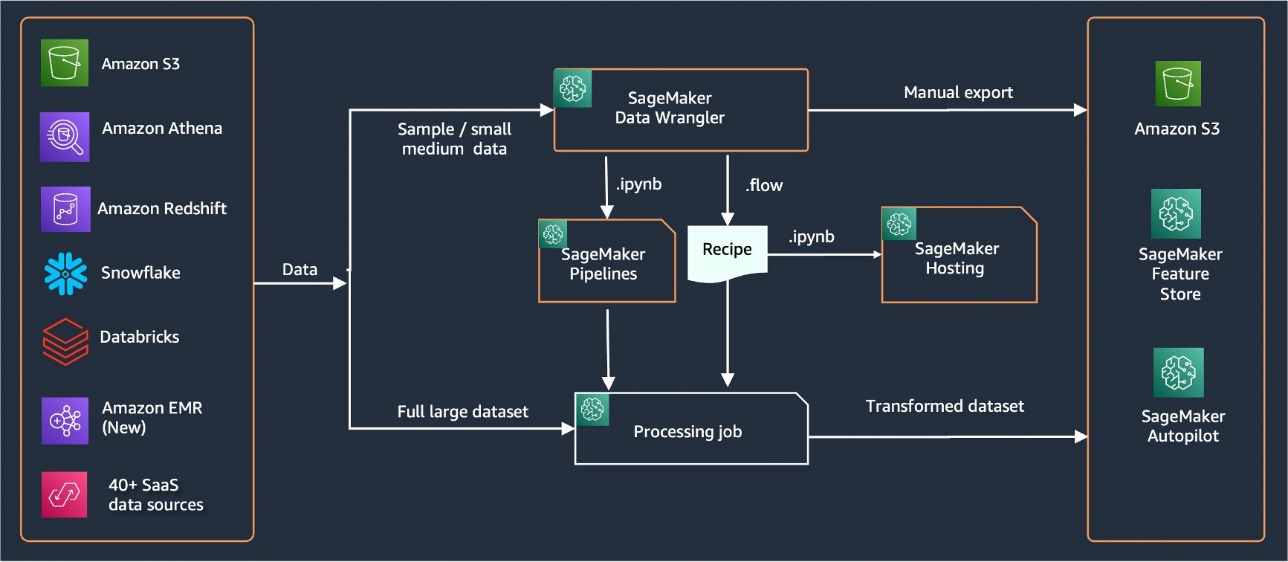

Data Wrangler, verileri içe aktarmak için 40'tan fazla yerleşik konektör sağlar. Veriler içe aktarıldıktan sonra, 300'ün üzerinde yerleşik dönüşümü kullanarak veri analizinizi ve dönüşümlerinizi oluşturabilirsiniz. Ardından, özellikleri şuraya itmek için endüstriyel boru hatları oluşturabilirsiniz: Amazon Basit Depolama Hizmeti (Amazon S3) veya Amazon SageMaker Özellik Mağazası. Aşağıdaki diyagram, uçtan uca üst düzey mimariyi göstermektedir.

Önkoşullar

Data Wrangler, içinde bulunan bir SageMaker özelliğidir. Amazon SageMaker Stüdyosu. Takip edebilirsin Studio katılım süreci Studio ortamını ve not defterlerini hızlandırmak için. Birkaç kimlik doğrulama yönteminden birini seçebilseniz de, bir Studio etki alanı oluşturmanın en basit yolu şu adımları izlemektir: Hızlı başlangıç talimatları. Hızlı başlangıç, standart Studio kurulumuyla aynı varsayılan ayarları kullanır. Ayrıca şunu kullanarak katılmayı da seçebilirsiniz: AWS IAM Kimlik Merkezi (AWS Single Sign-On'un halefi) kimlik doğrulaması için (bkz. IAM Identity Center'ı Kullanarak Amazon SageMaker Etki Alanında Yerleşik).

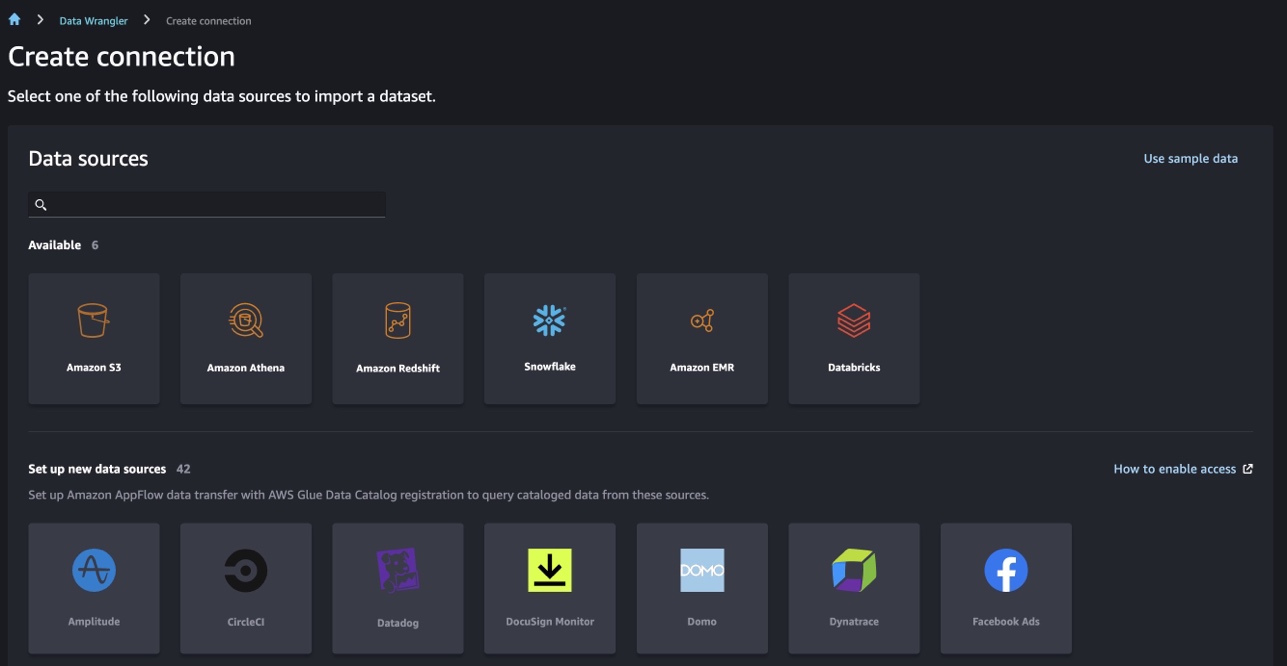

Titanik veri kümesini içe aktarın

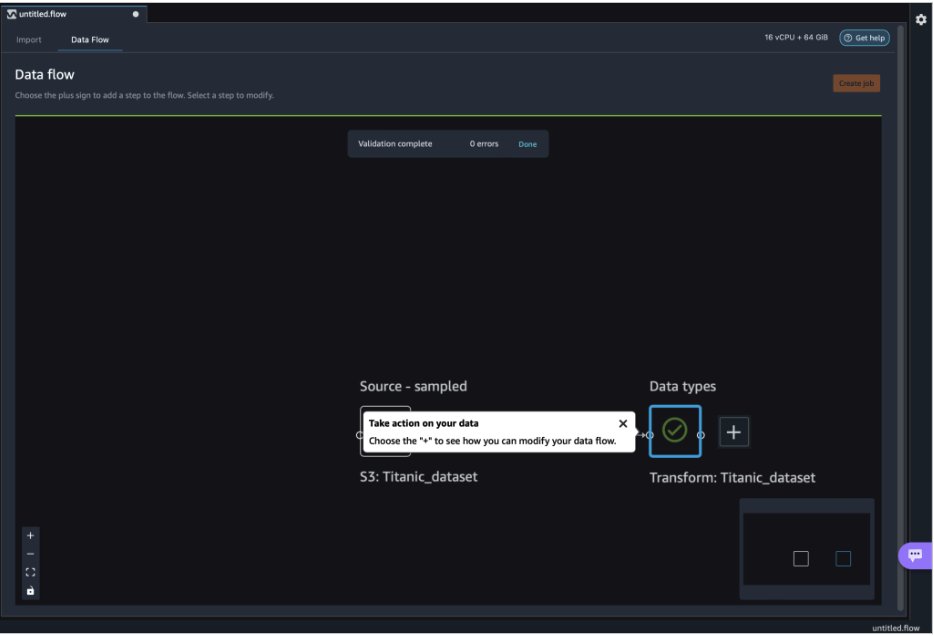

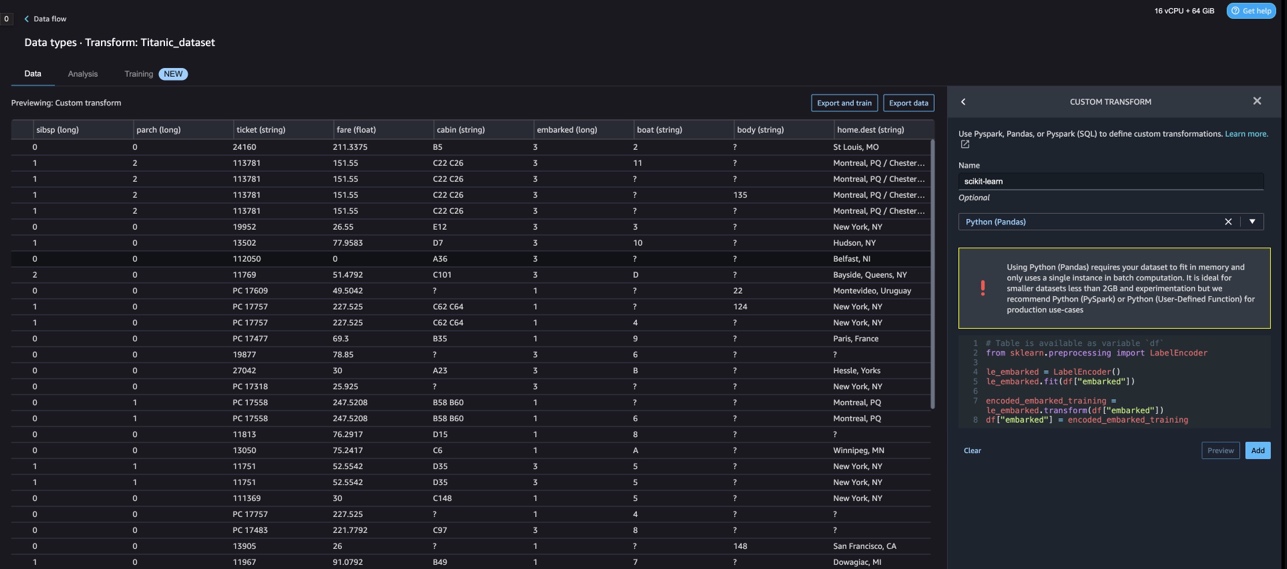

Studio ortamınızı başlatın ve yeni bir ortam oluşturun. Veri Wrangler akışı. Aşağıdaki ekran görüntüsünde gösterildiği gibi kendi veri setinizi içe aktarabilir veya örnek bir veri seti (Titanic) kullanabilirsiniz. Data Wrangler, farklı veri kaynaklarından veri kümelerini içe aktarmanıza olanak tanır. Kullanım durumumuz için, örnek veri kümesini bir S3 kovasından içe aktarıyoruz.

İçe aktarıldıktan sonra, veri akışında iki düğüm (kaynak düğüm ve veri türü düğümü) göreceksiniz. Data Wrangler, veri kümesindeki tüm sütunlar için veri türünü otomatik olarak tanımlar.

NLTK ile özel dönüşümler

Data Wrangler ile veri hazırlama ve özellik mühendisliği için 300'den fazla yerleşik dönüşüm kullanabilir veya kendi özel dönüşümlerinizi oluşturabilirsiniz. Özel dönüşümler Data Wrangler içinde ayrı adımlar olarak yazılabilir. Data Wrangler içindeki .flow dosyasının parçası olurlar. Özel dönüştürme özelliği, kod parçacıklarında farklı adımlar olarak Python, PySpark ve SQL'i destekler. .flow dosyasından not defteri dosyaları (.ipynb) oluşturulduktan veya .flow dosyası tarif olarak kullanıldıktan sonra, özel dönüştürme kod parçacıkları herhangi bir değişiklik gerektirmeden devam eder. Data Wrangler'ın bu tasarımı, özel dönüşümlerin, büyük veri kümelerini özel dönüşümlerle işlemek için bir SageMaker İşleme işinin parçası olmasına olanak tanır.

Titanic veri kümesi, metin bilgisi içeren birkaç özelliğe (ad ve home.dest) sahiptir. Kullanırız NLTK ad sütununu bölmek ve soyadını çıkarmak ve soyadlarının sıklığını yazdırmak için. NLTK, insan dili verileriyle çalışacak Python programları oluşturmaya yönelik lider bir platformdur. için kullanımı kolay arayüzler sağlar. 50'den fazla kurum ve sözlük kaynağı WordNet gibi, sınıflandırma, tokenleştirme, kök çıkarma, etiketleme, ayrıştırma ve anlamsal akıl yürütme için bir metin işleme kitaplıkları paketi ve endüstriyel güçte doğal dil işleme (NLP) kitaplıkları için sarmalayıcılar.

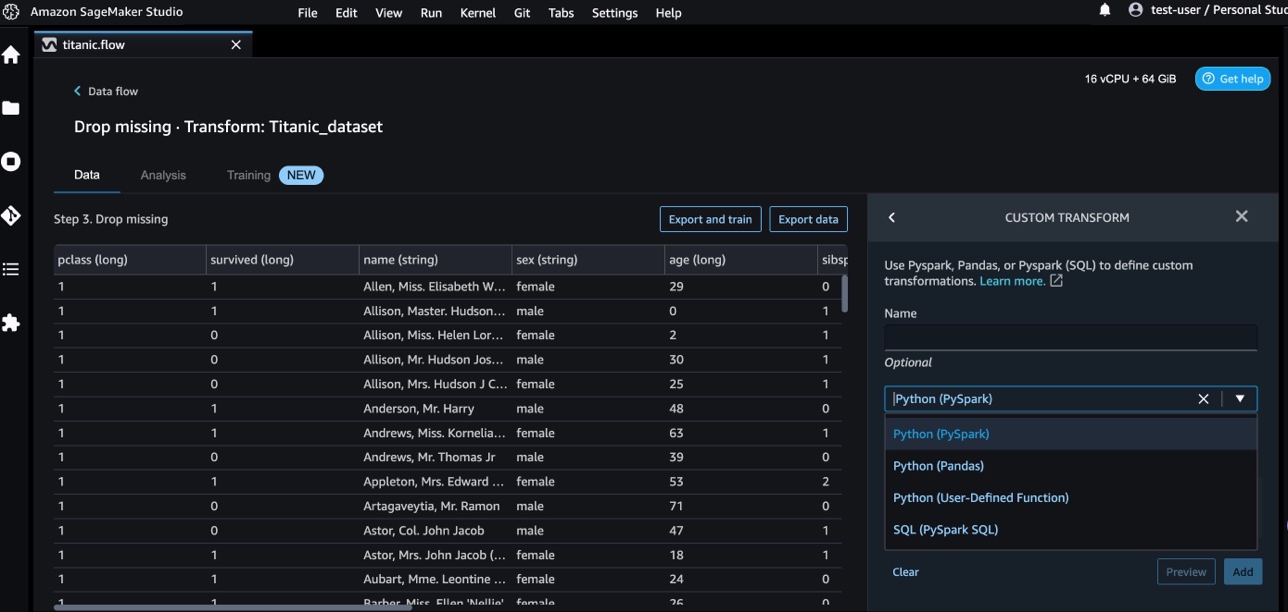

Yeni bir dönüşüm eklemek için aşağıdaki adımları tamamlayın:

- Artı işaretini seçin ve seçin Dönüşüm Ekle.

- Klinik Adım Ekle Ve seç Özel Dönüşüm.

Pandas, PySpark, Python kullanıcı tanımlı işlevleri ve SQL PySpark'ı kullanarak özel bir dönüşüm oluşturabilirsiniz.

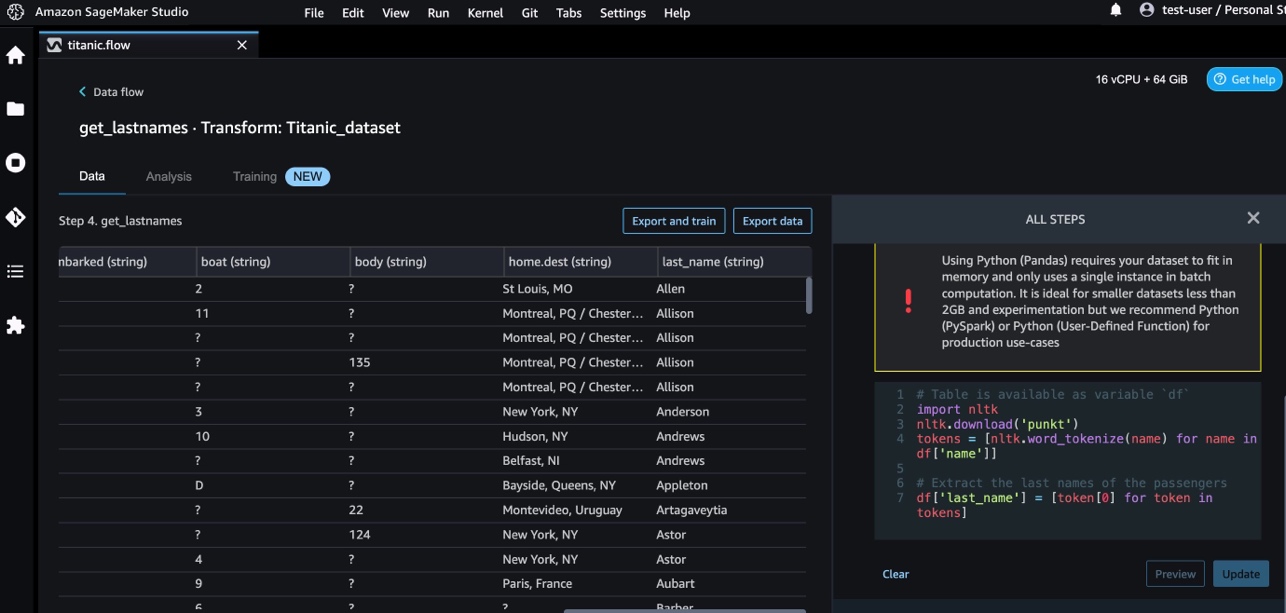

- Klinik Python (Pandalar) ve ad sütunundan soyadını çıkarmak için aşağıdaki kodu ekleyin:

- Klinik Önizleme sonuçları gözden geçirmek için.

Aşağıdaki ekran görüntüsü last_name sütun çıkarıldı.

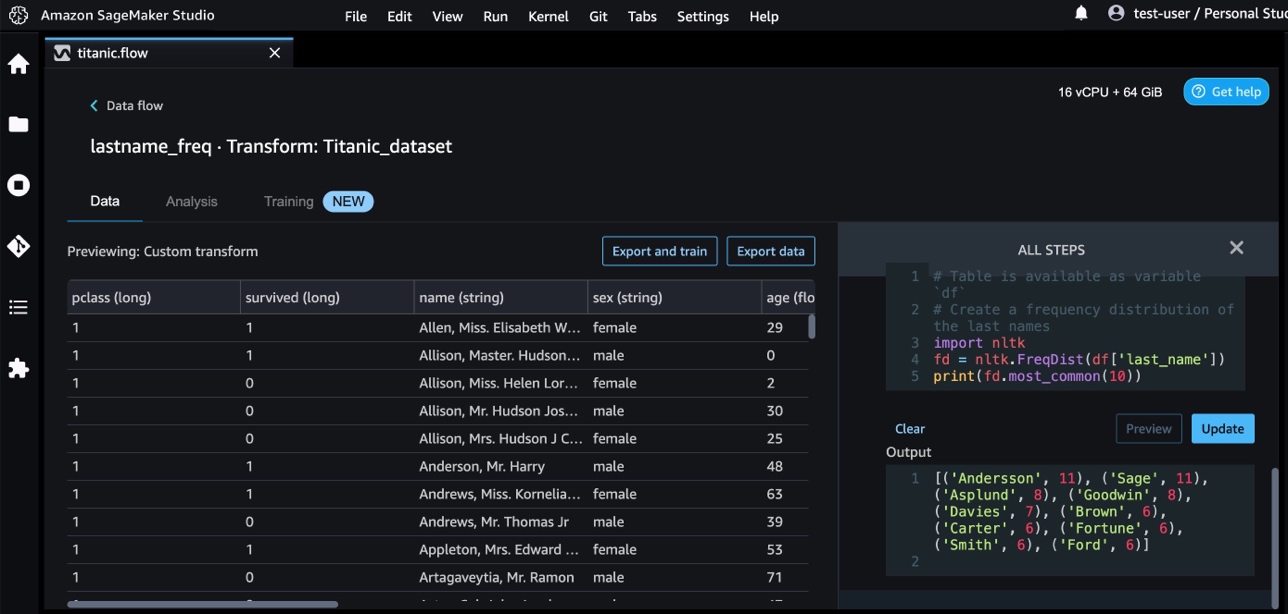

- Aşağıdaki kodu kullanarak soyadlarının sıklık dağılımını belirlemek için başka bir özel dönüştürme adımı ekleyin:

- Klinik Önizleme frekans sonuçlarını incelemek için

AWS AI hizmetleriyle özel dönüşümler

AWS'de önceden eğitilmiş yapay zeka hizmetleri, uygulamalarınız ve iş akışlarınız için hazır zeka sağlar. AWS AI hizmetleri, birçok yaygın kullanım durumunu ele almak için uygulamalarınızla kolayca entegre olur. Artık AWS AI hizmetlerinin özelliklerini Data Wrangler'da özel bir dönüştürme adımı olarak kullanabilirsiniz.

Amazon Kavramak belgelerin içeriği hakkında bilgi edinmek için NLP'yi kullanır. Bir belgedeki varlıkları, anahtar ifadeleri, dili, duyguları ve diğer ortak öğeleri tanıyarak içgörüler geliştirir.

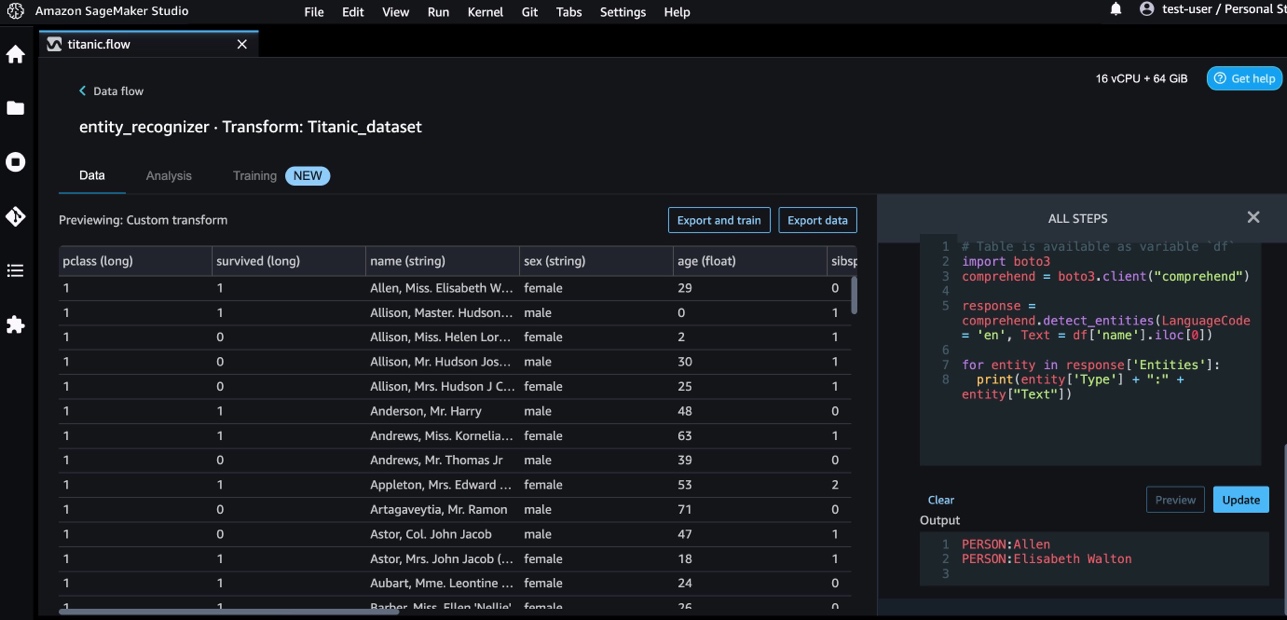

Varlıkları ad sütunundan çıkarmak için Amazon Comprehend'i kullanıyoruz. Aşağıdaki adımları tamamlayın:

- Özel bir dönüştürme adımı ekleyin.

- Klinik Python (Pandalar).

- Varlıkları ayıklamak için aşağıdaki kodu girin:

- Klinik Önizleme ve sonuçları görselleştirin.

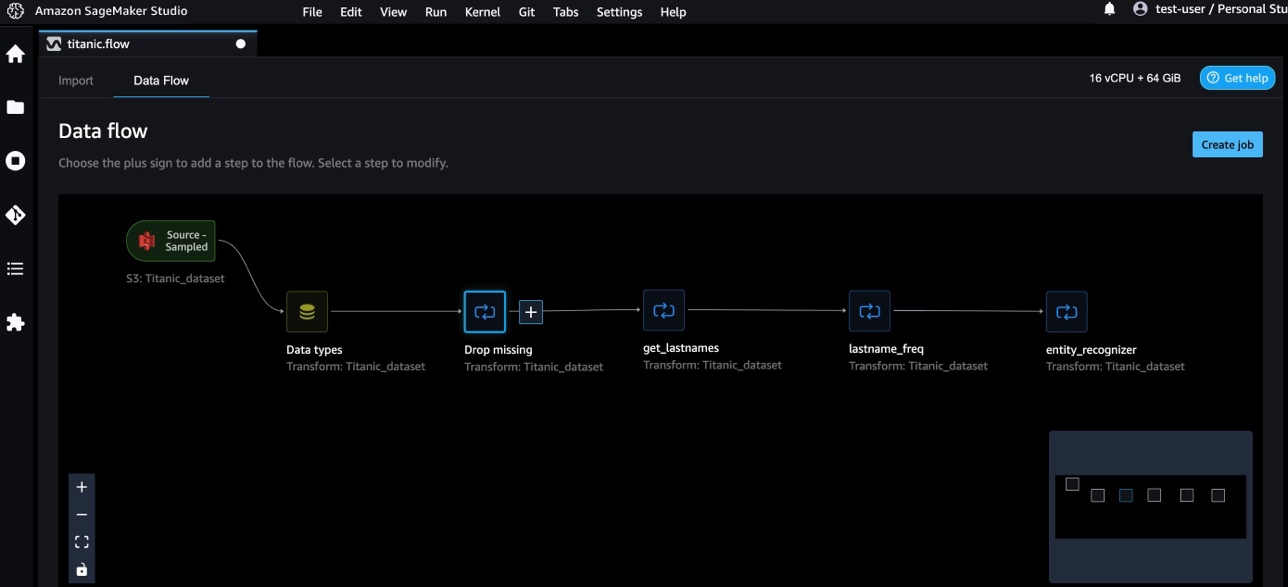

Şimdi Data Wrangler'a üç özel dönüşüm ekledik.

- Klinik Veri akışı uçtan uca veri akışını görselleştirmek için.

NumPy ve SciPy ile özel dönüşümler

Dizi Python için kapsamlı matematiksel işlevler, rasgele sayı üreteçleri, lineer cebir rutinleri, Fourier dönüşümleri ve daha fazlasını sunan açık kaynaklı bir kitaplıktır. scipy optimizasyon, doğrusal cebir, entegrasyon, enterpolasyon, özel fonksiyonlar, hızlı Fourier dönüşümü (FFT), sinyal ve görüntü işleme, çözücüler ve daha fazlası için modüller içeren, bilimsel hesaplama ve teknik hesaplama için kullanılan açık kaynaklı bir Python kitaplığıdır.

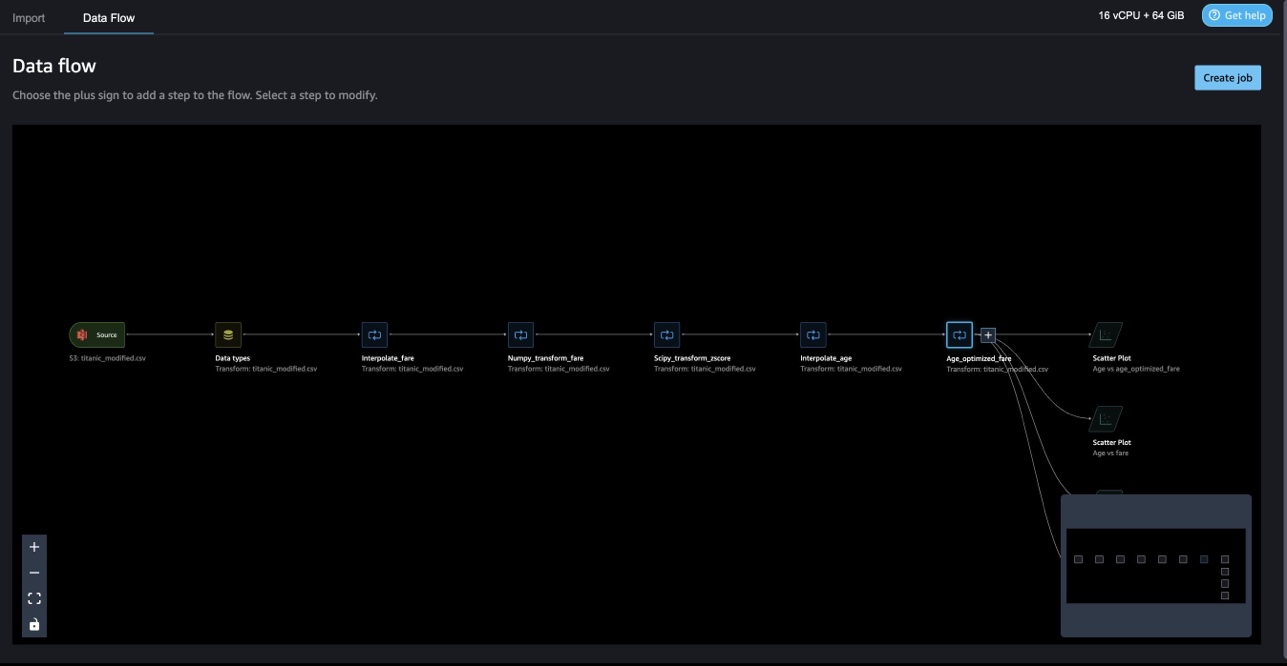

Data Wrangler özel dönüşümleri, Python, PySpark ve SQL'i farklı adımlar olarak birleştirmenize olanak tanır. Aşağıdaki Data Wrangler akışında, Python paketleri, NumPy ve SciPy'den farklı işlevler Titanic veri kümesine birden çok adım olarak uygulanır.

NumPy dönüşümleri

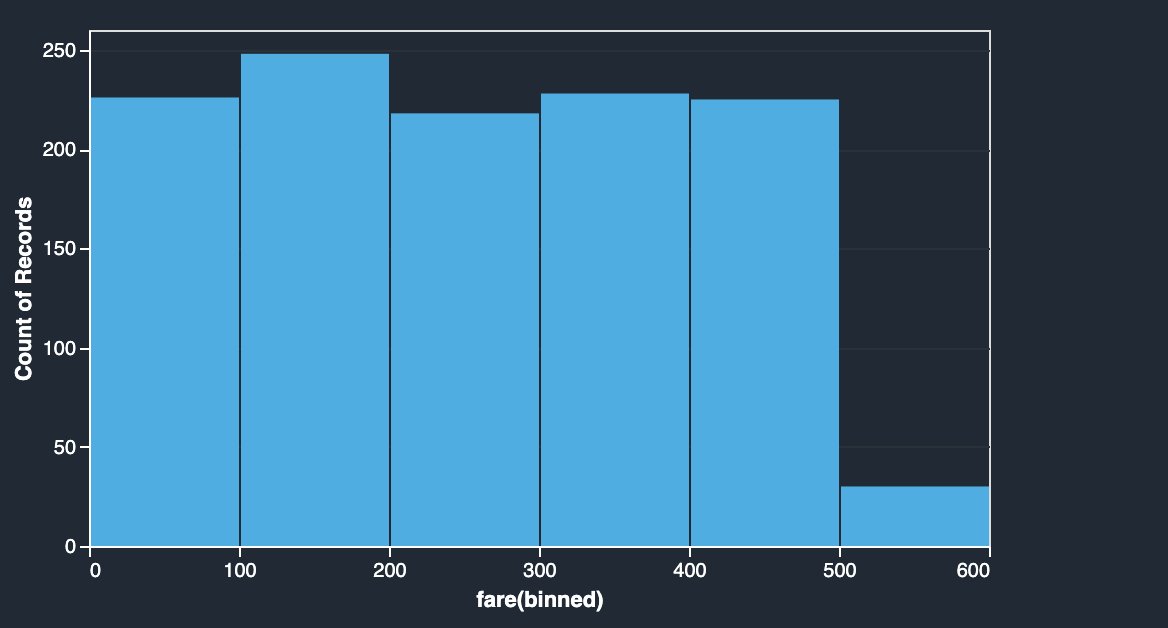

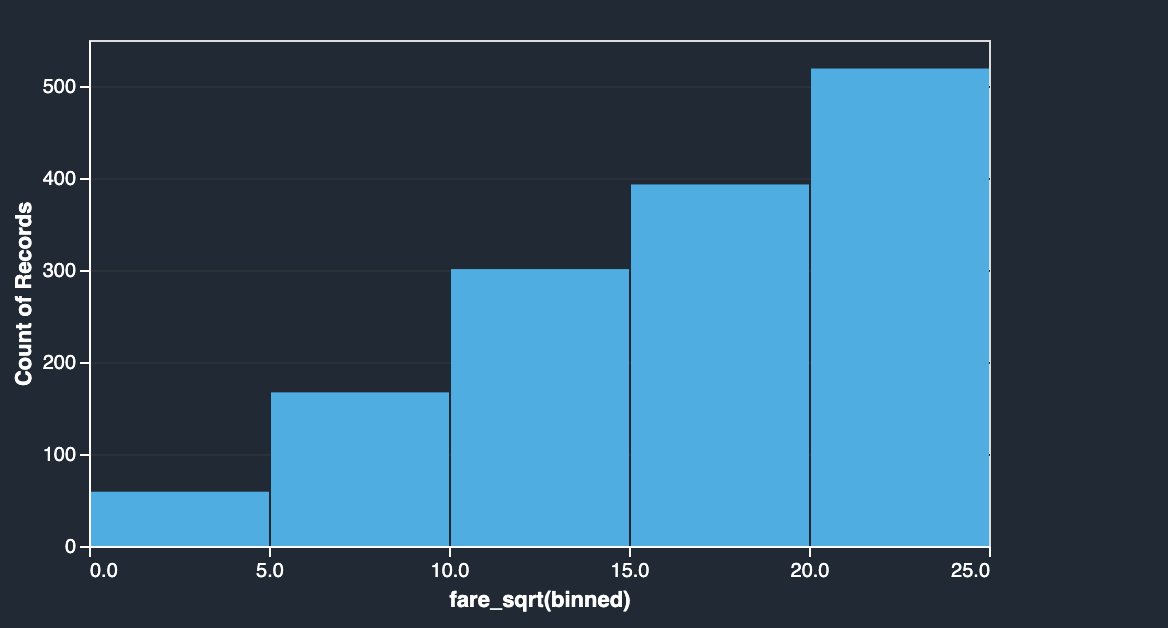

Titanic veri kümesinin ücret sütununda farklı yolcuların biniş ücretleri bulunur. Ücret sütununun histogramı, son kutu hariç tek tip dağılımı gösterir. Log veya karekök gibi NumPy dönüşümlerini uygulayarak dağılımı değiştirebiliriz (karekök dönüşümünde gösterildiği gibi).

|

|

Aşağıdaki koda bakın:

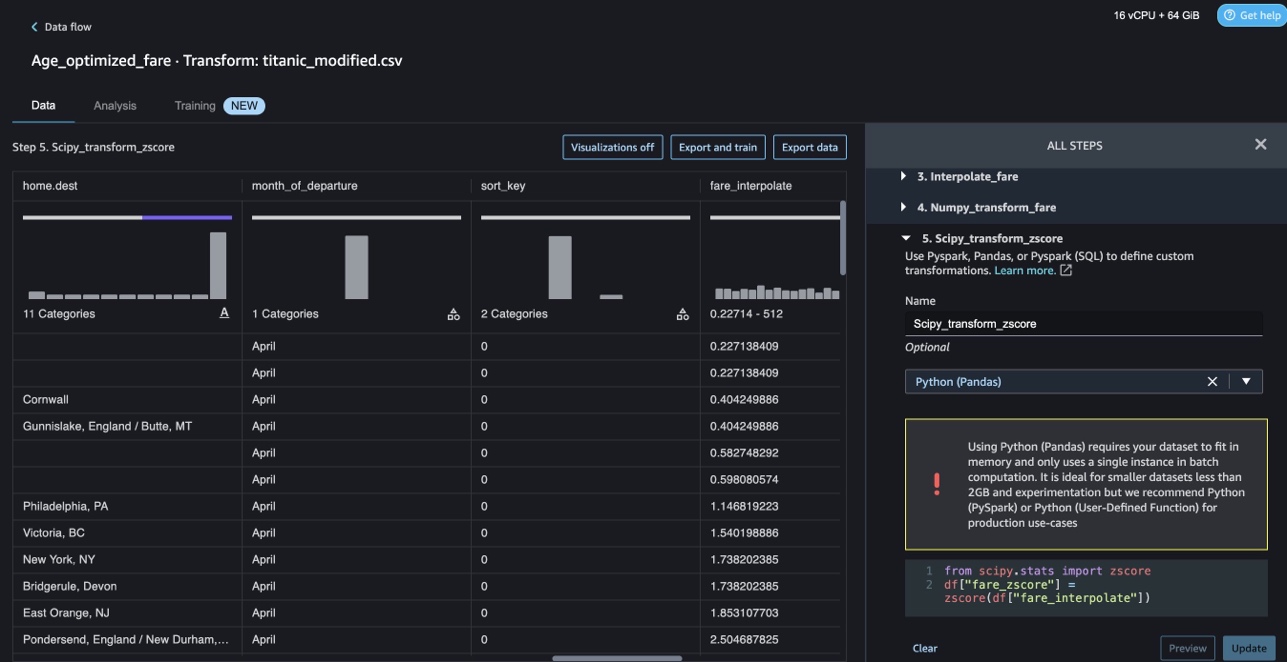

SciPy dönüşümleri

Z-skoru gibi SciPy işlevleri, ortalama ve standart sapma ile ücret dağıtımını standart hale getirmek için özel dönüşümün bir parçası olarak uygulanır.

Aşağıdaki koda bakın:

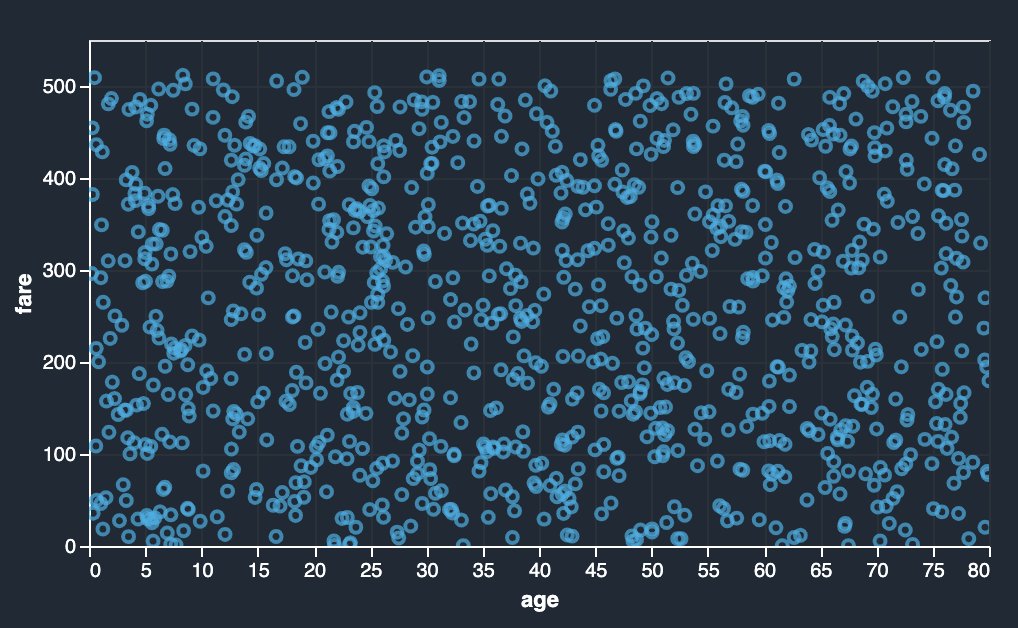

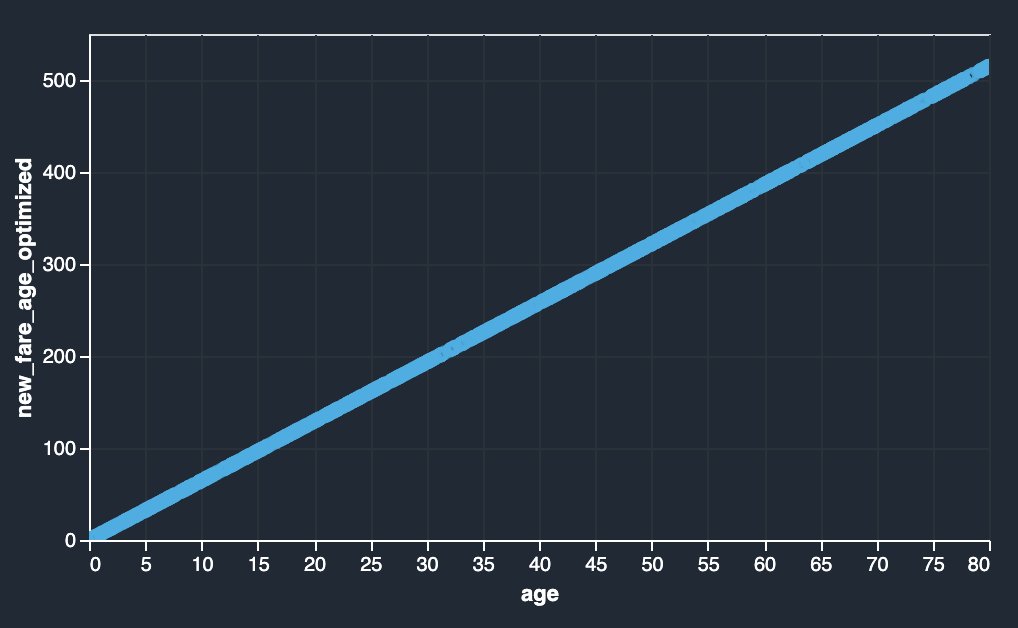

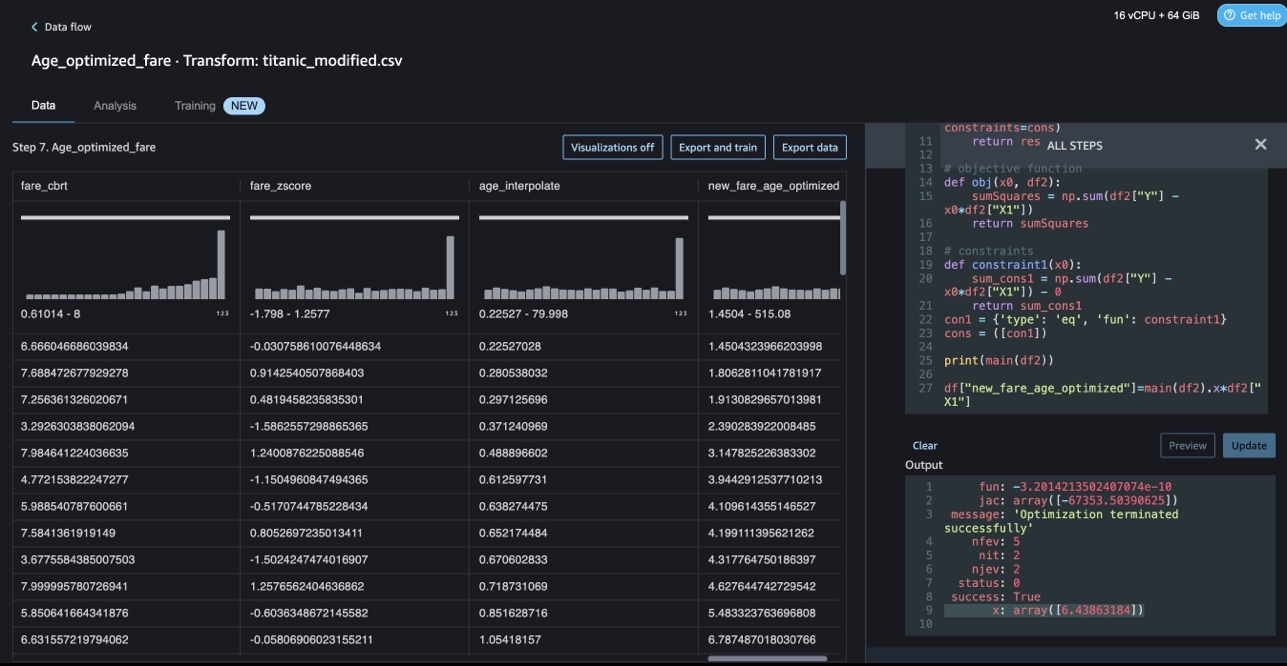

NumPy ve SciPy ile kısıtlama optimizasyonu

Data Wrangler özel dönüşümleri, kısıtlama optimizasyonu gibi SciPy optimizasyon işlevlerini uygulama ve SciPy'yi NumPy ile birleştirme gibi gelişmiş dönüşümleri işleyebilir. Aşağıdaki örnekte, yaşın bir fonksiyonu olarak ücret gözlemlenebilir herhangi bir eğilim göstermez. Bununla birlikte, kısıtlama optimizasyonu, ücreti yaşın bir fonksiyonu olarak dönüştürebilir. Bu durumda kısıtlama koşulu, yeni toplam ücretin eski toplam ücretle aynı kalmasıdır. Data Wrangler özel dönüşümleri, kısıtlı koşullar altında ücreti yaşın bir işlevi olarak dönüştürebilecek en uygun katsayıyı belirlemek için SciPy optimize etme işlevini çalıştırmanıza olanak tanır.

|

|

SciPy ve NumPy kullanarak bir Data Wrangler özel dönüşümünde kısıtlama optimizasyonu formüle edilirken optimizasyon tanımı, hedef tanımı ve çoklu kısıtlamalardan farklı işlevler olarak bahsedilebilir. Özel dönüşümler, SciPy optimize paketinin bir parçası olarak kullanılabilen farklı çözücü yöntemleri de getirebilir. Optimal katsayı orijinal sütunla çarpılarak yeni bir dönüştürülmüş değişken üretilebilir ve mevcut Data Wrangler sütunlarına eklenebilir. Aşağıdaki koda bakın:

Data Wrangler özel dönüştürme özelliği, optimum katsayı (veya birden çok katsayı) değeri gibi SciPy optimizasyon işlevlerinin sonuçlarını gösteren kullanıcı arabirimi özelliğine sahiptir.

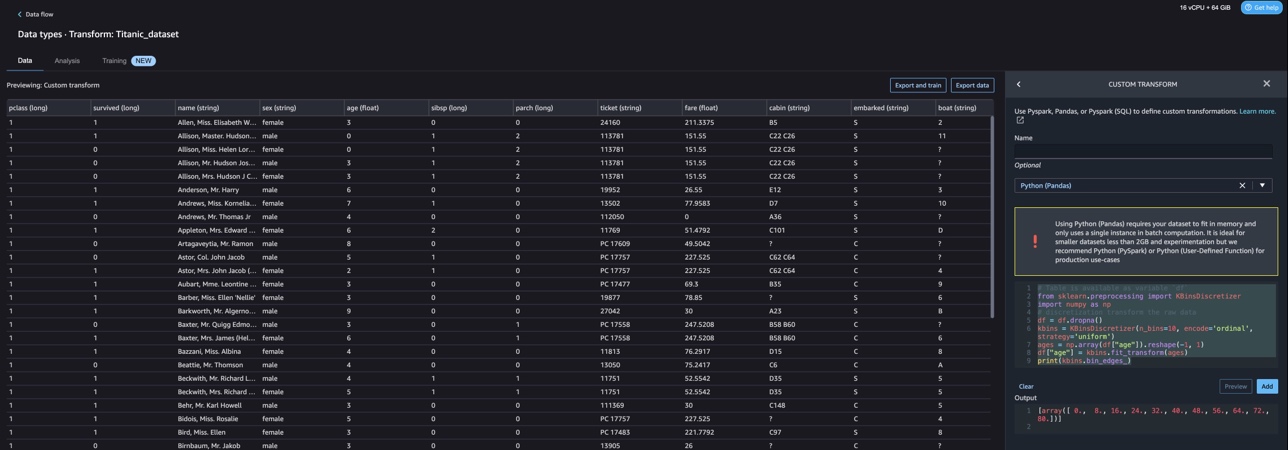

scikit-learn ile özel dönüşümler

scikit-öğrenme SciPy üzerine inşa edilmiş makine öğrenimi için bir Python modülüdür. Denetimli ve denetimsiz öğrenmeyi destekleyen açık kaynaklı bir makine öğrenimi kitaplığıdır. Ayrıca model uydurma, veri ön işleme, model seçimi, model değerlendirmesi ve diğer birçok yardımcı program için çeşitli araçlar sağlar.

Ayrıştırma

Ayrıştırma (diğer adıyla bilinir) niceleme or gruplama), sürekli özellikleri ayrık değerlere ayırmanın bir yolunu sağlar. Kesintisiz özelliklere sahip belirli veri kümeleri, ayrıklaştırmadan yararlanabilir çünkü ayrıklaştırma, sürekli özniteliklerin veri kümesini yalnızca nominal özniteliklere sahip bir veri kümesine dönüştürebilir. Tek seferlik kodlanmış ayrıklaştırılmış özellikler, yorumlanabilirliği korurken bir modeli daha anlamlı hale getirebilir. Örneğin, bir ayrıklaştırıcı ile ön işleme, doğrusal modellere doğrusal olmama durumu getirebilir.

Aşağıdaki kodda kullandığımız KBinsDiscretizer yaş sütununu 10 kutuya ayırmak için:

Aşağıdaki ekran görüntüsünde yazdırılan bölme kenarlarını görebilirsiniz.

Tek sıcak kodlama

Embarked sütunlarındaki değerler kategorik değerlerdir. Bu nedenle modelimiz ile sınıflandırmamızı yapabilmek için bu dizileri sayısal değerler olarak göstermemiz gerekmektedir. Bunu bir sıcak kodlama dönüşümü kullanarak da yapabiliriz.

Giriş için üç değer vardır: S, C ve Q. Bunları sayılarla temsil ediyoruz. Aşağıdaki koda bakın:

Temizlemek

Data Wrangler'ı kullanmadığınızda, ek ücret ödememek için çalıştığı bulut sunucusunu kapatmak önemlidir.

Data Wrangler, veri akışınızı her 60 saniyede bir otomatik olarak kaydeder. İş kaybından kaçınmak için Data Wrangler'ı kapatmadan önce veri akışınızı kaydedin.

- Studio'da veri akışınızı kaydetmek için fileto, Daha sonra seçmek Veri Wrangler Akışını Kaydet.

- Data Wrangler örneğini kapatmak için Studio'da Çalışan Örnekler ve Çekirdekler.

- Altında ÇALIŞAN UYGULAMALAR, sagemaker-data-wrangler-1.0 uygulamasının yanındaki kapatma simgesini seçin.

- Klinik hepsini kapat onaylamak.

Data Wrangler, bir ml.m5.4xlarge örneği üzerinde çalışır. Bu örnek şuradan kaybolur: ÇALIŞAN ÖRNEKLER Data Wrangler uygulamasını kapattığınızda.

Data Wrangler uygulamasını kapattıktan sonra, Data Wrangler akış dosyasını bir sonraki açışınızda uygulamanın yeniden başlatılması gerekir. Bu birkaç dakika sürebilir.

Sonuç

Bu gönderide, Data Wrangler'da özel dönüşümleri nasıl kullanabileceğinizi gösterdik. Yerleşik veri dönüştürme yeteneklerini genişletmek için Data Wrangler kapsayıcısı içindeki kitaplıkları ve çerçeveyi kullandık. Bu gönderideki örnekler, kullanılan çerçevelerin bir alt kümesini temsil eder. Data Wrangler akışındaki dönüşümler artık DataOps için bir boru hattına ölçeklendirilebilir.

Data Wrangler ile veri akışlarını kullanma hakkında daha fazla bilgi için bkz. Veri Wrangler Akışı Oluşturun ve Kullanın ve Amazon SageMaker Fiyatlandırması. Data Wrangler'ı kullanmaya başlamak için bkz. Amazon SageMaker Data Wrangler ile ML Verilerini Hazırlayın. SageMaker'da Autopilot ve AutoML hakkında daha fazla bilgi edinmek için şu adresi ziyaret edin: Amazon SageMaker Autopilot ile model geliştirmeyi otomatikleştirin.

yazarlar hakkında

Meenakshisundaram Thandavarayan AWS'de kıdemli bir AI/ML uzmanıdır. Yapay zeka ve makine öğrenimi yolculuklarında yüksek teknolojili stratejik hesaplara yardımcı olur. Veriye dayalı yapay zeka konusunda çok tutkulu.

Meenakshisundaram Thandavarayan AWS'de kıdemli bir AI/ML uzmanıdır. Yapay zeka ve makine öğrenimi yolculuklarında yüksek teknolojili stratejik hesaplara yardımcı olur. Veriye dayalı yapay zeka konusunda çok tutkulu.

Sovik Kumar Nath AWS ile bir AI/ML çözüm mimarıdır. Makine öğrenimi için uçtan uca tasarımlarda ve çözümlerde geniş deneyime sahiptir; finansal, operasyonel ve pazarlama analitiği içinde iş analitiği; sağlık hizmeti; tedarik zinciri; ve IoT. Sovik iş dışında seyahat etmeyi ve film izlemeyi seviyor.

Sovik Kumar Nath AWS ile bir AI/ML çözüm mimarıdır. Makine öğrenimi için uçtan uca tasarımlarda ve çözümlerde geniş deneyime sahiptir; finansal, operasyonel ve pazarlama analitiği içinde iş analitiği; sağlık hizmeti; tedarik zinciri; ve IoT. Sovik iş dışında seyahat etmeyi ve film izlemeyi seviyor.

Abigail Amazon SageMaker'da Yazılım Geliştirme Mühendisi. Müşterilerin verilerini DataWrangler'da hazırlamalarına ve dağıtılmış makine öğrenimi sistemleri oluşturmalarına yardımcı olma konusunda tutkulu. Abigail boş zamanlarında seyahat etmeyi, yürüyüş yapmayı, kayak yapmayı ve yemek pişirmeyi seviyor.

Abigail Amazon SageMaker'da Yazılım Geliştirme Mühendisi. Müşterilerin verilerini DataWrangler'da hazırlamalarına ve dağıtılmış makine öğrenimi sistemleri oluşturmalarına yardımcı olma konusunda tutkulu. Abigail boş zamanlarında seyahat etmeyi, yürüyüş yapmayı, kayak yapmayı ve yemek pişirmeyi seviyor.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- Plato blok zinciri. Web3 Metaverse Zekası. Bilgi Güçlendirildi. Buradan Erişin.

- Adryenn Ashley ile Geleceği Basmak. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/authoring-custom-transformations-in-amazon-sagemaker-data-wrangler-using-nltk-and-scipy/

- :vardır

- :dır-dir

- $UP

- 1

- 10

- 100

- 7

- 8

- 9

- a

- Hakkımızda

- Hesaplar

- katma

- Ek

- adres

- ileri

- Sonra

- Çağlar

- AI

- AI hizmetleri

- AI / ML

- Türkiye

- veriyor

- boyunca

- Rağmen

- Amazon

- Amazon Kavramak

- Amazon Adaçayı Yapıcı

- Amazon SageMaker Veri Düzenleyicisi

- analiz

- analytics

- çözümlemek

- ve

- Andrew

- Başka

- herhangi

- Apache

- uygulamayı yükleyeceğiz

- uygulamaları

- uygulamalı

- Uygulanması

- yaklaşım

- mimari

- ARE

- AS

- At

- öznitelikleri

- Doğrulama

- yazar

- yazma

- otomatik olarak

- AutoML

- mevcut

- AWS

- BE

- Çünkü

- müşterimiz

- olmuştur

- önce

- yarar

- BIN

- yatılı

- getirmek

- inşa etmek

- bina

- yapılı

- yerleşik

- iş

- by

- CAN

- yetenekleri

- dava

- durumlarda

- belli

- zincir

- değişiklik

- değişiklikler

- Klinik

- sınıflandırma

- kod

- kodlama

- Toplamak

- Sütun

- Sütunlar

- birleştirmek

- birleştirme

- ortak

- topluluk

- Şirketler

- tamamlamak

- idrak

- kapsamlı

- bilgisayar

- koşul

- koşullar

- Onaylamak

- Eksiler

- kısıtlamaları

- içermek

- Konteyner

- içerik

- sürekli

- olabilir

- Çift

- yaratmak

- görenek

- Müşteriler

- veri

- veri analizi

- Veri Hazırlama

- veri-güdümlü

- veri kümeleri

- Varsayılan

- gösterdi

- Dizayn

- tasarımlar

- Belirlemek

- gelişen

- gelişme

- geliştirir

- sapma

- farklı

- keşif

- tartışmak

- dağıtıldı

- dağıtım

- belge

- evraklar

- Değil

- domain

- aşağı

- kolayca

- kolay kullanımlı

- verimli

- ya

- elemanları

- son uca

- mühendis

- Mühendislik

- zenginleştirici

- kişiler

- varlık

- çevre

- değerlendirme

- Her

- örnek

- örnekler

- Dışında

- Egzersiz

- mevcut

- deneyim

- anlamlı

- uzatmak

- kapsamlı, geniş

- Kapsamlı Deneyim

- çıkarmak

- HIZLI

- Daha hızlı

- Özellikler(Hazırlık aşamasında)

- Özellikler

- Fiyatlandırma(Yakında)

- az

- fileto

- dosyalar

- mali

- uydurma

- akış

- Akışları

- odak

- odaklanma

- takip et

- takip etme

- İçin

- formüle etmek

- iskelet

- çerçeveler

- Ücretsiz

- Sıklık

- itibaren

- eğlence

- işlev

- fonksiyonlar

- oluşturmak

- oluşturulan

- jeneratörler

- almak

- sap

- Var

- he

- sağlık

- yardım

- yardımcı olur

- yüksek teknoloji ürünü

- üst düzey

- Ana Sayfa

- Ne kadar

- Ancak

- HTML

- http

- HTTPS

- insan

- ICON

- tanımlar

- belirlemek

- Kimlik

- görüntü

- ithalat

- önemli

- ithal

- geliştirme

- in

- Diğer

- bilgi

- anlayışlar

- kurmak

- örnek

- entegre

- bütünleşme

- İstihbarat

- arayüzler

- tanıtmak

- IOT

- IT

- İş

- seyahat

- jpg

- anahtar

- bilinen

- dil

- Soyad

- önemli

- ÖĞRENİN

- öğrenme

- kütüphaneler

- Kütüphane

- sevmek

- küçük

- kaybetme

- makine

- makine öğrenme

- Bakımı

- yapmak

- çok

- Pazarlama

- masif

- matematiksel

- Mayıs..

- adı geçen

- yöntemleri

- olabilir

- dakika

- ML

- model

- modelleri

- modül

- Modüller

- Daha

- hareket

- filmler

- çoklu

- çarpılması

- isim

- isimleri

- Doğal (Madenden)

- Doğal Dil İşleme

- gerek

- yeni

- sonraki

- nlp

- düğüm

- düğümler

- defter

- numara

- sayılar

- dizi

- nesnel

- of

- teklif

- Eski

- on

- Teknede

- Onboarding

- ONE

- açık

- açık kaynak

- işletme

- optimum

- optimizasyon

- optimize

- sipariş

- orijinal

- Diğer

- aksi takdirde

- bizim

- dışında

- tekrar

- kendi

- paket

- paketler

- pandalar

- Bölüm

- tutkulu

- Yapmak

- ifadeler

- boru hattı

- platform

- Platon

- Plato Veri Zekası

- PlatoVeri

- artı

- Popüler

- Çivi

- uygulamalar

- Hazırlamak

- işleme

- üretim

- profilleme

- Programlar

- sağlamak

- sağlar

- amaç

- Itmek

- Python

- kalite

- Hızlı

- rasgele

- Çiğ

- güvenilir

- kalıntılar

- temsil etmek

- yanıt

- Sonuçlar

- dönüş

- yorum

- kök

- koşmak

- s

- sagemaker

- aynı

- Örnek veri kümesi

- İndirim

- senaryolar

- bilimsel

- scikit-öğrenme

- scriptler

- saniye

- Güvenli

- seçim

- kıdemli

- ayrı

- hizmet

- Hizmetler

- ayarlar

- kurulum

- paylaş

- meli

- şov

- gösterilen

- Gösteriler

- kapatmak

- kapanma

- işaret

- işaret

- Basit

- basitleştirmek

- tek

- Yazılım

- yazılım geliştirme

- çözüm

- Çözümler

- biraz

- Kaynak

- kaynaklar

- Kıvılcım

- özel

- uzman

- Dönme

- bölmek

- kare

- standart

- başlama

- başladı

- istatistikler

- adım

- Basamaklar

- hafızası

- depolamak

- Stratejik

- yapılandırma

- stüdyo

- böyle

- süit

- arz

- tedarik zinciri

- Destekler

- Sistemler

- tablo

- Bizi daha iyi tanımak için

- alma

- Görev

- Teknik

- o

- The

- Kaynak

- ve bazı Asya

- bu nedenle

- Bunlar

- üç

- zaman

- için

- simge

- dizgeciklere

- Jeton

- araçlar

- üst

- Toplam

- Dönüştürmek

- Dönüşüm

- dönüşümler

- transforme

- dönüşüm

- Seyahat

- eğilim

- ui

- altında

- kullanım

- kullanım durumu

- Kullanılmış

- kamu hizmetleri

- değer

- Değerler

- çeşitli

- Türkiye Dental Sosyal Medya Hesaplarından bizi takip edebilirsiniz.

- izlerken

- Yol..

- yolları

- İYİ

- hangi

- süre

- irade

- ile

- içinde

- olmadan

- sözler

- İş

- iş akışları

- yazmak

- yazılı

- Sen

- zefirnet