Bu yazı, Veri Bilimcisi Shibangi Saha ve Equilibrium Point'in Kurucu Ortağı ve CTO'su Graciela Kravtzov tarafından birlikte yazılmıştır.

Pek çok kişi stres, anksiyete, depresyon, madde kullanımı ve travma sonrası stres bozukluğu (TSSB) gibi yeni zihinsel hastalık belirtileri yaşıyor. Buna göre Kaiser Aile VakfıÜlke genelindeki yetişkinlerin yaklaşık yarısı (%47) pandemi sırasında ruh sağlığının olumsuz etkilendiğini bildirdi; bu, pandemi öncesi seviyelere göre önemli bir artış. Ayrıca, bazı cinsiyetler ve yaş grupları diğerlerine göre çok daha yüksek oranlarda stres ve endişe bildirme olasılığı en yüksek olanlar arasındadır. Ek olarak, birkaç belirli etnik grubun ruh sağlığı üzerinde "büyük bir etki" olduğunu bildirme olasılığı diğerlerine göre daha yüksektir.

Hastalık Kontrol Merkezleri (CDC) tarafından toplananlar da dahil olmak üzere çeşitli araştırmalar, kişilerin bildirdiği davranışsal sağlık semptomlarında önemli artışlar olduğunu göstermiştir. Haziran 2020'nin sonlarında ABD genelinde yetişkinlerle anket yapan bir CDC raporuna göre, yanıt verenlerin %31'i anksiyete veya depresyon belirtileri bildirdi, %13'ü madde kullanmaya başladığını veya artırdığını, %26'sı stresle ilişkili semptomlar bildirdi ve %11'i stresle ilişkili semptomlar bildirdi. son 30 gün içinde ciddi intihar düşünceleri olduğunu bildirdi.

Kişinin bildirdiği veriler, ruh sağlığı bozukluklarının teşhisinde kesinlikle kritik olsa da, ruh sağlığı ve ruh sağlığı tedavisiyle ilgili devam eden damgalamayla ilgili etkilere maruz kalabilir. Yalnızca kişilerin bildirdiği verilere dayanmak yerine, sağlık kayıtlarından ve talep verilerinden elde edilen verileri kullanarak temel bir soruyu yanıtlamaya çalışarak zihinsel sıkıntıyı tahmin edebilir ve tahmin edebiliriz: Kimin akıl sağlığı yardımına ihtiyaç duyacağını, ihtiyaç duymadan önce tahmin edebilir miyiz? Bu bireyler belirlenebilirse, ruhsal bozuklukların etkilerini ve maliyetlerini azaltmak amacıyla altta yatan semptomlardaki yeni veya artışa yanıt vermek için erken müdahale programları ve kaynakları geliştirilebilir ve kullanılabilir.

Büyük hacimli karmaşık, boşluklarla dolu talep verilerini yönetmek ve işlemekle uğraşanlar için söylemesi yapmaktan daha kolay! Bu yazıda bunun nasıl yapıldığını paylaşıyoruz Denge Noktası IoT Kullanılmış Amazon SageMaker Veri Düzenleyicisi Sürecin her adımında veri kalitesini sağlarken, zihinsel sağlık kullanım durumumuz için talep verilerinin hazırlanmasını kolaylaştırmak.

Çözüme genel bakış

Veri hazırlama veya özellik mühendisliği, deneyimli veri bilimcileri ve mühendislerinin, verileri doğru şekle sokmak için gereken çeşitli dönüşümler (adımlar) için formüller oluşturmaya çok fazla zaman ve enerji harcamasını gerektiren sıkıcı bir süreçtir. Aslında araştırmalar, makine öğrenimi (ML) için veri hazırlamanın veri bilimcilerin zamanının %80'ini tükettiğini gösteriyor. Tipik olarak bilim adamları ve mühendisler, dönüşümlerini kodlamak ve dağıtılmış işleme işleri oluşturmak için Pandas, PySpark ve SQL gibi çeşitli veri işleme çerçevelerini kullanır. Data Wrangler ile bu süreci otomatikleştirebilirsiniz. Data Wrangler şunun bir bileşenidir: Amazon SageMaker Stüdyosu verileri içe aktarmak, hazırlamak, dönüştürmek, özelleştirmek ve analiz etmek için uçtan uca bir çözüm sağlar. Bir Veri Wrangler'ı entegre edebilirsiniz veri akışı Veri işlemeyi basitleştirmek ve kolaylaştırmak için mevcut makine öğrenimi iş akışlarınıza ve çok az kodlama kullanarak veya hiç kodlama gerektirmeden özellik mühendisliği yapın.

Bu yazıda, bir sonraki aşamada tahmin modellerini oluşturmak için orijinal ham veri kümelerini ML'ye hazır özelliklere dönüştürme adımlarını inceliyoruz. İlk olarak, kullanım durumumuz için kullanılan çeşitli veri kümelerinin doğasını ve bu veri kümelerini Data Wrangler aracılığıyla nasıl birleştirdiğimizi inceliyoruz. Birleştirmeler ve veri kümesi birleştirme sonrasında veri kümesinde tekilleştirme, eksik değerlerin ele alınması ve özel formüller gibi uyguladığımız bireysel dönüşümleri açıklıyoruz ve ardından dönüşümlerin mevcut durumunu doğrulamak için yerleşik Hızlı Model analizini nasıl kullandığımızı açıklıyoruz. tahminler için.

Veri Setleri

Deneyimiz için ilk olarak davranışsal sağlık müşterimizden hasta verilerini indirdik. Bu veriler aşağıdakileri içerir:

- Talep verileri

- Acil servis ziyaret sayıları

- Yatan hasta ziyaret sayıları

- Ruh sağlığıyla ilgili ilaç reçetesi sayıları

- Hiyerarşik durum kodlaması (HCC), zihinsel sağlıkla ilgili sayıları teşhis eder

Amaç, hasta kimliğine dayalı olarak bu ayrı veri kümelerini birleştirmek ve verileri akıl sağlığı teşhisini tahmin etmek için kullanmaktı. Beş ayrı veri kümesinin birleşiminden oluşan, birkaç milyon veri satırından oluşan devasa bir veri kümesi oluşturmak için Data Wrangler'ı kullandık. Sütun hesaplamalarına izin vermek amacıyla çeşitli dönüşümler gerçekleştirmek için Data Wrangler'ı da kullandık. Aşağıdaki bölümlerde uyguladığımız çeşitli veri hazırlama dönüşümlerini açıklıyoruz.

Birleştirmeden sonra yinelenen sütunları bırakın

Amazon SageMaker Data Wrangler, verilerinizin temizlenmesini, dönüştürülmesini ve öne çıkarılmasını kolaylaştırmak için çok sayıda makine öğrenimi veri dönüşümü sağlar. Bir dönüşüm eklediğinizde veri akışına bir adım eklenir. Eklediğiniz her dönüşüm, veri kümenizi değiştirir ve yeni bir veri çerçevesi üretir. Sonraki tüm dönüşümler, ortaya çıkan veri çerçevesine uygulanır. Data Wrangler, sütunları herhangi bir kod olmadan dönüştürmek için kullanabileceğiniz yerleşik dönüşümler içerir. Ayrıca PySpark, Pandas ve PySpark SQL'i kullanarak özel dönüşümler de ekleyebilirsiniz. Bazı dönüşümler yerinde çalışırken diğerleri veri kümenizde yeni bir çıktı sütunu oluşturur.

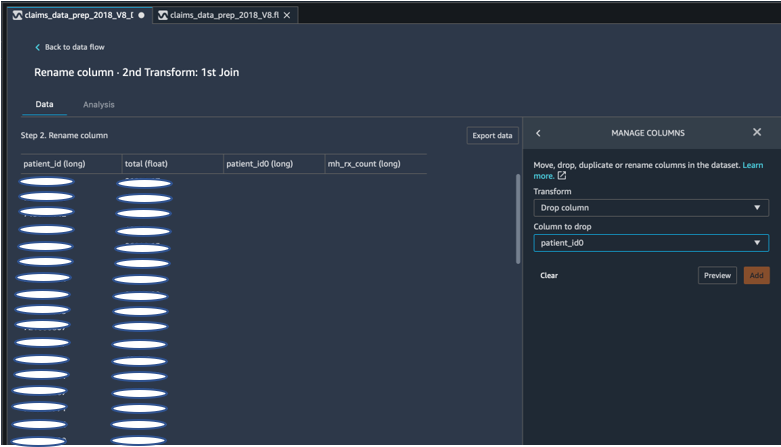

Deneylerimiz için, hasta kimliğindeki her birleştirmeden sonra, yinelenen hasta kimliği sütunlarıyla kaldık. Bu sütunları bırakmamız gerekiyordu. Aşağıdaki ekran görüntüsünde gösterildiği gibi, önceden oluşturulmuş uygulamayı kullanarak sağ hasta kimliği sütununu çıkardık. Sütunları Yönet ->Sütunu bırak yalnızca bir hasta kimliği sütununu (son veri kümesindeki hasta_kimliği) korumak için dönüştürün.

Pandaları kullanarak bir veri kümesini özetleme

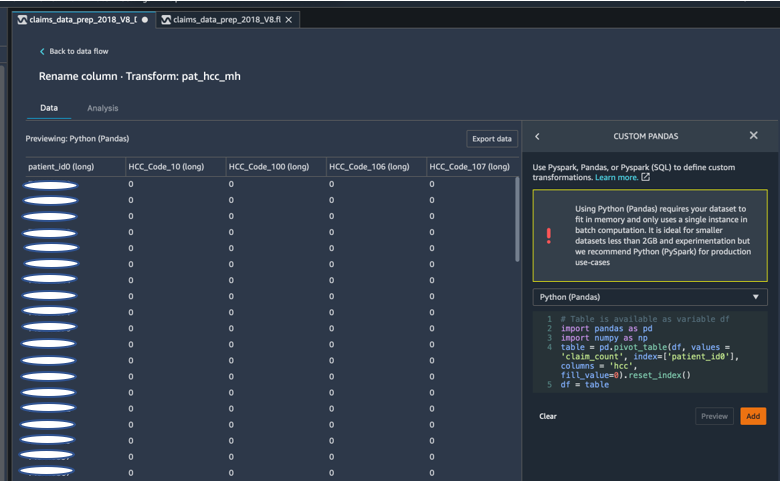

Talep veri kümeleri, acil durum ziyareti (ER), yatan hasta (IP), reçete sayıları ve halihazırda karşılık gelen HCC kodlarına (yaklaşık 189 kod) göre gruplandırılmış teşhis verileriyle birlikte hasta düzeyindeydi. Bir hasta veri merkezi oluşturmak için, talep HCC kodlarını hastaya göre topluyoruz ve HCC kodunu satırlardan sütunlara dönüştürüyoruz. Veri kümesini döndürmek, hastaya göre HCC kodlarının sayısını saymak ve ardından hasta kimliğindeki birincil veri kümesine katılmak için Pandaları kullandık. Tercih çerçevesi olarak Python'u (Pandalar) seçerek Data Wrangler'daki özel dönüştürme seçeneğini kullandık.

Aşağıdaki kod parçacığı, tabloyu döndürmek için dönüştürme mantığını gösterir:

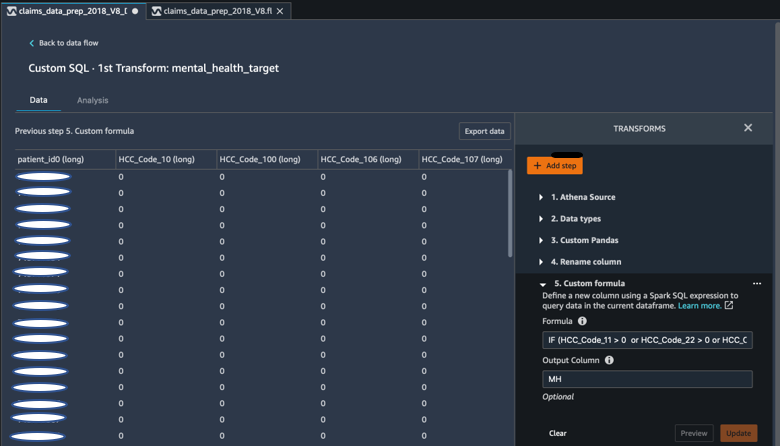

Özel formüller kullanarak yeni sütunlar oluşturma

Ruh sağlığı tanılarında hangi HCC kodlarının belirleyici olduğunu belirlemek için araştırma literatürünü inceledik. Daha sonra bu mantığı, DataFrame'in sonuna eklediğimiz Ruh Sağlığı Teşhisi hedef sütununu (MH) hesaplamak için Spark SQL ifadesi kullanan bir Data Wrangler özel formül dönüşümü kullanarak yazdık.

Aşağıdaki dönüşüm mantığını kullandık:

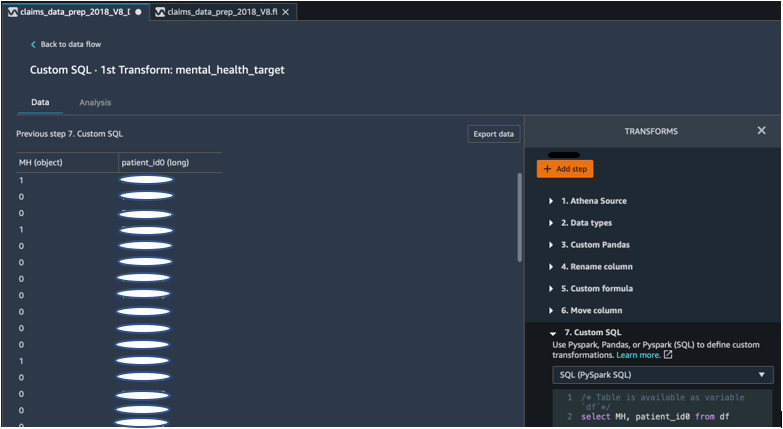

PySpark'ı kullanarak DataFrame'den sütunları bırakın

Hedef (MH) sütununun hesaplanmasından sonra gereksiz tüm kopya sütunları çıkardık. Birincil veri kümemize katılmak üzere hasta kimliğini ve MH sütununu koruduk. Bu, tercih ettiğimiz bir çerçeve olarak PySpark SQL'i kullanan özel bir SQL dönüşümüyle kolaylaştırıldı.

Aşağıdaki mantığı kullandık:

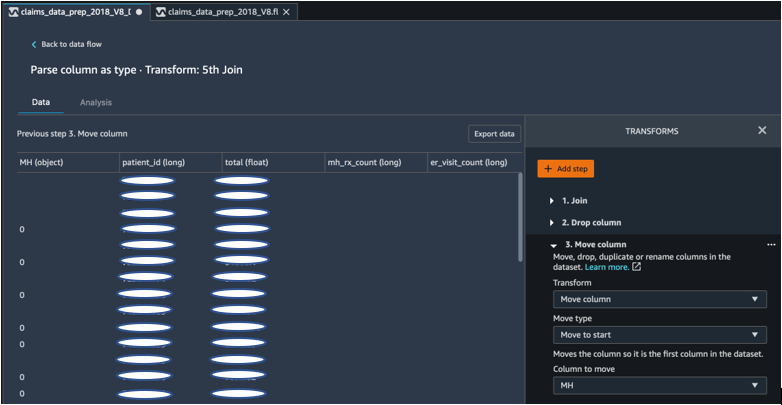

Başlamak için MH sütununu taşıyın

ML algoritmamız, etiketli girişin ilk sütunda olmasını gerektirir. Bu nedenle, hesaplanan MH sütununu dışa aktarmaya hazır olması için DataFrame'in başlangıcına taşıdık.

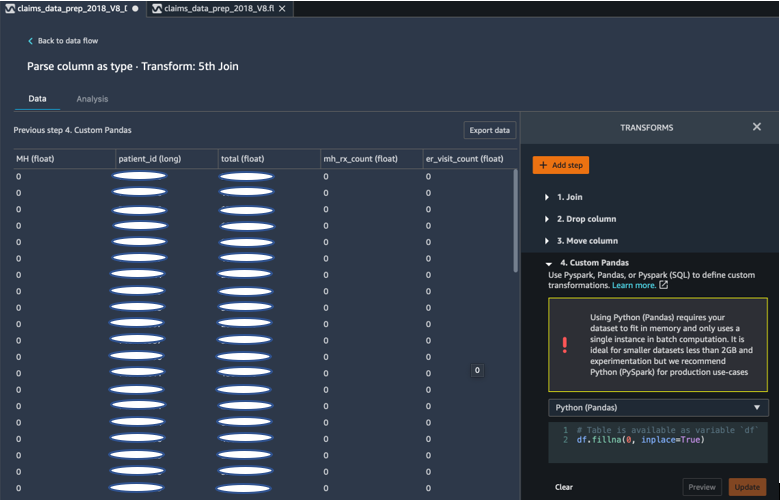

Pandaları kullanarak boşlukları 0 ile doldurun

ML algoritmamız ayrıca giriş verilerinde boş alan olmamasını gerektirir. Bu nedenle son veri setinin boş alanlarını 0'larla doldurduk. Bunu Data Wrangler'daki özel bir dönüşüm (Pandalar) aracılığıyla kolayca yapabiliriz.

Aşağıdaki mantığı kullandık:

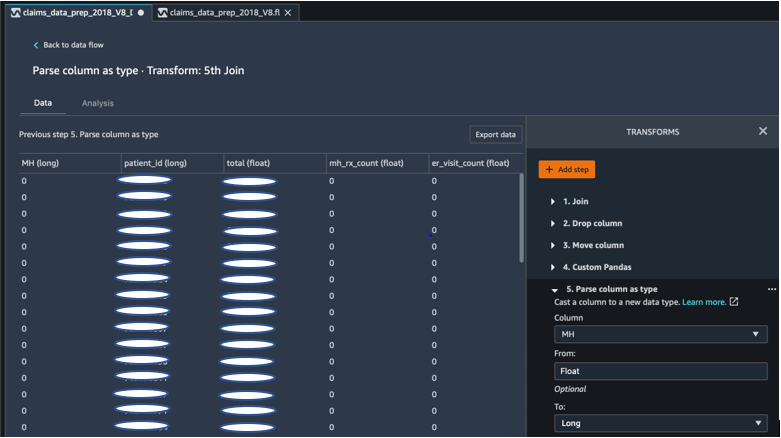

Sütunu kayan konumdan uzun konuma aktar

Ayrıca Data Wrangler'da bir sütunu kolayca herhangi bir yeni veri türüne ayrıştırabilir ve yayınlayabilirsiniz. Bellek optimizasyonu amacıyla zihinsel sağlık etiketi giriş sütunumuzu kayan nokta olarak belirledik.

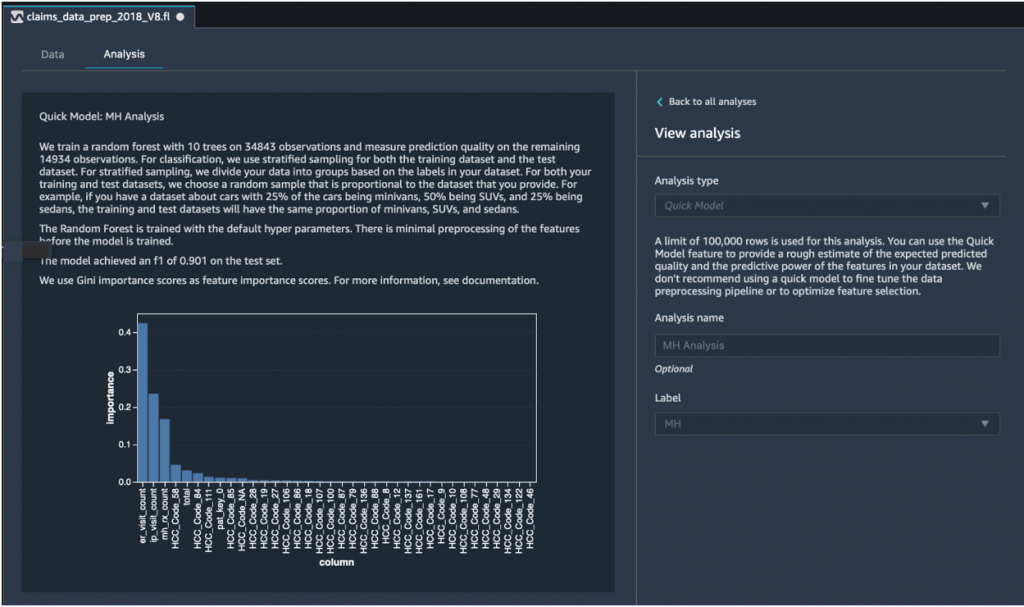

Hızlı Model analizi: Özellik önem grafiği

Nihai veri kümemizi oluşturduktan sonra, veri tutarsızlıklarını hızlı bir şekilde belirlemek ve model doğruluğumuzun beklenen aralıkta olup olmadığını veya modeli eğitme zamanını harcamadan önce özellik mühendisliğine devam etmemiz gerekip gerekmediğini hızlı bir şekilde belirlemek için Data Wrangler'daki Hızlı Model analiz türünü kullandık. Model, 1 en yüksek olmak üzere 0.901 F1 puanı verdi. F1 puanı, modelin kesinliğini ve geri çağrılmasını birleştirmenin bir yoludur ve ikisinin harmonik ortalaması olarak tanımlanır. Bu ilk olumlu sonuçları inceledikten sonra verileri dışarı aktarmaya ve dışarı aktarılan veri kümesini kullanarak model eğitimine devam etmeye hazırdık.

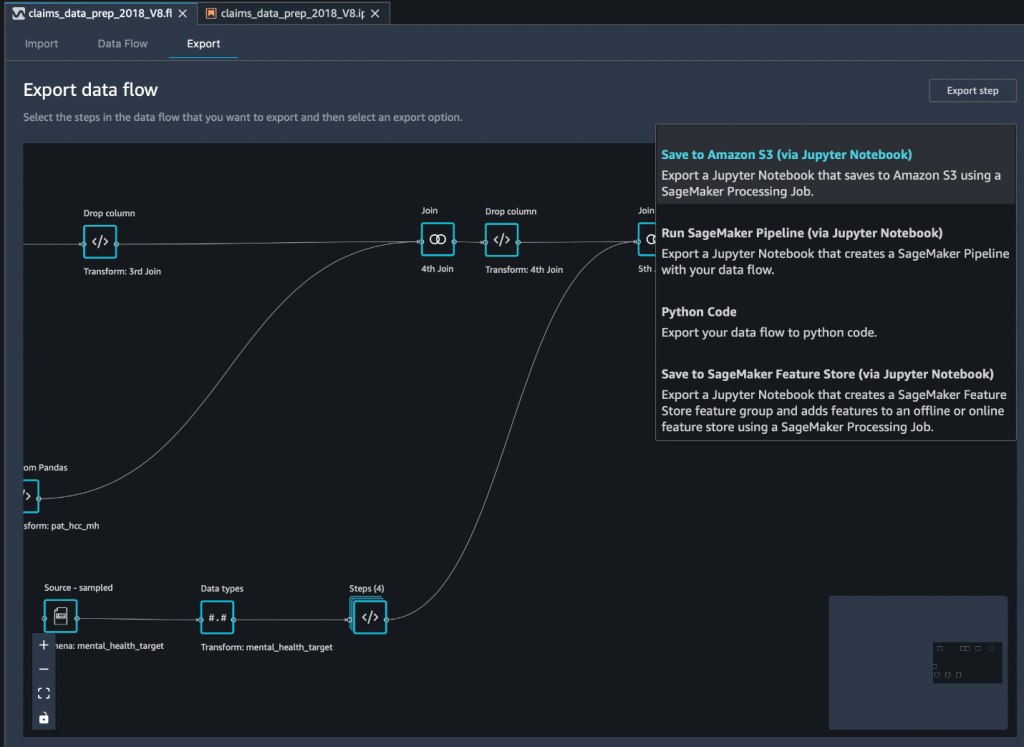

Nihai veri kümesini bir Jupyter not defteri aracılığıyla Amazon S3'e aktarın

Son adım olarak, veri kümesini mevcut haliyle (dönüştürülmüş) dışa aktarmak Amazon Basit Depolama Hizmeti (Amazon S3) gelecekte model eğitiminde kullanmak üzere Amazon S3'e kaydedin (Jupyter Notebook aracılığıyla) ihracat seçeneği. Bu not defteri dağıtılmış ve ölçeklenebilir bir Amazon SageMaker İşleme oluşturulan tarifi (veri akışı) belirtilen girişlere (genellikle daha büyük veri kümeleri) uygulayan ve sonuçları Amazon S3'e kaydeden iş. Ayrıca dönüştürülmüş sütunlarınızı (özelliklerinizi) şuraya aktarabilirsiniz: Amazon SageMaker Özellik Mağazası veya dönüşümleri kullanarak bir ardışık düzen olarak dışa aktarın Amazon SageMaker Ardışık Düzenleriveya dönüşümleri Python kodu olarak dışa aktarın.

Verileri Amazon S3'e aktarmak için üç seçeneğiniz vardır:

- Dönüştürülen verileri Data Wrangler kullanıcı arayüzü aracılığıyla doğrudan Amazon S3'e aktarın

- Dönüşümleri bir Jupyter not defteri aracılığıyla SageMaker İşleme işi olarak dışa aktarın (bu yazı için yaptığımız gibi).

- Dönüşümleri bir hedef düğüm aracılığıyla Amazon S3'e aktarın. Bir hedef düğüm, Data Wrangler'a verileri işledikten sonra nerede depolayacağını bildirir. Bir hedef düğüm oluşturduktan sonra verilerin çıktısını almak için bir işleme işi yaratırsınız.

Sonuç

Bu yazıda, Equilibrium Point IoT'nin, makine öğrenimine hazırlık aşamasında veri temizleme ve dönüştürme amacıyla büyük miktardaki talep verilerimizin yükleme sürecini hızlandırmak için Data Wrangler'ı nasıl kullandığını gösterdik. Ayrıca Data Wrangler'da Pandas ve PySpark'ı kullanarak özellik mühendisliğini özel dönüşümlerle nasıl birleştireceğimizi gösterdik; bu, kalite güvencesi amacıyla verileri adım adım (her katılımdan sonra) dışa aktarmamıza olanak sağladı. Kullanımı kolay bu dönüşümlerin Data Wrangler'da uygulanması, uçtan uca veri dönüşümü için harcanan süreyi yaklaşık %50 oranında azaltır. Ayrıca Data Wrangler'daki Hızlı Model analizi özelliği, veri hazırlama ve özellik mühendisliği sürecinde dolaşırken dönüşümlerin durumunu kolayca doğrulamamıza olanak sağladı.

Artık zihinsel sağlık riski modelleme kullanım durumumuz için verileri hazırladığımıza göre, bir sonraki adım olarak SageMaker'ı ve sunduğu yerleşik algoritmaları kullanarak, akıl sağlığına başvurması gereken üyeleri belirlemek için talep veri kümemizi kullanarak bir makine öğrenimi modeli oluşturmayı planlıyoruz. Hizmetlere ihtiyaç duydukları noktaya gelmeden önce. Bizi izlemeye devam edin!

Yazarlar Hakkında

Şibangi Sahası Denge Noktasında Veri Bilimcisidir. Sağlık hizmeti ödeme sistemindeki içgörüleri ve eyleme geçirilebilir iyileştirmeleri yönlendiren sağlık veri hatları, raporlama ve analiz süreçlerini tasarlamak, uygulamak, otomatikleştirmek ve belgelemek için sağlık hizmeti ödemesi yapan talep verileri ve makine öğrenimi konusundaki uzmanlığını birleştiriyor. Shibangi, Biyoinformatik alanında Yüksek Lisans derecesini Northeastern Üniversitesi Fen Fakültesi'nden ve Khoury Bilgisayar Bilimleri ve Bilişim Bilimleri Fakültesi'nden Biyoloji ve Bilgisayar Bilimleri alanında lisans diplomasını aldı.

Şibangi Sahası Denge Noktasında Veri Bilimcisidir. Sağlık hizmeti ödeme sistemindeki içgörüleri ve eyleme geçirilebilir iyileştirmeleri yönlendiren sağlık veri hatları, raporlama ve analiz süreçlerini tasarlamak, uygulamak, otomatikleştirmek ve belgelemek için sağlık hizmeti ödemesi yapan talep verileri ve makine öğrenimi konusundaki uzmanlığını birleştiriyor. Shibangi, Biyoinformatik alanında Yüksek Lisans derecesini Northeastern Üniversitesi Fen Fakültesi'nden ve Khoury Bilgisayar Bilimleri ve Bilişim Bilimleri Fakültesi'nden Biyoloji ve Bilgisayar Bilimleri alanında lisans diplomasını aldı.

Graciela Kravtzov Equilibrium Point'in Kurucu Ortağı ve CTO'sudur. Grace, Mühendislik, Operasyon ve Kalite alanında C düzeyinde/VP liderlik pozisyonlarında bulundu ve sağlık ve eğitim endüstrileri ile IoT endüstriyel alanında iş stratejisi ve ürün geliştirme konusunda yönetici danışman olarak görev yaptı. Grace, Buenos Aires Üniversitesi'nden Elektromekanik Mühendisliği alanında Yüksek Lisans derecesi ve Boston Üniversitesi'nden Bilgisayar Bilimleri alanında Yüksek Lisans derecesi aldı.

Graciela Kravtzov Equilibrium Point'in Kurucu Ortağı ve CTO'sudur. Grace, Mühendislik, Operasyon ve Kalite alanında C düzeyinde/VP liderlik pozisyonlarında bulundu ve sağlık ve eğitim endüstrileri ile IoT endüstriyel alanında iş stratejisi ve ürün geliştirme konusunda yönetici danışman olarak görev yaptı. Grace, Buenos Aires Üniversitesi'nden Elektromekanik Mühendisliği alanında Yüksek Lisans derecesi ve Boston Üniversitesi'nden Bilgisayar Bilimleri alanında Yüksek Lisans derecesi aldı.

Arunprasath Şankar AWS'li bir Yapay Zeka ve Makine Öğrenimi (AI / ML) Uzman Çözüm Mimarıdır ve küresel müşterilerin yapay zeka çözümlerini bulutta etkili ve verimli bir şekilde ölçeklendirmelerine yardımcı olur. Arun boş zamanlarında bilim kurgu filmleri izlemekten ve klasik müzik dinlemekten hoşlanıyor.

Arunprasath Şankar AWS'li bir Yapay Zeka ve Makine Öğrenimi (AI / ML) Uzman Çözüm Mimarıdır ve küresel müşterilerin yapay zeka çözümlerini bulutta etkili ve verimli bir şekilde ölçeklendirmelerine yardımcı olur. Arun boş zamanlarında bilim kurgu filmleri izlemekten ve klasik müzik dinlemekten hoşlanıyor.

Ajai Sharma Amazon SageMaker'da Kıdemli Ürün Yöneticisi olarak görev yapmaktadır ve burada veri bilimcilere yönelik görsel bir veri hazırlama aracı olan SageMaker Data Wrangler'a odaklanmaktadır. Ajai, AWS'den önce McKinsey and Company'de Veri Bilimi Uzmanı olarak çalışıyordu ve burada dünya çapında önde gelen finans ve sigorta şirketleri için makine öğrenimi odaklı çalışmalara liderlik ediyordu. Ajai, veri bilimi konusunda tutkulu ve en yeni algoritmaları ve makine öğrenimi tekniklerini keşfetmeyi seviyor.

Ajai Sharma Amazon SageMaker'da Kıdemli Ürün Yöneticisi olarak görev yapmaktadır ve burada veri bilimcilere yönelik görsel bir veri hazırlama aracı olan SageMaker Data Wrangler'a odaklanmaktadır. Ajai, AWS'den önce McKinsey and Company'de Veri Bilimi Uzmanı olarak çalışıyordu ve burada dünya çapında önde gelen finans ve sigorta şirketleri için makine öğrenimi odaklı çalışmalara liderlik ediyordu. Ajai, veri bilimi konusunda tutkulu ve en yeni algoritmaları ve makine öğrenimi tekniklerini keşfetmeyi seviyor.

- Akıllı para. Avrupa'nın En İyi Bitcoin ve Kripto Borsası.

- Plato blok zinciri. Web3 Metaverse Zekası. Bilgi Güçlendirildi. SERBEST ERİŞİM.

- KriptoHawk. Altcoin Radarı. Ücretsiz deneme.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/build-a-mental-health-machine-learning-risk-model-using-amazon-sagemaker-data-wrangler/

- "

- 100

- 2020

- Hakkımızda

- Göre

- karşısında

- AI

- algoritma

- algoritmalar

- Türkiye

- Izin

- zaten

- Amazon

- arasında

- tutarları

- analiz

- analytics

- kaygı

- Uygulama

- yapay

- yapay zeka

- Yapay Zeka ve Makine Öğrenimi

- mevcut

- AWS

- olmak

- Biyoloji

- sınır

- boston

- inşa etmek

- bina

- yerleşik

- iş

- iddia

- Temizlik

- bulut

- Kurucu

- kod

- kodlama

- Kolej

- Sütun

- şirket

- karmaşık

- bileşen

- Bilgisayar Bilimleri

- koşul

- sağlamlaştırma

- danışman

- devam etmek

- kontrol

- maliyetler

- Oluşturma

- kritik

- CTO

- akım

- Şu anki durum

- görenek

- Müşteriler

- veri

- veri işleme

- veri bilimi

- veri bilimcisi

- teslim

- gösterdi

- Depresyon

- Dizayn

- gelişmiş

- gelişme

- Hastalık

- dağıtıldı

- aşağı

- sürücü

- Damla

- düştü

- Erken

- kolayca

- Eğitim

- etkileri

- enerji

- mühendis

- Mühendislik

- Mühendisler

- sağlanması

- tahmin

- yürütme

- beklenen

- deneyimli

- deneme

- Uzmanlık

- keşfetmek

- aile

- Özellikler(Hazırlık aşamasında)

- Özellikler

- Alanlar

- maliye

- Ad

- akış

- odaklanır

- takip etme

- Airdrop Formu

- iskelet

- gelecek

- Küresel

- gol

- kullanma

- sahip olan

- Sağlık

- sağlık

- yardım et

- daha yüksek

- Ne kadar

- Nasıl Yapılır

- HTTPS

- belirlemek

- hastalık

- uygulamak

- önem

- Dahil olmak üzere

- Artırmak

- artmış

- bireysel

- Sanayi

- Endüstri

- bilgi

- anlayışlar

- sigorta

- entegre

- İstihbarat

- IOT

- IP

- IT

- İş

- Mesleki Öğretiler

- kaydol

- katıldı

- Katıldı

- büyük

- büyük

- son

- Liderlik

- önemli

- öğrenme

- Led

- seviye

- Dinleme

- Edebiyat

- küçük

- makine

- makine öğrenme

- korumak

- müdür

- yönetme

- masif

- Üyeler

- Bellek

- Ruh sağlığı

- milyon

- ML

- model

- modelleri

- Daha

- çoğu

- filmler

- Music

- Tabiat

- defter

- numara

- sayısız

- Teklifler

- Operasyon

- optimizasyon

- seçenek

- Opsiyonlar

- yaygın

- Pivot

- Nokta

- pozitif

- tahmin

- tahmin

- Tahminler

- reçete

- birincil

- süreç

- Süreçler

- PLATFORM

- Programlar

- sağlar

- amaçlı

- kalite

- soru

- hızla

- menzil

- oranlar

- Çiğ

- kayıtlar

- rapor

- araştırma

- Kaynaklar

- Sonuçlar

- Risk

- Adı geçen

- ölçeklenebilir

- ölçek

- Bilim

- BİLİMLERİ

- bilim adamı

- bilim adamları

- Hizmetler

- paylaş

- önemli

- Basit

- çözüm

- Çözümler

- uzay

- hız

- Harcama

- Aşama

- başlama

- başladı

- başlar

- Eyalet

- kalmak

- hafızası

- mağaza

- Verileri saklayın

- Stratejileri

- stres

- madde

- önemli

- sistem

- Hedef

- teknikleri

- anlatır

- İçinden

- boyunca

- zaman

- araç

- Eğitim

- Dönüştürmek

- Dönüşüm

- dönüşüm

- tedavi

- tipik

- üniversite

- us

- kullanım

- genellikle

- kullanmak

- çeşitli

- DSÖ

- içinde

- olmadan

- Dünya çapında