- Şubat 24, 2014

- Vasilis Vryniotis

- . 3 Yorumlar

DEA olarak da bilinen Veri Zarflama Analizi, sınır analizi yapmak için parametrik olmayan bir yöntemdir. Çoklu karar verme birimlerinin verimliliğini tahmin etmek için doğrusal programlama kullanır ve genellikle üretim, yönetim ve ekonomide kullanılır. Teknik ilk olarak tarafından önerildi Charnes, Cooper ve Rhodes, 1978'de ve o zamandan beri üretim sınırlarını tahmin etmek için değerli bir araç haline geldi.

Güncelleme: Datumbox Machine Learning Framework artık açık kaynak kodlu ve ücretsiz indir. Java'da Veri Zarflama Analizinin uygulamasını görmek için com.datumbox.framework.algorithms.dea paketine göz atın.

Yöntemle 5-6 yıl önce ilk karşılaştığımda algoritmanın özgünlüğü, sadeliği ve kullandığı fikirlerin zekası karşısında hayrete düşmüştüm. Çevrimiçi Pazarlama, Arama Motoru Sıralaması ve bileşik ölçümler oluşturmak için başarıyla uygulanabildiğinden, tekniğin normal uygulamalarının (finansal, operasyon araştırması vb.) Dışında iyi çalıştığını görmek beni daha da şaşırttı. Buna rağmen, bugün DEA neredeyse yalnızca iş bağlamında tartışılmaktadır. Bu nedenle, bu yazıda DEA'nın arkasındaki temel fikirleri ve matematiksel çerçeveyi ele alacağım ve bir sonraki yazıda size algoritmanın web uygulamalarında bazı yeni uygulamalarını göstereceğim.

Veri Zarflama Analizi neden ilginçtir?

Veri Zarflama Analizi, kayıtları (mağazalar, çalışanlar, fabrikalar, web sayfaları, pazarlama kampanyaları vb.) Özelliklerine göre (ağırlık, boyut, maliyet, gelirler ve diğer ölçütler veya KPI'lar) herhangi bir ön varsayım yapmadan karşılaştırmamızı ve sıralamanızı sağlayan bir yöntemdir. özelliklerin önemi veya ağırlıkları. Bu tekniğin en ilginç yanı, tamamen farklı ölçü birimlerine sahip birden çok özellikten oluşan kayıtları karşılaştırmamıza izin vermesidir. Bu, kilometre, kilogram veya para birimi cinsinden ölçülen özelliklere sahip kayıtlara sahip olabileceğimiz ve yine de bunları karşılaştırabileceğimiz, sıralayabileceğimiz ve en iyi / en kötü ve ortalama performans gösteren kayıtları bulabileceğimiz anlamına gelir. İlginç geliyor mu? Okumaya devam et.

Veri Zarflama Analizinin tanımı ve varsayımları

Daha önce tartıştığımız gibi, VZA, iş dünyasında üretkenliği ölçmek için icat edilmiş bir yöntemdir. Dolayısıyla, fikirlerinden birkaçı bu bağlamda üretkenliğin ölçülme biçiminden gelmektedir. Yöntemin temel özelliklerinden biri, kayıt özelliklerinin iki kategoriye ayrılmasıdır: girdi ve çıktı. Örneğin bir arabanın verimini ölçersek, girdinin litre benzin olduğunu ve çıktının katettiği kilometre sayısı olduğunu söyleyebiliriz.

VZA'da, tüm özellikler pozitif olmalıdır ve değerleri ne kadar yüksekse, giriş / çıkışlarının o kadar fazla olduğu varsayılır. Ek olarak Veri Zarflama Analizi, özelliklerin negatif olmayan ağırlıkların ağırlıklı toplamı olarak doğrusal olarak birleştirilebileceğini ve her kaydın verimliliğini ölçecek girdi ve çıktı arasında bir oran oluşturabileceğini varsayar. Bir kaydın verimli olması için bize sağlanan girdiye göre "iyi" bir çıktı vermesi gerekir. Verimlilik, çıktı ve girdi arasındaki oranla ölçülür ve ardından diğer kayıtların oranıyla karşılaştırılır.

DEA'nın arkasındaki ustaca fikir

Şimdiye kadar ele aldıklarımız sağduyu / pratiktir. Kayıtlarımızı sıralamak için girdi ve çıktıları, ağırlıklı toplamları ve oranları kullanırız. VZA'nın akıllıca fikri, özelliklerin ağırlıklarının hesaplanma şeklidir. Analizi çalıştırmadan önce özelliklerin ağırlıklarını ayarlamak ve önemlerine karar vermek yerine, Veri Zarflama Analizi bunları verilerden hesaplar. Üstelik ağırlıklar her kayıt için aynı DEĞİLDİR!

DEA ağırlıkları şu şekilde seçer: Uygun özellik ağırlıklarını seçerek her kaydın oranını maksimize etmeye çalışırız; aynı zamanda, diğer tüm kayıtların oranlarını hesaplamak için aynı ağırlıkları kullanırsak, hiçbirinin 1'den büyük olmayacağından emin olmalıyız.

Fikir başlangıçta biraz tuhaf geliyor. Bu, farklı ağırlıklı oranların hesaplanmasına yol açmaz mı? Cevap Evet. Bu, aslında her kayıt için oranları farklı şekilde hesapladığımız anlamına gelmiyor mu? Cevap yine evet. Peki bu nasıl çalışıyor? Cevap basit: Özellikleri göz önüne alındığında, her kayıt için oranının olabildiğince yüksek olacağı ve böylece mümkün olduğu kadar etkili olacağı "ideal durumu" (ağırlıkları) bulmaya çalışıyoruz. ANCAK aynı zamanda, bu "ideal durum" göz önüne alındığında, diğer kayıtların hiçbirinin çıktı / girdi oranı 1'den büyük olmamalıdır, yani% 100'den daha etkili olamazlar! Her "ideal durum" altındaki tüm kayıtların oranlarını hesapladıktan sonra, oranlarını onları sıralamak için kullanırız.

Dolayısıyla, VZA'nın ana fikri şu şekilde özetlenebilir: "Her kaydın özelliklerine göre en iyi oran puanını elde edebileceğimiz ideal durumu bulun. Sonra her kaydın bu ideal oranını hesaplayın ve etkinliklerini karşılaştırmak için kullanın ”.

Bir örnek görelim

DEA'yı kullanabileceğimiz bir örnek görelim.

Belirli bir zincirin süpermarket mağazalarının verimliliğini bir dizi özelliğe göre değerlendirmekle ilgilendiğimizi varsayalım: toplam çalışan sayısı, metrekare olarak mağazanın büyüklüğü, ürettikleri satış miktarı ve müşteri sayısı her ay ortalama olarak hizmet veriyorlar. En verimli mağazaları bulmanın, kayıtları birden çok özellikle karşılaştırmamızı gerektirdiği aşikardır.

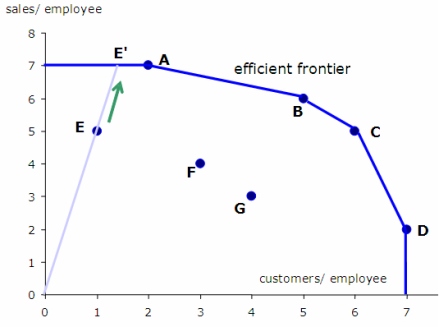

VZA'yı uygulamak için hangisinin girdi ve çıktı olduğunu tanımlamalıyız. Bu durumda çıktı açık bir şekilde satış miktarı ve hizmet verdikleri müşteri sayısıdır. Girdi, çalışan sayısı ve mağazanın büyüklüğüdür. DEA'yı çalıştırırsak, ideal ağırlıklar altında (yukarıda tartışıldığı gibi) her mağaza için çıktı / girdi oranını tahmin edeceğiz. Oranlarını aldığımızda, onları verimliliklerine göre sıralayacağız.

Matematik zamanı!

Artık DEA'nın nasıl çalıştığına dair bir sezgiye sahip olduğumuza göre, matematiğe girmenin zamanı geldi.

Belirli bir i kaydının x girişi ve y çıkışı (her ikisi de pozitif değerli özellik vektörleri) ile verimlilik oranı aşağıdaki formül kullanılarak tahmin edilir:

![]()

U ve v, kaydın her bir çıktısının ve girişinin ağırlıkları olduğunda, s, çıkış özelliklerinin sayısı ve m, giriş özelliklerinin sayısıdır.

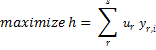

Belirli bir kayıt i için en iyi / ideal ağırlıkları bulma sorunu aşağıdaki gibi formüle edilebilir:

![]()

![]()

![]()

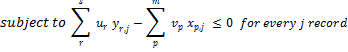

Yine yukarıdaki, i kaydının verimliliğini maksimize eden u ve v ağırlıklarını bulmanın matematiksel yoludur, ancak bu ağırlıkların diğer kayıtların hiçbirini% 100'den daha verimli hale getirmemesi şartıyla.

Bu sorunu çözmek için doğrusal programlama kullanmalıyız. Ne yazık ki doğrusal programlama kesirleri kullanmamıza izin vermiyor ve bu nedenle problemin formülasyonunu aşağıdaki gibi dönüştürmemiz gerekiyor:

![]()

![]()

Yukarıdaki doğrusal programlama probleminin bize kayıt i için en iyi ağırlıkları vereceğini ve bu optimum ağırlıklar altında verimliliğini hesaplayacağını vurgulamalıyız. Veri setimizdeki her kayıt için aynısı tekrarlanmalıdır. Yani n kaydımız varsa, n ayrı doğrusal problemi çözmeliyiz. DEA'nın nasıl çalıştığına dair sözde kod:

ratio_scores = [];

for every record i {

i_ratio = get_maximum_effectiveness();

ratio_scores[i] = i_ratio;

}

Veri Zarflama Analizinin Sınırlamaları

DEA harika bir tekniktir ancak sınırlamaları vardır. DEA'nın kara kutu gibi olduğunu anlamalısın. Her kaydın etkililik oranında kullanılan ağırlıklar farklı olduğu için her bir puanın nasıl ve neden hesaplandığını açıklamaya çalışmak anlamsızdır. Genellikle etkililik puanlarının gerçek değerleri yerine kayıtların sıralamasına odaklanırız. Ayrıca ekstremumların varlığının puanların çok düşük değerlere sahip olmasına neden olabileceğine dikkat edin.

DEA'nın oranları tahmin etmek için özelliklerin doğrusal kombinasyonlarını kullandığını unutmayın. Dolayısıyla, bunları doğrusal olarak birleştirmek uygulamamızda uygun değilse, özelliklere dönüşümler uygulamalı ve doğrusal olarak birleştirilmelerini mümkün kılmalıyız. Bu tekniğin bir başka dezavantajı, kayıt sayısı kadar doğrusal programlama problemlerini çözmemiz gerektiğidir, bu çok fazla hesaplama kaynağı gerektiren bir şeydir.

VZA'nın karşılaştığı bir diğer sorun da yüksek boyutlu verilerle iyi çalışmamasıdır. VZA'yı kullanmak için, d = m + s boyutlarının sayısı, gözlem sayısından önemli ölçüde daha düşük olmalıdır. D n'den çok yakın veya daha büyük olduğunda DEA'yı çalıştırmak yararlı sonuçlar sağlamaz, çünkü büyük olasılıkla tüm kayıtlar optimal olarak bulunacaktır. Yeni bir çıktı değişkeni (boyut) eklediğinizde, bu boyuttaki maksimum değere sahip tüm kayıtların optimal bulunacağını unutmayın.

Son olarak, algoritmanın genel biçiminde, VZA'daki özelliklerin ağırlıklarının verilerden tahmin edildiğini ve bu nedenle sorunumuzda sahip olabileceğimiz özelliklerin önemi hakkında önceden herhangi bir bilgi kullanmadıklarını not etmeliyiz (tabii ki bu bilgiyi sınırlamalar olarak doğrusal problemimize dahil etmek mümkündür). Ayrıca hesaplanan verimlilik puanları, “ideal durumlar” altında hesaplandığından, aslında her kaydın üst sınır verimlilik oranlarıdır. Bu, özelliklerin önemi hakkında herhangi bir varsayımda bulunmak mümkün olmadığında VZA'nın iyi bir çözüm olabileceği anlamına gelir, ancak önceden herhangi bir bilgiye sahipsek veya önemlerini ölçebilirsek, o zaman alternatif tekniklerin kullanılması tavsiye edilir.

Bir sonraki makalede, size bir uygulamanın nasıl geliştirileceğini göstereceğim. JAVA'da Veri Zarflama Analizi ve sosyal medya ağlarında web sayfalarının ve makalelerin popülerliğini tahmin etmek için bu yöntemi kullanacağız.

Makaleyi beğendiyseniz, Twitter veya Facebook'ta paylaşmak için bir dakikanızı ayırın. 🙂

- AI

- yapay zeka

- AI sanat üreteci

- yapay zeka robotu

- yapay zeka

- yapay zeka sertifikası

- yapay zeka robotu

- yapay zeka robotları

- yapay zeka yazılımı

- blockchain

- blockchain konferans ai

- zeka

- konuşma yapay zekası

- kripto konferans ai

- dal-e

- Veri kutusu

- derin öğrenme

- google ai

- makine öğrenme

- Makine Öğrenimi ve İstatistikler

- Platon

- plato yapay zekası

- Plato Veri Zekası

- Plato Oyunu

- PlatoVeri

- plato oyunu

- ölçek ai

- sözdizimi

- zefirnet