Whisper, çeşitli dilleri ve görevleri kapsayan, web'den alınan 680,000 saatlik denetlenen veriler kullanılarak eğitilmiş bir Otomatik Konuşma Tanıma (ASR) modelidir. Sınırlamalarından biri, Marathi dili ve Dravidian dilleri gibi düşük kaynaklı dillerdeki düşük performanstır ve bu, ince ayar ile giderilebilir. Bununla birlikte, bir Whisper modeline ince ayar yapmak, hem hesaplama kaynakları hem de depolama gereksinimleri açısından önemli bir zorluk haline geldi. Whisper modelleri için beş ila on tam ince ayar çalıştırması yaklaşık 100 saat A100 GPU (40 GB SXM4) gerektirir (model boyutlarına ve model parametrelerine göre değişir) ve her ince ayarlı kontrol noktası yaklaşık 7 GB depolama alanı gerektirir. Yüksek hesaplama ve depolama taleplerinin bu kombinasyonu, özellikle sınırlı kaynaklara sahip ortamlarda önemli engeller oluşturabilir ve çoğu zaman anlamlı sonuçlara ulaşmayı son derece zorlaştırabilir.

Düşük Sıralı Uyarlama olarak da bilinir LoRA, modelin ince ayarına benzersiz bir yaklaşım getiriyor. Önceden eğitilmiş model ağırlıklarını statik bir durumda tutar ve Transformer yapısının her katmanına eğitilebilir sıralama ayrıştırma matrisleri ekler. Bu yöntem, aşağı akış görevleri için gereken eğitilebilir parametrelerin sayısını 10,000 kat azaltabilir ve GPU bellek gereksinimini 3 kat azaltabilir. Model kalitesi açısından LoRA'nın, eğitilebilir daha az parametreyle çalışmasına rağmen geleneksel ince ayar yöntemlerinin performansıyla eşleştiği ve hatta bu performansı aştığı gösterilmiştir (orijinalden elde edilen sonuçlara bakın) LoRA kağıdı). Aynı zamanda artan eğitim verimi avantajını da sunar. Farklı olarak adaptör LoRA, çıkarım sırasında ek gecikmeye neden olmaz, böylece dağıtım aşamasında modelin verimliliği korunur. LoRA kullanılarak Whisper'ın ince ayarının yapılması umut verici sonuçlar verdi. Örneğin Whisper-Large-v2'yi ele alalım: 3 GB bellek GPU'sunda 12 saatlik ortak ses veri kümesiyle 8 dönemi çalıştırmak 6-8 saat sürerKarşılaştırılabilir performansla tam ince ayardan 5 kat daha hızlıdır.

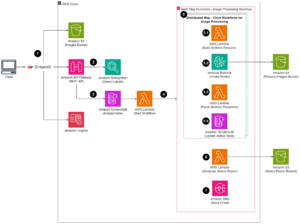

Amazon Adaçayı Yapıcı Whisper'ın LoRA ince ayarını uygulamak için ideal bir platformdur. Amazon SageMaker, tam olarak yönetilen altyapı, araçlar ve iş akışlarıyla her türlü kullanım senaryosuna yönelik makine öğrenimi modelleri oluşturmanıza, eğitmenize ve dağıtmanıza olanak tanır. Ek model eğitimi avantajları arasında Yönetilen Nokta Eğitimi ile daha düşük eğitim maliyetleri, modelleri ve eğitim veri kümelerini AWS GPU bulut sunucuları arasında bölmek için dağıtılmış eğitim kitaplıkları ve Daha. Eğitilmiş SageMaker modelleri, doğrudan SageMaker üzerinde çıkarım yapmak üzere kolayca dağıtılabilir. Bu yazıda, SageMaker'da LoRA ince ayarını uygulamaya yönelik adım adım bir kılavuz sunuyoruz. Bu uygulamaya ilişkin kaynak kodu şu adreste bulunabilir: GitHub.

Veri kümesini ince ayar için hazırlama

İnce ayar görevi için düşük kaynaklı Marathi dilini kullanıyoruz. Kullanmak Sarılma Yüzü veri kümeleri Kitaplığınızda Common Voice veri kümesini indirebilir ve eğitim ve test veri kümelerine bölebilirsiniz. Aşağıdaki koda bakın:

Fısıltı konuşma tanıma modeli, ses girişlerinin 16kHz mono 16 bit işaretli tamsayı WAV dosyaları. Common Voice veri kümesi 48K örnekleme hızına sahip olduğundan, önce ses dosyalarını alt örneklemeniz gerekecektir. Daha sonra, log-mel spektrogram özelliklerini çıkarmak için Whisper'ın özellik çıkarıcısını sese uygulamanız ve transkriptteki her cümleyi bir simge kimliğine dönüştürmek için Whisper'ın simgeleştiricisini çerçeveli özelliklere uygulamanız gerekir. Aşağıdaki koda bakın:

Tüm eğitim örneklerini işledikten sonra işlenen verileri Amazon S3'e yükleyin, böylece işlenen eğitim verilerini ince ayar aşamasında kullanırken HızlıDosya S3 dosyasını yerel diske kopyalamak yerine doğrudan bağlamak için:

Modeli eğitin

Gösterim amacıyla, Hugging Face transformatör kitaplığı aracılığıyla içe aktarılabilen, önceden eğitilmiş model olarak (whisper v2 artık mevcuttur) fısıltı-büyük-v3'yi kullanıyoruz. Kullanabilirsiniz 8 bitlik nicemleme eğitim verimliliğini daha da artırmak. 8 bit niceleme, kayan noktadan 8 bit tam sayılara yuvarlayarak bellek optimizasyonu sunar. Çıkarım sırasında hassasiyetten çok fazla ödün vermeden azaltılmış bellekten tasarruf sağlamak için yaygın olarak kullanılan bir model sıkıştırma tekniğidir.

Önceden eğitilmiş modeli 8 bitlik nicelenmiş formatta yüklemek için, aşağıdaki kodda gösterildiği gibi modeli başlatırken basitçe load_in_8bit=True argümanını ekleriz. Bu, 8 bit'e nicelenen model ağırlıklarını yükleyerek bellek alanını azaltır.

Hugging Face'in LoRA uygulamasını kullanıyoruz tepe paket. LoRA kullanarak bir modele ince ayar yapmak için dört adım vardır:

- Bir temel model oluşturun (son adımda yaptığımız gibi).

- Bir yapılandırma oluşturun (

LoraConfig) LoRA'ya özgü parametrelerin tanımlandığı yer. - Temel modeli şununla sarın:

get_peft_model()eğitilebilir bir şey almak içinPeftModel. - eğitmek

PeftModeltemel model olarak

Aşağıdaki koda bakın:

Çalıştırmak için Adaçayı Yapıcı eğitimi iş olarak kendi Docker konteynerimizi getiriyoruz. Docker görüntüsünü şuradan indirebilirsiniz: GitHubffmpeg4 ve git-lfs'nin diğer Python gereksinimleriyle birlikte paketlendiği yer. Kendi Docker kapsayıcınızı SageMaker ile çalışacak şekilde nasıl uyarlayacağınız hakkında daha fazla bilgi edinmek için bkz. Kendi eğitim konteynerinizi uyarlama. Daha sonra Sarılma Yüz Tahmincisini kullanabilir ve bir SageMaker eğitim işine başlayabilirsiniz:

LoRA'nın uygulanması, Whisper büyük ince ayar görevini tek bir GPU örneğinde (örneğin, ml.g5.2xlarge) çalıştırmamızı sağladı. Karşılaştırıldığında, Whisper'ın büyük tam ince ayar görevi birden fazla GPU (örneğin, ml.p4d.24xlarge) ve çok daha uzun bir eğitim süresi gerektirir. Daha spesifik olarak, deneyimimiz, tam ince ayar görevinin LoRA yaklaşımına kıyasla 24 kat daha fazla GPU saati gerektirdiğini gösterdi.

Model performansını değerlendirin

İnce ayarlı Whisper modelinin performansını değerlendirmek için, uzatılmış bir test seti üzerinde kelime hata oranını (WER) hesaplıyoruz. WER, tahmin edilen transkript ile temel gerçek transkripti arasındaki farkı ölçer. Daha düşük bir WER daha iyi performansı gösterir. Aşağıdaki komut dosyasını önceden eğitilmiş model ve ince ayarlı modelle çalıştırabilir ve bunların WER farklarını karşılaştırabilirsiniz:

Sonuç

Bu yazıda, son teknoloji ürünü bir konuşma tanıma modeli olan Whisper'ın ince ayarını gösterdik. Özellikle Hugging Face'in PEFT LoRA'sını kullandık ve verimli eğitim için 8 bit nicelemeyi etkinleştirdik. Ayrıca SageMaker'da eğitim işinin nasıl yürütüleceğini de gösterdik.

Bu önemli bir ilk adım olmasına rağmen, fısıltı modelini daha da geliştirmek için bu çalışmayı geliştirebileceğiniz birkaç yol vardır. İleriye dönük olarak, eğitimi çok daha büyük bir veri kümesinde ölçeklendirmek için SageMaker dağıtılmış eğitimini kullanmayı düşünün. Bu, modelin daha çeşitli ve kapsamlı veriler üzerinde eğitim almasına ve doğruluğu artırmasına olanak tanıyacak. Gerçek zamanlı konuşma tanımayı etkinleştirmek için Whisper modelini sunarken gecikmeyi de optimize edebilirsiniz. Ek olarak, model mimarisinde ve eğitim planlarında değişiklik yapılmasını gerektiren daha uzun ses transkripsiyonlarını ele alacak şekilde çalışmayı genişletebilirsiniz.

Teşekkür

Yazarlar, gönderiye ilişkin anlayışlı geri bildirimleri ve incelemeleri için Paras Mehra, John Sol ve Evandro Franco'ya şükranlarını sunarlar.

Yazarlar Hakkında

Jun Shi Amazon Web Services'te (AWS) Kıdemli Çözüm Mimarıdır. Şu anki odak alanları AI/ML altyapısı ve uygulamalarıdır. FinTech endüstrisinde yazılım mühendisi olarak on yıldan fazla deneyime sahiptir.

Jun Shi Amazon Web Services'te (AWS) Kıdemli Çözüm Mimarıdır. Şu anki odak alanları AI/ML altyapısı ve uygulamalarıdır. FinTech endüstrisinde yazılım mühendisi olarak on yıldan fazla deneyime sahiptir.

Dr Çangşa Ma AWS'de AI/ML Uzmanıdır. Bilgisayar Bilimleri alanında doktorası, Eğitim Psikolojisi alanında yüksek lisans derecesi olan ve veri bilimi ve AI/ML'de bağımsız danışmanlık alanında uzun yıllara dayanan deneyime sahip bir teknoloji uzmanıdır. Makine ve insan zekasına yönelik metodolojik yaklaşımları araştırma konusunda tutkulu. İş dışında yürüyüş yapmayı, yemek yapmayı, yemek avlamayı ve arkadaşları ve aileleriyle vakit geçirmeyi seviyor.

Dr Çangşa Ma AWS'de AI/ML Uzmanıdır. Bilgisayar Bilimleri alanında doktorası, Eğitim Psikolojisi alanında yüksek lisans derecesi olan ve veri bilimi ve AI/ML'de bağımsız danışmanlık alanında uzun yıllara dayanan deneyime sahip bir teknoloji uzmanıdır. Makine ve insan zekasına yönelik metodolojik yaklaşımları araştırma konusunda tutkulu. İş dışında yürüyüş yapmayı, yemek yapmayı, yemek avlamayı ve arkadaşları ve aileleriyle vakit geçirmeyi seviyor.

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://aws.amazon.com/blogs/machine-learning/fine-tune-whisper-models-on-amazon-sagemaker-with-lora/

- :vardır

- :dır-dir

- :Neresi

- 000

- 1

- 10

- 100

- 13

- İNDİRİM

- 17

- 24

- 25

- İNDİRİM

- 40

- 7

- 8

- 97

- a

- Hakkımızda

- doğruluk

- Başarmak

- karşısında

- uyarlamak

- adaptasyon

- eklemek

- Ek

- Ayrıca

- karşı

- AI / ML

- Türkiye

- izin vermek

- Ayrıca

- Amazon

- Amazon Adaçayı Yapıcı

- Amazon Web Servisleri

- Amazon Web Services (AWS)

- amp

- an

- ve

- herhangi

- uygulamaları

- Tamam

- yaklaşım

- yaklaşımlar

- yaklaşık olarak

- mimari

- ARE

- alanlar

- tartışma

- Dizi

- AS

- ilişkili

- At

- ses

- Yazarlar

- Oto

- Otomatik

- mevcut

- AWS

- baz

- merkezli

- BE

- Çünkü

- müşterimiz

- olmuştur

- yarar

- faydaları

- Daha iyi

- arasında

- her ikisi de

- getirmek

- inşa etmek

- by

- hesaplamak

- CAN

- dava

- meydan okuma

- değişiklikler

- kod

- kombinasyon

- ortak

- çoğunlukla

- karşılaştırılabilir

- karşılaştırmak

- karşılaştırıldığında

- karşılaştırma

- kapsamlı

- bilişimsel

- hesaplamak

- bilgisayar

- Bilgisayar Bilimleri

- yapılandırma

- Düşünmek

- önemli

- danışman

- Konteyner

- dönüştürmek

- kopyalama

- maliyetler

- olabilir

- akım

- veri

- Veri Hazırlama

- veri bilimi

- veri kümeleri

- onyıl

- azaltmak

- tanımlı

- derece

- del

- talepleri

- gösterdi

- dağıtmak

- konuşlandırılmış

- açılma

- Rağmen

- DID

- fark

- zor

- direkt olarak

- dağıtıldı

- dağıtılmış eğitim

- liman işçisi

- Değil

- indir

- sırasında

- her

- kolayca

- Eğitim

- verim

- verimli

- etkinleştirmek

- etkin

- sağlar

- kapsayan

- mühendis

- ortamları

- çağ

- hata

- özellikle

- değerlendirmek

- Hatta

- örnek

- aşmak

- son derece

- Genişletmek

- deneyim

- deneme

- uzatmak

- çıkarmak

- Yüz

- aileleri

- Daha hızlı

- Özellikler(Hazırlık aşamasında)

- Özellikler

- geribesleme

- daha az

- fileto

- dosyalar

- fintech

- Ad

- beş

- yüzer

- odak

- takip etme

- Gıda

- ayak izi

- İçin

- biçim

- ileri

- bulundu

- dört

- arkadaşlar

- itibaren

- tam

- tamamen

- işlev

- daha fazla

- almak

- gidiş

- GPU

- GPU'lar

- şükran

- Zemin

- rehberlik

- sap

- Var

- he

- Yüksek

- onun

- SAAT

- Ne kadar

- Nasıl Yapılır

- Ancak

- HTML

- HTTPS

- insan

- insan zekası

- avcılık

- Engelli koşu

- ID

- ideal

- kimlikleri

- görüntü

- uygulamak

- uygulama

- ithalat

- önemli

- iyileştirmek

- geliştirme

- in

- dahil

- artmış

- bağımsız

- gösterir

- sanayi

- Altyapı

- giriş

- girişler

- anlayışlı

- örnek

- yerine

- İstihbarat

- içine

- tanıtmak

- Tanıtımlar

- IT

- ONUN

- İş

- John

- jpg

- bilinen

- etiket

- Etiketler

- dil

- Diller

- büyük

- büyük

- Soyad

- Gecikme

- tabaka

- ÖĞRENİN

- öğrenme

- kütüphaneler

- Kütüphane

- sınırlamaları

- Sınırlı

- yük

- yerel

- uzun

- seviyor

- alt

- makine

- makine öğrenme

- Bakımı

- tutar

- Yapımı

- yönetilen

- harita

- yüksek lisans

- Maç

- anlamlı

- önlemler

- Bellek

- yöntem

- yöntemleri

- metrik

- ML

- model

- modelleri

- Daha

- MOUNT

- mr

- çok

- çoklu

- gerektiriyor

- gerek

- gerekli

- Hayır

- şimdi

- numara

- Nvidia

- of

- Teklifler

- sık sık

- on

- ONE

- işletme

- optimizasyon

- optimize

- Opsiyonlar

- or

- orijinal

- Diğer

- bizim

- dışında

- tekrar

- kendi

- paket

- paketlenmiş

- parametreler

- belirli

- tutkulu

- performans

- faz

- doktora

- platform

- Platon

- Plato Veri Zekası

- PlatoVeri

- Nokta

- poz

- Çivi

- Hassas

- tahmin

- hazırlık

- mevcut

- İşlenmiş

- umut verici

- Psikoloji

- Python

- kalite

- menzil

- rütbe

- oran

- gerçek zaman

- tanıma

- azaltmak

- Indirimli

- azaltarak

- başvurmak

- gereklilik

- Yer Alan Kurallar

- gerektirir

- Kaynaklar

- Sonuçlar

- dönüş

- yorum

- yuvarlatma

- koşmak

- ishal

- s

- feda

- sagemaker

- Tasarruf

- ölçek

- şemaları

- Bilim

- senaryo

- görmek

- kıdemli

- cümle

- Hizmetler

- servis

- set

- birkaç

- o

- gösterilen

- imzalı

- önemli

- sadece

- tek

- boyutları

- So

- Yazılım

- Yazılım Mühendisi

- SOL

- Çözümler

- Kaynak

- kaynak kodu

- uzay

- uzman

- özellikle

- konuşma

- Konuşma Tanıma

- Harcama

- bölmek

- Spot

- Aşama

- başlama

- Eyalet

- state-of-the-art

- statik

- adım

- Basamaklar

- hafızası

- yapı

- böyle

- Bizi daha iyi tanımak için

- alır

- Hedef

- Görev

- görevleri

- teknik

- teknoloji uzmanı

- on

- şartlar

- test

- Test yapmak

- metin

- göre

- o

- The

- Kaynak

- ve bazı Asya

- sonra

- Orada.

- böylece

- Re-Tweet

- İçinden

- verim

- zaman

- zamanlar

- için

- birlikte

- simge

- çok

- araçlar

- meşale

- geleneksel

- Tren

- eğitilmiş

- Eğitim

- Transkript

- transformatör

- transformatörler

- Hakikat

- benzersiz

- aksine

- us

- kullanım

- kullanım durumu

- Kullanılmış

- kullanma

- çeşitli

- ses

- yolları

- we

- ağ

- web hizmetleri

- ne zaman

- hangi

- Fısıltı

- irade

- ile

- olmadan

- Word

- İş

- iş akışları

- yıl

- Sen

- zefirnet