Amazon Adaçayı Yapıcı her geliştiriciye ve veri bilimcisine, makine öğrenimi (ML) modellerini uygun ölçekte hızlı bir şekilde oluşturma, eğitme ve dağıtma yeteneği sağlayan, tam olarak yönetilen bir hizmettir. ML çıkarımda gerçekleştirilir. SageMaker dört Çıkarım seçeneği sunar:

Bu dört seçenek genel olarak Çevrimiçi ve Toplu çıkarım seçenekleri olarak sınıflandırılabilir. Çevrimiçi Çıkarımda, isteklerin geldikleri anda işlenmesi beklenir ve tüketen uygulama, her istek işlendikten sonra bir yanıt bekler. Bu, eşzamanlı olarak (gerçek zamanlı Çıkarım, sunucusuz) veya eşzamansız olarak (eşzamansız çıkarım) gerçekleşebilir. Eşzamanlı bir düzende, tüketen uygulama engellenir ve yanıt alana kadar ilerleyemez. Bu iş yükleri, yanıtların milisaniyelerden saniyelere kadar beklendiği ve istek yüklerinin küçük (birkaç MB) olduğu çevrimiçi kredi kartı sahtekarlığı tespiti gibi gerçek zamanlı uygulamalar olma eğilimindedir. Eşzamansız modelde, uygulama deneyimi engellenmez (örneğin, bir mobil uygulama aracılığıyla sigorta talebinin gönderilmesi) ve genellikle daha büyük yük boyutları ve/veya daha uzun işlem süreleri gerektirir. Çevrimdışı çıkarımda, çıkarım isteklerinin bir toplamı (toplu kısmı) birlikte işlenir ve yanıtlar yalnızca toplu işin tamamı işlendikten sonra sağlanır. Genellikle bu iş yükleri gecikmeye duyarlı değildir, büyük hacimlerde (birden fazla GB) veri içerir ve düzenli bir tempoda planlanır (örneğin, günün sonunda güvenlik kamerası görüntülerinde nesne algılamayı çalıştırın veya maaş bordrosu verilerini günün sonunda işleyin). ayın sonu).

Çıplak kemiklerde, SageMaker Gerçek Zamanlı Çıkarım bir modelden/modellerden, birlikte çalıştığınız çerçeveden/kapsayıcıdan ve konuşlandırılmış uç noktanızı destekleyen altyapıdan/örneklerden oluşur. Bu yazıda, Tek Model Uç Noktasını nasıl oluşturup çağırabileceğinizi keşfedeceğiz.

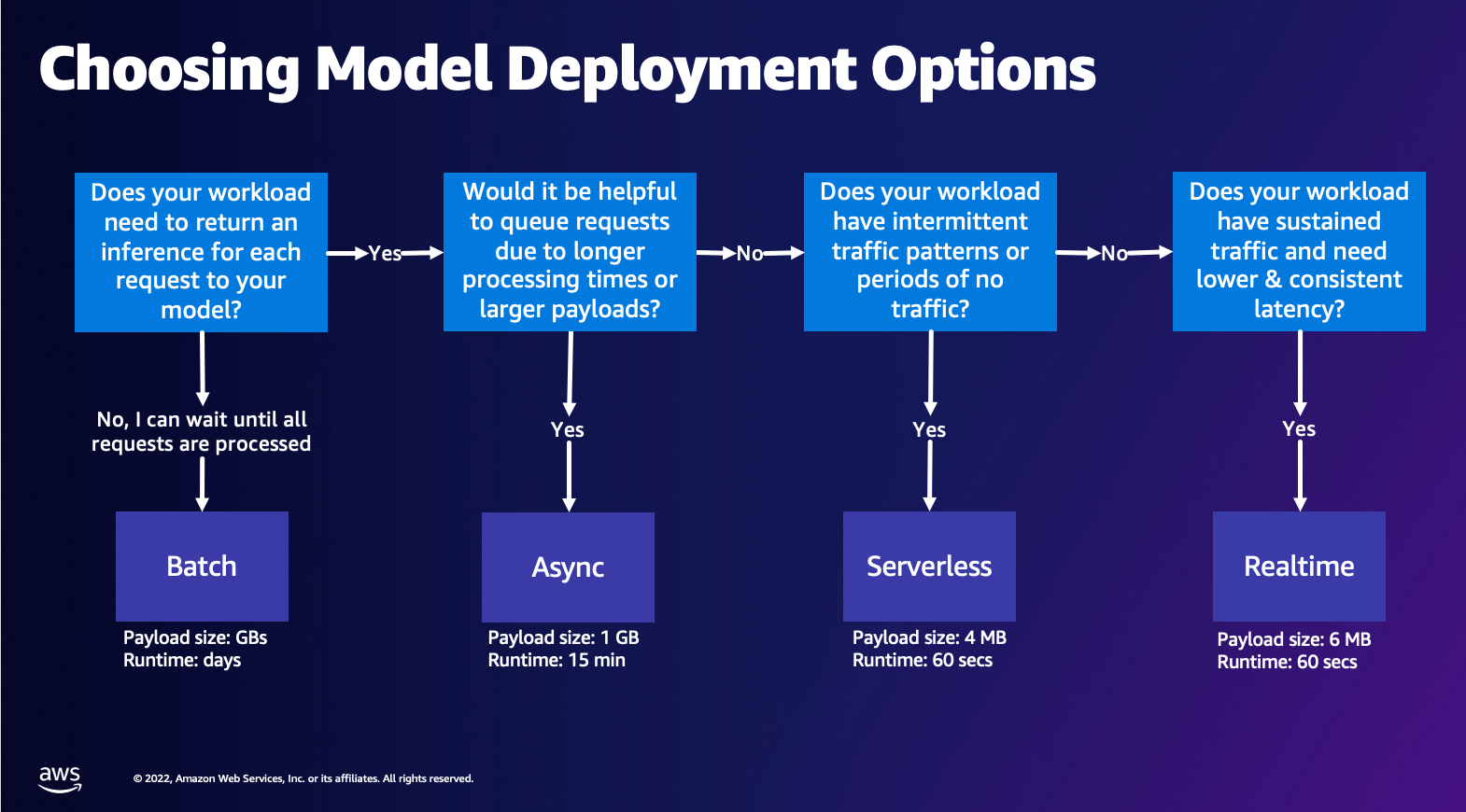

Model dağıtım seçeneğini seçme

Doğru çıkarım türünü seçmek zor olabilir ve aşağıdaki basit kılavuz size yardımcı olabilir. Bu katı bir akış şeması değildir, bu nedenle başka bir seçeneğin sizin için daha iyi olduğunu fark ederseniz, bunları kullanmaktan çekinmeyin. Özellikle, Gerçek Zamanlı Çıkarım, düşük ve tutarlı gecikme süresine (milisaniye veya saniye düzeyinde) ve aktarım hızına duyarlı iş yüklerine sahip olduğunuzda modellerinizi barındırmak için mükemmel bir seçenektir. Aynı zamanda yapılandırırken bulut sunucusu tipini kontrol edebilir ve uç noktanızın gerisindeki sayımı yapabilirsiniz. Otomatik Ölçeklendirme trafiği idare etme politikası. Bir uç nokta oluşturmak için kullanabileceğiniz iki SageMaker Çıkarımı seçeneği daha vardır. Eşzamansız Çıkarım, büyük veri yükü boyutlarına ve neredeyse gerçek zamanlı gecikme bant genişliğine sahip olduğunuz zamandır. Bu, özellikle daha uzun ön işleme süreleri olan NLP ve Görüntü İşleme modelleri için iyi bir seçenektir. Sunucusuz Çıkarım, kesintili trafiğiniz olduğunda ve altyapı ölçeklendirmesini yönetmek istemediğinizde mükemmel bir seçenektir. Bir uç nokta oluşturmanın tarifi, seçtiğiniz Çıkarım türünden bağımsız olarak aynı kalır. Bu yazıda, gerçek zamanlı örnek tabanlı bir uç nokta oluşturmaya odaklanacağız ancak bunu, kullanım durumunuza göre diğer Çıkarım Seçeneklerinden birine kolayca uyarlayabilirsiniz. Son olarak, Toplu çıkarım çevrimdışı olarak gerçekleştirilir, böylece çıkarım yapmak istediğiniz bir veri kümesini sağlayabilirsiniz, biz de onu çalıştırırız. Bu da benzer şekilde bulut sunucusu tabanlı olduğundan iş yükünüz için en uygun bulut sunucusunu seçebilirsiniz. Çalışan bir uç nokta olmadığından yalnızca işin süresi boyunca ödeme yaparsınız. Gigabaytlarca veriyi işlemek için iyidir ve iş süresi günlerce sürebilir. Yapılandırılmış verilerle çalışmayı kolaylaştıran yerleşik özellikler ve yapılandırılmış verileri otomatik olarak dağıtmak için optimizasyonlar mevcuttur. Bazı örnek kullanım durumları eğilim modellemesi, tahmine dayalı bakım ve kayıp tahminidir. Belirli bir olaya tepki vermesi gerekmediğinden tüm bunlar toplu olarak çevrimdışı gerçekleşebilir.

SageMaker Uç Noktalarında bir model barındırma

İşin özünde, SageMaker Gerçek Zamanlı Uç Noktalar, Uç Noktayı yedeklemeyi seçeceğiniz bir model ve altyapıdan oluşur. SageMaker, modelleri barındırmak için kapsayıcılar kullanır; bu, sağladığınız her model için kullandığınız çerçeveye yönelik ortamı uygun şekilde ayarlayan bir kapsayıcıya ihtiyacınız olduğu anlamına gelir. Örneğin, bir Sklearn modeliyle çalışıyorsanız, model komut dosyalarınızı/verilerinizi Sklearn'ü doğru şekilde kuran bir kapsayıcıya aktarmanız gerekir. Neyse ki SageMaker şunları sağlıyor yönetilen görseller TensorFlow, PyTorch, Sklearn ve HuggingFace gibi popüler çerçeveler için. Bu görüntüleri üst düzey kullanarak alabilir ve kullanabilirsiniz. SageMaker Python SDK'sı ve model komut dosyalarınızı ve verilerinizi bu kapsayıcılara enjekte edin. SageMaker'ın desteklenen bir kapsayıcısı olmaması durumunda şunları da yapabilirsiniz: Kendi Konteynerinizi Oluşturun ve modeliniz için gerekli olan bağımlılıkları yükleyerek kendi özel görüntünüzü aktarın.

SageMaker hem eğitilmiş hem de önceden eğitilmiş modelleri destekler. Önceki paragrafta model komut dosyaları/verilerden bahsederken bu konuya atıfta bulunuyoruz. Kapsayıcınıza bir komut dosyası bağlayabilir veya önceden eğitilmiş bir model yapıtınız varsa (örneğin, `model.joblib` SKLearn için), ardından bunu görselinizle birlikte SageMaker'a sağlayabilirsiniz. SageMaker Inference'ı anlamak için Uç Nokta oluşturma sürecinde oluşturacağınız üç ana varlık vardır:

- SageMaker Model Entity – Buraya, eğitilmiş model verilerinizi/model komut dosyanızı ve ister AWS'ye ait olsun, ister sizin tarafınızdan oluşturulmuş olsun, birlikte çalıştığınız görüntünüzü aktarabilirsiniz.

- Uç nokta konfigürasyonu oluşturma – Burada altyapınızı tanımlarsınız, yani bulut sunucusu tipini, sayısını vb. seçersiniz.

- Uç nokta oluşturma – Bu, yanıt almak için çağırdığınız modelinizi barındıran REST Uç Noktadır. Bir uç noktayı dağıtmak için yönetilen bir SageMaker Görüntüsünü ve kendi özel oluşturulmuş görüntünüzü nasıl kullanabileceğinize bakalım.

Gerçek zamanlı uç nokta gereksinimleri

- Bir Uç Nokta oluşturmadan önce ne tür bir Modeli barındırmak istediğinizi anlamalısınız. TensorFlow, PyTorch veya MXNet gibi bir Framework modeliyse aşağıdaki seçeneklerden birini kullanabilirsiniz: önceden oluşturulmuş Çerçeve görüntüleri.

Özel bir modelse veya SageMaker'ın çıkarım için çalıştıracağı kapsayıcıyı oluşturmada tam esneklik istiyorsanız, kendi kapsayıcınızı oluşturabilirsiniz.

SageMaker Uç Noktaları oluşur Adaçayı Yapıcı Modeli ve Uç Nokta Yapılandırması.

Boto3 kullanıyorsanız her iki nesneyi de yaratırsınız. Aksi takdirde, SageMaker Python SDK'yı kullanıyorsanız Uç Nokta Yapılandırması sizin adınıza oluşturulur. .deploy(..) fonksiyonu.

SageMaker varlıkları:

- Adaçayı Yapıcı Modeli:

- Çıkarım görüntüsünün ayrıntılarını ve model yapılarının konumunu içerir. Amazon Basit Depolama Hizmeti (Amazon S3), ağ yapılandırması ve AWS Kimlik ve Erişim Yönetimi (IAM) Uç Nokta tarafından kullanılacak rol.

- SageMaker, model yapılarınızın sıkıştırılmasını gerektirir.

.tar.gzdosya. SageMaker bunu otomatik olarak çıkarır.tar.gziçine dosya/opt/ml/model/kapsayıcınızdaki dizin. TensorFlow, PyTorch veya MXNet gibi çerçeve kapsayıcılarından birini kullanıyorsanız kapsayıcı, TAR yapınızın aşağıdaki gibi olmasını bekler:- TensorFlow

- PyTorch

- MX Ağı

- Sklearn

- TensorFlow

- Bir Çerçeve görüntüsü kullanırken, kendi ön ve son işlemlerimizi uygulayabileceğimiz özel bir giriş noktası komut dosyası sağlayabiliriz. Bizim durumumuzda çıkarım betiği /code dizini altındaki model.tar.gz dosyasında paketlenmiştir.

- SageMaker, model yapılarınızın sıkıştırılmasını gerektirir.

- Çıkarım görüntüsünün ayrıntılarını ve model yapılarının konumunu içerir. Amazon Basit Depolama Hizmeti (Amazon S3), ağ yapılandırması ve AWS Kimlik ve Erişim Yönetimi (IAM) Uç Nokta tarafından kullanılacak rol.

-

- Uç Nokta Yapılandırması

- SageMaker Modelini Uç Noktaya dağıtmak için gereken altyapı bilgilerini içerir.

- Örneğin oluşturduğumuz SageMaker Modelinin yanı sıra Bulut Sunucusu Türü ve İlk Bulut Sunucusu sayısı da burada belirtilir.

Çerçeveler ve BYOC

-

- SageMaker görüntülerini alma

- Bu kısım her zaman gerekli değildir ve tahminciler aracılığıyla SageMaker Python SDK tarafından soyutlanmıştır. Ancak SageMaker tarafından yönetilen bir görüntüyü genişletmek için almak istiyorsanız SDK aracılığıyla kullanılabilen görüntüleri alabilirsiniz. Aşağıda çıkarım için bir TF 2.2 görüntüsünün alınmasına bir örnek verilmiştir.

- çerçeveler

- TensorFlow, PyTorch veya MXNet gibi bir Çerçeve Modelini dağıtmak istemeniz durumunda ihtiyacınız olan tek şey model yapıtlarıdır.

- Modelleri doğrudan model yapıtlarından dağıtmak için belgelere bakın. TensorFlow, PyTorchya da MX Ağı.

- SageMaker görüntülerini alma

-

- 1P ve BYOC arasında seçim yapma

- SageMaker SDK ayrıca önceki Çerçeveler bölümünde gördüğünüz gibi görüntünün işlenmesini de soyutlar. Seçtiğiniz sürüme göre görüntüyü sizin için otomatik olarak seçen Sklearn, TensorFlow ve PyTorch için hazır tahmin edicilere sahiptir. Daha sonra bir eğitim/çıkarım komut dosyasından geçebilirsiniz. Komut Dosyası Modu bu tahmin edicilere

- Tüm paketler ve görseller SageMaker tarafından desteklenmez ve bu durumda kendi konteynerinizi getirin (BYOC). Bu, model sunumunuz için uygun ortamı ayarlayacak bir Dockerfile oluşturmak anlamına gelir. Bunun bir örneği Spacy NLP modülüdür ve bu çerçeve için yönetilen SageMaker kapsayıcısı yoktur. Bu nedenle Spacy'yi yükleyen bir Dockerfile sağlamanız gerekir. Kapsayıcının içine model çıkarım komut dosyalarınızı da monte edersiniz. Çoğu örnekte tutarlı kaldığından, Kendi Kabını Getir formatında sağladığınız bileşenleri hızlı bir şekilde tartışalım.

- “nginx.conf” nginx ön ucunun yapılandırma dosyasıdır. Bu kısımları ayarlamak istemediğiniz sürece bu dosyayı düzenlemeniz gerekmeyecektir.

- “tahmin.py” aslında uygulamanız için Flask web sunucusunu ve model kodunu uygulayan programdır. Kapsayıcınızda, bu dosyada çağırabileceğiniz başka Python dosyaları veya işlevleri olabilir.

- "sert" konteyner barındırma için başlatıldığında program başlatılır. Basitçe, preditor.py'de tanımlanan Flask uygulamasının birden fazla örneğini çalıştıran gunicorn sunucusunu başlatır. Nginx.conf gibi, gerçekleştirmek istediğiniz başka ayarlamalar olmadığı sürece bu dosyayı düzenlemeniz gerekmez.

- "tren" Container eğitim amacıyla çalıştırıldığında çağrılan programdır. Eğitim algoritmanızı uygulamak için bu programı değiştireceksiniz. Spacy gibi önceden eğitilmiş bir model veya çerçeve getiriyorsanız bu dosyaya ihtiyacınız yoktur.

- “wsgi.py” Flask uygulamasını çağırmak için kullanılan küçük bir sarmalayıcıdır. Preditor.py dosyanızın adını değiştirmediğiniz sürece bu dosyayı olduğu gibi alabilmeniz gerekir. Bu durumda, buradaki haritaların doğru şekilde yapıldığından emin olun.

- 1P ve BYOC arasında seçim yapma

-

- Özel çıkarım komut dosyası

- SageMaker Framework kapsayıcıları, özel bir giriş noktası script/inference.py kullanarak isteğin ön/sonra işlenmesini ve model yüklemeyi yönetme esnekliği sağlar.

- Özel bir Inference.py betiği oluşturmak için belgelere bakın. TensorFlow, PyTorch ve MX Ağı.

- Özel konteyner

- Özel çıkarım komut dosyası

SageMaker Uç Noktalarıyla etkileşim kurmanın farklı yolları

Çıkarım elde etmek amacıyla dağıtılan modellerinizi arayabilmeniz için SageMaker'ı programlı olarak kullanmanın birçok seçeneği vardır. AWS Komut Satırı Arayüzü (AWS CLI), REST API'leri, AWS CloudFormation, AWS Bulut Geliştirme Kiti (AWS CDK) ve AWS SDK'ları, AWS tarafından sunulan ve diğer AWS hizmetleri tarafından geniş çapta desteklenen yaygın araçlardır. SageMaker için ayrıca bir SageMaker Python SDK'mız da var. Şimdi SageMaker Uç Noktalarını oluşturmak, çağırmak ve yönetmek için farklı seçenekleri karşılaştıralım.

Ek olarak SageMaker CLI'siSDK'lar aracılığıyla SageMaker'daki Uç Noktalarla programlı olarak etkileşim kurmanın iki yolu vardır. Aradaki bazı farklara bakalım SageMaker Python SDK'sı ve Boto3 Python SDK'sı:

- Üst düzey SageMaker "Python" SDK'sı – Bu SDK, özellikle Python kullanarak SageMaker API'lerini programlı olarak çağırmak için tasarlanmış daha yüksek düzeyde soyutlama sağlayan açık kaynaklı bir kitaplıktır. Bu SDK'nın iyi tarafı, sagemaker API'lerini çağırmanın çok kolay olması, API'leri senkronize/eşzamansız mod (yoklamanın önlenmesine yardımcı olur) çağırmak gibi birçok ağır işin zaten yapılması, daha basit istek/yanıt şeması, çok daha az kod ve çok daha fazlasıdır. daha basit kod SageMaker Python SDK, SageMaker ile çalışmak için çeşitli üst düzey soyutlamalar sağlar. Paket, SageMaker'daki farklı makine öğrenimi süreçlerini basitleştirmeyi amaçlamaktadır.

- Düşük düzeyli AWS SDK (Boto3 SDK) – Bu SDK, kullanıcının desteklenen programlama dilleri arasından seçim yapmasına ve herhangi bir AWS hizmetini programlı olarak çağırmasına olanak tanıyarak daha düşük düzeyde çalışır. Bu yalnızca SageMaker'a özel değildir, genel olarak tüm AWS hizmetleri için kullanılabilir. Düşük seviyeli AWS SDK'ları .NET, Python, Java, Node.js vb. gibi çeşitli programlama dillerinde mevcuttur. Kullanılan popüler SDK'lardan biri, makine öğrenimi için veri bilimci topluluğunda popüler olan boto3 python SDK'dır. Bu SDK'nın iyi yanı, çok hafif olması ve varsayılan olarak yüklü olması AWS Lambda Çalışma süresi. Ayrıca bu SDK'yı SageMaker dışındaki herhangi bir AWS hizmetiyle etkileşimde bulunmak için kullanabilirsiniz.

Bu SDK'ların her ikisi de aynı görevler için kullanılabilir ancak bazı durumlarda birinin diğerinden daha fazla kullanılması daha sezgiseldir. Kolay test için SageMaker Python SDK önerilirken, performans üzerinde daha iyi kontrol sağlamak amacıyla üretim kullanım senaryoları için AWS SDK/Boto3 önerilir. Örneğin, hizmet olarak SageMaker, Sklearn, PyTorch ve TensorFlow gibi popüler çerçeveler için önceden oluşturulmuş ve bakımı yapılan görüntüler sağlar. Derin öğrenme görüntülerini almak, modelleri eğitmek için SageMaker SDK'yı kullanmak özellikle yararlı olabilir. Kestirimcilerve basit bir API çağrısı kullanarak modeli kolayca dağıtın. Bunu eylem halinde sergilemek için bir örnek bulunabilir okuyun.

Öte yandan, bazen önceden eğitilmiş modelleriniz veya kullanıyor olabileceğiniz farklı çerçeveleriniz olabilir. Bu, daha fazla özelleştirme gerektirir ve SageMaker SDK her zaman bunu sunmaz. Bir uç noktayı dağıtmak için yürütmemiz gereken üç önemli adımımız ve bunlara karşılık gelen boto3 API çağrılarımız var: Model Oluşturma, Uç Nokta Yapılandırması Oluşturma, ve Uç Nokta Oluşturma. İlk iki varlık, desteklediğimiz çerçevelerle SageMaker SDK'sıyla soyutlandı, ancak bu ayrıntıları Boto3 SDK'da görüyoruz. Bir uç nokta oluşturmak ve yönetmek için Boto3 SDK kullanmanın içerdiği adımları gösteren kapsamlı bir örnek bulunabilir okuyun.

SageMaker barındırmayla ilgili hususlar

SageMaker Gerçek Zamanlı Çıkarım'ın dikkate alabileceğiniz iki ana optimizasyonu vardır: 1/ Performans optimizasyonu ve 2/ Maliyet optimizasyonu. İlk önce şuna bakalım verim iyileştirmesiGecikmeye duyarlı iş yükleriyle uğraşırken her milisaniye çok önemlidir. Gecikme sürenizi ve veriminizi optimize etmek için ayarlayabileceğiniz farklı düğmeler vardır. Örnek düzeyinde şunları kullanabilirsiniz: Çıkarım Önericisiİş yükünüz için doğru bulut sunucusu türünü ve sayısını seçmenize yardımcı olacak yerleşik yük testi aracımız. Doğru bilgi işlem kombinasyonunu kullanmak, hem performans hem de maliyet açısından size yardımcı olacaktır. Ayrıca kapsayıcı ve çerçeve düzeyinde de ayar yapabilirsiniz.

Kendinize sormanız gereken sorular şunları içerir:

- Hangi çerçeveyi kullanıyorsunuz?

- Kapsayıcınızda ayarlayabileceğiniz herhangi bir ortam değişkeni var mı?

Bunun bir örneği maksimize etmektir SageMaker konteynerleriyle TensorFlow performansı. Kapsayıcı düzeyindeki optimizasyonlara başka bir örnek: grPC'yi kullanma uç noktanızın arkasında REST yerine. Son olarak, komut dosyası düzeyinde de optimizasyon yapabilirsiniz. Çıkarım kodunuz belirli bloklarda fazladan zaman mı alıyor? Komut dosyanızın her satırını zamanlamak, kodunuzdaki tüm darboğazları yakalamanıza yardımcı olacaktır.

Bakmanın üç yolu var kullanımın iyileştirilmesi Gerçek Zamanlı uç noktanızın:

- Çok Modelli Uç Noktalar (MME)

- Binlerce modeli tek bir uç noktanın arkasında barındırabilirsiniz. Bu, modellerinizin her biri için özel bir uç noktaya ihtiyaç duymadığınız kullanım durumları için mükemmeldir. MME, modeller benzer boyut ve gecikme süresine sahip olduğunda ve aynı ML çerçevesine ait olduğunda en iyi şekilde çalışır. Bunlar genellikle aynı modeli her zaman aramanıza gerek olmadığında kullanılabilir. İsteğinizi yerine getirmek için ilgili modeli dinamik olarak SageMaker Endpoint'e yükleyebilirsiniz.. MME'yi çalışırken gösteren bir örnek bulunabilir okuyun. MME'de model barındırmaya ilişkin farklı uyarılar ve en iyi uygulamalar hakkında daha fazla bilgi edinmek istiyorsanız yazıya bakın. okuyun.

- Çoklu Konteyner Uç Noktaları (MCE)

- Birden çok kapsayıcıyı barındırmak için birden çok uç nokta kullanmak yerine, tek bir uç noktada 15'e kadar kapsayıcıyı barındırmayı inceleyebilirsiniz. Bu kapların her biri doğrudan çağrılabilir. Bu nedenle, farklı çerçevelerin farklı modellerini tek bir uç noktada barındırmaya bakabilirsiniz. Bu seçenek, kapsayıcılar benzer kullanım ve performans özellikleri gösterdiğinde en iyisidir. MCE'yi gösteren bir örnek bulunabilir okuyun. MCE'de barındırma modelleri için farklı uyarılar ve en iyi uygulamalar hakkında daha fazla bilgi edinmek istiyorsanız yazıya bakın. okuyun.

- Seri Çıkarım Hattı (SIP)

- Çıkarım mantığınızda adımlardan oluşan bir boru hattınız varsa Seri Çıkarım Hattını (SIP) kullanabilirsiniz. SIP, tek bir uç noktanın arkasında 2-15 konteyneri birbirine zincirlemenize olanak tanır. SIP, ön işleme ve işleme sonrası adımlarınız olduğunda iyi çalışır. Seri çıkarım hatlarına yönelik tasarım modelleri hakkında daha fazla bilgi edinmek istiyorsanız yazıya bakın. okuyun.

Akılda tutulması gereken ikinci ana optimizasyon maliyet. Gerçek Zamanlı Çıkarım, SageMaker Uç Noktaları oluşturmadaki üç seçenekten biridir. SageMaker Uç Noktaları, silinmediği sürece her zaman çalışır. Bu nedenle, uç noktanın kullanımını iyileştirmeye bakmalısınız, bu da maliyet avantajı sağlar.

SageMaker ayrıca şunları sunar: Tasarruf Planları. Tasarruf Planları maliyetlerinizi %64'e kadar azaltabilir. Bu, tutarlı miktarda kullanıma ($/saat) yönelik 1 veya 3 yıllık bir taahhüttür. Bunu gör Link daha fazla bilgi için. Ve şunu gör Link Amazon SageMaker'da Çıkarım maliyetlerini optimize etmek için en iyisi.

Sonuç

Bu yazıda size SageMaker'daki farklı model barındırma seçenekleri arasında seçim yapabileceğiniz en iyi uygulamalardan bazılarını gösterdik. SageMaker Endpoint gereksinimlerini tartıştık ve ayrıca Çerçeve ile BYOC gereksinimleri ve işlevlerini karşılaştırdık. Ayrıca, üretimde makine öğrenimi modellerinizi barındırmak için Gerçek Zamanlı Uç Noktalardan yararlanabileceğiniz farklı yollardan bahsettik. uygun maliyetli ve yüksek performansa sahip.

İlgili olanlara bakın GitHub deposu ve örnekleri deneyin.

yazarlar hakkında

Raghu Rameşa Amazon SageMaker Service ekibiyle birlikte bir ML Çözümleri Mimarıdır. Müşterilerin ML üretim iş yüklerini uygun ölçekte oluşturmasına, dağıtmasına ve SageMaker'a geçirmesine yardımcı olmaya odaklanıyor. Makine öğrenimi, yapay zeka ve bilgisayarla görme alanlarında uzmandır ve UT Dallas'tan Bilgisayar Bilimi alanında yüksek lisans derecesine sahiptir. Boş zamanlarında seyahat etmeyi ve fotoğraf çekmeyi sever.

Raghu Rameşa Amazon SageMaker Service ekibiyle birlikte bir ML Çözümleri Mimarıdır. Müşterilerin ML üretim iş yüklerini uygun ölçekte oluşturmasına, dağıtmasına ve SageMaker'a geçirmesine yardımcı olmaya odaklanıyor. Makine öğrenimi, yapay zeka ve bilgisayarla görme alanlarında uzmandır ve UT Dallas'tan Bilgisayar Bilimi alanında yüksek lisans derecesine sahiptir. Boş zamanlarında seyahat etmeyi ve fotoğraf çekmeyi sever.

Ram Vegiraju SageMaker Servis ekibine sahip bir ML Mimarıdır. Müşterilerin AI/ML çözümlerini Amazon SageMaker'da oluşturmasına ve optimize etmesine yardımcı olmaya odaklanıyor. Boş zamanlarında seyahat etmeyi ve yazmayı sever.

Ram Vegiraju SageMaker Servis ekibine sahip bir ML Mimarıdır. Müşterilerin AI/ML çözümlerini Amazon SageMaker'da oluşturmasına ve optimize etmesine yardımcı olmaya odaklanıyor. Boş zamanlarında seyahat etmeyi ve yazmayı sever.

Marc Karp SageMaker Servis ekibine sahip bir ML Mimarıdır. Müşterilerin ML iş yüklerini uygun ölçekte tasarlamasına, dağıtmasına ve yönetmesine yardımcı olmaya odaklanıyor. Boş zamanlarında seyahat etmekten ve yeni yerler keşfetmekten hoşlanır.

Marc Karp SageMaker Servis ekibine sahip bir ML Mimarıdır. Müşterilerin ML iş yüklerini uygun ölçekte tasarlamasına, dağıtmasına ve yönetmesine yardımcı olmaya odaklanıyor. Boş zamanlarında seyahat etmekten ve yeni yerler keşfetmekten hoşlanır.

Dhaval Patel AWS'de Baş Makine Öğrenimi Mimarıdır. Dağıtılmış bilgi işlem ve yapay zeka ile ilgili sorunlar üzerinde büyük işletmelerden orta ölçekli girişimlere kadar çeşitli kuruluşlarla çalıştı. NLP ve bilgisayarla görme alanları dahil olmak üzere derin öğrenmeye odaklanmaktadır. Müşterilerin Amazon SageMaker'da yüksek performanslı model çıkarımı yapmasına yardımcı olur.

Dhaval Patel AWS'de Baş Makine Öğrenimi Mimarıdır. Dağıtılmış bilgi işlem ve yapay zeka ile ilgili sorunlar üzerinde büyük işletmelerden orta ölçekli girişimlere kadar çeşitli kuruluşlarla çalıştı. NLP ve bilgisayarla görme alanları dahil olmak üzere derin öğrenmeye odaklanmaktadır. Müşterilerin Amazon SageMaker'da yüksek performanslı model çıkarımı yapmasına yardımcı olur.

Saurabh Trikande Amazon SageMaker Inference için Kıdemli Ürün Yöneticisidir. Müşterilerle çalışma konusunda tutkulu ve makine öğrenimini demokratikleştirme hedefiyle motive oluyor. Karmaşık makine öğrenimi uygulamaları, çok kiracılı makine öğrenimi modelleri, maliyet optimizasyonları ve derin öğrenme modellerinin dağıtımını daha erişilebilir hale getirmeyle ilgili temel zorluklara odaklanıyor. Saurabh boş zamanlarında yürüyüş yapmaktan, yenilikçi teknolojiler hakkında bilgi edinmekten, TechCrunch'ı takip etmekten ve ailesiyle vakit geçirmekten hoşlanıyor.

Saurabh Trikande Amazon SageMaker Inference için Kıdemli Ürün Yöneticisidir. Müşterilerle çalışma konusunda tutkulu ve makine öğrenimini demokratikleştirme hedefiyle motive oluyor. Karmaşık makine öğrenimi uygulamaları, çok kiracılı makine öğrenimi modelleri, maliyet optimizasyonları ve derin öğrenme modellerinin dağıtımını daha erişilebilir hale getirmeyle ilgili temel zorluklara odaklanıyor. Saurabh boş zamanlarında yürüyüş yapmaktan, yenilikçi teknolojiler hakkında bilgi edinmekten, TechCrunch'ı takip etmekten ve ailesiyle vakit geçirmekten hoşlanıyor.

- Gelişmiş (300)

- AI

- yapay zeka

- AI sanat üreteci

- yapay zeka robotu

- Amazon Adaçayı Yapıcı

- yapay zeka

- yapay zeka sertifikası

- bankacılıkta yapay zeka

- yapay zeka robotu

- yapay zeka robotları

- yapay zeka yazılımı

- AWS Makine Öğrenimi

- blockchain

- blockchain konferans ai

- zeka

- konuşma yapay zekası

- kripto konferans ai

- dal-e

- derin öğrenme

- google ai

- makine öğrenme

- Platon

- plato yapay zekası

- Plato Veri Zekası

- Plato Oyunu

- PlatoVeri

- plato oyunu

- ölçek ai

- sözdizimi

- zefirnet