Giriş

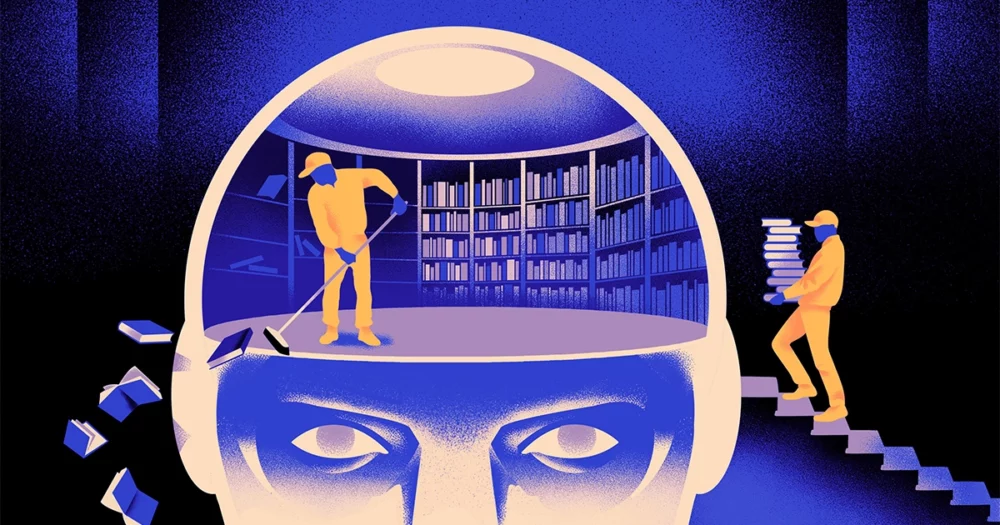

Bilgisayar bilimcilerden oluşan bir ekip, bir daha çevik, daha esnek tip makine öğrenimi modelinin İşin püf noktası: Bildiğini periyodik olarak unutması gerekir. Bu yeni yaklaşım, en büyük uygulamaları destekleyen devasa modellerin yerini almayacak olsa da, bu programların dili nasıl anladığı hakkında daha fazla bilgi verebilir.

Yeni araştırmanın “alanda önemli bir ilerlemeye” işaret ettiği belirtildi Jea KwonGüney Kore'deki Temel Bilimler Enstitüsü'nde yapay zeka mühendisi.

Günümüzde kullanılan yapay zeka dil motorları çoğunlukla yapay sinir ağları. Ağdaki her "nöron", diğer nöronlardan sinyaller alan, bazı hesaplamalar yapan ve sinyalleri birden fazla nöron katmanına gönderen matematiksel bir fonksiyondur. Başlangıçta bilgi akışı az çok rastgeledir, ancak eğitim yoluyla, ağ eğitim verilerine uyum sağladıkça nöronlar arasındaki bilgi akışı gelişir. Örneğin bir yapay zeka araştırmacısı iki dilli bir model oluşturmak istiyorsa, modeli her iki dilden gelen büyük bir metin yığınıyla eğitir; bu, nöronlar arasındaki bağlantıları, bir dildeki metni eşdeğeriyle ilişkilendirecek şekilde ayarlar. diğerindeki kelimeler.

Ancak bu eğitim süreci çok fazla bilgi işlem gücü gerektirir. Model çok iyi çalışmıyorsa veya kullanıcının ihtiyaçları sonradan değişirse, onu uyarlamak zordur. "Diyelim ki 100 dile sahip bir modeliniz var, ancak istediğiniz dillerden birinin kapsanmadığını hayal edin" dedi Mikel ArtetxeYeni araştırmanın ortak yazarı ve AI girişimi Reka'nın kurucusu. "Sıfırdan başlayabilirsiniz ama bu ideal değil."

Artetxe ve meslektaşları bu sınırlamaları aşmaya çalıştılar. Birkaç yıl önceArtetxe ve diğerleri, bir sinir ağını tek bir dilde eğittiler, ardından token adı verilen kelimelerin yapı taşları hakkında bildiklerini sildiler. Bunlar sinir ağının gömme katmanı adı verilen ilk katmanında depolanır. Modelin diğer tüm katmanlarını olduğu gibi bıraktılar. Birinci dilin belirteçlerini sildikten sonra, modeli ikinci dil üzerinde yeniden eğittiler; bu, yerleştirme katmanını o dilden yeni belirteçlerle doldurdu.

Model uyumsuz bilgiler içerse de yeniden eğitim işe yaradı: Model yeni dili öğrenip işleyebildi. Araştırmacılar, yerleştirme katmanının dilde kullanılan kelimelere özgü bilgileri depolarken, ağın daha derin düzeylerinin insan dillerinin ardındaki kavramlar hakkında daha soyut bilgiler depoladığını ve bunun da modelin ikinci dili öğrenmesine yardımcı olduğunu tahmin etti.

“Aynı dünyada yaşıyoruz. Aynı şeyleri farklı dillerde farklı kelimelerle kavramlaştırıyoruz” dedi. Yihong Chen, son makalenin baş yazarı. “Bu nedenle modelde aynı üst düzey mantığa sahipsiniz. Elma sadece bir kelimeden ziyade tatlı ve sulu bir şeydir.”

Giriş

Bu unutma yaklaşımı, önceden eğitilmiş bir modele yeni bir dil eklemenin etkili bir yolu olsa da, yeniden eğitim hala zorluydu; çok fazla dilsel veri ve işlem gücü gerektiriyordu. Chen bir ince ayar önerdi: Eğitim vermek, gömme katmanını silmek ve ardından yeniden eğitmek yerine, eğitimin ilk turu sırasında gömme katmanını periyodik olarak sıfırlamalılar. Artetxe, "Bunu yaparak tüm model sıfırlamaya alışır" dedi. "Bu, modeli başka bir dile genişletmek istediğinizde bunun daha kolay olduğu anlamına gelir, çünkü yaptığınız da budur."

Araştırmacılar yaygın olarak kullanılan bir dil modelini aldılar. Roberta, onu periyodik unutma tekniğini kullanarak eğitti ve aynı modelin standart, unutmayan yaklaşımla eğitildiğindeki performansıyla karşılaştırdı. Unutma modeli geleneksel modelden biraz daha kötü performans gösterdi ve ortak bir dil doğruluğu ölçümünde 85.1 puana kıyasla 86.1 puan aldı. Daha sonra, ilk eğitimde kullandıkları 5 milyar jeton yerine yalnızca 70 milyon jetondan oluşan çok daha küçük veri kümelerini kullanarak modelleri diğer dillerde yeniden eğittiler. Standart modelin doğruluğu ortalama 53.3'e düşerken unutma modelinin doğruluğu yalnızca 62.7'ye düştü.

Unutma modeli, ekibin yeniden eğitim sırasında hesaplama sınırları koyması durumunda çok daha iyi sonuç verdi. Araştırmacılar eğitim uzunluğunu 125,000 adımdan sadece 5,000 adıma düşürdüğünde unutma modelinin doğruluğu ortalama 57.8'e düşerken standart modelin doğruluğu rastgele tahminlerden daha iyi olmayan 37.2'ye düştü.

Giriş

Ekip, periyodik unutmanın, modeli genel olarak dil öğrenmede daha iyi hale getirdiği sonucuna vardı. "Eğitim sırasında unutmaya ve yeniden öğrenmeye devam ettikleri için, ağa daha sonra yeni bir şeyler öğretmek daha kolay hale geliyor" dedi Evgenii NikişinQuebec'teki derin öğrenme araştırma merkezi Mila'da araştırmacı. Bu, dil modellerinin bir dili anladığında, bunu yalnızca tek tek kelimelerin anlamlarından daha derin bir düzeyde anladığını öne sürüyor.

Yaklaşım beynimizin çalışma şekline benzer. "İnsan hafızası genel olarak büyük miktardaki ayrıntılı bilgiyi doğru bir şekilde saklama konusunda pek iyi değildir. Bunun yerine insanlar, soyutlama ve çıkarımlarda bulunarak deneyimlerimizin özünü hatırlama eğiliminde oluyorlar” dedi. Benjamin LevySan Francisco Üniversitesi'nden bir sinir bilimci. "Yapay zekayı uyarlanabilir unutma gibi daha insani süreçlerle etkinleştirmek, onları daha esnek bir performansa ulaştırmanın bir yoludur."

Artetxe, anlamanın nasıl çalıştığına ilişkin söyleyebileceklerinin yanı sıra, daha esnek unutma dili modellerinin de en yeni yapay zeka buluşlarının daha fazla dile getirilmesine yardımcı olabileceğini umuyor. Yapay zeka modelleri, bol miktarda eğitim materyali içeren iki dil olan İspanyolca ve İngilizce'yi kullanmada iyi olsa da, modeller kuzeydoğu İspanya'ya özgü yerel dil olan anadili Baskça ile o kadar iyi değil. "Büyük teknoloji şirketlerinin çoğu modeli bunu pek iyi yapmıyor" dedi. "Mevcut modelleri Bask'a uyarlamak gidilecek yoldur."

Chen ayrıca daha fazla yapay zeka çiçeğinin çiçek açtığı bir dünyayı sabırsızlıkla bekliyor. “Dünyanın büyük bir dil modeline ihtiyaç duymadığı bir durumu düşünüyorum. O kadar çok şeyimiz var ki" dedi. “Dil modelleri üreten bir fabrika varsa bu tür bir teknolojiye ihtiyacınız var. Yeni alanlara hızla uyum sağlayabilecek tek bir temel modeli var.”

- SEO Destekli İçerik ve Halkla İlişkiler Dağıtımı. Bugün Gücünüzü Artırın.

- PlatoData.Network Dikey Üretken Yapay Zeka. Kendine güç ver. Buradan Erişin.

- PlatoAiStream. Web3 Zekası. Bilgi Genişletildi. Buradan Erişin.

- PlatoESG. karbon, temiz teknoloji, Enerji, Çevre, Güneş, Atık Yönetimi. Buradan Erişin.

- PlatoSağlık. Biyoteknoloji ve Klinik Araştırmalar Zekası. Buradan Erişin.

- Kaynak: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :vardır

- :dır-dir

- :olumsuzluk

- :Neresi

- ][P

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Hakkımızda

- ÖZET

- doğruluk

- tam olarak

- uyarlamak

- adaptif

- uyarlar

- eklemek

- ilave

- ilerlemek

- Sonra

- AI

- AI modelleri

- Türkiye

- tek başına

- zaten

- Ayrıca

- tutarları

- an

- ve

- Başka

- Apple

- yaklaşım

- uygulamalar

- ARE

- AS

- At

- yazar

- ortalama

- baz

- temel

- Çünkü

- olur

- olmuştur

- arkasında

- Daha iyi

- arasında

- Büyük

- büyük teknoloji

- Biggest

- Milyar

- Blokları

- Çiçek açmak

- her ikisi de

- buluşların

- getirmek

- bina

- fakat

- by

- hesaplamalar

- denilen

- CAN

- Merkez

- değişiklik

- chen

- atlatmak

- Ortak Yazar

- arkadaşları

- ortak

- çoğunlukla

- Şirketler

- karşılaştırıldığında

- bilişimsel

- bilgisayar

- bilgisayar

- işlem gücü

- kavramlar

- sonucuna

- Bağlantılar

- içerdiği

- geleneksel

- olabilir

- kaplı

- yaratmak

- çevrimiçi kurslar düzenliyorlar.

- kesim

- veri

- veri kümeleri

- azalmış

- derin

- derin öğrenme

- derin

- talep

- detaylı

- DID

- farklı

- do

- Değil

- yapıyor

- etki

- Dont

- düştü

- sırasında

- her

- kolay

- Etkili

- katıştırma

- mühendis

- Motorlar

- İngilizce

- Tüm

- Eşdeğer

- örnek

- mevcut

- Deneyimler

- uzatmak

- fabrika

- az

- alan

- dolu

- Ad

- esnek

- akış

- İçin

- ileri

- kurucu

- Francisco

- itibaren

- işlev

- genel

- genellikle

- almak

- GitHub

- Go

- Tercih Etmenizin

- kullanma

- Zor

- Var

- he

- yardım et

- yardım

- üst düzey

- onun

- umut

- Ne kadar

- HTTPS

- Kocaman

- insan

- İnsan gibi

- İnsanlar

- ideal

- if

- resim

- dayatılan

- geliştirir

- in

- bireysel

- bilgi

- ilk

- başlangıçta

- yerine

- Enstitü

- IT

- sadece

- tutmak

- Nezaket.

- bilir

- Kore

- dil

- Diller

- büyük

- sonra

- son

- tabaka

- katmanları

- öncülük etmek

- ÖĞRENİN

- öğrenme

- sol

- uzunluk

- az

- seviye

- seviyeleri

- sevmek

- sınırlamaları

- sınırları

- yaşamak

- yerel

- GÖRÜNÜYOR

- Çok

- makine

- makine öğrenme

- dergi

- yapmak

- Yapımı

- çok

- malzemeler

- matematiksel

- anlamları

- anlamına geliyor

- ölçmek

- Bellek

- olabilir

- milyon

- model

- modelleri

- Daha

- çoğunlukla

- çok

- çoklu

- şart

- yerli

- gerek

- ihtiyaçlar

- ağ

- sinir

- sinir ağı

- Nöronlar

- yeni

- yok hayır

- of

- on

- ONE

- bir tek

- or

- Diğer

- Diğer

- bizim

- tekrar

- kendi

- kâğıt

- performans

- periyodik

- Platon

- Plato Veri Zekası

- PlatoVeri

- daldı

- güç kelimesini seçerim

- powered

- süreç

- Süreçler

- işleme

- İşleme gücü

- Programlar

- Quanta dergisi

- Quebec

- hızla

- rasgele

- daha doğrusu

- alır

- alma

- son

- hatırlamak

- gereklidir

- araştırma

- araştırmacı

- Araştırmacılar

- açığa vurmak

- yuvarlak

- ishal

- Adı geçen

- aynı

- San

- San Francisco

- söylemek

- Bilim

- bilim adamları

- Gol

- çizik

- İkinci

- görünüyor

- seçici

- gönderir

- Setleri

- o

- meli

- sinyalleri

- önemli

- benzer

- durum

- daha küçük

- So

- biraz

- bir şey

- güney

- Güney Kore

- ispanya

- İspanyolca

- özel

- standart

- başlama

- başlangıç

- Basamaklar

- Yine

- saklı

- depolamak

- böyle

- Önerdi

- tatlı

- alır

- Öğretim

- takım

- teknoloji

- teknoloji şirketleri

- teknik

- Teknoloji

- eğilimindedir

- metin

- göre

- o

- The

- Bilgi

- Dünya

- ve bazı Asya

- Onları

- sonra

- Bunlar

- onlar

- işler

- Düşünme

- Re-Tweet

- gerçi?

- İçinden

- için

- bugün

- Jeton

- aldı

- Tren

- eğitilmiş

- Eğitim

- hile

- denenmiş

- çimdik

- iki

- anlamak

- anlayış

- üniversite

- kullanım

- Kullanılmış

- kullanma

- çok

- istemek

- istiyor

- oldu

- Yol..

- we

- webp

- İYİ

- Ne

- ne zaman

- hangi

- süre

- neden

- ile

- Word

- sözler

- İş

- işlenmiş

- çalışır

- Dünya

- kötü

- olur

- yıl

- Sen

- zefirnet