Beynin mekansal bilgiyi nasıl organize ettiğini ve bu bilgiye nasıl eriştiğini anlamak (neredeyiz, köşede ne var, oraya nasıl gidilir) hala zorlu bir görevdir. Süreç, her biri binlerce diğerine bağlı olan on milyarlarca nörondan gelen tüm anılar ağının ve depolanmış uzamsal verilerin geri çağrılmasını içerir. Sinirbilimciler aşağıdaki gibi temel unsurları belirlediler: ızgara hücrelerikonumları haritalandıran nöronlar. Ancak daha derine inmek zor olacaktır: Araştırmacılar, konuma dayalı görüntü, ses ve koku anılarının nasıl aktığını ve birbirine nasıl bağlandığını izlemek için insanın gri maddesinden kesitler alıp inceleyemezler.

Yapay zeka başka bir yol sunuyor. Sinir bilimciler yıllardır beyindeki nöronların ateşlenmesini modellemek için birçok türde sinir ağını (derin öğrenme uygulamalarının çoğuna güç sağlayan motorlar) kullandılar. Son zamanlarda yapılan çalışmalarda araştırmacılar, beynin hafıza için kritik bir yapısı olan hipokampusun temelde özel bir tür sinir ağı olduğunu gösterdi. transformatör, kılık değiştirmiş. Yeni modelleri, mekansal bilgiyi beynin iç işleyişine paralel olacak şekilde izliyor. Olağanüstü bir başarı elde ettiler.

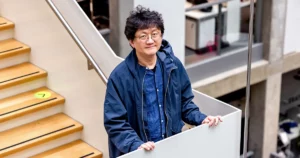

"Beynin bu modellerinin transformatöre eşdeğer olduğunu bilmemiz, modellerimizin çok daha iyi performans gösterdiği ve eğitilmelerinin daha kolay olduğu anlamına geliyor" dedi. James Whittingtonzamanını Stanford Üniversitesi ile laboratuvar arasında paylaştıran bilişsel sinir bilimci Tim Behrens Oxford Üniversitesi'nde.

Whittington ve diğerlerinin çalışmaları, transformatörlerin, sinir ağı modellerinin, ızgara hücreleri ve beynin diğer bölümleri tarafından gerçekleştirilen hesaplama türlerini taklit etme yeteneğini büyük ölçüde geliştirebileceğini ima ediyor. Whittington, bu tür modellerin yapay sinir ağlarının nasıl çalıştığına ve hatta daha büyük olasılıkla hesaplamaların beyinde nasıl yürütüldüğüne dair anlayışımızı geliştirebileceğini söyledi.

"Beyni yeniden yaratmaya çalışmıyoruz" dedi david haGoogle Brain'de transformatör modelleri üzerinde de çalışan bir bilgisayar bilimcisi. “Fakat beynin yaptığını yapabilecek bir mekanizma yaratabilir miyiz?”

Transformers ilk olarak beş yıl önce yapay zekanın dili işlemesinin yeni bir yolu olarak ortaya çıktı. Bunlar, manşetlere çıkan cümle tamamlama programlarındaki gizli soslardır. Bert ve ikna edici şarkı sözleri üretebilen, Shakespeare soneleri oluşturabilen ve müşteri hizmetleri temsilcilerini taklit edebilen GPT-3.

Transformatörler, her girdinin (bir kelime, bir piksel, bir dizideki bir sayı) her zaman diğer girdilere bağlı olduğu, öz-dikkat adı verilen bir mekanizma kullanarak çalışır. (Diğer sinir ağları, girdileri yalnızca diğer belirli girdilere bağlar.) Ancak dönüştürücüler dil görevleri için tasarlanırken, o zamandan beri görüntüleri sınıflandırmak ve şimdi de beyni modellemek gibi diğer görevlerde başarılı oldular.

2020 yılında liderliğindeki bir grup Eylül HochreiterAvusturya'daki Linz Johannes Kepler Üniversitesi'nden bilgisayar bilimci, Hopfield ağı adı verilen güçlü, uzun süredir devam eden bir bellek alma modelini yeniden düzenlemek için bir transformatör kullandı. İlk kez 40 yıl önce Princeton'lu fizikçi John Hopfield tarafından ortaya atılan bu ağlar genel bir kurala uyuyor: Aynı anda aktif olan nöronlar birbirleriyle güçlü bağlantılar kuruyor.

Hochreiter ve işbirlikçileri, araştırmacıların daha iyi hafıza geri çağırma modelleri aradıklarını belirterek, Hopfield ağlarının anıları nasıl geri getirdiği ile transformatörlerin dikkati nasıl yerine getirdiği arasında bir bağlantı gördüler. Hopfield ağını yükselterek onu bir transformatöre dönüştürdüler. Whittington, bu değişikliğin, modelin daha etkili bağlantılar sayesinde daha fazla anı depolamasına ve almasına olanak sağladığını söyledi. Hopfield, MIT-IBM Watson Yapay Zeka Laboratuvarı'ndan Dmitry Krotov ile birlikte, transformatör tabanlı bir Hopfield ağının biyolojik olarak makul olduğunu kanıtladı.

Daha sonra, bu senenin başlarındaWhittington ve Behrens, Hochreiter'in yaklaşımında daha fazla değişiklik yapılmasına yardımcı oldular; dönüştürücüyü değiştirerek anıları doğrusal bir dizi olarak (bir cümledeki kelimeler dizisi gibi) ele almak yerine onları yüksek boyutlu uzaylardaki koordinatlar olarak kodladılar. Araştırmacıların adlandırdığı gibi bu "bükülme", modelin sinirbilim görevlerindeki performansını daha da geliştirdi. Ayrıca modelin, sinir bilimcilerin fMRI taramalarında gördüğü ızgara hücre ateşleme modellerine matematiksel olarak eşdeğer olduğunu da gösterdiler.

University College London'dan sinir bilimci Caswell Barry, "Izgara hücreler heyecan verici, güzel, düzenli bir yapıya ve rastgele ortaya çıkması muhtemel olmayan çarpıcı desenlere sahip" dedi. Yeni çalışma, transformatörlerin hipokampusta gözlemlenen kalıpları tam olarak nasıl kopyaladığını gösterdi. "Bir transformatörün, önceki durumlara dayanarak nerede olduğunu ve nasıl hareket ettiğini ve geleneksel ızgara hücresi modellerine göre kilitlenmiş bir şekilde anlayabildiğini fark ettiler."

Son zamanlarda yapılan diğer çalışmalar, transformatörlerin diğer beyin fonksiyonlarına ilişkin anlayışımızı da geliştirebileceğini öne sürüyor. Geçtiğimiz yıl, Massachusetts Teknoloji Enstitüsü'nde hesaplamalı sinir bilimci olan Martin Schrimpf, 43 farklı sinir ağı modelini analiz etti fMRI ve elektrokortikografi tarafından rapor edilen insan sinir aktivitesi ölçümlerini ne kadar iyi tahmin ettiklerini görmek için. Transformatörlerin, görüntülemede bulunan hemen hemen tüm varyasyonları tahmin eden, mevcut lider, son teknoloji ürünü sinir ağları olduğunu buldu.

Ve Ha, bilgisayar bilimcisi arkadaşıyla birlikte Yujin Tang, yakın zamanda insan vücudunun duyusal gözlemleri beyne nasıl ilettiğini taklit ederek büyük miktarlarda veriyi bir transformatör aracılığıyla rastgele, sırasız bir şekilde kasıtlı olarak gönderebilecek bir model tasarladı. Beynimiz gibi onların transformatörü de düzensiz bilgi akışını başarıyla yönetebiliyordu.

Tang, "Sinir ağları belirli bir girişi kabul edecek şekilde programlanmıştır" dedi. Ancak gerçek hayatta veri kümeleri sıklıkla hızlı bir şekilde değişir ve çoğu yapay zekanın uyum sağlama yolu yoktur. "Çok hızlı adapte olabilecek bir mimariyi denemek istedik."

Bu ilerleme işaretlerine rağmen Behrens, transformatörleri arayışın sonu değil, beynin doğru modeline doğru atılmış bir adım olarak görüyor. "Burada şüpheci bir sinirbilimci olmam gerekiyor" dedi. “Örneğin, mevcut en iyi cümle modeline sahip olmalarına rağmen, dönüştürücülerin beyindeki dil hakkında düşündüğümüz gibi olacağını düşünmüyorum.”

“Nerede olduğum ve bundan sonra ne göreceğim hakkında tahminlerde bulunmak için en etkili temel bu mu? Dürüst olmak gerekirse bunu söylemek için henüz çok erken" dedi Barry.

Schrimpf de en iyi performans gösteren dönüştürücülerin bile sınırlı olduğunu, örneğin kelimeler ve kısa ifadeler için iyi çalıştığını, ancak hikaye anlatmak gibi daha büyük ölçekli dil görevleri için işe yaramadığını belirtti.

Schrimpf, "Bana göre bu mimari, bu dönüştürücü, sizi beynin yapısını anlamanız için doğru yere koyuyor ve eğitimle geliştirilebilir" dedi. "Bu iyi bir yön, ancak alan son derece karmaşık."