Amazon Adaçayır Veri Düzenleyici verileri daha hızlı temizlemeye, dönüştürmeye ve hazırlamaya yönelik özelliklerle veri analizi, ön işleme ve görselleştirmenin gerçekleştirilmesine yardımcı olan kullanıcı arayüzü tabanlı bir veri hazırlama aracıdır. Data Wrangler'ın önceden oluşturulmuş akış şablonları, ortak veri kümelerini kullanan veri akışlarına yönelik en iyi uygulama modellerini hızlandırmanıza ve anlamanıza yardımcı olarak veri bilimcileri ve makine öğrenimi (ML) uygulayıcıları için veri hazırlığının daha hızlı yapılmasına yardımcı olur.

Aşağıdaki görevleri gerçekleştirmek için Data Wrangler akışlarını kullanabilirsiniz:

- Veri goruntuleme – Veri setindeki her sütun için istatistiksel özelliklerin incelenmesi, histogramların oluşturulması, aykırı değerlerin incelenmesi

- Veri temizleme – Yinelenenleri kaldırmak, girişleri bırakmak veya eksik değerlerle doldurmak, aykırı değerleri kaldırmak

- Veri zenginleştirme ve özellik mühendisliği – Daha etkileyici özellikler oluşturmak için sütunları işleme, eğitim için bir özellik alt kümesi seçme

Bu gönderi, aşağıdaki örnek önceden oluşturulmuş akışları kullanarak Data Wrangler'ı anlamanıza yardımcı olacaktır. GitHub. Depo, tablo halinde veri dönüşümünü, zaman serisi veri dönüşümlerini ve birleştirilmiş veri kümesi dönüşümlerini sergiliyor. Her biri temel doğaları gereği farklı türde dönüşümler gerektirir. Standart tablo veya kesitsel veriler zamanın belirli bir noktasında toplanır. Bunun aksine, zaman serisi verileri zaman içinde tekrar tekrar yakalanır ve her ardışık veri noktası geçmiş değerlerine bağlıdır.

Tablo verileri için örnek veri akışını nasıl kullanabileceğimize dair bir örneğe bakalım.

Önkoşullar

Data Wrangler bir Amazon Adaçayı Yapıcı özelliği mevcut Amazon SageMaker Stüdyosu, bu nedenle Studio ortamını ve not defterlerini başlatmak için Studio katılım sürecini izlememiz gerekiyor. Birkaç kimlik doğrulama yöntemi arasından seçim yapabilmenize rağmen Studio alanı oluşturmanın en basit yolu şu adımları takip etmektir: Hızlı başlangıç talimatlar. Hızlı başlangıç, Hızlı Başlangıç ile aynı varsayılan ayarları kullanır. standart Stüdyo kurulumu. Ayrıca şunu kullanarak katılmayı da seçebilirsiniz: AWS IAM Kimlik Merkezi (AWS Single Sign-On'un halefi) kimlik doğrulaması için (bkz. IAM Identity Center'ı Kullanarak Amazon SageMaker Etki Alanında Yerleşik).

Studio'yu kullanarak veri kümesini ve akış dosyalarını Data Wrangler'a aktarın

Aşağıdaki adımlar, Data Wrangler tarafından kullanılacak verilerin SageMaker'a nasıl aktarılacağını özetlemektedir:

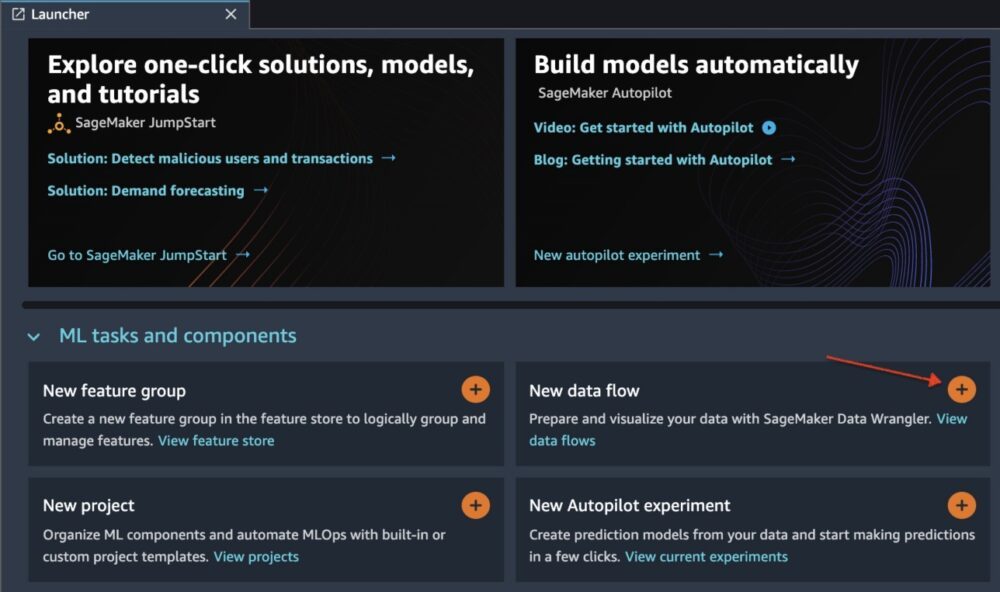

Data Wrangler'ı Studio kullanıcı arayüzü aracılığıyla aşağıdakileri seçerek başlatın: Yeni veri akışı.

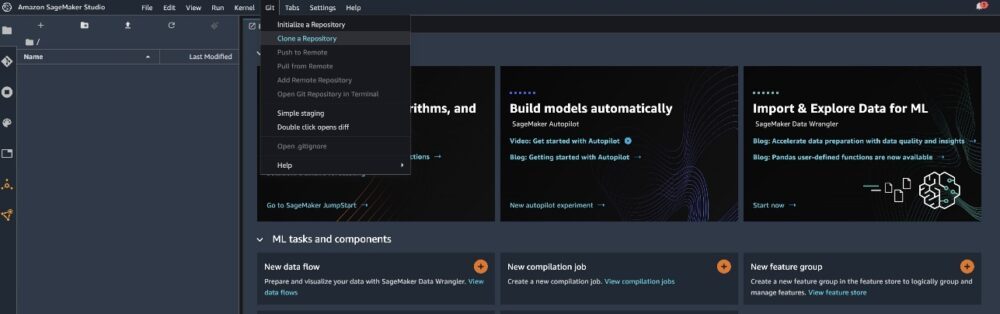

klonlamak GitHub repo Akış dosyalarını Studio ortamınıza indirmek için.

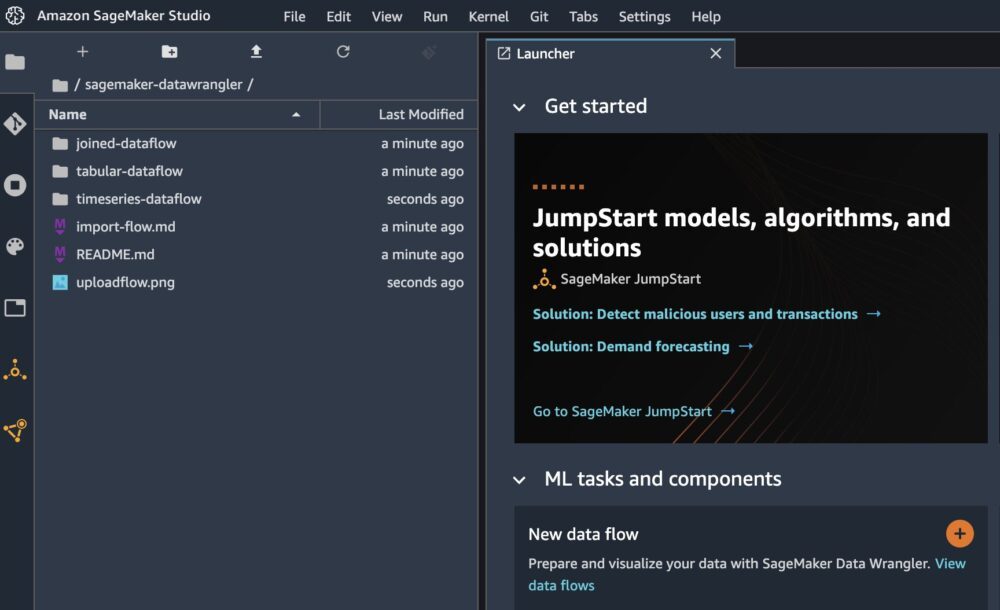

Klonlama tamamlandığında sol bölmede depo içeriğini görebilmeniz gerekir.

Dosyayı seçin Otel-Rezervasyonları-Sınıflandırma.flow akış dosyasını Data Wrangler'a aktarmak için.

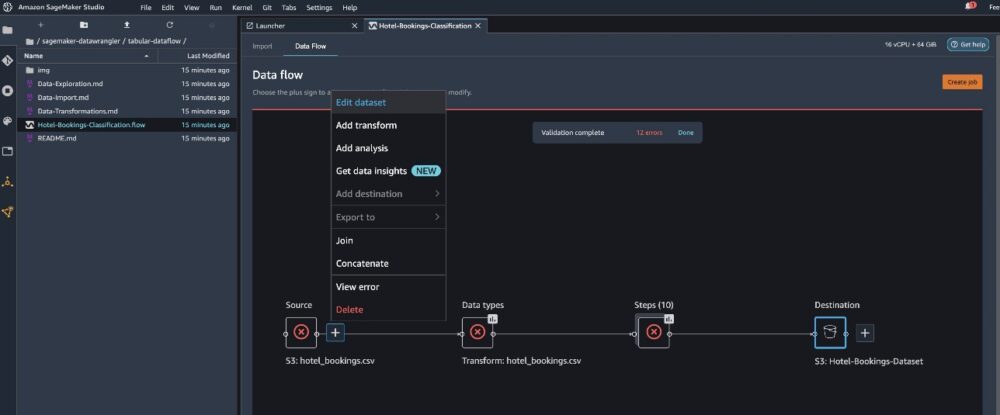

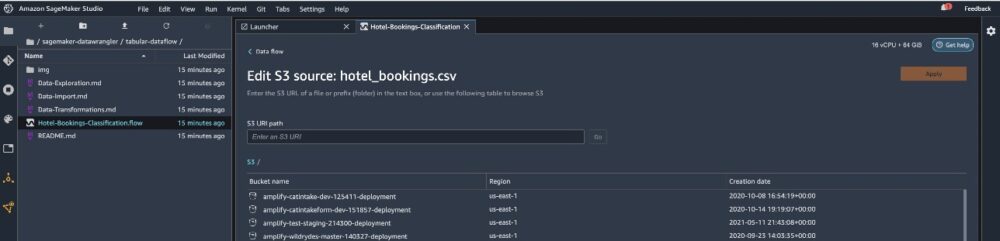

Zaman serisini veya birleştirilmiş veri akışını kullanırsanız akış farklı bir adla görünecektir. Akış içe aktarıldıktan sonra aşağıdaki ekran görüntüsünü görmelisiniz. Bu bize hataları gösterir çünkü akış dosyasının doğru veri kaynağına işaret ettiğinden emin olmamız gerekir. Amazon Basit Depolama Hizmeti (Amazon S3).

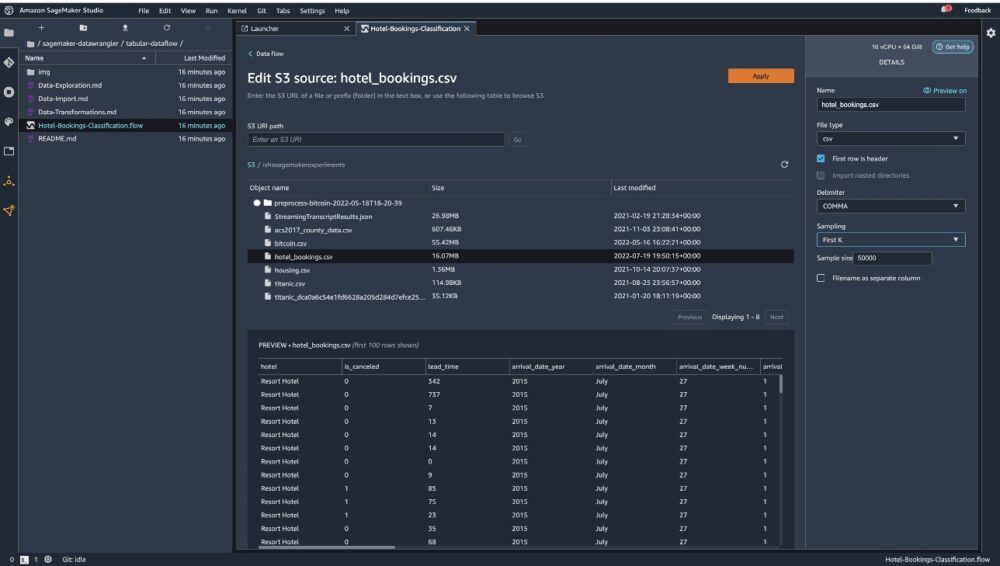

Klinik Veri kümesini düzenle tüm S3 klasörlerinizi getirmek için. Ardından veri kümesini seçin hotel_bookings.csv çalıştırmak için S3 kovanızdan tablo halinde veri akışı.

kullanıyorsanız şunu unutmayın: birleştirilmiş veri akışıbirden fazla veri kümesini Data Wrangler'a aktarmanız gerekebilir

Sağ bölmede, emin olun VİRGÜL sınırlayıcı olarak seçilir ve Örnekleme ayarlandı İlk K. Veri kümemiz, Data Wrangler dönüşümlerini tüm veri kümesinde çalıştırabilecek kadar küçüktür, ancak veri kümesini nasıl içe aktarabileceğinizi vurgulamak istedik. Büyük bir veri kümeniz varsa örneklemeyi kullanmayı düşünün. Seçmek ithalat Bu veri kümesini Data Wrangler'a aktarmak için.

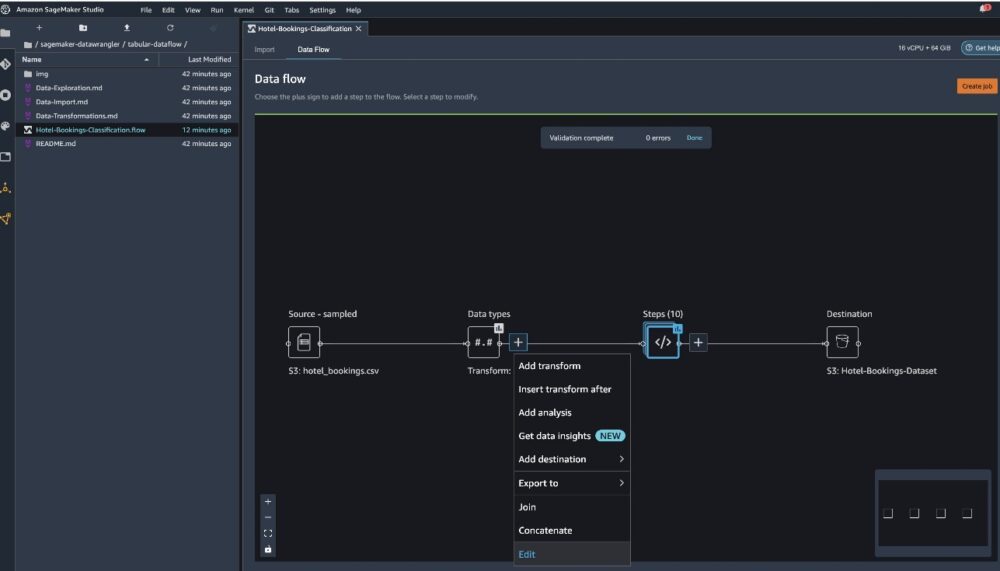

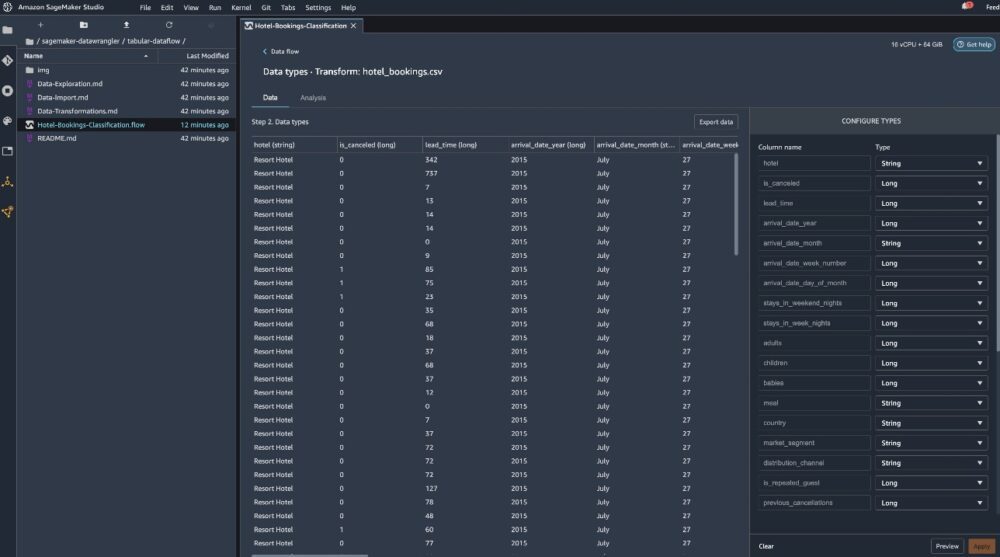

Veri kümesi içe aktarıldıktan sonra Data Wrangler, veri kümesini otomatik olarak doğrular ve veri türlerini algılar. Doğru veri kümesini işaret ettiğimiz için hataların ortadan kalktığını görebilirsiniz. Akış düzenleyicisi artık verilerin bir kaynaktan içe aktarıldığını ve tanınan veri türlerini gösteren iki blok gösteriyor. Gerekirse veri türlerini de düzenleyebilirsiniz.

Aşağıdaki ekran görüntüsü veri türlerimizi göstermektedir.

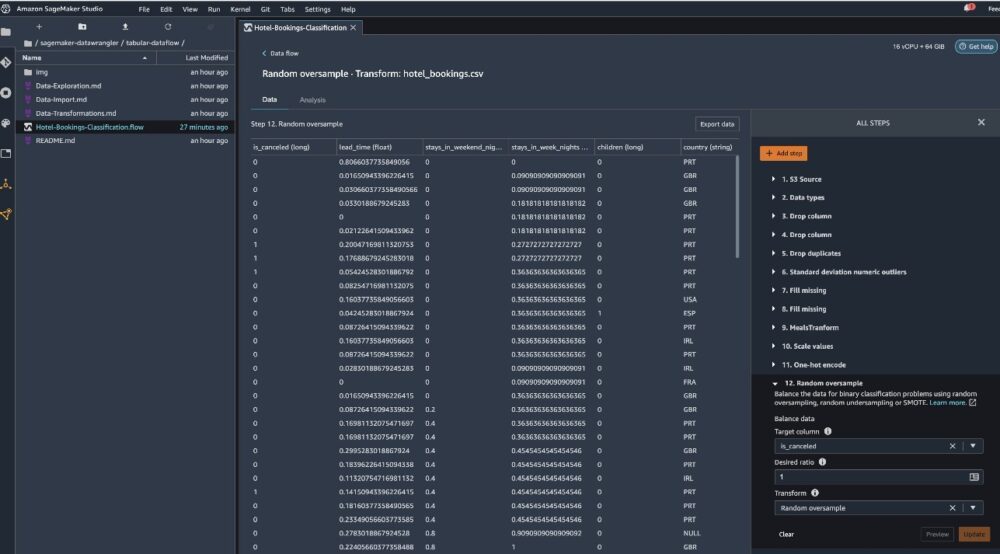

Bu tablo akışının bir parçası olarak yapılan bazı dönüşümlere bakalım. Eğer kullanıyorsanız Zaman serisi or katıldı veri akışlarında bazı yaygın dönüşümlere göz atın GitHub repo. Hedef sızıntıyı ve veri kümesindeki özellik eşgüdümünü, tablo özeti analizlerini ve hızlı modelleme yeteneğini inceleyen veri öngörü raporlarını kullanarak bazı temel keşifsel veri analizleri gerçekleştirdik. Şuradaki adımları keşfedin: GitHub repo.

Artık Veri Analizleri ve Kalite Raporu tarafından sağlanan önerilere dayalı olarak sütunları kaldırıyoruz.

- Hedef sızıntısı için bırakın rezervasyon_durumu.

- Yedekli sütunlar için bırakın bekleme_listesindeki gün sayısı, otel, ayrılmış_oda_türü, varış_tarihi_ay, rezervasyon_durum_tarihi, bebekler, ve Arrival_date_day_of_month.

- Doğrusal korelasyon sonuçlarına göre sütunları bırakın Arrival_date_week_number ve varış_tarihi_yıl çünkü bu özellik (sütun) çiftlerinin korelasyon değerleri önerilen eşik olan 0.90'dan daha yüksektir.

- Doğrusal olmayan korelasyon sonuçlarına dayanarak, düşüş rezervasyon_durumu. Bu sütun zaten hedef sızıntı analizine göre çıkarılmak üzere işaretlenmişti.

- İşlem sayısal değerleri (min-maks ölçeklendirme) teslim süresi, hafta sonu_gecelerindeki konaklamalar, hafta içi_gecelerdeki konaklamalar, tekrarlanan_misafir, önceki_iptaller, önceki_rezervasyonlar_iptal edilmeyen, rezervasyon_değişiklikleri, adr, toplam_özel_istekler, ve gerekli_car_parking_spaces.

- Tek sıcak kodlama gibi kategorik değişkenler yemek, tekrarlanan_misafir, pazar_segmenti, tahsis edilen_oda_türü, mevduat_türü, ve müşteri tipi.

- Hedef değişkeni dengeleyin Sınıf dengesizliği için rastgele aşırı örnekleme. Aykırı değerleri ve eksik değerleri işlemek için hızlı modelleme yeteneğini kullanın.

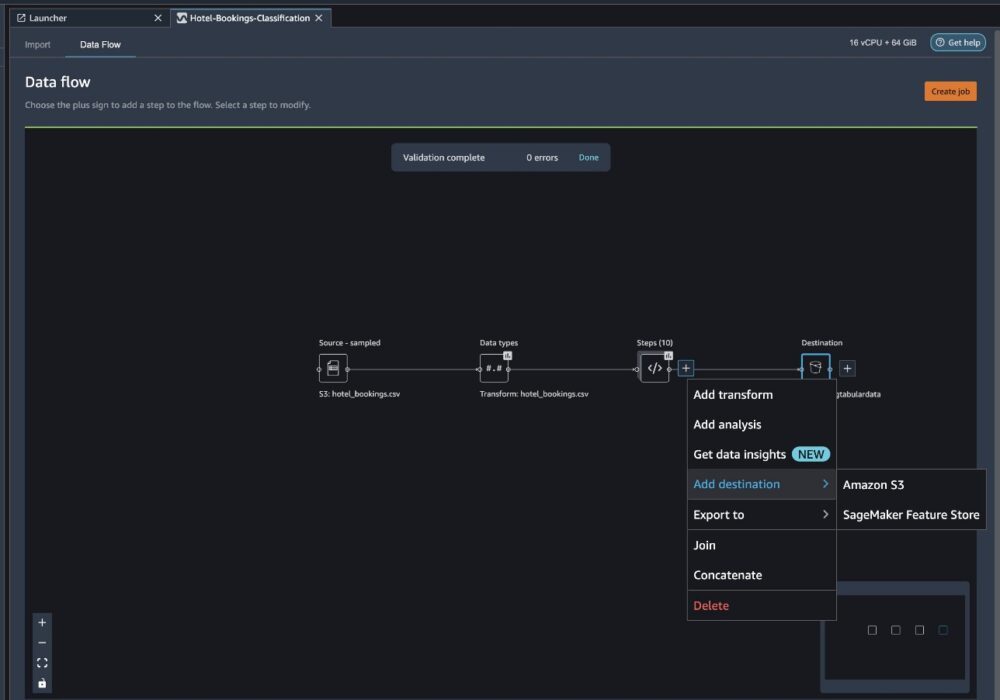

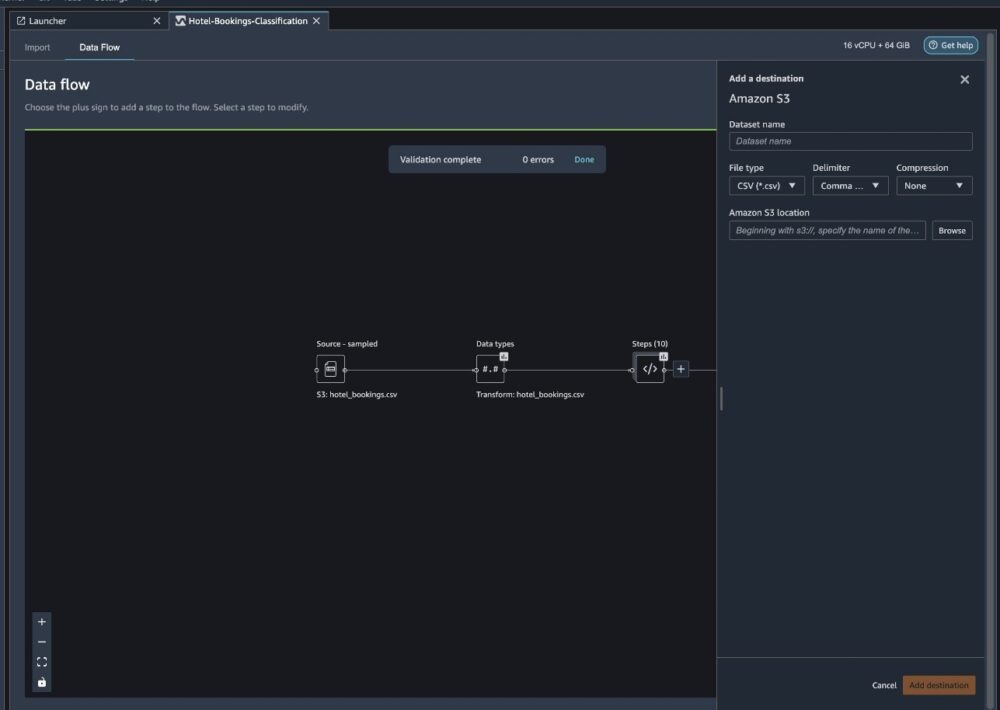

Amazon S3'e aktar

Artık farklı dönüşümlerden geçtik ve verileri Amazon S3'e aktarmaya hazırız. Bu seçenek, Data Wrangler işleme akışını çalıştıran ve elde edilen veri kümesini belirli bir S3 klasörüne kaydeden bir SageMaker işleme işi oluşturur. Amazon S3'e aktarmayı ayarlamak için sonraki adımları izleyin:

Dönüşüm öğeleri koleksiyonunun yanındaki artı işaretini seçin ve Hedef ekle, Daha sonra Amazon S3.

- İçin Veri kümesi adı, yeni veri kümesi için bir ad girin; örneğin

NYC_export. - İçin Dosya türü, seçmek CSV.

- İçin Sınırlayıcı, seçmek Virgül.

- İçin Sıkıştırma, seçmek Hayır.

- İçin Amazon S3 konumu, daha önce oluşturduğumuz paket adını kullanın.

- Klinik Hedef ekle.

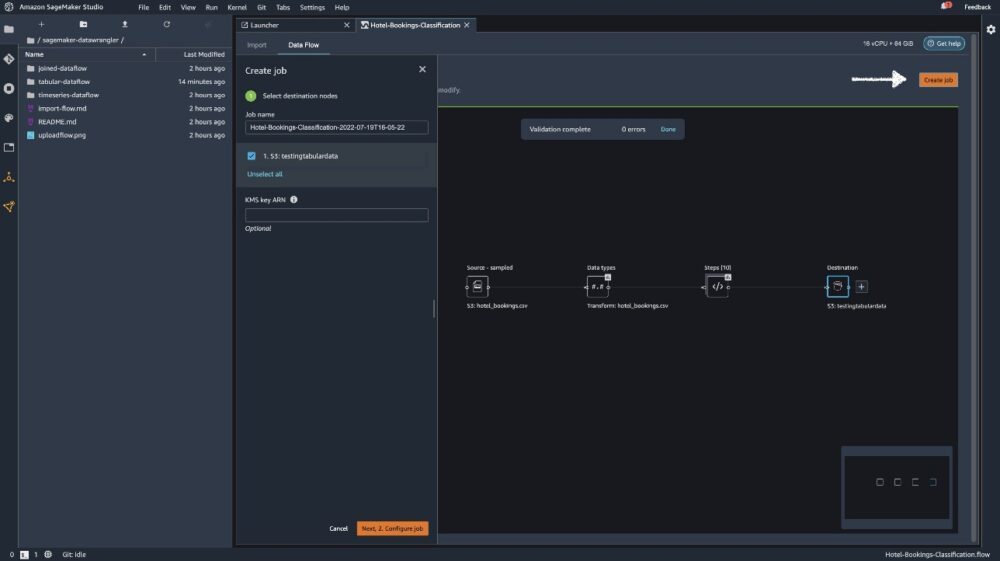

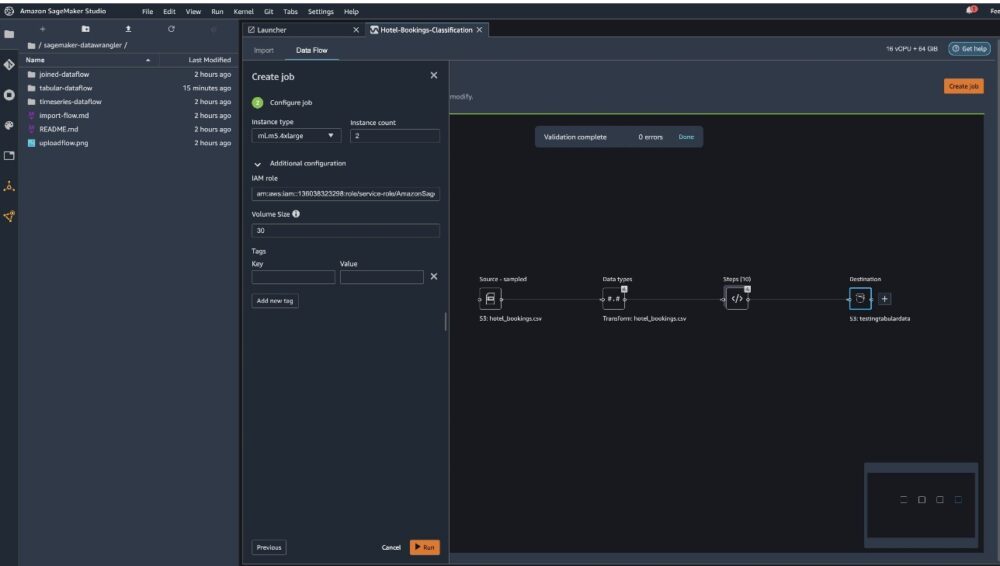

Klinik İş oluştur.

İçin İş adı, bir ad girin veya otomatik oluşturulan seçeneği koruyun ve hedef. Tek hedefimiz var, S3:testingtabulardata, ancak iş akışınızdaki farklı adımlardan birden fazla hedefiniz olabilir. Bırak KMS anahtarı ARN alanı boş bırakın ve seçin Sonraki.

Artık bir iş için işlem kapasitesini yapılandırmanız gerekiyor. Bu örnek için tüm varsayılan değerleri koruyabilirsiniz.

- İçin Örnek türü, ml.m5.4xlarge kullanın.

- İçin Örnek sayısı, 2'yi kullanın.

- keşfedebilirsin Ek yapılandırmaancak varsayılan ayarları koruyun.

- Klinik koşmak.

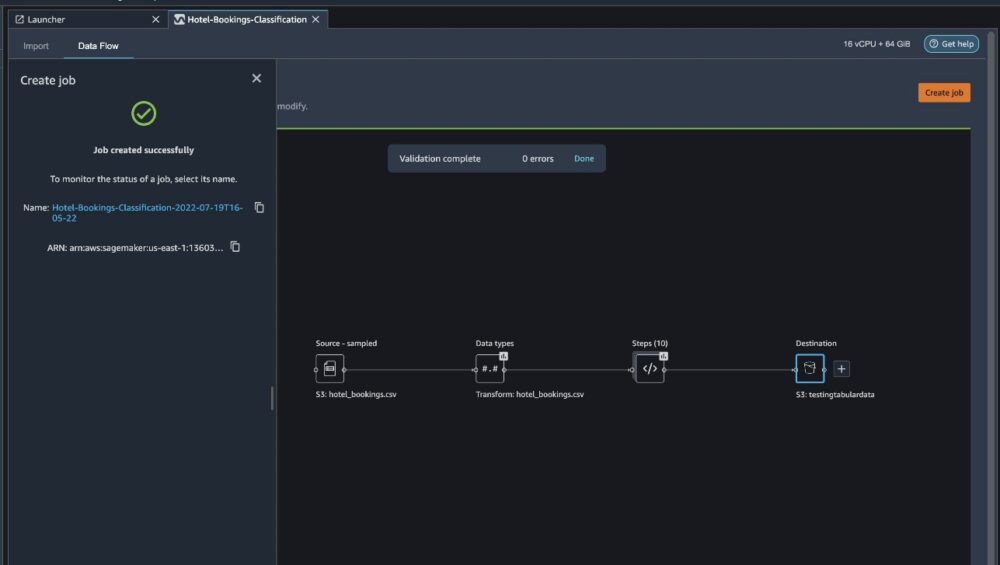

Artık işiniz başladı ve Data Wrangler işleme akışımıza göre 6 GB verinin işlenmesi biraz zaman alıyor. Bu işin maliyeti yaklaşık 2 ABD Doları olacaktır çünkü ml.m5.4xlarge'ın maliyeti saat başına 0.922 ABD Dolarıdır ve biz bunlardan ikisini kullanıyoruz.

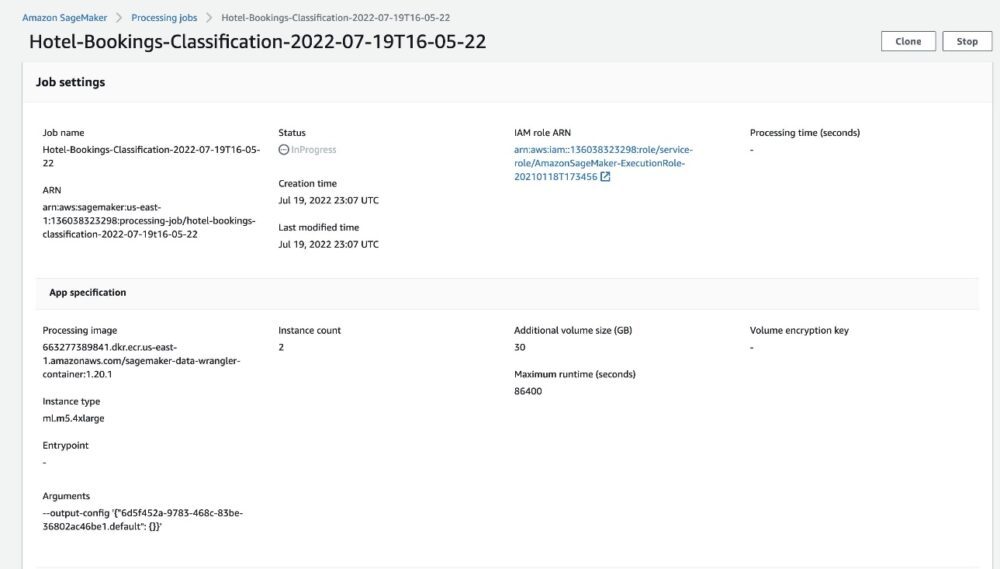

İşin adını seçerseniz iş ayrıntılarının bulunduğu yeni bir pencereye yönlendirilirsiniz.

İş ayrıntıları sayfasında önceki adımlardaki tüm parametreleri görebilirsiniz.

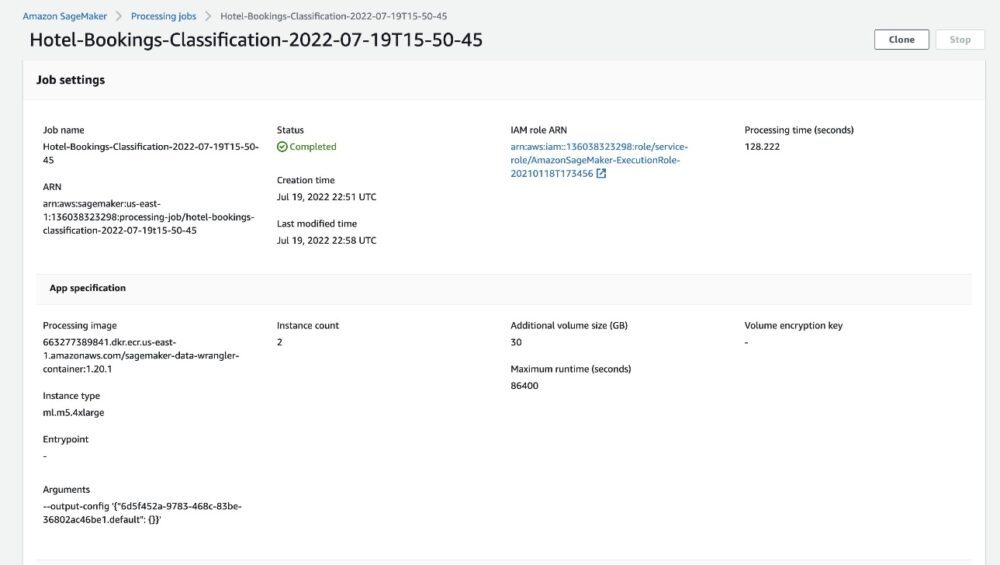

İş durumu Tamamlandı olarak değiştiğinde ayrıca şunları da kontrol edebilirsiniz: İşlem süresi (saniye) değer. Bu işleme işinin tamamlanması yaklaşık 5-10 dakika sürer.

İş tamamlandığında eğitim ve test çıktı dosyaları ilgili S3 çıktı klasörlerinde bulunur. Çıkış konumunu işleme işi yapılandırmalarından bulabilirsiniz.

Data Wrangler işleme işi tamamlandıktan sonra S3 klasörümüze kaydedilen sonuçları kontrol edebiliriz. Güncellemeyi unutmayın job_name iş adınızla birlikte değişken.

Artık dışa aktarılan bu verileri makine öğrenimi modellerini çalıştırmak için kullanabilirsiniz.

Temizlemek

S3 paketlerinizi silin ve Veri Wrangler akışı denemeyi tamamladıktan sonra temel kaynakları silmek ve istenmeyen maliyetleri önlemek için.

Sonuç

Bu yazıda, tablo halinde önceden oluşturulmuş veri akışını Data Wrangler'a nasıl aktarabileceğinizi, veri kümemize nasıl bağlayabileceğinizi ve sonuçları Amazon S3'e nasıl aktarabileceğinizi gösterdik. Kullanım senaryolarınız zaman serisi verilerini değiştirmenizi veya birden fazla veri kümesini birleştirmenizi gerektiriyorsa, aşağıdaki önceden oluşturulmuş diğer örnek akışları inceleyebilirsiniz. GitHub repo.

Önceden oluşturulmuş bir veri hazırlama iş akışını içe aktardıktan sonra bunu Amazon SageMaker Processing ile entegre edebilirsiniz. Amazon SageMaker Ardışık Düzenleri, ve Amazon SageMaker Özellik Mağazası ML eğitim verilerinin işlenmesi, paylaşılması ve saklanması görevini basitleştirmek. Ayrıca bu örnek veri akışını bir Python betiğine aktarabilir ve özel bir makine öğrenimi veri hazırlama hattı oluşturarak yayın hızınızı artırabilirsiniz.

Sitemize göz atmanızı öneririz GitHub deposu uygulamalı pratik yapmak ve model doğruluğunu iyileştirmenin yeni yollarını bulmak için! SageMaker hakkında daha fazla bilgi edinmek için şu adresi ziyaret edin: Amazon SageMaker Geliştirici Kılavuzu.

Yazarlar Hakkında

yatsı duası San Francisco Körfez Bölgesi'nde yerleşik bir Kıdemli Çözüm Mimarıdır. AWS Enterprise müşterilerinin hedeflerini ve zorluklarını anlayarak büyümelerine yardımcı olur ve esnek ve ölçeklenebilir olduklarından emin olarak uygulamalarını bulutta yerel bir şekilde nasıl tasarlayabilecekleri konusunda onlara rehberlik eder. Makine öğrenimi teknolojileri ve çevresel sürdürülebilirlik konusunda tutkulu.

yatsı duası San Francisco Körfez Bölgesi'nde yerleşik bir Kıdemli Çözüm Mimarıdır. AWS Enterprise müşterilerinin hedeflerini ve zorluklarını anlayarak büyümelerine yardımcı olur ve esnek ve ölçeklenebilir olduklarından emin olarak uygulamalarını bulutta yerel bir şekilde nasıl tasarlayabilecekleri konusunda onlara rehberlik eder. Makine öğrenimi teknolojileri ve çevresel sürdürülebilirlik konusunda tutkulu.

- AI

- yapay zeka

- AI sanat üreteci

- yapay zeka robotu

- Amazon Adaçayı Yapıcı

- Amazon SageMaker Veri Düzenleyicisi

- yapay zeka

- yapay zeka sertifikası

- bankacılıkta yapay zeka

- yapay zeka robotu

- yapay zeka robotları

- yapay zeka yazılımı

- AWS Makine Öğrenimi

- blockchain

- blockchain konferans ai

- zeka

- konuşma yapay zekası

- kripto konferans ai

- dal-e

- derin öğrenme

- google ai

- makine öğrenme

- Platon

- plato yapay zekası

- Plato Veri Zekası

- Plato Oyunu

- PlatoVeri

- plato oyunu

- ölçek ai

- sözdizimi

- zefirnet