Цю публікацію спільно написали Шібангі Саха, спеціаліст із обробки даних, і Грасіела Кравцов, співзасновник і технічний директор Equilibrium Point.

Багато людей відчувають нові симптоми психічного захворювання, такі як стрес, тривога, депресія, вживання психоактивних речовин і посттравматичний стресовий розлад (ПТСР). Відповідно до Фонд сім'ї кайзерів, приблизно половина дорослих (47%) по всій країні повідомили про негативний вплив на психічне здоров’я під час пандемії, що є значним збільшенням порівняно з рівнями до пандемії. Крім того, певні статі та вікові групи є одними з тих, хто найімовірніше повідомляє про стрес і занепокоєння, причому показники набагато вищі, ніж інші. Крім того, кілька конкретних етнічних груп частіше повідомляють про «значний вплив» на своє психічне здоров’я, ніж інші.

Кілька опитувань, у тому числі проведених Центром контролю за захворюваннями (CDC), показали значне збільшення частоти поведінкових симптомів, про які повідомляють люди. Відповідно до одного звіту CDC, який опитував дорослих у США наприкінці червня 2020 року, 31% респондентів повідомили про симптоми тривоги або депресії, 13% повідомили, що почали або збільшили вживання психоактивних речовин, 26% повідомили про симптоми, пов’язані зі стресом, і 11% повідомили про симптоми, пов’язані зі стресом. повідомили про серйозні думки про самогубство протягом останніх 30 днів.

Дані, отримані власноруч, хоч і є критично важливими для діагностики розладів психічного здоров’я, на них може впливати стигматизація щодо психічного здоров’я та лікування психічного здоров’я. Замість того, щоб покладатися виключно на дані, які ми повідомляємо самі, ми можемо оцінити та спрогнозувати психічний стрес, використовуючи дані з медичних записів і даних заяв, щоб спробувати відповісти на фундаментальне запитання: чи можемо ми передбачити, хто, ймовірно, потребуватиме психічної допомоги, перш ніж вона їм знадобиться? Якщо цих осіб вдасться ідентифікувати, програми раннього втручання та ресурси можуть бути розроблені та використані для реагування на будь-які нові чи посилення базових симптомів для пом’якшення наслідків психічних розладів і витрат.

Простіше сказати, ніж зробити для тих, хто мав проблеми з керуванням та обробкою великих обсягів складних, рясніючих даних про претензії! У цій публікації ми розповідаємо, як Точка рівноваги IoT використовуваний Amazon SageMaker Data Wrangler щоб оптимізувати підготовку даних про претензії для нашого випадку використання психічного здоров’я, забезпечуючи при цьому якість даних на кожному етапі процесу.

Огляд рішення

Підготовка даних або розробка функцій — це виснажливий процес, який вимагає від досвідчених спеціалістів із обробки даних та інженерів, які витрачають багато часу й енергії на формулювання рецептів для різноманітних перетворень (кроків), необхідних для приведення даних у правильну форму. Насправді дослідження показують, що підготовка даних для машинного навчання (ML) забирає до 80% часу спеціалістів із обробки даних. Як правило, науковці та інженери використовують різні інфраструктури обробки даних, такі як Pandas, PySpark і SQL, для кодування своїх перетворень і створення завдань розподіленої обробки. За допомогою Data Wrangler ви можете автоматизувати цей процес. Data Wrangler є компонентом Студія Amazon SageMaker який надає наскрізне рішення для імпорту, підготовки, трансформації, представлення та аналізу даних. Ви можете інтегрувати Data Wrangler потік даних у ваші існуючі робочі процеси машинного навчання, щоб спростити й оптимізувати обробку даних і розробку функцій, використовуючи майже без кодування.

У цій публікації ми розповімо про етапи перетворення оригінальних необроблених наборів даних у функції, готові до ML, щоб використовувати їх для створення моделей прогнозування на наступному етапі. По-перше, ми заглибимося в природу різних наборів даних, які використовуються для нашого сценарію використання, і як ми об’єднали ці набори даних за допомогою Data Wrangler. Після об’єднань і консолідації набору даних ми описуємо окремі перетворення, які ми застосували до набору даних, як-от усунення дублікатів, обробка відсутніх значень і спеціальні формули, а потім описуємо, як ми використовували вбудований аналіз швидкої моделі для перевірки поточного стану перетворень. для прогнозів.

Набори даних

Для нашого експерименту ми спершу завантажили дані пацієнтів із нашого клієнта поведінкового здоров’я. Ці дані включають наступне:

- Дані про претензії

- Відвідування невідкладної допомоги зараховується

- Стаціонарне відвідування зараховується

- Ліки, призначені за рецептом, пов’язані з психічним здоров’ям

- Ієрархічне кодування стану (HCC) діагностує підрахунки, пов’язані з психічним здоров’ям

Мета полягала в тому, щоб об’єднати ці окремі набори даних на основі ідентифікатора пацієнта та використати дані для прогнозування діагнозу психічного здоров’я. Ми використали Data Wrangler, щоб створити величезний набір даних із кількох мільйонів рядків даних, який є об’єднанням п’яти окремих наборів даних. Ми також використовували Data Wrangler, щоб виконати кілька перетворень, щоб уможливити обчислення стовпців. У наступних розділах ми описуємо різноманітні перетворення підготовки даних, які ми застосували.

Видалити повторювані стовпці після об’єднання

Amazon SageMaker Data Wrangler забезпечує численні перетворення даних ML для спрощення очищення, перетворення та представлення ваших даних. Коли ви додаєте перетворення, воно додає крок до потоку даних. Кожне додане вами перетворення змінює ваш набір даних і створює новий кадр даних. Усі наступні перетворення застосовуються до отриманого кадру даних. Data Wrangler містить вбудовані перетворення, які можна використовувати для перетворення стовпців без коду. Ви також можете додавати власні перетворення за допомогою PySpark, Pandas і PySpark SQL. Деякі перетворення працюють на місці, тоді як інші створюють новий вихідний стовпець у вашому наборі даних.

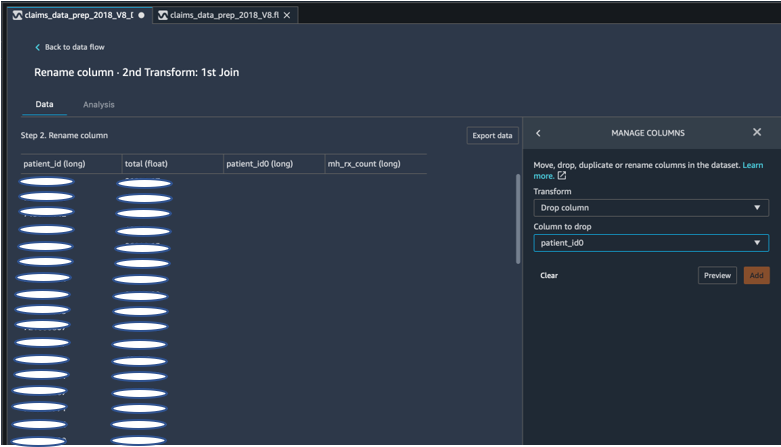

Для наших експериментів, оскільки після кожного об’єднання ідентифікатора пацієнта ми залишали дублікати стовпців ідентифікатора пацієнта. Нам потрібно було скинути ці стовпці. Ми відкинули правий стовпець ідентифікатора пацієнта, як показано на наступному знімку екрана, використовуючи попередньо створений Керування стовпцями ->Колонка скидання transform, щоб підтримувати лише один стовпець ідентифікатора пацієнта (patient_id у остаточному наборі даних).

Зведіть набір даних за допомогою Pandas

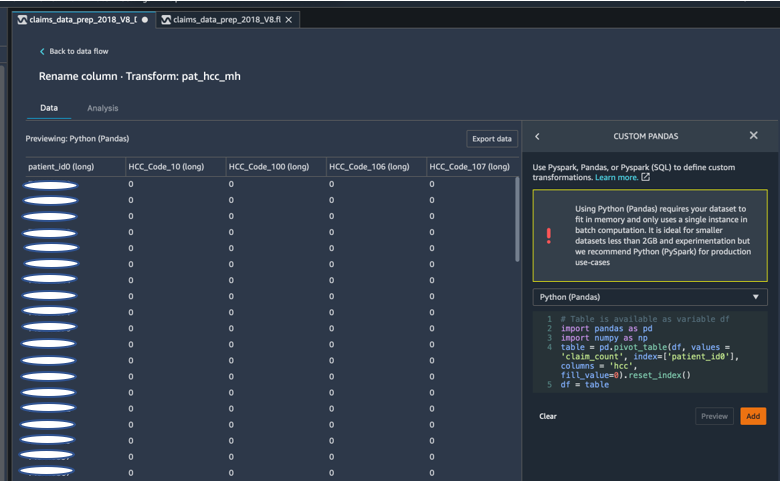

Набори даних претензій були на рівні пацієнта з екстреним візитом (ER), стаціонарним (IP), кількістю рецептів і даними про діагнози, які вже згруповані за відповідними кодами HCC (приблизно 189 кодів). Щоб побудувати ринок даних пацієнтів, ми об’єднуємо коди HCC заявок за пацієнтом і розподіляємо код HCC із рядків у стовпці. Ми використовували Pandas, щоб повернути набір даних, підрахувати кількість кодів HCC для кожного пацієнта, а потім приєднати до основного набору даних за ідентифікатором пацієнта. Ми використали спеціальну опцію перетворення в Data Wrangler, вибравши Python (Pandas) як фреймворк.

У наступному фрагменті коду показано логіку перетворення для зведення таблиці:

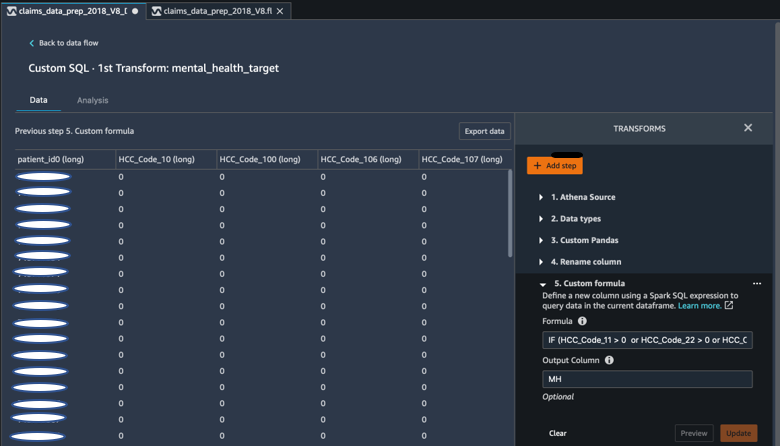

Створіть нові стовпці за допомогою спеціальних формул

Ми вивчили дослідницьку літературу, щоб визначити, які коди HCC є детерміністичними в діагностиці психічного здоров’я. Потім ми написали цю логіку за допомогою перетворення спеціальної формули Data Wrangler, яка використовує вираз SQL Spark для обчислення цільового стовпця «Діагностика психічного здоров’я» (MH), який ми додали в кінець DataFrame.

Ми використали таку логіку перетворення:

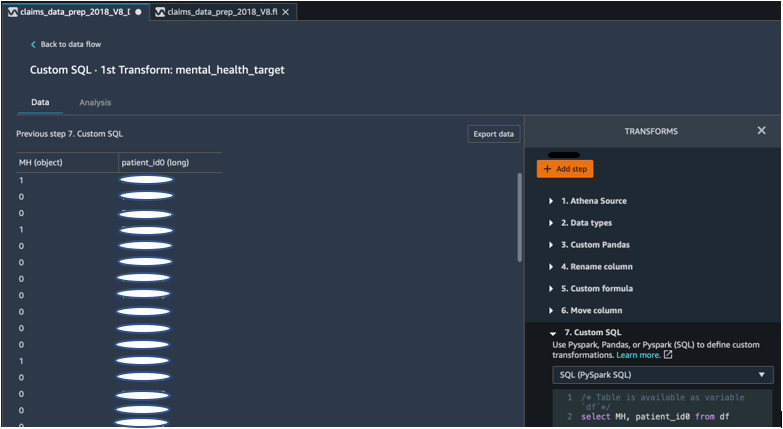

Витягніть стовпці з DataFrame за допомогою PySpark

Після обчислення цільового стовпця (MH) ми видалили всі непотрібні дублікати стовпців. Ми зберегли ідентифікатор пацієнта та стовпець MH для приєднання до нашого основного набору даних. Цьому сприяло спеціальне перетворення SQL, яке використовує PySpark SQL як рамку за нашим вибором.

Ми використовували наступну логіку:

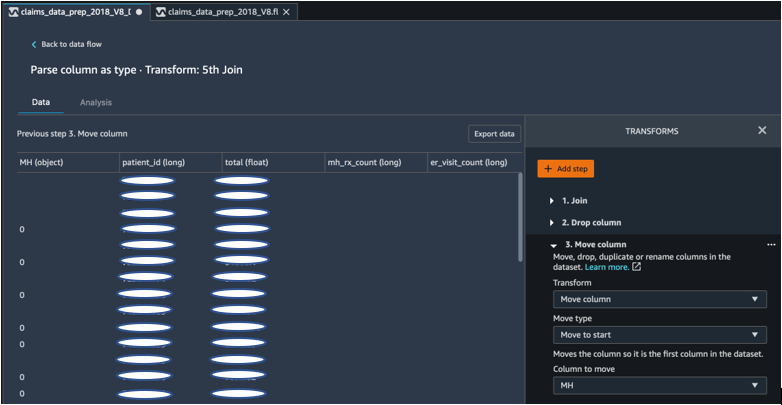

Щоб почати, перемістіть стовпець MH

Наш алгоритм ML вимагає, щоб позначений вхід був у першому стовпці. Тому ми перемістили обчислений стовпець MH на початок DataFrame, щоб бути готовим до експорту.

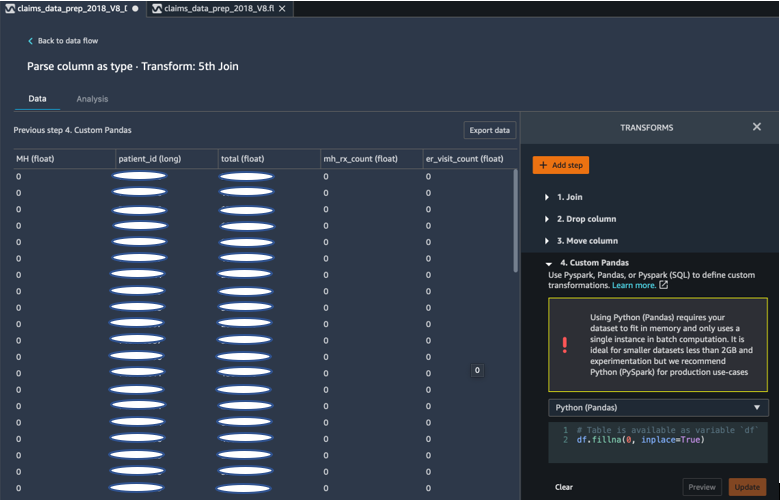

Заповніть порожні поля 0 за допомогою Pandas

Наш алгоритм ML також вимагає, щоб у вхідних даних не було порожніх полів. Тому ми заповнили порожні поля остаточного набору даних нулями. Ми можемо легко зробити це за допомогою спеціального перетворення (Pandas) у Data Wrangler.

Ми використовували наступну логіку:

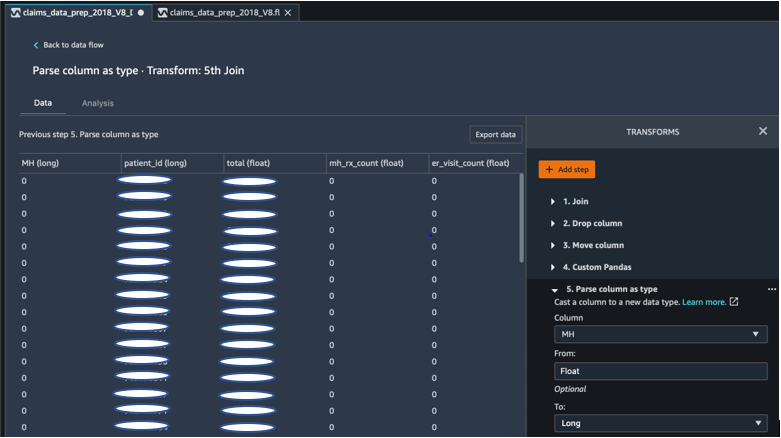

Литий стовпчик від поплавця до довгого

Ви також можете легко проаналізувати та привести стовпець до будь-якого нового типу даних у Data Wrangler. З метою оптимізації пам’яті ми перетворюємо наш вхідний стовпець мітки психічного здоров’я як float.

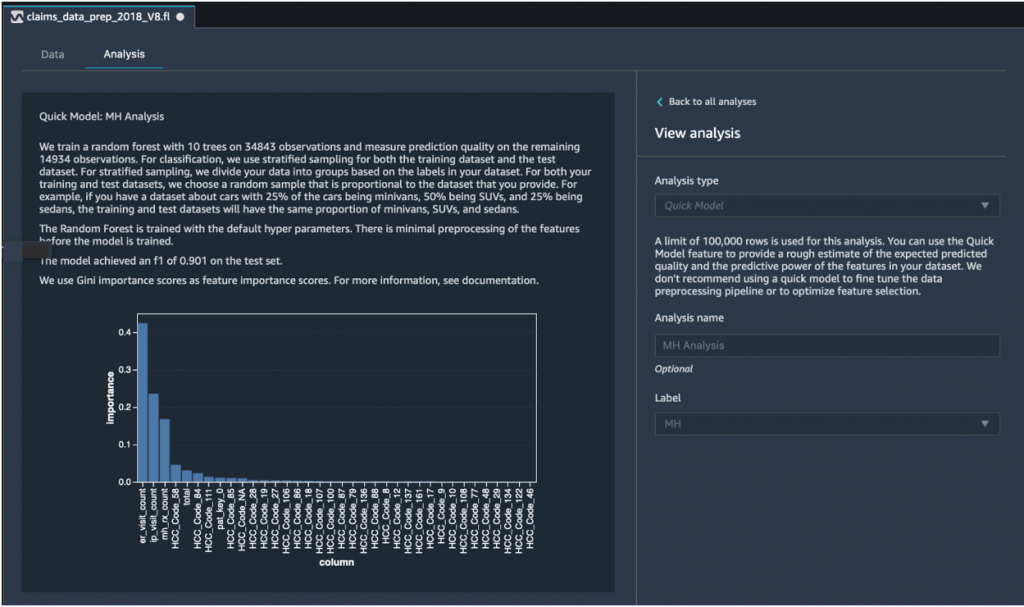

Швидкий аналіз моделі: графік важливості ознак

Після створення остаточного набору даних ми використали тип аналізу швидкої моделі в Data Wrangler, щоб швидко виявити невідповідності даних і визначити, чи була точність нашої моделі в очікуваному діапазоні, чи нам потрібно було продовжити розробку функцій, перш ніж витрачати час на навчання моделі. Модель показала оцінку F1 0.901, де 1 є найвищим. Оцінка F1 — це спосіб поєднання точності та запам’ятовування моделі, і він визначається як середнє гармонійне значення двох. Перевіривши ці початкові позитивні результати, ми були готові експортувати дані та продовжити навчання моделі з використанням експортованого набору даних.

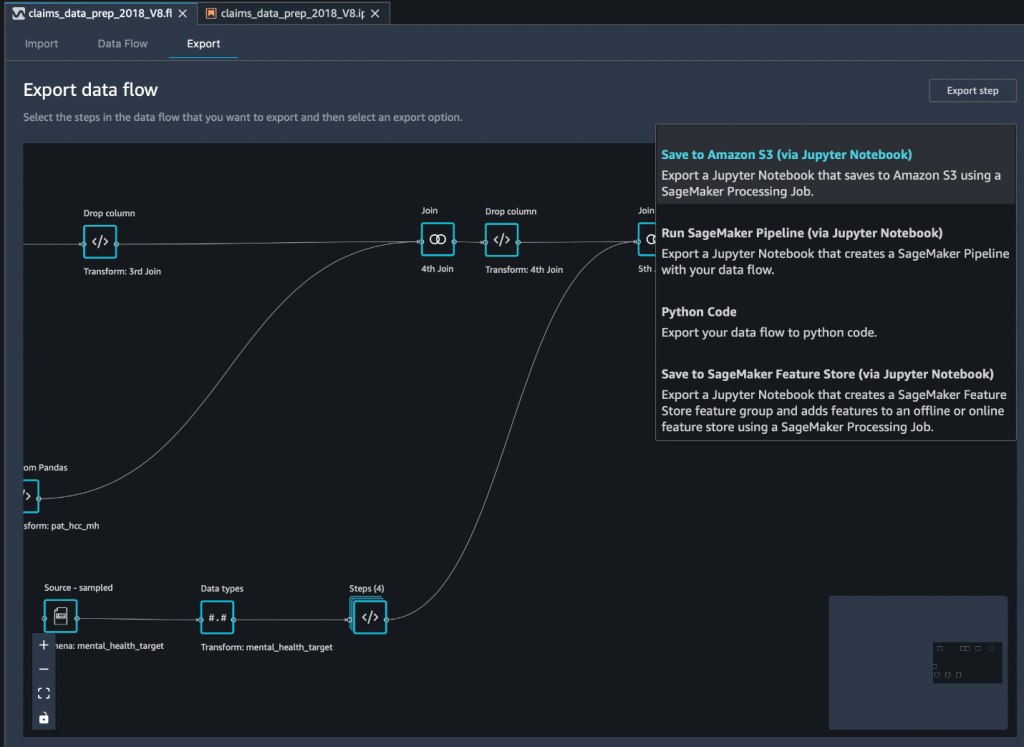

Експортуйте остаточний набір даних в Amazon S3 через блокнот Jupyter

Як останній крок, експортуйте набір даних у його поточній формі (трансформованій). Служба простого зберігання Amazon (Amazon S3) для майбутнього використання під час навчання моделі ми використовуємо Зберегти в Amazon S3 (через Jupyter Notebook) варіант експорту. Цей блокнот запускається як розподілений і масштабований Обробка Amazon SageMaker завдання, яке застосовує створений рецепт (потік даних) до вказаних вхідних даних (зазвичай більших наборів даних) і зберігає результати в Amazon S3. Ви також можете експортувати свої трансформовані стовпці (об’єкти) у Магазин функцій Amazon SageMaker або експортуйте перетворення як конвеєр за допомогою Трубопроводи Amazon SageMakerабо просто експортуйте перетворення як код Python.

Щоб експортувати дані в Amazon S3, у вас є три варіанти:

- Експортуйте перетворені дані безпосередньо в Amazon S3 за допомогою інтерфейсу користувача Data Wrangler

- Експортуйте перетворення як завдання SageMaker Processing через блокнот Jupyter (як ми робимо для цієї публікації).

- Експортуйте перетворення в Amazon S3 через вузол призначення. Вузол призначення повідомляє Data Wrangler, де зберігати дані після їх обробки. Після створення вузла призначення ви створюєте завдання обробки для виведення даних.

Висновок

У цій публікації ми продемонстрували, як Equilibrium Point IoT використовує Data Wrangler для прискорення процесу завантаження великих обсягів наших даних претензій для очищення та трансформації даних під час підготовки до ML. Ми також продемонстрували, як об’єднати розробку функцій із користувальницькими перетвореннями за допомогою Pandas і PySpark у Data Wrangler, що дозволяє експортувати дані крок за кроком (після кожного приєднання) для цілей забезпечення якості. Застосування цих простих у використанні перетворень у Data Wrangler скоротило час, витрачений на наскрізне перетворення даних, майже на 50%. Крім того, функція швидкого аналізу моделі в Data Wrangler дозволила нам легко перевірити стан трансформацій під час циклічного проходження процесу підготовки даних та розробки функцій.

Тепер, коли ми підготували дані для нашого сценарію використання моделювання ризиків для психічного здоров’я, наступним кроком ми плануємо побудувати модель ML за допомогою SageMaker і вбудованих алгоритмів, які він пропонує, використовуючи наш набір даних претензій, щоб визначити учасників, які повинні шукати психіатричне здоров’я. послуги, перш ніж вони дійдуть до точки, де вони їм потрібні. Залишайтеся на зв'язку!

Про авторів

Шибангі Саха є спеціалістом із обробки даних у Equilibrium Point. Вона поєднує свій досвід роботи з даними про вимоги платників у сфері охорони здоров’я та машинним навчанням, щоб розробляти, впроваджувати, автоматизувати та документувати конвеєри даних про здоров’я, звітність і аналітичні процеси, які сприяють аналізу та ефективним покращенням системи надання медичних послуг. Шибангі отримала ступінь магістра наук з біоінформатики в Науковому коледжі Північно-Східного університету та ступінь бакалавра наук з біології та комп’ютерних наук у Коледжі комп’ютерних наук та інформаційних наук Хурі.

Шибангі Саха є спеціалістом із обробки даних у Equilibrium Point. Вона поєднує свій досвід роботи з даними про вимоги платників у сфері охорони здоров’я та машинним навчанням, щоб розробляти, впроваджувати, автоматизувати та документувати конвеєри даних про здоров’я, звітність і аналітичні процеси, які сприяють аналізу та ефективним покращенням системи надання медичних послуг. Шибангі отримала ступінь магістра наук з біоінформатики в Науковому коледжі Північно-Східного університету та ступінь бакалавра наук з біології та комп’ютерних наук у Коледжі комп’ютерних наук та інформаційних наук Хурі.

Граціела Кравцова є співзасновником і технічним директором Equilibrium Point. Грейс обіймала керівні посади C-level/VP у відділах інженерії, операцій та якості, а також була виконавчим консультантом із бізнес-стратегії та розробки продуктів у галузях охорони здоров’я та освіти та промисловому просторі IoT. Грейс отримала ступінь магістра наук у галузі інженера-електромеханіка в Університеті Буенос-Айреса та ступінь магістра наук у галузі комп’ютерних наук у Бостонському університеті.

Граціела Кравцова є співзасновником і технічним директором Equilibrium Point. Грейс обіймала керівні посади C-level/VP у відділах інженерії, операцій та якості, а також була виконавчим консультантом із бізнес-стратегії та розробки продуктів у галузях охорони здоров’я та освіти та промисловому просторі IoT. Грейс отримала ступінь магістра наук у галузі інженера-електромеханіка в Університеті Буенос-Айреса та ступінь магістра наук у галузі комп’ютерних наук у Бостонському університеті.

Арунпрасат Шанкар є архітектором спеціалізованих рішень із штучного інтелекту та машинного навчання (AI / ML) з AWS, допомагаючи світовим клієнтам ефективно та ефективно масштабувати свої рішення в галузі ШІ в хмарі. У вільний час Арун із задоволенням дивиться науково-фантастичні фільми та слухає класичну музику.

Арунпрасат Шанкар є архітектором спеціалізованих рішень із штучного інтелекту та машинного навчання (AI / ML) з AWS, допомагаючи світовим клієнтам ефективно та ефективно масштабувати свої рішення в галузі ШІ в хмарі. У вільний час Арун із задоволенням дивиться науково-фантастичні фільми та слухає класичну музику.

Аджай Шарма є старшим менеджером із продуктів Amazon SageMaker, де він зосереджується на SageMaker Data Wrangler, інструменті візуальної підготовки даних для науковців. До роботи в AWS Аджай працював експертом з обробки даних у компанії McKinsey and Company, де керував проектами, орієнтованими на ML, для провідних фінансових і страхових компаній у всьому світі. Аджай захоплюється наукою про дані та любить досліджувати новітні алгоритми та методи машинного навчання.

Аджай Шарма є старшим менеджером із продуктів Amazon SageMaker, де він зосереджується на SageMaker Data Wrangler, інструменті візуальної підготовки даних для науковців. До роботи в AWS Аджай працював експертом з обробки даних у компанії McKinsey and Company, де керував проектами, орієнтованими на ML, для провідних фінансових і страхових компаній у всьому світі. Аджай захоплюється наукою про дані та любить досліджувати новітні алгоритми та методи машинного навчання.

- Coinsmart. Найкраща в Європі біржа біткойн та криптовалют.

- Платоблокчейн. Web3 Metaverse Intelligence. Розширені знання. БЕЗКОШТОВНИЙ ДОСТУП.

- CryptoHawk. Альткойн Радар. Безкоштовне випробування.

- Джерело: https://aws.amazon.com/blogs/machine-learning/build-a-mental-health-machine-learning-risk-model-using-amazon-sagemaker-data-wrangler/

- "

- 100

- 2020

- МЕНЮ

- За

- через

- AI

- алгоритм

- алгоритми

- ВСІ

- Дозволити

- вже

- Amazon

- серед

- суми

- аналіз

- аналітика

- Занепокоєння

- додаток

- штучний

- штучний інтелект

- Штучний інтелект і машинне навчання

- доступний

- AWS

- буття

- біологія

- border

- Бостон

- будувати

- Створюємо

- вбудований

- бізнес

- претензій

- Очищення

- хмара

- Співзасновник

- код

- Кодування

- коледж

- Колонка

- компанія

- комплекс

- компонент

- Інформатика

- стан

- консолідація

- консультант

- продовжувати

- контроль

- витрати

- створення

- критичний

- CTO

- Поточний

- Поточний стан

- виготовлений на замовлення

- Клієнти

- дані

- обробка даних

- наука про дані

- вчений даних

- доставка

- продемонстрований

- депресія

- дизайн

- розвиненою

- розробка

- Захворювання

- розподілений

- вниз

- управляти

- Падіння

- впав

- Рано

- легко

- Освіта

- ефекти

- енергія

- інженер

- Машинобудування

- Інженери

- забезпечення

- оцінити

- виконавчий

- очікуваний

- досвідчений

- експеримент

- експертиза

- дослідити

- сім'я

- особливість

- риси

- Поля

- фінансування

- Перший

- потік

- фокусується

- після

- форма

- Рамки

- майбутнє

- Глобальний

- мета

- Обробка

- має

- здоров'я

- охорона здоров'я

- допомога

- вище

- Як

- How To

- HTTPS

- ідентифікувати

- хвороба

- здійснювати

- значення

- У тому числі

- Augmenter

- збільшений

- індивідуальний

- промислові

- промисловості

- інформація

- розуміння

- страхування

- інтегрувати

- Інтелект

- КАТО

- IP

- IT

- робота

- Джобс

- приєднатися

- приєднався

- з'єднання

- великий

- більше

- останній

- Керівництво

- провідний

- вивчення

- Led

- рівень

- Прослуховування

- літератури

- трохи

- машина

- навчання за допомогою машини

- підтримувати

- менеджер

- управління

- масивний

- члени

- пам'ять

- Психічне здоров'я

- мільйона

- ML

- модель

- Моделі

- більше

- найбільш

- кіно

- музика

- природа

- ноутбук

- номер

- численний

- Пропозиції

- операції

- оптимізація

- варіант

- Опції

- пандемія

- Стрижень

- точка

- позитивний

- передбачати

- прогноз

- Прогнози

- рецепт

- первинний

- процес

- процеси

- Product

- програми

- забезпечує

- цілей

- якість

- питання

- швидко

- діапазон

- ставки

- Сировина

- облік

- звітом

- дослідження

- ресурси

- результати

- Risk

- Зазначений

- масштабовані

- шкала

- наука

- НАУКИ

- вчений

- Вчені

- Послуги

- Поділитись

- значний

- простий

- рішення

- Рішення

- Простір

- швидкість

- Витрати

- Стажування

- старт

- почалася

- починається

- стан

- залишатися

- зберігання

- зберігати

- Зберігайте дані

- Стратегія

- стрес

- речовина

- істотний

- система

- Мета

- методи

- розповідає

- через

- по всьому

- час

- інструмент

- Навчання

- Перетворення

- Перетворення

- перетворення

- лікування

- типово

- університет

- us

- використання

- зазвичай

- використовувати

- різний

- ВООЗ

- в

- без

- світовий