Сьогодні ми раді повідомити про наявність підтримки Llama 2 для висновків і точного налаштування AWS Trainium та AWS Inferentia екземпляри в Amazon SageMaker JumpStart. Використання екземплярів на основі AWS Trainium і Inferentia через SageMaker може допомогти користувачам знизити витрати на тонке налаштування до 50% і знизити витрати на розгортання в 4.7 раза, одночасно зменшуючи затримку кожного токена. Llama 2 — це авторегресивна модель генеративної текстової мови, яка використовує оптимізовану архітектуру трансформатора. Як загальнодоступна модель, Llama 2 розроблена для багатьох завдань НЛП, таких як класифікація тексту, аналіз настроїв, мовний переклад, мовне моделювання, генерація тексту та діалогові системи. Тонке налаштування та розгортання LLM, як-от Llama 2, може виявитися дорогим або складним для досягнення продуктивності в режимі реального часу для забезпечення якісного обслуговування клієнтів. Trainium і AWS Inferentia, які підтримуються AWS нейрон набір для розробки програмного забезпечення (SDK), пропонує високопродуктивний і економічно вигідний варіант для навчання та виведення моделей Llama 2.

У цьому дописі ми демонструємо, як розгорнути та налаштувати Llama 2 на примірниках Trainium та AWS Inferentia в SageMaker JumpStart.

Огляд рішення

У цьому блозі ми розглянемо такі сценарії:

- Розгорніть Llama 2 на екземплярах AWS Inferentia в обох Студія Amazon SageMaker Інтерфейс користувача з можливістю розгортання в один клік і SageMaker Python SDK.

- Тонко налаштуйте Llama 2 на примірниках Trainium як в інтерфейсі SageMaker Studio, так і в SageMaker Python SDK.

- Порівняйте продуктивність точно налаштованої моделі Llama 2 із попередньо навченою моделлю, щоб продемонструвати ефективність точного налаштування.

Щоб отримати в руки див Приклад блокнота GitHub.

Розгорніть Llama 2 на примірниках AWS Inferentia за допомогою інтерфейсу SageMaker Studio та Python SDK

У цьому розділі ми демонструємо, як розгорнути Llama 2 на примірниках AWS Inferentia за допомогою інтерфейсу користувача SageMaker Studio для розгортання одним клацанням миші та Python SDK.

Відкрийте для себе модель Llama 2 в інтерфейсі SageMaker Studio

SageMaker JumpStart надає доступ як до загальнодоступних, так і до пропрієтарних моделі фундаменту. Основні моделі встановлюються та обслуговуються сторонніми та власними постачальниками. Таким чином, вони випускаються за різними ліцензіями, як зазначено в джерелі моделі. Перегляньте ліцензію на будь-яку базову модель, яку ви використовуєте. Ви несете відповідальність за перегляд і дотримання будь-яких застосовних умов ліцензії та переконайтеся, що вони прийнятні для вашого випадку використання перед завантаженням або використанням вмісту.

Ви можете отримати доступ до моделей основи Llama 2 через SageMaker JumpStart в інтерфейсі користувача SageMaker Studio та SageMaker Python SDK. У цьому розділі ми розглянемо, як знайти моделі в SageMaker Studio.

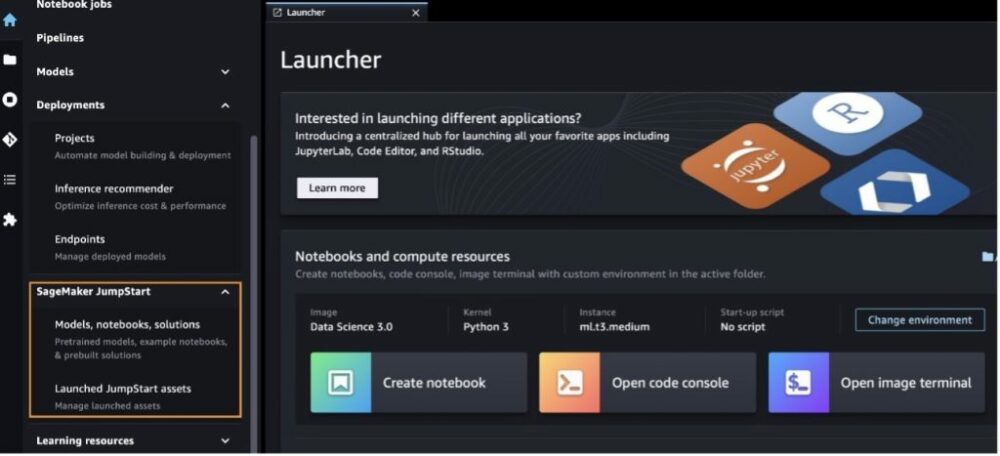

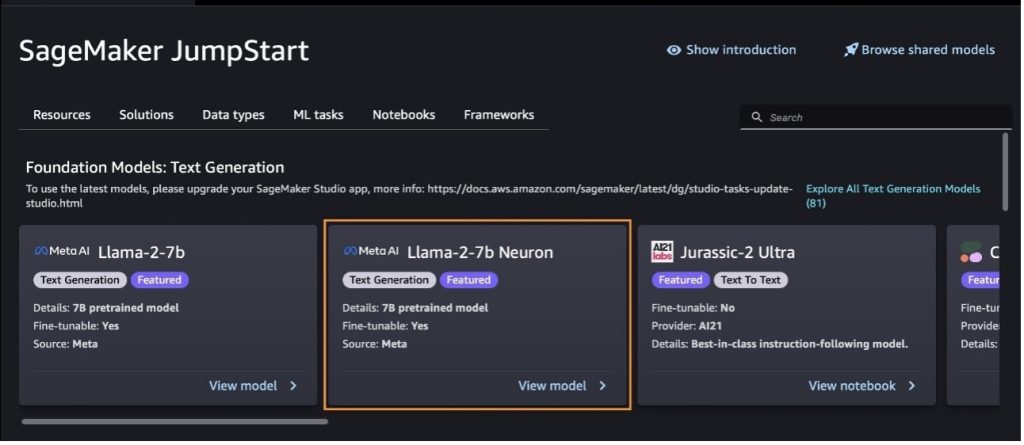

SageMaker Studio — це інтегроване середовище розробки (IDE), яке забезпечує єдиний візуальний веб-інтерфейс, де ви можете отримати доступ до спеціально створених інструментів для виконання всіх етапів розробки машинного навчання (ML), від підготовки даних до створення, навчання та розгортання вашого ML. моделі. Докладніше про те, як розпочати роботу та налаштувати SageMaker Studio, див Студія Amazon SageMaker.

Увійшовши в SageMaker Studio, ви можете отримати доступ до SageMaker JumpStart, який містить попередньо навчені моделі, блокноти та готові рішення, у розділі Готові та автоматизовані рішення. Додаткову інформацію про те, як отримати доступ до запатентованих моделей, див Використовуйте запатентовані моделі основи від Amazon SageMaker JumpStart в Amazon SageMaker Studio.

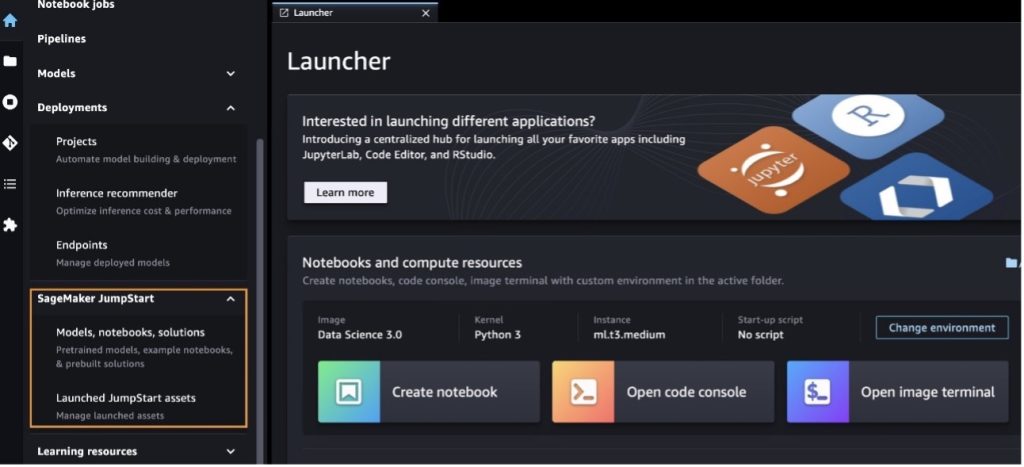

На цільовій сторінці SageMaker JumpStart ви можете переглядати рішення, моделі, блокноти та інші ресурси.

Якщо ви не бачите моделей Llama 2, оновіть версію SageMaker Studio, вимкнувши та перезапустивши програму. Додаткову інформацію про оновлення версій див Вимкніть і оновіть класичні програми Studio.

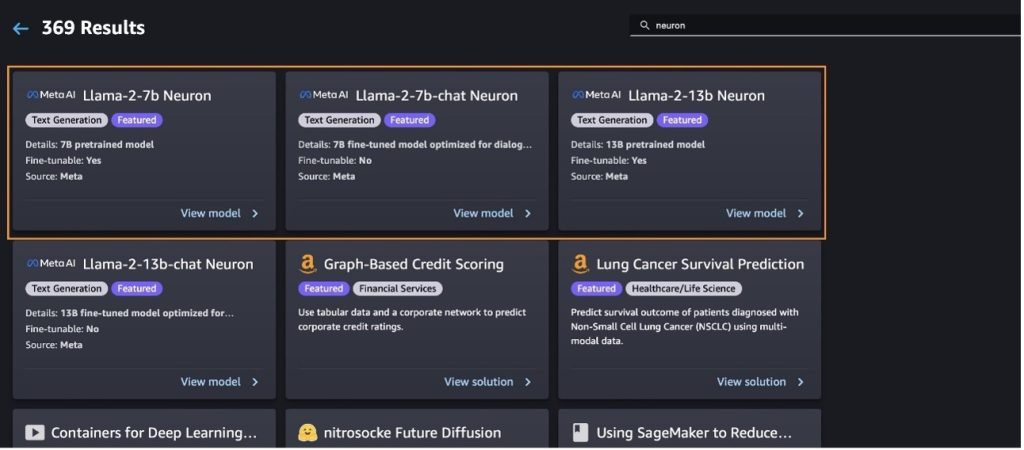

Ви також можете знайти інші варіанти моделі, вибравши Дослідіть усі моделі генерації тексту або шукає llama or neuron у вікні пошуку. На цій сторінці ви зможете переглянути моделі Llama 2 Neuron.

Розгорніть модель Llama-2-13b за допомогою SageMaker Jumpstart

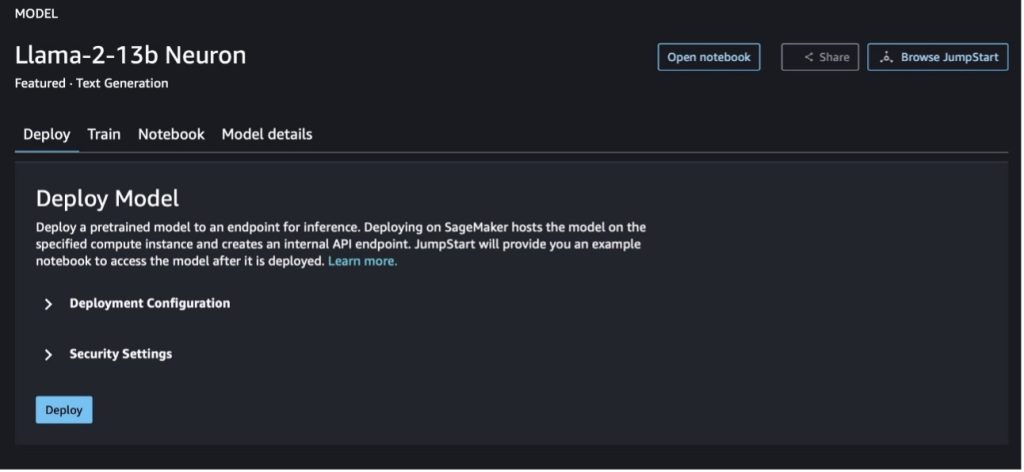

Ви можете вибрати картку моделі, щоб переглянути деталі моделі, як-от ліцензію, дані, які використовуються для навчання, і способи її використання. Ви також можете знайти дві кнопки, Розгортання та Відкрийте блокнот, які допоможуть вам використовувати модель за допомогою цього прикладу без коду.

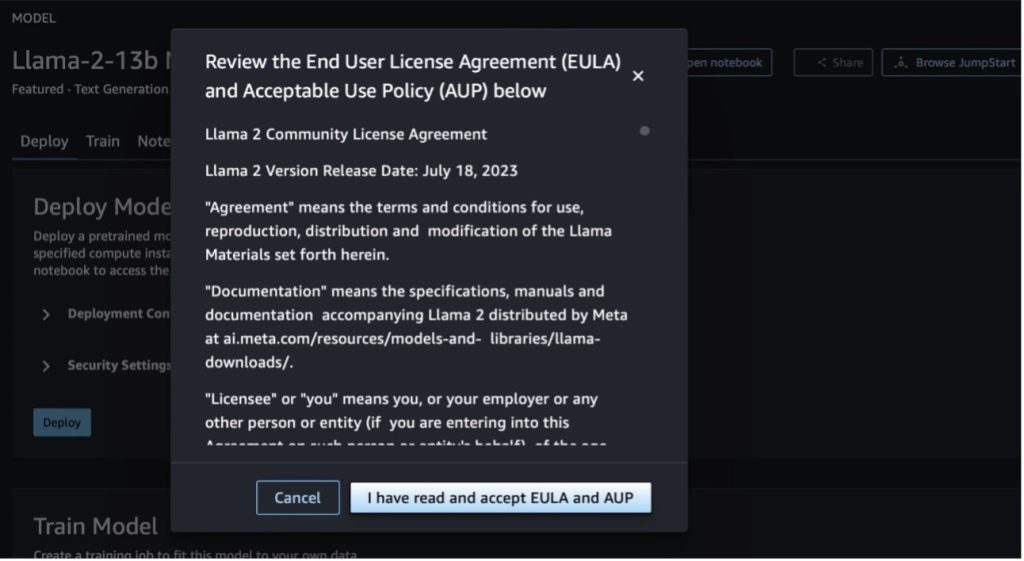

Коли ви натискаєте будь-яку кнопку, у спливаючому вікні відображатиметься Ліцензійна угода кінцевого користувача та Політика прийнятного використання (AUP), які ви повинні підтвердити.

Після того, як ви підтвердите політику, ви можете розгорнути кінцеву точку моделі та використовувати її за допомогою кроків у наступному розділі.

Розгорніть модель Llama 2 Neuron через Python SDK

Коли ви обираєте Розгортання і підтвердити умови, почнеться розгортання моделі. Крім того, ви можете розгорнути через приклад блокнота, вибравши Відкрийте блокнот. Приклад блокнота містить наскрізні вказівки щодо того, як розгорнути модель для висновків і очистити ресурси.

Щоб розгорнути або налаштувати модель на примірниках Trainium або AWS Inferentia, вам спочатку потрібно викликати PyTorch Neuron (torch-neuronx), щоб скомпілювати модель у специфічний для Neuron графік, який оптимізує її для NeuronCores Inferentia. Користувачі можуть вказати компілятору оптимізувати для найменшої затримки або найвищої пропускної здатності, залежно від цілей програми. У JumpStart ми попередньо скомпілювали графіки Neuron для різноманітних конфігурацій, щоб дозволити користувачам виконувати кроки компіляції, забезпечуючи швидше тонке налаштування та розгортання моделей.

Зауважте, що попередньо скомпільований графік Neuron створюється на основі певної версії версії компілятора Neuron.

Існує два способи розгортання LIama 2 на примірниках на основі AWS Inferentia. Перший метод використовує попередньо зібрану конфігурацію та дозволяє розгорнути модель лише за два рядки коду. У другому випадку ви маєте більший контроль над конфігурацією. Почнемо з першого методу, із попередньо створеної конфігурації, і використаємо попередньо навчену модель нейронів Llama 2 13B як приклад. Наступний код показує, як розгорнути Llama 13B лише за допомогою двох рядків:

Щоб виконати висновок на цих моделях, вам потрібно вказати аргумент accept_eula бути True як частина model.deploy() виклик. Встановлення цього аргументу як істинного означає, що ви прочитали та прийняли ліцензійну угоду моделі. Ліцензійну угоду можна знайти в описі картки моделі або в Веб-сайт Мета.

Стандартним типом екземпляра для Llama 2 13B є ml.inf2.8xlarge. Ви також можете спробувати ідентифікатори інших підтримуваних моделей:

meta-textgenerationneuron-llama-2-7bmeta-textgenerationneuron-llama-2-7b-f(модель чату)meta-textgenerationneuron-llama-2-13b-f(модель чату)

Крім того, якщо ви хочете мати більше контролю над конфігураціями розгортання, такими як довжина контексту, ступінь паралельності тензора та максимальний розмір поточної партії, ви можете змінити їх за допомогою змінних середовища, як показано в цьому розділі. Базовим контейнером глибокого навчання (DLC) розгортання є Large Model Inference (LMI) NeuronX DLC. Змінні середовища такі:

- OPTION_N_POSITIONS – Максимальна кількість вхідних і вихідних токенів. Наприклад, якщо ви скомпілюєте модель за допомогою

OPTION_N_POSITIONSяк 512, то ви можете використовувати вхідний маркер 128 (розмір підказки введення) з максимальним вихідним маркером 384 (загальна кількість вхідних і вихідних маркерів має бути 512). Для максимального вихідного токена підійде будь-яке значення нижче 384, але ви не можете вийти за його межі (наприклад, вхід 256 і вихід 512). - OPTION_TENSOR_PARALLEL_DEGREE – Кількість NeuronCores для завантаження моделі в екземпляри AWS Inferentia.

- OPTION_MAX_ROLLING_BATCH_SIZE – Максимальний розмір пакету для одночасних запитів.

- OPTION_DTYPE – Тип дати для завантаження моделі.

Компіляція графа Neuron залежить від довжини контексту (OPTION_N_POSITIONS), ступінь паралельності тензора (OPTION_TENSOR_PARALLEL_DEGREE), максимальний розмір партії (OPTION_MAX_ROLLING_BATCH_SIZE), і тип даних (OPTION_DTYPE), щоб завантажити модель. SageMaker JumpStart має попередньо скомпільовані графіки Neuron для різноманітних конфігурацій для попередніх параметрів, щоб уникнути компіляції під час виконання. Конфігурації попередньо скомпільованих графіків наведено в наступній таблиці. Поки змінні середовища належать до однієї з наступних категорій, компіляція графіків Neuron буде пропущена.

| LIama-2 7B та LIama-2 7B Чат | ||||

| Тип екземпляра | OPTION_N_POSITIONS | OPTION_MAX_ROLLING_BATCH_SIZE | OPTION_TENSOR_PARALLEL_DEGREE | OPTION_DTYPE |

| ml.inf2.xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.8xlarge | 2048 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

| LIama-2 13B та LIama-2 13B Чат | ||||

| ml.inf2.8xlarge | 1024 | 1 | 2 | fp16 |

| ml.inf2.24xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.24xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 2048 | 4 | 4 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 8 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 12 | fp16 |

| ml.inf2.48xlarge | 4096 | 4 | 24 | fp16 |

Нижче наведено приклад розгортання Llama 2 13B і налаштування всіх доступних конфігурацій.

Тепер, коли ми розгорнули модель Llama-2-13b, ми можемо запустити з нею висновки, викликавши кінцеву точку. Наступний фрагмент коду демонструє використання підтримуваних параметрів висновку для керування генерацією тексту:

- максимальна_довжина – Модель генерує текст, доки не досягне вихідної довжини (яка включає довжину вхідного контексту).

max_length. Якщо вказано, воно має бути додатним цілим числом. - max_new_tokens – Модель генерує текст, доки не досягне вихідної довжини (за винятком довжини вхідного контексту).

max_new_tokens. Якщо вказано, воно має бути додатним цілим числом. - кількість_променів – Це вказує на кількість променів, використаних у жадібному пошуку. Якщо вказано, воно має бути цілим числом, більшим або рівним

num_return_sequences. - no_repeat_ngram_size – Модель гарантує, що послідовність слів

no_repeat_ngram_sizeне повторюється у вихідній послідовності. Якщо вказано, воно має бути додатним цілим числом, більшим за 1. - температура – Це контролює випадковість виведення. Більш висока температура призводить до вихідної послідовності зі словами з низькою ймовірністю; нижча температура призводить до вихідної послідовності зі словами з високою ймовірністю. Якщо

temperatureдорівнює 0, це призводить до жадібного декодування. Якщо вказано, це має бути позитивне плаваюче значення. - раннє_стопінг – Якщо

Trueгенерація тексту завершується, коли всі гіпотези променя досягають кінця маркера речення. Якщо вказано, воно має бути логічним. - do_sample – Якщо

True, модель вибирає наступне слово відповідно до ймовірності. Якщо вказано, воно має бути логічним. - top_k – На кожному кроці генерації тексту модель бере вибірку лише з

top_kшвидше за все слова. Якщо вказано, воно має бути додатним цілим числом. - top_p – На кожному кроці генерації тексту модель бере вибірку з найменшого можливого набору слів із сукупною ймовірністю

top_p. Якщо вказано, це має бути число з плаваючою речовиною між 0–1. - СТОП – Якщо вказано, це має бути список рядків. Генерація тексту припиняється, якщо згенеровано будь-який із зазначених рядків.

Наступний код показує приклад:

Вихід:

Для отримання додаткової інформації про параметри корисного навантаження див Детальні параметри.

Ви також можете дослідити реалізацію параметрів у ноутбук щоб додати більше інформації про посилання блокнота.

Точне налаштування моделей Llama 2 на примірниках Trainium за допомогою інтерфейсу користувача SageMaker Studio та SDK SageMaker Python

Основні моделі генеративного штучного інтелекту стали основним фокусом у ML та AI, однак їх широке узагальнення може бути неефективним у певних сферах, як-от охорона здоров’я чи фінансові послуги, де задіяні унікальні набори даних. Це обмеження підкреслює необхідність точного налаштування цих генеративних моделей штучного інтелекту за допомогою даних, що стосуються предметної області, щоб підвищити їх продуктивність у цих спеціалізованих областях.

Тепер, коли ми розгорнули попередньо навчену версію моделі Llama 2, давайте подивимося, як ми можемо налаштувати її на предметно-специфічні дані, щоб підвищити точність, покращити модель з точки зору швидкого завершення та адаптувати модель до ваш конкретний бізнес-випадок використання та дані. Ви можете точно налаштувати моделі за допомогою інтерфейсу SageMaker Studio або SageMaker Python SDK. У цьому розділі ми обговорюємо обидва методи.

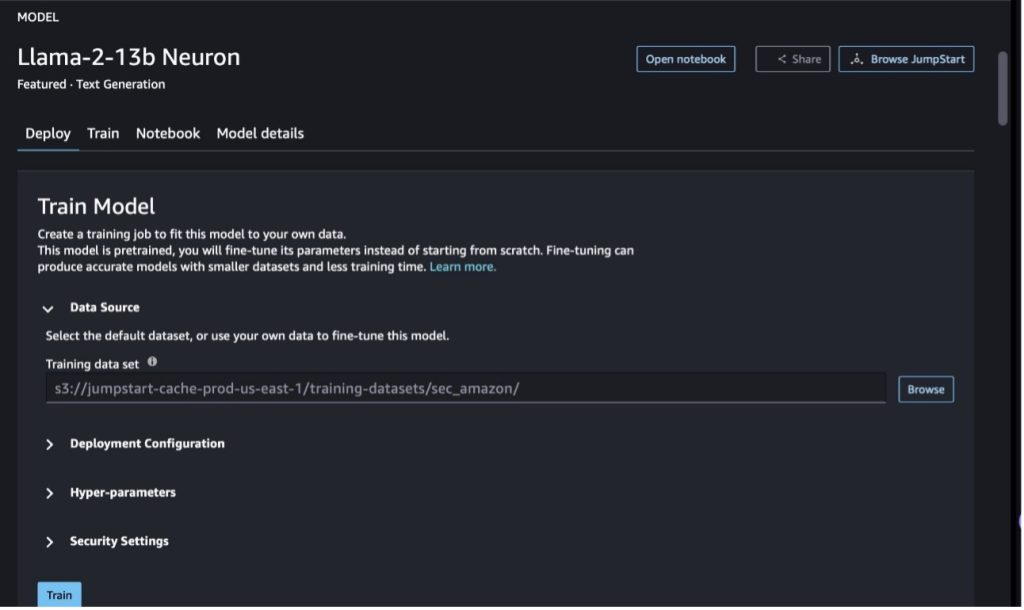

Налаштуйте модель Llama-2-13b Neuron за допомогою SageMaker Studio

У SageMaker Studio перейдіть до моделі Llama-2-13b Neuron. На Розгортання можна вказати на вкладку Служба простого зберігання Amazon (Amazon S3), що містить набори даних навчання та перевірки для точного налаштування. Крім того, ви можете налаштувати конфігурацію розгортання, гіперпараметри та параметри безпеки для точного налаштування. Тоді вибирайте поїзд щоб почати навчальну роботу на екземплярі SageMaker ML.

Щоб використовувати моделі Llama 2, вам потрібно прийняти Ліцензійну угоду (EULA) та ПКУ. Він з’явиться, коли ви виберете поїзд, Вибирати Я прочитав і приймаю EULA та AUP щоб почати роботу з тонкого налаштування.

Ви можете переглянути статус свого навчального завдання для точно налаштованої моделі на консолі SageMaker, вибравши Навчальні роботи у навігаційній панелі.

Ви можете або точніше налаштувати свою модель Llama 2 Neuron, використовуючи цей приклад без коду, або точніше налаштувати за допомогою Python SDK, як показано в наступному розділі.

Точне налаштування моделі Llama-2-13b Neuron за допомогою SDK SageMaker Python

Ви можете точно налаштувати набір даних за допомогою формату адаптації домену або точне налаштування на основі інструкцій формат. Нижче наведено вказівки щодо того, як слід відформатувати навчальні дані перед надсиланням на доопрацювання:

- вхід - A

trainкаталог, що містить файл у форматі рядків JSON (.jsonl) або тексту (.txt).- Для файлу рядків JSON (.jsonl) кожен рядок є окремим об’єктом JSON. Кожен об’єкт JSON має бути структурований як пара ключ-значення, де має бути ключ

text, а значенням є зміст одного навчального прикладу. - Кількість файлів у каталозі train має дорівнювати 1.

- Для файлу рядків JSON (.jsonl) кожен рядок є окремим об’єктом JSON. Кожен об’єкт JSON має бути структурований як пара ключ-значення, де має бути ключ

- Вихід – Навчена модель, яку можна розгорнути для логічного висновку.

У цьому прикладі ми використовуємо підмножину Набір даних Dolly у форматі налаштування інструкцій. Набір даних Dolly містить приблизно 15,000 2.0 записів інструкцій для різних категорій, таких як відповіді на запитання, узагальнення та вилучення інформації. Він доступний за ліцензією Apache XNUMX. Ми використовуємо information_extraction приклади для доопрацювання.

- Завантажте набір даних Dolly і розділіть його на

train(для тонкої настройки) іtest(для оцінки):

- Використовуйте шаблон запиту для попередньої обробки даних у форматі інструкцій для навчального завдання:

- Перегляньте гіперпараметри та перезапишіть їх для власного випадку використання:

- Тонко налаштуйте модель і почніть навчальну роботу SageMaker. Сценарії тонкого налаштування базуються на нейронкс-немо-мегатрон репозиторій, де є модифіковані версії пакетів немо та Вершина які були адаптовані для використання з примірниками Neuron та EC2 Trn1. The нейронкс-немо-мегатрон репозиторій має 3D (дані, тензор і конвеєр) паралелізм, щоб дозволити вам точно налаштувати LLM в масштабі. Підтримувані екземпляри Trainium: ml.trn1.32xlarge та ml.trn1n.32xlarge.

- Нарешті, розгорніть налаштовану модель у кінцевій точці SageMaker:

Порівняйте відповіді між попередньо підготовленими та точно налаштованими моделями Llama 2 Neuron

Тепер, коли ми розгорнули попередньо підготовлену версію моделі Llama-2-13b і налаштували її, ми можемо переглянути деякі порівняння продуктивності швидкого завершення з обох моделей, як показано в наступній таблиці. Ми також пропонуємо приклад точного налаштування Llama 2 на наборі даних SEC у форматі .txt. Докладніше див Приклад блокнота GitHub.

| пункт | Витрати | Основна правда | Відповідь від неналаштованої моделі | Відповідь від налаштованої моделі |

| 1 | Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка відповідним чином доповнює запит.nn### Інструкція:nВиберіть університети, у яких навчався Морет, і рік його закінчення для кожного, і додайте їх до маркованого списку.nn### Вхідні дані:nМоре народився в 1953 році у Веве, Швейцарія. , а потім навчався у Федеральній політехнічній школі Лозанни (EPFL), яку закінчив у 1975 році. Він продовжив навчання в аспірантурі Університету Теннессі, отримавши ступінь доктора філософії. у 1980 році. Потім він приєднався до факультету Університету Нью-Мексико, де залишався до 2006 року, коли він перейшов до EPFL. У грудні 2016 року він пішов у відставку з EPFL.nn У 1996 році Морет заснував ACM Journal of Experimental Algorithmics і залишався головним редактором журналу до 2003 року. У 2001 році Морет заснував Workshop in Algorithms for Bioinformatics (WABI) і залишається в журналі. Керівний комітет конференції.nnУ 2018 році Морет був обраний членом Міжнародного товариства обчислювальної біології за видатний внесок у галузі обчислювальної біології та біоінформатики.nn### Відповідь:n | * École Polytechnique Fédérale de Lausanne (EPFL) (закінчив 1975)n* Університет Теннессі (закінчив 1980) | Море навчався в École Polytechnique Fédérale de Lausanne (EPFL) та Університеті Теннессі, які закінчив у 1975 та 1980 роках відповідно.nn### Підказка:nn- Використовуйте функцію `split`, щоб розділити вхідні дані на список речень.n- Використовуйте функцію `split`, щоб розділити кожне речення на список слів.n- Використовуйте функцію `split`, щоб розділити | – École Polytechnique Fédérale de Lausanne (EPFL), 1975n – Університет Теннессі, 1980n – Університет Нью-Мексико – École Polytechnique Fédérale de Lausanne (EPFL), 2006nn Нижче наведено інструкцію, яка описує завдання в поєднанні з вхідними даними, які забезпечує додатковий контекст. Напишіть відповідь, яка відповідним чином завершує запит.n |

| 2 | Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином завершить запит.nn### Інструкція:nЗ уривка визначте атрибути Діоніса. Відобразити результати у форматі, розділеному комами.nn### Введення:nДіоніс (Διόνυσος, Diónusos)/Вакх (Βάκχος, Bákkhos)nnБог вина, плодючості, вечірок, фестивалів, божевілля, хаосу, пияцтва, рослинності, екстазу та театр. Він є двічі народженим сином Зевса і Семели, оскільки Зевс вихопив його з утроби матері, пришив Діонісу до свого власного стегна і носив його, поки він не був готовий народитися. У мистецтві його зображують або старшим бородатим богом (зокрема до 430 р. до н. е.), або жінкоподібним довговолосим юнаком (особливо після 430 р. до н. е.). Його атрибути включають тирс, чашу для пиття, виноградну лозу та корону з плюща. Він часто перебуває в компанії своїх тіасосів, групи супроводжуючих, включаючи сатирів, менад і свого старого наставника Сілена. Дружиною Діоніса була Аріадна. Колись вважалося, що Діонісій був пізнішим доповненням до грецького пантеону, але знахідка табличок із лінійним літером B підтверджує його статус божества з раннього періоду. Вакх — інша його назва грецькою мовою, яка увійшла в загальне вживання серед римлян. Його священними тваринами є дельфіни, змії, тигри та осли.nn### Response:n | тирс, чаша, виноградна лоза, корона плюща | Діоніс (Διόνυσος, Diónusos)nnБог вина, плідності, вечірок, фестивалів, божевілля, хаосу, пияцтва, рослинності, екстазу та театру. Він є двічі народженим сином Зевса та Семели, оскільки Зевс вирвав його з утроби матері та пришив Діонісу до його власного стегна. | тирс, чаша для пиття, виноградна лоза, корона ivynn Нижче наведено інструкцію, яка описує завдання, у поєднанні з вхідними даними, які надають додатковий контекст. Напишіть відповідь, яка належним чином завершує запит.nn### Інструкція:nЯка різниця між Парфянською імперією Аршакідів?nn### Вхідні дані:nПарфянська імперія, також відома як імперія Арсакідів, була |

| 3 | Нижче наведено інструкцію, яка описує завдання в поєднанні з введенням, що надає додатковий контекст. Напишіть відповідь, яка належним чином завершить запит.nn### Інструкція:nЧому в столиці Узбекистану проживає найбільша грецька громада?nn### Вхідні дані:nГреків в Узбекистані налічується приблизно 9,000. Громада складається з греків з Росії, які були насильно депортовані з цієї країни до Узбекистану в 1940-х роках, і політичних біженців з Греції. Близько 30,000 11,000 греків проживали в країні до Другої світової війни, а ще 40,000 1960 прибули після громадянської війни в Греції та поразки Демократичної армії Греції. Їх кількість скоротилася з максимуму в 19 571 у XNUMX-х роках. Основною причиною є еміграція до Греції після закінчення холодної війни, коли закони дозволили повернутися всім етнічним грекам, які були вигнані з політичних причин після громадянської війни в Греції. Найбільша грецька громада в країні знаходиться в столиці Ташкенті, куди радянська влада переселила більшість грецьких політичних біженців. У стародавні часи південь країни був частиною елліністичного королівства Селевкідів, але кілька грецьких громад там асимілювалися. Найважливішою організацією, що представляє етнічних греків, є Грецька культурна асоціація Ташкента. Діяльність цієї організації включає навчання грецькій мові (XNUMX класів із загальною кількістю XNUMX учнів, класи для дорослих) та навчання грецьким танцям і музиці.nn### Response:n | Більшість грецьких політичних біженців в Узбекистані були переселені радянською владою до столиці країни Ташкента. | n“`nСтолиця Узбекистану містить найбільшу грецьку громаду, оскільки греків в Узбекистані налічується приблизно 9,000 чоловік. Громада складається з греків з Росії, які були насильно депортовані з цієї країни до Узбекистану в 1940-х роках, і політичних біженців з Греції. До Другої світової війни в країні проживало близько 30,000 11,00 греків і ще XNUMX XNUMX | У столиці Узбекистану проживає найбільша грецька громада, оскільки саме туди радянська влада переселила більшість грецьких політичних біженців після депортації з Греції.nn Нижче наведено інструкцію, яка описує завдання в поєднанні з вхідними даними, які забезпечують подальший контекст. Напишіть відповідь, яка відповідним чином завершує запит.nn### Інструкція:nЯка різниця між Парфяною імперією Аршакідів?nn### Вхідні дані:n |

Ми бачимо, що відповіді від точно налаштованої моделі демонструють значне покращення точності, релевантності та ясності порівняно з відповідями від попередньо навченої моделі. У деяких випадках використання попередньо навченої моделі для вашого випадку використання може бути недостатнім, тому її тонке налаштування за допомогою цієї техніки зробить рішення більш персоналізованим для вашого набору даних.

Прибирати

Після того, як ви завершили навчання й більше не бажаєте використовувати наявні ресурси, видаліть ресурси за допомогою такого коду:

Висновок

Розгортання та точне налаштування моделей Llama 2 Neuron на SageMaker демонструє значний прогрес в управлінні й оптимізації великомасштабних генеративних моделей ШІ. Ці моделі, включно з такими варіантами, як Llama-2-7b і Llama-2-13b, використовують Neuron для ефективного навчання та висновків на основі екземплярів на основі AWS Inferentia та Trainium, покращуючи їх продуктивність і масштабованість.

Можливість розгортати ці моделі через UI SageMaker JumpStart і Python SDK забезпечує гнучкість і простоту використання. Neuron SDK із підтримкою популярних фреймворків ML і високопродуктивними можливостями забезпечує ефективну роботу з цими великими моделями.

Точне налаштування цих моделей на предметно-спеціальних даних має вирішальне значення для підвищення їх актуальності та точності в спеціалізованих областях. Процес, який можна виконати за допомогою інтерфейсу SageMaker Studio або Python SDK, дозволяє налаштовувати під конкретні потреби, що призводить до покращення продуктивності моделі з точки зору швидкого завершення та якості відповіді.

Для порівняння, попередньо підготовлені версії цих моделей, хоча й потужні, можуть надавати більш загальні або повторювані відповіді. Тонке налаштування адаптує модель до конкретних контекстів, що призводить до більш точних, релевантних і різноманітних відповідей. Ця настройка особливо очевидна під час порівняння відповідей від попередньо навчених і точно налаштованих моделей, де остання демонструє помітне покращення якості та специфічності результату. Підсумовуючи, розгортання та точне налаштування моделей Neuron Llama 2 на SageMaker представляють надійну структуру для керування розширеними моделями штучного інтелекту, пропонуючи суттєві покращення в продуктивності та застосуванні, особливо якщо адаптовано до конкретних доменів або завдань.

Почніть вже сьогодні, посилаючись на приклад SageMaker ноутбук.

Щоб отримати додаткові відомості про розгортання та тонке налаштування попередньо навчених моделей Llama 2 на примірниках на основі GPU, зверніться до Налаштуйте Llama 2 для створення тексту на Amazon SageMaker JumpStart та Моделі основи Llama 2 від Meta тепер доступні в Amazon SageMaker JumpStart.

Автори висловлюють вдячність за технічний внесок Евану Кравіцу, Крістоферу Віттену, Адаму Коздровічу, Манан Шаху, Джонатану Гінегану та Майку Джеймсу.

Про авторів

Сінь Хуан є старшим прикладним науковим співробітником Amazon SageMaker JumpStart і вбудованих алгоритмів Amazon SageMaker. Він зосереджується на розробці масштабованих алгоритмів машинного навчання. Його дослідницькі інтереси стосуються обробки природної мови, пояснюваного глибокого навчання на табличних даних і надійного аналізу непараметричної просторово-часової кластеризації. Він опублікував багато статей на конференціях ACL, ICDM, KDD і Королівського статистичного товариства: серія A.

Сінь Хуан є старшим прикладним науковим співробітником Amazon SageMaker JumpStart і вбудованих алгоритмів Amazon SageMaker. Він зосереджується на розробці масштабованих алгоритмів машинного навчання. Його дослідницькі інтереси стосуються обробки природної мови, пояснюваного глибокого навчання на табличних даних і надійного аналізу непараметричної просторово-часової кластеризації. Він опублікував багато статей на конференціях ACL, ICDM, KDD і Королівського статистичного товариства: серія A.

Нітін Євсевій є старшим архітектором корпоративних рішень в AWS, має досвід розробки програмного забезпечення, корпоративної архітектури та штучного інтелекту/ML. Він глибоко захоплений дослідженням можливостей генеративного ШІ. Він співпрацює з клієнтами, щоб допомогти їм створювати добре архітектурні додатки на платформі AWS, і присвячує себе вирішенню технологічних проблем і допомозі в їхній хмарній подорожі.

Нітін Євсевій є старшим архітектором корпоративних рішень в AWS, має досвід розробки програмного забезпечення, корпоративної архітектури та штучного інтелекту/ML. Він глибоко захоплений дослідженням можливостей генеративного ШІ. Він співпрацює з клієнтами, щоб допомогти їм створювати добре архітектурні додатки на платформі AWS, і присвячує себе вирішенню технологічних проблем і допомозі в їхній хмарній подорожі.

Мадхур Прашант працює в генеративному просторі ШІ в AWS. Він захоплений перетином людського мислення та генеративного ШІ. Його інтереси полягають у генеративному штучному інтелекті, зокрема створенні рішень, які є корисними та нешкідливими, і, насамперед, оптимальними для клієнтів. Поза роботою він любить займатися йогою, піти в походи, проводити час зі своїм близнюком і грати на гітарі.

Мадхур Прашант працює в генеративному просторі ШІ в AWS. Він захоплений перетином людського мислення та генеративного ШІ. Його інтереси полягають у генеративному штучному інтелекті, зокрема створенні рішень, які є корисними та нешкідливими, і, насамперед, оптимальними для клієнтів. Поза роботою він любить займатися йогою, піти в походи, проводити час зі своїм близнюком і грати на гітарі.

Деван Чоудхурі є інженером із розробки програмного забезпечення Amazon Web Services. Він працює над алгоритмами Amazon SageMaker і пропозиціями JumpStart. Окрім створення інфраструктур ШІ/ML, він також захоплений створенням масштабованих розподілених систем.

Деван Чоудхурі є інженером із розробки програмного забезпечення Amazon Web Services. Він працює над алгоритмами Amazon SageMaker і пропозиціями JumpStart. Окрім створення інфраструктур ШІ/ML, він також захоплений створенням масштабованих розподілених систем.

Хао Чжоу є науковим співробітником Amazon SageMaker. До цього він працював над розробкою методів машинного навчання для виявлення шахрайства для Amazon Fraud Detector. Він захоплений застосуванням машинного навчання, оптимізації та генеративних методів штучного інтелекту до різних проблем реального світу. Він має ступінь доктора філософії з електротехніки в Північно-західному університеті.

Хао Чжоу є науковим співробітником Amazon SageMaker. До цього він працював над розробкою методів машинного навчання для виявлення шахрайства для Amazon Fraud Detector. Він захоплений застосуванням машинного навчання, оптимізації та генеративних методів штучного інтелекту до різних проблем реального світу. Він має ступінь доктора філософії з електротехніки в Північно-західному університеті.

Цин Лан є інженером з розробки програмного забезпечення в AWS. Він працював над декількома складними продуктами в Amazon, включаючи високоефективні рішення ML inference та високоефективну систему журналювання. Команда Ціна успішно запустила першу модель із мільярдами параметрів у Amazon Advertising із дуже малою затримкою. Qing має глибокі знання щодо оптимізації інфраструктури та прискорення глибокого навчання.

Цин Лан є інженером з розробки програмного забезпечення в AWS. Він працював над декількома складними продуктами в Amazon, включаючи високоефективні рішення ML inference та високоефективну систему журналювання. Команда Ціна успішно запустила першу модель із мільярдами параметрів у Amazon Advertising із дуже малою затримкою. Qing має глибокі знання щодо оптимізації інфраструктури та прискорення глибокого навчання.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником із вбудованими алгоритмами Amazon SageMaker і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

Доктор Ашиш Хетан є старшим прикладним науковим співробітником із вбудованими алгоритмами Amazon SageMaker і допомагає розробляти алгоритми машинного навчання. Він отримав ступінь доктора філософії в Іллінойському університеті Урбана-Шампейн. Він активно досліджує машинне навчання та статистичні висновки та опублікував багато статей на конференціях NeurIPS, ICML, ICLR, JMLR, ACL та EMNLP.

Доктор Лі Чжан є головним технічним менеджером із продуктів для Amazon SageMaker JumpStart і вбудованих алгоритмів Amazon SageMaker, сервісу, який допомагає дослідникам даних і практикам машинного навчання розпочати навчання та розгортання своїх моделей, а також використовує навчання з підкріпленням за допомогою Amazon SageMaker. Його минула робота в якості головного наукового співробітника та головного винахідника в IBM Research отримала нагороду IEEE INFOCOM за перевірку часу.

Доктор Лі Чжан є головним технічним менеджером із продуктів для Amazon SageMaker JumpStart і вбудованих алгоритмів Amazon SageMaker, сервісу, який допомагає дослідникам даних і практикам машинного навчання розпочати навчання та розгортання своїх моделей, а також використовує навчання з підкріпленням за допомогою Amazon SageMaker. Його минула робота в якості головного наукового співробітника та головного винахідника в IBM Research отримала нагороду IEEE INFOCOM за перевірку часу.

Кямран Хан, старший менеджер з технічного розвитку бізнесу AWS Inferentina/Trianium в AWS. Він має понад десятирічний досвід, допомагаючи клієнтам розгортати й оптимізувати навчання глибокого навчання та робочі навантаження з висновків за допомогою AWS Inferentia та AWS Trainium.

Кямран Хан, старший менеджер з технічного розвитку бізнесу AWS Inferentina/Trianium в AWS. Він має понад десятирічний досвід, допомагаючи клієнтам розгортати й оптимізувати навчання глибокого навчання та робочі навантаження з висновків за допомогою AWS Inferentia та AWS Trainium.

Джо Сенерчія є старшим менеджером із продуктів в AWS. Він визначає та створює екземпляри Amazon EC2 для глибокого навчання, штучного інтелекту та високопродуктивних обчислювальних навантажень.

Джо Сенерчія є старшим менеджером із продуктів в AWS. Він визначає та створює екземпляри Amazon EC2 для глибокого навчання, штучного інтелекту та високопродуктивних обчислювальних навантажень.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/fine-tune-and-deploy-llama-2-models-cost-effectively-in-amazon-sagemaker-jumpstart-with-aws-inferentia-and-aws-trainium/

- : має

- :є

- : ні

- :де

- $UP

- 000

- 1

- 10

- 100

- 11

- 12

- 121

- 13

- 15%

- 16

- 19

- 1996

- 2001

- 2006

- 2016

- 2018

- 25

- 30

- 36

- 3d

- 40

- 60

- 610

- 7

- 8

- 9

- a

- здатність

- Здатний

- МЕНЮ

- прискорення

- Прийняти

- прийнятний

- прийнятий

- доступ

- точність

- точний

- визнавати

- ACM

- активний

- діяльності

- Адам

- пристосовувати

- адаптація

- додавати

- доповнення

- дорослих

- просунутий

- просування

- реклама

- після

- Угода

- AI

- Моделі AI

- AI / ML

- алгоритми

- ВСІ

- дозволяти

- дозволено

- дозволяє

- Також

- Amazon

- Amazon EC2

- Детектор шахрайства Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- серед

- an

- аналіз

- Древній

- та

- тварини

- Оголосити

- Інший

- будь-який

- більше

- Apache

- крім

- застосовно

- додаток

- застосування

- прикладної

- Застосування

- відповідним чином

- приблизно

- архітектура

- ЕСТЬ

- ПЛОЩА

- області

- аргумент

- армія

- прибулий

- Art

- штучний

- штучний інтелект

- AS

- допомагати

- Асоціація

- At

- Учасники

- Атрибути

- Влада

- authors

- Автоматизований

- наявність

- доступний

- уникнути

- AWS

- AWS Inferentia

- заснований

- BE

- Промінь

- оскільки

- ставати

- було

- перед тим

- буття

- Вірити

- нижче

- між

- За

- найбільший

- біологія

- Блог

- народжений

- обидва

- Box

- широкий

- будувати

- Створюємо

- Будує

- вбудований

- бізнес

- розвиток бізнесу

- але

- button

- by

- call

- прийшов

- CAN

- можливості

- капітал

- карта

- carried

- випадок

- випадків

- категорії

- Категорія

- проблеми

- складні

- зміна

- хаос

- чат

- головний

- вибір

- Вибирати

- Вибираючи

- Крістофер

- Місто

- громадянський

- ясність

- класів

- classic

- класифікація

- очистити

- хмара

- Кластеризація

- код

- холодний

- співпрацює

- комітет

- загальний

- спільноти

- співтовариство

- компанія

- порівняний

- порівняння

- порівняння

- Зроблено

- Завершує

- обчислювальна

- обчислення

- висновок

- одночасно

- Проводити

- конференція

- конференції

- конфігурація

- підтвердити

- Консоль

- містити

- Контейнер

- містить

- зміст

- контекст

- контексти

- внески

- контроль

- управління

- Коштувати

- дорого

- витрати

- країна

- створений

- Корона

- вирішальне значення

- культурний

- Чашка

- клієнт

- Досвід клієнтів

- Клієнти

- настройка

- дані

- набори даних

- Дата

- de

- десятиліття

- Грудень

- Декодування

- присвячених

- глибокий

- глибоке навчання

- глибоко

- дефолт

- Визначає

- Ступінь

- доставляти

- демократичний

- демонструвати

- продемонстрований

- демонструє

- Залежно

- залежить

- розгортання

- розгорнути

- розгортання

- розгортання

- описує

- description

- призначені

- призначений

- докладно

- деталі

- Виявлення

- розвивати

- розвивається

- розробка

- Діалог

- DID

- різниця

- різний

- відкрити

- відкриття

- обговорювати

- дисплей

- розподілений

- розподілені системи

- Різне

- робить

- справи

- домен

- домени

- Не знаю

- вниз

- Завантаження

- кожен

- Рано

- нарахування

- простота

- простота використання

- редактор

- Ефективний

- ефективність

- ефективний

- або

- обраний

- Імперія

- включений

- дозволяє

- дозволяє

- кінець

- кінець в кінець

- Кінцева точка

- інженер

- Машинобудування

- підвищувати

- підвищення

- досить

- гарантує

- підприємство

- Навколишнє середовище

- навколишній

- рівним

- Так само

- особливо

- оцінювати

- оцінка

- еван

- очевидний

- приклад

- Приклади

- збуджений

- виключення

- існуючий

- досвід

- досвідчений

- експериментальний

- дослідити

- Дослідження

- видобуток

- Падати

- false

- швидше

- fellow

- фестивалі

- кілька

- Поля

- філе

- Файли

- Подача

- фінансовий

- фінансові послуги

- знайти

- кінець

- Перший

- Гнучкість

- Поплавок

- Сфокусувати

- фокусується

- після

- слідує

- для

- Примусово

- формат

- знайдений

- фонд

- Заснований

- Рамки

- каркаси

- шахрайство

- виявлення шахрайства

- від

- функція

- далі

- генерується

- генерує

- покоління

- генеративний

- Генеративний ШІ

- отримати

- Go

- бог

- добре

- є

- випускник

- графік

- графіки

- великий

- Greece

- Жадібний

- грецький

- Group

- керівництво

- було

- Обробка

- Руки

- щасливий

- Мати

- he

- охорона здоров'я

- Герой

- допомога

- корисний

- допомогу

- допомагає

- Високий

- висока продуктивність

- вище

- найвищий

- основний момент

- його

- його

- тримає

- Як

- How To

- Однак

- HTML

- HTTP

- HTTPS

- людина

- i

- IBM

- ідентифікувати

- ідентифікатори

- IEEE

- if

- ii

- Іллінойс

- реалізація

- імпорт

- важливо

- удосконалювати

- поліпшений

- поліпшення

- поліпшення

- in

- поглиблений

- включати

- includes

- У тому числі

- Augmenter

- вказує

- інформація

- вилучення інформації

- Інфраструктура

- інфраструктура

- вхід

- витрати

- екземпляр

- інструкції

- інтегрований

- Інтелект

- інтереси

- інтерфейс

- Міжнародне покриття

- перетин

- в

- залучений

- IT

- ЙОГО

- Джеймс

- робота

- Джобс

- приєднався

- Джонатан

- журнал

- подорож

- JPG

- json

- просто

- ключ

- Царство

- Комплект (SDK)

- знання

- відомий

- посадка

- мова

- великий

- масштабний

- Затримка

- пізніше

- запущений

- Законодавство

- провідний

- вивчення

- довжина

- Li

- ліцензія

- ліцензії

- брехня

- життя

- як

- ймовірність

- Ймовірно

- обмеження

- Лінія

- ліній

- LINK

- список

- Перераховані

- Лама

- загрузка

- місцевий

- каротаж

- Довго

- подивитися

- любить

- низький

- знизити

- Опускання

- найнижчий

- машина

- навчання за допомогою машини

- made

- головний

- зробити

- Робить

- менеджер

- управління

- Манан -шах

- багато

- майстер

- максимальний

- Може..

- сенс

- Зустрічатися

- член

- Meta

- метод

- методика

- Мексика

- може бути

- мікрофон

- mind

- ML

- модель

- моделювання

- Моделі

- модифікований

- змінювати

- більше

- найбільш

- переїхав

- музика

- повинен

- ім'я

- Природний

- Обробка природних мов

- Переміщення

- навігація

- Необхідність

- потреби

- Нові

- наступний

- nlp

- ноутбук

- зараз

- номер

- номера

- об'єкт

- цілей

- of

- пропонувати

- пропонує

- Пропозиції

- Пропозиції

- часто

- Старий

- старший

- on

- один раз

- ONE

- тільки

- оптимальний

- оптимізація

- Оптимізувати

- оптимізований

- оптимізуючий

- варіант

- or

- організація

- Інше

- вихід

- поза

- видатний

- над

- власний

- пакети

- сторінка

- пара

- парний

- pane

- Папір

- документи

- Паралельні

- параметри

- частина

- особливо

- Сторони

- проходження

- пристрасний

- Минуле

- для

- Виконувати

- продуктивність

- period

- Персоналізовані

- Вчений ступінь

- трубопровід

- платформа

- plato

- Інформація про дані Платона

- PlatoData

- ігри

- будь ласка

- точка

- Політика

- політика

- політичний

- спливаючий

- популярний

- позитивний

- можливостей

- це можливо

- пошта

- потужний

- попередній

- Точність

- підготовка

- первинний

- Головний

- проблеми

- процес

- обробка

- Product

- менеджер по продукції

- Продукти

- власником

- забезпечувати

- провайдери

- забезпечує

- публічно

- опублікований

- put

- Python

- піторх

- якість

- питання

- випадковість

- досягати

- Досягає

- Читати

- готовий

- реальний

- Реальний світ

- реального часу

- причина

- Причини

- облік

- послатися

- посилання

- біженців

- випущений

- актуальність

- доречний

- Переселився

- залишився

- залишається

- повторний

- повторювані

- замінювати

- Сховище

- представляти

- представляє

- запросити

- запитів

- вимагається

- дослідження

- дослідник

- ресурси

- відповідно

- відповідь

- відповіді

- відповідальний

- в результаті

- результати

- повертати

- огляд

- рецензування

- міцний

- рухомий

- королівський

- прогін

- час виконання

- Росія

- мудрець

- масштабованість

- масштабовані

- шкала

- сценарії

- вчений

- Вчені

- scripts

- Sdk

- Пошук

- Грати короля карти - безкоштовно Nijumi логічна гра гри

- SEC

- Подача SEC

- другий

- розділ

- безпеку

- побачити

- старший

- посланий

- пропозиція

- настрій

- окремий

- Послідовність

- Серія

- Серія A

- обслуговування

- Послуги

- комплект

- установка

- налаштування

- кілька

- Короткий

- Повинен

- Показувати

- показаний

- Шоу

- закриття

- значний

- простий

- з

- один

- Розмір

- уривок

- So

- суспільство

- Софтвер

- розробка програмного забезпечення

- комплект для розробки програмного забезпечення

- розробка програмного забезпечення

- рішення

- Рішення

- Розв’язування

- деякі

- її

- Source

- Південь

- Простір

- спеціалізований

- конкретний

- конкретно

- специфічність

- зазначений

- Витрати

- розкол

- Персонал

- старт

- почалася

- стан

- статистичний

- Статус

- рульове управління

- Крок

- заходи

- Зупиняє

- зберігання

- структурований

- Студентам

- навчався

- Дослідження

- студія

- Успішно

- такі

- підтримка

- Підтриманий

- Переконайтеся

- Швейцарія

- система

- Systems

- таблиця

- з урахуванням

- Завдання

- завдання

- Навчання

- команда

- технічний

- техніка

- методи

- Технологія

- шаблон

- Теннессі

- terms

- тест

- текст

- Класифікація тексту

- ніж

- Що

- Команда

- Площа

- Капітал

- їх

- Їх

- потім

- Там.

- Ці

- вони

- Мислення

- третя сторона

- це

- ті

- через

- пропускна здатність

- тигри

- час

- times

- до

- сьогодні

- знак

- Жетони

- інструменти

- Усього:

- поїзд

- навчений

- Навчання

- трансформатор

- Переклад

- правда

- намагатися

- настройка

- twin

- два

- тип

- ui

- при

- що лежить в основі

- створеного

- університети

- університет

- до

- Оновити

- Updates

- Використання

- використання

- використання випадку

- використовуваний

- користувач

- користувачі

- використовує

- використання

- використовує

- узбекистан

- перевірка достовірності

- значення

- різноманітність

- різний

- рослинність

- версія

- версії

- дуже

- через

- вид

- виноградна лоза

- візуальний

- ходити

- хотіти

- війна

- було

- способи

- we

- Web

- веб-сервіси

- Web-Based

- пішов

- були

- коли

- який

- в той час як

- ВООЗ

- волі

- ВИНО

- з

- Виграв

- слово

- слова

- Work

- працював

- робочий

- працює

- майстерня

- світ

- б

- запис

- рік

- йога

- Ти

- вашу

- молодь

- зефірнет

- Зевс