- Травень 12, 2014

- Василіс Врініотис

- . 4 коментарі

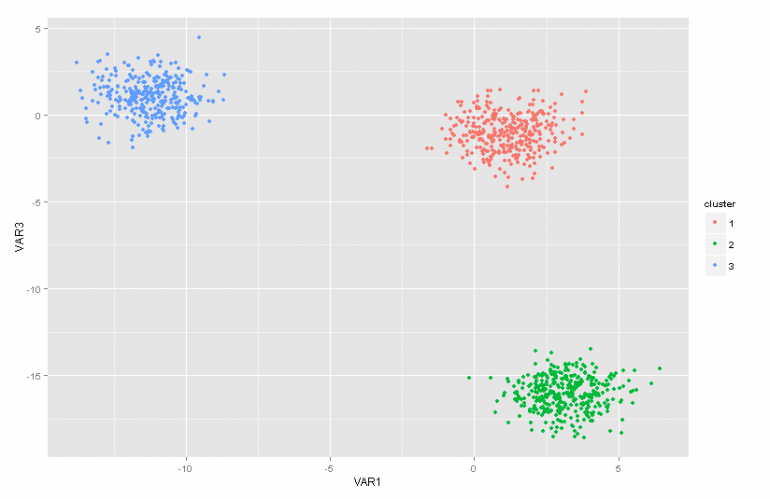

Ця публікація в блозі є другою частиною серії статей про моделі суміші процесу Діріхле. У попередній статті ми мали огляд кількох методів кластерного аналізу і ми обговорили деякі проблеми/обмеження, які виникають при їх використанні. Крім того, ми коротко представили моделі технологічних сумішей Діріхле, поговорили про те, чому вони корисні, і представили деякі їх застосування.

Оновлення: Система машинного навчання Datumbox тепер є відкритою та безкоштовною скачати. Перевірте пакет com.datumbox.framework.machinelearning.clustering, щоб побачити реалізацію моделей суміші процесів Діріхле на Java.

Змішані моделі процесу Діріхле на початку може бути трохи важко сприйняти насамперед тому, що це моделі нескінченної суміші з багатьма різними представленнями. На щастя, хороший спосіб підійти до теми — почати з моделей кінцевої суміші з розподілом Діріхле, а потім перейти до нескінченних.

Отже, у цій статті я коротко представлю деякі важливі розподіли, які нам знадобляться, ми використаємо їх для побудови моделі Діріхле Пріора з мультиноміальною правдоподібністю, а потім перейдемо до моделі кінцевої суміші на основі розподілу Діріхле.

1. Бета-розповсюдження

Команда Бета-розповсюдження це сімейство неперервних розподілів, яке визначено в інтервалі [0,1]. Він параметризований двома позитивними параметрами a і b, і його форма значною мірою залежить від вибору цих двох параметрів.

Рисунок 1: Бета-розподіл для різних параметрів a, b

Бета-розподіл зазвичай використовується для моделювання розподілу ймовірностей і має таку щільність ймовірності:

![]()

Рівняння 1: бета-версія PDF

Де Γ(x) – гамма-функція, а a, b – параметри розподілу. Бета зазвичай використовується як розподіл значень ймовірностей і дає нам імовірність того, що змодельована ймовірність дорівнює певному значенню P = p0. За своїм визначенням бета-розподіл здатний моделювати ймовірність бінарних результатів, які приймають значення true або false. Параметри a і b можна розглядати як псевдорахунки успіху та невдачі відповідно. Таким чином, бета-розподіл моделює ймовірність успіху з урахуванням a успіхів і b невдач.

2. Розподіл Діріхле

Команда Розподіл Діріхле це узагальнення бета-розподілу для кількох результатів (іншими словами, воно використовується для подій із кількома результатами). Він параметризований k параметрами ai яка повинна бути позитивною. Розподіл Діріхле дорівнює бета-розподілу, коли кількість змінних k = 2.

Рисунок 2: Розподіл Діріхле для різних ai параметри

Розподіл Діріхле зазвичай використовується для моделювання розподілу ймовірностей і має таку щільність ймовірності:

![]()

Рівняння 2: Діріхле PDF

Де Γ(x) – гамма-функція, pi приймати значення в [0,1] і Σpi=1. Розподіл Діріхле моделює спільний розподіл pi і дає ймовірність P1=p1,P2=p2,….,PK-1=pK-1 з Пk=1 – ΣPi. Як і у випадку з Beta, ai параметри можна розглядати як псевдорахунки появи кожної події i. Розподіл Діріхле використовується для моделювання ймовірності виникнення k суперницьких подій і часто позначається як Діріхле(a).

3. Пріор Діріхле з мультиноміальною правдоподібністю

Як згадувалося раніше, розподіл Діріхле можна розглядати як розподіл над розподілами ймовірностей. У випадках, коли ми хочемо змоделювати ймовірність виникнення k подій, слід використовувати байєсівський підхід Мультиноміальна правдоподібність і пріоритети Діріхле .

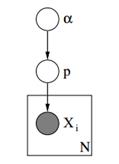

Нижче ми можемо побачити графічну модель такої моделі.

Малюнок 3: Графічна модель пріоритетів Діріхле з мультиноміальною правдоподібністю

У наведеній вище графічній моделі α є ak-вимірним вектором із гіперпараметрами Діріхле, p є ak-вимірним вектором зі значеннями ймовірності та xi це скалярне значення від 1 до k, яке повідомляє нам, яка подія сталася. Насамкінець слід зазначити, що P відповідає розподілу Діріхле, параметризованому вектором α, і, таким чином, P ~ Діріхле(α), тоді як xi змінні відповідають дискретному розподілу (мультиноміальному), параметризованому вектором ймовірностей p. Подібні ієрархічні моделі можна використовувати в класифікації документів для представлення розподілу частот ключових слів у різних темах.

4. Модель кінцевої суміші з розподілом Діріхле

Використовуючи розподіл Діріхле, ми можемо побудувати a Модель кінцевої суміші які можна використовувати для виконання кластеризації. Припустимо, що ми маємо таку модель:

![]()

![]()

![]()

![]()

Рівняння 3: Модель кінцевої суміші з розподілом Діріхле

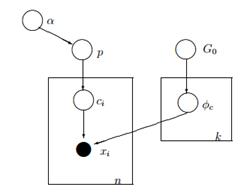

Наведена вище модель передбачає наступне: у нас є набір даних X із n спостережень, і ми хочемо виконати кластерний аналіз на ньому. K — постійне кінцеве число, яке показує кількість кластерів/компонентів, які ми будемо використовувати. ci змінні зберігають кластерне призначення спостереження Xi, вони приймають значення від 1 до k і відповідають дискретному розподілу з параметром p, який є ймовірністю суміші компонентів. F — це генеративний розподіл нашого X, який параметризовано за допомогою параметра ![]() що залежить від кластерного призначення кожного спостереження. Всього маємо k унікальних

що залежить від кластерного призначення кожного спостереження. Всього маємо k унікальних ![]() параметри, що дорівнюють кількості наших кластерів. The

параметри, що дорівнюють кількості наших кластерів. The ![]() змінна зберігає параметри, які параметризують генеративний F-розподіл, і ми припускаємо, що він слідує базі G0 розподіл. Змінна p зберігає відсотки суміші для кожного з k кластерів і відповідає Діріхле з параметрами α/k. Нарешті, α is ak розмірний вектор з гіперпараметрами (псевдовідліками) розподілу Діріхле [2].

змінна зберігає параметри, які параметризують генеративний F-розподіл, і ми припускаємо, що він слідує базі G0 розподіл. Змінна p зберігає відсотки суміші для кожного з k кластерів і відповідає Діріхле з параметрами α/k. Нарешті, α is ak розмірний вектор з гіперпараметрами (псевдовідліками) розподілу Діріхле [2].

Рисунок 4: Графічна модель моделі кінцевої суміші з розподілом Діріхле

Більш простим і менш математичним способом пояснення моделі є наступний. Ми припускаємо, що наші дані можна згрупувати в k кластерів. Кожен кластер має свої параметри ![]() і ці параметри використовуються для створення наших даних. Параметри

і ці параметри використовуються для створення наших даних. Параметри ![]() припускається, що вони дотримуються деякого розподілу G0. Кожне спостереження представлено вектором xi і aci значення, яке вказує на кластер, до якого він належить. Отже, ci можна розглядати як змінну, яка слідує дискретному розподілу з параметром p, який є нічим іншим, як ймовірністю суміші, тобто ймовірністю появи кожного кластера. Враховуючи те, що ми вирішуємо нашу проблему байєсівським способом, ми не розглядаємо параметр p як постійний невідомий вектор. Натомість ми припускаємо, що P слід за Діріхле, який параметризований гіперпараметрами α/k.

припускається, що вони дотримуються деякого розподілу G0. Кожне спостереження представлено вектором xi і aci значення, яке вказує на кластер, до якого він належить. Отже, ci можна розглядати як змінну, яка слідує дискретному розподілу з параметром p, який є нічим іншим, як ймовірністю суміші, тобто ймовірністю появи кожного кластера. Враховуючи те, що ми вирішуємо нашу проблему байєсівським способом, ми не розглядаємо параметр p як постійний невідомий вектор. Натомість ми припускаємо, що P слід за Діріхле, який параметризований гіперпараметрами α/k.

5. Робота з нескінченними k кластерами

Попередня змішана модель дозволяє нам виконувати навчання без контролю, дотримується байєсівського підходу та може бути розширена, щоб мати ієрархічну структуру. Тим не менш, це кінцева модель, оскільки вона використовує постійну попередньо визначену k кількість кластерів. У результаті це вимагає від нас визначення кількості компонентів перед виконанням кластерного аналізу, і, як ми обговорювали раніше, у більшості програм це невідомо та не може бути легко оцінено.

Один із способів вирішити це — уявити, що k має дуже велике значення, яке прагне до нескінченності. Іншими словами, ми можемо уявити межу цієї моделі, коли k прагне до нескінченності. Якщо це так, то ми бачимо, що незважаючи на те, що кількість кластерів k нескінченна, фактична кількість активних кластерів (тих, які мають принаймні одне спостереження), не може бути більшою за n (що є загальна кількість спостережень у нашому наборі даних). Насправді, як ми побачимо пізніше, кількість активних кластерів буде значно меншою за n, і вони будуть пропорційні ![]() .

.

Звичайно, обмеження k до нескінченності є нетривіальним. Виникає кілька питань, наприклад, чи можна прийняти такий ліміт, як буде виглядати ця модель і як ми можемо побудувати і використовувати таку модель.

У наступній статті ми зосередимося саме на цих питаннях: ми дамо визначення процесу Діріхле, ми представимо різні представлення DP і, нарешті, ми зосередимося на процесі китайського ресторану, який є інтуїтивно зрозумілим та ефективним способом побудови процесу Діріхле.

Сподіваюся, ця публікація була для вас корисною. Якщо так, знайдіть час, щоб поділитися статтею у Facebook і Twitter. 🙂

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- штучний інтелект

- сертифікація штучного інтелекту

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- Датабокс

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- Машинне навчання та статистика

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- зефірнет