Відео Відповідно до останнього дослідження веб-гіганта, найбільша модель мови ШІ Google допомагає роботам бути більш гнучкими в розумінні та інтерпретації команд людини.

Машини, як правило, найкраще реагують на дуже конкретні вимоги – відкриті запити іноді можуть збити їх із ладу та призвести до результатів, про які користувачі не мали на увазі. Люди вчаться взаємодіяти з роботами жорстким способом, наприклад, ставити запитання певним чином, щоб отримати бажану відповідь.

Однак остання система Google, яка отримала назву PaLM-SayCan, обіцяє бути розумнішою. Фізичний пристрій від Everyday Robots – стартапу, створеного з Google X – має камери для очей у голові та руку з кліщами, заправленими за довгий прямий корпус, який розташований на вершині набору коліс.

Ви можете побачити робота в дії на відео нижче:

Запитати робота щось на кшталт «Я щойно потренувався, ти можеш принести мені здорову закуску?» підштовхне його принести яблуко. «PaLM-SayCan [є] інтерпретованим і загальним підходом до використання знань із мовних моделей, який дозволяє роботу слідувати текстовим інструкціям високого рівня для виконання фізично обґрунтованих завдань», — дослідники з команди Google Brain пояснені.

Google представив свою найбільшу мовну модель PaLM у квітні цього року. PaLM навчався на даних, зібраних з Інтернету, але замість того, щоб викидати відкриті текстові відповіді, система була адаптована для створення списку інструкцій, яким повинен слідувати робот.

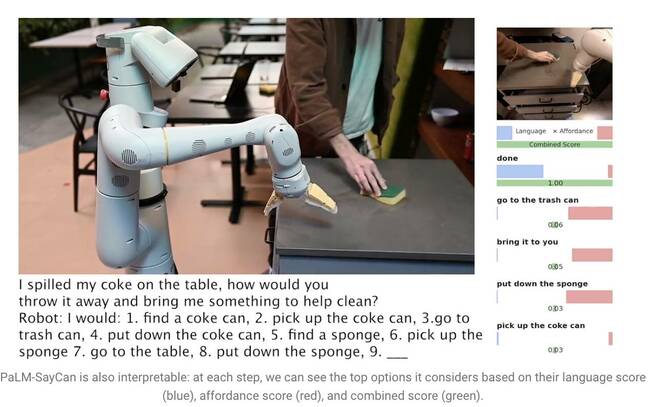

Сказавши «Я пролив свою колу на стіл, як би ти її викинув і приніс мені щось для очищення?», спонукає PaLM зрозуміти запитання та створити список кроків, які робот може виконати, щоб виконати завдання, наприклад перейти підібрати банку, викинувши її у відро для сміття та дістати губку.

Однак великі мовні моделі (LLM), такі як PaLM, не розуміють значення нічого, що вони говорять. З цієї причини дослідники навчили окрему модель, використовуючи навчання з підкріпленням, щоб перетворити абстрактну мову на візуальні уявлення та дії. Таким чином робот навчиться асоціювати слово «Cola» із зображенням банки з газованим напоєм.

PaLM-SayCan також вивчає так звані «функції дозволу» – метод, який ранжує можливість виконання певної дії з урахуванням об’єктів у його оточенні. Робот з більшою ймовірністю візьме губку, ніж пилосос, наприклад, якщо він виявить губку, але немає пилососа біля неї.

«Наш метод, SayCan, витягує та використовує знання LLM у фізично обґрунтованих завданнях», — пояснила команда в дипломну роботу. «LLM (Say) забезпечує обґрунтування завдань для визначення корисних дій для досягнення мети високого рівня, а вивчені функції дозволу (Can) забезпечують світове обґрунтування для визначення того, що можна виконати за планом. Ми використовуємо навчання з підкріпленням (RL) як спосіб вивчення мовних обумовлених функцій цінностей, які забезпечують можливості того, що можливо у світі».

Щоб робот не відхилявся від виконання завдання, він навчений вибирати дії лише зі 101 різної інструкції. Google навчив його адаптуватися до кухні – PaLM-SayCan може отримувати закуски, напої та виконувати прості завдання з прибирання. Дослідники вважають, що LLM є першим кроком у тому, щоб змусити роботів безпечно виконувати більш складні завдання, одержуючи абстрактні інструкції.

«Наші експерименти з низкою реальних робототехнічних завдань демонструють здатність планувати та виконувати довгострокові, абстрактні інструкції природною мовою з високим рівнем успіху. Ми віримо, що інтерпретація PaLM-SayCan дозволяє безпечно взаємодіяти користувача з роботами в реальному світі», – підсумували вони. ®

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- Реєстр

- зефірнет