У динамічному світі потокового передавання Amazon Music, кожен пошук пісні, подкасту чи списку відтворення містить історію, настрій чи потік емоцій, які чекають на розкриття. Ці пошуки служать шлюзом до нових відкриттів, цінного досвіду та довговічних спогадів. Панель пошуку призначена не лише для пошуку пісні; це про мільйони активних користувачів, які починають свою особисту подорож у багатий і різноманітний світ, який пропонує Amazon Music.

Забезпечення чудового досвіду для клієнтів, щоб миттєво знаходити музику, яку користувачі шукають, вимагає платформи, яка є розумною та чуйною. Для цього Amazon Music використовує потужність ШІ. Однак оптимізувати взаємодію з клієнтами, одночасно керуючи вартістю навчання та виведення моделей штучного інтелекту, які забезпечують можливості панелі пошуку, наприклад перевірку орфографії в реальному часі та векторний пошук, важко під час пікового трафіку.

Amazon SageMaker надає повний набір послуг, які дозволяють Amazon Music створювати, навчати та розгортати в хмарі AWS з мінімальними зусиллями. Дбаючи про недиференційовану важку роботу, SageMaker дозволяє вам зосередитися на роботі над моделями машинного навчання (ML) і не турбуватися про такі речі, як інфраструктура. Як частина моделі спільної відповідальності, SageMaker гарантує, що надані послуги є надійними, ефективними та масштабованими, а ви переконаєтеся, що застосування моделей ML найкращим чином використовує можливості, які надає SageMaker.

У цій публікації ми розповідаємо про те, як Amazon Music оптимізувала продуктивність і вартість за допомогою SageMaker і NVIDIA Triton Inference Server і TensorRT. Ми глибоко занурюємось у те, щоб показати, як працює цей, здавалося б, простий, але складний пошуковий рядок, забезпечуючи безперервну подорож у всесвіт Amazon Music із мінімальними неприємними затримками та релевантними результатами пошуку в реальному часі.

Amazon SageMaker і NVIDIA: швидкий і точний векторний пошук і перевірка орфографії

Amazon Music пропонує величезну бібліотеку з понад 100 мільйонів пісень і мільйонів епізодів подкастів. Однак знайти потрібну пісню чи подкаст може бути складно, особливо якщо ви не знаєте точної назви, виконавця чи назви альбому, або пошуковий запит є дуже широким, наприклад «подкасти новин».

Amazon Music застосував двосторонній підхід до покращення процесу пошуку та пошуку. Першим кроком є запровадження векторного пошуку (також відомого як пошук на основі вбудовування), техніки ML, яка може допомогти користувачам знайти найбільш відповідний вміст, який вони шукають, використовуючи семантику вмісту. Другий крок передбачає впровадження моделі виправлення орфографії на основі Transformer у стек пошуку. Це може бути особливо корисним під час пошуку музики, оскільки користувачі не завжди можуть знати точне написання назви пісні чи імені виконавця. Виправлення орфографії може допомогти користувачам знайти музику, яку вони шукають, навіть якщо вони зробили орфографічну помилку у своєму пошуковому запиті.

Введення моделей трансформатора в конвеєр пошуку та отримання (у генерації вбудованих запитів, необхідних для векторного пошуку, і генеративної моделі трансформатора Seq2Seq у системі виправлення орфографії) може призвести до значного збільшення загальної затримки, що негативно вплине на взаємодію з клієнтами. Тому для нас стало першочерговим завданням оптимізувати затримку логічного висновку в реальному часі для моделей векторного пошуку та корекції орфографії.

Amazon Music і NVIDIA об’єдналися, щоб забезпечити найкращу взаємодію з клієнтами на панелі пошуку, використовуючи SageMaker для реалізації як швидкої, так і точної перевірки орфографії та пропозицій семантичного пошуку в реальному часі за допомогою методів векторного пошуку. Рішення передбачає використання хостингу SageMaker на базі G5, який використовує графічні процесори NVIDIA A10G Tensor Core, підтримуваний SageMaker контейнер NVIDIA Triton Inference Server Container і NVIDIA TensorRT формат моделі. Зменшивши затримку висновку моделі перевірки орфографії до 25 мілісекунд під час пікового трафіку, а також зменшивши затримку створення вбудованих пошукових запитів у середньому на 63% і вартість на 73% порівняно з висновком на основі ЦП, Amazon Music підвищив продуктивність панелі пошуку.

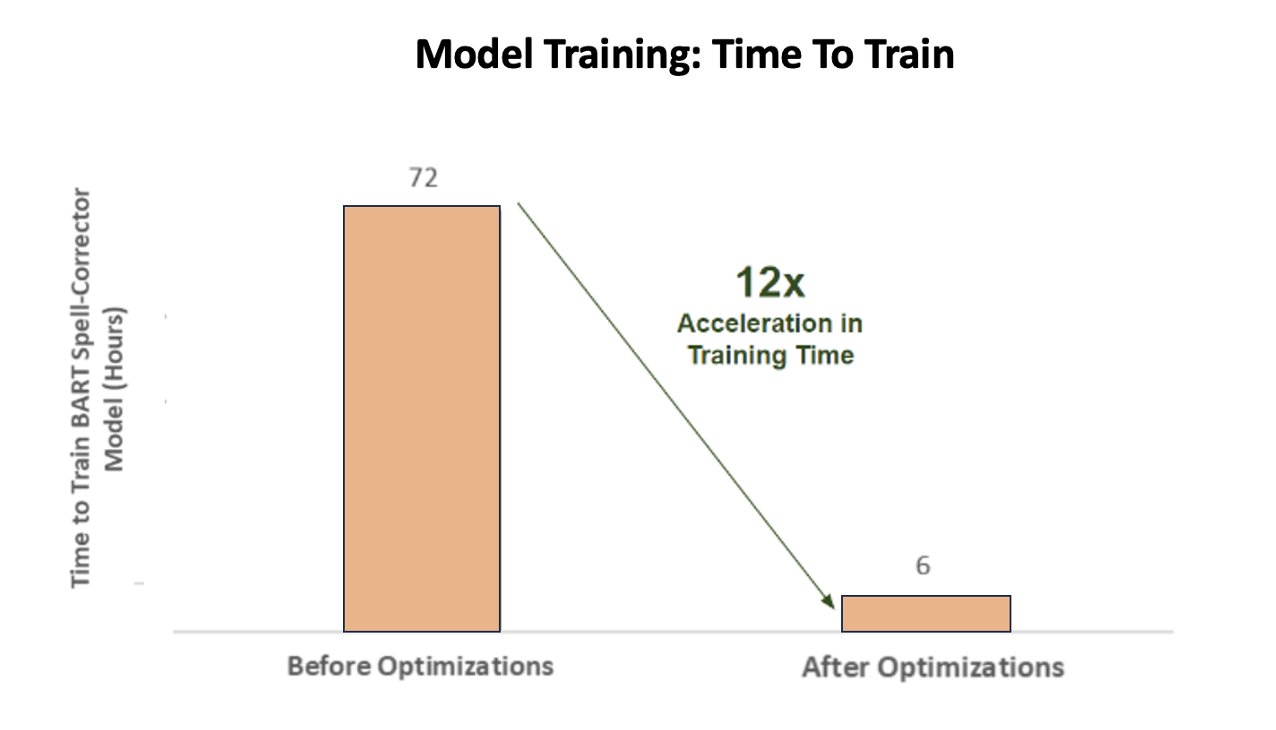

Крім того, під час навчання моделі штучного інтелекту для отримання точних результатів Amazon Music досягла приголомшливого 12-кратного прискорення часу навчання для своєї моделі трансформатора корекції заклинань BART послідовності до послідовності, заощадивши час і гроші завдяки оптимізації використання графічного процесора.

Amazon Music співпрацює з NVIDIA, щоб надати пріоритет клієнтському пошуку та створити рядок пошуку з добре оптимізованою перевіркою орфографії та векторним пошуком. У наступних розділах ми розповімо більше про те, як ці оптимізації були організовані.

Оптимізація навчання за допомогою графічних процесорів NVIDIA Tensor Core

Отримання доступу до графічного процесора NVIDIA Tensor Core для навчання великої мовної моделі недостатньо, щоб відобразити його справжній потенціал. Існують ключові кроки оптимізації, які мають відбуватися під час навчання, щоб повністю максимізувати використання GPU. Однак недостатнє використання графічного процесора, безсумнівно, призведе до неефективного використання ресурсів, тривалості навчання та збільшення операційних витрат.

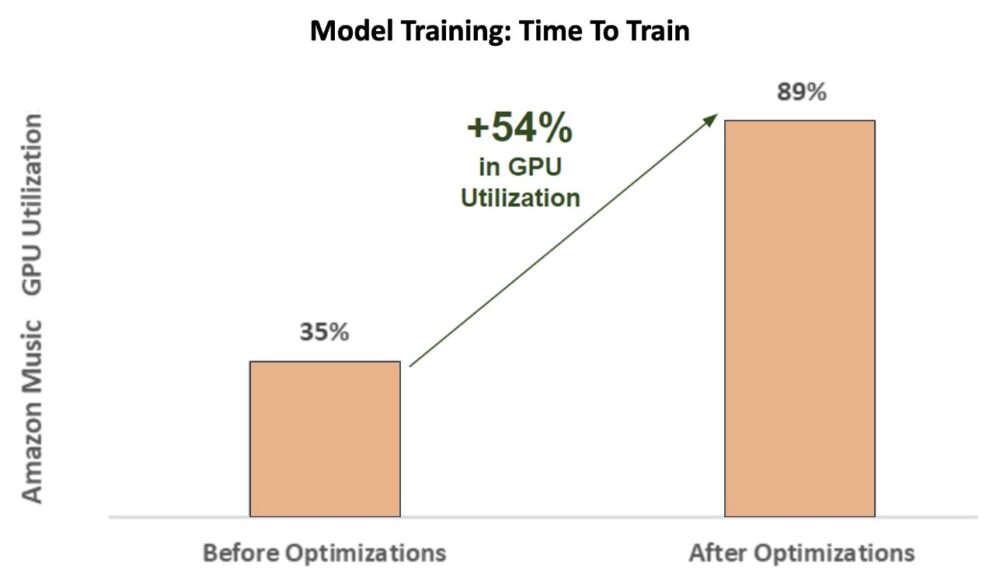

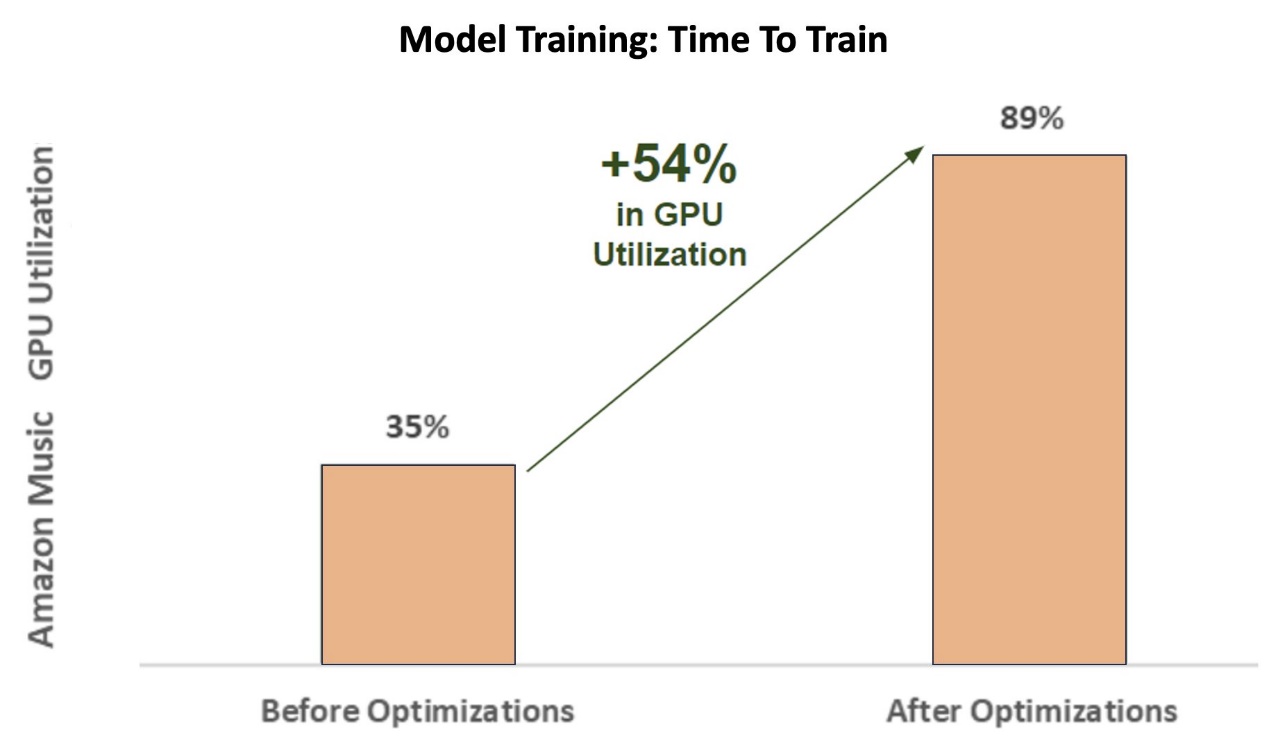

На початкових етапах навчання коректор орфографії BART (барт-основа) моделі трансформатора на екземплярі SageMaker ml.p3.24xlarge (8 графічних процесорів NVIDIA V100 Tensor Core), використання графічного процесора Amazon Music становило близько 35%. Щоб максимізувати переваги навчання з прискоренням графічного процесора NVIDIA, архітектори рішень AWS і NVIDIA підтримали Amazon Music у визначенні областей для оптимізації, зокрема щодо розміру партії та параметрів точності. Ці два важливі параметри впливають на ефективність, швидкість і точність навчання моделей глибокого навчання.

Результатом оптимізації стало нове й покращене використання графічного процесора V100 зі стабільним рівнем близько 89%, що різко скоротило час навчання Amazon Music із 3 днів до 5–6 годин. Змінивши розмір партії з 32 на 256 і використовуючи методи оптимізації, наприклад запуск автоматичне навчання змішаної точності замість того, щоб використовувати лише точність FP32, Amazon Music змогла заощадити час і гроші.

На наведеній нижче діаграмі показано збільшення використання GPU на 54% після оптимізації.

Наступний малюнок ілюструє прискорення часу навчання.

Це збільшення розміру пакета дозволило графічному процесору NVIDIA обробляти значно більше даних одночасно на кількох тензорних ядрах, що призвело до прискореного часу навчання. Однак важливо підтримувати тонкий баланс із пам’яттю, оскільки більші розміри пакетів вимагають більше пам’яті. І збільшення розміру партії, і використання змішаної точності можуть мати вирішальне значення для розкриття потужності графічних процесорів NVIDIA Tensor Core.

Після того, як модель було навчено конвергенції, настав час оптимізувати для розгортання висновків на панелі пошуку Amazon Music.

Виправлення орфографії: висновок моделі BART

За допомогою екземплярів SageMaker G5 і NVIDIA Triton Inference Server (програмне забезпечення з відкритим вихідним кодом), а також NVIDIA TensorRT, SDK для високопродуктивного глибокого навчання, що включає оптимізатор висновків і середовище виконання, Amazon Music обмежує перевірку орфографії BART (барт-основа) моделювати затримку висновку сервера лише до 25 мілісекунд під час пікового трафіку. Це включає такі накладні витрати, як балансування навантаження, попередня обробка, визначення моделі та час постобробки.

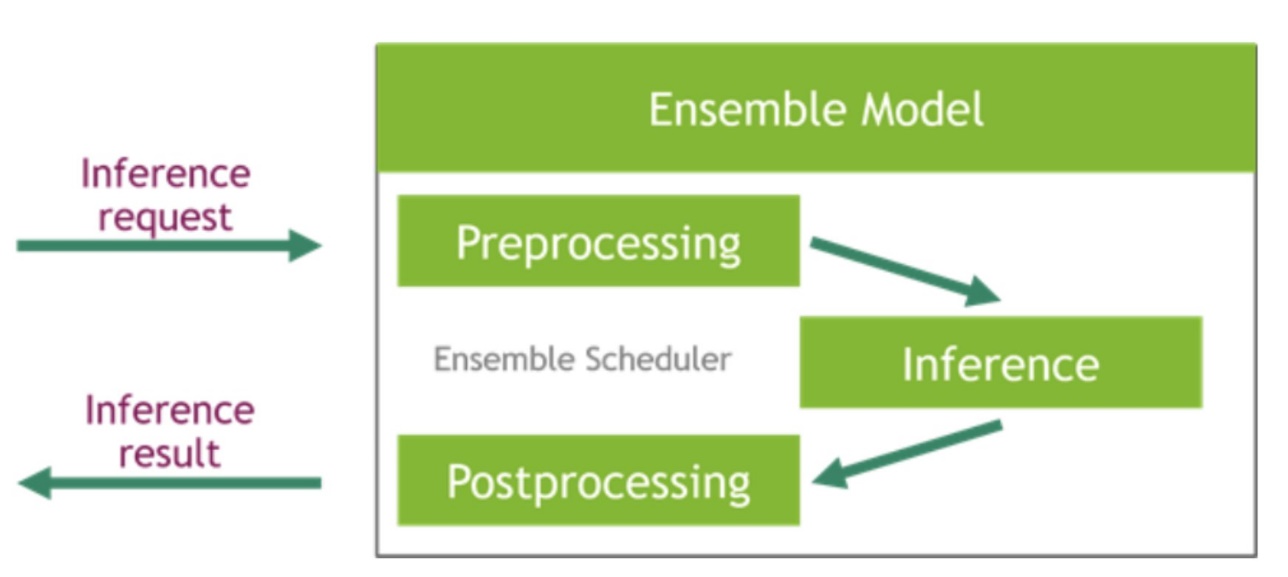

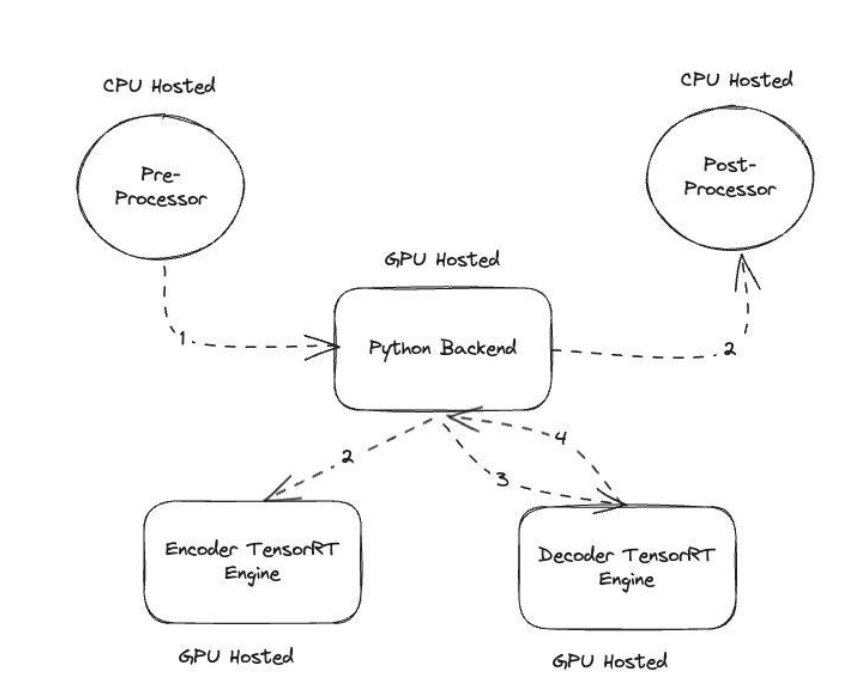

Сервер NVIDIA Triton Inference Server надає два різних типи серверних модулів: один для розміщення моделей на графічному процесорі та серверний механізм Python, де ви можете додати свій власний код для використання на етапах попередньої та постобробки. Наступний малюнок ілюструє схема модельного ансамблю.

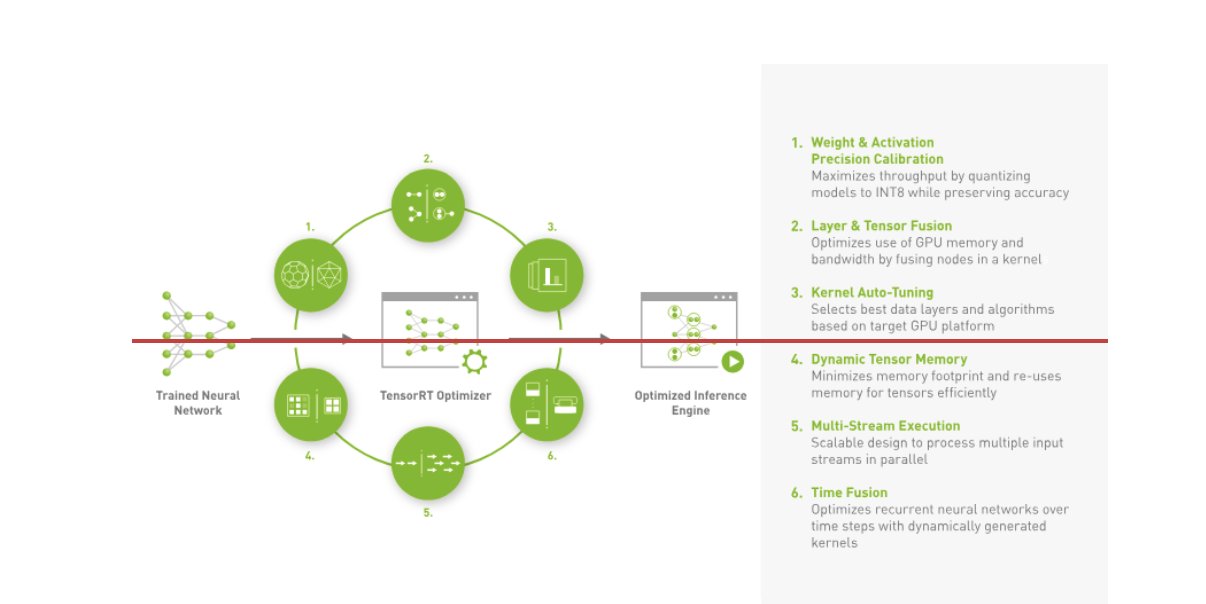

Amazon Music створив свій BART конвеєр висновку шляхом виконання етапів попередньої обробки (токенізація тексту) і постобробки (маркери в текст) на ЦП, тоді як етап виконання моделі виконується на Графічні процесори NVIDIA A10G Tensor Core. Сервер Python знаходиться в середині етапів попередньої та постобробки та відповідає за зв’язок із перетвореними за допомогою TensorRT моделями BART, а також мережами кодера/декодера. TensorRT підвищує продуктивність логічного висновку за допомогою точного калібрування, злиття шарів і тензорів, автоматичного налаштування ядра, динамічної пам’яті тензорів, багатопотокового виконання та злиття часу.

На наступному малюнку показано високорівневий дизайн ключових модулів, які складають конвеєр виведення моделі коректора орфографії BART.

Векторний пошук: вбудовування запиту, генерація речень, висновок моделі BERT

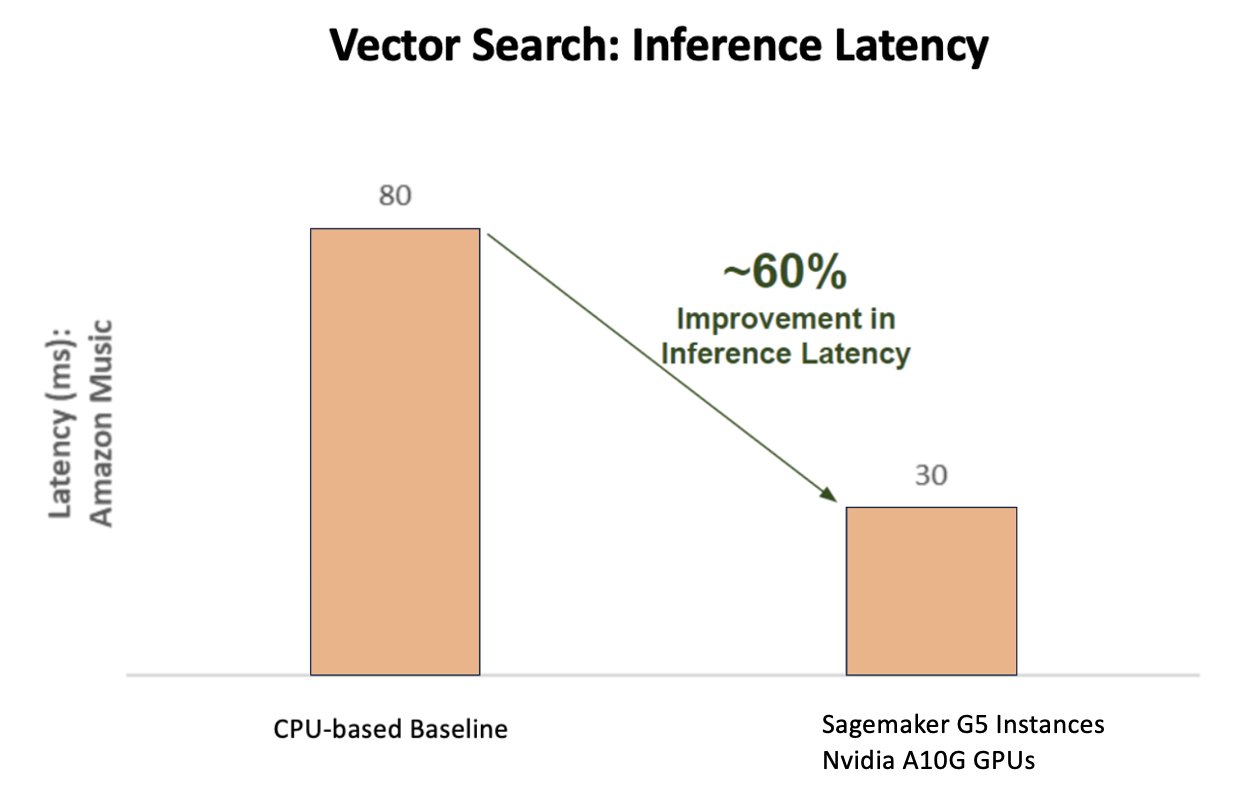

На наступній діаграмі показано 60% покращення затримки (обслуговування p90 800–900 TPS) при використанні платформи NVIDIA AI Inference Platform порівняно з базовим рівнем на основі ЦП.

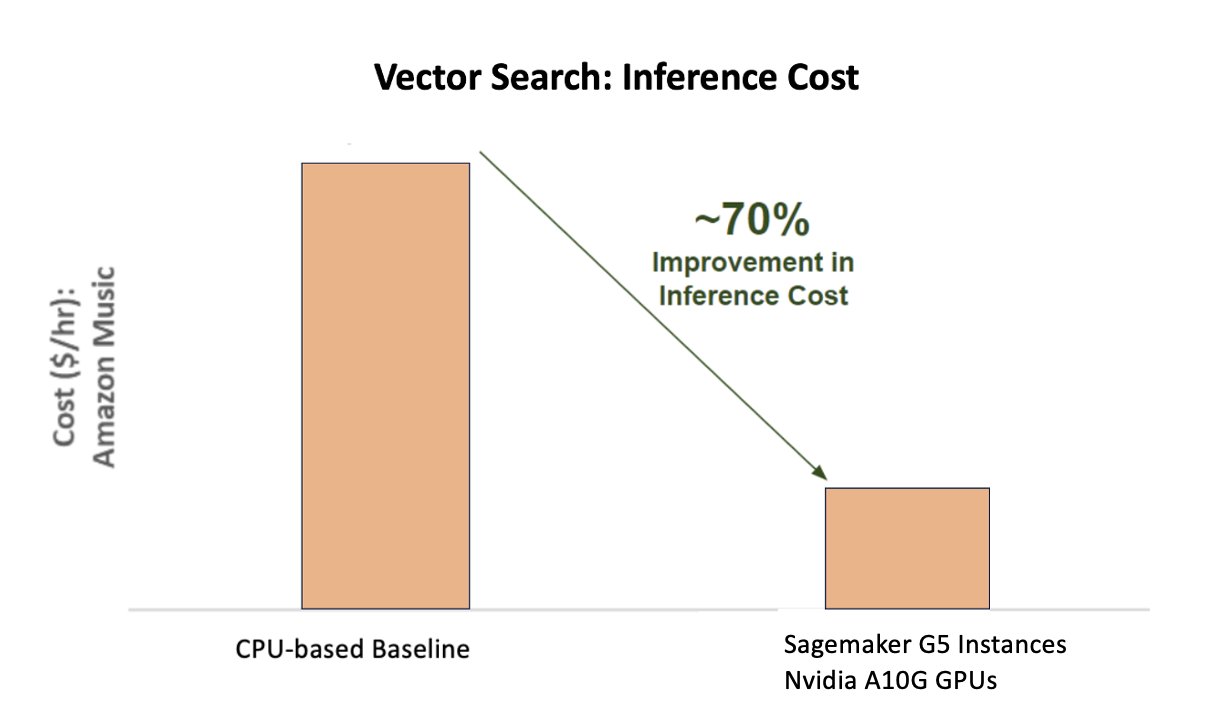

На наступній діаграмі показано підвищення вартості на 70% при використанні платформи NVIDIA AI Inference Platform порівняно з базовим сценарієм на основі ЦП.

На наступному малюнку показано SDK для високопродуктивного глибокого навчання. Він містить оптимізатор логічного висновку глибокого навчання та середовище виконання, яке забезпечує низьку затримку та високу пропускну здатність для програм логічного висновку.

Щоб досягти цих результатів, Amazon Music експериментувала з кількома різними параметрами розгортання Triton Аналізатор моделі Triton, інструмент, який допомагає знайти найкращу конфігурацію моделі NVIDIA Triton для розгортання ефективного висновку. Щоб оптимізувати висновок моделі, Triton пропонує такі функції, як динамічне пакетування та одночасне виконання моделі, а також має підтримку фреймворку для інших можливостей гнучкості. Динамічне групування збирає запити на висновок, плавно групуючи їх у когорти, щоб максимізувати пропускну здатність, забезпечуючи при цьому відповіді в реальному часі для користувачів Amazon Music. Можливість одночасного виконання моделі ще більше підвищує продуктивність логічного висновку, розміщуючи кілька копій моделі на одному GPU. Нарешті, використовуючи Аналізатор моделі Triton, Amazon Music зміг ретельно налаштувати параметри хостингу динамічного пакетування та моделювання паралелізму, щоб знайти оптимальні параметри, які максимізують ефективність висновку за допомогою змодельованого трафіку.

Висновок

Оптимізація конфігурацій за допомогою Triton Inference Server і TensorRT на SageMaker дозволила Amazon Music досягти видатних результатів як для навчання, так і для конвеєрів висновків. Платформа SageMaker — це наскрізна відкрита платформа для виробництва штучного інтелекту, яка забезпечує швидку окупність і універсальність для підтримки всіх основних варіантів використання штучного інтелекту як на апаратному, так і на програмному забезпеченні. Завдяки оптимізації використання графічного процесора V100 для навчання та переходу з процесорів на екземпляри G5 за допомогою графічних процесорів NVIDIA A10G Tensor Core, а також за допомогою оптимізованого програмного забезпечення NVIDIA, такого як Triton Inference Server і TensorRT, такі компанії, як Amazon Music, можуть заощадити час і гроші, одночасно підвищуючи продуктивність обох навчання та висновки, що безпосередньо перетворюється на кращий досвід клієнтів і зниження операційних витрат.

SageMaker справляється з недиференційованою важкою роботою для навчання та хостингу МЛ, дозволяючи Amazon Music забезпечувати надійні масштабовані операції МЛ як на апаратному, так і на програмному забезпеченні.

Ми рекомендуємо вам перевірити, чи ваші робочі навантаження оптимізовані за допомогою SageMaker, завжди оцінюючи ваш вибір апаратного та програмного забезпечення, щоб побачити, чи є способи досягти кращої продуктивності за менших витрат.

Щоб дізнатися більше про NVIDIA AI в AWS, див.

Про авторів

Сіддхарт Шарма є технічним керівником машинного навчання в команді науки та моделювання Amazon Music. Він спеціалізується на проблемах моделювання, пов’язаних з пошуком, пошуком, ранжуванням і НЛП. Сідхарт має багатий досвід роботи з проблемами великомасштабного машинного навчання, які чутливі до затримки, наприклад, націлювання реклами, мультимодальне отримання, розуміння пошукових запитів тощо. До роботи в Amazon Music Сідхарт працював у таких компаніях, як Meta, Walmart Labs, Rakuten про проблеми машинного навчання, орієнтовані на електронну комерцію. Сіддхарт провів першу частину своєї кар’єри, працюючи з рекламними технологічними стартапами.

Сіддхарт Шарма є технічним керівником машинного навчання в команді науки та моделювання Amazon Music. Він спеціалізується на проблемах моделювання, пов’язаних з пошуком, пошуком, ранжуванням і НЛП. Сідхарт має багатий досвід роботи з проблемами великомасштабного машинного навчання, які чутливі до затримки, наприклад, націлювання реклами, мультимодальне отримання, розуміння пошукових запитів тощо. До роботи в Amazon Music Сідхарт працював у таких компаніях, як Meta, Walmart Labs, Rakuten про проблеми машинного навчання, орієнтовані на електронну комерцію. Сіддхарт провів першу частину своєї кар’єри, працюючи з рекламними технологічними стартапами.

Тарун Шарма є менеджером з розробки програмного забезпечення, який веде релевантність пошуку в Amazon Music. Його команда науковців та інженерів ML відповідає за надання контекстуально відповідних і персоналізованих результатів пошуку клієнтам Amazon Music.

Тарун Шарма є менеджером з розробки програмного забезпечення, який веде релевантність пошуку в Amazon Music. Його команда науковців та інженерів ML відповідає за надання контекстуально відповідних і персоналізованих результатів пошуку клієнтам Amazon Music.

Джеймс Парк є архітектором рішень в Amazon Web Services. Він працює з Amazon.com над проектуванням, створенням і розгортанням технологічних рішень на AWS, і особливо цікавиться ШІ та машинним навчанням. У вільний час він любить шукати нові культури, нові враження та бути в курсі останніх технологічних тенденцій. Ви можете знайти його на LinkedIn.

Джеймс Парк є архітектором рішень в Amazon Web Services. Він працює з Amazon.com над проектуванням, створенням і розгортанням технологічних рішень на AWS, і особливо цікавиться ШІ та машинним навчанням. У вільний час він любить шукати нові культури, нові враження та бути в курсі останніх технологічних тенденцій. Ви можете знайти його на LinkedIn.

Кшітіз Гупта є архітектором рішень у NVIDIA. Йому подобається навчати клієнтів хмарних технологій технологіям штучного інтелекту графічного процесора, які може запропонувати NVIDIA, і допомагати їм у прискоренні машинного та глибокого навчання програм. Поза роботою він захоплюється бігом, пішим туризмом і спостереженням за дикою природою.

Кшітіз Гупта є архітектором рішень у NVIDIA. Йому подобається навчати клієнтів хмарних технологій технологіям штучного інтелекту графічного процесора, які може запропонувати NVIDIA, і допомагати їм у прискоренні машинного та глибокого навчання програм. Поза роботою він захоплюється бігом, пішим туризмом і спостереженням за дикою природою.

Цзяхон Лю є архітектором рішень у команді постачальників хмарних послуг у NVIDIA. Він допомагає клієнтам у прийнятті рішень машинного навчання та штучного інтелекту, які використовують прискорені обчислення NVIDIA для вирішення їхніх проблем навчання та висновків. У вільний час він любить орігамі, DIY-проекти та грає в баскетбол.

Цзяхон Лю є архітектором рішень у команді постачальників хмарних послуг у NVIDIA. Він допомагає клієнтам у прийнятті рішень машинного навчання та штучного інтелекту, які використовують прискорені обчислення NVIDIA для вирішення їхніх проблем навчання та висновків. У вільний час він любить орігамі, DIY-проекти та грає в баскетбол.

Тугрул Конук є старшим архітектором рішень у NVIDIA, який спеціалізується на широкомасштабному навчанні, мультимодальному глибокому навчанні та високопродуктивних наукових обчисленнях. До NVIDIA він працював в енергетичній галузі, зосереджуючись на розробці алгоритмів для обчислювального зображення. У рамках свого доктора філософії він працював над глибоким навчанням на основі фізики для чисельного моделювання в масштабі. У вільний час любить читати, грати на гітарі та піаніно.

Тугрул Конук є старшим архітектором рішень у NVIDIA, який спеціалізується на широкомасштабному навчанні, мультимодальному глибокому навчанні та високопродуктивних наукових обчисленнях. До NVIDIA він працював в енергетичній галузі, зосереджуючись на розробці алгоритмів для обчислювального зображення. У рамках свого доктора філософії він працював над глибоким навчанням на основі фізики для чисельного моделювання в масштабі. У вільний час любить читати, грати на гітарі та піаніно.

Рохіл Бхаргава є менеджером з маркетингу продуктів у NVIDIA, зосередженим на розгортанні фреймворків програм NVIDIA та SDK на конкретних платформах CSP.

Рохіл Бхаргава є менеджером з маркетингу продуктів у NVIDIA, зосередженим на розгортанні фреймворків програм NVIDIA та SDK на конкретних платформах CSP.

Еліут Тріана Ісаза є менеджером зі зв’язків із розробниками в NVIDIA, який надає можливості Amazon MLOps, DevOps, науковцям і технічним експертам AWS оволодіти обчислювальним стеком NVIDIA для прискорення й оптимізації моделей Generative AI Foundation, які охоплюють курацію даних, навчання графічного процесора, визначення моделі та розгортання виробництва на екземплярах графічного процесора AWS . Крім того, Елют є пристрасним гірським велосипедистом, лижником, гравцем у теніс і покер.

Еліут Тріана Ісаза є менеджером зі зв’язків із розробниками в NVIDIA, який надає можливості Amazon MLOps, DevOps, науковцям і технічним експертам AWS оволодіти обчислювальним стеком NVIDIA для прискорення й оптимізації моделей Generative AI Foundation, які охоплюють курацію даних, навчання графічного процесора, визначення моделі та розгортання виробництва на екземплярах графічного процесора AWS . Крім того, Елют є пристрасним гірським велосипедистом, лижником, гравцем у теніс і покер.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- : має

- :є

- : ні

- :де

- $UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Здатний

- МЕНЮ

- прискорений

- прискорення

- прискорення

- доступ

- виконувати

- точність

- точний

- Achieve

- досягнутий

- через

- активний

- доповнення

- адреса

- Прийняття

- оголошення

- зачіпає

- після

- AI

- Моделі AI

- випадки використання ai

- альбом

- алгоритми

- ВСІ

- дозволяти

- дозволено

- Дозволити

- дозволяє

- Також

- завжди

- Amazon

- Amazon Web Services

- Amazon.com

- an

- та

- додаток

- застосування

- підхід

- архітектори

- ЕСТЬ

- ПЛОЩА

- області

- навколо

- художник

- AS

- допомагати

- допомагає

- At

- середній

- AWS

- Backend

- Balance

- Балансування

- бар

- заснований

- Базова лінія

- баскетбол

- затока

- BE

- стали

- оскільки

- Переваги

- КРАЩЕ

- Краще

- підвищення

- підсилює

- обидва

- приносити

- широкий

- будувати

- побудований

- by

- CAN

- можливості

- можливості

- захоплення

- який

- кар'єра

- обережно

- випадків

- проблеми

- складні

- Графік

- перевірка

- плекав

- вибір

- клієнтів

- хмара

- код

- COM

- Приходити

- спілкування

- Компанії

- порівняний

- обчислювальна

- обчислення

- одночасно

- конфігурація

- Контейнер

- зміст

- Зближення

- Core

- Коштувати

- витрати

- виробити

- критичний

- вирішальне значення

- CSP

- курація

- виготовлений на замовлення

- клієнт

- Досвід клієнтів

- Клієнти

- дані

- Дата

- Днів

- знизився

- глибокий

- глибоке навчання

- затримки

- доставляти

- надання

- постачає

- Попит

- розгортання

- розгортання

- розгортання

- дизайн

- Розробник

- розвивається

- розробка

- різний

- важкий

- безпосередньо

- занурення

- Різне

- Diy

- Не знаю

- різко

- під час

- динамічний

- e

- e-commerce

- Рано

- освіту

- ефективність

- ефективний

- зусилля

- піднесений

- вбудовування

- емоції

- наймаючи

- уповноважують

- включений

- заохочувати

- кінець в кінець

- енергія

- Інженери

- Підсилює

- досить

- забезпечення

- особливо

- і т.д.

- оцінки

- Навіть

- Кожен

- виконання

- досвід

- Досліди

- experts

- ШВИДКО

- риси

- Рисунок

- в кінці кінців

- знайти

- виявлення

- Перший

- Гнучкість

- повінь

- Сфокусувати

- увагу

- фокусування

- після

- для

- формат

- фонд

- Рамки

- каркаси

- від

- розчарування

- повністю

- функціональні можливості

- далі

- злиття

- шлюз

- покоління

- генеративний

- Генеративний ШІ

- GPU

- Графічні процесори

- Ручки

- траплятися

- апаратні засоби

- Мати

- he

- важкий

- важкий підйом

- допомога

- корисний

- допомагає

- Високий

- на вищому рівні

- висока продуктивність

- його

- його

- тримає

- хостинг

- ГОДИННИК

- Як

- Однак

- HTML

- HTTPS

- ідентифікує

- if

- ілюструє

- Зображеннями

- здійснювати

- важливо

- удосконалювати

- поліпшений

- поліпшення

- in

- includes

- Augmenter

- збільшений

- зростаючий

- промисловість

- неефективний

- вплив

- Інфраструктура

- початковий

- екземпляр

- негайно

- замість

- інтерес

- в

- вводити

- введення

- IT

- ЙОГО

- подорож

- JPG

- просто

- ключ

- Дитина

- Знати

- відомий

- Labs

- мова

- великий

- масштабний

- більше

- міцний

- Затримка

- останній

- шар

- вести

- провідний

- УЧИТЬСЯ

- вивчення

- Важіль

- бібліотека

- підйомний

- як

- рамки

- загрузка

- шукати

- низький

- знизити

- машина

- навчання за допомогою машини

- підтримувати

- основний

- зробити

- РОБОТИ

- менеджер

- управління

- Маркетинг

- майстер

- Максимізувати

- Може..

- пам'яті

- пам'ять

- Meta

- Середній

- мільйона

- мільйони

- мілісекунд

- мінімальний

- помилка

- змішаний

- ML

- MLOps

- модель

- моделювання

- Моделі

- Модулі

- гроші

- більше

- найбільш

- Гора

- багато

- множинний

- музика

- повинен

- ім'я

- необхідний

- негативно

- мереж

- Нові

- nlp

- Nvidia

- of

- пропонувати

- Пропозиції

- on

- ONE

- тільки

- відкрити

- з відкритим вихідним кодом

- операційний

- оперативний

- операції

- оптимальний

- оптимізація

- Оптимізувати

- оптимізований

- оптимізуючий

- or

- організував

- порядок

- Інше

- з

- поза

- видатний

- над

- загальний

- власний

- параметри

- частина

- приватність

- особливо

- партнерська

- пристрасний

- Peak

- відсоток

- продуктивність

- персонал

- Персоналізовані

- Вчений ступінь

- трубопровід

- платформа

- Платформи

- plato

- Інформація про дані Платона

- PlatoData

- гравець

- ігри

- Подкаст

- подкасти

- точка

- покер

- це можливо

- пошта

- потенціал

- влада

- Харчування

- Точність

- попередній

- Пріоритетність

- пріоритет

- проблеми

- процес

- Product

- Production

- проектів

- забезпечувати

- Постачальник

- забезпечує

- забезпечення

- Python

- Швидко

- Ранжування

- читання

- реального часу

- зниження

- послатися

- пов'язаний

- відносини

- актуальність

- доречний

- надійний

- запитів

- Вимагається

- ресурси

- відповіді

- відповідальність

- відповідальний

- реагувати

- в результаті

- результати

- Багаті

- право

- біг

- пробіжки

- час виконання

- мудрець

- то ж

- зберегти

- економія

- масштабовані

- шкала

- наука

- науковий

- Вчені

- Sdk

- sdks

- плавно

- Пошук

- пошук

- Грати короля карти - безкоштовно Nijumi логічна гра гри

- другий

- розділам

- побачити

- пошук

- мабуть

- семантика

- старший

- чутливий

- пропозиція

- служити

- сервер

- обслуговування

- Постачальник послуг

- Послуги

- виступаючої

- комплект

- налаштування

- кілька

- Поділитись

- загальні

- Шоу

- значний

- істотно

- простий

- сидить

- Розмір

- розміри

- розумний

- Софтвер

- розробка програмного забезпечення

- рішення

- Рішення

- пісня

- Source

- напруга

- спеціалізується

- спеціалізується

- конкретний

- швидкість

- ОРФОГРАФІЯ

- орфографія

- відпрацьований

- стек

- Починаючи

- Стартапи

- перебування

- стійкий

- Крок

- заходи

- Історія

- потоковий

- такі

- чудовий

- підтримка

- Підтриманий

- Переконайтеся

- прийняті

- взяття

- націлювання

- команда

- технології

- технічний

- техніка

- методи

- Технології

- Технологія

- текст

- Що

- Команда

- їх

- Їх

- Там.

- отже

- Ці

- вони

- речі

- це

- через

- пропускна здатність

- час

- times

- назва

- до

- разом

- Токенізація

- Жетони

- прийняли

- інструмент

- топ

- TPS

- трафік

- поїзд

- навчений

- Навчання

- трансформатор

- Тенденції

- Triton

- правда

- два

- розуміння

- безсумнівно

- Всесвіт

- розблокування

- представила

- us

- використання

- використовуваний

- користувачі

- використовує

- використання

- використовує

- значення

- величезний

- Універсальність

- дуже

- Очікування

- ходити

- Walmart

- було

- спостереження

- способи

- we

- Web

- веб-сервіси

- ДОБРЕ

- були

- коли

- в той час як

- в той час як

- волі

- з

- Work

- працював

- робочий

- працює

- світ

- турбуватися

- ще

- дали

- Ти

- вашу

- зефірнет