Це гостьовий допис, співавторами якого є Нафі Ахмет Тургут, Хасан Бурак Єль і Дамла Шентюрк із Getir.

Заснована в 2015, приніс позиціонує себе як новатор у сфері надшвидкої доставки продуктів. Ця інноваційна технологічна компанія зробила революцію в сегменті доставки «останньої милі» своєю переконливою пропозицією «продукти за лічені хвилини». Маючи присутність у Туреччині, Великобританії, Нідерландах, Німеччині та Сполучених Штатах, Getir став багатонаціональною силою, з якою потрібно рахуватися. Сьогодні бренд Getir являє собою диверсифікований конгломерат, що охоплює дев’ять різних вертикалей, і всі вони працюють разом під єдиною парасолькою.

У цій публікації ми пояснюємо, як ми створили наскрізний конвеєр прогнозування категорій продуктів, щоб допомогти комерційним командам за допомогою Amazon SageMaker та Пакет AWS, скорочуючи тривалість навчання моделі на 90%.

Детальне розуміння наявного асортименту нашої продукції є критичною проблемою, з якою ми, як і багато компаній, стикаємося на сучасному швидкозмінному та конкурентному ринку. Ефективним рішенням цієї проблеми є прогнозування товарних категорій. Модель, яка генерує повне дерево категорій, дозволяє нашим комерційним командам порівнювати наш існуючий портфель продуктів із продуктами наших конкурентів, пропонуючи стратегічну перевагу. Таким чином, нашою основною проблемою є створення та впровадження точної моделі прогнозування категорії продукту.

Ми використали потужні інструменти, надані AWS, щоб впоратися з цією проблемою та ефективно орієнтуватися в складній сфері машинного навчання (ML) і прогнозної аналітики. Наші зусилля привели до успішного створення наскрізного конвеєра прогнозування категорій продуктів, який поєднує в собі сильні сторони SageMaker і AWS Batch.

Ця можливість прогнозної аналітики, зокрема точне прогнозування категорій продуктів, виявилася неоціненною. Це дало нашим командам важливу інформацію на основі даних, яка оптимізувала управління запасами, покращила взаємодію з клієнтами та зміцнила нашу присутність на ринку.

Методологія, яку ми пояснюємо в цій публікації, варіюється від початкової фази збору набору функцій до остаточної реалізації конвеєра передбачення. Важливим аспектом нашої стратегії було використання SageMaker і AWS Batch для вдосконалення попередньо підготовлених моделей BERT для семи різних мов. Крім того, наша бездоганна інтеграція зі службою зберігання об’єктів AWS Служба простого зберігання Amazon (Amazon S3) стала ключем до ефективного зберігання та доступу до цих вдосконалених моделей.

SageMaker — це повністю керована служба машинного навчання. За допомогою SageMaker науковці та розробники даних можуть швидко й без зусиль створювати та навчати моделі ML, а потім безпосередньо розгортати їх у готовому до виробництва середовищі.

Будучи повністю керованим сервісом, AWS Batch допомагає запускати пакетні обчислювальні навантаження будь-якого масштабу. AWS Batch автоматично надає обчислювальні ресурси та оптимізує розподіл робочого навантаження на основі кількості та масштабу робочого навантаження. З AWS Batch не потрібно встановлювати або керувати програмним забезпеченням для пакетних обчислень, тому ви можете зосередити свій час на аналізі результатів і вирішенні проблем. Ми використовували завдання GPU, які допомагають нам запускати завдання, які використовують GPU екземпляра.

Огляд рішення

Над цим проектом разом працювали п’ятеро людей із команди Getir із вивчення даних та команди інфраструктури. Проект було завершено за місяць і запущено у виробництво після тижня тестування.

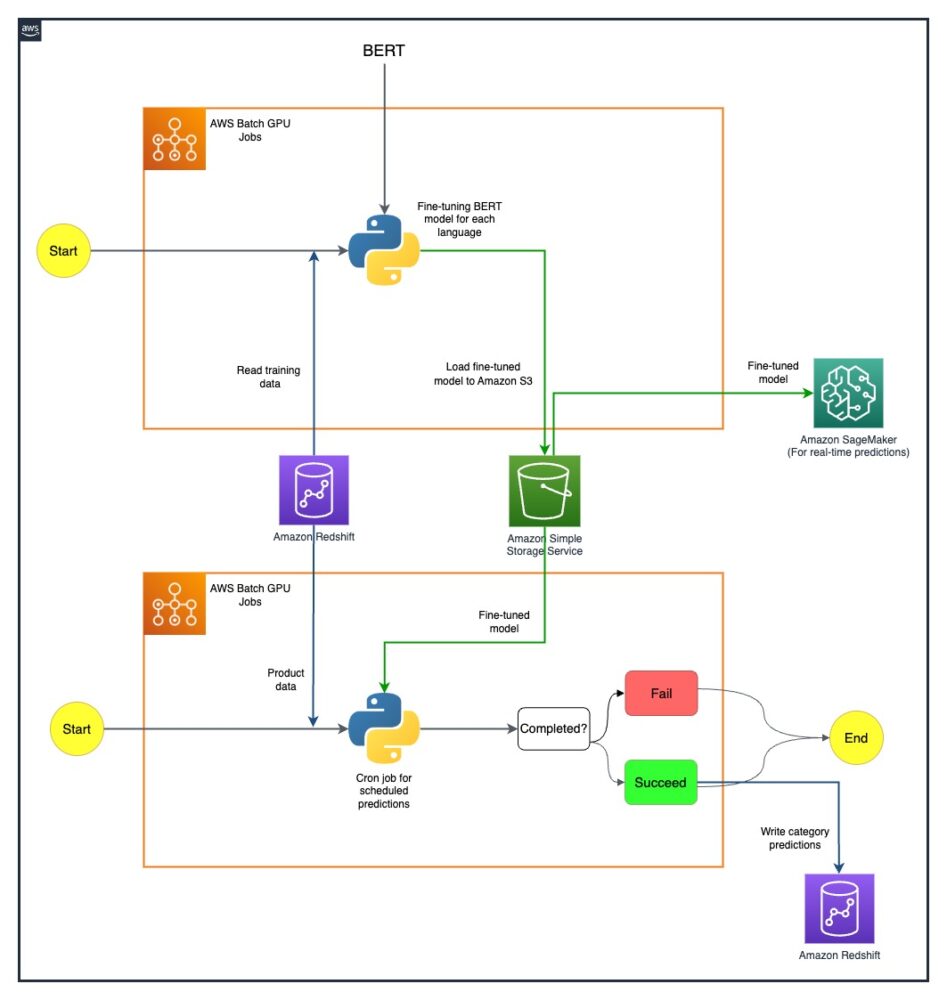

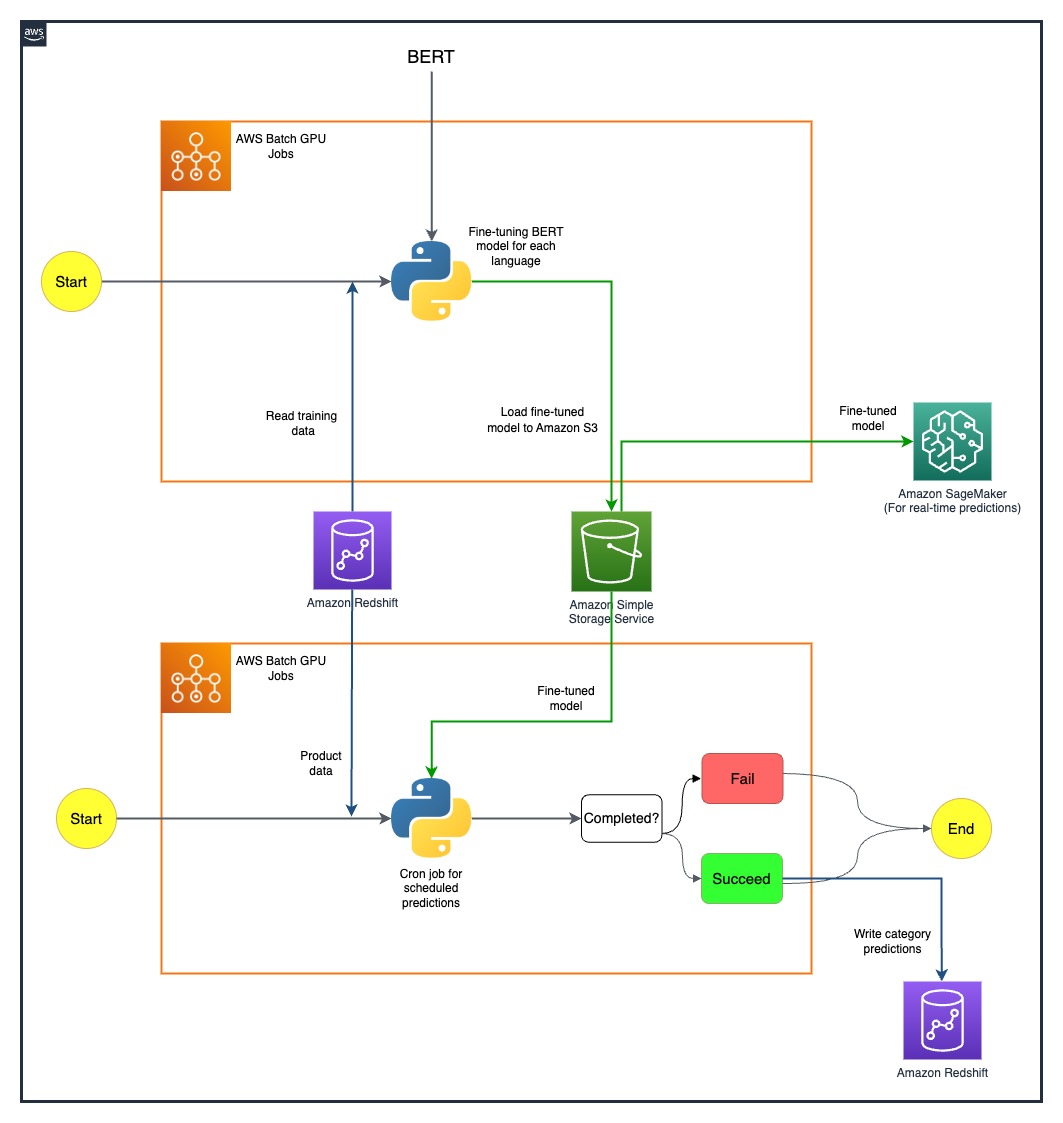

На наступній діаграмі показано архітектуру рішення.

Конвеєр моделей запускається окремо для кожної країни. Архітектура включає два завдання AWS Batch GPU cron для кожної країни, що виконуються за визначеними розкладами.

Ми подолали деякі труднощі, стратегічно розгорнувши ресурси SageMaker і AWS Batch GPU. Процес, який використовується для вирішення кожної проблеми, детально описано в наступних розділах.

Точне налаштування багатомовних моделей BERT із завданнями AWS Batch GPU

Ми шукали рішення для підтримки кількох мов для нашої різноманітної бази користувачів. Моделі BERT були очевидним вибором через їх встановлену здатність ефективно вирішувати складні завдання природної мови. Щоб пристосувати ці моделі до наших потреб, ми використали потужність AWS, використовуючи завдання екземплярів GPU з одним вузлом. Це дозволило нам точно налаштувати попередньо підготовлені моделі BERT для кожної з семи мов, підтримку яких нам потрібна. Завдяки цьому методу ми забезпечили високу точність у прогнозуванні категорій продуктів, подолавши будь-які потенційні мовні бар’єри.

Ефективне зберігання моделей за допомогою Amazon S3

Нашим наступним кроком було вирішення питання про зберігання та керування моделлю. Для цього ми вибрали Amazon S3, відомий своєю масштабованістю та безпекою. Зберігання наших точно налаштованих моделей BERT на Amazon S3 дозволило нам забезпечити легкий доступ до різних команд у нашій організації, тим самим значно оптимізувавши наш процес розгортання. Це був вирішальний аспект у досягненні гнучкості наших операцій і повної інтеграції наших зусиль з машинного навчання.

Створення наскрізного конвеєра передбачення

Для найкращого використання наших попередньо навчених моделей потрібен був ефективний конвеєр. Ми вперше розгорнули ці моделі на SageMaker, дії, яка дозволяла робити прогнози в реальному часі з низькою затримкою, тим самим покращуючи нашу взаємодію з користувачами. Для більш масштабних пакетних прогнозів, які були однаково важливими для нашої роботи, ми використовували завдання AWS Batch GPU. Це забезпечило оптимальне використання наших ресурсів, забезпечивши ідеальний баланс продуктивності та ефективності.

Вивчення майбутніх можливостей із SageMaker MME

Оскільки ми продовжуємо розвиватися та шукати ефективність у нашому конвеєрі машинного навчання, одним із напрямків, який ми прагнемо дослідити, є використання мультимодельних кінцевих точок (MME) SageMaker для розгортання наших точно налаштованих моделей. За допомогою MME ми потенційно можемо оптимізувати розгортання різноманітних точно налаштованих моделей, забезпечуючи ефективне керування моделями, а також виграючи від власних можливостей SageMaker, таких як тіньові варіанти, автоматичне масштабування та Amazon CloudWatch інтеграція. Це дослідження узгоджується з нашим безперервним прагненням покращити наші можливості прогнозної аналітики та забезпечити чудовий досвід для наших клієнтів.

Висновок

Наша успішна інтеграція SageMaker і AWS Batch не тільки вирішила наші специфічні проблеми, але й значно підвищила нашу операційну ефективність. Завдяки впровадженню складної системи прогнозування категорій продуктів ми можемо надати нашим комерційним командам інформацію на основі даних, сприяючи тим самим більш ефективному прийняттю рішень.

Наші результати красномовно говорять про ефективність нашого підходу. Ми досягли 80% точності прогнозів на всіх чотирьох рівнях деталізації категорій, що відіграє важливу роль у формуванні асортименту продуктів для кожної країни, яку ми обслуговуємо. Цей рівень точності розширює наш охоплення за межі мовних бар’єрів і гарантує, що ми обслуговуємо нашу різноманітну базу користувачів з максимальною точністю.

Крім того, стратегічно використовуючи заплановані завдання AWS Batch GPU, ми змогли скоротити тривалість навчання моделі на 90%. Ця ефективність ще більше оптимізувала наші процеси та підвищила нашу операційну гнучкість. Ефективне зберігання моделей за допомогою Amazon S3 зіграло вирішальну роль у цьому досягненні, збалансувавши прогнози в реальному часі та пакетні прогнози.

Щоб дізнатися більше про те, як розпочати створення власних конвеєрів машинного навчання за допомогою SageMaker, див Ресурси Amazon SageMaker. AWS Batch — чудовий варіант, якщо ви шукаєте недороге, масштабоване рішення для виконання пакетних завдань із низькими операційними витратами. Для початку див Початок роботи з AWS Batch.

Про авторів

Нафі Ахмет Тургут отримав ступінь магістра електротехніки та електроніки та працював науковим співробітником. Він зосереджувався на створенні алгоритмів машинного навчання для моделювання аномалій нервової мережі. Він приєднався до Getir у 2019 році та зараз працює старшим менеджером з аналізу даних і аналітики. Його команда відповідає за розробку, впровадження та підтримку наскрізних алгоритмів машинного навчання та рішень на основі даних для Getir.

Нафі Ахмет Тургут отримав ступінь магістра електротехніки та електроніки та працював науковим співробітником. Він зосереджувався на створенні алгоритмів машинного навчання для моделювання аномалій нервової мережі. Він приєднався до Getir у 2019 році та зараз працює старшим менеджером з аналізу даних і аналітики. Його команда відповідає за розробку, впровадження та підтримку наскрізних алгоритмів машинного навчання та рішень на основі даних для Getir.

Хасан Бурак Єл отримав ступінь бакалавра з електротехніки та електроніки в Університеті Богазічі. Він працював у Turkcell, в основному зосереджений на прогнозуванні часових рядів, візуалізації даних та автоматизації мережі. Він приєднався до Getir у 2021 році та зараз працює менеджером з аналізу даних і аналітики, відповідаючи за домени пошуку, рекомендацій і розвитку.

Хасан Бурак Єл отримав ступінь бакалавра з електротехніки та електроніки в Університеті Богазічі. Він працював у Turkcell, в основному зосереджений на прогнозуванні часових рядів, візуалізації даних та автоматизації мережі. Він приєднався до Getir у 2021 році та зараз працює менеджером з аналізу даних і аналітики, відповідаючи за домени пошуку, рекомендацій і розвитку.

Дамла Шентюрк отримала ступінь бакалавра комп’ютерної інженерії в Галатасарайському університеті. Вона продовжує здобуття ступеня магістра комп’ютерної інженерії в Університеті Богазічі. Вона приєдналася до Getir у 2022 році та працювала Data Scientist. Вона працювала над комерційними проектами, проектами ланцюга поставок і відкриттями.

Дамла Шентюрк отримала ступінь бакалавра комп’ютерної інженерії в Галатасарайському університеті. Вона продовжує здобуття ступеня магістра комп’ютерної інженерії в Університеті Богазічі. Вона приєдналася до Getir у 2022 році та працювала Data Scientist. Вона працювала над комерційними проектами, проектами ланцюга поставок і відкриттями.

Есра Каябалі є старшим архітектором рішень в AWS, який спеціалізується на сфері аналітики, включаючи сховища даних, озера даних, аналітику великих даних, пакетну передачу даних і потокове передавання даних у реальному часі, а також інтеграцію даних. Вона має 12 років досвіду розробки програмного забезпечення та архітектури. Вона захоплена вивченням та викладанням хмарних технологій.

Есра Каябалі є старшим архітектором рішень в AWS, який спеціалізується на сфері аналітики, включаючи сховища даних, озера даних, аналітику великих даних, пакетну передачу даних і потокове передавання даних у реальному часі, а також інтеграцію даних. Вона має 12 років досвіду розробки програмного забезпечення та архітектури. Вона захоплена вивченням та викладанням хмарних технологій.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- : має

- :є

- : ні

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- здатність

- Здатний

- МЕНЮ

- доступ

- доступ до

- точність

- точний

- досягнутий

- досягнення

- досягнення

- через

- дію

- Додатково

- адреса

- адресований

- Перевага

- після

- проти

- алгоритми

- Вирівнює

- ВСІ

- дозволено

- дозволяє

- по

- Також

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- аналітика

- Аналізуючи

- та

- та інфраструктури

- аномалії

- будь-який

- архітектура

- ЕСТЬ

- AS

- зовнішній вигляд

- асортимент

- At

- автоматичний

- автоматично

- Автоматизація

- Проспект

- AWS

- Balance

- Балансування

- бар'єри

- база

- заснований

- BE

- ставати

- було

- еталонний тест

- вигода

- КРАЩЕ

- За

- Великий

- Великий даних

- Підвищений

- обидва

- марка

- будувати

- Створюємо

- побудований

- підприємства

- але

- by

- CAN

- можливості

- можливості

- з великої літери

- категорії

- Категорія

- догоджати

- центральний

- ланцюг

- виклик

- проблеми

- вибір

- хмара

- комбінати

- комерційний

- компанія

- переконливий

- конкурентоспроможний

- конкурентів

- Зроблено

- комплекс

- всеосяжний

- обчислення

- комп'ютер

- Комп'ютерна інженерія

- обчислення

- конгломерат

- продовжувати

- триває

- безперервний

- країна

- створення

- критичний

- вирішальне значення

- В даний час

- клієнт

- Клієнти

- дані

- Analytics даних

- наука про дані

- вчений даних

- візуалізація даних

- керовані даними

- Прийняття рішень

- певний

- Ступінь

- доставка

- розгортання

- розгорнути

- розгортання

- розгортання

- проектування

- докладно

- розробників

- розробка

- різний

- трудність

- безпосередньо

- розподіл

- Різне

- диверсифіковані

- домен

- домени

- два

- тривалість

- кожен

- легко

- Ефективний

- фактично

- ефективність

- Ефективність

- ефективність

- ефективний

- продуктивно

- легко

- зусилля

- електроніка

- уповноважувати

- включений

- охоплюючий

- кінець в кінець

- Машинобудування

- підвищена

- підвищення

- забезпечується

- гарантує

- забезпечення

- Навколишнє середовище

- однаково

- встановлений

- еволюціонувати

- відмінно

- існуючий

- досвід

- Досліди

- Пояснювати

- дослідження

- дослідити

- продовжується

- Face

- сприяння

- швидкий темп

- особливість

- поле

- остаточний

- Перший

- Сфокусувати

- увагу

- після

- для

- Примусово

- Прогноз

- чотири

- від

- повністю

- далі

- майбутнє

- збір

- генерує

- Німеччина

- отримати

- GPU

- Графічні процесори

- випускник

- Зростання

- гість

- Guest Post

- обробляти

- Мати

- he

- допомога

- допомагає

- її

- Високий

- його

- відбувся

- Як

- How To

- HTML

- HTTP

- HTTPS

- if

- реалізація

- реалізації

- важливо

- важливий аспект

- in

- includes

- У тому числі

- інформація

- Інфраструктура

- початковий

- інноваційний

- розуміння

- встановлювати

- екземпляр

- інтеграція

- Взаємодії

- в

- безцінний

- інвентаризація

- Управління запасами

- IT

- ЙОГО

- сам

- Джобс

- приєднався

- JPG

- Кін

- ключ

- відомий

- озера

- мова

- мови

- Затримка

- вивчення

- Led

- рівень

- рівні

- як

- шукати

- низький

- недорогий

- машина

- навчання за допомогою машини

- головним чином

- Підтримка

- зробити

- управляти

- вдалося

- управління

- менеджер

- манера

- багато

- ринок

- магістра

- метод

- Методологія

- хвилин

- ML

- модель

- Моделі

- місяць

- більше

- багатонаціональний

- множинний

- рідний

- Природний

- Переміщення

- Необхідність

- потреби

- Нідерланди

- мережу

- наступний

- дев'ять

- немає

- об'єкт

- Очевидний

- of

- пропонує

- on

- ONE

- тільки

- оперативний

- операції

- оптимальний

- оптимізований

- Оптимізує

- варіант

- or

- порядок

- організація

- наші

- подолання

- власний

- особливо

- пристрасний

- Люди

- ідеальний

- продуктивність

- фаза

- трубопровід

- plato

- Інформація про дані Платона

- PlatoData

- грав

- відіграє

- портфель

- розташовані

- можливостей

- пошта

- потенціал

- потенційно

- влада

- потужний

- Точність

- прогнозування

- прогноз

- Прогнози

- Прогностична аналітика

- наявність

- Проблема

- проблеми

- процес

- процеси

- Product

- Production

- проект

- проектів

- доведений

- забезпечувати

- за умови

- забезпечення

- переслідування

- кількість

- швидко

- діапазони

- досягати

- реального часу

- дані в режимі реального часу

- отримано

- Рекомендація

- зменшити

- Знижений

- зниження

- удосконалювати

- рафінований

- представляє

- вимагається

- дослідження

- ресурси

- відповідальність

- відповідальний

- результати

- революціонізували

- Роль

- прогін

- біг

- мудрець

- масштабованість

- масштабовані

- шкала

- Масштабування

- плановий

- наука

- вчений

- Вчені

- безшовні

- Пошук

- розділам

- безпеку

- побачити

- Шукати

- сегмент

- обраний

- старший

- Серія

- служити

- обслуговування

- Послуги

- комплект

- сім

- тінь

- формуючи

- вона

- Шоу

- істотно

- простий

- особливий

- So

- Софтвер

- розробка програмного забезпечення

- рішення

- Рішення

- Розв’язування

- деякі

- складний

- шукати

- говорити

- спеціалізований

- конкретний

- почалася

- Штати

- Крок

- зберігання

- зберігання

- Стратегічний

- Стратегічно

- Стратегія

- потоковий

- раціоналізувати

- обтічний

- упорядкування

- посилений

- сильні сторони

- успішний

- чудовий

- поставка

- ланцюжка поставок

- підтримка

- снасті

- кравець

- завдання

- Навчання

- команда

- команди

- технології

- Технічна компанія

- Технології

- Тестування

- Що

- Команда

- Нідерланди

- Великобританія

- їх

- Їх

- потім

- тим самим

- отже

- Ці

- це

- через

- час

- Часовий ряд

- до

- сьогодні

- сьогоднішній

- разом

- інструменти

- трейлблейзер

- поїзд

- Навчання

- дерево

- Туреччина

- два

- Uk

- парасолька

- при

- United

- Сполучені Штати

- університет

- us

- використання

- використовуваний

- користувач

- User Experience

- використання

- використовувати

- максимально

- різний

- вертикалі

- візуалізації

- життєво важливий

- Обсяги

- було

- we

- Web

- веб-сервіси

- week

- були

- який

- в той час як

- з

- в

- працював

- робочий

- працює

- років

- Ти

- вашу

- зефірнет