By Кенна Хьюз-Каслберрі опубліковано 02 грудня 2022 р

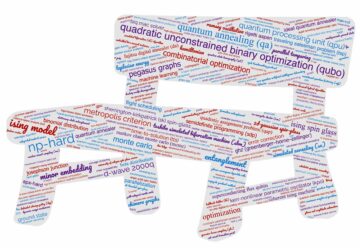

Завдяки прогресу технологій стає все важче розрізнити, що правда, а що ні. Ця проблема посилюється з використанням технології deepfake—аудіо та відео які використовують ШІ для заміни людей або їхніх голосів. Хоча багато дипфейків успішно використовувалися для розваг (наприклад, якщо Ніколас Кейдж був у Індіана Джонс: У пошуках втраченого ковчега) або ігор (наприклад, у Спортсмени ФІФА), великий відсоток із них було створено для більшого зловісні причини. Оскільки створювати ці фальшиві відео стає легше, багато експертів сподіваються, що квантові обчислення допоможуть подолати потенційні загрози цієї технології, що розвивається.

Як працює технологія Deepfake?

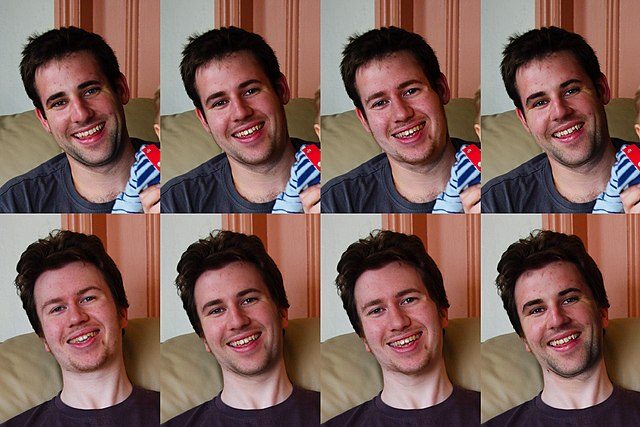

Щоб створити успішне глибоке фейкове відео, вам потрібно навчання за допомогою машини алгоритми. «Алгоритми глибокого навчання навчаються вирішувати проблеми на основі великих наборів даних, а потім використовуються для обміну обличчями між відео та іншим цифровим вмістом», — пояснили. Постквантовий CEO Андерсен Ченг. Post-Quantum є провідною компанією з кібербезпеки, яка фокусується на квантово-стійкий безпека, в тому числі від дипфейків. «Існує кілька методів створення цих дипфейків, — заявив Ченг, — але найпопулярнішим є використання глибоких нейронних мереж із залученням автокодерів. Ан автокодер — це програма глибокого навчання штучного інтелекту, яка вивчає відеокліпи, щоб зрозуміти, як виглядає людина з різних ракурсів і в навколишньому середовищі, а потім відображає цю людину на особистості, знаходячи спільні риси».

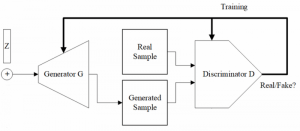

Налаштування технології deepfake (PC Wikimedia Commons)

Щоб переконатися, що автокодер працює успішно, потрібно проаналізувати кілька відеозаписів обличчя об’єкта, щоб отримати більший пул даних. Потім автокодер може допомогти створити складене відео, замінивши оригінальну окрему тему новим об’єктом. Другий тип машинного навчання під назвою Загальна змагальна мережа (GAN) виявлятиме та виправлятиме недоліки в новому композитному відео. За словами а 2022 стаття: «GAN навчає «генератор» створювати нові зображення з прихованого представлення вихідного зображення та «дискримінатор» для оцінки реалістичності згенерованих матеріалів». Цей процес повторюється кілька разів, доки дискримінатор не зможе визначити, чи відео фальсифіковано, а дипфейк завершено.

Загроза технології Deepfake

Наразі існує багато програмного забезпечення з відкритим кодом або безкоштовних програм, які люди можуть використовувати для створення глибоких фейків. Хоча це може здатися корисним для багатьох, особливо тих, хто працює в індустрії розваг, це призвело до серйозних, навіть кримінальних, проблем. За словами а Звіт Deeptrace, 96% deepfake відео в Інтернеті в 2019 році були, як не дивно, порнографією. У той час як багато з цих незаконних відео були зроблені для помсти колишнім, інші використовувалися для створення скандалів для жінок-знаменитостей і навіть політиків. У 2018 році було опубліковано глибоке фейкове відео від a Бельгійська політична партія показує, як тодішній президент Трамп обговорює Паризькі кліматичні угоди. У зв’язку з тим, що фейкові новини вже стали проблемою для широкого загалу, глибокі фейкові відео можуть стати тією соломинкою, яка зламає спину верблюду. Навіть deepfake аудіо сіє хаос, оскільки один підроблений аудіофайл із CEO технологічної компанії допоміг здійснити шахрайство. На думку Ченга, такі типи ЗМІ можуть досить швидко втрачати довіру суспільства. «У нас є ширша проблема суспільної довіри: як громадськість зможе відрізнити, що є справжнім, а що — глибоким фейком», — додав Ченг. «Як ми бачили, є навіть докази того, що дипфейки використовуються для обходу захисних заходів, таких як біометрична автентифікація». З огляду на ці зростаючі занепокоєння, Ченг і його команда в Post-Quantum вважають, що вони мають рішення у вигляді Номідіо, спеціалізоване програмне забезпечення ультра-безпеки.

Підготовка до загроз технології DeepFake

Розглядаючи численні загрози, пов’язані з квантовими обчисленнями та глибокими фейками, Ченг і ця команда створили Nomidio, щоб переконатися, що дані для входу та навіть біометрична автентифікація залишаються безпечними. «Nomidio — це біометричний багатофакторний біометричний (MFB) сервіс без пароля, який забезпечує безпечну автентифікацію за допомогою простої та інтуїтивно зрозумілої взаємодії з користувачем», — сказав Ченг. «Він замінює вхід на основі імені користувача/паролю та єдиний вхід, при цьому користувачі аутентифікуються за їхнім біометричним профілем за допомогою багатофакторної аутентифікації (MFA) за лаштунками». Оскільки Ченг був експертом з кібербезпеки протягом багатьох років, він переконався, що Nomidio також може бути захищеним від глибоких фейків. «Наша основна філософія під час створення полягала в тому, щоб використовувати якомога більше додаткових вхідних даних і справжню багатофакторну автентифікацію (тобто з більш ніж двома факторами), тому це фактично ідеальне рішення для вирішення будь-яких майбутніх розробок технології deepfake. Зрештою це пов’язано з тим, що традиційного MFA недостатньо, але MFB може зробити атаки в реальному часі практично неможливими. Тобто комбінація, наприклад, голосу, обличчя та PIN-коду є дуже безпечною через те, що будь-який окремий фактор можна підробити, але підробити всі три в одному випадку практично неможливо. За допомогою Nomidio можна об’єднати в єдину систему аутентифікації поєднання біометрії голосу й обличчя, розпізнавання мовлення, контекстно-залежних даних і навіть аналізу поведінки. »

Хоча сама Nomidio не використовує квантові обчислення для подолання загроз deepfake, квантові комп’ютери потенційно можуть працювати проти цих підроблених медіафайлів. як квантові комп'ютери часто використовують алгоритми машинного навчання, щоб працювати швидше й ефективніше, вони можуть виявити підроблені відео або аудіофайли з більшою швидкістю. Хоча технологія все ще розробляється, і мало хто дивиться на дипфейки як на потенційний варіант використання квантових комп’ютерів, ці машини наступного рівня можна буде використовувати в майбутньому, щоб зробити наші медіа більш правдивими та точними.

З огляду на те, що загрози технології deepfake стають усе більш очевидними, багато урядів і компаній уже намагаються знайти способи боротьби з ними. У 2021 році Facebook запустив Виклик Deepfake Detection, з призом у 500,000 XNUMX доларів США для тих, хто створить нову технологію для виявлення дипфейків. У США такі штати, як Каліфорнія, Техас і Вірджинія, мають закони, які забороняють використання глибоких фейків як для порнографії, так і для політики. The Європейський парламент також встановили додаткові правила щодо deepfake, змінивши Закон про цифрові послуги, щоб накласти використання міток на deepfake відео. Хоча це законодавство не набуде чинності до 2024 року, воно демонструє серйозність загрози технології deepfake.

Кенна Хьюз-Кастлберрі є штатним автором Inside Quantum Technology і науковим комунікатором JILA (партнерство між Університетом Колорадо в Боулдері та NIST). Її ритми написання включають глибинні технології, метавсесвіт і квантові технології.