За останні кілька років онлайн-освітні платформи спостерігали збільшення запровадження та зростання попиту на навчання на основі відео, оскільки воно пропонує ефективне середовище для залучення учнів. Щоб вийти на міжнародні ринки та звернути увагу на культурно та лінгвістично різноманітне населення, компанії також шукають можливість урізноманітнити свої навчальні пропозиції шляхом локалізації вмісту кількома мовами. Ці компанії шукають надійні та економічно ефективні способи вирішення своїх випадків локалізації.

Локалізація вмісту в основному включає переклад оригінальних голосів на нові мови та додавання візуальних засобів, таких як субтитри. Традиційно цей процес є надто дорогим, ручним і займає багато часу, включаючи роботу з фахівцями з локалізації. Завдяки потужності сервісів машинного навчання (ML) AWS, таких як Амазонська розшифровка, Amazon Translate та Амазонка Поллі, ви можете створити життєздатне та економічно ефективне рішення локалізації. Ви можете використовувати Amazon Transcribe, щоб створити стенограму наявних аудіо- та відеопотоків, а потім перекласти цю стенограму кількома мовами за допомогою Amazon Translate. Потім ви можете використовувати Amazon Polly, службу перетворення тексту в мовлення, щоб перетворити перекладений текст на природно звучачу людську мову.

Наступним кроком локалізації є додавання субтитрів до вмісту, що може покращити доступність і розуміння, а також допомогти глядачам краще зрозуміти відео. Створення субтитрів у відеоконтенті може бути складним, оскільки переклад мови не збігається з оригінальним мовленням. Ця синхронізація між звуком і субтитрами є критично важливою задачею, оскільки вона може відключити аудиторію від вашого вмісту, якщо вони не синхронізовані. Amazon Polly пропонує вирішення цієї проблеми шляхом увімкнення мовленнєві знаки, який можна використовувати для створення файлу субтитрів, який можна синхронізувати зі згенерованим мовним виводом.

У цій публікації ми розглядаємо рішення локалізації за допомогою служб AWS ML, де ми використовуємо оригінальне відео англійською мовою та перетворюємо його на іспанську мову. Ми також зосереджуємося на використанні мовних позначок для створення синхронізованого файлу субтитрів іспанською мовою.

Огляд рішення

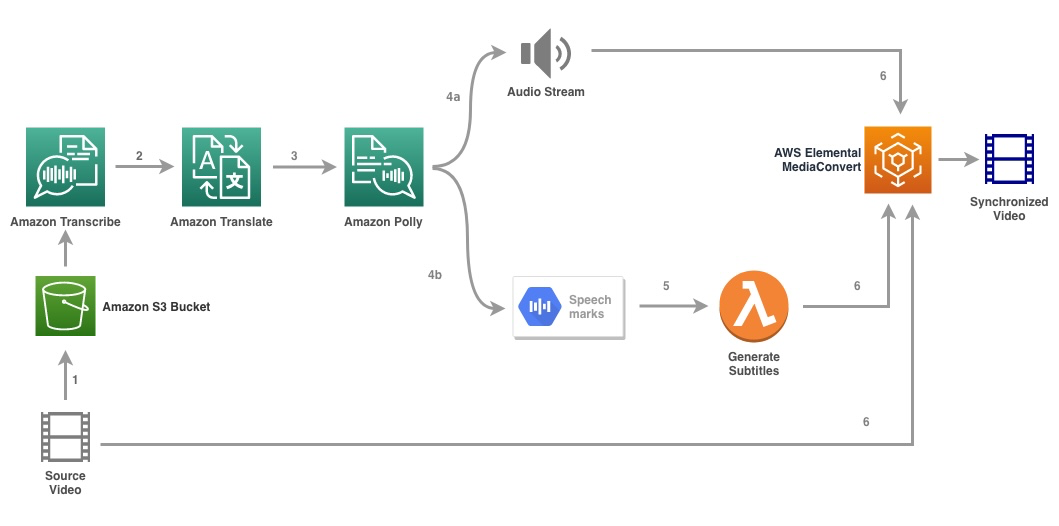

Наступна діаграма ілюструє архітектуру рішення.

Рішення приймає відеофайл і налаштування цільової мови як вхідні дані та використовує Amazon Transcribe для створення транскрипції відео. Потім ми використовуємо Amazon Translate, щоб перекласти розшифровку на цільову мову. Перекладений текст надається як вхідні дані в Amazon Polly для створення аудіопотоку та мовних позначок цільовою мовою. Amazon Polly повертається вихід мовних знаків у потоці JSON із розділеними рядками, який містить такі поля, як час, тип, початок, кінець і значення. Значення може змінюватися залежно від типу мовного знака, запитуваного у вхідних даних, наприклад SSML, вісема, слово чи речення. Для цілей нашого прикладу ми запросили тип мовного знака as word. За допомогою цього параметра Amazon Polly розбиває речення на окремі слова в реченні та час їх початку та закінчення в аудіопотоці. За допомогою цих метаданих мовні позначки потім обробляються для створення субтитрів для відповідного аудіопотоку, створеного Amazon Polly.

Нарешті використовуємо AWS Elemental MediaConvert щоб відтворити остаточне відео з перекладеним аудіо та відповідними субтитрами.

Наступне відео демонструє остаточний результат рішення:

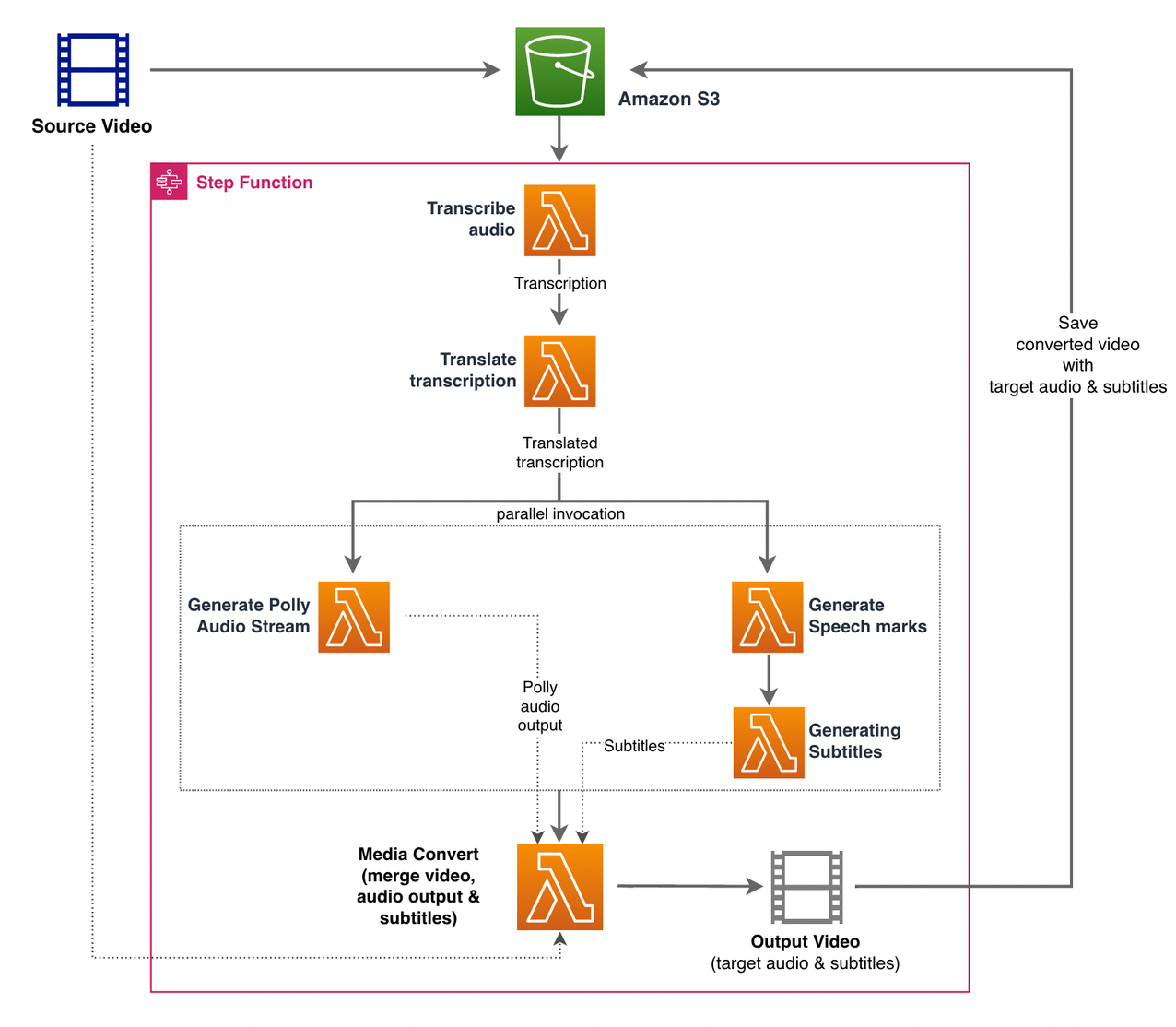

Робочий процес AWS Step Functions

Ми використовуємо Функції кроку AWS організовувати цей процес. На наступному малюнку показано високорівневе подання робочого циклу крокових функцій (деякі кроки пропущено на діаграмі для кращої ясності).

Етапи робочого процесу такі:

- Користувач завантажує вихідний відеофайл на Служба простого зберігання Amazon (Amazon S3) відро.

- Команда Сповіщення про подію S3 запускає AWS Lambda функція state_machine.py (не показано на схемі), який викликає автомат стану Step Functions.

- Перший крок, Транскрибувати аудіо, викликає функцію Лямбда transcribe.py, який використовує Amazon Transcribe для створення розшифровки аудіо з вихідного відео.

Наведений нижче приклад коду демонструє, як створити завдання транскрипції за допомогою Amazon Transcribe Бото3 Python SDK:

Після завершення завдання вихідні файли зберігаються у відро S3, і процес продовжується до наступного кроку перекладу вмісту.

- Команда Перекласти транскрипцію крок викликає функцію Лямбда translate.py який використовує Amazon Translate для перекладу розшифровки на цільову мову. Тут ми використовуємо синхронний переклад/переклад у реальному часі за допомогою переклад_тексту функція:

Синхронний переклад має обмеження щодо розміру документа, який він може перекласти; на момент написання цієї статті встановлено значення 5,000 байт. Для документів більшого розміру розгляньте можливість використання асинхронного маршруту створення завдання за допомогою start_text_translation_job і перевірити статус через describe_text_translation_job.

- Наступним кроком є крокові функції Паралельні стан, де ми створюємо паралельні гілки в нашій машині стану.

- У першій гілці ми викликаємо функцію Lambda generate_polly_audio.py щоб створити наш аудіопотік Amazon Polly:

Тут ми використовуємо почати_завдання на_синтез_мовлення Amazon Polly Python SDK для запуску завдання синтезу мовлення, яке створює аудіо Amazon Polly. Ми встановили

OutputFormatдоmp3, який повідомляє Amazon Polly створити аудіопотік для цього виклику API. - У другій гілці ми викликаємо функцію Lambda generate_speech_marks.py щоб згенерувати вихідні позначки мови:

- У першій гілці ми викликаємо функцію Lambda generate_polly_audio.py щоб створити наш аудіопотік Amazon Polly:

- Знову використовуємо почати_завдання на_синтез_мовлення метод, але вкажіть

OutputFormatдоjson, який повідомляє Amazon Polly генерувати мовні позначки для цього виклику API.

На наступному кроці другої гілки ми викликаємо функцію Lambda generate_subtitles.py, який реалізує логіку генерації файлу субтитрів із виведення мовних позначок.

Він використовує модуль Python у файлі webvtt_utils.py. Цей модуль має кілька службових функцій для створення файлу субтитрів; один із таких методів get_phrases_from_speechmarks відповідає за аналіз файлу мовних позначок. Структура мовних позначок JSON надає лише час початку для кожного слова окремо. Щоб створити хронометраж субтитрів, необхідний для файлу SRT, ми спочатку створюємо фрази приблизно з n (де n=10) слів зі списку слів у файлі мовних позначок. Потім ми записуємо їх у формат файлу SRT, беручи час початку з першого слова у фразі, а для часу закінчення ми використовуємо час початку (n+1) слова та віднімаємо його на 1, щоб створити послідовний запис . Наступна функція створює фрази для підготовки до запису їх у файл SRT:

- Останній крок, Медіа Конвертувати, викликає функцію Лямбда create_mediaconvert_job.py щоб об’єднати аудіопотік із Amazon Polly і файл субтитрів із вихідним відеофайлом для створення остаточного вихідного файлу, який потім зберігається у відрі S3. Цей крок використовує

MediaConvert, служба перекодування відео на основі файлів із функціями трансляції. Він дозволяє легко створювати вміст відео на вимогу та поєднує розширені відео та аудіо можливості з простим веб-інтерфейсом. Тут ми знову використовуємо Python Бото3 SDK для створення aMediaConvertробота:

Передумови

Перш ніж почати, у вас повинні бути такі передумови:

Розгорніть рішення

Щоб розгорнути рішення за допомогою AWS CDK, виконайте такі дії:

- Клонуйте Сховище:

- Щоб переконатися, що AWS CDK є завантажений, запустіть команду

cdk bootstrapз кореня сховища: - Змініть робочий каталог на корінь сховища та виконайте таку команду:

За замовчуванням для параметрів цільового аудіо встановлено іспанську (США) (es-US). Якщо ви плануєте перевірити його з іншою цільовою мовою, скористайтеся такою командою:

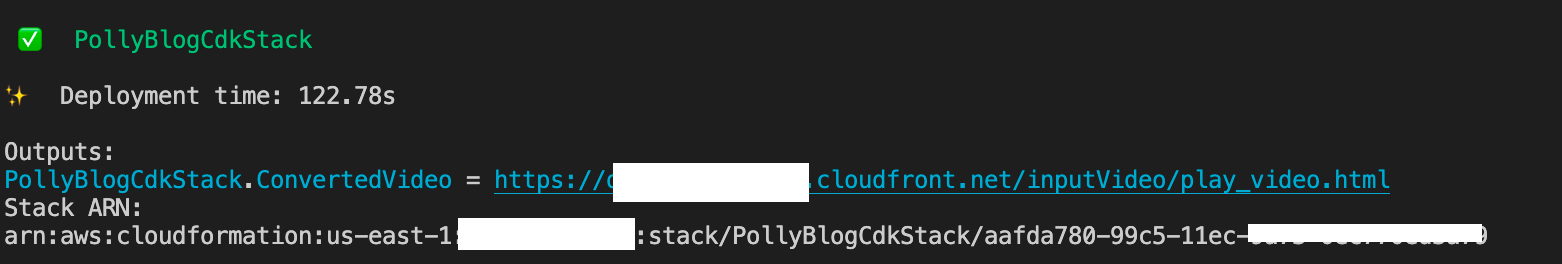

Процес триває кілька хвилин, після чого відображається посилання, за яким можна переглянути цільовий відеофайл із перекладеним аудіо та перекладеними субтитрами.

Перевірте розчин

Щоб перевірити це рішення, ми використали невелику частину наведеного нижче Відео AWS re:Invent 2017 з YouTube, де вперше було представлено Amazon Transcribe. Ви також можете перевірити рішення за допомогою власного відео. Оригінальна мова нашого тестового відео – англійська. Під час розгортання цього рішення можна вказати параметри цільового аудіо або використати параметри цільового аудіо за замовчуванням, які використовують іспанську мову для створення аудіо та субтитрів. Рішення створює сегмент S3, який можна використовувати для завантаження відеофайлу.

- На консолі Amazon S3 перейдіть до сегмента

PollyBlogBucket.

- Виберіть відро, перейдіть до

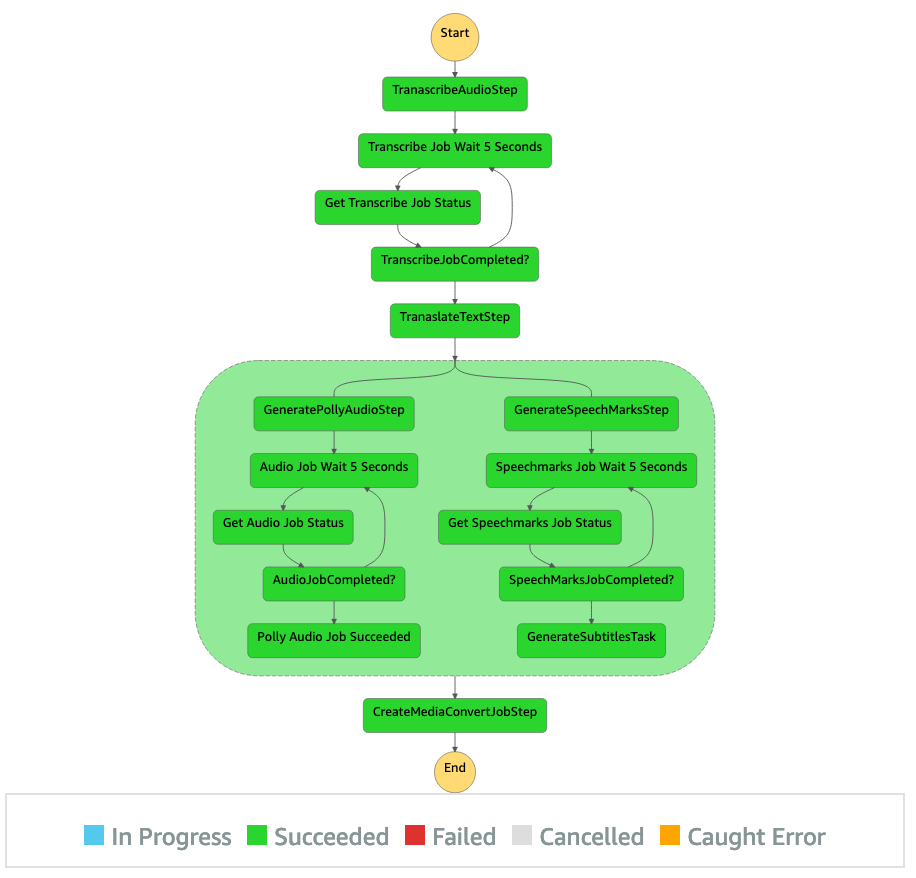

/inputVideoі завантажте відеофайл (рішення перевірено з відео типу mp4). У цей момент сповіщення про подію S3 запускає функцію Lambda, яка запускає кінцевий автомат. - На консолі Step Functions перейдіть до кінцевого автомата (

ProcessAudioWithSubtitles). - Виберіть один із запусків кінцевого автомата, щоб знайти Інспектор графів.

Це показує результати запуску для кожного стану. Робочий цикл функцій кроку займає кілька хвилин, після чого ви можете перевірити, чи всі кроки виконано успішно.

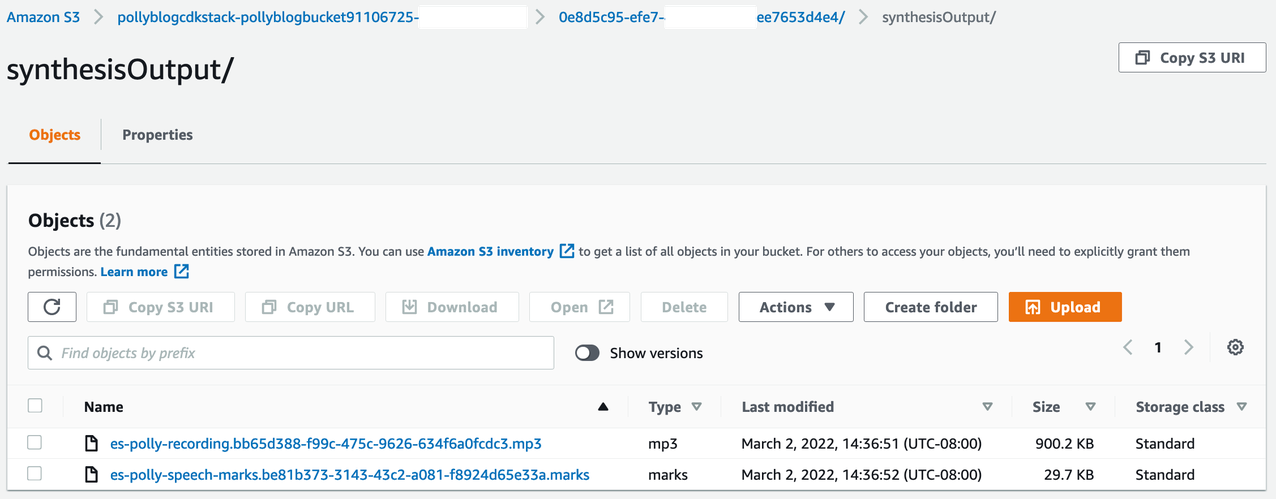

Перегляньте результат

Щоб переглянути результат, відкрийте консоль Amazon S3 і перевірте, чи аудіофайл (.mp3) і файл мовної позначки (.marks) зберігаються у відрі S3 у розділі <ROOT_S3_BUCKET>/<UID>/synthesisOutput/.

Нижче наведено зразок файлу мовних позначок, згенерованого з перекладеного тексту:

У цьому виводі кожна частина тексту розбита на мовні знаки:

- час – Мітка часу в мілісекундах від початку відповідного аудіопотоку

- тип – Тип мовного знака (речення, слово, візема або SSML)

- старт – Зсув у байтах (не символах) початку об’єкта у вхідному тексті (не враховуючи позначки візем)

- кінець – Зсув у байтах (не символах) кінця об’єкта у вхідному тексті (не враховуючи позначки візем)

- значення – Окремі слова в реченні

Згенерований файл субтитрів записується назад у відро S3. Ви можете знайти файл під <ROOT_S3_BUCKET>/<UID>/subtitlesOutput/. Перегляньте файл субтитрів; зміст має бути схожим на наступний текст:

Після створення файлу субтитрів і аудіофайлу за допомогою MediaConvert створюється остаточний вихідний відеофайл. Перевірте консоль MediaConvert, щоб перевірити, чи є статус завдання COMPLETE.

Після завершення завдання MediaConvert створюється остаточний відеофайл і зберігається назад у відро S3, яке можна знайти під <ROOT_S3_BUCKET>/<UID>/convertedAV/.

У рамках цього розгортання остаточне відео розповсюджується через an Amazon CloudFront (CDN) і відображається в терміналі або в AWS CloudFormation Консоль.

Відкрийте URL-адресу в браузері, щоб переглянути оригінальне відео з додатковими параметрами аудіо та субтитрів. Ви можете перевірити, чи синхронізовано перекладене аудіо та субтитри.

Висновок

У цій публікації ми обговорили, як створити нові мовні версії відеофайлів без необхідності втручання вручну. Творці вмісту можуть використовувати цей процес для синхронізації звуку та субтитрів своїх відео та охоплення глобальної аудиторії.

Ви можете легко інтегрувати цей підхід у власні виробничі лінії, щоб обробляти великі обсяги та масштабувати відповідно до ваших потреб. Amazon Поллі використовує Neural TTS (NTTS) створювати природні та схожі на людські голоси тексту в мовлення. Він також підтримує генерування мови з SSML, що дає вам додатковий контроль над тим, як Amazon Polly генерує мову з наданого тексту. Amazon Polly також надає a різноманітність різних голосів кількома мовами для підтримки ваших потреб.

Почніть роботу зі службами машинного навчання AWS, відвідавши веб-сайт Сторінка продукту, або зверніться до Лабораторія рішень машинного навчання Amazon сторінка, де ви можете співпрацювати з експертами, щоб запровадити рішення машинного навчання для вашої організації.

Додаткові ресурси

Щоб отримати додаткові відомості про служби, які використовуються в цьому рішенні, див.

Про авторів

Рейган Розаріо працює архітектором рішень в AWS, зосереджуючись на компаніях освітніх технологій. Йому подобається допомагати клієнтам створювати масштабовані, високодоступні та безпечні рішення в хмарі AWS. Він має більш ніж десятирічний досвід роботи на різних технологічних посадах, зосереджуючись на розробці програмного забезпечення та архітектурі.

Рейган Розаріо працює архітектором рішень в AWS, зосереджуючись на компаніях освітніх технологій. Йому подобається допомагати клієнтам створювати масштабовані, високодоступні та безпечні рішення в хмарі AWS. Він має більш ніж десятирічний досвід роботи на різних технологічних посадах, зосереджуючись на розробці програмного забезпечення та архітектурі.

Аніл Кодалі є архітектором рішень Amazon Web Services. Він працює з клієнтами AWS EdTech, навчаючи їх найкращими архітектурними методами переміщення наявних робочих навантажень у хмару та проектування нових робочих навантажень із підходом, орієнтованим на хмару. До того, як приєднатися до AWS, він працював з великими роздрібними торговцями, щоб допомогти їм з міграцією в хмару.

Аніл Кодалі є архітектором рішень Amazon Web Services. Він працює з клієнтами AWS EdTech, навчаючи їх найкращими архітектурними методами переміщення наявних робочих навантажень у хмару та проектування нових робочих навантажень із підходом, орієнтованим на хмару. До того, як приєднатися до AWS, він працював з великими роздрібними торговцями, щоб допомогти їм з міграцією в хмару.

Прасанна Сарасваті Крішнан є архітектором рішень Amazon Web Services, який працює з клієнтами EdTech. Він допомагає їм розвивати їхню хмарну архітектуру та стратегію даних, використовуючи найкращі практики. Його досвід роботи в області розподілених обчислень, аналітики великих даних та розробки даних. Він захоплюється машинним навчанням і обробкою природної мови.

Прасанна Сарасваті Крішнан є архітектором рішень Amazon Web Services, який працює з клієнтами EdTech. Він допомагає їм розвивати їхню хмарну архітектуру та стратегію даних, використовуючи найкращі практики. Його досвід роботи в області розподілених обчислень, аналітики великих даних та розробки даних. Він захоплюється машинним навчанням і обробкою природної мови.

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- Лабораторія рішень Amazon ML

- Амазонка Поллі

- Амазонська розшифровка

- Amazon Translate

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- AWS Машинне навчання

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- зефірнет