Amazon SageMaker дозволяє легко розгортати моделі машинного навчання (ML) для висновків у реальному часі та пропонує широкий вибір екземплярів ML, що охоплюють процесори та прискорювачі, такі як AWS Inferentia. Як повністю керований сервіс ви можете масштабувати розгортання моделей, мінімізувати витрати на висновки та ефективніше керувати своїми моделями у виробництві зі зменшенням операційного навантаження. Кінцева точка висновку SageMaker у реальному часі складається з кінцевої точки HTTPs та екземплярів ML, які розгортаються в кількох зонах доступності для високої доступності. SageMaker автомасштабування програми може динамічно регулювати кількість екземплярів ML, наданих для моделі, у відповідь на зміни робочого навантаження. Кінцева точка рівномірно розподіляє вхідні запити до екземплярів ML за допомогою циклічного алгоритму.

Коли моделі ML, розгорнуті в екземплярах, отримують виклики API від великої кількості клієнтів, випадковий розподіл запитів може працювати дуже добре, коли ваші запити та відповіді не відрізняються. Але в системах із генеративним робочим навантаженням ШІ запити та відповіді можуть бути дуже різними. У цих випадках часто бажано балансувати навантаження, враховуючи потужність і використання екземпляра, а не випадкове балансування навантаження.

У цьому дописі ми обговорюємо стратегію маршрутизації найменших запитів (LOR) SageMaker і те, як вона може мінімізувати затримку для певних типів робочих навантажень із висновками в реальному часі, беручи до уваги ємність і використання екземплярів ML. Ми говоримо про його переваги перед механізмом маршрутизації за замовчуванням і про те, як можна ввімкнути LOR для розгортання моделі. Нарешті, ми представляємо порівняльний аналіз покращень затримки за допомогою LOR порівняно зі стратегією маршрутизації за замовчуванням випадкової маршрутизації.

Стратегія LOR SageMaker

За замовчуванням кінцеві точки SageMaker мають стратегію випадкової маршрутизації. Тепер SageMaker підтримує стратегію LOR, яка дозволяє SageMaker оптимально направляти запити до примірника, який найкраще підходить для обслуговування цього запиту. SageMaker робить це можливим, відстежуючи навантаження екземплярів за вашою кінцевою точкою та моделі або компоненти висновків, які розгортаються на кожному екземплярі.

На наступній інтерактивній діаграмі показано політику маршрутизації за замовчуванням, коли запити, що надходять до кінцевих точок моделі, у випадковому порядку пересилаються до екземплярів ML.

Наступна інтерактивна діаграма показує стратегію маршрутизації, де SageMaker направлятиме запит до екземпляра, який має найменшу кількість невиконаних запитів.

Загалом маршрутизація LOR добре працює для базових моделей або генеративних моделей ШІ, коли ваша модель відповідає від сотень мілісекунд до хвилин. Якщо відповідь вашої моделі має меншу затримку (до сотень мілісекунд), ви можете отримати більше переваг від випадкової маршрутизації. Незважаючи на це, ми рекомендуємо вам протестувати та визначити найкращий алгоритм маршрутизації для ваших робочих навантажень.

Як налаштувати стратегії маршрутизації SageMaker

Тепер SageMaker дозволяє встановити RoutingStrategy під час створення EndpointConfiguration для кінцевих точок. Різні RoutingStrategy SageMaker підтримує такі значення:

LEAST_OUTSTANDING_REQUESTSRANDOM

Нижче наведено приклад розгортання моделі на кінцевій точці висновку, у якій увімкнено LOR:

- Створіть конфігурацію кінцевої точки за допомогою налаштування

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Створіть кінцеву точку за допомогою конфігурації кінцевої точки (без змін):

Результати роботи

Ми провели порівняльний аналіз продуктивності, щоб виміряти затримку наскрізного висновку та пропускну здатність codegen2-7B модель, розміщена на екземплярах ml.g5.24xl із маршрутизацією за замовчуванням і кінцевими точками розумної маршрутизації. Модель CodeGen2 належить до сімейства авторегресійних мовних моделей і генерує виконуваний код, коли отримує підказки англійською мовою.

У нашому аналізі ми збільшили кількість екземплярів ml.g5.24xl за кожною кінцевою точкою для кожного тестового запуску, оскільки кількість одночасних користувачів збільшувалася, як показано в наведеній нижче таблиці.

| Тест | Кількість одночасних користувачів | Кількість екземплярів |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

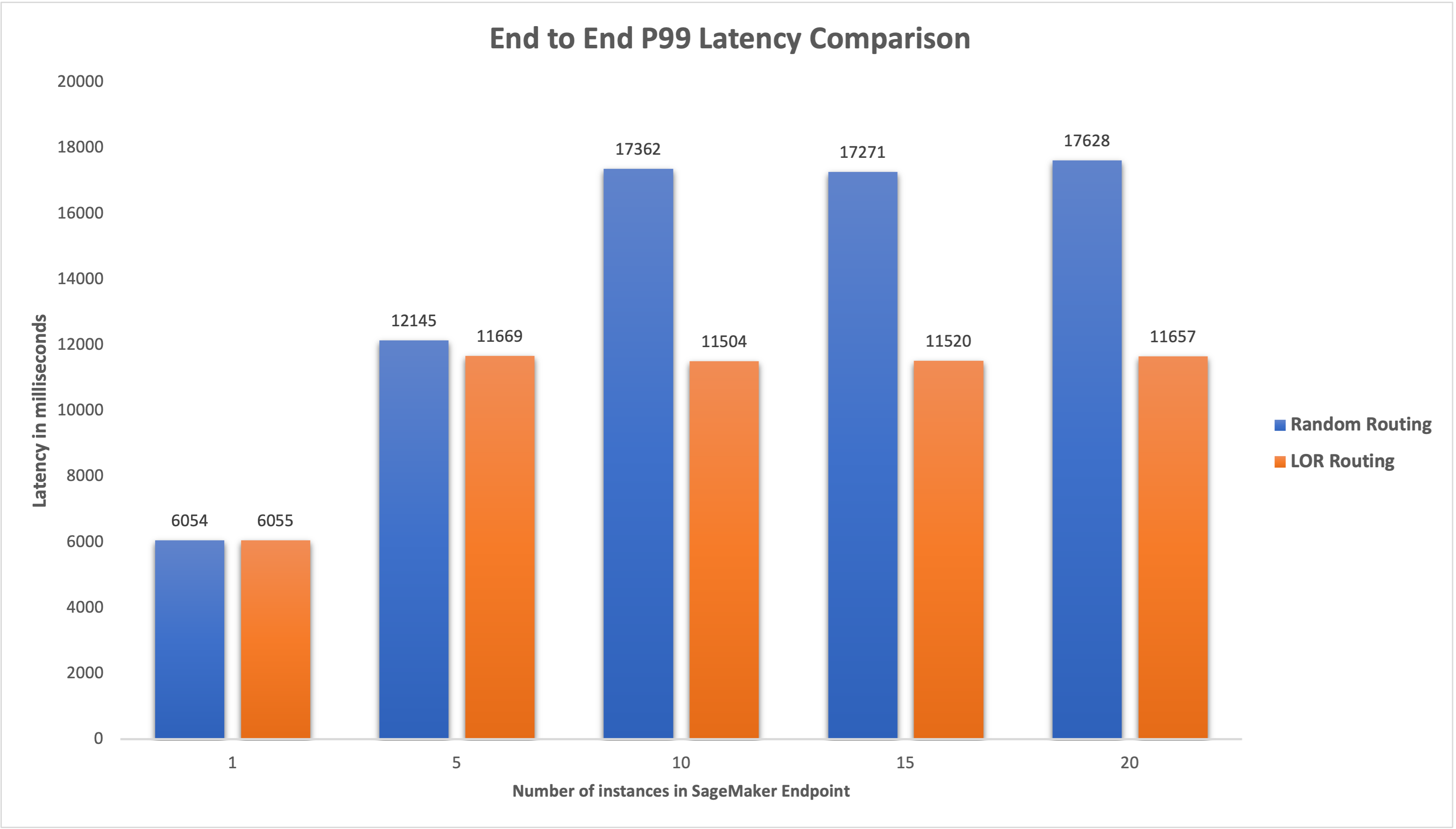

Ми виміряли наскрізну затримку P99 для обох кінцевих точок і спостерігали покращення затримки на 4–33%, коли кількість екземплярів було збільшено з 5 до 20, як показано на наступному графіку.

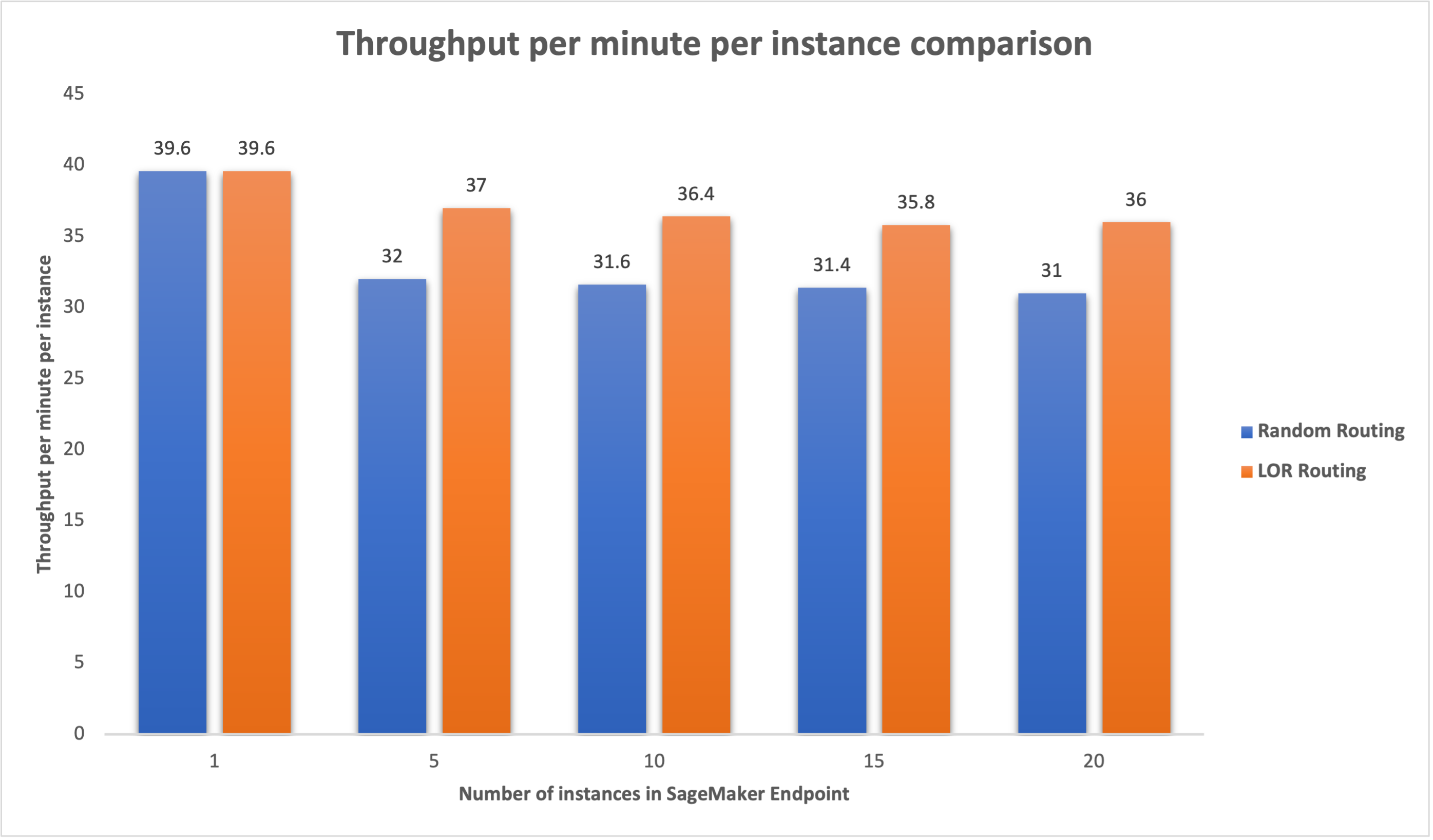

Подібним чином ми спостерігали підвищення пропускної здатності на хвилину на екземпляр на 15–16%, коли кількість екземплярів було збільшено з 5 до 20.

Це свідчить про те, що інтелектуальна маршрутизація може покращити розподіл трафіку між кінцевими точками, що призводить до покращення наскрізної затримки та загальної пропускної здатності.

Висновок

У цій публікації ми пояснили стратегії маршрутизації SageMaker і нову опцію для ввімкнення маршрутизації LOR. Ми пояснили, як увімкнути LOR і яку користь це може принести розгортанню ваших моделей. Наші тести продуктивності показали покращення затримки та пропускної здатності під час висновків у реальному часі. Щоб дізнатися більше про функції маршрутизації SageMaker, див документація. Ми заохочуємо вас оцінити ваші робочі навантаження на висновки та визначити, чи оптимально ви налаштовані зі стратегією маршрутизації.

Про авторів

Джеймс Парк є архітектором рішень в Amazon Web Services. Він працює з Amazon.com над проектуванням, створенням і розгортанням технологічних рішень на AWS, і особливо цікавиться ШІ та машинним навчанням. У вільний час він любить шукати нові культури, нові враження та бути в курсі останніх технологічних тенденцій. Ви можете знайти його на LinkedIn.

Джеймс Парк є архітектором рішень в Amazon Web Services. Він працює з Amazon.com над проектуванням, створенням і розгортанням технологічних рішень на AWS, і особливо цікавиться ШІ та машинним навчанням. У вільний час він любить шукати нові культури, нові враження та бути в курсі останніх технологічних тенденцій. Ви можете знайти його на LinkedIn.

Венугопал Пай є архітектором рішень в AWS. Він живе в Бенгалуру, Індія, і допомагає цифровим клієнтам масштабувати й оптимізувати свої програми на AWS.

Венугопал Пай є архітектором рішень в AWS. Він живе в Бенгалуру, Індія, і допомагає цифровим клієнтам масштабувати й оптимізувати свої програми на AWS.

Девід Нігенда є старшим інженером з розробки програмного забезпечення в команді Amazon SageMaker, зараз працює над удосконаленням робочих процесів машинного навчання виробництва, а також над запуском нових функцій висновків. У вільний час він намагається не відставати від своїх дітей.

Девід Нігенда є старшим інженером з розробки програмного забезпечення в команді Amazon SageMaker, зараз працює над удосконаленням робочих процесів машинного навчання виробництва, а також над запуском нових функцій висновків. У вільний час він намагається не відставати від своїх дітей.

Діпті Рага є інженером з розробки програмного забезпечення в команді Amazon SageMaker. Її поточна робота зосереджена на створенні функцій для ефективного розміщення моделей машинного навчання. У вільний час вона любить подорожувати, ходити в походи та вирощує рослини.

Діпті Рага є інженером з розробки програмного забезпечення в команді Amazon SageMaker. Її поточна робота зосереджена на створенні функцій для ефективного розміщення моделей машинного навчання. У вільний час вона любить подорожувати, ходити в походи та вирощує рослини.

Алан Тан є старшим менеджером із продуктів у SageMaker, керуючи зусиллями з виведення великих моделей. Він захоплений застосуванням машинного навчання в галузі аналітики. Поза роботою він любить прогулянки на природі.

Алан Тан є старшим менеджером із продуктів у SageMaker, керуючи зусиллями з виведення великих моделей. Він захоплений застосуванням машинного навчання в галузі аналітики. Поза роботою він любить прогулянки на природі.

Дхавал Патель є головним архітектором машинного навчання в AWS. Він працював з організаціями, починаючи від великих підприємств і закінчуючи стартапами середнього розміру, над проблемами, пов’язаними з розподіленими обчисленнями та штучним інтелектом. Він зосереджується на глибокому навчанні, включаючи домени НЛП та комп’ютерного зору. Він допомагає клієнтам досягти високопродуктивної моделі висновку на SageMaker.

Дхавал Патель є головним архітектором машинного навчання в AWS. Він працював з організаціями, починаючи від великих підприємств і закінчуючи стартапами середнього розміру, над проблемами, пов’язаними з розподіленими обчисленнями та штучним інтелектом. Він зосереджується на глибокому навчанні, включаючи домени НЛП та комп’ютерного зору. Він допомагає клієнтам досягти високопродуктивної моделі висновку на SageMaker.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- : має

- :є

- : ні

- :де

- $UP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- Здатний

- МЕНЮ

- прискорювачі

- Achieve

- через

- AI

- Моделі AI

- Алан

- алгоритм

- дозволяє

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- серед

- an

- аналіз

- аналітика

- та

- API

- застосування

- Застосування

- ЕСТЬ

- ПЛОЩА

- штучний

- штучний інтелект

- AS

- At

- автоматичний

- наявність

- AWS

- Balance

- Балансування

- BE

- за

- належить

- бенчмаркінг

- користь

- Переваги

- КРАЩЕ

- обидва

- широкий

- будувати

- Створюємо

- тягар

- але

- by

- Виклики

- CAN

- потужність

- випадків

- певний

- зміна

- Зміни

- клієнтів

- код

- COM

- майбутній

- Компоненти

- комп'ютер

- Комп'ютерне бачення

- обчислення

- одночасно

- конфігурація

- налаштувати

- розгляду

- беручи до уваги

- складається

- витрати

- створення

- Поточний

- В даний час

- Клієнти

- Дата

- глибокий

- глибоке навчання

- дефолт

- розгортання

- розгорнути

- розгортання

- розгортання

- дизайн

- Визначати

- розробка

- різний

- обговорювати

- розподілений

- розподілені обчислення

- розподіл

- домени

- під час

- динамічно

- кожен

- фактично

- продуктивно

- зусилля

- включіть

- включений

- заохочувати

- кінець в кінець

- Кінцева точка

- інженер

- англійська

- підприємств

- оцінювати

- приклад

- Досліди

- пояснені

- надзвичайно

- сім'я

- риси

- в кінці кінців

- знайти

- фокусується

- після

- для

- фундаментальні

- від

- повністю

- Загальне

- генерує

- генеративний

- Генеративний ШІ

- GIF

- даний

- графік

- Зростання

- Мати

- he

- допомагає

- її

- Високий

- його

- його

- господар

- відбувся

- Як

- How To

- HTML

- HTTPS

- Сотні

- ідентифікувати

- if

- ілюструє

- удосконалювати

- поліпшення

- поліпшення

- поліпшення

- in

- У тому числі

- Вхідний

- збільшений

- Індію

- екземпляр

- Інтелект

- інтерактивний

- інтерес

- в

- IT

- ЙОГО

- JPG

- тримати

- Діти

- мова

- великий

- Великі підприємства

- Затримка

- останній

- запуск

- провідний

- УЧИТЬСЯ

- вивчення

- найменш

- Місце проживання

- загрузка

- серія

- знизити

- машина

- навчання за допомогою машини

- РОБОТИ

- управляти

- вдалося

- менеджер

- манера

- Може..

- вимір

- механізм

- мілісекунд

- хвилин

- хвилин

- ML

- модель

- Моделі

- моніторинг

- більше

- множинний

- Нові

- nlp

- немає

- зараз

- номер

- of

- Пропозиції

- часто

- on

- оперативний

- Оптимізувати

- варіант

- or

- організації

- наші

- з

- на відкритому повітрі

- поза

- видатний

- над

- загальний

- параметр

- приватність

- пристрасний

- для

- продуктивність

- Рослини

- plato

- Інформація про дані Платона

- PlatoData

- політика

- це можливо

- пошта

- представити

- Головний

- проблеми

- Product

- менеджер по продукції

- Production

- підказок

- випадковий

- ранжування

- швидше

- реального часу

- отримати

- рекомендувати

- Знижений

- послатися

- Незалежно

- пов'язаний

- запросити

- запитів

- відповідь

- відповіді

- Маршрут

- Маршрутизація

- прогін

- мудрець

- шкала

- пошук

- вибір

- старший

- служити

- обслуговування

- Послуги

- комплект

- установка

- вона

- показав

- показаний

- Шоу

- розумний

- Софтвер

- розробка програмного забезпечення

- Рішення

- напруга

- Стартапи

- перебування

- просто

- стратегії

- Стратегія

- такі

- Підтриманий

- Опори

- Systems

- таблиця

- взяття

- балаканина

- команда

- Технологія

- тест

- Тести

- ніж

- Що

- Команда

- Площа

- їх

- Там.

- Ці

- це

- пропускна здатність

- час

- до

- трафік

- Подорож

- Тенденції

- Типи

- користувачі

- використання

- Цінності

- змінна

- дуже

- бачення

- we

- Web

- веб-сервіси

- ДОБРЕ

- були

- коли

- який

- в той час як

- волі

- з

- Work

- працював

- Робочі процеси

- робочий

- працює

- Ти

- вашу

- зефірнет

- зони