Команди з науки та інженерії даних витрачають значну частину свого часу на етапі підготовки даних життєвого циклу машинного навчання (ML), виконуючи етапи відбору, очищення та перетворення даних. Це необхідний і важливий крок будь-якого робочого процесу ML, щоб генерувати значущі ідеї та прогнози, оскільки погані або низькоякісні дані значно знижують релевантність отриманих ідей.

Команди розробників даних традиційно відповідають за прийом, консолідацію та перетворення вихідних даних для подальшого споживання. Дослідникам даних часто доводиться виконувати додаткову обробку даних для конкретних випадків використання ML, таких як природна мова та часові ряди. Наприклад, певні алгоритми ML можуть бути чутливими до відсутніх значень, розріджених ознак або викидів і вимагати особливої уваги. Навіть у випадках, коли набір даних знаходиться в хорошому стані, науковці з даних можуть захотіти трансформувати розподіл функцій або створити нові функції, щоб максимізувати розуміння, отримане з моделей. Щоб досягти цих цілей, науковцям з даних доводиться покладатися на команди розробників даних для врахування запитуваних змін, що призводить до залежності та затримки процесу розробки моделі. Крім того, групи з наукових даних можуть вирішити виконувати підготовку даних і розробку функцій всередині, використовуючи різні парадигми програмування. Однак це вимагає інвестування часу та зусиль на встановлення та конфігурацію бібліотек і фреймворків, що не ідеально, оскільки цей час можна краще витратити на оптимізацію продуктивності моделі.

Amazon SageMaker Data Wrangler спрощує підготовку даних і процес розробки функцій, скорочуючи час, необхідний для агрегації та підготовки даних для машинного навчання з тижнів до хвилин, забезпечуючи єдиний візуальний інтерфейс для науковців з даних, щоб вибирати, очищати та досліджувати свої набори даних. Data Wrangler пропонує понад 300 вбудованих перетворень даних, які допомагають нормалізувати, трансформувати та комбінувати функції без написання будь-якого коду. Ви можете імпортувати дані з кількох джерел даних, наприклад Amazon Simple Storage Service (Amazon S3), Амазонка Афіна, Амазонська червона зміна та Сніжинка. Тепер ви також можете використовувати Збір даних як джерело даних у Data Wrangler, щоб легко підготувати дані для ML.

Платформа Databricks Lakehouse поєднує в собі найкращі елементи озер даних і сховищ даних, щоб забезпечити надійність, ефективне управління та продуктивність сховищ даних із підтримкою озер даних відкритості, гнучкості та машинного навчання. Завдяки Databricks як джерелу даних для Data Wrangler ви можете швидко й легко підключатися до Databricks, інтерактивно запитувати дані, збережені в Databricks, за допомогою SQL, і переглядати дані перед імпортуванням. Крім того, ви можете об’єднати свої дані в Databricks з даними, що зберігаються в Amazon S3, і даними, запитаними через Amazon Athena, Amazon Redshift і Snowflake, щоб створити правильний набір даних для вашого випадку використання ML.

У цій публікації ми трансформуємо набір даних кредитування кредитного клубу за допомогою Amazon SageMaker Data Wrangler для використання в навчанні моделі ML.

Огляд рішення

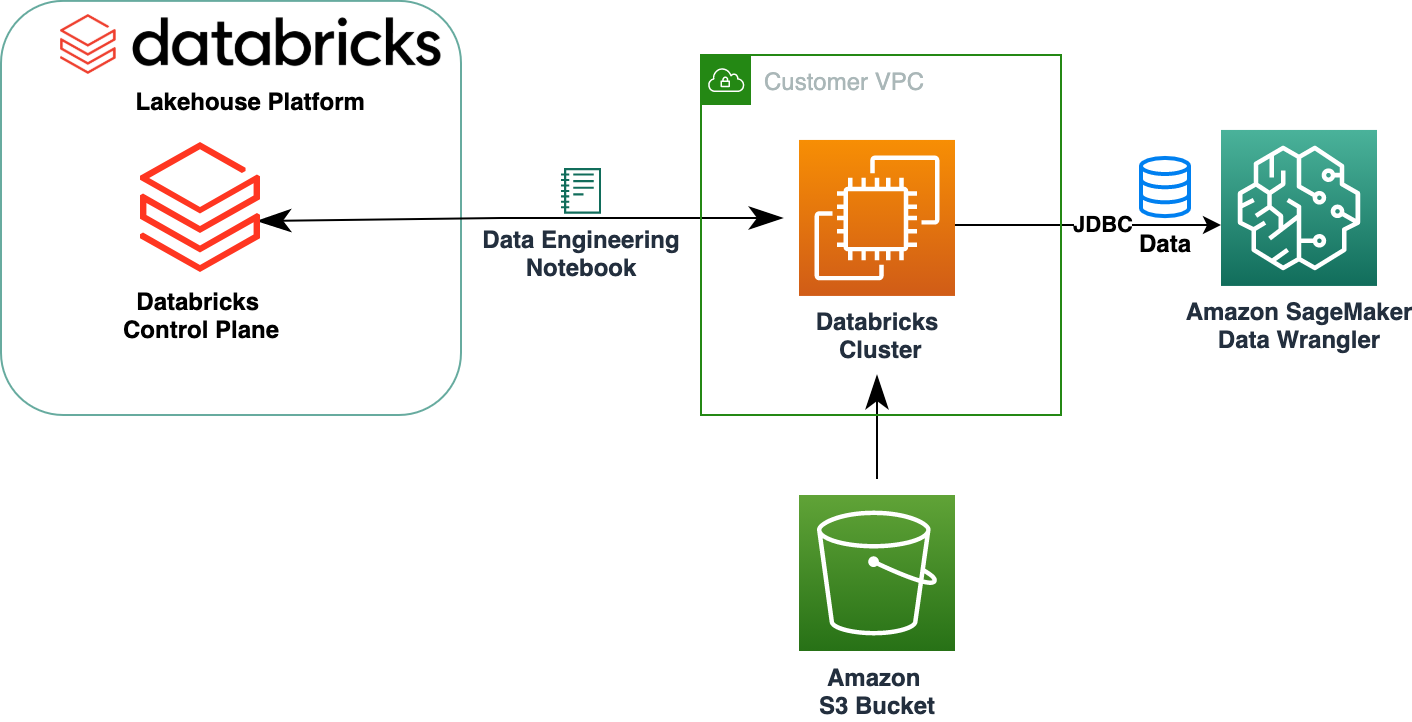

Наступна схема ілюструє нашу архітектуру рішення.

Набір даних позик Lending Club містить повні дані про позику для всіх позик, виданих протягом 2007–2011 років, включаючи поточний статус позики та інформацію про останні платежі. Він має 39,717 22 рядків, 3 стовпці об’єктів і XNUMX цільові мітки.

Щоб перетворити наші дані за допомогою Data Wrangler, ми виконуємо такі кроки високого рівня:

- Завантажте та розділіть набір даних.

- Створіть потік даних Wrangler.

- Імпортуйте дані з Databricks до Data Wrangler.

- Імпортуйте дані з Amazon S3 до Data Wrangler.

- Приєднуйтесь до даних.

- Застосувати трансформації.

- Експортуйте набір даних.

Передумови

У публікації передбачається, що у вас запущений кластер Databricks. Якщо ваш кластер працює на AWS, переконайтеся, що ви налаштували наступне:

Налаштування Databricks

- An профіль екземпляра з необхідними дозволами на доступ до сегмента S3

- A політика відра з необхідними дозволами для цільового сегмента S3

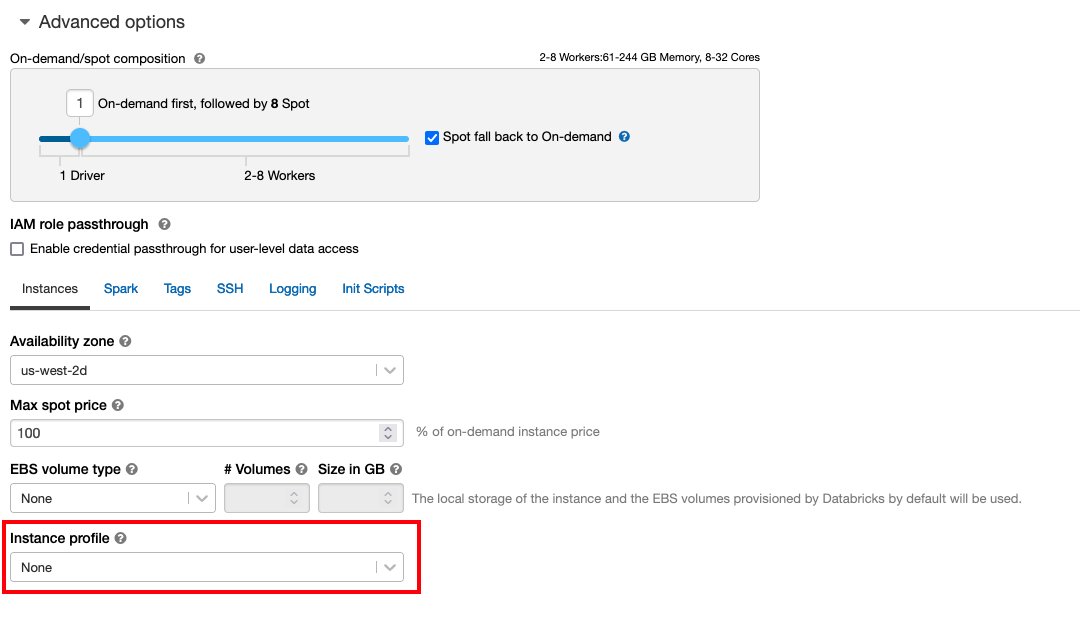

слідувати Безпечний доступ до сегментів S3 за допомогою профілів екземплярів для необхідного Управління ідентифікацією та доступом AWS (IAM), політика сегмента S3 і конфігурація кластера Databricks. Переконайтеся, що кластер Databricks налаштовано належним чином Instance Profile, вибраний у розширених параметрах, щоб отримати доступ до потрібного сегмента S3.

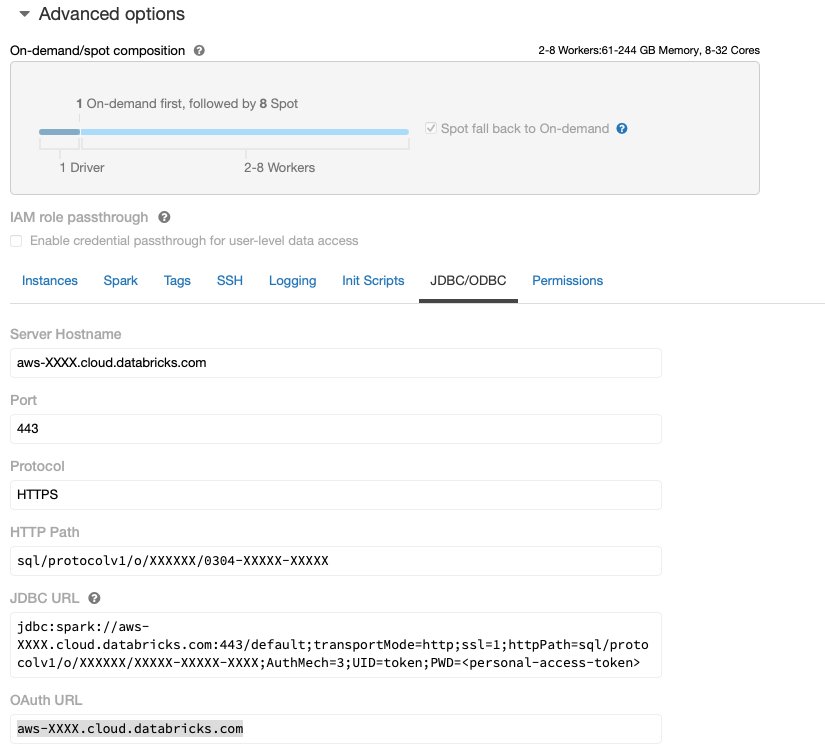

Після того, як кластер Databricks буде запущено та запущено з необхідним доступом до Amazon S3, ви можете отримати файл JDBC URL з вашого кластера Databricks, який буде використовуватися Data Wrangler для підключення до нього.

Отримати URL-адресу JDBC

Щоб отримати URL-адресу JDBC, виконайте такі дії:

- У Databricks перейдіть до інтерфейсу кластерів.

- Виберіть свій кластер.

- на конфігурація вкладку, виберіть Додаткові параметри.

- під Додаткові параметри, виберіть JDBC/ODBC Вкладка.

- Скопіюйте URL-адресу JDBC.

Обов’язково замініть особистий доступ знак в URL-адресі.

Налаштування Data Wrangler

Цей крок передбачає, що у вас є доступ до Amazon SageMaker, екземпляра Студія Amazon SageMaker, і користувач Studio.

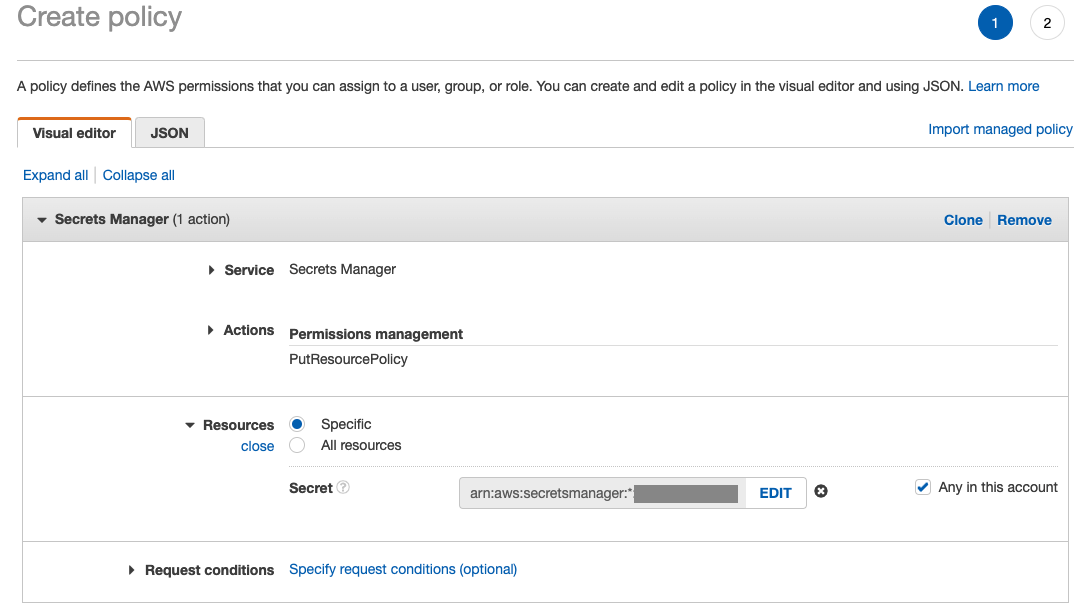

Щоб надати доступ до з’єднання Databricks JDBC із Data Wrangler, користувачу Studio потрібен такий дозвіл:

secretsmanager:PutResourcePolicy

Виконайте наведені нижче кроки, щоб оновити роль виконання IAM, призначену користувачу Studio з наведеним вище дозволом, як користувачу-адміністратора IAM.

- На консолі IAM виберіть Ролі у навігаційній панелі.

- Виберіть роль, призначену вашому користувачеві Studio.

- Вибирати Додати дозволи.

- Вибирати Створіть вбудовану політику.

- Для обслуговування виберіть Менеджер секретів.

- On Діївиберіть Рівень доступу.

- Вибирати Керування дозволами.

- Вибирати PutResourcePolicy.

- для ресурсивиберіть питома і виберіть Будь-який в цьому обліковому записі.

Завантажте та розділіть набір даних

Ви можете почати з завантаження набору даних. Для демонстраційних цілей ми розділили набір даних, скопіювавши стовпці ознак id, emp_title, emp_length, home_owner та annual_inc створити другу позики_2.csv файл. Ми видаляємо вищезгадані стовпці з оригінального файлу позик, за винятком id і перейменуйте вихідний файл у позики_1.csv. Завантажте позики_1.csv файл в Збір даних для створення таблиці loans_1 та позики_2.csv у відрі S3.

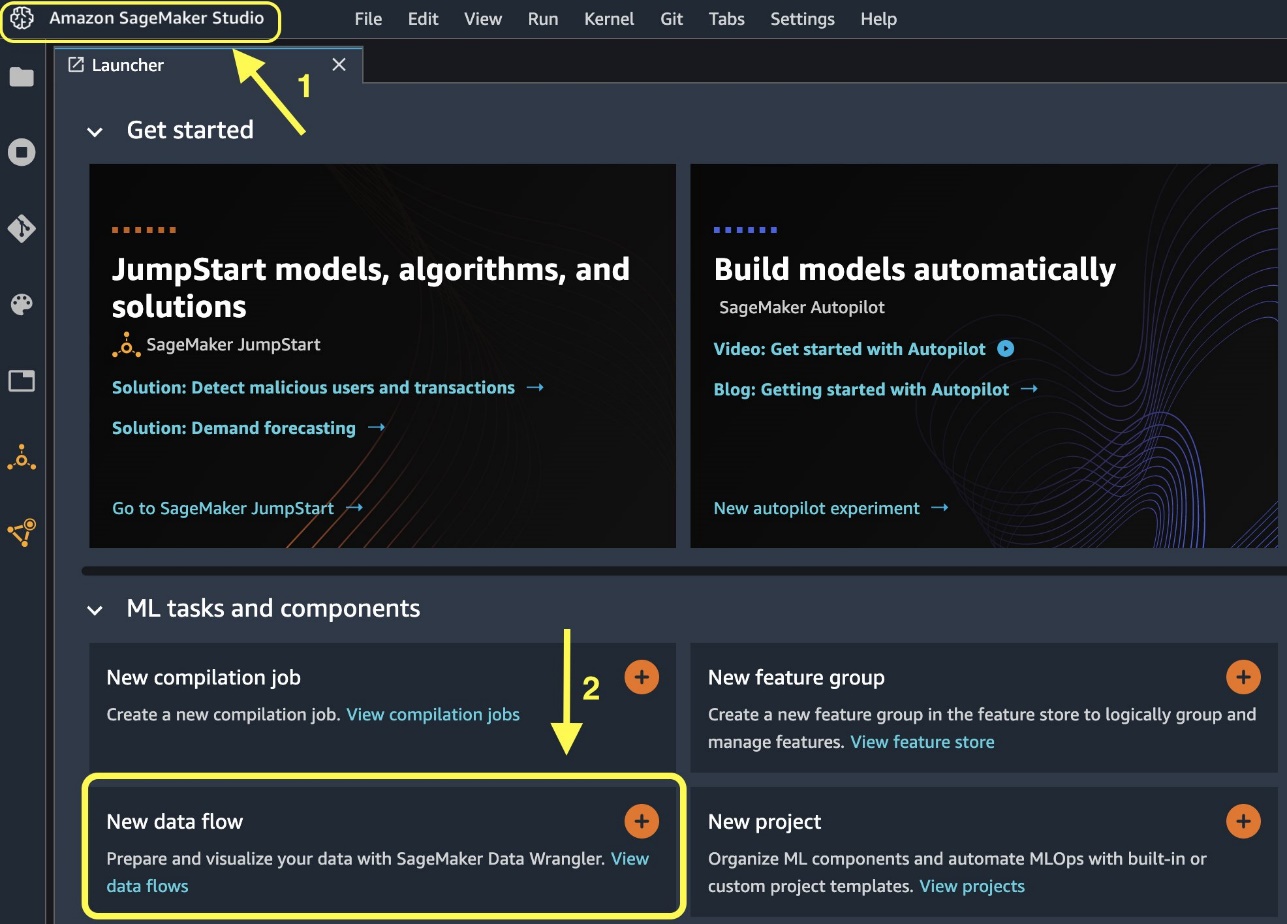

Створіть потік даних Wrangler

Інформацію про необхідні умови Data Wrangler див Почніть роботу з Data Wrangler.

Почнемо зі створення нового потоку даних.

- На консолі Studio, на філе меню, виберіть Нові.

- Вибирати Потік даних Wrangler.

- Перейменуйте потік за бажанням.

Крім того, ви можете створити новий потік даних із панелі запуску.

- На консолі Studio виберіть Студія Amazon SageMaker у навігаційній панелі.

- Вибирати Новий потік даних.

Створення нового потоку може зайняти кілька хвилин. Після створення потоку ви побачите Дати імпорту стр.

Імпортуйте дані з Databricks в Data Wrangler

Далі ми налаштуємо Databricks (JDBC) як джерело даних у Data Wrangler. Щоб імпортувати дані з Databricks, нам спочатку потрібно додати Databricks як джерело даних.

- на Дати імпорту на вкладці вашого потоку даних Wrangler виберіть Додати джерело даних.

- У спадному меню виберіть Databricks (JDBC).

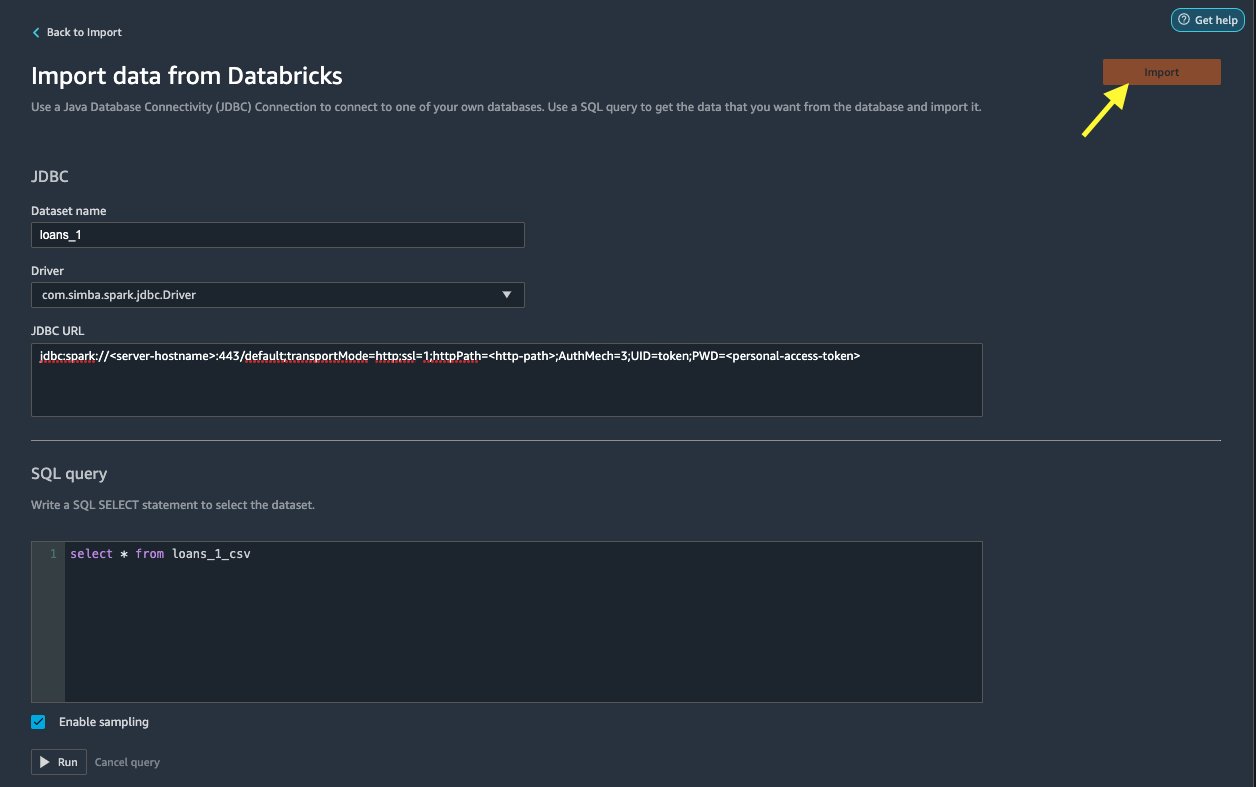

на Імпортуйте дані з Databricks на сторінці, ви вводите дані свого кластера.

- для Назва набору даних, введіть ім’я, яке потрібно використовувати у файлі потоку.

- для Водій, виберіть драйвер

com.simba.spark.jdbc.Driver. - для URL-адреса JDBC, введіть URL-адресу вашого кластера Databricks, отриману раніше.

URL-адреса має нагадувати такий формат jdbc:spark://<serve- hostname>:443/default;transportMode=http;ssl=1;httpPath=<http- path>;AuthMech=3;UID=token;PWD=<personal-access-token>.

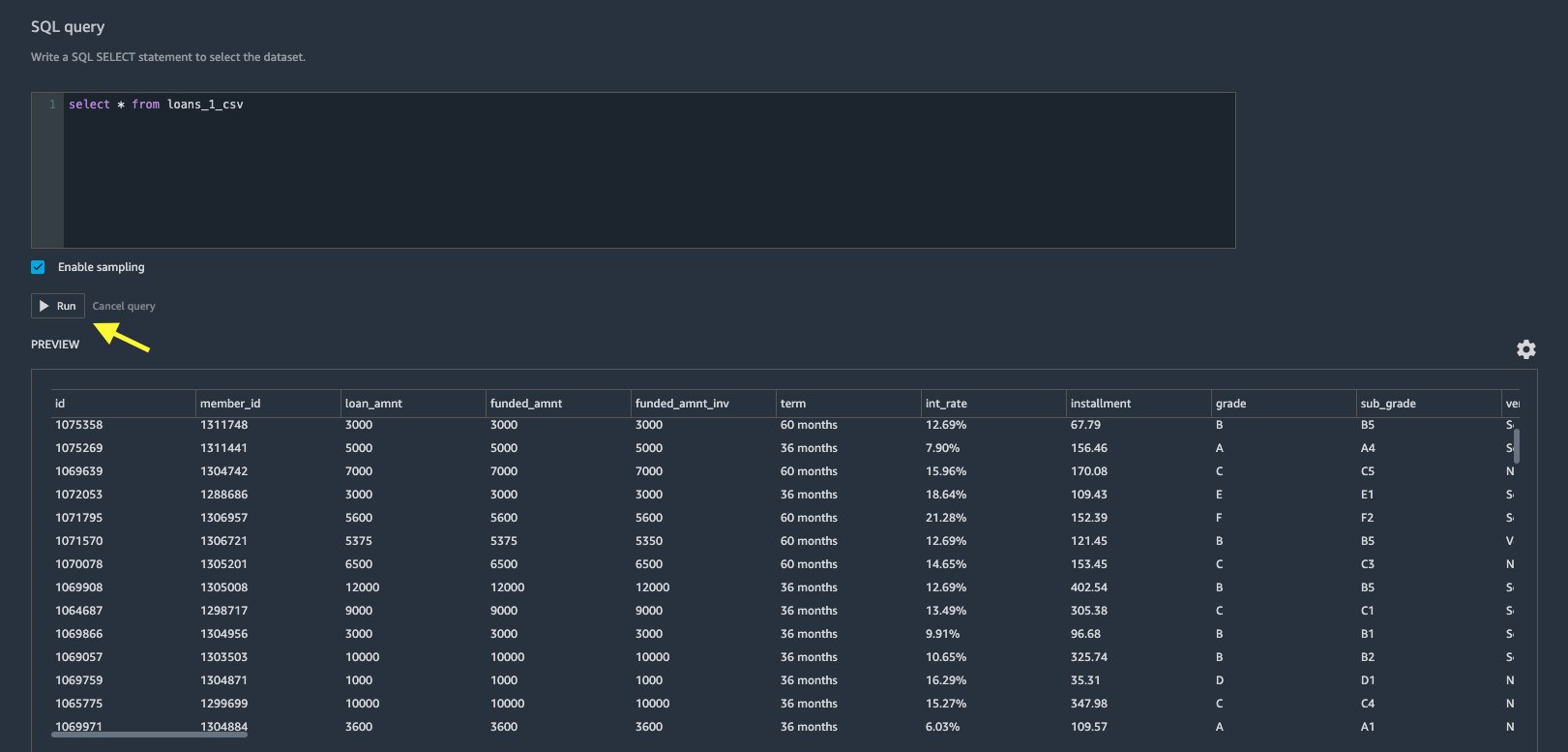

- У редакторі запитів SQL вкажіть такий оператор SQL SELECT:

Якщо ви вибрали іншу назву таблиці під час завантаження даних у Databricks, замініть loans_1 у наведеному вище запиті SQL відповідно.

У SQL query у розділі Data Wrangler, ви можете зробити запит до будь-якої таблиці, підключеної до бази даних JDBC Databricks. Попередньо відібраний Увімкнути вибірку Параметр за замовчуванням отримує перші 50,000 XNUMX рядків вашого набору даних. Залежно від розміру набору даних, зніміть вибір Увімкнути вибірку може призвести до збільшення часу імпорту.

- Вибирати прогін.

Виконання запиту дає попередній перегляд вашого набору даних Databricks безпосередньо в Data Wrangler.

Data Wrangler забезпечує гнучкість налаштування кількох одночасних з’єднань з одним кластером Databricks або кількома кластерами, якщо потрібно, що дозволяє аналізувати та підготувати об’єднані набори даних.

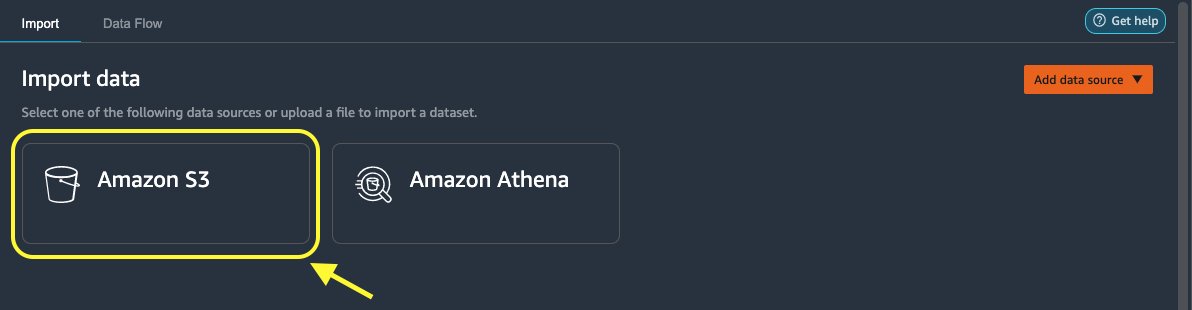

Імпортуйте дані з Amazon S3 в Data Wrangler

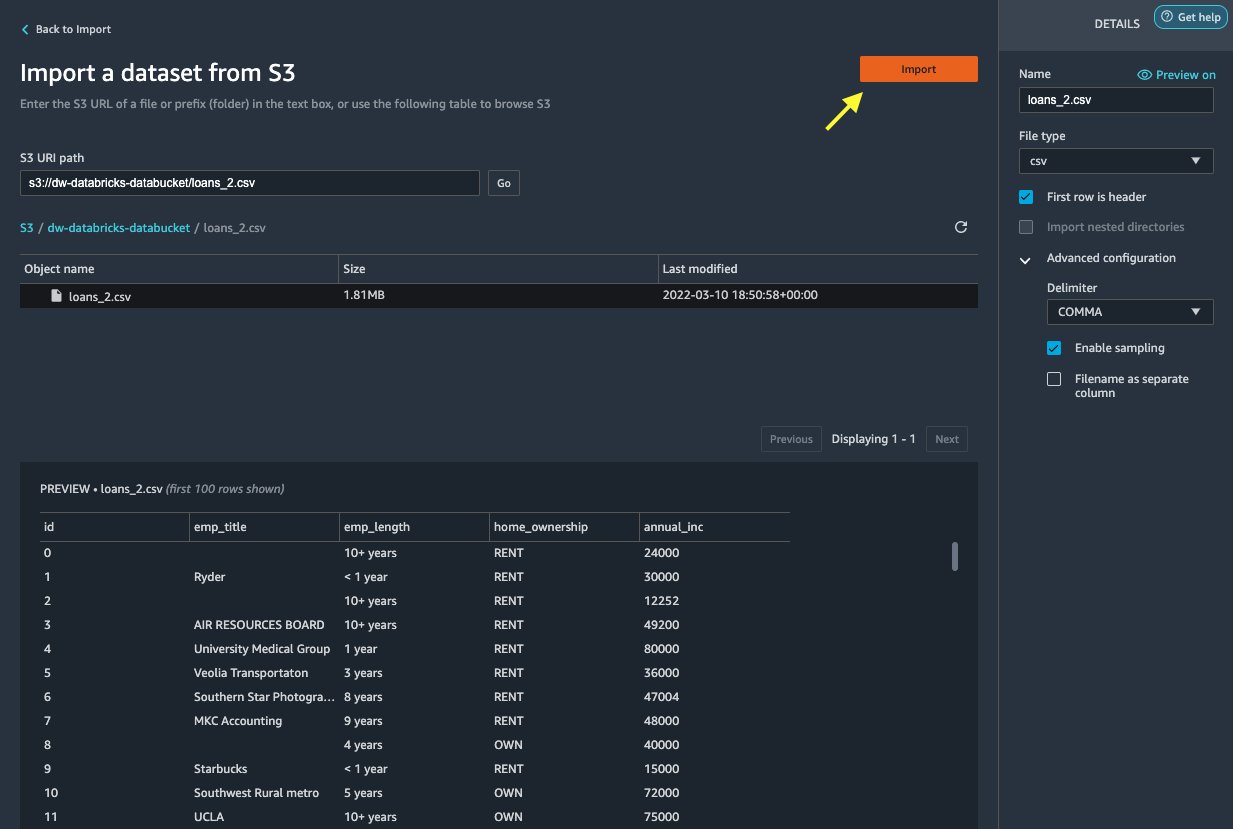

Далі давайте імпортуємо loan_2.csv файл із Amazon S3.

Вибравши файл CSV, можна попередньо переглянути дані.

- У ПОДРОБИЦІ панель, виберіть Розширена конфігурація щоб переконатися, що Увімкнути вибірку вибирається і ПАРАГРАФ вибирається для Delimiter.

- Вибирати Імпортувати.

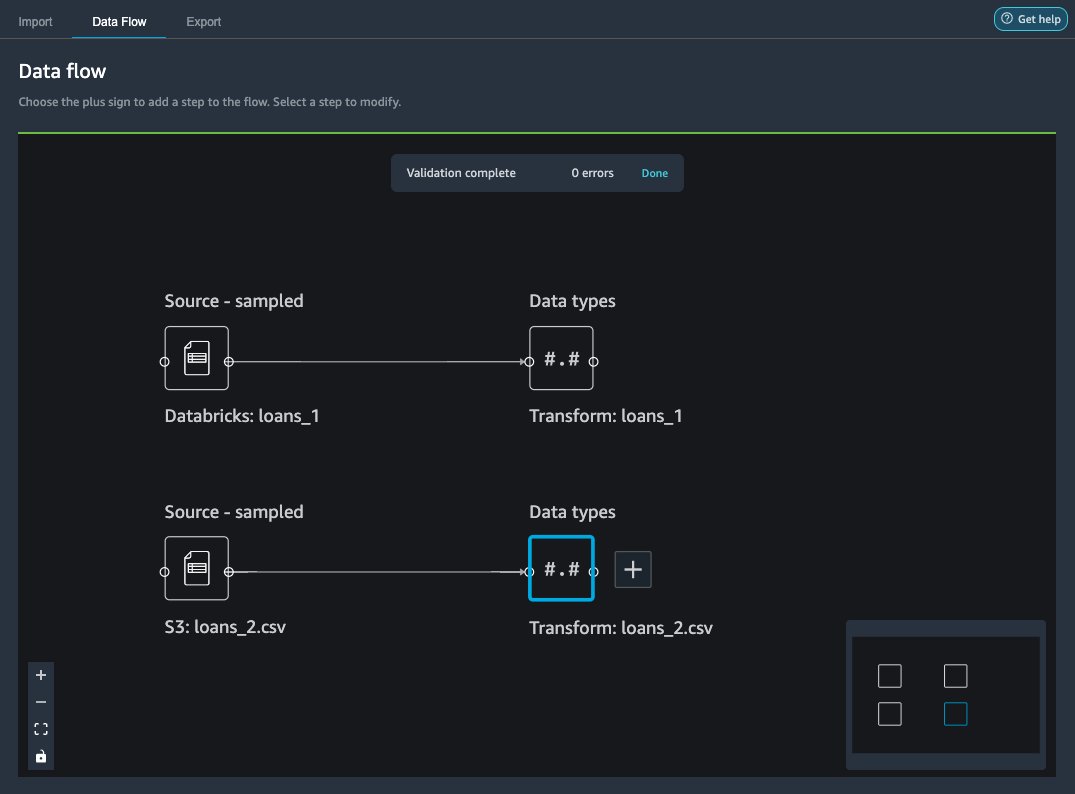

Після loans_2.csv набір даних успішно імпортовано, інтерфейс потоку даних відображає як джерела даних Databricks JDBC, так і Amazon S3.

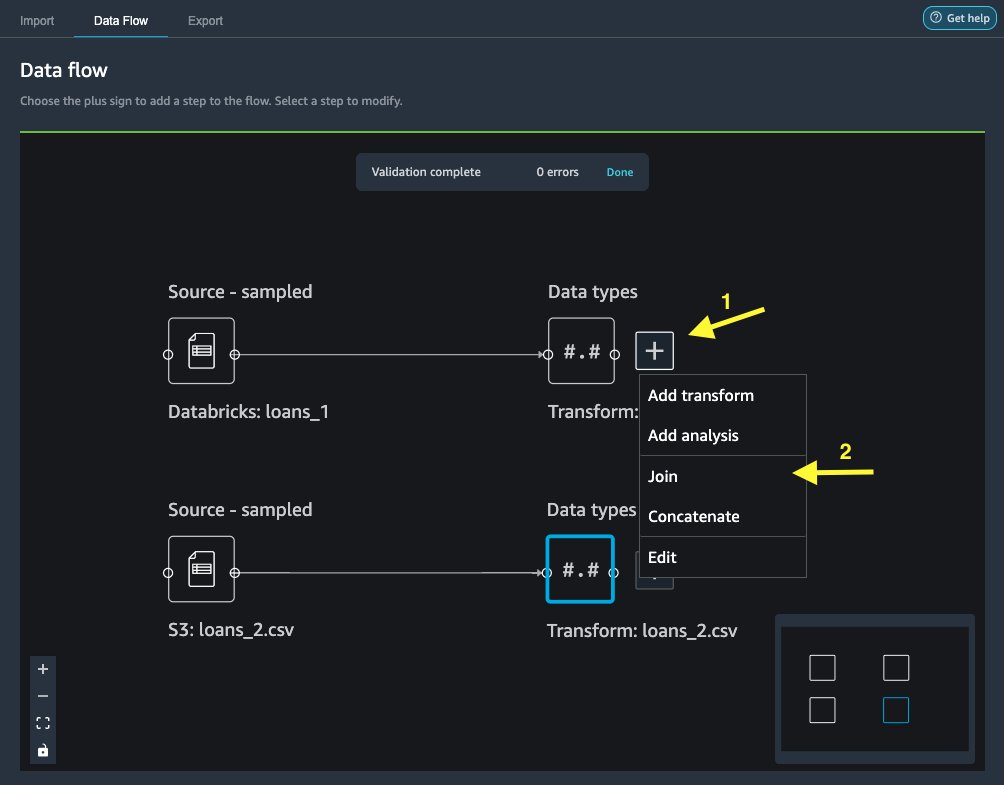

Приєднуйтесь до даних

Тепер, коли ми імпортували дані з Databricks та Amazon S3, давайте об’єднаємо набори даних за допомогою спільного стовпця унікального ідентифікатора.

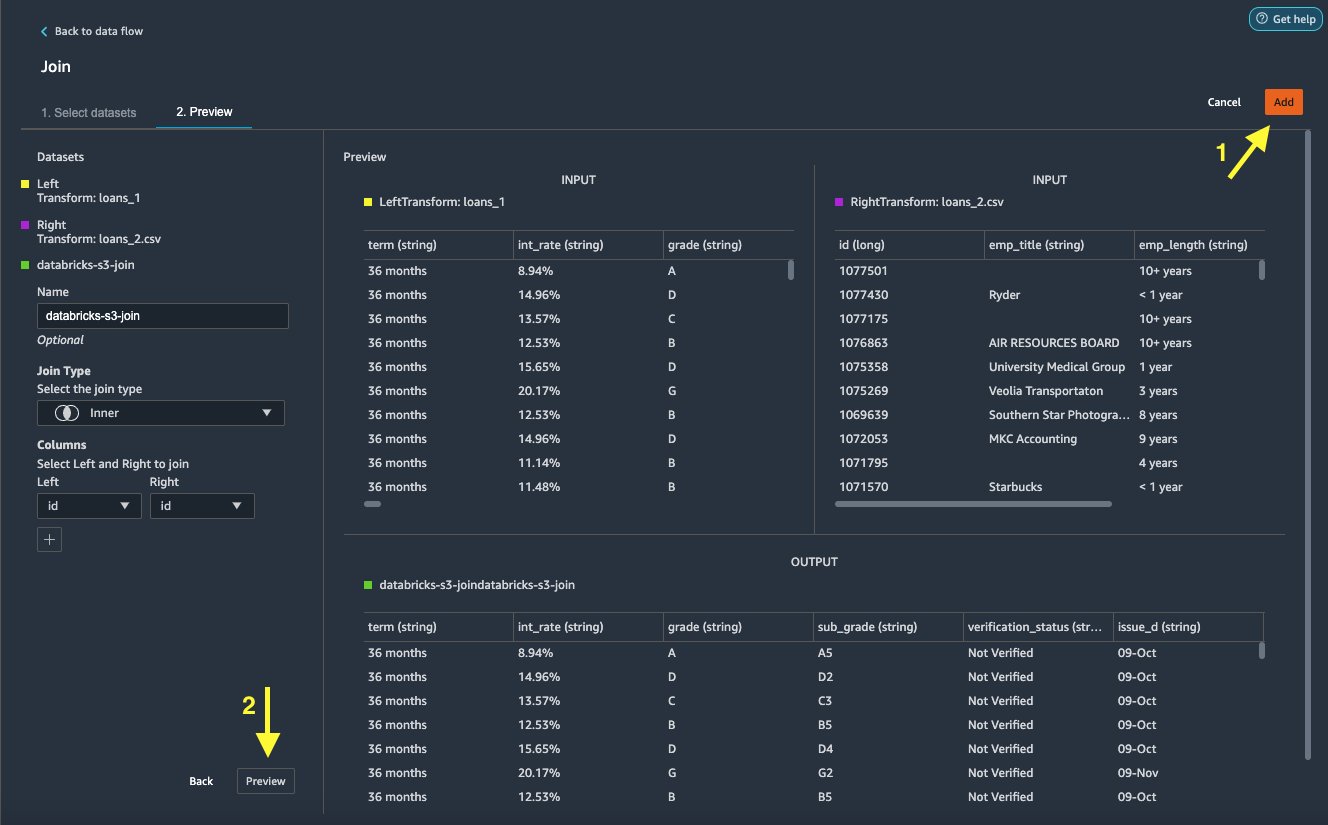

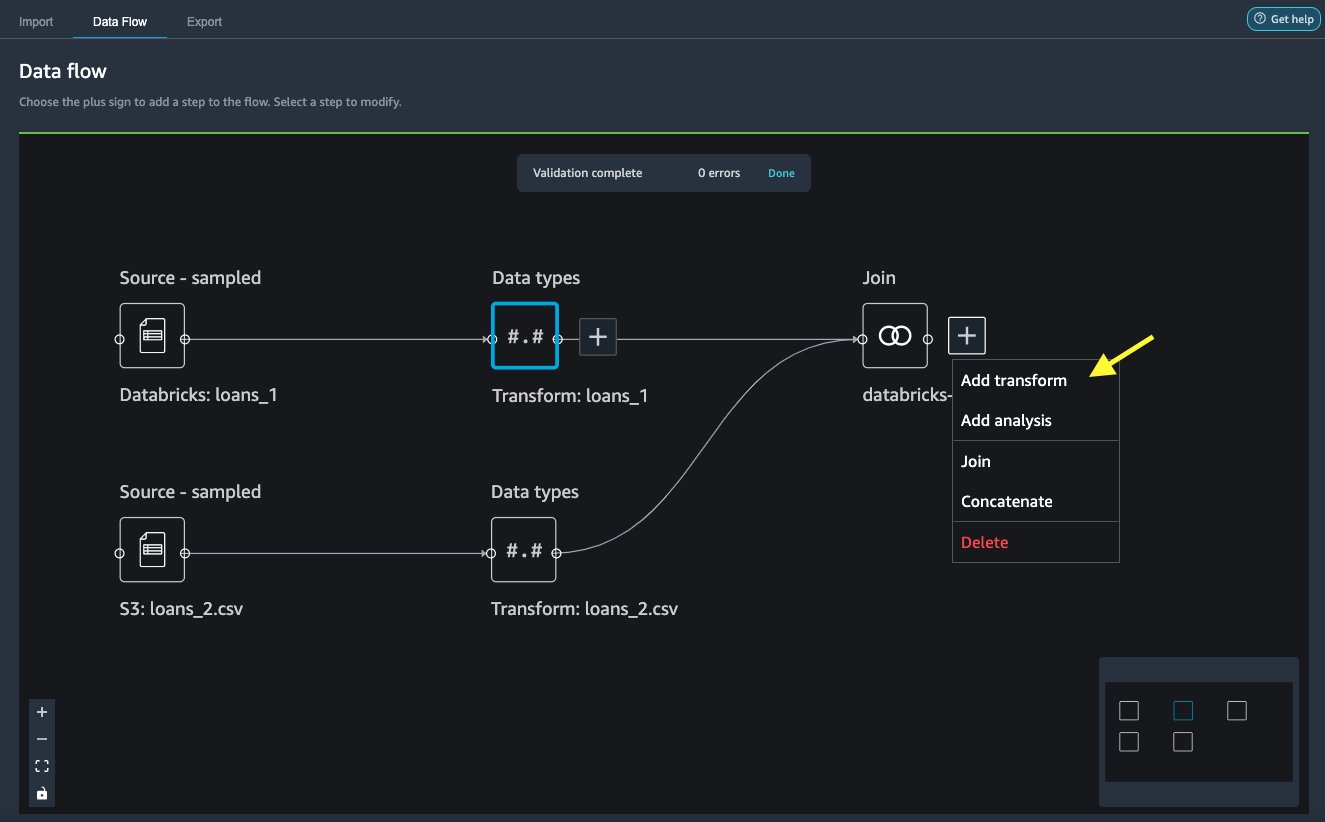

- на Потік даних вкладка, для Типи даних, виберіть знак плюса для

loans_1. - Вибирати Приєднайся до.

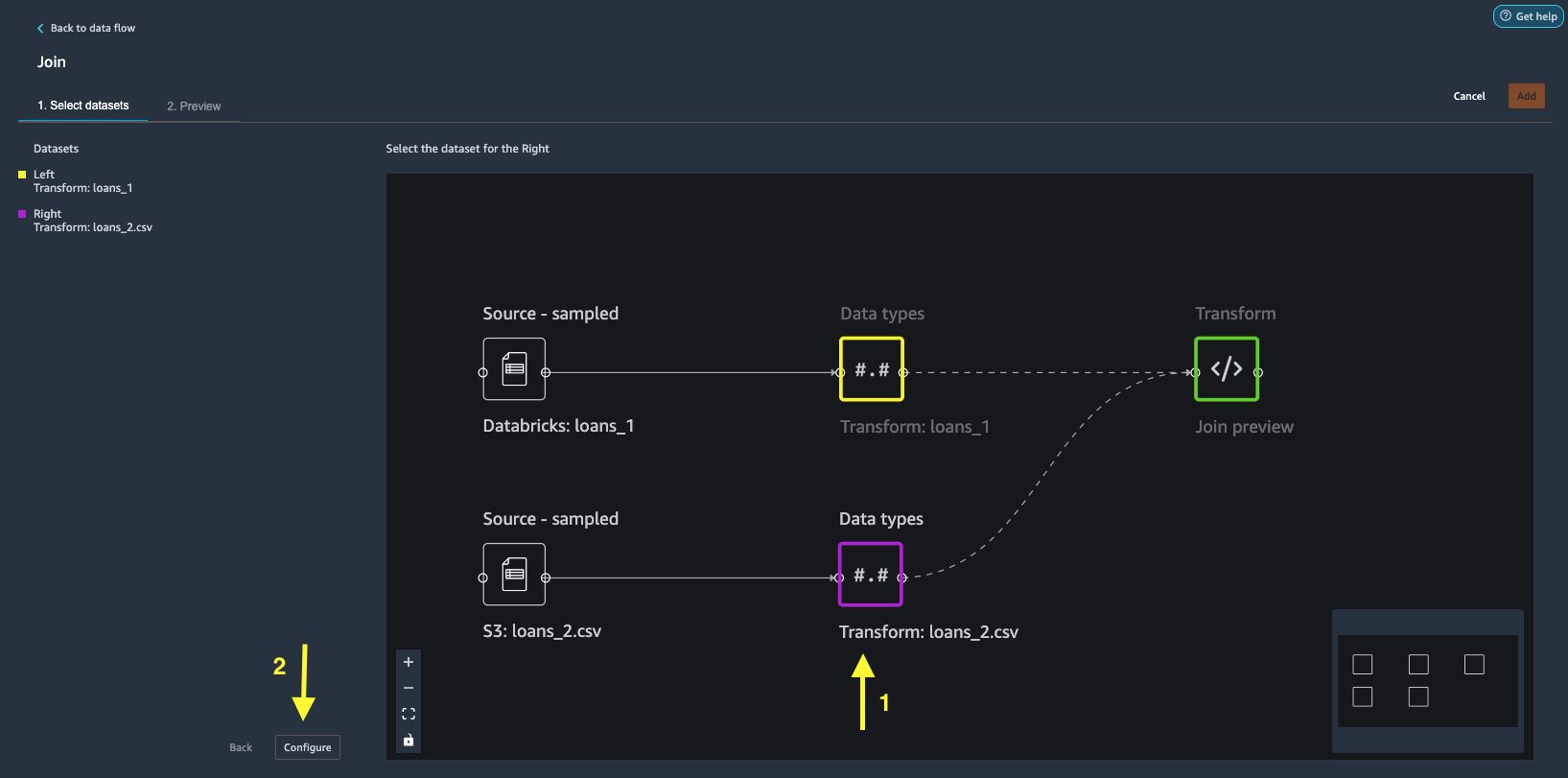

- Виберіть

loans_2.csvфайл як правий набір даних. - Вибирати Конфігурувати щоб налаштувати критерії приєднання.

- для ІМ'Я, введіть назву для об’єднання.

- для Тип приєднаннявиберіть Внутрішній за цей пост.

- Виберіть

idколонка для приєднання. - Вибирати Застосовувати для попереднього перегляду об’єднаного набору даних.

- Вибирати додавати щоб додати його до потоку даних.

Застосувати трансформації

Data Wrangler має понад 300 вбудованих перетворень, які не вимагають кодування. Давайте використаємо вбудовані перетворення для підготовки набору даних.

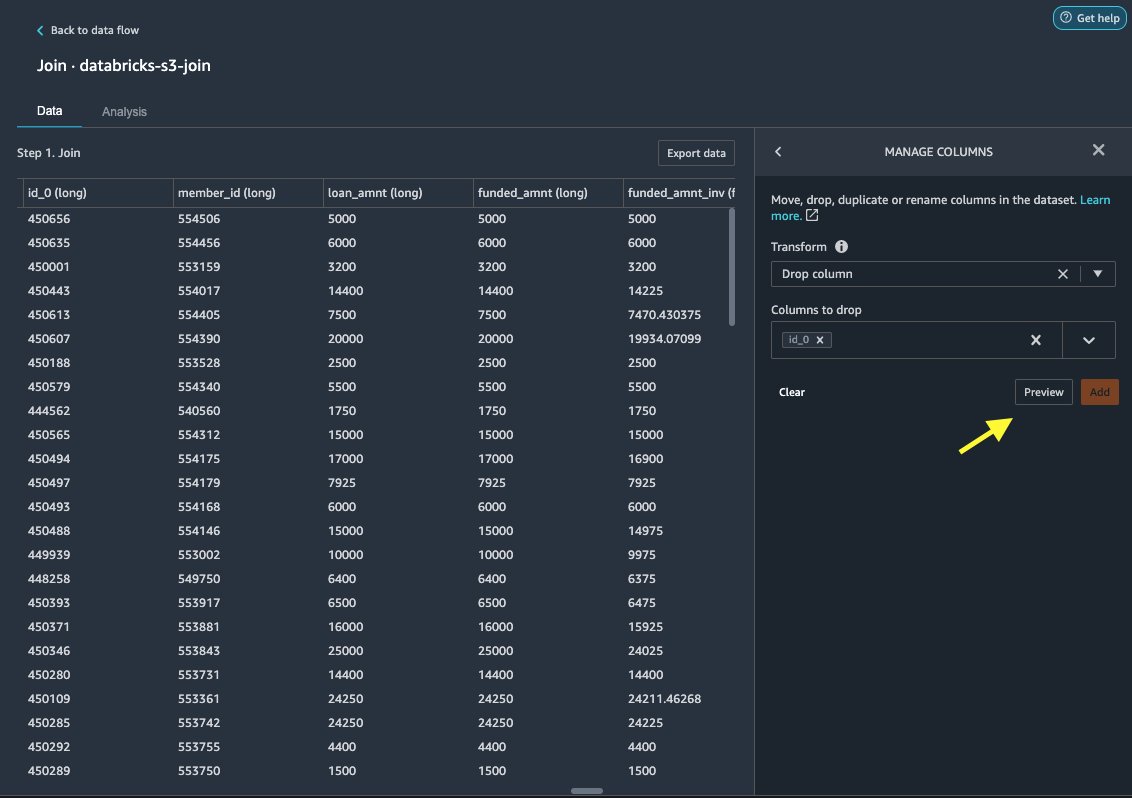

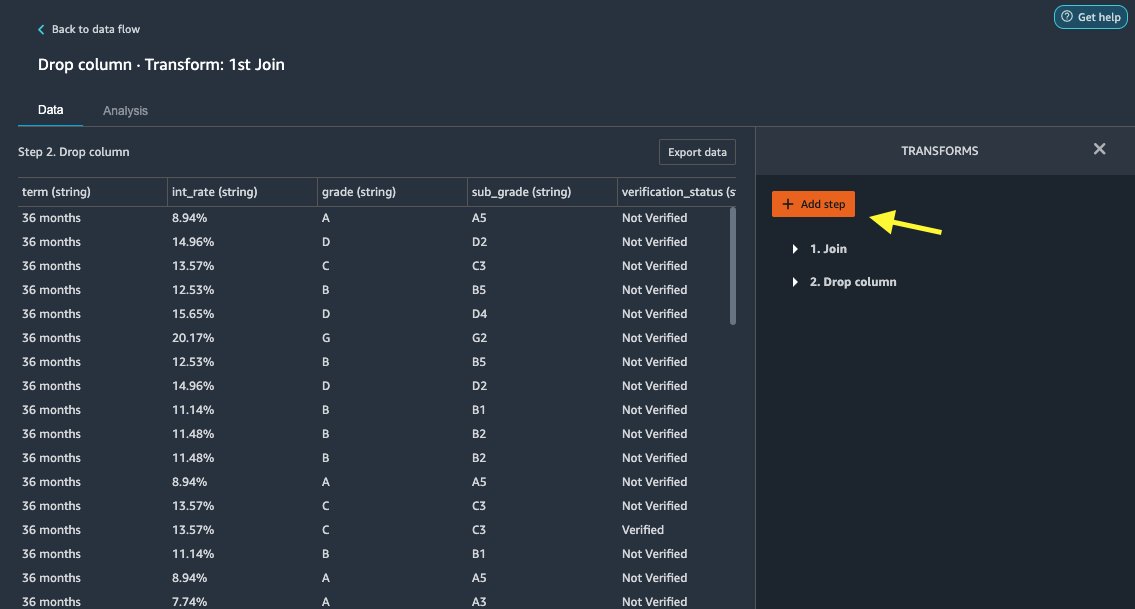

Колонка скидання

Спочатку ми скидаємо зайвий стовпець ідентифікатора.

- На приєднаному вузлі виберіть знак плюс.

- Вибирати Додати трансформацію.

- під трансформує, вибирати + Додати крок.

- Вибирати Керувати стовпцями.

- для Перетвореннявиберіть Колонка скидання.

- для Стовпчики для опускання, виберіть стовпець

id_0. - Вибирати попередній перегляд.

- Вибирати додавати.

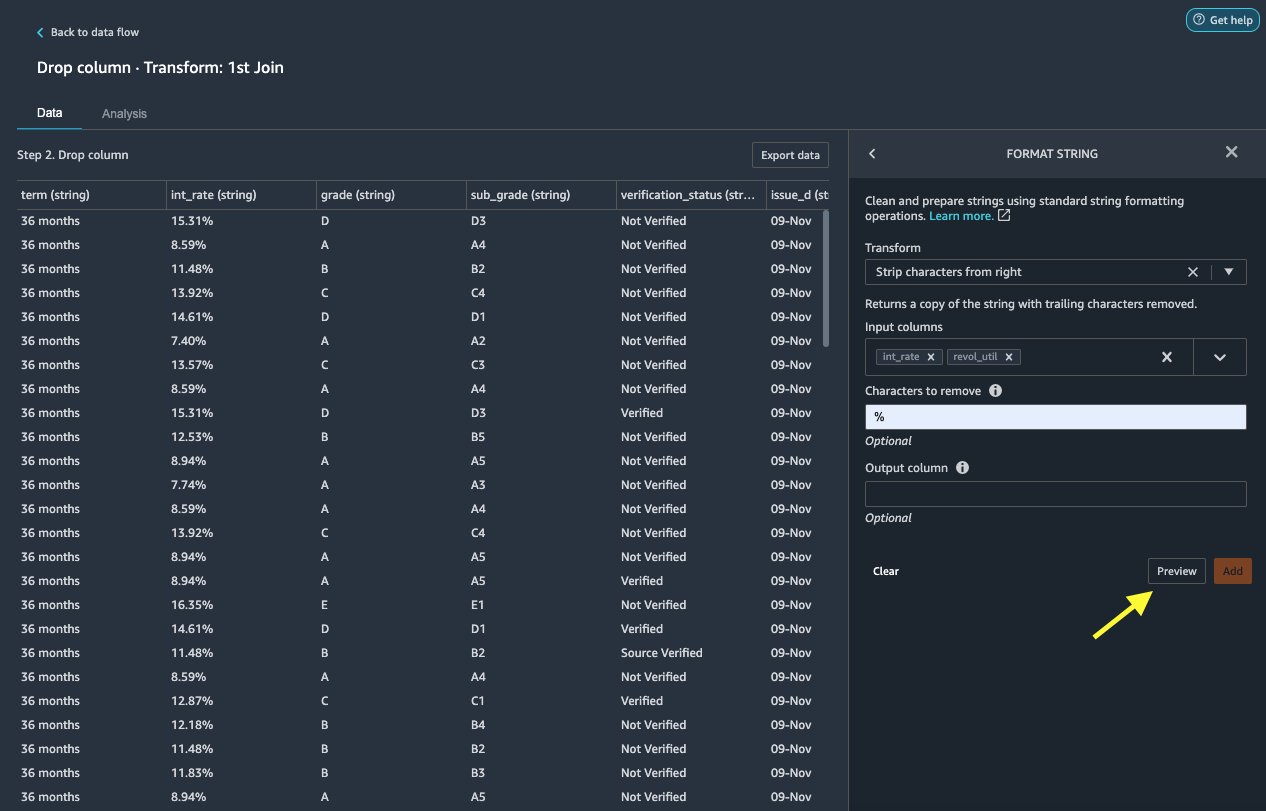

Формат рядка

Давайте застосуємо форматування рядка, щоб видалити символ відсотка з int_rate та revol_util стовпчики.

- на дані вкладка, під Перетворюєвиберіть + Додати крок.

- Вибирати Формат рядка.

- для Перетвореннявиберіть Зніміть символи справа.

Data Wrangler дозволяє застосувати вибрану трансформацію до кількох стовпців одночасно.

- для Вхідні стовпцівиберіть

int_rateтаrevol_util. - для Символи для видалення, введіть

%. - Вибирати попередній перегляд.

- Вибирати додавати.

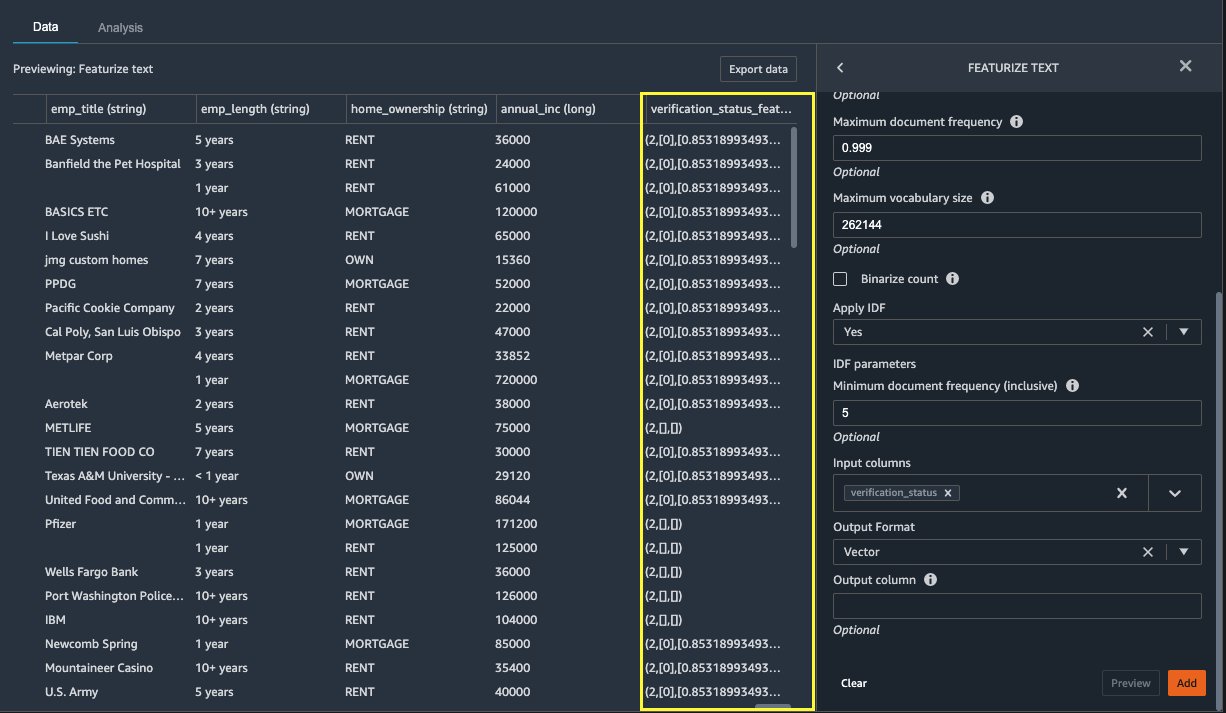

Визначте текст

Тепер давайте векторизуємо verification_status, стовпець текстової функції. Ми перетворюємо текстовий стовпець у вектори частота термінів–зворотна частота документа (TF-IDF), застосовуючи векторізатор лічильника та стандартний токенізатор, як описано нижче. Data Wrangler також надає можливість принести свій власний токенізатор, якщо потрібно.

- під трансформеривиберіть + Додати крок.

- Вибирати Визначте текст.

- для Перетвореннявиберіть Векторизувати.

- для Вхідні стовпцівиберіть

verification_status. - Вибирати попередній перегляд.

- Вибирати додавати.

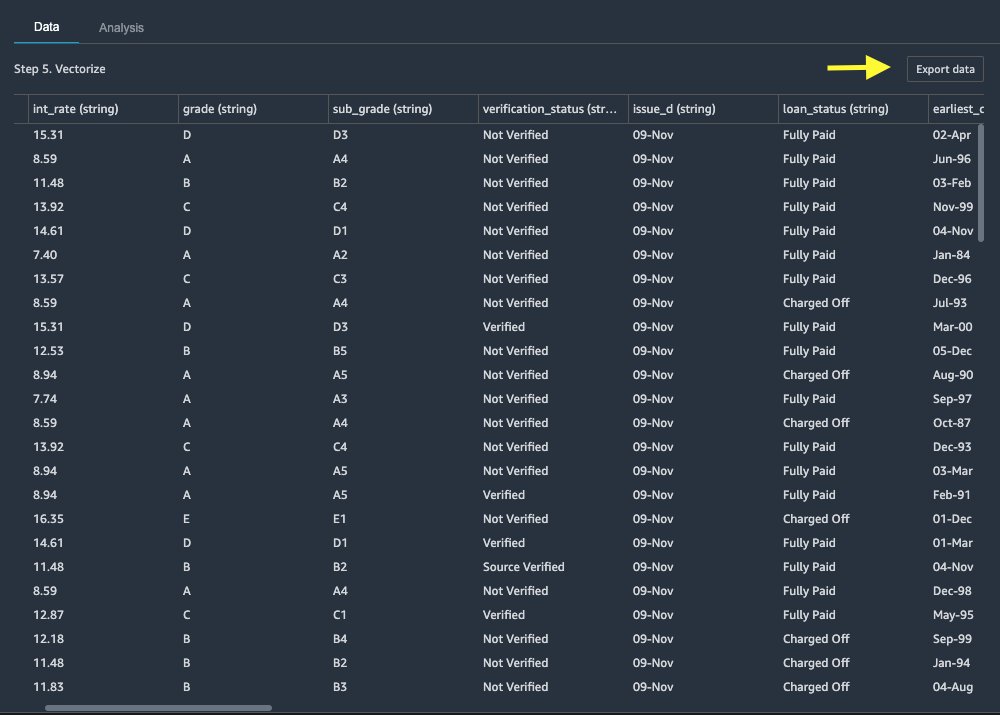

Експортуйте набір даних

Після того, як ми застосували кілька перетворень до різних типів стовпців, включаючи текстові, категоріальні та числові, ми готові використовувати перетворений набір даних для навчання моделі ML. Останнім кроком є експорт трансформованого набору даних до Amazon S3. У Data Wrangler у вас є кілька варіантів на вибір для подальшого використання перетворень:

- Вибирати Крок експорту щоб автоматично створити блокнот Jupyter з кодом обробки SageMaker для обробки та експортувати перетворений набір даних у відро S3. Для отримання додаткової інформації див Запускайте завдання обробки кількома клацаннями за допомогою Amazon SageMaker Data Wrangler.

- Експортуйте блокнот Studio, який створює файл a Конвеєр SageMaker з вашим потоком даних або блокнот, який створює файл Магазин функцій Amazon SageMaker групу функцій і додає функції в автономний або онлайн-магазин функцій.

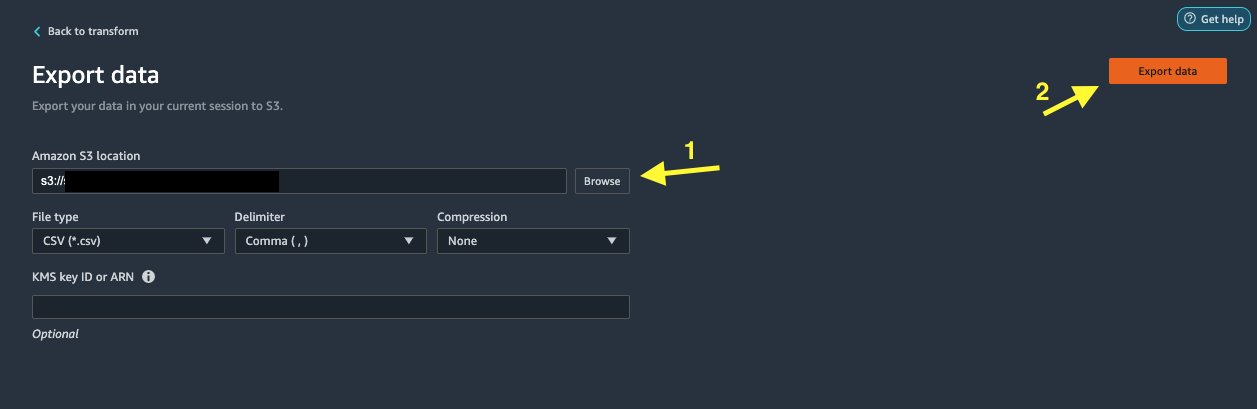

- Вибирати Експорт даних експортувати безпосередньо в Amazon S3.

У цій публікації ми використовуємо переваги Експорт даних опція в Перетворення view, щоб експортувати перетворений набір даних безпосередньо в Amazon S3.

- Вибирати Експорт даних.

- для Розташування S3виберіть перегорнути і виберіть своє відро S3.

- Вибирати Експорт даних.

Прибирати

Якщо ваша робота з Data Wrangler завершена, закрийте свій екземпляр Data Wrangler щоб уникнути додаткових комісій.

Висновок

У цій публікації ми розповіли, як можна швидко й легко налаштувати та підключити Databricks як джерело даних у Data Wrangler, інтерактивно запитувати дані, збережені в Databricks, за допомогою SQL, та попередньо переглянути дані перед імпортуванням. Крім того, ми розглянули, як ви можете об’єднати свої дані в Databricks з даними, що зберігаються в Amazon S3. Потім ми застосували перетворення даних до об’єднаного набору даних, щоб створити конвеєр підготовки даних. Щоб вивчити більше можливостей аналізу Data Wrangler, включаючи створення звітів про цільові витоки та упередження, перегляньте наступну публікацію в блозі Прискорте підготовку даних за допомогою Amazon SageMaker Data Wrangler для прогнозування повторної госпіталізації пацієнтів з цукровим діабетом.

Щоб почати роботу з Data Wrangler, див Підготуйте дані ML за допомогою Amazon SageMaker Data Wrangler, і переглянути останню інформацію про Data Wrangler Сторінка продукту.

Про авторів

Руп Бейнз є архітектором рішень в AWS, який зосереджується на AI/ML. Він прагне допомагати клієнтам впроваджувати інновації та досягати їхніх бізнес-цілей за допомогою штучного інтелекту та машинного навчання. У вільний час Руп любить читати та ходити в походи.

Руп Бейнз є архітектором рішень в AWS, який зосереджується на AI/ML. Він прагне допомагати клієнтам впроваджувати інновації та досягати їхніх бізнес-цілей за допомогою штучного інтелекту та машинного навчання. У вільний час Руп любить читати та ходити в походи.

Ігор Алексєєв — архітектор партнерських рішень в AWS в області даних та аналітики. Ігор працює зі стратегічними партнерами, допомагаючи їм створювати складні архітектури, оптимізовані для AWS. Перед тим як приєднатися до AWS як архітектор даних/рішень, він реалізував багато проектів у сфері великих даних, включаючи кілька озер даних в екосистемі Hadoop. Як інженер з обробки даних, він брав участь у застосуванні AI/ML для виявлення шахрайства та автоматизації офісу. Проекти Ігоря були в різних галузях, включаючи комунікації, фінанси, громадську безпеку, виробництво та охорону здоров’я. Раніше Ігор працював повним інженером/технічним керівником.

Ігор Алексєєв — архітектор партнерських рішень в AWS в області даних та аналітики. Ігор працює зі стратегічними партнерами, допомагаючи їм створювати складні архітектури, оптимізовані для AWS. Перед тим як приєднатися до AWS як архітектор даних/рішень, він реалізував багато проектів у сфері великих даних, включаючи кілька озер даних в екосистемі Hadoop. Як інженер з обробки даних, він брав участь у застосуванні AI/ML для виявлення шахрайства та автоматизації офісу. Проекти Ігоря були в різних галузях, включаючи комунікації, фінанси, громадську безпеку, виробництво та охорону здоров’я. Раніше Ігор працював повним інженером/технічним керівником.

Хуонг Нгуєн є старшим менеджером з продуктів у AWS. Вона керує користувацьким досвідом для SageMaker Studio. Вона має 13-річний досвід створення продуктів, орієнтованих на клієнтів, і керованих даними, як для підприємств, так і для споживачів. У вільний час вона любить читати, бувати на природі та проводити час із сім’єю.

Хуонг Нгуєн є старшим менеджером з продуктів у AWS. Вона керує користувацьким досвідом для SageMaker Studio. Вона має 13-річний досвід створення продуктів, орієнтованих на клієнтів, і керованих даними, як для підприємств, так і для споживачів. У вільний час вона любить читати, бувати на природі та проводити час із сім’єю.

Генрі Ван є інженером з розробки програмного забезпечення в AWS. Нещодавно він приєднався до команди Data Wrangler після закінчення UC Davis. Він цікавиться наукою про дані та машинним навчанням, а як хобі займається 3D-друком.

Генрі Ван є інженером з розробки програмного забезпечення в AWS. Нещодавно він приєднався до команди Data Wrangler після закінчення UC Davis. Він цікавиться наукою про дані та машинним навчанням, а як хобі займається 3D-друком.

- Coinsmart. Найкраща в Європі біржа біткойн та криптовалют.

- Платоблокчейн. Web3 Metaverse Intelligence. Розширені знання. БЕЗКОШТОВНИЙ ДОСТУП.

- CryptoHawk. Альткойн Радар. Безкоштовне випробування.

- Джерело: https://aws.amazon.com/blogs/machine-learning/prepare-data-from-databricks-for-machine-learning-using-amazon-sagemaker-data-wrangler/

- "

- 000

- 100

- 39

- 3d

- МЕНЮ

- доступ

- розмістити

- Додатковий

- просунутий

- Перевага

- алгоритми

- ВСІ

- Amazon

- аналіз

- аналітика

- Застосування

- архітектура

- штучний

- штучний інтелект

- Штучний інтелект і машинне навчання

- призначений

- Автоматизація

- AWS

- буття

- КРАЩЕ

- Великий даних

- Блог

- border

- будувати

- вбудований

- бізнес

- можливості

- випадків

- Вибирати

- Очищення

- клуб

- код

- Кодування

- Колонка

- комбінований

- загальний

- зв'язку

- комплекс

- конфігурація

- підключений

- зв'язку

- Зв'язки

- розгляду

- Консоль

- консолідація

- споживач

- споживання

- містить

- створений

- створює

- створення

- Поточний

- Клієнти

- дані

- наука про дані

- Database

- затримка

- Залежно

- Виявлення

- розробка

- різний

- безпосередньо

- дисплеїв

- вниз

- водій

- Падіння

- легко

- екосистема

- редактор

- включіть

- дозволяє

- інженер

- Машинобудування

- Що натомість? Створіть віртуальну версію себе у

- підприємство

- приклад

- Крім

- виконання

- досвід

- дослідити

- сім'я

- особливість

- риси

- Інформація про оплату

- фінансування

- Перший

- Гнучкість

- потік

- після

- формат

- шахрайство

- Повний

- породжувати

- покоління

- добре

- управління

- Group

- охорона здоров'я

- допомога

- Як

- HTTPS

- Особистість

- реалізовані

- важливо

- імпорт

- У тому числі

- промисловості

- інформація

- розуміння

- Інтелект

- інтерес

- інтерфейс

- інвестиції

- залучений

- IT

- Джобс

- приєднатися

- приєднався

- етикетки

- мова

- останній

- вести

- провідний

- вивчення

- кредитування

- Кредити

- подивився

- машина

- навчання за допомогою машини

- менеджер

- виробництво

- ML

- модель

- Моделі

- більше

- множинний

- Природний

- природа

- навігація

- Нові можливості

- ноутбук

- Пропозиції

- offline

- онлайн

- варіант

- Опції

- порядок

- власний

- партнер

- партнери

- пристрасний

- оплата

- відсоток

- продуктивність

- персонал

- фаза

- платформа

- політика

- Прогнози

- попередній перегляд

- процес

- Product

- Продукти

- Програмування

- проектів

- забезпечує

- забезпечення

- громадськість

- цілей

- швидко

- Сировина

- читання

- зниження

- звітом

- вимагати

- вимагається

- відповідальний

- біг

- Безпека

- наука

- Вчені

- обраний

- Серія

- обслуговування

- комплект

- установка

- значний

- простий

- Розмір

- Софтвер

- розробка програмного забезпечення

- рішення

- Рішення

- пробіли

- витрачати

- Витрати

- розкол

- стек

- standard

- старт

- почалася

- Заява

- Статус

- зберігання

- зберігати

- Стратегічний

- сильний

- студія

- Успішно

- підтримка

- Мета

- команда

- через

- час

- Навчання

- Перетворення

- Перетворення

- ui

- створеного

- Оновити

- використання

- різноманітність

- різний

- в той час як

- без

- Work

- працював

- працює

- лист