Передача даних і аналізу в режимі майже в реальному часі дозволяє компаніям швидко реагувати на потреби клієнтів. Дані в реальному часі можуть надходити з різних джерел, включаючи соціальні мережі, пристрої IoT, моніторинг інфраструктури, моніторинг колл-центру тощо. Завдяки широті та глибині даних, які надходять із багатьох джерел, компанії шукають рішення для захисту конфіденційності своїх клієнтів і захисту конфіденційних даних від доступу з кінцевих систем. Раніше вам доводилося покладатися на механізми правил щодо ідентифікаційної інформації (PII), які могли позначати помилкові спрацьовування або пропускати дані, або вам доводилося створювати та підтримувати власні моделі машинного навчання (ML), щоб ідентифікувати PII у ваших потокових даних. Вам також потрібно було запровадити та підтримувати інфраструктуру, необхідну для підтримки цих механізмів або моделей.

Щоб спростити цей процес і зменшити витрати, ви можете використовувати «Амазонка», служба обробки природної мови (NLP), яка використовує ML для пошуку інформації та зв’язків, як-от людей, місць, настроїв і тем, у неструктурованому тексті. Тепер ви можете використовувати можливості Amazon Comprehend ML для виявлення та редагування ідентифікаційної інформації в електронних листах клієнтів, заявках у службу підтримки, оглядах продуктів, соціальних мережах тощо. Досвід ML не потрібен. Наприклад, ви можете проаналізувати запити служби підтримки та статті бази знань, щоб виявити ідентифікаційні сутності та відредагувати текст, перш ніж індексувати документи. Після цього документи звільняються від ідентифікаційної інформації, і користувачі можуть використовувати дані. Редагування ідентифікаційних даних допомагає вам захистити конфіденційність ваших клієнтів і дотримуватися місцевих законів і правил.

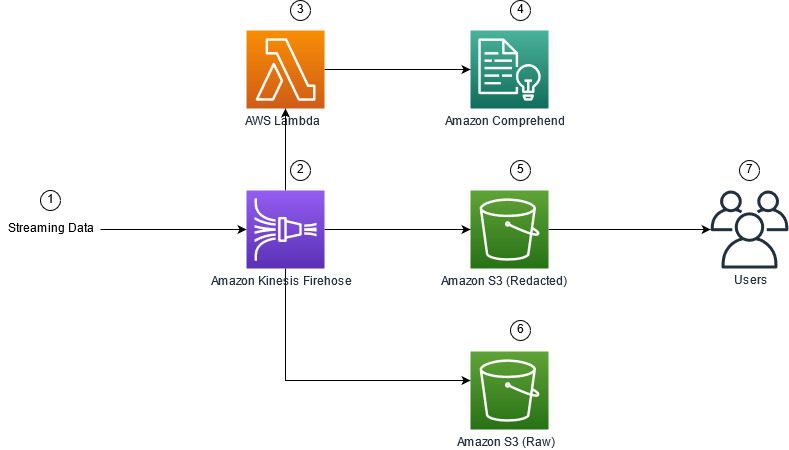

У цій публікації ви дізнаєтесь, як застосувати Amazon Comprehend у вашій потоковій архітектурі, щоб редагувати ідентифікаційні сутності майже в реальному часі за допомогою Amazon Kinesis Data Firehose з AWS Lambda.

Ця публікація зосереджена на редагуванні даних із вибраних полів, які завантажуються в потокову архітектуру за допомогою Kinesis Data Firehose, де ви хочете створювати, зберігати та підтримувати додаткові похідні копії даних для використання кінцевими користувачами або додатками нижче. Якщо ви використовуєте Потоки даних Amazon Kinesis або мати додаткові випадки використання поза редакцією ідентифікаційної інформації, див Перекладайте, редагуйте й аналізуйте потокові дані за допомогою функцій SQL із Amazon Kinesis Data Analytics, Amazon Translate та Amazon Comprehend, де ми показуємо, як можна використовувати Студія аналітики даних Amazon Kinesis живлення від Апач Цепелін та Apache Flash для інтерактивного аналізу, перекладу та редагування текстових полів у потокових даних.

Огляд рішення

На наступному малюнку показано приклад архітектури для редагування ідентифікаційної інформації потокових даних у реальному часі за допомогою Служба простого зберігання Amazon (Amazon S3), Kinesis Data Перетворення даних Firehose, «Амазонка» та AWS Lambda. Крім того, ми використовуємо AWS SDK для Python (Boto3) для лямбда-функцій. Як показано на схемі, необроблений сегмент S3 містить невідредаговані дані, а відредагований сегмент S3 містить відредаговані дані після використання Amazon Comprehend DetectPiiEntities API у лямбда-функції.

Залучені витрати

Окрім витрат на Kinesis Data Firehose, Amazon S3 і Lambda, це рішення спричинить витрати на використання від Amazon Comprehend. Сума, яку ви сплачуєте, є фактором загальної кількості записів, які містять ідентифікаційну інформацію, і символів, які обробляються функцією лямбда. Для отримання додаткової інформації див Ціни Amazon Kinesis Data Firehose, Amazon Comprehend Pricing та Ціни AWS Lambda.

Для прикладу припустімо, що у вас є 10,000 500 записів журналу, а значення ключа, з якого ви хочете відредагувати ідентифікаційну інформацію, становить 10,000 символів. З 50 XNUMX записів журналу XNUMX визначено як такі, що містять ідентифікаційну інформацію. Деталі вартості такі:

Містить вартість ідентифікаційної інформації:

- Розмір кожного значення ключа = 500 символів (1 одиниця = 100 символів)

- Кількість одиниць (100 символів) на запис (мінімум 3 одиниці) = 5

- Усього одиниць = 10,000 5 (записів) x 1 (одиниць на запис) x 50,000 (запитів Amazon Comprehend на запис) = XNUMX XNUMX

- Ціна за одиницю = 0.000002 $

- Загальна вартість ідентифікації записів журналу з ідентифікаційною інформацією за допомогою ContainsPiiEntities API = $0.1 [50,000 0.000002 одиниць x $XNUMX]

Відредагувати вартість ідентифікаційної інформації:

- Загальна кількість одиниць, що містять ідентифікаційну інформацію = 50 (записів) x 5 (одиниць на запис) x 1 (запитів Amazon Comprehend на запис) = 250

- Ціна за одиницю = 0.0001 $

- Загальна вартість визначення місцезнаходження ідентифікаційної інформації за допомогою DetectPiiEntities API = [кількість одиниць] x [вартість за одиницю] = 250 x 0.0001 $ = 0.025 $

Загальна вартість ідентифікації та редагування:

- Загальна вартість: 0.1 дол. США (перевірка, якщо поле містить ідентифікаційну інформацію) + 0.025 дол. США (редагувати поля, які містять ідентифікаційну інформацію) = 0.125 дол. США

Розгорніть рішення за допомогою AWS CloudFormation

Для цієї публікації ми надаємо файл AWS CloudFormation редагування потокових даних шаблон, який містить усі деталі впровадження, щоб уможливити повторювані розгортання. Після розгортання цей шаблон створює два сегменти S3: одне для зберігання необроблених зразків даних, отриманих із Amazon Kinesis Data Generator (KDG), і друге для зберігання відредагованих даних. Крім того, він створює потік доставки Kinesis Data Firehose DirectPUT як вхідні дані та функцію Lambda, яка викликає Amazon Comprehend Містить PiiEntities та DetectPiiEntities API для ідентифікації та редагування ідентифікаційних даних. Функція лямбда покладається на введені користувачем змінні середовища, щоб визначити, які ключові значення потрібно перевірити на ідентифікаційну інформацію.

Функція Lambda в цьому рішенні має обмежений розмір корисного навантаження до 100 КБ. Якщо надається корисне навантаження, де текст перевищує 100 КБ, функція Lambda пропустить його.

Щоб розгорнути рішення, виконайте такі дії:

- Запустіть стек CloudFormation на сході США (Північна Вірджинія)

us-east-1:

- Введіть назву стека та залиште інші параметри за замовчуванням

- Select Я визнаю, що AWS CloudFormation може створювати ресурси IAM із користувацькими іменами.

- Вибирати Створити стек.

Розгорнути ресурси вручну

Якщо ви віддаєте перевагу будувати архітектуру вручну замість використання AWS CloudFormation, виконайте кроки в цьому розділі.

Створіть сегменти S3

Створіть свої сегменти S3, виконавши такі кроки:

- На консолі Amazon S3 виберіть Відра у навігаційній панелі.

- Вибирати Створити відро.

- Створіть одне відро для необроблених даних і одне для відредагованих даних.

- Зверніть увагу на назви щойно створених сегментів.

Створіть лямбда-функцію

Щоб створити та розгорнути функцію Lambda, виконайте такі дії:

- На консолі Lambda виберіть Створити функцію.

- Вибирати Автор з нуля.

- для Назва функції, введіть

AmazonComprehendPII-Redact. - для Час виконаннявиберіть Python 3.9.

- для архітектуравиберіть x86_64.

- для Виконавча рольвиберіть Створіть нову роль із дозволами Lambda.

- Після створення функції введіть такий код:

- Вибирати Розгортання.

- На панелі навігації виберіть Конфігурація.

- перейдіть до Змінні середовища.

- Вибирати Редагувати.

- для ключ, введіть

keys. - для значення, введіть ключові значення, з яких потрібно видалити ідентифікаційну інформацію, розділивши їх комою та пробілом. Наприклад, enter

Tweet1,Tweet2якщо ви використовуєте зразки тестових даних, надані в наступному розділі цієї публікації. - Вибирати зберегти.

- перейдіть до Загальна конфігурація.

- Вибирати Редагувати.

- Зміна значення Тайм-аут до 1 хвилини.

- Вибирати зберегти.

- перейдіть до Дозволи.

- Виберіть назву ролі під Виконавча роль.

Ви перенаправлені на Управління ідентифікацією та доступом AWS (IAM) консоль. - для Додати дозволивиберіть Додайте політику.

-

Що натомість? Створіть віртуальну версію себе у

Comprehendу рядок пошуку та виберіть політикуComprehendFullAccess. - Вибирати Додайте політику.

Створіть потік доставки Firehose

Щоб створити потік доставки Firehose, виконайте такі дії:

- На консолі Kinesis Data Firehose виберіть Створіть потік доставки.

- для Sourceвиберіть Прямий ПУТ.

- для призначеннявиберіть Amazon S3.

- для Назва потоку доставки, введіть

ComprehendRealTimeBlog. - під Трансформуйте вихідні записи за допомогою AWS Lambdaвиберіть включено.

- для Функція AWS Lambda, введіть ARN для створеної вами функції або перейдіть до функції

AmazonComprehendPII-Redact. - для Розмір буфера, встановіть значення 1 МБ.

- для Буферний інтервал, залиште 60 секунд.

- під Параметри призначеннявиберіть сегмент S3, який ви створили для відредагованих даних.

- під Налаштування резервної копіївиберіть сегмент S3, який ви створили для необроблених записів.

- під дозвіл, створіть або оновіть роль IAM або виберіть наявну роль із відповідними дозволами.

- Вибирати Створіть потік доставки.

Розгорніть рішення потокової передачі даних за допомогою Kinesis Data Generator

Ви можете використовувати Kinesis Data Generator (KDG), щоб отримати зразки даних у Kinesis Data Firehose та перевірити рішення. Щоб спростити цей процес, ми пропонуємо функцію Lambda та шаблон CloudFormation для створення Амазонка Когніто користувача та призначити відповідні дозволи на використання KDG.

- на Сторінка Amazon Kinesis Data Generatorвиберіть Створіть користувача Cognito за допомогою CloudFormation.Ви будете перенаправлені на консоль AWS CloudFormation, щоб створити свій стек.

- Введіть ім’я користувача та пароль для користувача, під яким ви входите в KDG.

- Залиште інші налаштування за замовчуванням і створіть свій стек.

- на Виходи виберіть посилання KDG UI.

- Введіть своє ім'я користувача та пароль для входу.

Надсилайте тестові записи та перевіряйте редагування в Amazon S3

Щоб перевірити рішення, виконайте такі дії:

- Увійдіть за URL-адресою KDG, яку ви створили на попередньому кроці.

- Виберіть регіон, де розгорнуто стек AWS CloudFormation.

- для Потік/потік доставки, виберіть створений вами потік доставки (якщо ви використовували шаблон, він має формат

accountnumber-awscomprehend-blog). - Залиште інші налаштування за замовчуванням.

- Для шаблону запису ви можете створити власні тести або скористатися наведеним нижче шаблоном. Якщо ви використовуєте наведені нижче зразки даних для тестування, ви повинні мати оновлені змінні середовища в

AmazonComprehendPII-RedactЛямбда-функція доTweet1,Tweet2. У разі розгортання через CloudFormation оновіть змінні середовища доTweet1,Tweet2у створеній лямбда-функції. Зразок тестових даних наведено нижче: - Вибирати Надіслати даніі зачекайте кілька секунд, щоб записи були надіслані у ваш потік.

- Через кілька секунд зупиніть генератор KDG і перевірте свої сегменти S3 на наявність доставлених файлів.

Нижче наведено приклад необроблених даних у необробленому сегменті S3:

Нижче наведено приклад відредагованих даних у відредагованому сегменті S3:

Конфіденційну інформацію було видалено з відредагованих повідомлень, що забезпечує впевненість у тому, що ви можете надати ці дані кінцевим системам.

Прибирати

Коли ви закінчите експериментувати з цим рішенням, очистіть свої ресурси за допомогою консолі AWS CloudFormation, щоб видалити всі ресурси, розгорнуті в цьому прикладі. Якщо ви виконували вказівки вручну, вам потрібно буде вручну видалити два сегменти, AmazonComprehendPII-Redact функція, ComprehendRealTimeBlog потік, група журналу для ComprehendRealTimeBlog потік і будь-які створені ролі IAM.

Висновок

Ця публікація показала, як інтегрувати редагування ідентифікаційної інформації у вашу потокову архітектуру майже в реальному часі та скоротити час обробки даних, виконуючи редагування під час польоту. У цьому сценарії ви надаєте відредаговані дані своїм кінцевим користувачам, а адміністратор озера даних захищає необроблений сегмент для подальшого використання. Ви також можете створити додаткову обробку за допомогою Amazon Comprehend, щоб ідентифікувати тон чи почуття, ідентифікувати сутності в даних і класифікувати кожне повідомлення.

У цій публікації ми надали окремі кроки для кожної служби, а також включили шаблон CloudFormation, який дозволяє вам надати необхідні ресурси у вашому обліковому записі. Цей шаблон слід використовувати лише для підтвердження концепції або сценаріїв тестування. Зверніться до посібників для розробників «Амазонка», Лямбда та Kinesis Data Firehose для будь-яких лімітів обслуговування.

Щоб розпочати ідентифікацію та редагування ідентифікаційної інформації, див Особиста інформація (PII). За допомогою прикладу архітектури в цій публікації ви можете інтегрувати будь-який API Amazon Comprehend з даними майже в реальному часі за допомогою перетворення даних Kinesis Data Firehose. Щоб дізнатися більше про те, що можна створювати за допомогою даних майже в реальному часі за допомогою Kinesis Data Firehose, див Посібник розробника Amazon Kinesis Data Firehose. Це рішення доступне в усіх регіонах AWS, де доступні Amazon Comprehend і Kinesis Data Firehose.

Про авторів

Джо Моротті є архітектором рішень у Amazon Web Services (AWS), допомагаючи корпоративним клієнтам на Середньому Заході США. Він обіймав широкий спектр технічних посад і любив демонструвати клієнтам мистецтво можливого. У свій вільний час він із задоволенням проводить час із сім’єю, досліджуючи нові місця та надмірно аналізуючи результати своєї спортивної команди.

Джо Моротті є архітектором рішень у Amazon Web Services (AWS), допомагаючи корпоративним клієнтам на Середньому Заході США. Він обіймав широкий спектр технічних посад і любив демонструвати клієнтам мистецтво можливого. У свій вільний час він із задоволенням проводить час із сім’єю, досліджуючи нові місця та надмірно аналізуючи результати своєї спортивної команди.

Шріхарш Адарі є старшим архітектором рішень у Amazon Web Services (AWS), де він допомагає клієнтам працювати у зворотному напрямку від бізнес-результатів для розробки інноваційних рішень на AWS. Протягом багатьох років він допомагав багатьом клієнтам трансформувати платформу даних у різних галузевих вертикалях. Його основна сфера знань включає технологічну стратегію, аналітику даних і науку про дані. У вільний час він любить грати в теніс, дивитися телевізійні шоу та грати в таблу.

Шріхарш Адарі є старшим архітектором рішень у Amazon Web Services (AWS), де він допомагає клієнтам працювати у зворотному напрямку від бізнес-результатів для розробки інноваційних рішень на AWS. Протягом багатьох років він допомагав багатьом клієнтам трансформувати платформу даних у різних галузевих вертикалях. Його основна сфера знань включає технологічну стратегію, аналітику даних і науку про дані. У вільний час він любить грати в теніс, дивитися телевізійні шоу та грати в таблу.

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- Амазонський кінезіс

- аналітика

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- AWS Машинне навчання

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- середній (200)

- Kinesis Data Firehose

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- зефірнет