Ця публікація розповідає про найпоширеніші проблеми, з якими стикаються клієнти під час пошуку внутрішніх документів, і дає конкретні вказівки щодо того, як служби AWS можна використовувати для створення генеративного розмовного бота AI, який робить внутрішню інформацію більш корисною.

Неструктуровані дані складають 80% усіх даних які знаходяться в організаціях і складаються зі сховищ посібників, PDF-файлів, поширених запитань, електронних листів та інших документів, які щодня зростають. Сучасний бізнес покладається на постійно зростаючі сховища внутрішньої інформації, і проблеми виникають, коли обсяг неструктурованих даних стає неможливим для керування. Часто користувачі читають і перевіряють багато різних внутрішніх джерел, щоб знайти потрібні відповіді.

Внутрішні форуми запитань і відповідей можуть допомогти користувачам отримати дуже конкретні відповіді, але також потребують довшого часу очікування. У випадку внутрішніх поширених запитань компанії тривалий час очікування призводить до зниження продуктивності співробітників. Форуми запитань і відповідей важко масштабувати, оскільки вони покладаються на написані вручну відповіді. З генеративним штучним інтелектом зараз відбувається зміна парадигми того, як користувачі шукають і знаходять інформацію. Наступним логічним кроком є використання генеративного штучного інтелекту для ущільнення великих документів у меншу інформацію розміром уривків для полегшення використання користувачем. Замість того, щоб витрачати тривалий час на читання тексту чи очікування відповідей, користувачі можуть створювати підсумки в режимі реального часу на основі кількох існуючих сховищ внутрішньої інформації.

Огляд рішення

Рішення дозволяє клієнтам отримувати підібрані відповіді на запитання щодо внутрішніх документів за допомогою моделі трансформатора для генерування відповідей на запитання щодо даних, на яких він не навчався, метод, відомий як нульовий запит. Приймаючи це рішення, клієнти можуть отримати такі переваги:

- Знайти точні відповіді на запитання за наявними джерелами внутрішніх документів

- Скоротіть час, який користувачі витрачають на пошук відповідей, використовуючи великі мовні моделі (LLM), щоб надавати майже миттєві відповіді на складні запити за допомогою документів із найновішою інформацією.

- Шукайте попередні відповіді на запитання через централізовану інформаційну панель

- Зменште стрес, спричинений витрачанням часу на читання інформації вручну, щоб знайти відповіді

Доповнена генерація пошуку (RAG)

Retrieval Augmented Generation (RAG) зменшує деякі недоліки запитів на основі LLM, знаходячи відповіді у вашій базі знань і використовуючи LLM для узагальнення документів у стислі відповіді. Будь ласка, прочитайте це після навчитися впроваджувати підхід RAG Амазонка Кендра. Нижче наведені ризики та обмеження, пов’язані із запитами на базі LLM, які розглядає підхід RAG із Amazon Kendra:

- Галюцинації та відстеження – LLMS навчаються на великих наборах даних і генерують відповіді на ймовірності. Це може призвести до неточних відповідей, які називаються галюцинаціями.

- Кілька силосів даних – щоб посилатися на дані з кількох джерел у вашій відповіді, потрібно налаштувати екосистему конектора для агрегування даних. Доступ до кількох сховищ виконується вручну та займає багато часу.

- Безпека. Безпека та конфіденційність є критично важливими при розгортанні розмовних ботів на базі RAG і LLM. Незважаючи на використання «Амазонка» щоб відфільтрувати особисті дані, які можуть бути надані через запити користувачів, залишається ймовірність ненавмисного розкриття особистої або конфіденційної інформації, залежно від отриманих даних. Це означає, що контроль доступу до чат-бота має вирішальне значення для запобігання ненавмисному доступу до конфіденційної інформації.

- Релевантність даних – LLMS навчаються на даних до певної дати, що означає, що інформація часто не актуальна. Витрати, пов’язані з моделями навчання на останніх даних, є високими. Щоб забезпечити точні та актуальні відповіді, організації несуть відповідальність за регулярне оновлення та збагачення вмісту проіндексованих документів.

- Вартість – витрати, пов’язані з розгортанням цього рішення, повинні розглядатися компаніями. Компанії повинні ретельно оцінити свій бюджет і вимоги до ефективності під час впровадження цього рішення. Запуск LLM може вимагати значних обчислювальних ресурсів, що може збільшити експлуатаційні витрати. Ці витрати можуть стати обмеженням для програм, які повинні працювати у великих масштабах. Однак одна з переваг AWS Cloud це гнучкість платити лише за те, що ви використовуєте. AWS пропонує просту, узгоджену модель ціноутворення за принципом оплати за використання, тож ви платите лише за спожиті вами ресурси.

Використання Amazon SageMaker JumpStart

Для мовних моделей на основі трансформаторів організації можуть отримати вигоду від використання Amazon SageMaker JumpStart, який пропонує колекцію готових моделей машинного навчання. Amazon SageMaker JumpStart пропонує широкий спектр основоположних моделей створення тексту та відповідей на запитання (Q&A), які можна легко розгорнути та використовувати. Це рішення інтегрує модель FLAN T5-XL Amazon SageMaker JumpStart, але є різні аспекти, про які слід пам’ятати, коли вибір моделі фундаменту.

Інтеграція безпеки в наш робочий процес

Дотримуючись найкращих практик Стовпа безпеки Добре архітектурна структура, Амазонка Когніто використовується для автентифікації. Amazon Cognito User Pools можна інтегрувати зі сторонніми постачальниками ідентифікаційних даних, які підтримують декілька інфраструктур, що використовуються для контролю доступу, зокрема Open Authorization (OAuth), OpenID Connect (OIDC) або Security Assertion Markup Language (SAML). Ідентифікація користувачів і їхніх дій дозволяє рішенню підтримувати відстеження. Рішення також використовує Виявлення персональної інформації (PII) Amazon Comprehend функція для автоматичної ідентифікації та редагування ідентифікаційної інформації. Видалена ідентифікаційна інформація містить адреси, номери соціального страхування, адреси електронної пошти та іншу конфіденційну інформацію. Цей дизайн гарантує, що будь-яка ідентифікаційна інформація, надана користувачем через вхідний запит, буде відредагована. PII не зберігається, не використовується Amazon Kendra і не передається LLM.

Покрокове керівництво рішенням

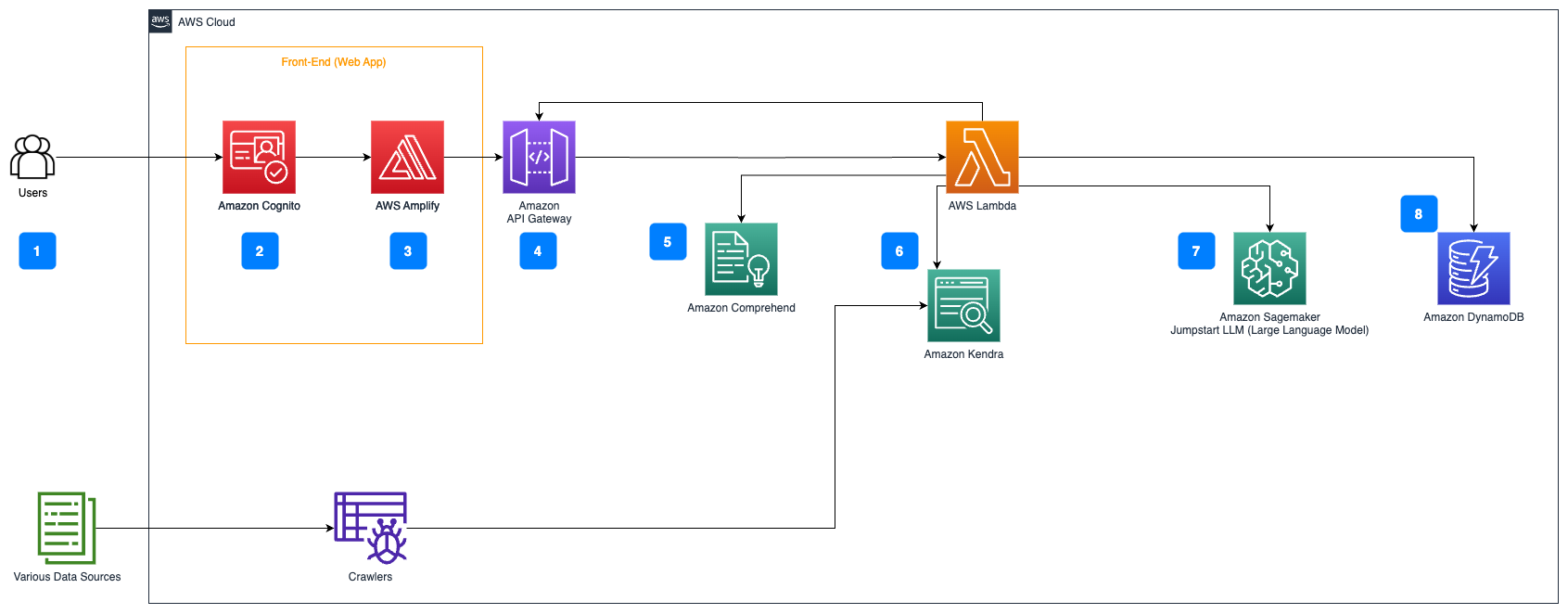

Наступні кроки описують робочий процес відповіді на запитання через потік документів:

- Користувачі надсилають запит через веб-інтерфейс.

- Амазонка Когніто використовується для автентифікації, що забезпечує безпечний доступ до веб-додатку.

- Інтерфейс веб-програми розміщено на AWS Amplify.

- API -шлюз Amazon розміщує REST API з різними кінцевими точками для обробки запитів користувачів, автентифікованих за допомогою Amazon Cognito.

- ПІІ редакція с «Амазонка»:

- Обробка запитів користувача: коли користувач надсилає запит або вводить дані, вони спочатку передаються через Amazon Comprehend. Служба аналізує текст і визначає будь-які ідентифікаційні сутності, присутні в запиті.

- Витяг ідентифікаційної інформації: Amazon Comprehend витягує виявлені ідентифікаційні дані із запиту користувача.

- Пошук відповідної інформації с Амазонка Кендра:

- Amazon Kendra використовується для керування індексом документів, який містить інформацію, яка використовується для створення відповідей на запити користувача.

- Команда LangChain QA пошук Модуль використовується для побудови ланцюжка розмов, що містить релевантну інформацію про запити користувача.

- Інтеграція з Amazon SageMaker JumpStart:

- Функція AWS Lambda використовує бібліотеку LangChain і з’єднується з кінцевою точкою Amazon SageMaker JumpStart за допомогою контекстного запиту. Кінцева точка Amazon SageMaker JumpStart служить інтерфейсом LLM, який використовується для висновків.

- Зберігання відповідей і повернення їх користувачеві:

- Відповідь від LLM зберігається в Amazon DynamoDB разом із запитом користувача, міткою часу, унікальним ідентифікатором та іншими довільними ідентифікаторами для елемента, наприклад категорією питання. Зберігання питання та відповіді як окремих елементів дозволяє функції AWS Lambda легко відтворювати історію розмов користувача на основі часу, коли було задано запитання.

- Нарешті, відповідь надсилається назад користувачеві за допомогою HTTP-запиту через інтеграційну відповідь Amazon API Gateway REST API.

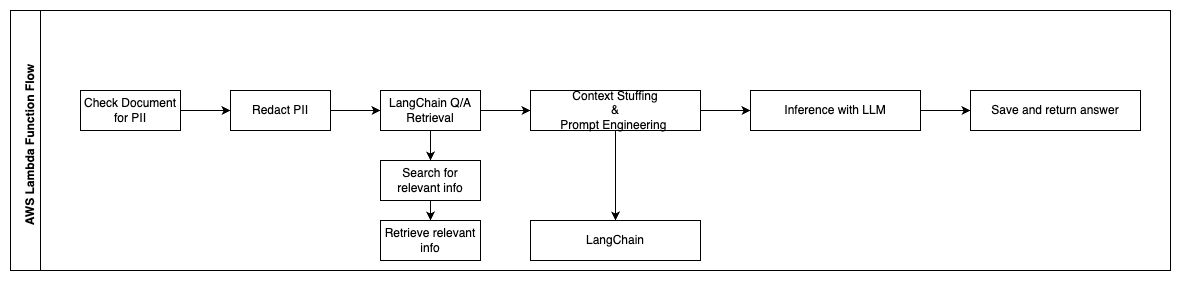

У наступних кроках описуються функції AWS Lambda та їх потік у процесі:

- Перевірте та відредагуйте будь-яку ідентифікаційну/конфіденційну інформацію

- LangChain QA Retrieval Chain

- Шукайте та отримуйте відповідну інформацію

- Наповнення контексту та підказка

- Висновок з LLM

- Повернути відповідь і зберегти її

Use cases

Існує багато бізнес-випадків, коли клієнти можуть використовувати цей робочий процес. У наступному розділі пояснюється, як робочий процес можна використовувати в різних галузях і вертикалях.

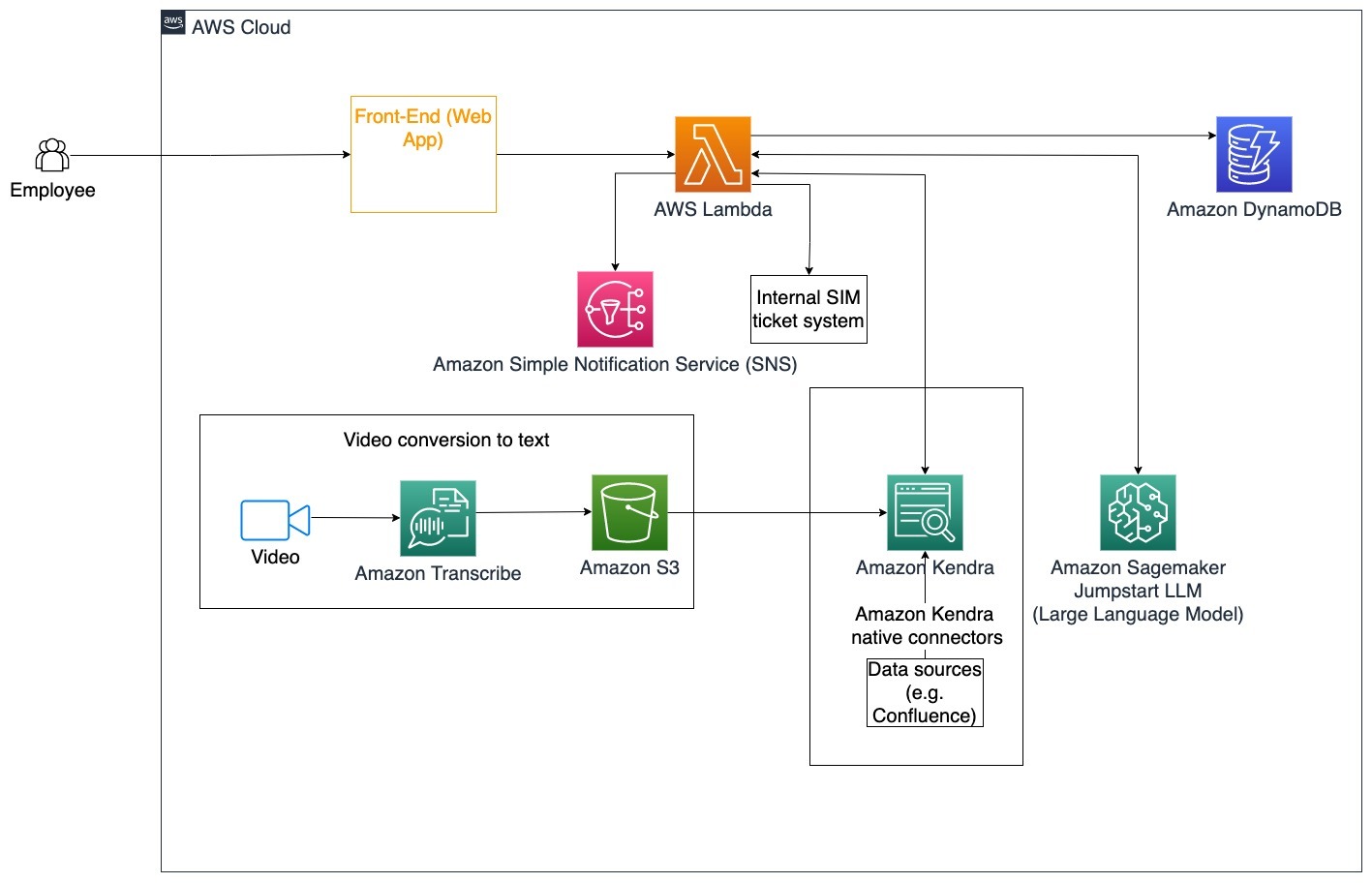

Допомога працівникам

Добре продумане корпоративне навчання може покращити задоволеність працівників і скоротити час, необхідний для адаптації нових співробітників. Оскільки організації ростуть і складність зростає, співробітникам стає важко зрозуміти численні джерела внутрішніх документів. Внутрішні документи в цьому контексті включають вказівки компанії, політику та стандартні операційні процедури. У цьому сценарії у співробітника виникає питання, як продовжити та відредагувати квиток про внутрішню проблему. Співробітник може отримати доступ і використовувати розмовний бот генеративного штучного інтелекту (AI), щоб запитувати та виконувати наступні кроки для певного квитка.

Конкретний випадок використання: Автоматизуйте вирішення проблем для співробітників на основі корпоративних інструкцій.

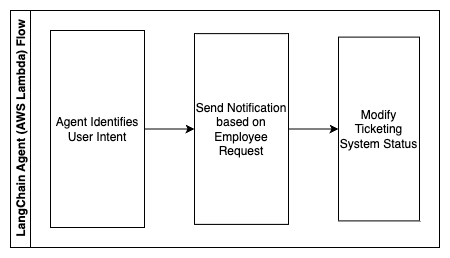

У наступних кроках описуються функції AWS Lambda та їх потік у процесі:

- Агент LangChain для визначення наміру

- Надіслати повідомлення на вимогу співробітника

- Змінити статус заявки

На цій діаграмі архітектури можна завантажувати корпоративні навчальні відео Амазонська розшифровка щоб зібрати журнал цих сценаріїв відео. Крім того, корпоративний навчальний контент, що зберігається в різних джерелах (наприклад, Confluence, Microsoft SharePoint, Google Drive, Jira тощо), можна використовувати для створення індексів через конектори Amazon Kendra. Прочитайте цю статтю, щоб дізнатися більше про колекцію рідних Роз'єми ви можете використовувати в Amazon Kendra як джерело. Тоді веб-сканер Amazon Kendra може використовувати сценарії корпоративного навчального відео та документацію, що зберігається в цих інших джерелах, щоб допомогти розмовному боту відповідати на запитання, що стосуються інструкцій щодо корпоративного навчання компанії. Агент LangChain перевіряє дозволи, змінює статус заявки та сповіщає потрібних осіб за допомогою Amazon Simple Notification Service (Amazon SNS).

Команди підтримки клієнтів

Швидке вирішення запитів клієнтів покращує взаємодію з клієнтами та заохочує лояльність до бренду. База лояльних клієнтів сприяє збільшенню продажів, що сприяє прибутку та підвищує залучення клієнтів. Команди підтримки клієнтів витрачають багато енергії, посилаючись на численні внутрішні документи та програмне забезпечення для керування взаємовідносинами з клієнтами, щоб відповісти на запити клієнтів щодо продуктів і послуг. Внутрішні документи в цьому контексті можуть включати загальні сценарії викликів служби підтримки клієнтів, посібники, інструкції з ескалації та бізнес-інформацію. Генеративний розмовний бот AI допомагає оптимізувати витрати, оскільки він обробляє запити від імені команди підтримки клієнтів.

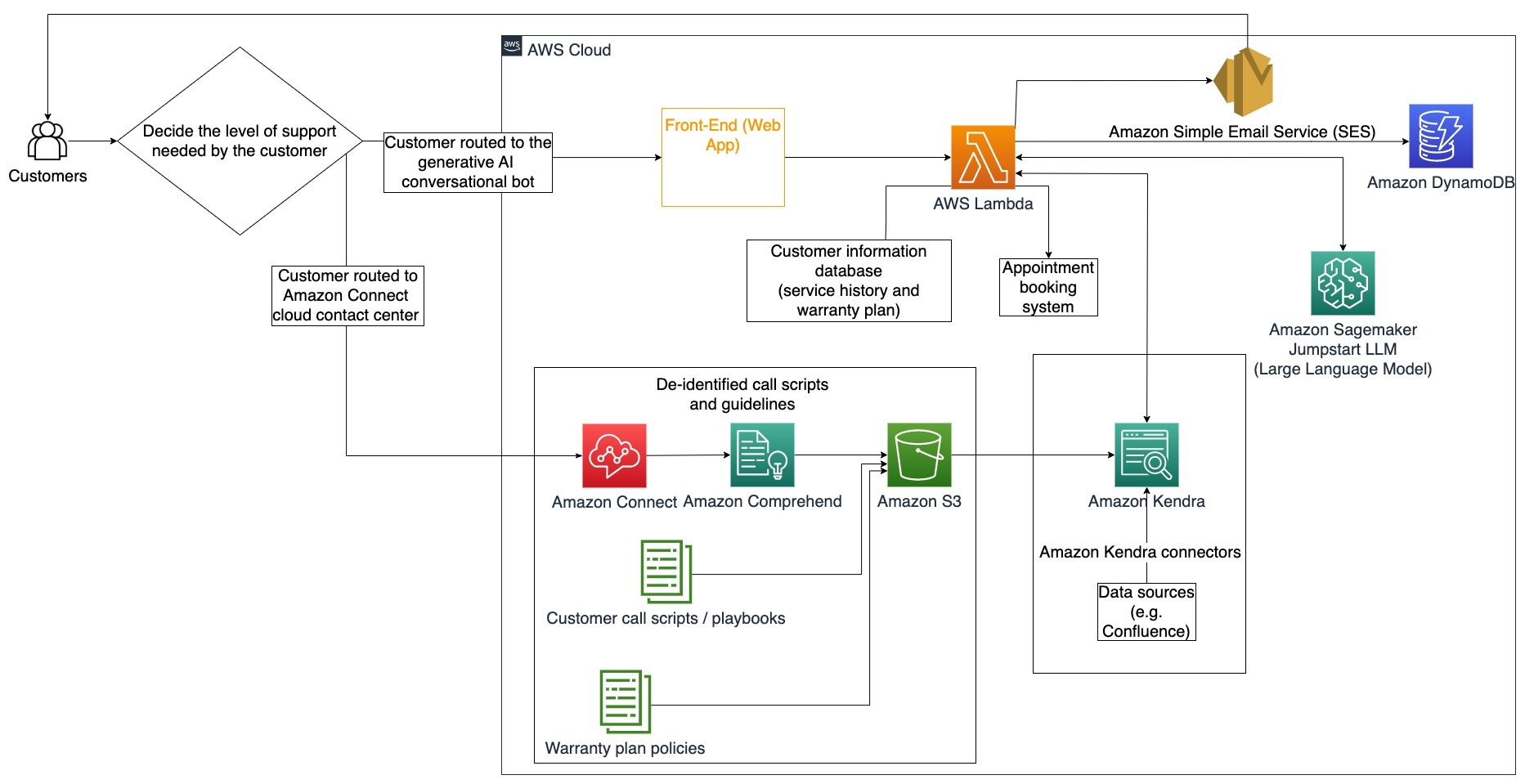

Конкретний випадок використання: Обробка запиту на заміну масла на основі історії обслуговування та придбаного плану обслуговування клієнтів.

На цій діаграмі архітектури клієнт спрямовується або до генеративного розмовного бота ШІ, або до Amazon Connect контактний центр. Це рішення може ґрунтуватися на рівні необхідної підтримки або наявності агентів служби підтримки клієнтів. Агент LangChain визначає намір клієнта та перевіряє особу. Агент LangChain також перевіряє історію обслуговування та придбаний план підтримки.

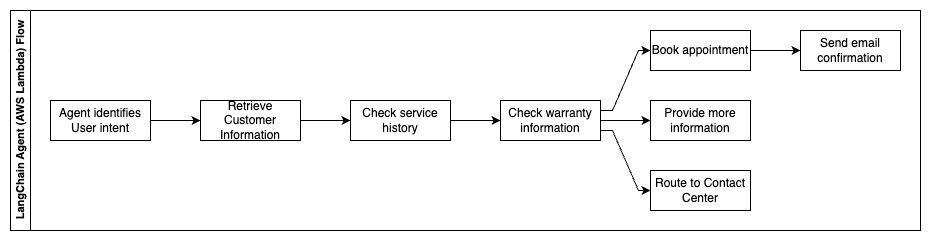

У наступних кроках описуються функції AWS Lambda та їх потік у процесі:

- Агент LangChain визначає намір

- Отримати інформацію про клієнта

- Перевірте історію обслуговування клієнтів і інформацію про гарантію

- Забронюйте зустріч, надайте додаткову інформацію або маршрут до контакт-центру

- Надіслати підтвердження електронною поштою

Amazon Connect використовується для збору голосових журналів і журналів чату, а Amazon Comprehend використовується для видалення ідентифікаційної інформації (PII) із цих журналів. Потім сканер Amazon Kendra може використовувати відредаговані голосові журнали та журнали чату, сценарії викликів клієнтів і політики плану обслуговування клієнтів для створення індексу. Після прийняття рішення генеративний розмовний бот штучного інтелекту вирішує, записатися на прийом, надати додаткову інформацію чи направити клієнта до контакт-центру для отримання додаткової допомоги. Для оптимізації витрат агент LangChain також може генерувати відповіді, використовуючи меншу кількість токенів і менш дорогу модель великої мови для запитів клієнтів із меншим пріоритетом.

Фінансові послуги

Фінансові компанії покладаються на своєчасне використання інформації, щоб залишатися конкурентоспроможними та відповідати фінансовим нормам. За допомогою генеративного розмовного бота зі штучним інтелектом фінансові аналітики та консультанти можуть взаємодіяти з текстовою інформацією в розмовній манері та скоротити час і зусилля, необхідні для прийняття більш обґрунтованих рішень. Крім інвестицій і маркетингових досліджень, генеративний розмовний бот зі штучним інтелектом також може розширити людські можливості, вирішуючи завдання, які традиційно вимагали б більше людських зусиль і часу. Наприклад, фінансова установа, що спеціалізується на персональних позиках, може збільшити швидкість обробки позик, забезпечуючи при цьому кращу прозорість для клієнтів.

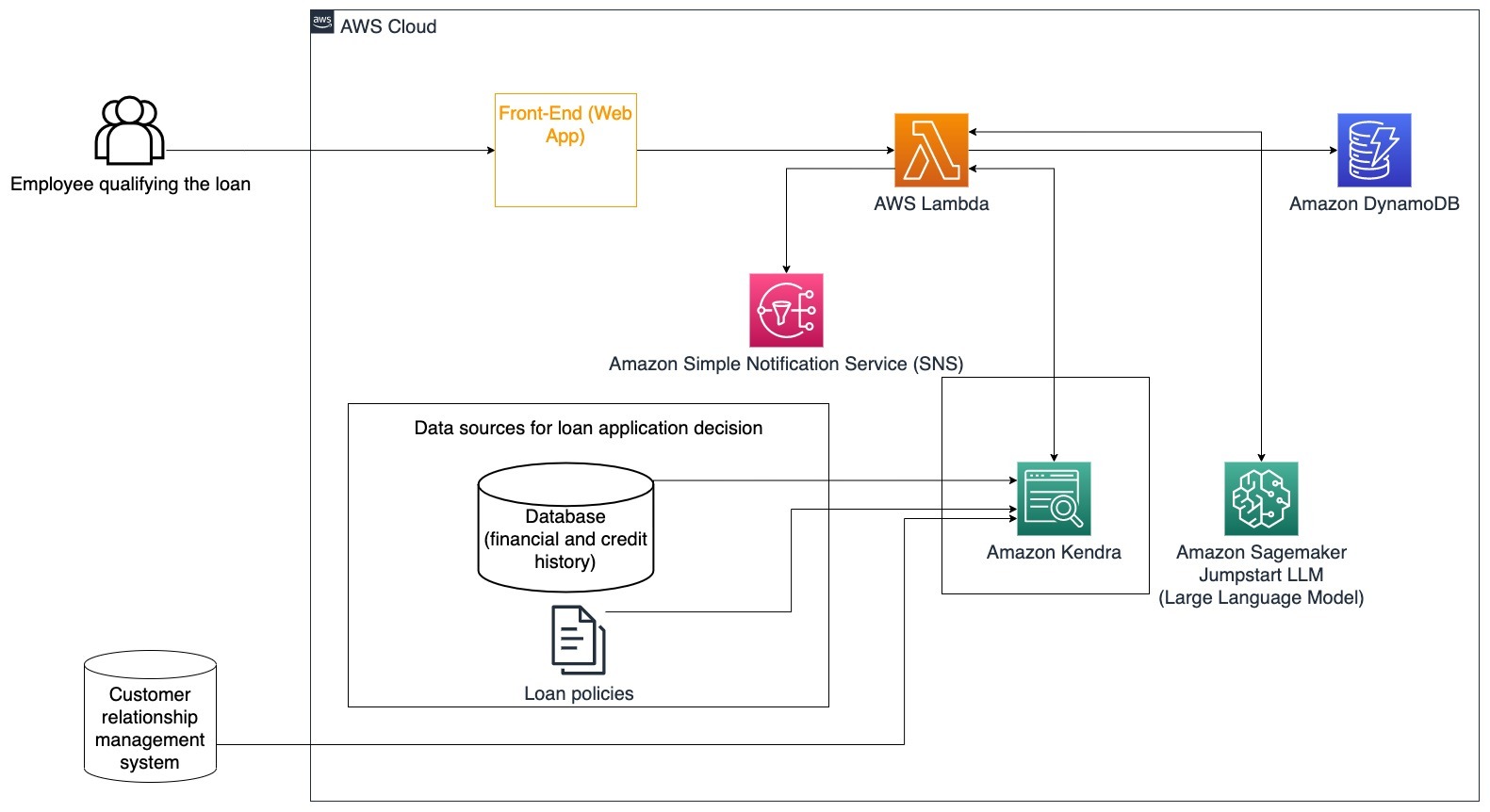

Конкретний випадок використання: Використовуйте фінансову історію клієнта та попередні заявки на позику, щоб прийняти рішення та пояснити рішення про позику.

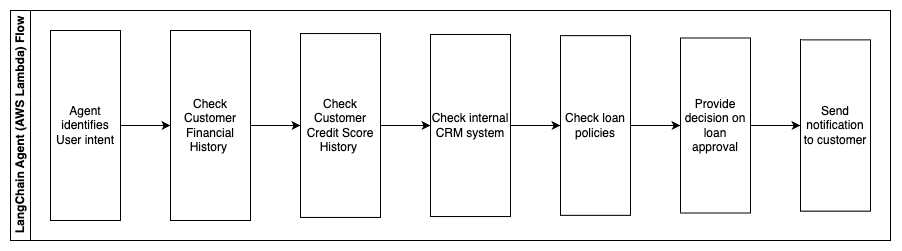

У наступних кроках описуються функції AWS Lambda та їх потік у процесі:

- Агент LangChain для визначення наміру

- Перевірте фінансову та кредитну історію клієнта

- Перевірте внутрішню систему управління взаємовідносинами з клієнтами

- Перевірте стандартну кредитну політику та запропонуйте рішення для працівника, який відповідає вимогам кредиту

- Надіслати сповіщення клієнту

Ця архітектура включає фінансові дані клієнта, що зберігаються в базі даних, і дані, що зберігаються в інструменті керування взаємовідносинами з клієнтами (CRM). Ці точки даних використовуються для прийняття рішення на основі внутрішньої кредитної політики компанії. Клієнт може поставити уточнюючі запитання, щоб зрозуміти, на які позики він має право та умови позик, які він може прийняти. Якщо генеративний розмовний бот штучного інтелекту не може схвалити заявку на позику, користувач все одно може поставити запитання щодо покращення кредитних балів або альтернативних варіантів фінансування.

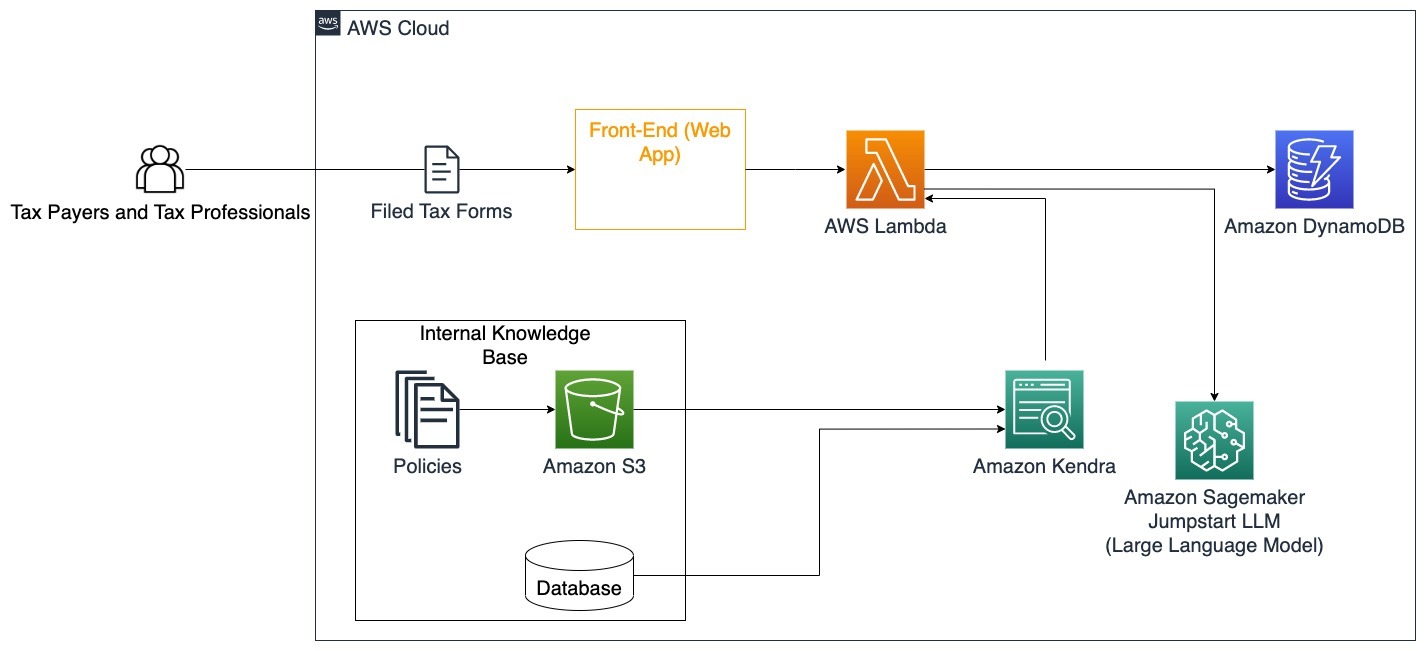

Уряд

Генеративні розмовні боти штучного інтелекту можуть значно принести користь державним установам, пришвидшивши комунікацію, ефективність і процеси прийняття рішень. Розмовні боти Generative AI також можуть надавати миттєвий доступ до внутрішніх баз знань, щоб допомогти державним службовцям швидко отримувати інформацію, політики та процедури (тобто критерії прийнятності, процеси подання заявок, а також служби та підтримку для громадян). Одним із рішень є інтерактивна система, яка дозволяє платникам податків і податковим фахівцям легко знаходити податкові деталі та переваги. Його можна використовувати для розуміння запитань користувачів, узагальнення податкових документів і надання чітких відповідей за допомогою інтерактивних розмов.

Користувачі можуть задавати такі запитання, як:

- Як працює податок на спадщину та які податкові пороги?

- Чи можете ви пояснити поняття податку на прибуток?

- Які податкові наслідки при продажу другої нерухомості?

Крім того, користувачі можуть мати зручність надсилання податкових форм до системи, яка може допомогти перевірити правильність наданої інформації.

Ця архітектура ілюструє, як користувачі можуть завантажувати заповнені податкові форми в рішення та використовувати їх для інтерактивної перевірки та вказівок щодо точного заповнення необхідної інформації.

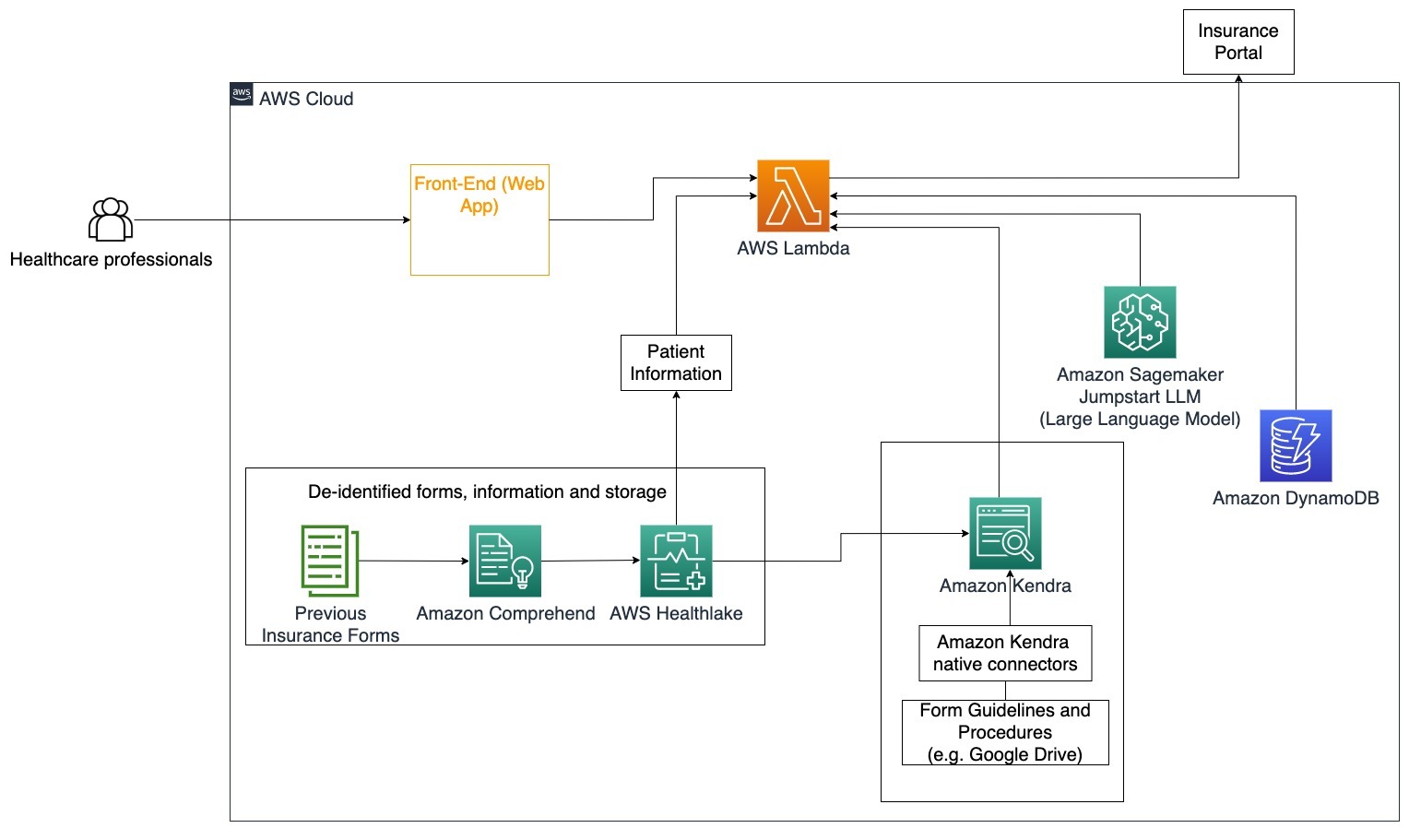

Здоров'я

Підприємства охорони здоров’я мають можливість автоматизувати використання великої кількості внутрішньої інформації про пацієнтів, а також відповідати на загальні запитання щодо варіантів використання, таких як варіанти лікування, страхові вимоги, клінічні випробування та фармацевтичні дослідження. Використання генеративного розмовного бота штучного інтелекту дозволяє швидко й точно генерувати відповіді про інформацію про здоров’я з наданої бази знань. Наприклад, деякі медичні працівники витрачають багато часу на заповнення форм для подання страхових вимог.

У подібних умовах адміністратори клінічних випробувань і дослідники повинні знайти інформацію про варіанти лікування. Генеративний розмовний бот зі штучним інтелектом може використовувати попередньо створені з’єднувачі в Amazon Kendra, щоб отримувати найрелевантнішу інформацію з мільйонів документів, опублікованих у результаті поточних досліджень, які проводять фармацевтичні компанії та університети.

Конкретний випадок використання: Зменште кількість помилок і час, необхідний для заповнення та надсилання страхових форм.

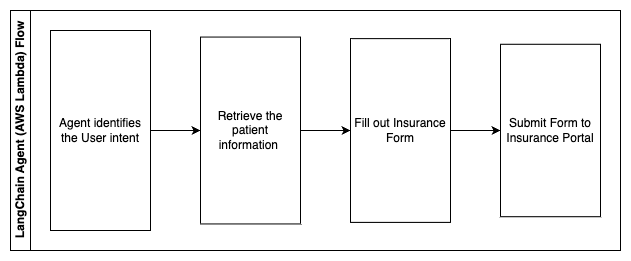

На цій схемі архітектури медичний працівник може використовувати генеративний розмовний бот ШІ, щоб визначити, які форми потрібно заповнити для страхування. Потім агент LangChain може отримати потрібні форми та додати необхідну інформацію для пацієнта, а також надати відповіді на описові частини форм на основі страхових полісів і попередніх форм. Медичний працівник може редагувати відповіді, надані LLM, перш ніж затвердити та відправити форму на страховий портал.

У наступних кроках описуються функції AWS Lambda та їх потік у процесі:

- Агент LangChain для визначення наміру

- Отримайте необхідну інформацію про пацієнта

- Заповніть форму страхування на основі інформації про пацієнта та вказівок щодо форми

- Надішліть форму на страховий портал після схвалення користувача

AWS HealthLake використовується для безпечного зберігання даних про здоров’я, включаючи попередні страхові форми та інформацію про пацієнтів, а Amazon Comprehend використовується для видалення особистої інформації (PII) із попередніх страхових форм. Потім сканер Amazon Kendra може використовувати набір страхових форм і вказівок для створення індексу. Після того, як форма(и) заповнена генеративним штучним інтелектом, форма(и), переглянута медичним працівником, може бути надіслана на портал страхування.

Кошторис

Вартість розгортання базового рішення для підтвердження концепції показано в наступній таблиці. Оскільки базове рішення вважається доказом концепції, Amazon Kendra Developer Edition було використано як недорогий варіант, оскільки робоче навантаження не було б у виробництві. Наше припущення для Amazon Kendra Developer Edition становило 730 активних годин на місяць.

Для Amazon SageMaker ми зробили припущення, що клієнт використовуватиме екземпляр ml.g4dn.2xlarge для висновку в реальному часі з однією кінцевою точкою висновку на екземпляр. Ви можете знайти більше інформації про ціни Amazon SageMaker і доступні типи екземплярів висновку тут.

| Обслуговування | Спожиті ресурси | Оцінка вартості на місяць у доларах США |

| AWS Amplify | 150 хвилин збірки Обслуговується 1 ГБ даних 500,000 запитів |

15.71 |

| API -шлюз Amazon | 1 млн викликів REST API | 3.5 |

| AWS Lambda | 1 мільйон запитів Тривалість 5 секунд на запит Виділено 2 ГБ пам'яті |

160.23 |

| Amazon DynamoDB | 1 мільйонів читань 1 мільйон пише зберігання 100 GB |

26.38 |

| Amazon Sagemaker | Висновок у реальному часі з ml.g4dn.2xlarge | 676.8 |

| Амазонка Кендра | Версія для розробників із 730 годинами на місяць Відскановано 10,000 XNUMX документів 5,000 запитів/день |

821.25 |

| . | . | Загальна вартість: 1703.87 |

* Amazon Cognito має безкоштовний рівень із 50,000 50 активних користувачів щомісяця, які використовують пули користувачів Cognito, або 2.0 активних користувачів щомісяця, які використовують постачальників ідентифікаційних даних SAML XNUMX

Прибирати

Щоб заощадити кошти, видаліть усі ресурси, які ви розгорнули під час навчання. Ви можете видалити будь-які кінцеві точки SageMaker, які ви могли створити за допомогою консолі SageMaker. Пам’ятайте, видалення індексу Amazon Kendra не видаляє оригінальні документи з вашого сховища.

Висновок

У цьому дописі ми показали вам, як спростити доступ до внутрішньої інформації шляхом узагальнення з кількох сховищ у режимі реального часу. Після нещодавніх розробок комерційно доступних LLM можливості генеративного ШІ стали більш очевидними. У цій публікації ми продемонстрували способи використання служб AWS для створення безсерверного чат-бота, який використовує генеративний штучний інтелект для відповідей на запитання. Цей підхід включає рівень автентифікації та виявлення ідентифікаційної інформації Amazon Comprehend для фільтрації будь-якої конфіденційної інформації, наданої в запиті користувача. Незалежно від того, чи то працівники охорони здоров’я, які розуміють нюанси оформлення страхових претензій, чи то відділ кадрів, який розуміє конкретні нормативні акти всієї компанії, є багато галузей і галузей, які можуть скористатися цим підходом. Базова модель Amazon SageMaker JumpStart є механізмом, що стоїть за чат-ботом, тоді як підхід доповнення контекстом із використанням техніки RAG використовується для того, щоб відповіді точніше посилалися на внутрішні документи.

Щоб дізнатися більше про роботу з генеративним ШІ на AWS, див Анонс нових інструментів для створення з Generative AI на AWS. Щоб отримати докладніші вказівки щодо використання техніки RAG зі службами AWS, див Швидко створюйте високоточні програми Generative AI на корпоративних даних за допомогою Amazon Kendra, LangChain і великих мовних моделей. Оскільки підхід у цьому блозі є агностиком LLM, будь-який LLM можна використовувати для висновків. У нашій наступній публікації ми окреслимо способи впровадження цього рішення за допомогою Amazon Bedrock і Amazon Titan LLM.

Про авторів

Абхішек Малігехаллі Шівалінгая є старшим архітектором рішень AI Services в AWS. Він захоплений створенням програм за допомогою Generative AI, Amazon Kendra та NLP. Він має близько 10 років досвіду створення рішень для обробки даних і ШІ для створення цінності для клієнтів і підприємств. Він навіть створив (персональний) чат-бот для розваги, щоб відповідати на запитання про свою кар’єру та професійний шлях. Поза роботою він любить робити портрети родини та друзів, а також любить створювати твори мистецтва.

Абхішек Малігехаллі Шівалінгая є старшим архітектором рішень AI Services в AWS. Він захоплений створенням програм за допомогою Generative AI, Amazon Kendra та NLP. Він має близько 10 років досвіду створення рішень для обробки даних і ШІ для створення цінності для клієнтів і підприємств. Він навіть створив (персональний) чат-бот для розваги, щоб відповідати на запитання про свою кар’єру та професійний шлях. Поза роботою він любить робити портрети родини та друзів, а також любить створювати твори мистецтва.

Медха Айя є асоційованим архітектором рішень в AWS, що базується в Остіні, штат Техас. У грудні 2022 року вона нещодавно закінчила Техаський університет у Далласі, отримавши ступінь магістра комп’ютерних наук зі спеціалізацією в інтелектуальних системах, зосередженою на ШІ/ML. Їй цікаво дізнатися більше про AI/ML і використання сервісів AWS, щоб знайти рішення, від яких клієнти можуть отримати вигоду.

Медха Айя є асоційованим архітектором рішень в AWS, що базується в Остіні, штат Техас. У грудні 2022 року вона нещодавно закінчила Техаський університет у Далласі, отримавши ступінь магістра комп’ютерних наук зі спеціалізацією в інтелектуальних системах, зосередженою на ШІ/ML. Їй цікаво дізнатися більше про AI/ML і використання сервісів AWS, щоб знайти рішення, від яких клієнти можуть отримати вигоду.

Уго Це є асоційованим архітектором рішень в AWS, що базується в Сіетлі, штат Вашингтон. Він має ступінь магістра інформаційних технологій в Університеті штату Арізона та ступінь бакалавра економіки в Чиказькому університеті. Він є членом Асоціації аудиту та контролю інформаційних систем (ISACA) та Міжнародного консорціуму сертифікації безпеки інформаційних систем (ISC)2. Йому подобається допомагати клієнтам отримувати користь від технологій.

Уго Це є асоційованим архітектором рішень в AWS, що базується в Сіетлі, штат Вашингтон. Він має ступінь магістра інформаційних технологій в Університеті штату Арізона та ступінь бакалавра економіки в Чиказькому університеті. Він є членом Асоціації аудиту та контролю інформаційних систем (ISACA) та Міжнародного консорціуму сертифікації безпеки інформаційних систем (ISC)2. Йому подобається допомагати клієнтам отримувати користь від технологій.

Айман Ішимве є асоційованим архітектором рішень в AWS, що базується в Сіетлі, штат Вашингтон. Він має ступінь магістра з програмної інженерії та ІТ в Оклендському університеті. Він має попередній досвід розробки програмного забезпечення, зокрема створення мікросервісів для розподілених веб-додатків. Він захоплено допомагає клієнтам створювати надійні та масштабовані рішення в хмарних сервісах AWS, дотримуючись найкращих практик.

Айман Ішимве є асоційованим архітектором рішень в AWS, що базується в Сіетлі, штат Вашингтон. Він має ступінь магістра з програмної інженерії та ІТ в Оклендському університеті. Він має попередній досвід розробки програмного забезпечення, зокрема створення мікросервісів для розподілених веб-додатків. Він захоплено допомагає клієнтам створювати надійні та масштабовані рішення в хмарних сервісах AWS, дотримуючись найкращих практик.

Шервін Суреш є асоційованим архітектором рішень в AWS, що базується в Остіні, штат Техас. Він отримав ступінь магістра з розробки програмного забезпечення з концентрацією на хмарних обчисленнях і віртуалізації та ступінь бакалавра з комп’ютерної інженерії в Державному університеті Сан-Хосе. Він захоплений використанням технологій, щоб допомогти покращити життя людей з будь-якого походження.

Шервін Суреш є асоційованим архітектором рішень в AWS, що базується в Остіні, штат Техас. Він отримав ступінь магістра з розробки програмного забезпечення з концентрацією на хмарних обчисленнях і віртуалізації та ступінь бакалавра з комп’ютерної інженерії в Державному університеті Сан-Хосе. Він захоплений використанням технологій, щоб допомогти покращити життя людей з будь-якого походження.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. Автомобільні / електромобілі, вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- ChartPrime. Розвивайте свою торгову гру за допомогою ChartPrime. Доступ тут.

- BlockOffsets. Модернізація екологічної компенсаційної власності. Доступ тут.

- джерело: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- : має

- :є

- : ні

- :де

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Здатний

- МЕНЮ

- Прийняти

- доступ

- доступ до

- Рахунки

- точний

- точно

- дії

- активний

- додавати

- Додатково

- адреси

- адресація

- Адміністратори

- Прийняття

- радники

- після

- Агент

- агенти

- сукупність

- AI

- Послуги ШІ

- AI / ML

- ВСІ

- дозволяє

- по

- Також

- альтернатива

- Amazon

- API -шлюз Amazon

- Амазонка Когніто

- «Амазонка»

- Амазонка Кендра

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- кількість

- суми

- an

- аналітики

- аналізи

- та

- відповідь

- Відповіді

- будь-який

- API

- здається

- додаток

- застосування

- призначення

- підхід

- схвалювати

- архітектура

- ЕСТЬ

- виникати

- Арізона

- навколо

- стаття

- штучний

- штучний інтелект

- Штучний інтелект (AI)

- художні твори

- AS

- запитати

- аспекти

- оцінити

- допомогу

- Допомога

- Юрист

- асоційований

- Асоціація

- припущення

- At

- аудит

- збільшено

- Остін

- автентифіковано

- Authentication

- авторизації

- автоматизувати

- автоматично

- наявність

- доступний

- AWS

- AWS Lambda

- назад

- фони

- база

- заснований

- BE

- ведмідь

- оскільки

- ставати

- стає

- було

- перед тим

- імені

- за

- користь

- Переваги

- КРАЩЕ

- передового досвіду

- Краще

- Блог

- книга

- Бот

- обидва

- боти

- дно

- марка

- бюджет

- будувати

- Створюємо

- побудований

- бізнес

- підприємства

- але

- by

- call

- CAN

- можливості

- кар'єра

- обережно

- випадок

- випадків

- Категорія

- викликаний

- Центр

- централізована

- певний

- сертифікація

- ланцюг

- проблеми

- зміна

- стягується

- Chatbot

- контроль

- Перевірки

- Чикаго

- претензій

- ясно

- Клінічний

- клінічні випробування

- хмара

- хмарних обчислень

- хмарні сервіси

- збирати

- збір

- комерційно

- загальний

- Комунікація

- Компанії

- компанія

- Компанії

- конкурентоспроможний

- Зроблено

- завершення

- комплекс

- складність

- дотримуватися

- осягнути

- комп'ютер

- Комп'ютерна інженерія

- Інформатика

- обчислення

- концентрація

- концепція

- лаконічний

- проводиться

- злиття

- З'єднуватися

- з'єднує

- розгляду

- міркування

- вважається

- послідовний

- Складається

- Консоль

- консорціуму

- споживати

- споживання

- контакт

- контакт-центр

- містить

- зміст

- контекст

- постійно

- сприяє

- контроль

- управління

- зручність

- Розмова

- діалоговий

- розмови

- Корпоративний

- виправити

- Коштувати

- витрати

- гусеничний

- створювати

- Створити цінність

- створений

- створення

- кредит

- Критерії

- критичний

- CRM

- вирішальне значення

- Куратор

- Поточний

- В даний час

- клієнт

- Залучення клієнтів

- Досвід клієнтів

- Контакти

- підтримка клієнтів

- Клієнти

- щодня

- Даллас

- дані

- точки даних

- набори даних

- Database

- Дата

- Грудень

- вирішувати

- рішення

- Прийняття рішень

- рішення

- Ступінь

- поставляється

- Залежно

- розгорнути

- розгортання

- описувати

- дизайн

- Незважаючи на

- деталі

- виявлено

- Виявлення

- Розробник

- розробка

- події

- різний

- важкий

- відкрити

- розподілений

- документація

- документація

- робить

- Ні

- управляти

- тривалість

- e

- легше

- легко

- Економіка

- екосистема

- видання

- ефективність

- зусилля

- або

- права

- повідомлення електронної пошти

- Співробітник

- співробітників

- дозволяє

- заохочує

- Кінцева точка

- енергія

- зачеплення

- двигун

- Машинобудування

- збагачення

- забезпечувати

- гарантує

- забезпечення

- підприємство

- підприємств

- юридичні особи

- помилки

- ескалація

- оцінити

- і т.д.

- Навіть

- приклад

- виконувати

- існуючий

- дорогий

- досвід

- Пояснювати

- Пояснює

- видобуток

- Виписки

- Face

- сім'я

- особливість

- Fed

- менше

- Рисунок

- філе

- заповнювати

- заповнений

- наповнення

- фільтрувати

- фінансовий

- фінансові дані

- фінансова історія

- фінансова установа

- фінансування

- знайти

- виявлення

- Перший

- Гнучкість

- потік

- фокусування

- після

- для

- форма

- форми

- форуми

- знайдений

- фонд

- каркаси

- Безкоштовна

- друзі

- від

- веселощі

- функція

- Функції

- далі

- Отримувати

- шлюз

- породжувати

- покоління

- генеративний

- Генеративний ШІ

- отримати

- даний

- дає

- дає

- Уряд

- значно

- Рости

- Зростання

- Зростає

- керівництво

- керівні вказівки

- обробляти

- Ручки

- Обробка

- Мати

- має

- he

- здоров'я

- інформація про стан здоров'я

- охорона здоров'я

- допомога

- допомогу

- допомагає

- її

- Високий

- дуже

- його

- історія

- тримає

- відбувся

- хостів

- ГОДИННИК

- Як

- How To

- Однак

- hr

- HTML

- HTTPS

- людина

- i

- ідентифікатор

- ідентифікатори

- ідентифікує

- ідентифікувати

- ідентифікує

- Особистість

- if

- ілюструє

- здійснювати

- реалізації

- наслідки

- удосконалювати

- поліпшується

- поліпшення

- in

- поглиблений

- неточні

- включати

- includes

- У тому числі

- Дохід

- податок на прибуток

- Augmenter

- Збільшує

- індекс

- індексований

- покажчики

- осіб

- промисловості

- повідомити

- інформація

- Інформаційні системи

- інформаційна технологія

- повідомив

- спадкування

- вхід

- екземпляр

- мить

- замість

- Установа

- установи

- страхування

- інтегрований

- Інтеграція

- інтеграція

- Інтелект

- Розумний

- намір

- взаємодіяти

- інтерактивний

- зацікавлений

- інтерфейс

- внутрішній

- Міжнародне покриття

- в

- інвестиції

- питання

- IT

- пунктів

- подорож

- JPG

- тримати

- знання

- відомий

- мова

- великий

- шар

- вести

- УЧИТЬСЯ

- вивчення

- менше

- рівень

- використання

- бібліотека

- обмеження

- недоліки

- Лінія

- Місце проживання

- LLM

- позику

- Кредити

- журнал

- логічний

- Довго

- багато часу

- довше

- подивитися

- серія

- любить

- недорогий

- знизити

- лояльний

- Лояльність

- машина

- навчання за допомогою машини

- made

- підтримувати

- зробити

- РОБОТИ

- Робить

- управляти

- управління

- манера

- керівництво

- вручну

- багато

- ринок

- дослідження ринку

- магістра

- Може..

- засоби

- медичний

- член

- пам'ять

- мікросервіс

- Microsoft

- мільйона

- мільйони

- mind

- ML

- модель

- Моделі

- Модулі

- місяць

- щомісячно

- більше

- найбільш

- множинний

- рідний

- необхідно

- Необхідність

- необхідний

- потреби

- Нові

- наступний

- nlp

- сповіщення

- номера

- Окленд

- oauth

- of

- Пропозиції

- часто

- Нафта

- on

- На борту

- один раз

- ONE

- постійний

- тільки

- відкрити

- працювати

- операційний

- оперативний

- Можливість

- оптимізація

- варіант

- Опції

- or

- порядок

- організації

- оригінал

- Інше

- наші

- з

- план

- поза

- над

- парадигма

- частина

- частини

- Пройшов

- пристрасний

- пацієнт

- Платити

- Люди

- для

- продуктивність

- Дозволи

- персонал

- особисті дані

- Особисто

- фармацевтична

- стовп

- план

- plato

- Інформація про дані Платона

- PlatoData

- будь ласка

- точка

- точок

- Політика

- Басейни

- Портал

- портрети

- можливостей

- можливість

- пошта

- Харчування

- практики

- представити

- запобігати

- попередній

- раніше

- ціни без прихованих комісій

- модель ціноутворення

- попередній

- пріоритет

- недоторканність приватного життя

- проблеми

- Процедури

- продовжити

- процес

- Оброблено

- процеси

- обробка

- Production

- продуктивність

- Продукти

- професійний

- професіонали

- власність

- забезпечувати

- за умови

- провайдери

- забезпечення

- опублікований

- придбано

- Питання та відповіді

- кваліфікувати

- кваліфікаційний

- запити

- питання

- питань

- Швидко

- швидко

- діапазон

- ставка

- Читати

- читання

- реального часу

- останній

- нещодавно

- зменшити

- знижує

- послатися

- посилання

- про

- регулярно

- правила

- відносини

- актуальність

- доречний

- покладатися

- залишається

- запам'ятати

- видаляти

- запросити

- запитів

- вимагати

- вимагається

- Вимога

- дослідження

- Дослідники

- дозвіл

- рішення

- ресурси

- відповідь

- відповіді

- відповідальність

- REST

- результат

- повернення

- відгуки

- право

- ризики

- міцний

- Маршрут

- біг

- s

- мудрець

- продажів

- Сан -

- Сан - Хосе

- задоволення

- зберегти

- масштабовані

- шкала

- сценарій

- наука

- рахунок

- scripts

- Пошук

- Грати короля карти - безкоштовно Nijumi логічна гра гри

- Сіетл

- другий

- seconds

- розділ

- безпечний

- безпечно

- безпеку

- Продаж

- послати

- старший

- чутливий

- посланий

- Без сервера

- служить

- обслуговування

- Послуги

- комплект

- набори

- налаштування

- кілька

- вона

- зсув

- недоліки

- Повинен

- продемонстрований

- показав

- показаний

- силоси

- аналогічний

- простий

- спростити

- з

- один

- розміром

- менше

- So

- соціальна

- Софтвер

- розробка програмного забезпечення

- розробка програмного забезпечення

- рішення

- Рішення

- деякі

- Source

- Джерела

- спеціалізується

- конкретний

- конкретно

- витрачати

- Витрати

- standard

- стан

- Статус

- залишатися

- Крок

- заходи

- Як і раніше

- зберігання

- зберігати

- зберігати

- зберігання

- стрес

- начинка

- істотний

- такі

- пропонувати

- підсумовувати

- підтримка

- система

- Systems

- таблиця

- приймає

- завдання

- податок

- команда

- команди

- Технологія

- terms

- Техас

- текст

- текстуальний

- Що

- Команда

- інформація

- їх

- самі

- потім

- Там.

- Ці

- вони

- третя сторона

- це

- через

- квиток

- квитки

- ярус

- час

- трудомісткий

- своєчасно

- times

- відмітка часу

- велетень

- до

- сьогодні

- Жетони

- інструмент

- інструменти

- Простежуваність

- традиційно

- навчений

- Навчання

- трансформатор

- прозорість

- лікування

- суд

- випробування

- підручник

- Типи

- не в змозі

- розуміти

- розуміння

- створеного

- університети

- університет

- Чиказький університет

- відповідний сучасним вимогам

- оновлений

- оновлення

- використання

- використання випадку

- використовуваний

- користувач

- користувачі

- використовує

- використання

- використовувати

- використовувати

- використовує

- значення

- різний

- перевірка

- перевірити

- вертикалі

- через

- Відео

- Відео

- Голос

- чекати

- Очікування

- було

- Вашингтон

- способи

- we

- Web

- Веб-додаток

- веб-додатки

- веб-сервіси

- ДОБРЕ

- були

- Що

- коли

- Чи

- який

- в той час як

- ВООЗ

- широкий

- Широкий діапазон

- з

- в

- Work

- робочий

- робочий

- б

- письмовий

- років

- Ти

- вашу

- зефірнет