Вступ

У машинному навчанні компроміс зміщення-дисперсії є фундаментальною концепцією, яка впливає на ефективність будь-якої прогнозної моделі. Це відноситься до тонкого балансу між похибкою зміщення та похибкою дисперсії моделі, оскільки неможливо одночасно мінімізувати обидва. Встановлення правильного балансу має вирішальне значення для досягнення оптимальної продуктивності моделі.

У цій короткій статті ми визначимо зміщення та дисперсію, пояснимо, як вони впливають на модель машинного навчання, і надамо кілька практичних порад щодо того, як із ними впоратися на практиці.

Розуміння зміщення та дисперсії

Перш ніж заглибитися у взаємозв’язок між зміщенням і дисперсією, давайте визначимо, що означають ці терміни в машинному навчанні.

Помилка зсуву стосується різниці між прогнозом моделі та правильними значеннями, які вона намагається передбачити (основна істина). Іншими словами, зміщення — це помилка моделі через її неправильні припущення щодо базового розподілу даних. Моделі з високим зміщенням часто надто спрощені, не враховуючи складність даних, що призводить до недостатнього підбору.

Помилка дисперсії, з іншого боку, відноситься до чутливості моделі до невеликих коливань у навчальних даних. Моделі з високою дисперсією є надто складними і, як правило, підлаштовуються під шум у даних, а не під базовий шаблон, що призводить до переобладнання. Це призводить до низької продуктивності нових, невидимих даних.

Високе зміщення може призвести до недостатнього підбору, коли модель занадто проста, щоб охопити всю складність даних. Він робить сильні припущення щодо даних і не в змозі зафіксувати справжній зв’язок між вхідними та вихідними змінними. З іншого боку, висока дисперсія може призвести до переобладнання, коли модель є надто складною та вивчає шум у даних, а не основний зв’язок між вхідними та вихідними змінними. Таким чином, моделі з надмірною адаптацією, як правило, надто точно відповідають навчальним даним і погано узагальнюють нові дані, тоді як моделі з недостатньою адаптацією навіть не можуть точно відповідати навчальним даним.

Як згадувалося раніше, зміщення та дисперсія пов’язані, і хороша модель балансує між помилкою зміщення та помилкою дисперсії. Компроміс зміщення – це процес пошуку оптимального балансу між цими двома джерелами помилок. Модель з низьким зміщенням і низькою дисперсією, швидше за все, добре працюватиме як на навчанні, так і на нових даних, мінімізуючи загальну помилку.

Компроміс зміщення та дисперсії

Досягнення балансу між складністю моделі та її здатністю узагальнювати невідомі дані є основою компромісу зміщення та дисперсії. Загалом, більш складна модель матиме менший зсув, але вищу дисперсію, тоді як простіша модель матиме вищий зсув, але меншу дисперсію.

Оскільки неможливо одночасно мінімізувати зміщення та дисперсію, пошук оптимального балансу між ними має вирішальне значення для створення надійної моделі машинного навчання. Наприклад, коли ми збільшуємо складність моделі, ми також збільшуємо дисперсію. Це пов’язано з тим, що більш складна модель, швидше за все, відповідатиме шуму в навчальних даних, що призведе до переобладнання.

З іншого боку, якщо ми залишимо модель занадто простою, ми збільшимо упередження. Це пояснюється тим, що простіша модель не зможе охопити базові зв’язки в даних, що призведе до недостатнього підбору.

Мета полягає в тому, щоб навчити модель, яка є досить складною, щоб охопити базові зв’язки в навчальних даних, але не настільки складною, щоб відповідати шуму в навчальних даних.

Компроміс зміщення та дисперсії на практиці

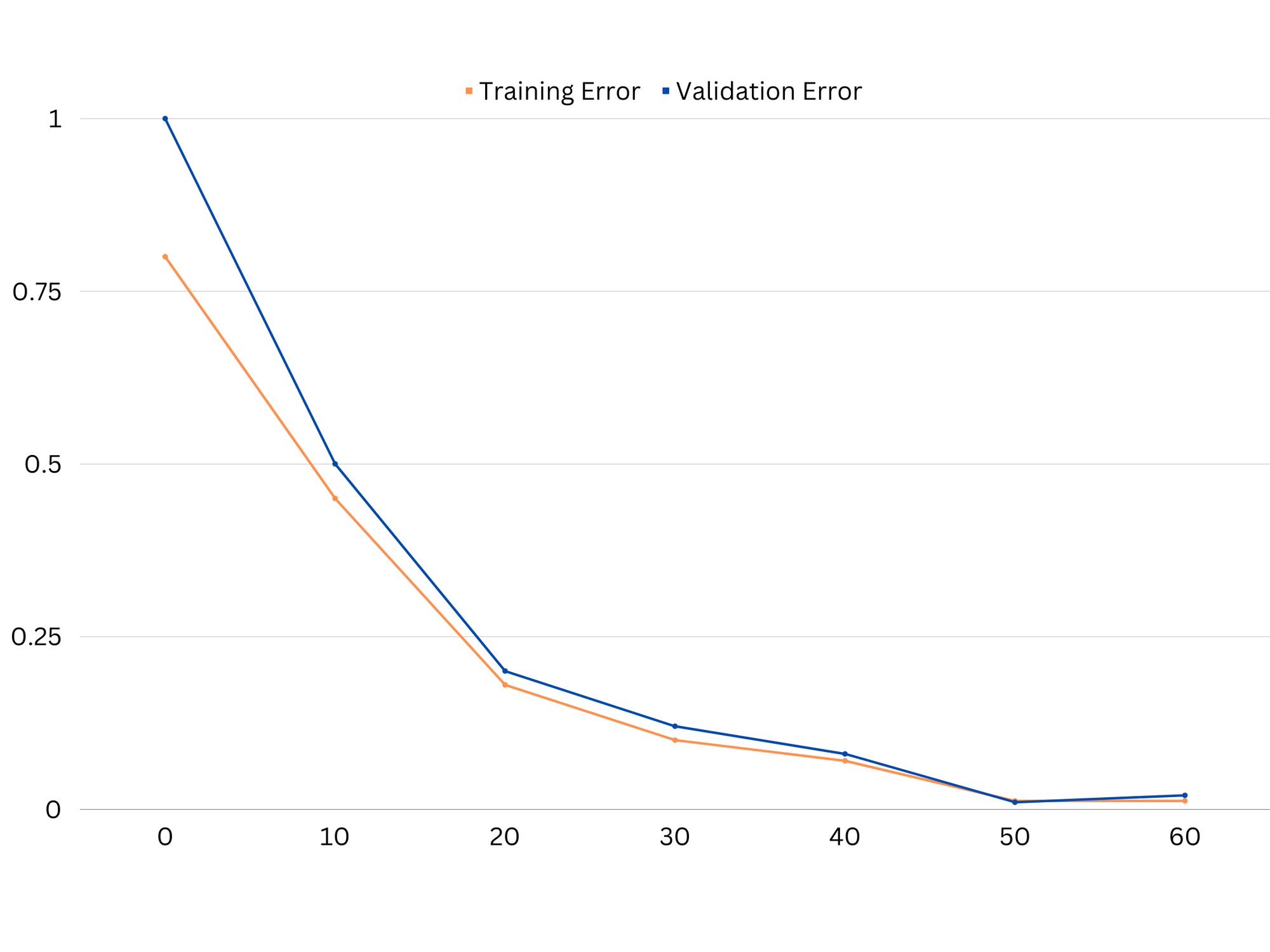

Щоб діагностувати продуктивність моделі, ми зазвичай обчислюємо та порівнюємо помилки тренування та перевірки. Корисним інструментом для візуалізації цього є графік кривих навчання, який відображає продуктивність моделі як на курсі, так і на даних перевірки протягом усього процесу навчання. Досліджуючи ці криві, ми можемо визначити, чи є модель надмірною (висока дисперсія), недостатньою (велике зміщення) чи добре підігнаною (оптимальний баланс між зміщенням і дисперсією).

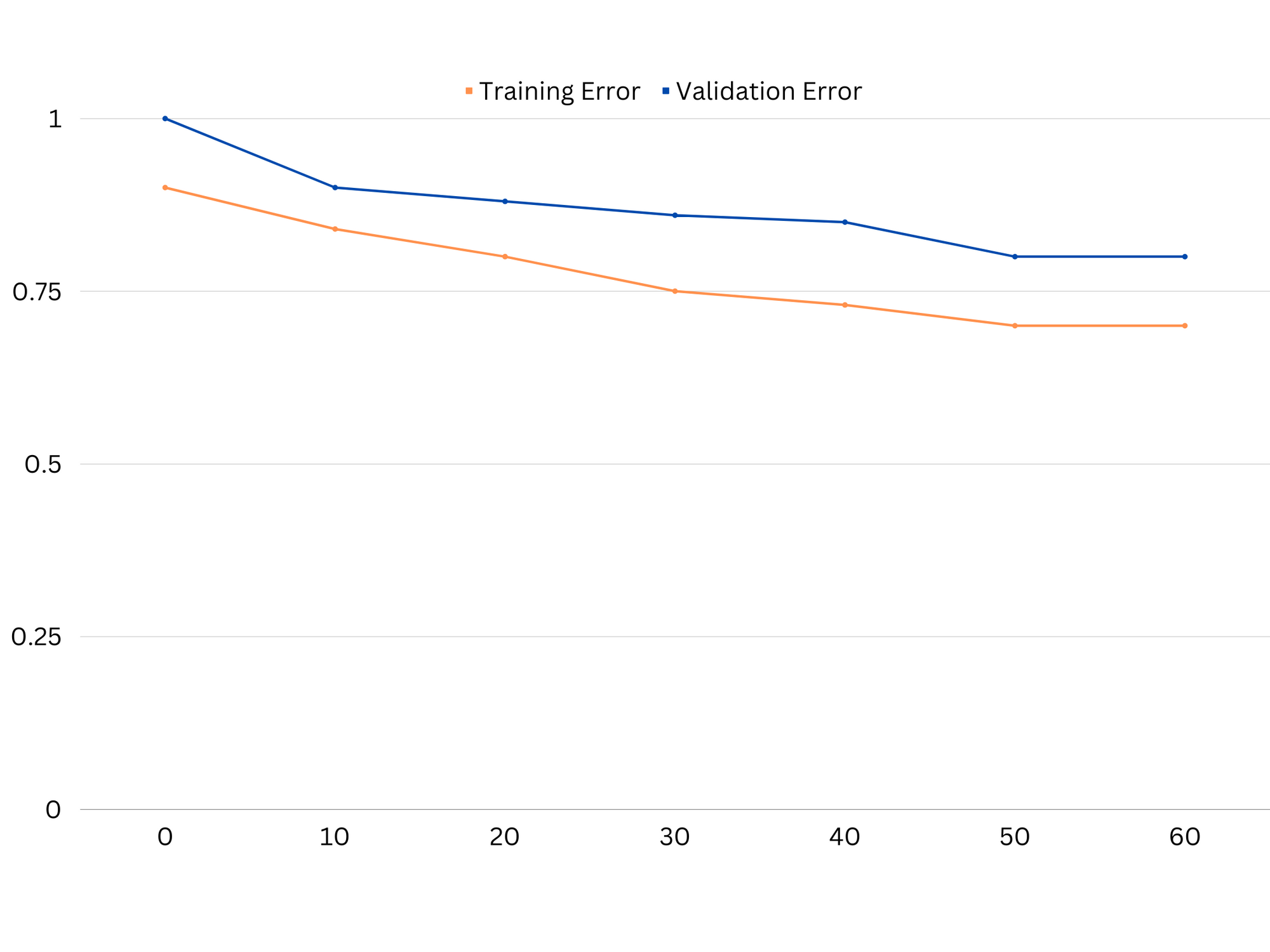

Приклад кривих навчання недостатньої моделі. І помилка поїзда, і помилка перевірки є високими.

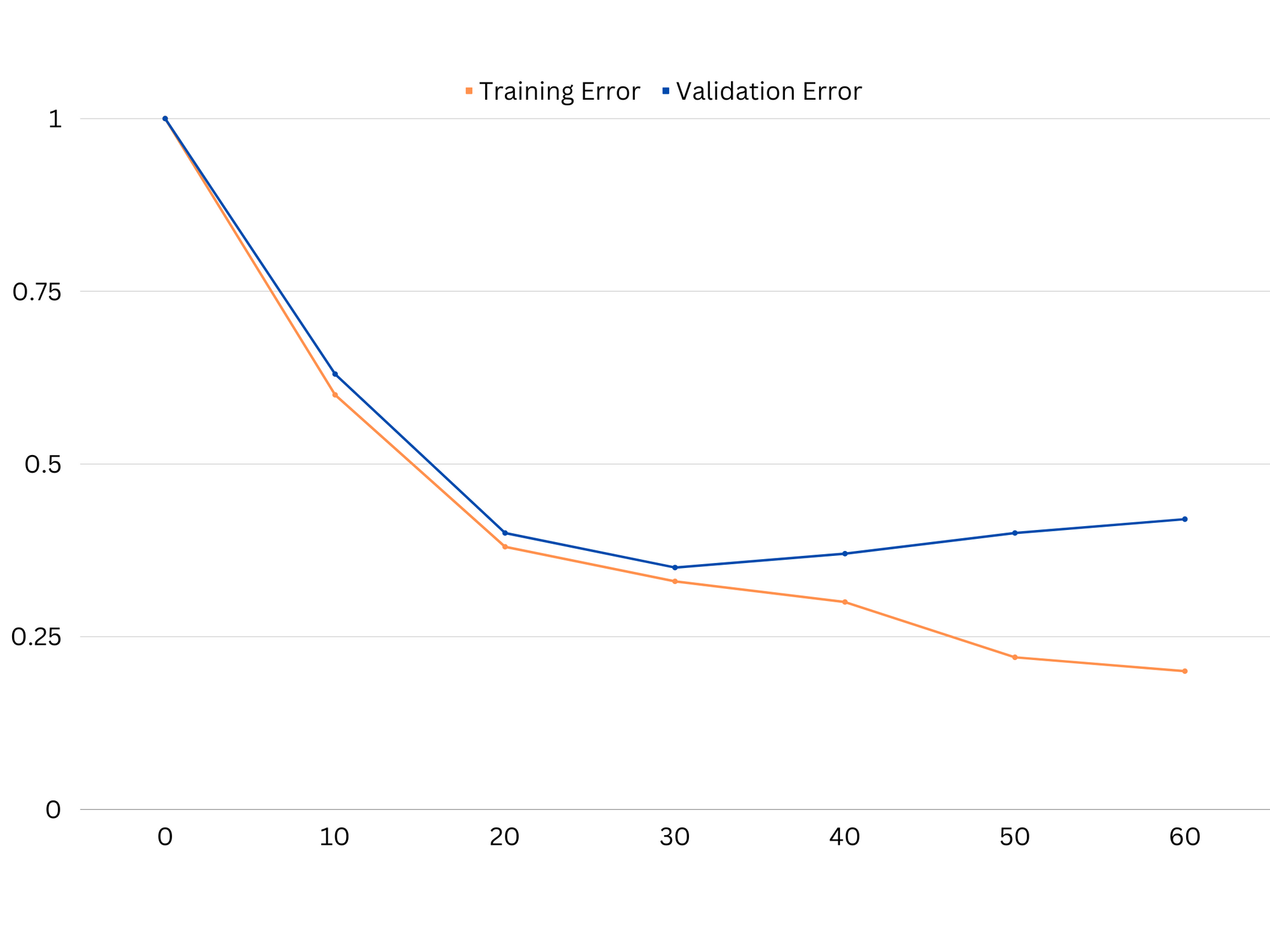

На практиці низька ефективність даних як навчання, так і перевірки свідчить про те, що модель занадто проста, що призводить до недостатнього пристосування. З іншого боку, якщо модель дуже добре працює з навчальними даними, але погано з тестовими даними, складність моделі, ймовірно, занадто висока, що призводить до переобладнання. Щоб усунути недостатнє пристосування, ми можемо спробувати збільшити складність моделі, додавши більше функцій, змінивши алгоритм навчання або вибравши інші гіперпараметри. У разі переобладнання ми повинні розглянути можливість регулярізації моделі або використання таких методів, як перехресна перевірка, щоб покращити її можливості узагальнення.

Приклад кривих навчання моделі переобладнання. Помилка тренування зменшується, тоді як помилка перевірки починає збільшуватися. Модель не здатна до узагальнення.

Регуляризація — це техніка, яка може бути використана для зменшення помилки дисперсії в моделях машинного навчання, допомагаючи вирішити проблему зміщення та дисперсії. Існує кілька різних методів регулярізації, кожна з яких має свої переваги та недоліки. Деякі популярні методи регуляризації включають гребневу регресію, регресію ласо та еластичну мережеву регуляризацію. Усі ці методи допомагають запобігти переобладнанню, додаючи штрафний термін до цільової функції моделі, що перешкоджає екстремальним значенням параметрів і заохочує до більш простих моделей.

Регресія хребта, також відома як регулярізація L2, додає штрафний термін, пропорційний квадрату параметрів моделі. Ця техніка, як правило, призводить до моделей із меншими значеннями параметрів, що може призвести до зменшення дисперсії та покращеного узагальнення. Однак він не виконує вибір функцій, тому всі функції залишаються в моделі.

Ознайомтеся з нашим практичним практичним посібником із вивчення Git з передовими методами, прийнятими в галузі стандартами та включеною шпаргалкою. Припиніть гуглити команди Git і фактично вчитися це!

Регресія ласо, або регулярізація L1, додає штрафний термін, пропорційний абсолютному значенню параметрів моделі. Ця техніка може призвести до моделей із розрідженими значеннями параметрів, ефективно виконуючи вибір ознак, встановлюючи деякі параметри на нуль. Це може привести до більш простих моделей, які легше інтерпретувати.

Еластична мережева регулярізація є комбінацією регуляризації L1 і L2, що забезпечує баланс між регресією хребта та ласо. Контролюючи співвідношення між двома умовами штрафу, еластична сітка може досягти переваг обох методів, таких як покращене узагальнення та вибір ознак.

Приклад кривих навчання добре підігнаної моделі.

Висновки

Компроміс зміщення та дисперсії є ключовим поняттям у машинному навчанні, яке визначає ефективність і добротність моделі. У той час як високе зміщення призводить до недообладнання, а висока дисперсія призводить до переобладнання, пошук оптимального балансу між ними необхідний для створення надійних моделей, які добре узагальнюють нові дані.

За допомогою кривих навчання можна виявити проблеми з надмірним або недостатнім оснащенням, а шляхом налаштування складності моделі або впровадження методів регулярізації можна покращити ефективність даних навчання та перевірки, а також даних тестування.

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoAiStream. Web3 Data Intelligence. Розширення знань. Доступ тут.

- Карбування майбутнього з Адріенн Ешлі. Доступ тут.

- Купуйте та продавайте акції компаній, які вийшли на IPO, за допомогою PREIPO®. Доступ тут.

- джерело: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :є

- : ні

- :де

- 1

- 12

- 20

- 8

- a

- здатність

- Здатний

- МЕНЮ

- абсолют

- точно

- Achieve

- досягнення

- насправді

- додати

- адреса

- Додає

- Переваги

- рада

- впливати

- зачіпає

- алгоритм

- ВСІ

- Дозволити

- Також

- an

- та

- будь-який

- ЕСТЬ

- стаття

- AS

- Balance

- баланси

- BE

- оскільки

- Переваги

- між

- зміщення

- border

- обидва

- Створюємо

- але

- by

- обчислювати

- CAN

- можливості

- захоплення

- випадок

- заміна

- Вибираючи

- тісно

- поєднання

- порівняти

- комплекс

- складність

- концепція

- Вважати

- управління

- Core

- виправити

- вирішальне значення

- дані

- угода

- зменшується

- Визначати

- визначає

- різниця

- різний

- дисплеїв

- розподіл

- робить

- два

- кожен

- Раніше

- легше

- фактично

- ефективність

- заохочує

- досить

- помилка

- помилки

- Навіть

- Вивчення

- приклад

- Пояснювати

- екстремальний

- відсутності

- зазнає невдачі

- особливість

- риси

- виявлення

- відповідати

- пристосування

- коливання

- Сфокусувати

- для

- функція

- фундаментальний

- Загальне

- Git

- мета

- добре

- Земля

- керівництво

- рука

- практичний

- Мати

- допомога

- допомогу

- Високий

- вище

- hover

- Як

- How To

- Однак

- HTTPS

- ідентифікувати

- if

- реалізації

- неможливе

- удосконалювати

- поліпшений

- in

- В інших

- включати

- включені

- Augmenter

- зростаючий

- вхід

- в

- Вступ

- IT

- ЙОГО

- тримати

- відомий

- L1

- l2

- вести

- провідний

- Веде за собою

- вивчення

- дозволяти

- LG

- як

- Ймовірно

- ll

- низький

- знизити

- машина

- навчання за допомогою машини

- РОБОТИ

- згаданий

- мінімізація

- модель

- Моделі

- більше

- необхідно

- мережу

- Нові

- шум

- номер

- мета

- of

- часто

- on

- оптимальний

- or

- Інше

- наші

- з

- вихід

- власний

- параметр

- параметри

- Викрійки

- Виконувати

- продуктивність

- виконанні

- виступає

- plato

- Інформація про дані Платона

- PlatoData

- бідні

- популярний

- це можливо

- Практичний

- практика

- передбачати

- прогноз

- запобігати

- проблеми

- процес

- забезпечувати

- швидше

- співвідношення

- зменшити

- Знижений

- відноситься

- пов'язаний

- відносини

- Відносини

- залишатися

- представляти

- результат

- в результаті

- результати

- право

- кільце

- міцний

- s

- вибір

- Чутливість

- установка

- тінь

- лист

- Короткий

- Повинен

- простий

- одночасно

- невеликий

- менше

- So

- деякі

- Джерела

- площа

- Stackabuse

- стандартів

- Стоп

- сильний

- такі

- Запропонує

- методи

- термін

- terms

- тест

- ніж

- Що

- Команда

- їх

- Їх

- Там.

- Ці

- вони

- це

- по всьому

- до

- занадто

- інструмент

- Усього:

- поїзд

- Навчання

- перехід

- правда

- Правда

- намагатися

- два

- типово

- не в змозі

- що лежить в основі

- невідомий

- використовуваний

- використання

- перевірка достовірності

- значення

- Цінності

- дуже

- we

- ДОБРЕ

- Що

- Чи

- який

- в той час як

- волі

- з

- слова

- зефірнет

- нуль