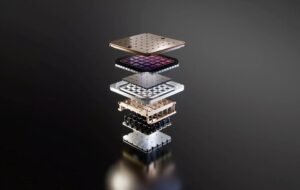

У нашому прагненні обмежити руйнівний потенціал штучного інтелекту нова стаття Кембриджського університету запропонувала вставити дистанційні вимикачі та блокування, подібні до тих, що були розроблені, щоб зупинити несанкціонований запуск ядерної зброї, в апаратне забезпечення, яке його живить.

Папір, документ [PDF], який включає голоси багатьох академічних установ і кількох з OpenAI, стверджує, що регулювання апаратного забезпечення, на яке спираються ці моделі, може бути найкращим способом запобігти його неправильному використанню.

«Обчислення, пов’язані зі штучним інтелектом, є особливо ефективною точкою втручання: їх можна виявити, виключити та піддати кількісному вимірюванню, і вони створюються через надзвичайно концентрований ланцюжок поставок», — стверджують дослідники.

Навчання найпродуктивніших моделей, які, як вважають, перевищують трильйон параметрів, вимагає величезної фізичної інфраструктури: десятки тисяч графічних процесорів або прискорювачів і тижні або навіть місяці часу обробки. Це, як кажуть дослідники, ускладнює приховування існування та відносної ефективності цих ресурсів.

Більше того, найдосконаліші чіпи, які використовуються для навчання цих моделей, виробляються відносно невеликою кількістю компаній, як-от Nvidia, AMD і Intel, що дозволяє політикам обмежувати продаж цих товарів особам або країнам, які викликають занепокоєння.

Ці фактори разом з іншими, такими як обмеження ланцюга поставок у виробництві напівпровідників, пропонують політикам засоби для кращого розуміння того, як і де розгортається інфраструктура штучного інтелекту, хто має, а хто не має доступу до неї, а також застосовують покарання за її неправильне використання, стверджує газета. .

Контроль інфраструктури

У документі висвітлено численні способи, якими політики можуть підійти до регулювання апаратного забезпечення ШІ. Багато пропозицій, зокрема ті, що спрямовані на покращення видимості та обмеження продажу прискорювачів штучного інтелекту, уже застосовуються на національному рівні.

Минулого року президент США Джо Байден висунув розпорядження спрямований на виявлення компаній, що розробляють великі моделі ШІ подвійного призначення, а також постачальників інфраструктури, здатних навчання їх. Якщо ви не знаєте, «подвійне використання» стосується технологій, які можуть служити подвійним обов’язком у цивільному та військовому застосуванні.

Зовсім недавно Міністерство торгівлі США запропонований регулювання, яке вимагатиме від американських хмарних провайдерів запроваджувати суворішу політику «знай свого клієнта», щоб запобігти обходу експортних обмежень особами чи країнами, які викликають занепокоєння.

Дослідники відзначають, що такий вид видимості є цінним, оскільки він може допомогти уникнути нової гонки озброєнь, подібної до тієї, що була спровокована суперечкою про ракетний розрив, коли помилкові повідомлення призвели до масового накопичення балістичних ракет. Незважаючи на цінність, вони попереджають, що виконання цих вимог до звітності може порушити конфіденційність клієнтів і навіть призвести до витоку конфіденційних даних.

Тим часом на торговому фронті Міністерство торгівлі продовжувало активізувати обмеження, що обмежують продуктивність прискорювачів, що продаються в Китай. Але, як ми повідомляли раніше, хоча ці зусилля ускладнили таким країнам, як Китай, отримати американські мікросхеми, вони далекі від досконалості.

Щоб усунути ці обмеження, дослідники запропонували запровадити глобальний реєстр продажів чіпів штучного інтелекту, який відстежував би їх протягом життєвого циклу, навіть після того, як вони залишили країну походження. Вони припускають, що такий реєстр міг би включати унікальний ідентифікатор у кожен чіп, що могло б допомогти у боротьбі з контрабанда компонентів.

На більш екстремальному кінці спектру дослідники припустили, що перемикачі блокування можна вмонтувати в кремній, щоб запобігти їх використанню в шкідливих програмах.

Теоретично це може дозволити регуляторам швидше реагувати на зловживання чутливими технологіями, віддалено відключаючи доступ до чіпів, але автори попереджають, що це не без ризику. Мається на увазі, що за неправильної реалізації такий перемикач може стати мішенню для кіберзлочинців.

Інша пропозиція вимагатиме від кількох сторін підписання потенційно ризикованих завдань навчання ШІ, перш ніж їх можна буде розгорнути в масштабі. «Ядерна зброя використовує подібні механізми, які називаються зв’язками дозволеної дії», — написали вони.

Для ядерної зброї ці захисні замки призначені для того, щоб запобігти одній особі від шахрайства та першого удару. Однак для штучного інтелекту ідея полягає в тому, що якщо окрема особа чи компанія хочуть навчити модель над певним порогом у хмарі, їм спочатку потрібно буде отримати дозвіл на це.

Незважаючи на те, що це потужний інструмент, дослідники відзначають, що він може призвести до зворотного ефекту, перешкоджаючи розвитку бажаного ШІ. Аргумент полягає в тому, що хоча використання ядерної зброї має досить чіткий результат, ШІ не завжди такий чорно-білий.

Але якщо це здається надто антиутопічним на ваш смак, стаття присвячує цілий розділ перерозподілу ресурсів ШІ для покращення суспільства в цілому. Ідея полягає в тому, що політики можуть об’єднатися, щоб зробити обчислення штучного інтелекту більш доступними для груп, які, ймовірно, не будуть використовувати його на зло. Ця концепція описується як «розподіл».

Що не так із регулюванням розвитку ШІ?

Навіщо робити всі ці проблеми? Що ж, автори статті стверджують, що фізичне обладнання за своєю суттю легше контролювати.

Порівняно з апаратним забезпеченням, «інші вхідні та вихідні дані розробки штучного інтелекту — дані, алгоритми та навчені моделі — є неконкурентними нематеріальними благами, якими легко ділитися», — йдеться в статті.

Аргумент полягає в тому, що після того, як модель опублікована, у відкритому доступі чи злита, джина неможливо помістити назад у пляшку та зупинити його поширення в мережі.

Дослідники також підкреслили, що спроби запобігти неправильному використанню моделей виявилися ненадійними. В одному прикладі автори підкреслили легкість, з якою дослідники змогли демонтувати засоби захисту в Meta's Llama 2, які мали на меті запобігти створенню образливої лексики цією моделлю.

Доведені до крайності, є побоювання, що досить просунута модель подвійного використання може бути використана для прискорення розробка хімічної чи біологічної зброї.

У статті визнається, що регулювання апаратного забезпечення штучного інтелекту не є ідеальним рішенням і не усуває потреби в регулюванні інших аспектів галузі.

Однак участь кількох дослідників OpenAI важко ігнорувати, враховуючи участь генерального директора Сема Альтмана спроби контролювати розповідь про регулювання ШІ. ®

- Розповсюдження контенту та PR на основі SEO. Отримайте посилення сьогодні.

- PlatoData.Network Vertical Generative Ai. Додайте собі сили. Доступ тут.

- PlatoAiStream. Web3 Intelligence. Розширення знань. Доступ тут.

- ПлатонЕСГ. вуглець, CleanTech, Енергія, Навколишнє середовище, Сонячна, Поводження з відходами. Доступ тут.

- PlatoHealth. Розвідка про біотехнології та клінічні випробування. Доступ тут.

- джерело: https://go.theregister.com/feed/www.theregister.com/2024/02/16/boffins_propose_regulating_ai_hardware/

- : має

- :є

- : ні

- :де

- $UP

- 7

- a

- Здатний

- зловживання

- AC

- академічний

- прискорювати

- прискорювачі

- доступ

- доступною

- через

- дію

- адреса

- просунутий

- після

- AI

- Моделі AI

- Навчання AI

- спрямований

- алгоритми

- ВСІ

- розподіл

- дозволяти

- дозволено

- Дозволити

- по

- вже

- Також

- завжди

- AMD

- американська

- an

- та

- Інший

- застосування

- підхід

- ЕСТЬ

- сперечатися

- аргумент

- зброю

- навколо

- штучний

- штучний інтелект

- AS

- аспекти

- At

- авторизації

- authors

- уникнути

- назад

- BE

- ставати

- перед тим

- буття

- вважається,

- КРАЩЕ

- Краще

- Краще

- біден

- Black

- будувати

- але

- by

- званий

- Кембридж

- CAN

- здатний

- випадок

- Генеральний директор

- певний

- ланцюг

- хімічний

- Китай

- чіп

- Чіпси

- цивільний

- хмара

- CO

- боротьби з

- Приходити

- Торгівля

- Компанії

- компанія

- Компоненти

- обчислення

- Концентрований

- концепція

- Занепокоєння

- беручи до уваги

- обмеження

- триває

- контроль

- спір

- може

- країни

- країна

- Курс

- клієнт

- різання

- кіберзлочинці

- дані

- відділ

- розгорнути

- описаний

- призначений

- розвиненою

- розвивається

- розробка

- важкий

- do

- байдуже

- справи

- подвійний

- дистопія

- кожен

- простота

- легше

- легко

- Ефективний

- зусилля

- або

- усунутий

- працевлаштований

- кінець

- примусове виконання

- Весь

- Навіть

- приклад

- перевищувати

- виконання

- існування

- експорт

- екстремальний

- надзвичайно

- фактори

- знайомий

- далеко

- швидше

- боялися

- почуває

- Перший

- для

- Вперед

- від

- перед

- розрив

- породжує

- джин

- отримати

- отримання

- Глобальний

- Go

- буде

- товари

- Графічні процесори

- Групи

- Руки

- Жорсткий

- важче

- апаратні засоби

- Мати

- допомога

- приховувати

- Виділено

- основний момент

- Як

- Однак

- HTTPS

- ідея

- ідентифікатор

- ідентифікує

- if

- ігнорувати

- величезний

- здійснювати

- реалізовані

- реалізації

- удосконалювати

- in

- В інших

- includes

- У тому числі

- включати

- невірно

- індивідуальний

- промисловість

- Інфраструктура

- за своєю суттю

- витрати

- установи

- нематеріальний

- Intel

- Інтелект

- втручання

- в

- isn

- IT

- ЙОГО

- JOE

- Джо Байден

- JPG

- вбити

- Дитина

- мова

- великий

- запуск

- запуск

- вести

- Led

- залишити

- рівень

- Життєвий цикл

- як

- МЕЖА

- недоліки

- обмежуючий

- зв'язку

- трохи

- Лама

- Волосся

- made

- зробити

- РОБОТИ

- Робить

- malicious

- виробництво

- багато

- масивний

- Може..

- засоби

- означав

- механізми

- Meta

- може бути

- військовий

- Військові додатки

- ракети

- зловживання

- модель

- Моделі

- місяців

- більше

- найбільш

- множинний

- NARRATIVE

- National

- Необхідність

- мережу

- Нові

- немає

- увагу

- ядерний

- номер

- численний

- Nvidia

- спостерігати

- of

- від

- наступ

- пропонувати

- on

- один раз

- ONE

- відкрити

- OpenAI

- or

- походження

- Інше

- інші

- наші

- з

- Результат

- виходи

- над

- Папір

- параметри

- участь

- особливо

- Сторони

- штрафні санкції

- ідеальний

- продуктивність

- людина

- осіб

- фізичний

- plato

- Інформація про дані Платона

- PlatoData

- ігри

- точка

- Політика

- політиків

- сильнодіючий

- потенціал

- потенційно

- повноваження

- президент

- президент Джо Біден

- досить

- запобігати

- попередження

- раніше

- недоторканність приватного життя

- обробка

- Вироблений

- плодовитий

- пропозиція

- запропонований

- доведений

- провайдери

- опублікований

- put

- Поклавши

- піддається кількісній оцінці

- пошук

- Гонки

- RE

- нещодавно

- відноситься

- реєстру

- Регулювати

- регулюючий

- Регулювання

- Регулятори

- відносний

- щодо

- покладатися

- віддалений

- віддалено

- Повідомляється

- Звітність

- Звіти

- вимагати

- Вимога

- Вимагається

- Дослідники

- ресурси

- Реагувати

- обмежити

- Обмеження

- Risk

- ризики

- Ризикований

- s

- гарантії

- sale

- продажів

- Сем

- Сем Альтман

- say

- шкала

- розділ

- безпеку

- Здається,

- напівпровідник

- чутливий

- служити

- кілька

- підпис

- Кремній

- срібло

- аналогічний

- невеликий

- So

- суспільство

- проданий

- спектр

- поширення

- старт

- Стоп

- зупинка

- удар

- строгий

- такі

- пропонувати

- поставка

- ланцюжка поставок

- перемикач

- Мета

- завдання

- смаки

- Технології

- тензор

- Що

- Команда

- їх

- Їх

- теорія

- Там.

- Ці

- вони

- це

- ті

- тисячі

- поріг

- час

- до

- разом

- занадто

- інструмент

- трек

- торгувати

- поїзд

- навчений

- Навчання

- спрацьовує

- трильйон

- біда

- несанкціонований

- розуміти

- створеного

- університет

- Кембриджський університет

- навряд чи

- us

- Президент США

- використання

- використовуваний

- Цінний

- Ve

- постачальники

- через

- видимість

- ГОЛОСИ

- хотів

- шлях..

- способи

- we

- Зброя

- тижня

- ДОБРЕ

- були

- який

- в той час як

- білий

- ВООЗ

- всі

- з

- без

- б

- Неправильно

- пише

- рік

- Ти

- вашу

- зефірнет