Amazon SageMaker Data Wrangler це інструмент підготовки даних на основі інтерфейсу користувача, який допомагає виконувати аналіз даних, попередню обробку та візуалізацію з функціями очищення, трансформації та підготовки даних швидше. Попередньо створені шаблони потоків Data Wrangler допомагають пришвидшити підготовку даних для спеціалістів із обробки даних і машинного навчання (ML), допомагаючи вам прискорити та зрозуміти шаблони найкращих практик для потоків даних із використанням загальних наборів даних.

Ви можете використовувати потоки Data Wrangler для виконання таких завдань:

- Візуалізація даних – Вивчення статистичних властивостей для кожного стовпця в наборі даних, побудова гістограм, вивчення викидів

- Очищення даних – Видалення дублікатів, видалення або заповнення записів пропущеними значеннями, видалення викидів

- Збагачення даних і розробка функцій – Обробка стовпців для створення більш виразних функцій, вибір підмножини функцій для навчання

Ця публікація допоможе вам зрозуміти Data Wrangler за допомогою наведених нижче зразків попередньо створених потоків GitHub. Репозиторій демонструє перетворення табличних даних, перетворення даних часових рядів і перетворення об’єднаного набору даних. Кожен вимагає різного типу перетворень через свою основну природу. Стандартні табличні або перехресні дані збираються в певний момент часу. Навпаки, дані часових рядів збираються неодноразово протягом певного часу, причому кожна наступна точка даних залежить від її минулих значень.

Давайте розглянемо приклад того, як ми можемо використовувати зразок потоку даних для табличних даних.

Передумови

Data Wrangler – це Amazon SageMaker функція доступна в межах Студія Amazon SageMaker, тому нам потрібно стежити за процесом адаптації Studio, щоб розкрутити середовище Studio та блокноти. Хоча ви можете вибрати один з кількох методів автентифікації, найпростішим способом створення домену Studio є дотримання Швидкий початок інструкції. Швидкий старт використовує ті самі налаштування за замовчуванням, що й стандартне налаштування Studio. Ви також можете вибрати використання на борту Центр ідентифікації AWS IAM (наступник AWS Single Sign-On) для автентифікації (див Підключення до домену Amazon SageMaker за допомогою IAM Identity Center).

Імпортуйте набір даних і файли потоку в Data Wrangler за допомогою Studio

У наступних кроках описано, як імпортувати дані в SageMaker для використання Data Wrangler:

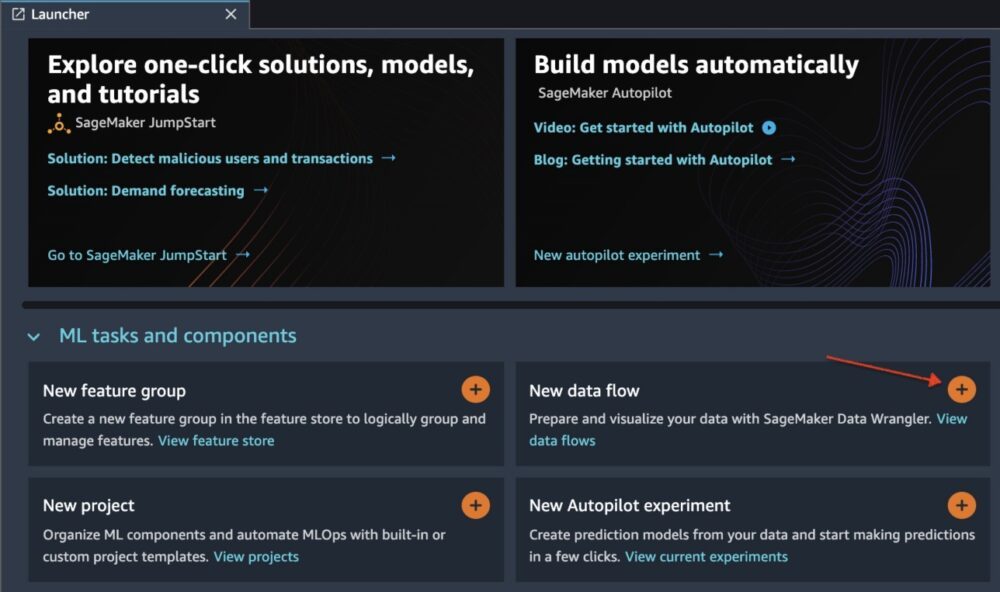

Ініціалізуйте Data Wrangler через інтерфейс користувача Studio, вибравши Новий потік даних.

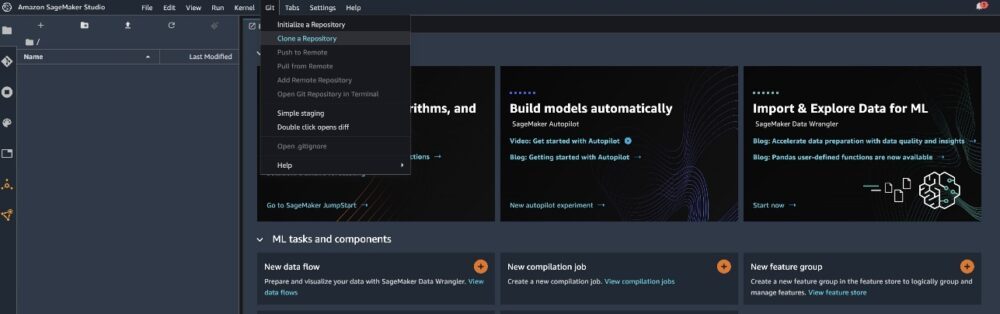

Клонуйте GitHub репо щоб завантажити файли потоку в середовище Studio.

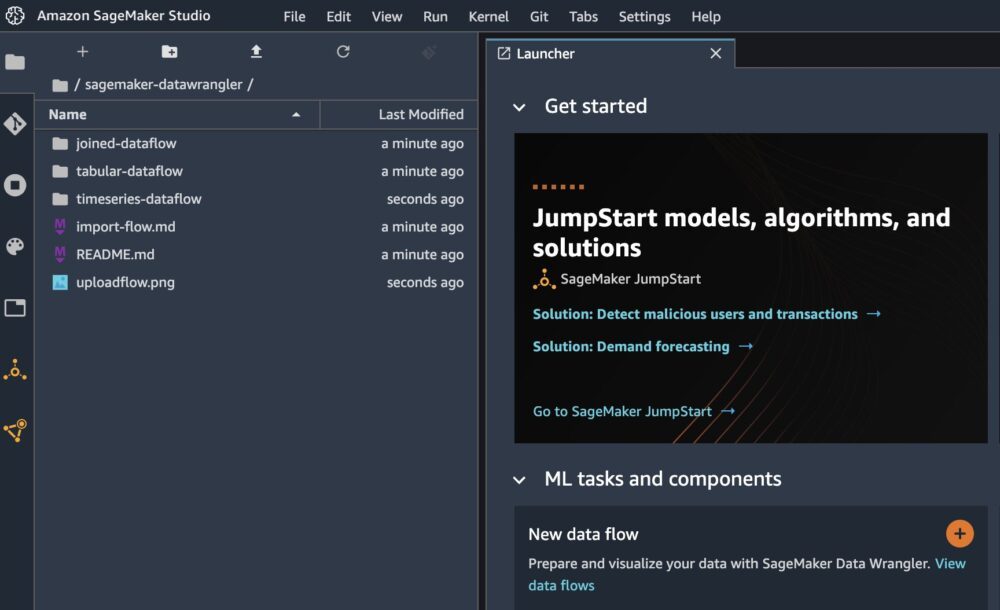

Після завершення клонування ви зможете побачити вміст сховища на лівій панелі.

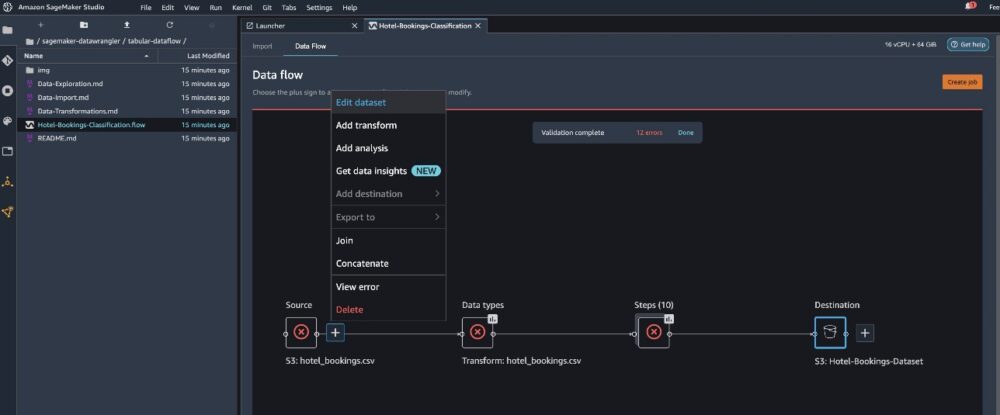

Виберіть файл Hotel-Bookings-Classification.flow щоб імпортувати файл потоку в Data Wrangler.

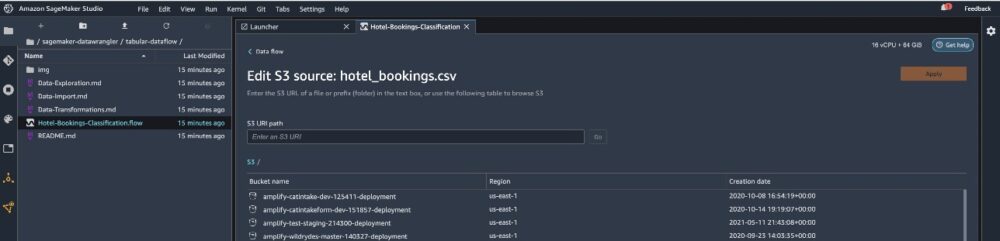

Якщо ви використовуєте часовий ряд або об’єднаний потік даних, потік відображатиметься під іншою назвою. Після імпорту потоку ви побачите наведений нижче знімок екрана. Це показує нам помилки, оскільки нам потрібно переконатися, що файл потоку вказує на правильне джерело даних Служба простого зберігання Amazon (Amazon S3).

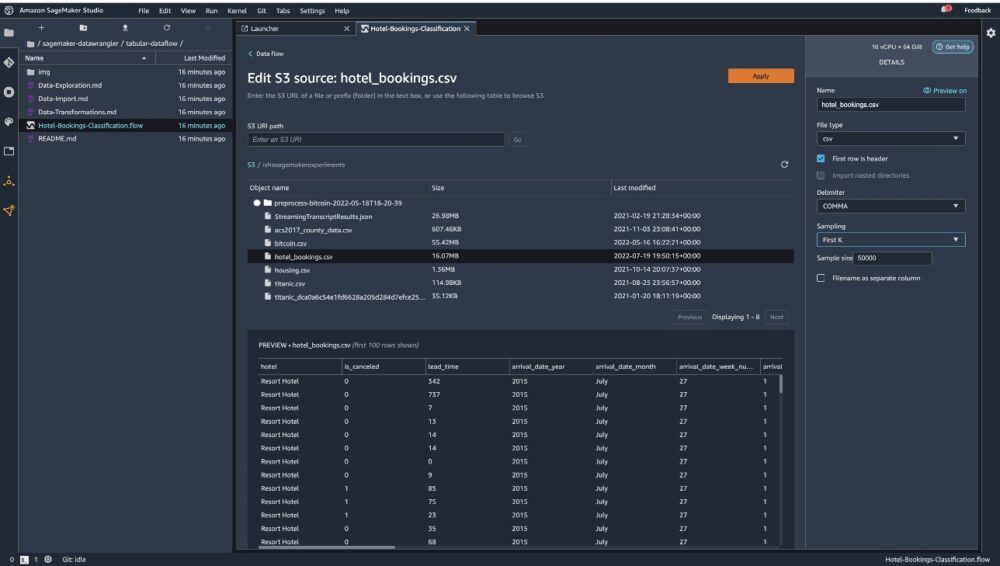

Вибирати Редагувати набір даних щоб відкрити всі ваші сегменти S3. Далі виберіть набір даних hotel_bookings.csv з вашого відра S3 для проходження через потік табличних даних.

Зауважте, що якщо ви використовуєте приєднаний потік даних, можливо, доведеться імпортувати кілька наборів даних у Data Wrangler

На правій панелі переконайтеся ПАРАГРАФ обирається роздільником і Вибірка встановлений в Перший К. Наш набір даних достатньо малий, щоб виконувати перетворення Data Wrangler на повному наборі даних, але ми хотіли підкреслити, як можна імпортувати набір даних. Якщо у вас великий набір даних, подумайте про використання вибірки. Виберіть Імпортувати щоб імпортувати цей набір даних до Data Wrangler.

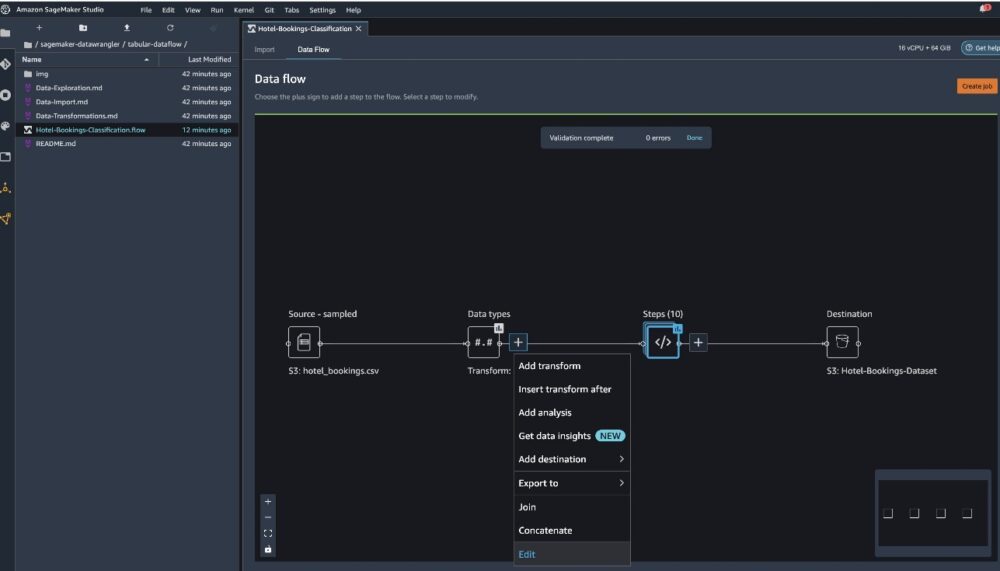

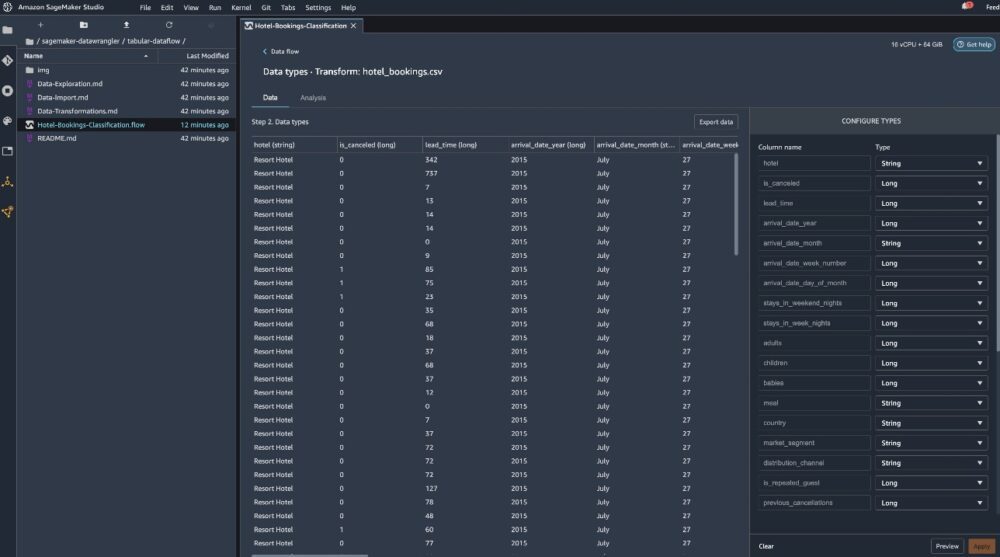

Після імпорту набору даних Data Wrangler автоматично перевіряє набір даних і визначає типи даних. Ви бачите, що помилки зникли, оскільки ми вказуємо на правильний набір даних. Редактор потоку тепер показує два блоки, які демонструють, що дані було імпортовано з джерела та розпізнано типи даних. За потреби ви також можете редагувати типи даних.

На наступному знімку екрана показано наші типи даних.

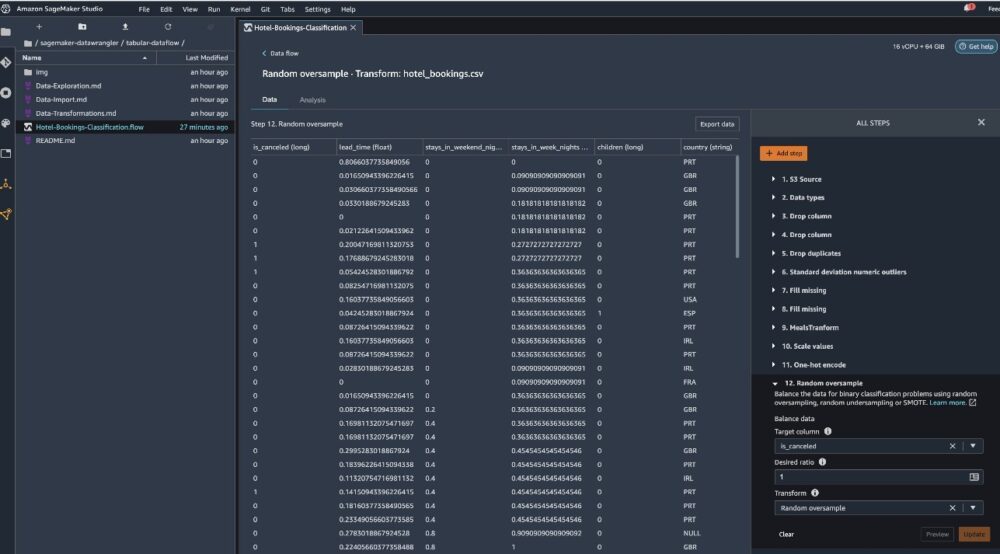

Давайте розглянемо деякі з перетворень, виконаних у рамках цього табличного потоку. Якщо ви використовуєте часовий ряд or приєднався потоки даних, перегляньте деякі загальні перетворення на GitHub репо. Ми провели базовий дослідницький аналіз даних, використовуючи звіти про аналіз даних, які вивчали цільовий витік і колінеарність функцій у наборі даних, підсумковий аналіз таблиці та можливість швидкого моделювання. Дослідіть кроки на GitHub репо.

Тепер ми видаляємо стовпці на основі рекомендацій, наданих звітом про аналіз даних і якість.

- Для цільового витоку скиньте reserve_status.

- Для зайвих стовпців відпустіть дні_в_списку_очікування, готель, зарезервований_тип_кімнати, дата_місяця_прибуття, дата_статусу_бронювання, діти, та дата_прибуття_день_місяця.

- Виключіть стовпці на основі результатів лінійної кореляції дата_прибуття_номер_тижня та дата_прибуття_рік оскільки значення кореляції для цих пар ознак (стовпців) перевищують рекомендоване порогове значення 0.90.

- На основі результатів нелінійної кореляції, падіння reserve_status. Цей стовпець уже було позначено як видалений на основі цільового аналізу витоку.

- Обробляти числові значення (мін.-макс. масштабування) для Lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_cancelled, booking_changes, adr, total_of_specical_requests, та потрібні_паркувальні_місця.

- Одночасне кодування категоріальних змінних, як-от meal, is_repeated_guest, market_segment, assigned_room_type, deposit_type, та customer_type.

- Збалансуйте цільову змінну. Випадкова надлишкова вибірка для дисбалансу класів. Використовуйте можливість швидкого моделювання для обробки викидів і відсутніх значень.

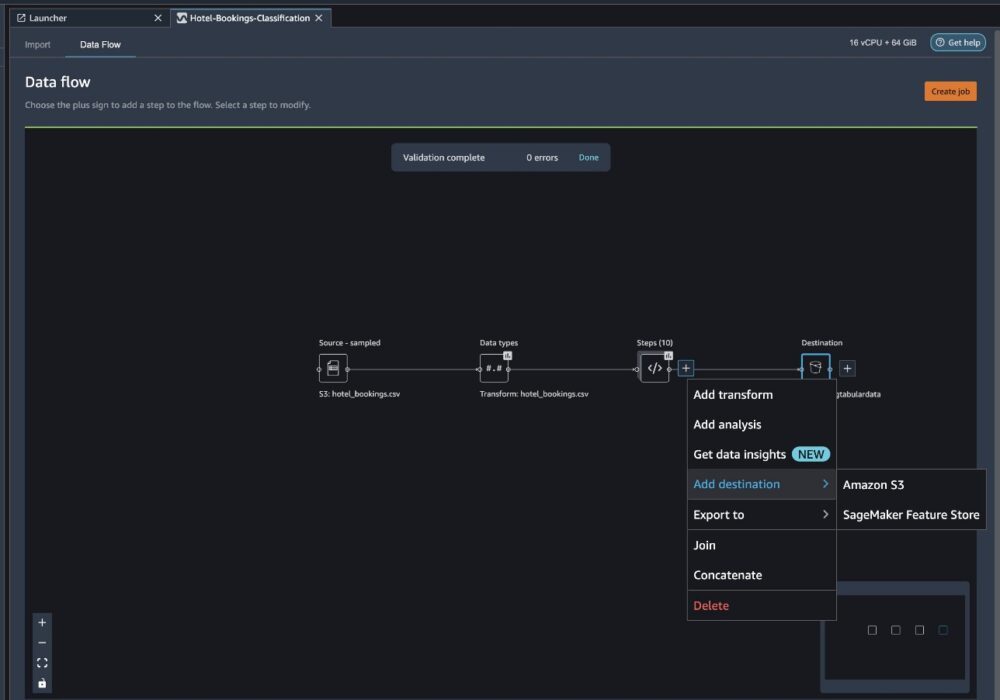

Експорт до Amazon S3

Тепер ми пройшли різні трансформації та готові експортувати дані в Amazon S3. Цей параметр створює завдання обробки SageMaker, яке запускає потік обробки Data Wrangler і зберігає отриманий набір даних у вказаному сегменті S3. Виконайте наступні дії, щоб налаштувати експорт до Amazon S3:

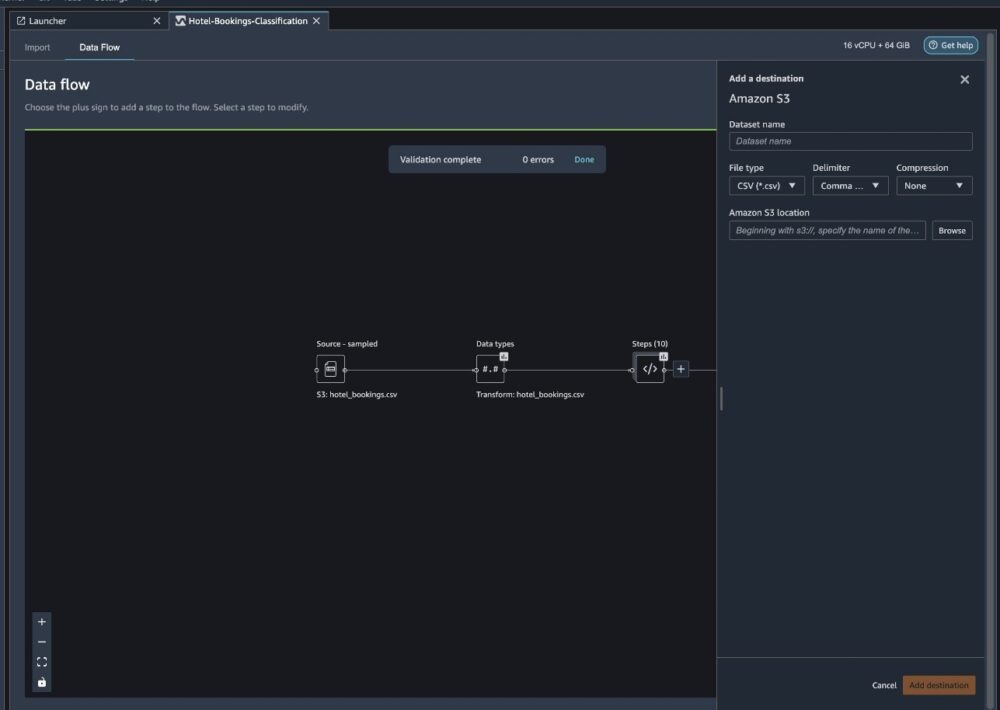

Виберіть знак плюс біля колекції елементів трансформації та виберіть Додати пункт призначення, То Amazon S3.

- для Назва набору даних, введіть, наприклад, назву для нового набору даних

NYC_export. - для Тип файлувиберіть CSV.

- для Delimiterвиберіть Кома.

- для компресіявиберіть ніхто.

- для Розташування Amazon S3, використовуйте ту саму назву сегмента, яку ми створили раніше.

- Вибирати Додати пункт призначення.

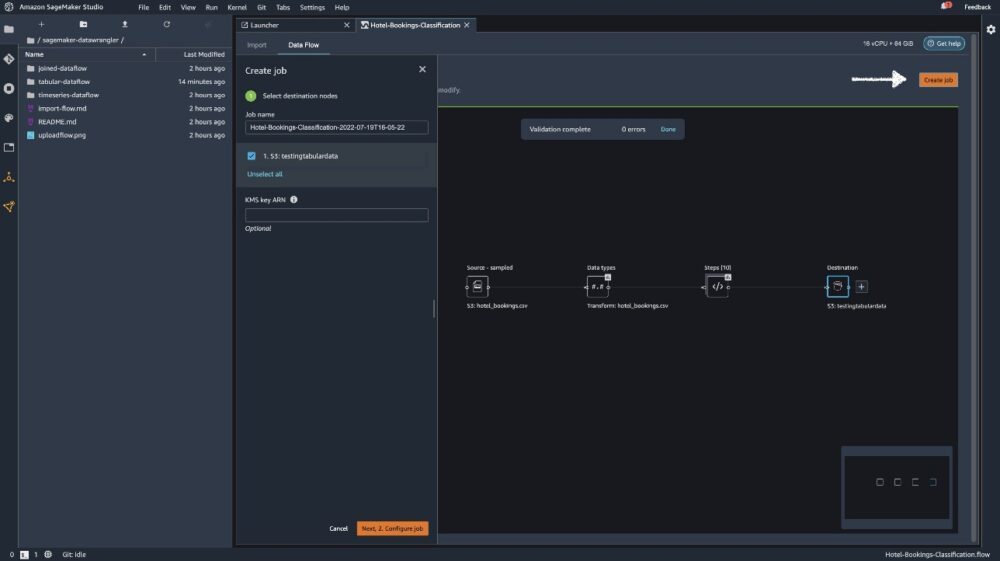

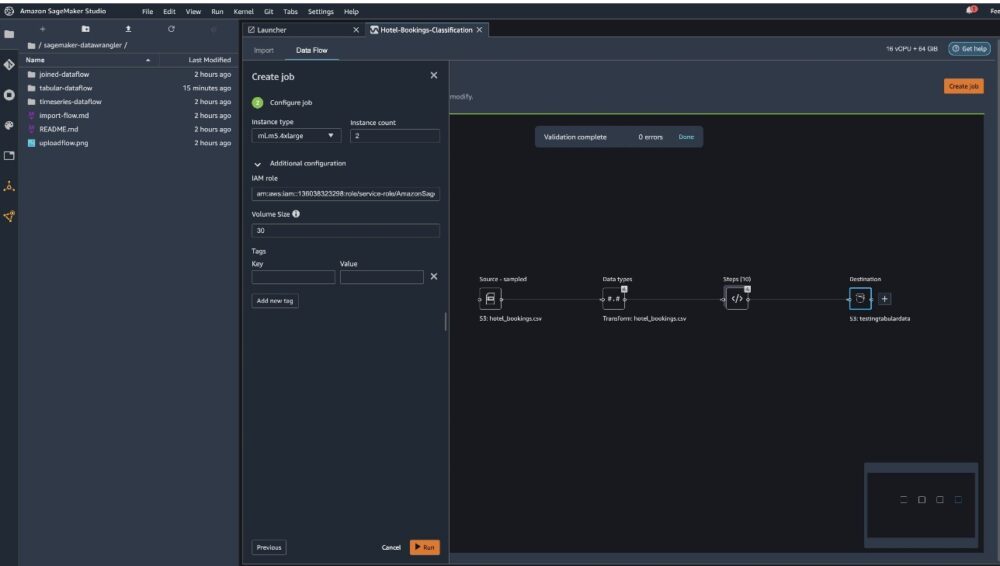

Вибирати Створити роботу.

для Назва роботи, введіть назву або збережіть автоматично згенерований параметр і виберіть призначення. У нас лише один пункт призначення, S3:testingtabulardata, але у вас може бути кілька місць призначення з різних етапів робочого процесу. Залиште Ключ KMS ARN поле порожнє та виберіть МАЙБУТНІ.

Тепер вам потрібно налаштувати обчислювальну потужність для завдання. Ви можете зберегти всі значення за замовчуванням для цього прикладу.

- для Тип екземпляра, використовуйте ml.m5.4xlarge.

- для Кількість екземплярів, використовуйте 2.

- Ви можете досліджувати Додаткова конфігурація, але збережіть налаштування за замовчуванням.

- Вибирати прогін.

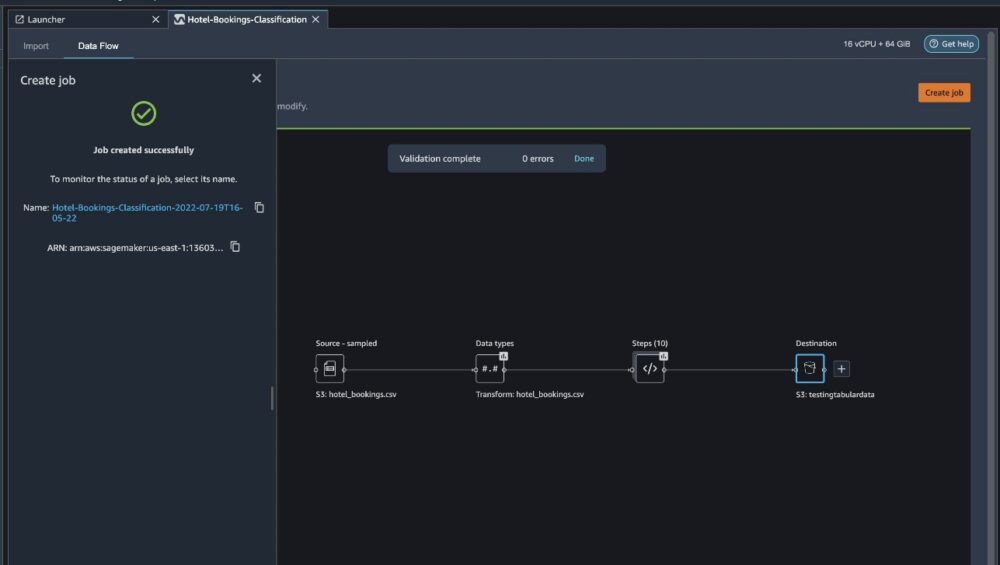

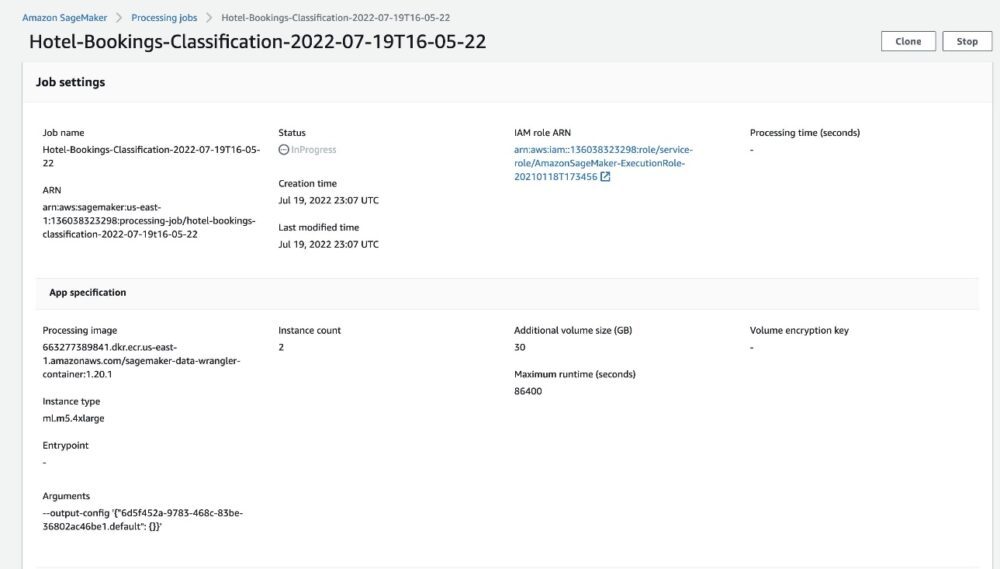

Тепер ваша робота почалася, і потрібен деякий час, щоб обробити 6 ГБ даних відповідно до процесу обробки даних Data Wrangler. Вартість цієї роботи становитиме близько 2 доларів США, оскільки ml.m5.4xlarge коштує 0.922 доларів США за годину, і ми використовуємо два з них.

Якщо ви виберете назву завдання, ви перейдете до нового вікна з деталями завдання.

На сторінці з інформацією про завдання ви можете побачити всі параметри з попередніх кроків.

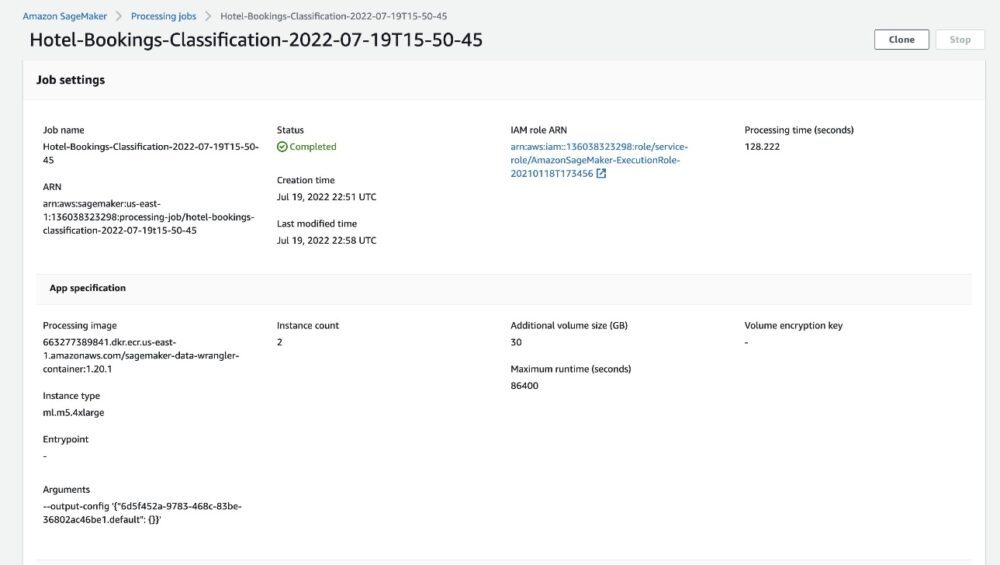

Коли статус завдання змінюється на Виконано, ви також можете перевірити Час обробки (секунди) значення. Ця робота обробки займає приблизно 5–10 хвилин.

Після завершення завдання вихідні файли підготовки та тестування будуть доступні у відповідних вихідних папках S3. Розташування виводу можна знайти в конфігураціях завдань обробки.

Після завершення обробки Data Wrangler ми можемо перевірити результати, збережені в нашому сегменті S3. Не забудьте оновити job_name змінна з назвою вашої роботи.

Тепер ви можете використовувати ці експортовані дані для запуску моделей ML.

Прибирати

Видаліть ваші сегменти S3 і твій Потік даних Wrangler щоб видалити базові ресурси та запобігти небажаним витратам після завершення експерименту.

Висновок

У цьому дописі ми показали, як можна імпортувати табличний попередньо створений потік даних у Data Wrangler, підключити його до нашого набору даних і експортувати результати в Amazon S3. Якщо ваші випадки використання вимагають маніпулювання даними часових рядів або об’єднання кількох наборів даних, ви можете пройти через інші попередньо створені потоки зразків у GitHub репо.

Після того, як ви імпортували попередньо створений робочий процес підготовки даних, ви можете інтегрувати його в Amazon SageMaker Processing, Трубопроводи Amazon SageMaker та Магазин функцій Amazon SageMaker щоб спростити завдання обробки, обміну та зберігання навчальних даних ML. Ви також можете експортувати цей зразок потоку даних у сценарій Python і створити спеціальний конвеєр підготовки даних ML, тим самим прискоривши швидкість випуску.

Радимо вам ознайомитись з нашими GitHub сховище отримати практичну практику та знайти нові способи покращити точність моделі! Щоб дізнатися більше про SageMaker, відвідайте Посібник розробника Amazon SageMaker.

Про авторів

Іша Дуа є старшим архітектором рішень у районі затоки Сан-Франциско. Вона допомагає клієнтам AWS Enterprise розвиватися, розуміючи їхні цілі та виклики, і вказує їм, як вони можуть створювати свої додатки в хмарному стилі, гарантуючи їх стійкість і масштабованість. Вона захоплюється технологіями машинного навчання та екологічною стійкістю.

Іша Дуа є старшим архітектором рішень у районі затоки Сан-Франциско. Вона допомагає клієнтам AWS Enterprise розвиватися, розуміючи їхні цілі та виклики, і вказує їм, як вони можуть створювати свої додатки в хмарному стилі, гарантуючи їх стійкість і масштабованість. Вона захоплюється технологіями машинного навчання та екологічною стійкістю.

- AI

- ai мистецтво

- AI арт генератор

- ai робот

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- штучний інтелект

- сертифікація штучного інтелекту

- штучний інтелект у банківській справі

- робот зі штучним інтелектом

- роботи зі штучним інтелектом

- програмне забезпечення для штучного інтелекту

- AWS Машинне навчання

- blockchain

- блокчейн конференція AI

- coingenius

- розмовний штучний інтелект

- крипто конференція ai

- dall's

- глибоке навчання

- у вас є гугл

- навчання за допомогою машини

- plato

- платон ai

- Інформація про дані Платона

- Гра Платон

- PlatoData

- platogaming

- масштаб ai

- синтаксис

- зефірнет