یہ Qualcomm AI سے AK Roy کی ایک مہمان پوسٹ ہے۔

Amazon Elastic Compute Cloud (Amazon EC2) DL2q مثالیں، Qualcomm AI 100 اسٹینڈرڈ ایکسلریٹر کے ذریعے تقویت یافتہ، کو کلاؤڈ میں ڈیپ لرننگ (DL) ورک بوجھ کو لاگت سے موثر انداز میں تعینات کرنے کے لیے استعمال کیا جا سکتا ہے۔ انہیں ڈی ایل ورک بوجھ کی کارکردگی اور درستگی کو تیار کرنے اور درست کرنے کے لیے بھی استعمال کیا جا سکتا ہے جو Qualcomm ڈیوائسز پر تعینات کیے جائیں گے۔ DL2q مثالیں Qualcomm کی مصنوعی ذہین (AI) ٹیکنالوجی کو کلاؤڈ پر لانے کی پہلی مثالیں ہیں۔

آٹھ Qualcomm AI 100 سٹینڈرڈ ایکسلریٹر اور 128 GiB کل ایکسلریٹر میموری کے ساتھ، صارفین مقبول جنریٹو AI ایپلی کیشنز کو چلانے کے لیے DL2q مثالیں بھی استعمال کر سکتے ہیں، جیسے کہ مواد کی تیاری، متن کا خلاصہ، اور ورچوئل اسسٹنٹس کے ساتھ ساتھ قدرتی زبان کی پروسیسنگ کے لیے کلاسک AI ایپلی کیشنز۔ اور کمپیوٹر ویژن۔ مزید برآں، Qualcomm AI 100 accelerators میں وہی AI ٹیکنالوجی ہے جو سمارٹ فونز، خود مختار ڈرائیونگ، پرسنل کمپیوٹرز، اور توسیع شدہ رئیلٹی ہیڈسیٹ میں استعمال ہوتی ہے، لہذا DL2q مثالوں کو تعیناتی سے پہلے ان AI ورک لوڈز کو تیار کرنے اور ان کی تصدیق کرنے کے لیے استعمال کیا جا سکتا ہے۔

نئی DL2q مثال کی جھلکیاں

ہر DL2q مثال میں آٹھ Qualcomm Cloud AI100 ایکسلریٹر شامل ہیں، جس کی مجموعی کارکردگی Int2.8 inference کارکردگی کے 8 PetaOps اور FP1.4 inference کارکردگی کے 16 PetaFlops ہے۔ مثال میں مجموعی طور پر 112 اے آئی کور، ایکسلریٹر میموری کی گنجائش 128 جی بی اور میموری بینڈوڈتھ 1.1 ٹی بی فی سیکنڈ ہے۔

ہر DL2q مثال میں 96 vCPUs ہوتے ہیں، سسٹم میموری کی گنجائش 768 GB ہے اور 100 Gbps کی نیٹ ورکنگ بینڈوتھ کو بھی سپورٹ کرتی ہے۔ ایمیزون لچکدار بلاک اسٹور (ایمیزون ای بی ایس) 19 جی بی پی ایس کا ذخیرہ۔

| مثال کا نام | vCPUs | کلاؤڈ AI100 ایکسلریٹر | ایکسلریٹر میموری | ایکسلریٹر میموری BW (مجموعی) | مثال کی یادداشت | مثال کے طور پر نیٹ ورکنگ | اسٹوریج (ایمیزون ای بی ایس) بینڈوتھ |

| DL2q.24x بڑا | 96 | 8 | 128 GB | 1.088 ٹی بی / ایس | 768 GB | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100 ایکسلریٹر اختراع

کلاؤڈ AI100 ایکسلریٹر سسٹم آن چپ (SoC) ایک مقصد سے بنایا گیا، توسیع پذیر ملٹی کور فن تعمیر ہے، جو ڈیٹا سینٹر سے کنارے تک پھیلے ہوئے گہرے سیکھنے کے استعمال کے کیسز کی وسیع رینج کی حمایت کرتا ہے۔ ایس او سی اسکیلر، ویکٹر، اور ٹینسر کمپیوٹ کور کو استعمال کرتا ہے جس میں انڈسٹری کی معروف آن ڈائی SRAM صلاحیت 126 MB ہے۔ کور ایک اعلی بینڈوتھ کم لیٹنسی نیٹ ورک آن چپ (NoC) میش کے ساتھ آپس میں جڑے ہوئے ہیں۔

AI100 ایکسلریٹر ماڈلز اور استعمال کے کیسز کی ایک وسیع اور جامع رینج کو سپورٹ کرتا ہے۔ نیچے دی گئی جدول ماڈل سپورٹ کی حد کو نمایاں کرتی ہے۔

| ماڈل زمرہ | ماڈل کی تعداد۔ | مثالیں |

| این ایل پی | 157 | BERT, BART, FasterTransformer, T5, Z-code MOE |

| جنریٹو AI - NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| جنریٹیو AI - تصویر | 3 | مستحکم بازی v1.5 اور v2.1، OpenAI CLIP |

| CV - تصویری درجہ بندی | 45 | ViT، ResNet، ResNext، MobileNet، EfficientNet |

| CV - آبجیکٹ کا پتہ لگانا | 23 | YOLO v2, v3, v4, v5, and v7, SSD-ResNet, RetinaNet |

| CV - دیگر | 15 | LPRNet، سپر ریزولوشن/SRGAN، بائٹ ٹریک |

| آٹوموٹو نیٹ ورک* | 53 | پرسیپشن اور LIDAR، پیدل چلنے والوں، لین، اور ٹریفک لائٹ کا پتہ لگانا |

| کل | > 300 | |

* زیادہ تر آٹوموٹو نیٹ ورکس جامع نیٹ ورکس ہوتے ہیں جو انفرادی نیٹ ورکس کے فیوژن پر مشتمل ہوتے ہیں۔

DL2q ایکسلریٹر پر بڑی آن ڈائی SRAM اعلی کارکردگی کی تکنیکوں جیسے کہ وزن کو ذخیرہ کرنے کے لیے MX6 مائیکرو ایکسپوننٹ پریزیشن اور ایکسلریٹر سے ایکسلریٹر مواصلت کے لیے MX9 مائیکرو ایکسپوننٹ درستگی کے موثر نفاذ کے قابل بناتی ہے۔ مائیکرو ایکسپوننٹ ٹیکنالوجی کو مندرجہ ذیل اوپن کمپیوٹ پروجیکٹ (OCP) انڈسٹری کے اعلان میں بیان کیا گیا ہے: اے ایم ڈی، آرم، انٹیل، میٹا، مائیکروسافٹ، این وی آئی ڈی آئی اے، اور کوالکوم اسٹینڈرڈائز نیکسٹ جنریشن نیرو پریسجن ڈیٹا فارمیٹس برائے AI » اوپن کمپیوٹ پروجیکٹ.

مثال کے طور پر صارف کارکردگی فی لاگت کو زیادہ سے زیادہ کرنے کے لیے درج ذیل حکمت عملی کا استعمال کر سکتا ہے:

- آن ایکسلریٹر DDR میموری میں MX6 مائیکرو ایکسپوننٹ درستگی کا استعمال کرتے ہوئے وزن ذخیرہ کریں۔ MX6 درستگی کا استعمال دستیاب میموری کی گنجائش اور میموری بینڈ وڈتھ کے استعمال کو زیادہ سے زیادہ کرتا ہے تاکہ کلاس میں بہترین تھرو پٹ اور لیٹنسی فراہم کی جا سکے۔

- مطلوبہ استعمال کیس کی درستگی فراہم کرنے کے لیے FP16 میں کمپیوٹ کریں، جبکہ کارڈ پر اعلیٰ آن-چِپ SRAM اور فاضل TOPs کا استعمال کرتے ہوئے، اعلی کارکردگی والے کم لیٹنسی MX6 سے FP16 کرنل کو لاگو کریں۔

- وزن کے دوبارہ استعمال کو زیادہ سے زیادہ کرنے کے لیے دستیاب بڑی آن-چِپ SRAM کا استعمال کرتے ہوئے ایک بہترین بیچنگ کی حکمت عملی اور اعلیٰ بیچ سائز کا استعمال کریں، جبکہ ایکٹیویشنز کو زیادہ سے زیادہ ممکنہ حد تک آن چپ کو برقرار رکھتے ہوئے۔

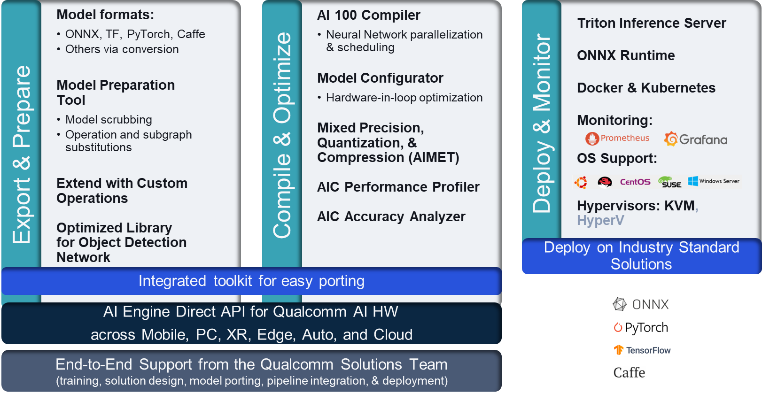

DL2q AI اسٹیک اور ٹول چین

DL2q مثال کے ساتھ Qualcomm AI Stack ہے جو Qualcomm AI میں کلاؤڈ اور دیگر Qualcomm پروڈکٹس میں ایک مستقل ڈویلپر کا تجربہ فراہم کرتا ہے۔ وہی Qualcomm AI اسٹیک اور بیس AI ٹیکنالوجی DL2q انسٹینسز اور Qualcomm edge ڈیوائسز پر چلتی ہے، جو صارفین کو ان کے کلاؤڈ، آٹوموٹیو، پرسنل کمپیوٹر، توسیعی حقیقت، اور اسمارٹ فون کی ترقی کے ماحول میں ایک متحد API کے ساتھ ایک مستقل ڈویلپر تجربہ فراہم کرتی ہے۔

ٹول چین مثال کے صارف کو اس قابل بناتا ہے کہ وہ پہلے سے تربیت یافتہ ماڈل کو تیزی سے جہاز میں لے جائے، مثال کی صلاحیتوں کے لیے ماڈل کو مرتب اور بہتر بنائے، اور بعد میں مندرجہ ذیل تصویر میں دکھائے گئے تین مراحل میں پروڈکشن انفرنس استعمال کے کیسز کے لیے مرتب کردہ ماڈلز کو تعینات کرے۔

ماڈل کی کارکردگی کو ٹیون کرنے کے بارے میں مزید جاننے کے لیے، دیکھیں Cloud AI 100 کلیدی کارکردگی کے پیرامیٹرز دستاویزی.

DL2q مثالوں کے ساتھ شروع کریں۔

اس مثال میں، آپ پہلے سے تربیت یافتہ کو مرتب اور تعینات کرتے ہیں۔ BERT ماڈل سے گلے لگانے والا چہرہ EC2 DL2q مثال کے طور پر چار مراحل میں پہلے سے تیار شدہ دستیاب DL2q AMI کا استعمال کرتے ہوئے۔

آپ یا تو پہلے سے بنایا ہوا استعمال کر سکتے ہیں۔ Qualcomm DLAMI مثال کے طور پر یا Amazon Linux2 AMI کے ساتھ شروع کریں اور اس میں دستیاب Cloud AI 2 پلیٹ فارم اور ایپس SDK کے ساتھ اپنا DL100q AMI بنائیں۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3) بالٹی: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

پیروی کرنے والے اقدامات پہلے سے تعمیر شدہ DL2q AMI کا استعمال کرتے ہیں، Qualcomm Base AL2 DLAMI.

Qualcomm Base AL2 DLAMI AMI کے ساتھ اپنے DL2q مثال تک رسائی حاصل کرنے کے لیے SSH کا استعمال کریں اور اقدامات 1 سے 4 تک عمل کریں۔

مرحلہ 1۔ ماحول کو ترتیب دیں اور مطلوبہ پیکجز انسٹال کریں۔

- Python 3.8 انسٹال کریں۔

- Python 3.8 ورچوئل ماحول ترتیب دیں۔

- Python 3.8 ورچوئل ماحول کو چالو کریں۔

- مطلوبہ پیکجز انسٹال کریں، جو میں دکھایا گیا ہے۔ requirements.txt دستاویز Qualcomm public Github سائٹ پر دستیاب ہے۔

- ضروری لائبریریاں درآمد کریں۔

مرحلہ 2۔ ماڈل درآمد کریں۔

- ماڈل کو درآمد اور ٹوکنائز کریں۔

- نمونہ ان پٹ کی وضاحت کریں اور نکالیں۔

inputIdsاورattentionMask. - ماڈل کو ONNX میں تبدیل کریں، جسے پھر کمپائلر کو بھیجا جا سکتا ہے۔

- آپ ماڈل کو FP16 درستگی میں چلائیں گے۔ لہذا، آپ کو یہ چیک کرنے کی ضرورت ہے کہ آیا ماڈل میں FP16 کی حد سے باہر کوئی مستقل موجود ہے۔ ماڈل کو پاس کریں۔

fix_onnx_fp16مطلوبہ اصلاحات کے ساتھ نئی ONNX فائل بنانے کے لیے فنکشن۔

مرحلہ 3۔ ماڈل مرتب کریں۔

۔ qaic-exec کمانڈ لائن انٹرفیس (CLI) کمپائلر ٹول ماڈل کو مرتب کرنے کے لیے استعمال کیا جاتا ہے۔ اس کمپائلر کا ان پٹ مرحلہ 2 میں تیار کردہ ONNX فائل ہے۔ کمپائلر ایک بائنری فائل تیار کرتا ہے (جسے کیو پی سی، کے لئے Qualcomm پروگرام کنٹینر) کے ذریعہ بیان کردہ راستے میں -aic-binary-dir دلیل.

ذیل میں کمپائل کمانڈ میں، آپ ماڈل کو مرتب کرنے کے لیے چار AI کمپیوٹ کور اور ایک بیچ سائز کا استعمال کرتے ہیں۔

QPC میں تیار کیا گیا ہے۔ bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc فولڈر.

مرحلہ 4۔ ماڈل چلائیں۔

DL100q مثال میں کلاؤڈ AI2 Qualcomm ایکسلریٹر پر اندازہ چلانے کے لیے ایک سیشن ترتیب دیں۔

Qualcomm qaic Python لائبریری APIs کا ایک سیٹ ہے جو کلاؤڈ AI100 ایکسلریٹر پر انفرنس چلانے کے لیے معاونت فراہم کرتا ہے۔

- سیشن کی مثال بنانے کے لیے سیشن API کال کا استعمال کریں۔ سیشن API کال qaic Python لائبریری کو استعمال کرنے کا انٹری پوائنٹ ہے۔

- آؤٹ پٹ بفر کے ساتھ ڈیٹا کو ری اسٹرکچر کریں۔

output_shapeاورoutput_type. - تیار کردہ آؤٹ پٹ کو ڈی کوڈ کریں۔

یہاں ان پٹ جملے کے نتائج ہیں "چٹائی پر کتا [MASK]۔"

یہی ہے. صرف چند قدموں کے ساتھ، آپ نے ایک Amazon EC2 DL2q مثال پر ایک PyTorch ماڈل مرتب کیا اور چلایا۔ DL2q مثال پر آن بورڈنگ اور مرتب کرنے کے بارے میں مزید جاننے کے لیے، دیکھیں کلاؤڈ AI100 ٹیوٹوریل دستاویزات۔

اس بارے میں مزید جاننے کے لیے کہ کون سے DL ماڈل آرکیٹیکچرز AWS DL2q مثالوں اور موجودہ ماڈل سپورٹ میٹرکس کے لیے موزوں ہیں، دیکھیں Qualcomm Cloud AI100 دستاویزات.

اب دستیاب

آپ آج ہی یو ایس ویسٹ (اوریگون) اور یورپ (فرینکفرٹ) AWS ریجنز میں DL2q مثالیں شروع کر سکتے ہیں۔ مطالبے پر, محفوظ ہے، اور اسپاٹ مثالوں، یا a کے حصے کے طور پر بچت کا منصوبہ. ہمیشہ کی طرح Amazon EC2 کے ساتھ، آپ صرف وہی ادائیگی کرتے ہیں جو آپ استعمال کرتے ہیں۔ مزید معلومات کے لیے دیکھیں ایمیزون ای سی 2 کی قیمت.

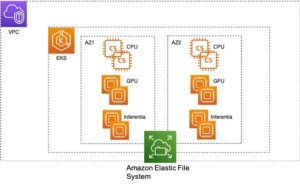

DL2q مثالوں کو استعمال کرتے ہوئے تعینات کیا جا سکتا ہے۔ AWS ڈیپ لرننگ AMIs (DLAMI)، اور کنٹینر کی تصاویر منظم خدمات کے ذریعے دستیاب ہیں جیسے ایمیزون سیج میکر, ایمیزون لچکدار کبرنیٹس سروس (ایمیزون ای کے ایس), ایمیزون لچکدار کنٹینر سروس (ایمیزون ای سی ایس)، اور AWS ParallelCluster.

مزید معلومات کے ل visit ، ملاحظہ کریں ایمیزون EC2 DL2q مثال صفحہ، اور فیڈ بیک بھیجیں۔ AWS re: EC2 کے لیے پوسٹ یا آپ کے معمول کے AWS سپورٹ رابطوں کے ذریعے۔

مصنفین کے بارے میں

اے کے رائے Qualcomm میں Cloud اور Datacenter AI مصنوعات اور حل کے لیے پروڈکٹ مینجمنٹ کے ڈائریکٹر ہیں۔ اس کے پاس پروڈکٹ کی حکمت عملی اور ترقی میں 20 سال سے زیادہ کا تجربہ ہے، جس میں کلاؤڈ میں AI تخمینہ کے لیے بہترین درجے کی کارکردگی اور کارکردگی/$ اینڈ ٹو اینڈ سلوشنز پر توجہ مرکوز ہے، استعمال کے کیسز کی وسیع رینج کے لیے، بشمول GenAI، LLMs، Auto اور Hybrid AI۔

اے کے رائے Qualcomm میں Cloud اور Datacenter AI مصنوعات اور حل کے لیے پروڈکٹ مینجمنٹ کے ڈائریکٹر ہیں۔ اس کے پاس پروڈکٹ کی حکمت عملی اور ترقی میں 20 سال سے زیادہ کا تجربہ ہے، جس میں کلاؤڈ میں AI تخمینہ کے لیے بہترین درجے کی کارکردگی اور کارکردگی/$ اینڈ ٹو اینڈ سلوشنز پر توجہ مرکوز ہے، استعمال کے کیسز کی وسیع رینج کے لیے، بشمول GenAI، LLMs، Auto اور Hybrid AI۔

جیانینگ لینگ AWS ورلڈ وائیڈ اسپیشلسٹ آرگنائزیشن (WWSO) میں پرنسپل سولیوشن آرکیٹیکٹ ہیں۔ اسے HPC اور AI فیلڈ میں کام کرنے کا 15 سال سے زیادہ کا تجربہ ہے۔ AWS میں، وہ صارفین کو تیز رفتار کمپیوٹنگ مثالوں پر ان کے AI/ML ورک بوجھ کو تعینات کرنے، بہتر بنانے اور اسکیل کرنے میں مدد کرنے پر توجہ مرکوز کرتی ہے۔ وہ HPC اور AI شعبوں میں تکنیک کو یکجا کرنے کا شوق رکھتی ہے۔ جیاننگ نے بولڈر میں کولوراڈو یونیورسٹی سے کمپیوٹیشنل فزکس میں پی ایچ ڈی کی ڈگری حاصل کی ہے۔

جیانینگ لینگ AWS ورلڈ وائیڈ اسپیشلسٹ آرگنائزیشن (WWSO) میں پرنسپل سولیوشن آرکیٹیکٹ ہیں۔ اسے HPC اور AI فیلڈ میں کام کرنے کا 15 سال سے زیادہ کا تجربہ ہے۔ AWS میں، وہ صارفین کو تیز رفتار کمپیوٹنگ مثالوں پر ان کے AI/ML ورک بوجھ کو تعینات کرنے، بہتر بنانے اور اسکیل کرنے میں مدد کرنے پر توجہ مرکوز کرتی ہے۔ وہ HPC اور AI شعبوں میں تکنیک کو یکجا کرنے کا شوق رکھتی ہے۔ جیاننگ نے بولڈر میں کولوراڈو یونیورسٹی سے کمپیوٹیشنل فزکس میں پی ایچ ڈی کی ڈگری حاصل کی ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- : ہے

- : ہے

- $UP

- 1

- 1 ٹی بی

- 10

- 100

- 11

- 12

- 13

- 15 سال

- 15٪

- 17

- 19

- 20

- 20 سال

- 22

- 23

- 7

- 75

- 8

- 84

- a

- ہمارے بارے میں

- اوپر

- تیز

- مسرع

- ایکسلریٹر

- تک رسائی حاصل

- کے ساتھ

- درستگی

- کے پار

- ایکٹیویشنز

- اس کے علاوہ

- اعلی درجے کی

- مجموعی

- AI

- AI / ML

- تمام

- بھی

- ایمیزون

- ایمیزون EC2

- ایمیزون ویب سروسز

- an

- اور

- اعلان

- کوئی بھی

- اے پی آئی

- APIs

- ایپلی کیشنز

- ایپس

- فن تعمیر

- کیا

- دلیل

- بازو

- مصنوعی

- AS

- اسسٹنٹ

- At

- آٹو

- آٹوموٹو

- خود مختار

- دستیاب

- AWS

- ایکسس

- بینڈوڈتھ

- بیس

- BE

- اس سے پہلے

- نیچے

- سے پرے

- بن

- بلاک

- بلوم

- لانے

- وسیع

- بفر

- تعمیر

- by

- فون

- کہا جاتا ہے

- کر سکتے ہیں

- صلاحیتوں

- اہلیت

- کارڈ

- کیس

- چیک کریں

- کلاسک

- بادل

- کولوراڈو

- امتزاج

- مواصلات

- وسیع

- کمپیوٹیشنل

- کمپیوٹنگ

- کمپیوٹر

- کمپیوٹر ویژن

- کمپیوٹر

- کمپیوٹنگ

- متواتر

- پر مشتمل ہے

- روابط

- کنٹینر

- پر مشتمل ہے

- مواد

- مواد پیدا کرنا

- تخلیق

- موجودہ

- گاہکوں

- اعداد و شمار

- ڈیٹا سنٹر

- گہری

- گہری سیکھنے

- کی وضاحت

- ڈگری

- نجات

- فراہم کرتا ہے

- تعیناتی

- تعینات

- تعیناتی

- بیان کیا

- ترقی

- ڈیولپر

- ترقی

- آلہ

- کے الات

- براڈ کاسٹننگ

- ڈائریکٹر

- دستاویزات

- کتا

- ڈرائیونگ

- متحرک

- ایج

- ہنر

- یا تو

- ملازمت کرتا ہے

- کے قابل بناتا ہے

- آخر سے آخر تک

- اندراج

- ماحولیات

- ماحول

- یورپ

- مثال کے طور پر

- تجربہ

- توسیع حقیقت

- نکالنے

- جھوٹی

- نمایاں کریں

- آراء

- چند

- میدان

- قطعات

- اعداد و شمار

- فائل

- پہلا

- فٹ

- توجہ مرکوز

- توجہ مرکوز

- پر عمل کریں

- کے بعد

- کے لئے

- ملا

- چار

- فرینکفرٹ

- سے

- تقریب

- فیوژن

- عام طور پر

- پیدا

- پیدا

- نسل

- پیداواری

- پیداواری AI۔

- GitHub کے

- دی

- اچھا

- مہمان

- مہمان پوسٹ

- he

- headsets کے

- مدد

- یہاں

- اعلی کارکردگی

- اعلی

- پر روشنی ڈالی گئی

- کی ڈگری حاصل کی

- ایچ پی سی

- HTML

- HTTPS

- ہائبرڈ

- i

- IDX

- if

- تصویر

- تصاویر

- پر عملدرآمد

- نفاذ

- درآمد

- in

- سمیت

- شامل

- انفرادی

- صنعت

- صنعت کے معروف

- معلومات

- ان پٹ

- انسٹال

- مثال کے طور پر

- انٹیل

- انٹیلجنٹ

- باہم منسلک

- انٹرفیس

- IT

- فوٹو

- صرف

- کلیدی

- لین

- زبان

- بڑے

- تاخیر

- شروع

- جانیں

- سیکھنے

- لائبریریوں

- لائبریری

- روشنی

- لائن

- بوجھ

- میں کامیاب

- انتظام

- ماسک

- میٹرکس

- میکس

- زیادہ سے زیادہ

- زیادہ سے زیادہ کرتا ہے

- زیادہ سے زیادہ

- یاد داشت

- میش

- میٹا

- مائیکروسافٹ

- منٹ

- ماڈل

- ماڈل

- نظر ثانی کی

- زیادہ

- سب سے زیادہ

- نام

- تنگ

- قدرتی

- قدرتی زبان عملیات

- ضروری

- ضرورت ہے

- نیٹ ورک

- نیٹ ورکنگ

- نیٹ ورک

- نئی

- اگلی نسل

- اب

- عجیب

- NVIDIA

- اعتراض

- of

- on

- جہاز

- جہاز

- ایک

- صرف

- کھول

- اوپنائی

- کی اصلاح کریں

- اصلاح

- or

- وریگن

- تنظیم

- OS

- دیگر

- باہر

- پیداوار

- نتائج

- پر

- خود

- پیکجوں کے

- صفحہ

- حصہ

- منظور

- منظور

- جذباتی

- راستہ

- ادا

- فی

- کارکردگی

- ذاتی

- پی ایچ ڈی

- طبعیات

- پلیٹ فارم

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوائنٹ

- مقبول

- ممکن

- پوسٹ

- طاقت

- صحت سے متعلق

- پہلے

- پرنسپل

- پروسیسنگ

- تیار

- پیدا کرتا ہے

- مصنوعات

- پروڈکٹ مینجمنٹ

- پیداوار

- حاصل

- پروگرام

- منصوبے

- فراہم کرتا ہے

- فراہم کرنے

- عوامی

- ازگر

- pytorch

- qualcomm

- جلدی سے

- رینج

- RE

- پڑھنا

- حقیقت

- خطوں

- ضرورت

- ضروریات

- برقرار رکھنے

- واپسی

- دوبارہ استعمال

- رای

- رن

- چل رہا ہے

- چلتا ہے

- اسی

- محفوظ کریں

- بچت

- توسیع پذیر

- پیمانے

- sdk

- دوسری

- دیکھنا

- بھیجنے

- سزا

- تسلسل

- سروس

- سروسز

- اجلاس

- مقرر

- وہ

- دکھایا گیا

- سادہ

- آسان بنانے

- سائٹ

- سائز

- اسمارٹ فون

- اسمارٹ فونز

- So

- حل

- تناؤ

- ماہر

- ڈھیر لگانا

- معیار

- شروع کریں

- شروع

- مرحلہ

- مراحل

- ذخیرہ

- ذخیرہ

- ذخیرہ کرنے

- حکمت عملی

- بعد میں

- اس طرح

- اعلی

- حمایت

- امدادی

- کی حمایت کرتا ہے

- سیس

- کے نظام

- ٹیبل

- تکنیک

- ٹیکنالوجی

- متن

- کہ

- ۔

- ان

- تو

- یہ

- وہ

- اس

- تین

- کے ذریعے

- تھرو پٹ

- میں

- کرنے کے لئے

- آج

- ٹوکن دینا

- کے آلے

- ٹاپس

- مشعل

- کل

- ٹریفک

- تربیت یافتہ

- ٹرانسفارمرز

- سچ

- ٹیوننگ

- سبق

- متحد

- یونیورسٹی

- us

- استعمال کی شرائط

- استعمال کیس

- استعمال کے معاملات

- استعمال کیا جاتا ہے

- رکن کا

- کا استعمال کرتے ہوئے

- ہمیشہ کی طرح

- v1

- تصدیق کریں۔

- قیمت

- مجازی

- نقطہ نظر

- دورہ

- we

- ویب

- ویب خدمات

- اچھا ہے

- مغربی

- کیا

- جس

- جبکہ

- وسیع

- وسیع رینج

- گے

- ساتھ

- لفظ

- کام کر

- دنیا بھر

- سال

- تم

- اور

- زیفیرنیٹ