"کوڈ پر توجہ مرکوز کرنے کے بجائے، کمپنیوں کو ڈیٹا کو بہتر بنانے کے لیے منظم انجینئرنگ کے طریقوں کو تیار کرنے پر توجہ دینی چاہیے جو قابل اعتماد، موثر اور منظم ہوں۔ دوسرے لفظوں میں، کمپنیوں کو ماڈل سینٹرک اپروچ سے ڈیٹا سینٹرک اپروچ کی طرف جانے کی ضرورت ہے۔ - اینڈریو این جی

ڈیٹا سینٹرک AI اپروچ میں کوالٹی ڈیٹا کے ساتھ AI سسٹمز بنانا شامل ہے جس میں ڈیٹا کی تیاری اور فیچر انجینئرنگ شامل ہے۔ یہ ایک مشکل کام ہو سکتا ہے جس میں ڈیٹا اکٹھا کرنا، دریافت کرنا، پروفائلنگ کرنا، صفائی کرنا، ڈھانچہ بنانا، تبدیلی کرنا، افزودہ کرنا، تصدیق کرنا اور محفوظ طریقے سے ڈیٹا کو محفوظ کرنا شامل ہے۔

ایمیزون سیج میکر ڈیٹا رینگلر میں ایک خدمت ہے ایمیزون سیج میکر اسٹوڈیو جو ڈیٹا کو درآمد کرنے، تیار کرنے، تبدیل کرنے، فیچرائز کرنے اور تجزیہ کرنے کے لیے بہت کم سے لے کر بغیر کوڈنگ کے ایک اینڈ ٹو اینڈ حل فراہم کرتا ہے۔ آپ ڈیٹا رینگلر ڈیٹا کی تیاری کے بہاؤ کو اپنی مشین لرننگ (ML) ورک فلو میں ضم کر سکتے ہیں تاکہ ڈیٹا پری پروسیسنگ اور فیچر انجینئرنگ کو آسان بنایا جا سکے، PySpark کوڈ لکھنے، Apache Spark انسٹال کرنے، یا اسپن اپ کلسٹرز کی ضرورت کے بغیر ڈیٹا کی تیاری کو تیزی سے پروڈکشن میں لے جا سکتے ہیں۔

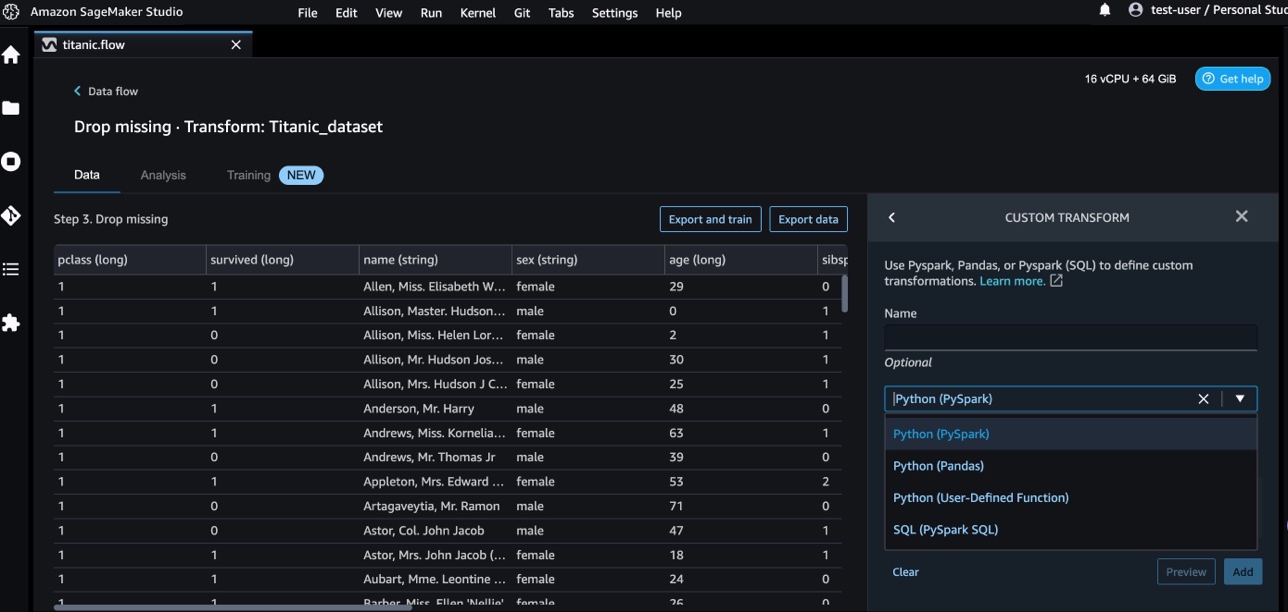

ایسے منظرناموں کے لیے جہاں آپ کو ڈیٹا کی تبدیلی کے لیے اپنی مرضی کے مطابق اسکرپٹس شامل کرنے کی ضرورت ہے، آپ اپنی تبدیلی کی منطق کو Pandas, PySpark, PySpark SQL میں لکھ سکتے ہیں۔ ڈیٹا رینگلر اب NLTK اور SciPy لائبریریوں کو ML کے لیے ٹیکسٹ ڈیٹا تیار کرنے اور کنسٹرنٹ آپٹیمائزیشن کو انجام دینے کے لیے حسب ضرورت تبدیلیوں کو تصنیف کرنے کے لیے سپورٹ کرتا ہے۔

آپ ایسے منظرناموں میں چل سکتے ہیں جہاں آپ کو ڈیٹا کی تبدیلی کے لیے اپنی مرضی کے مطابق اسکرپٹس کو شامل کرنا ہوگا۔ ڈیٹا رینگلر کسٹم ٹرانسفارم کی اہلیت کے ساتھ، آپ اپنی تبدیلی کی منطق کو Pandas، PySpark، PySpark SQL میں لکھ سکتے ہیں۔

اس پوسٹ میں، ہم بحث کرتے ہیں کہ آپ ML کے لیے ٹیکسٹ ڈیٹا تیار کرنے کے لیے NLTK میں اپنی مرضی کی تبدیلی کیسے لکھ سکتے ہیں۔ ہم دوسرے عام فریم ورک جیسے NLTK، NumPy، SciPy، اور scikit-learn کے ساتھ ساتھ AWS AI سروسز کا استعمال کرتے ہوئے کچھ مثالیں حسب ضرورت کوڈ ٹرانسفارم بھی شیئر کریں گے۔ اس مشق کے مقصد کے لیے، ہم استعمال کرتے ہیں۔ ٹائٹینک ڈیٹاسیٹ، ML کمیونٹی میں ایک مقبول ڈیٹاسیٹ، جسے اب بطور a شامل کیا گیا ہے۔ نمونہ ڈیٹاسیٹ ڈیٹا رینگلر کے اندر۔

حل جائزہ

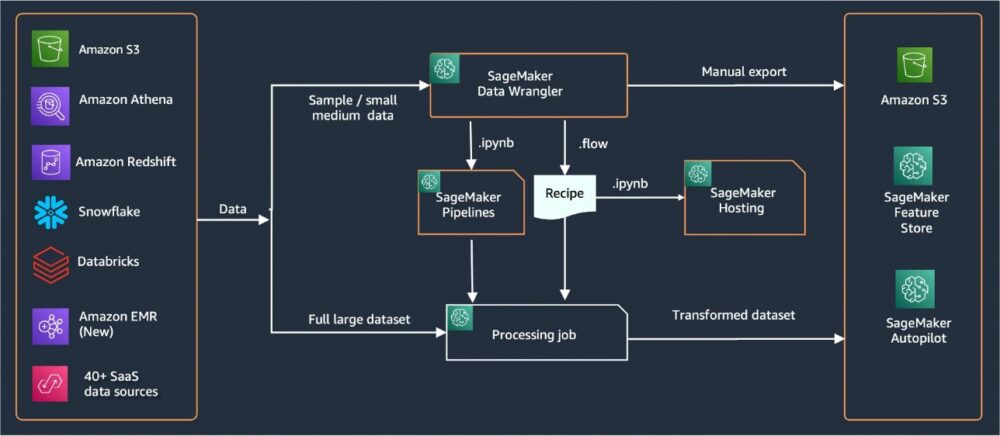

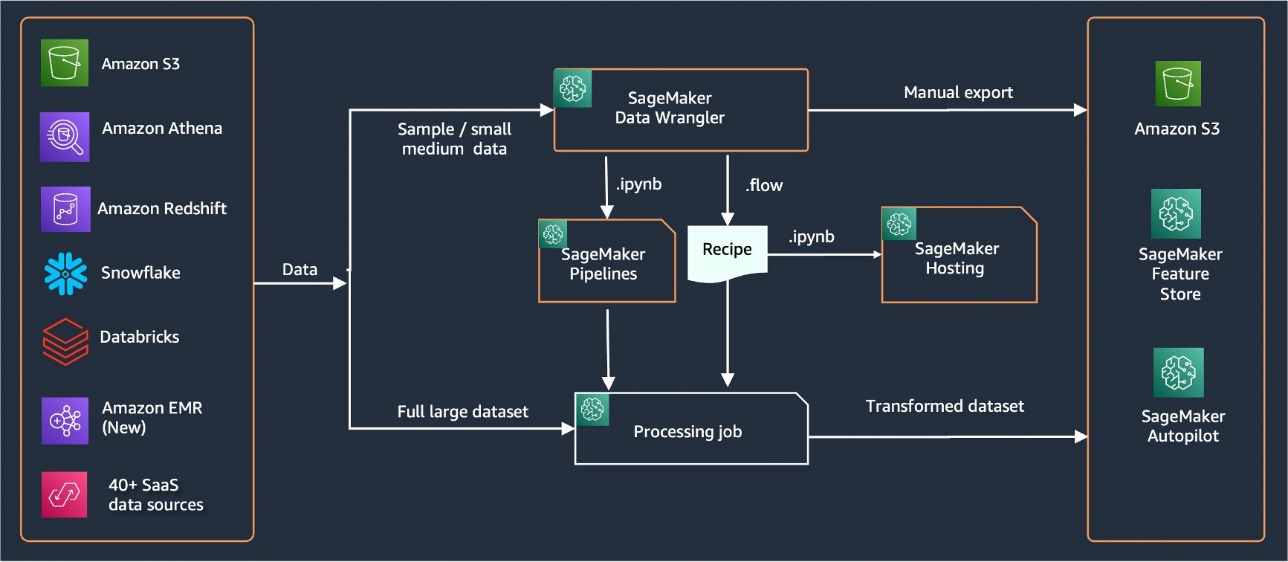

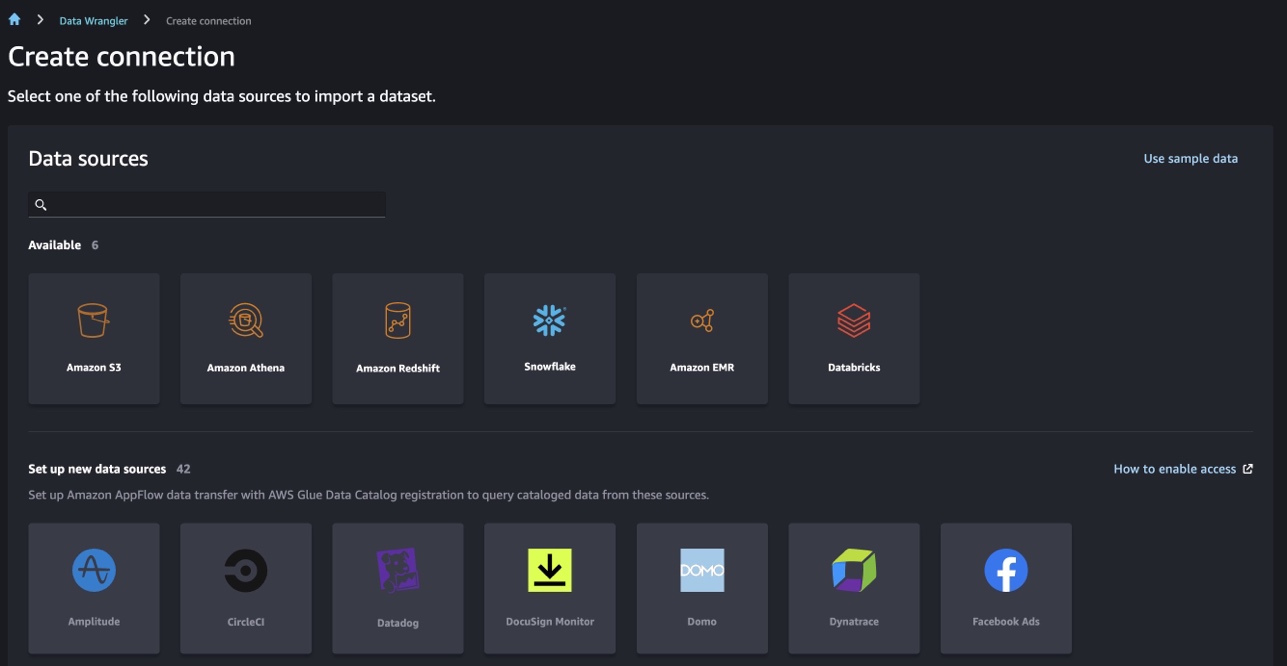

ڈیٹا رینگلر ڈیٹا درآمد کرنے کے لیے 40 سے زیادہ بلٹ ان کنیکٹر فراہم کرتا ہے۔ ڈیٹا درآمد کرنے کے بعد، آپ 300 سے زیادہ بلٹ ان ٹرانسفارمیشنز کا استعمال کرتے ہوئے اپنے ڈیٹا کا تجزیہ اور تبدیلیاں بنا سکتے ہیں۔ اس کے بعد آپ خصوصیات کو آگے بڑھانے کے لیے صنعتی پائپ لائنیں بنا سکتے ہیں۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3) یا ایمیزون سیج میکر فیچر اسٹور. درج ذیل خاکہ آخر سے آخر تک اعلیٰ سطحی فن تعمیر کو ظاہر کرتا ہے۔

شرائط

ڈیٹا رینگلر ایک سیج میکر فیچر ہے جو اس کے اندر دستیاب ہے۔ ایمیزون سیج میکر اسٹوڈیو. آپ پیروی کر سکتے ہیں۔ اسٹوڈیو میں آن بورڈنگ کا عمل اسٹوڈیو کے ماحول اور نوٹ بک کو گھماؤ۔ اگرچہ آپ تصدیق کے چند طریقوں میں سے انتخاب کر سکتے ہیں، لیکن اسٹوڈیو ڈومین بنانے کا آسان ترین طریقہ یہ ہے کہ فوری آغاز کی ہدایات. کوئیک اسٹارٹ معیاری اسٹوڈیو سیٹ اپ جیسی ڈیفالٹ سیٹنگز کا استعمال کرتا ہے۔ آپ آن بورڈ کا استعمال کرتے ہوئے بھی انتخاب کر سکتے ہیں۔ AWS IAM شناختی مرکز (AWS سنگل سائن آن کا جانشین) توثیق کے لیے (دیکھیں۔ IAM شناختی مرکز کا استعمال کرتے ہوئے Amazon SageMaker ڈومین پر آن بورڈ).

ٹائٹینک ڈیٹاسیٹ درآمد کریں۔

اپنا اسٹوڈیو ماحول شروع کریں اور ایک نیا بنائیں ڈیٹا رینگلر کا بہاؤ. آپ یا تو اپنا ڈیٹا سیٹ درآمد کر سکتے ہیں یا نمونہ ڈیٹا سیٹ (ٹائٹینک) استعمال کر سکتے ہیں جیسا کہ درج ذیل اسکرین شاٹ میں دکھایا گیا ہے۔ ڈیٹا رینگلر آپ کو مختلف ڈیٹا ذرائع سے ڈیٹا سیٹس درآمد کرنے کی اجازت دیتا ہے۔ اپنے استعمال کے معاملے کے لیے، ہم S3 بالٹی سے نمونہ ڈیٹاسیٹ درآمد کرتے ہیں۔

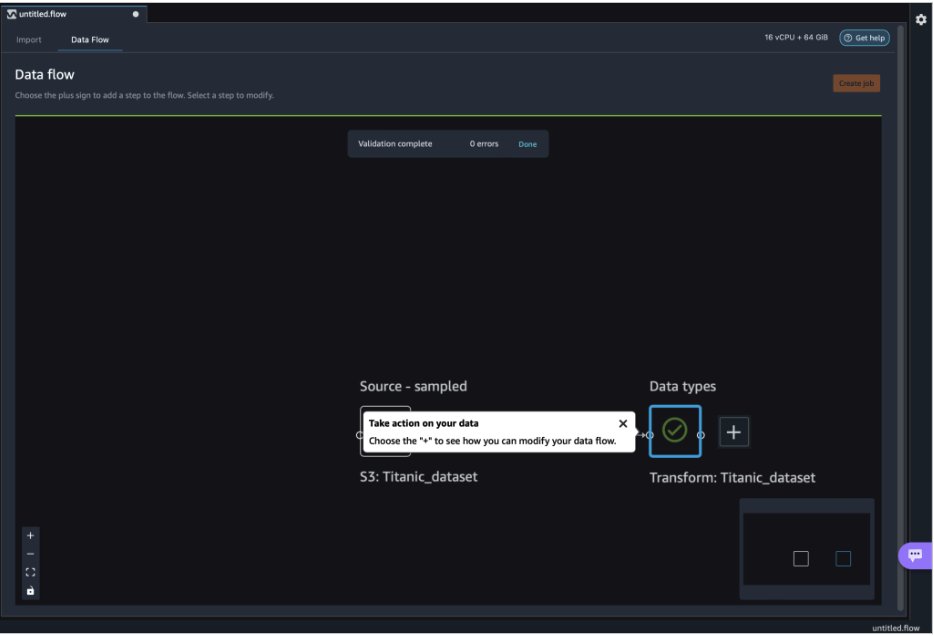

ایک بار درآمد کرنے کے بعد، آپ کو ڈیٹا فلو میں دو نوڈس (سورس نوڈ اور ڈیٹا ٹائپ نوڈ) نظر آئیں گے۔ ڈیٹا رینگلر ڈیٹا سیٹ میں موجود تمام کالموں کے لیے ڈیٹا کی قسم کی خود بخود شناخت کرتا ہے۔

NLTK کے ساتھ اپنی مرضی کے مطابق تبدیلیاں

ڈیٹا رینگلر کے ساتھ ڈیٹا کی تیاری اور فیچر انجینئرنگ کے لیے، آپ 300 سے زیادہ بلٹ ان ٹرانسفارمیشنز استعمال کر سکتے ہیں یا اپنی مرضی کے مطابق تبدیلیاں بنا سکتے ہیں۔ اپنی مرضی کے مطابق تبدیلیاں ڈیٹا رینگلر کے اندر الگ الگ مراحل کے طور پر لکھا جا سکتا ہے۔ وہ ڈیٹا رینگلر کے اندر موجود .flow فائل کا حصہ بن جاتے ہیں۔ کسٹم ٹرانسفارم فیچر Python، PySpark، اور SQL کو کوڈ کے ٹکڑوں میں مختلف مراحل کے طور پر سپورٹ کرتا ہے۔ نوٹ بک فائلز (.ipynb) کے .flow فائل سے تیار ہونے کے بعد یا .flow فائل کو بطور ترکیب استعمال کرنے کے بعد، اپنی مرضی کے ٹرانسفارم کوڈ کے ٹکڑے بغیر کسی تبدیلی کی ضرورت کے برقرار رہتے ہیں۔ ڈیٹا رینگلر کا یہ ڈیزائن کسٹم ٹرانسفارمز کو اپنی مرضی کے مطابق تبدیلیوں کے ساتھ بڑے ڈیٹا سیٹس پر کارروائی کرنے کے لیے سیج میکر پروسیسنگ جاب کا حصہ بننے دیتا ہے۔

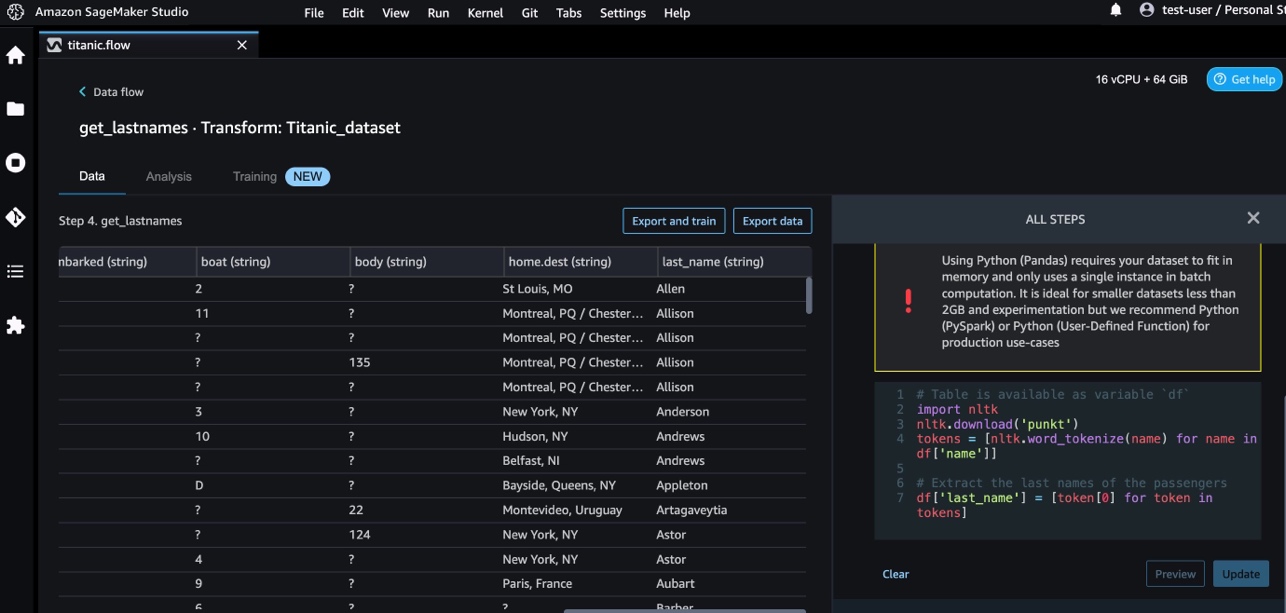

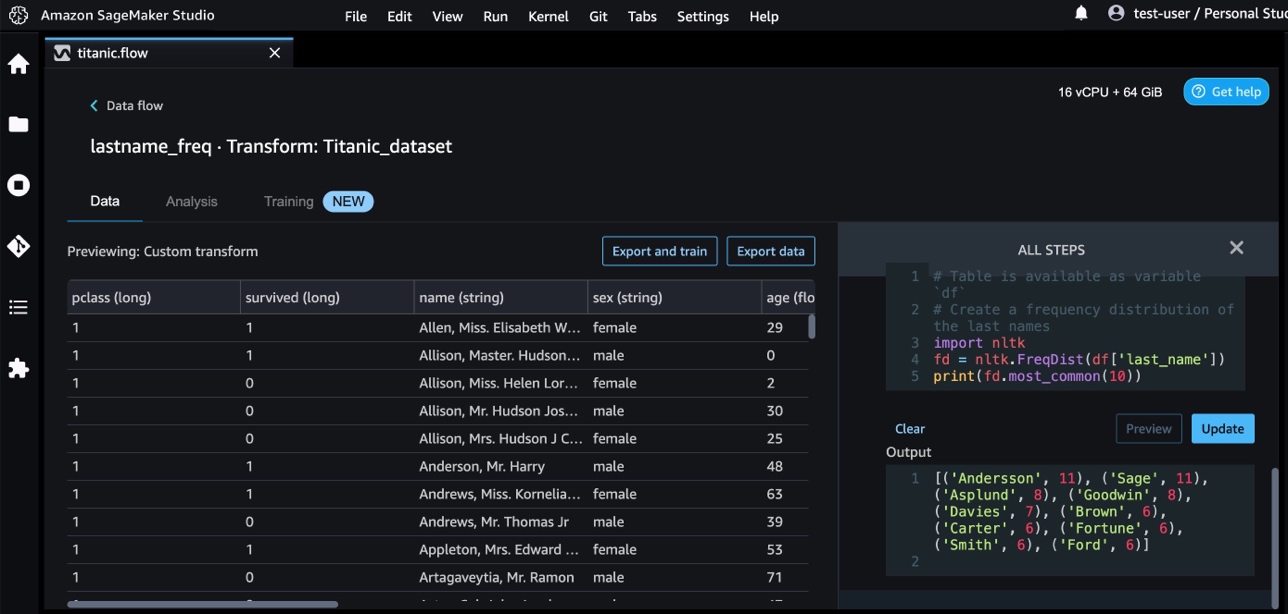

ٹائٹینک ڈیٹاسیٹ میں کچھ خصوصیات (نام اور home.dest) ہیں جن میں متن کی معلومات شامل ہیں۔ ہم استعمال کرتے ہیں این ایل ٹی کے نام کے کالم کو تقسیم کرنے اور آخری نام نکالنے کے لیے، اور آخری ناموں کی فریکوئنسی پرنٹ کرنے کے لیے۔ NLTK انسانی زبان کے ڈیٹا کے ساتھ کام کرنے کے لیے Python پروگرام بنانے کا ایک اہم پلیٹ فارم ہے۔ یہ استعمال میں آسان انٹرفیس فراہم کرتا ہے۔ 50 سے زیادہ کارپورا اور لغوی وسائل جیسے WordNet، درجہ بندی، ٹوکنائزیشن، اسٹیمنگ، ٹیگنگ، پارسنگ، اور سیمینٹک ریجننگ کے لیے ٹیکسٹ پروسیسنگ لائبریریوں کے ایک سوٹ کے ساتھ، اور صنعتی طاقت کی قدرتی زبان کی پروسیسنگ (NLP) لائبریریوں کے لیے ریپرز۔

ایک نیا ٹرانسفارم شامل کرنے کے لیے، درج ذیل مراحل کو مکمل کریں:

- جمع کا نشان منتخب کریں اور منتخب کریں۔ ٹرانسفارم شامل کریں۔.

- میں سے انتخاب کریں قدم شامل کریں اور منتخب کریں کسٹم ٹرانسفارم.

آپ Pandas، PySpark، Python صارف کی طرف سے طے شدہ فنکشنز، اور SQL PySpark کا استعمال کرتے ہوئے اپنی مرضی کی تبدیلی بنا سکتے ہیں۔

- میں سے انتخاب کریں ازگر (پانڈا) اور نام کے کالم سے آخری نام نکالنے کے لیے درج ذیل کوڈ شامل کریں:

- میں سے انتخاب کریں پیش نظارہ نتائج کا جائزہ لینے کے لیے۔

مندرجہ ذیل اسکرین شاٹ دکھاتا ہے۔ last_name کالم نکالا گیا۔

- درج ذیل کوڈ کا استعمال کرتے ہوئے آخری ناموں کی فریکوئنسی تقسیم کی شناخت کے لیے ایک اور حسب ضرورت تبدیلی کا مرحلہ شامل کریں:

- میں سے انتخاب کریں پیش نظارہ تعدد کے نتائج کا جائزہ لینے کے لیے۔

AWS AI خدمات کے ساتھ اپنی مرضی کے مطابق تبدیلیاں

AWS پہلے سے تربیت یافتہ AI سروسز آپ کی ایپلیکیشنز اور ورک فلو کے لیے تیار شدہ انٹیلی جنس فراہم کرتی ہیں۔ AWS AI سروسز آپ کی ایپلی کیشنز کے ساتھ آسانی سے ضم ہو جاتی ہیں تاکہ عام استعمال کے بہت سے معاملات کو حل کیا جا سکے۔ اب آپ ڈیٹا رینگلر میں اپنی مرضی کے مطابق تبدیلی کے قدم کے طور پر AWS AI سروسز کی صلاحیتوں کو استعمال کر سکتے ہیں۔

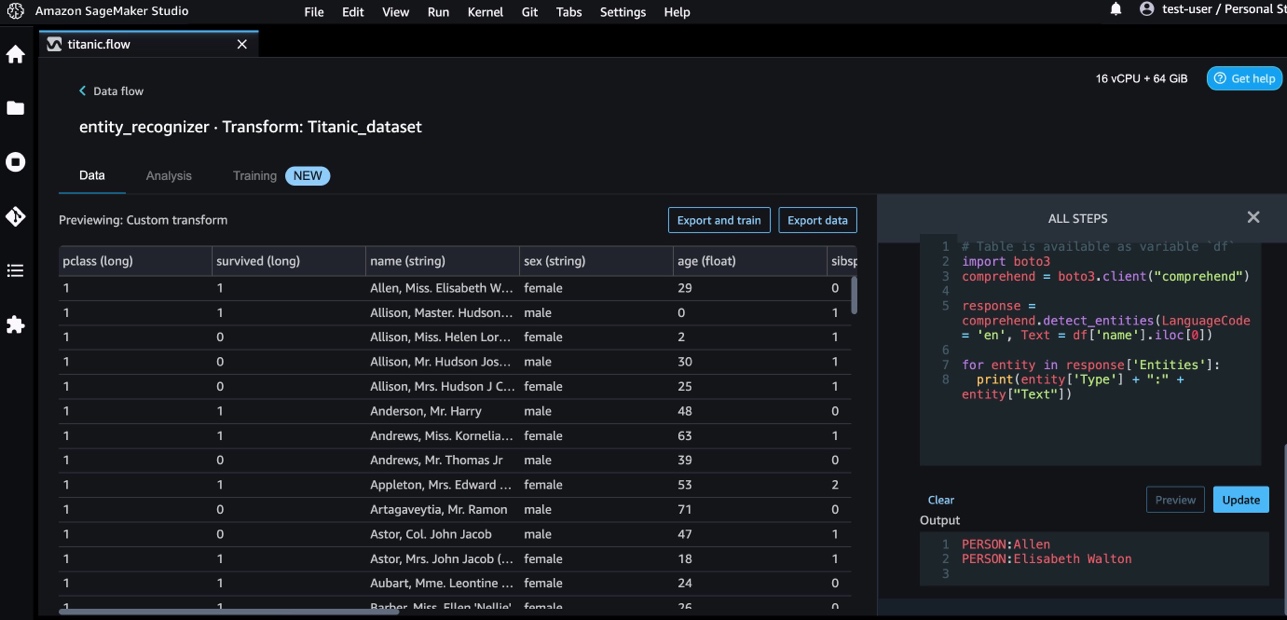

ایمیزون کی تعریف دستاویزات کے مواد کے بارے میں بصیرت حاصل کرنے کے لیے NLP کا استعمال کرتا ہے۔ یہ دستاویز میں موجود ہستیوں، کلیدی فقروں، زبان، جذبات اور دیگر عام عناصر کو پہچان کر بصیرت پیدا کرتا ہے۔

ہم نام کے کالم سے ہستیوں کو نکالنے کے لیے Amazon Comprehend کا استعمال کرتے ہیں۔ درج ذیل مراحل کو مکمل کریں:

- اپنی مرضی کے مطابق تبدیلی کا مرحلہ شامل کریں۔

- میں سے انتخاب کریں ازگر (پانڈا).

- اداروں کو نکالنے کے لیے درج ذیل کوڈ درج کریں:

- میں سے انتخاب کریں پیش نظارہ اور نتائج کا تصور کریں۔

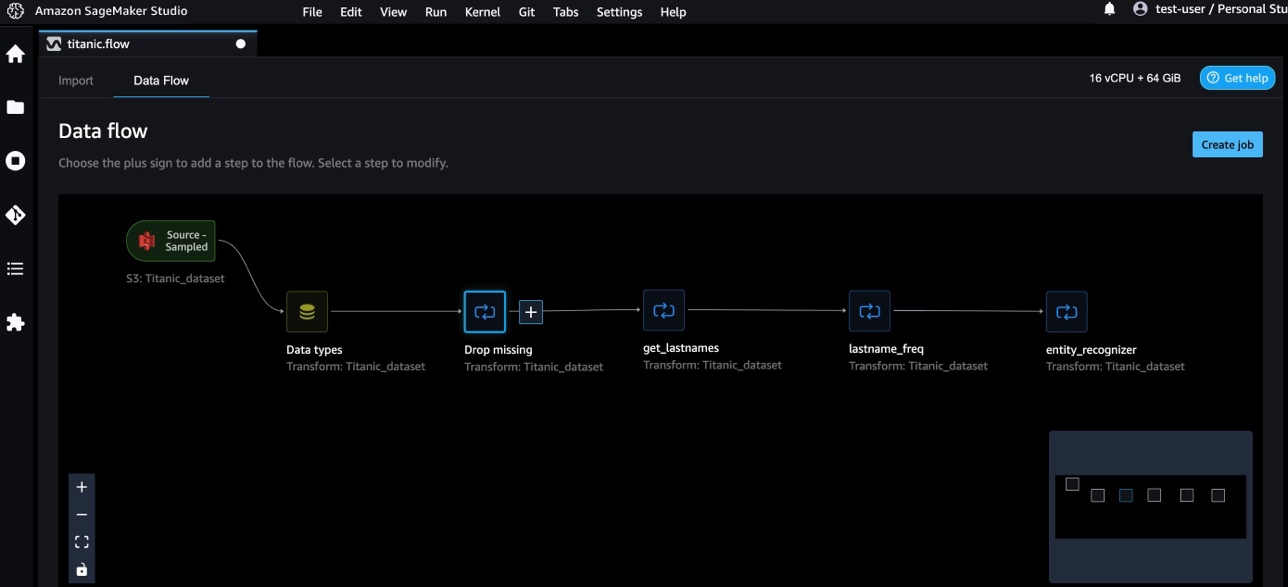

اب ہم نے ڈیٹا رینگلر میں تین کسٹم ٹرانسفارمز شامل کیے ہیں۔

- میں سے انتخاب کریں ڈیٹا کے بہاؤ آخر سے آخر تک ڈیٹا کے بہاؤ کو دیکھنے کے لیے۔

NumPy اور SciPy کے ساتھ حسب ضرورت تبدیلیاں

بے حس Python کے لیے ایک اوپن سورس لائبریری ہے جو جامع ریاضیاتی فنکشنز، بے ترتیب نمبر جنریٹر، لکیری الجبرا روٹینز، فوئیر ٹرانسفارمز، اور بہت کچھ پیش کرتی ہے۔ سائنس پائی۔ ایک اوپن سورس Python لائبریری ہے جو سائنسی کمپیوٹنگ اور تکنیکی کمپیوٹنگ کے لیے استعمال ہوتی ہے، جس میں اصلاح کے لیے ماڈیولز، لکیری الجبرا، انٹیگریشن، انٹرپولیشن، خصوصی فنکشنز، فاسٹ فوئیر ٹرانسفارم (FFT)، سگنل اور امیج پروسیسنگ، حل کرنے والے اور بہت کچھ شامل ہے۔

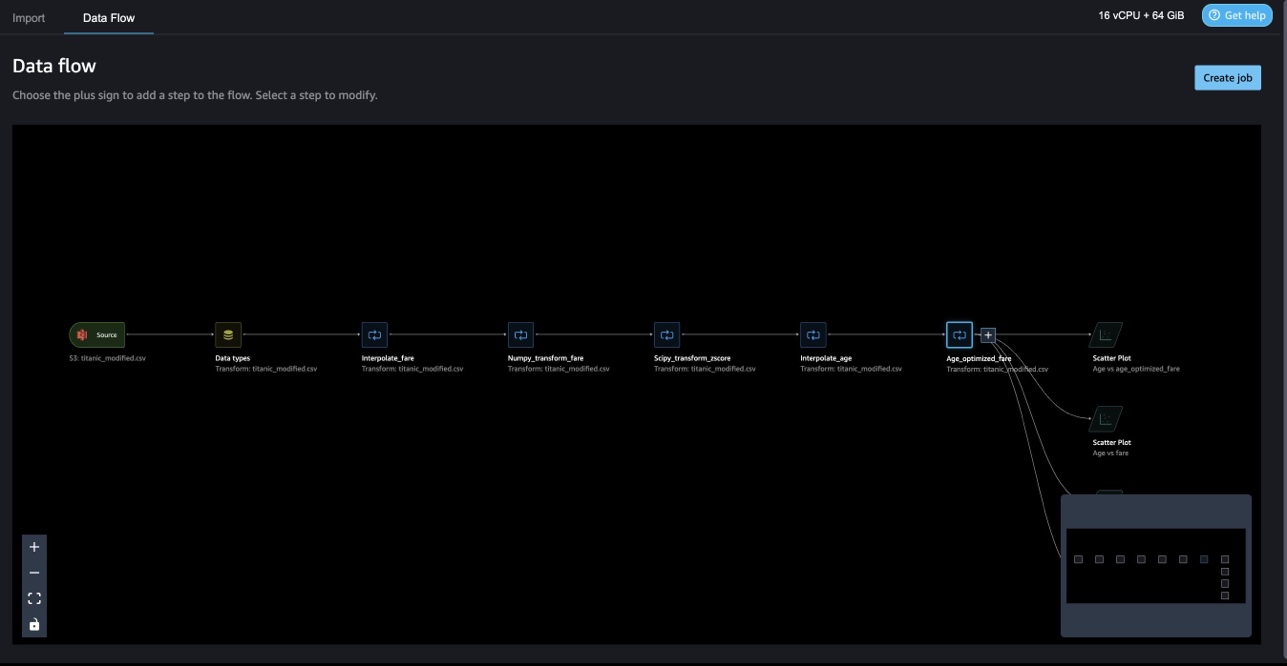

ڈیٹا رینگلر کسٹم ٹرانسفارمز آپ کو Python، PySpark، اور SQL کو مختلف مراحل کے طور پر یکجا کرنے کی اجازت دیتا ہے۔ مندرجہ ذیل ڈیٹا رینگلر کے بہاؤ میں، Python پیکجز، NumPy، اور SciPy کے مختلف فنکشنز کو متعدد مراحل کے طور پر ٹائٹینک ڈیٹاسیٹ پر لاگو کیا جاتا ہے۔

NumPy تبدیلیاں

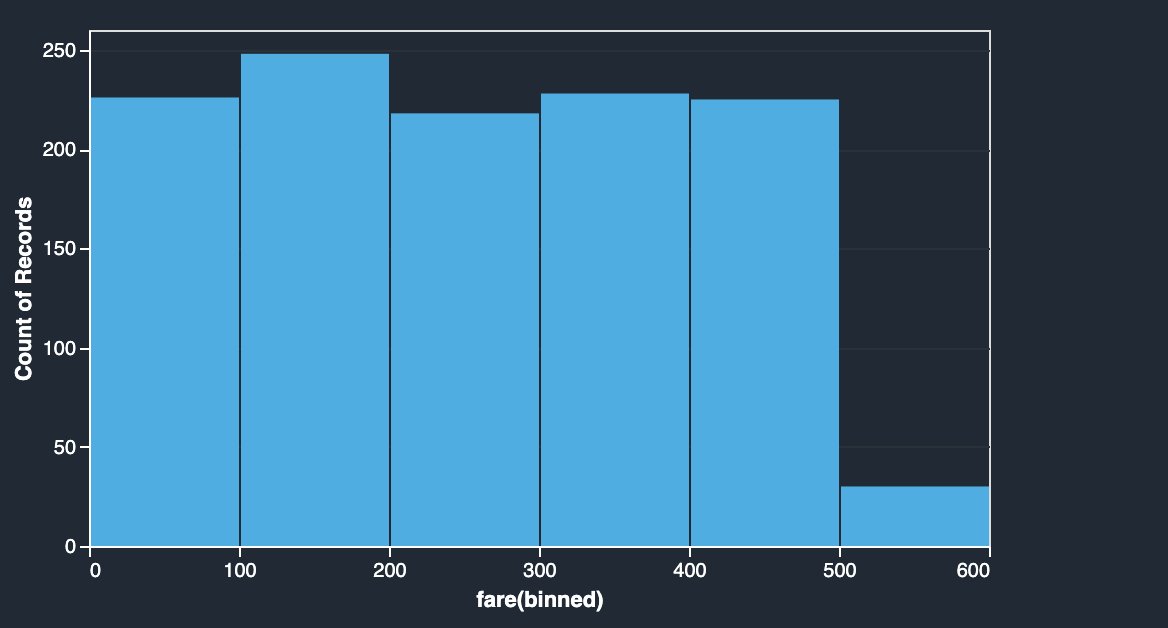

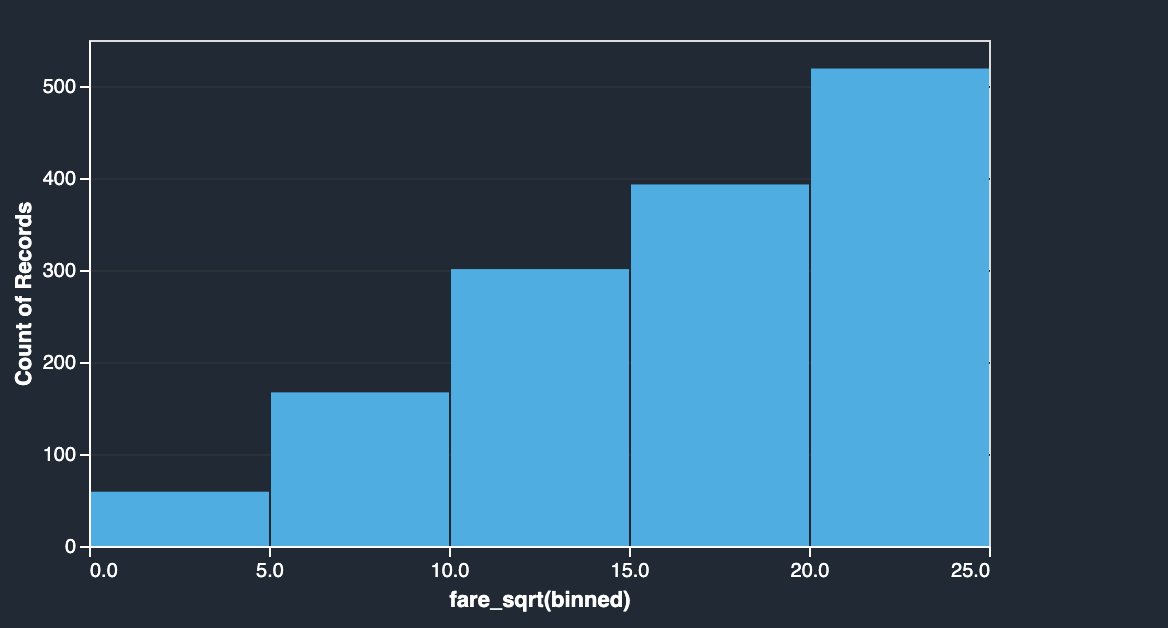

ٹائٹینک ڈیٹاسیٹ کے کرائے کے کالم میں مختلف مسافروں کے بورڈنگ کرایے ہیں۔ کرایہ کے کالم کا ہسٹوگرام یکساں تقسیم دکھاتا ہے، سوائے آخری ڈبے کے۔ لاگ یا مربع جڑ جیسے NumPy تبدیلیوں کو لاگو کرکے، ہم تقسیم کو تبدیل کر سکتے ہیں (جیسا کہ مربع جڑ کی تبدیلی سے دکھایا گیا ہے)۔

|

|

درج ذیل کوڈ دیکھیں:

SciPy تبدیلیاں

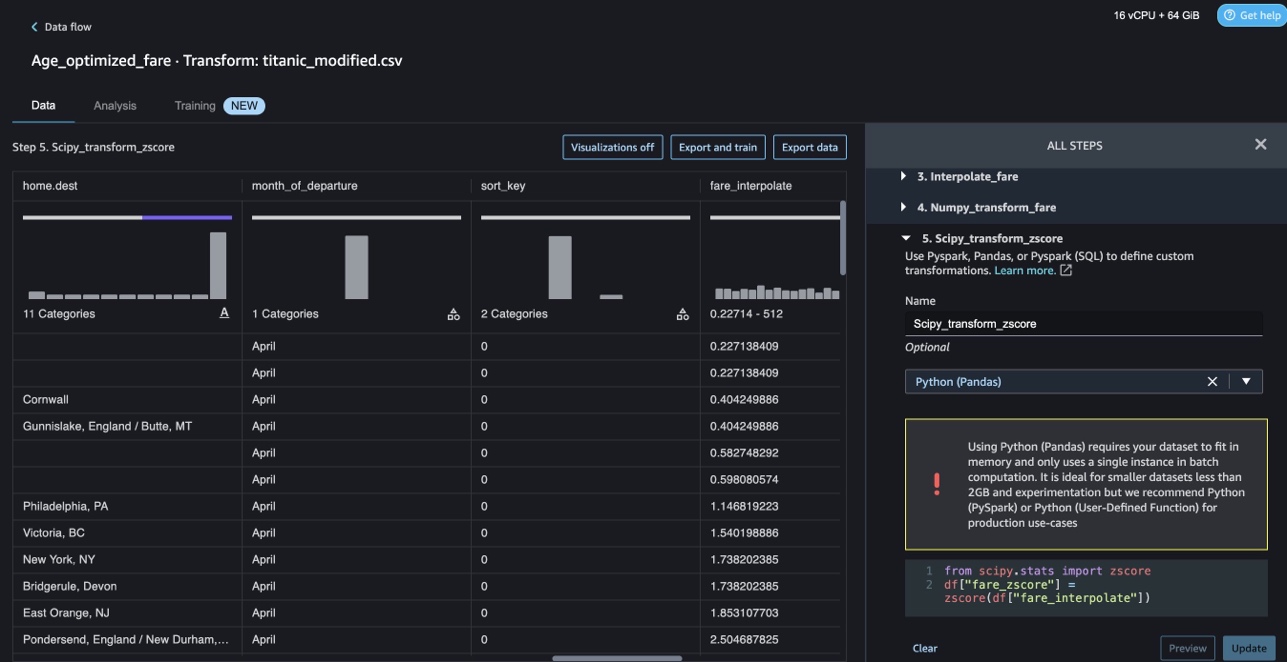

SciPy فنکشنز جیسے z-score کا اطلاق اپنی مرضی کے مطابق تبدیلی کے حصے کے طور پر کرائے کی تقسیم کو اوسط اور معیاری انحراف کے ساتھ معیاری بنانے کے لیے کیا جاتا ہے۔

درج ذیل کوڈ دیکھیں:

NumPy اور SciPy کے ساتھ رکاوٹ کی اصلاح

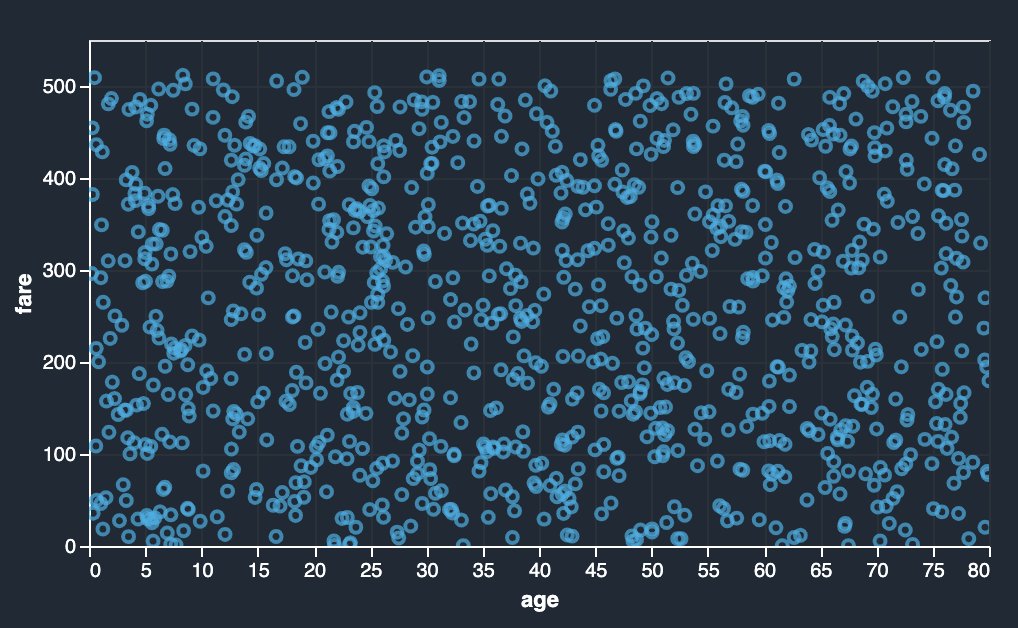

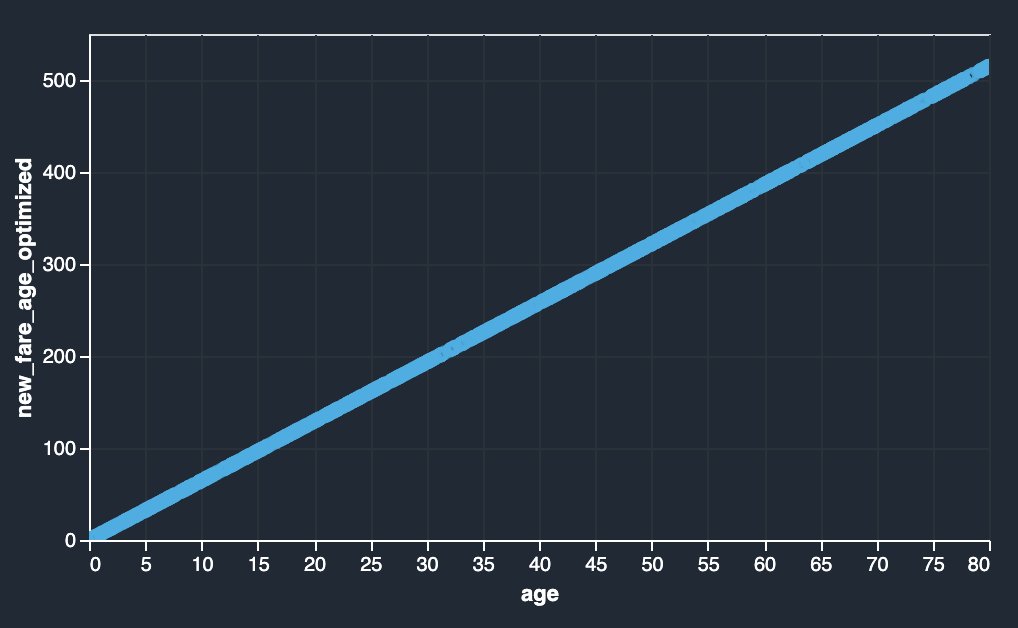

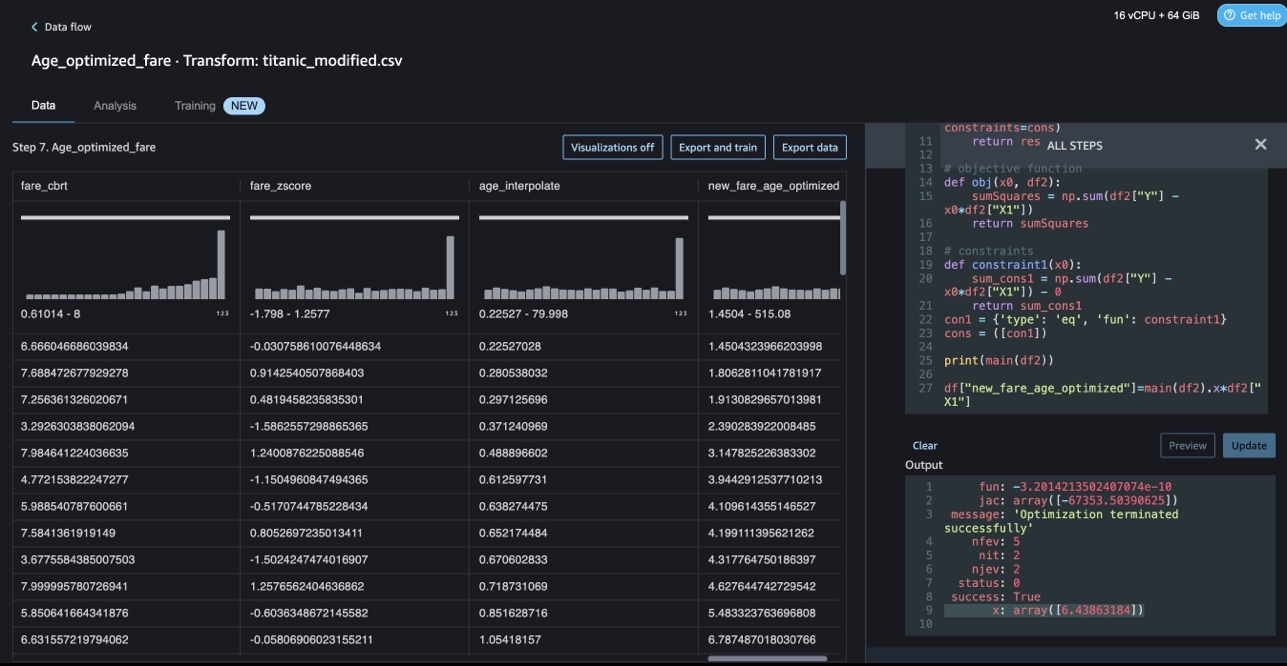

ڈیٹا رینگلر کسٹم ٹرانسفارمز ایڈوانس ٹرانسفارمیشنز کو سنبھال سکتے ہیں جیسے SciPy آپٹمائز فنکشنز کا اطلاق کرنا اور SciPy کو NumPy کے ساتھ ملانا۔ درج ذیل مثال میں، عمر کے فنکشن کے طور پر کرایہ کوئی قابل مشاہدہ رجحان نہیں دکھاتا ہے۔ تاہم، رکاوٹ کی اصلاح کرایہ کو عمر کے کام کے طور پر تبدیل کر سکتی ہے۔ اس معاملے میں رکاوٹ کی شرط یہ ہے کہ نیا کل کرایہ پرانے کل کرایہ جیسا ہی رہتا ہے۔ ڈیٹا رینگلر کسٹم ٹرانسفارمز آپ کو بہترین گتانک کا تعین کرنے کے لیے SciPy آپٹیمائز فنکشن چلانے کی اجازت دیتے ہیں جو کہ محدود حالات میں عمر کے فنکشن کے طور پر کرایہ کو تبدیل کر سکتا ہے۔

|

|

SciPy اور NumPy کا استعمال کرتے ہوئے ڈیٹا رینگلر کسٹم ٹرانسفارم میں رکاوٹ کو بہتر بنانے کے دوران اصلاح کی تعریف، مقصدی تعریف، اور متعدد رکاوٹوں کا ذکر مختلف افعال کے طور پر کیا جا سکتا ہے۔ کسٹم ٹرانسفارمز مختلف حل کرنے والے طریقے بھی لا سکتے ہیں جو SciPy آپٹیمائز پیکج کے حصے کے طور پر دستیاب ہیں۔ ایک نیا تبدیل شدہ متغیر اصل کالم کے ساتھ بہترین عدد کو ضرب دے کر اور ڈیٹا رینگلر کے موجودہ کالموں میں شامل کر کے تیار کیا جا سکتا ہے۔ درج ذیل کوڈ دیکھیں:

ڈیٹا رینگلر کسٹم ٹرانسفارم فیچر میں UI کی صلاحیت ہے کہ وہ SciPy آپٹیمائز فنکشنز کے نتائج کو ظاہر کرے جیسے کہ زیادہ سے زیادہ گتانک کی قدر (یا ایک سے زیادہ عدد)۔

اسکیٹ لرن کے ساتھ اپنی مرضی کے مطابق تبدیلیاں

سائنٹ سیکھنا مشین لرننگ کے لیے ایک Python ماڈیول ہے جو SciPy کے اوپر بنایا گیا ہے۔ یہ ایک اوپن سورس ML لائبریری ہے جو زیر نگرانی اور غیر زیر نگرانی سیکھنے کی حمایت کرتی ہے۔ یہ ماڈل فٹنگ، ڈیٹا پری پروسیسنگ، ماڈل سلیکشن، ماڈل کی تشخیص، اور بہت سی دیگر افادیت کے لیے مختلف ٹولز بھی فراہم کرتا ہے۔

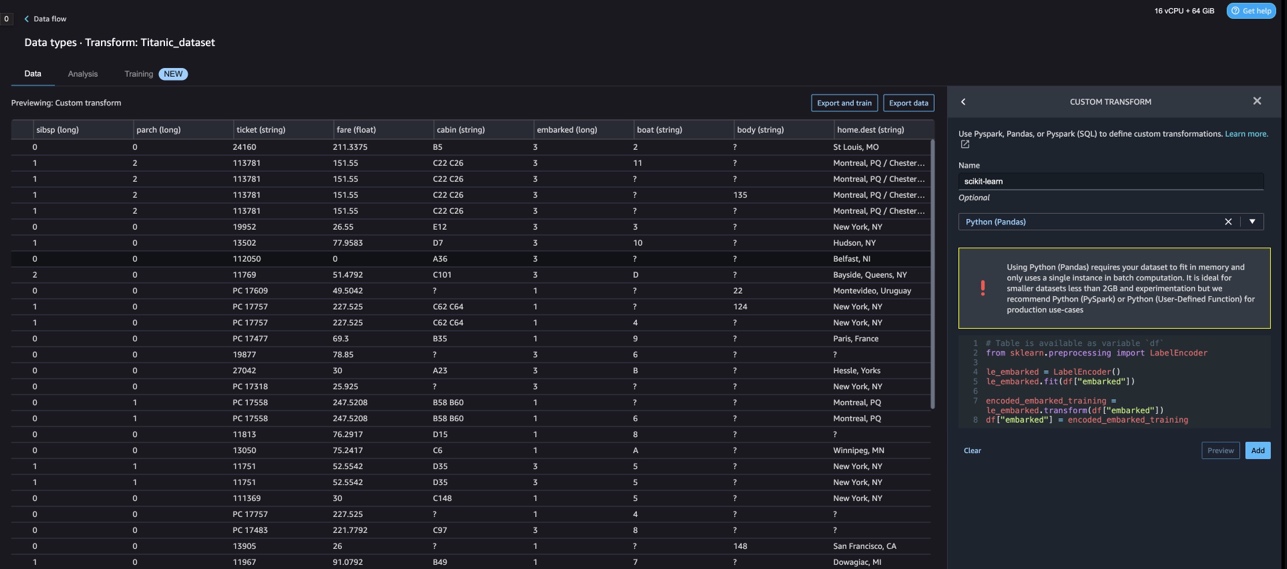

ڈسکریٹائزیشن

ڈسکریٹائزیشن (بصورت دیگر کے طور پر جانا جاتا ہے کوانٹائزیشن or بائننگ) مسلسل خصوصیات کو مجرد اقدار میں تقسیم کرنے کا ایک طریقہ فراہم کرتا ہے۔ مستقل خصوصیات کے ساتھ کچھ ڈیٹاسیٹس کو ڈسکریٹائزیشن سے فائدہ ہوسکتا ہے، کیونکہ ڈسکریٹائزیشن مسلسل صفات کے ڈیٹاسیٹ کو صرف برائے نام اوصاف کے ساتھ تبدیل کر سکتی ہے۔ ون ہاٹ انکوڈ شدہ ڈسکریٹائزڈ فیچرز تشریح کو برقرار رکھتے ہوئے ایک ماڈل کو مزید تاثراتی بنا سکتے ہیں۔ مثال کے طور پر، ڈسکریٹائزر کے ساتھ پری پروسیسنگ لکیری ماڈلز میں نان لائنیرٹی متعارف کروا سکتی ہے۔

درج ذیل کوڈ میں، ہم استعمال کرتے ہیں۔ KBinsDiscretizer عمر کے کالم کو 10 ڈبوں میں الگ کرنا:

آپ مندرجہ ذیل اسکرین شاٹ میں پرنٹ شدہ بن کے کنارے دیکھ سکتے ہیں۔

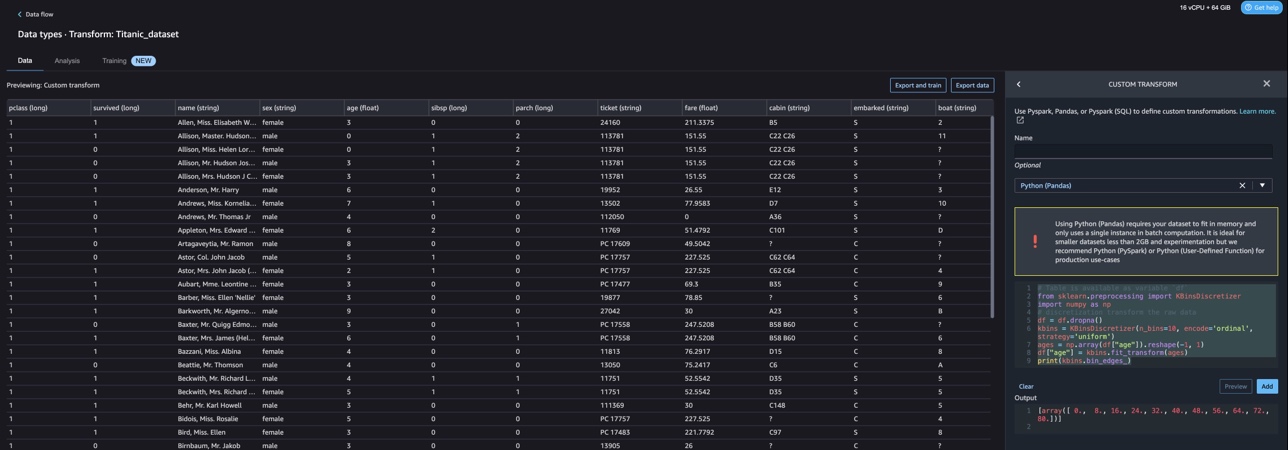

ایک گرم انکوڈنگ

ایمارکڈ کالموں میں قدریں واضح قدریں ہیں۔ لہذا، ہمیں اپنے ماڈل کے ساتھ درجہ بندی کرنے کے لیے ان تاروں کو عددی اقدار کے طور پر پیش کرنا ہوگا۔ ہم یہ ایک گرم انکوڈنگ ٹرانسفارم کا استعمال کرتے ہوئے بھی کر سکتے ہیں۔

Embarked کے لیے تین قدریں ہیں: S، C، اور Q۔ ہم ان کی نمائندگی نمبروں سے کرتے ہیں۔ درج ذیل کوڈ دیکھیں:

صاف کرو

جب آپ ڈیٹا رینگلر استعمال نہیں کر رہے ہیں، تو یہ ضروری ہے کہ اس مثال کو بند کر دیا جائے جس پر یہ چلتا ہے تاکہ اضافی فیسوں سے بچنے کے لیے۔

ڈیٹا رینگلر ہر 60 سیکنڈ میں آپ کے ڈیٹا کے بہاؤ کو خود بخود محفوظ کرتا ہے۔ کام کھونے سے بچنے کے لیے، ڈیٹا رینگلر کو بند کرنے سے پہلے اپنے ڈیٹا کے بہاؤ کو محفوظ کریں۔

- اسٹوڈیو میں اپنے ڈیٹا کے بہاؤ کو بچانے کے لیے، منتخب کریں۔ فائل، پھر منتخب کریں ڈیٹا رینگلر فلو کو محفوظ کریں۔.

- ڈیٹا رینگلر مثال کو بند کرنے کے لیے، اسٹوڈیو میں، منتخب کریں۔ رننگ انسٹینسز اور دانا.

- کے تحت چل رہی ایپسsagemaker-data-wrangler-1.0 ایپ کے آگے شٹ ڈاؤن آئیکن کا انتخاب کریں۔

- میں سے انتخاب کریں سب بند کرو تصدیق کے لئے.

ڈیٹا رینگلر ایک ml.m5.4xlarge مثال پر چلتا ہے۔ یہ مثال غائب ہو جاتی ہے۔ مثالیں چل رہی ہیں۔ جب آپ ڈیٹا رینگلر ایپ کو بند کرتے ہیں۔

ڈیٹا رینگلر ایپ کو بند کرنے کے بعد، اگلی بار جب آپ ڈیٹا رینگلر فلو فائل کھولیں گے تو اسے دوبارہ شروع کرنا ہوگا۔ اس میں چند منٹ لگ سکتے ہیں۔

نتیجہ

اس پوسٹ میں، ہم نے دکھایا کہ آپ ڈیٹا رینگلر میں کس طرح اپنی مرضی کے مطابق تبدیلیاں استعمال کر سکتے ہیں۔ ہم نے ڈیٹا رینگلر کنٹینر کے اندر موجود لائبریریوں اور فریم ورک کا استعمال کیا تاکہ پہلے سے موجود ڈیٹا کی تبدیلی کی صلاحیتوں کو بڑھایا جا سکے۔ اس پوسٹ میں مثالیں استعمال شدہ فریم ورک کے ذیلی سیٹ کی نمائندگی کرتی ہیں۔ ڈیٹا رینگلر کے بہاؤ میں ہونے والی تبدیلیوں کو اب ڈیٹا اوپس کے لیے ایک پائپ لائن میں چھوٹا کیا جا سکتا ہے۔

ڈیٹا رینگلر کے ساتھ ڈیٹا فلو استعمال کرنے کے بارے میں مزید جاننے کے لیے، دیکھیں ڈیٹا رینگلر فلو بنائیں اور استعمال کریں۔ اور ایمیزون سیج میکر قیمتوں کا تعین. ڈیٹا رینگلر کے ساتھ شروع کرنے کے لیے، دیکھیں ایمیزون سیج میکر ڈیٹا رینگلر کے ساتھ ایم ایل ڈیٹا تیار کریں۔. سیج میکر پر آٹو پائلٹ اور آٹو ایم ایل کے بارے میں مزید جاننے کے لیے، ملاحظہ کریں۔ ایمیزون سیج میکر آٹو پائلٹ کے ساتھ ماڈل کی ترقی کو خودکار بنائیں.

مصنفین کے بارے میں

میناکشی سندرم تھنڈاورائن AWS کے ساتھ ایک سینئر AI/ML ماہر ہے۔ وہ ان کے AI اور ML سفر میں ہائی ٹیک اسٹریٹجک اکاؤنٹس کی مدد کرتا ہے۔ وہ ڈیٹا سے چلنے والی AI کے بارے میں بہت پرجوش ہے۔

میناکشی سندرم تھنڈاورائن AWS کے ساتھ ایک سینئر AI/ML ماہر ہے۔ وہ ان کے AI اور ML سفر میں ہائی ٹیک اسٹریٹجک اکاؤنٹس کی مدد کرتا ہے۔ وہ ڈیٹا سے چلنے والی AI کے بارے میں بہت پرجوش ہے۔

سووک کمار ناتھ AWS کے ساتھ AI/ML سلوشن آرکیٹیکٹ ہے۔ اس کے پاس مشین لرننگ کے لیے اینڈ ٹو اینڈ ڈیزائنز اور سلوشنز کا وسیع تجربہ ہے۔ مالی، آپریشنل، اور مارکیٹنگ کے تجزیات کے اندر کاروباری تجزیات؛ صحت کی دیکھ بھال؛ فراہمی کا سلسلہ؛ اور IoT. کام سے باہر، سووک کو سفر کرنے اور فلمیں دیکھنے کا شوق ہے۔

سووک کمار ناتھ AWS کے ساتھ AI/ML سلوشن آرکیٹیکٹ ہے۔ اس کے پاس مشین لرننگ کے لیے اینڈ ٹو اینڈ ڈیزائنز اور سلوشنز کا وسیع تجربہ ہے۔ مالی، آپریشنل، اور مارکیٹنگ کے تجزیات کے اندر کاروباری تجزیات؛ صحت کی دیکھ بھال؛ فراہمی کا سلسلہ؛ اور IoT. کام سے باہر، سووک کو سفر کرنے اور فلمیں دیکھنے کا شوق ہے۔

ابیگیل ایمیزون سیج میکر میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ وہ صارفین کو DataWrangler میں اپنا ڈیٹا تیار کرنے اور تقسیم شدہ مشین لرننگ سسٹم بنانے میں مدد کرنے کے بارے میں پرجوش ہے۔ اپنے فارغ وقت میں، ابیگیل سفر، پیدل سفر، اسکیئنگ اور بیکنگ سے لطف اندوز ہوتی ہے۔

ابیگیل ایمیزون سیج میکر میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ وہ صارفین کو DataWrangler میں اپنا ڈیٹا تیار کرنے اور تقسیم شدہ مشین لرننگ سسٹم بنانے میں مدد کرنے کے بارے میں پرجوش ہے۔ اپنے فارغ وقت میں، ابیگیل سفر، پیدل سفر، اسکیئنگ اور بیکنگ سے لطف اندوز ہوتی ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو بلاک چین۔ Web3 Metaverse Intelligence. علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ایڈریین ایشلے کے ساتھ مستقبل کا نقشہ بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/authoring-custom-transformations-in-amazon-sagemaker-data-wrangler-using-nltk-and-scipy/

- : ہے

- : ہے

- $UP

- 1

- 10

- 100

- 7

- 8

- 9

- a

- ہمارے بارے میں

- اکاؤنٹس

- شامل کیا

- ایڈیشنل

- پتہ

- اعلی درجے کی

- کے بعد

- قرون

- AI

- AI خدمات

- AI / ML

- تمام

- کی اجازت دیتا ہے

- ساتھ

- اگرچہ

- ایمیزون

- ایمیزون کی تعریف

- ایمیزون سیج میکر

- ایمیزون سیج میکر ڈیٹا رینگلر

- تجزیہ

- تجزیاتی

- تجزیے

- اور

- اینڈریو

- ایک اور

- کوئی بھی

- اپاچی

- اپلی کیشن

- ایپلی کیشنز

- اطلاقی

- درخواست دینا

- نقطہ نظر

- فن تعمیر

- کیا

- AS

- At

- اوصاف

- کی توثیق

- مصنف

- تصنیف

- خود کار طریقے سے

- آٹو ایم ایل

- دستیاب

- AWS

- BE

- کیونکہ

- بن

- رہا

- اس سے پہلے

- فائدہ

- بن

- بورڈنگ

- لانے

- تعمیر

- عمارت

- تعمیر

- تعمیر میں

- کاروبار

- by

- کر سکتے ہیں

- صلاحیتوں

- کیس

- مقدمات

- کچھ

- چین

- تبدیل

- تبدیلیاں

- میں سے انتخاب کریں

- درجہ بندی

- کوڈ

- کوڈنگ

- مجموعہ

- کالم

- کالم

- جمع

- امتزاج

- کامن

- کمیونٹی

- کمپنیاں

- مکمل

- سمجھو

- وسیع

- کمپیوٹنگ

- شرط

- حالات

- کی توثیق

- خامیاں

- رکاوٹوں

- پر مشتمل ہے

- کنٹینر

- مواد

- مسلسل

- سکتا ہے

- جوڑے

- تخلیق

- اپنی مرضی کے

- گاہکوں

- اعداد و شمار

- ڈیٹا تجزیہ

- ڈیٹا کی تیاری

- اعداد و شمار پر مبنی ہے

- ڈیٹاسیٹس

- پہلے سے طے شدہ

- demonstrated,en

- ڈیزائن

- ڈیزائن

- اس بات کا تعین

- ترقی

- ترقی

- تیار ہے

- انحراف

- مختلف

- دریافت

- بات چیت

- تقسیم کئے

- تقسیم

- دستاویز

- دستاویزات

- نہیں کرتا

- ڈومین

- نیچے

- آسانی سے

- استعمال میں آسان

- ہنر

- یا تو

- عناصر

- آخر سے آخر تک

- انجینئر

- انجنیئرنگ

- افزودہ

- اداروں

- ہستی

- ماحولیات

- تشخیص

- ہر کوئی

- مثال کے طور پر

- مثال کے طور پر

- اس کے علاوہ

- ورزش

- موجودہ

- تجربہ

- اظہار

- توسیع

- وسیع

- وسیع تجربہ

- نکالنے

- فاسٹ

- تیز تر

- نمایاں کریں

- خصوصیات

- فیس

- چند

- فائل

- فائلوں

- مالی

- فٹنگ

- بہاؤ

- بہنا

- توجہ مرکوز

- توجہ مرکوز

- پر عمل کریں

- کے بعد

- کے لئے

- تشکیل

- فریم ورک

- فریم ورک

- مفت

- فرکوےنسی

- سے

- مزہ

- تقریب

- افعال

- پیدا

- پیدا

- جنریٹر

- حاصل

- ہینڈل

- ہے

- he

- صحت کی دیکھ بھال

- مدد

- مدد کرتا ہے

- ہائی ٹیک

- اعلی سطحی

- ہوم پیج (-)

- کس طرح

- تاہم

- HTML

- HTTP

- HTTPS

- انسانی

- آئکن

- شناخت

- شناخت

- شناختی

- تصویر

- درآمد

- اہم

- درآمد

- کو بہتر بنانے کے

- in

- دیگر میں

- معلومات

- بصیرت

- انسٹال

- مثال کے طور پر

- ضم

- انضمام

- انٹیلی جنس

- انٹرفیسز

- متعارف کرانے

- IOT

- IT

- ایوب

- سفر

- فوٹو

- کلیدی

- جانا جاتا ہے

- زبان

- آخری

- معروف

- جانیں

- سیکھنے

- لائبریریوں

- لائبریری

- کی طرح

- تھوڑا

- کھونے

- مشین

- مشین لرننگ

- برقرار رکھنے

- بنا

- بہت سے

- مارکیٹنگ

- بڑے پیمانے پر

- ریاضیاتی

- مئی..

- ذکر کیا

- طریقوں

- شاید

- منٹ

- ML

- ماڈل

- ماڈل

- ماڈیول

- ماڈیولز

- زیادہ

- منتقل

- فلم

- ایک سے زیادہ

- ضرب لگانا

- نام

- نام

- قدرتی

- قدرتی زبان عملیات

- ضرورت ہے

- نئی

- اگلے

- ویزا

- نوڈ

- نوڈس

- نوٹ بک

- تعداد

- تعداد

- عجیب

- مقصد

- of

- کی پیشکش

- پرانا

- on

- جہاز

- جہاز

- ایک

- کھول

- اوپن سورس

- آپریشنل

- زیادہ سے زیادہ

- اصلاح کے

- کی اصلاح کریں

- حکم

- اصل

- دیگر

- دوسری صورت میں

- ہمارے

- باہر

- پر

- خود

- پیکج

- پیکجوں کے

- pandas

- حصہ

- جذباتی

- انجام دیں

- جملے

- پائپ لائن

- پلیٹ فارم

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- علاوہ

- مقبول

- پوسٹ

- طریقوں

- تیار

- پرنٹ

- پروسیسنگ

- پیداوار

- پروفائلنگ

- پروگرام

- فراہم

- فراہم کرتا ہے

- مقصد

- پش

- ازگر

- معیار

- فوری

- بے ترتیب

- خام

- قابل اعتماد

- باقی

- کی نمائندگی

- جواب

- نتائج کی نمائش

- واپسی

- کا جائزہ لینے کے

- جڑ

- رن

- s

- sagemaker

- اسی

- نمونہ ڈیٹاسیٹ

- محفوظ کریں

- منظرنامے

- سائنسی

- سائنٹ سیکھنا

- سکرپٹ

- سیکنڈ

- محفوظ طریقے سے

- انتخاب

- سینئر

- علیحدہ

- سروس

- سروسز

- ترتیبات

- سیٹ اپ

- سیکنڈ اور

- ہونا چاہئے

- دکھائیں

- دکھایا گیا

- شوز

- بند کرو

- شٹ ڈاؤن

- سائن ان کریں

- اشارہ

- سادہ

- آسان بنانے

- ایک

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- حل

- حل

- کچھ

- ماخذ

- ذرائع

- چنگاری

- خصوصی

- ماہر

- سپن

- تقسیم

- چوک میں

- معیار

- شروع کریں

- شروع

- اعدادوشمار

- مرحلہ

- مراحل

- ذخیرہ

- ذخیرہ کرنے

- حکمت عملی

- ڈھانچہ

- سٹوڈیو

- اس طرح

- سویٹ

- فراہمی

- فراہمی کا سلسلہ

- کی حمایت کرتا ہے

- سسٹمز

- ٹیبل

- لے لو

- لینے

- ٹاسک

- ٹیکنیکل

- کہ

- ۔

- ماخذ

- ان

- لہذا

- یہ

- تین

- وقت

- کرنے کے لئے

- ٹوکن

- ٹوکن بنانا

- ٹوکن

- اوزار

- سب سے اوپر

- کل

- تبدیل

- تبدیلی

- تبدیلی

- تبدیل

- تبدیل

- سفر

- رجحان

- ui

- کے تحت

- استعمال کی شرائط

- استعمال کیس

- استعمال کیا جاتا ہے

- افادیت

- قیمت

- اقدار

- مختلف

- دورہ

- دیکھ

- راستہ..

- طریقوں

- اچھا ہے

- جس

- جبکہ

- گے

- ساتھ

- کے اندر

- بغیر

- الفاظ

- کام

- کام کے بہاؤ

- لکھنا

- لکھا

- تم

- اور

- زیفیرنیٹ